NLP2

NLP专业执行师课程

社会学理论

社会互动

01

研究人与人之间的互动关系,以及社会结构和社会规范对个体

行为的影响。

社会认知

02

探讨个体如何理解和解释社会现象,以及社会认知过程中的偏

差和刻板印象。

社会文化

03

研究不同文化背景下的人类行为和社会现象,以及文化对个体

和社会的影响。

神经语言学理论

神经语言学基础

研究语言处理过程中大脑的神经机制和功能。

通过计算机视觉技术对图像进行识别和分析,再结合NLP 技术对图像中的文字进行处理,可以实现图像中的文字识 别和信息抽取。

与大数据技术融合

通过大数据技术对海量数据进行处理和分析,再结合NLP 技术对文本数据进行处理,可以实现大规模文本数据的挖 掘和分析。

NLP在人工智能领域的应用前景

在智能客服领域

通过NLP技术对用户的问题进行 理解和分析,可以提供更加智能 化的客服服务,提高客户满意度。

NLP认为人类的行为和思考模式都是可以通过语言和行为来 影响和改变的,因此它提供了一套系统的方法和技巧,帮助 人们更好地理解自己和他人,提高沟通效果,解决心理和行 为问题。

NLP的历史与发展

NLP的历史可以追溯到20世纪70年代,当时美国加州大学的学者理查德·班德勒 和约翰·格林德尔开始研究人类的思维模式和沟通方式,并逐渐发展出了NLP的初 步理论。

教育与培训

NLP可以帮助教师和教育工作 者更好地理解学生的学习需求 ,提供更有针对性的教学方法 和培训方案。

商业与领导力

NLP可以帮助领导者更好地理 解员工的思维模式和行为习惯 ,提高团队协同作战能力,促

进组织发展。

02 NLP基本理论

语言学理论

语言结构

中文nlp预训练模型泛化能力评估

一、概述随着人工智能技术的发展,自然语言处理(NLP)领域也取得了长足的进步。

中文NLP预训练模型在自然语言理解、翻译、对话系统等方面都取得了显著的成就。

然而,这些预训练模型在真实场景中的泛化能力一直是一个备受关注的问题。

本文将对中文NLP预训练模型的泛化能力进行评估和探讨。

二、中文NLP预训练模型概述1. 当前主流的中文NLP预训练模型2. 这些模型在NLP任务中取得的成就3. 泛化能力对模型性能的重要性三、泛化能力的定义和评估方法1. 泛化能力的定义2. 目前常用的泛化能力评估方法3. 针对中文NLP预训练模型的泛化能力评估方法的优缺点分析四、中文NLP预训练模型的泛化能力问题1. 对比实验设计2. 结果分析2.1 泛化能力较好的模型2.2 泛化能力较差的模型3. 影响中文NLP预训练模型泛化能力的因素分析3.1 数据量3.2 数据质量3.3 预训练任务3.4 模型结构3.5 其他因素五、提升中文NLP预训练模型的泛化能力1. 数据增强方法2. 多任务学习3. 对抗训练4. 跨语言学习5. 模型结构优化六、结论与展望1. 对中文NLP预训练模型泛化能力进行总结2. 未来提升中文NLP预训练模型泛化能力的研究方向3. 结束语文章在概述部分直接指明本文要探讨的主题,即中文NLP预训练模型的泛化能力评估。

接着对中文NLP预训练模型进行了概述,并指出泛化能力对模型性能的重要性。

在泛化能力的定义和评估方法部分进行了详细的说明,为后续对中文NLP预训练模型的泛化能力问题进行分析打下了基础。

在第四部分对中文NLP预训练模型的泛化能力问题进行了深入的探讨和分析,并对影响泛化能力的因素进行了具体的分析。

在提升中文NLP预训练模型的泛化能力部分提出了具体的方法和建议。

最后在结论与展望部分对全文进行了总结,并展望了未来的研究方向。

整篇文章逻辑清晰,条理分明,结构合理。

七、提升中文NLP预训练模型的泛化能力为了提升中文NLP预训练模型的泛化能力,学术界和产业界提出了许多方法和技术。

ANSYS的最常用的命令解释

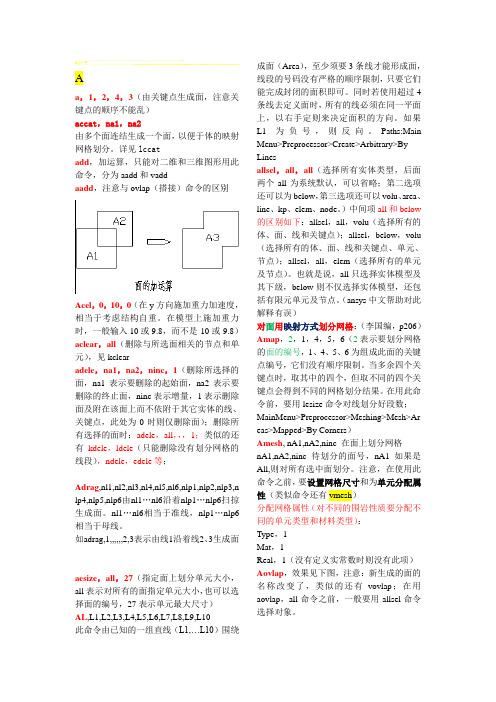

Aa,1,2,4,3(由关键点生成面,注意关键点的顺序不能乱)accat,na1,na2由多个面连结生成一个面,以便于体的映射网格划分。

详见lccatadd,加运算,只能对二维和三维图形用此命令,分为aadd和vaddaadd,注意与ovlap(搭接)命令的区别Acel,0,10,0(在y方向施加重力加速度,相当于考虑结构自重。

在模型上施加重力时,一般输入10或9.8,而不是-10或-9.8)aclear,all(删除与所选面相关的节点和单元),见kclearadele,na1,na2,ninc,1(删除所选择的面,na1表示要删除的起始面,na2表示要删除的终止面,ninc表示增量,1表示删除面及附在该面上而不依附于其它实体的线、关键点,此处为0时则仅删除面);删除所有选择的面时:adele,all,,,1;类似的还有kdele,ldele(只能删除没有划分网格的线段),ndele,edele等;Adrag,nl1,nl2,nl3,nl4,nl5,nl6,nlp1,nlp2,nlp3,n lp4,nlp5,nlp6由nl1…nl6沿着nlp1…nlp6扫掠生成面。

nl1…nl6相当于准线,nlp1…nlp6相当于母线。

如adrag,1,,,,,,2,3表示由线1沿着线2、3生成面aesize,all,27(指定面上划分单元大小,all表示对所有的面指定单元大小,也可以选择面的编号,27表示单元最大尺寸)AL,L1,L2,L3,L4,L5,L6,L7,L8,L9,L10此命令由已知的一组直线(L1,…L10)围绕成面(Area),至少须要3条线才能形成面,线段的号码没有严格的顺序限制,只要它们能完成封闭的面积即可。

同时若使用超过4条线去定义面时,所有的线必须在同一平面上,以右手定则来决定面积的方向。

如果L1为负号,则反向。

Paths:Main Menu>Preprocessor>Create>Arbitrary>By Linesallsel,all,all(选择所有实体类型,后面两个all为系统默认,可以省略;第二选项还可以为below,第三选项还可以volu、area、line、kp、elem、node。

NLP三个字母代表的意思

NLP三个字母代表的意思NLP为Neuro-Linguistic Programming的缩写,三个单词分别代表以下的意思:Neuro(脑神经),意为“身心”,指的是·我们的头脑和身体经由我们的脑神经系统联结在一起。

·我们的脑神经系统控制我们的感觉器官去维持与世界的联系。

Linguistic (语法),指的是·我们运用语言与别人作出相互影响,经由姿势、手势、习惯等无声语言显示我们的思考模式、信念及内心种种状态。

·我们的头脑与身体之间的联系机制所用的语言模式。

Programming(程序),指的是·借用计算机科学语言指出我们的意念、感觉和行为只不过是习惯性的程序,可以经由提升我们"思想”.的软件而行以改善。

·凭借改善我们思想和行为的重复程序,我信便能在行动中取得更满意的效果。

故此,我认为NLP也可以解释为研究我们的大脑如何工作的学问。

知道大脑如何工作后,我们可以配合和提升它,从而使人生更成功快乐。

也因此,我把NLP译为“身心语法程序学”。

3.美国科罗拉多州给NLP的定义关于人类行为与沟通程序的一套详细可行的模式。

虽然它本身并非一套心理治疗法,NLP 的重要法则可以被运用于了解人类经验和行为,和使之有所改变。

NLP曾被运用于治疗方面,结果是一套效果强大、快速和含蓄的技巧,能够在人类的行为和能力方面做成广泛和长久的改变。

NLP专注于修正和重似熊的设计思想模式,以求更大的灵活和能力。

4. NLP历史简介NLP的创立归功于两位美国人:理查德德德·班德勒和约翰…格林德。

美国加洲圣他·告鲁仕市的加州大学校园是NLP的发源地。

在20世纪70年代初期,理查德德德在那里读大学,在一次偶然的机会里他认识了家庭治疗大师弗占尼亚-萨特尔。

稍后,理查德德德受雇帮忙把弗吉尼亚刚在加拿大举行的为期一个月的工作访的内容制成录音带和文字记录。

nlp部分基本术语简释

nlp部分基本术语简释自然语言处理(Natural Language Processing,NLP)是计算机科学领域的一个重要研究方向,旨在让计算机具备理解人类语言的能力。

在NLP领域中,有一些基本术语需要了解,下面我将对其中的一些术语进行简单的解释。

1. 语言模型(Language Model):语言模型是根据一段文本的统计特征,预测下一个单词或句子的概率分布模型。

它可以用来生成新的语言序列或者评估一个句子的合理程度。

2. 分词(Tokenization):分词是将一段连续的文本切割成单个的词或者字符的过程。

它是NLP的基础步骤,常用于对句子进行处理和处理中文文本。

3. 词性标注(Part-of-Speech Tagging):词性标注是指为一段文本中的每个词标注其所属的词性,如名词、动词、形容词等。

它可以帮助计算机理解文本的语法结构和语义信息。

4. 命名实体识别(Named Entity Recognition,NER):命名实体识别是指识别一段文本中特定类型的实体,如人名、地名、组织机构等。

它可以帮助计算机理解文本中的重要信息和实体关系。

5. 文本分类(Text Classification):文本分类是指将一段文本划分到预定义的类别中。

它可以用于情感分析、垃圾邮件过滤、新闻分类等任务。

6. 机器翻译(Machine Translation):机器翻译是将一种语言的文本自动翻译为另一种语言的技术。

它可以帮助人们解决跨语言交流的问题。

7. 问答系统(Question Answering System):问答系统是指能够根据用户提出的问题,在知识库或大规模文本中找到相应答案的系统。

它常用于智能助手、搜索引擎等应用中。

8. 情感分析(Sentiment Analysis):情感分析是指识别一段文本中包含的情感倾向,如积极、消极、中立等。

它可以帮助企业了解用户对产品或服务的评价和态度。

以上介绍了一些NLP领域的基本术语,它们涵盖了NLP技术在不同应用中的核心概念。

NLP水性领导力的八项修炼

NLP水性領導力的八項修煉NLP (Neuro-Linguistic Programming) 是一門旨在改善溝通和領導能力的學科。

在這個快速變化和不確定的時代,水性領導力成為一種越來越受歡迎的領導風格。

水性領導者能夠適應各種情況、應對挑戰和引領團隊前進。

在這篇文章中,將探討NLP水性領導力的八項修煉。

1. 自我意識:水性領導者首先要有自我意識。

他們了解自己的價值觀、信念和偏好。

透過深入了解自己,他們能夠更好地了解其他人的想法和感受,從而更好地領導他們。

2. 情商:情商是理解和管理自己以及與他人的情感的能力。

水性領導者具有高情商,能夠理解和處理自己和團隊成員的情緒。

他們能夠有效地應對壓力和挫折,並在壓力下保持冷靜。

3. 彈性:水性領導者需具備彈性思維。

他們能夠快速適應變化,並針對不同的情況調整自己的策略。

他們不僅能夠在困難時保持冷靜,還能夠從挫折中學習並成長。

4. 創造力:水性領導者具有創造力。

他們能夠想出新的點子和解決方案,並鼓勵團隊成員采用創新方法。

他們能夠看到問題的不同面向,並提出符合團隊目標的創新解決方案。

5. 問題解決能力:水性領導者擁有強大的問題解決能力。

他們能夠分析問題、確定目標並制定有效的解決方案。

他們不僅能夠在壓力下保持冷靜,還能夠在面對挑戰時快速做出反應。

6. 影響力:水性領導者具有良好的影響力和說服能力。

他們能夠以積極的方式影響他人,激勵團隊成員並引導他們向共同的目標前進。

他們善於溝通和表達,能夠以有效的方式傳達他們的想法和願景。

7. 團隊合作:水性領導者重視團隊合作和合作精神。

他們能夠建立和諧的團隊關係,並培養團隊成員的信任和合作。

他們重視每個團隊成員的貢獻,並激勵他們發揮潛力。

8. 持續學習:水性領導者不斷學習和進步。

他們知道自己的知識和技能是不斷發展的,並持續尋求學習和成長的機會。

他們常常參加培訓課程、閱讀相關的書籍和研究報告,以保持競爭力。

總之,NLP水性領導力是一種強大且受歡迎的領導風格,它能夠幫助領導者適應不確定的環境、應對挑戰和引領團隊前進。

关于nlp十二条前提假设的问答延伸

题目:探讨自然语言处理(NLP)中的十二条前提假设1. 引言近年来,自然语言处理(NLP)技术的发展取得了长足的进步,其应用场景日益丰富,影响力也逐渐凸显。

在NLP领域,研究人员提出了一系列的前提假设,用以推动该领域的发展,其中最著名的便是“关于nlp十二条前提假设”。

本文将从深度和广度的角度探讨这十二条前提假设,并对其进行问答延伸,旨在为读者提供全面、深入的了解。

2. 十二条前提假设的解读1)意义:十二条前提假设是NLP领域的基石,它们在语言处理的过程中起着至关重要的作用。

2)信息:这些假设包含了对语言、语境、沟通等方面的认知,为理解和处理自然语言提供了基本的指导原则。

3)有效性:这些假设在实践中被广泛验证,对NLP技术的应用和改进具有重要意义。

3. 问答延伸Q1: 在NLP中,十二条前提假设的作用是什么?A: 十二条前提假设为NLP的研究和应用提供了指导原则,帮助研究人员理解和处理自然语言,推动了NLP技术的发展。

Q2: 这些前提假设具体包括哪些内容?A: 这些前提假设涉及到语言的结构、意义的表达、语境的影响等方面,涵盖了语言处理的基本要素。

Q3: 这些前提假设在实际应用中是否有效?A: 是的,这些前提假设经过多次实践验证,被证明对NLP技术的应用和改进具有积极的意义。

4. 深入探讨让我们回顾一下这十二条前提假设的具体内容。

其中,包括语言的通用性、语言的双重系统性、语言精度的限制等。

这些假设为我们理解并处理自然语言提供了基本原则,同时也在一定程度上限制了NLP技术的发展。

然而,随着人工智能的不断发展和NLP技术的深入研究,我们也逐渐意识到这些假设的局限性,并寻求突破的方法。

对于个人而言,我认为这些前提假设的提出是为了逼迫我们不断思考和探索语言的本质,在实践中发现问题、解决问题。

虽然这些假设或许不能完全覆盖自然语言的复杂性,但它们仍然是我们理解和处理语言的起点,也是NLP技术发展的基础。

我认为在今后的研究和实践中,我们应该以这些前提假设为基础,并不断对其进行验证和修正,以推动NLP技术的进一步发展。

nlp二指疗法

NLP二指疗法1. 引言NLP(自然语言处理)是一门研究人机之间自然语言交流的学科,旨在使计算机能够理解、处理和生成人类语言。

随着人工智能的发展,NLP在各个领域都扮演着重要的角色。

其中,NLP二指疗法是一种基于自然语言处理技术的心理疗法,通过分析和处理语言信息,帮助人们解决心理问题,改善心理健康。

2. NLP二指疗法的原理NLP二指疗法的核心原理是通过语言的运用来改变人们的思维方式和行为模式。

它结合了NLP的技术和心理疗法的理念,通过分析和处理人们的语言表达,帮助他们认识和改变不良的心理状态和行为习惯。

NLP二指疗法主要包括以下几个步骤:2.1 目标设定在进行NLP二指疗法之前,人们首先需要明确自己的目标。

目标的设定应该具体、可测量和可实现。

通过明确目标,人们可以更好地指导自己的思维和行为,达到心理健康的改善。

2.2 语言模式分析NLP二指疗法通过分析人们的语言模式,寻找其中的不良思维和行为习惯。

语言模式包括词汇、句式、表达方式等。

通过对语言模式的分析,人们可以认识到自己的不良思维和行为模式,并找到改善的方向。

2.3 语言模式改变在认识到自己的不良语言模式后,人们需要通过改变语言模式来改善心理健康。

改变语言模式可以包括以下几个方面:•积极语言:使用积极、正面的语言表达,避免消极、负面的词汇和表达方式。

•肯定语言:使用肯定、赞美的语言来表达自己的想法和感受,增强自信和自尊。

•目标导向语言:将语言与目标相结合,用积极的语言来描述自己的目标和期望。

•清晰明了的语言:使用简单、明了的语言表达,避免模糊和含糊不清的表达方式。

2.4 反馈和调整在进行语言模式改变后,人们需要进行反馈和调整。

通过观察自己的语言表达和思维方式的变化,人们可以评估自己的改善效果,并根据需要进行调整和改进。

3. NLP二指疗法的应用NLP二指疗法可以应用于个人心理健康的改善、情绪管理、行为习惯的调整等方面。

3.1 个人心理健康的改善NLP二指疗法可以帮助人们认识和改变自己的不良思维和行为习惯,提升个人的心理健康水平。

2.NLP是什么

NLP是什么?NLP这个名称是怎么来的呢?在NLP这名称中,N代表Neuro,指的是人类在用眼睛看、用耳朵听、用身体去感觉、用舌头去尝,以及用鼻子去闻的过程中,同时也发生在神经系统内的一些心理历程--也就是我们在进行内在思考的过程中,以及在体验外在世界的过程中所使用到的一些感觉。

一切我们所了解的,以及我们描述为意识的事物,都经由这些神经系统的窗口进入到我们的大脑。

L代表Linguistic,指的是语言,在我们与别人的沟通时,以及在我们思想并组织自己行为时所扮演的角色。

NLP帮助我们运用日常语言来做出更好的思考和更成功的行为。

P代表Programming,指的是我们可以用来设定我们本身思想行为的方式,就像电脑被设定程序去做某些特定的事情一样。

NLP这门学科的名字也反映了约翰?葛林德(John Grinder)和理查?班德勒(Richard Bandler)各自所学的背景。

一门无与伦比的身心科技在众多对人类身心运用方式的研究中,NLP(直译为神经语言程式学)是至今为止已出现的能够改变人类身心的方式,并使其到达卓越颠峰的身心行为的科技中效果最迅速、威力最强大的一种。

自1971年Richard Bandler与John Grinder二位发明人在美国加州大学Santa Cruz 分校开始着手研究以来,经过二十多年不断的发展,目前在北美与欧洲各国,NLP已逐渐发展成为一门新的学术,被广泛应用于人际沟通、个人成长、身心健康、企业经营管理、个人与组织学习、教育训练、心理治疗与成功辅导等领域,效果无与伦比,颇受赞赏,蔚为一股学习的新风潮。

目前全世界已出版的NLP书籍,英、德等文版有三百种左右之多,各种语言的NLP 专业杂志约有十种,英特网上的NLP网站约有一百多个。

此外,目前世界上的NLP训练机构约有一千个以上,欧美的三十多个国家已有全国性的NLP协会,更有两个国际组织在实施NLP专业资格的国际认证作业。

如此杰出而深受重视的一门身心科技,是在最近几年才开始出现在亚洲全国,尤其是华人地区,究其原因可归纳如下:(一)NLP的训练与应用,在过去都以英语传播,华人学习不易。

神经语言程序学(NLP)概况

神经语言程序学(NLP)概况神经语言程序学(Neuro-Linguistic Programming,简称NLP)是一种以心理学、语言学和神经科学为基础的行为变化和个人发展的方法论。

自20世纪70年代以来,NLP逐渐在心理治疗、教育、商业管理、体育和个人成长等多个领域中获得广泛应用。

本文将对神经语言程序学进行详细概述,包括其定义、主要理论、应用领域以及未来发展趋势。

一、神经语言程序学的定义神经语言程序学由理查德·班德勒(Richard Bandler)和约翰·格林德(John Grinder)于1970年代初期提出。

他们观察到一些成功的心理治疗师(如米尔顿·埃里克森)使用的技巧和策略能够有效促进客户的行为和情感变化,因此希望总结出一种系统化的方法来帮助更多的人。

NLP的核心理念在于,人的心理过程与生理过程有着密切的链接。

通过对语言的分析,我们可以理解个人如何构建自己的现实感知,并且通过改变其思维模式来影响情感及行为。

换言之,NLP着眼于个人内心世界与外部行为之间的相互作用,从而寻求更为积极和建设性的解决方案。

二、神经语言程序学的主要理论1. 代表系统NLP认为个体通过不同的感知系统来接收和处理信息,主要包括视觉、听觉和触觉三种基本代表系统。

每个人在交互中偏好使用某一特定代表系统,这影响了其思维方式和表达方式。

了解并运用适合对方代表系统的沟通方式,可以极大地改善人际交往效果。

2. 抽象层次理论抽象层次理论是理解人类思维方式的一种有力工具。

在决策和问题解决过程中,人们倾向于在不同的抽象层次上工作。

较低层次通常涉及具体事实和细节,而较高层次则涉及价值观、信念及使命感。

灵活地在不同抽象层次间移动,有助于提升创造力和解决问题的能力。

3. 改变信念NLP强调信念在塑造行为和情感上的重要性。

一些限制性的信念可能导致个人无法实现潜能,而转变这些信念则能够打开新的可能性。

通过针对特定问题运用NLP技术,个体可以识别并改变这些消极信念,从而提升自我效能感。

nlp2sql语义树规则

nlp2sql语义树规则

nlp2sql的语义树规则是一种将自然语言问题转化为SQL查询语句的方法。

它通过构建语义树来理解问题的语义,并将语义树转化为SQL语句。

NLP2SQL的语义树规则通常包括以下步骤:

1.词法分析:对输入的自然语言问题进行分词处理,将文本转换为单词序列。

2.句法分析:根据语法规则对分词后的结果进行句法分析,构建句法树。

3.语义分析:对句法树进行语义分析,理解句子的含义,构建语义树。

4.SQL语句生成:将语义树转化为SQL查询语句。

在NLP2SQL的语义树规则中,通常会使用一些启发式规则或机器学习算法来辅助构建语义树。

例如,可以使用实体识别技术来识别文本中的实体,如人名、地名、时间等;可以使用关系抽取技术来识别文本中的关系,如因果关系、时间关系等;还可以使用命名实体识别和关系抽取技术来构建更复杂的语义树。

总结,NLP2SQL的语义树规则是一种将自然语言问题转化为SQL查询语句的方法,它通过构建语义树来理解问题的语义,并将语义树转化为SQL语句。

nlp 动名词短语挖掘正则

nlp 动名词短语挖掘正则1. 嘿,你知道吗?NLP动名词短语挖掘正则那可真是个超酷的东西!就像是在文字的大森林里寻找宝藏的魔法咒语。

比如说“跑步锻炼”这个动名词短语,用正则表达式就能轻松把它从一堆文字里揪出来。

想象一下,你有一大堆日记内容,想找出自己所有关于运动的记录,正则表达式就像一个超级侦探,把每个“跑步锻炼”这样的短语都给你找出来,多厉害呀!2. NLP动名词短语挖掘正则,这就像是给混乱的文字世界建立秩序的魔法棒。

我曾经碰到这么个事儿,有个朋友要分析自己的工作记录,里面全是些杂七杂八的文字。

像“文件整理”这种动名词短语,用正则表达式挖掘的话,就像是把散落在地上的珍珠一颗颗串起来,一下就能知道自己到底做了多少文件整理相关的工作,真的很神奇呢,你难道不想试试吗?3. 哇塞,NLP动名词短语挖掘正则就像是打开神秘文字宝库的钥匙。

比如说在分析一部小说中的人物动作时,像“跳舞狂欢”这个动名词短语。

要是没有正则表达式,你得在那密密麻麻的文字里找多久呀?可正则表达式就不一样了,它能迅速定位这些动名词短语,就像老鹰抓小鸡一样准确,这多方便呀,你不觉得吗?4. 你有想过在浩如烟海的文本里快速找到动名词短语吗?NLP动名词短语挖掘正则就能做到。

我给你讲个例子哈,假如你是个老师,要分析学生作文里关于学习活动的描述,像“读书学习”这样的动名词短语。

正则表达式就像一个超级扫描仪,在作文里快速扫描,把这些短语一个不落的找出来,这是不是超级有用呢?5. NLP动名词短语挖掘正则,听起来有点复杂,但其实就像玩拼图游戏一样有趣。

拿新闻报道来说吧,要找出里面所有和事件发展相关的动名词短语,比如“会议讨论”。

正则表达式就像有双慧眼,能准确地把这些拼图碎片(动名词短语)从整幅画面(新闻报道)里挑出来,真的是非常奇妙,你难道不这么认为吗?6. 哟呵,NLP动名词短语挖掘正则就像是文字世界里的GPS。

我有个做市场调研的朋友,他要从调查问卷的回答里找到和产品使用相关的动名词短语,像“试用产品”。

nlp 大模型端到端解决问题的意思

NLP(自然语言处理)大模型端到端解决问题,是指利用大型深度学习模型,通过一次性输入原始数据并输出真实目标值的方式,直接解决各种自然语言处理问题。

这种方法颠覆了传统的 NLP 处理方法,从传统的分阶段处理转变为一步到位的方式,极大地提高了模型的准确性和效率。

1. NLP 大模型端到端解决问题的出现在深度学习技术逐渐成熟的背景下,利用大型深度学习模型解决端到端 NLP 问题逐渐成为可能。

这种方法的出现主要得益于以下几个方面的技术进步:(1)大型深度学习模型的出现,例如 Transformer、BERT 等,这些模型拥有数亿甚至数万亿的参数量,能够更好地挖掘文本中的信息,提高模型的表现;(2)端到端的训练方法的发展,通过一次性输入原始数据并输出真实目标值的方式,可以直接解决各种 NLP 问题,减少了传统分阶段处理的复杂度。

2. NLP 大模型端到端解决问题的意义NLP 大模型端到端解决问题的意义主要体现在以下几个方面:(1)提高了模型的准确性:大型深度学习模型能够更好地挖掘文本特征,通过端到端的训练方式能够更好地优化模型参数,从而提高了模型的准确性;(2)提高了模型的效率:端到端的训练方式减少了传统分阶段处理的复杂度,简化了模型训练过程,提高了模型的训练效率和推理速度;(3)拓展了 NLP 应用领域:NLP 大模型端到端解决问题的出现,使得 NLP 技术能够更好地应用于各个领域,例如机器翻译、文本生成、情感分析等。

3. NLP 大模型端到端解决问题的应用NLP 大模型端到端解决问题的应用已经涉及到各个领域,取得了显著的成果。

以机器翻译为例,利用大型深度学习模型,直接输入待翻译的句子,并输出目标语言的句子,能够更好地保持句子结构和语义信息;在文本生成领域,大型深度学习模型能够生成更加流畅、连贯的文本内容,实现更加人性化的文本输出;在情感分析领域,通过端到端的训练方式,能够更好地捕捉文本中的情感信息,提高情感分析的准确性。

自然语言处理NLP学习笔记二:NLP实战-开源工具tensorflow与jiagu使用

⾃然语⾔处理NLP学习笔记⼆:NLP实战-开源⼯具tensorflow与jiagu使⽤前⾔:NLP⼯具有⼈推荐使⽤spacy,有⼈推荐使⽤tensorflow。

jiagu的中⽂分词是基于深度学习的⽅法的。

看来甲⾻的分词还是⽐较先进的。

分词⼀般有3种,字典的,统计学的,深度学习的。

另:需要⼀点python知识,⾃⾏复习。

1. 环境准备经过各种折腾,总结如下:TensorFlow运⾏环境需要使⽤Python3.5或以上,建议Python3.7.3,tensorflow ⾄少1.6,建议1.14版本。

OS上的C运⾏库Glibc版本⾄少2.23以上。

如果你已经准备好这些环境了,跳过此步。

1) Windows:Python开发⼯具:pycharm 社区版anaconda 集成了python编译⼯具的管理⼯具2)Linux:2.1下载3.7安装包:2.2 解压:tar -xvJf Python-3.7.3.tar.xz2.3 安装依赖包:yum install zlib-devel bzip2-devel openssl-devel ncurses-devel sqlite-devel readline-devel tk-devel gcc makeyum install libffi-devel -y (如不安装,会报ModuleNotFoundError: No module named '_ctypes错误)2.4 编译安装:./configure prefix=/usr/local/python3make && make install2.5 检查效果以及设置Python2,3共存::[]# python2 -VPython 2.7.5[]# python -VPython 2.7.5[]# ln -s /usr/local/python3/bin/python3 /usr/bin/pythonln: ⽆法创建符号链接"/usr/bin/python": ⽂件已存在[]# mv /usr/bin/python /usr/bin/python22[]# ln -s /usr/local/python3/bin/python3 /usr/bin/python[]# python -VPython 3.7.3[]# ll python*lrwxrwxrwx. 1 root root 30 7⽉ 29 09:46 python -> /usr/local/python3/bin/python3lrwxrwxrwx. 1 root root 9 12⽉ 13 2017 python2 -> python2.7lrwxrwxrwx. 1 root root 7 12⽉ 13 2017 python22 -> python2-rwxr-xr-x. 1 root root 7136 8⽉ 4 2017 python2.7-rwxr-xr-x. 1 root root 1835 8⽉ 4 2017 python2.7-configlrwxrwxrwx. 1 root root 16 3⽉ 8 2018 python2-config -> python2.7-configlrwxrwxrwx. 1 root root 14 3⽉ 8 2018 python-config -> python2-config2. 安装tensorflow/Jiagupip install tensorflow或:pip install --target=e:\tensorflow tensorflowconda create -n tf --target=e:\tensorflow tensorflowpip install jiagu注:1.linux下如果报找不到pip命令,则需要先配置ln -s /usr/local/python3/bin/pip3 /usr/bin/pip2.linux下直接安装Jiagu,会⾃动关联安装上tensorflow,因此可以直接执⾏Jiagu安3. 默认国外源下载⾮常慢,使⽤国内的下载⽐较快4. 卸载TensorFlow:pip uninstall tensorflow 3. 中⽂分词demo代码功能:⽤户输⼊⼀段话,⼀键进⾏分词,关键词提取,⽂本摘要等。

利用Tensorflow进行自然语言处理(NLP)系列之二高级Word2Vec

利⽤Tensorflow进⾏⾃然语⾔处理(NLP)系列之⼆⾼级Word2Vec本篇也同步笔者另⼀博客上(https:///qq_37608890/article/details/81530542)⼀、概述在上⼀篇中,我们介绍了Word2Vec即词向量,对于Word Embeddings即词嵌⼊有了些基础,同时也阐述了Word2Vec算法的两个常见模型:Skip-Gram模型和CBOW模型,本篇会对两种算法做出⽐较分析并给出其扩展模型-GloVe模型。

⾸先,我们将⽐较下原Skip-gram算法和优化后的新Skip-gram算法情况。

对⽐下Skip-gram与CBOW之间的差异以及两者随迭代次数变化⽽表现出的不同,利⽤现有资料,分析⼀下哪种⽅法更有利于⼯作的开展。

其次,讨论⼀些有助于提⾼⼯作效率的Word2Vec的扩展⽅法。

在学习的过程中,Word2Vec扩展⽅法涉及负例采样、忽略⽆效信息等等。

当然,还会涉及到⼀种新的词嵌⼊技术---Global Vectors(GloVe)及GloVe与Skip-gram和CBOW的⽐较。

最后,将学习如何使⽤Word2VEC来解决现实世界的问题:⽂档分类。

⼆、原始Skip-gram模型优化前后⽐较1、理论说明原始Skip-gram模型实际是因为没有中间隐含层(Hidden Layers),⽽是使⽤两个不同的embedding 层(嵌⼊层)或projection层(投影层),且定义了由嵌⼊层本⾝派⽣的代价函数。

这⾥可以对原始Skip-gram和改进后的Skip-gram模型图做个对⽐。

图2-1 是原始Skip-gram模型图,图2-2是改进后的Skip-gram模型图(在上⼀篇系列⼀中也有出现)。

图2-1 不含隐藏层的原始Skip-gram模型图图2-2 含有隐含层的改进型Skip-gram模型图2、Tensorflow实施对⽐由于原始Skip-gram模型不含有隐藏层,所以我们⽆法像上⼀篇实现的版本那样简单,因为这⾥的损失函数需要利⽤TensorFlow⼿⼯编制,不像改进版的那样可以直接使⽤内置函数。

atv320hu40n4故障代码NLP

atv320hu40n4故障代码NLP

atv320hu40n4电动机短路故障

故障代码:NLP

(1)故障名称:变频器根据短路程度的不同,可显示NLP1电动机短路;NLP2有阻抗短路;NLP3接地短路。

(2)生故障的原因::NLP1:当变频器输出相间或输出对地发生短路,用硬件检测此故障并快速响应(几个微秒),触发故障的电流阈值在变频器3~4倍的额定电流之间。

(3)NLP2:变频器因为变频器输出相间或输出相对地发生阻抗短路,使用软件检测此故障,时间几个毫秒,变频器输出接地可能的原因有:电动机本身的短路;过长的电动机电缆,如果有多个电动机并联,电动机与变频器之间的电缆长度超过80米,而未使用电动机电抗器或变频器输出侧的正弦波滤波器来降低接地漏电流。

(4)产生故障的原因:电动机或变频器到电动机的电缆绝缘问题;电流互感器故障;电源板包括|GBT功率部分故障;控制板故障。

NLP3:当电动机起动或运行时,检测变频器输出与地发生短路,变频器检测到输出对地有大的漏电流。

(5)解决故障的方法:检查变频器到电动机之间的电缆绝缘;检查电动机绝缘;如果电动机与变频器之间的电缆过长,应使用电动机电抗器或变频器输出侧的正弦波滤波器以降低接地漏电流;降低变频器的开关频率,检查GBT功率部分是否正常。

llama2 原理

Llama2 原理解析引言Llama2 是一种基于深度学习的自然语言处理(NLP)模型,它在各种 NLP 任务中表现出色。

本文将详细解释 Llama2 的基本原理,包括其架构、预训练和微调过程、输入输出处理以及应用案例等内容。

Llama2 架构Llama2 的架构主要由两个主要组件组成:Transformer 编码器和任务特定的头部。

其中,Transformer 编码器负责将输入文本转换为表示向量,任务特定的头部则利用这些表示向量进行具体的任务处理。

Transformer 编码器Transformer 编码器是 Llama2 的核心组件,它由多个 Transformer 编码层组成。

每个 Transformer 编码层由多头自注意力机制和前馈神经网络组成。

自注意力机制(Self-Attention)是 Transformer 架构的关键组成部分。

它通过计算输入序列中每个位置的注意力权重,来获取每个位置的上下文表示。

具体而言,自注意力机制通过计算查询、键和值之间的相似度,得到一个权重分布,然后将值与权重相乘并求和,从而得到上下文表示。

前馈神经网络(Feed-Forward Neural Network)是 Transformer 编码层的另一个重要组件。

它由两个线性层和一个激活函数组成,用于对自注意力机制的输出进行非线性变换。

多个 Transformer 编码层的堆叠形成了 Llama2 的整体编码器。

通过多层堆叠,Llama2 可以通过多次自注意力机制和前馈神经网络的迭代来获取更丰富的表示能力。

任务特定的头部任务特定的头部是 Llama2 架构的第二个组件,它负责将 Transformer 编码器的输出转换为特定任务的预测结果。

不同的任务可能需要不同的头部结构,例如全连接层、卷积神经网络或者其他特定的结构。

预训练和微调过程Llama2 的性能得益于其预训练和微调的两个阶段。

预训练在预训练阶段,Llama2 使用大规模的无标签文本数据进行训练,以学习通用的语言表示。

ansys常用命令的中文翻译A

ansys常用命令的中文翻译1. A,P1,P2,…,P17,P18(以点定义面)2. AADD,NA1,NA2,…NA8,NA9(面相加)3. AATT,MAT,REAL,TYPE,ESYS,SECN(指定面的单元属性)【注】ESYS为坐标系统号、SECN为截面类型号。

4. *ABBR,Abbr,String(定义一个缩略词)5. ABBRES,Lab,Fname,Ext(从文件中读取缩略词)6. ABBSAVE,Lab,Fname,Ext(将当前定义的缩略词写入文件)7. ABS,IR,IA,--,--,Name,--,--,FACTA(取绝对值)【注】*************8. ACCAT,NA1,NA2(连接面)9. ACEL,ACEX,ACEY,ACEZ(定义结构的线性加速度)10. ACLEAR,NA1,NA2,NINC(清除面单元网格)11. ADAMS,NMODES,KSTRESS,KSHELL【注】*************12. ADAPT, NSOLN, STARGT, TTARGT, FACMN, FACMX, KYKPS, KYMAC【注】*************13. ADD,IR, IA, IB, IC, Name, --,-- , FACTA, FACTB, FACTC(变量加运算)14. ADELE,NA1,NA2,NINC,KSWP(删除面)【注】KSWP =0删除面但保留面上关键点、1删除面及面上关键点。

15. ADRAG,NL1,NL2,…,NL6,NLP1,NLP2,…,NLP6(将既有线沿一定路径拖拉成面)16. AESIZE,ANUM,SIZE(指定面上划分单元大小)17. AFILLT,NA1,NA1,RAD(两面之间生成倒角面)18. AFSURF,SAREA,TLINE(在既有面单元上生成重叠的表面单元)19. *AFUN, Lab(指定参数表达式中角度单位)20. AGEN, ITIME, NA1, NA2, NINC, DX, DY, DZ, KINC, NOELEM, IMOVE(复制面)21. AGLUE,NA1,NA2,…,NA8,NA9(面间相互粘接)22. AINA,NA1,NA2,…,NA8,NA9(被选面的交集)23. AINP,NA1,NA2,…,NA8,NA9(面集两两相交)24. AINV,NA,NV(面体相交)25. AL,L1,L2,…,L9,L10(以线定义面)26. ALIST,NA1,NA2,NINC,Lab(列表显示面的信息)【注】Lab=HPT时,显示面上硬点信息,默认为空。

nlp应用详解

nlp应用详解1. 社交媒体分析随着社交媒体的普及,用户在Facebook、Twitter、Instagram等平台上产生了大量的文本数据。

这些数据包括用户发布的言论、评论、分享的链接等,对这些数据进行分析能够帮助企业了解用户的喜好、情感倾向和社交网络结构。

NLP技术可以用于社交媒体数据的情感分析、主题提取、用户画像构建等任务。

情感分析(Sentiment Analysis)是指根据文本中的情感信息,判断文本表达的是正面情感还是负面情感。

情感分析的应用场景非常广泛,比如企业可以通过分析用户在社交媒体上发表的评论和言论,了解用户对其产品和服务的满意度和期望,为其产品定位和市场营销提供数据支持。

采用NLP技术来进行情感分析的方法一般是将文本转换成数字表示,然后利用机器学习模型进行训练和预测。

主题提取(Topic Extraction)是指从文本数据中自动抽取出描述文本主题的关键词或短语。

主题提取对于分析大规模社交媒体数据非常重要,可以帮助企业了解用户讨论的热点话题、行业趋势和竞争情报。

NLP技术可以用于TF-IDF、LDA(Latent Dirichlet Allocation)、BERT等方法的主题提取。

用户画像(User Profiling)是指从社交媒体数据中挖掘出用户的个人特征和行为习惯,包括用户的兴趣爱好、社交圈子、地理位置等。

用户画像能够帮助企业更精准地了解用户需求,推出符合用户口味的产品和服务。

NLP技术可以用于文本分类、实体抽取、关键词抽取等任务,从而实现用户画像的构建。

2. 智能客服随着人工智能技术的发展,智能客服系统已经成为企业服务的重要组成部分。

智能客服系统利用NLP技术分析用户提出的问题,通过自然语言理解(Natural Language Understanding,NLU)和自然语言生成(Natural Language Generation,NLG)技术生成自然语言的回复,与用户进行交互。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

B. 投契合拍七步法

5. 用字措词同步 6. 价值观同步

理解不代表认同,认同不代表接受,接受不代表投降

7. 自我身份同步

9

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

沟通从心开始 夫惟不争,故天下莫能与之争 —— 老子《道德经》

10

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

C. 投契合拍的更深层意义

和谐

平衡 同理心 尊重 一致性 最重要是与你自己投契合拍!

你喜欢你自己吗?

你聆听你自己吗? 你的行为与你的内在身份、信念、价 值观和精神灵性投契合拍吗?

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

NLP亲和力的奥秘(二)

讲师:胡谢骅

聚成华企在线商学院

1

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

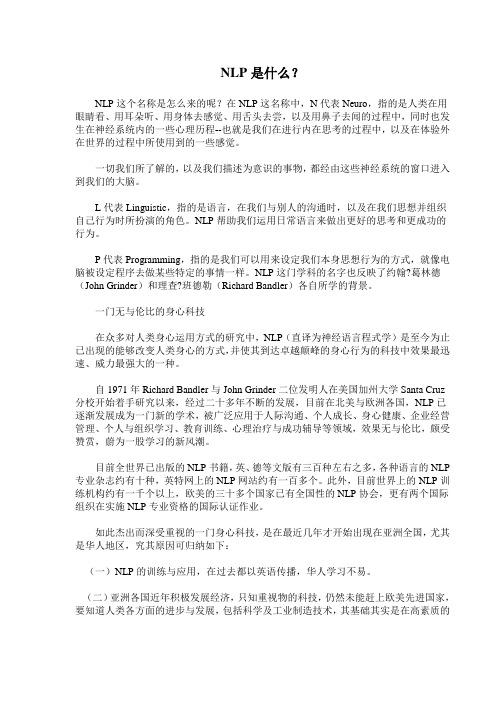

投契合拍的三种类型人的比较

1. 视觉型: 站、坐都比较直,讲话的时候喜欢眼睛直看着你 2. 听觉型: 坐姿喜欢翘二郎腿 ,聆听时喜欢头托着下巴 3. 触觉型:

投契合拍的实际运用

◆ 根据眼珠以及细微的表情,来知道一个

人是否在说谎

◆ 对于左撇子要把上面图画反过来就对了 ◆ 在想出来的,找到的那一刹那,那个眼 珠转在哪里才是关键

6

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

B. 投契合拍七个步骤

1. 情绪及面部表情同步

2. 语气语调语速同步 3. 肢体动作同步 4. 呼吸方式频率同步

11

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

“教育是为美好生活作准备!”

——斯宾塞

Thanks!

12

7

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

脑波—冥想—潜意识

Brainwave-Meditation-Subconscious/Unconscious

0.5

DELTA

1 2 3 4

4.5 5 5.5

6 6.5 7

THETA

7.5 8

9 10 11 12

ALPHA

13 14

VC视觉想像 Visual Constructed

VR视觉回忆 Visual Remembered

AC听觉想像 Auditory Constructed

K运动知觉 Kinesthetic

5

AR听觉回忆 Auditory Remembered

AD听觉用字 Auditory Digital

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

喜欢摸着,碰着,接触着

2

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

视觉型

右上 中 左上

听觉型

右 中 左

感觉型

右下

3

中下

左下

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台

回答问题眼珠不转的原因

1. 死人

2. 问题太简单

3. 拒绝回答

4

做 最 专 业 、 最 系 统 化 的 企 业 全 员 培 训 平 台