Python扩展TimedRotatingFileHandler

python内置模块之Log日志模块

python内置模块之Log⽇志模块Log⽇志模块前⾔logging 是python中的⼀个包,封装所有⽇志功能。

例如获取⽇志器 logging.getLogger 是logging包的__init__⽂件中定义的函数(包的 __init__⽂件中的函数直接可以使⽤包名.函数名调⽤),如下 getLogger 代码:def getLogger(name=None):"""Return a logger with the specified name, creating it if necessary.If no name is specified, return the root logger."""if not name or isinstance(name, str) and name == :return rootreturn Logger.manager.getLogger(name)root = RootLogger(WARNING)class RootLogger(Logger):"""A root logger is not that different to any other logger, except thatit must have a logging level and there is only one instance of it inthe hierarchy."""def__init__(self, level):"""Initialize the logger with the name "root"."""Logger.__init__(self, "root", level)def__reduce__(self):return getLogger, ()即 getLogger 函数返回值为Logger类的实例对象。

Python模块之Logging——常用handlers的使用

Python模块之Logging——常⽤handlers的使⽤⼀、StreamHandler流handler——包含在logging模块中的三个handler之⼀。

能够将⽇志信息输出到sys.stdout, sys.stderr 或者类⽂件对象(更确切点,就是能够⽀持write()和flush()⽅法的对象)。

只有⼀个参数:class logging.StreamHandler(stream=None)12⽇志信息会输出到指定的stream中,如果stream为空则默认输出到sys.stderr。

⼆、FileHandlerlogging模块⾃带的三个handler之⼀。

继承⾃StreamHandler。

将⽇志信息输出到磁盘⽂件上。

构造参数:class logging.FileHandler(filename, mode='a', encoding=None, delay=False)12模式默认为append,delay为true时,⽂件直到emit⽅法被执⾏才会打开。

默认情况下,⽇志⽂件可以⽆限增⼤。

三、NullHandler空操作handler,logging模块⾃带的三个handler之⼀。

没有参数。

四、WatchedFileHandler位于logging.handlers模块中。

⽤于监视⽂件的状态,如果⽂件被改变了,那么就关闭当前流,重新打开⽂件,创建⼀个新的流。

由于newsyslog或者logrotate的使⽤会导致⽂件改变。

这个handler是专门为linux/unix系统设计的,因为在windows系统下,正在被打开的⽂件是不会被改变的。

参数和FileHandler相同:class logging.handlers.WatchedFileHandler(filename, mode='a', encoding=None, delay=False)12五、RotatingFileHandler位于logging.handlers⽀持循环⽇志⽂件。

python中rotate方法 pil库 语法

文章标题:深度解析Python中的rotate方法和PIL库在Python编程和图像处理中,rotate方法是一个非常重要的功能。

PIL(Python Imaging Library)作为Python中用于图像处理的核心库,其rotate方法更是被广泛应用。

在本文中,我将深入探讨Python中的rotate方法和PIL库,帮助您全面理解其语法、功能和应用。

一、rotate方法的基本概念在PIL库中,rotate方法用于对图像进行旋转操作。

通过指定旋转的角度,可以使图像按照指定的角度进行旋转变换。

其基本语法如下:```pythonnew_image = image.rotate(angle)```其中,new_image为旋转后的新图像对象,image为待旋转的原图像对象,angle为旋转的角度。

二、rotate方法的深度理解1. 逆时针旋转和顺时针旋转在rotate方法中,角度可正可负。

正角度表示逆时针旋转,负角度表示顺时针旋转。

通过灵活运用正负角度,可以实现灵活的图像旋转效果。

2. 旋转中心的控制除了旋转角度外,rotate方法还可接受一个可选的参数,用于指定旋转中心。

默认情况下,旋转中心为图像的中心点。

但如果需要指定其他旋转中心,只需在rotate方法中传入center参数即可实现。

3. 填充颜色的处理在旋转过程中,由于图像的形状可能会发生变化,因此可能会产生一些空白的区域。

这时,可以通过指定fillcolor参数,来填充旋转后空白区域的颜色,使得图像旋转后更加美观。

三、PIL库在图像处理中的应用PIL库作为Python中最重要的图像处理库之一,其功能非常强大。

除了rotate方法外,PIL还提供了丰富的图像处理功能,如缩放、裁剪、滤镜等。

结合rotate方法,可以实现更加灵活多样的图像处理效果。

四、个人观点和总结作为一名经验丰富的Python开发者,我对于PIL库中的rotate方法有着深刻的理解和丰富的实践经验。

rotatingfilehandler函数定义-概述说明以及解释

rotatingfilehandler函数定义-概述说明以及解释1.引言1.1 概述在现代的计算机编程中,日志记录是非常重要的一部分。

在软件开发中,我们经常会需要记录程序的运行情况,以便后续分析和故障排查。

而日志记录的方式有很多种,其中之一就是利用Python的logging模块。

在logging模块中,RotatingFileHandler函数是一个非常常用的工具,它可以帮助我们实现日志文件的滚动和管理。

通过RotatingFileHandler函数,我们可以设置日志文件的大小和数量,当日志文件到达设定的大小后,会自动创建新的日志文件来继续记录日志。

本文将就RotatingFileHandler函数的定义、参数和作用进行详细介绍,帮助读者更好地理解和应用这一功能。

1.2文章结构1.2 文章结构本文将首先介绍rotatingfilehandler函数的定义,包括其参数和作用。

然后将探讨rotatingfilehandler函数在实际应用场景中的使用方法和优势。

最后将对rotatingfilehandler函数的未来发展和潜在发展方向进行展望。

通过本文的介绍,读者将能够更全面地了解rotatingfilehandler函数及其在日常开发中的重要性和价值。

1.3 目的:rotatingfilehandler函数定义的目的是为了实现日志滚动功能,即将日志文件按指定的大小进行分割和保存,避免单个日志文件过大导致处理困难或占用过多磁盘空间。

通过使用rotatingfilehandler函数,可以方便地管理日志文件,实现日志的定期轮换和归档,确保系统的日志记录和管理工作的高效性和可靠性。

此函数的设计旨在提高日志记录和管理的效率,使得开发人员能够更好地跟踪和分析系统运行过程中产生的日志信息,从而更好地进行故障排查和性能优化。

通过深入了解rotatingfilehandler函数的定义和用法,可以更好地掌握Python中的日志处理技术,为系统的稳定性和可维护性提供有效支持。

pythonlogging模块之TimedRotatingFileHandler实现每天一。。。

TimedRotatingFileHandler类处于logging.handles 模块中,提供重命名磁盘上的日志文件(以某种形式)

官网上详细的介绍:

ex:

import logging from logging.handlers import TimedRotatingFileHandler

logHandler = TimedRotatingFileHandler("logfile",when="midnight") logFormatter = logging.Formatter('%(asctime)s %(name)-12s %(levelname)-8s %(message)s') logHandler.setFormatter( logFormatter ) logger = logging.getLogger( 'MyLogger' ) logger.addHandler( logHandler ) logger.setLevel( )

您使用的浏览器不受支持建议使用新版浏览器

pythonlogging模块之 TimedRotatingFileHandler实现每天一。。 。

方法很简单:写log到比如app.log的文件中,然后再满足一定条件之后(比如文件的大小不超过多少bytes,文件的行数不超过多少count, 或者每天生成一个日志文件)就会将满足条件的app.log 重命名。这样就可以实现每天生成一个日志文件的需求了。

for k in nge(5): ("Line %d" % k)

python通过TimedRotatingFileHandler按时间切割日志

python通过TimedRotatingFileHandler按时间切割⽇志通过TimedRotatingFileHandler按时间切割⽇志线上跑了⼀个定时脚本,每天⽣成的⽇志⽂件都写在了⼀个⽂件中。

但是⽇志信息不可能输出到单⼀的⼀个⽂件中。

原因有⼆:1.⽇志⽂件越来越⼤会影响系统的性能。

2.⽇志⽂件格式不够清晰,⽐如我想看今天的⽇志,不太⽅便找到的今天的⽇志信息(即使对⽇志输出做了时间提⽰)通过设置TimedRotatingFileHandler进⾏⽇志按周(W)、天(D)、时(H)、分(M)、秒(S)切割。

先看⼀个简单例⼦:import timeimport loggingimport osfrom logging import handlersdef _logging(**kwargs):level = kwargs.pop('level', None)filename = kwargs.pop('filename', None)datefmt = kwargs.pop('datefmt', None)format = kwargs.pop('format', None)if level is None:level = logging.DEBUGif filename is None:filename = 'default.log'if datefmt is None:datefmt = '%Y-%m-%d %H:%M:%S'if format is None:format = '%(asctime)s [%(module)s] %(levelname)s [%(lineno)d] %(message)s'log = logging.getLogger(filename)format_str = logging.Formatter(format, datefmt)# backupCount 保存⽇志的数量,过期⾃动删除# when 按什么⽇期格式切分(这⾥⽅便测试使⽤的秒)th = handlers.TimedRotatingFileHandler(filename=filename, when='S', backupCount=3, encoding='utf-8')th.setFormatter(format_str)th.setLevel()log.addHandler(th)log.setLevel(level)return logos.makedirs("./logs", exist_ok=True)logger = _logging(filename='./logs/default.log')if __name__ == '__main__':while True:time.sleep(0.1)('哈哈哈')结果如下:上述代码可以正常运⾏,⽽且也可以⽣成固定的⽇志个数,但是有⼀个问题,⽣成的⽇志⽂件格式是你的⽂件名+时间的格式,没有设置时间的话默认设置到了秒(这⾥是按秒切割)修改⽇志格式后缀名称:# 在上述代码中加⼊def namer(filename):return filename.split('default.')r = namer# 设置为S,默认的suffix为 Y-%m-%d_%H-%M-%Sth.suffix = "%Y-%m-%d_%H-%M-%S.log"# 为了看的更视觉效果,可以显⽰在控制台答应cmd = logging.StreamHandler()cmd.setFormatter(format_str)cmd.setLevel(level)log.addHandler(cmd)运⾏结果:名字好像可以了,但是⽇志好像没有起到⾃动删除的⽬的啊,⽽且也没在之前的log⽂件夹了。

Pythonlogging模块handlers用法详解

Pythonlogging模块handlers⽤法详解⼀、handlers是什么?logging模块中包含的类⽤来⾃定义⽇志对象的规则(⽐如:设置⽇志输出格式、等级等)常⽤3个⼦类:StreamHandler、FileHandler、TimedRotatingFileHandler⼆、handlers基础应⽤2.1 StreamHandler 控制台输出⽇志import logging#创建⼀个logger⽇志对象logger = logging.getLogger('test_logger')logger.setLevel(logging.DEBUG) #设置默认的⽇志级别#创建⽇志格式对象formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')#创建StreamHandler对象sh = logging.StreamHandler()#StreamHandler对象⾃定义⽇志级别sh.setLevel(logging.DEBUG)#StreamHandler对象⾃定义⽇志格式sh.setFormatter(formatter)logger.addHandler(sh) #logger⽇志对象加载StreamHandler对象#⽇志输出('newdream')上⾯代码执⾏后,会在控制台输出⽇志信息。

2.2 FileHandler ⽇志输出到⽂件import logging#创建⼀个logger⽇志对象logger = logging.getLogger('test_logger')logger.setLevel(logging.DEBUG) #设置默认的⽇志级别#创建⽇志格式对象formatter = logging.Formatter('%(asctime)s - %(name)s - %(levelname)s - %(message)s')#创建FileHandler对象fh = logging.FileHandler('test.log')#FileHandler对象⾃定义⽇志级别fh.setLevel(logging.DEBUG)#FileHandler对象⾃定义⽇志格式fh.setFormatter(formatter)logger.addHandler(fh) #logger⽇志对象加载FileHandler对象#⽇志输出('newdream')上⾯代码执⾏后,控制台不会输出⽇志信息,⽽会在当前⽂件夹新建⼀个test.log⽇志⽂件进⾏⽇志记录。

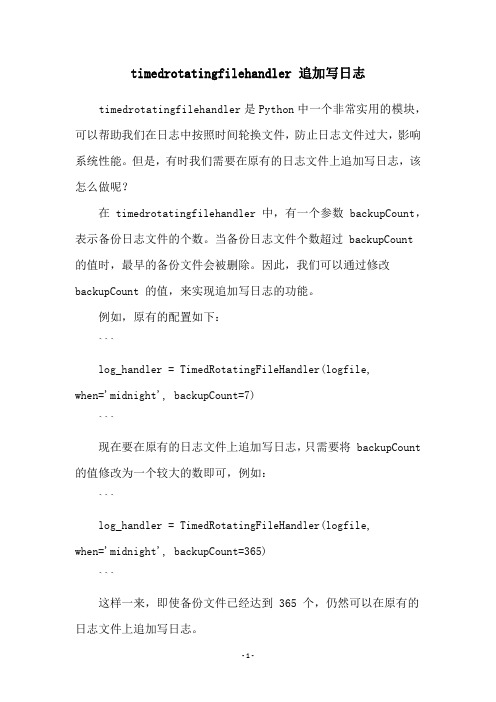

timedrotatingfilehandler 追加写日志

timedrotatingfilehandler 追加写日志timedrotatingfilehandler是Python中一个非常实用的模块,可以帮助我们在日志中按照时间轮换文件,防止日志文件过大,影响系统性能。

但是,有时我们需要在原有的日志文件上追加写日志,该怎么做呢?在 timedrotatingfilehandler 中,有一个参数 backupCount,表示备份日志文件的个数。

当备份日志文件个数超过 backupCount 的值时,最早的备份文件会被删除。

因此,我们可以通过修改backupCount 的值,来实现追加写日志的功能。

例如,原有的配置如下:```log_handler = TimedRotatingFileHandler(logfile,when='midnight', backupCount=7)```现在要在原有的日志文件上追加写日志,只需要将 backupCount 的值修改为一个较大的数即可,例如:```log_handler = TimedRotatingFileHandler(logfile,when='midnight', backupCount=365)```这样一来,即使备份文件已经达到 365 个,仍然可以在原有的日志文件上追加写日志。

当然,如果你需要在不同的时间段内,将日志写入不同的文件中,也可以通过设置不同的日志文件名来实现,例如:```log_handler = TimedRotatingFileHandler(logfile, when='M', backupCount=12)log_handler.suffix = '%Y-%m-%d.log'log_handler2 = TimedRotatingFileHandler(logfile2,when='W0', backupCount=5)log_handler2.suffix = '%Y-%m-%d.log'```这样,当时间按照月份轮换文件时,文件名为 YYYY-MM.log,当时间按照周日轮换文件时,文件名为 YYYY-MM-DD.log。

rotatingfilehandler 用法

rotatingfilehandler 用法RotatingFileHandler是Python标准库logging中的一种日志处理方式,可以在日志文件达到一定大小时,自动将文件进行切割,同时保留指定数量的历史日志文件。

关于RotatingFileHandler的使用,我们需要先了解一些历史背景。

日志是程序输出的一些信息,用于排查程序问题和进行分析。

早期的程序输出一般都是直接打印在控制台上的,这种方式存在一些很明显的缺陷,例如无法长期保存、无法追溯历史以及无法进行统计分析等。

这时候,程序员们开始思考如何更好地记录日志,于是乎产生了日志文件这个概念。

最早的日志文件管理方式是每过一定时间,程序就自动创建一个新的日志文件,将之前的日志文件命名为包含时间戳的文件,以此保留历史日志。

但这种方式存在一个很明显的问题,如果程序日志输出量很大,很快就会达到硬盘的存储上限,而老的日志文件由于一定时间后没有被清理,导致占用硬盘空间过多。

为了解决这个问题,RotatingFileHandler应运而生。

RotatingFileHandler的基本思路是:当日志文件大小达到设定值时,就将其备份并重新创建未使用的日志文件,以保留指定的最大备份数。

这样既可以限制单个日志文件的大小,也可以保留一定量的历史记录。

当然,RotatingFileHandler可以通过参数设置切割方式,支持按照文件大小和文件数量两种方式进行切割。

在Python中,通过以下方式可以使用RotatingFileHandler:```pythonimport loggingfrom logging.handlers import RotatingFileHandler# 创建RotatingFileHandler对象handler = RotatingFileHandler(filename,maxBytes=file_max_bytes, backupCount=file_num_limit)# 设置日志格式handler.setFormatter(logging.Formatter(format))# 添加handler到logger对象logger.addHandler(handler)```在代码中,我们需要传递三个参数给RotatingFileHandler,其中filename表示日志文件名,maxBytes表示单个日志文件的最大大小,backupCount表示保留历史备份的个数。

timedrotatingfilehandler 间隔

timedrotatingfilehandler 间隔

TimedRotatingFileHandler 是Python 的 logging 模块中用于日志处理的类,它可以按指定的时间间隔(例如每天、每小时等)轮换日志文件。

要设置 TimedRotatingFileHandler 的时间间隔,您需要指定一个时间字符串,该字符串描述了日志轮换的时间。

例如,以下设置将使日志文件每天轮换一次:

python复制代码:

import logging.handlers

handler = logging.handlers.TimedRotatingFileHandler('mylog',

when='daily', interval=1)

在这个例子中:

'mylog' 是日志文件的名称。

when='daily' 指定了时间单位,这里是每天。

interval=1 指定了时间间隔,这里是1天。

您还可以使用其他的时间单位,如 'midnight'(每天午夜)、'hourly'(每小时)等。

您还可以通过 backupCount 参数来指定保留的日志文件数量。

例如,以下设置将使日志文件每小时轮换一次,并保留

最近的3个文件:

python复制代码:

handler = logging.handlers.TimedRotatingFileHandler('mylog',

when='hourly', interval=1, backupCount=3)。

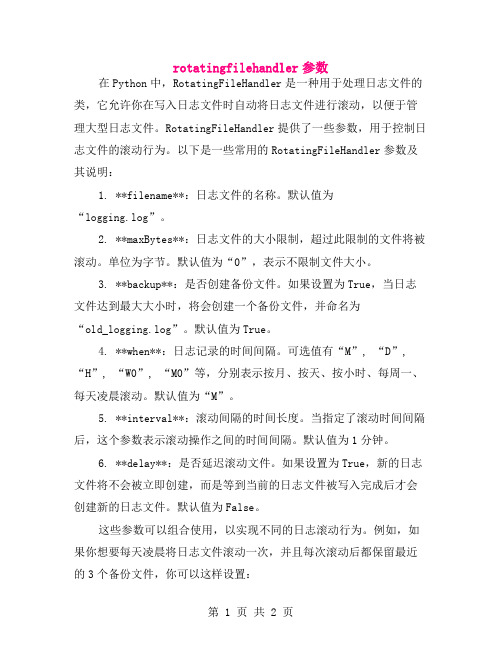

rotatingfilehandler参数

rotatingfilehandler参数在Python中,RotatingFileHandler是一种用于处理日志文件的类,它允许你在写入日志文件时自动将日志文件进行滚动,以便于管理大型日志文件。

RotatingFileHandler提供了一些参数,用于控制日志文件的滚动行为。

以下是一些常用的RotatingFileHandler参数及其说明:1. **filename**:日志文件的名称。

默认值为“logging.log”。

2. **maxBytes**:日志文件的大小限制,超过此限制的文件将被滚动。

单位为字节。

默认值为“0”,表示不限制文件大小。

3. **backup**:是否创建备份文件。

如果设置为True,当日志文件达到最大大小时,将会创建一个备份文件,并命名为“old_logging.log”。

默认值为True。

4. **when**:日志记录的时间间隔。

可选值有“M”, “D”, “H”, “W0”, “M0”等,分别表示按月、按天、按小时、每周一、每天凌晨滚动。

默认值为“M”。

5. **interval**:滚动间隔的时间长度。

当指定了滚动时间间隔后,这个参数表示滚动操作之间的时间间隔。

默认值为1分钟。

6. **delay**:是否延迟滚动文件。

如果设置为True,新的日志文件将不会被立即创建,而是等到当前的日志文件被写入完成后才会创建新的日志文件。

默认值为False。

这些参数可以组合使用,以实现不同的日志滚动行为。

例如,如果你想要每天凌晨将日志文件滚动一次,并且每次滚动后都保留最近的3个备份文件,你可以这样设置:```pythonimport logginglogging.basicConfig(filename='logging.log',maxBytes=10*1024*1024, backup=3, when='D')```在这个例子中,日志文件的最大大小被设置为10MB,每天凌晨滚动一次,并且每次滚动后都会保留最近的3个备份文件。

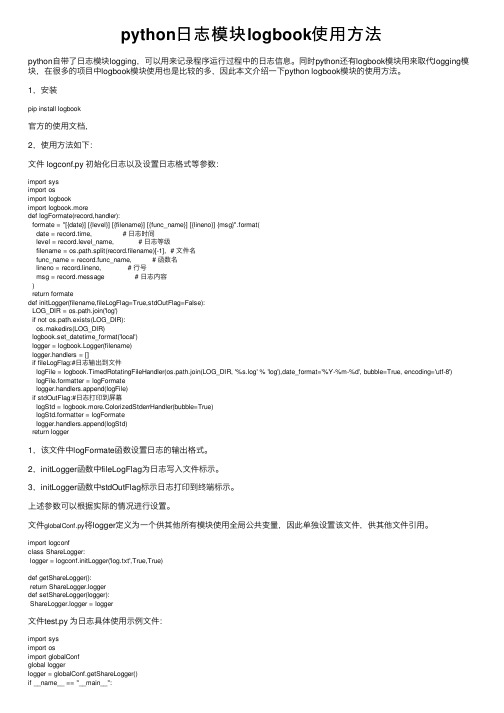

python日志模块logbook使用方法

python⽇志模块logbook使⽤⽅法python⾃带了⽇志模块logging,可以⽤来记录程序运⾏过程中的⽇志信息。

同时python还有logbook模块⽤来取代logging模块,在很多的项⽬中logbook模块使⽤也是⽐较的多,因此本⽂介绍⼀下python logbook模块的使⽤⽅法。

1,安装pip install logbook官⽅的使⽤⽂档,2,使⽤⽅法如下:⽂件 logconf.py 初始化⽇志以及设置⽇志格式等参数:import sysimport osimport logbookimport logbook.moredef logFormate(record,handler):formate = "[{date}] [{level}] [{filename}] [{func_name}] [{lineno}] {msg}".format(date = record.time, # ⽇志时间level = record.level_name, # ⽇志等级filename = os.path.split(record.filename)[-1], # ⽂件名func_name = record.func_name, # 函数名lineno = record.lineno, # ⾏号msg = record.message # ⽇志内容)return formatedef initLogger(filename,fileLogFlag=True,stdOutFlag=False):LOG_DIR = os.path.join('log')if not os.path.exists(LOG_DIR):os.makedirs(LOG_DIR)logbook.set_datetime_format('local')logger = logbook.Logger(filename)logger.handlers = []if fileLogFlag:#⽇志输出到⽂件logFile = logbook.TimedRotatingFileHandler(os.path.join(LOG_DIR, '%s.log' % 'log'),date_format='%Y-%m-%d', bubble=True, encoding='utf-8')logFile.formatter = logFormatelogger.handlers.append(logFile)if stdOutFlag:#⽇志打印到屏幕logStd = logbook.more.ColorizedStderrHandler(bubble=True)logStd.formatter = logFormatelogger.handlers.append(logStd)return logger1,该⽂件中logFormate函数设置⽇志的输出格式。

Pythonlogging日志的自动分割

Pythonlogging⽇志的⾃动分割⾃动切割⽰例Python的内置的logging模块通过设置TimedRotatingFileHandler进⾏⽇志按周(W)、天(D)、时(H)、分(M)、秒(S)切割。

import loggingimport osfrom logging import handlersclass Logger(object):# ⽇志级别关系映射level_relations = {'debug': logging.DEBUG,'info': ,'warning': logging.WARNING,'error': logging.ERROR,'critical': logging.CRITICAL}def__init__(self,filename,level='info',when='D',back_count=3,fmt='%(asctime)s - %(pathname)s[line:%(lineno)d] - %(levelname)s: %(message)s'):f_dir, f_name = os.path.split(filename)os.makedirs(f_dir, exist_ok=True) # 当前⽬录新建log⽂件夹self.logger = logging.getLogger(filename)format_str = logging.Formatter(fmt) # 设置⽇志格式self.logger.setLevel(self.level_relations.get(level)) # 设置⽇志级别sh = logging.StreamHandler() # 往屏幕上输出sh.setFormatter(format_str) # 设置屏幕上显⽰的格式th = handlers.TimedRotatingFileHandler(filename=filename, when=when, backupCount=back_count,encoding='utf-8') # 往⽂件⾥写⼊指定间隔时间⾃动⽣成⽂件的Handler# 实例化TimedRotatingFileHandler# interval是时间间隔,backupCount是备份⽂件的个数,如果超过这个个数,就会⾃动删除,when是间隔的时间单位,单位有以下⼏种:# S 秒# M 分# H ⼩时# D 天# 'W0'-'W6' 每星期(interval=0时代表星期⼀:W0)# midnight 每天凌晨th.setFormatter(format_str) # 设置⽂件⾥写⼊的格式self.logger.addHandler(sh) # 把对象加到logger⾥self.logger.addHandler(th)# 测试if__name__ == '__main__':logger = Logger('./logs/2020/app.log', 'debug', 'S', 5).loggerlogger.debug('debug')('info')logger.warning('警告')logger.error('报错')logger.critical('严重')# 单独记录errorerr_logger = Logger('./logs/2020/error.log', 'error', 'S', 3).loggererr_logger.error('错误 error')。

concurrentrotatingfilehandler参数解释 -回复

concurrentrotatingfilehandler参数解释-回复Centralised Logging with ConcurrentRotatingFileHandlerIntroduction:In modern software development, logging plays a crucial role in monitoring, troubleshooting, and debugging applications. As applications grow, managing logs becomes a challenge due to their sheer volume. In order to handle this challenge effectively, Python provides the `logging` module, which offers various features and functionalities for logging. One such feature is the`ConcurrentRotatingFileHandler` class, which helps in managing logs by rotating and concurrent logging. In this article, we will discuss the parameters of the `ConcurrentRotatingFileHandler` class and how they can be used to customize logging behavior.Part 1: Understanding Concurrent LoggingConcurrent logging allows multiple threads or processes to write to the same logger simultaneously. This is particularly useful when an application is multithreaded or uses multiple processes. Instead of locking access to the log file, concurrent logging enables multiple threads or processes to log concurrently, improving efficiency and reducing contention.Part 2: Rotating Log FilesRotating log files is the process of managing log files bycreating new files when a certain size or time threshold is reached. This helps in maintaining manageable log files and avoiding overwhelming storage. The `ConcurrentRotatingFileHandler` class combines the benefits of concurrent logging and log rotation.Part 3: Parameters of ConcurrentRotatingFileHandler1. `filename`: This parameter specifies the base file name of the log file. The log file will have the format `<filename>.log`.2. `mode`: The `mode` parameter determines the mode in which the log file is opened. Common modes are 'a' for appending logs and 'w' for overwriting.3. `maxBytes`: It defines the maximum size of a log file (in bytes) before it is rotated. When the log file exceeds this size, a new file is created, and the old file is renamed with an incremental number.4. `backupCount`: The `backupCount` parameter specifies the number of backup log files to retain. Once the number of log files reaches `backupCount`, the oldest log file is deleted and replaced with the new file.5. `encoding`: This parameter defines the encoding to be used for the log file.6. `delay`: The `delay` parameter specifies if the file opening for logging is delayed until the first log record is emitted. This can be useful when the log file is shared among multiple processes orthreads.7. `utc`: Setting `utc` to `True` enables the use of UTC time for logging instead of the local time.8. `when`: The `when` parameter determines the rotation interval. It accepts values like 'S' (seconds), 'M' (minutes), 'H' (hours), 'D' (days), 'W0'-'W6' (weekday), and 'midnight'.Part 4: Customizing Logging Behavior1. Setting Rotation Based on File Size: To rotate log files based on size, set `maxBytes` to the desired size. For example,`maxBytes=1000000` will rotate the file when it reaches 1 MB.2. Setting Rotation Based on Time: To rotate log files based on time, set `when` to the desired rotation interval. For example,`when='midnight'` will rotate the file every midnight.3. Combining Size and Time Rotation: It is possible to utilize both size and time rotation simultaneously by specifying both`maxBytes` and `when` parameters.4. Changing Backup Count: By adjusting the `backupCount` parameter, you can specify the number of backup log files to retain. For example, `backupCount=10` will keep the 10 most recent log files.5. Utilizing UTC Time: If you want to log using UTC time, set`utc` to `True`. This can be helpful when dealing with logs frommultiple time zones.Part 5: ConclusionIn this article, we have explored the`ConcurrentRotatingFileHandler` class and its parameters for managing logs. By utilizing concurrent logging and log rotation, we can efficiently handle log files while ensuring optimal performance. With the ability to customize log rotation based on size, time, and other parameters, Python's `logging` module provides a powerful tool for centralizing and managing logs in any application.。

python超时重新请求解决方案

python超时重新请求解决方案解决 Python 超时问题的常见方案包括:1.优化代码逻辑:分析性能瓶颈,优化算法和数据结构,减少运行时间。

可以使用算法复杂度较低的算法,避免使用嵌套循环或递归来提高程序性能。

对于多次调用相同函数的情况,可以将结果缓存,避免重复计算。

2.减少对外部资源的依赖:如网络请求、数据库查询等。

可以减少网络请求的次数,缓存数据等。

对于频繁的数据库查询,可以使用数据库索引、优化SQL查询语句等方式提高查询速度。

3. 使用多线程或多进程:Python 中的 GIL(全局解释器锁)限制了多线程并行执行代码的效果。

但在一些 IO 密集型任务中,可以使用多线程或多进程来提高程序执行效率,从而减少超时的可能性。

5. 使用并发库:Python 中有一些并发库可以帮助我们更好地处理并发请求,如 gevent、asyncio、threading、multiprocessing等。

这些库提供了异步执行的能力,可以同时处理多个请求,从而提高程序执行效率。

6. 分布式计算:对于一些大规模计算的任务,可以使用分布式计算框架(如 PySpark、Celery等)将任务分发到多台计算机上进行并行计算,从而加快任务执行速度。

7. 使用缓存:通过使用缓存,可以减少对外部资源的依赖,而只从缓存中获取数据,从而减少超时的可能性。

可以使用内存缓存(如Memcached、Redis)或文件缓存(如 SQLite、Pickle)等方法来缓存数据。

8. 设置合理的重试机制:当请求超时时,可以设置重试机制,重新发送请求。

可以在代码中使用 `try-except` 语句捕获超时异常,并在异常处理中进行重试。

10.使用缓存/代理服务器:将请求发送到缓存或代理服务器,这些服务器会缓存请求数据并返回,从而减少对原始服务器的请求次数。

总之,解决 Python 超时问题的方法有很多种,具体应根据具体情况选择合适的方案。

不同的问题可能需要不同的解决方案,需要着重分析程序运行瓶颈,并根据实际情况选择合适的优化方式。

解决Python设置函数调用超时,进程卡住的问题

解决Python设置函数调⽤超时,进程卡住的问题背景:最近写的Python代码不知为何,总是执⾏到⼀半卡住不动,为了使程序能够继续运⾏,设置了函数调⽤超时机制。

代码:import timeimport signaldef test(i):time.sleep(i % 4)print "%d within time" % (i)return iif __name__ == '__main__':def handler(signum, frame):raise AssertionErrorfor i in range(1, 10):try:signal.signal(signal.SIGALRM, handler)signal.alarm(3)test(i)except AssertionError:print "%d timeout" % (i)finally:signal.alarm(0)signal.signal(signal.SIGALRM, signal.SIG_DFL)说明:1、调⽤test函数超时监控,使⽤sleep模拟函数执⾏超时2、引⼊signal模块,设置handler捕获超时信息,返回断⾔错误3、alarm(3),设置3秒闹钟,函数调⽤超时3秒则直接返回4、捕获异常,打印超时信息程序执⾏结果:1 within time2 within time3 timeout4 within time5 within time6 within time7 timeout8 within time9 within time以上这篇解决Python设置函数调⽤超时,进程卡住的问题就是⼩编分享给⼤家的全部内容了,希望能给⼤家⼀个参考,也希望⼤家多多⽀持。

Pythonlog在fastapi中的全局配置

Pythonlog在fastapi中的全局配置在FastAPI中使⽤⽇志功能,实现⽇志切割。

原由⽇志在未实现切割以及回滚时候会将所有的⽇志记录写⼊同⼀个地⽅,这样就会使⽇志⽂件特别⼤,如果该项⽬的访问量很⼤,然后运⾏时间长了之后还有可能因为⽇志⽂件过⼤,造成服务器因存储空间不⾜⽽宕机,所以需要将⽇志进⾏切割以及回滚。

实现⽬录结构注释:conf⽂件主要放置项⽬参数配置⽂件以及⽇志配置⽂件logging.ini为⽇志的参数配置⽂件test.ini 为项⽬的参数配置⽂件app主要就是项⽬以及⼀些相关设置api 项⽬的接⼝⽂件routers⽂件(使⽤ APIRouter是更具有层次性)core项⽬的配置⽂件defines.py中主要配置各种固定参数,或者⽂件名setting.py中为项⽬的配置⽂件utils项⽬独⽴函数⽂件parser.py 常⽤⽂件或字符串解析函数server.py为项⽬的服务主⼊⼝⽂件logs为⽇志输出⽂件default.log 访问⽇志error.log 错误⽇志main.py为项⽬的启动⽂件部分代码以及注释按照时间切割 cinf/logging.ini[loggers]keys=root,test[handlers]keys=rotatingFileHandler,streamHandler,errorHandler[formatters]keys=simpleFmt, errorFmt, consoleFmt[logger_root]level=DEBUGhandlers=rotatingFileHandler,streamHandler,errorHandler[logger_test]level=DEBUGqualname=testhandlers=rotatingFileHandler,streamHandler,errorHandler[handler_rotatingFileHandler]class=handlers.TimedRotatingFileHandlerlevel=INFOformatter=simpleFmtargs=(os.path.join(sys.path[0], "logs/default.log"),"M", 1, 6,'utf-8')[handler_errorHandler]class=handlers.TimedRotatingFileHandlerlevel=ERRORformatter=errorFmtargs=(os.path.join(sys.path[0], "logs/error.log"), "M", 1, 6,'utf-8')[handler_streamHandler]level=INFOclass=StreamHandlerformatter=consoleFmtargs=(sys.stdout,)[formatter_consoleFmt]format=%(asctime)s.%(msecs)03d [%(levelname)s] [%(name)s] %(message)s[formatter_simpleFmt]format=%(asctime)s %(pathname)s(%(lineno)d): [%(levelname)s] [%(name)s] %(message)s[formatter_errorFmt]format=%(asctime)s %(pathname)s(%(lineno)d): [%(levelname)s] [%(name)s] %(message)sargs参数(filename, when, interval, backupCount, encoding) filename:⽇志⽂件的地址+⽂件名 when: 参数是⼀个字符串。

logging.file.maxhistory原理

logging.file.maxhistory原理在 Python 的 logging 模块中,可以设置日志文件的最大备份数量,即最多保留多少个备份日志文件,可以使用 logging.handlers.RotatingFileHandler 或logging.handlers.TimedRotatingFileHandler 来实现日志文件的滚动。

其中,RotatingFileHandler 会在日志文件达到一定大小时滚动,而TimedRotatingFileHandler 则会在一定时间间隔内滚动。

这两种滚动方式都支持设置最大备份数量。

在 RotatingFileHandler 中,最大备份数量可以通过 backupCount 参数进行设置,而在 TimedRotatingFileHandler 中,最大备份数量可以通过 backupCount 和 maxBackupIndex 两个参数进行设置,其中 backupCount 表示最大备份数量,maxBackupIndex 表示备份日志文件名的最大索引数。

对于 maxBackupIndex 参数,它的计算方式是根据时间间隔和滚动周期来确定的。

假设日志文件的滚动周期是 1 天,最大备份数量是 5,那么 maxBackupIndex 的计算方式如下:makefileCopy codemaxBackupIndex = 5 * 24 / 1 = 120也就是说,在一天内,最多可以生成 5 个备份文件,因此最大备份文件数量是 120。

需要注意的是,maxBackupIndex 参数只在 TimedRotatingFileHandler 中有效,而在 RotatingFileHandler 中,只需要设置 backupCount 参数即可,不需要设置 maxBackupIndex 参数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

else: # DST bows out before next rollover, so we need to add an hour

addend = 3600 newRolloverAt += addend self.rolloverAt = newRolloverAt

def doGzip(self, old_log):

with open(old_log) as old:

comp_log:

with gzip.open(old_log + '.gz', 'wb') as comp_log.writelines(old)

os.remove(old_log)

def getFilesToDelete(self): """ Determine the files to delete when rolling over.

More specific than the earlier method, which just used glob.glob().

""" dirName, baseName = os.path.split(self.baseFilename) fileNames = os.listdir(dirName) result = [] prefix = baseName + "." plen = len(prefix) for fileName in fileNames:

if fileName[:plen] == prefix: suffix = fileName[plen:].rstrip(".gz") if self.extMatch.match(suffix): result.append(os.path.join(dirName,

fileName)) result.sort() if len(result) < self.backupCount: result = [] else: result = result[:len(result) -

dstAtRollover = time.localtime(newRolloverAt) [-1]

if dstNow != dstAtRollover:

if not dstNow: # DST kicks in before next rollover, so we need to deduct an hour

def __init__(self, filename, when, backupCount, interval, delay=False):

super(GzTimedRotatingFileHandler, self).__init__(filename, when,

interval, backupCount, delay=delay)

os.rename(self.baseFilename, dfn) self.doGzip(dfn)

if self.backupCount > 0: for s in self.getFilesToDelete():

os.remove(s) #if self.stream is None:

self.stream = self._open()

扩展TimedRotatingFileHandler实现压缩

函数列表 1. getFilesToDelete 调用getFilesToDelete,获取要删除log文件列表 2. getFilesToDelete 根据self.baseFilename和self.suffix,获取已保留的log文件 3. doRollover 当出现log转存时调用,解决转存时压缩问题 4. doGzip 对文件进行压缩

if __name__=="__mian__": test_GzTimedRotatingFileHandler()

2. 调用示例

def test_GzTimedRotatingFileHandler(): log_filename='/var/log/logTest/log_rotate' logger=logging.getLogger('MyLogger') logger.setLevel(logging.DEBUG) handler =

newRolloverAt = puteRollover(currentTime)

while newRolloverAt <= currentTime:

newRolloverAt = newRolloverAt + self.interval

if (self.when == 'MIDNIGHT' or self.when.startswith('W')) and not self.utc:

timeTuple = time.localtime(t + addend) dfn = self.baseFilename + "." + time.strftime(self.suffix, timeTuple) if os.path.exists(dfn):

os.remove(dfn) # Issue 18940: A file may not have been created if delay is True. if os.path.exists(self.baseFilename):

实现代码 1. 代码示例

import logging

from logging.handlers import TimedRotatingFileHandler import gzip import time

class GzTimedRotatingFileHandler(TimedRotatingFileHandler):

timeTuple = time.gmtime(t) else:

timeTuple = time.localtime(t) dstThen = timeTuple[-1] if dstNow != dstThen:

if dstNow: = -3600

GzTimedRotatingFileHandler(filename=log_filename, maxBytes=10, when="D", backupCount=5, interval=1)

logger.addHandler(handler) for i in range(100000):

time.sleep(0.5) logger.debug('i=%d ' % i)

self.backupCount] return result

def doRollover(self): if self.stream: self.stream.close()

self.stream = None # get the time that this sequence started at and make it a TimeTuple currentTime = int(time.time()) dstNow = time.localtime(currentTime)[-1] t = self.rolloverAt - self.interval if self.utc: