hadoop学习 第二篇

Hadoop学习总结

Hadoop学习总结HDFS相关HDFS写数据的流程⾸先由客户端向NameNode服务发起写数据请求NameNode收到请求后会进⾏基本验证验证类容包括对请求上传的路径进⾏合法验证对请求的⽤户进⾏权限验证验证没有问题后,NameNode会响应客户端允许上传接下来客户端会对⽂件按照blocksize⼤⼩进⾏切块,切完后依次以块为单位上传此时客户端会请求上传第⼀个块信息服务端接到上传请求后会依据HDFS默认机架感知原理,返回3台存放数据块副本的DataNode机器客户端收到机器列表后会依据⽹络拓扑原理找到其中⼀台机器进⾏传输通道的建⽴然后依次和三台机器进⾏串⾏连接这样的连接主要是为了减轻客户端本地IO的压⼒当通道建⽴成功后,客户端会通过HDFS的FSOutputStream流对象进⾏数据传输数据传输的最⼩单位为packet传输过程中每台DataNode服务器串⾏连接,依次将数据传递最后⼀个数据块被传输完成后相当于⼀次写⼊结束,如果还有数据块要传输,那就接着传输第⼆个数据块HDFS读数据的流程和写数据⼀样,由客户端向NameNode发出请求NameNode收到请求后会进⾏⽂件下载路径的合法性以及权限验证如果验证没问题,就会给客户端返回⽬标⽂件的元数据信息信息中包含⽬标⽂件数据块对应的DataNode的位置信息然后客户端根据具体的DataNode位置信息结合就近原则⽹络拓扑原理找到离⾃⼰最近的⼀台服务器对数据进⾏访问和下载最后通过HDFS提供的FSInputStream对象将数据读取到本地如果有多个块信息就会请求多次DataNode直到⽬标⽂件的全部数据被下载HDFS的架构及每个服务的作⽤HDFS是Hadoop架构中负责完成数据分布式存储管理的⽂件系统⾮⾼可⽤集群⼯作时会启动三个服务,分别是NameNode、DataNode以及SecondaryNameNode其中NameNode是HDFS的中⼼服务,主要维护管理⽂件系统中的⽂件的元数据信息DataNode主要负责存储⽂件的真实数据块信息DataNode的数据块信息中也包含⼀些关于当前数据块的元数据信息,如检验值,数据长度,时间戳等在⾮⾼可⽤HDFS集群中,NameNode和DataNode可以理解为是⼀对多的关系⼆者在集群中也要保存通信,通常默认3秒钟会检测⼀下⼼跳最后SecondaryNameNode的⼯作很单⼀,就是为了给NameNode的元数据映像⽂件和编辑⽇志进⾏合并,并⾃⼰也保留⼀份元数据信息,以防NameNode元数据丢失后有恢复的保障HDFS中如何实现元数据的维护NameNode的元数据信息是通过fsimage⽂件 + edits编辑⽇志来维护的当NameNode启动的时候fsimage⽂件和edits编辑⽇志的内容会被加载到内存中进⾏合并形成最新的元数据信息当我们对元数据进⾏操作的时候,考虑到直接修改⽂件的低效性,⽽不会直接修改fsimage⽂件⽽是会往edits编辑⽇志⽂件中追加操作记录当满⾜⼀定条件时,会让Secondary NameNode来完成fsimage⽂件和edits编辑⽇志⽂件的合并Secondary NameNode⾸先会让NameNode停⽌对正在使⽤的edits编辑⽇志⽂件的使⽤,并重新⽣成⼀个新的edits编辑⽇志⽂件接着把NameNode的fsimage⽂件和已停⽌的edits⽂件拷贝到本地在内存中将edits编辑⽇志⽂件的操作记录合并到fsimage⽂件中形成⼀个最新的fsimage⽂件最后会将这个最新的fsimage⽂件推送给NameNode并⾃⼰也备份⼀份NN和DN的关系,以及DN的⼯作流程从数据结构上看,就是⼀对多的关系⼀个HDFS集群中只能有⼀个NameNode⽤于维护元数据信息,同时会有多个DataNode⽤于存储真实的数据块当HDFS集群启动的时候,会⾸先进⼊到安全模式下在安全模式下我们只能对数据进⾏读取不能进⾏任何写操作此时集群的每⼀台DataNode会向NameNode注册⾃⼰注册成功后DataNode会上报⾃⼰的数据块详细信息当数据块汇报满⾜最⼩副本条件后,会⾃动退出安全模式此后DataNode和NameNode每三秒会通信⼀次,如果NameNode检测到DataNode没有响应,会继续检测⼀直到10分30秒后还没有检测到,就确定当前的DataNode不可⽤MapReduce相关⼿写MR的⼤概流程和规范MR程序的结构可以分为3部分,⼀是程序的执⾏⼊⼝,通常简称为驱动类驱动类主要编写MR作业的提交流程以及⾃定义的⼀些配置项⼆是Map阶段核⼼类,需要⾃定义并继承Mappper类,重写Mapper中的map⽅法在map⽅法中编写⾃⼰的业务逻辑代码将数据处理后利⽤context上下⽂对象的写出落盘三是Reduce阶段的核⼼类,同时也需要继承Hadoop提供的Reducer类并重写reduce⽅法在reduce⽅法中编写⾃⼰的业务逻辑代码,处理完数据后通过context上下⽂对象将数据写出,这也就是最终的结果⽂件如何实现Hadoop的序列化,Hadoop的序列化和Java的序列化有什么区别⾸先,序列化是把内存中的Java对象转化成⼆进制字节码,反序列化是将⼆进制字节码转化成Java对象通常我们在对Java对象进⾏磁盘持久化写⼊或将Java对象作为数据进⾏⽹络传输的时候需要进⾏序列化相反如果要将数据从磁盘读出并转化成Java对象需要进⾏反序列化实现Hadoop中的序列化需要让JavaBean对象实现Writable接⼝,并重写wirte()⽅法和readFields()⽅法其中wirte()是序列化⽅法,readFields()⽅法是反序列化⽅法Hadoop序列化和Java序列化的区别在于,java序列化更重量级Java序列化后的结果不仅仅⽣成⼆进制字节码⽂件,同时还会针对当前Java对象⽣成对应的检验信息以及集成体系结构这样的话,⽆形中我们需要维护更多的数据但是Hadoop序列化不会产⽣除了Java对象内部属性外的任何信息,整体内容更加简洁紧凑,读写速度相应也会提升很多,这也符合⼤数据的处理背景MR程序的执⾏流程MR程序执⾏先从InputFormat类说起,由InputFormat负责数据读⼊,并在内部实现切⽚每个切⽚的数据对应⽣成⼀个MapTask任务MapTask中按照⽂件的⾏逐⾏数据进⾏处理,每⼀⾏数据会调⽤⼀次我们⾃定义的Mapper类的map⽅法map⽅法内部实现具体的业务逻辑,处理完数据会通过context对象将数据写出到磁盘,接下来ReduceTask会开始执⾏⾸先ReduceTask会将MapTask处理完的数据结果拷贝过来每组相同key的values会调⽤⼀次我们⾃定义Reducer类的reduce⽅法当数据处理完成后,会通过context对象将数据结果写出到磁盘上InputFormat负责数据写份时候要进⾏切⽚,为什么切⽚⼤⼩默认是128M⾸先切⽚⼤⼩是可以通过修改配置参数来改变的,但默认情况下是和切块blocksize⼤⼩⼀致这样做的⽬的就是为了在读取数据的时候正好能⼀次性读取⼀个块的数据,避免了在集群环境下发⽣跨机器读取的情况如果跨机器读取会造成额外的⽹络IO,不利于MR程序执⾏效率的提升描述⼀下切⽚的逻辑MR中的切⽚是发⽣在数据读⼊的阶段中,所以我们要关注InputFormat的实现通过追溯源码,在InputFormat这个抽象类中有⼀个getSplits(),这个⽅法就是实现切⽚的具体逻辑⾸先关注两个变量,分别是minSize和maxSize,默认情况minSize = 1,maxSize = Long.MAX_VALUE源码中声明了⼀个集合List splits = new ArrayList(),⽤于装载将来的切⽚对象并返回接下来根据提交的job信息获取到当前要进⾏切⽚的⽂件详情⾸先判断当前⽂件是否可以进⾏切分,这⼀步主要考虑到⼀些不⽀持切分的压缩⽂件不能进⾏切⽚操作,否则就破坏了数据的完整性如果当前⽂件可以切⽚的话,就要计算切⽚的⼤⼩切⽚的⼤⼩⼀共需要三个因⼦,分别是minSize、maxSize、blocksize最后通过Math.max(minSize,Math.min(maxSize,blocksize)),计算逻辑获取到切⽚的⼤⼩默认情况下切⽚⼤⼩和数据块⼤⼩⼀致如果想要改变切⽚的⼤⼩可以通过修改mapreduce.input.fileinputformat.split.minsize(把切⽚调⼤)、mapreduce.input.fileinputformat.split.maxsize(把切⽚调⼩)两个参数实现获取到切⽚⼤⼩后继续往下执⾏,在最终完成切⽚之前还有⼀个关键判断就是判断剩余⽂件是否要进⾏切⽚CombineTextInputFormat机制是怎么实现的CombineTextInoutFormat是InputFormat的⼀个实现类,主要⽤于解决⼩⽂件场景⼤概思路是先在Job提交中指定使⽤InputFormat的实现类为CombineTextInputFormat接下来的切⽚过程中会先把当前⽂件的⼤⼩和设置的切⽚的最⼤值进⾏⽐较如果⼩于最⼤值,就单独划分成⼀块如果⼤于切⽚的最⼤值并⼩于两倍的切⽚的最⼤值,就把当前⽂件⼀分为⼆划分成两块以此类推逐个对⽂件进⾏处理,这个过程称之为虚拟过程最后⽣成真正的切⽚的时候,根据虚拟好的⽂件进⾏合并只要合并后⽂件⼤⼩不超过最开始设置好的切⽚的最⼤值那就继续追加合并直到达到设置好的切⽚的最⼤值此时就会产⽣⼀个切⽚,对应⽣成⼀个MapTaskShuffle机制流程当MapTask执⾏完map()⽅法后通过context对象写数据的时候开始执⾏shuffle过程⾸先数据先从map端写⼊到环形缓冲区内写出的数据会根据分区规则进⼊到指定的分区,并且同时在内存中进⾏区内排序环形缓冲区默认⼤⼩为100M当数据写⼊的容量达到缓冲区⼤⼩的80%,数据开始向磁盘溢写如果数据很多的情况下,可能发⽣N次溢写这样在磁盘上就会产⽣多个溢写⽂件,并保证每个溢写⽂件中区内是有序的到此shuffle过程在Map端就完成了接着Map端输出的数据会作为Reduce端的数数据再次进⾏汇总操作此时ReduceTask任务会把每⼀个MapTask中计算完的相同的分区的数据拷贝到ReduceTask的内存中,如果内存放不下,开始写⼊磁盘再接着就是对数据进⾏归并排序,排序完还要根据相同的key进⾏分组将来⼀组相同的key对应的values调⽤⼀次reduce⽅法,如果有多个分区就会产⽣多个ReduceTask来处理,处理的逻辑都⼀样MR程序中由谁来决定分区的数量,哪个阶段环节会开始往分区中写数据在Job提交的时候可以设置ReduceTask的数量ReduceTask的数量决定分区的编号默认有多少ReduceTask任务就会产⽣多少个分区在Map阶段的map⽅法中通过context.wirte()往外写数据的时候其实就是在往指定的分区中写数据了阐述MR中实现分区的思路默认情况下不指定分区数量就会有⼀个分区如果要指定分区,可以通过在Job提交的时候指定ReduceTask的数量来指定分区的数量从Map端处理完数据后,数据就会被溢写到指定的分区中决定kv数据究竟写到哪个分区中是通过Hadoop提供的Partitioner对象控制的Partitioner对象默认实现HashPartitioner类它的规则就是⽤当前写出数据的key和ReduceTask的数量做取余操作,得到的结果就是当前数据要写⼊的分区的编号除此之外,我们也可以⾃定义分区器对象需要继承Hadoop提供的Partitioner对象,然后重写getPartitioner()⽅法在该⽅法中根据⾃⼰的业务实现分区编号的返回最后再将我们⾃定义的分区器对象设置到Job提交的代码中覆盖默认的分区规则Hadoop中实现排序的两种⽅案分别是什么第⼀种⽅式是直接让参与⽐较的对象实现WritableComparable接⼝并指定泛型接下来实现CompareTo()⽅法,在该⽅法中实现⽐较规则即可第⼆种⽅式是⾃定义⽐较器对象,需要继承WritableComparator类,重写它的compare⽅法在构造器中调⽤⽗类对当前的要参与⽐较的对象进⾏实例化当前要参与⽐较的对象必须要实现WritableComparable接⼝最后在Job提交代码中将⾃定义的⽐较器对象设置到Job中就可以了编写MR的时候什么情况下使⽤Combiner,实现的具体流程是什么Combiner在MR中是⼀个可选流程,通常也是⼀种优化⼿段当我们执⾏完Map阶段的计算后数据量⽐较⼤,kv组合过多这样在Reduce阶段执⾏的时候会造成拷贝⼤量的数据以及汇总更多的数据为了减轻Reduce的压⼒,此时可以选择在Map阶段进⾏Combiner操作,将⼀些汇总⼯作提前进⾏OutputFormat⾃定义实现流程OutputFormat是MR中最后⼀个流程,它主要负责数据最终结果的写出如果对最终输出结果⽂件的名称或者输出路径有个性化需求,就可以通过⾃定义OutputFormat来实现⾸先⾃定义⼀个OutputFormat类,然后继承OutputFormat重写OutputFormat的getRecordWriter()⽅法,在该⽅法中返回RecordWriter对象由于RecordWriter是Hadoop内部对象,如果我们想实现⾃⼰的逻辑,还得⾃定义⼀个RecordWriter类,然后继承RecordWriter类重写该类中的write()⽅法和close()⽅法MR实现MapJoin的思路,MapJoin的局限性是什么Mapjoin解决了数据倾斜给Reduce阶段带来的问题⾸先MapJoin的前提就是我们需要join的两个⽂件⼀个是⼤⽂件,⼀个是⼩⽂件在此前提下,我们可以将⼩的⽂件提前缓存到内存中,然后让Map端直接处理⼤⽂件每处理⼀⾏数据就根据当前的关联字段到内存中获取想要的数据,然后将结果写出。

最详细的Hadoop入门教程

最详细的Hadoop⼊门教程前⾔Hadoop 在⼤数据技术体系中的地位⾄关重要,Hadoop 是⼤数据技术的基础,对Hadoop基础知识的掌握的扎实程度,会决定在⼤数据技术道路上⾛多远。

这是⼀篇⼊门⽂章,Hadoop 的学习⽅法很多,⽹上也有很多学习路线图。

本⽂的思路是:以安装部署 Apache Hadoop2.x 版本为主线,来介绍 Hadoop2.x 的架构组成、各模块协同⼯作原理、技术细节。

安装不是⽬的,通过安装认识Hadoop才是⽬的。

本⽂分为五个部分、⼗三节、四⼗九步。

第⼀部分:Linux环境安装Hadoop是运⾏在Linux,虽然借助⼯具也可以运⾏在Windows上,但是建议还是运⾏在Linux系统上,第⼀部分介绍Linux环境的安装、配置、Java JDK安装等。

第⼆部分:Hadoop本地模式安装Hadoop 本地模式只是⽤于本地开发调试,或者快速安装体验 Hadoop,这部分做简单的介绍。

第三部分:Hadoop伪分布式模式安装学习 Hadoop ⼀般是在伪分布式模式下进⾏。

这种模式是在⼀台机器上各个进程上运⾏ Hadoop 的各个模块,伪分布式的意思是虽然各个模块是在各个进程上分开运⾏的,但是只是运⾏在⼀个操作系统上的,并不是真正的分布式。

第四部分:完全分布式安装完全分布式模式才是⽣产环境采⽤的模式,Hadoop 运⾏在服务器集群上,⽣产环境⼀般都会做HA,以实现⾼可⽤。

第五部分:Hadoop HA安装HA是指⾼可⽤,为了解决Hadoop单点故障问题,⽣产环境⼀般都做HA部署。

这部分介绍了如何配置Hadoop2.x的⾼可⽤,并简单介绍了HA的⼯作原理。

安装过程中,会穿插简单介绍涉及到的知识。

希望能对⼤家有所帮助。

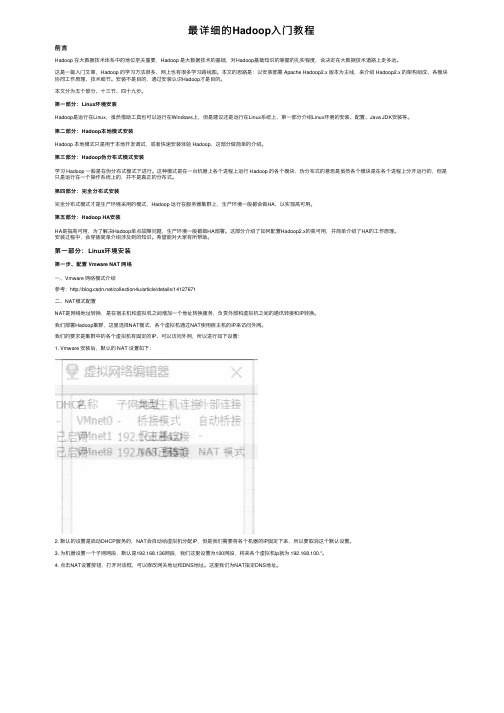

第⼀部分:Linux环境安装第⼀步、配置 Vmware NAT ⽹络⼀、Vmware ⽹络模式介绍参考:/collection4u/article/details/14127671⼆、NAT模式配置NAT是⽹络地址转换,是在宿主机和虚拟机之间增加⼀个地址转换服务,负责外部和虚拟机之间的通讯转接和IP转换。

Hadoop基础知识培训

存储+计算(HDFS2+Yarn)

集中存储和计算的主要瓶颈

Oracle IBM

EMC存储

scale-up(纵向扩展)

➢计算能力和机器数量成正比 ➢IO能力和机器数量成非正比

多,Intel,Cloudera,hortonworks,MapR • 硬件基于X86服务器,价格低,厂商多 • 可以自行维护,降低维护成本 • 在互联网有大规模成功案例(BAT)

总 结

• Hadoop平台在构建数据云(DAAS)平台有天 然的架构和成本的优势

成本投资估算:从存储要求计算所需硬件及系统软件资源(5000万用户 为例)

往HDFS中写入文件

• 首要的目标当然是数 据快速的并行处理。 为了实现这个目标, 我们需要竟可能多的 机器同时工作。

• Cient会和名称节点达 成协议(通常是TCP 协议)然后得到将要 拷贝数据的3个数据节 点列表。然后Client将 会把每块数据直接写 入数据节点中(通常 是TCP 协议)。名称 节点只负责提供数据 的位置和数据在族群 中的去处(文件系统 元数据)。

• 第二个和第三个数据 节点运输在同一个机 架中,这样他们之间 的传输就获得了高带 宽和低延时。只到这 个数据块被成功的写 入3个节点中,下一 个就才会开始。

• 如果名称节点死亡, 二级名称节点保留的 文件可用于恢复名称 节点。

• 每个数据节点既扮演者数据存储的角色又 冲当与他们主节点通信的守护进程。守护 进程隶属于Job Tracker,数据节点归属于 名称节点。

hadoop大数据技术实验指导书

Hadoop大数据技术实验指导书第一章实验概述1.1 实验目的本实验旨在全面了解Hadoop大数据技术的相关概念、架构和使用方法,通过实际操作掌握Hadoop大数据技术的基本应用和管理技能。

1.2 实验内容本实验内容包括Hadoop大数据技术的基本概念、HDFS分布式文件系统的搭建和管理、MapReduce分布式计算框架的使用、Hadoop 生态系统的其他相关工具等。

1.3 实验环境本实验采用Ubuntu 18.04操作系统,Hadoop版本为3.1.3,Java 版本为1.8。

1.4 实验预备知识对Linux操作系统的基本操作有一定了解,对Java编程语言有一定的基础认识,了解分布式系统和大数据概念。

第二章 Hadoop基础概念2.1 Hadoop概述Hadoop是一个开源的分布式计算框架,用于存储和处理大规模数据。

Hadoop项目由Apache软件基金会开发,主要包括Hadoop分布式文件系统(HDFS)和MapReduce分布式计算框架。

2.2 Hadoop架构Hadoop架构包括HDFS、MapReduce和YARN(资源调度和管理),HDFS负责数据的存储和管理,MapReduce负责数据的计算和处理,YARN负责集裙资源的调度和管理。

2.3 Hadoop生态系统除了HDFS和MapReduce,Hadoop生态系统还包括其他相关工具,如HBase(分布式数据库)、Hive(数据仓库)、Pig(数据分析)、Spark(内存计算框架)等。

第三章 HDFS分布式文件系统实验3.1 HDFS搭建1) 准备Hadoop安装包,解压到指定目录2) 配置hadoop-env.sh文件,设置JAVA_HOME环境变量3) 配置core-site.xml和hdfs-site.xml文件,设置Hadoop集裙的基本信息和存储路径3.2 HDFS管理1) 使用命令行工具上传、下载、删除文件2) 查看HDFS存储空间情况3) 监控HDFS集裙状态第四章 MapReduce分布式计算实验4.1 MapReduce程序编写1) 编写Map阶段的程序2) 编写Reduce阶段的程序3) 编译打包MapReduce程序4.2 MapReduce作业提交与监控1) 将MapReduce程序提交到Hadoop集裙2) 查看作业运行状态和日志3) 监控作业的运行情况第五章 Hadoop生态系统实验5.1 HBase实验1) 安装HBase并配置2) 创建HBase表并进行CRUD操作3) 监控HBase集裙状态5.2 Hive实验1) 安装Hive并配置2) 创建Hive表并进行数据查询3) 执行HiveQL语句进行数据分析5.3 Spark实验1) 安装Spark并配置2) 编写Spark应用程序3) 提交Spark应用程序到集裙运行结语通过本实验指导书的学习,相信读者对Hadoop大数据技术有了更深入的了解,掌握了HDFS的搭建与管理、MapReduce的编程与作业监控、Hadoop生态系统的应用等相关技能。

Hadoop高级培训教程 第2章 HDFS API开发指南

2.1 Java接口

通过FileSystem API实例文件查询

文件模式 * 匹配0或多个字符 ? 匹配1个字符 [ab] 匹配a,b集合中的一个字符 [^ab] 匹配非a,b集合中的一个字符 [a-b] 匹配a到b范围的字符 [^a-b] 匹配非a到b范围的字符 {a,b} 匹配a或b中的表达式 \c 匹配元字符c PathFilter对象 public interface PathFilter { boolean accept(Path path) }

something like: gcc above_sample.c I${HADOOP_HOME}/src/c++/libhdfs L${HADOOP_HOME}/libhdfs -lhdfs -o above_sample

2.2 C/C++接口

Thread safe

Concurrency and Hadoop FS "handles" - the hadoop FS implementation includes a FS handle cache which caches based on the URI of the namenode along with the user connecting. So, all calls to hdfsConnect will return the same handle but calls to hdfsConnectAsUser with

2.1 Java接口

通过FileSystem API创建目录 publish boolean mkdirs(Path p) throws IOException

Hadoop平台搭建与应用(第2版)(微课版)项目2 Hive环境搭建与基本操作

Hadoop平台搭建与应用教案教学过程教学提示项目2 Hive环境搭建与基本操作任务2.1 Hive的安装与配置Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一张数据库表,并提供完整的SQL查询功能,将类SQL语句转换为MapReduce任务,如图2-1所示,并执行此任务。

图2-1 将类SQL语句转换为MapReduce任务1.Hive数据结构Hive中所有的数据都存储在HDFS中,Hive中包含以下数据结构。

(1)Table:Hive中的Table和数据库中的Table在概念上是类似的,每一个Table在Hive中都有一个相应的目录存储数据。

(2)Partition(可选):在Hive中,表中的一个Partition对应于表中的一个目录,所有的Partition的数据都存储在对应的目录中。

(3)Bucket(可选):Bucket对指定列计算Hash,Partition根据某个列的Hash值散列到不同的Bucket中,目的是进行并行处理,每一个Bucket对应一个文件。

2.Hive架构Hive架构如图2-2所示。

Hadoop和MapReduce是Hive架构的基础。

用户接口主要有CLI客户端、HiveServer客户端、HWI客户端和HUE客户端(开源的Apache Hadoop UI系统),其中最常用的是CLI客户端。

在CLI客户端启动时,会同时启动一个Hive副本。

在Windows中,可通过JDBC连接HiveServer的图形界面工具,包括SQuirrel SQLClient、Oracle SQL Developer及DbVisualizer。

HWI通过浏览器访问Hive,通过Web控制台与Hadoop集群进行交互来分析及处理数据。

MetaStore用于存储和管理Hive的元数据,使用关系数据库来保存元数据信息(MySQL、Derby等),Hive中的元数据包括表的名称、表的列和分区及其属性、表的属性(是否为外部表等)、表的数据所在目录等。

hadoop复习资料大全

hadoop复习资料大全Hadoop复习资料大全在当今信息爆炸的时代,数据已经成为了一种宝贵的资源。

然而,要处理和分析海量的数据并从中获取有用的信息是一项复杂而困难的任务。

这就是为什么Hadoop这样的大数据处理框架变得如此重要和流行的原因之一。

作为一个开源的分布式系统,Hadoop提供了一种可靠和高效地处理大规模数据的方法。

对于那些希望深入了解和掌握Hadoop的人来说,复习资料是必不可少的。

一、Hadoop的基础知识要理解Hadoop的工作原理和基本概念,首先需要掌握一些基础知识。

这包括Hadoop的核心组件,如Hadoop分布式文件系统(HDFS)和MapReduce。

此外,还需要了解Hadoop的架构,包括主节点(NameNode)和从节点(DataNode)之间的交互方式。

二、Hadoop生态系统除了核心组件外,Hadoop还有一个庞大而丰富的生态系统。

这个生态系统包括各种工具和技术,用于处理和分析大规模数据。

其中一些工具包括Hive、Pig、HBase和Sqoop等。

每个工具都有其独特的功能和用途,掌握它们可以帮助我们更好地利用Hadoop的能力。

三、Hadoop的安装和配置要使用Hadoop,首先需要将其安装和配置在自己的机器上。

这可能是一个有些复杂的过程,因为Hadoop有很多配置选项和参数需要设置。

因此,掌握正确的安装和配置过程是非常重要的。

有很多在线教程和指南可以帮助你完成这个过程,你可以找到一些详细的步骤和说明。

四、Hadoop的性能调优一旦你安装和配置好了Hadoop,接下来就是优化它的性能。

Hadoop的性能调优是一个复杂的过程,需要细致的分析和调整。

这包括调整Hadoop的配置参数,优化数据存储和访问方式,以及使用适当的算法和技术来处理数据。

了解这些技巧和技术可以帮助你更好地利用Hadoop的潜力。

五、Hadoop的安全性和故障恢复在处理大规模数据时,安全性和故障恢复是非常重要的考虑因素。

hadoop 操作手册

hadoop 操作手册Hadoop 是一个分布式计算框架,它使用 HDFS(Hadoop Distributed File System)存储大量数据,并通过 MapReduce 进行数据处理。

以下是一份简单的 Hadoop 操作手册,介绍了如何安装、配置和使用 Hadoop。

一、安装 Hadoop1. 下载 Hadoop 安装包,并解压到本地目录。

2. 配置 Hadoop 环境变量,将 Hadoop 安装目录添加到 PATH 中。

3. 配置 Hadoop 集群,包括 NameNode、DataNode 和 JobTracker 等节点的配置。

二、配置 Hadoop1. 配置 HDFS,包括 NameNode 和 DataNode 的配置。

2. 配置 MapReduce,包括 JobTracker 和 TaskTracker 的配置。

3. 配置 Hadoop 安全模式,如果需要的话。

三、使用 Hadoop1. 上传文件到 HDFS,使用命令 `hadoop fs -put local_file_path/hdfs_directory`。

2. 查看 HDFS 中的文件和目录信息,使用命令 `hadoop fs -ls /`。

3. 运行 MapReduce 作业,编写 MapReduce 程序,然后使用命令`hadoop jar my_` 运行程序。

4. 查看 MapReduce 作业的运行结果,使用命令 `hadoop fs -cat/output_directory/part-r-00000`。

5. 从 HDFS 中下载文件到本地,使用命令 `hadoop fs -get/hdfs_directory local_directory`。

6. 在 Web 控制台中查看 HDFS 集群信息,在浏览器中打开7. 在 Web 控制台中查看 MapReduce 作业运行情况,在浏览器中打开四、管理 Hadoop1. 启动和停止 Hadoop 集群,使用命令 `` 和 ``。

hadoop实训报告文字

Hadoop实训报告引言Hadoop是一个开源的分布式计算平台,用于处理大规模数据集的存储和分析。

在本次实训中,我们学习了Hadoop的基本概念和使用方法,并通过实践掌握了Hadoop的各种组件及其功能。

实训内容1. Hadoop概述首先,我们学习了Hadoop的基本概念和架构。

Hadoop由HDFS(Hadoop分布式文件系统)和MapReduce两个核心组件组成。

HDFS用于存储大规模数据集,并提供高可靠性和容错性。

MapReduce是一种分布式计算模型,用于将数据分成多个小块,在集群中并行处理。

2. Hadoop安装与配置接下来,我们进行了Hadoop的安装与配置。

首先,我们下载了Hadoop的安装包,并解压到本地目录。

然后,我们配置了Hadoop的环境变量,使其能够在命令行中被识别。

3. Hadoop集群搭建为了更好地理解Hadoop的分布式特性,我们搭建了一个Hadoop集群。

我们使用了三台虚拟机,分别作为一个主节点和两个从节点。

在主节点上配置了HDFS和MapReduce的相关文件,并在从节点上配置了对应的通信信息。

4. Hadoop基本操作在学习了Hadoop的基本概念和架构后,我们开始进行一些基本的Hadoop操作。

首先,我们学习了Hadoop的文件操作命令,如上传、下载、删除等。

然后,我们学习了Hadoop的作业操作命令,如提交作业、查看作业状态等。

5. Hadoop应用开发在掌握了Hadoop的基本操作后,我们开始进行Hadoop应用的开发。

我们使用Java语言编写了一个简单的MapReduce程序,用于统计一个文本文件中的单词出现次数。

通过编写这个程序,我们更深入地理解了MapReduce的工作原理和应用。

6. Hadoop性能优化最后,我们学习了Hadoop的性能优化方法。

我们通过调整各种参数和配置文件,来提高Hadoop的运行效率和并行性能。

我们还学习了如何监控Hadoop集群的运行状态,并根据监控结果进行调整和优化。

02_尚硅谷大数据技术之Hadoop(入门)

02_尚硅⾕⼤数据技术之Hadoop(⼊门)尚硅⾕⼤数据技术之 Hadoop(⼊门)(作者:尚硅⾕⼤数据研发部)版本:V3.3第 1 章 Hadoop 概述1.1 Hadoop 是什么1) Hadoop是⼀个由Apache基⾦会所开发的分布式系统基础架构。

2)主要解决,海量数据的存储和海量数据的分析计算问题。

3)⼴义上来说,Hadoop通常是指⼀个更⼴泛的概念——Hadoop⽣态圈。

1.2 Hadoop 发展历史(了解)1)Hadoop创始⼈Doug Cutting,为了实现与Google类似的全⽂搜索功能,他在Lucene框架基础上进⾏优化升级,查询引擎和索引引擎。

2)2001年年底Lucene成为Apache基⾦会的⼀个⼦项⽬。

3)对于海量数据的场景,Lucene框架⾯对与Google同样的困难,存储海量数据困难,检索海量速度慢。

4)学习和模仿Google解决这些问题的办法:微型版Nutch。

5)可以说Google是Hadoop的思想之源(Google在⼤数据⽅⾯的三篇论⽂)GFS --->HDFSMap-Reduce --->MRBigTable --->HBase6)2003-2004年,Google公开了部分GFS和MapReduce思想的细节,以此为基础Doug Cutting等⼈⽤了2年业余时间实现了DFS和MapReduce机制,使Nutch性能飙升。

7)2005 年Hadoop 作为 Lucene的⼦项⽬ Nutch的⼀部分正式引⼊Apache基⾦会。

8)2006 年 3 ⽉份,Map-Reduce和Nutch Distributed File System (NDFS)分别被纳⼊到 Hadoop 项⽬中,Hadoop就此正式诞⽣,标志着⼤数据时代来临。

9)名字来源于Doug Cutting⼉⼦的玩具⼤象1.3 Hadoop 三⼤发⾏版本(了解)Hadoop 三⼤发⾏版本:Apache、Cloudera、Hortonworks。

Hadoop大数据开发基础教案Hadoop基础操作教案

一、Hadoop简介1. 教学目标(1) 了解Hadoop的定义和发展历程(2) 掌握Hadoop的核心组件及其作用(3) 理解Hadoop在大数据领域的应用场景2. 教学内容(1) Hadoop的定义和发展历程(2) Hadoop的核心组件:HDFS、MapReduce、YARN(3) Hadoop的应用场景3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 引入话题:大数据与Hadoop(2) 讲解Hadoop的定义和发展历程(3) 介绍Hadoop的核心组件及其作用(4) 分析Hadoop的应用场景(5) 总结本节课的重点内容二、HDFS操作1. 教学目标(1) 掌握HDFS的基本概念和架构(2) 学会使用HDFS客户端进行文件操作(3) 了解HDFS的配置和优化方法2. 教学内容(1) HDFS的基本概念和架构(2) HDFS客户端的使用方法(3) HDFS的配置和优化方法3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解HDFS的基本概念和架构(2) 演示HDFS客户端的使用方法(3) 介绍HDFS的配置和优化方法(4) 进行实操练习(5) 总结本节课的重点内容三、MapReduce编程模型1. 教学目标(1) 理解MapReduce的编程模型和原理(2) 掌握MapReduce的基本操作和编程步骤(3) 了解MapReduce的优缺点和适用场景2. 教学内容(1) MapReduce的编程模型和原理(2) MapReduce的基本操作和编程步骤(3) MapReduce的优缺点和适用场景3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解MapReduce的编程模型和原理(2) 介绍MapReduce的基本操作和编程步骤(3) 分析MapReduce的优缺点和适用场景(4) 进行案例实操(5) 总结本节课的重点内容四、YARN架构与资源管理1. 教学目标(1) 理解YARN的架构和功能(2) 掌握YARN的资源管理和调度机制(3) 了解YARN的应用场景和优势2. 教学内容(1) YARN的架构和功能(2) YARN的资源管理和调度机制(3) YARN的应用场景和优势3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解YARN的架构和功能(2) 介绍YARN的资源管理和调度机制(3) 分析YARN的应用场景和优势(4) 进行案例实操(5) 总结本节课的重点内容五、Hadoop生态系统简介1. 教学目标(1) 了解Hadoop生态系统的概念和组成(2) 掌握Hadoop生态系统中常用组件的功能和应用场景(3) 理解Hadoop生态系统的发展趋势2. 教学内容(1) Hadoop生态系统的概念和组成(2) Hadoop生态系统中常用组件:Hive、HBase、Pig、Sqoop、Flume(3) Hadoop生态系统的发展趋势3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解Hadoop生态系统的概念和组成(2) 介绍Hadoop生态系统中常用组件的功能和应用场景(3) 分析Hadoop生态系统的发展趋势(六、Hive大数据处理平台1. 教学目标(1) 理解Hive的概念和架构(2) 掌握Hive的基本操作和数据处理能力(3) 了解Hive的应用场景和优缺点2. 教学内容(1) Hive的概念和架构(2) Hive的基本操作:表的创建、数据的导入和导出(3) Hive的数据处理能力:查询、统计、分析(4) Hive的应用场景和优缺点3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解Hive的概念和架构(2) 演示Hive的基本操作(3) 介绍Hive的数据处理能力(4) 分析Hive的应用场景和优缺点(5) 进行实操练习(6) 总结本节课的重点内容七、HBase分布式数据库1. 教学目标(1) 理解HBase的概念和架构(2) 掌握HBase的基本操作和数据管理能力(3) 了解HBase的应用场景和优缺点2. 教学内容(1) HBase的概念和架构(2) HBase的基本操作:表的创建、数据的增删改查(3) HBase的数据管理能力:数据一致性、并发控制、灾难恢复(4) HBase的应用场景和优缺点3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解HBase的概念和架构(2) 演示HBase的基本操作(3) 介绍HBase的数据管理能力(4) 分析HBase的应用场景和优缺点(5) 进行实操练习(6) 总结本节课的重点内容八、Pig大数据脚本语言1. 教学目标(1) 理解Pig的概念和架构(2) 掌握Pig的基本操作和数据处理能力(3) 了解Pig的应用场景和优缺点2. 教学内容(1) Pig的概念和架构(2) Pig的基本操作:LOAD、STORE、FILTER(3) Pig的数据处理能力:数据转换、数据清洗、数据分析(4) Pig的应用场景和优缺点3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解Pig的概念和架构(2) 演示Pig的基本操作(3) 介绍Pig的数据处理能力(4) 分析Pig的应用场景和优缺点(5) 进行实操练习(6) 总结本节课的重点内容九、Sqoop数据迁移工具1. 教学目标(1) 理解Sqoop的概念和架构(2) 掌握Sqoop的基本操作和数据迁移能力(3) 了解Sqoop的应用场景和优缺点2. 教学内容(1) Sqoop的概念和架构(2) Sqoop的基本操作:导入、导出数据(3) Sqoop的数据迁移能力:关系数据库与Hadoop之间的数据迁移(4) Sqoop的应用场景和优缺点3. 教学方法(1) 讲授(2) 实操演示(3) 互动讨论4. 教学步骤(1) 讲解Sqoop的概念和架构(2) 演示Sqoop的基本操作(3) 介绍Sqoop的数据迁移能力(4) 分析Sqoop的应用场景和优缺点(5) 进行实操练习(6) 总结本节课的重点内容十、Flume数据采集系统1. 教学目标(1) 理解Flume的概念和架构(2) 掌握Flume的基本操作和数据采集能力(3) 了解Flume的应用场景和优缺点2. 教学内容(1) Flume的概念和架构(2) Flume的基本操作:配置文件编写、组件部署(3) Flume的数据采集能力:日志数据十一、日志数据处理实战1. 教学目标(1) 理解日志数据处理的重要性(2) 掌握使用Hadoop生态系统工具处理日志数据的方法(3) 能够设计日志数据处理流程2. 教学内容(1) 日志数据的特点和处理需求(2) 使用Hadoop生态系统中的工具(如LogParser, Flume, Hive, Pig)处理日志数据(3) 案例分析:构建一个简单的日志数据分析流程3. 教学方法(1) 讲授(2) 实操演示(3) 案例分析(4) 互动讨论4. 教学步骤(1) 讲解日志数据的特点和处理需求(2) 演示如何使用Hadoop生态系统工具处理日志数据(3) 通过案例分析,让学生设计一个简单的日志数据分析流程(4) 学生实操练习,应用所学知识处理实际日志数据(5) 总结本节课的重点内容,强调日志数据处理的最佳实践十二、大数据可视化分析1. 教学目标(1) 理解大数据可视化的重要性(2) 掌握使用可视化工具进行大数据分析的方法(3) 能够设计有效的大数据可视化方案2. 教学内容(1) 大数据可视化的概念和作用(2) 常用的大数据可视化工具:Tableau, QlikView, D3.js等(3) 如何选择合适的可视化工具和设计原则3. 教学方法(1) 讲授(2) 实操演示(3) 案例分析(4) 互动讨论4. 教学步骤(1) 讲解大数据可视化的概念和作用(2) 演示常用的大数据可视化工具的使用方法(3) 分析如何选择合适的可视化工具和设计原则(4) 通过案例分析,让学生设计一个大数据可视化方案(5) 学生实操练习,应用所学知识创建可视化分析(6) 总结本节课的重点内容,强调大数据可视化的最佳实践十三、大数据安全与隐私保护1. 教学目标(1) 理解大数据安全的重要性(2) 掌握大数据安全和隐私保护的基本概念(3) 了解大数据安全与隐私保护的技术和策略2. 教学内容(1) 大数据安全与隐私保护的基本概念(2) 大数据安全威胁和风险分析(3) 大数据安全和隐私保护技术和策略:加密、访问控制、匿名化等3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解大数据安全与隐私保护的基本概念(2) 分析大数据安全威胁和风险(3) 介绍大数据安全和隐私保护技术和策略(4) 通过案例分析,让学生了解如何实施大数据安全与隐私保护(5) 总结本节课的重点内容,强调大数据安全和隐私保护的最佳实践十四、大数据应用案例分析1. 教学目标(1) 理解大数据在不同行业的应用(2) 掌握大数据解决方案的设计思路(3) 能够分析大数据应用案例,提取经验教训2. 教学内容(1) 大数据在各行业的应用案例:金融、医疗、零售、物流等(2) 大数据解决方案的设计思路和步骤(3) 分析大数据应用案例,提取经验教训3. 教学方法(1) 讲授(2) 案例分析(3) 互动讨论4. 教学步骤(1) 讲解大数据在各行业的应用案例(2) 分析大数据解决方案的设计思路和步骤(3) 通过案例分析,让学生提取大数据应用的经验教训(4) 学生实操练习,分析特定行业的大数据应用案例(5) 总结本节课的重点内容,强调大数据应用的最佳实践十五、大数据的未来趋势与职业规划1. 教学目标(1) 理解大数据发展的未来趋势(2) 掌握大数据行业职业规划的方向(3) 能够根据个人兴趣和能力规划大数据相关职业发展路径2. 教学内容(1) 大数据发展的未来趋势:技术、应用、产业等(2) 大数据行业职业规划的方向重点和难点解析本文主要介绍了Hadoop大数据开发基础教案,包括Hadoop基础操作、HDFS 操作、MapReduce编程模型、YARN架构与资源管理、Hadoop生态系统简介、Hive大数据处理平台、HBase分布式数据库、Pig大数据脚本语言、Sqoop数据迁移工具、Flume数据采集系统、日志数据处理实战、大数据可视化分析、大数据安全与隐私保护、大数据应用案例分析以及大数据的未来趋势与职业规划等十五个章节。

Hadoop基础入门指南

Hadoop基础入门指南Hadoop是一个基于Java的开源分布式计算平台,能够处理大规模数据存储和处理任务。

它是处理大数据的一种解决方案,被广泛应用于各种领域,例如金融、医疗、社交媒体等。

本文将介绍Hadoop的基础知识,帮助初学者快速入门。

一、Hadoop的三大模块Hadoop有三个核心模块,分别是HDFS(Hadoop分布式文件系统)、MapReduce、和YARN。

1. HDFS(Hadoop分布式文件系统)HDFS是Hadoop的存储模块,它可以存储大量的数据,并在多台机器之间进行分布式存储和数据备份。

HDFS将文件切割成固定大小的块,并复制多份副本,存储在不同的服务器上。

如果某个服务器宕机,数据仍然可以从其他服务器中获取,保障数据的安全。

2. MapReduceMapReduce是Hadoop的计算模块,它可以对存储在HDFS上的大量数据进行分布式处理。

MapReduce模型将大数据集划分成小数据块,并行处理这些小数据块,最后将结果归并。

MapReduce模型包含两个阶段:Map阶段和Reduce阶段。

Map阶段:将输入的大数据集划分成小数据块,并将每个数据块分配给不同的Map任务处理。

每个Map任务对数据块进行处理,并生成键值对,输出给Reduce任务。

Reduce阶段:对每个键值对进行归并排序,并将具有相同键的一组值传递给Reduce任务,进行汇总和计算。

3. YARNYARN是Hadoop的资源管理器,它负责分配和管理Hadoop集群中的计算资源。

YARN包含两个关键组件:ResourceManager和NodeManager。

ResourceManager:管理整个集群的资源,包括内存、CPU等。

NodeManager:运行在每个计算节点上,负责监控本地计算资源使用情况,并与ResourceManager通信以请求或释放资源。

二、Hadoop的安装与配置在开始使用Hadoop之前,需要进行安装和配置。

hadoop学习总结

Client1 Client2

Name Node

Secondary Name Node

5

4

13 Data Node

5

8

1

4

Data Node

5

4

......

2

3

Data Node

HDFS 的 NameNode 和 DataNode 是和文件存储关系比较大的两个角色。NameNode

是 HDFS 系 统 中 的 管 理 者 , DataNode 是 HDFS 中 保 存 数 据 的 节 点 。 下 面 我 结 合

Share Knowledge Share Happiness 打开视界,打开世界

我总觉得诗人和旅行者天生有共同的特质:他们一直在追寻着灵魂的升华。在这一过程中, 他们眼里可能看到了人间百态或者是人间天堂,基于此,才有诗之深情之切。这种感知生命 深度的起源,在于视界!

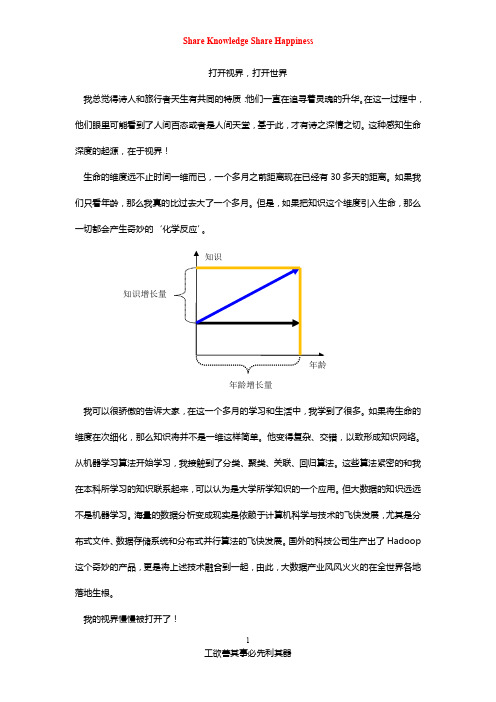

生命的维度远不止时间一维而已,一个多月之前距离现在已经有 30 多天的距离。如果我 们只看年龄,那么我真的比过去大了一个多月。但是,如果把知识这个维度引入生命,那么 一切都会产生奇妙的‘化学反应’。

3

工欲善其事必先利其器

Share Knowledge Share Happiness

Map/Reduce 程序来讲解文件存储在 HDFS 中,如何被运用的过程。

1.1 文件在 HDFS 的存储

我们将文件名为 test.txt(大小为 192MB)文件数据存放在 HDFS 的 http://localhost: 9010/user/sn/testdata 文件夹下 这时,HDFS 根据 test.txt 的大小和 HDFS 默认的数据快的大小(64MB)进行分片,HDFS 将 test.txt 文件分成 3 片。我们假设这三片的名称为 1,2,3. 我们假设我们的集群有四台机器,一台机器为 master,其他三台为 slave. Master 上的 NameNode 上保存着 Test.txt 的元数据信息,3 台 slave 上保存着 Test.txt 的具体数据信息。 具体如下图所示:

hadoop习题答案

hadoop习题答案Hadoop习题答案Hadoop是当前最流行的大数据处理框架之一,它提供了分布式存储和计算能力,使得处理大规模数据变得更加高效和可靠。

随着Hadoop的普及,越来越多的人开始学习和应用它。

在学习Hadoop的过程中,习题是非常重要的一部分,通过解答习题可以加深对Hadoop的理解和掌握。

本文将为大家提供一些常见的Hadoop习题答案,希望能对大家的学习有所帮助。

题目一:如何在Hadoop集群中上传文件?解答:在Hadoop集群中上传文件可以使用hadoop fs -put命令。

该命令将本地文件上传到Hadoop分布式文件系统(HDFS)中。

例如,要将本地文件example.txt上传到HDFS的/user/hadoop目录下,可以使用以下命令:hadoop fs -put example.txt /user/hadoop题目二:如何在Hadoop集群中查看文件内容?解答:在Hadoop集群中查看文件内容可以使用hadoop fs -cat命令。

该命令可以将HDFS中的文件内容输出到控制台。

例如,要查看HDFS中的example.txt文件内容,可以使用以下命令:hadoop fs -cat /user/hadoop/example.txt题目三:如何在Hadoop集群中删除文件?解答:在Hadoop集群中删除文件可以使用hadoop fs -rm命令。

该命令可以删除HDFS中的文件。

例如,要删除HDFS中的example.txt文件,可以使用以下命令:hadoop fs -rm /user/hadoop/example.txt题目四:如何在Hadoop集群中创建目录?解答:在Hadoop集群中创建目录可以使用hadoop fs -mkdir命令。

该命令可以在HDFS中创建新的目录。

例如,要在HDFS的根目录下创建一个名为data 的目录,可以使用以下命令:hadoop fs -mkdir /data题目五:如何在Hadoop集群中运行MapReduce作业?解答:在Hadoop集群中运行MapReduce作业可以使用hadoop jar命令。

Hadoop平台搭建与应用(第2版)(微课版)项目8 Hadoop平台应用综合案例

教 学 提 示

项目8 Hadoop平台应用综合案例

任务8.1 本地数据集上传到数据仓库Hive中

下面把test.txt中的数据导入到数据仓库Hive中。为了完成这个操作,需要先把test.txt上传到HDFS中,再在Hive中创建一个外部表,完成数据的导入。

1.启动HDFS

HDFS是Hadoop的核心组件,因此,要想使用HDFS,必须先安装Hadoop。这里已经安装了Hadoop,打开一个终端,执行命令“start-all.sh”,启动Hadoop服务。

(3)在项目名上,右击选择Open Module Settings,在弹出的页面中选择Modules,单击+号,选择Scala,若本地没有scala,则单击Create...,再单击Download...,选择scala版本2.11.0,单击OK。

(4)编辑pom.xml文件。

(5)在scala文件夹下,新建scala文件,选择Object型,命名为WordCount。

578 NodeManager

3154 Jps

1028 QuorumPeerMain

474 DataNode

1102 HRegionServer

进入HBase Shell。

在HBase中创建user_action表。

新建一个终端,导入数据。

再次切换到HBase Shell运行的终端窗口,执行命令“scan'user_action'”,查询插入的数据。

启动Hadoop集群和HBase服务,并查看集群节点进程。

master1节点的进程如下。

[root@master1 bin]# jps

1714 SecondaryNameNode

Hadoop大数据开发基础教案Hadoop教案MapReduce入门编程教案

Hadoop大数据开发基础教案Hadoop教案MapReduce入门编程教案第一章:Hadoop概述1.1 Hadoop简介了解Hadoop的发展历程理解Hadoop的核心价值观:可靠性、可扩展性、容错性1.2 Hadoop生态系统掌握Hadoop的主要组件:HDFS、MapReduce、YARN理解Hadoop生态系统中的其他重要组件:HBase、Hive、Pig等1.3 Hadoop安装与配置掌握Hadoop单机模式安装与配置掌握Hadoop伪分布式模式安装与配置第二章:HDFS文件系统2.1 HDFS简介理解HDFS的设计理念:大数据存储、高可靠、高吞吐掌握HDFS的基本架构:NameNode、DataNode2.2 HDFS操作命令掌握HDFS的基本操作命令:mkdir、put、get、dfsadmin等2.3 HDFS客户端编程掌握HDFS客户端API:Configuration、FileSystem、Path等第三章:MapReduce编程模型3.1 MapReduce简介理解MapReduce的设计理念:将大数据处理分解为简单的任务进行分布式计算掌握MapReduce的基本概念:Map、Shuffle、Reduce3.2 MapReduce编程步骤掌握MapReduce编程的四大步骤:编写Map函数、编写Reduce函数、设置输入输出格式、设置其他参数3.3 典型MapReduce应用掌握WordCount案例的编写与运行掌握其他典型MapReduce应用:排序、求和、最大值等第四章:YARN资源管理器4.1 YARN简介理解YARN的设计理念:高效、灵活、可扩展的资源管理掌握YARN的基本概念:ResourceManager、NodeManager、ApplicationMaster等4.2 YARN运行流程掌握YARN的运行流程:ApplicationMaster申请资源、ResourceManager 分配资源、NodeManager执行任务4.3 YARN案例实战掌握使用YARN运行WordCount案例掌握YARN调优参数设置第五章:Hadoop生态系统扩展5.1 HBase数据库理解HBase的设计理念:分布式、可扩展、高可靠的大数据存储掌握HBase的基本概念:表结构、Region、Zookeeper等5.2 Hive数据仓库理解Hive的设计理念:将SQL查询转换为MapReduce任务进行分布式计算掌握Hive的基本操作:建表、查询、数据导入导出等5.3 Pig脚本语言理解Pig的设计理念:简化MapReduce编程的复杂度掌握Pig的基本语法:LOAD、FOREACH、STORE等第六章:Hadoop生态系统工具6.1 Hadoop命令行工具掌握Hadoop命令行工具的使用:hdfs dfs, yarn命令等理解命令行工具在Hadoop生态系统中的作用6.2 Hadoop Web界面熟悉Hadoop各个组件的Web界面:NameNode, JobTracker, ResourceManager等理解Web界面在Hadoop生态系统中的作用6.3 Hadoop生态系统其他工具掌握Hadoop生态系统中的其他工具:Azkaban, Sqoop, Flume等理解这些工具在Hadoop生态系统中的作用第七章:MapReduce高级编程7.1 二次排序理解二次排序的概念和应用场景掌握MapReduce实现二次排序的编程方法7.2 数据去重理解数据去重的重要性掌握MapReduce实现数据去重的编程方法7.3 自定义分区理解自定义分区的概念和应用场景掌握MapReduce实现自定义分区的编程方法第八章:Hadoop性能优化8.1 Hadoop性能调优概述理解Hadoop性能调优的重要性掌握Hadoop性能调优的基本方法8.2 HDFS性能优化掌握HDFS性能优化的方法:数据块大小,副本系数等8.3 MapReduce性能优化掌握MapReduce性能优化的方法:JVM设置,Shuffle优化等第九章:Hadoop实战案例9.1 数据分析案例掌握使用Hadoop进行数据分析的实战案例理解案例中涉及的技术和解决问题的方法9.2 数据处理案例掌握使用Hadoop进行数据处理的实战案例理解案例中涉及的技术和解决问题的方法9.3 数据挖掘案例掌握使用Hadoop进行数据挖掘的实战案例理解案例中涉及的技术和解决问题的方法第十章:Hadoop项目实战10.1 Hadoop项目实战概述理解Hadoop项目实战的意义掌握Hadoop项目实战的基本流程10.2 Hadoop项目实战案例掌握一个完整的Hadoop项目实战案例理解案例中涉及的技术和解决问题的方法展望Hadoop在未来的发展和应用前景重点和难点解析重点环节1:Hadoop的设计理念和核心价值观需要重点关注Hadoop的设计理念和核心价值观,因为这是理解Hadoop生态系统的基础。

大数据分析课程2篇

大数据分析课程2篇大数据分析课程第一篇:大数据的基础概念和技术随着互联网的发展,大数据技术在各行各业得到广泛应用。

然而,大数据的概念可能对于许多人来说还不够清晰。

在这篇文章中,我们将介绍大数据的基础概念和技术。

首先,什么是大数据?大数据是指规模巨大、速度快到无法手动处理的数据。

这些数据来自各种来源,包括互联网、社交媒体、传感器等。

大数据的产生速度非常快,因此必须使用大数据技术来处理和分析这些数据。

大数据技术主要有以下几个方面:1. 数据采集和存储:数据采集是收集数据的过程,存储是将已采集到的数据保存在存储设备中。

在大数据时代,数据的形式和来源多种多样,如何高效地采集和存储数据成为了首要的问题。

常用的数据存储技术有关系型数据库、NoSQL、分布式文件系统等。

2. 数据处理和分析:一旦采集到大数据,就需要进行数据处理和分析。

数据处理可以包括数据的清洗、过滤、转换、归纳等操作,以获取更好的数据质量。

数据分析可以帮助我们从数据中发现模式和趋势,并提取有价值的信息。

常用的数据处理和分析工具有Hadoop、Spark、Storm等。

3. 机器学习和人工智能:机器学习和人工智能技术可以帮助我们从数据中发现更多的知识和洞见。

这些技术可以基于数据建模、预测、分类等,以达到自动化的目的。

在大数据时代,机器学习和人工智能技术被用于数据驱动的决策、智能客服、图像和语音识别等领域。

4. 可视化和报告:将数据转化为图表、图形等可视化方式可以帮助用户更直观地理解数据,从而做出更有意义的决策。

同时,报告可以向其他人展示数据分析的结果,以促进共享和合作。

常用的可视化和报告工具有Tableau、Power BI等。

总之,大数据技术已经成为处理和分析数据的核心工具。

在任何行业,只要有大量的数据需要处理,就需要掌握大数据技术,从而更好地利用数据来推动业务的发展。

第二篇:大数据分析的四个步骤大数据分析是利用大量数据、技术和算法来揭示数据中的模式和趋势,以便做出更明智的决策。

数据科学与大数据技术学什么2篇

数据科学与大数据技术学什么数据科学与大数据技术学什么第一篇:数据科学的学习内容数据科学是一门涵盖多个学科的综合性学科,其目的是利用数据来解决实际问题和做出有效决策。

在学习数据科学的过程中,人们需要掌握一系列的技能和知识。

第一个学习内容是数学。

数据科学的基础是统计学和线性代数。

统计学帮助我们理解数据的分布和变异性,而线性代数则用于处理大规模数据的矩阵运算。

此外,数学中的概率论和微积分也是数据科学不可或缺的工具。

第二个学习内容是编程和计算机科学。

数据科学家需要使用编程语言来处理和分析大规模的数据集。

流行的编程语言包括Python和R。

此外,了解计算机科学的基础知识,如数据结构和算法,也是非常重要的。

第三个学习内容是数据分析和数据挖掘技术。

数据科学家需要掌握各种数据分析技术,包括数据清洗、可视化、建模和预测。

此外,数据挖掘技术也是数据科学的重要组成部分,它可以帮助我们从大规模数据集中发现隐藏的模式和关联。

第四个学习内容是机器学习和人工智能。

机器学习是一种基于数据的预测和决策方法,它使用模型来从数据中学习和提取知识。

人工智能则是涉及到模拟和实现人类智能的技术。

了解机器学习和人工智能的基本原理和算法可以帮助数据科学家更好地处理和利用数据。

综上所述,数据科学的学习内容涵盖了数学、编程和计算机科学、数据分析和数据挖掘技术,以及机器学习和人工智能等方面的知识和技能。

通过学习这些内容,人们可以更好地处理和分析大规模的数据,从而做出更有效的决策和解决实际问题。

第二篇:大数据技术的学习内容随着信息时代的到来,大数据技术成为了一门热门的学科。

大数据技术是指为处理和分析大规模数据集而开发的各种工具和技术。

在学习大数据技术时,人们需要掌握一系列的基础知识和技能。

第一个学习内容是大数据平台和工具。

大数据技术的基础是分布式计算和存储技术。

学习者需要了解分布式计算的原理和基本模型,如MapReduce和Spark。

此外,使用大数据平台和工具,如Hadoop和Spark,来处理和分析大规模数据也是非常重要的。

Hadoop基础知识培训 ppt课件

海量数据存储的驱使,具备动态扩展系统容量的需求

把信息化打造成为中国电信企业核心竞争力之一

ppt课件

企业信息化部 35

Hadoop常用组件——Hive简介

Hive是基于Hadoop的一个数据仓库工具,可以将结构化的数据文件映射为一 张数据库表,并提供完整的类sql查询功能,可以将类sql语句转换为 MapReduce任务进行运行。 其优点是学习成本低,可以通过类SQL语句快速 实现简单的MapReduce统计,不必开发专门的MapReduce应用,十分适合数 据仓库的统计分析。

ppt课件

企业信息化部 31

HBase 简介(续)

• 大:一个表可以有上亿行,上百万列

• 面向列:面向列(族)的存储和权限控制, 列(族)独立检索

• 稀疏:对于为空的列,并不占用存储空 间,因此,表可以设计的非常稀疏

• 多版本:每条记录中的数据可以有多个 版本

• 无类型:存在HBase中的数据都是字符 串,无其他类型

ppt课件

企业信息化部 16

3 HDFS 之漫画读写

把信息化打造成为中国电信企业核心竞争力之一

ppt课件

企业信息化部 17

3 HDFS 之漫画读写

把信息化打造成为中国电信企业核心竞争力之一

ppt课件

企业信息化部 18

4 HDFS 之漫画容错

把信息化打造成为中国电信企业核心竞争力之一

ppt课件

企业信息化部 19

把信息化打造成为中国电信企业核心竞争力之一

ppt课件

企业信息化部 33

2 HBase 体系结构

第2章-Hadoop初体验

6、Pig Pig是一种数据流语言和运行环境,用于检索非常大的数据集。 Pig为大型数据集的处理提供了一个更高层次的抽象。与 MapReduce相比,Pig提供了更丰富的数据结构,还提供了一 套更强大的数据变换操作。Pig Latin语言的编译器会把类SQL 的数据分析请求转换为一系列经过优化处理的MapReduce运算。 Pig为复杂的海量数据并行计算提供了一个简单的操作和编程的 接口。

9、Sqoop Sqoop是Apache 旗下一款适用于Hadoop和关系型数据库服务 器之间传送数据的开源工具。通过Sqoop,可以方便地将数据 从MySQL,Oracle等关系数据库中导入到Hadoop的 HDFS、 Hive、HBase 等数据存储系统,也可以将数据从Hadoop的文 件系统中导出到mysql等关系数据库中,使得Hadoop和传统关 系数据库之间的数据迁移变得非常方便。

来增加其存储能力。

5、Hive(数据仓库) Hive是基于Hadoop的一个数据仓库工具,并提供简单的类 SQL的HiveQL 语言实现查询功能,可以将类SQL语句转换为 MapReduce任务进行运行。 其优点是学习成本低,可以通过 类SQL语句快速实现简单的MapReduce统计,不必开发专门的 MapReduce应用,减少开发人员的学习成本,主要适ut Mahout 是 Apache软件基金会旗下的一个开源项目,是 Hadoop系统基于MapReduce开发的数据挖掘/机器学习库,提 供一些可扩展的数据挖掘/机器学习领域经典算法的实现,旨在 帮助开发人员更加方便快捷地创建智能应用程序。Mahout实现 了大部分常用的数据挖掘算法,包括聚类、分类、推荐、频繁

3、 Hadoop优势 (3)高效性。 Hadoop以并行的方式工作,通过大规模的并行处理来加快 数据的处理速度,并保证各个节点的动态平衡,因此保证 了集群的整体处理速度。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Hadoop学习二硬件环境 (1)目录结构 (2)SSH设置 (2)Hadoop环境变量 (4)Hadoop配置文件 (5)启动Hadoop (7)本文主要是以安装和使用hadoop-0.12.0为例,指出在部署Hadoop的时候容易遇到的问题以及如何解决。

硬件环境共有3台机器,均使用的FC5系统,Java使用的是jdk1.6.0。

IP配置如下:dbrg-1:202.197.18.72dbrg-2:202.197.18.73dbrg-3:202.197.18.74这里有一点需要强调的就是,务必要确保每台机器的主机名和IP地址之间能正确解析。

一个很简单的测试办法就是ping一下主机名,比如在dbrg-1上ping dbrg-2,如果能ping通就OK!若不能正确解析,可以修改/etc/hosts文件,如果该台机器作Namenode用,则需要在hosts文件中加上集群中所有机器的IP 地址及其对应的主机名;如果该台机器作Datanode用,则只需要在hosts文件中加上本机IP地址和Namenode机器的IP地址。

以本文为例,dbrg-1中的/etc/hosts文件看起来就应该是这样的:127.0.0.0 localhost localhost202.197.18.72 dbrg-1 dbrg-1202.197.18.73 dbrg-2 dbrg-2202.197.18.74 dbrg-3 dbrg-3dbrg-2中的/etc/hosts文件看起来就应该是这样的:127.0.0.0 localhost localhost202.197.18.72 dbrg-1 dbrg-1202.197.18.73 dbrg-2 dbrg-2在上一篇学习笔记中提到过,对于Hadoop来说,在HDFS看来,节点分为Namenode和Datanode,其中Namenode只有一个,Datanode可以是很多;在MapReduce看来,节点又分为Jobtracker和Tasktracker,其中Jobtracker只有一个,Tasktracker可以是很多。

我是将namenode和jobtracker部署在dbrg-1上,dbrg-2,dbrg-3作为datanode和tasktracker。

当然你也可以将namenode,datanode,jobtracker,tasktracker全部部署在一台机器上。

目录结构由于Hadoop要求所有机器上hadoop的部署目录结构要相同,并且都有一个相同的用户名的帐户。

我的三台机器上是这样的:都有一个dbrg的帐户,主目录是/home/dbrg Hadoop部署目录结构如下:/home/dbrg/HadoopInstall,所有的hadoop版本放在这个目录中。

将hadoop0.12.0压缩包解压至HadoopInstall 中,为了方便以后升级,建议建立一个链接指向要使用的hadoop版本,不妨设hadoop[dbrg@dbrg-1:HadoopInstall]$ln –s hadoop0.12.0 hadoop 这样一来,所有的配置文件都在/hadoop/conf/目录中,所有执行程序都在/hadoop/bin目录中。

但是由于上述目录中hadoop的配置文件和hadoop的安装目录是放在一起的,这样一旦日后升级hadoop版本的时候所有的配置文件都会被覆盖,因此建议将配置文件与安装目录分离,一种比较好的方法就是建立一个存放配置文件的目录,/home/dbrg/HadoopInstall/hadoop-config/,然后将/hadoop/conf/目录中的hadoop_site.xml,slaves,hadoop_env.sh三个文件拷贝到hadoop-config/目录中(这个问题很奇怪,在官网上的Getting Started With Hadoop中说是只需要拷贝这个三个文件到自己创建的目录就可以了,但我在实际配置的时候发现还必须把masters这个文件也拷贝到hadoop-conf/目录中才行,不然启动Hadoop的时候就会报错说找不到masters这个文件),并指定环境变量$HADOOP_CONF_DIR指向该目录。

环境变量在/home/dbrg/.bashrc和/etc/profile中设定。

综上所述,为了方便以后升级版本,我们需要做到配置文件与安装目录分离,并通过设定一个指向我们要使用的版本的hadoop的链接,这样可以减少我们对配置文件的维护。

在下面的部分,你就会体会到这样分离以及链接的好处了。

SSH设置在Hadoop启动以后,Namenode是通过SSH(Secure Shell)来启动和停止各个节点上的各种守护进程的,这就需要在节点之间执行指令的时候是不需要输入密码的方式,故我们需要配置SSH使用无密码公钥认证的方式。

首先要保证每台机器上都装了SSH服务器,且都正常启动。

实际中我们用的都是OpenSSH,这是SSH协议的一个免费开源实现。

FC5中默认安装的OpenSSH 版本是OpenSSH4.3P2。

以本文中的三台机器为例,现在dbrg-1是主节点,它需要主动发起SSH连接到dbrg-2和dbrg-3,对于SSH服务来说,dbrg-1就是SSH 客户端,而dbrg-2、dbrg-3则是SSH服务端,因此在dbrg-2,dbrg-3上需要确定sshd服务已经启动。

简单的说,在dbrg-1上需要生成一个密钥对,即一个私钥,一个公钥。

将公钥拷贝到dbrg-2,dbrg-3上,这样,比如当dbrg-1向dbrg-2发起ssh连接的时候,dbrg-2上就会生成一个随机数并用dbrg-1的公钥对这个随机数进行加密,并发送给dbrg-1;dbrg-1收到这个加密的数以后用私钥进行解密,并将解密后的数发送回dbrg-2,dbrg-2确认解密的数无误后就允许dbrg-1进行连接了。

这就完成了一次公钥认证过程。

对于本文中的三台机器,首先在dbrg-1上生成密钥对:[dbrg@dbrg-1:~]$ssh-keygen -t rsa。

这个命令将为dbrg-1上的用户dbrg生成其密钥对,询问其保存路径时直接回车采用默认路径,当提示要为生成的密钥输入passphrase的时候,直接回车,也就是将其设定为空密码。

生成的密钥对id_rsa,id_rsa.pub,默认存储在/home/dbrg/.ssh目录下。

然后将id_rsa.pub的内容复制到每个机器(也包括本机)的/home/dbrg/.ssh/authorized_keys文件中,如果机器上已经有authorized_keys这个文件了,就在文件末尾加上id_rsa.pub中的内容,如果没有authorized_keys这个文件,直接cp或者scp就好了,下面的操作假设各个机器上都没有authorized_keys文件。

对于dbrg-1[dbrg@dbrg-1:.ssh]$cp id_rsa.pub authorized_keys对于dbrg-2(dbrg-3同dbrg-2的方法)[dbrg@dbrg-2:~]$mkdir .ssh[dbrg@dbrg-1:.ssh]$scp authorized_keys dbrg-2:/home/dbrg/.ssh/此处的scp就是通过ssh进行远程copy,此处需要输入远程主机的密码,即dbrg-2机器上dbrg帐户的密码,当然,你也可以用其他方法将authorized_keys 文件拷贝到其他机器上[dbrg@dbrg-2:.ssh]$chmod 644 authorized_keys这一步非常关键,必须保证authorized_keys只对其所有者有读写权限,其他人不允许有写的权限,否则SSH是不会工作的。

我就曾经在配置SSH的时候郁闷了好久。

[dbrg@dbrg-2:.ssh]ls -ladrwx------ 2 dbrg dbrg .drwx------ 3 dbrg dbrg ..-rw-r--r-- 1 dbrg dbrg authorized_keys注意每个机器上的.ssh目录的ls -la都应该和上面是一样的接着,在三台机器上都需要对sshd服务进行配置(其实是可以不用配置的,完成了上面的那些操作了以后SSH就已经可以工作了),在三台机器上修改文件/etc/ssh/sshd_config#去除密码认证PasswordAuthentication noAuthorizedKeyFile .ssh/authorized_keys至此各个机器上的SSH配置已经完成,可以测试一下了,比如dbrg-1向dbrg-2发起ssh连接[dbrg@dbrg-1:~]$ssh dbrg-2如果ssh配置好了,就会出现以下提示信息The authenticity of host [dbrg-2] can't be established. Keyfingerprintis10245f:a0:0b:65:d3:82:df:ab:44:62:6d:98:9c:fe:e9:52. Are you sure you want to continue connecting (yes/no)?OpenSSH告诉你它不知道这台主机,但是你不用担心这个问题,因为你是第一次登录这台主机。

键入“yes”。

这将把这台主机的“识别标记”加到“~/.ssh/know_hosts”文件中。

第二次访问这台主机的时候就不会再显示这条提示信息了。

然后你会发现不需要输入密码就可以建立ssh连接了,恭喜你,配置成功了不过,别忘了测试本机ssh dbrg-1Hadoop环境变量在/home/dbrg/HadoopInstall/hadoop-conf目录下的hadoop_env.sh中设置Hadoop需要的环境变量,其中JAVA_HOME是必须设定的变量。

HADOOP_HOME 变量可以设定也可以不设定,如果不设定,HADOOP_HOME默认的是bin目录的父目录,即本文中的/home/dbrg/HadoopInstall/hadoop。

我的是这样设置的export HADOOP_HOME=/home/dbrg/HadoopInstall/hadoopexport JAVA_HOME=/usr/java/jdk1.6.0从这个地方就可以看出前面所述的创建hadoop0.12.0的链接hadoop的优点了,当以后更新hadoop的版本的时候,就不需要在改配置文件,只需要更改链接就可以了。

Hadoop配置文件如前所述,在hadoop-conf/目录下,打开slaves文件,该文件用来指定所有的从节点,一行指定一个主机名。