Linux桥接功能的分析

Linux 网桥配置命令:brctl

Linux网关模式下将有线LAN和无线LAN共享网段实现局域网内互联:思路其实很简单:就是将虚拟出一个bridge口,将对应的有线LAN和无线LAN都绑定在这个虚拟bridge口上,并给这个bridge口分配一个地址,其他子网微机配置网关为bridge 口的地址便可以了。

当然,因为是设备是网关模式,路由和nat也是必须的了。

如果设备本身便是网桥模式,那么路由和nat便可以省掉了。

brctl addbr bridgebrctl addif bridge eth0brctl addif bridge ath0ifconfig eth0 0.0.0.0ifconfig bridge 10.0.0.1 netmask 255.255.255.0 up添加iptables -t nat -A POSTROUTING -o eth1 -j SNAT --to 192.168.2.173将有线和无线都设置为10.0.0.*网段,即可通过网上邻居进行访问当然了,要是Linux可以工作在网桥模式,必须安装网桥工具bridge-utils,运行命令:yum install bridge-utils或者下载bridge-utils-1.4.tar.gz进行安装,步骤如下:编译安装bridge-utils(1)进入到/usr/src 目录下,下载bridge-utils-1.4.tar.gz :#cd /usr/src#wget /bridgeutils/main/1.4/+download/bridge-utils-1.4.tar.gz(2)解压缩:#tar zxvf bridge-utils-1.4.tar.gz进入bridge-utils-1.4目录:#cd bridge-utils-1.4(3)编译安装:#autoconf生成configure文件:#./configure#make#make install编译安装完成。

linux tap原理

linux tap原理Linux Tap是一种在Linux系统中实现网络桥接的方式,它允许用户在物理网络上创建虚拟网络接口,从而实现网络流量在多个设备之间的转发和隔离。

本文将介绍Linux Tap的基本原理、实现方式、应用场景和注意事项。

Linux Tap的核心思想是将物理网络接口(如eth0)虚拟化为多个网络接口,每个接口代表一个虚拟网络,从而实现网络流量的隔离和转发。

具体来说,Linux Tap通过使用内核中的tap-netdev和tap-module模块来实现虚拟网络的创建和管理。

这些模块允许用户将物理网络接口桥接到虚拟网络上,并配置相应的网络参数,如IP地址、子网掩码、网关等。

二、Linux Tap的实现方式Linux Tap的实现方式主要涉及内核模块、驱动程序和用户空间工具三个层次。

内核模块负责注册tap设备,并提供基本的设备管理功能;驱动程序负责与内核模块进行交互,处理虚拟网络的创建、销毁和数据转发等操作;用户空间工具则提供用户接口,用于配置虚拟网络参数和管理tap设备。

三、Linux Tap的应用场景Linux Tap广泛应用于网络安全、云计算、物联网等领域。

在网络安全方面,Linux Tap可以实现网络流量的隔离和监控,提高网络安全性能;在云计算领域,Linux Tap可以实现虚拟机之间的网络通信和流量控制;在物联网方面,Linux Tap可以实现传感器数据传输和设备间通信。

四、注意事项在使用Linux Tap时,需要注意以下几点:1. 确保虚拟网络的安全性:Linux Tap可能会暴露物理网络接口给虚拟网络,因此需要采取适当的网络安全措施,如设置访问控制列表(ACL)来限制虚拟网络中设备的访问权限。

2. 配置正确的网络参数:用户需要正确配置虚拟网络的IP地址、子网掩码、网关等参数,以确保网络通信正常进行。

3. 考虑性能问题:由于Linux Tap需要将数据包从物理网络转发到虚拟网络,因此需要注意性能问题,如数据包丢失、延迟等。

Linux-网桥原理分析(三)

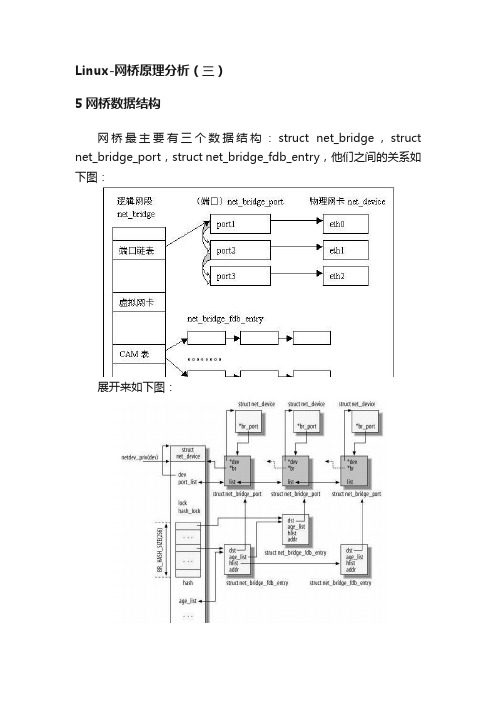

Linux-网桥原理分析(三)5网桥数据结构网桥最主要有三个数据结构:struct net_bridge,struct net_bridge_port,struct net_bridge_fdb_entry,他们之间的关系如下图:展开来如下图:说明:1. 其中最左边的net_device是一个代表网桥的虚拟设备结构,它关联了一个net_bridge结构,这是网桥设备所特有的数据结构。

2. 在net_bridge结构中,port_list成员下挂一个链表,链表中的每一个节点(net_bridge_port结构)关联到一个真实的网口设备的net_device。

网口设备也通过其br_port指针做反向的关联(那么显然,一个网口最多只能同时被绑定到一个网桥)。

3. net_bridge结构中还维护了一个hash表,是用来处理地址学习的。

当网桥准备转发一个报文时,以报文的目的Mac地址为key,如果可以在hash表中索引到一个net_bridge_fdb_entry结构,通过这个结构能找到一个网口设备的net_device,于是报文就应该从这个网口转发出去;否则,报文将从所有网口转发。

各个结构体具体内容如下:struct net_bridgespinlock_t hash_lock;//hash表的锁/*--CAM: 保存forwarding database的一个hash链表(这个也就是地址学习的东东,所以通过hash能快速定位),这里每个元素都是一个net_bridge_fsb_entry结构--*/struct hlist_head hash[BR_HASH_SIZE];struct list_head age_list;/* STP *///与stp 协议对应的数据bridge_id designated_root;bridge_id bridge_id;u32 root_path_cost;unsigned long max_age;unsigned long hello_time;unsigned long forward_delay;unsigned long bridge_max_age;unsigned long ageing_time;unsigned long bridge_hello_time;unsignedlong bridge_forward_delay;u16 root_port;2. struct net_bridge_portu8 priority;u8 state;u16 port_no;//本端口在网桥中的编号unsignedchar topology_change_ack;unsigned char config_pending;port_id port_id;port_id designated_port;bridge_id designated_root;bridge_id designated_bridge;u32 path_cost;u32 designated_cost;//端口定时器,也就是stp控制超时的一些定时器列表struct timer_list forward_delay_timer;struct timer_list hold_timer;struct timer_list message_age_timer;struct kobject kobj;struct rcu_head rcu;}3. struct net_bridge_fdb_entrystruct hlist_node hlist;//桥的端口(最主要的两个域就是这个域和下面的mac地址域)struct net_bridge_port *dst;struct rcu_head rcu;//当使用RCU 策略,才用到atomic_t use_count;//引用计数unsigned long ageing_timer;//MAC 超时时间mac_addr addr;//mac地址。

linux的bridge分析

linux的bridge分析Linux网桥模型:Linux内核通过一个虚拟的网桥设备来实现桥接的,这个设备可以绑定若干个以太网接口设备,从而将它们桥接起来。

如下图所示:网桥设备br0绑定了eth0和eth1。

对于网络协议栈的上层来说,只看得到br0,因为桥接是在数据链路层实现的,上层不需要关心桥接的细节。

于是协议栈上层需要发送的报文被送到br0,网桥设备的处理代码再来判断报文该被转发到eth0或是eth1,或者两者皆是;反过来,从eth0或从eth1接收到的报文被提交给网桥的处理代码,在这里会判断报文该转发、丢弃、或提交到协议栈上层。

而有时候eth0、eth1也可能会作为报文的源地址或目的地址,直接参与报文的发送与接收(从而绕过网桥)。

相关数据结构:其中最左边的net_device是一个代表网桥的虚拟设备结构,它关联了一个net_bridge结构,这是网桥设备所特有的数据结构。

在net_bridge结构中,port_list成员下挂一个链表,链表中的每一个节点(net_bridge_port结构)关联到一个真实的网口设备的net_device。

网口设备也通过其br_port指针做反向的关联(那么显然,一个网口最多只能同时被绑定到一个网桥)。

net_bridge结构中还维护了一个hash表,是用来处理地址学习的。

当网桥准备转发一个报文时,以报文的目的Mac地址为key,如果可以在hash表中索引到一个net_bridge_fdb_entry结构,通过这个结构能找到一个网口设备的net_device,于是报文就应该从这个网口转发出去;否则,报文将从所有网口转发。

网桥数据包的处理流程:接收过程:对于数据包的处理流程并没有明显的主线,主要就是根据内核代码中网桥部分的源码进行分析。

网口设备接收到的报文最终通过net_receive_skb函数被网络协议栈所接收。

这个函数主要做三件事情:1、如果有抓包程序需要skb,将skb复制给它们;2、处理桥接;3、将skb提交给网络层。

设计模式之桥接(bridge)模式

设计模式之桥接(bridge)模式 在现实⽣活中,我们常常会⽤到两种或多种类型的笔,⽐如⽑笔和蜡笔。

假设我们需要⼤、中、⼩三种类型的画笔来绘制12中不同的颜⾊,如果我们使⽤蜡笔,需要准备3*12=36⽀。

但如果使⽤⽑笔的话,只需要提供3种型号的⽑笔,外加12个颜料盒即可,涉及的对象个数仅为3+12=15,远远⼩于36却能实现与36⽀蜡笔同样的功能。

如果需要新增⼀种画笔,并且同样需要12种颜⾊,那么蜡笔需要增加12⽀,⽽⽑笔却只需要新增1⽀。

通过分析,在蜡笔中,颜⾊和型号两个不同的变化维度耦合在⼀起,⽆论对其中任何⼀个维度进⾏扩展,都势必会影响另外⼀个维度。

但在⽑笔中,颜⾊和型号实现了分离,增加新的颜⾊或者型号都对另外⼀⽅没有任何影响。

在软件系统中,有些类型由于⾃⾝的逻辑,它具有两个或多个维度的变化。

为了解决这种多维度变化,⼜不引⼊复杂度,这就要使⽤今天介绍的Bridge桥接模式。

⼀、跨平台的图像浏览系统1.1 需求介绍M公司开发部想要开发⼀个跨平台的图像浏览系统,要求该系统能够显⽰JPG、BMP、GIF、PNG等多种格式的⽂件,并且能够在Windows、Linux以及Unix等多个操作系统上运⾏。

该系统⾸先将各种格式的⽂件解析为像素矩阵(Matrix),然后将像素矩阵显⽰在屏幕上,在不同的操作系统中可以调⽤不同的绘制函数来绘制像素矩阵。

该系统需要具备较好的扩展性以⽀持新的⽂件格式和操作系统。

1.2 初始设计 M公司开发部的程序猿针对需求,⽴马提出了⼀个初始的设计⽅案,其基本结构如下图所⽰: 通过对这个设计⽅案的分析,发现存在以下两个主要问题: (1)由于采⽤了多重继承结构,导致系统中类的个数急剧增加,系统中类的个数达到了17个。

(2)系统扩展⿇烦,由于每⼀个具体类既包括图像⽂件格式信息,⼜包含操作系统信息,因此⽆论增加新图像⽂件格式还是新的操作系统,都需要增加⼤量的具体类。

这将导致系统变得⾮常庞⼤,增加运⾏和维护开销。

Linux系统常见的网络连接问题及解决方案详解

Linux系统常见的网络连接问题及解决方案详解在使用Linux系统过程中,我们经常会遇到各种网络连接问题。

本文将详细介绍几种常见的网络连接问题,并提供相应的解决方案。

一、无法连接到网络无法连接到网络是最常见的网络问题之一。

当我们无法连接到网络时,首先需要确认以下几点:1. 网络连接是否正常:检查网络连接是否已启用,确保网络线缆连接到正确的接口上。

2. IP地址是否配置正确:通过 ifconfig 命令检查当前网络接口的IP地址和子网掩码是否配置正确。

3. DNS解析是否正常:配置 DNS 服务器的地址,可通过编辑/etc/resolv.conf 文件来指定 DNS 服务器地址。

若以上检查都正常,而仍无法连接到网络,则可能有以下原因导致:1. 防火墙配置问题:检查防火墙是否阻止了网络连接。

可以使用iptables 命令来查看、修改防火墙规则。

2. 硬件问题:检查网卡是否正常工作,可以通过 lspci 命令查看系统中是否存在网卡设备。

3. 路由器配置问题:检查路由器的配置,确保网络设置正确。

二、网络延迟高网络延迟高会导致网络连接变慢或不稳定。

以下是一些降低网络延迟的解决方案:1. 检查网络带宽:使用网速测试工具(如speedtest-cli)检查当前网络带宽情况。

如果带宽使用率过高,可以考虑限制某些应用程序的带宽使用。

2. 优化网络设置:调整系统的TCP参数,可以使用 sysctl 命令来修改。

例如,通过增加tcp_fin_timeout 值来减少关闭连接时的等待时间。

3. 检查网络设备:检查路由器、交换机等网络设备是否正常工作。

可以尝试重新启动这些设备,或升级其固件。

三、无法解析域名无法解析域名是指无法通过域名获取相应的IP地址。

解决这个问题可以从以下几个方面入手:1. 检查DNS配置:查看 /etc/resolv.conf 文件,确认已正确配置DNS 服务器的地址。

也可以尝试更换为其他的DNS服务器地址,如Google DNS(8.8.8.8)。

两台linux主机传送大文件的方法-解释说明

两台linux主机传送大文件的方法-概述说明以及解释1.引言1.1 概述概述:在进行文件传输时,Linux主机之间有多种方法可供选择。

本文将介绍三种常用的方法:使用SCP命令进行文件传输、使用rsync命令进行文件传输,以及使用FTP服务器进行文件传输。

这些方法各有优缺点,我们将对它们进行详细的比较和总结。

同时,我们也会给出我们的最佳推荐方法,并展望未来的发展方向。

文件传输在日常工作和生活中非常常见,特别是在Linux环境下。

无论是在服务器之间进行文件备份、数据同步,还是在不同的开发环境中共享文件,选择合适的文件传输方法能够提高效率、节省时间。

在接下来的章节中,我们将详细介绍每种方法的基本用法和高级用法,并分析它们的优缺点。

首先,我们将介绍SCP命令,它是一种简单直观的文件传输方式。

然后,我们将介绍rsync命令,它提供了更为灵活和高效的文件传输选项。

最后,我们将介绍FTP服务器的搭建和使用方法,探讨它的优势和不足。

通过对这些方法的比较和分析,我们将总结出每种方法的适用场景,并给出我们的最佳推荐方法。

此外,我们也会对未来的文件传输技术发展进行展望,以期提升文件传输的速度、安全性和便利性。

通过本文的阅读,读者将能够了解到不同的文件传输方法之间的差异,为自己的工作环境选择合适的传输方式提供参考和指导。

接下来,让我们开始介绍第一种传输方法:使用SCP命令进行文件传输。

1.2文章结构文章结构部分内容如下:2. 正文2.1 方法一:使用SCP命令进行文件传输2.1.1 SCP命令的基本用法2.1.2 SCP命令的高级用法2.1.3 SCP命令的优缺点2.2 方法二:使用rsync命令进行文件传输2.2.1 rsync命令的基本用法2.2.2 rsync命令的高级用法2.2.3 rsync命令的优缺点2.3 方法三:使用FTP服务器进行文件传输2.3.1 搭建FTP服务器2.3.2 使用FTP客户端进行文件传输2.3.3 FTP服务器的优缺点3. 结论3.1 对比和总结各种方法的优缺点3.2 推荐最佳的方法3.3 展望未来的发展方向在本文中,我们将重点探讨两台Linux主机之间传送大文件的方法。

brctl 原理

brctl 原理BRCTL原理详解BRCTL是一个基于Linux的网络桥接工具,它允许将多个网络接口连接成一个透明的网络,包括虚拟机、容器等,是构建网络架构的核心组件之一。

本文将详细介绍BRCTL的原理。

一、基本概念1.1 网桥网络桥(bridge)是一种设备,作用是将两个物理局域网合并成一个单一的逻辑网络。

1.2 网络接口网络接口(NIC)是一种设备,可以接收和发送数据包,如物理网卡、虚拟网卡等。

1.3 MAC地址MAC地址是一种唯一标识网卡的地址,由48位二进制数组成。

1.4 VLANVLAN(Virtual Local Area Network)是虚拟局域网的缩写,是一种将物理局域网分割成多个逻辑局域网的技术。

二、BRCTL原理2.1 什么是BRCTLBRCTL是一个Linux内核的网络桥接工具,允许将多个网络接口连接成一个透明的网络,可以将同一网段的多个主机桥接起来形成一个局域网。

BRCTL的作用是实现虚拟机、容器等应用程序的网络互通,使其可以同物理机及其他虚拟机等设备通信,实现网络的无缝连接。

2.2 BRCTL的工作原理BRCTL的工作过程如下:(1)当一个数据包从一个网络接口进入时,BRCTL将其转发到所有其他接口。

(2)当一个数据包从一个接口进入BRCTL后,它的源MAC地址和端口号将被存储,并被用于之后的数据包转发。

(3)当一个数据包从BRCTL转发到网络接口时,目的MAC地址将被匹配并将数据包转发到目标接口。

(4)如果目标MAC地址无法匹配,则数据包将被转发到所有其他接口。

2.3 BRCTL的配置参数BRCTL的常用配置参数如下:(1)addbr:创建一个新的网络桥。

(2)delbr:删除一个网络桥。

(3)addif:将一个网络接口添加到指定的网络桥中。

(4)delif:将一个网络接口从指定的网络桥中删除。

(5)show:显示当前可用的网络桥和绑定在它们上面的网络接口。

2.4 BRCTL的应用场景BRCTL广泛用于以下场景:(1)虚拟化环境:容器和虚拟机之间网络互通。

linux中管道的作用

linux中管道的作用管道是Linux操作系统中非常重要的功能之一,它在不同进程之间建立了一个通信通道,使得这些进程可以相互传递数据。

本文将探讨管道在Linux中的作用及其重要性。

管道可以实现进程间的数据传递。

在Linux中,每个进程都是独立的,拥有自己的内存空间。

但是,有时候我们需要将一个进程的输出作为另一个进程的输入,以便它们之间进行数据交换。

这时候就可以使用管道来实现。

通过管道,一个进程的输出数据可以直接传递给另一个进程,而不需要将数据写入文件再读取,大大提高了数据传输的效率。

管道可以实现进程的串联。

在Linux中,我们可以通过管道将多个进程连接起来,形成一个进程链。

每个进程都可以处理前一个进程的输出数据,并将处理结果传递给下一个进程。

这样,多个进程可以有机地协同工作,完成复杂的任务。

例如,在一个数据处理流程中,可以通过管道将数据从一个进程传递到另一个进程,每个进程负责一部分数据处理工作,最终得到最终的结果。

管道还可以实现进程的并行计算。

在Linux中,我们可以使用管道将数据分发给多个进程,每个进程独立地处理一部分数据,并将处理结果传递给下一个进程。

这样,多个进程可以并行地处理数据,大大加快了计算速度。

这对于一些需要大量计算的任务,如科学计算、数据分析等非常有用。

除了上述作用,管道还可以用于进程的控制和同步。

在Linux中,我们可以通过管道向某个进程发送特定的命令或信号,以控制其行为。

同时,管道也可以用于进程的同步,确保多个进程之间的执行顺序和结果的一致性。

管道是Linux中非常重要的功能之一,它在不同进程之间建立了一个通信通道,实现了进程间的数据传递、串联和并行计算。

同时,管道还可以用于进程的控制和同步。

在Linux的命令行环境下,我们可以通过各种命令和符号来创建、使用和管理管道。

掌握了管道的使用方法,可以大大提高工作效率,简化任务的处理过程。

因此,对于Linux系统的用户来说,熟练掌握管道的使用是非常重要的。

linux进程间通信实验心得

linux进程间通信实验心得随着对Linux系统的深入了解,我对进程间通信(IPC)的重要性有了更深刻的认识。

在这次实验中,我通过实际操作,掌握了多种Linux进程间通信的方法,并对它们的特点和应用场景有了更清晰的了解。

实验过程中,我主要接触了三种主要的进程间通信方法:管道(Pipe)、信号(Signal)和共享内存(Shared Memory)。

每种方法都有其独特的特点和使用场景。

管道是最基本的进程间通信方式,它允许父子进程之间进行通信。

通过管道,一个进程可以将数据写入到管道中,而另一个进程可以从管道中读取数据。

我在实验中创建了多个进程,并通过管道实现了它们之间的数据传递。

虽然管道简单易用,但它的通信能力有限,只能用于父子进程或兄弟进程之间的通信。

信号是一种异步的进程间通信方式,一个进程可以向另一个进程发送信号。

接收进程可以根据信号的类型采取不同的行动。

我在实验中通过信号实现了进程间的控制和同步。

虽然信号可以用于任何两个进程之间的通信,但由于它是异步的,使用起来需要小心处理信号的捕获和处理。

共享内存是一种高效的进程间通信方式,它允许多个进程访问同一块内存空间。

通过共享内存,进程可以快速地读写数据,避免了数据在进程间传递的开销。

我在实验中创建了多个进程,让它们共享一块内存区域,并通过读写共享内存实现了数据的快速传递。

共享内存的优点是通信速度快,但需要处理好同步和互斥问题,以避免数据冲突和错误。

通过这次实验,我对Linux进程间通信有了更深入的了解。

在实际应用中,需要根据具体的需求和场景选择合适的进程间通信方法。

同时,我也认识到进程间通信的复杂性和挑战性,需要仔细考虑和处理各种可能的问题。

在未来的学习和工作中,我将继续深入学习Linux系统及其相关技术,不断提高自己的技能和能力。

同时,我也将关注新技术的发展和应用,保持对行业的敏感度和竞争力。

网桥转发的原理

网桥的基本工作原理数据链路层互联的设备是网桥(bridge),在网络互联中它起到数据接收、地址过滤与数据转发的作用,用来实现多个网络系统之间的数据交换。

网桥的基本特征1.网桥在数据链路层上实现局域网互连;2.网桥能够互连两个采用不同数据链路层协议、不同传输介质与不同传输速率的网络;3.网桥以接收、存储、地址过滤与转发的方式实现互连的网络之间的通信;4.网桥需要互连的网络在数据链路层以上采用相同的协议;5.网桥可以分隔两个网络之间的广播通信量,有利于改善互连网络的性能与安全性。

网桥的工作过程网桥最常见的用法是用于连接两个局域网,下图给出了两个局域网通过网桥互联的工作原理。

网桥的基本分类网桥按照其路由表的建立方法分为两类--透明网桥(transparent bridge)--源路选网桥(source routing bridge)透明网桥的主要特点透明网桥由各个网桥自己来决定路由选择,局域网上的各结点不负责路由选择,网桥对于互连局域网的各结点来说是“透明”的;透明网桥一般用在两个使用同样的MAC层协议的网段之间的互连。

例如连接两个Ethernet网段,或两个令牌环网;透明网桥的最大优点是容易安装,是一种即插即用设备。

Linux-网桥原理分析(一)时间:2010-11-15 12:00:56来源:网络作者:未知点击:293次目录1..... 前言2 网桥的原理2.1 桥接的概念2.2 linux的桥接实现2.3 网桥的功能3 网桥的配置4 网桥的实现4.1 初始化4.2 新建网桥目录1..... 前言2 网桥的原理2.1 桥接的概念2.2 linux的桥接实现2.3 网桥的功能3 网桥的配置4 网桥的实现4.1 初始化4.2 新建网桥4.3 添加删除端口5 网桥数据结构6 网桥数据库的维护6.1 数据库的创建和销毁6.2 数据库更新6.3 创建数据项6.4 查找数据项6.5 MAC地址过期清理7 网桥数据包的处理流程7.1 netif_receive_skb7.2 Br_handle_frame7.3 Br_handle_frame_finish7.4 Br_pass_frame_up7.5 Br_forward7.6 __br_forward7.7 Br_forward_finish7.8 Br_dev_queue_push_xmit8..... 参考文献1 前言本文的参考分析的源代码版本是2.6.15,我是边学习边总结,学习的过程中得益于Linux论坛(/bbs/)上大侠们总结分析的文档,他山之石可以攻玉,学习过程中我也会边学边总结,开源的发展在于共享,我也抛块砖,望能引到玉!由于自身水平有限,且相关的参考资料较少,因此其中的结论不能保证完全正确,如果在阅读本文的过程中发现了问题欢迎及时与作者联系。

虚拟机 桥接 原理

虚拟机桥接原理桥接(bridging)是一种网络连接技术,用于将两个或多个局域网(LAN)或广域网(WAN)互联。

虚拟机的桥接模式允许虚拟机直接与主机所在的物理网络连接,使得虚拟机可以像一个独立的实体一样在网络中进行通信。

下面将详细介绍桥接模式的原理。

1. 桥接设备在虚拟机的桥接模式中,虚拟机网络接口被绑定到一个桥接设备上。

这个桥接设备实际上是一个虚拟的网络交换机,它有一个虚拟网卡和一个物理网卡。

虚拟网卡负责与虚拟机进行通信,物理网卡则负责与物理网络进行通信。

2. MAC 地址学习当虚拟机在桥接模式下启动时,虚拟网卡会向桥接设备发送一个广播,请求其他设备的MAC 地址。

桥接设备会接收到这个广播消息,并将其转发到物理网络上。

当物理网络上的设备接收到此广播消息时,会将自己的MAC 地址回复给虚拟机的虚拟网卡。

虚拟网卡将收到的MAC 地址保存在一个学习表中,这样虚拟机就可以直接与其他设备进行通信。

3. 数据转发当虚拟机发送数据包时,数据包将首先发送到桥接设备的虚拟网卡,虚拟网卡根据目标MAC 地址查找学习表,确定数据包的下一跳。

如果目标MAC 地址在学习表中,那么数据包将被转发到对应的物理网卡上,然后发送到物理网络。

4. 广播包转发在桥接模式下,虚拟机发送的广播包将会被桥接设备复制并转发到物理网络上的所有设备上。

这样,虚拟机就可以像其他设备一样接收广播消息,并与物理网络上的其他设备进行通信。

5. 网络接通性使用桥接模式可以使虚拟机能够与同一网络中的其他设备进行通信,而不需要经过主机。

这样,虚拟机可以直接访问网络中的其他设备,并可以被其他设备直接访问。

这种网络接通性使得虚拟机可以像一个独立的实体一样存在于网络中,提供各种网络服务。

总结:桥接模式将虚拟机与主机所在的物理网络连接起来,使得虚拟机可以直接与其他设备进行通信。

通过桥接设备的MAC 地址学习和数据转发功能,实现了虚拟机与物理网络之间的数据通信。

桥接模式还支持广播包转发,使得虚拟机可以与物理网络中的其他设备进行广播消息的交换。

linux网桥中stp分析

linux网桥中stp分析STP(Spanning Tree Protocol)是一个二层管理生成树协议。

在一个扩展的局域网中参与STP的所有交换机之间通过交换桥协议数据单元bpdu(bridge protocol data unit)来实现;为稳定的生成树拓扑结构选择一个根桥;为每个交换网段选择一台指定交换机;将冗余路径上的交换机置为blocking,来消除网络中的环路.其标准在IEEE 802.1d定义,提供网络的动态冗余切换机制.rSTP(rapid spanning tree protocol)是STP的扩展,其主要特点是增加了端口状态快速切换的机制,能够实现网络拓扑的快速转换.STP通过阻塞一个或多个冗余端口,维护一个无回路的网络(IEEE802.1d)2 代码分析1) 软中断网桥接收数据int netif_receive_skb(struct sk_buff *skb){...skb_reset_network_header(skb);skb_reset_transport_header(skb);skb->mac_len = skb->network_header - skb->mac_header;.../* 网桥处理 */skb = handle_bridge(skb, &pt_prev, &ret, orig_dev);if (!skb)goto out;...type = skb->protocol;list_for_each_entry_rcu(ptype,&ptype_base[ntohs(type) & PTYPE_HASH_MASK], list) {if (ptype->type == type &&(ptype->dev == null_or_orig || ptype->dev == skb->dev || ptype->dev == orig_dev)) {if (pt_prev)ret = deliver_skb(skb, pt_prev, orig_dev);pt_prev = ptype;}}if (pt_prev) {ret = pt_prev->func(skb, skb->dev, pt_prev, orig_dev);} else {kfree_skb(skb);ret = NET_RX_DROP;}out:rcu_read_unlock();return ret;}static inline struct sk_buff *handle_bridge(struct sk_buff *skb, struct packet_type **pt_prev, int *ret,struct net_device *orig_dev){struct net_bridge_port *port;/* 非网桥数据, 交给后面的网络层来处理 */if (skb->pkt_type == PACKET_LOOPBACK ||(port = rcu_dereference(skb->dev->br_port)) == NULL) return skb;if (*pt_prev) {*ret = deliver_skb(skb, *pt_prev, orig_dev);*pt_prev = NULL;}/* 网桥处理 */return br_handle_frame_hook(port, skb);}static int __init br_init(void){.../* 网桥HOOK点注册 */err = br_netfilter_init();if (err)goto err_out1;.../* 网桥处理接口 */br_handle_frame_hook = br_handle_frame;...}int __init br_netfilter_init(void){int ret;ret = nf_register_hooks(br_nf_ops, ARRAY_SIZE(br_nf_ops)); ...return 0;}static struct nf_hook_ops br_nf_ops[] __read_mostly = { { .hook = br_nf_pre_routing,.owner = THIS_MODULE,.pf = PF_BRIDGE,.hooknum = NF_BR_PRE_ROUTING,.priority = NF_BR_PRI_BRNF, },{ .hook = br_nf_local_in,.pf = PF_BRIDGE,.hooknum = NF_BR_LOCAL_IN,.priority = NF_BR_PRI_BRNF, }, { .hook = br_nf_forward_ip,.owner = THIS_MODULE,.pf = PF_BRIDGE,.hooknum = NF_BR_FORWARD,.priority = NF_BR_PRI_BRNF - 1, }, { .hook = br_nf_forward_arp,.owner = THIS_MODULE,.pf = PF_BRIDGE,.hooknum = NF_BR_FORWARD,.priority = NF_BR_PRI_BRNF, }, { .hook = br_nf_local_out,.owner = THIS_MODULE,.pf = PF_BRIDGE,.hooknum = NF_BR_LOCAL_OUT,.priority = NF_BR_PRI_FIRST, }, { .hook = br_nf_post_routing,.owner = THIS_MODULE,.pf = PF_BRIDGE,.hooknum = NF_BR_POST_ROUTING, .priority = NF_BR_PRI_LAST, }, { .hook = ip_sabotage_in,.owner = THIS_MODULE,.pf = PF_INET,.hooknum = NF_INET_PRE_ROUTING, .priority = NF_IP_PRI_FIRST, }, { .hook = ip_sabotage_in,.pf = PF_INET6,.hooknum = NF_INET_PRE_ROUTING,.priority = NF_IP6_PRI_FIRST, },};2) 网桥处理流程网桥有五种状态:#define BR_STATE_DISABLED 0 禁用状态,不参与生成树,不转发任何数据帧#define BR_STATE_LISTENING 1 监听状态,能够决定根,可以选择根端口、指定端口和非指定端口O在监昕状态的过程中,端口不能学习任何接收帧的单播地址#define BR_STATE_LEARNING 2 学习状态,端口能学习流入帧的MAC地址,不能转发帧#define BR_STATE_FORWARDING 3 转发状态,接口能够转发帧。

linux网桥的配置方法

大家好,请问linux怎么搭建网桥,麻烦给个操作步骤,多谢了我有台linux主机,上面有2块网卡,两块网卡一个是192,一个是10(这两个地址也许要搭建网桥的话,就没什么用处了,这里只是说明)我想把两块网卡搭建一个网桥,请问应该如何做。

搭建完网桥后,br0的地址是172brctl两种网桥的配置:1. RHEL5 下配置透明网桥硬件:双网卡。

如网卡不支持端口自动翻转MDIX,需要交叉网线。

从安装盘安装bridge-utils-1.1-2.i386.rpm,只需安装这一个。

运行如下命令:# ifconfig eth0 0.0.0.0# ifconfig eth1 0.0.0.0# brctl addbr bri0# brctl addif bri0 eth0# brctl addif bri0 eth1# echo 1 > /proc/sys/net/ipv4/ip_forward最后一句也可以:vi /etc/sysctl.confnet.ipv4.ip_forward=1#sysctl –p启动网桥:# ifconfig bri0 up至此,网桥实现连通。

给网桥指定ip地址:ifconfig bri0 10.10.8.85 broadcast 10.10.255.255或者:dhclient bri0以上命令写入脚本,开机时运行。

2. RHEL5 下配置ARP 代理网桥1. 双网卡2. 停用网卡。

两块网卡设成一样的IP 配置(地址/掩码/网关等)3. 运行下面的脚本。

配置脚本:#!/bin/bashmodprobe ip_conntrackmodprobe ip_tablesecho 1 > /proc/sys/net/ipv4/conf/eth0/proxy_arpecho 1 > /proc/sys/net/ipv4/conf/eth1/proxy_arpip route del 10.10.8.0/24 dev eth0ip route del 10.10.8.0/24 dev eth1ip route add 10.10.8.252 dev eth0ip route add 10.10.8.0/24 dev eth1echo 1 > /proc/sys/net/ipv4/ip_forward4. 启动网卡。

brctl_配置网桥

brctl 配置网桥先装好网卡,连上网线,这是废话,不用说了。

然后开始!设置linux让网桥运行配置网桥我们需要让linux知道网桥,首先告诉它,我们想要一个虚拟的以太网桥接口:(这将在主机bridge上执行,不清楚的看看测试场景)root@bridge:~> brctl addbr br0其次,我们不需要STP(生成树协议)等。

因为我们只有一个路由器,是绝对不可能形成一个环的。

我们可以关闭这个功能。

(这样也可以减少网络环境的数据包污染):root@bridge:~> brctl stp br0 off经过这些准备工作后,我们终于可以做一些立竿见影的事了。

我们添加两个(或更多)以太网物理接口,意思是:我们将他们附加到刚生成的逻辑(虚拟)网桥接口br0上。

root@bridge:~> brctl addif br0 eth0root@bridge:~> brctl addif br0 eth1现在,原来我们的两个以太网物理接口变成了网桥上的两个逻辑端口。

那两个物理接口过去存在,未来也不会消失。

要不信的话,去看看好了。

.现在他们成了逻辑网桥设备的一部分了,所以不再需要IP地址。

下面我们将这些IP地址释放掉root@bridge:~> ifconfig eth0 downroot@bridge:~> ifconfig eth1 downroot@bridge:~> ifconfig eth0 0.0.0.0 uproot@bridge:~> ifconfig eth1 0.0.0.0 up好了!我们现在有了一个任何IP地址都没有的box w/o了。

好了,这下如果你想通过TP 配置你的防火墙或路由器的话,你就只能通过本地的控制端口了。

你不会告诉我你的机器上连串行端口都没有吧?注:上面红色部分其实是可选的,在试验中,我发现,就算不把原有的网卡地址释放掉,网桥也能工作!但是,为了更规范,或者说为了避免有什幺莫名其妙的问题,最好还是按要求做,执行这四步吧!最后,启用网桥root@bridge:~> ifconfig br0 up可选:我们给这个新的桥接口分配一个IP地址root@bridge:~> ifconfig br0 10.0.3.129或者把最后这两步合成一步:root@bridge:~> ifconfig br0 10.0.3.129 up就是多一个up!这下我们做完了。

Linux虚拟网络——namespace、vethpair、bridge说明和命令实操

Linux虚拟网络——namespace、vethpair、bridge说明和命令实操namespace前言namespace是Linux虚拟网络的一个重要概念,传统的Linux的许多资源是全局的,如果进程id资源。

而namespace的目的首先就是讲这些资源做资源隔离。

Linux可以在一个Host内创建许多namespace,于是那些原本是linux的全局资源,就变成了namespace范围内的“全局”资源,而且不同namespace的资源相互不可见,彼此透明。

Linux namespace 可以隔离的资源有:uts_ns(内存、版本等底层信息)、ipc_ns(所有与进程通信的信息)、 mnt_ns(当前装载的文件系统)、 pid_ns(有关进程id的信息)、 user_ns(资源配额的信息)、 net_ns(网络信息)。

一个设备(Linux Device)只能位于一个namespace中,不同namespace中的设备可以利用veth pair进行桥接。

命令实操Linux 操作namespace的命令是ip netns。

# ip netns help首先创建一个namespace:# ip netns list# ip netns add ns_test当创建一个namespace后,就可以将一些虚拟设备迁移到这个namespace中去了,比如上一篇中介绍的tap。

# tunctl -t tap_test# ip addr add local 10.0.0.190/24 dev tap_test# ip a show创建namespace后,将前面创建的tap_test迁移到这个namespace中。

迁移之后,在外直接 ip a s 已经看不到这个虚拟设备了# ip link set tap_test netns ns_test# ip netns exec ns_test ip a sveth pair前言veth pair 不是一个设备,而是一对设备,以连接两个虚拟以太端口。

virt-manager桥接原理

virt-manager桥接原理virt-manager是一种用于管理虚拟机的图形化工具,它是基于libvirt的开源项目。

其桥接原理在于通过网络接口连接虚拟机与宿主机,使得虚拟机可以像实际的物理机一样与网络进行通信。

桥接模式是一种网络通信模式,它将物理网络接口和虚拟网络接口进行桥接,使得虚拟机可以直接访问物理网络。

在桥接模式下,虚拟机的网络流量会经过物理网络接口,与外部网络进行通信。

而virt-manager正是通过创建和配置桥接接口来实现虚拟机与外部网络的连接。

虚拟机的桥接接口是通过Linux内核的桥接设备来实现的,一般称为“brX”,其中X为数字。

桥接设备是一种虚拟网络设备,它可以将多个网络接口连接在一起,形成一个虚拟局域网。

虚拟机的网络流量会通过桥接设备转发到物理网络中。

在virt-manager中创建虚拟机时,可以选择使用桥接模式,并指定要使用的桥接接口。

虚拟机创建完成后,系统会自动创建一个与虚拟机相关的桥接接口,并将该接口与物理网络接口进行桥接,从而实现虚拟机与外部网络的连接。

具体来说,virt-manager桥接原理的步骤如下:1.创建桥接接口:在virt-manager中创建虚拟机时,可以选择使用桥接模式,并指定桥接接口的名称。

系统会自动创建一个与虚拟机相关的桥接接口,例如“br0”。

2.配置桥接接口:创建桥接接口后,还需要对其进行配置。

配置可能包括设置桥接接口的IP地址、子网掩码、网关等网络参数,以及设置允许通过桥接接口的物理网络接口。

3.创建虚拟机:在创建虚拟机时,选择使用已创建的桥接接口。

虚拟机将被连接到桥接接口,从而与外部网络进行通信。

4.虚拟机网络设置:在虚拟机设置中,设置虚拟机的网络参数,包括IP地址、子网掩码、网关等。

虚拟机的网络流量将通过桥接接口转发到物理网络。

5.桥接接口转发:桥接接口会将虚拟机的网络流量转发到与其桥接的物理网络接口上,从而实现虚拟机与外部网络的通信。

linux vlan子接口原理

linux vlan子接口原理Linux VLAN子接口原理概述:VLAN(Virtual Local Area Network)是一种虚拟局域网技术,可以将一个物理局域网划分成多个逻辑上独立的虚拟局域网。

Linux 操作系统提供了对VLAN的支持,可以通过创建VLAN子接口来实现对虚拟局域网的划分和管理。

本文将介绍Linux VLAN子接口的原理和工作方式。

VLAN的基本概念:VLAN是一种将多个LAN划分为逻辑上独立的虚拟局域网的技术。

它通过在数据帧的头部添加一个特殊的标记(VLAN标签)来标识不同的虚拟局域网。

这样可以在同一物理网络中实现不同虚拟局域网之间的隔离和通信。

VLAN标签的格式:VLAN标签是一个4字节的字段,包含了VLAN的ID(VLAN ID)和优先级(Priority)。

VLAN ID是12位的字段,用于标识不同的虚拟局域网,支持的VLAN ID范围是1-4094。

优先级是3位的字段,用于标识数据帧的优先级。

Linux的VLAN支持:Linux操作系统提供了对VLAN的原生支持,可以通过内核模块8021q来实现VLAN的功能。

在大多数Linux发行版中,该模块默认已经加载。

VLAN子接口的创建:在Linux中,可以通过创建VLAN子接口来实现对虚拟局域网的划分。

VLAN子接口是物理接口的一个逻辑副本,它与物理接口使用相同的驱动程序和硬件资源,但有不同的VLAN ID。

创建VLAN子接口的步骤如下:1. 确认系统中已经加载了8021q内核模块,可以使用命令"lsmod | grep 8021q"来查看。

2. 使用命令"ip link add link eth0 name eth0.10 type vlan id 10"来创建VLAN ID为10的VLAN子接口。

其中,eth0是物理接口的名称,eth0.10是VLAN子接口的名称,10是VLAN ID。

openmptcprouter 原理

openmptcprouter 原理介绍openmptcprouter是一种基于Linux的软件路由器,采用多路径传输控制(MPTCP)协议。

它的主要目的是将多个网络连接整合成一个高带宽、高可靠性的连接,从而提供更好的网络性能和可用性。

本文将深入探讨openmptcprouter的原理及其工作方式。

MPTCP 简介什么是MPTCP多路径传输控制(MPTCP)是一种扩展TCP协议的技术,允许在多个网络路径上同时传输数据。

传统的TCP协议只能在单条路径上传输数据,而MPTCP可以同时利用多个路径传输数据,从而提供更高的带宽和更好的网络性能。

MPTCP的优势1.增加带宽:利用多个网络路径传输数据可以增加总带宽,提供更快的数据传输速度。

2.提高可靠性:当某个路径发生故障时,MPTCP可以自动切换到其他可用路径,保持连接的可靠性。

3.负载均衡:MPTCP可以根据路径的负载情况动态调整数据的传输路径,实现负载均衡,提高网络的整体性能。

openmptcprouter 的原理openmptcprouter是一个基于Linux的软件路由器,它通过在Linux内核上运行的MPTCP模块实现多路径传输控制。

下面将详细介绍openmptcprouter的原理和工作方式。

客户端与服务器openmptcprouter由两部分组成:客户端和服务器。

客户端是安装在用户设备上的软件,用于管理和控制多个网络连接。

服务器是一台位于公共互联网上的计算机,用于转发和整合多个网络连接。

客户端工作原理1.客户端首先与服务器建立连接,并向服务器发送自己的网络信息,包括IP地址、网络接口等。

2.服务器收到客户端的信息后,根据客户端的网络情况为其分配一个或多个网络路径。

服务器会根据网络负载情况、带宽等因素选择最佳的路径。

3.客户端根据服务器分配的路径信息,通过Linux内核的MPTCP模块建立与服务器的多个网络连接。

4.客户端在发送数据时,MPTCP模块会将数据分割成多个小块,并通过不同的网络连接同时发送。

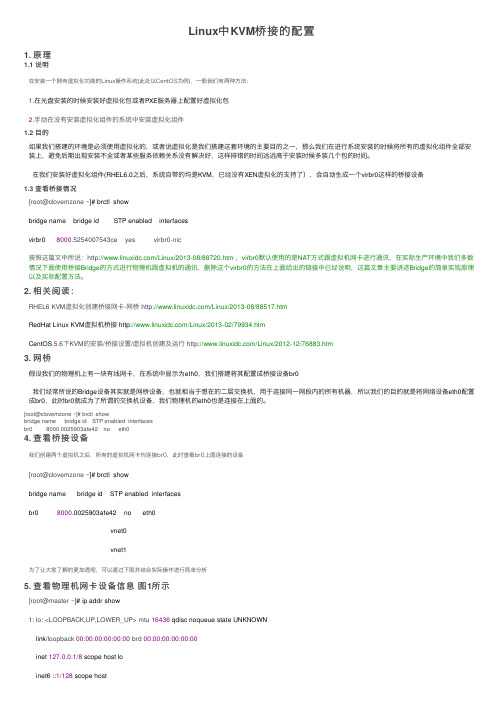

Linux中KVM桥接的配置

Linux中KVM桥接的配置1. 原理1.1 说明在安装⼀个拥有虚拟化功能的Linux操作系统(此处以CentOS为例),⼀般我们有两种⽅法:1.在光盘安装的时候安装好虚拟化包或者PXE服务器上配置好虚拟化包2.⼿动在没有安装虚拟化组件的系统中安装虚拟化组件1.2 ⽬的如果我们搭建的环境是必须使⽤虚拟化的,或者说虚拟化是我们搭建这套环境的主要⽬的之⼀,那么我们在进⾏系统安装的时候将所有的虚拟化组件全部安装上,避免后期出现安装不全或者某些服务依赖关系没有解决好,这样排错的时间远远⾼于安装时候多装⼏个包的时间。

在我们安装好虚拟化组件(RHEL6.0之后,系统⾃带的均是KVM,已经没有XEN虚拟化的⽀持了),会⾃动⽣成⼀个virbr0这样的桥接设备1.3 查看桥接情况[root@clovemzone ~]# brctl showbridge name bridge id STP enabled interfacesvirbr0 8000.5254007543ce yes virbr0-nic按照这篇⽂中所说:/Linux/2013-08/88720.htm ,virbr0默认使⽤的是NAT⽅式跟虚拟机⽹卡进⾏通讯,在实际⽣产环境中我们多数情况下⾯使⽤桥接Bridge的⽅式进⾏物理机跟虚拟机的通讯,删除这个virbr0的⽅法在上⾯给出的链接中已经说明,这篇⽂章主要讲述Bridge的简单实现原理以及实际配置⽅法。

2. 相关阅读:RHEL6 KVM虚拟化创建桥接⽹卡-⽹桥 /Linux/2013-08/88517.htmRedHat Linux KVM虚拟机桥接 /Linux/2013-02/79934.htmCentOS 5.6下KVM的安装/桥接设置/虚拟机创建及运⾏ /Linux/2012-12/76883.htm3. ⽹桥假设我们的物理机上有⼀块有线⽹卡,在系统中显⽰为eth0,我们搭建将其配置成桥接设备br0我们经常所说的Bridge设备其实就是⽹桥设备,也就相当于想在的⼆层交换机,⽤于连接同⼀⽹段内的所有机器,所以我们的⽬的就是将⽹络设备eth0配置成br0,此时br0就成为了所谓的交换机设备,我们物理机的eth0也是连接在上⾯的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Linux桥接功能的分析第一章网桥的基本概念1.1 网桥的作用网桥工作在ISO层次结构中的二层,通过mac地址来区分,实现几个网络或主机之间的互联。

1.2 网桥的工作原理网桥的工作原理其实很简单,就是:某个主机的消息从哪个端口进来,那么这个主机必定位与这个端口这一侧,从这个端口一定能找到这个主机,给这个主机的消息也就应该从这个端口转发。

比如,一个网桥连接主机A和主机B。

当主机A连接到网桥时,会告诉网桥,它在端口A 。

网桥会维持一个映射表,让端口A与主机A的mac地址对应。

当有其他主机试图通过网桥转发目的mac地址为主机A的mac地址的消息时,网桥会通过查表来指导应该由端口A转发。

同理,当网桥连接两个或两个以上主机或主机构成的网络时,也按照这个原则,维持一个记录端口和mac地址的映射表,需要转发消息的时候通过查找这个表来找到应该去的地址。

当然,如果收到的消息是发给网桥本身的,就要交给上层协议来处理。

这就是网桥的工作原理。

第二章数据结构2.1 net_bridge这个结构体描述一个网桥。

dev是这个桥对应的设备。

port_list是net_bridge_port的链表头。

hash[BR_HASH_SIZE]是net_bridge_fdb_entry 的散列表,也是网桥MAC地址和端口的映射表CAM。

struct net_bridge {spinlock_t lock; struct list_head port_list; struct net_device *dev; struct net_device_stats statistics; spinlock_t hash_lock; struct hlist_head struct list_head unsigned long unsigned longhash[BR_HASH_SIZE]; age_list; feature_mask; flags;bridge_id designated_root; bridge_id bridge_id;u32 root_path_cost; unsigned long max_age; unsigned long unsi gned long unsigned long unsigned long unsigned longhello_time; forward_delay; bridge_max_age; ageing_time;bridge_hello_time;unsigned long bridge_forward_delay;u8 group_addr[ETH_ALEN]; u16 root_port; enum {BR_NO_STP, BR_KERNEL_STP, BR_USER_STP,/* no spanning tree */ /* old STP in kernel */ /* new RSTP in userspace */} stp_enabled;unsigned char unsigned char struct timer_list struct timer_list struct timer_listtopology_change; topology_change_detected; hello_timer;tcn_timer;topology_change_timer;struct timer_listgc_timer; *ifobj;struct kobject };2.2 net_bridge_port这是网桥端口的结构体。

br指向它属于的网桥。

port_no是端口ID,唯一的标识。

struct net_bridge_port {struct net_bridge struct net_device*br; *dev;struct list_head list;u8 priority; u8 state; u16 port_no; unsigned char topology_change_ack;unsigned char config_pending; port_id port_id; port_id designated_port; bridge_id designated_root; bridge_id designated_bri dge; u32 path_cost; u32 designated_cost; struct timer_list struct timer_list struct timer_list struct kobjectforward_delay_timer; hold_timer; message_age_timer; kobj;rcu;struct rcu_head };2.3 net_bridge_fdb_entry这是散列表的中间链接结构体,net_bridge中的hash,通过这个结构链入net_bridge_port。

其中包含了端口的一些信息,最重要的是local,从它可以知道这个端口信息是本地的,还是其他相连主机的。

struct net_bridge_fdb_entry {struct hlist_node hlist; struct net_bridge_port *dst;};struct rcu_head rcu;atomic_t use_count; unsigned long ageing_timer; mac_addr addr; unsigned char is_local; unsigned charis_static;第三章桥的创建3.1 br_add_bridge [net\bridge\br_if.c]当使用SIOCBRADDBR调用ioctl时,会通过br_add_bridge函数创建新的网桥。

在这个函数中配置一个新网桥设备的初始参数。

这个函数在br_if.c中。

在这里申请一个桥设备。

dev = new_bridge_dev(net, name);然后给设备命名,并注册设备和设备文件。

ret = dev_alloc_name(dev, dev->name); ret = register_netdevice(dev); ret = br_sysfs_addbr(dev);3.2 br_add_if() [net\bridge\br_if.c]当使用SIOCBRADDIF调用ioctl时,会通过调用br_add_if向网卡加入新的端口。

创建新的net_bridge_port p,会从br->port_list中分配一个未用的port_no,p->br会指向br,p->state设为BR_STATE_DISABLED。

这里的p 实际代表的就是网卡设备。

p = new_nbp(br, dev);将新创建的p加入CAM表中,CAM表是用来记录mac地址与物理端口的对应关系;而刚刚创建了p,因此也要加入CAM表中,并且该表项应是local 的(具体关系如图3-1所示),可以看到,CAM表在实现中作为net_bridge 的hash表,以addr作为hash值,链入net_bridge_fdb_entry,再由它的dst 指向net_bridge_port。

err = br_fdb_insert(br, p, dev->dev_addr);br_fdb_insert函数中,如果这个物理地址已经存在记录,则删除原有的记录,保存新的记录。

但是如果是本地地址,直接返回。

fdb = fdb_find(head, addr); if (fdb) {设备的br_port指向p。

这里要明白的是,net_bridge可以看作全局量,是网桥,而net_bridge_port则是与网卡相对应的端口,因此每个设备dev有个指针br_port指向该端口。

rcu_assign_pointer(dev->br_port, p);将新创建的net_bridge_port加入br的链表port_list中,在创建新的net_bridge_port时,会分配一个未用的port_no,而这个port_no就是根据if (fdb->is_local)return 0;printk(KERN_WARNING "%s adding interface with same address " fdb_delete(br, fdb);}"as a received packet\n", source->dev->name);if (!fdb_create(br, head, source, addr, 1, 1))return -ENOMEM;return 0;br->port_list中的已经添加的net_bridge_port来找到未用的port_no的。

具体过程如图3-2所示。

list_add_rcu(&p->list, &br->port_list);重新计算网桥的ID,这里根据br->port_list链表中的net_bridge_port 的最小的addr来作为网桥的ID。

br_stp_recalculate_bridge_id(br);到这里,新网桥的创建就完成了。

第四章Linux桥功能4.1 数据包流程图4-1 Linux桥的数据包函数调用流程如图4-1所示,netif_receive_skb是数据包的基本接收函数,由网卡驱动调用,把网卡接收到并初步处理的数据包传递给链路层。

这个函数会首先根据设备类型做一个类型判断,这里的类型主要针对有没有master来区别。

如果找到匹配的,就交给对应的协议处理。

handle_bridge是桥功能开始的操作函数,在这里如果发现是回环类型的数据包,或者是br_port为空的数据包,则会直接返回到netif_receive_skb函数,进而进入以太网帧的协议类型的匹配来调用deliver_skb提交给上层操作,否则进入桥的下一步操作。

如果设备不作为网桥,也会调用deliver_skb,提交给上层。

deliver_skb通过不同的协议类型提交给不同的接收函数。

br_handle_frame函数,会先进入一个判断,判断数据包的目的地址是否为多播组地址,是则进入BR_LOCAL_IN,进而进入一些操作,更新桥接转发表CAM。

如果判断为否,则进入桥接的route阶段,进入BR_PRE_ROUTING这个HOOK点,然后调用br_handle_frame_finish。