计算机其它_Census-Income (KDD) Data Set(人口收入(知识发现)数据集)

数据分析术语解释

数据分析术语解释数据分析是一门在当今信息时代中至关重要的技能。

它的应用范围涵盖了各个领域,包括商业、科学、医疗和社会科学等。

在进行数据分析时,我们经常会遇到各种与数据相关的术语。

本文将对一些常见的数据分析术语进行解释,以帮助读者更好地理解和应用这些概念。

1. 数据集(Data set):数据集是指一组相关的数据的集合。

数据集可以以表格、文件或数据库的形式存在。

在数据分析过程中,我们通常会使用数据集作为分析的基础。

2. 变量(Variable):变量是数据集中的一个特征或属性。

它可以是数值型的,如年龄或销售额,也可以是分类型的,如性别或产品类型。

变量在数据分析中被用来描述和分析数据的不同方面。

3. 样本(Sample):样本是从总体中抽取的一部分数据。

通过对样本进行分析,我们可以推断出关于整个总体的特征和规律。

样本的大小通常取决于研究的目的和可行性。

4. 总体(Population):总体是指研究对象的全体。

在数据分析中,我们通常无法对整个总体进行研究,而是通过对样本数据的分析来对总体进行推断。

5. 描述统计(Descriptive Statistics):描述统计是对数据进行总结和描述的方法。

它包括计算平均值、中位数、标准差等指标,以便了解数据的集中趋势、离散程度和分布形态。

6. 探索性数据分析(Exploratory Data Analysis,EDA):探索性数据分析是一种用于探索数据和发现数据特征的方法。

它包括可视化、数据透视和统计方法等,旨在揭示数据中的规律和趋势,为后续的分析提供基础。

7. 假设检验(Hypothesis Testing):假设检验是通过对数据进行统计学分析来检验研究假设的方法。

在进行假设检验时,我们会先提出一个关于总体特征的假设,然后通过样本数据来验证这个假设是否成立。

8. 回归分析(Regression Analysis):回归分析是一种用来研究变量之间关系的方法。

quinn指数 -回复

quinn指数-回复什么是Quinn指数?Quinn指数是一种衡量国家或地区经济和发展水平的综合指标。

它是由经济学家詹姆斯·福伊·奎恩(James W. Quinn)提出的,并于20世纪60年代末至70年代初开始在经济学领域中得到广泛应用。

该指数通过综合考虑国家的国内生产总值(GDP)、贸易和人口增长等因素,评估和比较各个国家的整体经济活力和发展水平。

Quinn指数的计算方法Quinn指数的计算方法相对较为复杂,但总体来说,它主要通过三个方面的数据进行综合计算。

首先,是国内生产总值(GDP)。

GDP是一个国家或地区一年内所生产的全部最终产品和服务的市场价值的总和。

其次,是贸易数据。

贸易数据包括进出口额,通过考察国家的贸易状况,可以了解到该国的出口竞争力以及与其他国家之间的经济联系。

最后,是人口数据。

人口数据反映了国家或地区的人口规模以及劳动力资源的供给情况。

综合考虑了这三个方面的数据后,Quinn指数的计算方法可以大致分为以下几个步骤:第一步,将每个国家的GDP除以其人口数,得到人均GDP。

人均GDP可以反映一个国家的平均经济水平。

第二步,将每个国家的进出口总额除以其人口数,得到人均贸易数据。

人均贸易数据可以从国际贸易的角度了解到一个国家与其他国家之间的经济联系和交流情况。

第三步,根据第二步中的人均贸易数据,按照一定的比例加权到第一步计算的人均GDP上,得到加权后的人均GDP。

第四步,将加权后的人均GDP与其他国家进行比较和排序,得到Quinn 指数。

Quinn指数越高,表示该国经济发展水平相对较高。

Quinn指数的意义和应用Quinn指数作为一种衡量国家或地区经济发展水平的指标,在经济学研究和实际应用中有着广泛的意义和应用价值。

首先,它可以帮助人们了解各个国家的经济活力和发展差距。

通过比较Quinn指数,我们可以看到不同国家经济的强弱势,从而为国家和地区的经济决策提供参考依据。

计算机其它_Census-Income (KDD) Data Set(人口收入(知识发现)数据集)

Census-Income (KDD) Data Set(人口收入(知识发现)数据集)数据摘要:This data set contains weighted census data extracted from the 1994 and 1995 current population surveys conducted by the U.S. Census Bureau.中文关键词:多变量,分类,UCI,人口收入,知识发现,英文关键词:Multivariate,Classification,UCI,Census-Income,KDD,数据格式:TEXT数据用途:This data set is used for classification.数据详细介绍:Census-Income (KDD) Data SetAbstract: This data set contains weighted census data extracted from the 1994 and 1995Source:Original Owner:U.S. Census Bureau/United States Department of CommerceDonor:Terran Lane and Ronny KohaviData Mining and VisualizationSilicon Graphics.terran '@' , ronnyk '@' Data Set Information:This data set contains weighted census data extracted from the 1994 and 1995 Current Population Surveys conducted by the U.S. Census Bureau. The data contains 41 demographic and employment related variables.The instance weight indicates the number of people in the population that each record represents due to stratified sampling. To do real analysis and derive conclusions, this field must be used. This attribute should *not* be used in the classifiers.One instance per line with comma delimited fields. There are 199523 instances in the data file and 99762 in the test file.The data was split into train/test in approximately 2/3, 1/3 proportions using MineSet's MIndUtil mineset-to-mlc.Attribute Information:More information detailing the meaning of the attributes can be found in the Census Bureau's documentation To make use of the data descriptions at this site, the following mappings to the Census Bureau's internal database column names will be needed:age AAGEclass of worker ACLSWKRindustry code ADTINDoccupation code ADTOCCadjusted gross income AGIeducation AHGAwage per hour AHRSPAYenrolled in edu inst last wk AHSCOLmarital status AMARITLmajor industry code AMJINDmajor occupation code AMJOCCmace ARACEhispanic Origin AREORGNsex ASEXmember of a labor union AUNMEMreason for unemployment AUNTYPEfull or part time employment stat AWKSTATcapital gains CAPGAINcapital losses CAPLOSSdivdends from stocks DIVVALfederal income tax liability FEDTAXtax filer status FILESTATregion of previous residence GRINREGstate of previous residence GRINSTdetailed household and family stat HHDFMXdetailed household summary in household HHDRELinstance weight MARSUPWTmigration code-change in msa MIGMTR1migration code-change in reg MIGMTR3migration code-move within reg MIGMTR4live in this house 1 year ago MIGSAMEmigration prev res in sunbelt MIGSUNnum persons worked for employer NOEMPfamily members under 18 PARENTtotal person earnings PEARNVALcountry of birth father PEFNTVTYcountry of birth mother PEMNTVTYcountry of birth self PENATVTYcitizenship PRCITSHPtotal person income PTOTVALown business or self employed SEOTRtaxable income amount TAXINCfill inc questionnaire for veteran's admin VETQVAveterans benefits VETYNweeks worked in year WKSWORKNote that Incomes have been binned at the $50K level to present a binary classification problem, much like the original UCI/ADULT database. The goal field of this data, however, was drawn from the "total person income" field rather than the "adjusted gross income" and may, therefore, behave differently than the orginal ADULT goal field.数据预览:点此下载完整数据集。

如何利用数据透析表进行人口数据分析

如何利用数据透析表进行人口数据分析数据透析表(Data Analytics Table)是一种常用的工具,可以帮助研究者对人口数据进行深入分析。

通过运用透析表的功能,我们可以获得对人口特征、趋势和关联性的了解,帮助政府、企业以及其他组织做出更准确的决策。

首先,我们需要清楚了解一下数据透析表的基本构成。

透析表通常由行、列和值组成。

行代表数据的样本,列用来描述行数据的属性,而值则是数据的度量指标。

在人口数据分析中,透析表能够将人口属性列与人口统计量(如人口数量、年龄、性别等)进行关联,揭示人口数据的规律性。

在利用数据透析表进行人口数据分析时,我们可以使用以下几个关键步骤:第一步,选择适当的人口数据。

在分析数据之前,我们需要明确我们想要了解的具体人口特征和问题。

例如,我们可能对某个地区的人口结构、教育程度、就业率等感兴趣。

第二步,收集相关数据并整理为数据透析表的结构。

收集人口数据可以通过调查、统计报告、公开数据集等途径。

确保数据的准确性和完整性,以便于后续分析。

第三步,导入数据透析表并进行数据清理。

数据清理是一个重要的步骤,可以排除数据中的噪声和错误,确保分析的准确性和可靠性。

清理的过程包括删除重复数据、处理缺失值、校正数据格式等。

第四步,确定透析表的行、列和值。

在人口数据分析中,行可以代表个体或者地理区域,列可以代表人口属性,值可以代表人口统计量。

第五步,进行数据透析表的操作和分析。

透析表的操作包括数据筛选、分组、汇总、排序等。

通过这些操作,我们可以快速准确地获得我们所需要的信息。

例如,我们可以根据性别筛选数据,了解男女比例;或者根据年龄分组,比较不同年龄段人口的变化情况。

第六步,进行数据可视化和进一步分析。

通过数据透析表的操作,我们可以生成图表、图形和摘要,以便更好地理解人口数据的分布、趋势和关联。

常见的数据可视化方法包括柱状图、折线图、饼图、散点图等。

这些图表可以帮助我们更直观地观察和比较数据。

uci数据集大致情况翻译

来源:/ml/datasets.html?format=&task=&att=&area=&numAtt=&n umIns=&type=&sort=nameUp&view=list206 Data Sets Table View List View1. Abalone: Predict the age of abalone from physical measurements鲍鱼DataSet:根据物理度量,预测鲍鱼的年龄。

2. Abscisic Acid Signaling Network: The objective is to determine the set of boolean rules that describe the interactions of the nodes within this plant signaling network. The dataset includes 300 separate boolean pseudodynamic simulations using an asynchronous update scheme.目标是测定布尔值的度量集合,以描述植物的信号网路节点。

该数据集包括了300个独立的布尔值形式的虚拟动态模拟值,使用了异步更新的架构。

3. Acute Inflammations: The data was created by a medical expert as a data set to test the expert system, which will perform the presumptive diagnosis of two diseases of the urinary system.急性炎症DataSet:数据来源于一位医学专家的数据集,用以检测专家系统,可以推断出泌尿系统的两种疾病的诊断结果。

出院当天结算的病人数统计语句

出院当天结算的病人数统计语句

当需要统计出院当天结算的病人数时,可以使用以下 SQL 语句:

```sql

SELECT COUNT(*)

FROM discharge_records

WHERE discharge_date = CURDATE() AND settlement_status = 'settled';

```

上述语句使用了 COUNT 函数来计算满足条件的行数,即出院当天结算的病人数。

具体解释如下:

- `discharge_records` 是包含出院记录的表名。

- `discharge_date` 是出院记录中的出院日期列名。

- `CURDATE()` 是一个函数,用于获取当前日期。

- `settlement_status` 是出院记录中的结算状态列名。

- `'settled'` 是结算状态的取值,表示已结算。

该语句通过将出院日期与当前日期进行比较,并同时检查结算状态是否为'已结算',筛选出出院当天结算的病人记录,并计算记录数,即得到出院当天结算的病人数。

请注意,上述语句是基于 MySQL 数据库的示例,其他数据库可能会有不同的语法和函数,请根据你使用的具体数据库进行相应的调整。

另外,还可以根据实际需求对语句进行优化和扩展,例如加入其他筛选条件或分组统计等。

currentdb.openrecordset 参数 -回复

currentdb.openrecordset 参数-回复[currentdb.openrecordset 参数],是一个用于访问数据库中记录的函数。

在本文中,我们将深入探讨这个函数的参数,以及如何使用它来操作数据库。

首先,让我们了解一下什么是[currentdb.openrecordset] 函数。

这个函数是Visual Basic for Applications (VBA) 中的一个方法,用于从当前打开的数据库(当前数据库)中返回一个Recordset 对象。

该对象用于访问和操作数据库中的数据记录。

这个函数是在Microsoft Access 中常用的一个功能,可以通过VBA 代码来调用。

[currentdb.openrecordset] 函数的语法如下:vbaSet recordsetvar = currentdb.openrecordset(name[, type][, options][, lockedits])现在,让我们一步一步地解释这些参数。

第一个参数(name):name 参数指定要打开的表、查询或SQL 语句的名称。

这可以是字符串或包含表名或查询名的变量。

例如,可以使用以下代码打开名为"Employees" 的表:vbaSet rs = currentdb.openrecordset("Employees")或者,使用一个变量来代替表名:vbatableName = "Employees"Set rs = currentdb.openrecordset(tableName)正如上述示例所示,name 参数可以是字符串字面量,也可以是变量。

第二个参数(type):type 参数指定打开记录集的类型。

它是一个可选参数,默认值为`dbOpenTable`。

以下是一些常用的值:- `dbOpenTable`:打开一个表;- `dbOpenDynaset`:打开一个动态记录集,可以对其进行编辑、添加和删除操作;- `dbOpenSnapshot`:打开一个快照记录集,用于只读访问数据库中的数据;- `dbOpenForwardOnly`:打开一个只能向前浏览的记录集,不允许对其进行编辑。

kdd2008christen-febrl-demo

Febrl–An Open Source Data Cleaning,Deduplication and Record Linkage System with a Graphical User InterfacePeter ChristenDepartment of Computer ScienceThe Australian National UniversityCanberra ACT0200,Australiapeter.christen@.auABSTRACTMatching records that refer to the same entity across data-bases is becoming an increasingly important part of many data mining projects,as often data from multiple sources needs to be matched in order to enrich data or improve its quality.Significant advances in record linkage techniques have been made in recent years.However,many new tech-niques are either implemented in research proof-of-concept systems only,or they are hidden within expensive‘black box’commercial software.This makes it difficult for both researchers and practitioners to experiment with new record linkage techniques,and to compare existing techniques with new ones.The Febrl(Freely Extensible Biomedical Record Linkage)system aims tofill this gap.It contains many re-cently developed techniques for data cleaning,deduplication and record linkage,and encapsulates them into a graphi-cal user interface(GUI).Febrl thus allows even inexperi-enced users to learn and experiment with both traditional and new record linkage techniques.Because Febrl is written in Python and its source code is available,it is fairly easy to integrate new record linkage techniques into it.Therefore, Febrl can be seen as a tool that allows researchers to com-pare various existing record linkage techniques with their own ones,enabling the record linkage research community to conduct their work more efficiently.Additionally,Febrl is suitable as a training tool for new record linkage users,and it can also be used for practical linkage projects with data sets that contain up to several hundred thousand records. Categories and Subject Descriptors:H.2.8[Database applications]:Data miningGeneral Terms:Algorithms,Experimentation Keywords:Data matching,data linkage,deduplication, data cleaning,open source software,Python1.PROJECT BACKGROUNDFebrl has been developed since2002as part of a collab-orative research project conduced between the Australian National University in Canberra and the New South Wales Department of Health in Sydney,Australia.The objective of this project is to develop new techniques for improved data cleaning and standardisation,deduplication and record linkage within the domain of health databases.Copyright is held by the author/owner(s).KDD’08,August24–27,2008,Las Vegas,Nevada,USA.ACM978-1-60558-193-4/08/08.The Febrl system is written in the programming language Python1,which is an ideal platform for rapid prototype de-velopment,as it provides data structures such as sets,lists and dictionaries(associative arrays)that allow efficient han-dling of very large data sets.It also includes many modules offering a large variety of functionalities.It has excellent built-in string handling capabilities,and the large number of extension modules facilitate,for example,database ac-cess and GUI development.The Febrl GUI is based on the PyGTK2library and the Glade3toolkit.Febrl is published under an open source software licence. Due to the availability of its source code,Febrl is suitable for the rapid development,implementation,and testing of novel record linkage algorithms and techniques,as well as for both new and experienced users to learn about,and experiment with,various record linkage techniques.Since2002Febrl has been hosted on the repository at: https:///projects/febrl/The total number of downloads of Febrlfiles on14th June 2008has reached9,840.To the best of the author’s knowl-edge,Febrl is the only open source record linkage system with a GUI that allows data cleaning and standardisation, deduplication and record linkage.The current Febrl-0.4ver-sion includes the source code,several example data sets(as available from the SecondString toolkit4),and a data set generator.The documentation contains several papers that describe the techniques implemented in Febrl,and a manual that includes several step-by-step tutorials.Compared to earlier versions,Febrl-0.4not only contains a GUI,but also a variety of new techniques,as described below.Some of the screenshots following show an example linkage of the‘Census’data set from SecondString.2.STRUCTURE AND FUNCTIONALITY The Febrl GUI has been developed with the objective to make Febrl more accessible to non-technical record linkage users[8].The structure of the Febrl GUI follows the Rattle open source data mining tool[17].The basic idea is to have a window that contains one tab(similar to tabs in modern Web browsers)per major step of the record linkage process. The start-up Febrl GUI is shown in Figure1.First,only two tabs are visibly,additional tabs will appear once the input data has been initialised.Figure1:Initial Febrl user interface after start-up. On each tab,the user can select methods and their pa-rameters,and then confirm these settings by clicking the ‘Execute’button.Corresponding Febrl Python code will be generated and shown in the‘Log’tab.Once all necessary steps are set up,the generated Python code can be saved and run outside of the GUI,or a project can be started and its results can be evaluated from within the Febrl GUI.All major tabs will be described in more detail and illustrated with corresponding screenshots in the following sections.2.1Input Data InitialisationA userfirst has to select the type of project to be con-ducted:(a)cleaning and standardisation of a data set,(b) deduplication of a data set,or(c)linkage of two data sets. The‘Data’tab of the Febrl GUI will change accordingly and either show one or two input data set selection areas. Currently,several text basedfile formats are supported,in-cluding the commonly used CSV(comma separated values) format.Once afile has been selected,itsfirst few lines will be shown,as illustrated in Figure2.This enables the user to verify the chosen settings,or adjust them if required.When satisfied,a click on the‘Execute’button will confirm the settings,and the tabs for data exploration and,depending upon the project type selected,standardisation,or indexing, comparison and classification will become visible.2.2Data ExplorationThe‘Explore’tab enables the user to analyse the input data set(s)to get a better understanding of its/their content and quality.After a click on the‘Execute’button,the data set(s)will be read and allfields(or attributes,columns)will be analysed.A report will be displayed that for eachfield provides information about the number of different values in it,the alphabetically smallest and largest values,the most and least frequent values,the quantiles distribution of the values,the number of records with missing values,as well as a guess of the type of thefield(if it contains only digits, only letters,or is of mixed type).A summary table of this analysis is then displayed,as shown in Figure3.2.3Data Cleaning and StandardisationData cleaning and standardisation using the Febrl GUI is currently done separately from a linkage or deduplica-tion.A data set can be cleaned and standardised,andis Figure2:Febrl user interface for a linkage project af-ter the‘Census’input data sets have beeninitialised. Figure3:Data exploration tab showing summaryanalysis of recordfields(or attributes,columns). then written into a new data set,which in turn can then be deduplicated or used for a linkage.Currently,Febrl con-tains standardisers for names,addresses,dates,and tele-phone numbers.The name standardiser uses a rule-based approach for simple names(such as those made of one given-and one surname only)in combination with a probabilistic hidden Markov model(HMM)approach for more complex names[11],while address standardisation is fully based on a HMM approach[9].These HMMs currently have to be trained outside of the Febrl GUI,using separate Febrl mod-ules.Dates are standardised using a list of format stringsFigure 4:Example date and telephone number stan-dardisers (for a synthetic Febrl dataset).Figure 5:Example indexing definition using the ‘BlockingIndex’method and two index definitions.that provide the expected date formats likely to be found in the input data set.Telephone numbers are also standardised using a rule-based approach.Once initialised and confirmed with a click on ‘Execute’,on the ‘Output/Run’tab (see be-low)the file name of the standardised output file can be chosen,and a standardisation project can then be started by clicking ‘Execute’on the ‘Output/Run’tab.2.4Indexing (Blocking)DefinitionBlocking or indexing is used to reduce the number of de-tailed record pair comparisons to be done [2].On the ‘Index’tab,a user can select one of seven possible indexing meth-ods.Besides the ‘FullIndex’(which will compare all record pairs and thus has a quadratic complexity)and the stan-dard ‘BlockingIndex’approach [2]as implemented in many record linkage systems,Febrl contains five recently devel-oped indexing methods [4]:‘SortingIndex’,which is based on the sorted neighbourhood approach [15];‘QGramIndex’,which uses sub-strings of length q to allow fuzzy blocking [2];‘CanopyIndex’,which employs overlapping canopycluster-Figure 6:An example of three field comparison func-tion definitions.ing using TF-IDF or Jaccard similarity [12];‘StringMapIn-dex’,which maps the index key values into a multi-dim-ensional space and performs canopy clustering on these multi-dimensional objects [16];and ‘SuffixArrayIndex’,which gen-erates all suffixes of the index key values and inserts them into a sorted array to enable efficient access to the index key values and generation of the corresponding blocks [1].Once an index method has been chosen,the actual in-dex keys have to be selected and their various parameters have to be set.Index keys are made of one field value,or a concatenation of several field values,that are often phoneti-cally encoded to group similar sounding values into the same block.Febrl contains nine encoding methods [3],including Soundex,NYSIIS,Phonix,Phonex,and Double-Metaphone.2.5Field Comparison FunctionsThe similarity functions used to compare the field (at-tribute)values of record pairs can be selected on the ‘Com-parison’tab,as shown in Figure 6.Febrl contains 26simi-larity functions,including 20approximate string comparison functions [3],as well as functions specialised for dates,times,ages,or numerical values.All these similarity functions re-turn a numerical value between 0(total dissimilarity)and 1(exact match).It is possible to adjust these values by set-ting agreement and disagreement weights,as well as a special value that will be returned if one or both of the compared values is/are empty.The similarity weights calculated for each compared record pair will be stored in a weight vector,to be used for classifying record pairs in the next step.2.6Weight Vector ClassificationFebrl contains several record pair classifiers,both super-vised and unsupervised techniques.The traditional ‘Fel-legiSunter’classifier requires manual setting of two thresh-olds [13],while with the supervised ‘OptimalThreshold’clas-sifier it is assumed that the true match status for all com-pared record pairs is known,and thus an optimal thresh-old can be calculated based on the corresponding summed weight vectors.Another supervised classifier is ‘SuppVec-Machine’,which implements a support vector machine.Figure7:Example‘Two-Step’unsupervised weight vector classifier.Both the‘KMeans’and‘FarthestFirst’[14]classifiers are unsupervised clustering approaches,and group the weight vectors into a match and a non-match cluster.Various cen-troid initialisation and distance measures are implemented in Febrl.Finally,the‘TwoStep’classifier,shown in Figure7, is an unsupervised approach which in afirst step selects weight vectors from the compared record pairs that with high likelihood correspond to true matches and true non-matches,and in a second step uses these vectors as training examples for a binary classifier[5,7,6].2.7Output Files and Running a ProjectOn this tab(not shown due to space limitation)the user can select various settings of how the match status and the matched record pairs will be saved intofiles.With a click on ‘Execute’,the Febrl GUI will ask the user if the generated project should be saved as a Pythonfile,and if the project should be started and run within the GUI.Once started,a window will pop up showing a progress bar.2.8Evaluation and Clerical ReviewOn the‘Evaluation’tab,shown in Figure8,the results of a deduplication or linkage project are visualised as a his-togram of the summed matching weights of all compared record pairs.If the true match and non-match status of record pairs is available,the quality of the conducted link-age will be shown using the measurements of accuracy,pre-cision,recall and F-measure.Also shown are measures that allow the evaluation of the complexity of a deduplication or linkage project(i.e.the number of record pairs generated by the indexing step and their quality),these measures are the reduction ratio,pairs completeness and pairs quality[10].2.9Log TabOn this tab the Febrl Python code generated throughout a project is shown,allowing experienced users to verify the correctness of the generated code.It also enables copying of this code into a user’s own Febrl Python modules.3.ACKNOWLEDGEMENTSThis work is supported by an Australian Research Council (ARC)Linkage Grant LP0453463and partially funded by the New South Wales Department of Health,Sydney.Figure8:Evaluation tab showing the matching weight histogram and quality and complexity mea-sures for a linkage.4.REFERENCES[1] A.Aizawa and K.Oyama.A fast linkage detection scheme formulti-source information integration.In WIRI’05,pages30–39, Tokyo,2005.[2]R.Baxter,P.Christen,and T.Churches.A comparison of fastblocking methods for record linkage.In ACM SIGKDDworkshop on Data Cleaning,Record Linkage and ObjectConsolidation,pages25–27,Washington DC,2003.[3]P.Christen.A comparison of personal name matching:Techniques and practical issues.In MCD’06,held at IEEEICDM’06,Hong Kong,2006.[4]P.Christen.Towards parameter-free blocking for scalablerecord linkage.Technical Report TR-CS-07-03,The Australian National University,Canberra,2007.[5]P.Christen.A two-step classification approach to unsupervisedrecord linkage.In AusDM’07,pages111–119,Gold Coast,Australia,2007.[6]P.Christen.Automatic record linkage using seeded nearestneighbour and support vector machine classification.In ACMSIGKDD’08,Las Vegas,2008.[7]P.Christen.Automatic training example selection for scalableunsupervised record linkage.In PAKDD’08,Springer LNAI5012,pages511–518,Osaka,Japan,2008.[8]P.Christen.Febrl-A freely available record linkage systemwith a graphical user interface.In HDKM’08,CRPIT vol.80, pages17–25,Wollongong,Australia,2008.[9]P.Christen and D.Belacic.Automated probabilistic addressstandardisation and verification.In AusDM’05,Sydney,2005.[10]P.Christen and K.Goiser.Quality and complexity measures fordata linkage and deduplication.In F.Guillet and H.Hamilton, editors,Quality Measures in Data Mining,volume43ofStudies in Computational Intelligence.Springer,2007.[11]T.Churches,P.Christen,K.Lim,and J.X.Zhu.Preparationof name and address data for record linkage using hiddenMarkov models.BioMed Central Medical Informatics andDecision Making,2(9),2002.[12]W.W.Cohen and J.Richman.Learning to match and clusterlarge high-dimensional data sets for data integration.In ACM SIGKDD’02,Edmonton,2002.[13]I.P.Fellegi and A.B.Sunter.A theory for record linkage.Journal of the American Statistical Society,64(328):1183–1210,1969.[14]K.Goiser and P.Christen.Towards automated record linkage.In AusDM’06,pages23–31,Sydney,2006.[15]M.A.Hernandez and S.J.Stolfo.The merge/purge problemfor large databases.In ACM SIGMOD’95,pages127–138,San Jose,1995.[16]L.Jin,C.Li,and S.Mehrotra.Efficient record linkage in largedata sets.In DASF AA’03,Tokyo,2003.[17]G.J.Williams.Data mining with Rattle and R.Togaware,Canberra,2008.Software available at:/survivor/.。

数据分析报告常用术语

数据分析报告常用术语数据分析是当今信息时代中一项重要的技能,它为企业和组织提供了对大量数据的洞察力。

而在数据分析报告中,术语的使用将帮助读者更好地理解和解释数据。

本文将介绍一些数据分析报告中常用的术语,以帮助读者更好地应用和理解这些术语。

1. 数据集(Dataset):指存储在数据库或文件中的一组相关数据。

通常,数据集是由多个数据元素组成,每个数据元素包括多个数据字段。

2. 数据字段(Data Field):也称为列或属性,是数据集中的每个列。

每个数据字段包含特定类型的数据,例如日期、姓名、成绩等。

3. 数据行(Data Row):也称为记录,是数据集中的每行数据。

每一行包含了属于数据字段的具体值,它们按照相同的顺序排列。

4. 数据清洗(Data Cleaning):是数据分析过程中的一个重要步骤,用于检测和修复数据集中的错误、缺失或不准确的数据。

数据清洗可以提高数据质量,确保数据的准确性和一致性。

5. 数据探索(Data Exploration):也称为探索性数据分析(EDA),是数据分析的第一步。

数据探索旨在通过统计和可视化方法揭示数据集的内在特征、模式和关系,以了解数据的概况。

6. 描述统计(Descriptive Statistics):是通过总结和展示数据的集中趋势、离散程度、分布形状、相关性等统计量来描述数据集的统计学特征。

常见的描述统计量包括均值、中位数、标准差、最大值和最小值等。

7. 相关分析(Correlation Analysis):用于衡量两个或多个变量之间关系的统计分析方法。

相关系数是用来度量变量之间线性相关性的指标,其范围从-1到1,其中-1代表强负相关,1代表强正相关,0代表无相关性。

8. 数据可视化(Data Visualization):通过使用图表、图形和其他可视化工具来展示数据的过程。

数据可视化有助于有效地传达和解释数据,帮助读者更好地理解数据。

9. 数据挖掘(Data Mining):通过分析和发现数据中的模式、关联和趋势,从大量数据中提取有用的信息。

sql课后《习题》答案

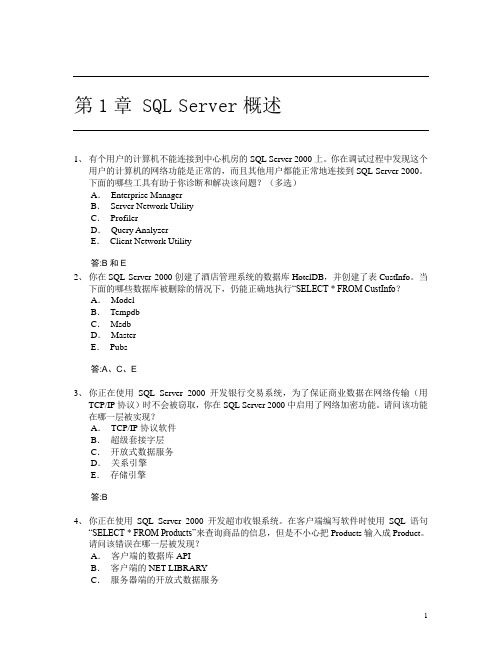

第1章 SQL Server概述1、有个用户的计算机不能连接到中心机房的SQL Server 2000上。

你在调试过程中发现这个用户的计算机的网络功能是正常的,而且其他用户都能正常地连接到SQL Server 2000。

下面的哪些工具有助于你诊断和解决该问题?(多选)A.Enterprise ManagerB.Server Network UtilityC.ProfilerD.Query AnalyzerE.Client Network Utility答:B和E2、你在SQL Server 2000创建了酒店管理系统的数据库HotelDB,并创建了表CustInfo。

当下面的哪些数据库被删除的情况下,仍能正确地执行“SELECT * FROM CustInfo?A.ModelB.TempdbC.MsdbD.MasterE.Pubs答:A、C、E3、你正在使用SQL Server 2000开发银行交易系统,为了保证商业数据在网络传输(用TCP/IP协议)时不会被窃取,你在SQL Server 2000中启用了网络加密功能。

请问该功能在哪一层被实现?A.TCP/IP协议软件B.超级套接字层C.开放式数据服务D.关系引擎E.存储引擎答:B4、你正在使用SQL Server 2000开发超市收银系统。

在客户端编写软件时使用SQL语句“SELECT * FROM Products”来查询商品的信息,但是不小心把Products输入成Product。

请问该错误在哪一层被发现?A.客户端的数据库APIB.客户端的NET-LIBRARYC.服务器端的开放式数据服务D.服务器端的关系引擎E.服务器端的存储引擎答:D5、你要为中小型商场开发一个商场收银软件,该软件由多个收银员在各自的收银台使用。

后端数据库是SQL Server 2000,所有收银员的收银信息集中存放在几个表内。

在采用两层架构(2-Tier)的软件开发时,商场收银软件需要数据库的帐号和密码(SQL Server认证)或Windows认证才能连接和访问数据库,就象SQL Server 2000的查询分析器在刚运行的时候要求你输入帐号和密码或使用Windows认证才能访问数据库。

宜搭subset的表达式

宜搭subset的表达式什么是宜搭subset的表达式?宜搭subset的表达式是指在统计学中,用于描述一个集合中某个子集的表达式。

具体而言,宜搭subset的表达式是通过特定的条件来筛选或限定数据集合中的一部分数据。

它可以基于各种属性或指标进行定义,从而帮助我们更好地理解数据集的特征和规律。

为了更好地理解宜搭subset的表达式,让我们考虑一个具体的例子。

假设我们有一个包含100个人的数据集,其中记录了每个人的年龄、性别、收入和教育水平。

现在,我们想要找出所有年龄在20岁以上且收入在平均水平以上的女性。

为了实现这个目标,我们可以使用宜搭subset的表达式。

首先,我们需要定义子集的条件。

在这个例子中,我们关心的是女性,所以我们限定性别为女性。

接下来,我们需要筛选出年龄在20岁以上的人。

最后,我们需要进一步筛选出收入在平均水平以上的人。

为了实现这个筛选过程,我们可以使用常见的统计软件或编程语言,如R 或Python。

首先,我们需要载入数据集,并将其转化为一个数据框(data frame)。

然后,我们可以使用条件筛选的功能,比如使用“subset”函数(在R中)或通过布尔索引(在Python中)来定义我们的条件。

在本例中,我们可以用以下R代码来实现宜搭subset的表达式:R# 载入数据集data <- read.csv("data.csv")# 定义子集的条件subset_condition <- datagender == "female" & dataage > 20 & dataincome > mean(dataincome)# 筛选数据子集subset_data <- subset(data, subset_condition)通过上述代码,我们将筛选出所有满足条件的女性数据,并将其保存到一个新的数据框中,即subset_data。

数据库常用名词解释

数据库常用名词解释♦DB:数据库(Database),DB是统一管理的相关数据的集合。

DB能为各种用户共享,具有最小冗余度,数据间联系密切,而又有较高的数据独立性。

♦DBMS:数据库管理系统(DatabaseManagementSystem),DBMS是位于用户与操作系统之间的一层数据管理软件,为用户或应用程序提供访问DB的方法,包括DB 的建立、查询、更新及各种数据控制。

DBMS总是基于某种数据模型,可以分为层次型、网状型、关系型、面向对象型DBMS。

♦DBS:数据库系统(DatabaseSystem),DBS是实现有组织地、动态地存储大量关联数据,方便多用户访问的计算机软件、硬件和数据资源组成的系统,即采用了数据库技术的计算机系统。

♦1:1联系:如果实体集E1中的每个实体最多只能和实体集E2中的一个实体有联系,反之亦然,好么实体集E1对E2的联系称为“一对一联系”,记为“1:1”。

♦1:N联系:如果实体集E1中每个实体与实体集E2中任意个(零个或多个)实体有联系,而E2中每个实体至多和E1中的一个实体有联系,那么E1对E2的联系是“一对多联系”,记为“1:N”。

♦M:N联系:如果实体集E1中每个实体与实体集E2中任意个(零个或多个)实体有联系反之亦然,那么E1对E2的联系是“多对多联系”记为“MN”。

♦数据模型:表示实体类型及实体类型间联系的模型称为“数据模型”。

它可分为两种类型:概念数据模型和结构数据模型。

♦概念数据模型:它是独门于计算机系统的模型,完全不涉及信息在系统中的表示,只是用来描述某个特定组织所关心的信息结构。

♦结构数据模型:它是直接面向数据库的逻辑结构,是现实世界的第二层抽象。

这类模型涉及到计算机系统和数据库管理系统,所以称为“结构数据模型”。

结构数据模型应包含:数据结构、数据操作、数据完整性约束三部分。

它主要有:层次、网状、关系三种模型。

♦层次模型:用树型结构表示实体间联系的数据模型♦网状模型:用有向图结构表示实体类型及实体间联系的数据模型。

押题宝典卫生招聘考试之卫生招聘(计算机信息管理)综合练习试卷B卷附答案

押题宝典卫生招聘考试之卫生招聘(计算机信息管理)综合练习试卷B卷附答案单选题(共48题)1、在EXCEL中,对某一单元格区域进行保护,应在菜单下完成A.工具B.表格C.编辑D.窗口【答案】A2、在具有多媒体功能的微型计算机中,常用的CD-ROM是A.只读型软盘B.只读型硬盘C.只读型光盘D.只读型半导体存储器【答案】C3、在Access中,说查询的结果是一个“动态集”,是指每次执行查询时所得到的数据集合()。

A.都是从数据来源表中随机抽取的B.基于数据来源表中数据的改变而改变C.随着用户设置的查询准则的不同而不同D.将更新数据来源表中的数据【答案】B4、以下for语句中不是死循环的是()A.for(int i=0;i<1;++i);B.for(int i=0;;++i);C.for(int i=1;i>0;++i);D.for(;;);【答案】A5、数据结构中,与所使用的计算机无关的是数据的()A.存储结构B.物理结构C.逻辑结构D.物理和存储结构【答案】C6、在下列四个选项中,不属于基本关系运算的是A.连接B.投影C.选择D.排序【答案】D7、一条计算机指令中,规定其执行功能的部分称为A.源地址码B.操作码C.目标地址码D.数据码【答案】B8、Internet实现了分布在世界各地的各类网络的互联,其最基础和核心的协议是A.TCP/IPB.FTPC.HTMLD.HTTP【答案】A9、能够将表单的Visible属性设置为.T.,并使表单成为活动对象的方法A.HideB.ShowC.ReleaseD.SetFocus【答案】B10、在计算机网络中,表征数据传输可靠性的指标是A.传输率B.误码率C.信息容量D.频带利用率【答案】A11、假设已经生成了名为mymenu的菜单文件,执行该菜单文件的命令是A.DOmymenuB.DOmymenu.mprC.DOmymenu.pjXD.DOmymenu.mnx【答案】B12、最简单的交换排序方法是A.快速排序B.选择排序C.堆排序D.冒泡排序【答案】D13、如果表达式--x+y中,--是作为成员函数重载的,+是作为成员函数重载的,则该表达式还可为()A.y.operator+(x.operator--(0))B.y.operator+(x.operator--())C.y.operator+(operator--(x,0))D.operator+(x.operator--())【答案】B14、要同时打开多个数据表文件,选择不同的工作区可使用的命令是EB.OPENC.SELECTD.以上命令均可【答案】C15、计算机病毒破坏的主要对象是A.软盘B.磁盘驱动器C.CPUD.程序和数据【答案】D16、在EXCEL中,分类汇总是在菜单下完成A.数据B.工具C.编辑D.格式【答案】A17、对于重载的运算符>>,它是一个()A.用于输入的友元函数B.用于输入的成员函数C.用于输出的友元函数D.用于输出的成员函数【答案】A18、以下for语句中不是死循环的是()A.for(int i=0;i<1;++i);B.for(int i=0;;++i);C.for(int i=1;i>0;++i);D.for(;;);【答案】A19、线性表L=(a1,a2,a3,…ai,…an),下列说法正确的是()A.每个元素都有一个直接前件和直接后件B.线性表中至少要有一个元素C.表中诸元素的排列顺序必须是由小到大或由大到小D.除第一个元素和最后一个元素外,其余每个元素都有且只有一个直接前件和直接后件【答案】D20、以下定义数组中错误的是()A.int a[10];B.int a[2][20];C.int a[20][];D.int a[];【答案】C21、大型计算机网络中的主机通常采用A.微机B.小型机C.大型机D.巨型机【答案】C22、()是一种符号化的机器语言。

currentdb.openrecordset 参数 -回复

currentdb.openrecordset 参数-回复数据库操作是现代软件开发中常见的一项任务,而为了实现对数据库的操作,我们需要使用到一系列相关的函数和方法。

其中,`currentdb.openrecordset`是Access数据库中一种非常重要的方法,用于打开一个记录集。

本文将以`currentdb.openrecordset`的参数作为主题,一步一步地解释其用法和实现过程。

首先,我们来了解一下`currentdb.openrecordset`的基本定义和功能。

在Access数据库中,`currentdb.openrecordset`是用于打开一个记录集的方法。

它的参数主要包括表名、查询、条件以及排序等信息,通过指定这些参数,我们可以打开指定的记录集并开始对其进行操作。

接下来,我们将详细介绍每个参数的作用和用法。

参数一:表名表名是`currentdb.openrecordset`方法的第一个参数,用于指定要打开的记录集所在的表。

一般情况下,我们可以直接使用表的名称作为参数,如`"Customers"`,其中"Customers"是数据库中的一张表。

另外,我们还可以使用SQL语句来指定要打开的表,例如`"SELECT * FROM Customers"`。

通过这种方式,我们可以根据特定的查询条件来打开所需的记录集。

参数二:查询查询是`currentdb.openrecordset`方法的第二个参数,用于指定要打开的记录集的查询条件。

对于复杂的查询,我们可以使用SQL语句来指定查询条件,例如`"SELECT * FROM Customers WHERE Country='China'"`,其中"Country='China'"表示查询条件为国家为中国的记录。

通过这种方式,我们可以根据不同的查询条件来打开所需的记录集,并对其进行操作。

quantitative data例子

quantitative data例子

以下是一些关于数量化数据(quantitative data)的例子:

1. 学生的考试分数:例如,小明的数学考试得了85分,英语考试得了78分。

2. 产品的价格:例如,一台电视的价格是500美元。

3. 人口统计数据:例如,某个城市的人口数量是100万人。

4. 温度记录:例如,某一天的最高气温是30摄氏度。

5. 股票价格:例如,苹果公司的股票价格是150美元。

6. 体重:例如,某人的体重是70公斤。

这些例子中的数据都是可以用数字表示的,可以进行数学运算和统计分析。

这些数据通常用于量化和测量,因此被称为数量化数据。

基尼系数计算stata

基尼系数计算stata基尼系数是一种用于衡量收入分配不平等程度的指标,它在经济、社会学等领域被广泛应用。

在Stata中,基尼系数的计算可以通过以下几个步骤进行:1. 打开数据集在Stata中,可以通过“use”命令打开需要计算基尼系数的数据集,例如:use "data.dta"其中,“data.dta”是数据集的文件名。

需要注意的是,数据集应包含一个表示个体收入的变量。

2. 计算个体收入的累积比例和累积人口比例个体收入的累积比例是指个体收入从小到大排序后的累积和占总收入的比例。

可以通过以下命令计算:egen cum_income = sum(income) // 计算个体收入累积和egen cum_perc = cum_income / sum(income) // 计算个体收入累积比例其中,“cum_income”表示个体收入的累积和,“cum_perc”表示个体收入的累积比例。

而累积人口比例是指人口分布从低到高排序后的累积和占总人口的比例。

可以通过以下命令计算:egen cum_pop = seqcount(id) // 计算人口累积和egen cum_pop_perc = cum_pop / _N // 计算人口累积比例其中,“cum_pop”表示人口的累积和,“cum_pop_perc”表示人口的累积比例,“_N”表示样本总数。

3. 计算基尼系数基尼系数的计算公式如下:G = (B / A) - (1 / n)其中,A表示累积收入比例的面积,B表示洛伦茨曲线与45度线之间的面积,n表示样本总数。

可以通过以下命令计算:gen lorenz_x = cum_pop_perc - (0.5 * cum_pop_perc[_n]) // 计算洛伦茨曲线横坐标gen lorenz_y = cum_perc // 计算洛伦茨曲线纵坐标gen lorenz_d = lorenz_y - lorenz_x // 计算洛伦茨曲线和45度线之间的距离sort income // 按收入排序gen gini_numerator = _n * lorenz_d // 计算基尼系数分子gen gini_denominator = 2 * cum_income - _n * (income[1] + income[_n]) // 计算基尼系数分母gen gini = gini_numerator / gini_denominator // 计算基尼系数其中,“lorenz_x”表示洛伦茨曲线的横坐标,“lorenz_y”表示洛伦茨曲线的纵坐标,“lorenz_d”表示洛伦茨曲线和45度线之间的距离,“gini_numerator”表示基尼系数的分子,“gini_denominator”表示基尼系数的分母,“gini”表示基尼系数。

2023年卫生招聘考试之卫生招聘(计算机信息管理)练习题库

2023年卫生招聘考试之卫生招聘(计算机信息管理)练习题库单选题(共20题)1. 不能作为重载函数的调用的依据是A.参数个数B.参数类型C.函数类型D.函数名称【答案】 D2. 找出在仓库面积大于500的仓库中工作的职工号,以及这些职工工作所在的城市,正确的命令是A.SELECT职工号,城市FROM职工;WHERE(面积>500)OR(职工.仓库号=仓库.仓库号)B.SELECT职工号,城市FROM职工;WHERE(面积>500)AND(职工.仓库号=仓库.仓库号)C.SELECT职工号,城市FROM仓库,职工;WHERE(面积>500)OR(职工.仓库号=仓库.仓库号)D.SELECT职工号,城市FROM仓库,职工;WHERE(面积>500)AND(职工.仓库号=仓库.仓库号)【答案】 D3. WindowsNT是人们非常熟悉的网络操作系统,其吸引力主要来自( )。

①适合做因特网标准服务平台②开放源代码③有丰富的软件支持④免费提供A.①③B.①②C.②③D.③④【答案】 A4. 所有在函数中定义的变量,连同形式参数,都属于( )A.全局变量B.局部变量C.静态变量D.寄存器变量【答案】 B5. 查询设计器中包含的选项卡有A.字段、联接、筛选、排序依据、分组依据、杂项B.字段、联接、筛选、分组依据、排序依据、更新条件C.字段、联接、筛选条件、排序依据、分组依据、杂项D.字段、联接、筛选依据、分组依据、排序依据、更新条件【答案】 A6. 在Internet中,按地址进行寻址。

( )A.邮件地址B.IP地址C.MAC地址D.网线接口地址【答案】 B7. 用计算机进行财务管理,这属于计算机在( )领域的应用。

A.数值计算B.人工智能C.电子商务D.信息管理【答案】 D8. SQL语言又称为A.结构化定义语言B.结构化控制语言C.结构化查询语言D.结构化操纵语言【答案】 C9. 网桥工作在互连网络的( )。

res(resident set size)计算公式

Resident Set Size (RSS) 是一个衡量进程在物理内存中占用空间大小的指标。

它表示进程当前在RAM中占用的空间大小,不包括交换出去的部分。

计算Resident Set Size 并没有一个通用的公式,因为它依赖于操作系统如何管理和跟踪进程的内存使用。

在Linux系统中,可以通过读取/proc 文件系统来获取进程的RSS。

例如,在Linux中,你可以使用以下命令来获取一个进程的RSS:

bash

ps -p <PID> -o rss=

的进程的进程ID。

这个命令会返回该进程的RSS 值,单位是KB。

如果你想要通过编程方式获取RSS,你可以读取/proc/<PID>/status 文件,并解析其中的VmRSS 字段。

这个字段表示的就是进程的Resident Set Size。

currentdb.openrecordset 参数 -回复

currentdb.openrecordset 参数-回复「currentdb.openrecordset 参数」指的是在Microsoft Access数据库中使用CurrentDb对象的OpenRecordset方法时所能传递的参数。

这些参数用于指定需要访问和操作的数据库记录集的条件和排序方式。

本文将详细介绍这些参数的使用方法,以帮助读者更好地了解和使用Access 数据库。

首先,我们需要明确OpenRecordset方法的基本语法。

它的一般形式如下:Set rs = CurrentDb.OpenRecordset(Source, Type, Options, LockEdit)其中:- rs表示一个Recordset对象,用于引用返回的记录集。

- Source是必需的参数,用于指定需要访问的数据库表名、查询(Query)名、SQL语句等。

例如:表名或查询名可以直接使用字符串,而SQL语句可以使用字符串变量或字符串常量等。

- Type是一个可选参数,用于指定打开记录集的类型。

这个参数可以是RecordsetTypeEnum中的一个常量,例如:dbOpenTable、dbOpenDynaset、dbOpenSnapshot等。

- Options也是一个可选参数,用于指定打开记录集时的选项。

这个参数可以是RecordsetOptionEnum中的一个常量,例如:dbReadOnly、dbAppendOnly、dbConsistent等。

- LockEdit也是一个可选参数,用于指定是否锁定记录集以进行编辑。

这个参数可以是RecordsetLockTypeEnum中的一个常量,例如:dbOptimistic、dbPessimistic等。

接下来,我们将逐个介绍这些参数的使用方法。

首先是Source参数。

在使用Source参数时,我们可以传递字符串、变量或SQL语句来指定要访问和操作的数据库记录集。

押题宝典土地登记代理人之土地登记相关法律知识通关试题库(有答案)

押题宝典卫生招聘考试之卫生招聘(计算机信息管理)模考模拟试题(全优)单选题(共45题)1、下列( )不是网络操作系统软件。

A.WindowsNTServerWareC.UNIXD.SQLServer【答案】 D2、下列赋值语句中正确的是A.STORE1ToX,YB.STORE1,2ToXC.STORE1ToXYD.STORE1、2ToX【答案】 A3、五笔字型输入法属于A.音码输入法B.形码输入法C.音形结合输入法D.联想输入法【答案】 B4、有如下sQLSELECT语句SELECT*FROMstockWHERE单价BETWEENl2.76ANDl5.20与该语句等价的是A.SELECT*FROMskWHERE单价<=15.20.AND.单价>一12.76B.SELECT*FROMskWHERE单价<15.20.AND.单价>12.76C.SELECT*FROMskWHERE单价>一15.20.AND.SELECT*FROMskWHgRE单价>15.20.AN单价<12.76【答案】 A5、若已定义的函数有返回值,则以下关于该函数调用的叙述中错误的是( )A.函数调用可以作为独立的语句存在B.函数调用可以无返回值C.函数调用可以出现在表达式中D.函数调用可以作为一个函数的形参【答案】 D6、在命令窗口中,打印报表YY1可使用的命令是A.REPORT FROM YY1B.REPORT FROM YY1>PREVIEWC.REPORT FORM YY1 To PRINTERD.REPORT FORM YY1PREVIEW【答案】 C7、IP协议是无连接的,其信息传输方式是( )A.点到点B.广播C.虚电路D.数据报【答案】 A8、下列各种进制的数中,最小的数是A.(101001)B.(52)OC.(2B)HD.(44)D【答案】 A9、在EXCEL中,分类汇总是在菜单下完成A.数据B.工具C.编辑D.格式【答案】 A10、下列软件中,( )是动画制作软件。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Census-Income (KDD) Data Set(人口收入(知识发现)

数据集)

数据摘要:

This data set contains weighted census data extracted from the 1994 and 1995 current population surveys conducted by the U.S. Census Bureau.

中文关键词:

多变量,分类,UCI,人口收入,知识发现,

英文关键词:

Multivariate,Classification,UCI,Census-Income,KDD,

数据格式:

TEXT

数据用途:

This data set is used for classification.

数据详细介绍:

Census-Income (KDD) Data Set

Abstract: This data set contains weighted census data extracted from the 1994 and 1995

Source:

Original Owner:

U.S. Census Bureau

/

United States Department of Commerce

Donor:

Terran Lane and Ronny Kohavi

Data Mining and Visualization

Silicon Graphics.

terran '@' , ronnyk '@'

Data Set Information:

This data set contains weighted census data extracted from the 1994 and 1995 Current Population Surveys conducted by the U.S. Census Bureau. The data contains 41 demographic and employment related variables.

The instance weight indicates the number of people in the population that each record represents due to stratified sampling. To do real analysis and derive conclusions, this field must be used. This attribute should *not* be used in the classifiers.

One instance per line with comma delimited fields. There are 199523 instances in the data file and 99762 in the test file.

The data was split into train/test in approximately 2/3, 1/3 proportions using MineSet's MIndUtil mineset-to-mlc.

Attribute Information:

More information detailing the meaning of the attributes can be found in the Census Bureau's documentation To make use of the data descriptions at this site, the following mappings to the Census Bureau's internal database column names will be needed:

age AAGE

class of worker ACLSWKR

industry code ADTIND

occupation code ADTOCC

adjusted gross income AGI

education AHGA

wage per hour AHRSPAY

enrolled in edu inst last wk AHSCOL

marital status AMARITL

major industry code AMJIND

major occupation code AMJOCC

mace ARACE

hispanic Origin AREORGN

sex ASEX

member of a labor union AUNMEM

reason for unemployment AUNTYPE

full or part time employment stat AWKSTAT

capital gains CAPGAIN

capital losses CAPLOSS

divdends from stocks DIVVAL

federal income tax liability FEDTAX

tax filer status FILESTAT

region of previous residence GRINREG

state of previous residence GRINST

detailed household and family stat HHDFMX

detailed household summary in household HHDREL

instance weight MARSUPWT

migration code-change in msa MIGMTR1

migration code-change in reg MIGMTR3

migration code-move within reg MIGMTR4

live in this house 1 year ago MIGSAME

migration prev res in sunbelt MIGSUN

num persons worked for employer NOEMP

family members under 18 PARENT

total person earnings PEARNVAL

country of birth father PEFNTVTY

country of birth mother PEMNTVTY

country of birth self PENATVTY

citizenship PRCITSHP

total person income PTOTVAL

own business or self employed SEOTR

taxable income amount TAXINC

fill inc questionnaire for veteran's admin VETQVA

veterans benefits VETYN

weeks worked in year WKSWORK

Note that Incomes have been binned at the $50K level to present a binary classification problem, much like the original UCI/ADULT database. The goal field of this data, however, was drawn from the "total person income" field rather than the "adjusted gross income" and may, therefore, behave differently than the orginal ADULT goal field.

数据预览:

点此下载完整数据集。