FFMpeg MPEG2的TS流的解码流程

ffmpeg 各种编码器 使用方法

一、介绍ffmpeg编码器ffmpeg是一个开源的音视瓶处理工具,可以进行音视瓶的编解码、转换和流媒体的处理。

在使用ffmpeg进行编码时,我们可以选择不同的编码器来实现不同的功能,比如压缩、转换、解码等。

本文将介绍一些常见的编码器,并说明它们的使用方法。

二、常见的音频编码器1. AAC编码器AAC(Advanced Audio Coding)是一种高级音频编码格式,常用于音乐和音频流媒体的编码。

在ffmpeg中,可以使用libfaac库来支持AAC编码,具体命令如下:ffmpeg -i input.wav -c:a libfaac -b:a 128k output.aac参数说明:-i input.wav:指定输入文件为input.wav-c:a libfaac:选择使用libfaac库进行音频编码-b:a 128k:设置音频比特率为128kbpsoutput.aac:指定输出文件为output.aac2. MP3编码器MP3(MPEG-1 Audio Layer 3)是一种广泛使用的有损音频压缩格式,适用于音乐和语音的编码。

在ffmpeg中,可以使用libmp3lame库来支持MP3编码,具体命令如下:ffmpeg -i input.wav -c:a libmp3lame -q:a 2 output.mp3参数说明:-i input.wav:指定输入文件为input.wav-c:a libmp3lame:选择使用libmp3lame库进行音频编码-q:a 2:设置音频质量因子为2(取值范围0-9,数值越大,音质越低)output.mp3:指定输出文件为output.mp3三、常见的视瓶编码器1. H.264编码器H.264(又称AVC)是一种高效的视瓶编码格式,适用于视瓶会议、高清电视等场景。

在ffmpeg中,可以使用libx264库来支持H.264编码,具体命令如下:ffmpeg -i input.mp4 -c:v libx264 -crf 23 -preset slowoutput.mp4参数说明:-i input.mp4:指定输入文件为input.mp4-c:v libx264:选择使用libx264库进行视瓶编码-crf 23:设置视瓶质量因子为23(取值范围0-51,数值越小,视瓶质量越高)-preset slow:设置编码速度为slow(速度越慢,压缩效率越高)output.mp4:指定输出文件为output.mp42. H.265编码器H.265(又称HEVC)是一种更高效的视瓶编码格式,可以实现更好的压缩效果和视瓶质量。

ffmpeg转码MPEG2

ffmpeg转码MPEG2ffmpeg转码MPEG2-TS的音视频同步机制分析一、FFmpeg忽略了adaptation_field()数据FFmpeg忽略了包含PCR值的adaptation_filed数据; 代码(libavformat/mpegts.c)分析如下:/* 解析TS包*/int handle_packet(MpegTSContext *ts, const uint8_t *packet){... pid = AV_RB16(packet + 1) & 0x1fff;//SYNTAX: PIDis_start = packet[1] & 0x40;//SYNTAX:payload_unit_start_indicator... /* continuity check (currently not used) */cc = (packet[3] & 0xf);//SYNTAX: continuity_counterexpected_cc = (packet[3] & 0x10) ? (tss->last_cc + 1) & 0x0f: tss->last_cc;cc_ok = (tss->last_cc < 0) || (expected_cc == cc);tss->last_cc = cc; /* skip adaptation field */afc = (packet[3] >> 4) & 3;//SYNTAX:adaptation_field_controlp = packet + 4;if (afc == 0) /* reserved value */return 0;if (afc == 2) /* adaptation field only */return 0;if (afc == 3){/* skip adapation field */p += p[0] + 1;}...}二、解码初始时间戳的计算原理如下:a. 分析阶段: 分析多个TS包,并找到第一个PES包的PTS,做为初始偏移量;b. PTS置零: 分析与初始化阶段完成后, 解码TS的第一个PES包,得到其PTS值, 减去初始偏移量,使得第一个编码后帧的PTS为零;c. DTS/PTS增量累加;1. PTS置零代码分析main(){|-- ...|-- parse_options(){|-- …|-- opt_input_file(){|-- …av_find_stream_info(ic);timestamp= start_time;timestamp+= ic->start_time;…input_files_ts_offset[nb_input_files] =input_ts_offset - (copy_ts ? 0 : timestamp);…}…}|-- transcode(){|-- …for( ; received_sigterm == 0; ){AVPacket pkt;…ret = av_read_frame(is,&pkt);…pkt.dts+=av_rescale_q(input_files_ts_offset[nb_input_files], AV_TIME_BASE_Q,ist->st->time_base);}} 三、编码音视频帧的DTS/PTS计算音频帧的DTS/PTS计算:一个音频帧(对于AAC来说, 是1024个采样点),相对于音频采样率(如44100个采样点/second = 44.1KHz)来说,累加上每帧的增量(1024*1000/44100 = 23ms/frame)st->time_base.den = 1000 //时钟基, 1 second = 1000 msframe_size = 1024 //一帧= 1024个采样点st->pts = {val=0,num=22050,den=44100}; // 音频采样率av_frac_add(&st->pts,(int64_t)st->time_base.de n * frame_size);/* f.val = f.val + ((f.num + incr) /f->den) */static void av_frac_add(AVFrac *f, int64_t incr){int64_t num, den;num = f->num + incr;den = f->den;if (num < 0){f->val += num / den;num = num % den;if (num< 0){num += den;f->val--;}}else if (num >= den){f->val += num / den;num = num % den;}f->num = num;st->pts = {val=23, // 计算后的时间戳num=31750, // 上一帧未播放完的余值den=44100}视频帧的DTS/PTS计算:一个视频帧,相对于视频帧率来说(如25 frames/second),累加上每帧的增量(1000ms/25frames =40ms/frame)time_base.den = 1000time_base.num = 1st->pts ={val=0, num=12, den=25},av_frac_add(&st->pts,(int64_t)st->time_base.de n * st->codec->time_base.num);st->pts ={val=40, num=12, den=25}四、解码时间戳与编码时间戳的同步机制正常的转码流程(ffmpeg version 0.8.10 在ffmpeg.c的transcode函数for(; received_sigterm == 0;){}循环中):step1. 解析PES包,得到时间戳、流索引、PES包长度等数据,并将这个PES包压入到PES包队列;见libavformat/mpegts.c函数int mpegts_push_data();step2. 从PES包队列中取出一个PES包;见libavformat/utils.c函数int av_read_frame();step3. 将这个PES包的PTS和/或DTS减去初始时间戳, 见ffmpeg.cpkt.dts+=av_rescale_q(input_files_ts_offset[ist->file_index],AV_TIME_BASE_Q,ist->st->time_base);pkt.pts+=av_rescale_q(input_files_ts_offset[ist->file_index],AV_TIME_BASE_Q,ist->st->time_base);并根据音频/视频流的采样率得到下一帧的PTS和/或DTS;见ffmpeg.c函数int output_packet();ist->next_pts = ist->pts=av_rescale_q(pkt->dts, ist->st->time_base,AV_TIME_BASE_Q);pkt_pts =av_rescale_q(pkt->pts,ist->st->time_base,AV_TIME_BASE_Q);如果本帧解码得到的时间戳和上一帧解码得到的时间戳的差值超过了设定的阈值,为了使输出的时间戳连续或同步,则需要调整,如,视频帧时间戳不连续,则丢弃音频帧以同步音频帧时间戳不连续,则插件静音帧;或是其它的策略。

MPEG-2视频解码

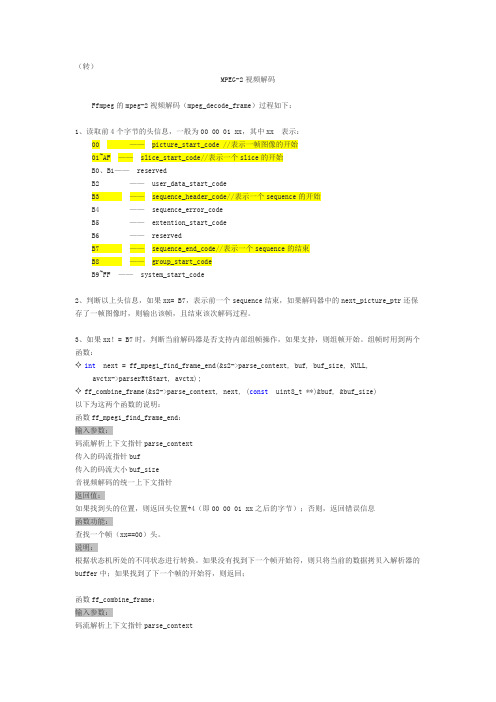

(转)MPEG-2视频解码Ffmpeg的mpeg-2视频解码(mpeg_decode_frame)过程如下:1、读取前4个字节的头信息,一般为00 00 01 xx,其中xx 表示:00 —— picture_start_code //表示一帧图像的开始01~AF —— slice_start_code//表示一个slice的开始B0、B1—— reservedB2 —— user_data_start_codeB3 —— sequence_header_code//表示一个sequence的开始B4 —— sequence_error_codeB5 —— extention_start_codeB6 —— reservedB7 —— sequence_end_code//表示一个sequence的结束B8 —— group_start_codeB9~FF —— system_start_code2、判断以上头信息,如果xx= B7,表示前一个sequence结束,如果解码器中的next_picture_ptr还保存了一帧图像时,则输出该帧,且结束该次解码过程。

3、如果xx!= B7时,判断当前解码器是否支持内部组帧操作,如果支持,则组帧开始。

组帧时用到两个函数:✧int next = ff_mpeg1_find_frame_end(&s2->parse_context, buf, buf_size, NULL,avctx->parserRtStart, avctx);✧ff_combine_frame(&s2->parse_context, next, (const uint8_t **)&buf, &buf_size)以下为这两个函数的说明:函数ff_mpeg1_find_frame_end:输入参数:码流解析上下文指针parse_context传入的码流指针buf传入的码流大小buf_size音视频解码的统一上下文指针返回值:如果找到头的位置,则返回头位置+4(即00 00 01 xx之后的字节);否则,返回错误信息函数功能:查找一个帧(xx==00)头。

FFmpeg开发笔记(九):ffmpeg解码rtsp流并使用SDL同步播放

FFmpeg开发笔记(九):ffmpeg解码rtsp流并使⽤SDL同步播放前⾔ ffmpeg播放rtsp⽹络流和摄像头流。

Demo 使⽤ffmpeg播放局域⽹rtsp1080p海康摄像头:延迟0.2s,存在马赛克 使⽤ffmpeg播放⽹络rtsp⽂件流:偶尔卡顿,延迟看不出 使⽤vlc软件播放局域⽹rtsp1080p海康摄像头:演⽰2s,不存在马赛克 使⽤vlc软件播放⽹络rtsp⽂件流:不卡顿,延迟看不出FFmpeg基本播放流程ffmpeg解码流程 ffmpeg新增API的解码执⾏流程。

新api解码基本流程如下:步骤⼀:注册: 使⽤ffmpeg对应的库,都需要进⾏注册,可以注册⼦项也可以注册全部。

步骤⼆:打开⽂件: 打开⽂件,根据⽂件名信息获取对应的ffmpeg全局上下⽂。

步骤三:探测流信息: ⼀定要探测流信息,拿到流编码的编码格式,不探测流信息则其流编码器拿到的编码类型可能为空,后续进⾏数据转换的时候就⽆法知晓原始格式,导致错误。

步骤四:查找对应的解码器 依据流的格式查找解码器,软解码还是硬解码是在此处决定的,但是特别注意是否⽀持硬件,需要⾃⼰查找本地的硬件解码器对应的标识,并查询其是否⽀持。

普遍操作是,枚举⽀持⽂件后缀解码的所有解码器进⾏查找,查找到了就是可以硬解了(此处,不做过多的讨论,对应硬解码后续会有⽂章进⾏进⼀步研究)。

(注意:解码时查找解码器,编码时查找编码器,两者函数不同,不要弄错了,否则后续能打开但是数据是错的)步骤五:打开解码器 开打解码器的时候,播放的是rtsp流,需要设置⼀些参数,在ffmpeg中参数的设置是通过AVDictionary来设置的。

使⽤以上设置的参数,传⼊并打开获取到的解码器。

AVDictionary *pAVDictionary = 0// 设置缓存⼤⼩ 1024000byteav_dict_set(&pAVDictionary, "buffer_size", "1024000", 0);// 设置超时时间 20sav_dict_set(&pAVDictionary, "stimeout", "20000000", 0);// 设置最⼤延时 3sav_dict_set(&pAVDictionary, "max_delay", "30000000", 0);// 设置打开⽅式 tcp/udpav_dict_set(&pAVDictionary, "rtsp_transport", "tcp", 0);ret = avcodec_open2(pAVCodecContext, pAVCodec, &pAVDictionary);if(ret){LOG << "Failed to avcodec_open2(pAVCodecContext, pAVCodec, pAVDictionary)";return;}步骤六:申请缩放数据格式转换结构体 此处特别注意,基本上解码的数据都是yuv系列格式,但是我们显⽰的数据是rgb等相关颜⾊空间的数据,所以此处转换结构体就是进⾏转换前到转换后的描述,给后续转换函数提供转码依据,是很关键并且⾮常常⽤的结构体。

MPEG-2 TS码流分析

MPEG-2 TS码流分析一、TS流概述ES流(Elementary Stream,基本流):数字电视各组成部分编码后所形成的直接表示基本元素内容的流,包含视频、音频或数据的连续码流。

PES流(Paketized Elementary Stream,打包基本码流):是将基本的码流ES流根据需要分成长度不等的数据包,并加上包头就形成了打包的基本码流PES流。

PS (Program Stream,节目流):将一个节目的多个组成部分按照它们之间的互相关系进行组织并加入各组成部分关系描述后的码流。

PS流是一种多路复用数字音频、视频等的封装容器,它一个或多个具有共同的时间基准的PES流合并成一个整体流,主要用于节目存储。

其包长不固定,且较长,一旦失去同步信息,接收机无法确定下一包的同步位置,会造成失步,导致严重的信息丢失。

PS流适用于误码小、信道较好的环境,如演播室、家庭环境和存储介质中。

TS流(Transport Stream,传输流):是将一个节目的多个组成部分按照它们之间的互相关系进行组织并加入各组成部分关系描述和节目组成信息,并进一步封装成传输包后的码流。

TS流是将视频、音频、PSI等数据打包成传输包进行传送。

主要用于节目传输。

TS的传输包长度固定,一般为188字节。

TS流和PS流是MPEG-2标准中规定的两种输出码流。

TS格式中,从视频流的任意一片断开始都可以独立解码,而PS格式不可以。

由于TS流具备较强的抵抗传输误码的能力,因此目前在传输媒体中进行传输的MPEG-2码流基本上都采用了TS 流的包格式。

TS流的播放:播放前将TS流文件的后缀名该为.mpg或者.mpeg,用可以直接播放MPEG-TS流的播放器(一般的播放器都可以)打开播放即可。

TS流的优点:1、动态带宽分配:由于TS的传输包长度是固定的,因此可过PID可以将规定的信道总频带在视频、音频和数据信息见进行实时的、灵活的分配。

利用这一特性,可在广播付费节目前实时地将解密钥匙插入到TS流中送给广大用户。

MPEG2-TS流文件的简介

MPEG2-TS流文件的简介引用自/question/5502243.html随着从HDTV录制的高清节目在网上的流传,烧友们现在对TS这个名词大概已经不陌生了,但随之而来就是如何播放、如何添加字幕等等的一系列问题,本文将重点介绍一下这方面的应用操作。

先来简要介绍一下什么是MPEG2-TS吧。

MPEG2格式大家都通过对DVD的接触而多多少少了解了一些,DVD节目中的MPEG2格式,确切地说是MPEG2-PS,全称是Program Stream,而TS的全称则是Transport Stream。

MPEG2-PS主要应用于存储的具有固定时长的节目,如DVD电影,而MPEG-TS则主要应用于实时传送的节目,比如实时广播的电视节目。

这两种格式的主要区别是什么呢?简单地打个比喻说,你将DVD上的VOB文件的前面一截cut 掉(或者干脆就是数据损坏),那么就会导致整个文件无法解码了,而电视节目是你任何时候打开电视机都能解码(收看)的,所以,MPEG2-TS格式的特点就是要求从视频流的任一片段开始都是可以独立解码的。

【MPEG2-TS流文件的简单回放】有一些播放器软件可以直接播放MPEG2-TS流,比如:=> 1.WinDVD 5.x=> 2.VLC Media Player=> 3.Elecard Player等等。

播放前,先将TS流文件的后缀名改为.mpg,以便播放器可以识别它是一个MPEG文件,否则一些\"以貌取人\"的播放器可能会拒绝提供服务。

修改了后缀名后,直接用播放器打开文件播放即可。

但是需要通过VOBSub外挂字幕的朋友,可能很快就会发现,在WinDVD里无法对MPEG 文件加载字幕,这是因为WinDVD在对MPEG文件解码的时候,用了内部的解码流程,而没有按照微软的DirectShow标准去搭建解码框架,这样自然就无法触发VOBSub这些基于DirectShow标准的外挂控件了。

FFMPEG解码流程详细分析

*@注意的业余头不弱者受制与正确的 START_TIME 的业余

*分路器必须不设定此。

*/

int64_t start_time;

/ **

*解码:时间流流时基。

*如果源文件中没有指定的时间,但不指定

*比特率,这个值将被从码率和文件大小的估计。

*/

int64_t duration;

#if LIBAVFORMAT_VERSION_INT < (53<<16)

FFMPEG 解码流程:

1. 注册所有容器格式和 CODEC: av_register_all()

2. 打开文件:

av_open_input_file()

3. 从文件中提取流信息:源自av_find_stream_info()

4. 穷举所有的流,查找其中种类为 CODEC_TYPE_VIDEO

5. 查找对应的解码器:

time_base:流的时间基准,是一个实数,该流中媒体数据的 pts 和 dts 都将以这个时间 基准为粒度。通常,使用 av_rescale/av_rescale_q 可以实现不同时间基准的转换。

start_time:流的起始时间,以流的时间基准为单位,通常是该流中第一个帧的 pts。 duration:流的总时间,以流的时间基准为单位。 need_parsing:对该流 parsing 过程的控制域。 nb_frames:流内的帧数目。 r_frame_rate/framerate/avg_frame_rate:帧率相关。 codec:指向该流对应的 AVCodecContext 结构,调用 avformat_open_input 时生成。 parser:指向该流对应的 AVCodecParserContext 结构,调用 avformat_find_stream_info 时生成。。

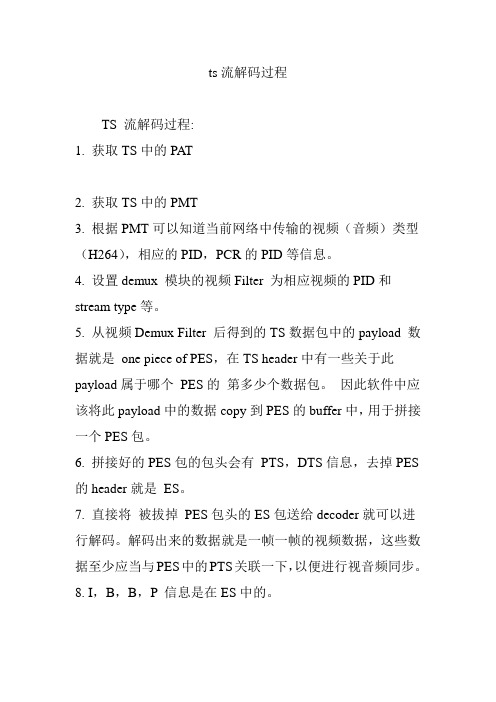

ts流解码过程

ts流解码过程TS 流解码过程:1. 获取TS中的PAT2. 获取TS中的PMT3. 根据PMT可以知道当前网络中传输的视频(音频)类型(H264),相应的PID,PCR的PID等信息。

4. 设置demux 模块的视频Filter 为相应视频的PID和stream type等。

5. 从视频Demux Filter 后得到的TS数据包中的payload 数据就是one piece of PES,在TS header中有一些关于此payload属于哪个PES的第多少个数据包。

因此软件中应该将此payload中的数据copy到PES的buffer中,用于拼接一个PES包。

6. 拼接好的PES包的包头会有PTS,DTS信息,去掉PES 的header就是ES。

7. 直接将被拔掉PES包头的ES包送给decoder就可以进行解码。

解码出来的数据就是一帧一帧的视频数据,这些数据至少应当与PES中的PTS关联一下,以便进行视音频同步。

8. I,B,B,P 信息是在ES中的。

ES是直接从编码器出来的数据流,可以是编码过的视频数据流,音频数据流,或其他编码数据流的统称。

ES流经过PES 打包器之后,被转换成PES包。

PES包由包头和payload组成.在PES层,主要是在PES包头信息中加入PTS(显示时间标签)和DTS(解码时间标签)用于视频、音频同步。

其实,Mpeg-2用于视音频同步以及系统时钟恢复的时间标签分别在ES,PES和TS这3个层次中。

在ES层,与同步有关的主要是视频缓冲验证VBV(VideoBuffer Verifier),用以防止解码器的缓冲器出现上溢或下溢;在PES层,主要是在PES头信息里出现的显示时间标签PTS (PresentationTime Stamp)和解码时间标签DTS(Decoding Time Stamp);在TS层中,TS头信息包含了节目时钟参考PCR(Program Clock Reference),用于恢复出与编码端一致的系统时序时钟STC(System Time Clock)。

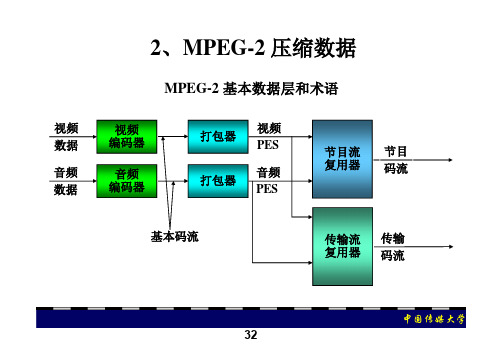

第四讲MPEG2压缩数字视频码流(二)

节目关联表 - PAT PID 0

Prog 0 Prog 1 Prog 2 PID16 PID 20 PID 30

中国传媒大学

43

2、视频编码时PCR值的产生和插入过程

计数器1 Base Clock 提取的 参考时钟 27MHz±5Hz 计数器2 Clock Extension 视频PES流 码率 控制 输出TS流比特率参 考时钟(独立于各 视频信号时钟)

数字 视频

10bit to 8bit 或422 to 420

52

1、PAT

• PAT表由PID为0x0000的TS包传送,它的作用 是为复用的每一路传送流提供出所包含的节目 和节目编号,以及对应节目的节目映射表 (PMT)的位置,即PMT的TS包的包标识符 (PID)的值,同时还提供网络信息表(NIT) 的位置,即NIT的TS包的包标识符(PID)的 值。

中国传媒大学

57

CAT结构

Table id Section syntax indicator 0 section length reserved version number current next Indicator section number Last section number N loop

– 节目关联表Program Association Table (PAT) – 节目映射表Program Map Tables (PMT) – 条件接收表Conditional Access Table (CAT) – 网络信息表Network Information Table (NIT)

中国传媒大学

6、节目时间基准和传输码率关系

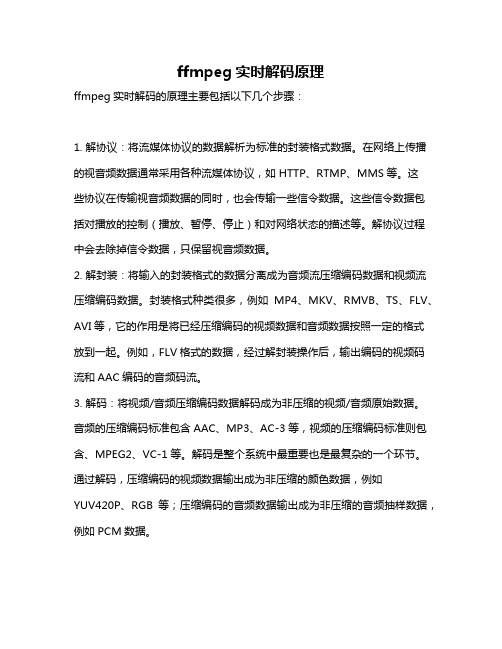

ffmpeg实时解码原理

ffmpeg实时解码原理

ffmpeg实时解码的原理主要包括以下几个步骤:

1. 解协议:将流媒体协议的数据解析为标准的封装格式数据。

在网络上传播的视音频数据通常采用各种流媒体协议,如HTTP、RTMP、MMS等。

这

些协议在传输视音频数据的同时,也会传输一些信令数据。

这些信令数据包括对播放的控制(播放、暂停、停止)和对网络状态的描述等。

解协议过程中会去除掉信令数据,只保留视音频数据。

2. 解封装:将输入的封装格式的数据分离成为音频流压缩编码数据和视频流压缩编码数据。

封装格式种类很多,例如MP4、MKV、RMVB、TS、FLV、AVI等,它的作用是将已经压缩编码的视频数据和音频数据按照一定的格式放到一起。

例如,FLV格式的数据,经过解封装操作后,输出编码的视频码流和AAC编码的音频码流。

3. 解码:将视频/音频压缩编码数据解码成为非压缩的视频/音频原始数据。

音频的压缩编码标准包含AAC、MP3、AC-3等,视频的压缩编码标准则包含、MPEG2、VC-1等。

解码是整个系统中最重要也是最复杂的一个环节。

通过解码,压缩编码的视频数据输出成为非压缩的颜色数据,例如

YUV420P、RGB等;压缩编码的音频数据输出成为非压缩的音频抽样数据,例如PCM数据。

4. 视音频同步:根据解封装模块处理过程中获取到的参数信息,同步解码出来的视频和音频数据,并将视频音频数据送至系统的显卡和声卡播放出来。

以上信息仅供参考,如需了解ffmpeg实时解码原理的更多信息,建议查阅ffmpeg相关书籍或咨询专业人士。

如何播放M2TS文件

如何播放M2TS文件

方案一:退出播放器,启动设置中心,在“解码模式”中选择“视频编码”→去掉“自动模式”的勾→主播放器改为“The KMPlayer”→把“A VI分离器”设为“KMP内置”→把“MPEG2 TS/PS分离器”改为“Gabest”→把“H.264视频解码器”改为“CoreA VC”→把“音频解码器&输出”第一框改为“FFDShow”,第二框改为“2.1立体声”(使用音响不同设置不同)→点击“VC-1视频解码器”对应的“配置”→把“WMV硬件加速”的勾打上,设为“禁用”→确定→确定。

方案二:退出播放器,启动设置中心,在“解码模式”中选择“影音播放HDTV(PowerDVD DXV A)”→去掉“自动模式”的勾→把“MPEG2 TS/PS分离器”改为“Gabest”→把“H.264视频解码器”改为“CoreA VC”→把“音频解码器&输出”第一框改为“FFDShow”,第二框改为“2.1立体声”→应用→点击“VC-1视频解码器”对应的“配置”→把“WMV硬件加速”的勾打上,设为“禁用”→确定→确定。

以上两种方案可以完美播放蓝光原盘文件msts,画面效果好,流畅,音色好。

暂时没有发现什么问题。

此外这两种方案能够通杀各种格式,测试了多种格式的视频文件(TS、TP、M2TS、EVO、MPG、A VI、WMV、MKV、MOV、RMVB、RM……)无问题。

PS:关于ISO蓝光文件如何提取出来,我唠叨下,使用daemon4123以上的版本都是可以的,其他的没有测试,只是要多安装v2.5以上的UDF.Reader。

ffmpeg 硬件解码命令行参数

ffmpeg 硬件解码命令行参数

要使用FFmpeg进行硬件解码,你需要使用特定的命令行参数来

指定硬件解码器。

在大多数情况下,硬件解码通常是通过显卡的

GPU来实现的。

以下是一些常见的命令行参数示例:

1. 使用CUDA进行硬件解码:

bash.

ffmpeg -hwaccel cuda -i input.mp4 output.mp4。

这个命令使用CUDA进行硬件加速解码,输入文件是input.mp4,输出文件是output.mp4。

2. 使用OpenMAX进行硬件解码:

bash.

ffmpeg -c:v h264_omx -i input.mp4 -c:a copy output.mp4。

这个命令使用OpenMAX进行H.264视频的硬件解码,同时保持音频流不变,输入文件是input.mp4,输出文件是output.mp4。

3. 使用VAAPI进行硬件解码:

bash.

ffmpeg -vaapi_device /dev/dri/renderD128 -i input.mp4 -vf 'format=nv12,hwupload' -c:v h264_vaapi -b:v 5M -c:a copy output.mp4。

这个命令使用VAAPI进行H.264视频的硬件解码,并指定了输出的视频码率为5M,输入文件是input.mp4,输出文件是

output.mp4。

这些只是一些常见的示例,实际上硬件解码的命令行参数可能会因系统环境、硬件设备和FFmpeg版本而有所不同。

在使用硬件解码时,建议查阅FFmpeg官方文档以获取最新的命令行参数信息,并根据具体情况进行调整。

ffmpeg编解码流程

FFmpeg编解码流程一、简介FFmpeg是一个开源跨平台的音视频处理工具,它提供了一套完整的音视频编解码解决方案。

本文将深入探讨FFmpeg的编解码流程,重点介绍其原理和各个步骤。

二、FFmpeg编解码流程概述FFmpeg的编解码过程可以分为以下几个步骤: 1. 读取输入文件 2. 解封装 3. 视频/音频解码 4. 音视频处理 5. 视频/音频编码 6. 封装输出文件下面将逐一介绍每个步骤的具体内容。

2.1 读取输入文件编解码过程的第一步是读取输入文件。

FFmpeg支持多种音视频格式,可以通过指定输入格式来读取不同类型的文件。

通过读取输入文件,FFmpeg可以获取到音视频的基本信息。

2.2 解封装解封装是将输入文件中的音视频数据提取出来的过程。

FFmpeg支持各种常见的封装格式,如AVI、MP4、FLV等。

解封装的目的是将音视频数据从封装格式中分离出来,方便后续的解码和处理。

2.3 视频/音频解码解码是将音视频数据从原始的二进制数据转换为可读取的格式的过程。

FFmpeg支持的视频解码器包括H.264、H.265、MPEG-4等,音频解码器包括AAC、MP3、WAV 等。

解码过程中,FFmpeg将原始数据解析成具体的像素、采样等信息,以供后续处理使用。

2.4 音视频处理音视频处理是对解码后的音视频数据进行各种处理操作的过程。

包括视频的裁剪、旋转、缩放、滤镜效果的添加等,音频的混音、音量调整、变速变调等。

FFmpeg 提供了丰富的滤镜效果和处理函数,可以满足各种需求。

2.5 视频/音频编码编码是将处理后的音视频数据重新转换为压缩格式的二进制数据的过程。

FFmpeg 支持的视频编码器包括H.264、H.265、MPEG-4等,音频编码器包括AAC、MP3、WAV等。

编码过程中,FFmpeg将处理后的音视频数据压缩成较小的体积,减少文件的大小。

2.6 封装输出文件封装输出文件是将编码后的音视频数据重新封装为指定格式的文件的过程。

ffmpeg ts名称获得的参数

一、引言在视频处理中,使用ffmpeg工具可以完成各种复杂的任务,而ts流媒体是常见的视频格式之一。

在使用ffmpeg处理ts流媒体时,需要获取一些参数进行设置,以实现对视频的操作和处理。

本文将就ffmpeg获取ts流媒体名称的参数进行详细介绍,方便读者在使用ffmpeg工具时能够准确获取所需的参数,从而更好地完成视频处理任务。

二、ts流媒体格式介绍1. ts流媒体格式是一种常见的视频传输格式,常用于网络视频的传输和播放。

2. ts格式的特点是可以将视频数据和音频数据进行分离,并且支持多种编码格式和多路复用。

三、ffmpeg工具简介1. ffmpeg是一款开源的跨评台多媒体处理工具,可以用于对音频、视频等多媒体数据进行编解码、转换、处理等操作。

2. 使用ffmpeg工具可以对多种格式的音视频文件进行处理,并且支持丰富的参数设置和功能扩展。

四、获取ts流媒体名称的参数在使用ffmpeg处理ts流媒体时,需要获取一些参数进行设置,以便于对视频进行操作和处理。

以下是获取ts流媒体名称的参数的方法:1. 使用ffprobe工具ffprobe是ffmpeg工具中用于查看多媒体文件信息的工具,可以用于获取ts流媒体文件的名称参数。

命令格式如下:```shellffprobe -show_streams -print_format json {ts流媒体文件名}```执行以上命令可以获取ts流媒体文件中的多路流信息,包括名称参数。

2. 使用ffmpeg工具ffmpeg工具本身也可以用于获取ts流媒体文件的名称参数,具体命令如下:```shellffmpeg -i {ts流媒体文件名}```执行以上命令可以获取ts流媒体文件中的音视频流信息,包括名称参数。

3. 解析输出信息在获取ts流媒体文件的名称参数后,需要进行输出信息的解析,以便于获取所需的参数。

使用json解析工具可以将ffprobe或ffmpeg命令的输出结果进行解析,从而获取ts流媒体文件的名称参数。

ffmpeg解码编码时间基转换

ffmpeg解码编码时间基转换介绍在音视频处理领域,ffmpeg是一个非常强大的工具,可以用于解码、编码、转换、编辑等多种操作。

其中,时间基转换是一个常见的需求,可以通过ffmpeg来实现。

本文将详细介绍ffmpeg解码编码时间基转换的原理、步骤和常见应用场景。

原理在音视频处理中,时间基是非常重要的概念。

时间基指的是对时间的度量单位,常见的时间基有时钟时间、帧率等。

不同的时间基之间可能存在不一致的情况,这就需要进行时间基的转换。

ffmpeg解码编码时间基转换的原理主要包括以下几个步骤: 1. 解码:将原始的音视频文件进行解码,获取其中的音频流和视频流。

2. 时间基转换:根据需要转换的时间基,对音频流和视频流中的时间戳进行转换。

3. 编码:将转换后的音频流和视频流进行编码,生成新的音视频文件。

步骤下面将详细介绍ffmpeg解码编码时间基转换的步骤:步骤一:解码1.使用ffmpeg命令行工具,输入以下命令进行解码:ffmpeg -i input.mp4 -c:v copy -c:a copy output.mkv其中,input.mp4为原始的音视频文件,output.mkv为解码后的音视频文件。

步骤二:时间基转换1.使用ffmpeg命令行工具,输入以下命令进行时间基转换:ffmpeg -i input.mkv -vf setpts=PTS/1.5 -af atempo=1.5 output.mkv其中,input.mkv为解码后的音视频文件,output.mkv为转换后的音视频文件。

2. 在上述命令中,setpts=PTS/1.5表示将视频流的时间戳除以1.5,实现时间基的转换;atempo=1.5表示将音频流的时间戳除以1.5,实现时间基的转换。

步骤三:编码1.使用ffmpeg命令行工具,输入以下命令进行编码:ffmpeg -i input.mkv -c:v libx264 -c:a aac output.mp4其中,input.mkv为转换后的音视频文件,output.mp4为编码后的音视频文件。

MPEG-2传输流及PSI信息的解析

MPEG-2传输流及其PSI信息的解析在数字电视业务中,为了节约带宽资源,常常将不同的节目复用到一个信道上,并且,为了在容易发生错误的信道上进行可靠的传输,复用后的数据流称为传输流;终端在收到其中的某套节目时,必须从码流中对该节目进行提取,即在解码端必须对传输流进行解复用。

如果在传输流中不包含引导信息,由于传输流存在多套节目,数字电视终端设备将无法正确找到需要解码的信息,从而不能正确解码。

针对这一问题,MPEG2专门定义了节目专用信息PSI(Program Specific Information),它的作用是自动设置和引导终端设备进行解码。

这就需要在前端向传输流TS(Transport Stream)中进行PSI信息的复用,并用特定的包标识符(PID)进行标识。

本文就传输流TS的组成及其PSI信息进行了解析,重点对PSI信息的组成及功能进行了说明,并对终端如何利用PSI信息进行自动解码进行了阐述。

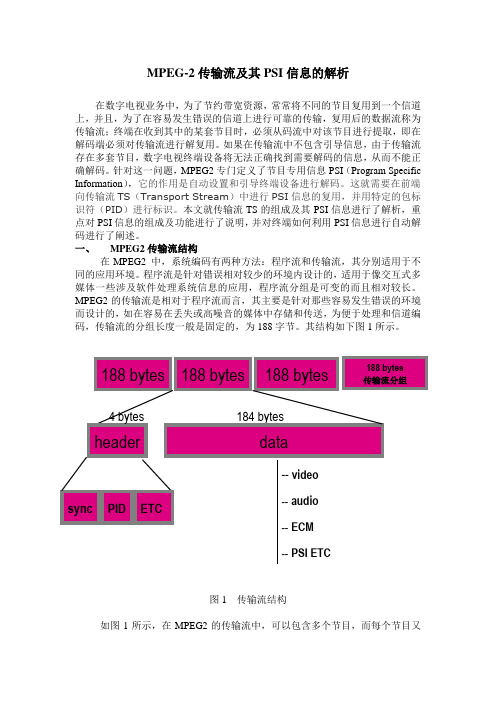

一、MPEG2传输流结构在MPEG2 中,系统编码有两种方法:程序流和传输流,其分别适用于不同的应用环境。

程序流是针对错误相对较少的环境内设计的,适用于像交互式多媒体一些涉及软件处理系统信息的应用,程序流分组是可变的而且相对较长。

MPEG2的传输流是相对于程序流而言,其主要是针对那些容易发生错误的环境而设计的,如在容易在丢失或高噪音的媒体中存储和传送,为便于处理和信道编码,传输流的分组长度一般是固定的,为188字节。

其结构如下图1所示。

图1 传输流结构如图1所示,在MPEG2的传输流中,可以包含多个节目,而每个节目又是由多个基本码流(如视频、音频、数据等)组成,基本码流、PSI信息及其他控制数据都被打成固定长度的包分组,这些数据流分组的区分都是通过PID (packet ID)来区分的。

传输流的实例可如图2表示。

TS流实例图2 传输流实例图中,PAT,PMT,NIT,CAT为PSI信息,下面将进行说明,而VIDEO,AUDIO则为视、音频传输流,ECM(Entitlement Control Message)、EMM (Entitlement Management Massage)为授权信息,用于对视音频数据的解扰。

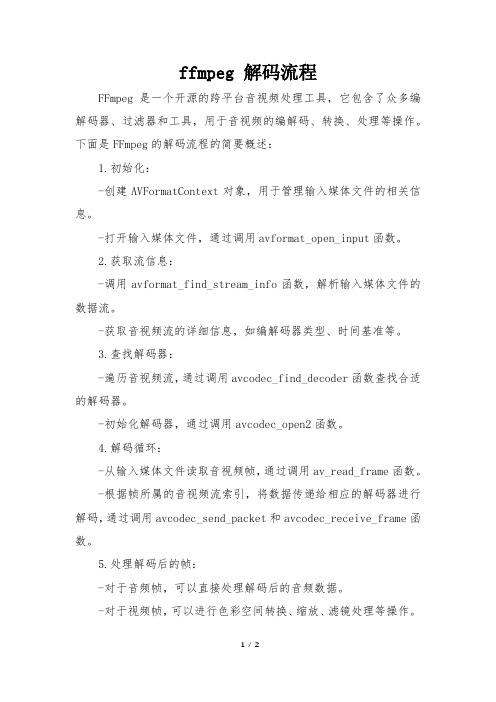

ffmpeg 解码流程

ffmpeg 解码流程FFmpeg是一个开源的跨平台音视频处理工具,它包含了众多编解码器、过滤器和工具,用于音视频的编解码、转换、处理等操作。

下面是FFmpeg的解码流程的简要概述:1.初始化:-创建AVFormatContext对象,用于管理输入媒体文件的相关信息。

-打开输入媒体文件,通过调用avformat_open_input函数。

2.获取流信息:-调用avformat_find_stream_info函数,解析输入媒体文件的数据流。

-获取音视频流的详细信息,如编解码器类型、时间基准等。

3.查找解码器:-遍历音视频流,通过调用avcodec_find_decoder函数查找合适的解码器。

-初始化解码器,通过调用avcodec_open2函数。

4.解码循环:-从输入媒体文件读取音视频帧,通过调用av_read_frame函数。

-根据帧所属的音视频流索引,将数据传递给相应的解码器进行解码,通过调用avcodec_send_packet和avcodec_receive_frame函数。

5.处理解码后的帧:-对于音频帧,可以直接处理解码后的音频数据。

-对于视频帧,可以进行色彩空间转换、缩放、滤镜处理等操作。

6.清理:-释放解码器资源,通过调用avcodec_close函数。

-关闭输入媒体文件,通过调用avformat_close_input函数。

-释放相关的内存空间。

以上是FFmpeg解码流程的基本步骤。

实际应用中,可能会涉及更多的细节和处理步骤,如处理音视频同步、处理字幕、音频重采样等。

具体的解码流程和操作可根据需求和具体情况进行调整和扩展。

ts流 标准 -回复

ts流标准-回复什么是TS流(Transport Stream)?如何实现TS流的传输和播放?如今TS流在数字视频广播和流媒体传输中有何应用?接下来,我们将一步一步回答这些问题。

TS流(Transport Stream)是一种用于数字视频广播和流媒体传输的标准流媒体格式。

它是MPEG-2标准中定义的一种封装格式,用于将视频、音频和其他元数据按照特定的规则打包成一系列的数据包,以进行高效的传输和播放。

首先,我们需要了解TS流的基本结构和特点。

TS流采用分层和多路复用的方式来组织数据。

它由多个PID(Packet Identifier)所对应的数据包组成,每个PID可以承载不同类型(如视频、音频、字幕等)的数据。

这种分层结构使得TS流可以同时传输、解码和显示多路音视频流。

为了实现TS流的传输和播放,需要使用一些特定的工具和协议。

首先,需要一个流媒体服务器来提供TS流的分发和传输。

常用的流媒体服务器软件包括Wowza、Kurento、NGINX等。

这些服务器软件可以根据客户端的请求,向其发送相应的TS流数据。

在传输层,TS流一般使用TCP或UDP协议进行传输。

TCP协议可提供可靠的数据传输,适用于对数据完整性要求较高的场景;而UDP协议则提供了更低的延迟和更高的传输效率,适用于实时性要求较高的场景。

在播放端,需要使用支持TS流的播放器来解析和显示数据。

常见的TS流播放器有VLC、FFmpeg、Windows Media Player等。

这些播放器能够将接收到的TS流进行解封装,并按照其中的PID进行数据提取和解码。

然后,根据需要将视频画面和音频声音同步输出到屏幕和音箱上,实现完整的播放效果。

TS流在数字视频广播和流媒体传输中有着广泛的应用。

在数字电视广播领域,TS流被用于将多路电视频道同时通过有线或无线传输到电视机上。

利用TS流的分层和多路复用特点,可以在一个通道内传输多个节目,大大提高了频谱利用率。

mpeg的工作原理

mpeg的工作原理MPEG的工作原理MPEG(Moving Picture Experts Group)是一种常用的视频压缩标准,旨在实现高效的视频压缩和传输。

MPEG的工作原理可以分为三个主要步骤:视频编码、视频传输和视频解码。

1. 视频编码视频编码是将原始视频信号转换为压缩格式的过程。

在编码过程中,MPEG使用了一系列的算法和技术来减少视频数据的冗余和不必要的信息,从而实现高效的压缩。

首先,MPEG对视频进行空间预处理,将连续的图像分成不同的图像块,并对每个块进行分析和变换。

然后,MPEG使用离散余弦变换(DCT)来提取每个图像块的频域特征。

接下来,MPEG使用运动估计技术来检测图像中的运动部分,并将其表示为运动矢量。

最后,MPEG使用熵编码技术将图像块的频域特征和运动矢量进行编码,并生成最终的压缩视频数据。

2. 视频传输视频传输是指将压缩后的视频数据传输到接收端的过程。

在传输过程中,MPEG使用了一种称为帧间编码的技术来减少视频数据的传输量。

帧间编码是指将连续的视频帧之间的差异进行编码和传输的方法。

具体而言,MPEG将每个视频帧分为关键帧(I帧)和预测帧(P 帧)。

关键帧是完整的图像帧,而预测帧只包含与前一帧之间的差异。

通过传输较少的预测帧和更多的差异信息,MPEG能够在保持视频质量的同时减少传输带宽。

3. 视频解码视频解码是指将接收到的压缩视频数据转换回原始视频信号的过程。

在解码过程中,MPEG使用解码器来还原压缩视频数据。

首先,解码器对接收到的压缩视频数据进行解码,将频域特征和运动矢量恢复为图像块。

然后,解码器使用逆离散余弦变换(IDCT)将频域特征转换为时域特征,从而得到还原的图像块。

接下来,解码器使用运动补偿技术将预测帧与关键帧进行合成,生成完整的视频帧。

最后,解码器将所有视频帧按照正确的顺序组合起来,生成最终的解码视频。

总结起来,MPEG的工作原理是通过视频编码、视频传输和视频解码三个步骤实现高效的视频压缩和传输。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

在这也可以看到,FFmpeg 支持的 protocol 有:

/* protocols */

REGISTER_PROTOCOL (FILE, file);

REGISTER_PROTOCOL (HTTP, http);

REGISTER_PROTOCOL (PIPE, pipe);

REGISTER_PROTOCOL (RTP, rtp);

REGISTER_PROTOCOL (TCP, tcp);

REGISTER_PROTOCOL (UDP, udp); 而大部分情况下,如果你不指明类似 file://xxx,http://xxx 格 式,它都以 FILE protocol 来处理。

[liavformat/avio.c] int url_open(URLContext **puc, const char *filename, int flags) {

return err; err = url_fdopen(s, h); if (err < 0) {

url_close(h); return err; } return 0; }

可以看到,下面的这个函数,先查找是否是 FFmpeg 支持的 protocol 的格式,如果文件 名不符合,则默认是 FILE protocol 格式,很显然,这里 protocol 判断是以 URL 的方式判读 的,因此基本上所有的 IO 接口函数都是 url_xxx 的形式。

AVInputFormat *fmt, int buf_size, AVFormatParameters *ap) { int err, probe_size; AVProbeData probe_data, *pd = &probe_data; ByteIOContext *pb = NULL; pd->filename = ""; if (filename) pd->filename = filename; pd->buf = NULL; pd->buf_size = 0; ######################################################################### 【1】这段代码其实是为了针对不需要 Open 文件的容器 Format 的探测,其实就是使用 AVFMT_NOFILE 标记的容器格式单独处理,现在只有使用了该标记的 Demuxer 很少, 只有 image2_demuxer,rtsp_demuxer,因此我们分析 TS 时候可以不考虑这部分 ######################################################################### if (!fmt) { /* guess format if no file can be opened */ fmt = av_probe_input_format(pd, 0); } /* Do not open file if the format does not need it. XXX: specific hack needed to handle RTSP/TCP */ if (!fmt || !(fmt->flags & AVFMT_NOFILE)) { /* if no file needed do not try to open one */ ##################################################################### 【2】这个函数似乎很好理解,无非是带缓冲的 IO 的封装,不过我们既然到此了 ,不妨跟踪下去,看看别人对带缓冲的 IO 操作封装的实现:) ##################################################################### if ((err=url_fopen(&pb, filename, URL_RDONLY)) < 0) { goto fail; } if (buf_size > 0) { url_setbufsize(pb, buf_size); } for(probe_size= PROBE_BUF_MIN; probe_size<=PROBE_BUF_MAX && !fmt; probe_size<<=1){ int score= probe_size < PROBE_BUF_MAX ? AVPROBE_SCORE_MAX/4 : 0; /* read probe data */ pd->buf= av_realloc(pd->buf, probe_size + AVPROBE_PADDING_SIZE); ################################################################## 【3】真正将文件读入到 pd 的 buffer 的地方,实际上最终调用 FILE protocol 的 file_read(),将内容读入到 pd 的 buf,具体代码如果有兴趣可以自己跟踪 ################################################################## pd->buf_size = get_buffer(pb, pd->buf, probe_size); memset(pd->buf+pd->buf_size, 0, AVPROBE_PADDING_SIZE); if (url_fseek(pb, 0, SEEK_SET) < 0) { url_fclose(pb); if (url_fopen(&pb, filename, URL_RDONLY) < 0) { pb = NULL; err = AVERROR(EIO); goto fail; } } ################################################################## 【4】此时的 pd 已经有了需要分析的原始文件,只需要查找相应容器 format 的 Tag 比较,以判断读入的究竟为什么容器格式,这里 ################################################################## /* guess file format */ fmt = av_probe_input_format2(pd, 1, &score); } av_freep(&pd->buf); } /* if still no format found, error */ if (!fmt) {

一、 FFMPEG 中 MPEG2 TS 流解码的流程分析

说道具体的音频或者视频格式,一上来就是理论,那是国内混资历的所谓教授的做为, 对于我们,不合适,还是用自己的方式理解这些晦涩不已的理论吧。

其实 MPEG2 是一族协议,至少已经成为 ISO 标准的就有以下几部分: ISO/IEC-13818-1:系统部分; ISO/IEC-13818-2: 视频编码格式; ISO/IEC-13818-3:音频编码格式; ISO/IEC-13818-4:一致性测试; ISO/IEC-13818-5: 软件部分; ISO/IEC-13818-6:数字存储媒体命令与控制; ISO/IEC-13818-7:高级音频编码; ISO/IEC-13818-8: 系统解码实时接口; 我不是很想说实际的音视频编码格式,毕竟协议已经很清楚了,我主要想说说这些部分 怎么组合起来在实际应用中工作的。 第一部分(系统部分)很重要,是构成以 MPEG2 为基础的应用的基础. 很绕口,是吧, 我简单解释一下:比如 DVD 实际上是以系统部分定义 的 PS 流为基础,加上版权管理等其 他技术构成的。而我们的故事主角,则是另外一种流格式,TS 流,它在现阶段最大的应用 是在数字电视节目 的传输与存储上,因此,你可以理解 TS 实际上是一种传输协议,与实 际传输的负载关系不大,只是在 TS 中传输了音频,视频或者其他数据。先说一下为什么会 有这两种格式的出现,PS 适用于没有损耗的环境下面存储,而 TS 则适用于可能出现损耗或 者错误的各种物理网络环境,比如你 在公交上看到的电视,很有可能就是基于 TS 的 DVB-T 的应用:) 我们再来看 MPEG2 协议中的一些概念,为理解代码做好功课: l ES(Elementary Stream): wiki 上说“An elementary stream (ES) is defined by MPEG communication protocol is usually the output of an audio or video encoder” 恩,很简单吧,就是编码器编出的一组数据,可能是音频的,视频的,或者其他数据。 说到着,其实可以对编码器的流程思考一下,无非是执行:采样,量化,编码这 3 个步骤中 的编码而已(有些设备可能会包含前面的采样和量化)。 关于视频编码的基本理论,还是请 参考其它的资料。 l PES(Packetized Elementary Stream): wiki 上说“allows an Elementary stream to be divided into packets” 其实可以理解成,把一个源源不断的数据(音频,视频或者其他)流,打断成 一段一段, 以便处理. l TS(Transport Stream): l PS(Program Stream): 这两个上面已经有所提及,后面会详细分析 TS,我对 PS 格式兴趣不大. 步入正题 才进入正题,恩,看来闲话太多了:(,直接看 Code. 前面说过,TS 是一种传输协议,因此,对应到 FFmpeg,可以认为他是一种封装格式。