Eclipse中编译运行Hadoop-0.20.1源码

Hadoop eclipse-plugin编译方法

Hadoop eclipse-plugin编译方法在Hadoop程序目录下的src/contrib目录下有一个eclipse-plugin项目,其为Hadoop在eclipse中的插件。

在新版的Hadoop中,已经不再编译好,而需要用户根据自己的eclipse版本自行编译。

该项目使用Ant及Ivy构建,其包含build.xml、ivy.xml及plugin.xml配置文件。

以下详细描述在eclipse中编译插件的方法。

1、新建一个workspace,将Hadoop程序全部拷贝到该workspace2、点击File->Import,选择Existing Projects To Workspace,选择该workspace目录进行搜索,会找到MapReduceTools项目,点击导入3、右键MapReduceTools项目,点击Propertites,选择Builder,点击New,选择AntBuilder,勾选选择后的builder,将java builder的勾取消。

4、修改build.xml,为如下内容<?xml version="1.0" encoding="UTF-8" standalone="no"?><project default="jar"name="eclipse-plugin"><import file="../build-contrib.xml"/><path id="eclipse-sdk-jars"><fileset dir="${eclipse.home}/plugins/"><include name="org.eclipse.ui*.jar"/><include name="org.eclipse.jdt*.jar"/><include name="org.eclipse.core*.jar"/><include name="org.eclipse.equinox*.jar"/><include name="org.eclipse.debug*.jar"/><include name="org.eclipse.osgi*.jar"/><include name="org.eclipse.swt*.jar"/><include name="org.eclipse.jface*.jar"/><include name="org.eclipse.team.cvs.ssh2*.jar"/><include name="com.jcraft.jsch*.jar"/></fileset></path><!-- Override classpath to include Eclipse SDK jars --><path id="classpath"><pathelement location="${build.classes}"/><pathelement location="${hadoop.root}/build/classes"/><path refid="eclipse-sdk-jars"/></path><!-- Skip building if eclipse.home is unset. --><target name="check-contrib"unless="eclipse.home"><property name="skip.contrib"value="yes"/><echo message="eclipse.home unset: skipping eclipse plugin"/> </target><target name="compile"depends="init, ivy-retrieve-common" unless="skip.contrib"><echo message="contrib: ${name}"/><javacencoding="${build.encoding}"srcdir="${src.dir}"includes="**/*.java"destdir="${build.classes}"debug="${javac.debug}"deprecation="${javac.deprecation}"><classpath refid="classpath"/></javac></target><!-- Override jar target to specify manifest --><target name="jar"depends="compile"unless="skip.contrib"><mkdir dir="${build.dir}/lib"/><copy file="${hadoop.root}/hadoop-core-${version}.jar"tofile="${build.dir}/lib/hadoop-core.jar"verbose="true"/><copy file="${hadoop.root}/lib/commons-cli-${commons-cli.version}.jar" todir="${build.dir}/lib"verbose="true"/><jarjarfile="${build.dir}/hadoop-${name}-${version}.jar"manifest="${root}/META-INF/MANIFEST.MF"><fileset dir="${build.dir}"includes="classes/ lib/"/><fileset dir="${root}"includes="resources/ plugin.xml"/></jar></target></project>5、编辑Ant Builder运行参数右键MapReduceTools项目,点击Propertites,选择Builder,选中AntBuilder,点击Edit,编辑参数如下:-Declipse.home=E:\eclipse -Dversion=1.0.0-Dbuild.dir=E:\CloudProject\hadoop-1.0.0\src\contrib\eclipse-plugin(路径以自己为主)如图:。

eclipse hadoop开发环境配置

eclipse hadoop开发环境配置win7下安装hadoop完成后,接下来就是eclipse hadoop开发环境配置了。

具体的操作如下:一、在eclipse下安装开发hadoop程序的插件安装这个插件很简单,haoop-0.20.2自带一个eclipse的插件,在hadoop目录下的contrib\eclipse-plugin\hadoop-0.20.2-eclipse-plugin.jar,把这个文件copy到eclipse的eclipse\plugins目录下,然后启动eclipse就算完成安装了。

这里说明一下,haoop-0.20.2自带的eclipse的插件只能安装在eclipse 3.3上才有反应,而在eclipse 3.7上运行hadoop程序是没有反应的,所以要针对eclipse 3.7重新编译插件。

另外简单的解决办法是下载第三方编译的eclipse插件,下载地址为:/p/hadoop-eclipse-plugin/downloads/list由于我用的是Hadoop-0.20.2,所以下载hadoop-0.20.3-dev-eclipse-plugin.jar.然后将hadoop-0.20.3-dev-eclipse-plugin.jar重命名为hadoop-0.20.2-eclipse-plugin.jar,把它copy到eclipse的eclipse\plugins目录下,然后启动eclipse完成安装。

安装成功之后的标志如图:1、在左边的project explorer 上头会有一个DFS locations的标志2、在windows -> preferences里面会多一个hadoop map/reduce的选项,选中这个选项,然后右边,把下载的hadoop根目录选中如果能看到以上两点说明安装成功了。

二、插件安装后,配置连接参数插件装完了,启动hadoop,然后就可以建一个hadoop连接了,就相当于eclipse里配置一个weblogic的连接。

eclipse开发hadoop程序

hadoop Map/Reduce开发实例1) Eclipse插件配置与程序开发在windows下开发Map/Readuce程序,首先要在windows安装cygwin,目的是让hadoop在执行过程中可以用到linux下的一些shell命令,sygwin则给window装了一个linux外壳。

配置eclipse及运行程序具体步骤如下:1. 安装cygwin步骤略过(网上安装步骤很多,因为不是此篇文章重点,不再赘述)但值得注意的在安装过程中一定要安装以下部分(1). net下的openssh和openssl,base下的sed,devel下的subversion(2). 设置环境变量path,需要设置 Cygwin 的bin 目录,具体是否需要设置 Cygwin 的usr\bin 目录还不是很确定,但本人设置了提示:cygwin安装完成后会有cygwin ssd服务在windows服务中,可以启动也可以不启动。

2. 下载并安装hadoop,(本人使用hadoop0.20.2版本)下载:/dyn/closer.cgi/hadoop/core/安装:即将hadoop-0.20.2.tar.gz解压即可2. 下载并安装hadoop eclipse插件(1)下载插件:https:///jira/browse/MAPREDUCE-1280(注意:此hadoop-eclipse-plugin-0.20.3-SNAPSHOT.jar插件支持eclipse3.4+,hadoop0.20.2目录 hadoop-0.20.2\contrib\eclipse-plugin中的插件只支持到eclipse3.3版本,版本不支持的话,导致插件不能正常使用。

)(2). 将插件拷贝到eclipse的plugins目录中(使用其他方法装载插件也可以),启动eclipse(3). 配置插件a.打开eclipse -->window->open prespective,可见并打开“ Map/Reduce ” 视图,如图:b. 打开eclipse -->window->show view, 可见并打开MapReduce tool --> Map/Reduce locations ,点击新建locations,视图如下:General选项卡各个参数说明:Location name:本地视图的location名称,自己自定义一个名称即可Map/Reduce Master组内host和port: 为Map/Reduce Master的地址与端口号,此地址端口与hadoop服务器安装配置过程中conf/mapred-site.xml文件中mapred.job.tracker节点值一致。

如何使用Eclipse编译Hadoop 源代码

如何使用Eclipse编译Hadoop 源代码1. 下载Hadoop 源代码目录下包括了很多非源代码文件,很庞大,导致需要很长的check-out 时间。

2. 准备编译环境2.1. Hadoop 代码版本本教程所采用的Hadoop 是北京时间2009-8-26 日上午下载的源代码,和hadoop-0.19.x 版本的差异可能较大。

2.2. 联网编译Hadoop 会依赖很多第三方库,但编译工具Ant 会自动从网上下载缺少的库,所以必须保证机器能够访问Internet。

2.3.java编译Hadoop 要用JDK1.6 以上,安装好之后,请设置好JAVA_HOME 环境变量。

2.4.Ant 和Cygwin需要使用Ant 工具来编译Hadoop,而Ant 需要使用到Cygwin 提供的一些工具,如sed 等,下载Ant,下载Cygwin(Cygwin 的安装,请参考《在Windows 上安装Hadoop 教程》一文)。

安装好之后,需要将Ant 和Cygwin 的bin 目录加入到环境变量PATH 中,如下图所示:注意:在安装Cygwin 时,建议将SVN 安装上,因为在Ant 编译过程中会通过SVN 下载些文件,但这个不是必须的,下载不成功时,并未见出错,编译仍然可以成功。

2.5.Eclipse3.编译Hadoop在这里,我们以编译Hadoop 家庭成员common 为例,对Hadoop 其它成员的编译方法是类似的。

3.1.编译common 成员步骤 1) 在Elipse 的Package 视图中单击右键,选择New->Java Project,如下图所示:步骤 2) 选择源代码目录,设置Project 名。

在上图所示的对话框中,点击Browse 按钮,选择common 源代码目录,并设置Project name 为common。

工程导入完成后,进入Eclipse 主界面,可以看到common 已经导入进来,但可以看到common 上有红叉叉,是因为Elipse 默认使用了Java Builder,而不是Ant Builder,所以下一步就是设置使用Ant Builder。

hadoop搭建与eclipse开发环境设置--已验证通过

hadoop搭建与eclipse开发环境设置――刘刚1.Windows下eclipse开发环境配置1.1 安装开发hadoop插件将hadoop安装包hadoop\contrib\eclipse-plugin\hadoop-0.20.2-eclipse-plugin.jar拷贝到eclipse的插件目录plugins下。

需要注意的是插件版本(及后面开发导入的所有jar包)与运行的hadoop一致,否则可能会出现EOFException异常。

重启eclipse,打开windows->open perspective->other->map/reduce 可以看到map/reduce开发视图。

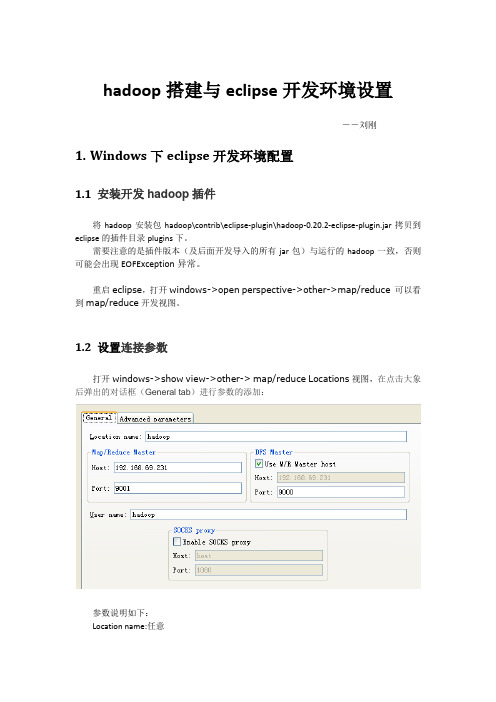

1.2 设置连接参数打开windows->show view->other-> map/reduce Locations视图,在点击大象后弹出的对话框(General tab)进行参数的添加:参数说明如下:Location name:任意map/reduce master:与mapred-site.xml里面mapred.job.tracker设置一致。

DFS master:与core-site.xml里设置一致。

User name: 服务器上运行hadoop服务的用户名。

然后是打开“Advanced parameters”设置面板,修改相应参数。

上面的参数填写以后,也会反映到这里相应的参数:主要关注下面几个参数::与core-site.xml里设置一致。

mapred.job.tracker:与mapred-site.xml里面mapred.job.tracker设置一致。

dfs.replication:与hdfs-site.xml里面的dfs.replication一致。

hadoop.tmp.dir:与core-site.xml里hadoop.tmp.dir设置一致。

hadoop.job.ugi:并不是设置用户名与密码。

hadoop搭建与eclipse开发环境设置

hadoop搭建与eclipse开发环境设置――罗利辉1.前言1.1 目标目的很简单,为进行研究与学习,部署一个hadoop运行环境,并搭建一个hadoop开发与测试环境。

具体目标是:✓在ubuntu系统上部署hadoop✓在windows 上能够使用eclipse连接ubuntu系统上部署的hadoop进行开发与测试1.2 软硬件要求注意:Hadoop版本和Eclipse版本请严格按照要求。

现在的hadoop最新版本是hadoop-0.20.203,我在windows上使用eclipse(包括3.6版本和3.3.2版本)连接ubuntu上的hadoop-0.20.203环境一直没有成功。

但是开发测试程序是没有问题的,不过需要注意权限问题。

如果要减少权限问题的发生,可以这样做:ubuntu上运行hadoop的用户与windows 上的用户一样。

1.3 环境拓扑图ubuntu 192.168.69.231ubuntu2192.168.69.233 ubuntu1192.168.69.2322.Ubuntu 安装安装ubuntu11.04 server系统,具体略。

我是先在虚拟机上安装一个操作系统,然后把hadoop也安装配置好了,再克隆二份,然后把主机名与IP修改,再进行主机之间的SSH配置。

如果仅作为hadoop的运行与开发环境,不需要安装太多的系统与网络服务,或者在需要的时候通过apt-get install进行安装。

不过SSH服务是必须的。

3.Hadoop 安装以下的hadoop安装以主机ubuntu下进行安装为例。

3.1 下载安装jdk1.6安装版本是:jdk-6u26-linux-i586.bin,我把它安装拷贝到:/opt/jdk1.6.0_263.2 下载解压hadoop安装包是:hadoop-0.20.2.tar.gz。

3.3 修改系统环境配置文件切换为根用户。

●修改地址解析文件/etc/hosts,加入3.4 修改hadoop的配置文件切换为hadoop用户。

基于Eclipse的Hadoop开发环境配置方法

基于Eclipse的Hadoop开发环境配置方法(1)启动hadoop守护进程在Terminal中输入如下命令:$ bin/hadoop namenode -format$ bin/start-all.sh(2)在Eclipse上安装Hadoop插件找到hadoop的安装路径,我的是hadoop-0.20.2,将/home/wenqisun/hadoop-0.20.2/contrib/eclipse-plugin/下的hadoop-0.20.2-eclipse-plugin.jar拷贝到eclipse安装目录下的plugins里,我的是在/home/wenqisun/eclipse /plugins/下。

然后重启eclipse,点击主菜单上的window-->preferences,在左边栏中找到Hadoop Map/Reduce,点击后在右边对话框里设置hadoop的安装路径即主目录,我的是/home/wenqisun/hadoop-0.20.2。

(3)配置Map/Reduce Locations在Window-->Show View中打开Map/Reduce Locations。

在Map/Reduce Locations中New一个Hadoop Location。

在打开的对话框中配置Location name(为任意的名字)。

配置Map/Reduce Master和DFS Master,这里的Host和Port要和已经配置的mapred-site.xml 和core-site.xml相一致。

一般情况下为Map/Reduce MasterHost:localhostPort:9001DFS MasterHost:localhostPort:9000配置完成后,点击Finish。

如配置成功,在DFS Locations中将显示出新配置的文件夹。

(4)新建项目创建一个MapReduce Project,点击eclipse主菜单上的File-->New-->Project,在弹出的对话框中选择Map/Reduce Project,之后输入Project的名,例如Q1,确定即可。

如何使用Eclipse导入并运行源码

如何使用Eclipse导入并运行源码作为一名Java开发者,我们经常需要使用Eclipse作为开发工具来写代码,但有时候需要导入别人的源码,这时候我们就需要知道如何正确的导入源码,并且运行起来。

本文将会介绍如何使用Eclipse导入源码,并运行起来。

1. 下载源码首先,我们需要下载源码。

通常情况下,我们可以从开源社区或Github等代码托管平台中下载对应的源码。

在本文中,我们以Spring Framework为例,来说明如何导入源码。

我们需要在Github上先找到Spring Framework项目的源码,可以在Github上面搜索Spring Framework关键字,然后找到spring-projects/spring-framework这个项目即可。

2. 解压源码文件下载下来的Spring Framework源码是一个zip压缩包,我们需要先将其解压缩到一个目录下。

解压后的文件一般会包括一些项目文件、配置文件和源代码文件等。

在本文中,我们将源码解压到名为spring-framework的文件夹中。

3. 在Eclipse中创建一个新的Java项目我们需要在Eclipse中创建一个新的Java项目,来容纳我们刚才解压缩出来的源码。

我们可以按照以下步骤进行:1.打开Eclipse,点击“File” -> “New” -> “Java Project”。

2.在弹出的对话框中,输入项目的名称,比如“spring-framework”。

然后点击“Finish”按钮,Eclipse会自动创建一个新的Java项目。

4. 将源码导入到Eclipse项目中现在我们已经在Eclipse中创建了一个新的Java项目,接下来我们需要将刚才解压缩出来的源码导入到这个项目中。

1.右键点击Eclipse项目的名称,选择“Import”菜单项。

2.在弹出的对话框中,选择“General” -> “File System”,然后点击“Next”按钮。

Hadoop在Windows7操作系统下使用Eclipse来搭建hadoop开发环境-电脑资料

Hadoop在Windows7操作系统下使用Eclipse来搭建hadoop开发环境-电脑资料网上有一些都是在Linux下使用安装Eclipse来进行hadoop应用开发,但是大部分Java程序员对linux系统不是那么熟悉,所以需要在windows下开发hadoop程序,所以经过试验,总结了下如何在windows下使用Eclipse来开发hadoop程序代码,。

1、需要下载hadoop的专门插件jar包2、把插件包放到eclipse/plugins目录下为了以后方便,我这里把尽可能多的jar包都放进来了,如下图所示:3、重启eclipse,配置Hadoop installation directory如果插件安装成功,打开Windows—Preferences后,在窗口左侧会有Hadoop Map/Reduce选项,点击此选项,在窗口右侧设置Hadoop安装路径。

4、配置Map/Reduce Locations打开Windows-->Open Perspective-->Other选择Map/Reduce,点击OK,在右下方看到有个Map/Reduce Locations的图标,如下图所示:点击Map/Reduce Location选项卡,点击右边小象图标,打开Hadoop Location配置窗口:输入Location Name,任意名称即可.配置Map/Reduce Master 和DFS Mastrer,Host和Port配置成与core-site.xml的设置一致即可。

去找core-site.xml配置: hdfs://name01:9000在界面配置如下:点击"Finish"按钮,关闭窗口。

点击左侧的DFSLocations—>myhadoop(上一步配置的location name),如能看到user,表示安装成功,但是进去看到报错信息:Error: Permission denied: user=root,access=READ_EXECUTE,inode="/tmp";hadoop:superg roup:drwx---------,如下图所示:应该是权限问题:把/tmp/目录下面所有的关于hadoop的文件夹设置成hadoop用户所有然后分配授予777权限。

配置eclipse编译_开发Hadoop(MapReduce)源代码

3. 安装 Subclipse(Eclipse 的 SVN 插件)

用于从 Hadoop 获得源代码。我们使用 eclipse 自带的软件安装功能,通过 Subclipse 提供的地址自动下载安装该插件。

•首先访问,在Download and Install页面找到与Eclipse版本合适的Subclipse版本,最新为1.6,将其Eclipse update site URL

•如果选择 release 版本,需进入 tags 目录浏览,找到所需的版本,如 0.21.0 版 MapReduce 源代码地址为:/repos/asf/hadoop/common/tags/release-0.21.0/mapreduce

确定好 SVBiblioteka 地址后,本地 eclipse 需要的操作如下:

将其下的三个全选,然后像subclipse一样安装上。安装好之后,进入Window-Preferences-Team-svn,将svn本地接口选择上安装的那个(下拉就可以看到)。

4. 下载 Hadoop(MapReduce)源代码

首先,Hadoop 源代码共包括 common、hdfs(分布式文件系统)、mapred(MapReduce) 三部分,它们之间存在依赖关系:common 是后两者的公共组件,mapred

查看Window-Preferences-Team-svn,会发现svn本地接口显示为不可用。

可以通过以下方法解决(安装svn所需kit):

打开 eclipse 的菜单 Help > Install New Software,填入上边安装subclipse时所用的安装地址(即 /update_1.6.x),选择第三个subclipse svnkit option,

hadoop-0.20.1部署手记

hadoop-0.20.1部署手记作者:田逸(sery@) from 如需转载请注明出处及署名,否则追究责任。

因为需要分析大量的访问日志,现有的分析方式(单机)不能满足需求,因此需要部署hadoop来解决这个问题。

在我做分布式文件系统之前,曾经部署测试过hadoop,使用的版本为hadoop-0.19.0,记得当时配置起来很快就成功了。

这次测试,我使用的是最新版本hadoop- 0.20.1,在部署过程中,花了不少时间才做成功(2天)。

为备忘,特记录之。

hadoop-0.20.1跟旧的版相比,有些文件发生了变化,主要的变化是conf目录,网上现有的hadoop文章,需要修改的文件是hadoop-site.xml,可是hadoop-0.20.1版本确没有这个文件,取而代之的是core-site.xml。

一、部署hadoophadoop部署分两步:名称节点(namenode)无密码访问各数据节点(datanode)和配置hadoop.我的实验环境为一个名称节点,两个数据节点.不幸的是其中的一个数据节点坏了。

因此只能用一个数据节点来测试。

在这个测试中,namenode 的ip: 192.168.199.135,datanode的ip:192.168.199.136.(一)、名称节点(namenode)无密码访问各数据节点(datanode)1、名称节点和数据节点各自创建用户hadoop,使用相同的密码。

2、以hadoop用户名登陆名称节点执行ssh-keygen -t rsa 然后一路回车,完毕后生成文件.ssh/id_rsa.pub,把这个文件复制到当前位置,命名为authorized_keys;然后执行命令 ssh 127.0.0.1,如果不需要密码则直接登陆进去的话,就达到要求;否则需检查authorized_keys的权限,看是否为644(-rw-r-- r--)。

接下来,同样也hadoop用户登陆数据节点服务器,创建.ssh 目录,并给与600权限(chmod 600 .ssh); 再把名称服务器上的authorized_keys 复制到目录./ssh,注意权限和目录结构跟名称节点保持一致,然后再从名称节点用 ssh登陆数据节点,如果不需要密码能登陆成功,则ssh的配置结束。

Hadoop源代码eclipse编译教程

源代码eclipse编译教程一见/hadoopor@1.下载Hadoop源代码Hadoop各成员源代码下载地址:/repos/asf/hadoop,请使用SVN 下载,在SVN浏览器中将trunk目录下的源代码check-out出来即可:请注意只check-out出SVN上的trunk目录下的内容,如:/repos/asf/hadoop/common/trunk,而不是/repos/asf/hadoop/common,原因是/repos/asf/hadoop/common目录下包括了很多非源代码文件,并且很庞大,会导致需要很长的check-out时间。

建议组织成如下图所示的目录结构,以保持本地的目录结构和SVN上的目录结构一致:2.准备编译环境2.1.Hadoop代码版本本教程所采用的Hadoop是北京时间2009-8-26日上午下载的源代码,和hadoop-0.19.x 版本的差异可能较大。

2.2.联网编译Hadoop会依赖很多第三方库,但编译工具Ant会自动从网上下载缺少的库,所以必须保证机器能够访问Internet。

2.3.java编译Hadoop要求使用1.6或更新的JDK,可以从:/javase/downloads/index.jsp上下载JDK。

安装好之后,请设置好JAVA_HOME环境变量,如下图所示:2.4.Ant和Cygwin需要使用Ant工具来编译Hadoop,而Ant需要使用到Cygwin提供的一些工具,如sed 等,可以从:/ivy/download.cgi下载Ant,从/下载Cygwin(Cygwin的安装,请参考《在Windows上安装Hadoop教程》一文)。

安装好之后,需要将Ant和Cygwin的bin目录加入到环境变量PATH中,如下图所示:在安装Cygwin时,建议将SVN安装上,因为在Ant编译过程中会通过SVN下载些文件,但这个不是必须的,下载不成功时,并未见出错,编译仍然可以成功。

hdfs java api 使用 eclipse编程进行文件操作的基本流程

hdfs java api 使用 eclipse编程进行文件操作的基本流程HDFS(Hadoop Distributed File System)是一个分布式文件系统,用于存储大规模数据集。

它是Apache Hadoop项目的一部分,旨在提供可靠且高容错性的文件存储。

HDFS Java API是用于与Hadoop分布式文件系统进行交互的API。

它提供了一组类和方法,可以用于在Java应用程序中进行文件和目录的操作,如创建、读取、写入和删除文件等。

本文将介绍如何使用Eclipse开发环境编写Java程序来操作HDFS。

首先,我们需要安装并配置Hadoop环境,并确保Hadoop集群已经处于运行状态。

接下来,我们将创建一个简单的Java项目,在项目中使用HDFS Java API进行文件操作。

最后,我们将在Eclipse中运行该项目,并验证文件操作的结果。

1.安装和配置Hadoop环境在开始之前,我们需要先安装和配置Hadoop环境。

可以从Hadoop 官网下载最新版本的Hadoop,并按照官方文档进行安装和配置。

确保Hadoop集群中包含NameNode、DataNode和ResourceManager等组件,并且集群处于正常运行状态。

2.创建Java项目打开Eclipse开发环境,选择File -> New -> Java Project,创建一个新的Java项目。

在项目中创建一个新的Java类,用于编写HDFS文件操作的代码。

3.导入Hadoop依赖库在Eclipse中,右键单击项目名称,选择Properties -> Java Build Path -> Libraries,点击Add External JARs,导入Hadoop的依赖库。

依赖库包括hadoop-common.jar、hadoop-hdfs客戶端包以及所需的其他依赖库。

4.编写HDFS文件操作代码创建一个新的Java类,编写HDFS文件操作的代码。

搭建eclipse的hadoop开发环境知识点

搭建eclipse的hadoop开发环境知识点一、概述在大数据领域,Hadoop是一个非常重要的框架,它提供了分布式存储和处理海量数据的能力。

而Eclipse作为一款强大的集成开发环境,为我们提供了便利的开发工具和调试环境。

搭建Eclipse的Hadoop 开发环境对于开发人员来说是必不可少的。

本文将从安装Hadoop插件、配置Hadoop环境、创建Hadoop项目等方面来详细介绍搭建Eclipse的Hadoop开发环境的知识点。

二、安装Hadoop插件1. 下载并安装Eclipse我们需要在全球信息湾上下载最新版本的Eclipse,并按照提示进行安装。

2. 下载Hadoop插件在Eclipse安装完成后,我们需要下载Hadoop插件。

可以在Eclipse 的Marketplace中搜索Hadoop,并进行安装。

3. 配置Hadoop插件安装完成后,在Eclipse的偏好设置中找到Hadoop插件,并按照提示进行配置。

在配置过程中,需要指定Hadoop的安装目录,并设置一些基本的环境变量。

三、配置Hadoop环境1. 配置Hadoop安装目录在Eclipse中配置Hadoop的安装目录非常重要,因为Eclipse需要通过这个路径来找到Hadoop的相关文件和库。

2. 配置Hadoop环境变量除了配置安装目录,还需要在Eclipse中配置Hadoop的环境变量。

这些环境变量包括HADOOP_HOME、HADOOP_COMMON_HOME、HADOOP_HDFS_HOME等,它们指向了Hadoop的各个组件所在的目录。

3. 配置Hadoop项目在Eclipse中创建一个新的Java项目,然后在项目的属性中配置Hadoop库,以及其它一些必要的依赖。

四、创建Hadoop项目1. 导入Hadoop库在新建的Java项目中,我们需要导入Hadoop的相关库,比如hadoopmon、hadoop-hdfs、hadoop-mapreduce等。

如何使用Eclipse导入并运行源码

如何使用Eclipse导入并运行源码如何使用Eclipse导入并运行源码(原创哦,如有转载,请注明作者forest077)网上关于Eclipse配置和开发入门程序的文章很多,可是要么很粗浅,要么很高深,却很少看到讲解如何把别人的源码导入到自己的Eclipse 环境中编译运行的描述。

做为初学者,能够学习网上一些优秀源码是提高的必由之路,可是Eclipse却不象VC和Delphi那样容易上手,对于很多初学者来说,它似乎还是太难了点。

在找不到很好的关于Eclipse入门教程的情况下,为了能运行网上下载的Java源码,我颇费了一些时间寻找如何正确的导入源码并运行的方法,不敢独美,特贡献出来与初学者共享。

运行环境:Java EE 5.0Eclipse 3.2.1中文版源代码用例(都是Java Application):仿真Windows记事本连连看上述的两个源代码在赛迪网上可以找到。

关于JDK的配置、安装和Eclipse的安装本文不再赘述,读者可以很容易地找到相关的资料。

本文只讲使用Eclipse来导入源代码的方法。

首先确保你的工作空间已经创建好,在我的机器上工作空间所在的目录是“e:\workspace”。

源代码存放路径假设为“我的文档\cai\Java\一个仿windows的记事本”和“我的文档\cai\Java\连连看\kyodai”。

下面开始介绍导入源码的方法。

◎选择菜单“文件/新建/项目”,选择“Java项目”,弹出“创建Java 项目”对话框。

◎在“创建Java项目”中输入“项目名”,项目名可以为任意名字,不必和main类的名字一样。

这里假设为“Notepad”。

在“内容”中有两个单选按钮,视你的需要来使用。

其中“在工作空间中创建新项目”会在你的工作空间中创建一个新目录,目录名与项目名一致;“从现有资源创建项目”可以在源码所在目录中直接编译运行,生成的class文件也会存放在源码目录中。

下面先讲“在工作空间中创建新项目”的方法。

Hadoop编译之Eclipse平台方法

国家超级计算深圳中心Hadoop编译——Eclipse平台编译方法研究开发部2011-8-5Hadoop 编译——Eclipse平台编译方法目录Eclipse编译Hadoop (1)1 Windows环境下编译 (4)1.1安装Cygwin (4)1.2安装java (4)1.3安装ant (4)1.4安装Eclipse (5)1.5下载源码 (6)1.6编译Hadoop (6)步骤1 (6)步骤2 (7)步骤3 (8)2 Linux环境下编译 (8)2.1 ant下载 (8)2.2下载JDK (8)2.3下载源码 (9)2.4 Eclipse下载 (9)2.5编译Hadoop (9)步骤1 (9)步骤2 (10)步骤3 (11)版本信息1 Windows环境下编译1.1安装Cygwin到下载cygwin最新版本。

下载后执行安装(安装目录为C:\cygwin)即可,安装时默认的配置即可,必须联网下载内容。

安装过程中选择svn和sed。

用于下载源代码。

在环境变量中Path加入:C:\cygwin\bin1.2安装java下载Jdk1.6_26。

将Java的可执行文件安装路径+bin,形如:C:\Program Files\Java\jdk1.6.0_26\bin目录加入到Path变量中。

如下图所示:添加JAVA_HOME变量。

1.3安装ant到下载ant1.7或者1.8都可以。

解压到C盘后,设置环境变量:ANT_HOME 和PATH. 我的电脑右键->属性->高级->环境变量-新建:如下图所示,输入内容。

我的电脑右键->属性->高级->环境变量,找到系统变量中的PATH,单击编辑,如下图所示,加入:%ANT_HOME%\bin1.4安装Eclipse下载:/eclipse/technology/epp/downloads/release/ indigo/R/eclipse-jee-indigo-win32.zip 。

hadoop源码编译

hadoop源码编译Hadoop是目前最流行的分布式计算框架之一,广泛应用于大数据领域。

为了更好地理解Hadoop的内部运行机制,我们有时需要对其源码进行深入研究和编译。

下面就来一步步讲解如何编译Hadoop源码。

一、环境准备在开始编译Hadoop源码之前,需要安装一些必备的软件和环境。

首先要确保已经安装了Java JDK和Maven,其中Java JDK的版本应该至少是1.7或1.8,而Maven则需要3.0以上的版本。

其次需要安装SSH,这是Hadoop用于节点之间通信和管理的必备组件。

最后需要下载Hadoop源码压缩包,解压到本地文件夹。

二、修改配置文件在进行编译过程之前,还需要修改一些Hadoop的配置文件。

具体来说,需要先修改pom.xml文件中的Hadoop版本号,确保与本地安装的版本一致。

然后需要修改hadoop-common-project/hadoop-common/src/main/conf/hadoop-metrics2.properties文件中的hostname值,确保与你当前的主机名一致。

三、编译源码当所有环境准备工作完成后,就可以开始编译Hadoop源码了。

首先需要在hadoop源码文件夹下运行以下命令,生成configure脚本:$ ./bootstrap.sh接着需要执行configure命令,生成Makefile:$ ./configure这个命令会检查编译环境,并根据环境配置参数。

最后,你需要执行make命令来编译Hadoop源码:$ mvn package -Pdist,native -DskipTests -Dtar以上命令会编译生成Hadoop发布版本,并将所有生成的二进制文件打成一个.tar包。

编译过程需要一定的时间,具体取决于你的电脑性能和网络速度。

四、启动HadoopHadoop源码编译完成之后,就可以启动它了。

首先需要将生成的.tar包解压到一个文件夹中:$ tar xf hadoop-x.x.x.tar.gz然后使用以下命令添加环境变量:$ export HADOOP_HOME=/path/to/hadoop-x.x.x$ export PATH=$PATH:$HADOOP_HOME/bin至此,Hadoop就已经编译成功并且可以在本地运行了。

hdfs java api 使用 eclipse编程进行文件操作的基本流程

如何使用HDFS Java API 在Eclipse中进行文件操作一、概述在本文中,我将向您介绍如何使用Hadoop分布式文件系统(HDFS)的Java API在Eclipse中进行文件操作的基本流程。

HDFS是Hadoop生态系统中的一个核心组件,用于在分布式环境下存储和处理大规模数据。

通过本文的学习,您将能够深入了解HDFS的基本操作,并掌握在Eclipse中使用Java API对HDFS进行文件操作的技巧。

二、准备工作在开始之前,您需要进行一些准备工作:1. 安装Hadoop和Eclipse您需要安装Hadoop和Eclipse。

您可以从官方网站下载Hadoop和Eclipse的安装包,并按照官方指南进行安装。

2. 配置Hadoop环境在安装Hadoop之后,您需要配置Hadoop的环境变量。

确保Hadoop的bin目录已经加入到系统的PATH变量中,以便在Eclipse 中调用Hadoop命令。

3. 创建Hadoop项目在Eclipse中,您需要创建一个新的Java项目,并将Hadoop库添加到项目的Build Path中。

这样您才能够在项目中使用Hadoop的Java API。

三、基本流程1. 创建HDFS客户端要在Eclipse中使用Hadoop的Java API对HDFS进行文件操作,首先需要创建一个HDFS客户端。

您可以通过以下代码来创建一个HDFS客户端并连接到HDFS集群:```javaConfiguration conf = new Configuration();conf.set("fs.defaultFS", "hdfs://localhost:9000");FileSystem fs = FileSystem.get(conf);```在这段代码中,我们首先创建了一个Configuration对象,并设置了HDFS的默认文件系统为hdfs://localhost:9000。

在eclipse中配置hadoop插件

关于在eclipse中配置hadoop插件的文档一、下载hadoop下载hadoop开发包,并解压到一个文件中。

(或将hadoop文件直接从服务器上复制到本地电脑上)。

二、导入hadoop插件开发包1.在左侧项目窗口中,点击右键,选择“import”,弹出导入提示窗口。

2.在提示窗口中选择“Existing Projects into Workspace”,点击“next”。

3.默认选择“Select root directory”,点击“Browse”按钮,选择导入项目存在的根目录,(选择文件路径为:hadoop1.2.1\hadoop\src\contrib\eclipse-plugin),在“Projects”中选择“MapReduceTools”项目,并选中“Copy projects into workspace”选项,最后点击“Finish”按钮。

三、配制导入的项目1.删除错误Jar包,并添加正确jar包在左侧选择“MapReduceTools”项目,点击右键,选择“Properties”选项。

在弹出的“属性”对话框中选择“Java Build Path”,右侧选择“Libraries”标签。

删除错误Jar包,点击“AddExternal JARs...”按钮,在弹出的对话框中选择相对应的hadoop-XXX根目录下“hadoop-core-xxx.jar”。

点击“OK”,完成此次操作。

2.导入新的jar包在项目中新建“lib”的文件夹。

选择下图中的8个jar包将其复制到此“lib”中。

全选这些jar包,点击右键,选择“Build Path”-->“Add to Build Path”,将这些jar包编译通过。

3.操作“plugin.xml”文件双击项目最下方的“plugin.xml”文件,选择“Runtime”模式。

将图中的jar删除,并点击“Add...”按钮,添加新的jar包。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Linux中使用Eclipse编译运行Hadoop-0.20.1源码

说明:在hadoop伪分布式模式下,编译运行hadoop的源码,在集群中运行。

(0)确保Eclipse的JDK、JRE是1.6以上(包含1.6)。

(1)下载hadoop-0.20.1,并解压,配置为伪分布式模式。

(2)在eclipse中新建一个Java Project,名字自己定义(hadoop-0.20.1),选择"Create project from existing source",选择hadoop-0.20.1目录。

下一步,切换到"Libraries",选择"Add Class Folder..." 按钮,从列表中选择"conf";

切换到"Order and Export"找到"conf",点击top把它移到顶端;

情况而定),点击finish,完成导入。

若没有第(2)步,而直接导入,编译运行源码时会出现以下错误:

(3)导入后,发现hadoop-0.20.1存在两处处错误,忽略他们,这不会影响编译运行hadoop源程序。

(4)启动hadoop,进入hadoop-0.20.1目录,先格式化hadoop,然后执行命令

bin/start-all.sh启动hadoop。

(5)编译运行源代码,以src/examples中的WordCount为例,做如下操作,这样

wordcount程序将在集群下运行。