最大k距离

knn概念

K最近邻算法(K-Nearest Neighbors)1. 概念定义K最近邻算法(K-Nearest Neighbors,简称KNN)是一种基本的监督学习算法,用于分类和回归问题。

它的基本思想是通过找到与待分类样本最相似的K个训练样本,利用这些样本的标签进行预测。

KNN算法没有显式的训练过程,而是在预测时直接利用训练数据。

在KNN中,每个样本由一个特征向量表示,特征向量中的每个维度代表一个特征。

通过计算不同样本之间的距离来衡量它们之间的相似性。

常用的距离度量方法包括欧氏距离、曼哈顿距离和闵可夫斯基距离等。

2. 算法步骤KNN算法的步骤如下:1.计算待分类样本与训练集中所有样本之间的距离;2.根据距离找出与待分类样本最相似的K个训练样本;3.统计这K个训练样本中各类别出现的次数;4.将待分类样本归为出现次数最多的类别。

3. 关键概念3.1 K值选择KNN算法中的K值是一个重要的参数,它决定了用于预测的邻居样本数量。

K值的选择会对算法的性能产生影响。

较小的K值可能会导致模型过拟合,而较大的K值可能会导致模型欠拟合。

通常,K值需要通过交叉验证等方法进行选择。

3.2 距离度量在KNN算法中,距离度量是衡量样本之间相似性的重要指标。

常用的距离度量方法包括欧氏距离、曼哈顿距离和闵可夫斯基距离等。

不同的距离度量方法适用于不同类型的数据。

3.3 分类决策规则分类决策规则决定了如何根据邻居样本的标签进行分类预测。

常见的分类决策规则有多数表决法和加权多数表决法。

多数表决法将待分类样本归为出现次数最多的类别,而加权多数表决法考虑了邻居样本与待分类样本之间的距离,在投票过程中给距离较近的样本更大的权重。

4. 重要性和应用4.1 重要性•简单有效:KNN算法简单易懂,没有复杂的训练过程,适用于小规模数据集;•非参数化学习:KNN是一种非参数化学习算法,不需要对数据的分布做出任何假设,具有较强的灵活性;•可解释性强:KNN算法对于分类决策过程具有较强的可解释性,可以通过查看邻居样本的标签来理解预测结果;•泛化能力强:KNN算法在处理多类别、非线性问题时表现良好。

k-means算法例题

k-means算法例题

K-means算法是一种基于迭代的聚类算法,它利用距离公式将数据集分为K个不同的聚类,每个聚类具有最相似的数据点。

以下是使用K-means算法的一个简单案例:

题目:使用K-means算法将下列数据点进行聚类(这里使用欧式距离作为度量,K取值为2)

数据点:P1(1,2), P2(2,3), P3(5,6), P4(7,8), P5(9,10), P6(15,14), P7(16,13), P8(18,17), P9(20,19)

解题步骤:

1. 选择聚类的个数K=2。

2. 任意选择两个数据点作为初始聚类中心,例如选择P1和P6。

3. 计算每个数据点到两个聚类中心的距离,并将每个数据点分配到距离最近的聚类中。

4. 重新计算每个聚类的中心点,即将该聚类中所有数据点的坐标求平均值得到新的聚类中心。

5. 重复步骤3和4,直到聚类中心不再发生变化或达到最大迭代次数。

6. 输出最终的聚类结果。

根据以上步骤,可以得到该数据集的聚类结果为:{P1, P2, P3, P4, P5}和{P6, P7, P8, P9}。

其中,第一个聚类中心为(3,4),第二个聚类中心为(17,16)。

k-最近邻算法

k-最近邻算法

1.k-最近邻算法是一种基于实例(Instance-based)的学习方法,也称为惰性学习(Lazy learning)方法或者近似实例学习方法。

它是一种分类方法,它不学习实例及其

之间的关系,而是直接存储数据,当需要进行分类预测时,寻找距离最近的K个点,然后

根据这些点的类别进行预测。

2.k-最近邻算法原理:通过比较未知实例与训练数据库中的实例,测量它们之间的距离,来预测该未知实例的类别。

与距离它最近的K个实例的类别最多的作为该未知实例的

类别。

3.k-近邻算法的优缺点:

优点:

1.简单易行:最近邻算法是计算机最简单的分类算法,直观有效,操作简单易行。

2.可预测性良好:最近邻分类算法可以获得较好的解决方法,并达到较高的预测性能。

3.大规模数据集可以很快地进行分类:kNN算法仅依赖训练数据中出现的模型,而不

用于存储数据,因此它可以在庞大的数据集上进行分类并实现极快的计算性能。

1.计算复杂度高:KNN算法比较复杂,需要调参数,计算复杂度较高且及时性较差。

2.存在样本不平衡问题:由于KNN算法没有考虑数据的内在分布特征,对于样本不平

衡的问题容易出现误分的情况。

3.维数灾难:KNN算法容易陷入维数灾难,即随着维数增加,距离也会不断增加,准

确率越来越低。

knn算法伪代码

knn算法伪代码简介knn算法(K-Nearest Neighbors)是一种用于分类和回归的非参数统计方法,被广泛应用于机器学习领域。

它的基本思想是通过比较待分类样本与训练样本之间的相似度,将待分类样本归为最相似的k个训练样本的类别。

knn算法简单、易于理解和实现,并且在某些场景下具有较好的性能。

算法步骤knn算法流程可以分为以下几个步骤:1. 导入数据从训练集中读取已知分类的样本数据和对应的类别标签,同时导入待分类的样本数据。

2. 计算距离对于待分类的每个样本,计算它与训练集中每个样本之间的距离。

常用的距离度量方法有欧氏距离、曼哈顿距离、闵可夫斯基距离等。

3. 选择k值确定k的取值,k代表着需要找出与待分类样本最相似的k个训练样本。

4. 找出k个最近邻根据计算的距离,找出与待分类样本最相似的k个训练样本。

5. 统计类别统计k个最近邻中各个类别的数量,选择数量最多的类别作为待分类样本的类别。

6. 输出结果将待分类样本划分到最终确定的类别中,完成分类任务。

伪代码实现以下是knn算法的伪代码实现:function knn(data, labels, new_sample, k):distances = []for i in range(length(data)):dist = distance(data[i], new_sample)distances.append((dist, labels[i]))distances.sort()k_nearest = distances[:k]class_counts = {}for _, label in k_nearest:if label in class_counts:class_counts[label] += 1else:class_counts[label] = 1return max(class_counts, key=class_counts.get)其中,data是训练集的样本数据,labels是训练集中每个样本的类别标签,new_sample是待分类的样本数据,k是最近邻的个数。

knn算法的基本原理及公式

knn算法的基本原理及公式KNN(K-Nearest Neighbors)算法是一种常用的分类和回归算法,它的基本原理简单而直观。

KNN算法的核心思想是通过找出与待分类样本最相似的K个已知类别样本,根据这K个样本的类别多数表决的原则,来判断待分类样本属于何种类别。

KNN算法步骤如下:1. 首先,我们需要将训练样本集中的每个样本点的特征向量表示成一个点在n维空间中的坐标,每个坐标轴代表一个特征属性。

2. 对于一个待分类的样本点,我们需要计算它与训练样本集中每个样本点的距离。

常用的距离度量方法有欧式距离、曼哈顿距离等。

3. 然后,根据上一步计算得到的距离,从小到大对训练样本集进行排序。

4. 接下来,选择距离待分类样本点最近的K个样本点。

5. 最后,根据这K个样本点的类别进行多数表决,将待分类样本点归为类别最多的一类。

KNN算法的公式表示如下:对于一个样本点x,其特征属性表示为(x1, x2, ..., xn)。

训练样本集中的某个样本点i表示为(xi1, xi2, ..., xin),则样本点x和样本点i之间的欧氏距离d(x, i)为:d(x, i) = √((x1 - xi1)^2 + (x2 - xi2)^2 + ... + (xn - xin)^2)找出距离样本点x最近的K个样本点后,根据多数表决原则,可将样本点x归为其中样本类别最多的一类。

KNN算法的特点是简单易于理解,适用于多种领域的分类问题。

它没有明确的训练过程,只需要保存训练样本集,因此训练时间很短,预测效率较高。

但是,KNN算法在处理大规模数据集时,计算距离的复杂度较高,需要耗费较多的计算资源。

另外,KNN算法对数据集中的噪声和异常值比较敏感,需要进行数据预处理和特征选择。

总的来说,KNN算法是一种简单但有效的分类方法。

通过寻找与待分类样本最相似的K个已知类别样本,它可以进行准确的分类和回归预测。

在实际应用中,可以根据具体的需求和问题特点,选择合适的K 值和距离度量方法,以获得更好的分类性能。

k近邻算法对鸢尾花数据集的分类

K近邻算法(k-nearest neighbors algorithm)是一种常用的分类算法,它通过计算待分类对象与训练集中各个样本的距离,找到与待分类对象距离最近的k个样本,然后根据这k个样本的类别来确定待分类对象的类别。

K近邻算法的简单易懂的特点使其成为机器学习入门的经典算法之一。

鸢尾花数据集(Iris dataset)是机器学习领域中常用的数据集之一,由英国统计学家和生物学家Ronald Fisher于1936年提出。

数据集包含了150个样本,分为三类,每类包含50个样本,每个样本包含4个特征,分别是花萼长度、花萼宽度、花瓣长度和花瓣宽度。

鸢尾花数据集是一个经典的分类问题,很适合用于测试和验证分类算法的性能。

本文将对鸢尾花数据集使用K近邻算法进行分类,并探讨K值的选择、距离度量的方法以及算法性能评估等方面。

一、K值的选择K近邻算法中的K值是一个重要的超参数,它决定了待分类对象的类别依赖于多少个最近邻样本。

K值的选择对算法的性能有着直接的影响,一般来说,K值越小,模型对噪声的敏感度越高,容易受到局部极值的影响;K值越大,模型的鲁棒性越强,但可能会忽略掉样本的局部特征。

在实际应用中,K值的选择需要经过交叉验证等方法来确定,常用的K 值一般在3-10之间。

在本文中,我们将尝试不同的K值来对鸢尾花数据集进行分类,并比较不同K值下的分类性能。

二、距离度量的方法K近邻算法中,样本之间的距离度量是决定待分类对象类别的重要因素之一。

常用的距离度量方法有欧氏距离、曼哈顿距离、切比雪夫距离等。

对于鸢尾花数据集,我们将尝试不同的距离度量方法,比较它们在分类性能上的差异。

三、算法性能评估在对鸢尾花数据集进行分类时,我们将使用常见的性能评估指标来评估算法的性能,包括准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1值等。

这些指标将帮助我们更直观地了解K近邻算法在鸢尾花数据集上的表现,并为算法的优化提供参考。

knn计算公式

knn计算公式

KNN(K-Nearest Neighbors)是一种常用的监督学习算法,常用于分类和回归问题。

它的基本思想是根据邻近样本的类别来预测新样本的类别或数值。

在 KNN 分类中,计算公式通常涉及到计算样本之间的距离,然后选择前 K 个最邻近的样本。

常见的距离度量方法包括欧几里德距离、曼哈顿距离和余弦相似度等。

以下是一个简单的 KNN 分类算法的计算公式示例:

1. 计算样本之间的距离:可以使用欧几里德距离公式(Euclidean distance)来计算两个样本之间的距离。

欧几里德距离公式为:d(x, y) = \sqrt{(x_1 - y_1)^2 + (x_2 - y_2)^2 + ... + (x_n - y_n)^2}

其中,(x_1, x_2, ..., x_n)和(y_1, y_2, ..., y_n)分别是两个样本的特征向量。

2. 选择前 K 个最邻近的样本:根据计算得到的距离,对每个待预测的样本,选择距离最近的 K 个样本。

3. 统计前 K 个最邻近样本的类别:对选择的 K 个邻近样本,统计它们的类别出现次数。

4. 确定预测类别:根据统计的类别出现次数,选择出现次数最多的类别作为待预测样本的类别。

在 KNN 回归中,计算公式通常涉及到计算样本之间的距离,然后选择前 K 个最邻近的样本。

然后,可以使用这

些邻近样本的平均值、众数或其他统计量来预测新样本的数值。

需要注意的是,KNN 算法的准确性和性能在很大程度上取决于 K 值的选择、距离度量方法以及数据的特征工程。

在实际应用中,需要根据具体问题和数据集进行调整和优化。

一条直线两侧两点到直线距离差的最大值

一、概述在数学中,直线和点是基本的几何概念,而直线与点之间的距离也是几何学中常见的问题。

在本文中,我们将探讨一条直线两侧两点到直线距离差的最大值的问题。

二、问题描述假设有一条直线L和两个点A和B,我们希望找到直线L两侧两点到直线L的距离之差的最大值。

三、问题分析为了解决这个问题,我们首先需要确定直线L的方程。

一般情况下,直线可以由方程Ax + By + C = 0来表示,其中A、B、C为常数。

然后我们可以利用直线到点的距离公式来计算点A和点B到直线L的距离。

设点A的坐标为(x1, y1),点B的坐标为(x2, y2),直线L的方程为Ax + By + C = 0,则点到直线的距离公式为D = |Ax1 + By1 + C| / √(A^2 + B^2)四、问题求解1. 确定直线L的方程我们需要确定直线L的方程。

假设直线L经过点P1(x1, y1)和点P2(x2, y2),斜率为k,则直线L的方程可以表示为y - y1 = k(x - x1)2. 确定点A和点B到直线L的距离现在,我们可以利用点到直线的距离公式计算点A和点B到直线L的距离。

假设点A的坐标为(x3, y3),点B的坐标为(x4, y4),则点A和点B到直线L的距离分别为D_A = |kx3 - y3 + y1 - kx1| / √(k^2 + 1)D_B = |kx4 - y4 + y1 - kx1| / √(k^2 + 1)3. 计算距离差的最大值我们可以计算点A和点B到直线L的距离差的最大值。

点A和点B到直线L的距离差为|D_A - D_B| = |(kx3 - y3 + y1 - kx1) - (kx4 - y4 + y1 - kx1)| /√(k^2 + 1) = |k(x3 - x4) - (y3 - y4)| / √(k^2 + 1)五、总结通过上述分析,我们可以得出一条直线两侧两点到直线距离差的最大值的计算方法。

首先确定直线L的方程,然后计算点A和点B到直线L的距离,最后求出距离差的最大值。

两点间距离公式有k的

两点间距离公式有k的在我们学习数学的旅程中,有一个重要的知识点——两点间距离公式。

这个公式看似简单,却蕴含着奇妙的数学之美。

先来说说这个两点间距离公式。

假设我们有两个点,一个点的坐标是$(x_1,y_1)$,另一个点的坐标是$(x_2,y_2)$,那么这两点之间的距离$d$就可以通过公式$d = \sqrt{(x_2 - x_1)^2 + (y_2 - y_1)^2}$来计算。

但今天咱要说的是,假如这个公式里多了个“k”,那会怎么样呢?前几天我在给学生们讲这部分内容的时候,就遇到了一个有趣的情况。

有个学生特别积极,一直举手说他有不同的想法。

我就让他站起来讲讲,结果他把这个带“k”的两点间距离公式理解得乱七八糟。

当时我就笑了,我跟他说:“别着急,咱们一步步来。

”咱们先从最基础的开始理解。

两点间距离公式,其实就是通过坐标的差值来计算距离。

想象一下,在一个平面上,两个点就像两个小房子,我们要算出从一个小房子到另一个小房子要走多远。

那这个距离,就是通过横坐标的差的平方加上纵坐标的差的平方,再开平方得到的。

如果公式里多了个“k”,那可能是增加了一些条件或者变化。

比如说,“k”可能是某个比例系数,或者是某个特殊的参数。

这就需要我们更仔细地去分析题目中的条件,看看这个“k”到底是怎么影响两点之间的距离的。

我记得有一道题是这样的:已知点$A(x_1,y_1)$和点$B(x_2,y_2)$,两点间距离为$d$,且存在一个系数$k$,使得$d = k\sqrt{(x_2 - x_1)^2+ (y_2 - y_1)^2}$,然后给了一些关于点的具体坐标和$k$的值,让求其他的相关量。

这时候,我们就得先把这个公式弄清楚,搞明白“k”在这里的作用。

再比如说,还有一种情况,“k”可能是在坐标轴上的缩放比例。

就好像我们拿着一个放大镜或者缩小镜去看这个平面,原本的距离因为“k”的存在而发生了变化。

在学习这个知识点的过程中,大家可千万不能马虎。

两点间距离公式带k的推导

两点间距离公式带k的推导在几何学和物理学中,计算两点之间的距离是一项基本的任务。

一种常用的方法是使用直线距离公式,该公式可以用来计算在欧几里得空间中的两点之间的直线距离。

然而,在某些情况下,我们需要计算一个带有参数k的两点之间的距离,其中k是一个非负实数。

在本文中,我们将推导出这种带有k的两点间距离的公式。

假设我们有一个平面上的点A(x1, y1)和点B(x2, y2),我们的目标是计算这两点之间的距离。

首先,我们可以使用直线的斜率来推导出距离公式。

首先,我们计算点A和点B之间的斜率m,可以使用下面的公式来计算:m = (y2 - y1) / (x2 - x1)接下来,我们考虑点A和点B之间的直线方程。

使用点斜式,我们有:y - y1 = m(x - x1)现在,我们可以推导出x和y:y = m*x - m*x1 + y1然后,我们将点B的坐标代入上述方程,得到:y2 = m*x2 - m*x1 + y1接下来,我们将上述方程变换为标准形式:m*x2 - y2 = m*x1 - y1现在,我们引入参数k,将公式改写为:k*(m*x2 - y2) = k*(m*x1 - y1)我们将k(m x2 - y2)表示为d1,将k(m x1 - y1)表示为d2,上述方程变成了:d1 = d2现在,我们可以计算d1和d2的值。

首先,我们计算d1:d1 = k*(m*x2 - y2)= k*(y2 - y1)接下来,我们计算d2:d2 = k*(m*x1 - y1)= k*(y2 - y1)由于d1和d2相等,我们可以将它们设置为距离的平方。

所以,我们的带有参数k的两点间距离公式为:d^2 = (k*(y2 - y1))^2 + (k*(x2 - x1))^2这是带有参数k的两点间距离的公式。

通过设置k的值,我们可以根据需要调整距离的大小。

总结起来,我们在本文中推导了带有参数k的两点间距离的公式。

这个公式可以在平面几何和物理学的应用中发挥作用,通过调整参数k的值,可以灵活地改变距离的大小。

knn算法中评估距离的指标

knn算法中评估距离的指标k最近邻(k-Nearest Neighbor,k-NN)算法是一种基本分类与回归方法,其核心思想是在训练集中搜索和目标实例最近的k个实例,然后根据这k个实例的分类情况进行分类决策。

在kNN算法中,评估距离的指标对于算法的效果有着至关重要的作用。

常见的评估距离的指标有欧氏距离、曼哈顿距离、切比雪夫距离、闵可夫斯基距离等指标。

1. 欧氏距离欧氏距离是最常用的评估距离的指标之一,它表示两个向量在欧几里得空间的距离。

两个向量之间的欧氏距离距离公式为:d(x,y) = sqrt[(x1-y1)^2 + (x2-y2)^2 + … + (xn-yn)^2]其中,x和y是两个向量,n为向量的维度。

欧氏距离适用于数据量较大但维度较小的数据集,当维度较大时,由于所得距离过于接近,导致算法的精度下降。

3. 切比雪夫距离切比雪夫距离也称为棋盘距离,是指两个向量在各个维度上距离的最大差值。

切比雪夫距离的距离公式为:d(x,y) = max(|x1-y1|, |x2-y2|, …, |xn-yn|)切比雪夫距离适用于数据集中的维度比较小,而且特征值被刻意控制在较小的范围内的情况。

4. 闵可夫斯基距离闵可夫斯基距离是一种通用距离度量方法,它可以表示多种不同距离指标。

其距离公式为:d(x,y) = (|x1-y1|^p + |x2-y2|^p + … + |xn-yn|^p)^(1/p)其中,p是一个参数,可以控制不同距离指标的影响程度。

当p=1时,闵可夫斯基距离等价于曼哈顿距离;当p=2时,闵可夫斯基距离等价于欧氏距离;当p->无穷大时,闵可夫斯基距离等价于切比雪夫距离。

在应用kNN算法时,不同的评估距离指标对于算法的效果有着不同的影响。

选择适合的距离度量指标可以使算法的精度更加稳定和高效。

因此,在实际应用中,需要根据数据集的特征及业务需求选择合适的评估距离指标。

K均值算法的距离计算方法及应用技巧(十)

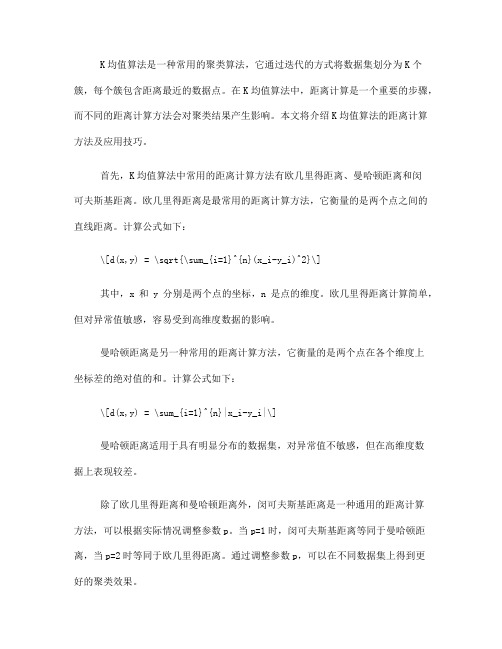

K均值算法是一种常用的聚类算法,它通过迭代的方式将数据集划分为K个簇,每个簇包含距离最近的数据点。

在K均值算法中,距离计算是一个重要的步骤,而不同的距离计算方法会对聚类结果产生影响。

本文将介绍K均值算法的距离计算方法及应用技巧。

首先,K均值算法中常用的距离计算方法有欧几里得距离、曼哈顿距离和闵可夫斯基距离。

欧几里得距离是最常用的距离计算方法,它衡量的是两个点之间的直线距离。

计算公式如下:\[d(x,y) = \sqrt{\sum_{i=1}^{n}(x_i-y_i)^2}\]其中,x和y分别是两个点的坐标,n是点的维度。

欧几里得距离计算简单,但对异常值敏感,容易受到高维度数据的影响。

曼哈顿距离是另一种常用的距离计算方法,它衡量的是两个点在各个维度上坐标差的绝对值的和。

计算公式如下:\[d(x,y) = \sum_{i=1}^{n}|x_i-y_i|\]曼哈顿距离适用于具有明显分布的数据集,对异常值不敏感,但在高维度数据上表现较差。

除了欧几里得距离和曼哈顿距离外,闵可夫斯基距离是一种通用的距离计算方法,可以根据实际情况调整参数p。

当p=1时,闵可夫斯基距离等同于曼哈顿距离,当p=2时等同于欧几里得距离。

通过调整参数p,可以在不同数据集上得到更好的聚类效果。

其次,K均值算法的距离计算方法在应用中有一些技巧。

一种常见的技巧是对数据进行标准化处理,使得各个维度的数据具有相同的重要性。

标准化处理可以通过Z-score方法或Min-Max方法实现,将数据映射到相同的尺度上,减小不同维度对距离计算的影响。

另一种技巧是选择合适的K值。

K值的选择对聚类结果有着重要的影响,通常可以通过肘部法则或轮廓系数来确定最优的K值。

肘部法则通过绘制不同K值下的SSE(误差平方和)曲线,选择肘部处的K值作为最优值。

轮廓系数则通过计算簇内距离和簇间距离来评估聚类的紧密程度,选择轮廓系数最大的K值作为最优值。

此外,K均值算法的距离计算方法还可以通过其他技巧来提高聚类效果。

k-mean 等距离方法

K-means算法是一种常用的聚类算法,它基于样本之间的距离来将样本分为K个簇。在Kmeans算法中,通常使用欧氏距离(Euclidean distance)来度量样本之间的距离。

等距离方法(Equal distance method)是一种简单的距离度量方法,它将所有样本之间 的距离都视为相等。在等距离方法中,不考虑样本之间的实际距离,而是将它们视为等距离 的。

需要注意的是,在使用K-means算法进行聚类时,距离度量方法的选择会对聚类结果产 生影响。因此,在应用K-means算法之前,需要根据实际情况选择合适的距离度量方法,并 进行适当的数据预处理和参数调优在实际应用中,等距离方法往往不够准确,因为它没有考虑到样本之间的实际距离 差异。欧氏距离等更复杂的距离度量方法通常能够更好地反映样本之间的相似度或差异度。

k-mean 等距离方法

在K-means算法中,使用欧氏距离作为默认的距离度量方法,因为它在大多数情况下都 能够提供较好的聚类效果。然而,根据具体的应用场景和数据特点,也可以选择其他距离度 量方法,如曼哈顿距离(Manhattan distance)、闵可夫斯基距离(Minkowski distance )等,以更好地适应数据的特点和需求。

excel实现kn邻近算法 -回复

excel实现kn邻近算法-回复Excel实现k近邻算法:一步一步回答K近邻算法(K-Nearest Neighbors, KNN)是一种常用的分类算法。

它通过计算待分类样本点与训练数据集中已知类别样本点的距离来实现分类。

本文将介绍如何使用Excel实现KNN算法,并逐步讲解每个步骤。

一、准备数据要使用Excel实现KNN算法,首先需要准备好训练数据。

训练数据应包括已知的样本点及其对应的类别。

每个样本点都应包括多个特征值,以便计算距离。

在Excel中,可以将训练数据存储在一个工作表中。

每一行代表一个样本点,其中的每一列代表一个特征值。

最后一列则代表该样本点的类别。

二、计算距离KNN算法的核心是计算待分类样本点与已知样本点之间的距离。

常见的距离计算方法有欧氏距离、曼哈顿距离等。

这里我们以欧氏距离为例进行讲解。

在Excel中,可以使用“=SQRT(SUMSQ(range))”公式来计算欧氏距离,其中range代表样本点的特征值区域。

假设已知样本点的特征值存储在A2:B5区域,待分类样本点的特征值存储在A7:B7区域,则可以在C7单元格输入“=SQRT(SUMSQ(A2:A5-A7:A7)+SUMSQ(B2:B5-B7:B7))”来计算欧氏距离。

三、选择最近邻计算完待分类样本点与已知样本点的距离后,需要选择K个最近的邻居样本点。

K值是KNN算法中的一个重要参数,可以根据实际需求设置。

在Excel中,可以使用排序和筛选功能来选择最近的邻居。

首先在结果区域插入一列序号,然后利用“=RANK(range,range,1)”公式来计算每个样本点的排名,其中第一个range代表待分类样本点的距离区域,第二个range代表已知样本点的距离区域,1表示按升序排列。

然后使用筛选功能,选择排名前K的样本点。

四、投票决策选择最近的邻居样本点后,需要根据它们的类别进行投票决策。

多数表决是一种常见的决策方法,即选择K个邻居中出现次数最多的类别作为待分类样本点的类别。

异常检测(1)——局部异常因子算法

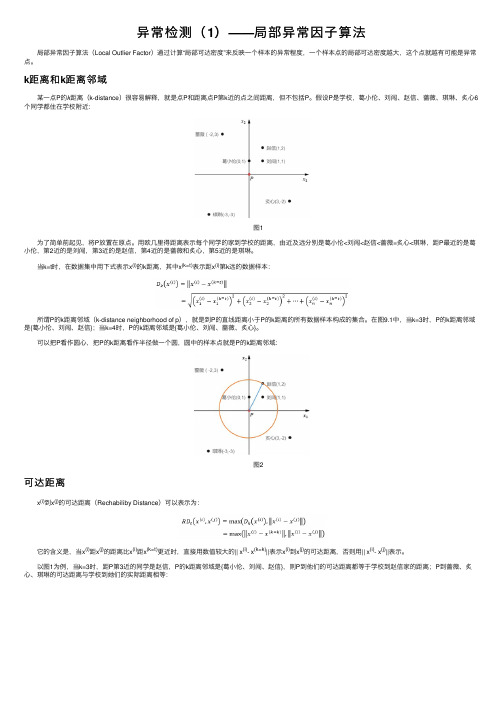

异常检测(1)——局部异常因⼦算法 局部异常因⼦算法(Local Outlier Factor)通过计算“局部可达密度”来反映⼀个样本的异常程度,⼀个样本点的局部可达密度越⼤,这个点就越有可能是异常点。

k距离和k距离邻域 某⼀点P的k距离(k-distance)很容易解释,就是点P和距离点P第k近的点之间距离,但不包括P。

假设P是学校,葛⼩伦、刘闯、赵信、蔷薇、琪琳、炙⼼6个同学都住在学校附近: 图1 为了简单前起见,将P放置在原点。

⽤欧⼏⾥得距离表⽰每个同学的家到学校的距离,由近及远分别是葛⼩伦<刘闯<赵信<蔷薇=炙⼼<琪琳,距P最近的是葛⼩伦,第2近的是刘闯,第3近的是赵信,第4近的是蔷薇和炙⼼,第5近的是琪琳。

当k=t时,在数据集中⽤下式表⽰x(i)的k距离,其中x(k=t)表⽰距x(i)第k远的数据样本: 所谓P的k距离邻域(k-distance neighborhood of p),就是到P的直线距离⼩于P的k距离的所有数据样本构成的集合。

在图9.1中,当k=3时,P的k距离邻域是{葛⼩伦、刘闯、赵信};当k=4时,P的k距离邻域是{葛⼩伦、刘闯、蔷薇、炙⼼}。

可以把P看作圆⼼,把P的k距离看作半径做⼀个圆,圆中的样本点就是P的k距离邻域: 图2可达距离 x(i)到x(j)的可达距离(Rechabiliby Distance)可以表⽰为: 它的含义是,当x(i)距x(j)的距离⽐x(i)距x(k=t)更近时,直接⽤数值较⼤的|| x(i)- x(k=k)||表⽰x(i)到x(j)的可达距离,否则⽤|| x(i)- x(j)||表⽰。

以图1为例,当k=3时,距P第3近的同学是赵信,P的k距离邻域是{葛⼩伦、刘闯、赵信},则P到他们的可达距离都等于学校到赵信家的距离;P到蔷薇、炙⼼、琪琳的可达距离与学校到她们的实际距离相等: 由于以x(i)的k近距离和x(j)的k距离并不相等,所以x(i)到x(j)的可达距离和x(j)到x(i)的可达距离并不相等: 图3 在图3中,当k=2时,先计算x(1)到x(2)的可达距离,此时距x(1)第2近的点是x(4): 再来看看x(2)到x(1)的可达距离,距x(2)第2近的点是x(3): 由此可见:局部可达密度 点与点之间的密度很容易理解,点之间距离越远,密度越低,距离越近,密度越⾼。

比例尺标度的最大值300km

比例尺标度的最大值300km

比例尺标度的最大值是300km,这意味着这个比例尺用于表示最大的距离是300km。

具体而言,根据这个比例尺,1个单位长度代表了300km的实际距离。

当在这个比例尺上表示距离时,最大只能表示到300km,超过这个距离就需要更大的比例尺或者拆分成多段来表示。

例如,如果要表示400km的距离,那么在300km的比例尺上就无法直接表示,需要使用更大的比例尺或者将400km的距离拆分成100km和300km两段来表示。

因此,在设计地图、规划图等需要使用比例尺的场合时,需要根据实际需求选择合适的比例尺标度,以确保能够准确、清晰地表示所需的距离和范围。

同时,了解比例尺的最大值也能够帮助使用者更好地理解地图、规划图上的信息,避免因比例尺不当导致误导或者信息不准确的情况发生。

两点间距离公式斜率带k推导

两点间距离公式斜率带k推导在几何中,我们经常需要计算两点之间的距离。

这在很多领域中都是一个重要的概念,例如数学、物理学和计算机图形学等。

计算两点之间的距离可以帮助我们理解它们之间的相对位置和空间关系。

本文将介绍一种通过斜率带k推导两点间距离公式的方法。

1. 引言给定直角坐标系中的两点,我们可以使用勾股定理来计算它们之间的距离。

勾股定理表达了直角三角形的斜边长度与两个直角边长度之间的关系。

然而,当我们只知道两点的坐标而不知道它们之间的直角边时,我们不能直接使用勾股定理。

2. 斜率的概念斜率是一个用于描述直线的概念。

在直角坐标系中,斜率定义为直线上任意两点在x轴和y轴上的坐标差之比。

假设我们有两个点P1(x1, y1)和P2(x2, y2),我们可以使用以下公式来计算这两点之间的斜率:k = (y2 - y1) / (x2 - x1)这个斜率k描述了直线在x轴上每增加一个单位,y轴上的变化量。

通过斜率,我们可以得到直线的相关性质,如方向和趋势。

3. 使用斜率推导两点间距离公式现在,我们将使用斜率来推导两点间的距离公式。

假设我们有两个点P1(x1, y1)和P2(x2, y2)。

我们可以使用勾股定理计算这两点之间的距离d:d = sqrt((x2 - x1)^2 + (y2 - y1)^2)接下来,我们将使用斜率来表示y坐标与x坐标之间的关系。

我们从斜率定义开始:k = (y2 - y1) / (x2 - x1)通过移项,我们可以将上述公式改写为:y2 - y1 = k * (x2 - x1)接下来,我们将x轴和y轴上的坐标差之比替换为斜率k:d = sqrt((x2 - x1)^2 + k^2 * (x2 - x1)^2)将上式进行化简,得到:d = sqrt((x2 - x1)^2 * (1 + k^2))继续进行化简:d = sqrt((x2^2 - 2 * x1 * x2 + x1^2) * (1 + k^2))继续展开,得到:d = sqrt(x2^2 - 2 * x1 * x2 + x1^2 + k^2 * (x2^2 - 2 * x1 * x2 + x1^2))合并同类项,得到:d = sqrt(x2^2 - 2 * x1 * x2 + x1^2 + k^2 * x2^2 - 2 * k^2 * x1 * x2 + k^2 * x1^2)继续合并同类项,得到最终的两点间距离公式:d = sqrt((1 + k^2) * (x2^2 - 2 * x1 * x2 + x1^2))4. 结论通过使用斜率来推导两点间的距离公式,我们得到了如下结果:d = sqrt((1 + k^2) * (x2^2 - 2 * x1 * x2 + x1^2))这个公式可以帮助我们计算直角坐标系中任意两点之间的距离,而无需使用勾股定理。

轮廓系数判断k的最优的原理

轮廓系数判断k的最优的原理在聚类算法中,确定聚类数量k是一个重要的问题。

过多或过少的聚类数量都会导致聚类结果的不准确性。

轮廓系数是一种常用的评估指标,用于衡量聚类结果的紧密度和分离度,从而帮助确定最优的聚类数量k。

轮廓系数的计算过程相对简单,其基本思想是将每个样本的轮廓系数计算出来,然后对所有样本的轮廓系数求平均值。

具体计算公式如下:轮廓系数 = (b - a) / max(a, b)其中,a表示样本与同一簇内其他样本的平均距离,b表示样本与最近簇内样本的平均距离。

轮廓系数的取值范围在[-1, 1]之间,越接近1表示聚类结果越好,越接近-1表示聚类结果越差。

根据轮廓系数的计算原理,我们可以通过以下步骤来判断k的最优值:1. 初始化k的取值范围,一般从2开始,因为至少需要两个样本才能进行聚类。

2. 对每个k值进行聚类,并计算聚类结果的轮廓系数。

3. 比较不同k值下的轮廓系数,选择轮廓系数最大的k值作为最优的聚类数量。

4. 如果轮廓系数在某个k值上达到了最大值,但仍然较低,可以尝试增加k值继续进行聚类,直到找到满意的聚类结果。

需要注意的是,轮廓系数作为一种评估指标,并不是绝对准确的。

它只是通过计算样本间的距离来评估聚类结果的紧密度和分离度,无法解决聚类中的一些特殊情况,比如存在噪音或重叠数据。

因此,在使用轮廓系数判断k的最优时,还需结合实际问题和经验进行综合考虑。

除了轮廓系数,还有其他一些常用的评估指标,如Davies-Bouldin 指数和Calinski-Harabasz指数。

这些指标在一定程度上可以补充轮廓系数的不足,帮助更准确地判断聚类数量k的最优值。

轮廓系数是一种常用的评估指标,可以帮助我们判断聚类结果的好坏,并确定最优的聚类数量k。

在实际应用中,我们可以根据轮廓系数的计算原理,结合其他评估指标和实际问题,选择合适的k值,从而得到更准确和可解释的聚类结果。

k最近距离法

k最近距离法k最近距离法是一种常用的机器学习算法,用于解决分类、回归和聚类问题。

它基于一个简单的原理,即根据最近邻的距离来确定一个样本的类别或属性。

本文将介绍k最近距离法的基本原理、应用场景以及实现步骤。

首先,我们来了解k最近距离法的基本原理。

在k最近距离法中,k代表的是选择的最近邻的个数。

该算法的核心思想是根据k个最近邻的距离来判断一个样本的类别或属性。

具体来说,对于一个未知样本,k最近距离法会计算该样本与训练集中所有样本的距离,并选择最近的k个样本。

然后,通过对这k个最近邻的类别或属性进行统计,来确定该未知样本的类别或属性。

k最近距离法的应用场景非常广泛。

例如,在分类问题中,可以使用k最近距离法来判断一个新样本属于哪个类别。

在回归问题中,k最近距离法可以用来预测一个样本的数值属性。

此外,k最近距离法还可以用于聚类问题,通过将样本划分为不同的簇来发现数据中的隐藏结构。

接下来,我们将介绍k最近距离法的实现步骤。

首先,需要准备一个带有标签或属性的训练集。

然后,对于一个未知样本,需要计算该样本与训练集中所有样本的距离。

常用的距离度量方法包括欧几里得距离和曼哈顿距离。

接下来,选择最近的k个样本,并根据这k个样本的标签或属性进行统计。

最后,根据统计结果来判断未知样本的类别或属性。

在实际应用中,我们还需要选择合适的k值。

k值的选择对于算法的性能有着重要的影响。

当k值过小时,模型的复杂度会增加,容易受到异常值的影响。

而当k值过大时,模型的偏差会增大,可能导致欠拟合的问题。

因此,选择合适的k值是使用k最近距离法的关键之一。

总结起来,k最近距离法是一种简单而有效的机器学习算法。

它基于最近邻的距离来判断样本的类别或属性,适用于分类、回归和聚类问题。

在实际应用中,我们需要选择合适的k值,并根据训练集和测试集的性能评估来确定算法的效果。

通过了解和掌握k最近距离法的基本原理和实现步骤,我们可以更好地应用该算法来解决实际问题。

距离聚类算法

距离聚类算法

距离聚类是一种常见的聚类算法,它基于样本之间的相似性度量(通常是距离)来将样本分组为不同的簇。

在距离聚类中,每个样本都被视为一个数据点,并且聚类的目标是将相似的数据点分配到同一个簇中,从而使得同一簇内的数据点之间的距离最小化。

距离聚类算法的常见代表包括以下几种:

1. K均值聚类(K-means clustering):K均值聚类是一种迭代的聚类算法,它将样本分为K个簇,其中K是用户指定的参数。

该算法通过不断迭代优化每个簇的质心位置,使得簇内样本之间的平均距离最小化。

2. 层次聚类(Hierarchical clustering):层次聚类是一种自底向上或自顶向下的聚类方法。

自底向上的方法(凝聚型层次聚类)首先将每个样本视为一个簇,然后逐步合并最相似的簇,直到形成一个大的簇,或者达到预设的簇的数量。

自顶向下的方法(分裂型层次聚类)首先将所有的样本视为一个簇,然后逐步将簇划分为更小的子簇,直到达到预设的簇的数量。

3. 密度聚类(Density-based clustering):密度聚类算法基于样本的密度来划分簇。

它将高密度区域视为一个簇,而低密度区域被视为簇的边界或噪音。

DBSCAN(Density-Based Spatial Clustering of Applications with Noise)是密度聚类的一个常见算法。

这些算法中,K均值聚类是最常见且实现简单的一种距离聚类算法。

但需要注意的是,使用距离聚类算法时,需要根据具体的数据特点和应用场景选择适合的距离度量方法(如欧氏距离、曼哈顿距离等)和合适的簇的数量(对于K均值聚类)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

西安邮电大学(计算机学院)课内实验报告实验名称:最大 k 乘积问题专业名称:班级:学生姓名:学号(8位):指导教师:实验日期:一.实验目的及实验环境实验目的:1)理解动态规划算法的概念2)掌握动态规划算法的基本要素3)掌握设计动态规划算法的步骤4)针对具体问题,能应用动态规划法设计有效算法5)用C++实现算法,并且分析算法的效率实验环境:CPU:2.40GHz内存:4.00GB操作系统:Windows 8.1中文版软件平台:Microsoft Visual Studio 2010二. 实验内容【问题描述】设k是一个n位十进制整数。

如果将I划分为k段,则可以得到k个整数。

这k个整数的乘积成为一个I的k乘积。

试设计一个算法,对于给定的I和k,求出I 的最大k乘积。

【算法设计】对于给定的I 和k,计算I的最大k乘积【数据输入】由文件input.txt提供输入数据。

文件的第一行中有两个正整数n和k。

正整数n是序列的长度,正整数k是分割的段数。

在接下来的一行中是一个n位十进制整数(n<=10)。

【结果输出】将计算结果输出到文件output.txt。

文件的第一行数是计算出来的最大k 乘积。

输入文件示例输出文件示例Input.txt output.txt2 1 1515三.方案设计【思想分析】:假设给定正整数I。

I(s,t)是I的s位开始的t位数字组成的十进制数。

R(i,j)表示I(0,i)的j乘积。

假定j乘积的第j段的起始位置为第w位,其中1<w<=j。

显然存在关系:R(i,j)= R(i,j-1)× I(w,j-w)。

设maxI[i][j]表示I(0,j)的最大j 乘积,则原始问题的最优值为maxI[n][k]。

(1)当k = 1时,maxI[n][1] = I(0,n)。

(2)当k!= 1时,若计算max[n][k]的第k段的起始位置为第w位。

1<w<=j。

则有maxI[n][k] = maxI[w][k-1]×I(w, n-w)。

由于在计算时不知道第k 段的起始位置w,w未定。

但w的取值只有n-k+2种可能,也即k-1<=w<=n。

所以maxI[n][k]可以递归地定义为:max[n][k]给出了最优值,同时还确定了计算最优值的断开位置w,也即对于这个w有:max[n][k] = maxI[w][k-1]×I(w, n-w)。

若将对应于max[n][k]的断开位置w记为dt[n][k]后,就可以递归地由dt[n][k]构造相应的最优解。

【代码分析】:1)main()函数:(1)打开文件input.txt。

得到n和k以及number的值。

(2)申请动态内存空间。

(3)调用void GetMax()函数得到最优值。

(4)屏幕上以连乘的方式输出最优解。

(5)释放内存空间。

2)int GetValue(int s, int t, string str);这个函数的功能其实就是实现题目中的I(s, t);将字符串转换为正整数并返回。

3)void GetMax(int n, int k, int** maxI, int** dt, string str) 这个函数是求出最优值和最优解。

(1)当k=1时,最优解maxI[n][1]就是I(0, n);(2)初始化二维表右上角的值,它们在实际运算中是用不到的。

(3)三层循环计算最优值。

(4)将结果最优值写入output.txt文件。

4)int Init();这个函数是一个测试用例。

用来检验代码的正确性。

在主函数中屏蔽这个函数,则不用随机数生成数据,而是自己从文件中输入。

不屏蔽这个函数的话,则可以每次运行产生不同的结果。

四.测试数据及运行结果1.正常测试数据(3组)及运行结果;(1)(2)(3)2.非正常测试数据(2组)及运行结果。

五.总结1.实验过程中遇到的问题及解决办法;问题:(1)如何生成随机数才能达到题目的要求。

(2)如何将字符串转换为整数。

(3)刚开始往文件中写入随机数产生的数字时,屏幕上显示正确,文件中总是有乱码。

(4)K=1时产生的最优值在文件中总是无法显示。

(5)在屏幕上以连乘方式显示结果时无法正确显示结果,总是多一个乘号。

(6)如何用getline()读取一行数据后,将值赋给两个变量。

解决办法:(1)题目要求的n,k以及number相互之间是有联系的。

先生成n再根据n生成适当的数字给k和number。

由于想用str.substr(s,t)来完成实现I(s, t),所以要往GetValue()中传入字符串。

因此产生随机数来实现number的赋值时,必须要用字符数组,然后把字符数组转换为字符串 string str(&number[0],&number[strlen(number)]);再传入。

(2)atoi()函数可以将字符串转换为整数。

(3)发现文件流用的是fstream,改为ofstream后解决了问题。

(4)发现是往文件中写入数据的那段代码的位置写错了。

调整后问题解决。

(5)改变了一下策略,将最后一个数字单独输出。

问题解决。

(6)stringstream文件流。

问题解决。

2.对设计及调试过程的心得体会。

这次的上机实验难度较大。

算法思路比较难想。

还有用随机数生成适当的结果写入到文件也是一个比较难的地方。

用到了几个在这段代码中比较重要的函数。

比如说str.substr(startpos, length);以及const char *c_str();等等。

在调试过程中,一定要把题目的逻辑思考清楚。

只有搞清楚了自己想做什么,才知道下一步怎么做,才能对代码的框架有一个比较完整的理解。

通过这次上机,我对动态规划法有了更深一步的理解,应用得更加熟练。

以后要多加练习,掌握得更加牢固。

六.附录:源代码(电子版)#include<iostream>#include<fstream>#include<string.h>#include<sstream>#include<time.h>using namespace std;int Init(){int n;int k;int i;char* number = NULL;srand((unsigned)time( NULL ));n = rand()%10 + 1;k = rand()%n +1;number = new char[n+1];memset(number,'\0',sizeof(char)*(n+1));number[0] = rand()%9+49;for(i = 1;i < n;i++){number[i] = rand()%10+48;}number[n]='\0';cout<<"序?长¤度è为a:阰"<<n<<endl<<"分?割?的?段?数簓为a:阰"<<k<<endl;cout<<"n位?正y整?数簓为a:阰";for(i = 0;i <= n;i++){cout<<number[i];}cout<<endl;ofstream input("F:\\input.txt");if(!input.is_open()){cout<<"文?件t打洙?开a失骸?败悒?<<endl;return -1;}input<<n<<" "<<k<<'\n';for(i = 0;i <= n;i++){input<<number[i];}input.close();}//I(s,t)int GetValue(int s, int t, string str){string strtemp;strtemp = str.substr(s,t);return atoi(strtemp.c_str());}void GetMax(int n, int k, int** maxI, int** dt, string str) {int i;int j;int w;int result;int tmax;int kt = 0;for(i = 1; i <= n;i++){maxI[i][1] = GetValue(0,i,str);}for(i = 1;i < n;i++){for(j = i+1;j < k;j++){maxI[i][j] = 0;}}for(j = 2;j <= k;j++){for(i = j; i <= n;i++){result = 0;for(w = 1;w < i ;w++){tmax = maxI[w][j-1] * GetValue(w,i-w,str);if(result <= tmax){result = tmax;kt = w;}}maxI[i][j] = result;dt[i][j] = kt;}}ofstream output("F:\\output.txt");output<<maxI[n][k]<<endl;output.close();}int main(){int n;int k;int i;int j;int **MAX;int **Dt;int *p;char* str1 = new char[80];char* number = new char[80];memset(str1,0,sizeof(char)*80);memset(number,0,sizeof(char)*80);//Init(); //可以调用也可以屏蔽ifstream input("F:\\input.txt");if(!input.is_open()){cout<<"文?件t打洙?开a失骸?败悒?<<endl;return -1;}input.getline(str1,80);stringstream s(str1);s>>n>>k;cout<<"长¤度èn="<<n<<" "<<"分?割?数簓k="<<k<<endl;input.getline(number,80);cout<<"a:阰"<<number<<endl;if(n < k){cout<<"输?入?错洙?误ó!?!?"<<endl;return -1;}if(n != strlen(number)){cout<<"输?入?与?实害?际ê不?符?!?!?"<<endl;return -1;}MAX = new int*[n+1];for(i = 0;i<= n;i++){MAX[i] = new int[k+1];}Dt = new int*[n+1];for(i = 0;i <= n;i++){Dt[i] = new int[k+1];}p = new int[k+1];string str(&number[0],&number[strlen(number)]);GetMax(n,k,MAX,Dt,str);for(int i = k,q = n;i >= 1 && q > 0;i--){p[i] = q;q = Dt[q][i];}p[0] = 0;for(j = 0;j < k-1;j++){cout<<(str.substr(p[j],p[j+1]-p[j])).c_str()<<" ×á ";}cout<<(str.substr(p[j],p[j+1]-p[j])).c_str()<<" = "<<MAX[n][k]<<endl;for(int i = 0; i<= n;i++){delete MAX[i];}for(int i = 0;i <= n;i++){delete Dt[i];}delete []MAX;delete []Dt;delete []p;delete str1;delete number;return 0;}。