WordCount运行全程录

Hadoop的配置及运行WordCount

Hadoop的配置及运行WordCount目录Hadoop的配置及运行WordCount (1)一、环境: (1)二、步骤: (1)1 JDK及SSH安装配置: (1)1.1 卸载Fedora自带的OpenJDK,安装Oracle的JDK (1)1.2 配置SSH (2)2 Hadoop安装配置: (4)2.1 下载并配置Hadoop的JDK环境 (4)2.2 为系统配置Hadoop环境变量 (5)2.3 修改Hadoop的配置文件 (6)2.4 初始化HDFS文件系统,和启动Hadoop (8)2.5 关闭HDFS (11)3 运行WordCount: (11)3.1 下载和编译WordCount示例 (11)3.2 建立文本文件并上传至DFS (13)3.3 MapReduce执行过程显示信息 (14)结尾: (15)一、环境:计算机Fedora 20、jdk1.7.0_60、Hadoop-2.2.0二、步骤:1 JDK及SSH安装配置:1.1 卸载Fedora自带的OpenJDK,安装Oracle的JDK*由于Hadoop,无法使用OpenJDK,所以的下载安装Oracle的JDK。

1.1.1、以下为卸载再带的OpenJDK:然后到/technetwork/java/javase/downloads/index.html下载jdk,可以下载rpm格式的安装包或解压版的。

rpm版本的下载完毕后可以运行安装,一般会自动安装在/usr/java/的路径下面。

接下来就配置jdk的环境变量了。

1.1.2、进入到系统的环境变量配置文件,加入以下内容:(按i进行编辑,编辑完毕按ESC,输入:wq,回车即保存退出)截图如下:Java环境变量配置输入这个回车即可保存退出java –version,检测配置是否成功。

如下结果则Java 配置安装成功。

1.2 配置SSH搭建hadoop分布式集群平台,为了实现通讯之间的可靠,防止远程管理过程中的信息泄露问题。

《大数据技术原理与应用》实验一WordCount

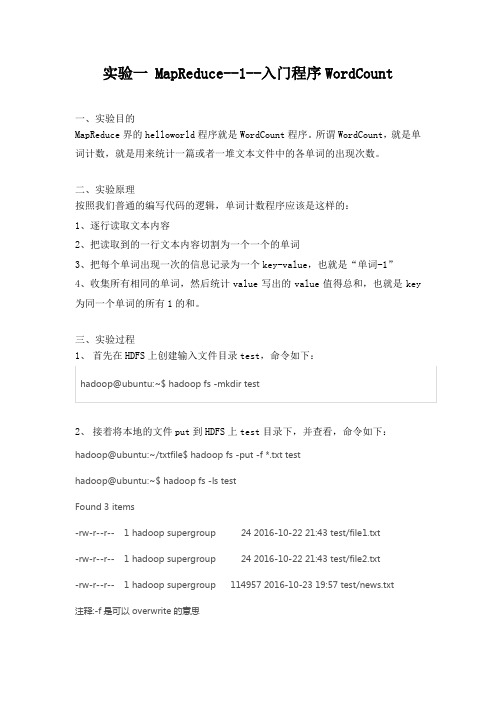

实验一 MapReduce--1--入门程序WordCount一、实验目的MapReduce界的helloworld程序就是WordCount程序。

所谓WordCount,就是单词计数,就是用来统计一篇或者一堆文本文件中的各单词的出现次数。

二、实验原理按照我们普通的编写代码的逻辑,单词计数程序应该是这样的:1、逐行读取文本内容2、把读取到的一行文本内容切割为一个一个的单词3、把每个单词出现一次的信息记录为一个key-value,也就是“单词-1”4、收集所有相同的单词,然后统计value写出的value值得总和,也就是key 为同一个单词的所有1的和。

三、实验过程1、首先在HDFS上创建输入文件目录test,命令如下:hadoop@ubuntu:~$ hadoop fs -mkdir test2、接着将本地的文件put到HDFS上test目录下,并查看,命令如下:hadoop@ubuntu:~/txtfile$ hadoop fs -put -f *.txt testhadoop@ubuntu:~$ hadoop fs -ls testFound 3 items-rw-r--r-- 1 hadoop supergroup 24 2016-10-22 21:43 test/file1.txt-rw-r--r-- 1 hadoop supergroup 24 2016-10-22 21:43 test/file2.txt-rw-r--r-- 1 hadoop supergroup 114957 2016-10-23 19:57 test/news.txt注释:-f是可以overwrite的意思3、使用InteliJ新建一个Javaproject,编写wordcount程序,如下所示:package example;import org.apache.hadoop.fs.Path;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.LongWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapred.*;import java.io.IOException;import java.util.Iterator;import java.util.StringTokenizer;/*** Created by hadoop on 10/22/16.*/public class WordCount {///Mapper: <LongWritable Text> project to <Text IntWritable>public static class Map extends MapReduceBase implementsMapper<LongWritable, Text, Text, IntWritable> {private final static IntWritable one = new IntWritable(1);private Text word = new Text();///reporter report the progress or they are livepublic void map(LongWritable key, Text value, OutputCollector<Text, IntWritable> output, Reporter reporter) throws IOException {String line = value.toString();StringTokenizer tokenizer = new StringTokenizer(line);while (tokenizer.hasMoreTokens()) {//set change string to Textword.set(tokenizer.nextToken());output.collect(word, one); }}}public static class Reduce extends MapReduceBase implements Reducer<Text, IntWritable, Text, IntWritable> {///is called for every key///IntWritable:you can use it as intpublic void reduce(Text key, Iterator<IntWritable> values, OutputCollector<Text, IntWritable> output, Reporter reporter) throws IOException {int sum = 0;while (values.hasNext()) {sum += values.next().get(); }output.collect(key, new IntWritable(sum)); } }public static void main(String[] args) throws Exception {JobConf conf = new JobConf(WordCount.class);conf.setJobName("wordcount");conf.setOutputKeyClass(Text.class);conf.setOutputValueClass(IntWritable.class);conf.setMapperClass(Map.class);//conf.setCombinerClass(Reduce.class);conf.setReducerClass(Reduce.class);//input formatconf.setInputFormat(TextInputFormat.class);conf.setOutputFormat(TextOutputFormat.class);FileInputFormat.setInputPaths(conf, new Path(args[0]));FileOutputFormat.setOutputPath(conf, new Path(args[1]));JobClient.runJob(conf); }}4、导出jar包File->Project Structure->Artifacts->绿色“+”->JAR->From modules with dependcies->applyBuild->Build Artifacts5、运行jar包hadoop@ubuntu:~/txtfile$ hadoop jar WordCount.jar test test-out6、最后查看HDFS上的结果并将结果get到本地hadoop@ubuntu:~$ hadoop fs -ls test-outFound 2 items-rw-r--r-- 1 hadoop supergroup 0 2016-10-23 00:59 test-out/_SUCCESS-rw-r--r-- 1 hadoop supergroup 40 2016-10-23 00:59 test-out/part-00000 hadoop@ubuntu:~/exp$ hadoop fs -get /user/hadoop/test_out/part-r-00000 .四、实验结果运行jar包之后,使用浏览器登录http://localhost:8088,点击左侧Node Labels,可以看到运行状态如图1.在bash下查看实验输出结果,如图2所示。

Hadoop世界中的HelloWorld之WordCount具体分析

Hadoop世界中的HelloWorld之WordCount具体分析MapReduce 应⽤举例:单词计数WorldCount可以说是MapReduce中的helloworld了,下⾯来看看hadoop中的例⼦worldcount对其进⾏的处理过程,也能对mapreduce的执⾏过程有⼀个清晰的认识,特别是对于每⼀个阶段的函数执⾏所产⽣的键值对单词计数主要完成的功能是:统计⼀系列⽂本⽂件中每个单词出现的次数,如下图所⽰。

下⾯将通过分析源代码帮助读者摸清 MapReduce程序的基本结构。

图 3-1 单词计数WordCount 详细的执⾏步骤如下:(1) 将⽂件拆分成 splits,由于测试⽤的⽂件较⼩,所以每个⽂件为⼀个 split,并将⽂件按⾏分割形成<key, value>对,如图 3-2 所⽰。

这⼀步由 MapReduce 框架⾃动完成,其中偏移量(即 key 值)包括了回车所占的字符数(Windows 和 Linux 环境下会不同)。

图 3-2 分割过程(2) 将分割好的<key, value>对交给⽤户定义的 map ⽅法进⾏处理,⽣成新的<key, value> 对,如图 3-3 所⽰。

图 3-3 执⾏ map(3) 得到 map ⽅法输出的<key, value>对后,Mapper 会将它们按照 key 值进⾏排序,并执⾏ Combine 过程,将 key 值相同的 value 值累加,得到 Mapper 的最终输出结果。

图 3-4 map 端排序以及 combine 过程(4) Reducer 先对从 Mapper 接收的数据进⾏排序,再交由⽤户⾃定义的 reduce ⽅法进⾏处理,得到新的<key, value>对,并作为WordCount 的输出结果,如图 3-5 所⽰。

图 3-5 reduce 端排序以及输出结果以上就是wordcount在mapreduce中执⾏的具体细节,这⾥⾯对于中间的键值对产⽣描述的很详细,这是理解mapreduce很好的资料;下⾯来看看hadoop源码中提供的这⼀源代码:这份代码我的注释很详细,但是运⾏时需要导⼊很多包,还要给Eclipse配置hadoop的环境,这⾥主要是分析worldcount的源码;19import java.io.IOException;20import java.util.StringTokenizer;2122import org.apache.hadoop.conf.Configuration;2324import org.apache.hadoop.fs.Path;25import org.apache.hadoop.io.IntWritable;26import org.apache.hadoop.io.Text;27import org.apache.hadoop.mapreduce.Job;28import org.apache.hadoop.mapreduce.Mapper;29import org.apache.hadoop.mapreduce.Reducer;30import org.apache.hadoop.mapreduce.lib.input.FileInputFormat;31import org.apache.hadoop.mapreduce.lib.output.FileOutputFormat;32import org.apache.hadoop.util.GenericOptionsParser;3334public class WordCount {3536public static class TokenizerMapper extends Mapper<Object, Text, Text, IntWritable> {3738private final static IntWritable one = new IntWritable(1);// 初始的单词都是1次,即使重复39private Text word = new Text();// word表⽰单词40/*41 * 重写map⽅法,读取初试划分的每⼀个键值对,即⾏偏移量和⼀⾏字符串,key为偏移量,value为该⾏字符串42*/4344public void map(Object key, Text value, Context context) throws IOException, InterruptedException {45/*46 * 因为每⼀⾏就是⼀个spilt,并会为之⽣成⼀个mapper,所以我们的参数,key就是偏移量,value就是⼀⾏字符串47*/48 StringTokenizer itr = new StringTokenizer(value.toString());// value是⼀⾏的字符串,这⾥将其切割成多个单词49while (itr.hasMoreTokens()) {// 多个单词50 word.set(itr.nextToken());// 每个word51 context.write(word, one);// one代表1,最开始每个单词都是1次,context直接将<word,1>写到本地磁盘上52// write函数直接将两个参数封装成<key,value>53 }54 }55 }5657public static class IntSumReducer extends Reducer<Text, IntWritable, Text, IntWritable> {58private IntWritable result = new IntWritable();5960/*61 * 重写reduce函数,key为单词,values是reducer从多个mapper中得到数据后进⾏排序并将相同key组62 * 合成<key.list<V>>中的list<V>,也就是说明排序这些⼯作都是mapper和reducer⾃⼰去做的,63 * 我们只需要专注与在map和reduce函数中处理排序处理后的结果64*/65public void reduce(Text key, Iterable<IntWritable> values, Context context)66throws IOException, InterruptedException {67/*68 * 因为在同⼀个spilt对应的mapper中,会将其进⾏combine,使得其中单词(key)不重复,然后将这些键值对按照69 * hash函数分配给对应的reducer,reducer进⾏排序,和组合成list,然后再调⽤的⽤户⾃定义的这个函数,70 * 所以有values71 * 这⼀Iterable对象,说明,这个reducer排序后有多少个键值对,就会有多少次调⽤这个算法,每⼀次都会进⾏写,72 * 并且key在整个并⾏的多个节点中是唯⼀的73 *74*/75int sum = 0;76for (IntWritable val : values) {77 sum += val.get();78 }79 result.set(sum);80 context.write(key, result);81 }82 }8384public static void main(String[] args) throws Exception {85 Configuration conf = new Configuration();86 String[] otherArgs = new GenericOptionsParser(conf, args).getRemainingArgs();87if (otherArgs.length < 2) {88 System.err.println("Usage: wordcount <in> [<in>...] <out>");89 System.exit(2);90 }91 @SuppressWarnings("deprecation")92 Job job = new Job(conf, "word count");93 job.setJarByClass(WordCount.class);// 本次作业的job94 job.setMapperClass(TokenizerMapper.class);// map函数95 job.setCombinerClass(IntSumReducer.class);// combine的实现个reduce函数⼀样,都是将相同的单词组合成⼀个键值对96 job.setReducerClass(IntSumReducer.class);// reduce函数97 job.setOutputKeyClass(Text.class);// 键key的类型,98 job.setOutputValueClass(IntWritable.class);// value的类型99for (int i = 0; i < otherArgs.length - 1; ++i) {100 FileInputFormat.addInputPath(job, new Path(otherArgs[i]));//输⼊输出参数的获取,说明可以是多个输⼊⽂件101 }102 FileOutputFormat.setOutputPath(job, new Path(otherArgs[otherArgs.length - 1]));//参数的最后⼀个是输出⽂件103 System.exit(job.waitForCompletion(true) ? 0 : 1);104 }105 }。

利用Word的宏录制功能自动执行常用操作

利用Word的宏录制功能自动执行常用操作Word是一款广泛使用的文字处理软件,具备强大的功能和灵活的操作方式,对于日常办公和学习非常实用。

尤其是利用Word的宏录制功能,可以将常用操作自动化执行,提高工作效率。

本文将介绍如何利用Word的宏录制功能来自动执行常用操作。

一、什么是宏录制在Word中,宏录制是指将一系列操作录制下来,并将其保存为一个宏,以便以后可以自动执行这些操作。

通过宏录制,我们可以省去重复性操作的繁琐过程,提高工作效率。

二、开始录制宏1. 打开Word软件,点击“开发工具”选项卡,找到“宏”按钮。

点击“宏”按钮弹出“宏”对话框。

2. 在“宏”对话框中,可以输入宏的名称,比如“自动排版”。

宏的名称可以根据实际需要进行命名,方便后续使用和识别。

3. 点击“宏录制”按钮,开始录制宏操作。

三、录制常用操作在开始录制宏之前,我们需要明确需要录制的常用操作内容。

下面以自动排版为例,介绍如何录制常用操作。

1. 录制字体格式设置首先,我们需要设置默认的字体格式。

在录制宏过程中,可以手动设置字体大小、颜色、样式等,并将其保存为宏。

2. 录制段落格式设置其次,我们需要设置默认的段落格式。

例如,可以手动设置段落的对齐方式、行距、首行缩进等,并将其保存为宏。

3. 录制页眉页脚设置如果需要在文档中添加页眉页脚,可以在录制宏过程中手动添加并设置页眉页脚的内容、位置等,并将其保存为宏。

4. 录制插入图片和图表如果需要在文档中插入图片和图表,可以在录制宏过程中手动插入并设置图片和图表的样式、位置等,并将其保存为宏。

5. 录制保存文档最后,需要在录制宏过程中手动保存文档,并指定保存的路径和文件名,并将其保存为宏。

四、执行录制的宏完成上述录制过程后,可以点击“停止录制”按钮停止录制宏。

此时,我们已经完成了一个可以自动执行常用操作的宏。

在之后的使用过程中,只需要点击“开发工具”选项卡中的“宏”按钮,选择之前录制的宏名称,点击“运行”按钮即可自动执行录制的操作。

Hadoop集群(第6期)_WordCount运行详解

Hadoop集群(第6期)_WordCount运⾏详解1、MapReduce理论简介1.1 MapReduce编程模型 MapReduce采⽤"分⽽治之"的思想,把对⼤规模数据集的操作,分发给⼀个主节点管理下的各个分节点共同完成,然后通过整合各个节点的中间结果,得到最终结果。

简单地说,MapReduce就是"任务的分解与结果的汇总"。

在Hadoop中,⽤于执⾏MapReduce任务的机器⾓⾊有两个:⼀个是JobTracker;另⼀个是TaskTracker,JobTracker是⽤于调度⼯作的,TaskTracker是⽤于执⾏⼯作的。

⼀个Hadoop集群中只有⼀台JobTracker。

在分布式计算中,MapReduce框架负责处理了并⾏编程中分布式存储、⼯作调度、负载均衡、容错均衡、容错处理以及⽹络通信等复杂问题,把处理过程⾼度抽象为两个函数:map和reduce,map负责把任务分解成多个任务,reduce负责把分解后多任务处理的结果汇总起来。

需要注意的是,⽤MapReduce来处理的数据集(或任务)必须具备这样的特点:待处理的数据集可以分解成许多⼩的数据集,⽽且每⼀个⼩数据集都可以完全并⾏地进⾏处理。

1.2 MapReduce处理过程 在Hadoop中,每个MapReduce任务都被初始化为⼀个Job,每个Job⼜可以分为两种阶段:map阶段和reduce阶段。

这两个阶段分别⽤两个函数表⽰,即map函数和reduce函数。

map函数接收⼀个<key,value>形式的输⼊,然后同样产⽣⼀个<key,value>形式的中间输出,Hadoop函数接收⼀个如<key,(list of values)>形式的输⼊,然后对这个value集合进⾏处理,每个reduce产⽣0或1个输出,reduce的输出也是<key,value>形式的。

Word文档中使用宏录制和运行的步骤

Word文档中使用宏录制和运行的步骤在Word文档中使用宏录制和运行的步骤Word宏是一种记录和自动执行特定任务的功能,可以为用户在Word文档中的操作提供方便和效率。

宏可以录制和运行特定的操作序列,从而节省用户的时间和精力。

下面是在Word文档中使用宏录制和运行的步骤。

第一步:打开Word文档在您的电脑上打开Microsoft Word软件,并创建或打开您要使用宏的文档。

第二步:打开开发者选项在Word软件的顶部菜单栏中,单击“文件”选项,然后选择“选项”。

接下来,在弹出的选项窗口中,选择“自定义功能区”选项,并勾选“开发者选项”复选框,然后单击“确定”按钮。

现在,您将在Word软件的顶部菜单栏中看到一个名为“开发者”的选项卡。

第三步:录制宏单击顶部菜单栏上的“开发者”选项卡,然后单击“宏录制器”按钮。

在弹出的宏录制器窗口中,输入宏的名称,并选择您要将宏保存在哪个位置(通常选择“本文档”)。

接下来,单击“确定”按钮开始录制。

第四步:执行操作序列开始录制宏后,您所进行的任何操作都将被记录下来。

例如,您可以执行文本格式设置、插入图像、应用样式等操作。

所有这些操作将成为宏的一部分。

当您完成所有操作后,点击录制宏窗口的“停止录制”按钮。

第五步:保存宏录制完宏后,您需要将它保存在文档中。

单击“开发者”选项卡上的“宏”按钮,然后选择您刚刚录制的宏。

接着,点击“创建”按钮打开宏编辑器窗口。

在宏编辑器中,您可以对宏进行编辑和修改。

编辑完成后,关闭宏编辑器,然后单击“确定”按钮以保存宏。

第六步:运行宏现在,您可以随时运行所创建的宏。

在Word文档中,单击“开发者”选项卡上的“宏”按钮,选择您要运行的宏名称,然后点击“运行”按钮。

宏将自动执行您录制的操作序列,节省您的时间和劳动力。

总结:借助Word文档中的宏录制和运行功能,您可以快速有效地完成各种操作。

按照以上步骤,您可以轻松地录制和运行宏,提高文档处理的效率。

wordCount的执行流程

wordCount的执⾏流程 我们对于wordCount的这个流程,在清晰不过了,不过我们在使⽤spark以及hadoop本⾝的mapReduce的时候,我们是否理解其中的原理呢,今天我们就来介绍⼀下wordCount的执⾏原理, 1.⾸先我们都会这样⼦执⾏(wordCount执⾏在hadoop中) val rdd = sc.textFile("hdfs://weekday01:9000/wc").flatMap(_.split(" ")).map((_,1)).reduceByKey(_+_) rdd.saveAsTextFile("hdfs://weekday01:9000/out") 如果我们此时想看依赖的关系的话,我们可以这样操作 rdd.toDebugString(执⾏完这⼀步操作之后,你就可以看到你在hadoop中执⾏wordCount的这个过程,中间到底⽣成了 多少个rdd) 2.rdd与rdd的⼀些依赖关系 其实在我们每⼀次⽣成rdd的时候,都是由于后⾯的rdd要依赖前⾯的rdd 3.Lineage(⾎统) RDD只⽀持粗粒度转换,即在⼤量记录上执⾏的单个操作。

将创建RDD的⼀系列Lineage记录下来,以便恢复丢失 的分区, 此时rdd不会记录这个⾎统中的各个rdd的具体的值是多少。

RDD的Lineage会记录RDD的元数据信息和转换⾏为, 当该RDD的部分分区数据丢失时,它可以根据这些信息来重新运算和恢复丢失的数据分区 4.内部实现细节 1.textFile会产⽣两个RDD,1.HadoopRDD,为什么第⼀个是HadoopRDD,因为我们需要在hadoop⾥⾯读取数据, 读取数据的时候是以(key,value)的形式读取数据,其中的可以是偏移量,⽽value是⼀⾏的数据, 2.MapPartitionsRDD,以为我们调⽤了map⽅法,⽽这其中的map的作⽤是把key取消掉了,从⽽我们把value取出来 2.xxx.flatMap,则这个产⽣⼀个RDD,即MapPartionsRDD, 3.map((_,1)),这个是读取每⼀⾏的数据,然后在对每⼀⾏进⾏操作,然后在⽣成⼀个MapPartitionsRDD, 经过这个RDD之后,这个⾥⾯装的都是(key,value)类型的数据 4.reduceByKey,这个⾥⾯new了⼀个ShuffleRDD,要进⾏聚合,这个会经历两次聚合,第⼀聚合是在这个分区⾥⾯, 当聚合完成之后,从上游拉下来,在进⾏总体的聚合,这就是所谓的先分区,在总体 5..saveAsTextFile(path:String),因为这个的操作是往hdfs写数据,所以我们需要拿到hdfs的流,不过如果我们⽤map的话, 就相当于我的每⼀条数据我都会拿⼀个流,这样浪费资源,所以此时的我,使⽤的是mapPartition(),则此时是拿取⼀个分区⾥ ⾯的数据,我们拿⼀个流,把这⼀个分区的数据都写进去 综上所述,⼀共产⽣了6个RDD/*** Created by root on 2016/5/14.*/object WordCount {def main(args: Array[String]) {//⾮常重要,是通向Spark集群的⼊⼝val conf = new SparkConf().setAppName("WC").setJars(Array("C:\\HelloSpark\\target\\hello-spark-1.0.jar")).setMaster("spark://:7077")val sc = new SparkContext(conf)//textFile会产⽣两个RDD:HadoopRDD -> MapPartitinsRDDsc.textFile(args(0)).cache()// 产⽣⼀个RDD :MapPartitinsRDD.flatMap(_.split(""))//产⽣⼀个RDD MapPartitionsRDD.map((_, 1))//产⽣⼀个RDD ShuffledRDD.reduceByKey(_+_)//产⽣⼀个RDD: mapPartitions.saveAsTextFile(args(1))sc.stop()}} 流程图。

hadoop运行wordcount实例

3、运行实例出现IO异常,原因是datanode未启动,具体原因是运行hadoop namenode -format时只格式化了namenode导致datanode信息与namenode信息不一致导致不能启动,解决办法:找到问题1中的tmp,删除tmp下所有文件,然后打开cygwin,运行hadoop namenode -format再启动start-all.sh问题解决

3、运行指令 bin/hadoop fs -mkdir input4、运行指令 bin/hadoop fs -put f1.txt input 将f1.txt复制到input文件夹下,运行bin/hadoop fs -ls input查看是否复制成功

运行hadoop自带wordcount实例步骤:

1、打开cygwin,启动hadoop,运行jps命令查看节点启动情况

2、切换到hadoop根目录,运行指令 echo "hello boy hei baby hello word hello hadoop baby girl baby">f1.txt 在hadoop根目录下新建f1.txt,可用-ls 查看是否创建成功

5、运行指令 bin/hadoop jar hadoop-0.20.2-examples.jar wordcount input output 并输出到output文件夹下

6、运行指令 bin/hadoop fs -cat output/* 查看输出结果,即词频统计结果

启动hadoop常见问题:

1、启动hadoop出现java no such file or directory,解决办法:cygwin下运行命令dos2unix conf/hadoop-env.sh,将hadoop-env.sh

Word中的宏录制和运行功能提高工作效率

Word中的宏录制和运行功能提高工作效率在 Word 中,宏录制和运行功能是提高工作效率的重要工具之一。

宏是一系列的操作命令和步骤的集合,可以被录制并保存下来,然后可以通过运行宏来自动执行这些命令和步骤,从而省去了重复性的劳动。

下面将详细介绍 Word 中的宏录制和运行功能以及如何有效利用它们提高工作效率。

一、宏录制功能宏录制功能可以将用户在 Word 中执行的一系列操作录制下来,包括文本输入、格式设置、样式应用、插入图片等等。

通过录制宏,可以将反复出现的操作步骤记录下来,并且可以自定义快捷键或将宏添加到工具栏上,方便以后的使用。

录制宏的方法如下:1. 打开 Word 文件,点击 "视图" 选项卡,在 "宏" 组中点击 "宏录制"。

2. 在 "宏名称" 对话框中输入宏的名称,然后点击 "确定"。

3. 在录制宏之前,可以先进行一些准备工作,例如设置页面格式、插入表格等。

4. 点击 "停止录制" 按钮,结束录制。

需要注意的是,录制宏时要小心不要包含任何个人敏感信息,以免泄露。

二、宏的运行功能录制完成后,就可以运行宏来自动执行之前录制的操作命令和步骤了。

Word 提供了多个运行宏的方式:1. 快捷键运行:可以为宏设置一个自定义的快捷键,通过按下快捷键来运行宏。

设置快捷键的方法是:点击"文件" 选项卡,选择"选项",在弹出的对话框中选择 "自定义功能区",然后找到并选中 "宏",点击 "新建组" 和 "新增命令",选择相应的宏并为其设置快捷键。

2. 工具栏运行:可以将宏添加到 Word 的工具栏上,通过点击工具栏上的按钮来运行宏。

添加宏到工具栏的方法是:点击"文件" 选项卡,选择 "选项",在弹出的对话框中选择 "自定义功能区",然后找到并选中 "宏",点击 "新建组" 和 "新增命令",选择相应的宏并将其添加到工具栏上。

Word中的宏录制和运行技巧自动化重复任务

Word中的宏录制和运行技巧自动化重复任务Word是一款广泛使用的办公软件,它不仅可以帮助我们创建和编辑文档,还提供了一些实用的功能来简化重复性的任务。

其中,宏录制和运行技巧就是一种自动化操作的方式,可以极大地提高我们的工作效率。

本文将介绍Word中的宏录制和一些运行技巧,帮助读者更好地利用这些功能。

一、宏录制的基本操作宏录制是将一系列操作记录下来,以便在以后使用相同的方式自动执行。

下面是宏录制的基本操作流程:1. 打开Word软件,点击菜单栏中的“开发工具”选项卡,找到“宏”按钮,点击进入宏录制界面。

2. 在宏录制界面中,输入宏的名称并选择宏的存储位置。

一般来说,我们可以选择将宏存储在全局模板中,这样在任何Word文档中都可以使用。

3. 开始录制宏之前,可以选择设置宏的快捷键或添加按钮,以方便快速运行宏。

设置完成后,点击“确定”按钮。

4. 此时,Word将开始记录您的操作。

您可以执行任何您希望在宏中自动执行的操作,比如插入文字、格式调整、添加图片等。

注意,所有的操作都会被记录下来。

5. 当您完成了所有的操作后,返回到宏录制界面,点击“停止录制”按钮。

宏就会保存。

二、宏运行技巧宏的录制方法我们已经介绍完了,接下来是如何运行宏的技巧。

以下是一些常用的运行宏的方式:1. 使用快捷键:通过在宏录制过程中设置快捷键,您可以在任何时候通过按下对应的组合键来运行宏。

这是最常用的一种运行宏的方式。

2. 添加到工具栏:您还可以将宏添加到Word工具栏中,以便在单击按钮时运行宏。

这种方法尤其适用于经常使用的宏。

3. 使用宏列表:Word软件还提供了一个宏列表,您可以在其中选择您要运行的宏。

4. 使用宏窗口:按下“ALT+F8”快捷键,可以打开宏窗口,您可以在其中选择和运行宏。

5. 配置自动运行:如果您希望在打开文档时自动运行某个特定的宏,可以在Word选项中进行相关配置。

三、其他宏的使用技巧除了宏录制和运行之外,Word中还有一些其他有用的宏技巧可以帮助您更好地利用宏功能。

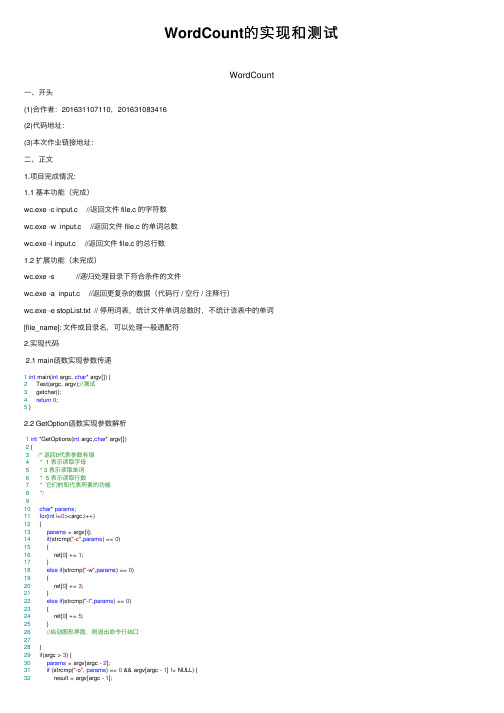

WordCount的实现和测试

WordCount的实现和测试WordCount⼀、开头(1)合作者:201631107110,201631083416(2)代码地址:(3)本次作业链接地址:⼆、正⽂1.项⽬完成情况:1.1 基本功能(完成)wc.exe -c input.c //返回⽂件 file.c 的字符数wc.exe -w input.c //返回⽂件 file.c 的单词总数wc.exe -l input.c //返回⽂件 file.c 的总⾏数1.2 扩展功能(未完成)wc.exe -s //递归处理⽬录下符合条件的⽂件wc.exe -a input.c //返回更复杂的数据(代码⾏ / 空⾏ / 注释⾏)wc.exe -e stopList.txt // 停⽤词表,统计⽂件单词总数时,不统计该表中的单词[file_name]: ⽂件或⽬录名,可以处理⼀般通配符2.实现代码2.1 main函数实现参数传递1int main(int argc, char* argv[]) {2 Test(argc, argv);//测试3 getchar();4return0;5 }2.2 GetOption函数实现参数解析1int *GetOptions(int argc,char* argv[])2 {3/* 返回0代表参数有错4 * 1 表⽰读取字母5 * 3 表⽰读取单词6 * 5 表⽰读取⾏数7 * 它们的和代表所要的功能8*/910char* params;11for(int i=0;i<argc;i++)12 {13params = argv[i];14if(strcmp("-c",params) == 0)15 {16 ret[0] += 1;17 }18else if(strcmp("-w",params) == 0)19 {20 ret[0] += 3;21 }22else if(strcmp("-l",params) == 0)23 {24 ret[0] += 5;25 }26//启动图形界⾯,则退出命令⾏结⼝2728 }29if(argc > 3) {30params = argv[argc - 2];31if (strcmp("-o", params) == 0 && argv[argc - 1] != NULL) {32 result = argv[argc - 1];33 ret[1] = argc - 3;34 }35else36 {37 ret[1]= argc - 1;38 }39 }else {40 ret[1] = argc - 1;41 }42//处理 -o之前缺少输⼊⽂件43return ret;44 }2.3 WordCount函数根据解析的参数执⾏相应操作 1void WordCount(int argc,char* argv[])2 {3 list = createlist();//创建单词列表4char* fileName;5if (argc <= 1) {6 Help();7 exit(0);8 }9 GetOptions(argc,argv);10 fileName = argv[ret[1]];11switch(ret[0])12 {13case1:14 ReadChar(fileName);15break;16case3:17 ReadWord(fileName);18break;19case5:20 Readlines(fileName);21break;22case4: {23 ReadChar(fileName);24 flag = 1;25 ReadWord(fileName);26break;27 }28case6: {29 ReadChar(fileName);30 flag = 1;31 Readlines(fileName);32break;33 }34case8:{35 ReadWord(fileName);36 flag = 1;37 Readlines(fileName);38break;39 }40case9: {41 CharWordLine(fileName);42break;43 }44default:45 Help();46break;47 }48 }2.4 ReadChar函数实现对⽂件的字符统计1void *ReadChar(char* fileName)2 {3char* feature = "字符数: ";4char buf;5//int count[1] = {0}; //⽤来储存字母出现过的次数6int sum = 0;7 FILE* fp = fopen(fileName,"r");8if (fp == NULL)9 {10 printf("Fail to open the file!\n");11 Help();12 exit(-1);13 }14while(!feof(fp))15 {16 buf = fgetc(fp);17 sum ++;18 }19 fclose(fp);20int count[1] = {sum};21 WriteToFile(fileName,count,1,feature);22 print(fileName, count, 1, feature);23 }2.5 ReadWord实现对⽂件的单词统计1void *ReadWord(char* fileName)2 {3/*在记录单词个数的时候,4 * 我们通过统计逗号和空格的个数5 * 然后通过计算得到单词的个数6 * 假设每个单词的长度不超过256字母7*/89char *feature = "单词数:";10 getwordCount(fileName);//得到⽂件的单词统计11 printword();12int sum = 0;13for (int i = 0; i < list.count; i++)14 sum += list.list[i].count;//计算总量15int count[1] = { sum };16 WriteToFile(fileName, count, 1, feature);17return NULL;18 }2.6 ReadLine 实现对⽂件⾏数的统计1void *Readlines(char* fileName)2 {3char buf = '\0';4char* feature = "⾏数: ";5 FILE* fp = NULL;6 fp = fopen(fileName,"r");7if (fp == NULL)8 {9 printf("Fail to open the file!\n");10 Help();11 exit(-1);12 }13int space[1] = {0}; //记录⾏数14while(!feof(fp))15 {16 buf = fgetc(fp);17if (buf == 10) //换⾏符的ASCII码为10 只要找出所有的换⾏符就好18 {19 space[0] ++;20 }21 }22 space[0] ++; //在最后⼀个⾏中会把换⾏符设置为其他字符,随意需要加123 WriteToFile(fileName,space,1,feature);24 print(fileName, space, 1, feature);25//关闭⽂件26 fclose(fp);27 }2.7 WriteToFile函数实现将统计信息存⼊⽂件中1void WriteToFile(char* fileName,int count[],int Csize,char* feature)2 {3/*fileName 表⽰读取的⽂件4 * count 表⽰记录的个数5 * Csize 表⽰记录数组的⼤⼩6 * feature表⽰记录的内容单词或者字母或者⾏数7 * flag 表⽰只写,还是追加模式,0 表⽰只写,1表⽰追加8*/9char *mode = '\0';10if (flag == 1)11 {12 mode = "a+";13 }14else15 {16 mode = "w+";17 }18int index = 0; //记录字符数19for(int i=0;i<Csize;i++)20 {21if(count[i] != 0)22 {23 index += count[i]; //计算总的单词个数24 }25 }26 FILE *fp = NULL;27 fp = fopen(result,mode); //将结果写⼊⽂件28if (fp == NULL)29 {30 printf("Failed when writing the count to file\n");31 exit(-1);32 }33 fprintf(fp,"%s,%s %d\n",fileName,feature,index); //写⼊⽂件3435if (list.count > 0)36 {37for (int i = 0; i < list.count; i++)38 {39 fprintf(fp, "%s:%d\n", list.list[i].wordstring, list.list[i].count); //写⼊⽂件40 }41 }42 fclose(fp);43 }2.8 getwordCount函数实现对⽂件中各单词的分离和统计1void getwordCount(char *filename)//得到各单词的个数统计2 {3char data[100];//假设每⾏最多100个字符4 FILE* fp = NULL;5 fp = fopen(filename, "r");6if (fp == NULL)7 {8 printf("Fail to open the file!\n");9 Help();10 getchar();11 exit(-1);12 }13while (!feof(fp))14 {15 fscanf(fp, "%s", &data);16char str[n];17for (int i = 0; i < n; i++)18 {19 str[i] = '\0';20 }21int len = 0;22for (int i = 0; i < strlen(data); i++)23 {24char c = data[i];25if (!issplitchar(c))//若不为单词分隔符26 {27 str[len] = c;2829 len++;30 }31else//若为单词分隔符且指针不超过字符长度32 {33if (len > 0)34 {35 additem(&list, str);//添加36 }3738for (int i = 0; i < n; i++)39 {40 str[i] = '\0';41 }42 len = 0;43 }44 }45if (len > 0)46 {47 additem(&list, str);//添加48 }49 }50 fclose(fp);5152 }2.9 word和wordlist结构体⽤于保存单词和单词的个数1 typedef struct word//保存单词信息2 {3char* wordstring;//内容4int count;//数量5 }word;67 typedef struct wordlist//单词列表定义8 {9 word *list;//单词列表10int count;//单词种类个数11 }wordlist;参数功能-w统计⽂件中的单词个数以及各单词的个数并写⼊输出⽂件中-l统计⽂件的⾏数并写⼊输出⽂件中-c统计⽂件中的字符个数并写⼊输出⽂件中-o ⽂件的路径⽤例编号输⼊输出测试结果1WordCount.exe -c text.txt ⽂件字符数:726通过2WordCount.exe -ltext.txt⽂件⾏数:8通过3WordCount.exe -wtext.txt 单词种类数:80单词总量:108通过4WordCount.exe -c -l text.txt ⽂件字符数::736⽂件⾏数: :8 通过5WordCount.exe -c -l -w text.txt ⽂件字符数::736单词种类数:80单词总量:108⽂件⾏数:8 通过3.互审代码情况已完成WordCount 的基本功能,包括字符计数、⾏数计数、单词统计等,但在单词统计和⾏数统计同时存在时,输出⽂件中的⾏数会写错位,该版本的WordCount 可以接收多个参数,⽐如-w -c -l 等,可以同时存在,⽽-w 参数可以统计⽂本⽂件中的各单词的个数并将其保存在输出⽂件中。

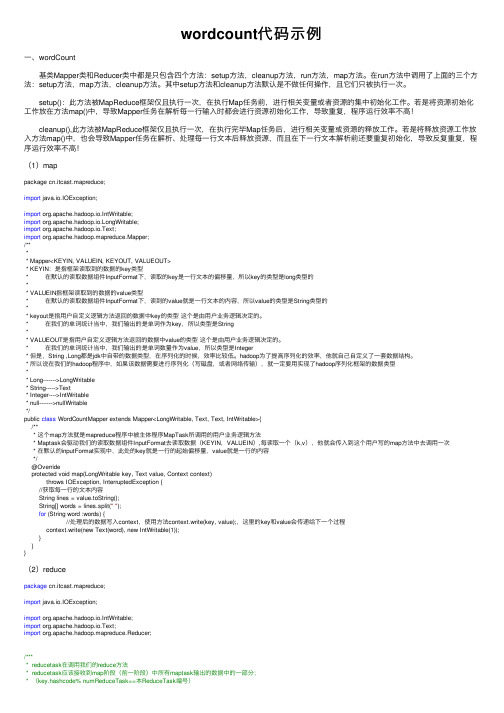

wordcount代码示例

wordcount代码⽰例⼀、wordCount 基类Mapper类和Reducer类中都是只包含四个⽅法:setup⽅法,cleanup⽅法,run⽅法,map⽅法。

在run⽅法中调⽤了上⾯的三个⽅法:setup⽅法,map⽅法,cleanup⽅法。

其中setup⽅法和cleanup⽅法默认是不做任何操作,且它们只被执⾏⼀次。

setup():此⽅法被MapReduce框架仅且执⾏⼀次,在执⾏Map任务前,进⾏相关变量或者资源的集中初始化⼯作。

若是将资源初始化⼯作放在⽅法map()中,导致Mapper任务在解析每⼀⾏输⼊时都会进⾏资源初始化⼯作,导致重复,程序运⾏效率不⾼! cleanup(),此⽅法被MapReduce框架仅且执⾏⼀次,在执⾏完毕Map任务后,进⾏相关变量或资源的释放⼯作。

若是将释放资源⼯作放⼊⽅法map()中,也会导致Mapper任务在解析、处理每⼀⾏⽂本后释放资源,⽽且在下⼀⾏⽂本解析前还要重复初始化,导致反复重复,程序运⾏效率不⾼!(1)mappackage cn.itcast.mapreduce;import java.io.IOException;import org.apache.hadoop.io.IntWritable;import org.apache.hadoop.io.LongWritable;import org.apache.hadoop.io.Text;import org.apache.hadoop.mapreduce.Mapper;/**** Mapper<KEYIN, VALUEIN, KEYOUT, VALUEOUT>* KEYIN:是指框架读取到的数据的key类型* 在默认的读取数据组件InputFormat下,读取的key是⼀⾏⽂本的偏移量,所以key的类型是long类型的** VALUEIN指框架读取到的数据的value类型* 在默认的读取数据组件InputFormat下,读到的value就是⼀⾏⽂本的内容,所以value的类型是String类型的** keyout是指⽤户⾃定义逻辑⽅法返回的数据中key的类型这个是由⽤户业务逻辑决定的。

软件工程-构建之法WordCount小程序统计文件中字符串个数,单词个数,词频,行数

软件⼯程-构建之法WordCount⼩程序统计⽂件中字符串个数,单词个数,词频,⾏数⼀、前⾔在之前写过⼀个词频统计的C语⾔课设,别⼈说你⼀个⼤三的怎么写C语⾔课程,我只想说我是先学习VB,VB是我编程语⾔的开始,然后接触到C语⾔及C++;再后来我是学习C++,然后反过来学习C语⾔,记得那时候⾃⼰在C++中没有好好学习,考试之前疯狂的背代码,然后过了。

后来学习C语⾔的时候,⾃⼰知道基础很重要,然后认真学习。

这WC这回⾃⼰就轻车熟路,记得那时候丁国辉课设⽼师,问我有多少是⾃⼰写的,我说有80%⾃⼰写的,然后他让我当场给程序增加⼀个总的单词数和每⼀个单词的频率,当时记得⾃⼰在旁边改了⼗分钟左右才弄完,因为⾃⼰太⼤意,出现了低级错误,然后⾃⼰还⼀直没有发现。

⾃⼰学习的map来写词频统计map<string,int>mp,发现更快。

代码更短,效率更⾼。

⼆、分析1、在命令⾏中直接输⼊⼀串英⽂字符串,统计单词的个数,⾃⼰是C语⾔学习的⼀个初学者,在C语⾔机考中⾃⼰总是会很快的敲出来。

#include <iostream>#include<cstdio>#include<cstdlib>using namespace std;//统计单词的个数int main(){char a;int count=0;while((a=getchar())!='\n'){if(a=='')count++;}cout << count+1 << endl;return0;}2、使⽤的map的写的统计单词的出现的次数#include<iostream>#include<stdio.h>#include<stdlib.h>#include<map>#include<string.h>using namespace std;int main(){cout<<"输⼊以0结尾"<<endl;map<string,int>mp;string str1;while(str1!="0"){cin>>str1;mp[str1]++;}map<string,int>::iterator iter;for(iter=mp.begin();iter!=mp.end();iter++){if(iter->first!="0") //字符的判断与0cout<<iter->first<<""<<iter->second<<endl;}return0;}3、在⽂件中怎么读取字符呢。

Spark在Yarn上运行Wordcount程序–过往记忆

Spark在Yarn上运行Wordcount程序–过往记忆关注iteblog_hadoop公众号,并在这里评论区留言并且留言点赞数排名前5名的粉丝,各免费赠送一本《大数据时代的算法:机器学习、人工智能及其典型实例》,活动截止至3月21日19:00,心动不如行动。

我们在接触Hadoop的时候,第一个列子一般是运行Wordcount 程序,在Spark我们可以用Java代码写一个Wordcount程序并部署在Yarn上运行。

我们知道,在Spark源码中就存在一个用Java编写好的JavaWordCount程序,源码如下:package org.apache.spark.examples;import org.apache.spark.api.java.JavaPairRDD;import org.apache.spark.api.java.JavaRDD;import org.apache.spark.api.java.JavaSparkContext;import org.apache.spark.api.java.function.FlatMapFunction;import org.apache.spark.api.java.function.Function2;import org.apache.spark.api.java.function.PairFunction;import scala.Tuple2;import java.util.Arrays;import java.util.List;import java.util.regex.Pattern;public final class JavaWordCount {private static final Pattern SPACE = pile(" ");public static void main(String[] args) throws Exception {if (args.length < 2) {System.err.println("Usage: JavaWordCount <master> <file>");System.exit(1);}JavaSparkContext ctx = new JavaSparkContext(args[0],"JavaWordCount",System.getenv("SPARK_HOME"), JavaSparkContext.jarOfClass(JavaWordCount.class)); JavaRDD<String> lines = ctx.textFile(args[1], 1); JavaRDD<String> words = lines.flatMap(new FlatMapFunction<String, String>() {@Overridepublic Iterable<String> call(String s) {return Arrays.asList(SPACE.split(s));}});JavaPairRDD<String, Integer> ones = words.map(new PairFunction<String, String, Integer>() {@Overridepublic Tuple2<String, Integer> call(String s) {return new Tuple2<String, Integer>(s, 1);}});JavaPairRDD<String, Integer> counts = ones.reduceByKey( new Function2<Integer, Integer, Integer>() {@Overridepublic Integer call(Integer i1, Integer i2) {return i1 + i2;}});List<Tuple2<String, Integer>> output = counts.collect(); for (Tuple2<?, ?> tuple : output) {System.out.println(tuple._1() + ": " + tuple._2());}System.exit(0);}}这里有必要介绍一下这里用到的几个函数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

reducer的调用次数通常小于mapper的调用次数,因此调用reducer带来的开销无需特别在意。

13.reducer类的输出

因此,本例中的 reducer的最终输出集合为:

如果集群有足够的能力一次性执行所有的map任务,它们将会被全部启动,并获得它们将要

处理的分块数据和作业JAR文件。每个TaskTracker随后将分块复制到本地文件系统。

如果任务数超出了集群处理能力,JobTracker将维护一个挂起队列,并在节点完成最初分配的map任务后,将挂起任务分配给节点。

(This,1),(is,2),(a,1), (test,1), (Yes, 1), (this, 1)

这些数据将被输出到驱动程序指定的输出路径下的分块文件中,并将使用指定的

OutputFormat对其进行格式化。每个reduce任务写入一个以part -r-nnnnn为文件名的文件,其中nnnnn从0OOOO开始并逐步递增。

3.任务分配

一旦JobTracker确定了所需的map任务数,它就会检查集群中的主机数,正在运行的TaskTracker数以及可并发执行的map任务数(用户自定义的配置变量)。JobTracker也会查看各个输入数据块在集群中的分布位置,并尝试定义一个执行计划,使TaskTracker尽可能处理位于相同物理主机上的数据块。或者即使做不到这一点,TaskTracker至少处理一个位于相同硬件机架中的数据块。

现在,我们准备查看map任务执行完毕的数据。听起来工作量似乎很大,事实却是如此。这也解释了在运行任意MapReduce作业时,为什么系统启动及执行上述步骤会花费大量时间。

5.不断监视JobTracker

现在,JobTracker执行所有的mapper和reducer。它不断地狱TaskTracker交换心跳和状态消息,查找进度或问题的证据。它还从整个作业执行过程的所有任务中收集指标,其中一些指标是Hadoop提供的,还有一些是map和reduce任务的开发人员指定的,不过本例中我们没有使用任何指标。

16.也许缺了combiner

前面讲述了MapReduce程序运行的各个步骤,却漏掉了另外一个可选步骤。在reducer获取map方法的输出之前,Hadoop允许使用combiner类对map方法的输出执行一些前期的排序操作。

为什么要有combiner

Hadoop设计的前提是,减少作业中成本较高的部分,通常指磁盘和网络输入输出。mapper的输出往往是巨大的--它的大小通常是原始输入数据的许多倍。Hadoop的一些配置选项可以帮助减少reducer在网络上传输如此大的数据带来的性能影响。combiner则采取了不同的方法,它对数据进行早期聚合以减少所需传输的数据量。

2.将输入分块

这些交互首先发生在JobTracker接受输入数据,并确定如何将其分配给map任务的时候。回想一下,HDFS文件通常被分成至少64MB的数据块,JobTracker会将每个数据块分配给一个map任务。

当然,WordCount示例涉及的数量是微不足道的,它刚好适合放在一个数据块中。设想一个

数据局部优化是Hadoop能高效处理巨大数据集的一个关键原因。默认情况下,每个数据块会被复制到三台不同主机。所以,在本地处理大部分数据块的任务/主机计划比起初预想的可能性更高。

4.任务启动

然后,每个TaskTracker开启一个独立的Java虚拟机来执行任务。这确实增加了启动时间损失,但它将因错误运行map或reduce任务所引发的问题与TaskTracker隔离开来,而且可以将它配置成在随后执行的任务之间共享。

shuffle阶段,这也是许多MapReduce奇迹发生的地方。

9.分块

Reduce接口的隐性保证之一是,与给定键相关的所有值都会被提交到同一个reducer。由于一个集群中运行着多个reduce任务,因此,每个mapper的输出必须被分块,使其分别传入相应的各个reducer。这些分块文件保存在本地节点的文件系统。

0 This is a test

14 Yes it is

7.mapper的执行

根据作业配置的方式,mapper接收到的键/值对分别是相应行在文件中多我们不关心每行文本在文件中的位置,所以WordCountMapper类的map方法舍弃了键,并使用标准的Java String类的split方法将每行文本内容拆分成词。需要注意的是,使用正则表达式或StringTokenizer类可以更好地断词,但对于我们的需求,这种简单的方法就足够了。

查看WordCount的运行全貌

为了更详细地探讨mapper和reducer之间的关系,并揭示Hadoop的一些内部工作机理,现在我们将全景呈现WordCount是如何执行的。

1.启动

调用驱动中的Job.waitForCompletion()是所有行动的开始。该驱动程序是唯一一段运行在本地机器上的代码,上述调用开启了本地主机与JobTracker的通信。请记住,JobTracker负责作业调度和执行的各个方面,所以当执行任何与作业管理相关的任务时,它成为了我们的主要接口,JobTracker代表我们与NameNode通信,并对储存在HDFS上的Байду номын сангаас据相关的所有交互进行管理。

15.这就是MapReduce的全部

如你所见,Hadoop为每个MapReduce程序提供了大量机制,同时,Hadoop提供的框架在许

多方面都进行了简化。如前所述,对于WordCount这样的小程序来说,MapReduce的大部分机制并没有多大价值,但是不要忘了,无论在本地Hadoop或是EMP,我们可以使用相同的软件和mapper/reducer在巨大的集群上对更大的数据集进行字数统计。那时,Hadoop所做的大量工作使用户能够在如此大的数据集上进行数据分析。否则,手工实现代码分发、代码同步以及并行运算将付出超乎想象的努力。

更大的以TB为单位的输入文件,切分模型变得更有意义。。每段文件(或用MapReduce术语来讲,每个split)由一个map作业处理。

一旦对各分块完成了运算,JobTracker就会将它们和包含Mapper与Reducer类的JAR文件放

置在HDFS上作业专用的目录,而该路径在任务开始时将被传递给每个任务。

10.可选分块函数

Partitioner类在org.apache.hadoop.mapreduce包中,该抽象类具有如下特征:

public abstract class Partitioner<Key, Value>{

public abstract int getPartition( Key key, Value value,int numPartitions);

combiner没有自己的接口,它必须具有与reducer相同的特征,因此也要继承org.apache.hadoop.mapreduce包里的Reduce类。这样做的效果主要是,在map节点上对发往各个reducer的输出执行mini-reduce操作。

Hadoop不保证combiner是否被执行。有时候,它可能根本不执行,而某些时候,它可能被执行一次、两次甚至多次,这取决与mapper为每个reducer生成的输出文件的大小和数量。

14 关机

一旦成功完成所有任务,JobTracker向客户端输出作业的最终状态,以及作业运行过程中一些比较重要的计数器集合。完整的作业和任务历史记录存储在每个节点的日志路径中,通过JobTracker的网络用户接口更易于访问,只需将浏览器指向JobTracker节点的50030端口即可。

}

默认情况下,Hadoop将对输出的键进行哈希运算,从而实现分块。此功能由org.apache.hadoop.mapreduce.lib.partition包里的HashPartitioner类实现,但某些情况下,用户有必要提供一个自定义的partitioner子类,在该子类中实现针对具体应用的分块逻辑。特别是当应用标准哈希函数导致数据分布极不均匀时,自定义partitioner子类尤为必要。

8.mapper的输出和reducer的输入

mapper的输出是一系列形式为(word,1)的键值对。本例中,mapper的输出为:

(This,1),(is,1),(a,1),(test.,1),(Yes,1),(it,1),(is,1)

这些从mapper输出的键值对并不会直接传给reducer。在map和reduce之间,还有一个

然后,针对每个单独的词,mapper输出由单词本身组成的键和值1。

注意:

以静态变量的形式创建IntWritable对象,并在每次调用时复用该对象。这样做的原因是,尽管它对我们小型的输入文件帮助不大,但处理巨大数据集时,可能会对mapper进行成千上万次调用。如果每次调用都为输出的键和值创建一个新对象,这将消耗大量的资源,同时垃圾回收会引发更频繁的停滞。我们使用这个值,知道Context .write方法不会对其进行改动。

6.mapper的输入

假设输入文件是一个极为普通的两行文本文件。

This is a test

Yes this is

驱动类使用TextInputFormat指定了输入文件的格式和结构,因此,Hadoop会把输入文件

看做以偏移量为键并以该行内容为值的文本。因此mapper的两次调用将被赋予以下输入。

集群中的Reduce任务数并不像mapper数量一样是动态,事实上,我们可以在作业提交阶段指定reduce任务数。因此,每个TaskTracker就知道集群中有多少个reducer,并据此得知mapper输出应切为多少块。