三种光流算法的实现源码及测试结果

LK光流算法

已被广泛的应用于运动车辆跟踪和人脸特征点跟踪[47,48];下面介绍文献[27],并对其

进行相关实验。

§4.3.1问题提出

提下,推导出灰度图像光流场计算的基本等式,这是经典光流方法[18,24]。

光流的算法多种多样,其用于目标跟踪常用的算法有:检测和跟踪特征点[25]、跟

好的特征点[26]、金字塔图像的Lucas Kanade特征点跟踪算法(因为其跟踪过程是迭

的光流法计算过程,因此,为了更好的体现光流的作用,本文将其简称为:Lucas

(4-3-13)

B(x,y)~=JL(x+gL

x

,y+gL

y

)

?(x,y)∈[px?ωx,px+ωx]×[py?ωy,py+ωy]

(4-3-14)

注意到A(x,y)和B(x,y)的定义域稍微有些差异。实际上,A(x,y)是在窗口大小为

(2ωx+3)×(2ωy+3)的范围内定义,而不是(2ωx+1)×(2ωy+1)。在后面运用中心差分算子

px+ωx

x=px?ωx

py+ωy

y=py?ωy

(A(x,y)?B(x,y)?[?

B

?x

?B

?y

]υ)?[

?B

?x

?B

?y]

(4-3-18)

注意到A(x,y)?B(x,y)可以看作是在点[x,y]T的一个导数,所以:

δI(x,y)~=A(x,y)?B(x,y)

?(x,y)∈[px?ωx,px+ωx]×[py?ωy,py+ωy]

计算机视觉中的光流计算算法分析

计算机视觉中的光流计算算法分析计算机视觉是一门涉及计算机处理和理解视觉数据的学科。

光流计算算法是其中一项重要的技术之一。

光流计算是指基于图像序列的时间相邻性,计算图像上每一个像素的运动速度和方向。

光流计算算法的应用非常广泛,可以被用于目标跟踪、图像稳定、自动驾驶等领域。

本文将从光流计算算法的原理、分类及其应用方面进行探讨。

一、光流计算算法的原理光流计算基于运动恒定假设,假设图像上同一物体在不同时间间隔内位置的变化量是连续的,图像的颜色值变化是由物体的运动引起的。

在计算光流时,需要利用相邻两帧图像之间的变化来计算每个像素在X和Y方向上的运动速度和方向。

设两幅灰度图像的亮度值分别为I(x, y, t)和I(x+u, y+v,t+1),其中(x, y)为图像中的像素坐标,t为时间,u和v是在像素上的位移,光流v=(u, v) 是取决于基于灰度不变假设的图像变量,因此可以用下式来计算:Ixu+Iyv+It=0;其中Ix表示灰度图像在x方向上的梯度,Iy表示灰度图像在y方向上的梯度,It表示两帧图像之间的灰度值变化。

二、光流计算算法的分类为了更好地研究和解决光流计算问题,光流计算算法可以分为密集算法、稠密算法和稀疏算法等几种不同的算法类别。

密集算法密集算法的优势在于可以对整个图像进行运动的跟踪,因此,可以检查相邻像素之间的连续性,并可以提高图像的精度。

但是,这种算法的缺点在于经常需要更强大的计算硬件来处理。

稠密算法稠密算法是基于密集的光流计算,它可以保证准确性和稳定性。

这种算法可以提高像素之间光流的连续性,并抑制误差的导致。

稠密算法有丰富的应用,例如可以用于图像稳定和视频抖动消除。

稀疏算法稀疏算法的优势在于计算量较小,这使得该算法非常适合于在计算能力低的计算机设备上实现。

然而,由于其只针对某些特定像素的元素计算光流,因此可能会导致图像间断。

三、光流计算算法的应用光流计算算法已经有广泛的应用领域,包括了目标跟踪、图像稳定、自动驾驶等等。

H-S光流算法及仿真总结

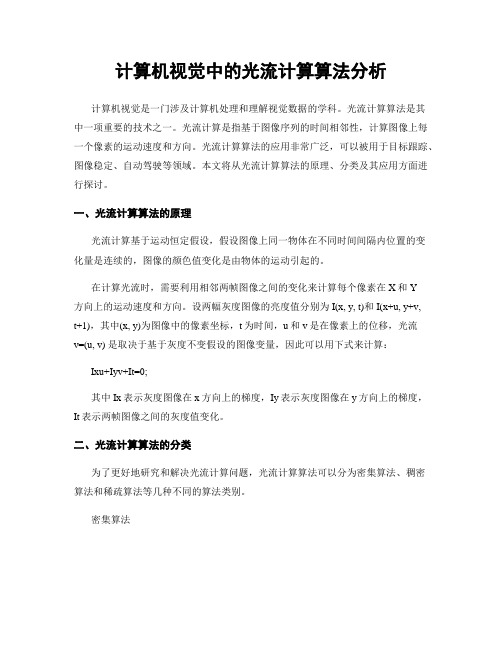

H-S光流算法及仿真总结一、光流的概念二维图像是三维实景在成像面的投影,反映了三维实景中物体的位置等信息。

假设Po是三维实景中的一点,Pi是Po在成像面上的投影,Po的运动反映在成像面中就是Pi的运动,假设Po在δt时间内运动了δs到Po’,Pi则运动了δs’到Pi,Pi运动的速度为'stδδ。

如下图所示:图1 Po的运动在成像面上反映为Pi的运动Pi的运动速度'stδδ就是Pi的光流。

由此得出,光流就是三维实景在成像面上的投影的运动速度。

三维实景中的某一点在成像面上的投影的运动速度形成点光流,所有点在成像面上的投影的运动速度则形成光流场。

光流场反映了三维实景中物体的位置、运动等信息。

光照的变化必然引起光流的变化,有些运动不产生光流,如光照不变时,均匀亮度的球体绕中心轴自转的运动。

因此我们在研究实际问题时常常假设光照亮度不变。

二、光流的H-S算法1、光流基本约束方程假定:1、图像的灰度始终不变,2、光流在整个图像中满足一定的约束条件,即全局性约束,3光流在整个图像中均匀变化, 无重叠,即平滑性约束。

设I (x ,y ,t )是图像上点(x ,y )某一时刻t 的亮度,u (x ,y )和v (x ,y )分别是点(x ,y )在x 方向和y 方向上的光流分量,点(x ,y )在t+δt 时间内运动到(x+δx ,y+δy ),其中,δx=u*δt ,δy=v*δt 。

由于亮度不变,所以有I (x+δx ,y+δy ,t+δt )=I (x ,y ,t ) 用泰勒级数展开得(,,)(,,)I I II x y t dx dy dt I x y t x y tε∂∂∂++++=∂∂∂ 其中ε是关于δx 、δy 、δt 的二阶以上的项,可以忽略不计 两边同除以δt 得0I dx I dy dI x dt y dt dt ∂∂++=∂∂ 设x I I x ∂=∂,y I I y ∂=∂,t I I t ∂=∂,dx u dt =,dy v dt =,则有光流基本约束方程x y t I u I v I ++=2、H-S 提出的光流算法迭代方程 迭代方程()()(1)()222k k x y tk k xx yI u I v I uuI I Iλ+++=-++,()()(1)()222k k x y tk k yx yI u I v I vvI I Iλ+++=-++其中,k 是迭代次数, u 和v 是光流局部平均值,λ为权重系数。

特征点 光流法 直接法-概念解析以及定义

特征点光流法直接法-概述说明以及解释1.引言概述:特征点、光流法和直接法是计算机视觉中常用的技术手段,用于图像和视频处理、运动估计以及SLAM等领域。

特征点是图像中具有显著特征的点,可以通过特征点检测算法来提取。

光流法是一种通过计算图像序列中像素点的位移来描绘物体运动的方法。

直接法则是直接使用像素值和相机运动来进行匹配和估计,相较于特征点法,直接法减少了特征点提取和匹配的过程,从而提高了算法的速度和鲁棒性。

本文将分别介绍特征点的定义、光流法的原理和直接法在SLAM中的应用。

"5.3 展望": {} }}}请编写文章1.1 概述部分的内容1.2 文章结构文章结构章节为了更好地组织和呈现论文内容,通常包括以下几个部分:1. 引言:介绍研究背景、问题意义和研究现状,引出文章的主题和目的。

2. 文章结构:概述文中各个章节的内容和主题,提供读者整体了解文章结构的指引。

3. 主体部分:包括对特征点、光流法和直接法的详细介绍和讨论。

4. 结论:总结论文的主要发现和观点,强调研究的贡献和局限性,提出展望和未来研究方向。

5. 参考文献:列出引用过的文献和资料,为读者提供查证和深入研究的依据。

在文章结构部分中,我们将对以上内容进行详细展开,并说明各个章节的主要内容和关联性,使读者能够更好地理解整篇文章的脉络和逻辑思路。

1.3 目的本文的目的是探讨特征点、光流法和直接法在计算机视觉和SLAM (Simultaneous Localization and Mapping)领域的应用。

通过对特征点的定义、检测算法以及在计算机视觉中的应用进行介绍,读者可以更加深入地了解特征点在图像处理中的重要性和作用。

同时,对光流法和直接法的概念、原理和在运动估计以及SLAM中的具体应用进行详细讨论,旨在帮助读者了解这两种方法在实际场景中的工作原理和优缺点。

通过本文的阐述,读者可以更好地理解和应用特征点、光流法和直接法在计算机视觉和SLAM领域中的重要性,为相关研究和应用提供指导和参考。

光流法(OpticalFlowMethod)

光流法(OpticalFlowMethod)在计算机视觉中,光流法即可用于运动目标检测,也可以用于目标跟踪。

本文主要介绍光流法在运动目标检测和目标跟踪中的区别与联系。

1、光流与光流场光流的概念最初是由 Gibson 于 1950 年首先提出来的。

当人的眼睛观察运动物体时,物体的景象在人眼的视网膜上形成一系列连续变化的图像,这一系列连续变化的信息不断“流过”视网膜(即图像平面),好像是一种光的“流”,故称之为光流。

光流表达图像的变化,包含目标运动的信息,可用来确定目标的运动。

光流三个要素:一是运动速度场,这是形成光流的必要条件;二是带光学特征的部分例如有灰度的象素点,它可以携带运动信息;三是成像投影从场景到图像平面,因而能被观察到。

定义光流以点为基础,具体来说,设(u, v) 为图像点 (x, y) 的光流,则把 (x, y, u, v) 称为光流点。

所有光流点的集合称为光流场。

当带光学特性的物体在三维空间运动时,在图像平面上就形成了相应的图像运动场,或称为图像速度场。

在理想情况下,光流场对应于运动场。

总而言之,光流是由图像的亮度变化形成的,因此,光流场近似于运动场。

2、光流场的计算2.1、光流约束方程光流场的计算最初是由 Horn 和 Schunck[1]于 1981 年提出的,而后由 Lueas 和 Kanad[2]提出了改进光流算法。

光流法的核心就是求解出运动目标的光流,即速度。

根据视觉感知原理,客观物体在空间上一般是相对连续运动的,在运动过程中,投射到传感器平面上的图像实际上也是连续变化的。

为此可以假设瞬时灰度值不变,即灰度不变性原理。

由此可以得到光流基本方程,灰度对时间的变化率等于灰度的空间梯度与光流速度的点积。

如下:约束方程只有一个,而方程的变量有两个,在这种情况下无法求得 u 和 v 的确切值。

这种不确定性称为孔径问题(aperture problem)。

此时需要引入另外的约束条件,从不同的角度引入约束条件,导致了不同的光流场计算方法。

光流匹配算法 -回复

光流匹配算法-回复光流匹配算法:理论与应用引言:光流是计算机视觉领域中的一项重要研究内容,它可以用于目标跟踪、运动估计、深度计算等多个应用领域。

光流匹配算法是一种基于图像序列的方法,通过对图像的像素点进行跟踪和匹配,从而获取图像序列中物体的运动信息。

本文将以光流匹配算法为主题,详细介绍该算法的原理、实现步骤以及应用领域。

一、光流的定义与原理光流是指在连续时间的两幅图像之间,同一点的运动矢量。

它是由图像序列中不同帧的像素对应关系得到的。

光流的计算过程基于两个基本原理:一致性原理和亮度恒定性原理。

1. 一致性原理一致性原理假设在一个图像序列中,同一物体的不同帧图像中的像素点具有相同的运动矢量。

这是基于物体在连续的时间间隔内,其运动状态是相对连续稳定的。

2. 亮度恒定性原理亮度恒定性原理假设在图像序列中,一个像素点的灰度值在连续帧中保持不变。

这是因为在一个相对较小的时间间隔内,只要物体的运动速度不过大,像素的灰度值不会发生显著改变。

基于以上原理,光流匹配算法通过图像序列中的像素点间的灰度值变化,计算出像素点的运动矢量,从而实现物体运动信息的获取。

二、光流匹配算法的步骤光流匹配算法主要包括以下步骤:图像预处理、特征提取、匹配计算和结果优化。

1. 图像预处理图像预处理包括对原始图像进行去噪、灰度化、边缘检测等操作,以提高后续处理步骤的准确性和稳定性。

2. 特征提取特征提取是指从图像中提取出具有代表性的局部区域,用于计算光流。

常用的特征提取算法有Harris角点检测、SIFT、SURF等。

3. 匹配计算匹配计算是光流匹配算法的核心步骤,它通过计算相邻帧中提取到的特征点之间的灰度变化,得到光流场。

常用的光流计算算法有Lucas-Kanade 算法、Horn-Schunck算法等。

4. 结果优化结果优化是对得到的光流场进行滤波和平滑处理,以减少噪声和误差,提高光流计算的准确性和稳定性。

常用的结果优化算法有中值滤波、高斯滤波等。

【视觉SLAM十四讲】直接法视觉里程计

2 LK 光流(5分,约3小时)2.1光流文献综述(1分)我们课上演示了Lucas-Kanade 稀疏光流,用OpenCV 函数实现了光流法追踪特征点。

实际上,光流法有很长时间的研究历史,直到现在人们还在尝试用Deeplearning 等方法对光流进行改进[1,2]。

本题将指导你完成基于Gauss-Newton 的金字塔光流法。

首先,请阅读文献[3](paper 目录下提供了pdf ),回答下列问题。

问题:1. 按此文的分类,光流法可分为哪几类?答:作者在文中对光流法按照两种不同的方法进行分类。

➢ 按照估计的是参数的叠加增量还是增量Warp 将光流法分为叠加(additional)和组合(compositional)算法➢ 按照Warp 更新规则可以将光流法分为前向(forward )和逆向/反向(inverse)两种算法综上:可以分4类,分别是 FA(Forward Additional), FC(Forward Composition), (Inverse Additional) 和 IC(Inverse Compositional)。

2. 在compositional 中,为什么有时候需要做原始图像的wrap ?该wrap 有何物理意义?答: 与Lucas-Kanade 算法中那样简单地将迭代的更新 p ∆添加到当前估计的参数p 不同,组合(compositional )算法中,对扭曲();W x p ∆的增量更新必须由Warp 的当前估计组成() ;Wx p 。

这两个 warp 的组合可能更复杂。

因此,我们对 warp 集合有两个要求: 1)warp 集合必须包含 identity warp 。

2)warp 集合必须在组合运算中闭合。

需要在当前位姿估计之前引入增量式 warp (incremental warp )以建立半群约束要求(the semi-group requirement )。

calcopticalflowpyrlk 用法

Calcopticalflowpyrlk是OpenCV中的一个函数,用于计算稀疏特征光流。

在计算机视觉中,光流是指图像中的像素随着时间的变化而产生的位移。

光流可以用来估计目标的运动轨迹,对于运动跟踪、目标检测等任务具有重要意义。

1. 算法原理calcopticalflowpyrlk算法是基于图像金字塔的Lucas-Kanade算法的改进版本。

它通过构建图像金字塔来实现多尺度处理,从而提高光流的稳定性和精度。

该算法首先对输入的两幅图像进行金字塔分解,然后从粗到细依次计算光流,最终得到目标的像素位移。

2. 输入参数calcopticalflowpyrlk函数的输入参数包括当前帧图像、前一帧图像、前一帧的特征点、输出的特征点位置、特征点的状态等。

其中,前一帧的特征点可以通过GoodFeaturesToTrack函数或其他方式获得。

3. 输出结果calcopticalflowpyrlk函数的输出结果包括当前帧的特征点位置、特征点的运动状态等。

这些结果可以用来进行目标跟踪、运动分析等应用。

4. 使用步骤使用calcopticalflowpyrlk函数进行光流计算的步骤如下:(1)导入OpenCV库import cv2(2)读取输入的两幅图像prev_img = cv2.imread('prev.jpg')curr_img = cv2.imread('curr.jpg')(3)获取前一帧的特征点prev_pts = cv2.goodFeaturesToTrack(prev_img, maxCorners=100, qualityLevel=0.01, minDistance=10)(4)调用calcopticalflowpyrlk函数计算光流curr_pts, status, err = cv2.calcOpticalFlowPyrLK(prev_img, curr_img, prev_pts, None)(5)根据光流结果进行目标跟踪等应用...5. 注意事项在使用calcopticalflowpyrlk函数时,需要注意以下几点:(1)输入的两幅图像应该是连续的帧,且图像尺寸应该相同。

matlab光流法源代码 -回复

matlab光流法源代码-回复Matlab光流法是计算机视觉领域中一种常用的运动估计技术,能够分析图像序列中物体的运动情况。

本篇文章将详细介绍Matlab光流法的原理和源代码实现,并给出具体的步骤和解释。

第一步:理解光流法原理光流法是一种基于连续图像的运动估计方法,它利用图像中的像素点在时间上的变化来估计运动速度。

具体而言,光流法假设图像中相邻像素点的灰度值在运动过程中保持不变,即光强约束条件。

根据这一假设,我们可以通过分析图像中像素点的灰度值变化来推断相邻像素点的位置和速度关系。

光流法的基本原理可以使用以下公式表示:I(x + Δx, y + Δy, t + Δt) - I(x, y, t) = 0其中,(x, y)是初始时刻的像素位置,(Δx, Δy)是像素在时间Δt内的位移,I(x, y, t)是初始时刻的像素强度,I(x + Δx, y + Δy, t + Δt)是Δt时间后的像素强度。

第二步:准备工作在开始编写Matlab光流法代码之前,我们需要准备两幅图像作为输入。

这两幅图像应该是连续的时间序列帧,例如,图像1表示初始时刻的图像,图像2表示稍后时刻的图像。

在Matlab中,我们可以通过imread函数读取图像文件为矩阵形式,并使用imshow函数显示图像。

第三步:计算光流向量在Matlab中,我们可以使用内置函数opticalFlowFarneback实现光流计算。

该函数基于Farneback算法,可以计算图像序列的光流向量。

光流向量的计算可以通过以下代码实现:matlabflow = opticalFlowFarneback(im1, im2);其中,im1和im2为输入图像。

第四步:可视化光流向量计算完光流向量后,我们可以使用内置函数quiver来可视化光流向量。

它能够在图像上绘制箭头,表示像素点的运动方向和速度。

可视化光流向量的代码如下:matlabimshow(im2);hold on;quiver(flow);hold off;第五步:保存光流向量如果需要将光流向量保存到文件中,我们可以使用内置函数save。

光流(OpticalFlow)原理及其算法示例

光流(OpticalFlow)原理及其算法示例光流的概念最早是由Gibson在1950年提出的。

它是空间移动物体在像素观察平面中移动的瞬时速度。

是一种计算物体在相邻帧间运动信息的方法。

一般来说,光流(Optical Flow)是物体在三维空间中的运动在二维像平面上的投影。

它是由物体和相机的相对速度产生的,反映了物体在极小时间内对应的图像像素的运动方向和速度。

Lucas–Kanade方法(KLT)是一种基于光流原理的特征点跟踪算法。

本文首先介绍光流的原理,然后介绍了KLT及其相关的KLT变体算法。

光流约束方程假设I(x,y,t)为时刻t像素点(x,y)的像素值(亮度),该像素点在两个图像帧之间移动了Δx,Δy,Δt。

因此我们可以得出相同亮度的结论:假设运动很小,我们可以从泰勒级数推导一阶泰勒展开式:因此,其中(dx/dt, dy/dt) = (u, v)为待解像素的光流。

(∂I/∂x,∂I/∂y) = (I_x, I_y)是像素灰度空间微分,t = I_x是像素坐标点的时间灰度微分。

整理成矩阵形式:该公式表明,同一坐标位置上的时间灰度微分是空间灰度微分与该位置上相对于观测者的速度的乘积。

假设空间一致性,对于周围的多个点,有:这个方程组的方程多于未知数,因此通常是超定的。

Lucas-Kanade方法通过最小二乘原理获得折衷解决方案:这就是光流算法的孔径问题。

为了找到光流,需要另一组方程,并附加约束条件。

所有的光流方法都引入了估算实际流的附加条件。

局部差分法:Lucas-Kanade算法为了使方程可求解,进行以下假设:•亮度是恒定的,图像中对象的像素亮度在连续帧之间不会改变;•短距离(短期)运动,相邻帧之间的时间足够短,并且物体运动很小;•空间一致性,相邻像素具有相似的运动;恒定亮度是指某些像素的跟踪不随时间变化:公式表示被跟踪像素的灰度不随时间变化:连续时间意味着相邻帧之间的运动很小。

换句话说,运动的变化可以被认为是亮度相对于时间的导数。

光流法

光流法光流是一种简单实用的图像运动的表达方式,通常定义为一个图像序列中的图像亮度模式的表观运动,即空间物体表面上的点的运动速度在视觉传感器的成像平面上的表达。

中文名:光流法属于:简单实用的图像运动表示:一种几何变化分为:匹配的方法频域的方法梯度的方法人类主要通过眼睛,耳朵和大脑来获取、处理与理解获得的信息。

然而图像具有最直观、明了、让人一看就懂的特质,因为人们获取信息70%以上依靠视觉,20%左右依靠听觉,10%左右依靠触觉和嗅觉,这就是为什么“百闻不如一见”,一幅图像说明一切问题,胜过千言万语。

计算机视觉这一领域的先驱可追溯到很早的时候,但是直到20世纪70年代后期,当计算机的性能提高到足以处理诸如图像这样的大规模数据时,计算机视觉才得到了正式的关注和发展。

计算机视觉就是用各种成象系统代替视觉器官作为输入敏感手段,由计算机来代替大脑完成处理和解释,也包括对视觉信息的采集,传输,处理,存储与理解等过程。

计算机视觉最终研究目标就是使计算机能像人那样通过视觉观察和理解世界,具有自主适应环境的能力,要经过长期的努力才能达到的目标。

因此,在实现最终目标以前,人们努力的中期目标是建立一种视觉系统,这个系统能依据视觉敏感和反馈的某种程度的智能完成一定的任务。

计算机视觉应用领域较广泛,包括航空航天、卫星照片、军事导弹精确制导、移动机器人视觉导航、工业自动化系统、医学辅助诊断等。

计算机视觉系统的结构形式很大程度上依赖于其具体应用方向。

有些是独立工作的,用于解决具体的测量或检测问题,也有些作为某个大型复杂系统的组成部分出现,比如工业控制系统,汽车导航系统。

计算机视觉系统的具体实现方法同时也由其功能决定,有些是预先固定的,有些是在运行过程中自动学习调整。

尽管如此,以下几个功能却几乎是每个计算机系统都需要具备的。

图像获取,一幅数字图像是由一个或多个图像感知器产生的,例如摄像机,红外遥感摄像仪,雷达,超声波接收器等,所产生的图片包括二维图像,三维图像或者一个图像序列。

stm32光流算法

stm32光流算法【原创实用版】目录1.STM32 光流算法概述2.STM32 光流算法的原理3.STM32 光流算法的实现4.STM32 光流算法的应用案例5.总结正文【1.STM32 光流算法概述】STM32 光流算法是一种基于运动目标检测的光流算法,它可以通过检测图像中的光流场来确定物体的运动状态。

STM32 作为一款广泛应用的微控制器,可通过硬件实现光流算法,从而在嵌入式系统中实现运动目标检测。

【2.STM32 光流算法的原理】STM32 光流算法的原理基于光流场的概念。

光流场是指图像中物体的运动产生的光学流场的强度和方向。

通过计算图像中物体的光流场,可以得到物体的运动状态。

STM32 光流算法通过计算图像中像素点的光流场,实现对运动目标的检测。

【3.STM32 光流算法的实现】STM32 光流算法的实现主要包括以下几个步骤:(1) 图像预处理:对输入的图像进行预处理,包括降噪、缩放等操作,提高算法的稳定性和精度。

(2) 光流场计算:对预处理后的图像进行光流场计算,得到物体的运动状态。

(3) 运动目标检测:根据光流场的变化,检测出图像中的运动目标。

STM32 光流算法的实现可以借助硬件加速,提高算法的运算速度和实时性。

【4.STM32 光流算法的应用案例】STM32 光流算法在嵌入式系统中具有广泛的应用,例如:(1) 智能监控:通过 STM32 光流算法实现运动目标检测,可应用于智能监控领域,实现对异常行为的自动识别和报警。

(2) 无人驾驶:STM32 光流算法可应用于无人驾驶领域,实现对道路环境中运动目标的检测,提高无人驾驶系统的安全性。

(3) 机器人视觉:STM32 光流算法可应用于机器人视觉系统,实现对环境中运动目标的检测,提高机器人的导航和避障能力。

【5.总结】STM32 光流算法是一种基于运动目标检测的光流算法,通过检测图像中的光流场来确定物体的运动状态。

光流计的原理及应用

光流计的原理及应用1. 引言光流计是一种常用的计算机视觉技术,用于估计相邻视频帧之间像素的运动信息。

通过分析像素的灰度值变化,光流计可以得到视频中运动目标的速度和方向。

本文将介绍光流计的基本原理和应用领域。

2. 光流计的原理光流计的原理基于光流方程,即在连续的时间和空间中,像素的灰度值随着时间和位置的变化而变化。

该方程可以用以下公式表示:v = dI / dt - ∇·I其中,v表示像素的运动速度,dI / dt表示像素灰度值随时间的变化率,∇·I表示像素灰度值的空间梯度。

光流计的目标是根据给定的两帧图像,通过求解光流方程来得到像素的运动速度。

3. 光流计的算法光流计的算法可以分为密集光流和稀疏光流两种类型。

密集光流算法计算每个像素的运动速度,而稀疏光流算法仅计算选定的像素点的运动速度。

3.1 密集光流算法密集光流算法的计算量较大,但结果更精确。

其中最常用的算法包括光流约束方程(Lucas-Kanade方法)和全局光流法(Horn-Schunck方法)。

这些算法通过最小化光流方程的误差来估计像素的运动速度。

3.2 稀疏光流算法稀疏光流算法通过选择少量的像素点来计算运动速度,从而减少了计算量。

常用的稀疏光流算法包括金字塔LK光流法和光流追踪器。

4. 光流计的应用光流计在计算机视觉领域有广泛的应用。

4.1 视频稳定通过光流计算视频帧与参考帧之间的运动信息,可以实现视频稳定。

通过识别并补偿相机的抖动,使视频看起来更加平滑。

4.2 运动分析光流计可以用于运动分析,例如识别物体的运动轨迹、速度和加速度,从而分析物体的运动行为。

4.3 目标跟踪光流计可以用于目标跟踪,通过估计目标的运动速度和方向,从而实现目标在视频中的持续跟踪。

4.4 自动驾驶光流计在自动驾驶领域也有重要应用。

通过分析车辆周围环境的光流信息,可以判断车辆与其他物体的相对运动关系,从而实现智能驾驶中的决策和控制。

5. 总结光流计是一种计算机视觉技术,用于估计相邻视频帧之间像素的运动信息。

matlab光流法源代码 -回复

matlab光流法源代码-回复光流法是一种在计算机视觉领域中常用的技术,它可以用来估计图像中像素的运动变化。

它广泛应用于目标跟踪、运动分析、虚拟现实等领域。

本文将一步一步回答关于光流法源代码的问题,为读者介绍该算法的实现步骤和原理。

在MATLAB中,有许多开源的光流法源代码可以使用。

其中,Lucas-Kanade光流法是最简单和最常用的一种,我们将以此为例进行讲解。

首先,我们需要明确计算光流需要的输入数据。

光流法需要两个连续图像作为输入,通过对比图像中相邻像素的亮度值变化来计算像素的运动。

因此,我们将使用一个图像序列作为输入数据,该图像序列包含多个连续的帧,用于估计一个帧到另一个帧的像素运动。

接下来,我们需要加载图像序列。

在MATLAB中,我们可以使用imread 函数来读取图像,并将其存储为一个图像序列。

为了方便实验,我们将图像序列存储为一个大小为[H, W, N]的三维矩阵,其中H和W分别表示图像的高度和宽度,N表示图像序列的帧数。

matlabimage_sequence = zeros(H, W, N);for i = 1:Nimage_sequence(:,:,i) = imread(sprintf('image04d.png', i));end然后,我们需要为光流法设置一些参数。

主要的参数包括窗口大小和光流法的迭代次数。

窗口大小表示在计算每个像素的光流向量时,算法将考虑该像素周围的像素数目。

通常,窗口大小越大,计算的精度越高,但计算速度越慢。

迭代次数表示光流法的迭代次数。

通常,迭代次数越多,计算的精度越高,但计算速度越慢。

在这里,我们将设置窗口大小为15x15,迭代次数为10。

matlabwindow_size = 15;iterations = 10;接下来,我们可以实现光流法的主要计算步骤。

首先,我们需要对每一帧图像计算光流。

在计算光流时,我们需要根据图像序列的前一帧和当前帧,选择一些特征点或像素点,并追踪它们在当前帧中的位置。

光流法c++完整代码

光流法是比较经典的运动估计方法,本文不仅叙述简单明了,而且附代码,故收藏.在空间中,运动可以用运动场描述。

而在一个图像平面上,物体的运动往往是通过图像序列中不同图象灰度分布的不同体现的。

从而,空间中的运动场转移到图像上就表示为光流场,光流场反映了图像上每一点灰度的变化趋势。

光流可以看作带有灰度的像素点在图像平面运动产生的瞬时速度场。

下面我们推导光流方程:假设E(x,y,t)为(x,y)点在时刻t的灰度(照度)。

设t+dt时刻该点运动到(x+dx,y+dy)点,他的照度为E(x+dx,y+dy,t+dt)。

我们认为,由于对应同一个点,所以E(x,y,t) = E(x+dx,y+dy,t+dt) ——光流约束方程将上式右边做泰勒展开,并令dt->0,则得到:Exu+Eyv+Et = 0,其中:Ex = dE/dx Ey = dE/dy Et = dE/dt u = dx/dt v = dy/dt上面的Ex,Ey,Et的计算都很简单,用离散的差分代替导数就可以了。

光流法的主要任务就是通过求解光流约束方程求出u,v。

但是由于只有一个方程,所以这是个病态问题。

所以人们提出了各种其他的约束方程以联立求解。

但是由于我们用于摄像机固定的这一特定情况,所以问题可以大大简化。

摄像机固定的情形在摄像机固定的情形下,运动物体的检测其实就是分离前景和背景的问题。

我们知道对于背景,理想情况下,其光流应当为0,只有前景才有光流。

所以我们并不要求通过求解光流约束方程求出u,v。

我么只要求出亮度梯度方向的速率就可以了,即求出sqrt(u*u+v*v)。

而由光流约束方程可以很容易求到梯度方向的光流速率为V = abs(Et/sqrt(Ex*Ex+Ey*Ey))。

这样我们设定一个阈值T。

V(x,y) > T 则(x,y)是前景,反之是背景C++实现在实现摄像机固定情况的光流法时,需要有两帧连续的图像,下面的算法针对RGB24格式的图像计算光流:void calculate(unsigned char* buf){int Ex,Ey,Et;int gray1,gray2;int u;int i,j;memset(opticalflow,0,width*height*sizeof(int));memset(output,255,size);for(i=2;i<height-2;i++){for(j=2;j<width-2;j++){gray1 = int(((int)(buf[(i*width+j)*3])+(int)(buf[(i*width+j)*3+1])+(int)(buf[(i*width+j)*3+2]))*1.0/3);gray2 = int(((int)(prevframe[(i*width+j)*3])+(int)(prevframe[(i*width+j)*3+1])+(int)(prevframe[(i*width+j)*3+2]))*1.0/3);Et = gray1 - gray2;gray2 = int(((int)(buf[(i*width+j+1)*3])+(int)(buf[(i*width+j+1)*3+1])+(int)(buf[(i*width+j+1)*3+2]))*1.0/3);Ex = gray2 - gray1;gray2 = int(((int)(buf[((i+1)*width+j)*3])+(int)(buf[((i+1)*width+j)*3+1])+(int)(buf[((i+1)*width+j)*3+2]))*1.0/3);Ey = gray2 - gray1;Ex = ((int)(Ex/10))*10;Ey = ((int)(Ey/10))*10;Et = ((int)(Et/10))*10;u = (int)((Et*10.0)/(sqrt((Ex*Ex+Ey*Ey)*1.0))+0.1);opticalflow[i*width+j] = u;if(abs(u)>10){output[(i*width+j)*3] = 0;output[(i*width+j)*3+1] = 0;output[(i*width+j)*3+2] = 0;}}}memcpy(prevframe,buf,size);}///////////////////////////////////////////////////////////////////////////另一个代码//////////////////////////////////////////////////////////////////////////////WW_RETURN HumanMotion::ImgOpticalFlow(IplImage *pre_grey,IplImage *grey)/*************************************************Function:Description: 光流法计算运动速度与方向Date: 2006-6-14Author:Input:Output:Return:Others:*************************************************/{IplImage *velx = cvCreateImage( cvSize(grey->width ,grey->height),IPL_DEPTH_32F, 1 ); IplImage *vely = cvCreateImage( cvSize(grey->width ,grey->height),IPL_DEPTH_32F, 1 ); velx->origin = vely->origin = grey->origin;CvSize winSize = cvSize(5,5);cvCalcOpticalFlowLK( prev_grey, grey, winSize, velx, vely );cvAbsDiff( grey,prev_grey, abs_img );cvThreshold( abs_img, abs_img, 29, 255, CV_THRESH_BINARY);CvScalar xc,yc;for(int y =0 ;y<velx->height; y++)for(int x =0;x<velx->width;x++ ){xc = cvGetAt(velx,y,x);yc = cvGetAt(vely,y,x);float x_shift= (float)xc.val[0];float y_shift= (float)yc.val[0];const int winsize=5; //计算光流的窗口大小if((x%(winsize*2)==0) && (y%(winsize*2)==0) ){if(x_shift!=0 || y_shift!=0){if(x>winsize && y>winsize && x <(velx->width-winsize) && y<(velx->height-winsize) ) {cvSetImageROI( velx, cvRect( x-winsize, y-winsize, 2*winsize, 2*winsize));CvScalar total_x = cvSum(velx);float xx = (float)total_x.val[0];cvResetImageROI(velx);cvSetImageROI( vely, cvRect( x-winsize, y-winsize, 2*winsize, 2*winsize));CvScalar total_y = cvSum(vely);float yy = (float)total_y.val[0];cvResetImageROI(vely);cvSetImageROI( abs_img, cvRect( x-winsize, y-winsize, 2*winsize, 2*winsize));CvScalar total_speed = cvSum(abs_img);float ss = (float)total_speed.val[0]/(4*winsize*winsize)/255;cvResetImageROI(abs_img);const double ZERO = 0.000001;const double pi = 3.1415926;double alpha_angle;if(xx<ZERO && xx>-ZERO)alpha_angle = pi/2;elsealpha_angle = abs(atan(yy/xx));if(xx<0 && yy>0) alpha_angle = pi - alpha_angle ;if(xx<0 && yy<0) alpha_angle = pi + alpha_angle ;if(xx>0 && yy<0) alpha_angle = 2*pi - alpha_angle ;CvScalar line_color;float scale_factor = ss*100;line_color = CV_RGB(255,0,0);CvPoint pt1,pt2;pt1.x = x;pt1.y = y;pt2.x = static_cast<int>(x + scale_factor*cos(alpha_angle));pt2.y = static_cast<int>(y + scale_factor*sin(alpha_angle));cvLine( image, pt1, pt2 , line_color, 1, CV_AA, 0 );CvPoint p;p.x = (int) (pt2.x + 6 * cos(alpha_angle - pi / 4*3));p.y = (int) (pt2.y + 6 * sin(alpha_angle - pi / 4*3));cvLine( image, p, pt2, line_color, 1, CV_AA, 0 );p.x = (int) (pt2.x + 6 * cos(alpha_angle + pi / 4*3));p.y = (int) (pt2.y + 6 * sin(alpha_angle + pi / 4*3));cvLine( image, p, pt2, line_color, 1, CV_AA, 0 );/*line_color = CV_RGB(255,255,0);pt1.x = x-winsize;pt1.y = y-winsize;pt2.x = x+winsize;pt2.y = y+winsize;cvRectangle(image, pt1,pt2,line_color,1,CV_AA,0);*/}}}}cvShowImage( "Contour", abs_img);cvShowImage( "Contour2", vely);cvReleaseImage(&velx);cvReleaseImage(&vely);cvWaitKey(20);return WW_OK;}。

光流对齐算法-概述说明以及解释

光流对齐算法-概述说明以及解释1.引言1.1 概述光流对齐算法是一种用于计算图像序列中相邻帧之间运动信息的方法。

在计算机视觉领域,光流是指由于物体在连续帧间的相对运动而导致的像素亮度变化模式。

光流对齐算法通过分析图像中像素点的亮度变化,推断出像素点在不同帧间的运动轨迹和速度。

光流对齐算法的基本原理是基于两个关键假设:亮度恒定性和空间一致性。

亮度恒定性指的是在连续帧之间,同一物体的像素点的亮度保持不变;空间一致性则表明光流在相邻像素点之间应具有较高的一致性。

基于这两个假设,光流对齐算法通过优化像素点的亮度变化来估计物体在视频序列中的运动轨迹。

光流对齐算法在许多领域有着广泛的应用。

其中,视频稳定和视频压缩是最为常见的应用之一。

通过光流对齐算法,可以实现视频稳定,即抑制由于相机抖动或运动引起的视频模糊。

在视频压缩中,光流对齐算法可以用于提供更好的运动预测,以减少视频编码中的冗余信息,从而实现更高效的压缩算法。

总结而言,光流对齐算法是一种基于图像亮度变化的运动估计方法,凭借其在视频稳定和视频压缩等领域的广泛应用,成为计算机视觉领域中重要的技术手段。

本文将围绕光流算法的基本概念、光流对齐算法的原理和应用领域展开讨论,总结光流对齐算法的优点,并探讨其改进和未来发展的展望。

1.2 文章结构本文将详细介绍光流对齐算法的原理、应用领域以及相关的改进和展望。

文章的结构如下:第一部分是引言部分,其中包括以下内容:- 概述:介绍光流对齐算法的背景和意义。

探讨光流对齐算法在图像处理和计算机视觉领域的重要性。

- 文章结构:概括介绍本文的整体结构和各个部分的内容。

- 目的:明确论文的目标和意图,阐述本文旨在解决的问题。

第二部分是正文部分,主要包括以下内容:- 光流算法的基本概念:对光流算法的基本原理和概念进行详细解释,包括描述光流的定义、计算光流的方法以及光流场的特点等。

- 光流对齐算法的原理:剖析光流对齐算法的基本原理和实现方法,介绍对齐算法中使用的技术和策略,包括特征点匹配、运动估计和图像对齐等。

opencv的光流估计算法案例

光流估计是计算机视觉领域的一个重要问题,它可以用于检测图像中的运动物体、跟踪物体的运动轨迹等应用。

OpenCV是一个开源编程库,提供了丰富的图像处理和计算机视觉算法,其中也包括了光流估计算法。

本文将通过一个实际的案例来介绍OpenCV中的光流估计算法,通过对该算法的实现和应用展示其在图像处理中的重要性和实用性。

1. 算法原理我们需要了解光流估计算法的原理。

光流估计算法是通过对图像中的像素点在不同帧之间的运动进行分析,来估计出物体的运动轨迹。

常见的光流估计算法包括Lucas-Kanade算法、Horn-Schunk算法等。

这些算法主要通过对图像中像素点在时间上的变化进行建模,从而估计出物体的运动情况。

2. 案例介绍接下来,我们将通过一个具体的案例来演示OpenCV中光流估计算法的应用。

假设我们有一段视瓶,其中包含了一辆汽车在道路上行驶的画面。

我们希望通过光流估计算法来跟踪汽车的运动轨迹,并对其进行分析。

3. 数据准备我们需要准备视瓶数据和OpenCV编程环境。

我们可以通过OpenCV 提供的视瓶处理模块读取视瓶数据,并将其转换为图像序列。

我们可以使用OpenCV提供的图像处理函数对图像进行预处理,以提取出我们感兴趣的目标物体(即汽车)的特征点。

4. 算法实现接下来,我们可以使用OpenCV提供的光流估计算法对图像序列进行分析。

我们可以选择适合我们场景的光流估计算法,并将其应用到图像序列中。

通过分析光流场的变化,我们可以估计出汽车在道路上的运动轨迹,并对其进行可视化展示。

5. 结果分析我们可以对光流估计算法的结果进行分析。

我们可以通过对汽车的运动轨迹进行统计分析,从而得出关于汽车行驶速度、加速度等运动特性的信息。

我们还可以将光流估计算法的结果与其他传感器(如GPS、惯性传感器)得到的数据进行对比,从而验证光流估计算法的准确性和实用性。

通过这个案例,我们可以看到OpenCV中的光流估计算法在图像处理和计算机视觉领域的重要性和实用性。

光流

• Gabor滤波器和脊椎动物视觉皮层感受野响应的比较:第一行代 • 表脊椎动物的视觉皮层感受野,第二行是Gabor滤波器,第三行 • 是两者的残差。可见两者相差极小。Gabor滤波器的这一性质, • 使得其在视觉领域中经常被用来作图像的预处理。

• 常用的偶对称二维Gabor滤波器可表示为:

• 1. 不同方向下的Gabor滤波器:

4 基于相位的方法

• 相位信息用以计算光流由Fleet和Jepson首次提出。在计算光流的 时候图像上的相位信息往往比亮度信息更加可靠。 • 将二维图像变换到频率域中,变换如下: • I(X,t)=I0(X,n-Vt) • 式中n=(sinα,-cosα),α是图像的属性角。 • 通过带通滤波器,图像的相位为: • R(X,t)=ρ(X,t)exp[iφ(X,t)] • 式中:ρ为滤波器输出的幅值;φ为相角。

孔径问题

• 从圆孔中无法确定线条移动方向的来源,造成错觉。

• 为了解决孔径问题,必须找新的约束。一般使用的是HornSchunck算法和Lucas–Kanade方法。

1.1Horn-Schunck 模型

1981年,Horn和Schunck根据同一个运动物体的光流场具有连续、 平滑的特点, 提出一个附加约束条件,将光流场的整体平滑约束 转换为一个变分的问题。它的能量方程如下:

• 匹配法,分为区域匹配法和特征匹配。 • 2.1 • 区域匹配法认为上一帧中某个区域,在下一帧中会形成对应的模 式,块匹配光流定义为相邻两帧中,相应区域块之间产生最佳拟 合的位移。

案例:

• 景象匹配定位技术是一种重要的地物辅助导航技术, 具有很高的 导航定位精度, 常用于巡航弹等飞行器的导航制导。 景象匹配制 导中用到的参考图与实时图由于拍摄时间与条件的变化, 同时由 于成像设备的限制, 使得参考图与实时图之间存在灰度差异和几 何形变。

光流法原理(详细)

(3-3)

其中, u

dx dy ,v 分别是该点的光流沿 x, y 方向上的分量; I ( x, y ) 是像素点 ( x, y ) 在时刻 dt dt I I I , I y , I t 分别是灰度值 I 对 x、y 和 t 的偏导数,可从图像序列中 x t y

u Vx v V y

(3-8)

也就是说,ROI 内的 N 个像素点的速度是相同的。将其代入式(3-3)中得:

I I I Vx Vy x y t

(3-9)

该方程对 ROI 中的 N 个像素都成立,这样就可以得到由 N 个方程组成的方程组,用矩阵的

形式表示如下:

U

y z流场

约束线

b a

灰度的梯度 方向

图 3-9 孔径问题

因此,为了求得相邻帧 IVUS 图像之间血管壁的光流场,需增加另外的约束条件。设在 图像平面内足够小的区域(region of interest,ROI)内,在足够短的时间间隔内,两帧图像 之间的运动近似为线性的,即:

V It I 2 t 2 1/ 2 I (I x I y )

(3-7)

却无法确定光流在与梯度垂直方向(即沿等亮度线)上的分量。因此,只使用一点信息是不 能完全确定光流的,这种不确定问题就是孔径问题(aperture problem)[36]。

图像 平面 p' O

V

p P' P

(3-10)

这就产生了方程的超定问题:2个未知数, N 个方程。采用最小二乘法可以很容易地求解该 方程,所花费的计算时间比常用的迭代法要少。

(3-4) (3-5) (3-6)

Iy

It

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于OpenCV的三种光流算法实现源码及测试结果本文包括三种基于OpenCV的光流算法实现源码及测试结果。

具体为HS算法,LK算法,和ctfLK算法,算法的原实现作者是Eric Yuan,这里是作者的博客主页:http://eric-yuan.me。

本文对这三种光流算法进行了相关调试及结果验证,供大家在自己的项目开发中参考。

1.第一种:HS光流法(作者HORN 和SCHUNCK)#include"opencv2/core/core.hpp"#include"opencv2/imgproc/imgproc.hpp"#include"opencv2/highgui/highgui.hpp"#include<math.h>#include<fstream>#include<iostream>using namespace cv;using namespace std;#define ATD at<double>#define elif else if#ifndef bool#define bool int#define false ((bool)0)#define true ((bool)1)#endifMat get_fx(Mat &src1, Mat &src2){Mat fx;Mat kernel = Mat::ones(2, 2, CV_64FC1);kernel.ATD(0, 0) = -1.0;kernel.ATD(1, 0) = -1.0;Mat dst1, dst2;filter2D(src1, dst1, -1, kernel);filter2D(src2, dst2, -1, kernel);fx = dst1 + dst2;return fx;}Mat get_fy(Mat &src1, Mat &src2){Mat fy;Mat kernel = Mat::ones(2, 2, CV_64FC1);kernel.ATD(0, 0) = -1.0;kernel.ATD(0, 1) = -1.0;Mat dst1, dst2;filter2D(src1, dst1, -1, kernel);filter2D(src2, dst2, -1, kernel);fy = dst1 + dst2;return fy;}Mat get_ft(Mat &src1, Mat &src2){Mat ft;Mat kernel = Mat::ones(2, 2, CV_64FC1);kernel = kernel.mul(-1);Mat dst1, dst2;filter2D(src1, dst1, -1, kernel);kernel = kernel.mul(-1);filter2D(src2, dst2, -1, kernel);ft = dst1 + dst2;return ft;}bool isInsideImage(int y, int x, Mat &m){int width = m.cols;int height = m.rows;if (x >= 0 && x < width && y >= 0 && y < height) return true;else return false;}double get_Average4(Mat &m, int y, int x){if (x < 0 || x >= m.cols) return 0;if (y < 0 || y >= m.rows) return 0;double val = 0.0;int tmp = 0;if (isInsideImage(y - 1, x, m)){++tmp;val += m.ATD(y - 1, x);}if (isInsideImage(y + 1, x, m)){++tmp;val += m.ATD(y + 1, x);}if (isInsideImage(y, x - 1, m)){++tmp;val += m.ATD(y, x - 1);}if (isInsideImage(y, x + 1, m)){++tmp;val += m.ATD(y, x + 1);}return val / tmp;}Mat get_Average4_Mat(Mat &m){Mat res = Mat::zeros(m.rows, m.cols, CV_64FC1);for (int i = 0; i < m.rows; i++){for (int j = 0; j < m.cols; j++){res.ATD(i, j) = get_Average4(m, i, j);}}return res;}void saveMat(Mat &M, string s){s += ".txt";FILE *pOut = fopen(s.c_str(), "w+");for (int i = 0; i<M.rows; i++){for (int j = 0; j<M.cols; j++){fprintf(pOut, "%lf", M.ATD(i, j));if (j == M.cols - 1) fprintf(pOut, "\n");else fprintf(pOut, " ");}}fclose(pOut);}void getHornSchunckOpticalFlow(Mat img1, Mat img2){double lambda = 0.05;Mat u = Mat::zeros(img1.rows, img1.cols, CV_64FC1);Mat v = Mat::zeros(img1.rows, img1.cols, CV_64FC1);Mat fx = get_fx(img1, img2);Mat fy = get_fy(img1, img2);Mat ft = get_ft(img1, img2);int i = 0;double last = 0.0;while (1){Mat Uav = get_Average4_Mat(u);Mat Vav = get_Average4_Mat(v);Mat P = fx.mul(Uav) + fy.mul(Vav) + ft;Mat D = fx.mul(fx) + fy.mul(fy) + lambda;Mat tmp;divide(P, D, tmp);Mat utmp, vtmp;utmp = Uav - fx.mul(tmp);vtmp = Vav - fy.mul(tmp);Mat eq = fx.mul(utmp) + fy.mul(vtmp) + ft;double thistime = mean(eq)[0];cout << "i = " << i << ", mean = " << thistime << endl;if (i != 0 && fabs(last) <= fabs(thistime)) break;i++;last = thistime;u = utmp;v = vtmp;}saveMat(u, "U");saveMat(v, "V");imshow("U", u);imshow("v", v);waitKey(20000);}int main(){Mat img1 = imread("table1.jpg", 0);Mat img2 = imread("table2.jpg", 0);img1.convertTo(img1, CV_64FC1, 1.0 / 255, 0);img2.convertTo(img2, CV_64FC1, 1.0 / 255, 0);getHornSchunckOpticalFlow(img1, img2);// waitKey(0);return 0;}图1 HS光流法原始图像(之一)图2:HS光流法计算结果:U图3 HS光流法计算结果:V2.第二种:LK光流法(作者LUCAS 和KANADE)#include"opencv2/core/core.hpp"#include"opencv2/imgproc/imgproc.hpp"#include"opencv2/highgui/highgui.hpp"#include<math.h>#include<fstream>#include<iostream>using namespace cv;using namespace std;#define ATD at<double>#define elif else if#ifndef bool#define bool int#define false ((bool)0)#define true ((bool)1)#endifMat get_fx(Mat &src1, Mat &src2){Mat fx;Mat kernel = Mat::ones(2, 2, CV_64FC1);kernel.ATD(0, 0) = -1.0;kernel.ATD(1, 0) = -1.0;Mat dst1, dst2;filter2D(src1, dst1, -1, kernel);filter2D(src2, dst2, -1, kernel);fx = dst1 + dst2;return fx;}Mat get_fy(Mat &src1, Mat &src2){Mat fy;Mat kernel = Mat::ones(2, 2, CV_64FC1);kernel.ATD(0, 0) = -1.0;kernel.ATD(0, 1) = -1.0;Mat dst1, dst2;filter2D(src1, dst1, -1, kernel);filter2D(src2, dst2, -1, kernel);fy = dst1 + dst2;return fy;}Mat get_ft(Mat &src1, Mat &src2){Mat ft;Mat kernel = Mat::ones(2, 2, CV_64FC1);kernel = kernel.mul(-1);Mat dst1, dst2;filter2D(src1, dst1, -1, kernel);kernel = kernel.mul(-1);filter2D(src2, dst2, -1, kernel);ft = dst1 + dst2;return ft;}bool isInsideImage(int y, int x, Mat &m){int width = m.cols;int height = m.rows;if (x >= 0 && x < width && y >= 0 && y < height) return true;else return false;}double get_Sum9(Mat &m, int y, int x){if (x < 0 || x >= m.cols) return 0;if (y < 0 || y >= m.rows) return 0;double val = 0.0;int tmp = 0;if (isInsideImage(y - 1, x - 1, m)){++tmp;val += m.ATD(y - 1, x - 1);}if (isInsideImage(y - 1, x, m)){++tmp;val += m.ATD(y - 1, x);}if (isInsideImage(y - 1, x + 1, m)){++tmp;val += m.ATD(y - 1, x + 1);}if (isInsideImage(y, x - 1, m)){++tmp;val += m.ATD(y, x - 1);}if (isInsideImage(y, x, m)){++tmp;val += m.ATD(y, x);}if (isInsideImage(y, x + 1, m)){++tmp;val += m.ATD(y, x + 1);}if (isInsideImage(y + 1, x - 1, m)){++tmp;val += m.ATD(y + 1, x - 1);}if (isInsideImage(y + 1, x, m)){++tmp;val += m.ATD(y + 1, x);}if (isInsideImage(y + 1, x + 1, m)){++tmp;val += m.ATD(y + 1, x + 1);}if (tmp == 9) return val;else return m.ATD(y, x) * 9;}Mat get_Sum9_Mat(Mat &m){Mat res = Mat::zeros(m.rows, m.cols, CV_64FC1);for (int i = 1; i < m.rows - 1; i++){for (int j = 1; j < m.cols - 1; j++){res.ATD(i, j) = get_Sum9(m, i, j);}}return res;}void saveMat(Mat &M, string s){s += ".txt";FILE *pOut = fopen(s.c_str(), "w+");for (int i = 0; i<M.rows; i++){for (int j = 0; j<M.cols; j++){fprintf(pOut, "%lf", M.ATD(i, j));if (j == M.cols - 1) fprintf(pOut, "\n");else fprintf(pOut, " ");}}fclose(pOut);}void getLucasKanadeOpticalFlow(Mat &img1, Mat &img2, Mat &u, Mat &v){Mat fx = get_fx(img1, img2);Mat fy = get_fy(img1, img2);Mat ft = get_ft(img1, img2);Mat fx2 = fx.mul(fx);Mat fy2 = fy.mul(fy);Mat fxfy = fx.mul(fy);Mat fxft = fx.mul(ft);Mat fyft = fy.mul(ft);Mat sumfx2 = get_Sum9_Mat(fx2);Mat sumfy2 = get_Sum9_Mat(fy2);Mat sumfxft = get_Sum9_Mat(fxft);Mat sumfxfy = get_Sum9_Mat(fxfy);Mat sumfyft = get_Sum9_Mat(fyft);Mat tmp = sumfx2.mul(sumfy2) - sumfxfy.mul(sumfxfy);u = sumfxfy.mul(sumfyft) - sumfy2.mul(sumfxft);v = sumfxft.mul(sumfxfy) - sumfx2.mul(sumfyft);divide(u, tmp, u);divide(v, tmp, v);saveMat(u, "U");saveMat(v, "V");imshow("U", u);imshow("V", v);waitKey(2000);}int main(){Mat img1 = imread("car1.jpg", 0);Mat img2 = imread("car2.jpg", 0);img1.convertTo(img1, CV_64FC1, 1.0 / 255, 0);img2.convertTo(img2, CV_64FC1, 1.0 / 255, 0);Mat u = Mat::zeros(img1.rows, img1.cols, CV_64FC1);Mat v = Mat::zeros(img1.rows, img1.cols, CV_64FC1);getLucasKanadeOpticalFlow(img1, img2, u, v);cout << "done" << endl;return 0;}图4 LK光流法原始图像(之一)图5 LK光流法计算结果:U图6 LK光流法计算结果:V3.第三种:ctfLK光流法(LK光流法的Coarse to fine版本)#include"opencv2/core/core.hpp"#include"opencv2/imgproc/imgproc.hpp"#include"opencv2/highgui/highgui.hpp"#include<math.h>#include<fstream>#include<iostream>using namespace cv;using namespace std;#define ATD at<double>#define ATF at<float>#define elif else if#ifndef bool#define bool int#define false ((bool)0)#define true ((bool)1)#endifMat get_fx(Mat &src1, Mat &src2){Mat fx;Mat kernel = Mat::ones(2, 2, CV_64FC1);kernel.ATD(0, 0) = -1.0;kernel.ATD(1, 0) = -1.0;Mat dst1, dst2;filter2D(src1, dst1, -1, kernel);filter2D(src2, dst2, -1, kernel);fx = dst1 + dst2;return fx;}Mat get_fy(Mat &src1, Mat &src2){Mat fy;Mat kernel = Mat::ones(2, 2, CV_64FC1);kernel.ATD(0, 0) = -1.0;kernel.ATD(0, 1) = -1.0;Mat dst1, dst2;filter2D(src1, dst1, -1, kernel);filter2D(src2, dst2, -1, kernel);fy = dst1 + dst2;return fy;}Mat get_ft(Mat &src1, Mat &src2){Mat ft;Mat kernel = Mat::ones(2, 2, CV_64FC1);kernel = kernel.mul(-1);Mat dst1, dst2;filter2D(src1, dst1, -1, kernel);kernel = kernel.mul(-1);filter2D(src2, dst2, -1, kernel);ft = dst1 + dst2;return ft;}bool isInsideImage(int y, int x, Mat &m){int width = m.cols;int height = m.rows;if (x >= 0 && x < width && y >= 0 && y < height) return true;else return false;}double get_Sum9(Mat &m, int y, int x){if (x < 0 || x >= m.cols) return 0;if (y < 0 || y >= m.rows) return 0;double val = 0.0;int tmp = 0;for (int i = -1; i <= 1; i++){for (int j = -1; j <= 1; j++){if (isInsideImage(y + i, x + j, m)){++tmp;val += m.ATD(y + i, x + j);}}}if (tmp == 9) return val;else return m.ATD(y, x) * 9;}Mat get_Sum9_Mat(Mat &m){Mat res = Mat::zeros(m.rows, m.cols, CV_64FC1);for (int i = 1; i < m.rows - 1; i++){for (int j = 1; j < m.cols - 1; j++){res.ATD(i, j) = get_Sum9(m, i, j);}}return res;}void saveMat(Mat &M, string s){s += ".txt";FILE *pOut = fopen(s.c_str(), "w+");for (int i = 0; i<M.rows; i++){for (int j = 0; j<M.cols; j++){fprintf(pOut, "%lf", M.ATD(i, j));if (j == M.cols - 1) fprintf(pOut, "\n");else fprintf(pOut, " ");}}fclose(pOut);}void getLucasKanadeOpticalFlow(Mat &img1, Mat &img2, Mat &u, Mat &v){Mat fx = get_fx(img1, img2);Mat fy = get_fy(img1, img2);Mat ft = get_ft(img1, img2);Mat fx2 = fx.mul(fx);Mat fy2 = fy.mul(fy);Mat fxfy = fx.mul(fy);Mat fxft = fx.mul(ft);Mat fyft = fy.mul(ft);Mat sumfx2 = get_Sum9_Mat(fx2);Mat sumfy2 = get_Sum9_Mat(fy2);Mat sumfxft = get_Sum9_Mat(fxft);Mat sumfxfy = get_Sum9_Mat(fxfy);Mat sumfyft = get_Sum9_Mat(fyft);Mat tmp = sumfx2.mul(sumfy2) - sumfxfy.mul(sumfxfy);u = sumfxfy.mul(sumfyft) - sumfy2.mul(sumfxft);v = sumfxft.mul(sumfxfy) - sumfx2.mul(sumfyft);divide(u, tmp, u);divide(v, tmp, v);}vector<Mat> getGaussianPyramid(Mat &img, int nLevels){vector<Mat> pyr;pyr.push_back(img);for (int i = 0; i < nLevels - 1; i++){Mat tmp;pyrDown(pyr[pyr.size() - 1], tmp);pyr.push_back(tmp);}return pyr;}void coarseToFineEstimation(Mat &img1, Mat &img2, Mat &u, Mat &v, int nLevels){vector<Mat> pyr1 = getGaussianPyramid(img1, nLevels);vector<Mat> pyr2 = getGaussianPyramid(img2, nLevels);Mat upu, upv;for (int i = nLevels - 1; i >= 0; i--){Mat tmpu = Mat::zeros(pyr1[i].rows, pyr1[i].cols, CV_64FC1);Mat tmpv = Mat::zeros(pyr2[i].rows, pyr2[i].cols, CV_64FC1);getLucasKanadeOpticalFlow(pyr1[i], pyr2[i], tmpu, tmpv);if (i != nLevels - 1){tmpu += upu;tmpv += upv;}if (i == 0){u = tmpu;v = tmpv;return;}pyrUp(tmpu, upu);pyrUp(tmpv, upv);Mat map1(upu.size(), CV_32FC2);Mat map2(upu.size(), CV_32FC2);for (int y = 0; y < map1.rows; ++y){for (int x = 0; x < map1.cols; ++x){Point2f f = Point2f((float)(upu.ATD(y, x)),(float)(upv.ATD(y, x)));map1.at<Point2f>(y, x) = Point2f(x + f.x / 2, y + f.y / 2);map2.at<Point2f>(y, x) = Point2f(x - f.x / 2, y - f.y / 2);}}Mat warped1, warped2;remap(pyr1[i - 1], warped1, map1, cv::Mat(), INTER_LINEAR);remap(pyr2[i - 1], warped2, map2, cv::Mat(), INTER_LINEAR);warped1.copyTo(pyr1[i - 1]);warped2.copyTo(pyr2[i - 1]);}}int getMaxLayer(Mat &img){int width = img.cols;int height = img.rows;int res = 1;int p = 1;while (1){int tmp = pow(2, p);if (width % tmp == 0) ++p;else break;}res = p;p = 1;while (1){int tmp = pow(2, p);if (height % tmp == 0) ++p;else break;}res = res < p ? res : p;return res;}int main(){Mat ori1 = imread("table1.jpg", 0);Mat ori2 = imread("table2.jpg", 0);Mat img1 = ori1(Rect(0, 0, 640, 448));Mat img2 = ori2(Rect(0, 0, 640, 448));int maxLayer = getMaxLayer(img1);cout << img1.rows << ", " << img1.cols << ", Max layer = " << maxLayer << endl;img1.convertTo(img1, CV_64FC1, 1.0 / 255, 0);img2.convertTo(img2, CV_64FC1, 1.0 / 255, 0);Mat u = Mat::zeros(img1.rows, img1.cols, CV_64FC1);Mat v = Mat::zeros(img1.rows, img1.cols, CV_64FC1);Mat u2 = Mat::zeros(img1.rows, img1.cols, CV_64FC1);Mat v2 = Mat::zeros(img1.rows, img1.cols, CV_64FC1);if (maxLayer >= 1){coarseToFineEstimation(img1, img2, u, v, maxLayer);saveMat(u, "U");saveMat(v, "V");}getLucasKanadeOpticalFlow(img1, img2, u2, v2);saveMat(u2, "U2");saveMat(v2, "V2");imshow("U2", u2);imshow("v2", v2);waitKey(20000);return 0;}图7 ctfLK光流法测试原始图像(之一)图8 ctfLK光流法计算结果:U2图9 ctfLK光流法计算结果:v2。