机器学习_US Census Data (1990) Data Set(美国人口普查数据(1990)数据集)

机器学习算法的发展和应用

机器学习算法的发展和应用引言机器学习(Machine Learning)是一种基于数据的人工智能领域,从数据中自动提取模式并学习如何做出决策或预测。

随着数据量不断增大和计算能力的不断提高,机器学习算法在各个领域的应用日益普及。

本文将从历史发展、算法分类和应用领域三个方面探讨机器学习算法的发展和应用。

发展历程机器学习的发展历程可以追溯到上世纪50年代,当时,学者们开始尝试用仿生学习的方式来训练机器。

1980年代,神经网络算法被提出来,使机器学习得以实现非线性运算。

1990年代,支持向量机(SVM)算法被提出来,得到了广泛的应用。

进入21世纪,深度学习算法取得了重大突破,使得机器学习在图像识别、自然语言处理等领域有了很大的进展。

算法分类机器学习算法可以分为监督学习、非监督学习和强化学习三大类。

1. 监督学习监督学习算法是一种利用已有数据训练模型,从而预测未知数据的方法。

它需要交给机器一组已知的输入和输出数据,然后通过这些数据训练出一个模型来预测未知的输出数据。

其中,最常见的方法是决策树、神经网络、支持向量机等。

2. 非监督学习非监督学习算法是一种不需要已知输出的方法,它是从没有标记的数据中学习规律,能够用于聚类、降维、特征提取等。

常见的算法有K均值聚类、自组织映射网络等。

3. 强化学习强化学习算法是一种基于奖励和惩罚的学习方式。

它是一种机器学习的方法,用于训练智能体(agent)去适应在动态环境中的行为方式。

在这种方法中,机器不用事先知道正确的输出结果,而是通过与环境互动,得到不断的奖励和惩罚,从而实现优化自身的行为方式。

Q学习、策略梯度等是常见的强化学习算法。

应用领域机器学习算法在各个领域均有广泛应用,如图像识别、自然语言处理、金融、医疗等。

1. 图像识别图像识别是机器学习领域中的一个重点应用领域。

深度学习算法的出现极大地推动了图像识别的发展,它不仅可以识别物体或场景,还可以进行人脸识别、自动驾驶等。

机器学习课件ppt

逻辑回归通过将输入变量映射到概率 值来工作,然后使用阈值将概率值转 换为二进制类别。它通常用于二元分 类问题,如点击率猜测或敲诈检测。

决策树

总结词

决策树是一种监督学习算法,它通过树形结构进行决策和分 类。

详细描写

决策树通过递归地将数据集划分为更小的子集来工作,直到 到达终止条件。每个内部节点表示一个特征的测试,每个分 支表示测试的一个结果,每个叶节点表示一个类标签。

深度学习的应用场景包括图像 辨认、语音辨认、自然语言处 理和推举系统等。

强化学习

01

强化学习是机器学习的一个分支 ,通过让智能体与环境交互来学 习最优的行为策略。

02

强化学习的特点是基于环境的反 馈来不断优化行为,以到达最终

的目标。

常见的强化学习算法包括Qlearning、SARSA和Deep Qnetwork等。

计算机视觉

机器学习在计算机视觉领域的应用包 括图像分类、目标检测、人脸辨认等 。

推举系统

机器学习在推举系统中的应用是通过 分析用户行为和偏好来推举相关的内 容或产品。

语音助手

机器学习在语音助手中的应用是通过 语音辨认和自然语言处理技术来理解 用户意图并作出相应回应。

02

机器学习基础

线性回归

总结词

线性回归是一种通过拟合数据点来猜测连续值的算法。

详细描写

线性回归通过找到最佳拟合直线来猜测因变量的值,该直线基于自变量和因变 量之间的关系。它使用最小二乘法来拟合数据,并输出一个线性方程,可以用 来进行猜测。

逻辑回归

总结词

逻辑回归是一种用于分类问题的算法 ,它将连续的输入变量转换为二进制 的输出变量。

数据清洗

去除特殊值、缺失值和重复数据,确保数据质量。

机器学习中的时间序列数据处理方法(十)

机器学习中的时间序列数据处理方法一、引言在当今数字化时代,大量的时间序列数据被广泛应用于金融、医疗、气象、工业生产等领域。

时间序列数据是按时间顺序排列的数据集合,如股票价格、交通流量、气温变化等,其特点是具有时间相关性和趋势性。

由于时间序列数据的高维度和复杂性,传统的统计方法往往难以有效处理,因此机器学习方法成为处理时间序列数据的重要手段。

本文将介绍机器学习中常用的时间序列数据处理方法,以及其在不同领域的应用。

二、预处理时间序列数据预处理是机器学习中的重要环节,主要包括数据清洗、平稳性检验和特征工程。

数据清洗是指对采集到的原始数据进行去噪、缺失值填补和异常值处理,以保证数据质量。

平稳性检验是为了确定时间序列数据是否平稳,通常通过单位根检验、ADF检验等进行判断。

特征工程则包括特征提取、特征选择和特征变换,以提取出对预测任务最有用的特征。

三、时间序列模型在时间序列数据处理中,常用的模型包括自回归移动平均模型(ARMA)、自回归积分移动平均模型(ARIMA)、季节性自回归积分移动平均模型(SARIMA)等。

这些模型可以对时间序列数据进行建模和预测,对于短期和长期预测具有较好的效果。

此外,随机游走模型(Random Walk)和指数平滑模型(Exponential Smoothing)也是常用的时间序列模型。

四、循环神经网络循环神经网络(Recurrent Neural Network,RNN)是一种专门用于处理序列数据的神经网络结构。

RNN具有记忆功能,能够捕捉序列数据之间的时间依赖关系,因此在自然语言处理、语音识别和股票预测等领域有着广泛的应用。

另外,长短期记忆网络(Long Short-Term Memory,LSTM)和门控循环单元(Gated Recurrent Unit,GRU)是RNN的改进版本,能够更好地解决长序列数据的梯度消失和梯度爆炸问题。

五、卷积神经网络卷积神经网络(Convolutional Neural Network,CNN)通常被用于处理图像数据,在时间序列数据处理中也有着广泛的应用。

如何处理机器学习中的时间序列数据问题

如何处理机器学习中的时间序列数据问题机器学习中的时间序列数据问题是指在处理时间相关性强的数据时所面临的挑战。

时间序列数据是按照时间顺序收集的数据,常见于金融、天气、股票等领域。

在处理时间序列数据时,要考虑数据的趋势、周期性和季节性等因素,以预测未来的趋势和进行相关分析。

本文将介绍如何处理机器学习中的时间序列数据问题。

首先,对时间序列数据进行可视化是理解数据的重要步骤。

绘制数据的时间序列图可以帮助我们了解数据的整体趋势、季节性和异常值。

常见的时间序列图包括折线图、柱状图和箱型图等。

通过观察这些图形,我们可以初步判断数据是否具有趋势性、周期性或季节性,并检测是否存在异常值。

其次,时间序列数据中常常存在噪声和趋势。

噪声是指数据中的随机波动,而趋势是指数据随时间变化的整体趋势。

为了更好地分析数据中的趋势和模式,通常需要对数据进行平滑处理。

常见的平滑技术包括移动平均、加权平均和指数平滑等。

这些方法可以帮助我们去除噪声,凸显数据的趋势和模式。

另外,时间序列数据通常具有自相关性。

自相关性是指数据点与其滞后版本之间的相关性。

通过计算自相关函数(ACF)和偏自相关函数(PACF),我们可以确定时间序列数据的滞后阶数,从而选择适当的模型。

常见的时间序列模型包括AR、MA、ARMA和ARIMA等。

这些模型可以帮助我们理解数据中的动态关系,并进行预测和分析。

此外,时间序列数据中还常常存在季节性的影响。

季节性是指数据随时间呈现出明显的周期性变化。

为了处理具有季节性的时间序列数据,我们可以使用季节性差分和季节性模型。

季节性差分是指对数据进行周期性差分,以去除季节性影响。

而季节性模型可以通过建立SARIMA模型来捕捉季节性的影响。

在处理时间序列数据时,还需要考虑数据的缺失值和异常值处理。

缺失值是指在时间序列数据中存在的空值,而异常值是指与数据集中其他值显著不同的极端值。

为了处理缺失值,我们可以采用插值法或者建立模型进行填充。

机器学习的基本认识

机器学习的基本认识机器学习(Machine Learning,ML)是一种通过计算机程序进行无需明确编程的人工智能(Artificial Intelligence,AI)学习的方法。

它通过对大量数据进行分析和处理,从中学习规律和模式,以便做出预测和决策。

机器学习已经成为现代科学和技术研究的重要领域,广泛应用于图像和语音识别、自然语言处理、推荐系统等诸多领域。

机器学习的基本原理是利用统计学和优化理论的方法,通过对样本数据的学习来推断输入和输出之间的关系,并将学习到的模型用于未知数据的预测和分类。

其中,输入数据称为特征,输出数据称为标签或目标变量。

在机器学习中,我们常用的任务可以分为监督学习、无监督学习和强化学习。

监督学习(Supervised Learning)是指在训练样本中,除了输入特征外,还给出了对应的标签或目标变量,如分类和回归问题。

分类问题是指将输入样本分为预先定义的类别,如垃圾邮件识别和图像分类;而回归问题则是建立输入和输出之间的连续关系,如房价预测和股票价格预测。

无监督学习(Unsupervised Learning)与监督学习相反,它只给出输入数据的特征,没有给出输出数据的标签或目标变量。

无监督学习主要用于聚类和降维。

聚类是一种将样本划分到不同组别的方法,如市场用户分群、图像分割和推荐系统;降维则是减少数据特征维度的方法,以便更好地可视化和理解数据。

强化学习(Reinforcement Learning)是指智能体通过与环境进行交互,根据环境的反馈调整自己的行为以获得最大化的奖励。

强化学习常用于游戏策略、机器人控制和搜索优化等领域。

其中,智能体通过学习、规划和执行三个步骤来梳理与环境的交互。

机器学习的方法有很多,其中最常用的方法包括决策树、逻辑回归、支持向量机、人工神经网络和集成学习等。

决策树是一种根据特征逐步判断目标变量的方法;逻辑回归是一种线性分类方法,用于解决二分类问题;支持向量机则是非线性分类的方法,它通过引入核函数将数据映射到高维空间,以便更好地分割不同类别;人工神经网络则是一种模拟大脑神经元的计算模型,通过多个神经元的相互连接来实现复杂的模式识别。

机器学习的发展历史介绍

机器学习的发展历史介绍从1642年Pascal发明的手摇式计算机,到1949年Donald Hebb 提出的赫布理论——解释学习过程中大脑神经元所发生的变化,都蕴含着机器学习思想的萌芽。

事实上,1950年图灵在关于图灵测试的文章中就已提及机器学习的概念。

到了1952年,IBM的亚瑟·塞缪尔(Arthur Samuel,被誉为“机器学习之父”)设计了一款可以学习的西洋跳棋程序。

它能够通过观察棋子的走位来构建新的模型,用来提高自己的下棋技巧。

塞缪尔和这个程序进行多场对弈后发现,随着时间的推移,程序的棋艺变得越来越好[1]。

塞缪尔用这个程序推翻了以往“机器无法超越人类,不能像人一样写代码和学习”这一传统认识,并在1956年正式提出了“机器学习”这一概念。

他认为“机器学习是在不直接针对问题进行编程的情况下,赋予计算机学习能力的一个研究领域”。

对机器学习的认识可以从多个方面进行,有着“全球机器学习教父”之称的Tom Mitchell则将机器学习定义为:对于某类任务T和性能度量P,如果计算机程序在T上以P衡量的性能随着经验E而自我完善,就称这个计算机程序从经验E学习。

这些定义都比较简单抽象,但是随着对机器学习了解的深入,我们会发现随着时间的变迁,机器学习的内涵和外延在不断地变化。

因为涉及到的领域和应用很广,发展和变化也相当迅速,简单明了地给出“机器学习”这一概念的定义并不是那么容易。

普遍认为,机器学习(Machine Learning,常简称为ML)的处理系统和算法是主要通过找出数据里隐藏的模式进而做出预测的识别模式,它是人工智能(Artificial Intelligence,常简称为AI)的一个重要子领域,而人工智能又与更广泛的数据挖掘(Data Mining,常简称为DM)和知识发现(KnowLEDge Discovery in Database,常简称为KDD)领域相交叉。

1956年机器学习的概念由Arthur Samuel正式提出。

机器学习的发展历程

机器学习的发展历程机器学习(Machine Learning)是人工智能(Artificial Intelligence)领域的一个重要分支,其发展历程可以追溯到上世纪五六十年代。

以下按时间顺序梳理了机器学习的重要发展阶段和里程碑事件。

1. 逻辑回归(1957年):逻辑回归是早期机器学习算法之一,用于二分类问题。

由美国统计学家David Cox开发,被广泛应用于生物学和医学领域。

2. 人工神经网络(1958年):美国心理学家Frank Rosenblatt提出了感知器模型,该模型模拟了生物神经元的功能。

这是神经网络在机器学习中的首次应用。

3. 决策树算法(1963年):美国计算机科学家Leo Breiman开发了决策树算法,通过一系列的决策节点将数据划分成不同的类别或子集。

决策树在数据挖掘和分类问题中被广泛使用。

4. 支持向量机(1992年):由Vladimir Vapnik和Alexey Chervonenkis提出,支持向量机是一种强大的分类算法,通过在特征空间中构造最优超平面实现分类。

5. 集成学习(1994年):通过将多个弱学习器组合成强学习器,以取长补短,提高分类性能。

Adaboost是最早的集成学习算法之一。

6. EM算法(1997年):EM算法由Arthur Dempster、NanLaird和Donald Rubin提出,用于解决含有隐变量的概率模型参数估计问题。

7. K-近邻算法(2001年):K-近邻算法是一种基于实例的学习方法,利用已知样本进行分类或回归预测。

根据最邻近的K 个样本确定未知样本的类别。

8. 深度学习(2012年):深度学习是一种模仿人脑神经网络结构和工作原理的机器学习方法。

由于其强大的学习能力和特征表示能力,深度学习在图像识别、语音识别等领域取得了突破性进展。

9. 强化学习(2013年):强化学习是一种通过与环境交互学习策略的机器学习方法。

AlphaGo的胜利,标志着强化学习在游戏领域的成功,并为其在其他领域的应用带来了更多关注。

机器学习

研究现状

传统的研究现 状

大数据环境下 的研究现状

传统机器学习的研究方向主要包括决策树、随机森林、人工神经络、贝叶斯学习等方面的研究。

决策树是机器学习常见的一种方法。20世纪末期,机器学习研究者J.Ross Quinlan将Shannon的信息论引入 到了决策树算法中,提出了ID3算法。1984年I.Kononenko、E.Roskar和I.Bratko在ID3算法的基础上提出了ASSISTANTAlgorithm,这种算法允许类别的取值之间有交集。同年,A.Hart提出了Chi-Squa统计算法,该算法采 用了一种基于属性与类别关联程度的统计量。1984年L.Breiman、C.Ttone、R.Olshen和J.Freidman提出了决策 树剪枝概念,极大地改善了决策树的性能。1993年,Quinlan在ID3算法的基础上提出了一种改进算法,即C4.5 算法。C4.5算法克服了ID3算法属性偏向的问题增加了对连续属性的处理通过剪枝,在一定程度上避免了“过度 适合”现象。但是该算法将连续属性离散化时,需要遍历该属性的所有值,降低了效率,并且要求训练样本集驻 留在内存,不适合处理大规模数据集。2010年Xie提出一种CART算法,该算法是描述给定预测向量X条件分布变量 Y的一个灵活方法,已经在许多领域得到了应用。CART算法可以处理无序的数据,采用基尼系数作为测试属性的 选择标准。CART算法生成的决策树精确度较高,但是当其生成的决策树复杂度超过一定程度后,随着复杂度的提 高,分类精确度会降低,所以该算法建立的决策树不宜太复杂。2007年房祥飞表述了一种叫SLIQ(决策树分类) 算法,这种算法的分类精度与其他决策树算法不相上下,但其执行的速度比其他决策树算法快,它对训练样本集 的样本数量以及属性的数量没有限制。SLIQ算法能够处理大规模的训练样本集,具有较好的伸缩性;执行速度快 而且能生成较小的二叉决策树。SLIQ算法允许多个处理器同时处理属性表,从而实现了并行性。但是SLIQ算法依 然不能摆脱主存容量的限制。

数据洞见名词解释

数据洞见名词解释数据洞见( data insight),是一种新型的管理方式,可以通过对大量不同来源、不同时间、不同渠道的数据进行挖掘和分析,使得管理者从海量的数据中提炼出有价值的信息,进而对商业问题作出正确的决策。

数据洞见最早由美国麻省理工学院和哈佛大学的学者彼得·希尔在1999年提出, 2002年英特尔公司将数据洞见应用到产品创新上,实现了企业管理的重要转变。

2012年被财富杂志评为改变商业世界的十项技术之一。

2013年,联合国数据与可持续发展委员会建议将“数据洞见”纳入数字发展蓝图。

an agent,管理学里的一个名词,用来定义以下四类角色:“数据仓库”管理者。

他们需要精通并能有效地运用各种数据挖掘工具。

“规划者”。

他们负责从宏观和微观角度整体性地审视和设计数据洞见。

“建构师”。

他们以人为本,帮助客户更加高效地利用所拥有的信息资源。

“运营商”。

他们需要了解不同组织的相关情况,建立跨部门团队,发挥协同效应。

20世纪50年代,一批批的管理者采用传统的科学管理模式,致力于研究提升生产率、降低成本等指标。

但随着市场经济的发展,科学管理已经无法满足新时期企业管理的需求。

20世纪70年代末80年代初,彼得·德鲁克、安索夫·辛格、哈罗德·孔茨等一批知名管理学家针对这些问题进行了探讨,并把“数据洞见”作为管理领域的重要手段,并广泛应用到企业管理中。

20世纪90年代初,英特尔公司首次将“数据洞见”应用到产品创新中,在开发手机芯片时,通过对2亿多颗芯片数据的采集、处理,英特尔实现了每平方厘米功耗减少3瓦的目标。

20世纪50年代,福特汽车公司引进流水线后,最初取得了良好的经济效益,但随着竞争的激烈化,成本越来越高,利润越来越薄,工人的生产积极性也不断降低,严重制约了生产效率的提高,甚至导致了工厂效益的下滑。

到20世纪60年代,美国出现了“看得见的行动迟缓”( visible action slows)的怪现象,这种现象表明,尽管企业不断努力缩短顾客的等待时间,以提高生产效率,但由于顾客缺乏积极的反馈意识,顾客的9e81e66de785beea6 e7corresponded85c91fef6d86b865e4758e56f56f6cd5e9a2ba988d9d2fd d a动机一直不高,造成企业经济效益的下降。

《机器学习》期末考试试卷附答案

《机器学习》期末考试试卷附答案一、选择题(每题5分,共25分)1. 机器学习的主要目的是让计算机从数据中____,以实现某些任务或预测未知数据。

A. 抽取特征B. 生成模型C. 进行推理D. 分类标签答案:B. 生成模型2. K-近邻算法(K-NN)是一种____算法。

A. 监督学习B. 无监督学习C. 半监督学习D. 强化学习答案:A. 监督学习3. 在决策树算法中,节点的分裂是基于____进行的。

A. 信息增益B. 基尼不纯度C. 均方误差D. 交叉验证答案:A. 信息增益4. 支持向量机(SVM)的主要目的是找到一个超平面,将不同类别的数据点____。

A. 完全分开B. 尽量分开C. 部分分开D. 不分开答案:B. 尽量分开5. 哪种优化算法通常用于训练深度学习模型?A. 梯度下降B. 牛顿法C. 拟牛顿法D. 以上都对答案:D. 以上都对二、填空题(每题5分,共25分)1. 机器学习可以分为监督学习、无监督学习和____学习。

A. 半监督B. 强化C. 主动学习D. 深度答案:A. 半监督2. 线性回归模型是一种____模型。

A. 线性B. 非线性C. 混合型D. 不确定型答案:A. 线性3. 在进行特征选择时,常用的评估指标有____、____和____。

A. 准确率B. 召回率C. F1 分数D. AUC 值答案:B. 召回率C. F1 分数D. AUC 值4. 神经网络中的激活函数通常用于引入____。

A. 非线性B. 线性C. 噪声D. 约束答案:A. 非线性5. 当我们说一个模型具有很好的泛化能力时,意味着该模型在____上表现良好。

A. 训练集B. 验证集C. 测试集D. 所有集答案:C. 测试集三、简答题(每题10分,共30分)1. 请简要解释什么是过拟合和欠拟合,并给出解决方法。

2. 请解释什么是交叉验证,并说明它的作用。

答案:交叉验证是一种评估模型泛化能力的方法,通过将数据集分成若干个互斥的子集,轮流用其中若干个子集作为训练集,其余子集作为验证集,对模型进行评估。

机器学习_Census-Income Database(人口调查收入数据集)

Census-Income Database(人口调查收入数据集)数据摘要:This data set contains unweighted PUMS census data from the Los Angeles and Long Beach areas for the years 1970, 1980, and 1990. The coding schemes have been standardized (by the IPUMS project) to be consistent across years.中文关键词:人口普查收入,洛杉矶,分类,IPUMS project,UCI KDD,英文关键词:Census income,Los Angeles,Classification,IPUMS project,UCI KDD,数据格式:TEXT数据用途:Classification,multivariate数据详细介绍:Census-Income DatabaseData TypemultivariateAbstractThis data set contains weighted census data extracted from the 1994 and 1995 current population surveys conducted by the U.S. Census Bureau. The data contains demographic and employment related variables.SourcesOriginal OwnerU.S. Census BureauUnited States Department of CommerceDonorTerran Lane and Ronny KohaviData Mining and VisualizationSilicon Graphics.terran@, ronnyk@Date Donated: March 7, 2000Data CharacteristicsThis data set contains weighted census data extracted from the 1994 and 1995 Current Population Surveys conducted by the U.S. Census Bureau. The data contains 41 demographic and employment related variables.The instance weight indicates the number of people in the population that each record represents due to stratified sampling. To do real analysis and derive conclusions, this field must be used. This attribute should *not* be used in the classifiers.More information detailing the meaning of the attributes can be found in the Census Bureau's documentation To make use of the data descriptions at this site, the following mappings to the Census Bureau's internal database column names will be needed:age AAGEclass of worker ACLSWKR industry code ADTIND occupation code ADTOCC adjusted gross income AGI education AHGAwage per hour AHRSPAY enrolled in edu inst last wk AHSCOL marital status AMARITL major industry code AMJIND major occupation code AMJOCC mace ARACE hispanic Origin AREORGN sex ASEX member of a labor union AUNMEM reason for unemployment AUNTYPE full or part time employment stat AWKSTATcapital gains CAPGAIN capital losses CAPLOSS divdends from stocks DIVVAL federal income tax liability FEDTAXtax filer status FILESTATregion of previous residence GRINREG state of previous residence GRINST detailed household and family stat HHDFMXdetailed household summary in household HHDREL instance weight MARSUPWT migration code-change in msa MIGMTR1 migration code-change in reg MIGMTR3 migration code-move within reg MIGMTR4 live in this house 1 year ago MIGSAME migration prev res in sunbelt MIGSUN num persons worked for employer NOEMP family members under 18 PARENT total person earnings PEARNVAL country of birth father PEFNTVTY country of birth mother PEMNTVTY country of birth self PENATVTY citizenship PRCITSHP total person income PTOTVAL own business or self employed SEOTR taxable income amount TAXINCfill inc questionnaire for veteran's admin VETQVAveterans benefits VETYNweeks worked in year WKSWORKNote that Incomes have been binned at the $50K level to present a binary classification problem, much like the original UCI/ADULT database. The goal field of this data, however, was drawn from the "total person income" field rather than the "adjusted gross income" and may, therefore, behave differently than the orginal ADULT goal field.Basic statistics for this data setNumber of instances in data = 199523Duplicate or conflicting instances : 46716Number of instances in test = 99762Duplicate or conflicting instances : 20936Number of attributes = 40 (continuous : 7 nominal : 33)Data FormatOne instance per line with comma delimited fields. There are 199523 instances in the data file and 99762 in the test file.The data was split into train/test in approximately 2/3, 1/3 proportions using MineSet's MIndUtil mineset-to-mlc.数据预览:点此下载完整数据集。

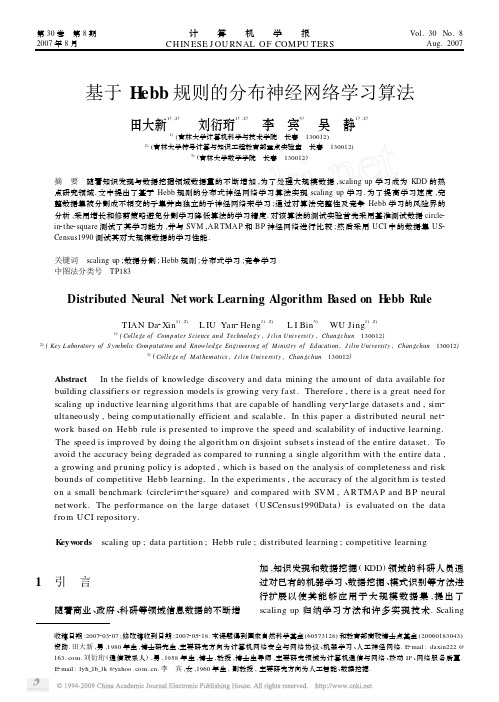

基于Hebb规则的分布神经网络学习算法

机器学习_SECOM Data Set(SECOM公司数据集)

SECOM Data Set(SECOM公司数据集)数据摘要:Data from a semi-conductor manufacturing process. A complex modern semi-conductor manufacturing process is normally under consistent surveillance via the monitoring of signals/variables collected from sensors and or process measurement points. However, not all of these signals are equally valuable in a specific monitoring system. The measured signals contain a combination of useful information, irrelevant information as well as noise. It is often the case that useful information is buried in the latter two. Engineers typically have a much larger number of signals than are actually required. If we consider each type of signal as a feature, then feature selection may be applied to identify the most relevant signals. The Process Engineers may then use these signals to determine key factors contributing to yield excursions downstream in the process. This will enable an increase in process throughput, decreased time to learning and reduce the per unit production costs.中文关键词:semi-conductor,manufacturing process,monitoringsystem,signals,production costs,英文关键词:半导体,制造过程,监控系统,信号,生产成本,数据格式:TEXT数据用途:Classification, Causal-Discovery数据详细介绍:SECOM Data Set Abstract: Data from a semi-conductor manufacturing processSource:Authors: Michael McCann, Adrian JohnstonData Set Information:A complex modern semi-conductor manufacturing process is normally under consistent surveillance via the monitoring of signals/variables collected from sensors and or process measurement points. However, not all of these signals are equally valuable in a specific monitoring system. The measured signals contain a combination of useful information, irrelevant information as well as noise. It is often the case that useful information is buried in the latter two. Engineers typically have a much larger number of signals than are actually required. If we consider each type of signal as a feature, then feature selection may be applied to identify the most relevant signals. The Process Engineers may then use these signals to determine key factors contributing to yield excursions downstream in the process. This will enable an increase in process throughput, decreased time to learning and reduce the per unit production costs.To enhance current business improvement techniques the application of feature selection as an intelligent systems technique is being investigated.The dataset presented in this case represents a selection of such features where each example represents a single production entity with associated measured features and the labels represent a simple pass/fail yield for in house line testing, figure 2, and associated date time stamp. Where ?1 corresponds to a pass and 1 corresponds to a fail and the data time stamp is for that specific test point.Using feature selection techniques it is desired to rank features according to their impact on the overall yield for the product, causal relationships may also be considered with a view to identifying the key features.Results may be submitted in terms of feature relevance for predictability using error rates as our evaluation metrics. It is suggested that cross validation be applied to generate these results. Some baseline results are shown below for basic feature selection techniques using a simple kernel ridge classifier and 10 fold cross validation.Baseline Results: Pre-processing objects were applied to the dataset simply to standardize the data and remove the constant features and then a number of different feature selection objects selecting 40 highest ranked features were applied with a simple classifier to achieve some initial results. 10 fold cross validation was used and the balanced error rate (*BER) generated as our initial performance metric to help investigate this dataset.SECOM Dataset: 1567 examples 591 features, 104 failsFSmethod (40 features) BER % True + % True - %S2N (signal to noise) 34.5 +-2.6 57.8 +-5.3 73.1 +2.1Ttest 33.7 +-2.1 59.6 +-4.7 73.0 +-1.8Relief 40.1 +-2.8 48.3 +-5.9 71.6 +-3.2Pearson 34.1 +-2.0 57.4 +-4.3 74.4 +-4.9Ftest 33.5 +-2.2 59.1 +-4.8 73.8 +-1.8Gram Schmidt 35.6 +-2.4 51.2 +-11.8 77.5 +-2.3Attribute Information:Key facts: Data Structure: The data consists of 2 files the dataset file SECOM consisting of 1567 examples each with 591 features a 1567 x 591 matrix and a labels file containing t he classifications and date time stamp for each example.As with any real life data situations this data contains null values varying in intensity depending on the individuals features. This needs to be taken into consideration when investigating the data either through pre-processing or within the technique applied.The data is represented in a raw text file each line representing an individual example and the features seperated by spaces. The null values are represented by the 'NaN' value as per MatLab.Relevant Papers:N/ACitation Request:Please refer to the Machine Learning Repository's citation policy数据预览:点此下载完整数据集。

机器学习技术中的时序数据分析方法解析

机器学习技术中的时序数据分析方法解析时序数据分析是机器学习领域中的一个重要研究方向,它涉及到对具有时间属性的数据进行建模、预测和分析。

在许多领域中,如金融、天气预测、生物医学等,时序数据分析的应用已经变得非常重要。

本文将介绍机器学习技术中常用的时序数据分析方法,包括时间序列预测、时间序列聚类和异常检测等。

时间序列是一组按时间先后顺序排列的数据点,通常具有趋势、季节性和周期性等特征。

时间序列预测是根据过去的观测值,对未来的数值进行预测。

常用的时间序列预测方法包括自回归移动平均模型(ARIMA)、指数平滑法和循环神经网络(RNN)等。

ARIMA模型基于时间序列的自回归和移动平均性质,能够捕捉到时间序列的趋势和季节性变化。

指数平滑法通过对过去观测值的加权平均来预测未来值,适用于对有趋势但无季节性的时间序列进行预测。

RNN是一种基于神经网络的模型,能够对时序数据进行长期依赖的建模,适用于处理较长时间范围的预测问题。

除了时间序列预测,时间序列聚类也是时序数据分析中常用的方法。

时间序列聚类旨在将相似的时间序列分组或聚类在一起,以便发现数据中的潜在模式或相似性。

常用的时间序列聚类方法包括K均值聚类和基于密度的聚类等。

K均值聚类是一种基于距离度量的聚类方法,通过迭代更新簇的质心来划分数据点。

基于密度的聚类方法将聚类看作是在样本空间中发现高密度区域的过程,能够发现不同形状和密度的簇。

时间序列聚类可以帮助我们发现数据中的潜在模式和异常点,对于相似性分析和异常检测非常有用。

另外,对于时序数据的异常检测也是一个重要的研究方向。

时序数据中的异常点通常指的是与其他数据点相比具有显著不同的观测值。

常用的时序数据异常检测方法包括基于统计的方法、基于机器学习的方法和基于深度学习的方法。

基于统计的方法通过对数据点的统计特性进行分析,识别与其他数据点显著偏离的观测值。

基于机器学习的方法通过训练分类器或回归模型来预测正常数据的范围,将与预测结果有显著偏差的观测值识别为异常点。

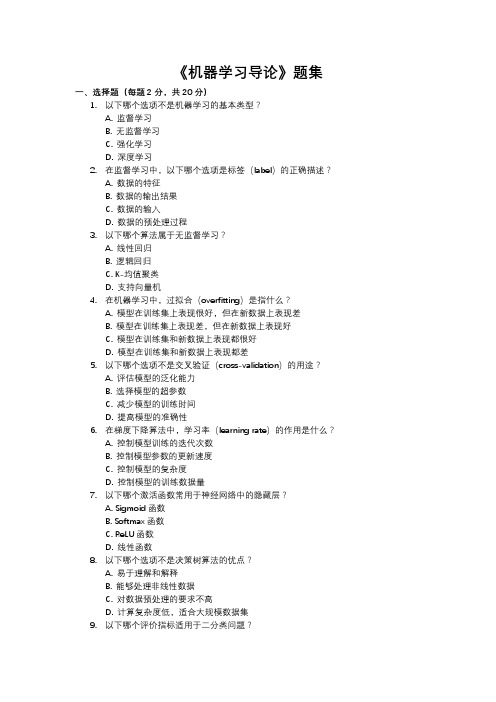

《机器学习导论》题集

《机器学习导论》题集一、选择题(每题2分,共20分)1.以下哪个选项不是机器学习的基本类型?A. 监督学习B. 无监督学习C. 强化学习D. 深度学习2.在监督学习中,以下哪个选项是标签(label)的正确描述?A. 数据的特征B. 数据的输出结果C. 数据的输入D. 数据的预处理过程3.以下哪个算法属于无监督学习?A. 线性回归B. 逻辑回归C. K-均值聚类D. 支持向量机4.在机器学习中,过拟合(overfitting)是指什么?A. 模型在训练集上表现很好,但在新数据上表现差B. 模型在训练集上表现差,但在新数据上表现好C. 模型在训练集和新数据上表现都很好D. 模型在训练集和新数据上表现都差5.以下哪个选项不是交叉验证(cross-validation)的用途?A. 评估模型的泛化能力B. 选择模型的超参数C. 减少模型的训练时间D. 提高模型的准确性6.在梯度下降算法中,学习率(learning rate)的作用是什么?A. 控制模型训练的迭代次数B. 控制模型参数的更新速度C. 控制模型的复杂度D. 控制模型的训练数据量7.以下哪个激活函数常用于神经网络中的隐藏层?A. Sigmoid函数B. Softmax函数C. ReLU函数D. 线性函数8.以下哪个选项不是决策树算法的优点?A. 易于理解和解释B. 能够处理非线性数据C. 对数据预处理的要求不高D. 计算复杂度低,适合大规模数据集9.以下哪个评价指标适用于二分类问题?A. 准确率(Accuracy)B. 召回率(Recall)C. F1分数(F1 Score)D. 以上都是10.以下哪个算法属于集成学习(ensemble learning)?A. 随机森林B. K-近邻算法C. 朴素贝叶斯D. 感知机二、填空题(每空2分,共20分)1.在机器学习中,数据通常被分为训练集、_______和测试集。

2._______是一种常用的数据预处理技术,用于将数值特征缩放到一个指定的范围。

机器学习的基础概念

机器学习的基础概念机器学习(Machine Learning)是一门涉及人工智能和计算机科学的交叉学科,旨在使计算机系统不仅能够执行某些特定任务,还能通过不断学习和优化来提高性能。

机器学习的基础概念对于理解和应用机器学习算法至关重要。

本文将介绍机器学习的基础概念,包括监督学习、无监督学习、强化学习以及常见的机器学习算法和评估方法。

一、监督学习在监督学习中,机器学习算法通过训练样本和对应的标签进行学习,从而预测未知数据的标签。

监督学习可以被分为回归(Regression)和分类(Classification)两种类型。

回归是一种预测连续值的监督学习任务,通过建立输入变量和输出变量之间的数学模型,预测给定输入值的输出值。

常见的回归算法包括线性回归(Linear Regression)、决策树回归(Decision Tree Regression)和支持向量回归(Support Vector Regression)等。

分类是一种预测离散标签的监督学习任务,将输入数据映射到预定义的类别中。

常见的分类算法包括逻辑回归(Logistic Regression)、决策树分类(Decision Tree Classification)和朴素贝叶斯分类(Naive Bayes Classification)等。

二、无监督学习与监督学习不同,无监督学习中的训练样本没有对应的标签。

无监督学习的目标是从数据中发现潜在的结构、模式或者关系。

聚类(Clustering)是无监督学习中常见的任务之一,它通过将数据样本划分为相似的组别来寻找内在的数据结构。

常见的聚类算法包括K均值聚类(K-Means Clustering)和层次聚类(Hierarchical Clustering)等。

降维(Dimensionality Reduction)是另一个无监督学习的任务,它通过减少数据的维度,提取出最相关的特征以便更好地表示数据。

常用的降维算法包括主成分分析(Principal Component Analysis)和因子分析(Factor Analysis)等。

机器学习的基本概念和原理

机器学习的基本概念和原理机器学习是一种人工智能的领域,它研究如何让机器通过经验来学习并提高性能。

与传统的编程方法不同,机器学习依赖于大量的数据和算法,从中提取规律和模式,从而自动进行预测和决策。

机器学习的基本概念包括数据、模型和算法。

数据是机器学习的基础,它可以是结构化数据(如表格数据)或非结构化数据(如文字、图像和音频)。

模型是机器学习对数据的抽象表示,它描述了数据之间的关系和规律。

算法是机器学习的数学和统计方法,用于从数据中构建模型,并根据模型进行预测和决策。

机器学习的原理基于统计学和概率论。

机器学习是一种数据驱动的方法,它通过收集大量的数据来训练模型。

在训练过程中,机器学习算法通过最小化数据之间的误差来调整模型的参数,从而使模型能够更好地适应数据。

这一过程称为模型的学习或训练。

一旦模型被训练好,就可以用来进行预测和决策。

在机器学习中,有监督学习、无监督学习和强化学习这三种主要的学习方式。

有监督学习是通过已有的标记样本来训练模型,以预测新样本的标记;无监督学习是在没有标记样本的情况下,通过发现数据之间的结构和模式来训练模型;强化学习是通过与环境的交互来学习,在每一步的行动中,根据环境的反馈来调整模型的策略,以达到最大化奖励的目标。

在机器学习中,常见的算法包括线性回归、逻辑回归、决策树、支持向量机、神经网络和深度学习等。

线性回归是一种用于建立变量之间线性关系的算法,适用于回归问题;逻辑回归是一种用于建立变量之间逻辑关系的算法,适用于分类问题。

决策树是一种基于树形结构的分类模型,通过一系列的判断节点和叶节点来进行分类。

支持向量机是一种通过寻找最优超平面来进行分类的算法,适用于线性和非线性分类问题。

神经网络和深度学习是一种模仿人脑神经网络结构的算法,通过多层神经元的组合和计算来进行学习和预测。

机器学习的应用广泛,包括自然语言处理、计算机视觉、语音识别、推荐系统、金融风险评估和医学诊断等领域。

例如,在自然语言处理中,机器学习可以用于自动翻译、语义分析和情感分析;在计算机视觉中,机器学习可以用于图像分类、目标检测和人脸识别;在医学诊断中,机器学习可以用于癌症检测、疾病预测和药物发现。

机器学习实例--预测美国人口收入状况

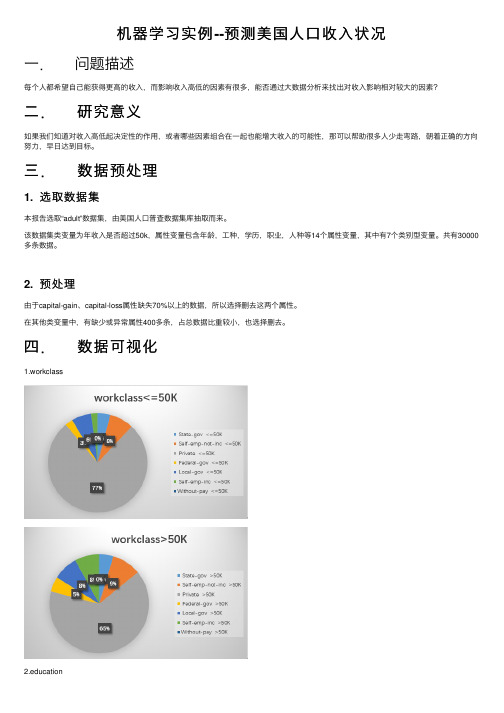

机器学习实例--预测美国⼈⼝收⼊状况⼀.问题描述每个⼈都希望⾃⼰能获得更⾼的收⼊,⽽影响收⼊⾼低的因素有很多,能否通过⼤数据分析来找出对收⼊影响相对较⼤的因素?⼆.研究意义如果我们知道对收⼊⾼低起决定性的作⽤,或者哪些因素组合在⼀起也能增⼤收⼊的可能性,那可以帮助很多⼈少⾛弯路,朝着正确的⽅向努⼒,早⽇达到⽬标。

三.数据预处理1. 选取数据集本报告选取“adult”数据集,由美国⼈⼝普查数据集库抽取⽽来。

该数据集类变量为年收⼊是否超过50k,属性变量包含年龄,⼯种,学历,职业,⼈种等14个属性变量,其中有7个类别型变量。

共有30000多条数据。

2. 预处理由于capital-gain、capital-loss属性缺失70%以上的数据,所以选择删去这两个属性。

在其他类变量中,有缺少或异常属性400多条,占总数据⽐重较⼩,也选择删去。

四.数据可视化1.workclasscation3.race4.sex5.marital-status五.算法选取与实现本次报告中选⽤决策树算法。

决策树是⼀种依托决策⽽建⽴起来的⼀种树。

在机器学习中,决策树是⼀种预测模型,代表的是⼀种对象属性与对象值之间的⼀种映射关系,每⼀个节点代表某个对象,树中的每⼀个分叉路径代表某个可能的属性值,⽽每⼀个叶⼦节点则对应从根节点到该叶⼦节点所经历的路径所表⽰的对象的值。

决策树仅有单⼀输出,如果有多个输出,可以分别建⽴独⽴的决策树以处理不同的输出。

由于数据量过⼤,普通决策树不能达到预期效果,所以再⽤预剪枝进⾏处理。

预剪枝是在决策树⽣成过程中,在划分节点时,若该节点的划分没有提⾼其在训练集上的准确率,则不进⾏划分。

下⾯是预剪枝决策树程序1. 计算数据集的基尼系数def calcGini(dataSet):numEntries=len(dataSet)labelCounts={}#给所有可能分类创建字典for featVec in dataSet:currentLabel=featVec[-1]if currentLabel not in labelCounts.keys():labelCounts[currentLabel]=0labelCounts[currentLabel]+=1Gini=1.0#以2为底数计算⾹农熵for key in labelCounts:prob = float(labelCounts[key])/numEntriesGini-=prob*probreturn Gini2. 对离散变量划分数据集,取出该特征取值为value的所有样本def splitDataSet(dataSet,axis,value):retDataSet=[]for featVec in dataSet:if featVec[axis]==value:reducedFeatVec=featVec[:axis]reducedFeatVec.extend(featVec[axis+1:])retDataSet.append(reducedFeatVec)return retDataSet3. 对连续变量划分数据集,direction规定划分的⽅向,决定是划分出⼩于value的数据样本还是⼤于value的数据样本集def splitContinuousDataSet(dataSet,axis,value,direction):retDataSet=[]for featVec in dataSet:if direction==0:if featVec[axis]>value:reducedFeatVec=featVec[:axis]reducedFeatVec.extend(featVec[axis+1:])retDataSet.append(reducedFeatVec)else:if featVec[axis]<=value:reducedFeatVec=featVec[:axis]reducedFeatVec.extend(featVec[axis+1:])retDataSet.append(reducedFeatVec)return retDataSet4. 选择最好的数据集划分⽅式def chooseBestFeatureToSplit(dataSet,labels):numFeatures=len(dataSet[0])-1bestGiniIndex=100000.0bestFeature=-1bestSplitDict={}for i in range(numFeatures):featList=[example[i] for example in dataSet]#对连续型特征进⾏处理if type(featList[0]).__name__=='float'or type(featList[0]).__name__=='int':#产⽣n-1个候选划分点sortfeatList=sorted(featList)splitList=[]for j in range(len(sortfeatList)-1):splitList.append((sortfeatList[j]+sortfeatList[j+1])/2.0)bestSplitGini=10000slen=len(splitList)#求⽤第j个候选划分点划分时,得到的信息熵,并记录最佳划分点for j in range(slen):value=splitList[j]newGiniIndex=0.0subDataSet0=splitContinuousDataSet(dataSet,i,value,0)subDataSet1=splitContinuousDataSet(dataSet,i,value,1)prob0=len(subDataSet0)/float(len(dataSet))newGiniIndex+=prob0*calcGini(subDataSet0)prob1=len(subDataSet1)/float(len(dataSet))newGiniIndex+=prob1*calcGini(subDataSet1)if newGiniIndex<bestSplitGini:bestSplitGini=newGiniIndexbestSplit=j#⽤字典记录当前特征的最佳划分点bestSplitDict[labels[i]]=splitList[bestSplit]GiniIndex=bestSplitGini#对离散型特征进⾏处理else:uniqueVals=set(featList)newGiniIndex=0.0#计算该特征下每种划分的信息熵for value in uniqueVals:subDataSet=splitDataSet(dataSet,i,value)prob=len(subDataSet)/float(len(dataSet))newGiniIndex+=prob*calcGini(subDataSet)GiniIndex=newGiniIndexif GiniIndex<bestGiniIndex:bestGiniIndex=GiniIndexbestFeature=i#若当前节点的最佳划分特征为连续特征,则将其以之前记录的划分点为界进⾏⼆值化处理#即是否⼩于等于bestSplitValue#并将特征名改为 name<=value的格式if type(dataSet[0][bestFeature]).__name__=='float'or type(dataSet[0][bestFeature]).__name__=='int':bestSplitValue=bestSplitDict[labels[bestFeature]]labels[bestFeature]=labels[bestFeature]+'<='+str(bestSplitValue)for i in range(shape(dataSet)[0]):if dataSet[i][bestFeature]<=bestSplitValue:dataSet[i][bestFeature]=1else:dataSet[i][bestFeature]=0return bestFeature5. 特征若已经划分完,节点下的样本还没有统⼀取值,则需要进⾏投票def majorityCnt(classList):classCount={}for vote in classList:if vote not in classCount.keys():classCount[vote]=0classCount[vote]+=1return max(classCount)6.由于在Tree中,连续值特征的名称以及改为了 feature<=value的形式,因此对于这类特征,需要利⽤正则表达式进⾏分割,获得特征名以及分割阈值def classify(inputTree,featLabels,testVec):firstStr=list(inputTree.keys())[0]if'<='in firstStr:featvalue=float(pile("(<=.+)").search(firstStr).group()[2:])featkey=pile("(.+<=)").search(firstStr).group()[:-2]secondDict=inputTree[firstStr]featIndex=featLabels.index(featkey)if testVec[featIndex]<=featvalue:judge=1else:judge=0for key in secondDict.keys():if judge==int(key):if type(secondDict[key]).__name__=='dict':classLabel=classify(secondDict[key],featLabels,testVec)else:classLabel=secondDict[key]else:secondDict=inputTree[firstStr]featIndex=featLabels.index(firstStr)for key in secondDict.keys():if testVec[featIndex]==key:if type(secondDict[key]).__name__=='dict':classLabel=classify(secondDict[key],featLabels,testVec)else:classLabel=secondDict[key]return classLabeldef testing(myTree,data_test,labels):error=0.0for i in range(len(data_test)):if classify(myTree,labels,data_test[i])!=data_test[i][-1]:error+=1print ('myTree %d' %error)return float(error)def testingMajor(major,data_test):error=0.0for i in range(len(data_test)):if major!=data_test[i][-1]:error+=1print ('major %d' %error)return float(error)7.主程序,递归产⽣决策树def createTree(dataSet,labels,data_full,labels_full,data_test):classList=[example[-1] for example in dataSet]if classList.count(classList[0])==len(classList):return classList[0]if len(dataSet[0])==1:return majorityCnt(classList)temp_labels=copy.deepcopy(labels)bestFeat=chooseBestFeatureToSplit(dataSet,labels)bestFeatLabel=labels[bestFeat]myTree={bestFeatLabel:{}}if type(dataSet[0][bestFeat]).__name__=='str':currentlabel=labels_full.index(labels[bestFeat])featValuesFull=[example[currentlabel] for example in data_full]uniqueValsFull=set(featValuesFull)featValues=[example[bestFeat] for example in dataSet]uniqueVals=set(featValues)del(labels[bestFeat])#针对bestFeat的每个取值,划分出⼀个⼦树。

机器学习(深度学习)编年史

机器学习编年史一、引言机器学习(Machine Learning,ML)可以认为是:通过数据,算法使得机器从大量历史数据中学习规律,从而对新样本做分类或者预测。

它是人工智能(Artificial Intelligence,AI)的核心,是使计算机具有智能的根本途径,其应用遍及人工智能的各个领域,主要使用归纳、综合的方法获取或总结知识。

作为一门交叉领域学科,它涉及到概率论,统计学,凸分析,最优化,计算机等多个学科。

专门研究计算机怎样模拟或实现人类的学习行为,从而获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能。

本文将以时间为顺序,从两个大阶段介绍机器学习,第一部分介绍浅层学习阶段,第二部分介绍深层学习阶段,就是所谓的深度学习。

二、浅层学习阶段1.Arthur Samuel1959年,IBM Arthur Samuel的写出了可以学习的西洋棋程序,并发表了一篇名为《Some Studies in Machine Learning Using the Game of Checkers》的论文中,定义并解释了一个新词—机器学习(Machine Learning,ML)。

将机器学习非正式定义为”在不直接针对问题进行编程的情况下,赋予计算机学习能力的一个研究领域”。

图1 Arthur Samuel的西洋棋1957年,Rosenblatt发明了感知机(或称感知器,Perceptron)[1],是神经网络的雏形,同时也是支持向量机的基础,在当时引起了不小的轰动。

感知机是二类分类的线性分类模型,其输入为实例的特征向量,输出为实例的类别,取+1和-1二值。

感知机对应于输入空间(特征空间)中将实例划分为正负两类的分离超平面,属于判别模型。

感知机学习旨在求出将训练数据进行线性划分的分离超平面。

图感知机算法其实设计感知器的初衷是制造一个识别用的机器,而不是一个算法。

虽然它的第一次实现是在IBM704上安装的软件中,但它随后在定制的硬件实现“Mark1感知器”。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

US Census Data (1990) Data Set(美国人口普查数据(1990)数据集)数据摘要:The US Census1990raw data set contains a one percent sample of the Public Use Microdata Samples (PUMS) person records drawn from the full 1990 census sample.中文关键词:多变量,聚类,UCI,人口普查,美国,英文关键词:Multivariate,Clustering,UCI,Census,US,数据格式:TEXT数据用途:This data set is used for clustering数据详细介绍:US Census Data (1990) Data SetAbstract: The USCensus1990raw data set contains a one percent sample of the Public Use Microdata Samples (PUMS) person records drawn from the full 1990 census sample.Source:The USCensus1990raw data set was obtained from the (U.S. Department of Commerce) Census Bureau website using the Data Extraction System. This system can be found at /DES/www/des.html.Donors:Chris Meek, Microsoft, meek '@' Bo Thiesson, Microsoft, thiesson '@' David Heckerman, Microsoft, heckerma '@' Data Set Information:The data was collected as part of the 1990 census.There are 68 categorical attributes. This data set was derived from the USCensus1990raw data set. The attributes are listed in the file USCensus1990.attributes.txt (repeated below) and the coding for the values is described below. Many of the less useful attributes in the original data set have been dropped, the few continuous variables have been discretized and the few discrete variables that have a large number of possible values have been collapsed to have fewer possible values.More specifically the USCensus1990 data set was obtained from the USCensus1990raw data set by the following sequence of operations;- Randomization: The order of the cases in the original USCensus1990raw data set were randomly permuted.- Selection of attributes: The 68 attributes included in the data set are given below. In the USCensus1990 data set we have added a single letter prefix to the original name. We add the letter 'i' to indicate that the original attribute values are used and 'd' to indicate that originalattribute values for each case have been mapped to new values (the precise mapping is described below).Hierarchies of values are provided in the file USCensus1990raw.coding.htm and the mapping functions used to transform the USCensus1990raw to the USCensus1990 data sets are giving in the file USCensus1990.mapping.sql.The data is contained in a file called USCensus1990.data.txt. The first row contains the list of attributes. The first attribute is a caseid and should be ignored during analysis. The data is comma delimited with one case per row.Attribute Information:--------------------------------------------------------------Old Variable New Variable--------------------------------------------------------------Age dAgeAncstry1 dAncstry1Ancstry2 dAncstry2Avail iAvailCitizen iCitizenClass iClassDepart dDepartDisabl1 iDisabl1Disabl2 iDisabl2English iEnglishFeb55 iFeb55Fertil iFertilHispanic dHispanicHour89 dHour89Hours dHoursImmigr iImmigrIncome1 dIncome1Income2 dIncome2Income3 dIncome3Income4 dIncome4Income5 dIncome5Income6 dIncome6Income7 dIncome7Income8 dIncome8Industry dIndustryKorean iKoreanLang1 iLang1Looking iLookingMarital iMaritalMay75880 iMay75880Means iMeansMilitary iMilitaryMobility iMobilityMobillim iMobillimOccup dOccupOthrserv iOthrservPerscare iPerscarePOB dPOBPoverty dPovertyPwgt1 dPwgt1Ragechld iRagechldRearning dRearningRelat1 iRelat1Relat2 iRelat2Remplpar iRemplparRiders iRidersRlabor iRlaborRownchld iRownchldRpincome dRpincomeRPOB iRPOBRrelchld iRrelchldRspouse iRspouseRvetserv iRvetservSchool iSchoolSept80 iSept80Sex iSexSubfam1 iSubfam1Subfam2 iSubfam2Tmpabsnt iTmpabsntTravtime dTravtimeVietnam iVietnamWeek89 dWeek89Work89 iWork89Worklwk iWorklwkWWII iWWIIYearsch iYearschYearwrk iYearwrkYrsserv dYrsservMapping: In this step we map all of the old values for variables with prefix 'd' to new values. The mappings for the variables dAncstry1, dAncstry2, dHispanic, dIndustry, dOccup, dPOBwere designed to correspond to a natural coarsening of the original values based on the information in the file coding.htm. The remaining variables are continuous valued variables and the mapping for these variables was chosen to make variables that were fairly uniformly distributed across the states (quantiles). The precise mappings are specified in the file USCensus1990.mapping.sql. This file contains all of T-SQL procedures used to map the variables. These procedures can be used directly in SQLServer to map the original values or translated to some other language.--------------------------------------------------------------Variable Procedure--------------------------------------------------------------dAge discAgedAncstry1 discAncstry1dAncstry2 discAncstry2dHispanic discHispanicdHour89 discHour89dHours discHoursdIncome1 discIncome1dIncome2 discIncome2to8dIncome3 discIncome2to8dIncome4 discIncome2to8dIncome5 discIncome2to8dIncome6 discIncome2to8dIncome7 discIncome2to8dIncome8 discIncome2to8dIndustry discIndustrydOccup discOccupdPOB discPOBdPoverty discPovertydPwgt1 discPwgt1dRearning discRearningdRpincome discRpincomedTravtime discTravtimedWeek89 discWeek89dYrsserv discYrsservRelevant Papers:Meek, Thiesson, and Heckerman (2001), "The Learning Curve Method Applied to Clustering", to appear in The Journal of Machine Learning Research.[Web Link]数据预览:点此下载完整数据集。