python设置代理ip的方法

代理ip使用方法

代理ip使用方法

代理IP是一种可以帮助用户隐藏真实IP地址的工具,可以在网络上保护用户的隐私和安全。

以下是代理IP的使用方法:

1.选择一个可靠的代理服务提供商。

有许多公司提供代理服务,但不是所有提供商都是可靠的。

建议选择一家信誉良好的公司,如Luminati、Proxyrack、Smartproxy等。

2.购买代理服务。

购买代理服务需要付费,每个提供商的费用不同。

用户需要选择适合自己需要的套餐,例如流量、IP数量、地理位置等。

3.设置代理服务器。

在使用代理IP之前,需要设置代理服务器。

用户可以使用浏览器插件或在设置中手动设置代理服务器。

具体设置请参考代理服务提供商的说明。

4.测试代理连接。

测试代理连接可以验证代理IP是否正常工作。

用户可以在浏览器中打开代理测试网站,如WhatIsMyIP、

IP2Location等。

5.使用代理IP。

使用代理IP可以隐藏真实IP地址,为用户提供更安全、私密的上网环境。

用户可以在浏览器中打开需要访问的网站,代理服务器会将用户的请求发送到目标网站,并将目标网站的内容返回给用户。

总之,代理IP可以为用户提供更可靠的上网安全保障,但使用代理IP也需要注意相关法律法规。

用户应该选择合法的代理服务提供商,不要用于非法用途。

python爬虫proxy代理的使用方法

python爬虫proxy代理的使用方法Python爬虫:Proxy代理的使用方法Introduction(引言)在进行网络爬虫开发时,常常会遇到一些访问限制,比如IP封禁,频率限制等。

为了绕过这些限制,我们需要使用代理服务器(Proxy Server)来隐藏我们的真实IP地址,从而实现匿名访问和规避限制。

在本文中,我们将介绍如何使用Python爬虫来使用Proxy代理。

1. 什么是Proxy代理?Proxy代理服务器是一种充当客户端与目标服务器之间的中间服务器,将客户端的请求转发给目标服务器,并将响应返回给客户端。

通过使用代理服务器,我们可以间接访问目标服务器,隐藏我们的真实IP地址,并绕过一些访问限制。

2. Proxy代理的类型Proxy代理可以分为以下几种类型:- HTTP Proxy:代理服务器接收HTTP请求,并转发给目标服务器。

- HTTPS Proxy:代理服务器接收HTTPS请求,并转发给目标服务器。

- SOCKS Proxy:一种网络传输协议,它可以将TCP/IP数据包转发到任何位置,并且不承认任何与协议无关的内容。

在爬虫开发中,我们常常会使用HTTP Proxy来实现代理功能。

3. 获取Proxy代理在使用Proxy代理之前,我们需要获取可用的代理服务器地址。

有很多在线提供免费代理服务器地址的网站,比如"下面是一个简单的示例,展示如何从"pythonimport requestsfrom bs4 import BeautifulSoupdef get_proxies():url = "response = requests.get(url)soup = BeautifulSoup(response.text, "html.parser")table = soup.find("table", attrs={"id": "proxylisttable"})rows = table.tbody.find_all("tr")proxies = []for row in rows:columns = row.find_all("td")ip = columns[0].textport = columns[1].textproxy = f"{ip}:{port}"proxies.append(proxy)return proxies4. 使用Proxy代理进行爬虫获取到可用的代理服务器地址后,我们可以使用Python的requests库来实现Proxy代理功能。

使用代理IP和随机请求头

使⽤代理IP和随机请求头#为什么要设置代理IP和随机请求头?#爬⾍默认的User-Agent(python-urllib/python版本)#1.服务器会判断⼀个频繁的请求是不是来⾃于同⼀个User-Agent标识,或者判断User-Agent是不是以python开头。

如果是,则会限制访问。

#解决⽅案:随机切换User-Agent的值#2.服务器会判断⼀个频繁的请求是不是来⾃于同⼀个IP地址发出的,如果是,则会对IP进⾏限制访问。

#解决⽅案:使⽤代理IP,随机切换IP地址,不使⽤真实的IP来发起请求。

1.设置随机请求头# #定义⼀个要访问的⽹址:url='/get'# #设置⼀个浏览器标识的列表user_agent_list=['Mozilla/5.0(Windows;U;WindowsNT6.1;en-us)AppleWebKit/534.50(KHTML,likeGecko)Version/5.1Safari/534.50','Mozilla/5.0(Macintosh;IntelMacOSX10.6;rv:2.0.1)Gecko/20100101Firefox/4.0.1','Mozilla/5.0(Macintosh;IntelMacOSX #设置⼀个请求头headers={'User-Agent':random.choice(user_agent_list)}request=urllib.request.Request(url,headers=headers,method='GET')response=urllib.request.urlopen(request).read().decode('utf-8')print(response)2.动态的添加请求头import urllib.requestimport randomresult=urllib.request.Request(url,method='GET')result.add_header('User-Agent','Mozilla/5.0(Windows;U;WindowsNT6.1;en-us)AppleWebKit/534.50(KHTML,likeGecko)Version/5.1Safari/534.50')response=urllib.request.urlopen(result)print(response.read().decode('utf-8'))3.设置代理随机IPimport urllib.requestimport randomfrom urllib.request import ProxyHandler,build_opener#设置⼀个代理IP列表ip_list=[{'http':'http://61.135.217.7:80'},{'https':'https://111.231.223.236:808'},{'http':'http://111.155.116.236:8123'}]#创建⼀个IP代理对象proxy_handler=ProxyHandler(random.choice(ip_list))#根据IP代理对象,创建⽤于发送请求的opener对象opener=build_opener(proxy_handler)opener.addheaders=[('User-Agent','Mozilla/5.0(Windows;U;WindowsNT6.1;en-us)AppleWebKit/534.50(KHTML,likeGecko)Version/5.1Safari/534.50')]#再使⽤opener这个对象发起请求response=opener.open('/get')print(response.read().decode('utf-8'))4.代理IP+随机请求头import urllib.requestimport randomfrom urllib.request import ProxyHandler,build_opener# url='/get'# #设置⼀个浏览器标识的列表user_agent_list=['Mozilla/5.0(Windows;U;WindowsNT6.1;en-us)AppleWebKit/534.50(KHTML,likeGecko)Version/5.1Safari/534.50','Mozilla/5.0(Macintosh;IntelMacOSX10.6;rv:2.0.1)Gecko/20100101Firefox/4.0.1','Mozilla/5.0(Macintosh;IntelMacOSX ip_list=[{'http':'http://61.135.217.7:80'},{'https':'https://111.231.223.236:808'},{'http':'http://111.155.116.236:8123'}]#设置⼀个请求头headers={'User-Agent':random.choice(user_agent_list)}request=urllib.request.Request(url,headers=headers,method='GET')#创建⼀个IP代理对象proxy_handler=ProxyHandler(random.choice(ip_list))#根据IP代理对象,创建⽤于发送请求的opener对象opener=build_opener(proxy_handler)#使⽤install_opener⽅法之后,会将程序中默认的urlopen⽅法替换掉,也就是说使⽤install_opener之后,在该⽂件中,再次调⽤urlopern会使⽤以及创建好的operner对象。

python3.4 使用代理访问网页内容的python脚本

1. python3.4 Manuals中, 使用代理访问网页内容的脚本

python3.4 Manuals中, 使用代理访问网页内容的脚本例子如下:

##== python3.4 Manuals中,使用代理访问网页内容的脚本例子 ===

f = opener.open('/')

a = f.read()

print(a)

在我的网络环境中 我把它换成下面的形式才能正常工作:

proxy_handler = urllib.request.ProxyHandler({'http':'user:passwd@proxyServer:port'}),

即 proxy_handler = urllib.request.ProxyHandler({'http':'user:passwd@:3128'})

proxy_handler = proxy_handler = urllib.request.ProxyHandler({'http':'user:passwd@:3128'})

opener = urllib.request.build_opener(proxy_handler)

proxy_handler = urllib.request.ProxyHandler({'http': ':3128/'})

st.ProxyBasicAuthHandler()

proxy_auth_handler.add_password('realm', '', 'user', 'passwd')

动态代理ip实现方法

动态代理IP实现方法在互联网的许多应用中,代理IP发挥着重要的作用,尤其是在网络爬虫、数据抓取、网络测试等场景中。

动态代理IP则更具有灵活性和可配置性,可以根据实际需求自动切换代理IP,以实现更高效的爬取或测试。

下面我们来探讨动态代理IP的实现方法。

1. HTTP代理实现HTTP代理是使用最广泛的代理协议之一,可以通过设置HTTP 请求头部的Proxy-Connection属性和Remote-Host属来实现代理。

在Java中,可以使用Apache HttpClient或者OkHttp等库来使用HTTP 代理。

在Python中,可以使用requests库来使用HTTP代理。

2. SOCKS代理实现SOCKS代理是一种更为通用的代理协议,支持多种网络协议,包括TCP、UDP等。

相比于HTTP代理,SOCKS代理更加灵活,可以根据实际需求选择不同的代理协议。

在Java中,可以使用JSch库来实现SOCKS代理。

在Python中,可以使用socks库来实现SOCKS 代理。

3. API接口调用许多代理服务商都提供了API接口,用户可以通过调用这些接口来获取代理IP,并进行自动切换。

这种方法一般需要注册账户,获取API Key,并在编程时调用相应的API来获取代理IP。

常见的代理服务商有:阿里云、腾讯云、网易等。

4. 动态代理IP软件自动切换当爬虫程序或其他需要使用代理IP的程序运行时,可以根据实际需求自动切换代理IP。

这种方法一般需要先获取可用的代理IP列表,并在程序中实现切换逻辑。

常见的实现方式是使用多线程或异步任务来切换代理IP,以保证程序的正常运行。

5. 浏览器设置动态代理IP除了在程序中实现动态代理IP切换外,还可以在浏览器中设置动态代理IP。

这种方法一般需要先获取可用的代理IP列表,并在浏览器中设置相应的代理地址。

这种方法适用于需要使用浏览器进行网络访问的场景,如网页爬取、网络测试等。

以上是动态代理IP实现方法的简要介绍,根据实际需求选择合适的方法来实现动态代理IP的使用。

代理IP如何使用代理IP的三种使用方法

代理IP如何使用代理IP的三种使用方法代理IP是一种网络技术,通过使用代理服务器来进行网络访问,隐藏真实的访问者IP地址。

代理IP使用起来可以带来很多好处,比如绕过地区限制、提升访问速度、保护个人隐私等。

下面将介绍代理IP的三种使用方法。

1.手动配置代理IP手动配置代理IP是最基本的使用方法,可以在浏览器或操作系统的设置中手动输入代理服务器的IP地址和端口号。

具体步骤如下:1.打开浏览器的设置或选项菜单,找到代理设置选项。

2.手动输入代理服务器的IP地址和端口号。

代理IP通常由代理服务提供商提供。

3.保存设置并重新启动浏览器。

从此以后,所有的网络请求都将通过代理服务器进行。

手动配置代理IP适合一些临时的、个别的需求,比如只需要访问一些特定的网站或绕过一些特定地区的限制。

但是,手动配置代理IP的方式操作比较繁琐,适用性相对较低。

2.使用代理IP软件为了避免手动配置代理IP的麻烦,可以使用代理IP软件来自动切换代理IP。

代理IP软件有很多种,如Lantern、Shadowsocks等。

使用代理IP软件的步骤如下:2.打开代理IP软件,选择需要的代理服务器。

代理IP软件通常会提供多个代理服务器,可以根据自己的需求选择。

3.保存设置并启动代理IP软件。

从此以后,所有的网络请求都将通过代理服务器进行。

使用代理IP软件的好处是可以自动切换代理服务器,避免了手动配置的麻烦。

同时,一些代理IP软件还提供了加密功能,可以进一步保护个人隐私和数据安全。

但是,代理IP软件通常需要用户付费或限制使用时间,且稳定性和速度也有一定的影响。

3.代理IP池代理IP池是一种更高级的代理IP使用方法,可以实现动态的、自动切换的代理IP。

代理IP池由一些代理IP提供商提供,用户可以通过API 接口来获取和使用代理IP。

1.注册并登录代理IP提供商的网站,获取API接口的密钥和使用方法。

2.调用API接口获取代理IP列表。

代理IP提供商通常会提供多个代理服务器,可以根据自己的需求选择。

socks5代理写法

socks5代理写法以下是基于Python的Socks5代理服务器的简单实现:```pythonimport socketimport structdef add_socks5_request(data):添加socks5请求头data = b"\x05\x00" + datareturn datadef parse_socks5_response(data):解析socks5响应头version, method = (">BB", data[:2])if version != 5:return Noneelif method != 0:return Noneelse:return data[2:]def handle_socks5_request(data):处理socks5请求version, nmethods = (">BB", data[:2])methods = data[2:2+nmethods]chosen_method = Nonefor method in methods:if method == 0: no authchosen_method = methodbreakelif method == 2: username/password authchosen_method = methodbreakif chosen_method is None:return b"\x05\x07\x00\x01" no acceptable methodselif chosen_method == 0: no authreturn b"\x05\x00" no authentication requiredelif chosen_method == 2: username/password authusername_length = data[2+nmethods]username = data[3+nmethods:3+nmethods+username_length]password_length = data[3+nmethods+username_length] password = data[4+nmethods+username_length:]TODO: implement username/password authentication logic hereif username == b"admin" and password == b"password": return b"\x05\x00" authentication successfulelse:return b"\x05\x01\x00" authentication failedelse: unknown methodreturn b"\x05\x07\x00\x01" no acceptable methodsdef main():server = (_INET, _STREAM)(('', 1080))(1)print("Socks5 proxy server is running on :1080")while True:client, addr = ()print("Accepted connection from", addr)data = (4096)if len(data) == 0: connection closed by client()continueif data[:2] == b"\x05\x00": no auth required request(b"\x05\x00") no auth required responsewhile True: handle request data stream until client closes connection or EOF is reacheddata = (4096)if len(data) == 0: connection closed by client or EOF reachedbreak(data) forward received data to client's destination server elif data[:2] == b"\x05\x01": username/password auth request (handle_socks5_request(data)) handle authentication request and send response back to clientwhile True: handle request data stream until client closes connection or EOF is reached or authentication fails or EOF is reached or EOF is reached (reconnect and try to authenticate again) or client cancels authentication or any other conditions for authentication failure that need to be implemented inhandle_socks5_request() function (, username/password timeout, invalid username/password, etc.) (see for more details)(authentication failure conditions are not implemented in this example) (EOF is not reached) (client cancels authentication) (authentication fails) (EOF is reached) (EOF is reached) (reconnect and try to authenticate again) (client closes connection) (EOF is reached) (break) (client closes connection) (break) (break) (break) (break) (break) (break) (break) (break) (break) (break) (break) (break) (break)。

python批量生成本地ip地址的方法

python批量生成本地ip地址的方法批量生成本地IP地址的方法可以通过遍历IP地址段来实现。

下面是一种方法:Step 1: 导入必要的模块首先,我们需要导入`ipaddress`模块来处理IP地址。

```pythonimport ipaddress```Step 2: 定义IP地址段接下来,我们需要定义一个IP地址段,例如`192.168.0.0/24`。

这个地址段表示了从`192.168.0.1`到`192.168.0.254`的一系列IP 地址。

```pythonip_network = ipaddress.IPv4Network('192.168.0.0/24')```Step 3: 遍历IP地址段接下来,我们可以使用`ip_network`对象的`hosts(`方法来遍历整个IP地址段,并生成每个IP地址。

这个方法返回一个迭代器,我们可以使用`for`循环来遍历生成的IP 地址。

```pythonfor ip_address in ip_network.hosts(:print(ip_address)```Step 4: 生成IP地址文件将生成的IP地址保存到一个文件中,我们可以在每次遍历时将IP地址写入文件。

首先,我们需要定义输出文件的名称和路径。

```pythonoutput_file = 'ip_addresses.txt'```然后,在遍历IP地址时,使用`with open(`语句打开文件,并将生成的IP地址写入文件。

```pythonwith open(output_file, 'w') as file:for ip_address in ip_network.hosts(:file.write(str(ip_address)+'\n')```这样,当遍历完成时,会生成一个名为 `ip_addresses.txt` 的文件,包含了整个IP地址段中生成的所有IP地址。

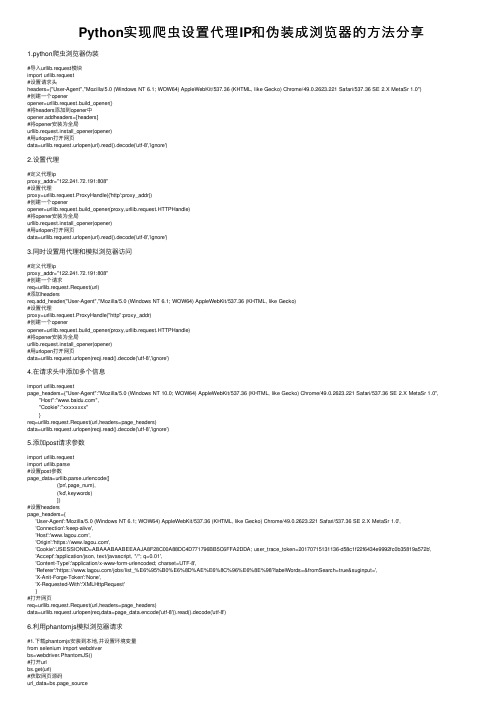

Python实现爬虫设置代理IP和伪装成浏览器的方法分享

Python实现爬⾍设置代理IP和伪装成浏览器的⽅法分享1.python爬⾍浏览器伪装#导⼊urllib.request模块import urllib.request#设置请求头headers=("User-Agent","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0")#创建⼀个openeropener=urllib.request.build_opener()#将headers添加到opener中opener.addheaders=[headers]#将opener安装为全局urllib.request.install_opener(opener)#⽤urlopen打开⽹页data=urllib.request.urlopen(url).read().decode('utf-8','ignore')2.设置代理#定义代理ipproxy_addr="122.241.72.191:808"#设置代理proxy=urllib.request.ProxyHandle({'http':proxy_addr})#创建⼀个openeropener=urllib.request.build_opener(proxy,urllib.request.HTTPHandle)#将opener安装为全局urllib.request.install_opener(opener)#⽤urlopen打开⽹页data=urllib.request.urlopen(url).read().decode('utf-8','ignore')3.同时设置⽤代理和模拟浏览器访问#定义代理ipproxy_addr="122.241.72.191:808"#创建⼀个请求req=urllib.request.Request(url)#添加headersreq.add_header("User-Agent","Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko)#设置代理proxy=urllib.request.ProxyHandle("http":proxy_addr)#创建⼀个openeropener=urllib.request.build_opener(proxy,urllib.request.HTTPHandle)#将opener安装为全局urllib.request.install_opener(opener)#⽤urlopen打开⽹页data=urllib.request.urlopen(req).read().decode('utf-8','ignore')4.在请求头中添加多个信息import urllib.requestpage_headers={"User-Agent":"Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0", "Host":"","Cookie":"xxxxxxxx"}req=urllib.request.Request(url,headers=page_headers)data=urllib.request.urlopen(req).read().decode('utf-8','ignore')5.添加post请求参数import urllib.requestimport urllib.parse#设置post参数page_data=urllib.parse.urlencode([('pn',page_num),('kd',keywords)])#设置headerspage_headers={'User-Agent':'Mozilla/5.0 (Windows NT 6.1; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0','Connection':'keep-alive','Host':'','Origin':'https://','Cookie':'JSESSIONID=ABAAABAABEEAAJA8F28C00A88DC4D771796BB5C6FFA2DDA; user_trace_token=20170715131136-d58c1f22f6434e9992fc0b35819a572b', 'Accept':'application/json, text/javascript, */*; q=0.01','Content-Type':'application/x-www-form-urlencoded; charset=UTF-8','Referer':'https:///jobs/list_%E6%95%B0%E6%8D%AE%E6%8C%96%E6%8E%98?labelWords=&fromSearch=true&suginput=','X-Anit-Forge-Token':'None','X-Requested-With':'XMLHttpRequest'}#打开⽹页req=urllib.request.Request(url,headers=page_headers)data=urllib.request.urlopen(req,data=page_data.encode('utf-8')).read().decode('utf-8')6.利⽤phantomjs模拟浏览器请求#1.下载phantomjs安装到本地,并设置环境变量from selenium import webdriverbs=webdriver.PhantomJS()#打开urlbs.get(url)#获取⽹页源码url_data=bs.page_source#将浏览到的⽹页保存为图⽚bs.get_screenshot_as_file(filename)7.phantomjs设置user-agent和cookiefrom selenium import webdriverfrom mon.desired_capabilities import DesiredCapabilitiesdcap = dict(DesiredCapabilities.PHANTOMJS)dcap["erAgent"] = ("Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/49.0.2623.221 Safari/537.36 SE 2.X MetaSr 1.0") bs = webdriver.PhantomJS(desired_capabilities=dcap)bs.get(url)#删除cookiebs.delete_all_cookies()#设置cookie#cookie格式:在浏览器cookie中查看,⼀个cookie需要包含以下参数,domain、name、value、pathcookie={'domain':'', #注意前⾯有.'name':'xxxx','value':'xxxx','path':'xxxx'}#向phantomjs中添加cookiebs.add_cookie(cookie)8.利⽤web_driver⼯具#1.下载web_driver⼯具(如chromdriver.exe)及对应的浏览器#2.将chromdriver.exe放到某个⽬录,如c:\chromdriver.exefrom selenium import webdriverdriver=webdriver.Chrome(executable_path="C:\chromdriver.exe")#打开urldriver.get(url)以上这篇Python实现爬⾍设置代理IP和伪装成浏览器的⽅法分享就是⼩编分享给⼤家的全部内容了,希望能给⼤家⼀个参考,也希望⼤家多多⽀持。

Python异步爬虫requests和aiohttp中代理IP的使用

Python异步爬⾍requests和aiohttp中代理IP的使⽤爬⾍要想爬的好,IP代理少不了。

现在⽹站基本都有些反爬措施,访问速度稍微快点,就会发现IP被封,不然就是提交验证。

下⾯就两种常⽤的模块来讲⼀下代理IP的使⽤⽅式。

话不多说,直接开始。

requests中代理IP的使⽤:requests中使⽤代理IP只需要添加⼀个proxies参数即可。

proxies的参数值是⼀个字典,key是代理协议(http/https),value就是ip和端⼝号,具体格式如下。

try:response = requests.get('https:///ip', headers=headers,proxies={'https':'https://221.122.91.74:9401'}, timeout=6)print('success')# 检测代理IP是否使⽤成功# 第⼀种⽅式,返回发送请求的IP地址,使⽤时要在 get() 添加 stream = True# print(response.raw._connection.sock.getpeername()[0])# 第⼆种⽅式,直接返回测试⽹站的响应数据的内容print(response.text)except Exception as e:print('error',e)注意:peoxies的key值(http/https)要和url⼀致,不然会直接使⽤本机IP直接访问。

aiohttp中代理IP的使⽤:由于requests模块不⽀持异步,迫不得已使⽤aiohttp,掉了不少坑。

它的使⽤⽅式和requests相似,也是在get()⽅法中添加⼀个参数,但此时的参数名为proxy,参数值是字符串,且字符串中的代理协议,只⽀持http,写成https会报错。

这⾥记录⼀下我的纠错历程。

conda的代理设置

conda的代理设置conda是一个流行的开源软件包管理系统,用于在Python环境中安装、管理和升级软件包。

在使用conda时,有时候我们需要通过代理服务器来访问互联网,以便下载和安装软件包。

本文将介绍如何在conda 中设置代理。

首先,我们需要了解代理服务器的基本概念。

代理服务器是位于客户端和目标服务器之间的中间服务器,它可以代表客户端向目标服务器发送请求,并将响应返回给客户端。

通过使用代理服务器,我们可以隐藏客户端的真实IP地址,提高网络安全性,并且可以加速网络访问。

在使用conda之前,我们需要先设置代理服务器。

在Windows系统中,我们可以通过以下步骤设置代理服务器:1. 打开“控制面板”,点击“网络和Internet”。

2. 在“Internet选项”中,点击“连接”选项卡。

3. 在“局域网设置”中,勾选“使用代理服务器”。

4. 输入代理服务器的地址和端口号。

5. 点击“确定”保存设置。

在Linux和Mac系统中,我们可以通过设置环境变量来配置代理服务器。

打开终端,输入以下命令:```export http_proxy=http://proxy_server:portexport https_proxy=https://proxy_server:port```其中,`proxy_server`是代理服务器的地址,`port`是代理服务器的端口号。

如果代理服务器需要用户名和密码进行身份验证,可以使用以下命令:```export http_proxy=http://username:password@proxy_server:portexport https_proxy=https://username:password@proxy_server:port```设置好代理服务器后,我们可以开始使用conda了。

在终端中输入conda命令时,conda会自动检测系统的代理设置,并通过代理服务器进行网络访问。

mitmproxy python代理用法

mitmproxy python代理用法mitmproxy是一个强大的Python代理工具,主要用于劫持网络流量并对其进行分析和修改。

使用mitmproxy可以轻松地截取和修改HTTP和HTTPS请求和响应。

以下是mitmproxy Python代理的使用方法:1. 安装mitmproxy在终端中输入以下命令:```pip install mitmproxy```2. 启动mitmproxy在终端中输入以下命令:```mitmproxy```3. 配置mitmproxy要配置mitmproxy,您可以在命令行参数中传递选项,例如: ```mitmproxy --listen-port 8080```这将使mitmproxy监听端口8080。

4. 使用mitmproxy一旦mitmproxy正在运行并监听请求,您就可以开始使用它。

要暂停或继续代理,按Ctrl-C。

要查看请求和响应的详细信息,按v。

5. 修改请求和响应要修改请求和响应,您可以使用mitmproxy的Python脚本API。

例如,以下脚本将在请求中添加一个自定义标头:```from mitmproxy import httpdef request(flow: http.HTTPFlow) -> None:flow.request.headers['X-Custom-Header'] = 'Hello,world!'```要使用此脚本,请将其保存为.py文件并在启动mitmproxy时使用以下命令:```mitmproxy -s script.py```这样,mitmproxy将加载并运行此脚本。

6. 导出数据要导出mitmproxy捕获的数据,请使用以下命令:```mitmproxy -w filename.pcap```这将将数据保存到filename.pcap文件中。

您可以使用Wireshark之类的工具来查看该文件。

conda的代理设置

conda的代理设置摘要:1.代理设置的背景和原因2.conda 的基本概念3.conda 代理设置的方法4.代理设置的优点和注意事项5.结论正文:1.代理设置的背景和原因在网络环境中,有时会遇到访问某些网站或资源受限的情况,这时候就需要通过代理服务器来实现访问。

代理服务器的作用是充当客户端与目标网站之间的中介,将客户端的请求转发给目标网站,并将响应返回给客户端。

这样,客户端就可以通过代理服务器来访问受限的资源。

在conda 环境中,代理设置可以帮助用户在安装和使用包时,突破网络限制,实现更顺畅的科研工作。

2.conda 的基本概念conda 是一个开源的Python 包管理工具,它可以帮助用户方便地安装、更新和管理Python 包。

conda 还可以创建虚拟环境,让不同项目的依赖关系互不干扰。

在使用conda 时,有时需要设置代理服务器来提高包的下载速度和稳定性。

3.conda 代理设置的方法要在conda 中设置代理,可以通过以下步骤实现:首先,打开终端或命令提示符,找到conda 的安装路径。

在Windows 系统中,通常位于“C:Users用户名AppDataRoamingconda”;在macOS 和Linux 系统中,通常位于“~/.conda”(macOS)或“~/.condarc”(Linux)。

接着,在相应的路径下创建一个名为“proxy.ini”的文件。

如果该文件已存在,可以直接编辑。

然后,在“proxy.ini”文件中填写代理设置的相关信息。

具体内容如下:```[common]http_proxy = http://代理服务器地址:端口https_proxy = https://代理服务器地址:端口```其中,“代理服务器地址”需要替换为实际的代理服务器地址,而“端口”通常为8080。

如果代理服务器需要用户名和密码,还需添加以下内容:```[common]http_proxy_user = 用户名http_proxy_password = 密码```完成设置后,保存文件并退出。

set_default_proxy参数 -回复

set_default_proxy参数-回复set_default_proxy参数用于设置默认的代理服务器,以便在网络请求中使用代理。

在本文中,我们将一步一步地回答关于set_default_proxy参数的问题,以帮助读者更好地理解和使用该功能。

第一步:什么是代理服务器?在网络通信中,代理服务器充当中间人,将客户端和目标服务器之间的请求和响应传递。

代理服务器可以为客户端提供各种功能,如防火墙保护、内容过滤、加密传输等。

此外,代理服务器还可以通过缓存响应数据来提高访问速度。

第二步:为什么使用代理服务器?使用代理服务器有多种好处。

首先,代理服务器可以提供匿名性,隐藏客户端的真实IP地址,增加网络安全性。

其次,代理服务器可以缓存响应数据,减少网络请求的时间和带宽消耗。

此外,代理服务器还可以绕过一些限制,例如访问被封锁的网站或平台。

第三步:set_default_proxy参数的作用是什么?set_default_proxy参数允许我们在Python脚本中设置全局的默认代理服务器。

这意味着所有使用网络请求库(如urllib、requests)进行的HTTP 或HTTPS请求都将通过设置的代理服务器发送和接收数据。

通过使用set_default_proxy参数,我们可以轻松地为整个应用程序设置统一的代理设置。

第四步:如何设置代理服务器?在Python中,我们可以使用urllib库来设置代理服务器。

首先,我们需要导入urllib库中的request模块。

然后,我们可以使用set_default_proxy函数来设置代理服务器。

pythonimport urllib.requestproxy = urllib.request.ProxyHandler({'http': 'urllib.request.install_opener(urllib.request.build_opener(proxy))在上面的代码中,我们通过代理服务器的URL和端口号创建一个代理处理器,并将其传递给build_opener函数。

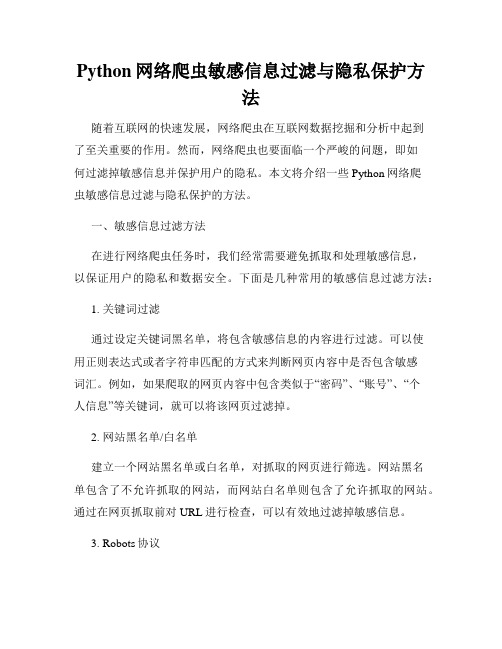

Python网络爬虫敏感信息过滤与隐私保护方法

Python网络爬虫敏感信息过滤与隐私保护方法随着互联网的快速发展,网络爬虫在互联网数据挖掘和分析中起到了至关重要的作用。

然而,网络爬虫也要面临一个严峻的问题,即如何过滤掉敏感信息并保护用户的隐私。

本文将介绍一些Python网络爬虫敏感信息过滤与隐私保护的方法。

一、敏感信息过滤方法在进行网络爬虫任务时,我们经常需要避免抓取和处理敏感信息,以保证用户的隐私和数据安全。

下面是几种常用的敏感信息过滤方法:1. 关键词过滤通过设定关键词黑名单,将包含敏感信息的内容进行过滤。

可以使用正则表达式或者字符串匹配的方式来判断网页内容中是否包含敏感词汇。

例如,如果爬取的网页内容中包含类似于“密码”、“账号”、“个人信息”等关键词,就可以将该网页过滤掉。

2. 网站黑名单/白名单建立一个网站黑名单或白名单,对抓取的网页进行筛选。

网站黑名单包含了不允许抓取的网站,而网站白名单则包含了允许抓取的网站。

通过在网页抓取前对URL进行检查,可以有效地过滤掉敏感信息。

3. Robots协议遵守网站的Robots协议,即robots.txt文件中的规定,限制爬虫的访问范围。

爬虫在抓取网页前,应该首先访问robots.txt文件,并根据其中的规则进行判断是否允许抓取该网页。

二、隐私保护方法除了过滤敏感信息,保护用户隐私也是网络爬虫开发者需要考虑的重要问题。

下面是几种常用的隐私保护方法:1. 使用代理IP使用代理IP进行爬取数据,可以隐藏真实的IP地址,保护用户隐私。

通过定期更换代理IP,可以有效避免被网站封禁。

2. 登录账号授权对于一些需要登录的网站,可以使用用户授权的方式进行爬取。

用户先进行登录,爬虫再携带授权信息进行数据抓取。

这种方式可以保护用户的隐私,并且能够获取到更多的数据。

3. 访问频率控制合理控制爬虫的访问频率,避免对网站服务器造成过大的负担。

设置合适的访问间隔和请求头信息,模拟真实用户的行为,可以降低被封禁的风险,同时保护用户隐私。

Python使用代理的方法

Python使⽤代理的⽅法我们在做爬⾍的过程中经常会遇到这样的情况:最初爬⾍正常运⾏,正常抓取数据,⼀切看起来都是那么的美好,然⽽⼀杯茶的功夫可能就会出现错误,⽐如403 Forbidden;出现这样的原因往往是⽹站采取了⼀些反爬⾍的措施,⽐如,服务器会检测某个IP在单位时间内的请求次数,如果超过了某个阈值,那么服务器会直接拒绝服务,返回⼀些错误信息。

这时候,代理就派上⽤场了。

国内的免费代理⽹站:接下来看如何设置代理:urllib代理设置:from urllib.error import URLErrorfrom urllib.request import ProxyHandler,build_openerproxy='123.58.10.36:8080'#使⽤本地代理#proxy='username:password@123.58.10.36:8080' #购买代理proxy_handler=ProxyHandler({'http':'http://'+proxy,'https':'https://'+proxy})opener=build_opener(proxy_handler)try:response=opener.open('/get') #测试ip的⽹址print(response.read().decode('utf-8'))except URLError as e:print(e.reason)运⾏结果如下:requests代理设置:import requestsproxy='123.58.10.36:8080'#本地代理#proxy='username:password@123.58.10.36:8080'proxies={'http':'http://'+proxy,'https':'https://'+proxy}try:response=requests.get('/get',proxies=proxies)print(response.text)except requests.exceptions.ConnectionError as e:print('错误:',e.args)运⾏结果如下:Selenium代理设置:from selenium import webdriverproxy='123.58.10.36:8080'chrome_options=webdriver.ChromeOptions()chrome_options.add_argument('--proxy-server=http://'+proxy)browser=webdriver.Chrome(chrome_options=chrome_options)browser.get('/get')运⾏结果:以上就是代理的⼀些简单设置、、、。

python设置代理和添加镜像源的方法

python设置代理和添加镜像源的⽅法为什么要修改镜像源?⼀般使⽤python安装库,会⽤到pip install xxx 指令或者conda install xxx指令,因为pip和conda默认国外镜像源,这时会在Python的官⽅源/pypi 下载,速度很慢,有时会因为超时会抛异常⽆法下载成功,所以可以选择⼀些⽐较稳定速度⽐较快的国内镜像来下载python库,可以显著加快模块安装速度。

为什么要设置代理?当计算机被限制上⽹时(公司安全考虑)就不能连外⽹了,此时需要设置代理来解决;通常公司要求通过代理联⽹以保证⽹络安全(即⽹络连接外⽹时需要设置代理才可访问);有时由于国外官⽅pypi被墙,导致不可⽤,也可通过设置代理访问。

【注意】:pip和conda修改镜像源的⽅式有所不同配置⽂件设置代理和添加镜像源前先检测配置⽂件是否存在,没有则创建之。

配置⽂件的路径(不同系统路径也有所不同):1). Unix:$HOME/.config/pip/pip.conf2). Mac:$HOME/Library/Application Support/pip/pip.conf3). Windows:%APPDATA%\pip\pip.ini,%APPDATA%表⽰实际路径,例如C:\Users\user_xxx\AppData\Roaming,可在cmd⾥执⾏echo %APPDATA%命令查看【补充】:1). 凡是pip命令⾏的参数都可以在配置⽂件⾥定义其默认值!2). which pip可以指出pip的位置(例如:/usr/local/bin/pip)pip设置代理1). 单次设置:(Windows和Linux系统⼀样)2). 临时设置(重连后失效):(1). Linux系统下:(在终端直接运⾏) export http_proxy='http://代理服务器IP:端⼝号port' export https_proxy='http://代理服务器IP:端⼝号port'export http_proxy=http://109.123.111.111:8000export https_proxy=http://109.123.111.111:8000(2). windows系统下:(在终端直接运⾏) set http_proxy='http://代理服务器IP:端⼝号port' set http_proxy='http://代理服务器IP:端⼝号port'set http_proxy=http://109.123.111.111:8000set https_proxy=http://109.123.111.111:8000【注意】:设置之后可能使⽤ping时还是⽆法连接外⽹,但是pip时可以的,因为ping的协议不⼀样不能使⽤这个代理、3). 永久设置:( 打开配置⽂件)(1). Linux系统下打开pip.conf配置⽂件添加内容如下: [global]# 在.pip⽬录创建并编辑pip.conf(没有配置⽂件时)mkdir ~/.pip # 创建pip⽂件夹cd ~/.pip # 创建pip.conf⽂件vi pip.conf # 打开pip.conf⽂件# 按i进⼊编辑模式:[global]proxy=http://10.20.217.2:8080# 按ESC键,再输⼊wq保存即可。

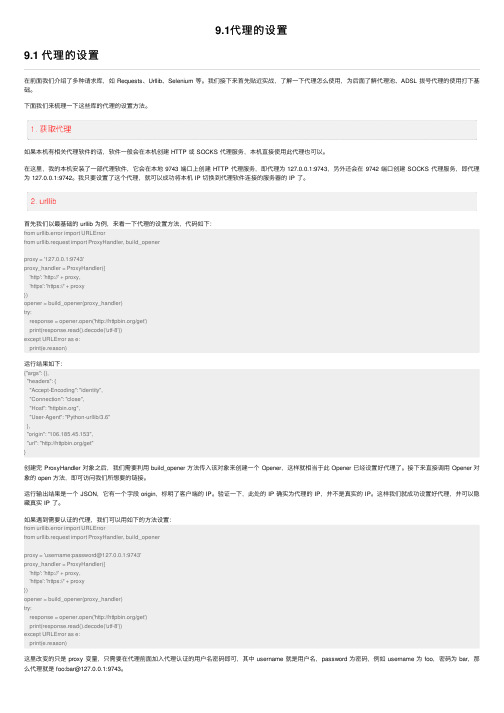

9.1代理的设置

9.1代理的设置9.1 代理的设置在前⾯我们介绍了多种请求库,如 Requests、Urllib、Selenium 等。

我们接下来⾸先贴近实战,了解⼀下代理怎么使⽤,为后⾯了解代理池、ADSL 拨号代理的使⽤打下基础。

下⾯我们来梳理⼀下这些库的代理的设置⽅法。

如果本机有相关代理软件的话,软件⼀般会在本机创建 HTTP 或 SOCKS 代理服务,本机直接使⽤此代理也可以。

在这⾥,我的本机安装了⼀部代理软件,它会在本地 9743 端⼝上创建 HTTP 代理服务,即代理为 127.0.0.1:9743,另外还会在 9742 端⼝创建 SOCKS 代理服务,即代理为 127.0.0.1:9742。

我只要设置了这个代理,就可以成功将本机 IP 切换到代理软件连接的服务器的 IP 了。

⾸先我们以最基础的 urllib 为例,来看⼀下代理的设置⽅法,代码如下:from urllib.error import URLErrorfrom urllib.request import ProxyHandler, build_openerproxy = '127.0.0.1:9743'proxy_handler = ProxyHandler({'http': 'http://' + proxy,'https': 'https://' + proxy})opener = build_opener(proxy_handler)try:response = opener.open('/get')print(response.read().decode('utf-8'))except URLError as e:print(e.reason)运⾏结果如下:{"args": {},"headers": {"Accept-Encoding": "identity","Connection": "close","Host": "","User-Agent": "Python-urllib/3.6"},"origin": "106.185.45.153","url": "/get"}创建完 ProxyHandler 对象之后,我们需要利⽤ build_opener ⽅法传⼊该对象来创建⼀个 Opener,这样就相当于此 Opener 已经设置好代理了。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

python设置代理ip的方法

摘要:

一、引言

二、Python设置代理IP的必要性

1.提高访问速度

2.保护隐私

3.绕过网络限制

三、设置代理IP的方法

1.使用代理IP库

1) 安装库

2) 获取代理IP

3) 设置代理

2.使用免费代理IP网站

1) 搜索免费代理IP

2) 验证代理IP有效性

3) 设置代理

四、常见问题与解决方法

1.代理IP无效

1) 更换代理IP

2) 检查代理IP是否可用

2.网络速度慢

1) 更换更快代理IP

2) 调整代理端口

3.连接失败

1) 检查代理IP是否正确

2) 检查网络连接

正文:

一、引言

在当今网络时代,许多应用程序和网站都对IP地址进行了限制,以防止恶意攻击和滥用资源。

因此,设置代理IP已成为突破这些限制的有效方法。

本文将为您介绍如何在Python中设置代理IP,以及相关技巧和注意事项。

二、Python设置代理IP的必要性

1.提高访问速度:通过代理IP,您的请求可以绕过直接访问目标服务器,由代理服务器转发,从而减轻服务器压力,提高访问速度。

2.保护隐私:使用代理IP可以隐藏您的真实IP地址,防止黑客攻击和网络监控,保护您的隐私。

3.绕过网络限制:许多国家和地区对网络访问设有限制,通过代理IP可以突破这些限制,访问受限制的网站和资源。

三、设置代理IP的方法

1.使用代理IP库:

1) 安装库:在Python环境中安装一款代理IP库,如`requests`。

2) 获取代理IP:使用库函数获取可用的代理IP,例如:

`requests.get_proxies()`。

3) 设置代理:将获取到的代理IP设置到Python的HTTP请求中,如:`http.client.HTTPSConnectionPool.connect()`.

2.使用免费代理IP网站:

1) 搜索免费代理IP:在搜索引擎中搜索“免费代理IP”,找到可靠的免费代理IP网站。

2) 验证代理IP有效性:使用Python编写验证代码,测试代理IP是否可以正常访问目标网站。

3) 设置代理:将有效代理IP设置到Python的HTTP请求中,方法同上。

四、常见问题与解决方法

1.代理IP无效:如果发现代理IP无效,可以尝试更换代理IP,或检查代理IP是否可用。

2.网络速度慢:如果发现网络速度较慢,可以尝试更换更快代理IP,或调整代理端口。

3.连接失败:如果连接失败,请检查代理IP是否正确,并确保网络连接正常。

通过以上方法,您可以在Python中设置代理IP,从而实现网络访问的优化和隐私保护。