lda 的高维数据处理模拟

高维数据降维算法的性能评估与改进

高维数据降维算法的性能评估与改进引言:在现实生活和科学研究中,我们经常面临处理高维数据的挑战。

高维数据具有大量的特征,因此难以直观地可视化和分析。

为了解决这个问题,降维算法被广泛应用于高维数据的预处理和分析。

降维旨在通过将高维数据映射到低维空间,保留最重要的信息,同时减少数据维度,以实现更有效的数据分析。

本文旨在探讨高维数据降维算法的性能评估与改进。

首先,我们将介绍几种常用的高维数据降维算法,包括主成分分析(PCA)、线性判别分析(LDA)和局部线性嵌入(LLE)。

然后,我们将讨论如何评估这些算法的性能,并提出一些改进方法以提高降维算法的效果和稳定性。

一、高维数据降维算法1. 主成分分析(PCA):PCA是一种最常用的降维算法。

它通过线性变换将原始数据映射到一个低维空间,以使得投影方差最大化。

这意味着通过选择最主要的特征,PCA 可以减少数据的维度,并且保留了大部分的变异性。

2. 线性判别分析(LDA):LDA是一种监督学习的降维算法。

它通过将数据投影到一个低维空间,以最大化不同类别之间的差异性,同时最小化同一类别内部的方差。

相比于PCA,LDA更适用于分类问题。

3. 局部线性嵌入(LLE):LLE是一种非线性的降维方法。

它通过局部的线性逼近来保持数据之间的局部关系。

LLE首先确定每个数据点的邻域,然后通过最小化邻域内点之间的重建误差,将原始数据映射到低维空间。

二、性能评估方法为了评估高维数据降维算法的性能,我们需要考虑以下几个指标:1. 降维后数据的可视化效果:降维算法的主要目标之一是可视化高维数据。

因此,我们可以通过可视化降维后的数据,观察数据的分布和结构是否更清晰可辨。

2. 信息保留能力:降维算法在减少数据维度的同时,应尽可能保留原始数据的重要信息。

我们可以使用各种信息论指标(如方差解释比例)来评估降维算法在信息保留方面的效果。

3. 计算效率:降维算法的计算效率也是一个重要的指标,特别是在处理大规模高维数据时。

LDA算法详解

线性鉴别分析法线性鉴别分析(Linear Discriminant Analysis, LDA),有时也称Fisher 线性判别(Fisher Linear Discriminant ,FLD), 这种算法是Ronald Fisher 于 1936年发明的,是模式识别的经典算法[i]。

在1996年由Belhumeur 引入模式识别和人工智能领域的。

性鉴别分析的基本思想是将高维的模式样本投影到最佳鉴别矢量空间,以达到抽取分类信息和压缩特征空间维数的效果,投影后保证模式样本在新的子空间有最大的类间距离和最小的类内距离,即模式在该空间中有最佳的可分离性。

因此,它是一种有效的特征抽取方法。

使用这种方法能够使投影后模式样本的类间散布矩阵最大,并且同时类内散布矩阵最小。

就是说,它能够保证投影后模式样本在新的空间中有最小的类内距离和最大的类间距离,即模式在该空间中有最佳的可分离性。

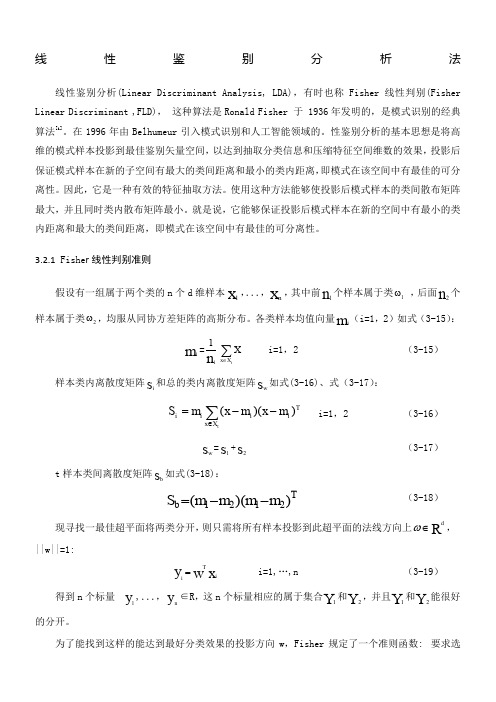

3.2.1 Fishe r 线性判别准则假设有一组属于两个类的n 个d 维样本x 1,...,x n,其中前n 1个样本属于类1ω ,后面n 2个样本属于类2ω,均服从同协方差矩阵的高斯分布。

各类样本均值向量m i (i=1,2)如式(3-15):m i =ni 1∑∈tX x X i=1,2 (3-15)样本类内离散度矩阵s i 和总的类内离散度矩阵s w 如式(3-16)、式(3-17):TiX x i ii m x m x m S t)()(--=∑∈ i=1,2 (3-16) s w=s 1+s2(3-17)t 样本类间离散度矩阵s b 如式(3-18):Tb m m m m S ))((2121--= (3-18)现寻找一最佳超平面将两类分开,则只需将所有样本投影到此超平面的法线方向上∈ωR d,||w||=1:x w y iTi= i=1,…,n (3-19)得到n 个标量y 1,...,y n∈R ,这n 个标量相应的属于集合Y 1和Y 2,并且Y 1和Y 2能很好的分开。

利用机器学习算法进行高维数据降维与特征提取研究

利用机器学习算法进行高维数据降维与特征提取研究在数据科学领域,高维数据和特征提取是两个重要的问题。

当数据具有很多特征时,我们往往需要找到一种方法来减少数据维度,并提取有用的特征以便进行进一步的分析和建模。

这就需要利用机器学习算法进行高维数据降维与特征提取研究。

高维数据降维是将高维数据映射到一个更低维度的空间,同时保留数据的主要结构和信息。

降维的目的是减少数据的冗余度,去除噪声,提高数据的可解释性。

常见的高维数据降维算法包括主成分分析(PCA)、线性判别分析(LDA)和t-SNE等。

首先,主成分分析是一种最常用的降维方法,它通过线性变换将高维数据映射到低维空间。

PCA通过计算数据的协方差矩阵,找到数据中的主要方向,并将数据投影到这些方向上,从而减少数据的维度。

主成分分析不仅能够降低数据维度,还能够提取数据中的重要特征。

其次,线性判别分析是一种有监督的降维方法,它将高维数据映射到一个低维空间,同时保留数据的类别信息。

LDA通过最大化类间距离和最小化类内距离的方式,选择最佳投影方向,从而实现数据的降维和特征提取。

相比于PCA,LDA更适用于分类问题,可以提高后续分类模型的性能。

另外,t-SNE(t-Distributed Stochastic Neighbor Embedding)是一种非线性降维方法,它能够将高维数据映射到低维空间,并保留数据之间的局部结构。

t-SNE通过计算高维数据点之间的相似度,构建一个低维空间中的相似度矩阵,然后使用梯度下降等优化算法来最小化高维和低维相似度之间的差异。

t-SNE在可视化和聚类等任务中广泛应用,能够更好地展现数据之间的关系。

除了以上提到的算法,还有很多其他的降维和特征提取方法,如因子分析、独立成分分析(ICA)和自动编码器等。

这些方法各有特点,适用于不同类型的数据和任务。

在应用机器学习算法进行高维数据降维和特征提取时,我们需要考虑以下几个因素。

首先,降维后的数据是否能够准确地表示原始数据的结构和信息。

线性判别分析算法在数据分类中的应用

线性判别分析算法在数据分类中的应用线性判别分析算法(Linear Discriminant Analysis, LDA)是一种常用的数据分类方法。

它的基本思想是通过将数据投影到一条直线(或者是高维空间中的一个超平面),使得同类之间的数据点尽可能接近,不同类之间的数据点尽可能远离。

这样,我们就可以用这条直线来区分不同的类别,从而实现数据分类的任务。

LDA算法的应用非常广泛,比如在机器学习、模式识别、图像处理、生物信息学等领域都有大量的应用。

下面,我们将从几个方面来介绍LDA算法在数据分类中的应用。

1. LDA算法在二分类问题中的应用二分类是指只涉及两个类别的分类问题。

LDA算法可以被用来解决二分类问题,特别是在数据样本有限的情况下,LDA算法表现得更加优秀。

LDA算法将数据样本投影到一条直线上,使得同类之间的数据点尽可能接近,不同类之间的数据点尽可能远离。

这样,我们可以通过比较投影后的数据点的位置来判断它属于哪个类别。

在实际应用中,我们可以通过LDA算法来处理一些二分类问题,如人脸识别、声音识别、图像分类等。

例如,在人脸识别中,我们可以将不同人的人脸图像看做不同的类别,通过LDA算法将它们投影到一条直线上,从而实现对不同人脸图像的识别。

2. LDA算法在多分类问题中的应用在许多实际问题中,涉及到的不止两个类别,而是多个类别。

LDA算法同样可以被用来解决多分类问题。

LDA算法在多分类问题中的应用稍有不同。

在二分类问题中,我们可以将数据点投影到一条直线上,但在多分类问题中,我们需要将数据点投影到更高维的空间中,即超平面上。

具体地,我们可以将每个类别看做一个投影方向,然后将所有的投影方向合并起来,形成一个超平面。

通过将数据样本投影到这个超平面上,我们可以将数据分类成多个类别。

3. LDA算法在降维问题中的应用在高维数据处理中,数据的维数通常会非常高。

这对数据处理带来了困难,因为高维数据不能直观地展示出来,也很难直接分析。

r语言lda函数用法

r语言lda函数用法R语言中的lda函数是一种用来进行文本主题建模的工具。

主题建模是一种分析文本数据的方法,旨在识别并提取文本数据中的主题或话题。

LDA(Latent Dirichlet Allocation)是一种常用的主题模型算法,通过统计学原理和贝叶斯推理理论来识别文本中的主题。

LDA函数在R语言的topicmodels软件包中实现,它提供了一系列功能来处理文本数据。

使用lda函数进行主题建模一般需要以下几个步骤:1. 数据预处理:首先,需要对文本数据进行预处理,包括分词、去除停用词、词干化等操作。

R语言中有许多文本处理包可以使用,如tm包、text mining包等,可以帮助完成这一步骤。

2. 创建文档-词频矩阵:将预处理后的文本数据转换成文档-词频矩阵。

这个矩阵表示了文本中每个词的出现频率。

可以使用tm包或者text mining包中的函数来完成这一步骤。

3. 构建LDA模型:使用lda函数构建LDA模型。

首先需要设置主题数量,即希望从文本中提取的主题个数。

然后,将文档-词频矩阵作为输入,应用lda函数进行模型构建。

lda函数提供了一些参数可以调整模型的性能,如迭代次数、主题-词分布的先验分布等。

4. 模型训练和推断:通过调用lda函数返回的模型对象,可以进行模型的训练和推断。

使用函数如topicmodels包中的Function, posterior, and logLik等函数可以获取模型的输出结果,如主题-词分布、文档-主题分布等。

通过上述步骤,可以使用R语言的lda函数对文本数据进行主题建模。

这个过程可以帮助我们发现文本中的隐藏主题,进一步分析和理解文本数据的内容。

lda函数是R语言中实现主题建模的一个重要工具,可以方便快捷地进行主题分析和主题挖掘。

svm 朴素贝叶斯 lda 数值

支持向量机(SVM)、朴素贝叶斯(N本人ve Bayes)、线性判别分析(LDA)和数值计算等是机器学习和数据挖掘领域中常用的方法和技术。

本文将就这些主题展开深入探讨,并对它们的原理、应用和优缺点进行详细阐述。

一、支持向量机(SVM)支持向量机是一种二分类模型,其基本原理是找到一个超平面,使得两类数据点距离超平面的间隔最大化。

SVM通过寻找最优超平面来进行分类,具有较强的泛化能力,对于高维数据和非线性数据有较好的分类效果。

SVM也可以通过核技巧来处理非线性分类问题。

但是,SVM的缺点是在处理大规模数据集时性能较差,且对参数的选择比较敏感。

二、朴素贝叶斯(N本人ve Bayes)朴素贝叶斯是一种基于贝叶斯定理和特征条件独立性假设的分类方法,适用于文本分类、垃圾邮件过滤等领域。

朴素贝叶斯方法简单、高效,对较小规模的数据集有很好的分类效果。

但是,朴素贝叶斯方法忽略了特征之间的相关性,因此对于非独立的特征,分类效果会有所下降。

三、线性判别分析(LDA)线性判别分析是一种经典的监督学习方法,用于减少数据的维度并保留最大类别间差异。

LDA通过最大化类间散布矩阵和最小化类内散布矩阵来寻找最佳投影方向,实现了数据的降维和有效分类。

LDA适用于高维数据的降维和特征提取,但要求数据满足正态分布和各类别具有相同的协方差矩阵。

四、数值计算数值计算是指利用计算机对数学问题进行数值求解和分析的过程,涉及到数值模拟、数值优化、数值插值等多个领域。

在数据处理和模型求解中,常常需要进行数值计算来获得近似解。

数值计算的基础包括数值稳定性和数值精度,计算方法包括二分法、牛顿迭代法、高斯消去法等。

支持向量机、朴素贝叶斯、线性判别分析和数值计算是机器学习和数据挖掘领域中常用的方法和技术,它们在不同领域有着广泛的应用。

深入理解这些方法的原理和特点,对于数据分析和模型建立非常重要。

而在实际应用中,需要根据具体问题的特点来选择适合的方法,并对其进行合理调参和优化,以获得最佳的分类效果和预测结果。

模式识别上lda的原理

模式识别上lda的原理

LDA(Linear Discriminant Analysis,线性判别分析)是一种经典的模式识别技术,用于降维、分类和数据可视化等任务。

其基本原理基于最大化类间差异和最小化类内差异,以找到能够有效区分不同类别的特征。

LDA 的主要目标是找到一个投影方向,使得投影后的数据在该方向上具有最大的可分性。

具体来说,LDA 假设数据来自两个或多个类别,并且每个类别可以通过一个高斯分布来描述。

通过找到一个投影方向,使得不同类别之间的投影距离尽可能大,同时同一类别内的投影距离尽可能小。

LDA 的原理可以通过以下步骤来解释:

1. 数据预处理:将数据进行标准化或中心化处理,使得每个特征具有零均值和单位方差。

2. 计算类内散度矩阵:通过计算每个类别的样本在原始特征空间中的协方差矩阵,得到类内散度矩阵。

3. 计算类间散度矩阵:通过计算所有类别样本的总体协方差矩阵,得到类间散度矩阵。

4. 计算投影方向:通过求解类间散度矩阵的特征值和特征向量,找到能够最大化类间差异的投影方向。

5. 投影数据:将原始数据在找到的投影方向上进行投影,得到降维后的特征。

6. 分类或可视化:可以使用投影后的特征进行分类任务或数据可视化。

LDA 的原理基于统计学习和降维的思想,通过最大化类间差异和最小化类内差异来找到最具判别力的投影方向。

它在模式识别和数据分析中具有广泛的应用,如人脸识别、语音识别和文本分类等领域。

Pca与lda算法分析

PCA与LDA算法分析主成份分析(PCA)和线性判别分析(LDA)是两种常见的统计分析技术,它们在数据降维、特征提取和分类问题方面都有广泛的应用。

本篇文章将介绍PCA和LDA算法的基本原理和应用。

PCA算法PCA算法是一种常用的数据降维算法,它可以将高维数据转化为低维数据,而且保留了原数据的大部分信息。

PCA主要应用于数据压缩和数据可视化的处理过程中。

PCA算法的步骤1.数据的标准化:将数据的每个特征缩放至零均值和单位标准差的规模。

2.计算协方差矩阵:计算出数据的协方差矩阵。

3.求出协方差矩阵的特征向量和特征值:计算协方差矩阵的特征向量和特征值,选择特征值最大的前K个。

4.将原始数据转换到新的坐标系上:将原始数据投影到新的坐标轴上。

PCA算法的应用1.数据的可视化:PCA算法降低了数据的维度,可以将数据在二维或三维平面上可视化。

2.数据压缩:PCA算法可以对数据进行压缩,减少存储空间和计算开销。

3.模式识别:PCA算法可以用于模式识别问题,例如人脸识别。

LDA算法LDA算法是一种有监督的线性降维技术,它可以对数据进行分类和特征提取。

与PCA算法不同,LDA算法对数据标签进行了考虑,通过最大化类内距离和最小化类间距离,将样本映射到一个低维子空间中。

LDA算法的步骤1.计算各类别的均值向量:计算各类别的均值向量。

2.计算类内离散度矩阵:计算每个类别的样本离其均值向量的距离的协方差矩阵的和。

3.计算类间离散度矩阵:计算所有类别均值向量之间的协方差矩阵。

4.求出最大化的目标函数:该目标函数可以通过求解广义特征值问题获得。

5.投影样本到低维子空间上:通过选择最大的前K个特征向量,将数据映射到一个低维子空间中。

LDA算法的应用LDA算法在目标识别和分类问题中有广泛的应用,例如人脸识别、指纹识别以及语音识别。

PCA和LDA算法的比较PCA和LDA都可以用于数据降维和特征提取,但是两种算法的应用场景不同。

•PCA通常用于未标记的数据,它是一种非监督方法,只是纯粹的降维,不能进行分类。

lda算法案例

lda算法案例一、什么是LDA算法LDA(Latent Dirichlet Allocation)是一种文本主题模型,用于从大规模文本语料库中发现隐藏的主题结构。

它基于概率图模型,将文档看作是主题的混合,每个主题又由单词的分布组成。

LDA算法可以帮助我们理解文本数据中的主题关联,从而实现文本分类、信息检索等应用。

二、LDA算法的原理LDA算法的核心思想是假设每个文档都由多个主题组成,每个主题又由多个单词组成。

LDA算法的目标是通过观察文档中的单词分布来推断主题的分布。

具体地,LDA算法的过程如下:1.初始化:设定主题数量K和每个主题的单词分布。

2.对于每个文档d中的每个单词w:–以一定的概率选择一个主题z,并从该主题的单词分布中选择一个单词w。

–更新主题z的单词分布和文档d中的主题分布。

3.重复步骤2,直到达到收敛条件。

三、LDA算法的应用场景LDA算法在自然语言处理领域有广泛的应用,例如:1. 文本分类LDA算法可以将文本数据转化为主题分布向量,从而实现文本分类。

通过计算文档与各个主题之间的相似度,可以将文档分到最相关的主题类别中。

2. 信息检索LDA算法可以用于信息检索,帮助用户快速找到相关的文档。

通过对用户查询进行主题建模,可以将查询与文档的主题向量进行匹配,从而得到相关的文档列表。

3. 推荐系统LDA算法可以用于推荐系统,帮助用户发现与其兴趣相关的内容。

通过对用户历史行为进行主题建模,可以将用户的兴趣与文档的主题进行匹配,从而实现个性化推荐。

4. 文本生成LDA算法可以用于生成新的文本内容,例如自动生成文章摘要、新闻标题等。

通过对主题分布进行采样,可以生成具有一定主题结构的文本。

四、LDA算法案例分析下面以一个新闻主题分类的案例来说明LDA算法的应用。

1. 数据准备我们收集了一批新闻文章,并对其进行了预处理,包括分词、去停用词等操作。

2. 模型训练使用LDA算法对预处理后的新闻文章进行建模。

高维数据降维与特征提取的方法与算法研究

高维数据降维与特征提取的方法与算法研究高维数据是指数据集中包含大量特征或属性的情况,这种数据集常常会导致计算和分析的困难。

因此,降维和特征提取方法在高维数据处理中变得至关重要。

本文将探讨一些常见的高维数据降维与特征提取的方法与算法。

一、维度灾难引发的问题在高维数据中,数据点的数量会迅速减少。

当数据集的特征数量远远超过训练样本的数量时,会出现维度灾难。

这会导致许多统计问题,如过拟合、计算复杂度增加和特征冗余等。

因此,我们需要降维和特征提取的方法来解决这些问题。

二、主成分分析(PCA)主成分分析(Principal Component Analysis,PCA)是一种常用的降维方法,通过线性变换将原始数据投影到新的几个维度上。

这些新的维度被称为主成分,它们的特点是彼此不相关。

PCA的目标是最大化投影方差,因此保留了原始数据中的大部分信息。

逐步进行主成分分析时,首先计算数据的协方差矩阵,然后对该矩阵进行特征值分解,得到特征向量和特征值。

特征向量构成主成分,特征值用于表示主成分的重要性。

根据特征值的大小,我们可以选择要保留的主成分数量,从而实现降维。

三、线性判别分析(LDA)线性判别分析(Linear Discriminant Analysis,LDA)是一种经典的降维方法,主要用于分类问题。

与PCA不同,LDA不仅考虑了方差,还考虑了类别与类别之间的区分度。

LDA通过最大化类别间的散射矩阵和最小化类别内的散射矩阵来实现降维。

散射矩阵可以用于计算投影矩阵,将原始数据映射到低维空间中。

LDA保留了类别之间的区分度,并提供了一种有效的特征提取方法。

四、非负矩阵分解(NMF)非负矩阵分解(Non-negative Matrix Factorization,NMF)是一种非线性的降维方法。

它将原始数据矩阵分解为两个非负矩阵的乘积。

NMF的优点是可以自动提取特征。

它假设原始数据矩阵可以由少数几个基本特征向量的组合表示。

大数据分析中的高维数据降维技术实现方法

大数据分析中的高维数据降维技术实现方法高维数据降维是大数据分析中非常重要的技术之一。

在许多场景下,我们需要处理具有大量特征的数据集,这些特征可能是冗余的、不相关的或者存在噪声,因此需要采取降维技术来减少特征维度,提高数据分析的效率和准确性。

本文将从线性降维和非线性降维两个方面介绍大数据分析中的高维数据降维技术实现方法。

线性降维是常用的降维技术之一,它通过保留数据的主要特征,将高维数据映射到低维空间中。

常用的线性降维技术包括主成分分析(Principal Component Analysis,PCA)和线性判别分析(Linear Discriminant Analysis,LDA)等。

首先介绍PCA,PCA是一种常用的线性降维技术,它通过找到数据中的主要方差方向来实现降维。

具体来说,PCA通过计算数据的协方差矩阵,然后对其进行特征值分解,得到特征值和特征向量。

根据特征值的大小,我们可以选择保留前n个特征向量,将数据映射到低维空间中。

这样,我们就得到了一组新的特征,这些特征是原始数据中最重要的特征。

PCA具有简单有效的特点,可以消除冗余特征,提高数据分析的效率。

另外一种常用的线性降维技术是LDA,它主要用于分类问题。

与PCA不同,LDA不仅考虑特征之间的方差关系,还考虑了类别之间的差异。

具体来说,LDA通过计算类别内散度矩阵和类别间散度矩阵,然后对其进行特征值分解,得到特征值和特征向量。

根据特征值的大小,我们可以选择保留前n个特征向量,将数据映射到低维空间中。

与PCA相比,LDA关注的是类别之间的差异,因此在分类问题上有较好的效果。

除了线性降维技术,非线性降维技术也被广泛应用于大数据分析中。

非线性降维技术主要通过保持数据的局部结构来实现降维。

常用的非线性降维技术包括流形学习(Manifold Learning)和自编码器(Autoencoder)等。

流形学习是一种重要的非线性降维技术,它通过将高维数据映射到低维流形空间中来实现降维。

高维数据处理与计算模型研究

高维数据处理与计算模型研究随着信息技术的飞速发展,人们获得的数据越来越多,涉及的领域也越来越广。

上千亿条的数据指标、生物学、化学、天文学的数据等等,这些数据不仅数量多,而且非常复杂,而且维度也越来越高。

那么高维数据处理是一个很重要的课题。

概念高维数据通常被认为是指其特征空间维度高于几百甚至千万以上的样本数据。

相对于低维数据,高维数据有一些显著的特点,例如样本数量相同的情况下,随着样本空间维度的增大,样本密度逐渐变得稀疏,同时,随着样本空间维度的增强,数据集中存在的噪声也会更加明显。

同时,高维数据的维度巨大,使得数据处理和计算非常困难。

处理对于高维数据的处理,最关键的问题是降维。

降维方法可以分为两类:线性降维和非线性降维。

线性降维方法,包括主成分分析(PCA)和线性判别分析(LDA)等,可以通过将数据一部分投影到新的空间中的少数维数,从而减少数据的维数。

它们可以在保留数据的原始特征及关系的同时,将数据降到低维度,便于分析和处理。

由于它们的其简单性和鲁棒性,线性降维方法是最广泛使用的降维方法之一。

相反,非线性降维并未影响数据的特征和关系,保留了原始数据的“内在流形结构”。

非线性降维方法包括ISOMAP、t-SNE等,其目标是从数据中捕捉数据的内在流形结构并恢复低维嵌入。

非线性降维的方法可以很好地捕捉强相关和非线性关系,因此可以在应用中更优秀。

运算模型高维数据模型也是实际应用和研究中最主要的问题之一。

如果数据模型不适当,可能会导致分析结果不准确或失效。

因此,开发高维数据模型并在处理和计算中使用它们是非常重要的。

常见的高维数据模型包括贝叶斯网络(BN)、高斯混合模型(GMM)和支持向量机(SVM)等,它们都可以用于高维数据的分类和聚类。

但是,在数据集数量有限的情况下,往往难以有效地训练模型,导致分类精度低。

因此,训练数据数量对模型性能的影响也应该被考虑。

在大规模高维数据处理中,计算模型也是至关重要的问题。

lda模型方法描述

lda模型方法描述

LDA 模型是由哥伦比亚大学的 David M Blei、斯坦福大学的吴恩达和 Michael Jordan (加州大学伯克利分校)在2003年提出的一种主题模型算法。

它属于自然语言处理领域中的无监督机器学习领域,可以有效地提取文本主题,并对文本评论数据进行文本挖掘建模分析。

LDA 主题模型的实现过程如下:

1. 将每个文档视为单词频率向量。

2. 在数学上将文本注释数据信息矢量化为易于建模的数字信息,然后建立一个单词袋模型。

3. 采用 Gibbs 抽样估计 LDA 主题模型的参数。

通过 LDA 主题建模分析,可以挖掘文本信息背后的潜在主题,然后分析文本特征词,从而更好地理解文本内容。

高维数据降维算法综述与性能评估

高维数据降维算法综述与性能评估摘要:高维数据降维是机器学习和数据挖掘领域中一个重要的问题。

随着数据量的不断增加,处理和分析高维数据变得越来越困难。

为了解决这个问题,研究者提出了各种高维数据降维算法。

本文将对目前主流的高维数据降维算法进行综述,并对它们的性能进行评估。

1. 引言随着信息技术的快速发展,数据的规模和维度也在不断增加。

高维数据具有复杂性和冗余性的特点,给数据处理和分析带来了挑战。

高维数据降维是一种有效的方式,可以减少数据的维度同时保留数据的特征,从而简化数据处理和分析过程。

2. 高维数据降维算法综述2.1 主成分分析(Principal Component Analysis,PCA)PCA是最常用的高维数据降维算法之一。

它通过寻找数据中方差最大的方向来进行降维。

PCA能够保留大部分的数据方差,从而保留数据的重要信息。

2.2 线性判别分析(Linear Discriminant Analysis,LDA)LDA是一种有监督的降维算法,主要用于分类问题。

它通过寻找能够最大程度地将不同类别的数据分开的方向来进行降维。

LDA能够在降维的同时保留类别之间的差异。

2.3 多维缩放(Multidimensional Scaling,MDS)MDS是一种非线性的降维算法,主要用于可视化高维数据。

它通过计算数据之间的相似性矩阵,然后将数据映射到低维空间。

MDS能够保持数据点之间的相对距离关系。

2.4 独立成分分析(Independent Component Analysis,ICA)ICA是一种基于统计的降维算法,主要用于信号处理和图像分析。

它假设数据是由若干个相互独立的信号混合而成,通过求解混合矩阵来进行降维。

ICA能够提取出数据中潜在的独立信号成分。

3. 高维数据降维算法的性能评估为了评估不同的高维数据降维算法的性能,研究者通常采用以下几种评估指标:3.1 降维效果评估降维效果评估是衡量算法降维能力的主要指标。

LDA模型的原理及其应用

6

i

1

n

i 1

6

i

N

X n1 , n2 , , n6

多项分布 (Multinomial Distribution)

N ! K ni pi K ni i1

i 1

p

i 1

K

i

1

n

i 1

K

i

N

X n1 , n2 , , nK

g 为归一化因子 为参数, 其中,

概率分布—共轭先验(Conjugate Prior)

对于概率分布(或密度)函数 p x | ,若p 满足如下条件,则称 p 为 p x | 的共轭 先验: (1) 后验分布p | x 与p 有相同的函数形 式。 指数分布族中的每一个成员均具有如下 形式的共轭先验: v p | , v f , v g exp v T

q 1 p p q 1

X k, N k

推广:现在投掷N次骰子,已知在每次 投掷中 i 向上的概率为 pi ,i = 1, 2, …, 6. 且 p 1. 那么在N次中 i 出现 ni 次,i = 1, 2, …, 6 的概率是多少?

6 i 1 i

N ! 6 ni pi 6 ni ! i1

i 1

p

i 1

6

i

1

n

i 1

6

i

N

X n1 , n2 , , n6

掷硬币

N! p k q N k k ! N k !

N ! 6 ni pi 6 ni i1

i 1

p q 1 X k, N k

解决高维数据问题的PCA与LDA降维算法比较

解决高维数据问题的PCA与LDA降维算法比较随着数据的普及和大规模化,高维数据已经成为了许多领域中不可避免的问题。

高维数据的存在意味着数据空间的维度非常大,这就给数据处理、分析和挖掘带来了许多困难。

高维数据的降维是一种常见的处理方法,PCA(Principal Component Analysis,主成分分析)与LDA(Linear Discriminant Analysis,线性判别分析)是常用的降维算法,本文将从算法原理、降维效果和应用场景三个方面对它们进行比较。

PCA算法原理PCA算法最初由Karl Pearson在1901年提出,是一种无监督学习算法。

PCA的主要思想是将高维空间转换为低维空间,同时保留数据的主要信息。

PCA算法通过计算数据间的协方差矩阵和其特征向量来实现降维。

具体来说,PCA算法的步骤如下:1.标准化数据集,使其均值为0,方差为1。

2.计算数据集的协方差矩阵。

3.计算协方差矩阵的特征值和特征向量。

4.选取特征值最大的前k个特征向量,组成转换矩阵。

5.将原始数据集投影到这个转换矩阵上,即可得到降维后的数据集。

LDA算法原理LDA算法最早由Fisher在1936年提出,是一种有监督学习算法。

LDA算法的主要思想是找到一个低维空间,使得数据在该空间中的分类尽可能明显。

具体来说,LDA算法的步骤如下:1.计算每个类别内部的协方差矩阵。

2.计算整个数据集的协方差矩阵。

3.计算S_{w}^{-1}S_{b}的特征值和特征向量,其中S_{w}表示类别内部协方差矩阵的加权和,S_{b}表示类别内部均值的差值矩阵的加权和。

4.选取特征值最大的前k个特征向量,组成转换矩阵。

5.将原始数据集投影到这个转换矩阵上,即可得到降维后的数据集。

降维效果比较PCA和LDA算法都是有效的降维算法,但它们的目标不相同。

PCA算法主要是为了保留最大量的数据信息而进行的降维处理,而LDA算法的目标是最大限度地提高类间距离和最小化类内距离或方差。

高维数据分析的降维技术

高维数据分析的降维技术高维数据分析是指数据集中包含大量特征或维度的数据,这种数据具有复杂性和高度抽象性,给数据分析和挖掘带来了挑战。

在实际应用中,高维数据分析往往会导致维度灾难和计算复杂度增加的问题,因此在处理高维数据时,降维技术成为了一种必不可少的方法。

一、PCA(Principal Component Analysis)主成分分析主成分分析是一种常用的降维技术,其基本思想是通过线性变换将原始数据映射到一组互相正交的主成分上,实现数据的降维。

主成分分析能够保留大部分数据的信息,同时去除特征之间的相关性,简化模型的训练和预测过程。

二、LDA(Linear Discriminant Analysis)线性判别分析与主成分分析类似,线性判别分析也是一种经典的降维技术。

其主要思想是将数据投影到一个低维空间中,使得同类样本尽可能接近,不同类样本尽可能远离。

线性判别分析在分类和模式识别领域得到了广泛应用。

三、t-SNE(t-Distributed Stochastic Neighbor Embedding)随机邻域嵌入t-SNE是一种非线性降维技术,能够有效地可视化高维数据集。

通过在高维空间中计算数据点间的相似度,并在低维空间中保持相似性关系,t-SNE能够呈现出数据集的结构和聚类特征,有助于数据的理解和分析。

四、Autoencoder自编码器自编码器是一种通过无监督学习实现数据降维和特征提取的神经网络模型。

通过训练自编码器,可以学习到数据的低维表示,并还原原始数据,实现高维数据到低维表征的映射。

自编码器在图像、文本和信号处理领域有着广泛的应用。

五、特征选择和特征抽取除了上述经典的降维技术外,特征选择和特征抽取也是重要的降维手段。

特征选择是指从原始特征中选择最具代表性的子集,保留有用信息并减少噪声。

特征抽取是通过数学变换将原始特征转换为新特征,保持数据的主要结构和关系。

这两种方法在实际应用中都能够有效地提高模型的性能和泛化能力。

高维数据的分析与建模方法研究

高维数据的分析与建模方法研究随着互联网、物联网、人工智能等技术的快速发展,大量的数据被产生并被应用到各个领域,例如社交网络、医药研发、金融投资等。

这些数据往往具有高维、大量、复杂等特点,如何有效地对这些高维数据进行分析和建模已成为一个重要的研究课题。

一、高维数据的概念高维数据是指数据集中的每个样本由多个特征组成,即数据的维度较大。

在实际应用中,高维数据的维度往往远远大于样本量。

例如,在图像识别中,每个图像都由像素组成,维度可以达到上百万,而往往只有几千张图像可供使用。

高维数据的处理和分析需要面对许多挑战,如维度灾难、过拟合等问题。

二、高维数据的降维方法为了解决高维数据处理和分析的困难,研究人员提出了许多降维方法。

降维是指将高维数据映射到低维空间,从而减少数据的维度,降低数据的复杂度,使得数据处理更加高效。

常用的降维方法包括主成分分析(PCA)、独立成分分析(ICA)、多维缩放(MDS)、局部线性嵌入(LLE)等。

其中,PCA是最常用的降维方法之一,其基本思想是从原始数据中找出最能代表样本间变异性的主成分,然后将数据投影到这些主成分上,从而实现降维。

PCA在高维数据压缩、特征提取、数据可视化等方面都有广泛的应用。

三、高维数据的分类方法在实际应用中,高维数据的分类是常见的任务之一。

高维数据的分类方法需要考虑到数据的方差和协方差矩阵,并满足线性可分的条件。

主要的分类方法包括线性判别分析(LDA)、支持向量机(SVM)、最近邻算法(KNN)等。

其中,SVM是最常用的分类方法之一,其基本思想是将数据映射到高维特征空间,并沿着最优分割平面进行分类。

SVM对于高维数据的分类效果很好,在金融、医疗、图像处理等领域有着广泛的应用。

四、高维数据的建模方法高维数据的建模方法是指根据数据集建立模型来描述数据分布、规律和关系的方法。

常见的建模方法包括聚类分析、回归分析、关联规则挖掘等。

聚类分析是将数据集划分成不同的类,每个类中的数据具有相似的特征,不同类之间的差异很大。

高维数据处理与降维技术研究

高维数据处理与降维技术研究随着信息时代的到来,我们进入了一个数据爆炸的时代。

大量的数据被采集、存储和处理,给我们带来了前所未有的机会和挑战。

然而,随着数据的不断增长,我们也面临着一个问题,那就是高维数据的处理。

在高维数据中,经典的数据分析和可视化方法会遭遇到维度灾难,导致效果不佳。

因此,研究高维数据处理与降维技术成为了重要而紧迫的任务。

高维数据处理的意义在于如何更好地挖掘数据的内在规律和特征。

而降维技术则是高维数据处理的一种有效方法。

降维技术可以将高维数据映射到低维空间,从而提取数据的主要信息并减少计算的复杂性。

降维技术有助于可视化、分类、聚类、数据分析和模型构建等领域的研究和应用。

在高维数据处理中,常见的降维技术包括主成分分析(PCA)、线性判别分析(LDA)、局部线性嵌入(LLE)、局部保持投影(LPP)等。

这些降维技术各有特点,适用于不同类型的数据分析任务。

下面将对其中几种常见的降维技术进行介绍。

主成分分析(PCA)是一种经典的无监督降维方法。

PCA通过将原始高维数据投影到低维空间上,使得数据在低维空间中的方差最大化,从而保留了数据的主要信息。

PCA具有简单易实现、计算复杂度低等优点,在数据预处理和可视化中得到广泛应用。

线性判别分析(LDA)则是一种有监督降维方法。

LDA通过最大化不同类别之间的差异并最小化同类别之间的差异,将高维数据映射到低维空间。

LDA在模式识别和分类问题中表现出了较好的性能。

局部线性嵌入(LLE)是一种非线性降维方法,它通过保持数据之间的局部性质来进行降维。

LLE假设数据在低维空间中近邻关系保持不变,并通过重新构建数据点之间的线性关系来降低维度。

局部保持投影(LPP)是一种基于图论的降维方法。

LPP通过构建一个数据图来描述数据之间的关系,并利用保持图的局部结构的方式进行降维。

LPP考虑到了样本的分布和近邻关系,对于保持数据的局部结构起到了良好的效果。

除了上述降维方法外,还有一些其他的高维数据处理方法,包括多视图学习、稀疏表示、核方法等。

高维数据降维及可视化算法研究

高维数据降维及可视化算法研究随着大数据时代的到来,数据规模不断增大,传统的数据挖掘和可视化方法已经不能很好地处理高维数据。

高维数据是指数据的特征数(维度)远大于样本数的数据,这些数据存在着许多问题,比如计算复杂度高、可视化难度大等。

因此,高维数据降维和可视化算法的研究变得越来越重要。

一、高维数据降维算法高维数据的降维是指将高维度的数据转化到低维度的空间中,保留原始数据的重要特征,并尽量减少信息损失。

常见的高维数据降维算法有主成分分析(PCA)、线性判别分析(LDA)、t-SNE等。

1. 主成分分析(PCA)PCA是一种常用的数据降维算法,用于发现数据的主要特征。

它对数据进行线性变换,将原始数据映射到一个新的坐标系中,使得数据在新坐标系下的方差最大化。

该算法可以有效地减少数据维度,并提取出数据中的主要特征。

2. 线性判别分析(LDA)LDA也是一种常用的数据降维算法,主要用于分类问题。

它将原始数据映射到低维空间中,并使得不同类别之间的距离最大化,同一类别内部的距离最小化。

与PCA不同的是,LDA不仅可以降维,还可以进行分类。

3. t-SNEt-SNE是一种非线性降维算法,它可以通过优化目标函数来将高维数据映射到低维空间中。

t-SNE算法可以保留高维空间中的相似性关系,并将它们映射到低维空间中。

这个算法常用于大规模数据集的可视化。

二、高维数据可视化算法高维数据的可视化是指将高维度的数据转化为能够在2D或3D空间中呈现的可视化图像。

高维数据的可视化问题源于我们的眼睛只能看到三维空间中的物体,无法直接观察高维数据。

常见的高维数据可视化算法有t-SNE、UMAP等。

1. t-SNEt-SNE不仅是一种常用的降维算法,还是一种常用的可视化算法。

该算法可以将高维数据映射到2D或3D空间中,并保留高维数据中的特征。

该算法为非线性算法,可以更好地保留数据的相似关系。

2. UMAPUMAP是一种新兴的降维和可视化算法,基于流形学习理论,主要用于结构化数据的可视化。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

hw1=a-repmat(m1,1,100) sw1=W'*hw1*hw1'*W hw2=b-repmat(m2,1,100) sw2=W'*hw1*hw1'*W sw=sw1+sw2;

7

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 9. 计算类间的方差

sb=W'*(m2-m1)*(m2-m1)'*W;

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 ⒈ 生成样本,随机产生两类样本,样本个数为5

a=rand(10000,100)*100

b=rand(10000,100)*100

1

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 2.全体样本矩阵 c=[a b]

2

2· 4 线性判别分析-LDA

11

2· 4 理 5. 计算样本特征 y=a(:,1)'*W*U

12

10

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 12. 计算投影矩阵 或者,先计算inv(sw),G=inv(sw)*sb [eigvector, eigvalue] = eig(G); eigvalue = diag(eigvalue); [junk, index] = sort(-eigvalue); eigvalue = eigvalue(index); eigvector =eigvector(:,index); U=eigvector(:,1:15);

2.4.3 高维样本降维处理 3. 计算全体样本的均值及总体方差

m=mean(c,2); ht1=c-repmat(m1,1,200); st=ht1'*ht1;

3

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 4. 计算投影矩阵

[eigvector, eigvalue] = eig(st); eigvalue = diag(eigvalue); [junk, index] = sort(-eigvalue); eigvalue = eigvalue(index); eigvector =eigvector(:,index); U=eigvector(:,1:200);

4

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 6. PCA所得投影阵为

W=c*eigvector

5

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 7. 计算样本的均值

m1=mean(a,2)

m2=mean(b,2)

6

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 8. 计算每类样本的类内方差

8

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 10. 计算投影矩阵

能使sw/sb最小化的投影矩阵;

9

2· 4 线性判别分析-LDA

2.4.3 高维样本降维处理 11. 计算投影矩阵

[eigvector, eigvalue] = eig(sw,sb); eigvalue = diag(eigvalue); [junk, index] = sort(eigvalue); eigvalue = eigvalue(index); eigvector =eigvector(:,index); U=eigvector(:,1:15);