非线性优化(例子)

5-非线性方程组的数值解法及最优化方法

非线性方程组的数值解法

不动点迭代法:根据非线性方程求根的迭代法,将方程组改 写为如下等价方程组

xi i x1, x2,, xn , i 1,2,, n

构造迭代公式

xik 1 i x1k , x2k ,, xnk , i 1,2,, n

非线性方程组的数值解法

若对任意A Cmn 都有一个实数 A 与之对应,且满足:

(1)非负性:当 A O 时, A 0 ;当A O 时,A 0;

(2)齐次性:对任何 C ,A A ;

(3)三角不等式:对任意 A, B C nn ,都有A B A B ;

(4)相容性:对任意A, B C nn ,都有 AB A B ,

…

…

18

(0.2325670051,0.0564515197)

19

(0.2325670051,0.0564515197)

max

1 i 2

xik

xik

1

0.2250 0.0546679688 0.0138638640 0.0032704648 0.0008430541 0.0001985303 0.0000519694 0.0000122370 0.0000032485 0.0000007649

10-9

非线性方程组的数值解法

练习题:用牛顿迭代法求解方程组

取 X 0 1.6,1.2T

xx1122

x22 x22

4 1

结果:1.5811,1.2247

非线性方程组的数值解法

应用经过海底一次反射到达水听器阵的特征声线传播时间, 来反演海底参数。假设水中和沉积层声速都是恒定的,海底 沉积层上界面水平,下界面倾斜。特征声线由水中声源出发 折射进入沉积层,经过沉积层的下界面反射后,再折射进入 水中,由水中水听器阵接收。特征声线的传播时间为声线在 水中和沉积层中的传播时间之和。 三维坐标关系如图所示:

数学中的优化与最优化问题

数学中的优化与最优化问题数学中的优化与最优化问题是数学领域中的一个重要研究方向。

本文将介绍优化和最优化问题的基本概念和方法,并通过实际案例来说明其在现实世界中的应用。

一、优化问题的概念与方法1.1 优化问题的定义在数学中,优化问题是指寻找函数的极值(最大值或最小值)的问题。

一般来说,优化问题可以表示为以下形式:$$\max f(x)$$或$$\min f(x)$$其中,$f(x)$为要优化的目标函数,$x$为自变量。

1.2 常用的优化方法常用的优化方法包括一维搜索、梯度下降、牛顿法和拟牛顿法等。

这些方法可以根据具体问题的特点选择合适的方法进行求解。

二、最优化问题的概念与方法最优化问题是优化问题的一个特例,它在满足一系列约束条件的前提下寻找目标函数的最优解。

最优化问题可以表示为以下形式:$$\max f(x)$$或$$\min f(x)$$约束条件为:$$g_i(x)\geq 0, i=1,2,\dots,m$$$$h_j(x)=0, j=1,2,\dots,n$$其中$g_i(x)$和$h_j(x)$为约束函数。

最优化问题可以分为线性最优化和非线性最优化两种情况。

2.1 线性最优化线性最优化问题是指目标函数和约束条件均为线性函数的最优化问题。

常用的求解线性最优化问题的方法有单纯形法和内点法等。

2.2 非线性最优化非线性最优化问题是指目标函数和约束条件至少有一个为非线性函数的最优化问题。

求解非线性最优化问题的方法较为复杂,常用的方法有梯度下降法、牛顿法和拟牛顿法等。

三、优化与最优化问题的应用优化和最优化问题在现实生活中有着广泛的应用。

以下是其中的一些例子:3.1 交通路径优化交通路径优化是指通过优化算法来寻找最短路径或最快路径,以减少交通拥堵和节约时间。

例如,在导航软件中,通过优化算法可以找到最短路径来指导驾驶员的行驶方向。

3.2 物流配送优化物流配送优化是指通过优化算法来确定最佳的物流配送路线,以提高物流效率和减少成本。

MATLAB优化工具箱--线性规划-非线性规划

linprog输入参数说明: f, A, b, Aeq, beq lb,ub 边界设置 说明: 如果x(i)无边界,则 lb(i) = -inf, ub(i) = inf

6

linprog 输出参数说明: x 决策变量取值 fval 目标函数最优值

exitflag > 0 成功找到最优解 0 达到最大迭代次数也没有找到最优解 < 0 该线性规划问题不可行或者linprog计

10

fmincon函数求解形如下面的有约束非线性规 划模型

一般形式:

min f ( X ) s.t. AX b

Aeq X beq l X u c(X ) 0 ceq ( X ) 0

Matlab求解有约束非线性最小化 1.约束中可以有等式约束 2.可以含线性、非线性约束均可

数学实验

输入参数语法:

例子:某农场种植两种作物A、B,需要甲、乙两种化肥。种植 每亩作物A和作物B分别需用的化肥数,可得利润及农场现有化

肥数量如下表所示:

问在现有条件下,如何安排种植,才能使利润最大?

作物

每亩所需化肥 (百公斤)

现有化肥

AB (百公斤)

化肥

甲

23

100) 6 4

数学实验

例题建模

[x,fval,exitflag,output,lambda]=fmincon(fun,x0,...)

数学实验

输入参数的几点说明

模型中如果没有A,b,Aeq,beq,lb,ub的限制,则以空矩阵[ ]作为 参数传入; nonlcon:如果包含非线性等式或不等式约束,则将这些函数

编写为一个Matlab函数, nonlcon就是定义这些函数的程序文件名;

3

数值分析中的非线性方程求解与优化

数值分析中的非线性方程求解与优化在数值分析领域中,非线性方程求解是一个重要的问题。

许多实际问题都可以被建模为非线性方程,而求解这些方程对于解决实际问题具有重要意义。

本文将介绍非线性方程求解的基本概念、方法和优化技术。

一、非线性方程求解的概念非线性方程是指方程中包含非线性项的方程。

与线性方程不同,非线性方程的解不再是一条直线,而是一条曲线或曲面。

非线性方程的求解是寻找方程中满足特定条件的变量值或函数的过程。

二、非线性方程求解的方法1. 迭代法迭代法是解决非线性方程求解问题中常用的方法。

迭代法的基本思想是通过不断逼近方程的解,使得迭代序列逐步收敛于方程的解。

常见的迭代法包括牛顿迭代法、割线法和弦截法等。

以牛顿迭代法为例,假设要求解方程f(x) = 0,首先选择一个初始估计值x0,然后通过迭代公式进行迭代计算直到满足收敛条件。

迭代公式为:xn+1 = xn - f(xn)/f'(xn),其中f'(xn)表示f(x)在xn处的导数。

2. 区间划分法区间划分法是通过将求解区间划分为若干个子区间,然后在每个子区间内搜索方程的解。

这种方法常用于求解具有多个解的非线性方程。

一般可以使用二分法、割线法和弦截法等算法进行区间划分和求解。

3. 优化技术优化技术常用于求解非线性方程的最优解。

在数值分析中,优化问题可以理解为寻找使得目标函数达到最大或最小值的变量值。

常用的优化算法包括梯度下降法、拟牛顿法和粒子群算法等。

这些算法通过迭代过程不断调整变量值,使得目标函数逐渐趋于最优解。

三、非线性方程求解与优化的应用非线性方程求解和优化技术在实际问题中具有广泛的应用。

以下是一些应用领域的例子:1. 工程领域:在工程设计中,需要求解非线性方程以确定优化的设计参数。

例如,在机械设计中,可以通过求解非线性方程来确定零件的几何尺寸和运动轨迹。

2. 金融领域:在金融衍生品定价和风险管理中,需要求解非线性方程来估计资产价格和风险敞口。

在Matlab中如何进行非线性优化

在Matlab中如何进行非线性优化非线性优化是数学中一个重要的领域,涉及到寻找使得目标函数取得最大或最小值的变量值的问题。

而Matlab作为一种强大的数学计算工具,提供了多种方法和工具来进行非线性优化任务的求解。

本文将介绍在Matlab中进行非线性优化的基本概念和常用方法,并通过实例演示其使用方法。

1. 优化问题的建模在进行非线性优化之前,首先需要将具体的优化问题转化为一个数学模型。

优化问题通常可以用以下公式表示:min f(x)s.t. g(x) <= 0h(x) = 0其中,f(x)是目标函数,表示要求解的问题的性能指标;g(x)和h(x)分别是不等式约束和等式约束函数。

x是一组待优化变量,通常是一个向量。

2. Matlab中的优化工具箱Matlab提供了专门的优化工具箱,其中包含了许多用于求解优化问题的函数和算法。

在使用这些工具之前,需要首先加载优化工具箱。

可以通过以下命令来实现:>> addpath('optim')接下来,我们将介绍一些常用的优化求解函数。

3. 无约束优化无约束优化是最简单的一种优化问题,即目标函数没有任何约束条件。

在Matlab中,可以使用fminunc函数求解无约束优化问题。

下面给出一个例子:>> fun = @(x) x(1)^2 + x(2)^2; % 目标函数是x1^2 + x2^2>> x0 = [0, 0]; % 初始点(x1=0, x2=0)>> [x, fval] = fminunc(fun, x0) % 求解优化问题在上述例子中,fun是目标函数的句柄,x0是初始点。

fminunc函数返回的x是优化问题的最优解,fval是目标函数在最优解处的取值。

4. 约束优化当优化问题存在约束条件时,可以使用fmincon函数进行求解。

fmincon函数需要提供目标函数、约束函数以及变量取值的上下界。

非线性最优化理论凸分析 (2)

非线性最优化理论与凸分析引言非线性最优化问题是数学领域中的重要课题之一,广泛应用于经济学、物理学、工程学等多个领域。

而凸分析作为非线性最优化理论的重要组成部分,提供了基础的理论和方法,用于解决非线性最优化问题。

本文将重点介绍非线性最优化理论和凸分析的基本概念、性质及其在实际问题中的应用。

非线性最优化问题基本概念非线性最优化问题可以形式化地表示为:$$ \\text{min} \\ f(x) \\quad \\text{subject to} \\quadg_i(x) \\leq 0, \\quad i = 1,2,...,m \\\\ h_j(x) = 0, \\quad j = 1,2,...,l $$其中,f(f)为目标函数,f f(f)和f f(f)为约束条件。

目标是在满足约束的条件下寻找使得目标函数最小化的变量f 的取值。

凸函数与凸集在凸分析中,凸函数和凸集是非常基础且重要的概念。

凸函数一个函数f(f)被称为凸函数,如果对于任意的 $x_1, x_2 \\in \\mathbb{R}^n$ 和 $t \\in [0, 1]$,满足以下条件:$$ f(tx_1 + (1-t)x_2) \\leq t f(x_1) + (1-t) f(x_2) $$即凸函数上的任意两点连线上的函数值不超过连线对应两点函数值的线性组合。

凸集对于向量集合 $C \\subset \\mathbb{R}^n$,如果对于任意的 $x_1, x_2 \\in C$ 和 $t \\in [0, 1]$,满足以下条件:$$ t x_1 + (1-t)x_2 \\in C $$则f被称为凸集。

即对于凸集f中的任意两点,它们之间的连线上的点仍属于f。

凸函数和凸集之间具有重要的联系,根据一定的条件,我们可以将凸优化问题转化为凸集上的最优化问题。

凸优化问题凸优化问题是指目标函数f(f)是凸函数,并且约束函数f f(f)和f f(f)构成的集合也是凸集的最优化问题。

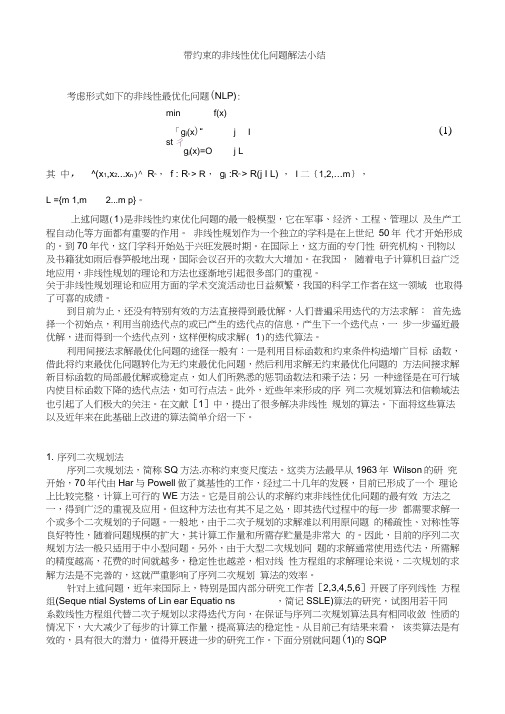

带约束的非线性优化问题解法小结

(1)带约束的非线性优化问题解法小结考虑形式如下的非线性最优化问题(NLP):min f(x)「g j (x )“ jI st 彳 g j (x)=O j L其 中, ^(x 1,x 2...x n )^ R n, f : R n > R , g j :R n > R(j I L) , I 二{1,2,…m }, L ={m 1,m 2...m p}。

上述问题(1)是非线性约束优化问题的最一般模型,它在军事、经济、工程、管理以 及生产工程自动化等方面都有重要的作用。

非线性规划作为一个独立的学科是在上世纪 50年 代才开始形成的。

到70年代,这门学科开始处于兴旺发展时期。

在国际上,这方面的专门性 研究机构、刊物以及书籍犹如雨后春笋般地出现,国际会议召开的次数大大增加。

在我国, 随着电子计算机日益广泛地应用,非线性规划的理论和方法也逐渐地引起很多部门的重视。

关于非线性规划理论和应用方面的学术交流活动也日益频繁,我国的科学工作者在这一领域 也取得了可喜的成绩。

到目前为止,还没有特别有效的方法直接得到最优解,人们普遍采用迭代的方法求解: 首先选择一个初始点,利用当前迭代点的或已产生的迭代点的信息,产生下一个迭代点,一 步一步逼近最优解,进而得到一个迭代点列,这样便构成求解( 1)的迭代算法。

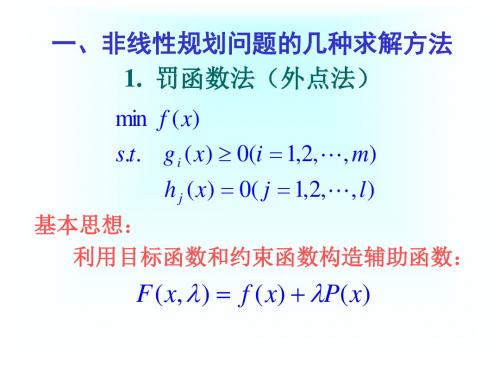

利用间接法求解最优化问题的途径一般有:一是利用目标函数和约束条件构造增广目标 函数,借此将约束最优化问题转化为无约束最优化问题,然后利用求解无约束最优化问题的 方法间接求解新目标函数的局部最优解或稳定点,如人们所熟悉的惩罚函数法和乘子法;另 一种途径是在可行域内使目标函数下降的迭代点法,如可行点法。

此外,近些年来形成的序 列二次规划算法和信赖域法也引起了人们极大的关注。

在文献[1]中,提出了很多解决非线性 规划的算法。

下面将这些算法以及近年来在此基础上改进的算法简单介绍一下。

1. 序列二次规划法序列二次规划法,简称SQ 方法.亦称约束变尺度法。

非线性优化一个曲线拟合(ceresg2o)

⾮线性优化⼀个曲线拟合(ceresg2o) 将代码和实际理论结合起来才能更好的理解理论上是怎么实现的,参考⽤⾼博⼗四讲的理论加实践亲⼿试⼀下,感觉公式和代码才能结合起来。

不能做到创新,⾄少做到了解和理解曲线拟合问题: 考虑这样⼀条曲线:y=exp(ax2+bx+c)+w,其中a,b,c为曲线的参数,w为⾼斯噪声,满⾜w=(0,σ2),假设有N个关于x,y的观测数据点,想根据这些数据点求出曲线的参数,(误差噪声)最⼩⼆乘min 我们⾸先明确我们要估计的变量是a,b,c这三个系数,思路是先根据模型⽣成x,y的真值,然后在真值中加⼊⾼斯分布的噪声。

随后使⽤⾼斯⽜顿法从带噪声的数据拟合参数模型。

定义误差为:{e_i} = {y_i} - \exp (ax_i^2 + b{x_i} + c),求取雅克⽐矩阵:{J_i} = \left[ {\begin{array}{*{20}{c}} {\frac{{\partial {e_i}}}{{\partial a}} = - x_i^2\exp (ax_i^2 + b{x_i} + c)}\\ {\frac{{\partial {e_i}}}{{\partial b}} = -{x_i}\exp (ax_i^2 + b{x_i} + c)}\\ {\frac{{\partial {e_i}}}{{\partial c}} = - \exp (ax_i^2 + b{x_i} + c)} \end{array}} \right]⾼斯⽜顿法的增量⽅程为:\left( {\sum\limits_{i = 1}^{100} {{J_i}{{({\sigma ^2})}^{ - 1}}{J_i}^T} } \right)\Delta {x_k} = \sum\limits_{i = 1}^{100} { - {J_i}{{({\sigma ^2})}^{ - 1}} {e_i}}1 #include <iostream>2 #include <chrono>3 #include <opencv2/opencv.hpp>4 #include <Eigen/Core>5 #include <Eigen/Dense>6using namespace cv;7using namespace std;8using namespace Eigen;910int main(int argc, char **argv) {11double ar = 1.0, br = 2.0, cr = 1.0; // 真实参数值12double ae = 2.0, be = -1.0, ce = 5.0; // 估计参数值,赋给⼀个初值,然后在这个初值的基础上进⾏变化量的迭代13int N = 100; // 数据点14double w_sigma = 1.0; // 噪声Sigma值15double inv_sigma = 1.0 / w_sigma; // 后⾯噪声1/(Sigma^2)值会⽤16 cv::RNG rng; // OpenCV随机数产⽣器1718 vector<double> x_data, y_data; // ⽤于拟合的观测数据19for (int i = 0; i < N; i++) {20double x = i / 100.0;21 x_data.push_back(x);22 y_data.push_back(exp(ar * x * x + br * x + cr) + rng.gaussian(w_sigma * w_sigma));23 }2425// 开始Gauss-Newton迭代26int iterations = 100; // 迭代次数27double cost = 0, lastCost = 0; // 本次迭代的cost和上⼀次迭代的cost最⼩⼆乘值,通过此值衡量迭代是否到位,进⾏终⽌2829 chrono::steady_clock::time_point t1 = chrono::steady_clock::now();//计算迭代时间⽤30for (int iter = 0; iter < iterations; iter++) {3132 Matrix3d H = Matrix3d::Zero(); // Hessian = J^T W^{-1} J in Gauss-Newton33 Vector3d b = Vector3d::Zero(); // bias34 cost = 0;3536for (int i = 0; i < N; i++) {37double xi = x_data[i], yi = y_data[i]; // 第i个数据点38double error = yi - exp(ae * xi * xi + be * xi + ce);39 Vector3d J; // 雅可⽐矩阵40 J[0] = -xi * xi * exp(ae * xi * xi + be * xi + ce); // de/da41 J[1] = -xi * exp(ae * xi * xi + be * xi + ce); // de/db42 J[2] = -exp(ae * xi * xi + be * xi + ce); // de/dc4344 H += inv_sigma * inv_sigma * J * J.transpose();//构造Hx=b45 b += -inv_sigma * inv_sigma * error * J;4647 cost += error * error;//计算最⼩⼆乘结果,看是否是最⼩的48 }4950// 求解线性⽅程 Hx=b51 Vector3d dx = H.ldlt().solve(b);52if (isnan(dx[0])) {53 cout << "result is nan!" << endl;54break;55 }5657if (iter > 0 && cost >= lastCost) {58 cout << "cost: " << cost << ">= last cost: " << lastCost << ", break." << endl;59break;60 }6162 ae += dx[0];//更新迭代量,继续迭代寻找最优值63 be += dx[1];64 ce += dx[2];6566 lastCost = cost;6768 cout << "total cost: " << cost << ", \t\tupdate: " << dx.transpose() <<69"\t\testimated params: " << ae << "," << be << "," << ce << endl;70 }7172 chrono::steady_clock::time_point t2 = chrono::steady_clock::now();73 chrono::duration<double> time_used = chrono::duration_cast<chrono::duration<double>>(t2 - t1);//给出优化⽤时74 cout << "solve time cost = " << time_used.count() << " seconds. " << endl;7576 cout << "estimated abc = " << ae << ", " << be << ", " << ce << endl;77 waitKey(0);78return0;7980 }同样的问题⽤ceres库进⾏曲线拟合,迭代和求解过程就可以通过ceres的模板库来操作1 #include <iostream>2 #include <opencv2/core/core.hpp>3 #include <ceres/ceres.h>4 #include <chrono>56using namespace std;78// 代价函数的计算模型9struct CURVE_FITTING_COST10 {11 CURVE_FITTING_COST ( double x, double y ) : _x ( x ), _y ( y ) {}12// 残差的计算13 template <typename T>14bool operator() (15const T* const abc, // 模型参数,有3维,也就是要要优化的参数块,16 T* residual ) const// 残差17 {18 residual[0] = T ( _y ) - ceres::exp ( abc[0]*T ( _x ) *T ( _x ) + abc[1]*T ( _x ) + abc[2] ); // y-exp(ax^2+bx+c) 19return true;20 }21const double _x, _y; // x,y数据22 };2324int main ( int argc, char** argv )25 {26double a=1.0, b=2.0, c=1.0; // 真实参数值27int N=100; // 数据点28double w_sigma=1.0; // 噪声Sigma值29 cv::RNG rng; // OpenCV随机数产⽣器30double abc[3] = {0,0,0}; // abc参数的估计值,这⾥初始化为03132 vector<double> x_data, y_data; // 定义观测数据3334 cout<<"generating data: "<<endl;35for ( int i=0; i<N; i++ )36 {37double x = i/100.0;38 x_data.push_back ( x );39 y_data.push_back (40 exp ( a*x*x + b*x + c ) + rng.gaussian ( w_sigma )41 );42 cout<<x_data[i]<<""<<y_data[i]<<endl;//产⽣观测数据43 }4445// 构建最⼩⼆乘问题46 ceres::Problem problem;47for ( int i=0; i<N; i++ )48 {49 problem.AddResidualBlock ( // 向问题中添加误差项50// 使⽤⾃动求导,模板参数:误差类型,输出维度,输⼊维度,维数要与前⾯struct中⼀致51new ceres::AutoDiffCostFunction<CURVE_FITTING_COST, 1, 3> (52new CURVE_FITTING_COST ( x_data[i], y_data[i] )// 观测数据53 ),54 nullptr, // 核函数,这⾥不使⽤,为空55 abc // 待估计参数56 );57 }5859// 配置求解器60 ceres::Solver::Options options; // 这⾥有很多配置项可以填61 options.linear_solver_type = ceres::DENSE_QR; // 增量⽅程如何求解62 options.minimizer_progress_to_stdout = true; // 输出到cout6364 ceres::Solver::Summary summary; // 优化信息65 chrono::steady_clock::time_point t1 = chrono::steady_clock::now();66 ceres::Solve ( options, &problem, &summary ); // 开始优化67 chrono::steady_clock::time_point t2 = chrono::steady_clock::now();68 chrono::duration<double> time_used = chrono::duration_cast<chrono::duration<double>>( t2-t1 );69 cout<<"solve time cost = "<<time_used.count()<<" seconds. "<<endl;7071// 输出结果72 cout<<summary.BriefReport() <<endl;73 cout<<"estimated a,b,c = ";74for ( auto a:abc ) cout<<a<<"";75 cout<<endl;7677return0;78 }图优化(g2o)进⾏曲线拟合参照细细看,多看⼏遍中间的来龙去脉1 #include <iostream>2 #include <g2o/core/base_vertex.h>3 #include <g2o/core/base_unary_edge.h>4 #include <g2o/core/block_solver.h>5 #include <g2o/core/optimization_algorithm_levenberg.h>6 #include <g2o/core/optimization_algorithm_gauss_newton.h>7 #include <g2o/core/optimization_algorithm_dogleg.h>8 #include <g2o/solvers/dense/linear_solver_dense.h>9 #include <Eigen/Core>10 #include <opencv2/core/core.hpp>11 #include <cmath>12 #include <chrono>13using namespace std;1415// 曲线模型的顶点,模板参数:优化变量维度和数据类型16class CurveFittingVertex: public g2o::BaseVertex<3, Eigen::Vector3d>17 {18public:19 EIGEN_MAKE_ALIGNED_OPERATOR_NEW20virtual void setToOriginImpl() // 重置21 {22 _estimate << 0,0,0;23 }2425virtual void oplusImpl( const double* update ) // 更新26 {27 _estimate += Eigen::Vector3d(update);28 }29// 存盘和读盘:留空30virtual bool read( istream& in ) {}31virtual bool write( ostream& out ) const {}32 };3334// 误差模型模板参数:观测值维度,类型,连接顶点类型35class CurveFittingEdge: public g2o::BaseUnaryEdge<1,double,CurveFittingVertex>36 {37public:38 EIGEN_MAKE_ALIGNED_OPERATOR_NEW39 CurveFittingEdge( double x ): BaseUnaryEdge(), _x(x) {}40// 计算曲线模型误差41void computeError()42 {43const CurveFittingVertex* v = static_cast<const CurveFittingVertex*> (_vertices[0]);44const Eigen::Vector3d abc = v->estimate();45 _error(0,0) = _measurement - std::exp( abc(0,0)*_x*_x + abc(1,0)*_x + abc(2,0) ) ;46 }47virtual bool read( istream& in ) {}48virtual bool write( ostream& out ) const {}49public:50double _x; // x 值, y 值为 _measurement51 };5253int main( int argc, char** argv )54 {55double a=1.0, b=2.0, c=1.0; // 真实参数值56int N=100; // 数据点57double w_sigma=1.0; // 噪声Sigma值58 cv::RNG rng; // OpenCV随机数产⽣器59double abc[3] = {0,0,0}; // abc参数的估计值6061 vector<double> x_data, y_data; // 数据6263 cout<<"generating data: "<<endl;64for ( int i=0; i<N; i++ )65 {66double x = i/100.0;67 x_data.push_back ( x );68 y_data.push_back (69 exp ( a*x*x + b*x + c ) + rng.gaussian ( w_sigma )70 );71 cout<<x_data[i]<<""<<y_data[i]<<endl;72 }7374// 构建图优化,先设定g2o75 typedef g2o::BlockSolver< g2o::BlockSolverTraits<3,1> > Block; // 每个误差项优化变量维度为3,误差值维度为176 Block::LinearSolverType* linearSolver = new g2o::LinearSolverDense<Block::PoseMatrixType>(); // 线性⽅程求解器77 Block* solver_ptr = new Block( linearSolver ); // 矩阵块求解器78// 梯度下降⽅法,从GN, LM, DogLeg 中选79 g2o::OptimizationAlgorithmLevenberg* solver = new g2o::OptimizationAlgorithmLevenberg( solver_ptr );80// g2o::OptimizationAlgorithmGaussNewton* solver = new g2o::OptimizationAlgorithmGaussNewton( solver_ptr );81// g2o::OptimizationAlgorithmDogleg* solver = new g2o::OptimizationAlgorithmDogleg( solver_ptr );82 g2o::SparseOptimizer optimizer; // 图模型83 optimizer.setAlgorithm( solver ); // 设置求解器84 optimizer.setVerbose( true ); // 打开调试输出8586// 往图中增加顶点87 CurveFittingVertex* v = new CurveFittingVertex();88 v->setEstimate( Eigen::Vector3d(0,0,0) );89 v->setId(0);90 optimizer.addVertex( v );9192// 往图中增加边93for ( int i=0; i<N; i++ )94 {95 CurveFittingEdge* edge = new CurveFittingEdge( x_data[i] );96 edge->setId(i);97 edge->setVertex( 0, v ); // 设置连接的顶点98 edge->setMeasurement( y_data[i] ); // 观测数值99 edge->setInformation( Eigen::Matrix<double,1,1>::Identity()*1/(w_sigma*w_sigma) ); // 信息矩阵:协⽅差矩阵之逆100 optimizer.addEdge( edge );101 }102103// 执⾏优化104 cout<<"start optimization"<<endl;105 chrono::steady_clock::time_point t1 = chrono::steady_clock::now();106 optimizer.initializeOptimization();107 optimizer.optimize(100);108 chrono::steady_clock::time_point t2 = chrono::steady_clock::now();109 chrono::duration<double> time_used = chrono::duration_cast<chrono::duration<double>>( t2-t1 );110 cout<<"solve time cost = "<<time_used.count()<<" seconds. "<<endl;111112// 输出优化值113 Eigen::Vector3d abc_estimate = v->estimate();114 cout<<"estimated model: "<<abc_estimate.transpose()<<endl;115116return0;117 }Loading [MathJax]/jax/element/mml/optable/BasicLatin.js。

非线性方程组求解方法的比较与优化

非线性方程组求解方法的比较与优化非线性方程组的求解在科学计算、工程领域以及其他许多实际问题中扮演着重要的角色。

在实际应用中,往往需要高效准确地求解非线性方程组,以获得所需的结果。

本文将对几种常用的非线性方程组求解方法进行比较,并探讨如何进一步优化这些方法,以提高求解效率。

一、牛顿法(Newton's Method)牛顿法是最常用的非线性方程组求解方法之一。

该方法基于泰勒级数展开,通过迭代逼近非线性方程组的解。

具体而言,给定初始猜测值x0,牛顿法通过以下迭代公式进行求解:x^(k+1) = x^k - [J(x^k)]^(-1) * F(x^k)其中,J(x^k)表示方程组F(x)的雅可比矩阵,F(x^k)表示方程组的值向量。

牛顿法通常具有快速收敛的特点,但在某些情况下可能出现发散或收敛速度慢的问题。

二、拟牛顿法(Quasi-Newton Methods)拟牛顿法是对牛顿法的改进和优化。

由于求解雅可比矩阵的逆矩阵相对困难且计算量大,拟牛顿法通过逼近雅可比矩阵的逆矩阵,避免了对逆矩阵的直接求解。

其中,最著名的拟牛顿法是DFP算法和BFGS算法。

DFP算法通过计算Hessian矩阵的逆矩阵的逼近,不断更新该逼近矩阵,以逼近真实的Hessian矩阵的逆矩阵。

BFGS算法同样通过逼近矩阵的更新来求解方程组,但采用了更加复杂的更新策略,相较于DFP算法在某些问题上具有更好的性能。

拟牛顿法通过避免直接计算逆矩阵,一定程度上提高了计算效率,但其迭代过程中的计算相对复杂,因此在实际问题中需要综合考虑。

三、Levenberg-Marquardt算法Levenberg-Marquardt算法是一种解决非线性最小二乘问题的方法,也可用于求解非线性方程组。

该算法基于牛顿法,利用信赖域思想进行调整,以提高求解的稳定性和收敛性。

Levenberg-Marquardt算法通过在牛顿迭代中引入一个参数,将其视为步长的控制因子,从而在迭代过程中实现步长的自适应调整。

kkt条件 例题

kkt条件例题

Kuhn-Tucker条件(KKT条件)是用于求解非线性规划问题的最优化方法之一。

以下是一个简单的Kuhn-Tucker条件的例题:

例题:假设我们有一个函数f(x, y) = x^2 + y^2,需要找到该函数的最小值点。

约束条件是x + y = 1。

首先,我们可以将问题表示为以下形式:

minimize: f(x, y) = x^2 + y^2

subject to: x + y = 1

为了应用Kuhn-Tucker条件,我们需要引入拉格朗日乘数λ,并构建拉格朗日函数L(x, y, λ) = x^2 + y^2 + λ(x + y - 1)。

接下来,我们将分别求L关于x、y和λ的偏导数,然后解得最优解。

根据Kuhn-Tucker条件,最优解必须满足以下条件:

1. L关于x的偏导数等于0,即2x + λ = 0。

2. L关于y的偏导数等于0,即2y + λ = 0。

3. L关于λ的偏导数等于0,即x + y - 1 = 0。

通过解以上三个方程,我们可以得到最优解为x = -1/3, y = 2/3, λ = -2/3。

因此,函数f(x, y)在点(-1/3, 2/3)处取得最小值。

这个例子展示了如何使用Kuhn-Tucker条件求解一个简单的非线性规划问题。

在实际应用中,可能需要考虑更复杂的函数和约束条件,但基本思路是类似的。

非线性规划问题的求解方法

运行输出:

最优解 1.00012815099165 -0.00000145071779

k= 33

练习题:

1、用外点法求解下列模型

min( x12 2x22 ) s.t. x1 x2 1

2、将例子程序改写为一个较为通用的罚函数 法程序。(考虑要提供哪些参数)

2. 内点法(障碍函数法)

min f (x) s.t. gi (x) 0,i 1,2,, m

第二步:求 (k) 最优的目标函数

function r=fungetlamada(lamada) %关于lamada的一元函数,求最优步长 global x0 d=fun1gra(x0); r=2*(x0(1)-lamada*d(1))^2+(x0(2)lamada*d(2))^2; %注意负号表示是负梯度

a 1, b 1 ,a,b 为常数,通常取 a=b=2。

算法步骤

(1)给定初始点 x(0),初始罚因子 (1) , 放大系数 c>1;允许误差 e>0,设置 k=1;

(2)以 x(k-1)作为搜索初始点,求解无约束规划问题 min f (x) P(x) ,令 x(k)为所求极小点。

lamada=fminsearch(‘fungetlamada’,la mada);%求最优步长lamada

x0=x0-lamada*fun1gra(x0);%计算x0 d=fun1gra(x0);%计算梯度 k=k+1;%迭代次数

end

disp('x='),disp(x0),disp('k='),disp (k),disp('funobj='),disp(2*x0(1)^2+ x0(2)^2)

化工过程最优化 非线性规划

A)试求最优的操作压力 P 和循环比 R, 使每年总费用为 最小; 操作费用=加压所需费用+产物分离费用+ 循环费用 =

目标: min(

)

优化模型属于无约束的最优化

(b) 若要求的 P 和 R 乘积为 900MPa, 试求最优的 P 和 R。

操作费用=加压所需费用+产物分离费用+ 循环费用 =

目标:

有无约束极值必要条件得 ∂P µ 2 = ( x1 + 1) − =0 2 ∂x1 ( x1 − 1) ∂P µ = 1− 2 = 0 ∂x2 x2 解上式方程组得 x = ( x1 , x2 )T = ( 1 + µ , µ )T

k 1 2 3 4 5

µ

x1 1 1.414213562

x2 1

上述例子: min( s.t. : PR=900

)

建立拉格朗日函数:

φ对p和R求导数,并令其为零, 得

求解以上三个方程得到, P=1500, R=6,λ=117.3

求φ在点(1500, 6)对p和R 二阶导数, 同样可以证明 赫森矩阵为正定,因而此点也为极小点。

2 罚函数法 罚函数法(Penalty Function Method)属于序列无约束 最优化方法。 其基本策略是,依据约束的特点构造某种“惩罚”函数, 并加到目标函数上,使得约束问题转化为一系列无约束问 题来求解。 对于在无约束问题求解过程中企图违反约束的那些迭代点 给于很的目标函数值,迫使该系列无约束问题的极小点或 者无限制地向可行域靠近,或者一直保持在可行域内移动, 直到收敛于原问题的极小点。

F1 设备1 F 设备2 F3 设备3 Fi=ai * F ∑ai=1 ai》0 F2

化工过程优化MIP问题的一般形式

视觉SLAM十四讲-第六讲-非线性优化说课讲解

• 能否回避Hessian的计算?

• Gauss-Newton • Levenberg-Marquadt

20 6.2 非线性最小二乘

• Gauss-Newton

• 一阶近似 f(x): • 平方误差变为:

4 第六讲 非线性优化

• 上讲回顾

• 三维世界中刚体运动的描述:旋转矩阵、旋转向量、欧拉角、四元数等。 • 观测:相机投影模型。

在给定模型和具体观测时,如何对估计 进行优化?

5

6.1状态估计问题

6 6.1状态估计问题

• 状态估计问题

• 最简单情况:线性系统,高斯噪声 • 复杂情况:非线性系统,非高斯噪声

• 该问题有何结构?

• 由许多个误差的平方和(或Sigma范数和)组成。 • 虽然总体维度高,但每个项很简单,只关联2个变量。 • 如果用李代数表达位姿,那么是无约束优化问题。

• 如何求解?

• 下面先来介绍通用的非线性最小二乘问题。

14

6.2 非线性最小二乘

15 6.2 非线性最小二乘

• 先考虑简单的问题:

7 6.1状态估计问题

• 历史上很长一段时间使用滤波器求解状态估计 • 但近年非线性优化已成为主流 • 我们首先来分析一下如何从概率角度看待此问题

8 6.1状态估计问题

• 状态变量(所有待求解的量)

• 状态估计等同于求解条件分布:

类似的,这里z,u也是统称

• 考虑更简单的情况:只有观测时,类似于Structure from Motion (SfM)

这里

• 当 f 很简单时:

• 解:

第三章非线性规划无约束问题的最优化方法

x0

0p 0

1.919877 还需要经过10次迭代才

能满足精度要求

0.003070

第三节 牛顿法

3. 牛顿法的缺点: 牛顿法要求初始解离最优解不远,若初始点选得离最优解太

远时,牛顿法并不能保证其收敛,甚至也不是下降方向。因此, 常将牛顿法与最速下降法结合起来使用。前期使用最速下降法, 当迭代到一定程度后,改用牛顿法,可得到较好的效果。 4. 修正牛顿法 基本思想: 保留了从牛顿法中选取牛顿方向作为搜索方向,摒弃其步长恒 为1的做法,而用一维搜索确定最优步长来构造算法。

2

2

0

2e2 2 3

00 21 0

03

f x3 9

第二节 最速下降法

再从x(3)点 出发,沿x3轴方向e3进行一维搜索:

0 x 3 e3 0

3

00 00 13

f x 3 e3

32

f' 0 x4 x3

3

3

0

3e3 0 0

f x4 0

第二节 最速下降法

因为 x 1

x 4 ,0故.0以1 x(4)点作为新的x(1) ,进行新一轮迭代。

0

1 33 22

f x0

p0

52 5

42

f' x0

p0 5 5 0

22

01

第三节 牛顿法

x1 x0

1 p0 3

2

3

f x1

14

12 2

0

30

12 1 2

2

f x1

所以选取 x* x 1

1 3 作为极小点。 2

第三节 牛顿法

6. 修正牛顿法的缺点: 修正牛顿法虽然比牛顿法有所改进,但也有不足之处:

关于非线性优化fminbnd函数的说明

关于非线性优化fminbnd函数的说明(仅供新手参考)(也可作为fmincon函数的参考)2011-04-20 22:09关于非线性优化fminbnd函数的说明(仅供新手参考)/thread-757055-1-1.html初学matlab优化,迭代中止后,经常一头雾水。

参看帮助后仍似懂非懂。

下面关于fminbnd 函数的说明(也可作为fmincon函数的参考)对于新手也许会有帮助,不当之处请指正。

目标函数fun:需要最小化的目标函数。

fun函数需要输入标量参数x,返回x处的目标函数标量值f。

可以将fun函数指定为命令行,如x = fminbnd(inline('sin(x*x)'),x0)同样,fun参数可以是一个包含函数名的字符串。

对应的函数可以是M文件、内部函数或MEX文件。

若fun='myfun',则M文件函数myfun.m必须有下面的形式:function f = myfun(x)f = ... %计算x处的函数值。

若fun函数的梯度可以算得,且options.GradObj设为'on'(用下式设定),options = optimset('GradObj','on')则fun函数必须返回解x处的梯度向量g到第二个输出变量中去。

注意,当被调用的fun 函数只需要一个输出变量时(如算法只需要目标函数的值而不需要其梯度值时),可以通过核对nargout的值来避免计算梯度值。

function [f,g] = myfun(x)f = ... %计算x处得函数值。

if nargout > 1 %调用fun函数并要求有两个输出变量。

g = ... %计算x处的梯度值。

end若Hessian矩阵也可以求得,并且options.Hessian设为'on',即,options = optimset('Hessian','on')则fun函数必须返回解x处的Hessian对称矩阵H到第三个输出变量中去。

非线性优化在组合优化中的应用

非线性优化在组合优化中的应用在当今科技飞速发展的时代,优化问题在各个领域中都扮演着至关重要的角色。

从物流运输的路径规划,到生产流程的资源分配,再到金融投资的策略制定,都离不开优化方法的运用。

而在优化领域中,非线性优化和组合优化是两个重要的分支,它们的交叉应用为解决复杂的实际问题提供了强有力的工具。

首先,让我们来了解一下什么是非线性优化和组合优化。

非线性优化是指目标函数或约束条件中包含非线性函数的优化问题。

这与线性优化形成鲜明对比,在线性优化中,目标函数和约束条件都是线性的。

而非线性优化问题通常更加复杂,求解难度也更大。

组合优化则是在给定的有限集合中寻找最优元素组合的问题。

这些问题的解空间通常是离散的,并且可能具有指数级的规模。

那么,非线性优化在组合优化中究竟有哪些应用呢?一个常见的例子是旅行商问题(Travelling Salesman Problem,TSP)。

在这个问题中,一个推销员需要访问若干个城市,并且每个城市只能访问一次,最后回到出发城市。

目标是找到一条最短的路径。

这是一个典型的组合优化问题,因为解是城市的访问顺序组合。

然而,我们可以将其转化为一个非线性优化问题。

例如,我们可以定义一个连续变量来表示城市之间的访问顺序,然后通过一些约束条件来确保每个城市只被访问一次。

通过这样的转化,我们就可以利用非线性优化的方法来求解旅行商问题。

再比如,背包问题(Knapsack Problem)也是一个经典的组合优化问题。

给定一组物品,每个物品都有一定的价值和重量,以及一个背包的最大承载重量。

问题是选择哪些物品放入背包,使得背包中物品的总价值最大。

我们同样可以将其构建为一个非线性优化问题。

通过定义合适的变量和约束条件,利用非线性优化的算法来寻找最优解。

在实际应用中,非线性优化为组合优化问题的求解带来了许多优势。

一方面,非线性优化方法具有更强大的表达能力,能够更好地处理复杂的约束条件和目标函数。

例如,在一些组合优化问题中,可能存在非线性的成本函数或者与时间、空间相关的复杂约束。

非线性优化方法及其应用

非线性优化方法及其应用随着计算机技术的不断发展,各行各业都在不断地寻找更加高效的解决方案。

其中,优化问题是无处不在的。

所谓优化问题,就是在一定的限制条件下,求得某一目标函数的最大值或最小值。

而非线性优化方法,就是针对目标函数为非线性函数的优化问题而提出的一种方法。

非线性优化方法主要分为两种:确定性方法和随机性方法。

确定性方法主要包括牛顿法、拟牛顿法、共轭梯度法等。

随机性方法则包括遗传算法、模拟退火算法等。

以下将简要介绍其中牛顿法和遗传算法两种优化方法及其应用。

牛顿法是一种基于一阶二阶导数的确定性方法。

其主要思想是通过一阶和二阶导数的信息来近似地求得函数的极值点。

具体来说,牛顿法在求得函数的极值点时,是通过对目标函数进行泰勒展开,然后利用泰勒展开式的一阶和二阶导数来求得极值点的。

牛顿法的优点在于其求解速度非常快,但缺点也同样很明显,主要体现在数值稳定性上。

当目标函数有很多局部极值点,还可能陷入局部最小值而不能找到全局最优解。

遗传算法则是一种基于模拟进化的随机性方法。

它模拟生物进化的过程,通过选择,交叉和变异等操作来产生更加优异的个体,以最终得到目标函数的最优解。

在遗传算法中,每个个体都是由一组基因表示的,并且每组基因都可以取不同的值。

算法的主要流程包括种群的初始化,个体的选择,交叉和突变操作。

其中,种群的初始化是先随机产生一组个体,这些个体是由一组随机生成的基因序列组成的。

接着,进行适应度函数的计算,选出一部分适应度较强的个体进行交叉和突变操作,最终得到下一代更加优异的个体。

遗传算法的优点在于其具有很好的鲁棒性,能够有效地避免陷入局部极值点。

但由于算法的随机性,其求解效率比较低且不稳定。

非线性优化方法的应用非常广泛,涉及到数学、物理、生物学等各个领域。

举个例子,对于物理学中的力学系统问题,比如弹性力学问题,可以通过非线性优化方法求解,得到最稳定且能量最小的解决方案。

同样,在生物学中,对于蛋白质结构预测问题也可以通过非线性优化方法来求解。

barzilar-borwein方法例题解析

barzilar-borwein方法例题解析Barzilai-Borwein 方法是一种非线性优化算法,用于求解无约束优化问题。

它基于近似计算函数梯度,通过迭代来更新变量的取值,使得目标函数在变量取值点上的下降方向与真正的负梯度方向非常接近。

下面我们来看一个例子,详细解析 Barzilai-Borwein 方法的应用:假设我们要最小化函数 f(x) = x^2,在 x_0 = 5 的初始点开始迭代求解,使用 Barzilai-Borwein 方法。

1. 初始化步长 alpha_0 = 0.1。

这个步长可以根据经验设置,一般取一个较小的值。

2. 计算初始点的梯度 g_0 = 2 * x_0 = 2 * 5 = 10。

梯度是目标函数相对于变量的变化率,用来指导下降方向。

3. 在当前点 x_0 = 5 上计算下一个迭代点 x_1。

x_1 = x_0 - alpha_0 * g_0 = 5 - 0.1 * 10 = 4。

4. 计算新的步长 alpha_1。

alpha_1 = (x_1 - x_0) * (g_1 - g_0) / (g_1^2 - g_0^2),其中,g_1 = 2 * x_1 = 2 * 4 = 8 是在 x_1 上的梯度值。

alpha_1 = (4 - 5) * (8 - 10) / (8^2 - 10^2) = 0.1。

5. 在当前点 x_1 = 4 上计算下一个迭代点 x_2。

x_2 = x_1 - alpha_1 * g_1 = 4 - 0.1 * 8 = 3.2。

6. 重复步骤 4 和步骤 5,直到满足停止条件,例如迭代次数达到预设的最大值或目标函数收敛到一个较小的值。

通过不断迭代更新变量的取值,Barzilai-Borwein 方法可以有效地找到函数的最小值。

每次迭代的计算量较小,因此该方法在求解大规模问题时具有一定的优势。

需要注意的是,Barzilai-Borwein 方法在某些非凸优化问题上可能会出现收敛到局部最小值的情况。