显卡帝手把手教你读懂GPU架构图

GPU架构与技术详解

GPU架构与技术详解在计算机科学领域中,GPU(Graphics Processing Unit,图形处理器)是一种高性能的并行处理器,专门用于处理图形和影像数据。

GPU架构和技术是GPU的核心部分,是其能够实现高性能并行计算的基础,下面将详细介绍GPU架构和技术。

一、GPU架构1.传统的固定管线架构:-传统的固定管线架构是指,GPU的硬件流水线是由多个固定功能单元组成的,包括顶点处理单元、光栅化单元、像素处理单元等。

这种架构适用于以图形渲染为主的应用,但对于一些通用计算任务来说效率较低。

2.可编程管线架构:-可编程管线架构是指,GPU的硬件流水线可以根据应用的需求进行动态配置和编程。

这种架构使得GPU能够处理更加复杂的图形和计算任务,提高了其灵活性和性能。

3.统一架构:- 统一架构是可编程管线架构的演化,它将GPU的顶点处理和像素处理合并为一个可编程的流处理器(Streaming Processor)。

这样一来,GPU可以根据任务需求动态分配处理资源,从而提高性能和灵活性。

4.并行处理架构:-并行处理架构是指GPU利用多个流处理器并行处理任务。

在这种架构下,每个流处理器都可以独立执行计算任务,从而实现高性能的并行计算。

二、GPU技术1.CUDA:2. OpenCL:3. Vulkan:- Vulkan是一种跨平台的图形和计算API,可以实现高性能的图形渲染和并行计算。

Vulkan具有低延迟、高吞吐量和低CPU开销等特点,适用于对性能要求较高的应用,如游戏开发、虚拟现实等。

4.光线追踪:-光线追踪是一种先进的图形渲染技术,它可以模拟光线在物体表面上的反射和折射,从而实现更加真实的图形效果。

GPU的并行计算能力使得光线追踪技术能够得到更好的应用和加速。

5.深度学习:-近年来,GPU的并行处理能力在深度学习领域得到了广泛的应用。

GPU能够高效地进行矩阵乘法等基本计算操作,并且具备大规模并行处理的能力,因此成为了深度学习训练和推理的重要工具。

GPU架构与技术详解

GPU架构与技术详解GPU(Graphics Processing Unit)是一种专门用于处理图形计算的处理器。

GPU的架构与技术一直是图形学和计算机科学研究的重要分支。

本文将从宏观和微观两个层面,详细讲解GPU的架构及相关技术。

一、GPU的宏观架构GPU的宏观架构分为三个部分:处理器、显存和外部接口。

1.处理器GPU内部的处理器架构,主要分为SIMD(Single Instruction Multiple Data)和MIMD(Multiple Instruction Multiple Data)两种。

SIMD在处理数据时仅使用一种指令并且把数据分成多个数据段。

而MIMD则使用不同的指令处理不同的数据,每个线程可以独立运作,相互之间互不干扰。

同时,GPU中的处理器也分为标量、向量和矩阵处理器。

标量是最基本的处理器,向量处理器则可以同时处理多个相同类型的向量数据。

矩阵处理器则适用于大规模矩阵计算,是GPU计算高性能的核心部件。

2.显存GPU的显存是一种特殊的内存,它是专门为图形处理而设计的,并采用非常高效的访问方式。

显存的带宽比普通内存大几倍,使GPU能够更快速地访问和处理图形数据。

同时,显存还采用了多通道和多级缓存技术,进一步提高了图形渲染和计算性能。

3.外部接口GPU的外部接口通常包括PCI-Express和AGP。

PCI-Express是目前最常见的GPU外部接口,它提供高速的数据传输,能够满足大多数应用场景的需求。

而AGP则较少使用,在一些较老的计算机中还可以见到。

二、GPU的微观架构GPU的微观架构主要包括计算单元、纹理单元和像素单元三个部分。

1.计算单元计算单元是GPU中最基本的部件,它主要负责整数和浮点数的计算。

计算单元包括SIMD处理器、标量处理器、向量处理器和矩阵处理器。

计算单元在执行计算任务时,需要高质量的处理器设计,如各种运算单元、指令管理单元、调度单元和寄存器文件等。

2.纹理单元纹理单元是GPU中的特殊部件,它主要负责处理图像数据。

了解电脑显卡中的GPU架构

了解电脑显卡中的GPU架构随着计算机技术的不断发展,电脑显卡已经成为了现代计算机中不可或缺的组件之一。

而在显卡中,GPU(图形处理器)架构则显得尤为重要。

本文将探讨GPU架构的概念、功能以及不同类型的GPU架构。

一、什么是GPU架构GPU架构是指在电脑显卡中用于处理图形和图像数据的架构。

它是显卡的核心组成部分,负责处理和加速计算机图形渲染、3D游戏以及其他图形相关的计算任务。

二、GPU架构的功能1. 并行计算能力:GPU架构具有强大的并行处理能力,能够同时处理多个任务和数据。

与传统的中央处理器(CPU)相比,GPU可以同时处理数百个线程,大大提高了图形处理的效率。

2. 图形渲染:GPU架构专注于图形渲染任务,可以加速计算机中的图形显示。

通过优化渲染算法和提高处理器的时钟频率,GPU可以实现流畅的图形效果和更快的画面刷新率。

3. 通用计算能力:除了图形渲染,现代的GPU架构还具备通用计算能力。

通过开发适用的计算框架和编程模型,GPU可以处理各种复杂的计算任务,如物理模拟、机器学习等。

三、不同类型的GPU架构1. NVIDIA的CUDA架构:CUDA(Compute Unified Device Architecture)是NVIDIA推出的一种GPU计算架构。

它采用了SIMD (Single Instruction, Multiple Data)并行计算模型,并集成了大量的高速缓存和计算单元。

CUDA架构在科学计算和深度学习等领域取得了显著的成果。

2. AMD的GCN架构:GCN(Graphics Core Next)是AMD开发的GPU架构,专注于图形处理和通用计算。

它采用了多核心和多指令流的设计,支持高性能计算和异构计算。

3. 英伟达的Turing架构:Turing架构是英伟达最新的GPU架构,于2018年发布。

它引入了RT Core(用于光线追踪)和Tensor Core (用于深度学习)等新技术,大幅提升了图形渲染和人工智能计算的性能。

解析电脑显卡的核心架构

解析电脑显卡的核心架构电脑显卡是现代电脑中一个非常重要的组件,它承担着图像处理和显示的任务。

显卡的性能直接影响到电脑的图像质量和运行速度。

而显卡的核心架构是决定其性能的重要因素之一。

本文将对电脑显卡的核心架构进行解析,以帮助读者更好地了解这一关键技术。

一、引言电脑显卡作为图像处理和显示的核心组件,在现代电脑中扮演着重要角色。

了解显卡的核心架构对于选择和使用显卡具有重要意义。

本文将从显卡的架构原理、功能模块和工作流程等方面进行详细解析。

二、显卡的架构原理显卡的核心架构包括GPU(Graphics Processing Unit,图形处理器)、显存和显卡接口等。

GPU是显卡的核心处理单元,负责图像数据的计算和处理。

显存是显卡的存储单元,用于存储图像数据和计算结果。

显卡接口则负责将显卡与电脑主板连接起来,实现数据传输和通信。

三、显卡的功能模块1. 图形处理单元(Graphics Processing Unit,GPU)GPU是显卡中最重要的组件,它承担着图像数据的计算和处理任务。

GPU通常由大量的处理核心(shader core)组成,能够并行地进行复杂的图像计算。

GPU的性能主要由核心数量、频率和架构等因素决定。

2. 显存(Video Random Access Memory,VRAM)显存是显卡的存储单元,用于存储图像数据和计算结果。

显存的大小和频率决定了显卡能够处理的图像数据量和传输速度。

高性能显卡通常采用GDDR(Graphics Double Data Rate)显存,以提供更快的访问速度和传输带宽。

3. 显卡接口显卡接口用于将显卡与电脑主板连接起来,实现数据传输和通信。

常见的显卡接口包括PCI Express和AGP等。

PCI Express是目前主流的显卡接口,它具有更高的传输带宽和更低的延迟,能够更好地满足高性能显卡的需求。

四、显卡的工作流程显卡在进行图像处理和显示时,通常采用以下工作流程:1. 数据传输:电脑主机将图像数据传输到显卡的显存中,供GPU进行处理。

GPU架构与技术详解

GPU架构与技术详解GPU(Graphics Processing Unit)是一种专为处理图形和图像数据而设计的处理器。

它具有高度并行化的计算能力,能够在相同的时钟周期内处理多个任务,因此广泛应用于游戏、计算机辅助设计、科学计算等领域。

而GPU架构和技术是指GPU的内部结构和相关的技术细节,下面将详细介绍。

1.GPU架构(1)处理单元:GPU的核心部分是处理单元(Processing Unit),也称为流处理器(Stream Processor)。

处理单元是一个高度并行化的计算单元,它包含多个流多处理器(Streaming Multiprocessor,SM),每个SM包含多个处理核心(Processing Core)。

每个处理核心可以执行单个线程的指令,而SM则能够同时执行多个线程,充分利用GPU的并行计算能力。

(2)内存层次结构:GPU的内存层次结构包括全局内存、共享内存和寄存器等部分。

全局内存用于存储全局变量和数据,可以被所有处理单元访问。

共享内存用于同一个线程块中的线程之间共享数据,访问速度比全局内存更快。

寄存器用于存储线程的局部变量和计算结果。

(3)数据通路:GPU的数据通路包括输入/输出接口、数据总线、内存控制器等部分。

输入/输出接口用于连接GPU与主机系统,数据总线用于传输数据,内存控制器则负责管理内存访问和数据的读写。

2.GPU技术GPU的技术主要包括并行计算、片上内存、纹理映射、着色器等技术。

(1)并行计算:GPU的设计初衷是处理图形数据,但是由于其高度并行化的计算能力,广泛应用于通用计算领域。

GPU通过并行计算能够同时处理多个任务,大大提高计算效率。

(2)片上内存:为了减少对全局内存的访问,GPU引入了片上内存(On-Chip Memory)作为高速缓存。

片上内存位于SM内部,能够快速共享数据,提高访问速度。

(3)纹理映射:纹理映射(Texture Mapping)是一种将二维图像映射到三维模型表面的技术。

显卡工作原理解析GPU的计算过程

显卡工作原理解析GPU的计算过程显卡工作原理解析:GPU的计算过程显卡是计算机中十分重要的组件之一,它负责处理图形和图像相关的计算任务。

而在显卡中,GPU(图形处理器)的计算过程扮演着关键的角色。

本文将深入解析GPU的计算过程,帮助读者更好地理解显卡的工作原理。

一、GPU的基本结构和功能望文生义,GPU即图形处理器,作为显卡的核心部件,具有强大的图形计算能力。

相比于CPU(中央处理器),GPU具备更多的并行计算单元,能够同时处理大量的数据和计算任务。

GPU通常采用多个计算核心(也称为流处理器),这些计算核心以高度并行的方式工作,加快了图形渲染、物理效果模拟等计算过程。

除此之外,GPU还拥有高速的显存,用于存储和处理图像数据。

显存的容量和频率对于显卡性能有着至关重要的影响。

同时,GPU还具备图像和视频解码的能力,能够高效地处理高清视频和复杂的图像渲染任务。

二、GPU的计算过程1. 数据准备在进行任何计算任务之前,GPU首先需要准备好所需的计算数据。

这些数据通常存储在主机内存中,GPU需要通过高速总线(如PCIe)将数据传输到显存中。

数据传输完成后,GPU即可开始进行后续的计算过程。

2. 并行计算GPU在进行计算任务时,采用高度并行的方式执行指令和数据处理。

与传统的CPU相比,GPU具备更多的计算核心,并且每个计算核心都可以同时处理多个数据元素。

这种并行计算的方式使得GPU在处理大规模计算任务时表现出色。

3. 线程调度为了更好地利用GPU的并行计算能力,编程人员需要将计算任务划分为许多线程,并合理地进行线程调度。

线程调度的目的是确保每个计算核心都能够得到充分的利用和负载均衡,从而提高整体的计算效率。

4. 计算结果返回完成计算任务后,GPU将计算的结果存储在显存中,并通过高速总线将结果传输回主机内存。

最终,CPU可以从主机内存中获取这些计算结果,并在需要的时候进行后续的处理。

三、GPU计算过程的应用GPU的强大计算能力使得它在许多领域得到广泛应用。

图形2.9GPU硬件架构概述

图形2.9GPU硬件架构概述GPU硬件架构概述GPU是什么? GPU全称是Graphics Processing Unit,图形处理单元。

它的功能最初与名字⼀致,是专门⽤于绘制图像和处理图元数据的特定芯⽚,后来渐渐加⼊了其它很多功能。

显卡就是由GPU、散热器、通讯元件、主板和显⽰器连接的各类插槽组成的。

GPU物理构架 由于纳⽶⼯艺的引⼊,GPU可以将数以亿记的晶体管和电⼦器件集成在⼀个⼩⼩的芯⽚内。

从宏观物理结构上看,现代⼤多数桌⾯级GPU的⼤⼩跟数枚硬币同等⼤⼩,部分甚⾄⽐⼀枚硬币还⼩。

当GPU结合散热风扇、PCI插槽、HDMI接⼝等部件之后,就组成了显卡,但显卡不能独⽴⼯作,需要装载在主板上,结合CPU、内存、显存、显⽰器等硬件设备,组成完整的PC机。

下⾯是历经多次变⾰的NVIDIA GPU架构:2008 - Tesla:最初给计算处理单元使⽤,应⽤于早期的CUDA系列显卡芯⽚中,但是并⾮真正意义上的图形处理芯⽚。

2010 - Fermi:第⼀个完整的GPU计算架构。

⾸款可⽀持与共享存储结合纯cache层次的GPU架构,⽀持ECC的GPU架构。

2012 - Kepler:相较于Fermi更快,效率更⾼,性能更好。

2014 - Maxwell:其全新的⽴体像素全局光照 (VXGI) 技术⾸次让游戏 GPU 能够提供实时的动态全局光照效果。

基于 Maxwell 架构的 GTX 980 和 970 GPU 采⽤了包括多帧采样抗锯齿 (MFAA)、动态超级分辨率 (DSR)、VR Direct 以及超节能设计在内的⼀系列新技术。

2016 - Pascal :将处理器和数据集成在同⼀个程序包内,以实现更⾼的计算效率。

1080系列、1060系列都是基于Pascal架构。

2017 - Volta:配备640 个Tensor 核⼼,每秒可提供超过100 兆次浮点运算(TFLOPS) 的深度学习效能,⽐前⼀代的Pascal 架构快5 倍以上。

深入解析GPU架构理解显卡性能的关键

深入解析GPU架构理解显卡性能的关键在现代计算机科学和图形处理领域中,GPU(图形处理器)扮演着越来越重要的角色。

它不仅用于游戏和图形渲染,还能有效地进行并行计算。

然而,要充分发挥GPU的潜力并理解其性能差异,对其架构进行深入分析是必不可少的。

一、GPU架构的基本组成GPU架构主要由处理器核心、存储器、缓存和片上互连等基本组成部分构建而成。

下面将对这些组成进行一一介绍。

1. 处理器核心:处理器核心是GPU的心脏,负责执行大量的计算任务。

每个处理器核心通常由多个执行单元(ALU)和流处理单元(SPU)组成,这些单元能够高效地执行向量运算和并行计算。

2. 存储器:存储器在GPU中起到存放数据的作用。

主要有全局内存、共享内存和常量内存等。

全局内存用于大规模数据存储,共享内存用于同一线程束的数据共享,而常量内存则用于存放常量数据,以提高存取效率。

3. 缓存:GPU中的缓存可以提高数据的访问速度和效率。

常见的缓存有纹理缓存、常量缓存和数据缓存等。

这些缓存能够减少主存和处理器之间的数据交互,从而加快数据处理速度。

4. 片上互连:片上互连是指连接GPU内部各个组件的通信通道。

它可以高效地传输大量的数据和指令,以确保各个组件之间的协同工作。

片上互连通常包括存储器总线、数据总线和控制总线等。

二、理解GPU架构对显卡性能的影响深入理解GPU架构对于评估显卡性能至关重要。

以下是几个可能影响性能的关键方面。

1. 成功率:GPU架构中的处理器核心数量直接影响到并行处理的能力。

拥有更多处理器核心的显卡可以同时执行更多的计算任务,进而提升性能。

2. 内存带宽:内存带宽是指GPU与主存之间数据传输的速度。

它取决于存储器的类型和带宽,对于需要大量数据传输的图形计算和并行计算任务尤为重要。

更高的内存带宽可以提高数据传输效率,从而加快计算速度。

3. 缓存:缓存的大小和速度对于提高性能至关重要。

更大的缓存可以存放更多的数据,减少存取延迟;而更快的缓存则可以提高数据处理速度。

A卡-N卡 GPU架构解析

为什么A卡的流处理器要比N卡多很多页脚内容1从DX10到DX10.1再到DX11,转眼间显卡已经发展到了第四代,但实际上不管ATI还是NVIDIA,它们的新一代显卡都是在最早的DX10显卡架构基础上不断优化、改进、扩充而来的。

换句话说,即便是到了DX11时代,NVIDIA与ATI的性能大战依然是G80与R600架构的延续。

那么,我们就很有必要对双方的GPU图形架构进行深入研究,详细分析各自的优势与劣势,并且顺便解答网友心中的疑惑:为什么A卡的流处理器要比N卡多很多?管线的由来和传统矢量运算单元的弊端页脚内容2● “管线”的由来——1个时钟周期4次运算在图形处理中,最常见的像素都是由RGB(红绿蓝)三种颜色构成的,加上它们共有的信息说明(Alpha),总共是4个通道。

而顶点数据一般是由XYZW四个坐标构成,这样也是4个通道。

在3D图形进行渲染时,其实就是改变RGBA四个通道或者XYZW四个坐标的数值。

为了一次性处理1个完整的像素渲染或几何转换,GPU的像素着色单元和顶点着色单元从一开始就被设计成为同时具备4次运算能力的算数逻辑运算器(ALU)。

传统像素管线/Shader示意图数据的基本单元是Scalar(标量),就是指一个单独的值,GPU的ALU进行一次这种变量操作,被称做1D标量。

由于传统GPU的ALU在一个时钟周期可以同时执行4次这样的并行运算,所以ALU的操作被称做4D Vector(矢量)操作。

页脚内容3SIMD架构示意图一个矢量就是N个标量,一般来说绝大多数图形指令中N=4。

所以,GPU的ALU指令发射端只有一个,但却可以同时运算4个通道的数据,这就是SIMD(Single Instruction Multiple Data,单指令多数据流)架构。

● “管线”弊端越发明显,引入混合型设计显然,SIMD架构能够有效提升GPU的矢量处理性能,由于顶点和像素的绝大部分运算都是4D Vector,它只需要一个指令端口就能在单周期内完成4倍运算量,效率达到100%。

手把手教你识别显卡主要性能参数(精)

手把手教你识别显卡主要性能参数初识显卡的玩家朋友估计在选购显卡的时候对显卡的各项性能参数有点摸不着头脑,不知道谁对显卡的性能影响最大、哪些参数并非越大越好以及同是等价位的显卡但在某些单项上A 卡或者是N卡其中的一家要比对手强悍等等。

这些问题想必是每个刚刚接触显卡的朋友所最想了解的信息,可以说不少卖场的销售员也正是利用这些用户对显卡基本性能参数的不了解来欺骗和蒙蔽消费者。

今天显卡帝就来为入门级的显卡用户来详细解读显卡的主要性能参数的意义。

手把手教你识别显卡主要性能参数关于显卡的性能参数,有许多硬件检测软件可以对显卡的硬件信息进行详细的检测,比如:Everest ,GPU-Z,GPU-Shark等。

这里我们以玩家最常用的GPU-Z软件来作为本文解析显卡性能参数的示例软件。

GTX590的GPU-Z截图首先我们对GPU-Z这款软件的界面进行一个大致分区的解读,从上至下共8 个分区,其中每个分区的具体含义是:①. 显卡名称部分:名称/Name:此处显示的是显卡的名称,也就是显卡型号②. 显示芯片型号部分:核心代号/GPU:此处显示GPU芯片的代号,如上图所示的:GF110、Antilles修订版本/Revision :此处显示GPU芯片的步进制程编号。

制造工艺/Technology :此处显示GPU芯片的制程工艺,如55nm、40nm等。

核心面积/Die Size :此处显示GPU芯片的核心尺寸。

③. 显卡的硬件信息部分:BIOS版本/BIOS Version :此处显示显卡BIOS的版本号。

设备ID/Device ID :此处显示设备的ID 码。

制造厂商/Subvendor :此处显示该显卡OEM制造厂商的名称。

④. 显示芯片参数部分:光栅操作单元/ROPs:此处显示GPU拥有的ROP光栅操作处理单元的数量。

总线接口/Bus Interface :此处显示显卡和主板北桥芯片之间的总线接口类型以及接口速度。

深度解析GPU技术_PPT模板.pptx

学习,GPU的发展经历了从简单到复杂,从单一

功能到多功能的转变,其强大的计算能力正在改

变我们的生活和工作方式。

02 GPU的工作原理解 析

GPU的工作原理解析

GPU的基本构造

GPU的工作模式

GPU与CPU的关系

GPU主要由核心处理器、显 存、供电模块等组成,这些 部分协同工作,实现图像的 快速处理和渲染。

深度解析GPU技术

从原理到应用全面掌握GPU

作者: 智文 汇报时间: 2023/12/05

目录

01 GPU的定义和发展历程 03 GPU的主要组成部分介绍 05 GPU在各领域的应用展示

02 GPU的工作原理解析 04 GPU与CPU的区别对比 06 GPU的未来发展趋势预测

01 GPU的定义和发展 历程

随着技术的进步,未来的 GPU在提供更高性能的同时 ,其功耗也将得到有效控制 ,这将使得GPU在更多的设 备上得到应用。

谢谢大家

1 GPU与CPU的工作原理对比

GPU是并行运算处理器,而CPU则是串行运算处

GPU与CPU的性能特点对比 2 理器。在处理大量数据时,GPU可以同时处理多

GPU擅长大规模并行计算,能够快速完成复杂数

个任务,而CPU则需要依次处理每个任务。

学运算,适用于图形渲染、深度学习等领域;而

CPU则更适合处理复杂的逻辑控制和少量数据的

GPU的定义和发展历程

1 GPU的定义

GPU,全称为图形处理器,是一种专门处理图像

GPU的功能特性

2

和影像的微处理器,它的主要任务是进行图形计

GPU具有大量的并行处理单元,使其在处理大规

算。

模数据时具有极高的效率,特别是在3D图形渲染

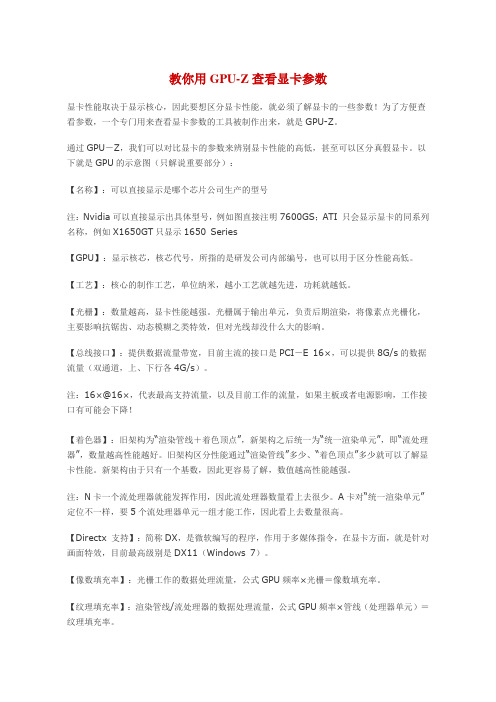

用GPU-Z查看显卡参数

教你用GPU-Z查看显卡参数显卡性能取决于显示核心,因此要想区分显卡性能,就必须了解显卡的一些参数!为了方便查看参数,一个专门用来查看显卡参数的工具被制作出来,就是GPU-Z。

通过GPU-Z,我们可以对比显卡的参数来辨别显卡性能的高低,甚至可以区分真假显卡。

以下就是GPU的示意图(只解说重要部分):【名称】:可以直接显示是哪个芯片公司生产的型号注:Nvidia可以直接显示出具体型号,例如图直接注明7600GS;ATI 只会显示显卡的同系列名称,例如X1650GT只显示1650 Series【GPU】:显示核芯,核芯代号,所指的是研发公司内部编号,也可以用于区分性能高低。

【工艺】:核心的制作工艺,单位纳米,越小工艺就越先进,功耗就越低。

【光栅】:数量越高,显卡性能越强。

光栅属于输出单元,负责后期渲染,将像素点光栅化,主要影响抗锯齿、动态模糊之类特效,但对光线却没什么大的影响。

【总线接口】:提供数据流量带宽,目前主流的接口是PCI-E 16×,可以提供8G/s的数据流量(双通道,上、下行各4G/s)。

注:16×@16×,代表最高支持流量,以及目前工作的流量,如果主板或者电源影响,工作接口有可能会下降!【着色器】:旧架构为“渲染管线+着色顶点”,新架构之后统一为“统一渲染单元”,即“流处理器”,数量越高性能越好。

旧架构区分性能通过“渲染管线”多少、“着色顶点”多少就可以了解显卡性能。

新架构由于只有一个基数,因此更容易了解,数值越高性能越强。

注:N卡一个流处理器就能发挥作用,因此流处理器数量看上去很少。

A卡对“统一渲染单元”定位不一样,要5个流处理器单元一组才能工作,因此看上去数量很高。

【Directx 支持】:简称DX,是微软编写的程序,作用于多媒体指令,在显卡方面,就是针对画面特效,目前最高级别是DX11(Windows 7)。

【像数填充率】:光栅工作的数据处理流量,公式GPU频率×光栅=像数填充率。

gpu组成原理

gpu组成原理GPU(图形处理单元)是一种专门用于处理图形和图像计算的处理器。

GPU的组成原理涉及到图形处理的并行性、流水线架构、纹理映射、着色器等多个方面。

以下是GPU的一般组成原理:1.并行性:GPU是设计用于高度并行计算的硬件。

它包含大量的处理单元,这些单元可以同时执行多个任务。

这种并行性使得GPU在处理大规模图形和图像计算时能够更为高效。

2.流水线架构:GPU通常采用流水线(pipeline)架构,将图形处理任务划分为多个阶段。

每个阶段执行特定的计算任务,数据在这些阶段之间流动,从而实现图形的渲染和处理。

3.顶点处理和几何处理:GPU首先接收到图形数据中的顶点信息,然后通过顶点处理单元进行处理。

接着,几何处理单元负责对这些顶点进行转换和投影,以确定它们在屏幕上的最终位置。

4.光栅化和片段处理:在屏幕上确定了顶点的位置后,GPU将图元转化为片段,并进行光栅化处理。

在片段处理阶段,进行着色、纹理映射、深度测试等操作,最终确定每个像素的颜色。

5.着色器:着色器是GPU中的关键组件,负责处理图形中的颜色、光照等方面。

主要包括顶点着色器(Vertex Shader)、像素着色器(Pixel Shader)等。

这些着色器是高度可编程的,允许程序员根据需要自定义图形效果。

6.纹理映射:GPU支持纹理映射,通过将图像或纹理映射到三维模型表面,增加了图形的细节和真实感。

7.帧缓冲和显示:处理后的图像数据最终存储在帧缓冲中,然后被发送到显示器进行呈现。

8.通用计算:现代的GPU不仅仅用于图形处理,还具备通用计算能力,可以执行广泛的并行计算任务,如深度学习、科学计算等。

总的来说,GPU的组成原理主要体现在并行计算、流水线架构、着色器的灵活性等方面,这些特性使得GPU在图形处理和通用计算领域都能够发挥强大的性能。

解析电脑显卡的架构设计

解析电脑显卡的架构设计在这份文章中,我将解析电脑显卡的架构设计。

电脑显卡作为计算机硬件的重要组成部分,在图形处理和显示方面发挥着关键作用。

了解显卡的架构设计有助于我们更好地理解其工作原理和性能特点。

I. 显卡的功能与作用显卡,也被称为图形处理器,是计算机中用于图像处理、显示以及与显示器的通信的重要设备。

显卡负责将计算机内部的数据转换成显示器可以识别和呈现的图像信号,通过数字信号到模拟信号的转换,使得计算机用户能够直观地观察到图像和视频。

II. 图形处理单元(GPU)的作用与结构1. GPU的作用:GPU是显卡的核心组件,其主要功能是进行图像处理和计算任务。

与中央处理器(CPU)相比,GPU在图像处理方面更具优势,可以并行地处理大量图像数据,提供更快速的计算和图形渲染能力。

2. GPU的结构:现代显卡中的GPU通常由多个处理单元组成,每个处理单元包含多个流处理器。

这些流处理器负责并行处理图像数据,并通过内存总线与显存进行数据交换。

此外,GPU还包含纹理单元、光栅化单元和输出控制单元等组件,以完成各种图像渲染和显示任务。

III. 显卡的架构设计类型1. 统一架构(Unified Architecture):统一架构是一种最常见的显卡架构设计,其特点是将图形处理单元(GPU)中的处理器核心用于执行多项任务,如图像处理、几何运算和物理模拟等。

这种设计使得显卡能够高效地处理各种不同类型的计算任务。

2. 流水线架构(Pipeline Architecture):流水线架构通过将图形渲染流程分为不同的阶段,并将每个阶段的计算任务分配给不同的处理器核心,实现对图像数据的并行处理。

这种设计能够提高显卡的计算效率,加快图形渲染速度。

3. 多核心架构(Multi-core Architecture):多核心架构是指在同一个GPU芯片中,集成了多个独立的处理器核心。

每个处理器核心可以独立地执行计算任务,实现更高的并行计算能力。

了解显卡架构显存GPU和渲染管线

了解显卡架构显存GPU和渲染管线显卡架构、显存、GPU和渲染管线是与图形处理有关的重要概念。

本文将深入探讨这些概念,以提供对显卡技术的全面了解。

一、显卡架构显卡架构是指显卡的物理设计和组织方式。

不同架构的显卡可能有不同的处理器数量、内存配置和功能特点。

常见的显卡架构包括AMD 的GCN架构和英伟达的Turing架构。

1.1 AMD的GCN架构AMD的GCN(Graphics Core Next)架构是一种高性能图形处理架构。

它采用了向量处理单元(vector processing unit)和着色单元(shader unit)的组合,以实现并行处理任务。

GCN架构的显卡通常具有高计算性能和较大的显存带宽,适用于游戏、数字媒体处理和科学计算等任务。

1.2 英伟达的Turing架构英伟达的Turing架构是一种专为实时追踪(ray tracing)和人工智能应用而设计的显卡架构。

Turing架构引入了RT核心(RT Cores)和张量核心(Tensor Cores),以提供更高的性能和更逼真的视觉效果。

Turing架构的显卡能够实现实时光线追踪,提供更真实的光影效果。

二、显存显存是显卡用于存储图形数据的内存。

它决定了显卡在处理图像、视频和游戏等任务时的性能和流畅度。

显存的容量越大,显卡能够处理更大规模的图像和数据。

在选择显卡时,显存的类型和带宽也需要考虑。

常见的显存类型包括GDDR6和HBM(High Bandwidth Memory)。

GDDR6具有较高的带宽和较低的延迟,适用于游戏和多媒体处理等应用。

而HBM则具有更高的内存带宽和能效,适合于高性能计算和人工智能等领域。

三、GPU(图形处理器)GPU是显卡的核心组件,用于执行图形计算任务。

它由众多的处理器核心组成,能够并行处理大量的图形数据。

GPU通过执行各种图形算法和渲染管线中的计算步骤,将输入数据转化为最终的图像输出。

GPU的性能指标包括核心数量、时钟频率和算力等。

手把手教你识别显卡主要性能参数

手把手教你识别显卡主要性能参数初识显卡的玩家朋友估计在选购显卡的时候对显卡的各项性能参数有点摸不着头脑,不知道谁对显卡的性能影响最大、哪些参数并非越大越好以及同是等价位的显卡但在某些单项上A 卡或者是N卡其中的一家要比对手强悍等等。

这些问题想必是每个刚刚接触显卡的朋友所最想了解的信息,可以说不少卖场的销售员也正是利用这些用户对显卡基本性能参数的不了解来欺骗和蒙蔽消费者。

今天显卡帝就来为入门级的显卡用户来详细解读显卡的主要性能参数的意义。

显卡帝手把手教你识别显卡主要性能参数关于显卡的性能参数,有许多硬件检测软件可以对显卡的硬件信息进行详细的检测,比如:Everest,GPU-Z,GPU-Shark等。

这里我们以玩家最常用的GPU-Z软件来作为本文解析显卡性能参数的示例软件。

GTX590的GPU-Z截图首先我们对GPU-Z这款软件的界面进行一个大致分区的解读,从上至下共8个分区,其中每个分区的具体含义是:①.显卡名称部分:名称/Name:此处显示的是显卡的名称,也就是显卡型号。

②.显示芯片型号部分:核心代号/GPU:此处显示GPU芯片的代号,如上图所示的:GF110、Antilles等。

修订版本/Revision:此处显示GPU芯片的步进制程编号。

制造工艺/Technology:此处显示GPU芯片的制程工艺,如55nm、40nm等。

核心面积/Die Size:此处显示GPU芯片的核心尺寸。

③.显卡的硬件信息部分:BIOS版本/BIOS Version:此处显示显卡BIOS的版本号。

设备ID/Device ID:此处显示设备的ID码。

制造厂商/Subvendor:此处显示该显卡OEM制造厂商的名称。

④.显示芯片参数部分:光栅操作单元/ROPs:此处显示GPU拥有的ROP光栅操作处理单元的数量。

总线接口/Bus Interface:此处显示显卡和主板北桥芯片之间的总线接口类型以及接口速度。

着色单元/Shaders:此处显示GPU拥有的着色器的数量。

显卡的基本结构

教你认识显卡的基本结构(多图)显示接口卡(Video card,Graphics card),又称为显示适配器(Video adapter),台湾与香港简称为显卡,是个人电脑最基本组成部分之一。

显卡的用途是将计算机系统所需要的显示信息进行转换驱动显示器,并向显示器提供行扫描信号,控制显示器的正确显示,是连接显示器和个人电脑主板的重要元件,是“人机对话”的重要设备之一。

显卡作为电脑主机里的一个重要组成部分,承担输出显示图形的任务,对于喜欢玩游戏和从事专业图形设计的人来说显卡非常重要。

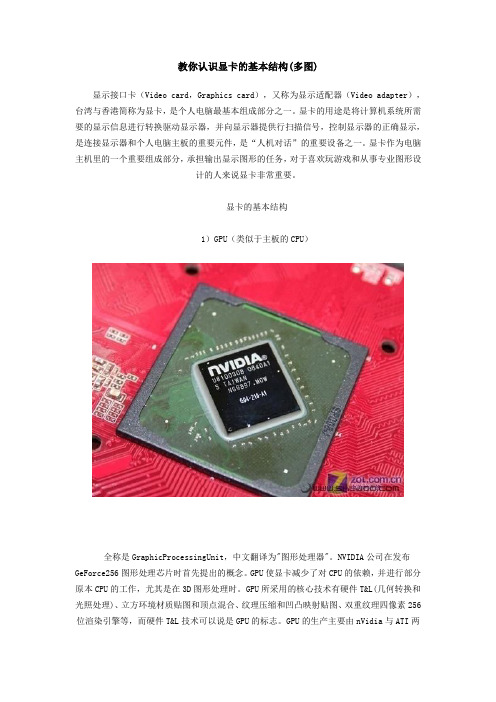

显卡的基本结构1)GPU(类似于主板的CPU)全称是GraphicProcessingUnit,中文翻译为"图形处理器"。

NVIDIA公司在发布GeForce256图形处理芯片时首先提出的概念。

GPU使显卡减少了对CPU的依赖,并进行部分原本CPU的工作,尤其是在3D图形处理时。

GPU所采用的核心技术有硬件T&L(几何转换和光照处理)、立方环境材质贴图和顶点混合、纹理压缩和凹凸映射贴图、双重纹理四像素256位渲染引擎等,而硬件T&L技术可以说是GPU的标志。

GPU的生产主要由nVidia与ATI两家厂商生产。

2)显存(类似于主板的内存)显示内存的简称。

顾名思义,其主要功能就是暂时将储存显示芯片要处理的数据和处理完毕的数据。

图形核心的性能愈强,需要的显存也就越多。

以前的显存主要是SDR的,容量也不大。

而现在市面上基本采用的都是DDR3规格的,在某些高端卡上更是采用了性能更为出色的DDR4或DDR5代内存。

显存主要由传统的内存制造商提供,比如三星、现代、Kingston 等。

3)显卡bios(类似于主板的bios)显卡BIOS主要用于存放显示芯片与驱动程序之间的控制程序,另外还存有显示卡的型号、规格、生产厂家及出厂时间等信息。

打开计算机时,通过显示BIOS内的一段控制程序,将这些信息反馈到屏幕上。

手把手教你深入认识显卡(图文讲解)

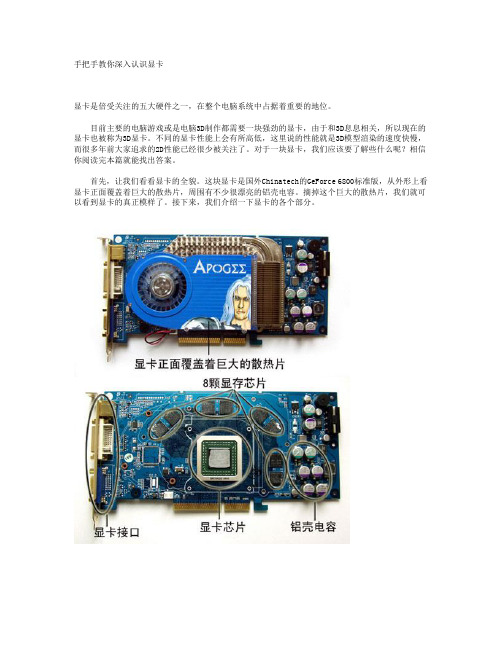

手把手教你深入认识显卡显卡是倍受关注的五大硬件之一,在整个电脑系统中占据着重要的地位。

目前主要的电脑游戏或是电脑3D制作都需要一块强劲的显卡,由于和3D息息相关,所以现在的显卡也被称为3D显卡。

不同的显卡性能上会有所高低,这里说的性能就是3D模型渲染的速度快慢,而很多年前大家追求的2D性能已经很少被关注了。

对于一块显卡,我们应该要了解些什么呢?相信你阅读完本篇就能找出答案。

首先,让我们看看显卡的全貌。

这块显卡是国外Chinatech的GeForce 6800标准版,从外形上看显卡正面覆盖着巨大的散热片,周围有不少很漂亮的铝壳电容。

摘掉这个巨大的散热片,我们就可以看到显卡的真正模样了。

接下来,我们介绍一下显卡的各个部分。

显卡芯片显卡芯片在显卡中扮演非常重要的角色,显卡的等级直接由显卡芯片来划分,所以很多显卡你只需要了解它使用的显卡芯片,就能对整块显卡的性能略知一二了。

下面这幅图就是GeForce 6800核心(图3),一般来说芯片都位于整个显卡的中央,根据封装不同,如TPBGA、FC-BGA等,在外观上也有不小的差异。

大部分的核心上都有代码,不少芯片上直接能够看出显卡芯片的型号。

如Radeon 9550核心的显卡芯片,核心上的第一排就有Radeon 9550的字样,我们可以很直观地看出芯片的型号。

不过也有的芯片只是标明了研发代码,如nVIDIA的NV18、NV31,ATi的R340、R420等等,这些研发代码表示不同型号的芯片。

从nVIDIA的GeForce 256开始,显示芯片就有了新的名称——GPU,意思是图形处理器,和计算机系统的CPU遥相呼应。

GPU的参数很多,我们一般要了解的是核心频率,以MHz为单位,如FX5200的核心频率为250MHz。

核心频率越快,GPU的运算速度也就越快。

但在性能上还要取决于很多方面,如渲染管道的数量,这个渲染管道就像是生产线一样,生产线越多,相同时间内生产出来的产品就越多,性能就越好。

一文详解GPU结构及工作原理

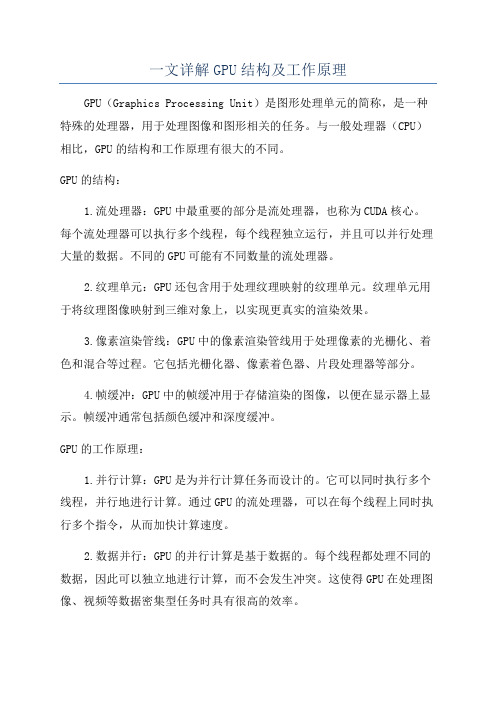

一文详解GPU结构及工作原理GPU(Graphics Processing Unit)是图形处理单元的简称,是一种特殊的处理器,用于处理图像和图形相关的任务。

与一般处理器(CPU)相比,GPU的结构和工作原理有很大的不同。

GPU的结构:1.流处理器:GPU中最重要的部分是流处理器,也称为CUDA核心。

每个流处理器可以执行多个线程,每个线程独立运行,并且可以并行处理大量的数据。

不同的GPU可能有不同数量的流处理器。

2.纹理单元:GPU还包含用于处理纹理映射的纹理单元。

纹理单元用于将纹理图像映射到三维对象上,以实现更真实的渲染效果。

3.像素渲染管线:GPU中的像素渲染管线用于处理像素的光栅化、着色和混合等过程。

它包括光栅化器、像素着色器、片段处理器等部分。

4.帧缓冲:GPU中的帧缓冲用于存储渲染的图像,以便在显示器上显示。

帧缓冲通常包括颜色缓冲和深度缓冲。

GPU的工作原理:1.并行计算:GPU是为并行计算任务而设计的。

它可以同时执行多个线程,并行地进行计算。

通过GPU的流处理器,可以在每个线程上同时执行多个指令,从而加快计算速度。

2.数据并行:GPU的并行计算是基于数据的。

每个线程都处理不同的数据,因此可以独立地进行计算,而不会发生冲突。

这使得GPU在处理图像、视频等数据密集型任务时具有很高的效率。

3. 高峰性能:GPU在处理大规模并行任务时表现出色。

它可以同时执行大量的计算,并利用硬件加速技术,如流处理器的SIMD(Single Instruction, Multiple Data)架构,以实现极高的计算性能。

4.调度和资源管理:GPU内部有专门的调度器和资源管理器,用于管理并分配计算和内存资源。

调度器负责将不同的任务分配给可用的流处理器,以便更好地利用GPU的计算能力。

资源管理器负责管理帧缓冲和纹理等存储资源。

总结:GPU是一种用于图形处理的特殊处理器,具有并行计算、数据并行、高峰性能和调度资源管理等特点。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

GPU架构“征途之旅”即日起航显卡GPU架构之争永远是DIY玩家最津津乐道的话题之一,而对于众多普通玩家来说经常也就看看热闹而已。

大多数玩家在购买显卡的时候其实想的是这款显卡是否可以满足我实际生活娱乐中的应用要求,而不大会很深入的关注GPU的架构设计。

不过,如果你想成为一个资深DIY玩家,想与众多DIY高手“高谈阔论”GPU架构设计方面的话题的时候,那么你首先且必须弄明白显卡GPU架构设计的基本思想和基本原理,而读懂GPU架构图正是这万里长征的第一步。

显卡帝手把手教你读懂GPU架构图通过本次GPU架构图的“征途之旅”,网友朋友将会和显卡帝共同来探讨和解密如下问题:一、顶点、像素、着色器是什么;二、SIMD与MIMD的架构区别;三、A/N在统一渲染架构革新中的三次交锋情况如何;四、为什么提出并行架构设计;五、A/N两家在GPU架构设计的特点及其异同点是什么。

以上目录也正是本文的大致行文思路,显卡帝希望能够通过循序渐进的分析与解读让众多玩家能够对GPU架构设计有个初步的认识,并且能够在读完本文之后能对GPU架构图进行独立认知与分析的基本能力,这将是本人莫大的欣慰。

非统一架构时代的GPU架构组件解读上世纪的绝大多数显示加速芯片都不能称之为完整意义上的GPU,因为它们仅仅只有像素填充和纹理贴图的基本功能。

而NVIDIA公司在1999年所发布的GeForce 256图形处理芯片则首次提出了GPU的概念。

GPU所采用的核心技术有硬件T&L、立方环境材质贴图和顶点混合、纹理压缩和凹凸映射贴图、双重纹理四像素256位渲染引擎等,而硬件T&L (Transform and Lighting,多边形转换与光源处理)技术可以说是GPU问世的标志。

演示硬件几何和光影(T&L)转换的Demo● 传统的固定渲染管线渲染管线也称为渲染流水线,是显示芯片内部处理图形信号相互独立的的并行处理单元。

在某种程度上可以把渲染管线比喻为工厂里面常见的各种生产流水线,工厂里的生产流水线是为了提高产品的生产能力和效率,而渲染管线则是提高显卡的工作能力和效率。

什么叫一条“像素渲染管线”?简单的说,传统的一条渲染管线是由包括Pixel Shader Unit (像素着色单元)+ TMU(纹理贴图单元) + ROP(光栅化引擎)三部分组成的。

用公式表达可以简单写作:PS=PSU+TMU+ROP 。

从功能上看,PSU完成像素处理,TMU负责纹理渲染,而ROP则负责像素的最终输出。

所以,一条完整的像素管线意味着在一个时钟周期完成至少进行1个PS运算,并输出一次纹理。

● Shader(着色器)的引入而GPU的下一次重大革新则是引入了Shader(着色器)。

着色器替代了传统的固定渲染管线,可以实现3D图形学计算中的相关计算,由于其可编辑性,从而可以实现各种各样的图像效果而不用受显卡的固定渲染管线限制。

这极大的提高了图像的画质。

而从GeForce 3到GeForce 9,GPU的发展都是一直基于这种用于显卡硬件几何架构/渲染过程的Shader来进行的。

传统(像素)管线/Shader示意图● Shader(着色器)的分类早期的Shader(着色器)有两种,一种是顶点着色器,称为Vertex Shader(OpenGL称为vertex program),取代固定渲染管线中的变换和光照部分,程序员可以自己控制顶点变换、光照等。

另一种是像素着色器,称为Pixel Shader(OpenGL称为fragment program),取代固定渲染管线中的光栅化部分,程序员可以自己控制像素颜色和纹理采样等。

3D场景的对象都是由顶点形成关于顶点,我们需要小小说明一下:所有3D场景的对象都是由顶点形成。

一个顶点是X、Y、Z坐标形成的3D空间中的一点,多个顶点聚在一起(至少四个)可形成一个多边形,如三角形、立方体或更复杂的形状,将材质贴在其上可使该组件(或几个排好的组件)看起来更真实。

上图的3D立方体就是由八个顶点所形成,使用大量顶点,可形成弧线形对象等较复杂的图像。

传统shader指令结构● GPU的像素着色单元和顶点着色单元在图形处理中,最常见的像素都是由RGB(红绿蓝)三种颜色构成的,加上它们共有的信息说明(Alpha),总共是4个通道。

而顶点数据一般是由XYZW四个坐标构成,这样也是4个通道。

在3D图形进行渲染时,其实就是改变RGBA四个通道或者XYZW四个坐标的数值。

为了一次性处理1个完整的像素渲染或几何转换,GPU的像素着色单元和顶点着色单元从一开始就被设计成为同时具备4次运算能力的算数逻辑运算器(ALU)。

SIMD和MIMD两种结构你知道吗?在我们继续介绍GPU架构设计之前我们需要对SIMD和MIMD这两种结构进行一个详细的说明。

1966年,MichealFlynn根据指令和数据流的概念对计算机的体系结构进行了分类,这就是所谓的Flynn分类法。

Flynn将计算机划分为四种基本类型,即SISD、MIMD、SIMD、MISD。

SIMD(Single Instruction Single Data Stream,单指令单数据流)结构传统的顺序执行的计算机在同一时刻只能执行一条指令(即只有一个控制流)、处理一个数据(即只有一个数据流),因此被称为单指令单数据流计算(Single Instruction Single Data Stream,SISD)。

MIMD(多指令流多数据流)结构而对于大多数并行计算机而言,多个处理单元都是根据不同的控制流程执行不同的操作,处理不同的数据,因此,它们被称作是多指令流多数据流计算机,即MIMD(Multiple Instruction Stream Multiple Data Stream,简称MIMD)计算机,它使用多个控制器来异步地控制多个处理器,从而实现空间上的并行性。

● 传统SIMD架构在执行效率下降的原因分析数据的基本单元是Scalar(标量),就是指一个单独的值,GPU的ALU进行一次这种变量操作,被称做1D标量。

由于传统GPU的像素着色单元和顶点着色单元从一开始就被设计成为同时具备4次运算能力的算数逻辑运算器(ALU),所以GPU的ALU在一个时钟周期可以同时执行4次这样的并行运算,所以ALU的操作被称做4D Vector(矢量)操作。

一个矢量就是N个标量,一般来说绝大多数图形指令中N=4。

图形指令中标量与矢量由于顶点和像素的绝大部分运算都是4D Vector,它只需要一个指令端口就能在单周期内完成4倍运算量,显然SIMD架构能够有效提升GPU的矢量处理性能以使效率达到100%。

但如果4D SIMD架构一旦遇上1D标量指令的时候,效率就会陡然降至原来的1/4,而其他的3/4模块几乎被闲置。

为了解决这种资源被浪费的情况,ATI和NVIDIA在进入DX9时代后相继采用混合型设计,比如R300就采用了3D+1D的架构,允许Co-issue操作(矢量指令和标量指令可以并行执行),NV40以后的GPU支持2D+2D和3D+1D两种模式,虽然很大程度上缓解了标量指令执行效率低下的问题,但依然无法最大限度的发挥ALU运算能力,尤其是一旦遇上分支预测的情况,SIMD在矢量处理方面高效能的优势将会大大降低。

分析一下其中的原因,我们可以得知:在早期,传统的1条渲染管线包含了4个基本单元,而大多数程序指令都是4D的,所以执行效率会很高。

然而随着API的不断革新以及游戏设计中复杂的Shader指令的发展,4D指令的出现比例开始逐步下降,而1D/2D/3D等混合指令开始大幅出现,故而传统的管线式架构效率开始越来越低下。

GPU架构大变革:统一渲染架构袭来微软DirectX 10对于统一渲染架构的提出,可谓是GPU架构设计的一场大变革。

它的核心思想是:将Vertex Shader(顶点着色)和Pixel Shader(像素着色)单元合并成一个具备完整执行能力的US(Unified Shader,统一渲染)单元,指令可以直接面向底层的ALU 而非过去的特定单元,所以在硬件层面US可以同时吞吐一切shader指令,同时并不会对指令进行任何的修改,也不会对shader program的编写模式提出任何的强迫性的改变要求。

GS(几何着色器)、PS(像素着色器)、VS(顶点着色器)首次三位一体:US从DirectX 10开始,微软真正将注意力开始转向了Shader效率上来,借助提升Shader效率来提升对应设计的运算单元的整体运行效率,而最终给玩家的体现就是带来流畅度(帧数)的提升。

当然也可以用来进行更复杂和灵活的其他操作。

●N卡第一代GPU统一架构核心之G802006年11月,NVIDIA发布了业界第一款DirectX 10构架的GPU——G80。

G80由一套完整的包含仲裁资源的几何处理单元,与之相连的8个SM阵列,6组TA(纹理寻址)和6组ROP(光栅化引擎)单元组成,整个构架以高速crossbar(交叉)总线直连。

G80的标量流处理器架构NVIDIA在G80核心架构上把原来的4D着色单元完全打散,流处理器统统由矢量设计改为了标量运算单元。

每一个ALU都有自己的专属指令发射器,初代产品拥有128个这样的1D运算器,称之为流处理器(SP)。

这些流处理器可以按照动态流控制智能的执行各种4D/3D/2D/1D指令,无论什么类型的指令执行效率都能接近于100%。

G80这种标量流处理器即MIMD(多指令流多数据流)架构。

虽然说G80将GPU Shader执行效率提升到了一个新高度,但我们知道:4个1D标量ALU和1个4D矢量ALU的运算能力是相当的,前者需要4个指令发射端和4个控制单元,而后者只需要1个,如此一来MIMD架构所占用的晶体管数就远大于了SIMD架构,这正是采用MIMD架构的G80核心的软肋。

●A卡第一代GPU统一架构核心之R6002007年5月,AMD收购ATI之后推出的第一款DirectX 10 GPU——R600正式发布了。

R600由一套几何处理单元,独立的线程仲裁器UTDP,与仲裁机构相连的SPU(流处理器)和TMU(纹理贴图)单元,以及完整的后端所组成。

整个构架以ringbus(环状)总线进行连接。

R600的超标量流处理器架构相比大胆革新的G80核心架构,从Stream Processing Units这一处可以观察出:R600身上有些许传统GPU的影子,因为SPU依然采用的是SIMD(单指令多数据流)架构。

R600拥有4个SIMD阵列,每个SIMD阵列包括了16个Stream Processing Units,这样总共就是64个,但不能简单地认为它拥有64个流处理器,因为R600的每个Units内部包含了5个ALU,从微观上来看即:5D Superscalar超标量架构。