线性回归方程中的相关系数r

线性回归方程中的相关系数r(20191224045858)

线性回归方程中的相关系数rr=∑(Xi-X的平均数)(Yi-Y平均数)/根号下[∑(Xi-X平均数)^2*∑(Yi-Y平均数)^2]R2就是相关系数的平方,R在一元线性方程就直接是因变量自变量的相关系数,多元则是复相关系数判定系数R^2也叫拟合优度、可决系数。

表达式是:R^2=ESS/TSS=1-RSS/TSS该统计量越接近于1,模型的拟合优度越高。

问题:在应用过程中发现,如果在模型中增加一个解释变量,R2往往增大这就给人一个错觉:要使得模型拟合得好,只要增加解释变量即可。

——但是,现实情况往往是,由增加解释变量个数引起的R2的增大与拟合好坏无关,R2需调整。

这就有了调整的拟合优度:R1^2=1-(RSS/(n-k-1))/(TSS/(n-1))在样本容量一定的情况下,增加解释变量必定使得自由度减少,所以调整的思路是:将残差平方和与总离差平方和分别除以各自的自由度,以剔除变量个数对拟合优度的影响:其中:n-k-1为残差平方和的自由度,n-1为总体平方和的自由度。

总是来说,调整的判定系数比起判定系数,除去了因为变量个数增加对判定结果的影响。

R = R接近于1表明Y与X1,X2 ,…,Xk之间的线性关系程度密切;R接近于0表明Y与X1,X2 ,…,Xk之间的线性关系程度不密切相关系数就是线性相关度的大小,1为(100%)绝对正相关,0为0%,-1为(100%)绝对负相关相关系数绝对值越靠近1,线性相关性质越好,根据数据描点画出来的函数-自变量图线越趋近于一条平直线,拟合的直线与描点所得图线也更相近。

如果其绝对值越靠近0,那么就说明线性相关性越差,根据数据点描出的图线和拟合曲线相差越远(当相关系数太小时,本来拟合就已经没有意义,如果强行拟合一条直线,再把数据点在同一坐标纸上画出来,可以发现大部分的点偏离这条直线很远,所以用这个直线来拟合是会出现很大误差的或者说是根本错误的)。

分为一元线性回归和多元线性回归线性回归方程中,回归系数的含义一元:Y^=bX+a b表示X每变动(增加或减少)1个单位,Y平均变动(增加或减少)b各单位多元:Y^=b1X1+b2X2+b3X3+a 在其他变量不变的情况下,某变量变动1单位,引起y平均变动量以b2为例:b2表示在X1、X3(在其他变量不变的情况下)不变得情况下,X2每变动1单位,y平均变动b2单位就一个reg来说y=a+bx+ea+bx的误差称为explained sum of squaree的误差是不能解释的是residual sum of square总误差就是TSS所以TSS=RSS+ESS判定系数也叫拟合优度、可决系数。

线性回归中的相关系数

说明:(1)对于相关系数r,首先值得注意的是它的符号,当r为正数时,表示变量x,y正相关;当r为负数时,表示两个变量x,y负相关;

(2)另外注意r的大小,如果 ,那么正相关很强;如果 ,那么负相关很强;如果 或 ,那么相关性一般;如果 ,那么相关性较弱.

(2)如果y与x之间具有线性相关关系,求回归直线方程;

(3)如果父亲的身高为73英寸,估计儿子身高.

解:(1) , , , , , ,

, ,

所以

,

所以y与x之间具有线性相关关系.

(2)设回归直线方程为 ,则 ,

.

故所求的回归直线方程为 .

(3)当 英寸时, ,

所以当父亲身高为73英寸时,估计儿子的身高约为69。9英寸.

下面我们就用相关系数法来分析身边的问题,确定两个变量是否相关,并且求出两个变量间的回归直线.

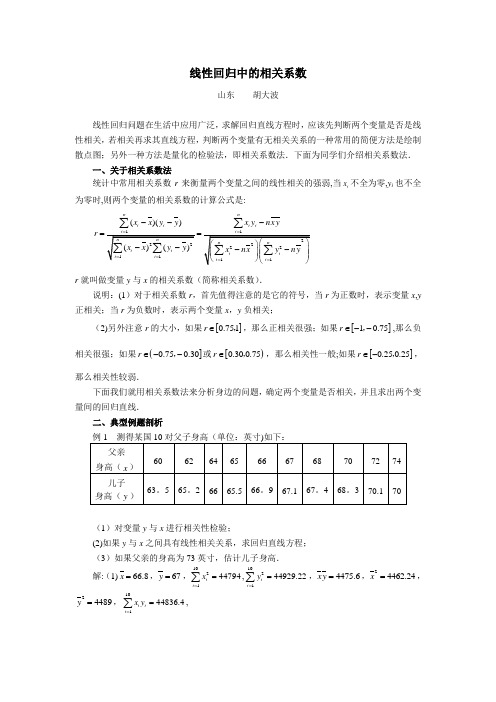

二、典型例题剖析

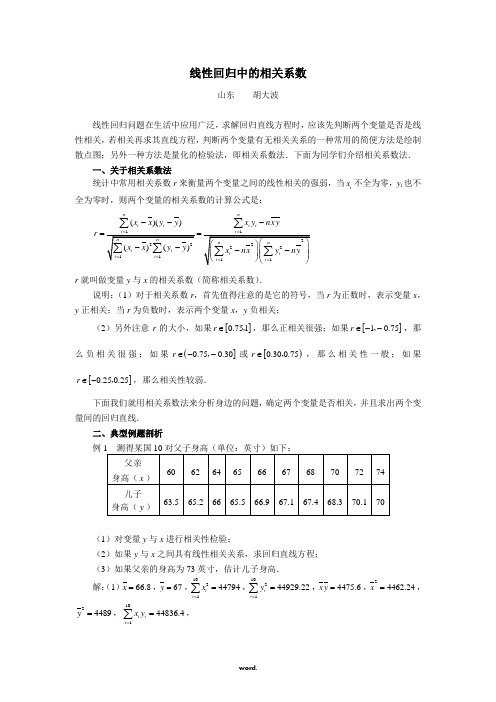

例1测得某国10对父子身高(单位:英寸)如下:

父亲

身高( )

60

62

64

65

66

67

68

70

72

74

儿子

身高( )

63。5

65。2

66

65.5

66。9

67.1

67。4

68。3

70.1

70

(1)对变量y与x进行相关性检验;

线性回归中的相关系数

山东胡大波

线性回归问题在生活中应用广泛,求解回归直线方程时,应该先判断两个变量是否是线性相关,若相关再求其直线方程,判断两个变量有无相关关系的一种常用的简便方法是绘制散点图;另外一种方法是量化的检验法,即相关系数法.下面为同学们介绍相关系数法.

线性回归方程中的相关系数r

线性回归方程中的相关系数rr=∑(Xi-X的平均数)(Yi-Y平均数)/根号下[∑(Xi-X平均数)^2*∑(Yi-Y平均数)^2]R2就是相关系数的平方,R在一元线性方程就直接是因变量自变量的相关系数,多元则是复相关系数判定系数R^2也叫拟合优度、可决系数。

表达式是:R^2=ESS/TSS=1-RSS/TSS该统计量越接近于1,模型的拟合优度越高。

问题:在应用过程中发现,如果在模型中增加一个解释变量,R2往往增大这就给人一个错觉:要使得模型拟合得好,只要增加解释变量即可。

——但是,现实情况往往是,由增加解释变量个数引起的R2的增大与拟合好坏无关,R2需调整。

这就有了调整的拟合优度:R1^2=1-(RSS/(n-k-1))/(TSS/(n-1))在样本容量一定的情况下,增加解释变量必定使得自由度减少,所以调整的思路是:将残差平方和与总离差平方和分别除以各自的自由度,以剔除变量个数对拟合优度的影响:其中:n-k-1为残差平方和的自由度,n-1为总体平方和的自由度。

总是来说,调整的判定系数比起判定系数,除去了因为变量个数增加对判定结果的影响。

R = R接近于1表明Y与X1,X2 ,…,Xk之间的线性关系程度密切;R接近于0表明Y与X1,X2 ,…,Xk之间的线性关系程度不密切相关系数就是线性相关度的大小,1为(100%)绝对正相关,0为0%,-1为(100%)绝对负相关相关系数绝对值越靠近1,线性相关性质越好,根据数据描点画出来的函数-自变量图线越趋近于一条平直线,拟合的直线与描点所得图线也更相近。

如果其绝对值越靠近0,那么就说明线性相关性越差,根据数据点描出的图线和拟合曲线相差越远(当相关系数太小时,本来拟合就已经没有意义,如果强行拟合一条直线,再把数据点在同一坐标纸上画出来,可以发现大部分的点偏离这条直线很远,所以用这个直线来拟合是会出现很大误差的或者说是根本错误的)。

分为一元线性回归和多元线性回归线性回归方程中,回归系数的含义一元:Y^=bX+a b表示X每变动(增加或减少)1个单位,Y平均变动(增加或减少)b各单位多元:Y^=b1X1+b2X2+b3X3+a 在其他变量不变的情况下,某变量变动1单位,引起y平均变动量以b2为例:b2表示在X1、X3(在其他变量不变的情况下)不变得情况下,X2每变动1单位,y平均变动b2单位就一个reg来说y=a+bx+ea+bx的误差称为explained sum of squaree的误差是不能解释的是residual sum of square总误差就是TSS所以TSS=RSS+ESS判定系数也叫拟合优度、可决系数。

线性回归相关系数R

线性回归相关系数R线性回归相关系数R是线性回归分析中最重要的指标之一,也是最常用的指标之一。

它可以反映一个变量与另一变量之间的关系强度。

R值介于 -1 1 之间,其中值越接近 1明两个变量的关系越紧密,反之值越接近 -1表明两个变量的关系越松散。

其中,R绝对值大于 0.7时候,表明这两个变量之间的关系被认为是强的,其绝对值小于 0.3表明这两个变量之间的关系被视为微弱。

因此,在使用线性回归进行研究时,需要考虑线性回归相关系数R。

它可以反映模型对观测样本的拟合程度,可以帮助我们观察研究中两个变量之间的关系。

在有效地解释结果之前,不可能忽视这项指标的影响。

在计算R的时候,首先要计算出其分子各项及其分母各项的值,在计算和回归分析中,其分子各项及其分母各项均为不同变量的和。

其中,分子各项依次为:个体变量总和x∑y,瞬时变量总和xyy,瞬时变量总和(1+∑y2);而分母各项依次为:瞬时变量总和(∑x2),总体变量总和(∑xy),瞬时变量总和(1+∑x2)。

之后,根据计算出的数值,计算出r的值,公式如下: r=∑xy(∑x∑y/n)/[√{∑x2(∑x2/n)}*√{∑y2(∑y2/n)]完成计算后,我们可以看到计算出的值可以介于-1到1之间,这个值可以反映两个变量的相关性,以及回归方程预测能力。

线性回归相关系数R的应用相当广泛,不仅可以测量两个变量之间的相关性,还可以测量模型对样本观测值的拟合程度,进而检验模型的效果及准确度等。

通过统计分析,研究可以得出不同变量之间的关系,进而更好地预测和解释现象。

然而,在使用线性回归模型之前,需要考虑线性回归相关系数R,它可以反映两变量之间的关系,可以帮助我们有效地分析结果,以便做出正确的决策。

线性回归相关系数R

线性回归相关系数R线性回归(LinearRegression)是一种用来分析两种变量间关系的统计技术,其中一个变量是解释变量,另一个变量是结果变量。

在学习线性回归时,一个非常重要的指标是相关系数r,也叫作Pearson 相关系数。

本文将介绍线性回归相关系数R,以及它对线性回归的重要性以及如何计算它。

什么是线性回归相关系数R?线性回归相关系数R是一种有效的度量两个变量之间相关性的指标。

它是一种可以评估变量之间在回归方程中的度量,它可以告诉我们两个变量之间是否有线性关系或接近线性关系,以及它们之间的线性度。

线性回归相关系数R取值范围线性回归相关系数r的取值范围为-1到1。

当r的值等于1时,代表两个变量之间有很强的线性关系;当r的值等于0时,代表两个变量之间没有线性关系;当r的值等于-1时,代表两个变量之间有强烈的负线性关系。

线性回归相关系数R的重要性线性回归相关系数r是研究两个变量间相关性的重要指标,它能反映变量之间关系的强弱,并可用于确定线性回归方程的系数。

它可以帮助研究者识别出研究中变量之间有趣的关系,并可以用来把变量之间的线性关系转换成数学表达式。

如何计算线性回归相关系数R?线性回归相关系数R可以用下式来计算:R=∑(xix)(yiy)/√(∑(xix)^2)(∑(yiy)^2)其中,x为x变量的平均值,y为y变量的平均值。

xi为x变量的实际值,yi为y变量的实际值。

总结线性回归相关系数R是评估变量之间关系强弱的一种重要指标,它的值可以在-1到1之间变化。

研究者可以通过上述公式计算线性回归相关系数R,从而分析出变量之间的关系。

而且,线性回归相关系数R也可以用来确定线性回归方程的系数以及变量之间的线性关系。

线性回归中的相关系数

线性回归中的相关系数山东 胡大波线性回归问题在生活中应用广泛,求解回归直线方程时,应该先判断两个变量就是否就是线性相关,若相关再求其直线方程,判断两个变量有无相关关系的一种常用的简便方法就是绘制散点图;另外一种方法就是量化的检验法,即相关系数法.下面为同学们介绍相关系数法. 一、关于相关系数法统计中常用相关系数r 来衡量两个变量之间的线性相关的强弱,当i x 不全为零,y i 也不全为零时,则两个变量的相关系数的计算公式就是:()()nnii i ixx y y x ynx yr ---==∑∑r 就叫做变量y 与x 的相关系数(简称相关系数).说明:(1)对于相关系数r ,首先值得注意的就是它的符号,当r 为正数时,表示变量x ,y 正相关;当r 为负数时,表示两个变量x ,y 负相关;(2)另外注意r 的大小,如果[]0.751r ∈,,那么正相关很强;如果[]10.75r ∈--,,那么负相关很强;如果(]0.750.30r ∈--,或[)0.300.75r ∈,,那么相关性一般;如果[]0.250.25r ∈-,,那么相关性较弱.下面我们就用相关系数法来分析身边的问题,确定两个变量就是否相关,并且求出两个变量间的回归直线. 二、典型例题剖析(1)对变量y 与x 进行相关性检验;(2)如果y 与x 之间具有线性相关关系,求回归直线方程; (3)如果父亲的身高为73英寸,估计儿子身高.解:(1)66.8x =,67y =,102144794i i x ==∑,102144929.22i i y ==∑,4475.6x y =,24462.24x =,24489y =,10144836.4i i i x y ==∑,所以10i ix ynx yr -∑44836.4104475.6(4479444622.4)(44929.2244890)-⨯=--80.40.9882.04≈≈, 所以y 与x 之间具有线性相关关系. (2)设回归直线方程为y a bx =+,则101102211010i ii i i x yxyb x x==-=-∑∑44836.4447560.46854479444622.4-=≈-,670.468566.835.7042a y bx =-=-⨯=.故所求的回归直线方程为0.468535.7042y x =+. (3)当73x =英寸时,0.46857335.704269.9047y =⨯+=, 所以当父亲身高为73英寸时,估计儿子的身高约为69、9英寸.点评:回归直线就是对两个变量线性相关关系的定量描述,利用回归直线,可以对一些实际问题进行分析、预测,由一个变量的变化可以推测出另一个变量的变化.这就是此类问题常见题型.例2 10其中x 为高一数学成绩,y 为高二数学成绩. (1)y 与x 就是否具有相关关系;(2)如果y 与x 就是相关关系,求回归直线方程. 解:(1)由已知表格中的数据,利用计算器进行计算得 101710ii x==∑,101723i i y ==∑,71x =,72.3y =,10151467i i i x y ==∑.102150520ii x==∑,102152541i i y ==∑.1010i ix yx yr -=∑0.78=≈.由于0.78r ≈,由0.780.75>知,有很大的把握认为x 与y 之间具有线性相关关系. (2)y 与x 具有线性相关关系,设回归直线方程为y a bx =+,则1011022211051467107172.31.2250520107110i ii i i x yx yb x x==--⨯⨯==≈-⨯-∑∑,72.3 1.227114.32a y bx =-=-⨯=-.所以y 关于x 的回归直线方程为 1.2214.32y x =-.点评:通过以上两例可以瞧出,回归方程在生活中应用广泛,要明确这类问题的计算公式、解题步骤,并会通过计算确定两个变量就是否具有相关关系.。

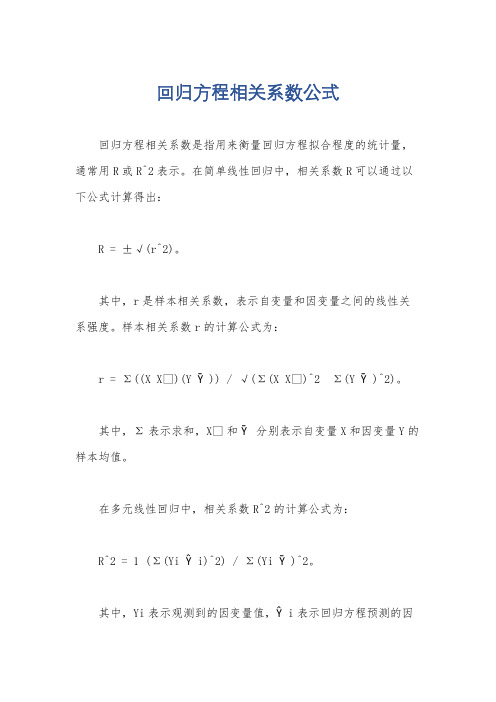

回归方程相关系数公式

回归方程相关系数公式

回归方程相关系数是指用来衡量回归方程拟合程度的统计量,通常用R或R^2表示。

在简单线性回归中,相关系数R可以通过以下公式计算得出:

R = ±√(r^2)。

其中,r是样本相关系数,表示自变量和因变量之间的线性关系强度。

样本相关系数r的计算公式为:

r = Σ((X X̄)(Y Ȳ)) / √(Σ(X X̄)^2 Σ(Y Ȳ)^2)。

其中,Σ表示求和,X̄和Ȳ分别表示自变量X和因变量Y的样本均值。

在多元线性回归中,相关系数R^2的计算公式为:

R^2 = 1 (Σ(Yi Ŷi)^2) / Σ(Yi Ȳ)^2。

其中,Yi表示观测到的因变量值,Ŷi表示回归方程预测的因

变量值,Ȳ表示因变量的样本均值。

相关系数R或R^2的取值范围在0到1之间,越接近1表示回归方程对样本数据的拟合程度越好,越接近0表示拟合程度越差。

相关系数的正负号表示自变量和因变量之间的正负相关关系。

需要注意的是,相关系数虽然可以衡量回归方程的拟合程度,但并不能说明因果关系,因此在解释回归分析结果时,需要综合考虑其他因素和背景知识。

线性回归相关系数R

线性回归相关系数R线性回归是统计学中最基础的方法之一,它用于描述一系列变量之间的相互关系,从而预测其中一种变量的变化对另一种变量的影响。

线性回归的一个重要统计指标就是相关系数R,其反映了变量之间的关系的强度,可以帮助我们更深入地理解变量之间的关系,从而更好地设计管理措施,从而获得更好的结果。

相关系数R表示两个变量之间的关系强度。

其取值可以介于-1到+1之间,R的绝对值越大,表明变量之间的关系越强,变化也越明显,效果越显著。

如果两个变量之间的R值为正,表示它们之间存在正相关,如果R值为负,表示它们之间存在负相关。

线性回归中的相关系数R可以用来衡量变量之间的相关性,以及线性回归模型的拟合能力。

它可以帮助我们更好地了解实际问题中的变量之间的关系,并确定最佳拟合线性回归模型,从而使数据分析更有效。

对于可以使用线性回归分析的实际问题,分析过程中最重要的步骤之一就是计算R值。

R值可以用来衡量变量之间的相关性,从而进一步确定变量间的关系是正相关还是负相关,从而更好地利用数据来解决问题。

为了计算相关系数R,首先需要准备好被观察变量的观察数据。

在计算R值之前,可以通过图表的方式查看变量之间的数据分布情况,以便快速发现异常情况,然后再进行深入的数据分析。

在计算R值之后,通常可以使用卡方检验确定R值是否显著,即变量之间是否存在一定程度的显著关系。

如果通过卡方检验发现R值运算结果显著,则表明变量之间存在一定的相关性,可以使用线性回归分析来更详细地解释变量之间的关系。

综上所述,线性回归中的相关系数R是一个重要的统计参数,可以用来反映两个变量之间的关系强度,帮助我们更好地理解变量之间的关系,从而更有效地利用数据管理措施,从而获得更好的结果。

线性回归方程中的相关系数r

2.多元线性回归分析中的参数

(1)宜相关系数R•亘和关系数卷示口变域x与其他的因变办i之间线性相关密切程度 的指标,圮相关系数使用字母尺表示*

复相关系数的取值范m^o-LZ间。其值越接近I,表示具线性关系越强,rfuJttfi越 接近0,表示线性关系越差。

在样本容量一定的情况下,增加解释变量必定使得自由度减少,所以调整的思路是:将残差

(4)无口相关性。假设随机误差项-的逐次观察值互不相关。即Cogi,e p=0(i^j)o

(5)£与x的不相关性。假设随机误差项J与相应的口变录凡对因变域y的影响相互

独立。换言之,两者对因变量y的影响是可以区分的。即Cov( e,,x.)=Oo

3.一元线性回归方程的检验

根拥原始数据,求出冋归方程后就需妥对冋归方程进彳J•检验。检验的假设是总体冋归 系数为0。另外要检验回归方程对因变虽的预测效果如何。

线性回归方程中的相关系数

r=刀(Xi-X的平均数)(Yi-Y平均数”根号下[刀(Xi-X平均数)A2*刀(Yi-Y平均数)A2]

R2就是相关系数的平方,

R在一元线性方程就直接是因变量自变量的相关系数,多元则是复相关系数

判定系数RA2

也叫拟合优度、可决系数。表达式是:

RA2=ESS/TSS=1-RSS/TSS

(4)DTirbui-^'atsoii检验

在对回归模型的诊断中,有一个非常重要的回归模型假设需要诊断,那就是回归模型 中的误差项的独立性.如杲误基项不独立,那么对回归摸吃的任何估计与假设所作出的第 论都是不可靠的。

其参数称为Dw或D*D的取值范围是0<D<4,它的统计学意义如F;

•当残差与自变量互为独立时’D那其

线性回归中的相关系数

线性回归中的相关系数文档编制序号:[KKIDT-LLE0828-LLETD298-POI08]线性回归中的相关系数山东胡大波线性回归问题在生活中应用广泛,求解回归直线方程时,应该先判断两个变量是否是线性相关,若相关再求其直线方程,判断两个变量有无相关关系的一种常用的简便方法是绘制散点图;另外一种方法是量化的检验法,即相关系数法.下面为同学们介绍相关系数法.一、关于相关系数法统计中常用相关系数r来衡量两个变量之间的线性相关的强弱,当x不全为零,y ii也不全为零时,则两个变量的相关系数的计算公式是:r就叫做变量y与x的相关系数(简称相关系数).说明:(1)对于相关系数r,首先值得注意的是它的符号,当r为正数时,表示变量x,y正相关;当r为负数时,表示两个变量x,y负相关;(2)另外注意r的大小,如果[]r∈,,那么正相关很强;如果[]0.751r∈--,,那10.75么负相关很强;如果(],或[)r∈,,那么相关性一般;如果0.300.75r∈--0.750.30[]r∈-,,那么相关性较弱.0.250.25下面我们就用相关系数法来分析身边的问题,确定两个变量是否相关,并且求出两个变量间的回归直线.二、典型例题剖析例1测得某国10对父子身高(单位:英寸)如下:(1)对变量y 与x 进行相关性检验;(2)如果y 与x 之间具有线性相关关系,求回归直线方程; (3)如果父亲的身高为73英寸,估计儿子身高.解:(1)66.8x =,67y =,102144794i i x ==∑,102144929.22i i y ==∑,4475.6x y =,24462.24x =,24489y =,10144836.4i i i x y ==∑,所以10i ix ynx yr -=∑80.40.9882.04≈≈, 所以y 与x 之间具有线性相关关系.(2)设回归直线方程为y a bx =+,则101102211010i ii i i x yxyb x x==-=-∑∑44836.4447560.46854479444622.4-=≈-,670.468566.835.7042a y bx =-=-⨯=.故所求的回归直线方程为0.468535.7042y x =+. (3)当73x =英寸时,0.46857335.704269.9047y =⨯+=, 所以当父亲身高为73英寸时,估计儿子的身高约为英寸.点评:回归直线是对两个变量线性相关关系的定量描述,利用回归直线,可以对一些实际问题进行分析、预测,由一个变量的变化可以推测出另一个变量的变化.这是此类问题常见题型.例2 10名同学在高一和高二的数学成绩如下表:其中x 为高一数学成绩,y 为高二数学成绩. (1)y 与x 是否具有相关关系;(2)如果y 与x 是相关关系,求回归直线方程. 解:(1)由已知表格中的数据,利用计算器进行计算得 101710i i x ==∑,101723i i y ==∑,71x =,72.3y =,10151467i i i x y ==∑.102150520ii x==∑,102152541i i y ==∑.0.78=≈.由于0.78r ≈,由0.780.75>知,有很大的把握认为x 与y 之间具有线性相关关系. (2)y 与x 具有线性相关关系,设回归直线方程为y a bx =+,则1011022211051467107172.31.2250520107110i ii i i x yx yb x x==--⨯⨯==≈-⨯-∑∑,72.3 1.227114.32a y bx =-=-⨯=-.所以y 关于x 的回归直线方程为 1.2214.32y x =-.点评:通过以上两例可以看出,回归方程在生活中应用广泛,要明确这类问题的计算公式、解题步骤,并会通过计算确定两个变量是否具有相关关系.。

线性回归中的相关系数(精.选)

山东胡大波

线性回归问题在生活中应用广泛,求解回归直线方程时,应该先判断两个变量是否是线性相关,若相关再求其直线方程,判断两个变量有无相关关系的一种常用的简便方法是绘制散点图;另外一种方法是量化的检验法,即相关系数法.下面为同学们介绍相关系数法.

一、关于相关系数法

统计中常用相关系数r来衡量两个变量之间的线性相关的强弱,当 不全为零,yi也不全为零时,则两个变量的相关系数的计算公式是:

(2)如果y与x之间具有线性相关关系,求回归直线方程;

(3)如果父亲的身高为73英寸,估计儿子身高.

解:(1) , , , , , ,

, ,

所以

,

所以y与x之间具有线性相关关系.

(2)设回归直线方程为 ,则 ,

.

故所求的回归直线方程为 .

(3)当 英寸时, ,

所以当父亲身高为73英寸时,估计儿子的身高约为69.9英寸.

r就叫做变量y与x的相关系数(简称相关系数).

说明:(1)对于相关系数r,首先值得注意的是它的符号,当r为正数时,表示变量x,y正相关;当r为负数时,表示两个变量x,y负相关;

(2)另外注意r的大小,如果 ,那么正相关很强;如果 ,那么负相关很强;如果 或 ,那么相关性一般;如果 ,那么相关性较弱.

下面我们就用相关系数法来分析身边的问题,确定两个变量是否相关,并且求出两个变量间的回归直线.

二、典型例题剖析

例1测得某国10对父子身高(单位:英寸)如下:

父亲

身高( )

60

62

64

65

66

67

68

70

72

74

儿子

身高( )

63.5

65.2

线性回归中的相关系数

,

.

所以y关于x的回归直线方程为 .

点评:通过以上两例可以看出,回归方程在生活中应用广泛,要明确这类问题的计算公式、解题步骤,并会通过计算确定两个变量是否具有相关关系.

2设回归直线方程为 ,则 ,

.

故所求的回归直线方程为 .

3当 英寸时, ,

所以当父亲身高为73英寸时,估计儿子的身高约为英寸.

点评:回归直线是对两个变量线性相关关系的定量描述,利用回归直线,可以对一些实际问题进行分析、预测,由一个变量的变化可以推测出另一个变量的变化.这是此类问题常见题型.

例2 10名同学在高一和高二的数学成绩如下表:

线性回归中的相关系数

山东 胡大波

线性回归问题在生活中应用广泛,求解回归直线方程时,应该先判断两个变量是否是线性相关,若相关再求其直线方程,判断两个变量有无相关关系的一种常用的简便方法是绘制散点图;另外一种方法是量化的检验法,即相关系数法.下面为同学们介绍相关系数法.

一、关于相关系数法

统计中常用相关系数r来衡量两个变量之间的线性相关的强弱,当 不全为零,yi也不全为零时,则两个变量的相关系数的计算公式是:

r就叫做变量y与x的相关系数简称相关系数.

说明:1对于相关系数r,首先值得注意的是它的符号,当r为正数时,表示变量x,y正相关;当r为负数时,表示两个变量x,y负相关;

2另外注意r的大小,如果 ,那么正相关很强;如果 ,那么负相关很强;如果 或 ,那么相关性一般;如果 ,那么相关性较弱.

下面我们就用相关系数法来分析身边的问题,确定两个变量是否相关,并且求出两个变量间的回归直线.

74

65

74

76

75

线性回归中的相关系数

说明:(1)对于相关系数r,首先值得注意的是它的符号,当r为正数时,表示变量x,y正相关;当r为负数时,表示两个变量x,y负相关;

(2)另外注意r的大小,如果 ,那么正相关很强;如果 ,那么负相关很强;如果 或 ,那么相关性一般;如果 ,那么相关性较弱.

线性回归中的相关系数

山东胡大波

线性回归问题在生活中应用广泛,求解回归直线方程时,应该先判断两个变量是否是线性相关,若相关再求其直线方程,判断两个变量有无相关关系的一种常用的简便方法是绘制散点图;另外一种方法是量化的检验法,即相关系数法.下面为同学们介绍相关系数法.

一、关于相关系数法

统计中常用相关系数r来衡量两个变量之间的线性相关的强弱,当 不全为零,yi也不全为零时,则两个变量的相关系数的计算公式是:

(2)如果y与x之间具有线性相关关系,求回归直线方程;

(3)如果父亲的身高为73英寸,估计儿子身高.

解:(1) , , , , , ,

, ,

所以

,

所以y与x之间具有线性相关关系.

(2)设回归直线方程为 ,则 ,

.

故所求的回归直线方程为 .

(3)当 英寸时, ,

所以当父亲身高为73英寸时,估计儿子的身高约为69.9英寸.

下面我们就用相关系数法来分析身边的问题,确定两个变量是否相关,并且求出两个变量间的回归直线.

二、典型例题剖析

例1测得某国10对父子身高(单位:英寸)如下:

父亲

身高( )

60

62

64

65

66

67

68

70

72

74

儿子

身高( )

63.5

6.9

线性回归方程中的相关系数r

•当相邻两点的残差为负相关时,D>2.

(耳残差图示法,在直角坐标系中*以预測值为冈横轴,以y与之间冈的误差©为纵轴(或学生化残蓋与拟和值或一个口变皐为纵轴h绘制毁莖的散点图。如果散点呈现出明証的规律性,则认为存在口相关性或者非线性或者非常数方差的问题•这样需要对数 据、冈变址或白变:/进行变换“如果散点呈现随机分布,斜率为零,则认为自相关存在的 可能性不大,独立性倔设成立。

因为1- (TSS-RSS)/TSS就可以化为RSS/TSS

⑶零阶和关系数、部分相关与偏相关系数

・这里的零阶相关系数(ZeroOidei)Lf算所有口变呈与凶变吐之间的简单相关关系。

•部分相关(PanConelarion)表示:任排除了其他口变试对圧的影响后,当一牛口变 暈进入回归方程模型后,复相关系数的平方增加

――但是,现实情况往往是,由增加解释变量个数引起的R2的增大与拟合好坏无关,R2

需调整。

这就有了调整的拟合优度

RSS

TSSl®

在样本容量一定的情况下,离差平方和分别除以各自的自由度,以剔除变量个数对拟合优度的影响:其

中:n-k-1为残差平方和的自由度,n-1为总体平方和的自由度。

(3)方差齐性检验

SPSS中pearson(皮尔逊相关系数)看r值还是P值,确定相关性

两个值都要看,r值表示在样本中变量间的相关系数,表示相关性的大小;p值是检验值,

是检验两变量在样本来自的总体中是否存在和样本一样的相关性。

SPSS回归系数SIG

在SPSS软件统计结果中,不管是回归分析还是其它分析,都会看到“SIG;

该统计量越接近于1,模型的拟合优度越高。

问题:在应用过程中发现,如果在模型中增加一个解释变量,R2往往增大

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

线性回归方程中的相关系数rr=∑(Xi-X的平均数)(Yi-Y平均数)/根号下[∑(Xi-X平均数)^2*∑(Yi-Y平均数)^2]R2就是相关系数的平方,R在一元线性方程就直接是因变量自变量的相关系数,多元则是复相关系数判定系数R^2也叫拟合优度、可决系数。

表达式是:R^2=ESS/TSS=1-RSS/TSS该统计量越接近于1,模型的拟合优度越高。

问题:在应用过程中发现,如果在模型中增加一个解释变量,R2往往增大这就给人一个错觉:要使得模型拟合得好,只要增加解释变量即可。

——但是,现实情况往往是,由增加解释变量个数引起的R2的增大与拟合好坏无关,R2需调整。

这就有了调整的拟合优度:R1^2=1-(RSS/(n-k-1))/(TSS/(n-1))在样本容量一定的情况下,增加解释变量必定使得自由度减少,所以调整的思路是:将残差平方和与总离差平方和分别除以各自的自由度,以剔除变量个数对拟合优度的影响:其中:n-k-1为残差平方和的自由度,n-1为总体平方和的自由度。

总是来说,调整的判定系数比起判定系数,除去了因为变量个数增加对判定结果的影响。

R = R接近于1表明Y与X1,X2 ,…,Xk之间的线性关系程度密切;R接近于0表明Y与X1,X2 ,…,Xk之间的线性关系程度不密切相关系数就是线性相关度的大小,1为(100%)绝对正相关,0为0%,-1为(100%)绝对负相关相关系数绝对值越靠近1,线性相关性质越好,根据数据描点画出来的函数-自变量图线越趋近于一条平直线,拟合的直线与描点所得图线也更相近。

如果其绝对值越靠近0,那么就说明线性相关性越差,根据数据点描出的图线和拟合曲线相差越远(当相关系数太小时,本来拟合就已经没有意义,如果强行拟合一条直线,再把数据点在同一坐标纸上画出来,可以发现大部分的点偏离这条直线很远,所以用这个直线来拟合是会出现很大误差的或者说是根本错误的)。

分为一元线性回归和多元线性回归线性回归方程中,回归系数的含义一元:Y^=bX+a b表示X每变动(增加或减少)1个单位,Y平均变动(增加或减少)b各单位多元:Y^=b1X1+b2X2+b3X3+a 在其他变量不变的情况下,某变量变动1单位,引起y平均变动量以b2为例:b2表示在X1、X3(在其他变量不变的情况下)不变得情况下,X2每变动1单位,y平均变动b2单位就一个reg来说y=a+bx+ea+bx的误差称为explained sum of squaree的误差是不能解释的是residual sum of square总误差就是TSS所以TSS=RSS+ESS判定系数也叫拟合优度、可决系数。

表达式是该统计量越接近于1,模型的拟合优度越高。

问题:在应用过程中发现,如果在模型中增加一个解释变量, R2往往增大这就给人一个错觉:要使得模型拟合得好,只要增加解释变量即可。

——但是,现实情况往往是,由增加解释变量个数引起的R2的增大与拟合好坏无关,R2需调整。

这就有了调整的拟合优度在样本容量一定的情况下,增加解释变量必定使得自由度减少,所以调整的思路是:将残差平方和与总离差平方和分别除以各自的自由度,以剔除变量个数对拟合优度的影响:其中:n-k-1为残差平方和的自由度,n-1为总体平方和的自由度。

总是来说,调整的判定系数比起判定系数,除去了因为变量个数增加对判定结果的影响。

顺便补充一下:一般做回归的时候要求拟合优度(实际值与拟合值相关系数的平方)越高越好,可以通过增加解释变量来实现,可是解释变量多了后很多解释变量的系数T检验不显著了,而且增加很多变量后模型的自由度就减少了,这些情况狂的存在往往使得模型预测不精确;修正拟合优度就是将残差平方和跟总离差平方和分别除以各自的自由度,这样就剔除了变量个数对其影响了。

首先有一个恒等式:TSS = ESS + RSS即总偏差平方和= 回归平方和+ 残差平方和通常情况,我们都是讨论解释变量对总效应的贡献,使用一个叫“拟合优度”(或者叫“判定系数”)的指标其定义为:回归平方和/ 总偏差平方和=ESS/TSS = (TSS-RSS)/TSS =(923-325)/923如果说随机误差对总效应的贡献,那可以直接RSS/TSS因为 1 - (TSS-RSS)/TSS 就可以化为RSS / TSSSPSS中pearson(皮尔逊相关系数)看r值还是P值,确定相关性两个值都要看,r值表示在样本中变量间的相关系数,表示相关性的大小;p值是检验值,是检验两变量在样本来自的总体中是否存在和样本一样的相关性。

SPSS回归系数SIG在SPSS软件统计结果中,不管是回归分析还是其它分析,都会看到“SIG”,SIG=significance,意为“显著性”,后面的值就是统计出的P值,如果P值0.01<P<0.05,则为差异显著,如果P<0.01,则差异极显著sig是指的的显著性水平,就是p值,一般来说接近0.00越好,过大的话只能说不显著,sig是F检验的结果,<0.01代表方程通过检验,进行回归分析是有效的F表示数据的方差,sig表示显著性,也就是对F检验的结果,如果sig>0.05则说明模型受误差因素干扰太大不能接受。

R是复相关系数,表示观测值和模型描述值之间的线性相关系数,越大越好。

R方通俗的说就是解释率,就是说你的自变量能够解释多少因变量的变化。

具体到你这个就是模型不能接受,自变量解释了22.1%,剩下的只能用误差解释。

spss软件的线性回归分析中,输出了一个anova表,表中的回归、残差、平方和、df、均方、F、sig分别代表什么回归是方法残差是实测与预计值的差值平方和有很多个,不同的平方和的意思不一样df是自由度均方是方差除以自由度f是f分布的统计量sig是p值anova表中的“回归平方和”表示反应变量的变异中的回归模式中所包含的自变量所能解释的部分。

“残差平方和”代表反应变量的变异中没有被回归模型所包含的变量解释的部分。

这两个值与样本量及模型中自变量的个数有关,样本量越大,相应变异就越大。

df是自由度,是自由取值的变量个数,F为F检验统计量,用于检验该回归方程是否有意义,当Sig对应的值小于0.05(当显著性水平为0.05时)时,说明所建立的回归方程具有统计学意义,即自变量和因变量之间存在线性关系。

多元线性回归分析中,t检验与F检验有何不同t检验常能用作检验回归方程中各个参数的显著性,而f检验则能用作检验整个回归关系的显著性。

各解释变量联合起来对被解释变量有显著的线性关系,并不意味着每一个解释变量分别对被解释变量有显著的线性关系F检验主要是检验因变量同多个自变量的整体线性关系是否显著,在k个自变量中,只要有一个自变量同因变量的线性关系显著,t检验则是对每个回归系数分别进行单独的检验,以判断每个自变量对因变量的影响是否显著。

计算结果肺活量例子标准化回归系数(Beta值)在多元回归中被用来比较变量间的重要性B是指回归系数,beta是指标准回归系数,beta=B/S(B),beta是用来比较各个系数之间的绝对作用或者贡献的大小,B值是不能判断的绝对贡献的。

t值是对该回归系数B做假设检验的结果,P值小于0.05才可以认为有意义,但是具体问题要具体分析,有的时候要考虑交互作用等常数项为负p值0.04,拒绝常数项为0的假设,统计显著,没问题beta coefficient就是标准回归系数,它是首先把各个自变量进行Z转换(数据值-数据平均值然后除以标准差)之后再进行回归,此时得出的回归系数称为标准化回归系数。

Z转换可以把各个自变量的数级、量纲统一标准化,也就可以根据标准化回归系数的大小比较出各个自变量在回归方程中的效应大小。

标准回归系数standardizedregressioncoefficient或standardregressioncoefficient消除了因变量y和自变量x1,x2,…xn所取单位的影响之后的回归系数,其绝对值的大小直接反映了xi对y的影响程度计算方法对数据标准化,即将原始数据减去相应变量的均数后再除以该变量的标准差,计算得到的回归方程称为标准化回归方程,相应得回归系数为标准化回归系数。

公式若假定回归方程的形式如下:Y=b0+b1X1+b2X2+…+bjXj+…+bJXJ(Y是估计值)其中,回归参数b0,b1,…,bJ通过最小二乘法求得。

则标准化回归系数bj'=bj*(Xj的标准差/Y的标准差)理解方法标准化回归系数(Beta值)在多元回归中被用来比较变量间的重要性。

但是由于重要性这一词意义的含糊性,这一统计常被误用。

有时人们说重要性,是指同样的条件下,哪一个东西更有效。

在提高教学质量上,是硬件条重要还是师资更重要?如果是师资更重要,那么同样的物力投在师资上就可以更快地提高教学质量。

但是这里要比较的两者必须有同样的测量单位,如成本(元)。

如果变量的单位不同,我们不能绝对地说那个变量更重要。

不同单位的两个东西是不能绝对地比出高低轻重来。

要想进行绝对地比较,就需要两个东西有着共同的测度单位,否则无法比较。

而标准化回归系数说的重要性则与上面的意义不同,这是一种相对的重要性,与某一特定的情况下,自变量间的离散程度有关。

比如说,虽然我们不能绝对地说出教育和年资在决定收入上那一个一定是重要的,但如果现在大家的教育程度比较相似,那么在收入的决定上,工作年数就是决定因素;反之,如果工作年数没有太大区别,那么教育就成为了重要原因。

这里的重要性是相对的,是根据不同情况而改变的。

再举一个通俗的例子,研究者研究的是遗传因素和后天因素对于人成长的影响。

那么在一个社会境遇悬殊巨大的环境中,有人在贫民窟成长,有人在贵族学校上学,那么我们会发现人格的大部分差异会从后天环境因素得到解释,而遗传的作用就相对较小;相反,如果儿童都是在一个相差不大的环境中长大的,你会发现,遗传会解释大部分的人格差异。

这种意义上的重要性,不仅与这一自变量的回归系数有关系,而且还与这个自变量的波动程度有关系:如果其波动程度较大,那么就会显得较为重要;否则,就显得不太重要。

标准化回归系数正是测量这种重要性的。

从标准化回归系数的公式中也可看出,Beta值是与自变量的标准差与成正比的,自变量波动程度的增加,会使它在这一具体情况下的重要性增加。

但是如果将两种重要性混同,就会得到误导性结论。

如环境因素的Beta值比遗传因素的Beta值大,就认为在个体的人格发展上应更注意环境因素,而轻视遗传因素,在目前对于Beta值的错误观念非常流行,甚至是一些高手中。

标准化回归系数的比较结果只是适用于某一特定环境的,而不是绝对正确的,它可能因时因地而变化。

举例来说,从某一次数据中得出,在影响人格形成的因素中,环境因素的Beta值比遗传因素的Beta值大,这只能说明数据采集当时当地的情况,而不能加以任何不恰当的推论,不能绝对地不加任何限定地说,环境因素的影响就是比遗传因素大。