信息论习题课

信息论与编码习题

1 0 1 1 1 0 0 H 1 1 1 0 0 1 0 0 1 1 1 0 0 1

13为提高通信系统传输消息有效性,信源编码采用的方法 是

A.压缩信源的冗余度 C.研究码的生成矩阵 B.在信息比特中适当加入冗余比特 D.对多组信息进行交织处理

14、给定xi条件下随机事件yj所包含的不确定度和条件自信 息量p(yj /xi),( ) A.数量上不等,单位不同 B.数量上不等,单位相同 C.数量上相等,单位不同 D.数量上相等,单位相同 15、条件熵和无条件熵的关系是: A.H(Y/X)<H(Y) B.H(Y/X)>H(Y) C.H(Y/X)≤H(Y) D.H(Y/X)≥H(Y)

8、对于相同的信息,不同的观察者所获得的信息量可能 不同,指的是信息的( ) A 可度量性 B 相对性 C 可替代性 D 可共享性 9、信源熵不满足以下哪个性质?( ) A 确定性 B 非负性 C 连续性 D 可加性 10、二进制通信系统使用符号0和1,由于存在失真,传输 时会产生误码,用符号表示下列事件,u0:一个0发出, u1:一个1发出,v0 :一个0收到,v1:一个1收到。则已知 收到的符号,被告知发出的符号能得到的信息量是 ( )。 A H(U/V) B H(V/U) C H(U,V) D H(UV)

2,二元对称信道如图。

2)求该信道的信道容量。

x3 x4 x5 x6 x7 X x1 x2 3,.信源空间为 P( X ) 0.2 0.19 0.18 0.17 0.15 0.1 0.01 ,试构造二元霍夫曼码,计算其平均码长和编码效率(要 求有编码过程)。

信息论习题集

信息论习题集1.有一离散无记忆信源12,31,44s s ??(1)构造出一个即时码,求出信息传输率和编码效率;(2)对其二次扩展信源编码,并求出信息传输率及编码效率,并与(1)的结果相比较。

解:(1)其信源熵为21()()log ()0.75log 0.750.25log 0.250.81127i i i H X P x P x ==-=--=∑比特现利用二进制符号(0,1)进行编码,令s1=0,s2=1,这时平均码长 211(/i i i L p l ===∑码元信源符号)信息传输率为:()0.811(/H S R bit L==码元符号)编码的效率为2()0.811log rH S L η==(2)为了提高传输效率,根据香农第一定理得物理概念,利用霍夫曼编码方法信源中每一个信源符号的码长信息传输率为:()0.811=0.961(/27/32H S R bit L==码元符号)编码的效率为2()0.961log rH S L η==。

结论:二次扩展信源编码复杂一些,但信息传输率和编码效率提高了。

2.设有一离散信道,其信道传递矩阵为0.50.30.20.20.30.50.30.30.4?并设123()0.4,()()0.3P x P x P x ===,分别按最小错误概率准则和最大似然译码准则确定译码规则,并计算相应的平均错误概率。

2*23/16*31/16*327/16/=++(码元两个信源符号)227/32(/2L L ==码元信源符号)3.二元对称信道如图。

1)若32(0),(1)55p p ==,,求;2)求该信道的信道容量和最佳输入分布。

4. 信源空间为试构造二元最佳编码,计算其编码效率。

解:二元码的码字依序为:10,11,010,011,1010,1011,1000,1001(注必须要有编码过程)平均码长,编码效率5.设有一离散信道,其信道矩阵为,求:当,时,求平均互信息信道疑义度解:当,时,有则6.设有一个马尔可夫信源,其状态图如图所示:(1)求平稳状态下各状态极限概率Q(E (i ))。

信息论习题集

信息论习题集第二章2.1 同时掷2颗骰子,事件A 、B 、C 分别表示:(A )仅有一个骰子是3;(B )至少有一个骰子是4;(C )骰子上点数的总和为偶数。

试计算A 、B 、C 发生后所提供的信息量。

2.3 一信源有4种输出符号i x ,i =0,1,2,3,且p(i x )=1/4。

设信源向信宿发出3x ,但由于传输中的干扰,接收者收到3x 后,认为其可信度为0.9。

于是信源再次向信宿发送该符号(3x ),信宿准确无误收到。

问信源在两次发送中发送的信息量各是多少?信宿在两次接收中得到的信息量又各是多少? 2.5 一信源有6种输出状态,概率分别为()p A =0.5, ()p B =0.25, ()p C =0.125, ()p D = ()p E =0.05, ()p F =0.025试计算()H X 。

然后求消息ABABBA 和FDDFDF 的信息量(设信源先后发出的符号相互独立),并将之与长度为6的消息序列信息量的期望值相比较。

2.6 中国国家标准局所规定的二级汉字共6763个。

设每字使用的频度相等,求一个汉字所含的信息量。

设每个汉字用一个16⨯16的二元点阵显示,试计算显示方阵所能表示的最大信息量。

显示方阵的利用率是多少?2.7 已知信源发出1a 和2a 两种消息,且12 ()()1/2p a p a ==。

此消息在二进制对称信道上传输,信道传输特性为1122(|)(|)1p b a p b a ε==-,1221(|)(|)p b a p b a ε==。

求互信息量11(;)I a b 和12(;)I a b 。

2.8 已知二维随机变量XY 的联合概率分布()i j p x y 为:(0,0)(1,1)1/8p p ==,(0,1)(1,0)3/8p p ==,求(|)H X Y 。

2.13 有两个二元随机变量X 和Y ,它们的联合概率分布如表2.5所列,同时定义另一随机变量Z X Y =(一般乘积)。

[课件]信息论第2章课后习题PPT

![[课件]信息论第2章课后习题PPT](https://img.taocdn.com/s3/m/ba611356a417866fb84a8e6a.png)

2018/12/3

6

[2.7的解答] (a)是求事件“来自本市”与随机变量“是否 被录取”的半平均互信息量。 (b)是求事件“学过英语” 与随机变量“是否被录取”的半平均互信息量。

以x表示是否被录取(0表示被录取,1表示未被录取),y表示是 否为本市学生(0表示本市学生,1表示非本市学生) ,z表示 是否学过英语(0表示学过英语,1表示未学过英语) ,则 P(xyz=000)=(1/4)×(50%)×1=12.5%; P(xyz=001)=(1/4)×(50%)×0=0; P(xyz=010)=(1/4)×(50%)×(40%)=5%; P(xyz=011)=(1/4)×(50%)×(60%)=7.5%; P(xyz=100)=(3/4)×(10%)×1=7.5%; P(xyz=101)=(3/4)×(10%)×0=0; P(xyz=110)=(3/4)×(90%)×(40%)=27%; P(xyz=111)=(3/4)×(90%)×(60%)=40.5%。

2018/12/3 2

习题课

2.6 园丁植树一行,若有3棵白杨、4棵白桦和5棵梧桐。设这12 棵树可随机地排列,且每一种排列都是等可能的。若告诉你没 有两棵梧桐树相邻时,你得到了多少关于树的排列的信息? [2.6的解答] 共有12!种不同的排列。满足“没有两棵梧桐树相 邻”的排列个数为 8×1+7×2+6×3+5×4+4×5+3×6+2×7+1×8=120(为什么?) 记X=“树的排列情况”, Y=“梧桐树有无相邻位置”。则本题要 求半平均互信息量

I ( x ; z 0 ) P ( xz 00 ) P ( xz 00 ) P ( xz 10 ) P ( xz 10 ) log log P ( z 0 ) P ( x 0 ) P ( z 0 ) P ( z 0 ) P ( x 1 ) P ( z 0 ) 35 35 69 23 log log 0 . 143 104 26 104 26

信息论课后习题-PPT

(Hz)

5.11(续)

(3)同样由信道容量公式可得:

其中C,

S

C

2B 1

N

log 11,B=0.5MHz

可求得:S

?

N

2.14(续)

(1)求X1X2X3的联合熵和平均符号熵; (2)求这个链的极限平均符号熵; (3)求H0,H1,H2和它们所对应的冗余度。

解始:序(列1X)1X一2X阶3的平联稳合马熵尔:可夫链X1,X2 ,,Xr ,

的起

H (X1X2X3)

P(x1x2 x3 ) log P(x1x2 x3 )

N

H(XN

|

X N 1

X1) H2

33

P(ai )P(a j | ai ) log P(a j | ai )

i1 j1

(3) 1.251 bit/符号

H0 log 3 1.585 bit/符号

3

H1 P(ai ) log P(ai ) 1.414 bit/符号 i 1

H2 1.251 bit/符号

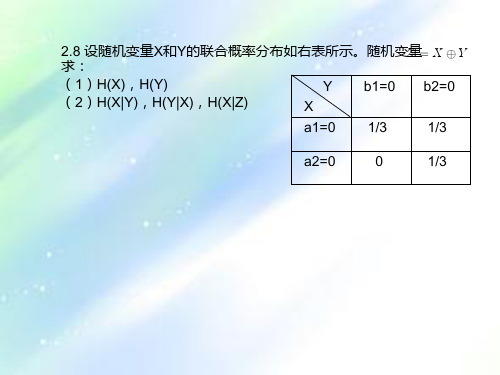

2.8 设随机变量X和Y的联合概率分布如右表所示。随机变Z量 X Y 求:

(1)H(X),H(Y)

Y b1=0 b2=0

(2)H(X|Y),H(Y|X),H(X|Z)

X

a1=0 1/3

1/3

a2=0

0

1/3

2.13 有一个马尔可夫信源,已知转移概率为:

P(S1

|

S1 )

2 3

,P

(

S2

|

S1 )

1 3

宽应为多少? (3)若信道通频带减为0.5MHz时,要保持相

同的信道容量,信道上的信号与噪声的平均功 率比值应等于多大?

信息论与编码习题

量

7、当信源符合( )时,信源熵最大。

A 均匀分布 B 等概分布 C 泊松分布 D 正态分布

8、对于相同的信息,不同的观察者所获得的信息量可能不同, 指的是信息的( )

A 可度量性 B 相对性 C 可替代性 D 可共享性

9、信源熵不满足以下哪个性质?( ) A 确定性 B 非负性 C 连续性 D 可加性

1 0 0 0 1 1 0 G 0 1 0 0 0 1 1

0 0 1 0 1 1 1 0 0 0 1 1 0 1

1 0 1 1 1 0 0 H 1 1 1 0 0 1 0

0 1 1 1 0 0 1

性发病率为0.5%,如果问一位男士他是否色盲,他的回答有可 能是“是”,或者“否”,从该男士的回答中得到平均信息量 是

A 0.366bit/sym B 0.414bit/sym C 0.259bit/sym D 0.887bit/sym

12、彩色电视显像管的屏幕上有5×105 个像元,设每个像元有64

4、下列离散信源,熵最大的是( )。

A. H(1/3,1/3,1/3); B. H(1/2,1/2);

C. H(0.9,0.1);

D. H(1/2,1/4,1/8,1/8)

5、以下选项中不是香农信息论中主要研究对象的是 A 信息的测度 B 信道容量 C 信息率失真函数 D 信息的

变换

6、以下关于信息量性质描述正确的是( )。 A 信息量可以为负 B 信息量是事件发生概率的递增函数

8、若一离散无记忆信源的信源熵H(X)等于2.5,对信源进行 等长的无失真二进制编码,则编码长度至少为 。

9、___提高通信的有效性,____目的是提高通信的可靠性,__

信息论第八章课后习题

(1)现将图像通过给定的信道传输,不考虑图像的任何统计特性,并采用二元

等长码,问需要多长时间才能传完这幅图像?

(2)若考虑图像的统计特性(不考虑图像的像素之间的依赖性),求此图像的

信源熵

H (S),并对灰度级进行霍夫曼最佳二元编码,问平均每个像素需

用多少二元码符号来表示?这时需多少时间才能传送完这幅图像?

1 1 1 1 1 1 1 1 1 1

2 2 2 2 2 2 2 2 2 2

2 2 2 2 2 2 2 3 3 3

3 3 3 3 3 3 3 4 4 4

4 4 4 4 4 4 4 5 5 5

5 5 5 5 6 6 6 6 6 6

7 7 7 7 7 8 8 8 8 8

另有一无损无噪二元信道,单位时间(秒)内传输

可见,二者的码字完全相同。

【8.2】设二元霍夫曼码为

(00,01,10,11)和(0,10,110,111),求出可以编得这样霍夫

曼码的信源的所有概率分布。

解:

二元霍夫曼编码的过程必定是信源缩减的过程,编码为

(00,01,10,11)的信

源,其码树如下图所示。

假设四个信源符号的概率分别是

i(2i -1) + 2(i +1) i2i + i + 22

L= == i +

i ii

2 + 12 + 12 + 1

【8.7】设信源

ss Lss

12 M -1 M ù

S :

pp L pp

12 M -1 M

M

i=1

é

信息论习题集+答案(完版整)

信息论习题集一、名词解释(每词2分)(25道)1、“本体论”的信息(P3)2、“认识论”信息(P3)3、离散信源(11)4、自信息量(12)5、离散平稳无记忆信源(49)6、马尔可夫信源(58)7、信源冗余度 (66)8、连续信源 (68)9、信道容量 (95)10、强对称信道 (99) 11、对称信道 (101-102)12、多符号离散信道(109)13、连续信道 (124) 14、平均失真度 (136) 15、实验信道 (138) 16、率失真函数 (139) 17、信息价值率 (163) 18、游程序列 (181) 19、游程变换 (181) 20、L-D 编码(184)、 21、冗余变换 (184) 22、BSC 信道 (189) 23、码的最小距离 (193)24、线性分组码 (195) 25、循环码 (213) 二、填空(每空1分)(100道)1、 在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用 三个方面的因素。

2、 1948年,美国数学家 香农 发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。

3、 按照信息的性质,可以把信息分成语法信息、语义信息和语用信息 。

4、 按照信息的地位,可以把信息分成 客观信息和主观信息 。

5、 人们研究信息论的目的是为了高效、可靠、安全 地交换和利用各种各样的信息。

6、 信息的可度量性 是建立信息论的基础。

7、 统计度量 是信息度量最常用的方法。

8、 熵是香农信息论最基本最重要的概念。

9、 事物的不确定度是用时间统计发生 概率的对数 来描述的。

10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用 随机矢量 描述。

11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为 其发生概率对数的负值。

12、自信息量的单位一般有 比特、奈特和哈特 。

13、必然事件的自信息是 0 。

14、不可能事件的自信息量是 ∞ 。

《信息论、编码与密码学》课后习题答案

《信息论、编码与密码学》课后习题答案第1章信源编码1.1 考虑一个信源概率为{0.30 , 0.25 , 0.20 , 0.15 , 0.10}的DMS求信源嫡H (X)。

5解:信源嫡H(X) = -£P k log 2( P k)H(X)=-[0.30*(-1.737)+0.25*(-2)+0.2*(-2.322)+0.15*(-2.737)+0.1*(-3.322)]=[0.521+0.5+0.464+0.411+0.332]=2.228(bit)故得其信源嫡H(X)为2.228bit1.2 证明一个离散信源在它的输出符号等概率的情况下其嫡达到最大值。

解:若二元离散信源的统计特性为P+Q=1 H(X)=-[P*log(P)+(1-P)*log(1-P)]对H(X)求导求极值,由dH(X)/d(P)=0可得log可知当概率P=Q=1/2时,有信源嫡H (X)max = 1(bit)对丁三元离散信源,当概率R = P2 = P3 = 1/3时,信源嫡H (X )m a=x1 .5 8 (5bit ),此结论可以推广到N元的离散信源。

1.3证明不等式lnx^x—1。

画出曲线y〔=lnx和y2 = x — 1的平■面图以表明上述不等式的正确性。

证明:f (x) = ln x 「x 1(x - 0) f(x)=【x令f(x),=0, x =1 又有x 0. 0 :. x < 1 时f(x) 0 此时 f(x) fx =0 也即 In x _x -1当x _1时同理可得此时Inx _x -1综上可得lnx 笑x -1证毕 绘制图形说明如下 可以很明确说明上述 不等式的正确性。

1.4证明I(X;Y)芝0。

在什么条件下等号成立?n mI(X ; V =' ' P(x,y j )i(x, y j )i 目j 目n m =' P(x,y j )logi 注j T 当和相互独立时等号成立。

信息论课后习题解答

问男,回答“否”所获得的信息量为:

男,平均回答中含有的信息量为:

同样,女为红绿色盲的概率空间为 问女,回答“是”所获昨的信息量为: 问女,回答“否”所获昨的信息量为: 女,平均回答中含有的信息量为

【2.12】 (1)为了使电视图像获得良好的清晰度和规定的适 当的对比度,需要用 5×105个像素和10个不同亮度电平,求传 递此图像所需的信息率(比特/秒)。并设每秒要传送 30帧图 像,所有像素是独立变化的,且所有亮度电平等概率出现。 (2)设某彩电系统,除了满足对于黑白电视系统的上述要求外, 还必须有30个不同的色彩度,试证明传输这彩色系统的信息率 要比黑白系统的信息率约大2.5倍。 解: (1)每个像素的电平取自10个不同的电平,形成的概率 空间为:

解: 每个像素的电平亮度形成了一个概率空间,如下:

平均每个像素携带的信息量为:

每帧图像由3×105个像素组成,且像素间是独立的,因此每帧图

像含有的信息量为:

平均每个汉字携带的信息量为 择1000字来描述,携带的信息量为

bit/sym; 选

需要汉字个数为:

【2.18】设有一信源,它在开始时以P(a)=0.6, P(b)=0.3, P(c)=0.1的概率发出X1。如果X1为a时,则 X2为 a、b、c 的概 率为1/3;如果X1为b时,则X2为 a、b、c 的概率为1/3;如果X1 为c时,则X2为a、b的概率为1/2,为c的概率为0。而且后面发 出Xi的概率只与Xi-1有关,又 。试用马尔克夫信源的图示法画出状态 转移图,并计算此信源的熵H∞。

解: 信源为一阶马尔克夫信源,其状态转换图如下所示。

根据上述状态转换图,设状态分别为

P(a)、P(b) 和P(c) ,

信息论基础 课后习题答案

信息论基础课后习题答案问题1问题:信息论的基本目标是什么?答案:信息论的基本目标是研究信息的传递、存储和处理的基本原理和方法。

主要关注如何量化信息的量和质,并通过定义信息熵、条件熵、互信息等概念来描述信息的特性和性质。

问题2问题:列举一些常见的信息论应用领域。

答案:一些常见的信息论应用领域包括:•通信领域:信息论为通信系统的性能分析和设计提供了基础方法,例如信道编码和调制调制等。

•数据压缩领域:信息论为数据压缩算法的研究和实现提供了理论依据,例如无损压缩和有损压缩等。

•隐私保护领域:信息论用于度量隐私保护方案的安全性和隐私泄露的程度,在隐私保护和数据共享中起着重要作用。

•机器学习领域:信息论被应用于机器学习中的特征选择、集成学习和模型评估等任务中,提供了许多有用的数学工具和概念。

•生物信息学领域:信息论被应用于分析DNA序列、蛋白质序列和生物网络等生物数据,发现其中的模式和规律。

问题3问题:信息熵是什么?如何计算信息熵?答案:信息熵是衡量一个随机变量的不确定性或信息量的度量值。

信息熵越大,表示随机变量的不确定性越高,每个可能的取值都相对等可能发生;反之,信息熵越小,表示随机变量的不确定性越低,某些取值较为集中或者出现的概率较大。

信息熵的计算公式如下所示:H(X) = -Σ P(x) * log2(P(x))其中,H(X) 表示随机变量 X 的信息熵,P(x) 表示随机变量X 取值为 x 的概率。

问题4问题:条件熵是什么?如何计算条件熵?答案:条件熵是在给定其他随机变量的条件下,一个随机变量的不确定性或信息量的度量。

条件熵基于条件概率定义,用于描述一个随机变量在给定其他相关随机变量的条件下的信息量。

条件熵的计算公式如下所示:H(Y|X) = -Σ P(x, y) * log2(P(y|x))其中,H(Y|X) 表示随机变量 Y 在给定随机变量 X 的条件下的条件熵,P(x, y) 表示随机变量 X 取值为 x 且随机变量 Y 取值为 y 的概率,P(y|x) 表示随机变量 Y 在给定随机变量 X 取值为x 的条件下取值为 y 的概率。

信息论习题集

信息论习题集第一章、判断题1、信息论主要研究目的是找到信息传输过程的共同规律,提高信息传输的可靠性、有效性、保密性和认证性,以达到信息传输系统的最优化。

(√)2、同一信息,可以采用不同的信号形式来载荷;同一信号形式可以表达不同形式的信息。

(√)3、通信中的可靠性是指使信源发出的消息准确不失真地在信道中传输;(√)4、有效性是指用尽量短的时间和尽量少的设备来传送一定量的信息。

(√)5、保密性是指隐蔽和保护通信系统中传送的消息,使它只能被授权接收者获取,而不能被未授权者接收和理解。

(√)6、认证性是指接收者能正确判断所接收的消息的正确性,验证消息的完整性,而不是伪造的和被窜改的。

(√)7、在香农信息的定义中,信息的大小与事件发生的概率成正比,概率越大事件所包含的信息量越大。

(×)第二章{一、判断题1、通信中获得的信息量等于通信过程中不确定性的消除或者减少量。

(√)2、离散信道的信道容量与信源的概率分布有关,与信道的统计特性也有关。

(×)3、连续信道的信道容量与信道带宽成正比,带宽越宽,信道容量越大。

(×)4、信源熵是信号符号集合中,所有符号的自信息的算术平均值。

(×)5、信源熵具有极值性,是信源概率分布P的下凸函数,当信源概率分布为等概率分布时取得最大值。

(×)6、离散无记忆信源的N次扩展信源,其熵值为扩展前信源熵值的N倍。

(√)7、互信息的统计平均为平均互信息量,都具有非负性。

(×)8、信源剩余度越大,通信效率越高,抗干扰能力越强。

(×)9、信道剩余度越大,信道利用率越低,信道的信息传输速率越低。

(×)|10、信道输入与输出之间的平均互信息是输入概率分布的下凸函数。

(×)11、在信息处理过程中,熵是不会增加的。

(√)12、熵函数是严格上凸的。

(√)13、信道疑义度永远是非负的。

(√)14、对于离散平稳信源,其极限熵等于最小平均符号熵。

信息论第3章习题课

a1a1 0.25 a1a2 0.15 a2a1 0.15 a1a3 0.10 a3a1 0.10 a2a2 0.09 a2a3 0.06 a3a2 0.06 a3a3 0.04

2013-7-25

(U1U2)的最佳二元码平均码长和编码效 率:

n(U 2 ) 2 0.25 3 (0.15 2 0.10 2) 4 (0.09 0.06 2 0.04) 3

2013-7-25

1

0

0.020

14

111 112 121 211 113 131 311 122 212 221 123 132 213 312 231 321 222 133 313 331 223 232 322 233 323 332 333

0.125 0.075 0.075 0.075 0.050 0.050 0.050 0.045 0.045 0.045 0.030 0.030 0.030 0.030 0.030 0.030 0.027 0.020 0.020 0.020 0.018 0.018 0.018 0.012 0.012 0.012 0.008 0 1 0 1 0.024

习题课

3.1 试证明长度不超过N的D元不等长码至多有D(DN-1)/(D-1) 个码字。 [3.1的解答] 长度等于k的D元码字至多有Dk个,其中k=1~N。 因此长度不超过N的D元码字至多有

D k D( D N 1) /( D 1)

k 1

N

2013-7-25

1

a2 a1 U ~ 0.004 0.996

0.4 k 0.4 1 e k! k 0

2013-7-25 3

习题课

[3.2的注解] 事实上,在对“含有两个或更少个al的长为100的序 列”提供不同的码字之后,还有210-596=428个富余的码字。这 些富余的码字如果提供给其中428 个“含有恰好三个al的长为 100的序列”,作为它们各自的不同码字。则错误概率不会超 过

信息论与编码习题课

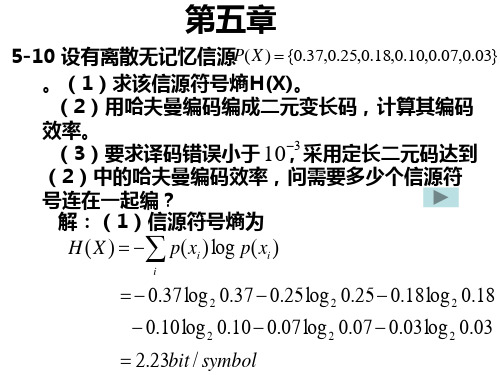

x2 0.25 x3 0.18 x4 0.10

x5 0.07 x6 0.03

0 1

0

0.10

1

0.62

0

0.20

1

0

0

1.00

0.38 1 1

编码 00 01 11 101

1000 1001

该哈夫曼码的平均码长为

K p(xi )Ki

i

0.37 2 0.25 2 0.18 2 0.10 3 0.07 4 0.03 4 2.3码元 / 符号

V2 {(0100 ), (1000 ), (0000 ), (1100 )} V2的一个两维4重对偶子空间为

V2' {(0010 ), (0001), (0000 ), (0011)}

6-3某系统(8,4)码,其四位校验位 vi , i 0,1, ,3

与四位信息位 ui ,i 0,1, ,3 的关系是

的熵及信息传输速率。 (2)对这8个符号作哈夫曼编码,写出相应码

字,并求出编码效率。 (3)采用香农编码,写出相应码字,求出编

码效率。 (4)进行费诺编码,写出相应码字,求出编

码效率。

解:(1)信源熵

H (X ) p(xi )log p(xi )

i

0.1log2 0.1 0.18log2 0.18 0.4log2 0.4 0.05log2 0.05 0.06log2 0.06 0.1log2 0.1 0.07log2 0.07 0.04log2 0.04

1 1 0 1 0 0 1

1 0 0 0 1 0 1 G 0 1 0 0 1 1 1

0 0 1 0 1 1 0 0 0 0 1 0 1 1

信息组m={(0000),(0001),(0010), (0011),(0100),(0101),(0110), (0111)(10000),(1001),(1010), (1011),(1100)(1101),(1110), (将1m11及1G)代} 入C=mG中求得16个对应的码字:

信息论习题课

解题关键:

二元Huffman编码:将两个最小概率消息组合成一个新的消息 D元 Huffman 编码: 将D个最小概率的消息组合成一个新的消息 其他的编码方法:shannon, shannon-Fano-Elias

解题关键:

二元Huffman编码:将两个最小概率消息组合成一个新的消息 D元 Huffman 编码: 将D个最小概率的消息组合成一个新的消息 其他的编码方法:Shannon, Shannon-Fano-Elias, 算术编码

4.1: 计算如下所示离散无记忆信道的容量: :

a) 是准对称DMC信道 b) 用定理4.2.2,直觉上X0=X2,设X1=p; 可以得出当P!=0时,无法满足定理4.2.2,即达不 到信道容量 所以p=0, 转化为一个准对称DMC信道

解题关键: 解题关键: 这两道题Байду номын сангаас是和信道,使用和信道的信道容量公式 2C=2C1+2C2 再用 p1=2c1-c, p2=2c2-c

解答: Y 的概率密度很容易得出

2.23,2.24,2.26 同一类型

3.2: :

解题关键:使用切比雪夫不等式,

其中

可以求出L0 1) L0=1884 2) L0=471e7

解题关键:

可以推出:

由此可以得出典型列集合的上下限界。

0001 1 010 11 110 0 0110 解题关键:使用后缀分解集法,每次用来分割的前缀和对应的重复码字组 成的序列是模糊序列。

X:测试者来自的村庄 Y: 测试者说话的状态

X:筛子出现的点数。x1: 为1,2,3,4, x2为5,6 Y: 硬币投掷出现正反面的情况

2.6: 对任意概率分布的随机变量,试证明下述三角不等式成立

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2.5:设一个系统传送 10 个数字:0,1,2,⋯,9,奇数在传送时以0.5 概 率等可能地错成另外的奇数,而其他数字总能正确接收。试求收到一个数 字后平均得到的信息量。

2.10 令X 是离散随即变量,Y = g(X )是X 的函数,求证H(X ) ≥ H(Y )。

解题关键: 和2.9 类似, 使用链式法则H(X ,Y ) = H(X ) + H(Y / X ) = H(Y ) + H(X /Y )

解题关键: a), 使用熵的可加性

H(X ) = aH(X1) + (1− a)H(X2) + H(a) b), 熵的凸性,所以有极大值

信息论习题课

2.1: A 村有一半人说真话,3|10人总说假话,2|10人拒绝回答; B 村有3|10人诚实,一半人说谎,2|10人拒绝回答。

现随机地从A村和B村抽取人,p 为抽到A村人的概率,1–p 为抽到B村人的 概率, 问通过测试某人说话的状态平均能获得多少关于该人属于哪个村的信息? 通过改变p,求出该信息的最大值。

C’=max(H(Y’ )) − H(Z) 则 使H(Y’ )最大与H(Y)最大是等效的(注:暂无详细论证) 使 X →Y′互信息最大与X →Y 的互信息最大是等效的

然后由Y分布获得a在不同条件下,Y的分布,并求出容量即可。

0

π-a π+a

2π

0 a-π

3π-a 2π

解题关键: X,Y 是独立的,Z是关于XY的函数,Z=f(X,Y) H(Z |X, Y) = 0 H(Y |Z, X) = 0 H(X | Y,Z) = 0 H(Z | X) = H(Y+X | X ) = H(Y | X )

当变量超过两个时,常常需要用链式法则, H(X ,Y ,Z ) = H(Z ) + H(X , Y | Z ) = H(X ,Y ) + H(Z |X, Y)= H(X,Y)

4.1: 计算如下所示离散无记忆信道的容量:

a) 是准对称DMC信道 b) 用定理4.2.2,直觉上X0=X2,设X1=p;

可以得出当P!=0时,无法满足定理4.2.2,即达不 到信道容量

所以p=0, 转化为一个准对称DMC信道

解题关键: 这两道题都是和信道,使用和信道的信道容量公式

X:测试者来自的村庄 Y: 测试者说话的状态

X:筛子出现的点数。x1: 为1,2,3,4, x2为5,6 Y: 硬币投掷出现正反面的情况

2.6: 对任意概率分布的随机变量,试证明下述三角不等式成立

2.9: 若三个随机变量 X,Y,Z,有X+Y=Z 成立,其中X 和Y 独立 (a) H(X)≤H(Z) (b) H(Y)≤H(Z) (c) H(X,Y)≥H(Z) (d) I (X;Z)=H(Z)-H(Y) (e) I (X,Y;Z)=H(Z) (f) I (X;Y,Z)=H(X) (g) I (Y;Z|X)=H(Y) (h) I (X;Y|Z)=H(X|Z)=H(Y|Z)

2C=2C1+2C2 再用 p1=2c1-c, p2=2c2-c

弄清楚积信道,和信道,级联信道的概念和信道容量

解题关键:

令Y ′ = X + Z 则 Y = Y′ mod 2π 则H(Y / X )= H(Y′ / X )= H(Z)

C = max(I (X ,Y )) = max(H(Y ))− H(Z)

解答: Y 的概率密度很容易得出

2.23,2.24,2.26 同一类型

3.2:

解题关键:使用切比雪夫不等式,

其中

可以求出L0 1) L0=1884 2) L0=471e7

解题关键: 可以推出: 由此可以得出典型列集合的上下限界。

0001 1

010 11 110 0 0110

解题关键:使用后缀分解集法,每次用来分割的前缀和对应的重复码字组

成的序列是模糊序列。

解题关键:

二元Huffman编码:将两个最小概率消息组合成一个新的消息 D元 Huffman 编码: 将D个最小概率的消息组合成一个新的消息 其他的编码方法:shannon, shannon-Faan编码:将两个最小概率消息组合成一个新的消息 D元 Huffman 编码: 将D个最小概率的消息组合成一个新的消息 其他的编码方法:Shannon, Shannon-Fano-Elias, 算术编码