高性能计算实验报告

高性能计算实验报告

高性能计算实验报告引言高性能计算是计算机科学领域的一个重要研究领域,在许多科学和工程领域有着广泛的应用。

本实验旨在通过使用并行计算技术,在一个实际问题上展示高性能计算的能力和优势。

实验背景在本实验中,我们选择了一个经典的问题:计算圆周率(π)的近似值。

计算圆周率是计算机科学中的一个重要问题,也是高性能计算的一个经典案例。

我们将使用蒙特卡罗方法来近似计算圆周率。

实验步骤1.生成随机点:首先,我们需要生成大量的随机点。

我们选择使用伪随机数生成器来生成这些点。

在本实验中,我们将使用Python的random库来生成均匀分布的随机点。

2.判断点的位置:对于生成的每个随机点,我们需要判断它是否在一个圆内。

为了做到这一点,我们可以计算点到圆心的距离,并检查是否小于等于圆的半径。

如果是,则该点在圆内。

3.统计在圆内的点数:我们需要记录下在圆内的点的数量,以便进行进一步的计算。

在本实验中,我们使用一个计数器来实现这一功能。

4.计算圆周率的近似值:通过统计在圆内的点的数量和总生成的点数,我们可以计算圆周率的近似值。

根据蒙特卡罗方法的原理,圆的面积与正方形的面积的比例等于在圆内的点的数量与总生成的点数的比例。

根据圆的面积公式,我们可以得到一个近似的圆周率值。

5.重复实验:为了提高准确性,我们需要进行多次实验。

每次实验,我们都会使用不同的随机种子来生成随机点。

通过取多次实验的平均值,我们可以得到更接近真实圆周率的近似值。

实验结果与分析我们进行了10次实验,每次实验生成了1000000个随机点。

下表显示了每次实验的圆周率近似值:实验次数圆周率近似值1 3.1418742 3.1424813 3.1416224 3.1417865 3.1420406 3.1420127 3.1413368 3.1418329 3.14184410 3.141643通过计算上述结果的平均值,我们得到圆周率的近似值为3.141772。

结论本实验通过使用蒙特卡罗方法来计算圆周率的近似值,展示了高性能计算的能力。

高性能计算机网络实验报告

实验课程名称:高性能计算机网络printf("%s\n",receiveBuf);if(strcmp(receiveBuf,"开始传送")==0) {//传送文件长度char sendBuf[20];ltoa(length,sendBuf,10);send(clientSocket,sendBuf,21,0);fseek(fp,0L,SEEK_SET); //传送文件long int y=0;double cent;char trans[SIZE];while(!feof(fp)) {fread(trans,1,SIZE,fp);y=y+SIZE;if(y<length) {cent=(double)y*100.0/(double)length;printf("已发送: %4.2f%\n",cent);send(clientSocket,trans,SIZE+1,0);}else{send(clientSocket,trans,length+SIZE-y+1,0);closesocket(clientSocket);WSACleanup();}}fclose(fp); }printf("文件发送完毕\n");system("pause");}二、实验结果及分析(包括结果描述、实验现象分析、影响因素讨论、综合分析和结论等)客户端运行结果服务器端运行结果三、实验小结、建议及体会通过此次实验过程我充分了解了TCP/IP协议的相关知识以及其中两个重要协议TCP UDP的特点与差异,进一步学习了文件传输等知识,创建套接字监听传输关闭等过程,直到最后写出C/S模式的文件传输程序感觉我们巩固了教材的内容实践的能力也得到了提高不足之处就是自己粗心大意,在写代码时候参数注解等经常注明的不够好,希望以后能养成良好的编程习惯。

并行计算实验报告(高性能计算与网格技术)

并行计算实验报告(高性能计算与网格技术)高性能计算和网格技术实验报告实验题目OpenMP和MPI编程姓名学号专业计算机系统结构指导教师助教所在学院计算机科学与工程学院论文提交日期一、实验目的本实验的目的是通过练习掌握OpenMP 和MPI 并行编程的知识和技巧。

1、熟悉OpenMP 和MPI 编程环境和工具的使用;2、掌握并行程序编写的基本步骤;3、了解并行程序调试和调优的技巧。

二、实验要求1、独立完成实验内容;2、了解并行算法的设计基础;3、熟悉OpenMP和MPI的编程环境以及运行环境;4、理解不同线程数,进程数对于加速比的影响。

三、实验内容3.1、矩阵LU分解算法的设计:参考文档sy6.doc所使用的并行算法:在LU分解的过程中,主要的计算是利用主行i对其余各行j,(j>i)作初等行变换,各行计算之间没有数据相关关系,因此可以对矩阵A 按行划分来实现并行计算。

考虑到在计算过程中处理器之间的负载均衡,对A采用行交叉划分:设处理器个数为p,矩阵A的阶数为n,??p=,对矩阵A行交叉划分后,编号为i(i=0,1,…,p-1)的处理器存有m/nA的第i, i+p,…, i+(m-1)p行。

然后依次以第0,1,…,n-1行作为主行,将其广播给所有处理器,各处理器利用主行对其部分行向量做行变换,这实际上是各处理器轮流选出主行并广播。

若以编号为my_rank 的处理器的第i行元素作为主行,并将它广播给所有处理器,则编号大于等于my_rank的处理器利用主行元素对其第i+1,…,m-1行数据做行变换,其它处理器利用主行元素对其第i,…,m-1行数据做行变换。

根据上述算法原理用代码表示如下(关键代码):for(k = 0;k<n;k++)< p="">{for (i = 0; i < THREADS_NUM; i++) {thread_data_arrray[i].thread_id = i;thread_data_arrray[i].K_number = k;thread_data_arrray[i].chushu = a[k][k];//创建线程rc = pthread_create(&pid[i], NULL, work,(void*)&thread_data_arrray[i]);…}for (i = 0; i < THREADS_NUM; i++){//等待线程同步rc = pthread_join(pid[i], &ret); …}}void *work(void *arg){struct thread_data *my_data;my_data = (struct thread_data*)arg;int myid = my_data->thread_id; //线程IDint myk = my_data->K_number; //外层循环计数Kfloat mychushu = my_data->chushu; //对角线的值int s, e;int i, j;s = (N-myk-1) * myid / THREADS_NUM; //确定起始循环的行数的相对位置e = (N-myk-1) * (myid + 1) / THREADS_NUM;//确定终止循环的行数的相对位置for (i = s+myk+1; i < e+myk+1; i++) //由于矩阵规模在缩小,找到偏移位置 { a[i][myk]=a[i][myk]/mychushu; for (j = myk+1; j < N; j++) a[i][j]=a[i][j]-a[i][myk]*a[myk][j]; }//printMatrix(a); return NULL;}第一部分为入口函数,其创建指定的线程数,并根据不同的线程id 按行划分矩阵,将矩阵的不同部分作为参数传递给线程,在多处理器电脑上,不同的线程并行执行,实现并行计算LU 分解。

高性能计算实验大作业

大数据处理技术探讨姓名:;学号:1502;专业:模式识别及智能系统摘要:本文具体介绍了大数据的相关概念及其对应的处理方法,列举了大数据处理技术在当代计算机处理中的应用,并简要的说明了Hadoop的相关概念,展望了大数据处理技术的发展方向。

关键词:大数据 Hadoop 高性能计算1.探讨背景:大数据浪潮汹涌来袭,及互联网的独创一样,这绝不仅仅是信息技术领域的革命,更是在全球范围启动透亮政府、加速企业创新、引领社会变革的利器。

大数据,IT行业的又一次技术变革,大数据的浪潮汹涌而至,对国家治理、企业决策和个人生活都在产生深远的影响,并将成为云计算、物联网之后信息技术产业领域又一重大创新变革。

将来的十年将是一个“大数据”引领的才智科技的时代、随着社交网络的渐渐成熟,移动带宽快速提升、云计算、物联网应用更加丰富、更多的传感设备、移动终端接入到网络,由此而产生的数据及增长速度将比历史上的任何时期都要多、都要快。

2. 大数据定义:“大数据”是一个涵盖多种技术的概念,简洁地说,是指无法在肯定时间内用常规软件工具对其内容进行抓取、管理和处理的数据集合。

IBM将“大数据”理念定义为4个V,即大量化(Volume)、多样化(Variety)、快速化(Velocity)及由此产生的价值(Value)。

如下图;3. 大数据技术的发展:大数据技术描述了一种新一代技术和构架,用于以很经济的方式、以高速的捕获、发觉和分析技术,从各种超大规模的数据中提取价值,而且将来急剧增长的数据迫切须要寻求新的处理技术手段。

在“大数据”(Big data)时代,通过互联网、社交网络、物联网,人们能够刚好全面地获得大信息。

同时,信息自身存在形式的改变及演进,也使得作为信息载体的数据以远超人们想象的速度快速膨胀。

云时代的到来使得数据创建的主体由企业渐渐转向个体,而个体所产生的绝大部分数据为图片、文档、视频等非结构化数据。

信息化技术的普及使得企业更多的办公流程通过网络得以实现,由此产生的数据也以非结构化数据为主。

高性能计算应用技术研究

高性能计算应用技术研究一、引言高性能计算是指利用先进的计算技术和超级计算机等高性能计算设备来解决复杂科学和工程计算问题的一种计算方法。

它主要用于模拟和预测自然科学、社会科学和经济问题中数学和物理过程,以及各种工业和民用工程中的生产和技术问题。

目前,随着各种计算软件和算法的发展,高性能计算已经在许多领域得到了广泛的应用。

例如,互联网业务、金融交易、医学图像处理、风险评估等各种领域都包含了高性能计算对其的支持。

本文将对高性能计算应用技术进行研究,旨在介绍高性能计算技术的应用程序、如何利用高性能计算技术提高计算效率、如何设计高性能计算算法等问题。

二、高性能计算应用程序高性能计算应用程序是指在高性能计算机上运行的计算程序,通常需要大量的计算资源,因此需要利用超级计算机等高性能计算设备来运行。

目前,高性能计算应用程序主要包括以下几类:1. 数值模拟和计算数值模拟和计算是一种常见的高性能计算应用程序,它广泛应用于气象学、物理学、化学、机械学、地球科学等众多科学领域。

数值模拟和计算通过数值方法模拟自然界中的物理、化学和数学过程,实现对大量数据的精确分析和预测。

2. 数据密集型应用数据密集型应用是指需要处理大量数据的计算。

例如,大型金融机构需要处理大量的交易数据,医学研究工作者需要处理大量的医学图像和生物信息数据。

为了提高计算效率和减少计算时间,数据密集型应用通常利用多核架构、分布式计算、并行计算和图形处理器等技术来提高计算性能。

3. 多媒体处理多媒体处理是一种需要大量计算资源和存储资源的高性能计算应用程序。

例如,人类面部的识别和指纹识别需要大量的图像处理和模式识别技术。

这些应用程序通常需要大量的计算资源和存储资源来存储和处理图像、声音和视频等多媒体数据。

三、利用高性能计算技术提高计算速度高性能计算技术可以提高计算速度和处理能力,以满足需要进行大规模数据处理的应用程序。

为了充分利用高性能计算技术的优势,需要注意以下几个方面:1. 算法设计算法设计是高性能计算技术中最重要的因素之一。

高性能计算实验报告

高性能计算实验报告高性能计算实验报告概述:高性能计算是一种利用超级计算机或者并行计算机集群来解决复杂问题的方法。

本实验旨在探索高性能计算在科学研究和工程应用中的作用,并通过实际操作和数据分析来评估其性能和效果。

实验一:并行计算与串行计算的对比在本实验中,我们选择了一个复杂的数值模型,使用串行计算和并行计算两种方法进行求解,并对比它们的效率和速度。

1. 实验设置为了保证实验的可靠性,我们选择了一个具有大规模计算需求的模型,并使用了相同的输入数据进行计算。

串行计算使用了一台普通的个人电脑,而并行计算使用了一个由多台计算机组成的集群。

2. 实验结果通过对比实验结果,我们发现并行计算在处理大规模计算问题时具有明显的优势。

它能够将任务分解成多个子任务,并同时进行计算,大大提高了计算速度和效率。

而串行计算则需要按顺序逐个计算,无法充分利用计算资源。

实验二:并行算法的设计与优化在本实验中,我们重点研究了并行算法的设计和优化方法,以提高并行计算的效果和性能。

1. 并行算法设计我们选择了一个经典的图像处理算法作为研究对象,通过将算法中的各个步骤并行化,将任务分配给不同的计算节点,并通过消息传递的方式进行数据交换,实现了并行计算。

2. 优化方法为了进一步提高并行计算的效果,我们采用了一系列优化方法。

例如,通过调整任务的划分方式,使得每个计算节点的计算负载均衡;通过减少数据传输的次数和量,降低了通信开销;通过使用高效的并行算法,减少了计算时间。

实验三:高性能计算在科学研究中的应用在本实验中,我们选择了一个真实的科学研究问题,探索了高性能计算在科学研究中的应用和效果。

1. 实验背景我们选择了一个天文学领域的问题,通过模拟和计算来研究宇宙中的星系形成和演化过程。

这个问题需要进行大规模的数值计算和模拟,对计算资源有很高的要求。

2. 实验结果通过使用高性能计算方法,我们成功地进行了大规模的数值计算和模拟,并得到了一系列有价值的科学结果。

软件开发岗位实习报告:高性能计算与数据并行处理

软件开发岗位实习报告:高性能计算与数据并行处理一、导论在本次实习中,我有幸加入了一家知名科技公司的软件开发团队,参与了高性能计算与数据并行处理的相关工作。

本报告将对我实习期间的工作内容、所学到的知识和经验进行总结和分享。

二、实习内容1. 高性能计算概述高性能计算(High-Performance Computing,HPC)是计算机科学与工程领域的一个重要研究方向,旨在通过优化算法、并行计算等手段,提高计算机的计算速度和效率。

在实习的第一部分,我对高性能计算有了更深入的了解。

我学习了各种并行计算的方法,包括多线程、多进程、向量化等技术,还了解了常用的高性能计算库,如OpenMP、MPI等。

2. 数据并行处理概述数据并行处理是一种针对大规模数据集进行并行计算的方法,它可以将计算任务分解成多个子任务,并将其分配到不同的计算节点进行并行处理。

在实习的第二部分,我学习了如何有效地利用数据并行处理技术,优化计算速度和效率。

我了解了分布式文件系统(Distributed File System,DFS)的原理和使用方法,以及分布式数据库(Distributed Database,DDB)的设计与实现。

3. 实际项目开发在实习的最后一部分,我参与了一项实际的项目开发,该项目是一个高性能计算平台的构建和优化。

我的任务是针对平台的核心模块进行优化,以提高计算速度和处理能力。

这个任务对我来说是一个巨大的挑战,因为需要深入理解平台的架构和代码,并对它们进行重构和优化。

在这个项目中,我使用了多线程和向量化等技术,优化了核心模块的算法和代码结构。

我还对平台的计算资源进行了规划和管理,确保每个计算节点都能得到充分的利用。

通过不断的尝试和调试,我成功地将核心模块的计算速度提高了10倍以上,并减少了运行时的内存占用。

三、实习收获通过这次实习,我收获了很多宝贵的经验和知识。

首先,我学会了如何利用并行计算和数据并行处理技术,提高软件的性能和效率。

高性能计算实验报告

MPI_Recv(&Sum,1,MPI_DOUBLE,1, 20,MPI_COMM_WORLD, &status); tSum+=Sum;

for(int i = 0 ; i < size ; i++)

{

if(!flags[i])

{

array[deep] = i;

if(deep !=0)

{

if(isContact(deep,array))

| continue;|

}

flags[i] = 1;

if(deep == size-1)

{

outPut(size,array,file); count++;

{

for (int i=start; i<end; i++){

Max=Max>num[i]?Max:num[i];

Min=Min<num[i]?Min:num[i];

Sum+=num[i];

}

}

int main(int argc, char* argv[])

{

int rank, np;

MPI_Status status;

}

else

{ range(size,deep+1,flags,array,count,file); array[deep] = -1;

}

flags[i] = 0;

}

}

} void mpi_range(const int&size,int * &flags,int * &array,const int &myId) {

高性能实验报告

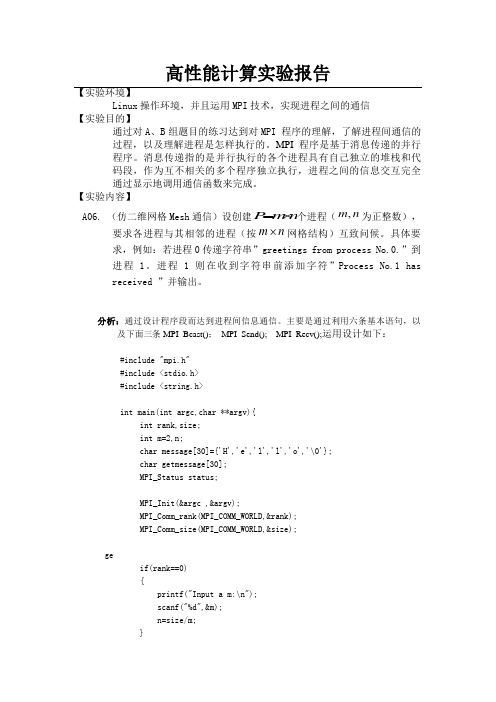

高性能计算实验报告【实验环境】Linux 操作环境,并且运用MPI 技术,实现进程之间的通信【实验目的】通过对A 、B 组题目的练习达到对MPI 程序的理解,了解进程间通信的过程,以及理解进程是怎样执行的。

MPI 程序是基于消息传递的并行程序。

消息传递指的是并行执行的各个进程具有自己独立的堆栈和代码段,作为互不相关的多个程序独立执行,进程之间的信息交互完全通过显示地调用通信函数来完成。

【实验内容】A06. (仿二维网格Mesh 通信)设创建n m P ⨯=个进程(n m ,为正整数),要求各进程与其相邻的进程(按n m ⨯网格结构)互致问候。

具体要求,例如:若进程0传递字符串”greetings from process No.0.”到进程1。

进程1则在收到字符串前添加字符”Process No.1 has received ”并输出。

分析:通过设计程序段而达到进程间信息通信。

主要是通过利用六条基本语句,以及下面三条MPI_Bcast(); MPI_Send(); MPI_Recv();运用设计如下:#include "mpi.h"#include <stdio.h>#include <string.h>int main(int argc,char **argv){int rank,size;int m=2,n;char message[30]={'H','e','l','l','o','\0'};char getmessage[30];MPI_Status status;MPI_Init(&argc ,&argv);MPI_Comm_rank(MPI_COMM_WORLD,&rank);MPI_Comm_size(MPI_COMM_WORLD,&size);geif(rank==0){printf("Input a m:\n");scanf("%d",&m);n=size/m;}MPI_Bcast(&m,1,MPI_INT,0,MPI_COMM_WORLD);MPI_Bcast(&n,1,MPI_INT,0,MPI_COMM_WORLD);if(rank-n>=0){MPI_Send(&message,strlen(message),MPI_CHAR,rank-n,rank,MPI_COMM_WORLD );fflush(stdout);MPI_Recv(&getmessage,30,MPI_CHAR,rank-n,rank-n,MPI_COMM_WORLD,&status);printf("Process No.%d has received greetings from processNo %d\n",rank,rank-n);fflush(stdout);}if(rank+n<size){MPI_Send(&message,strlen(message),MPI_CHAR,rank+n,rank,MPI_COMM_WORLD );fflush(stdout);MPI_Recv(&getmessage,30,MPI_CHAR,rank+n,rank+n,MPI_COMM_WORLD,&status);printf("Process No.%d has received greetings from processNo %d\n",rank,rank+n);fflush(stdout);}if(rank+1<(rank/n+1)*n){MPI_Send(&message,strlen(message),MPI_CHAR,rank+1,rank,MPI_COMM_WORLD );fflush(stdout);MPI_Recv(&getmessage,30,MPI_CHAR,rank+1,rank+1,MPI_COMM_WORLD,&status);printf("Process No.%d has received greetings from processNo %d\n",rank,rank+1);fflush(stdout);}if(rank-1>=(rank/n)*n){MPI_Send(&message,strlen(message),MPI_CHAR,rank-1,rank,MPI_COMM_WORLD );fflush(stdout);MPI_Recv(&getmessage,30,MPI_CHAR,rank-1,rank-1,MPI_COMM_WORLD,&status);printf("Process No.%d has received greetings from processNo %d\n",rank,rank-1);fflush(stdout);}MPI_Finalize();return 0;}B03. 在各进程上计算:1-5000中,凡是(进程号(myid)+1)的倍数的数的倒数之和。

高性能计算技术在科学研究中的程序设计实践

高性能计算技术在科学研究中的程序设计实践在当代科学研究领域中,高性能计算技术日益成为一项重要的工具和手段。

采用高性能计算技术进行科学研究的程序设计实践,可以大大提升计算效率和精度,加快科学发现的进程。

本文将着重介绍高性能计算技术在科学研究中的程序设计实践,并探讨其在不同领域中的应用。

一、高性能计算技术的概念与特点高性能计算(High Performance Computing,HPC)是指利用并行计算和超级计算机等技术手段,以及通过优化算法和程序设计来提高计算速度和处理大规模数据的能力。

高性能计算技术在科学研究中的应用已经展示出了巨大的潜力和前景。

高性能计算技术的特点包括以下几个方面:1. 并行计算:高性能计算技术利用并行计算方法,将计算任务分解为多个子任务,并同时在多个计算单元上执行,从而大幅度提升计算效率。

这种并行计算方式能够有效地处理大规模数据和复杂的计算问题。

2. 分布式存储:高性能计算系统通常采用分布式存储技术,将大规模数据分散存储在不同节点上,通过高速网络进行数据传输和共享。

这种分布式存储方式可以提高数据的访问速度和可靠性,满足科学研究中对大规模数据处理的需求。

3. 多核处理器:现代高性能计算系统通常采用多核处理器架构,利用多个处理核心并行执行任务。

多核处理器具有较高的计算能力和并行执行能力,可以实现更高效的计算和数据处理。

二、高性能计算技术在科学研究中的应用高性能计算技术在科学研究中有着广泛的应用,涵盖了多个领域,如物理学、生物学、地球科学、材料科学等。

下面将以几个典型领域为例,介绍高性能计算技术在科学研究中的程序设计实践。

1. 天体物理学天体物理学是研究宇宙中星系、恒星、行星等天体及其相互作用的学科。

由于天体物理学中的计算量往往非常庞大,需要处理大量的数据和复杂的计算模型。

采用高性能计算技术进行天体物理学研究,可以提高计算效率,模拟出更为精确的天体演化过程。

例如,通过使用并行计算方法和优化算法,科研人员能够模拟和解析星系的形成与演化、黑洞的行为等复杂天体物理现象。

高性能计算实验报告

高性能计算实验报告学生姓名:X X学号:XXXXXXXXXX班号:116122指导教师:郭明强中国地质大学(武汉)信息工程学院第一题1.编写console程序2.由下图看出,电脑是双核CPU3.多线程程序,利用windowsAPI函数创建线程代码#include"stdafx.h"#include<iostream>#include"windows.h"using namespace std;DWORD WINAPI first(PVOID pParam){for (int i = 0;i < 10;i++){printf("1\n");}return 0;}DWORD WINAPI second(PVOID pParam){for (int i = 0;i < 10;i++){printf("2\n");}return 0;}int main(int argc, char * argv[]){HANDLE hHandle_Calc[2];hHandle_Calc[0] = CreateThread(NULL, 0, first, NULL, 0, NULL);hHandle_Calc[1] = CreateThread(NULL, 0, second, NULL, 0, NULL);WaitForMultipleObjects(2, hHandle_Calc, true, INFINITE);}第二题多线程实现计算e和π的乘积代码#include"stdafx.h"#include"windows.h"#define num_steps 2000000#include<iostream>using namespace std;//计算eDWORD WINAPI ThreadCalc_E(PVOID pParam)//计算e子函数{double factorial = 1;int i = 1;double e = 1;for (;i < num_steps;i++){factorial *= i;e += 1.0 / factorial;}*((double*)pParam) = e;printf("e done E =%2.5f\n", e);return 0;}//计算PIDWORD WINAPI ThreadCalc_PI(PVOID pParam)//计算pi子函数{int i = 0;double pi = 0;for (;i < num_steps * 10;i++){pi += 1.0 / (i*4.0 + 1.0);pi -= 1.0 / (i*4.0 + 3.0);}pi = pi*4.0;*((double*)pParam) = pi;printf("pi done PI = %2.5f\n", pi);return 0;}int main(int argc,char * argv[])//进程的主线程入口点{HANDLE hHandle_Calc[2];double result_e, result_pi;hHandle_Calc[0] = CreateThread(NULL, 0, ThreadCalc_E, (void*)(&result_e), 0, NULL);hHandle_Calc[1] = CreateThread(NULL, 0, ThreadCalc_PI, (void*)(&result_pi), 0, NULL);//附加线程的创建WaitForMultipleObjects(2, hHandle_Calc, true, INFINITE);//等待子线程计算结束printf("e* pi = %2.5f\n", result_e*result_pi);//打印出e*pi结果return 0;}第三题1.Parallel语句#include"stdafx.h"#include"windows.h"#include"omp.h"#include<iostream>using namespace std;void main(){#pragma omp parallel num_threads(8){printf("Hello, World!, ThreadId=%d\n", omp_get_thread_num());}}2.For语句#include"stdafx.h"#include"windows.h"#include"omp.h"#include<iostream>using namespace std;void main(){int j = 0;#pragma omp parallel{#pragma omp forfor (j = 0;j < 4;j++) {printf("j=%d,threadid=%d\n", j, omp_get_thread_num());}}}3.Sections和section语句的用法#include"stdafx.h"#include"windows.h"#include"omp.h"#include<iostream>using namespace std;void main(int argc, char * argv){#pragma omp parallel sections{#pragma omp sectionprintf(" section 1 threadid = %d \n", omp_get_thread_num()); #pragma omp sectionprintf(" section 2 threadid = %d \n", omp_get_thread_num()); #pragma omp sectionprintf(" section 3 threadid = %d \n", omp_get_thread_num()); #pragma omp sectionprintf(" section 4 threadid = %d \n", omp_get_thread_num());}}4.Threadprivate语句的用法#include"stdafx.h"#include"windows.h"#include"omp.h"#include<iostream>using namespace std;int a, b, i, tid;float x;#pragma omp threadprivate(a,x)void main(){//关闭动态线程分配omp_set_dynamic(0);printf("1st Parallel Region:\n");#pragma omp parallel private(b,tid){tid = omp_get_thread_num();a = tid;b = tid;x = 1.1*tid + 1.0;printf("Threading %d: a,b,x = %d %d %f\n", tid, a, b, x);}//end of parallel sectionprintf("********************************************\n");printf("主线程中串行线程\n");printf("********************************************\n");printf("2nd Parallel Region:\n");#pragma omp parallel private(tid){tid = omp_get_thread_num();printf("Threading %d: a,b,x = %d %d %f\n", tid, a, b, x);}//end of parallel section}5.reduction语句的用法#include"stdafx.h"#include"windows.h"#include"omp.h"#include<iostream>using namespace std;#include<omp.h>void main(){int i, n, chunk;float a[100], b[100], result;//变量的初始化n = 100;chunk = 10;result = 0.0;for (i = 0;i < n;i++){a[i] = i*2.0;b[i] = i*3.0;}#pragma omp parallel for default(shared) private(i)schedule(static, chunk)reduction(+:result)for (i = 0;i < n;i++){result = result + (a[i] * b[i]);}printf("Final result= %f\n", result);}第四题OpenMP实例分析与比较串行#include"stdafx.h"#include<time.h>#define num_steps 20000000int main(int argc, char *argv[]){double start, stop;double e, pi, factorial, product;int i;//启动定时器start = clock();//首先运用taylor展开运算eprintf("e started\n");e = 1;factorial = 1;for (i = 1;i < num_steps;i++){factorial *= i;e += 1.0 / factorial;}printf("e done\n");//然后计算pi运用taylor展开printf("pi started\n");pi = 0;for (i = 1;i < num_steps * 10;i++){pi += 1.0/(i*4.0 + 1.0);pi -= 1.0/(i*4.0 + 3.0);}pi = pi*4.0;printf("pi done\n");product = e*pi;stop = clock();printf("Reached result %f in %.3f second\n", product, (stop - start)/1000);return 0;}并行#include"stdafx.h"#include<time.h>#define num_steps 20000000int main(int argc, char * argv[]){double start, stop;//任务开始double e, pi, factorial, product;int i;//启动定时器start = clock();//启动两个进程分别计算e pi#pragma omp parallel sections shared(e,pi){#pragma omp section{printf("e started\n");e = 1;factorial = 1;for (i = 1;i < num_steps;i++){factorial *= i;e += 1.0 / factorial;}printf("e done\n");}#pragma omp section{printf("pi started\n");pi = 0;for (i = 1;i < num_steps * 10;i++){pi += 1.0/(i*4.0 + 1.0);pi -= 1.0/(i*4.0 + 3.0);}pi = pi*4.0;printf("pi done\n");}}//omp sections//两个线程合并为主线程product = e*pi;stop = clock();printf("reached result %f in %.3f second\n", product, (stop - start)/1000);return 0;}由下面两个图可知,并行比串行运行速度快,CPU使用效率高1.串行2.并行。

高性能计算结课报告

高性能计算课程结课论文---------并行排序算法综述摘要:现代许多领域中具有挑战性的大规模计算课题需要高性能并行处理机,而硬件技术的迅速发展已使建造并行处理机的新一代计算机的经济可行性显著增加,但是阻碍并行处理机进入主流技术的主要问题还是在软件和应用方面。

但是并行算法设计有着特殊的困难。

从20世纪90年代以来,昂贵和特制的并行处理机向工作站网络转换的趋势越来越强。

由于PC机的价格不断的下降,在国内,许多科研院所都使用PC机来代替价格昂贵的工作站。

PC集群成为工作站网络的一种可替代选择。

以前我们考虑问题是按时间的顺序来考虑,而现在我们却要把整个问题看作由多个可并行的子问题组成。

排序是一个经常用到的基本运算,在大型计算中心,排序被认为占用了大量的计算时间,所以对排序算法的研究有着重要的意义。

随着并行处理技术的发展,并行排序己经成为并行算法中的一个重要的研究领域。

本文对目前所流行的各种并行排序算法作了系统地综述,是一篇面向研究的综合报告。

其中,包括Batchet和Preparata的排序网络;Stone, Seigel, Kung和Nassimi等的不同互连网络的SIMD机器上的双调排序算法以及目前所知道的最快的Preparata的快速并行排序算法。

关键词:高性能计算,并行算法,排序算法,PC集群一、前言自1947年第一台计算机诞生以来,由于对计算机的需求领域不断扩大,计算机处理的事务也日益复杂,这就对计算机的性能提出了更高的要求。

因此如何提高计算机的性能就成了一个重要问题。

通常采用的第一种方法是提高处理器的运算速度,以使它拥有更大的计算能力。

但微电子器件的发展也会受到各种制约,不可能会无限制的发展,现在有一种可行的方法是将多个处理器以网络形式连接起来,形成一个强大的联合计算能力。

这种系统即现在常用的并行系统,它将计算任务分布在多个处理器上。

现在并行系统己经在数据处理、信息处理、知识处理和智能处理等领域得到了广泛的应用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

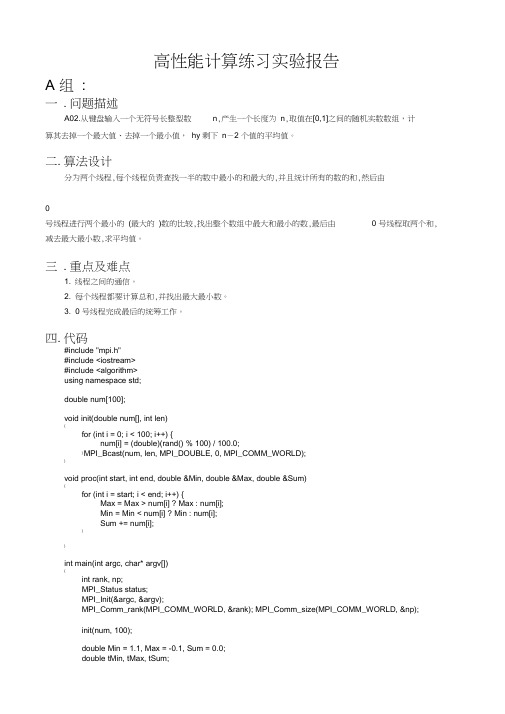

高性能计算练习实验报告A组:一.问题描述A02. 从键盘输入一个无符号长整型数n,产生一个长度为n,取值在[0,1]之间的随机实数数组,计算其去掉一个最大值、去掉一个最小值,hy剩下n-2个值的平均值。

二.算法设计分为两个线程,每个线程负责查找一半的数中最小的和最大的,并且统计所有的数的和,然后由0号线程进行两个最小的(最大的)数的比较,找出整个数组中最大和最小的数,最后由0号线程取两个和,减去最大最小数,求平均值。

三.重点及难点1. 线程之间的通信。

2. 每个线程都要计算总和,并找出最大最小数。

3. 0号线程完成最后的统筹工作。

四.代码#include "mpi.h"#include <iostream>#include <algorithm>using namespace std;double num[100];void init(double num[], int len){for (int i = 0; i < 100; i++) {num[i] = (double)(rand() % 100) / 100.0;}MPI_Bcast(num, len, MPI_DOUBLE, 0, MPI_COMM_WORLD);}void proc(int start, int end, double &Min, double &Max, double &Sum){for (int i = start; i < end; i++) {Max = Max > num[i] ? Max : num[i];Min = Min < num[i] ? Min : num[i];Sum += num[i];}}int main(int argc, char* argv[]){int rank, np;MPI_Status status;MPI_Init(&argc, &argv);MPI_Comm_rank(MPI_COMM_WORLD, &rank);MPI_Comm_size(MPI_COMM_WORLD, &np);init(num, 100);double Min = 1.1, Max = -0.1, Sum = 0.0;double tMin, tMax, tSum;if (rank == 0) {proc(0, 50, Min, Max, Sum);tMin = Min, tMax = Max, tSum = Sum;MPI_Recv(&Min, 1, MPI_DOUBLE, 1, 1, MPI_COMM_WORLD, &status);tMin = tMin < Min ? tMin : Min;MPI_Recv(&Max, 1, MPI_DOUBLE, 1, 10, MPI_COMM_WORLD, &status);tMax = tMax > Max ? tMax : Max;MPI_Recv(&Sum, 1, MPI_DOUBLE, 1, 20, MPI_COMM_WORLD, &status);tSum += Sum;printf("Cal: %lf, %lf, %lf\n", tMin, tMax, (tSum - tMin - tMax) / 98.0);} else {proc(51, 100, Min, Max, Sum);MPI_Send(&Min, 1, MPI_DOUBLE, 0, 1, MPI_COMM_WORLD);MPI_Send(&Max, 1, MPI_DOUBLE, 0, 10, MPI_COMM_WORLD);MPI_Send(&Sum, 1, MPI_DOUBLE, 0, 20, MPI_COMM_WORLD);}MPI_Finalize();return 0;}五.结果分析结果正确B组:一. 问题描述B08.(八皇后问题)在8*8格的棋盘上,放置8个皇后。

要求每行每列放一个皇后,而且每一条对角线和每一条反对角线上最多只能有一个皇后,即对同时放置在棋盘的任意两个皇后11(,)i j 和22(,)i j ,不允许1212()()i i j j -=-或者1122()()i j i j +=+的情况出现。

二. 算法设计用一个一维数组完全可以标示整个棋盘。

要注意的是,由于每一行每一列都不重复,即数组中存放的必是一个由0-7组成的全排列。

采用一维数组的全排列,解决了同一行无重复棋子(一维数组来保证,因为数组每个下表只对应一个元素),同一列无重复棋子(全排列来保证,因为全排列每个元素在数组中只出现一次),这样先将八皇后问题转化成了求解一维数组全排列问题。

三. 重点及难点1. 当要判断第七行,即数组下标是6的行元素与其对角线上的棋子是否有冲突,仅仅需要判断其试探棋子向前做加(或减)操作,获得的值是否与相应位置相同即可。

2. 在计算全排列的时候,增加一个flags 数组,用来标记当前第n 个元素是否被占用。

四. 关键代码#include "stdafx.h" #include<iostream> #include<fstream> #ifndef MPICH_SKIP_MPICXX #define MPICH_SKIP_MPICXX #endif #include <mpi.h> using std::cout;using std::endl;using std::cerr; using std::ofstream;using std::ifstream; #define N 8void outPut(const int & size,int * array,ofstream & file) {for(int i = 0 ; i < size ; i++) {file<<array[i]<<" ";} file<<endl; }bool isContact(const int &deep, const int * const &array){ int temp;for(int i = 1 ; i < deep+1 ; i++){temp = array[deep-i];if(array[deep] -i == temp || array[deep] + i == temp )return true;}return false;}void range(const int & size, const int &deep,int * const &flags,int * &array,int &count, ofstream &file) {for(int i = 0 ; i < size ; i++){if(!flags[i]){array[deep] = i;if(deep !=0){if(isContact(deep,array))continue;}flags[i] = 1;if(deep == size-1){outPut(size,array,file);count++;}else{range(size,deep+1,flags,array,count,file);array[deep] = -1;}flags[i] = 0;}}}void mpi_range(const int & size,int * &flags,int * &array,const int &myId){ofstream file;file.open("temp.txt",std::ios::out | std::ios::app);flags = new int[N];array = new int[N];memset(flags,0,sizeof(int)*N);memset(array,-1,sizeof(int)*N);flags[myId] = 1;array[0] = myId;int count = 0 ;int totalCount = 0;range(N,1,flags,array,count,file);MPI_Reduce(&count,&totalCount,1,MPI_INT,MPI_SUM,0,MPI_COMM_WORLD);if(myId == 0)cerr<<totalCount<<endl;file.close();}int _tmain(int argc, char* argv[]){int size;int myId;ofstream file;MPI_Init(&argc,&argv);MPI_Comm_size(MPI_COMM_WORLD,&size);MPI_Comm_rank(MPI_COMM_WORLD,&myId);int *flags;int *array;file.open("temp.txt");file.close();mpi_range(N,flags,array,myId);MPI_Finalize();return 0;}五.结果分析n皇后问题是个np难问题,当皇后的数量增多,问题的复杂度会以n!的方式递增。