Cache替换策略与写操作策略

cache基础知识

cache基础知识Cache是计算机系统中的一种高速缓存存储器,用于暂时存储计算机内部或外部存储器中的数据,以提高数据访问速度。

在计算机系统中,数据的读写通常需要经过多级存储结构,从而导致访问速度的下降。

而Cache作为位于CPU和主存之间的一级缓存,通过预先将部分数据复制到高速缓存中,可以大大提高数据的访问速度。

我们需要了解Cache的基本原理。

Cache的设计基于局部性原理,即计算机程序在执行过程中,往往会频繁访问相邻位置的数据。

因此,Cache通过采用较小但更快的存储器来存储最近被访问的数据,以便CPU在需要时能够快速获取数据,而不必每次都去主存中读取。

Cache的存储结构通常由多个Cache块组成,每个块可以存储一个或多个数据项。

每个Cache块都有一个唯一的标识符,用于标识该块存储的数据。

当CPU需要读取数据时,首先会在Cache中查找该数据是否已经存在。

如果存在,即命中Cache,CPU可以直接从Cache中读取数据,无需访问主存;如果不存在,即未命中Cache,CPU则需要从主存中读取数据,并将数据复制到Cache中,以便下次快速访问。

为了提高Cache的命中率,Cache通常采用一些替换策略来决定哪些数据应该被替换出去。

常见的替换策略有最近最少使用(LRU)和随机替换法。

LRU替换策略根据数据的访问历史来决定替换哪些数据,即最近最少使用的数据被替换出去;而随机替换法则是随机选择一个数据进行替换。

Cache还通常采用写回和写直达两种策略来处理写操作。

写回策略是指当CPU对Cache中的数据进行修改时,不立即将数据写回主存,而是将修改标记为"脏",并在未来某个时刻再将"脏"数据写回主存;而写直达策略则是指当CPU对Cache中的数据进行修改时,立即将数据写回主存。

写回策略可以减少对主存的写操作,提高写操作的效率,但可能会导致数据一致性问题。

在实际应用中,Cache的大小和映射方式是设计Cache的两个重要因素。

cache工作原理

cache工作原理缓存(Cache)是计算机系统中常用的一种优化技术,它通过暂时存储数据来提高数据访问速度,减少对慢速存储器(如硬盘)的访问次数。

缓存的工作原理是将最常用的数据存储在快速访问的存储介质中,以便快速检索和访问。

1. 缓存的作用缓存的主要作用是提高数据访问速度和系统性能。

当计算机需要数据时,它首先检查缓存中是否存在所需的数据。

如果数据在缓存中,计算机可以直接从缓存中获取数据,而不必访问慢速存储器。

这样可以大大减少数据访问的延迟时间,提高系统的响应速度。

2. 缓存的层次结构缓存通常按照层次结构进行组织,以便根据数据的使用频率和访问时间来管理数据。

常见的缓存层次结构包括L1、L2、L3缓存等。

L1缓存位于处理器内部,速度最快,但容量较小。

L2缓存位于处理器和内存之间,速度较快,容量较大。

L3缓存位于处理器和主存之间,速度较慢,容量最大。

缓存层次结构的设计旨在根据数据的使用模式和访问时间来提供最佳的性能。

3. 缓存的替换策略由于缓存的容量有限,当缓存已满时,需要替换掉一部份数据来腾出空间存储新的数据。

常见的缓存替换策略有以下几种:- 最近至少使用(Least Recently Used, LRU):替换最长期没有被使用的数据。

- 先进先出(First In First Out, FIFO):替换最早进入缓存的数据。

- 随机替换(Random):随机选择一个数据进行替换。

4. 缓存的命中率缓存的命中率是衡量缓存性能的重要指标之一。

命中率指的是在数据访问中,所需数据在缓存中的比例。

高命中率意味着大部份数据都能从缓存中获取,系统性能较好。

低命中率则意味着大部份数据都需要从慢速存储器中获取,系统性能较差。

提高缓存的命中率可以通过优化缓存的设计和替换策略来实现。

5. 缓存一致性缓存一致性是指多个缓存之间数据的一致性。

当多个缓存同时访问同一块数据时,需要保证数据的一致性,即每一个缓存中的数据都是最新的。

cache的写策略

cache的写策略Cache的写策略对于提高系统的性能和数据的访问速度非常重要。

下面我们将详细介绍几种常见的Cache写策略。

一、Write-through写策略:Write-through写策略是指,每次有数据存入Cache时,同时也会存入主存中。

这种写策略实现简单,数据一旦写入Cache,就一定会写入主存,不会丢失数据。

但是由于每次操作都需要将数据写入主存,会带来一定的延迟,当主存的带宽无法支撑高速Cache的写入时,性能可能会降低。

二、Write-around写策略:Write-around写策略是指,每次有数据存入Cache时,直接存储在主存中,不写入Cache。

这种写策略适用于需要快速读取数据,但写操作不太频繁的场景。

由于数据需要经过主存才能进入Cache,所以写操作的延迟会与主存的带宽有关。

三、Write-back写策略:Write-back写策略是指,每次有数据存入Cache时,先存储在Cache中,等到Cache的一块被替换时,将数据写回主存。

这种写策略相较于Write-through和Write-around写策略,可以大大减少写入主存的次数,提高写入数据的效率和速度。

但是由于数据在Cache中存在时间较长,需要一定的机制来保证数据的一致性,比如在Cache中标记某个数据块为“dirty”,表示该块中的数据已经被修改,需要写回主存。

四、Write-invalidate写策略:Write-invalidate写策略是指,在Cache中有数据被修改并写回主存后,该数据块会被标记为“invalid”,表示当前Cache中的数据已经过时,需要重新从主存中读取。

这种写策略的缺点是需要频繁从主存中读取数据,可能会降低Cache的效率和速度。

但是由于无需维护“dirty”位或其他数据一致性机制,所以比较适用于写操作不频繁的场景。

以上是常见的Cache写策略。

在实现Cache写策略时,需要根据实际场景选择合适的策略。

cache的基本原理

cache的基本原理缓存(cache)是一种用于存储临时数据的高速存储器,通常位于计算机的内部或接近CPU。

它具有快速的读写速度和较小的容量,以提高系统的性能和响应速度。

缓存的基本原理是利用数据的局部性原理,将最常用的数据复制到高速存储器中,使CPU能够更快地访问这些数据,从而减少对慢速外部存储器的访问次数。

缓存的基本原理可以分为三个层面:局部性原理、缓存一致性原理和替换策略。

1.局部性原理:局部性原理是缓存能够有效工作的基础。

程序在执行时的数据访问往往表现出两种局部性:时间局部性和空间局部性。

时间局部性指的是一旦程序访问了某个数据,它在短时间内很可能再次被访问到;空间局部性指的是一旦程序访问了某个数据,它附近的数据也很可能会被访问。

缓存利用了时间局部性特征,将最近被CPU访问的数据复制到缓存中,以便下次CPU再次访问相同数据时可以直接从缓存中读取,避免了从主存中读取数据的延迟。

同时,缓存还利用了空间局部性特征,在CPU访问一个数据时,将它所在的数据块一并复制到缓存中,预先加载相邻的数据,提高数据的连续性访问。

2.缓存一致性原理:缓存一致性原理是指在多级缓存系统中,各级缓存之间需要保持数据的一致性。

多级缓存系统中,数据可能被同时存储在多个级别的缓存中,当CPU修改了一个数据时,需要保证这个修改操作对其他缓存可见。

缓存一致性通过使用一致性协议来实现。

常见的一致性协议有:MESI协议(Modified、Exclusive、Shared、Invalid)和MOESI协议(Modified、Owned、Exclusive、Shared、Invalid)。

这些协议通过处理缓存之间的通信和同步,确保数据的一致性,避免了数据的冲突和错误。

3.替换策略:由于缓存容量有限,当缓存已满时,需要替换掉一个缓存行(Cache Line)来给新的数据腾出位置。

替换策略是决定哪个缓存行被替换的规则。

常见的替换策略有:随机替换、先进先出替换(FIFO)、最近最久未使用替换(LRU)等。

cache的读写策略

cache的读写策略Cache的读写策略是指在计算机系统中,对于缓存(Cache)的数据读取和写入操作所采取的策略和方法。

缓存是计算机系统中的一种高速存储器,用于临时存储频繁访问的数据,以提高系统的数据访问速度和性能。

不同的读写策略可以根据系统需求和应用场景进行选择和配置,以达到最优的性能和效果。

一、读策略1. 直接映射读策略直接映射是最简单和常见的读策略,将主存中的数据直接映射到缓存的某个位置。

当需要读取数据时,先检查缓存中是否存在该数据,如果存在则直接返回;如果不存在,则从主存中读取数据并写入缓存,然后返回。

2. 全相联映射读策略全相联映射是一种较为灵活的读策略,它允许缓存中的数据可以存储在任意位置。

当需要读取数据时,会遍历缓存中的所有位置,查找是否存在该数据。

如果存在,则返回;如果不存在,则从主存中读取数据并写入缓存。

3. 组相联映射读策略组相联映射是介于直接映射和全相联映射之间的一种读策略。

将缓存划分为多个组,每个组中可以存储多个数据。

当需要读取数据时,先确定数据所在的组,然后在该组中查找是否存在该数据。

如果存在,则返回;如果不存在,则从主存中读取数据并写入缓存。

二、写策略1. 写回策略写回策略是一种延迟写入的策略。

当需要写入数据时,先将数据写入缓存,不立即写入主存。

只有当该数据被替换出缓存时,才将其写回主存。

写回策略可以减少对主存的写操作次数,提高系统的性能。

2. 写直达策略写直达策略是一种立即写入的策略。

当需要写入数据时,同时将数据写入缓存和主存,保持缓存和主存的数据一致性。

写直达策略可以保证数据的一致性,但会增加对主存的写操作次数。

3. 写分配策略写分配策略是指在写回或写直达时,是否将数据直接写入缓存。

如果采用写分配策略,则将数据直接写入缓存;如果不采用写分配策略,则只将数据写入主存,不写入缓存。

写分配策略可以根据数据的访问情况进行灵活选择,以提高系统的性能。

Cache的读写策略对计算机系统的性能和效果有着重要的影响。

cache工作原理

cache工作原理一、引言Cache是计算机系统中的一种高速缓存存储器,用于提高系统的访问速度。

它通过存储最常用的数据和指令,以便在需要时能够快速访问。

本文将详细介绍Cache的工作原理,包括Cache的层次结构、替换策略、写回策略以及Cache一致性等。

二、Cache的层次结构Cache通常被组织成多级层次结构,以提供更高的访问速度。

常见的层次结构包括L1 Cache、L2 Cache和L3 Cache。

L1 Cache位于处理器核心内部,是最接近处理器的一级缓存,速度最快但容量较小。

L2 Cache位于处理器核心和主存之间,速度较快且容量较大。

L3 Cache则位于L2 Cache和主存之间,容量更大但速度相对较慢。

三、Cache的工作原理1. 缓存命中当处理器需要访问内存中的数据或者指令时,首先会在Cache中进行查找。

如果所需数据或者指令在Cache中存在,即发生了缓存命中,处理器可以直接从Cache中读取数据或者指令,避免了访问主存的延迟。

2. 缓存不命中如果所需数据或者指令不在Cache中,即发生了缓存不命中,处理器需要从主存中读取数据或者指令。

同时,处理器还会将主存中的一部份数据或者指令加载到Cache中,以便下次访问时能够直接命中。

3. 替换策略当Cache已满且需要加载新的数据或者指令时,就需要进行替换。

常见的替换策略有最近至少使用(LRU)、先进先出(FIFO)和随机替换等。

LRU策略会替换最近至少被访问的数据或者指令,而FIFO策略会替换最早被加载到Cache中的数据或者指令。

4. 写回策略当处理器对Cache中的数据进行修改时,有两种写回策略可供选择:写直达(Write-through)和写回(Write-back)。

写直达策略会立即将修改的数据写入主存,保证数据的一致性,但会增加总线流量和延迟。

写回策略则将修改的数据暂时保存在Cache中,惟独在被替换出Cache或者需要被其他处理器访问时才写回主存。

cache工作原理

cache工作原理1. 概述Cache是计算机系统中的一种高速缓存存储器,用于提高数据访问速度。

它位于主存和CPU之间,用于存储最常用的数据和指令。

Cache工作原理是通过在高速缓存中存储最常访问的数据,以便CPU能够更快地访问这些数据,从而提高系统的整体性能。

2. Cache的结构Cache通常由多级结构组成,其中包括L1、L2、L3等多级缓存。

每一级缓存都有不同的大小和访问速度,越靠近CPU的缓存级别越小且速度越快。

一般来说,L1缓存是最小且最快的,L3缓存是最大且最慢的。

3. Cache的工作原理当CPU需要访问数据时,它首先会检查L1缓存。

如果数据在L1缓存中找到,CPU就可以直接从缓存中读取数据,这样可以大大提高访问速度。

如果数据不在L1缓存中,CPU会继续检查更大的L2缓存,以此类推,直到找到数据或者最后一级缓存。

如果数据在任何一级缓存中找到,CPU会将数据加载到更靠近CPU的缓存级别中,并从缓存中读取数据。

如果数据在所有缓存中都找不到,CPU将从主存中读取数据,并将其加载到L1缓存中,以备将来的访问。

4. Cache的命中和未命中当CPU在缓存中找到所需的数据时,称为“命中”。

如果数据不在缓存中,称为“未命中”。

命中率是衡量缓存性能的重要指标。

高命中率意味着大部分数据都能够从缓存中读取,从而提高系统性能。

未命中率高则意味着缓存无法满足CPU的需求,导致频繁从主存中读取数据,降低系统性能。

5. Cache的替换策略当缓存满时,如果需要将新的数据加载到缓存中,就需要替换掉一部分已有的数据。

常用的替换策略有最近最少使用(LRU)、随机替换等。

LRU策略是指替换最近最长时间未被访问的数据,以便为新的数据腾出空间。

6. Cache的写策略Cache的写策略包括写回(Write Back)和写直达(Write Through)两种方式。

写回策略是指当CPU修改缓存中的数据时,只会更新缓存数据,不会立即写回主存,而是等到缓存被替换出去时才写回主存。

cache工作原理

cache工作原理一、概述Cache是计算机系统中常用的一种高速缓存技术,用于提高数据访问速度。

它是位于CPU和主内存之间的一层存储,通过存储最常用的数据和指令,减少CPU等待数据的时间,从而提高系统的整体性能。

本文将详细介绍Cache的工作原理。

二、Cache的组成1. Cache结构Cache由多个Cache行组成,每一个Cache行包含一个标记(Tag)、一组数据(Data)和一些控制位(Valid、Dirty等)。

2. Cache层次结构计算机系统中通常存在多级Cache,如L1 Cache、L2 Cache等。

L1 Cache位于CPU内部,速度最快,容量较小;L2 Cache位于CPU外部,速度较慢,容量较大。

多级Cache的目的是在速度和容量之间进行平衡。

三、Cache的工作流程1. 访问过程当CPU需要读取数据时,首先会在Cache中查找。

如果数据在Cache中命中(Hit),则直接从Cache中读取;如果未命中(Miss),则需要从主内存中读取数据,并将数据存入Cache中。

2. 命中率命中率是衡量Cache性能的重要指标,表示CPU在访问时命中Cache的比例。

命中率越高,Cache的效果越好。

命中率可以通过统计命中次数和访问次数来计算。

3. 替换策略当Cache已满且需要存储新数据时,需要进行替换操作。

常见的替换策略有随机替换、先进先出(FIFO)替换和最近至少使用(LRU)替换等。

其中,LRU替换策略根据数据的访问情况来选择替换的数据,通常能够获得较好的性能。

4. 写操作Cache支持读写操作,当CPU进行写操作时,有两种方式:写回(Write Back)和写直达(Write Through)。

写回方式先将数据写入Cache,当Cache行被替换时才写回主内存;写直达方式直接将数据写入Cache和主内存。

写回方式可以减少主内存的写操作,提高性能。

四、Cache的优化技术1. Cache块大小Cache块大小的选择对性能有重要影响。

disk cache policy write policy -回复

disk cache policy write policy -回复磁盘缓存策略和写策略在计算机系统中起着关键作用,它们能够优化磁盘操作的性能和效率。

本文将逐步解释和探讨磁盘缓存策略和写策略的原理和应用。

磁盘缓存策略是计算机系统中用于提高磁盘存储访问速度的一种方法。

磁盘缓存是一块用于暂时存储磁盘访问数据的高速缓存区域,它位于主存储器和磁盘之间。

通过将最常用的数据存储在磁盘缓存中,系统可以减少对慢速磁盘的访问次数,从而加快磁盘操作的速度。

磁盘缓存策略的一个关键方面是缓存替换算法。

缓存替换算法决定了哪些数据应该被保存在磁盘缓存中,并在需要时选择哪些数据应该从缓存中删除。

常见的缓存替换算法包括最近最少使用(LRU)、最不经常使用(LFU)和随机替换算法。

其中,最近最少使用(LRU)算法是一种基于时间的策略,它将最近最久未使用的数据块替换出缓存。

这意味着最近较少使用的数据将有更大可能性被保留在缓存中,以便可以更快地访问。

最不经常使用(LFU)算法则是根据频率信息确定哪些数据最少使用,并将其替换出缓存。

除了缓存替换算法之外,磁盘缓存策略还涉及到缓存的大小和缓存的位置等因素。

通过增加缓存的大小,系统可以提供更多的空间来存储频繁访问的数据,从而提高磁盘操作的性能。

而选择合适的缓存位置可以减少数据传输的延迟,从而提高访问速度。

然而,磁盘缓存策略并不仅仅关注读取操作,它还需要考虑写入操作。

写策略决定了何时将数据从缓存写入磁盘。

常见的写策略包括写回和写穿透。

写回策略是指在数据被修改后,先将数据保存在缓存中,并在适当的时候再将数据写回磁盘。

这可以减少对磁盘的实际写入次数,从而提高写入操作的效率。

然而,写回策略可能会导致数据的不一致性,因为缓存中的数据可能会与磁盘中的数据不同步。

为了避免数据的不一致性问题,可以使用写穿透策略。

写穿透策略在数据被修改后立即将数据写入磁盘,以确保数据的一致性。

这可能会增加磁盘访问的延迟,但可以保证数据的准确性。

cache读写流程

cache读写流程Cache是计算机系统中常用的一种存储技术,用于提高数据访问的效率。

在计算机系统中,CPU和内存之间的数据传输速度往往比较慢,因此引入了Cache作为一个高速缓存,用于存储CPU频繁访问的数据,以提高数据访问的速度。

Cache的读写流程包括数据的读取和写入两个过程。

下面将详细介绍Cache的读写流程。

1. 数据读取流程当CPU需要读取数据时,首先会在Cache中进行查找。

Cache通常被分为多个块(block),每个块可以存储一定数量的数据。

在读取数据时,CPU会先检查所需数据是否已经存储在Cache中。

如果数据已经在Cache中,那么CPU可以直接从Cache中获取,无需访问内存,从而提高读取速度。

如果所需数据不在Cache中,那么就发生了Cache未命中(Cache miss)。

此时,CPU会向内存发送读取请求,并将数据从内存读取到Cache中。

为了提高数据读取的效率,Cache通常会采用一种叫做缓存行(cache line)的数据单位,一次从内存读取的数据通常是一整个缓存行。

2. 数据写入流程当CPU需要写入数据时,首先会在Cache中进行查找。

与数据读取类似,CPU会先检查待写入的数据是否已经存在于Cache中。

如果数据已经存在于Cache中,那么CPU可以直接将数据写入Cache,而无需访问内存。

这种情况下的数据写入称为Cache命中(Cache hit)。

如果待写入的数据不在Cache中,那么就发生了Cache未命中。

此时,CPU会将待写入的数据同时写入Cache和内存中。

为了保持Cache和内存中的数据一致性,通常会采用一种叫做写回(write-back)的策略,即先将数据写入Cache,待Cache中的数据被替换出去时再写入内存。

3. Cache替换策略Cache的容量是有限的,当Cache已满时,如果发生了Cache未命中,就需要替换掉一个已有的缓存行,以腾出空间存储新的数据。

cache工作原理

cache工作原理1. 介绍Cache(高速缓存)是计算机系统中的一种关键组件,用于提高数据访问速度和系统性能。

它位于CPU与主内存之间,作为临时存储器,存储最常用的数据和指令。

本文将详细介绍Cache的工作原理及其相关概念。

2. Cache的层次结构Cache的层次结构通常由L1、L2和L3三级组成。

L1 Cache位于CPU内部,速度最快但容量最小;L2 Cache位于CPU与主内存之间,速度较快,容量适中;L3 Cache位于CPU外部,速度较慢但容量较大。

数据从L1 Cache开始查找,如果未找到,则继续在L2和L3 Cache中查找,直到找到或者在主内存中找到。

3. Cache的工作原理当CPU需要访问数据时,首先会在Cache中进行查找。

如果数据在Cache中找到(命中),则称为Cache命中,CPU可以直接从Cache中读取数据,避免了访问主内存的时间延迟。

如果数据未在Cache中找到(未命中),则需要访问主内存,将数据加载到Cache中,并返回给CPU。

Cache的目标是尽可能提高命中率,减少对主内存的访问次数,从而提高系统性能。

4. Cache的替换策略当Cache已满时,需要替换一部分数据以腾出空间来存储新的数据。

常见的替换策略有:最近最少使用(LRU)、先进先出(FIFO)和随机替换等。

LRU策略将最近最少使用的数据替换,FIFO策略将最早进入Cache的数据替换,随机替换则随机选择一部分数据进行替换。

替换策略的选择需要根据具体应用场景和性能需求来确定。

5. Cache的写策略Cache的写策略决定了数据何时写回主内存。

常见的写策略有:写回(Write Back)和写直达(Write Through)。

写回策略在Cache中修改数据时,不立即写回主内存,而是等到Cache中的数据被替换时才写回。

写直达策略则在Cache中修改数据时立即写回主内存。

写回策略可以减少对主内存的写操作次数,提高性能,但也增加了数据一致性的复杂性。

Cache替换策略

Cache替换策略LRU, Least Recently Used, LRU算法根据各block(cache line)使⽤的情况,总是选择那个最长时间未被使⽤的block进⾏替换。

这种策略⽐较好的反映了程序局部性规律。

gem5中该替换策略的代码:voidLRURP::invalidate(const std::shared_ptr<ReplacementData>& replacement_data)const{// Reset last touch timestampstd::static_pointer_cast<LRUReplData>(replacement_data)->lastTouchTick = Tick(0);}voidLRURP::touch(const std::shared_ptr<ReplacementData>& replacement_data) const{// Update last touch timestampstd::static_pointer_cast<LRUReplData>(replacement_data)->lastTouchTick = curTick();}voidLRURP::reset(const std::shared_ptr<ReplacementData>& replacement_data) const{// Set last touch timestampstd::static_pointer_cast<LRUReplData>(replacement_data)->lastTouchTick = curTick();}ReplaceableEntry*LRURP::getVictim(const ReplacementCandidates& candidates) const{// There must be at least one replacement candidateassert(candidates.size() > 0);// Visit all candidates to find victimReplaceableEntry* victim = candidates[0];for (const auto& candidate : candidates) {// Update victim entry if necessaryif (std::static_pointer_cast<LRUReplData>(candidate->replacementData)->lastTouchTick <std::static_pointer_cast<LRUReplData>(victim->replacementData)->lastTouchTick) {victim = candidate;}}return victim;}View CodeMRU(Most Recently Used)和LRU类似,差别在于选择最近被使⽤的block进⾏替换。

cache工作原理

cache工作原理1. 概述Cache是计算机体系结构中的一种高速缓存存储器,用于提高计算机系统的性能。

它位于CPU和主存之间,存储了最近访问的数据和指令,以便快速响应处理器的访问请求。

本文将详细介绍Cache的工作原理。

2. Cache的组成Cache由多个Cache行组成,每个Cache行包含一个标记(Tag)、一个有效位(Valid Bit)和一个数据块(Data Block)。

标记用于比较主存地址,有效位表示数据块是否有效。

3. Cache的工作流程当CPU需要读取数据时,首先会在Cache中查找。

如果数据在Cache中命中(Hit),则称为Cache命中,数据将直接从Cache中读取,称为Cache读取。

如果数据不在Cache中命中(Miss),则需要从主存中读取数据,称为主存读取,并将数据存入Cache中,称为Cache写入。

4. Cache命中Cache命中是指CPU访问的数据或指令在Cache中已经存在的情况。

Cache命中可以分为三种类型:直接映射、全相联映射和组相联映射。

4.1 直接映射直接映射是最简单的Cache映射方式。

CPU的地址被划分为三个部分:标记(Tag)、组索引(Index)和块内偏移(Offset)。

CPU访问的地址首先被分成组索引和块内偏移,组索引用于在Cache中选择一个Cache行,然后标记用于比较以确定是否命中。

4.2 全相联映射全相联映射是最灵活的Cache映射方式。

CPU的地址被划分为两个部分:标记(Tag)和块内偏移(Offset)。

每个Cache行的标记与CPU地址的标记进行比较,以确定是否命中。

4.3 组相联映射组相联映射是直接映射和全相联映射的折中方案。

CPU的地址被划分为三个部分:标记(Tag)、组索引(Index)和块内偏移(Offset)。

组相联映射将Cache分为多个组,每个组由多个Cache行组成。

CPU地址的组索引用于选择一个组,然后在该组中选择一个Cache行进行标记比较。

cache工作原理

cache工作原理一、概述Cache是计算机系统中一种高速缓存存储器,用于提高数据访问速度。

它位于CPU和主内存之间,存储了最常访问的数据和指令。

Cache工作原理是通过在CPU和主内存之间建立一个较小但更快的存储器层次结构,减少对主内存的访问次数,从而加快数据的读取和写入速度。

二、Cache的结构Cache分为多级,通常包括L1、L2、L3等级别。

L1 Cache挨近CPU,速度最快,但容量较小;L2 Cache速度稍慢,容量较大;L3 Cache速度最慢,容量最大。

数据在Cache中按照块的形式存储,每一个块包含一个数据单元和一个标记单元。

标记单元用于标记块中存储的数据是否有效。

三、Cache的工作原理1. 缓存命中当CPU需要访问某个数据或者指令时,首先会在Cache中查找。

如果数据在Cache中存在,即缓存命中,CPU可以直接从Cache中读取数据,避免了访问主内存的开消,提高了访问速度。

2. 缓存未命中如果数据在Cache中不存在,即缓存未命中,CPU需要从主内存中读取数据,并将其存储到Cache中。

此时,CPU会根据一定的算法将主内存中的数据块加载到Cache中的某个位置,并更新标记单元。

3. 替换策略当Cache已满时,如果需要加载新的数据块,就需要替换掉Cache中的某个旧的数据块。

常见的替换策略有:最近至少使用(LRU)、先进先出(FIFO)和随机替换等。

这些策略根据数据的访问频率和时间顺序来选择替换哪个数据块。

4. 写回和写直达当CPU对Cache中的数据进行写操作时,有两种策略:写回和写直达。

写回是指将修改后的数据仅写入Cache,而不即将写入主内存,这样可以减少写操作对性能的影响。

写直达是指将修改后的数据同时写入Cache和主内存,保持Cache和主内存的一致性。

5. Cache一致性Cache一致性是指多个Cache之间数据的一致性。

当多个CPU同时访问同一块数据时,可能会浮现数据不一致的情况。

cache工作原理

cache工作原理概述:Cache(缓存)是一种用于提高计算机系统性能的关键技术。

它通过存储最常用的数据,以便在需要时能够快速访问,减少对主存储器的访问次数,提高数据访问速度。

本文将详细介绍Cache的工作原理及其在计算机系统中的应用。

一、Cache的基本原理1.1 数据局部性原理Cache的设计基于数据局部性原理。

数据局部性包括时间局部性和空间局部性。

时间局部性指的是在一段时间内,同一数据被多次访问的概率较大;空间局部性指的是在一段时间内,与已访问数据相邻的数据被访问的概率较大。

1.2 Cache结构Cache通常由多级组成,每一级称为Cache层。

Cache层次结构通常包括L1、L2、L3等多级Cache。

L1 Cache离处理器最近,速度最快,但容量较小;L2 Cache次之,容量较大;L3 Cache则容量更大,但速度较慢。

不同级别的Cache之间通过总线或者互联网络连接。

1.3 缓存行Cache中的数据以缓存行为单位进行存储和管理。

缓存行是Cache中最小的可读写单位,通常为2的幂次方大小,如64字节或者128字节。

缓存行的大小决定了Cache的粒度。

1.4 缓存映射方式Cache中的数据通过地址映射方式进行访问。

常见的缓存映射方式有直接映射、全相联映射和组相联映射。

直接映射将主存地址直接映射到Cache中;全相联映射将主存地址的所有位都用于Cache索引;组相联映射将主存地址划分为多个组,每一个组内部采用全相联映射方式。

二、Cache的工作过程2.1 Cache读取数据当处理器需要读取数据时,首先会在Cache中查找。

如果数据在Cache中命中(hit),则直接从Cache中读取数据;如果未命中(miss),则需要从主存储器中读取数据,并将数据存入Cache中。

2.2 Cache写入数据当处理器需要写入数据时,首先会在Cache中查找。

如果数据在Cache中命中,则直接写入Cache;如果未命中,则需要从主存储器中读取该数据块,并将数据写入Cache。

cache工作原理

cache工作原理一、引言Cache是计算机系统中一种重要的高速缓存存储器,它的存在可以大大提高计算机系统的性能。

本文将详细介绍Cache的工作原理,包括Cache的基本概念、Cache的结构、Cache的工作流程以及Cache的替换策略。

二、Cache的基本概念Cache是一种位于CPU与主存之间的高速缓存存储器,用于存储CPU频繁访问的数据和指令。

它的作用是提供快速的数据访问,减少CPU等待主存的时间,从而提高计算机系统的整体性能。

三、Cache的结构Cache的结构一般包括Cache存储体、地址映射和替换策略三个部分。

1. Cache存储体:Cache存储体由一组存储单元组成,每个存储单元称为一个Cache行。

每个Cache行可以存储一部分主存的数据和对应的标记位。

Cache的大小一般以字节为单位进行描述,常见的大小有4KB、8KB等。

2. 地址映射:地址映射用于将主存地址映射到Cache中的对应位置。

常见的地址映射方式有直接映射、全相联映射和组相联映射。

直接映射是最简单的方式,每个主存地址只对应一个Cache行;全相联映射是最灵活的方式,每个主存地址可以映射到任意一个Cache行;组相联映射是直接映射和全相联映射的折中方式,将Cache存储体划分为多个组,每个组包含若干个Cache行。

3. 替换策略:当Cache已满时,新的数据需要替换掉已有的数据。

常见的替换策略有最近最少使用(LRU)、先进先出(FIFO)和随机替换等。

LRU是一种基于数据访问历史的替换策略,即替换最长时间未被访问的数据;FIFO是一种先进先出的替换策略,即替换最早进入Cache的数据;随机替换则是随机选择一个数据进行替换。

四、Cache的工作流程Cache的工作流程一般包括Cache命中和Cache未命中两种情况。

1. Cache命中:当CPU需要读取或写入数据时,首先检查Cache中是否存在对应的数据。

如果存在,则称为Cache命中,CPU可以直接从Cache中读取或写入数据,避免了访问主存的时间延迟,提高了系统性能。

cache工作原理

cache工作原理概述:Cache是计算机系统中的一种高速缓存,用于存储最近访问的数据,以提高系统的性能。

它位于CPU和主存之间,作为CPU和主存之间的数据传输的中间媒介。

本文将详细介绍Cache的工作原理。

一、Cache的基本原理:Cache的主要目的是减少CPU访问主存的次数,从而提高数据访问的速度。

Cache采用了一种局部性原理,即数据的访问具有时间和空间的局部性。

根据这个原理,Cache将最近访问的数据存储在高速存储器中,以便CPU快速获取。

二、Cache的结构:Cache的结构通常由三个部份组成:Cache存储体、地址转换和替换策略。

1. Cache存储体:Cache存储体是Cache中存储数据的部份,它由一组存储单元组成,每一个存储单元称为一个Cache块。

每一个Cache块包含一个数据单元和一个标记单元。

数据单元用于存储数据,标记单元用于标识数据的地址。

2. 地址转换:地址转换是将CPU发出的主存地址转换为Cache存储体中的地址。

通常采用的地址转换方式是通过Cache的索引、标记和块内地址来实现。

索引用于定位Cache中的存储块,标记用于比较Cache中存储块的地址是否与CPU请求的地址相匹配,块内地址用于确定具体的数据位置。

3. 替换策略:当Cache存储体已满时,新的数据需要替换掉旧的数据。

替换策略是决定哪些数据应该被替换的策略。

常用的替换策略有随机替换、先进先出(FIFO)替换和最近至少使用(LRU)替换等。

三、Cache的工作流程:Cache的工作流程通常包括读取和写入两个过程。

1. 读取数据:当CPU需要读取数据时,首先会将地址发送给Cache。

Cache会根据地址进行索引和标记的比较,以确定是否存在所需的数据。

如果Cache中存在所需的数据,即命中(hit),则Cache会立即将数据返回给CPU。

如果Cache中不存在所需的数据,即未命中(miss),则Cache会向主存发送请求,将数据从主存读取到Cache中,并返回给CPU。

计算机系统基础:Cache替换算法和写策略单元测试与答案

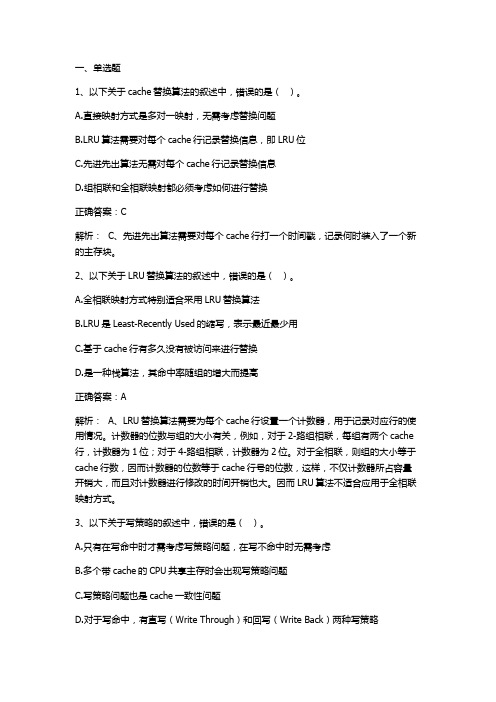

1、以下关于cache替换算法的叙述中,错误的是()。

A.直接映射方式是多对一映射,无需考虑替换问题B.LRU算法需要对每个cache行记录替换信息,即LRU位C.先进先出算法无需对每个cache行记录替换信息D.组相联和全相联映射都必须考虑如何进行替换正确答案:C解析: C、先进先出算法需要对每个cache行打一个时间戳,记录何时装入了一个新的主存块。

2、以下关于LRU替换算法的叙述中,错误的是()。

A.全相联映射方式特别适合采用LRU替换算法B.LRU是Least-Recently Used的缩写,表示最近最少用C.基于cache行有多久没有被访问来进行替换D.是一种栈算法,其命中率随组的增大而提高正确答案:A解析: A、LRU替换算法需要为每个cache行设置一个计数器,用于记录对应行的使用情况。

计数器的位数与组的大小有关,例如,对于2-路组相联,每组有两个cache 行,计数器为1位;对于4-路组相联,计数器为2位。

对于全相联,则组的大小等于cache行数,因而计数器的位数等于cache行号的位数,这样,不仅计数器所占容量开销大,而且对计数器进行修改的时间开销也大。

因而LRU算法不适合应用于全相联映射方式。

3、以下关于写策略的叙述中,错误的是()。

A.只有在写命中时才需考虑写策略问题,在写不命中时无需考虑B.多个带cache的CPU共享主存时会出现写策略问题C.写策略问题也是cache一致性问题D.对于写命中,有直写(Write Through)和回写(Write Back)两种写策略解析: A、写命中指要写的单元已经在cache中,写不命中指要写的单元不在cache 中。

不管是写命中还是写不命中,都需要考虑写策略问题。

在写命中时,可以采用直写(Write Through)或回写(Write Back)方式。

前者在写cache的同时也写主存;后者仅写cache,在被替换出去时再将整个主存块写入主存。

cache写策略

cache写策略Write Through (完全写⼊)CPU向cache写⼊数据时,同时向memory也写⼀份,使cache和memory的数据保持⼀致。

优点是简单,缺点是每次都要访问memory,速度⽐较慢。

Write Back (回写)CPU更新cache时,只是把更新的cache区标记⼀下,并不同步更新memory。

只是在cache区要被新进⼊的数据取代时,才更新 memory。

这样做的原因是考虑到很多时候cache存⼊的是中间结果,没有必要同步更新memory。

优点是CPU执⾏的效率提⾼,缺点是实现起来技术⽐较复杂。

区别完全写⼊(Write through)是⼀种实时同步的缓存机制,即每当缓存中的数据被更新后,这次改动会⽴即更新到计算机内存中。

⽽回写(Write Back)的机制则是⼀种⾮实时同步的缓存机制,也就是说,当CPU存取的数据在缓存中进⾏修改时,并不会马上将缓存中改变的数据实时同步到内存。

回写相对于完全写⼊来说,是⼀个更为复杂的缓存使⽤策略。

这种策略常被称作“延时写⼊”。

使⽤该回写策略时,CPU每次对缓存中的数据做出修改,都会对修改的数据块做上⼀个“记号”,表⽰该数据被修改过。

这些数据被称作“脏”数据,每当有CPU要求缓存中不存在的数据时,这些脏数据就会写⼊到内存中。

所以,⼀旦 CPU请求⼀个缓存中不存在的数据时,就需要两次访问内存的操作,第⼀次是在内存中检索该数据,第⼆次则是将脏数据写⼊到内存中,为新数据让位。

Write allocate policy在有cache的单机系统中,通常有两种写策略:write through和write back。

这两种写策略都是针对写命中(write hit)情况⽽⾔的:write through是既写cache也写main memory;write back是只写cache,并使⽤dirty标志位记录cache的修改,直到被修改的cache 块被替换时,才把修改的内容写回main memory。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Cache的替换策略

例: 访问顺序号:1 2 3 4 5 6 7 8 9 10 11 12 13 14 15

访问主存块地址:1 2 4 1 3 7 0 1 2 5 4 6 4 7 2

0

10 2 31

42 5 63

块 1 1 1 1 1 1 1 1 1 1 41 4 4 4 4

分

配

4 4 4 4 04 0 0 50 5 5 5 5 5

• 常见的写操作策略有两种: 1、全写法、写直达法(Write Through) 2、回写法、写回法(Write B法、写直达法(Write Through):命中时,不仅写Cache, 也同时写入主存。使主存与Cache相关块内容始终保持一致。

优点:主存与Cache始终同步。 缺点:当CPU向主存写操作时, Cache无高速缓冲功能,降低了

Cache的写操作策略

2、回写法、写回法(Write Back):命中需要将信息 写入主存时,暂时只写入 Cache,并不写入主存, Cache中的这个块作一个标记,只有当该块内容需要从 Cache中替换出来时,再一次性写入主存。

优点:减少对主存的写操作次数, 工作速度较快. 缺点:存在Cache与主存数据不一致的隐患.

Cache的功效。

Cache的写操作策略

2、回写法、写回法(Write Back):Cache命中需要将信息写入主存 时,暂时只写入 Cache,并不写入主存,Cache中的这个块作一个 标记,只有当该块内容需要从Cache中替换出来时,再一次性写入 主存。

优点:减少对主存的写操作次数, 工作速度较快。 缺点:存在Cache与主存数据不一致的隐患。

情

2 2 2 2 72 7 7 7 7 7 67 6 6 26

况

3 3 3 3 23 2 2 2 2 72 7

7

块失效

命中

命中率:3/15=0.2

Cache的写操作策略

写操作:Cache内容是主存部分内容的副本,在命中的情况下,如果 CPU对Cache写入,改变了Cache的内容,如何保证Cache内容与主 存中“原本”内容相一致。这就是只有“写”操作才有的问题。

Cache替换策略与 写操作策略

Cache的替换策略

替换:主存—cache地址变换中一旦发生不命中,即需将主存中一个 新的块调入Cache;而一般情况此时cache中相应位置的块中已经装满 数据,需找出一个不常用的块将其放回主存或丢弃,空出来的Cache 位置放新调入的块,此为替换。

替换算法:也叫替换策略。指按映射方式等,决定如何进行相应的数 据块的调入与调出操作。

• RAND算法 • FIFO----First In First Out,先进先出算法 • LRU----Least Recently Used,近期最少使用算法

Cache的替换策略

例:一个“Cache-主存”存储层次,主存分8块(0-7), Cache分4 块(0-3),采用2路组相联映射,组内块数为2块,替换算法为LRU. 对于如下主存块地址流:1、2、4、1、3、7、0、1、2、5、4、6、 4、7、2,如果主存中的内容初始时未装入Cache中,请列出随时 间的Cache中各块的使用情况。