第五讲 关联规则实验解释及决策树(2013)

决策树算法原理

决策树算法原理1 认识决策树1)决策树的生成过程一棵决策树的生成过程主要分为以下3个部分。

(1)特征选择:从训练数据众多的特征中选择一个特征作为当前节点的分裂标准,如何选择特征有着很多不同量化评估标准,从而衍生出不同的决策树算法。

(2)决策树生成:根据选择的特征评估标准,从上至下递归地生成子节点,直到数据集不可分时,决策树停止生长。

对于树结构来说,递归结构是最容易理解的方式。

(3)剪枝:决策树容易过拟合,一般都需要剪枝,缩小树结构规模、缓解过拟合。

2)基于信息论的3种决策树算法划分数据集的最大原则是使无序的数据变得有序。

如果一个训练数据中有10个特征,那么选取哪个作为划分依据?这就必须采用量化的方法来判断,量化划分方法有多种,其中一项就是“信息论度量信息分类”。

基于信息论的决策树算法有ID3、CART和C4.5等算法,其中C4.5和CART两种算法从ID3算法中衍生而来。

CART算法和C4.5算法支持数据特征为连续分布时的处理,主要通过使用二元切分来处理连续变量,即求一个特定的值——分裂值:特征值大于分裂值就走左子树,或者就走右子树。

这个分裂值的选取原则是使得划分后的子树中的“混乱程度”降低,具体到C4.5算法和CART算法有不同的定义方式。

ID3算法由Ross Quinlan发明,建立在“奥卡姆剃刀”的基础上,越是小型的决策树越优于大的决策树。

ID3算法中根据信息论的信息增益评估和选择特征,每次选择信息增益最大的特征作为判断模块。

ID3算法可用于划分标称型数据集,没有剪枝的过程,为了解决过度数据匹配的问题,可通过裁剪合并相邻的无法产生大量信息增益的叶节点(如设置信息增益阈值)。

使用信息增益其实是有一个缺点的,那就是它偏向于具有大量值的属性,就是在训练集中,某个属性所取的不同值的个数越多,那么越有可能拿它来作为分裂属性,而这样做有时候是没有意义的。

另外,ID3算法不能处理连续分布的数据特征,于是就有了C4.5算法。

06第5章-关联规则

<I2:4>

{I2 I1:4}

第22页,共88页。

输入:D:事务数据库; min_sup:最小支持度计数阀值 输出:频繁模式的完全集。

第五章 挖掘频繁模式、关联和相关

5.1 基本概念和线路图

5.1.1 购物篮分析:引发性例子

5.1.2 频繁项集、闭项集和关联规则

5.1.3频繁模式挖掘:路线图

第1页,共88页。

5.1.1 购物篮分析:引发性例子

频繁项集挖掘的一个典型例子是购物篮分 析。

例如:如果顾客在超市购物时购买了牛奶,他们有多大的可 能同时购买面包?

T500 T600 T700

T800

T900

商品ID的列表

I1,I2,I5 I2,I4 I2,I3 I1,I2,I4

I1,I3 I2,I3

I1,I3

I1,I2,I3,I5

I1,I2,I3

表5-1 AllElectronics某分店的是事务数据

第9页,共88页。

D

C1

项集

扫 {I1} 描

对 {I2}

for(k=2; Lk-1≠空集; k++) //由(k-1)项频繁项集产生第k项侯选项集;

Ck= apriori_gen(Lk-1); //产生的第k项侯选项集;

for each 事务 t∈D

//扫描数据库D中的每一个事务t;

{

Ct= subset(Ck,t); //对事务t,产生具有K项的子集赋给Ct; for each 侯选c∈Ct // 检查侯选项集中的某一项是否属于Ct;

1.它可能需要产生大量侯选项集;

2.它可能需要重复地扫描数据库,通过模式匹配检查一个很

大的侯选集合。

简单说明决策树原理

决策树原理简介一、什么是决策树决策树是一种机器学习中常用的分类和回归方法。

它通过对样本的特征进行一系列的判断,最终达到对样本进行分类或预测的目的。

决策树是一种可视化的算法,其结果可以形成一棵树状结构,每个内部节点代表一个特征判断,每个叶子节点代表一种分类或回归结果。

决策树在实践中被广泛应用,特别适用于复杂问题的决策以及数据探索性分析。

二、决策树的构造过程1. 特征选择决策树的构造过程从根节点开始,每次选择一个最好的特征作为当前节点的分裂条件。

特征选择的目标是使得对样本的划分尽可能的准确,即分类结果的纯度最高。

2. 样本划分选定了特征后,决策树根据该特征的取值将样本划分为不同的子集,每个子集对应一个子树。

划分的方式可以是二分法或多分法,具体取决于特征的类型和取值个数。

划分后,每个子树都会继续进行特征选择和样本划分的过程,直到满足终止条件。

3. 终止条件决策树的构建直到满足以下终止条件之一时才会停止: - 当前节点包含的样本属于同一类别。

- 当前节点包含的样本属于同一回归结果。

- 没有更多的特征可供选择,或者样本已经被划分得非常纯净。

4. 剪枝操作决策树的构建可能会造成过拟合现象,即模型过于复杂,对训练集的拟合程度很高,但是在新的数据上表现较差。

为了解决过拟合问题,可以对决策树进行剪枝操作。

剪枝过程可以通过删除一些节点或合并一些相邻节点来实现,目的是降低模型的复杂度,提高泛化能力。

三、决策树的优缺点1. 优点•决策树易于理解和解释,由于其树状结构,可以直观地表示特征间的关系。

•决策树能够处理混合数据类型,不需要对数据进行归一化处理。

•决策树算法可以灵活处理大型数据集。

2. 缺点•决策树容易产生过拟合,特别是在数据的噪声较大或特征维度较高时。

•决策树对于那些取值较多的属性有偏好,因为它通常选择那些能够更好地区分样本的特征进行分裂。

•决策树的稳定性较差,数据的微小变化可能导致生成完全不同的树。

四、决策树的应用场景决策树具有广泛的应用场景,包括但不限于以下几个方面:1. 医学诊断决策树可以用于医学诊断,根据患者的症状和检查结果判断患者的疾病类别。

决策树算法描述

决策树是一种常用的监督学习算法,用于分类和回归问题。

它基于数据的特征对数据进行划分,通过递归地构建树状结构来实现分类或预测目标。

以下是决策树算法的一般描述:

1.选择最佳分割特征:决策树的每个节点代表一个特征或属性,通

过选择最佳的特征来对数据进行分割。

2.创建分支节点:根据所选特征的取值,将数据集划分成不同的子

集。

3.递归构建决策树:对每个子集重复步骤1 和2,直到满足停止条

件(例如,当子集只包含一个类别或达到最大深度)。

4.生成预测结果:根据决策树的结构,对新数据进行预测。

从根节

点开始,根据特征值沿着路径到达叶子节点,得到相应的预测结果。

决策树算法的关键在于选择最佳分割特征和确定停止条件。

常用的特征选择方法包括信息增益、增益率、基尼系数等。

停止条件可以是最小样本数、最大树深度或其他阈值。

决策树算法具有易于理解、可视化和快速预测的优点。

然而,它可能会出现过拟合问题,因此通常会结合剪枝技术来优化决策树的性能。

这只是决策树算法的一个简要描述,实际应用中可能会涉及更多的细节和优化方法。

决策树算法在许多领域都有广泛的应用,如数据挖掘、机器学习和分类问题等。

决策树和决策规则概述课件

该例有14个样本,属性1有一个丢失值,用“?”表示。只有13个样本数据完整。分区前的熵是: Info(T)=-8/13log2(8/13)-5/13log2(5/13) =0.961属性1检验的信息: infox1(T)=5/13(-2/5log2(2/5)-3/5log2(3/5)) +3/13(-3/3log2(3/3)-0/3log2(0/3)) +5/13(-3/5log2(3/5)-2/5log2(2/5)) =0.747

对根节点下的T3子集进行同样的计算,按属性3=真和属性3=假检验,产生两个叶节点。图7-5表示数据库T的最终决策树。

另外,决策树可以用可执行代码(或伪代码)的形式表示。图7-6用伪代码给出了上面例子的决策树。

增益标准对具有许多输出的检验有严重的偏差,根据info(S)的定义,指定一个附加的参数:这表示通过把集T分区成n个子集Ti而生成的潜在信息。现在,定义一个新的增益标准: Gain-radio(X)=gain(X)/Split-info(X)

对应属性2的检验3(属性2≤80和属性2>80)的信息增益计算: infox3(T)=9/14(-7/9log2(7/9)-2/9log2(2/9)) +5/14(-2/5log2(2/5)-3/5log2(3/5)) =0.837 相应的增益: Gain(x3)=0.94-0.837=0.103属性1的增益最高,选择该属性进行首次分区。每个属性值具有一个分枝,产生3个分枝,如图7-4所示.

7.1 决策树

从数据中生成分类器的一个特别有效的方法是生成一个决策树。它是一种基于逻辑的方法,通过一组输入-输出样本构建决策树的有指导学习方法。决策树包含属性已被检验的节点,一个节点的输出分枝和该节点的所有可能的检验结果相对应。

关联规则分析

2013-7-31

总结

AA12 关联规则 史忠植

2

关联规则

关联规则反映一个事物与其他事物之间的相互依存性 和关联性。如果两个或者多个事物之间存在一定的关 联关系,那么,其中一个事物就能够通过其他事物预 测到。关联规则表示了项之间的关系。 示例: cereal, milk fruit

“买谷类食品和牛奶的人也会买水果.”

事务标识 TID 每一个事务关联着一个标识,称作 2013-7-31 AA12 关联规则 史忠植 TID.

7

关联规则的度量

支持度s D中包含A和 B 的事务数与总的事务数的比值

|| {T D | A B T } || s ( A B) || D ||

规则 AB 在数据集D中的支持度为s, 其中s 表示 D中包含AB (即同时包含A和B)的事务的百分率.

Itemset {B, C, E}

3rd scan

Itemset AA12 关联规则 史忠植 {B, C, E}

L3

Apriori 算法

Algorithm: Apriori 输入: Database, D, of transactions; minimum support threshold,min_sup. 输出: L, freuqent itemsets in D. 过程:

I是什么? 事务ID B的T是什么? s(Chips=>Salsa) 是什么? c(Chips=>Salsa)是什么?

2013-7-31 AA12 关联规则 史忠植 11

频繁项集

项集 – 任意项的集合 k-项集 – 包含k个项的项集 频繁 (或大)项集 – 满足最小支持度的项 集

关联规则实验报告

Apriori算法的设计与实现1,实验要求(1)频繁项目集的计算根据题目给定的原始事务记录和最小支持度,通过迭代的方法求出各项频繁项目集。

(2)关联规则的产生根据(1)中求得频繁项目集和给定的最小可信度,求出相关的关联规则。

2.1Apriori算法的原理Apriori算法是一种最有影响的挖掘布尔关联规则频繁项集的算法。

很多的的挖掘算法是在Apriori算法的基础上进行改进的,比如基于散列(Hash)的方法,基于数据分割(Partition)的方法以及不产生候选项集的FP-GROWTH方法等。

因此要了解关联规则算法不得不先要了解Apriori算法。

Apriori算法使用一种称作逐层迭代的候选产生测试(candidate generation and test)的方法,k-项目集用于探索(k+1)-项目集。

首先,找出频繁1-项目集的集合,该集合记作L 。

L 用于找频繁2-向募集到集合L ,而L 用于找L ,如此下去,直到不能找到频繁k-项目集。

找每一个L 均需要一次数据库的扫描。

Apriori性质:频繁项集的所有非空子集必须也是频繁的。

Apriori性质基于如下观察:根据定义,如果项集I不满足最小支持度阈值,则I不是频繁的,即support(I)<min-sup。

如果项A添加到I,则结果项集(即IUA)不可能比I更频繁出现。

因此,IUA也不是频繁的,即support(IUA)<min-sup。

算法应用Apriori性质以LK-1来找LK,这一过程由连接和剪枝组成。

C :Candidate itemset of size k,即k-候选项目集。

L :frequent itemset of size k,即k-频繁项目集。

1、连接步:为找L ,通过L 与自己连接产生候选k-项集的集合。

该候选项集记作C 。

设和是L 中的项集。

记[j]表示的第j项(例如,[k-2]表示的倒数第3项)。

为方便计,假定事务或项集中的项按字典次序排列。

决策树 算法

决策树算法1. 简介决策树算法是一种广泛应用于分类和回归问题的机器学习算法。

它通过从一组特征中选择最佳划分方式来构建一个树形结构的决策模型,从而对新样本进行预测或分类。

决策树算法简单易懂,可解释性强,且能处理同时包含离散和连续特征的数据。

2. 决策树的基本原理决策树算法基于以下几个关键概念:2.1 特征选择在构建决策树的过程中,需要选择最佳的特征来进行划分。

特征选择的目标是通过划分使得每个子节点的纯度最大化(分类问题)或者均方差最小化(回归问题)。

常用的特征选择指标有信息增益、增益率、基尼指数等。

2.2 决策树的构建决策树是通过不断选择最佳特征来递归地构建的。

首先将整个数据集作为根节点,选择一个最佳特征进行划分,然后将数据集划分为多个子集,每个子集对应一个子节点。

递归地对每个子节点进行特征选择和划分,直到满足终止条件(如纯度达到一定阈值或树的深度达到限制)为止。

2.3 决策树的剪枝决策树的构建过程容易导致过拟合,即模型对训练数据过于敏感而无法很好地推广到新样本。

为了避免过拟合,需要对决策树进行剪枝。

剪枝根据一定的准则,去除一些子树或叶节点,从而简化模型。

3. 决策树算法的优缺点3.1 优点•决策树易于理解和解释,模型生成的决策规则可以直观地呈现。

•决策树可以处理离散和连续特征,无需对数据进行特殊处理。

•决策树能够自动选择特征,并通过特征选择来提高模型的性能。

•决策树不需要很大的训练数据集,可以处理小型数据集。

3.2 缺点•决策树容易过拟合,特别是在处理复杂问题时。

•决策树对输入数据的变化非常敏感,哪怕是微小的变化也可能导致完全不同的树结构。

•决策树很难处理包含有不同类别交叉的数据集。

4. 决策树算法的应用决策树算法被广泛应用于许多领域,以下是一些常见的应用场景:4.1 金融风险评估决策树可以根据客户的个人信息和历史数据,判断其信用风险等级。

通过构建一个决策树模型,银行或金融机构可以快速准确地评估客户的风险,从而做出相应的贷款决策。

关联规则和关联分析PPT讲稿

购物篮事务的例子

TID

项集

1

{面包,牛奶}

2

{面包,尿布,啤酒,鸡蛋}

3

{牛奶,尿布,啤酒,可乐}

4

{面包,牛奶,尿布,啤酒}

5

{面包,牛奶,尿布,可乐}

第一节 关联规则基本概念和关联规则挖掘分类

• 关联规则的基本概念 • 关联规则挖掘的基本过程与分类

buys (X , "computer") buys (X , "software")

• 多维关联规则

关联规则挖掘分类 (2)

– 根据规则集所涉及的抽象层 • 单层关联规则 • 多层关联规则 (在不同的抽象层发现关联规则)

age ( X , "30...39") buys ( X , "computer") age ( X , "30...39") buys ( X , "laptop_ computer")

关联规则和关联分析课件

摘要

• 关联规则挖掘是数据挖掘中成果颇丰而且

比较活跃的研究分支。本章主要介绍了关 联规则挖掘的基本概念及其分类,以单维 单层布尔关联规则的挖掘理论为切入点, 介绍关联规则挖掘理论模型以及算法方面 的内容,并简单扼要介绍了多层关联规则 挖掘、多维关联规则挖掘的相关内容,最 后通过一个实例给出了关联分析的医学应 用。

中出现的不同项的相关性。

• 关联分析(association analysis):用于发现隐藏

在大型数据集中的令人感兴趣的联系。所发现的 联系可以用关联规则或者频繁项集的形式表示。 关联规则挖掘就是从大量的数据中挖掘出描述数 据项之间相互联系的有价值的有关知识。

5关联规则及相关算法讲解

㈡ 实例说明

4. 用一个简单的例子说明算法原理。

㈢ CARMA 算法描述

5. 用自然语言描述算法的实现过程。

已有的一些关联规则挖掘算法在运行之前要 求用户输入最小置信度和最小支持度。而对用户 来讲,确定合适的最小置信度和最小支持度比较 困难,需要运行算法多次判断最小置信度和最小 支持度是否过高或过低。 Christian Hidber 1999年提出了在线挖掘关联 规则的算法 CARMA (Continuous Association Rule Mining Algorithm) ,此算法在运行过程中给用户 以反馈,用户可根据反馈信息随时调整最小支持 度,如果用户对输出结果已感到满意,可随时终 止算法的运行。

先找到频繁1-项集集合L1,然后用L1找到频繁2-项集集 合L2,接着用L2找L3,直到找不到频繁k-项集,找每个 Lk需要一次数据库扫描。

以表5-1为例 min_sup=0.22

频繁1-项集为

L1={{牛奶},{果冻},{啤酒},{面包},{花生酱}}

频繁2-项集为

L2={{牛奶,果冻},{牛奶,啤酒},{牛奶,花生酱},{果冻, 啤 酒},{果冻, 面包},{果冻, 花生酱}}

设置 “Apriori 节点” 选项 (采用默认值)。

要产生关联规则,单击工具栏上的绿色箭头 执行流,或单击节点“执行”按钮,可产生 “Apriori 模型”。

设置 “Carma 节点” 选项 单击节点“执 行”按钮,可产生 “Carma 模型”

6. 浏览模型 执行 “ Apriori 节点” 时,生成的 “ Apriori 模型” 将被添加到窗口右上角的“模型”选项卡中。 右键单击此图标,然后从菜单中选择浏览。

决策树(完整)ppt课件

留出法:将数据集D划分为两个互斥的集合:训练集S和测试集T

DST且 ST

;.

18

;.

19

预剪枝

训练集:好瓜 坏瓜 1,2,3,6,7,10,14,15,16,17

1,2,3,14

4,5,13 (T,T,F)

6,7,15,17

8,9 (T,F)

精度:正确分类的样本占所有 样本的比例

验证集:4,5,8,9,11,12,13

三种度量结点“纯度”的指标: 1. 信息增益 2. 增益率 3. 基尼指数

;.

6

1. 信息增益 信息熵

香农提出了“信息熵”的概念,解决了对信息的量化度量问题。 香农用“信息熵”的概念来描述信源的不确定性。

对于二分类任务 y 2

;.

7

假设我们已经知道衡量不确定性大小的这个量已经存在了,不妨就叫做“信息量”

用“编号”将根结点划分后获得17个 分支结点的信息熵均为:

E n t( D 1 ) E n t(D 1 7 ) ( 1 1 lo g 2 1 1 1 0 lo g 2 1 0 ) 0

则“编号”的信息增益为:

G a in (D ,编 号 ) E n t(D )1 71E n t(D v) 0 .9 9 8

;.

30

1. 属性值缺失时,如何进行划分属性选择?(如何计算信息增益) 2. 给定划分属性,若样本在该属性上的值缺失,如何对样本进行划分?

(对于缺失属性值的样本如何将它从父结点划分到子结点中)

D : D : 训练集

训练集中在属性a上没有缺失值的样本子集

D D v :

被属性a划分后的样本子集

D D k :

;.

2

二分类学习任务 属性 属性值

PPT 决策树

2020/4/3

---

2020/4/3

---

优点

2020/4/3

决策树易于理解和实现,人们在在学习 过程中不需要使用者了解很多的背景知 识,这同时是它的能够直接体现数据的 特点,只要通过解释后都有能力去理解 决策树所表达的意义。

市场预测表明:产品销路好的概率为0.7;销路差的概 率为0.3。备选方案有三个:第一个方案是建设大工厂, 需要投资600万元,可使用10年;如销路好,每年可赢 利200万元;如销路不好,每年会亏损40万元。第二个 方案是建设小工厂,需投资280万元;如销路好,每年 可赢利80万元;如销路不好,每年也会赢利60万元。 第三个方案也是先建设小工厂,但是如销路好,3年后 扩建,扩建需投资400万元,可使用7年,扩建后每年 会赢利190万元。

P(c1 )

c1 s

9 14

P(c2 )

c2 s

5 14

计算对给定样本分类所需的期望信息

m

I (c1, c2 ) P(ci ) log(P(ci )) P(c1) log(P(c1)) P(c2 ) log(P(c2 )) = 0.94 i 1

下面计算每个属性的熵。从年龄开始计算

年龄=“<=30”: 年龄=“31~40”: 年龄=“>40”:

2020/4/3

---

组成

• □——决策点,是对几种可能方案的选择,即最后 选择的最佳方案。如果决策属于多级决策,则决策 树的中间可以有多个决策点,以决策树根部的决策 点为最终决策方案。

• ○——状态节点,代表备选方案的经济效果(期望 值),通过各状态节点的经济效果的对比,按照 一定的决策标准就可以选出最佳方案。由状态节 点引出的分支称为概率枝,概率枝的数目表示可 能出现的自然状态数目每个分枝上要注明该状态 出现的概率。

决策树(DecisionTree)原理简述及相关算法(ID3,C4.5)

决策树(DecisionTree)原理简述及相关算法(ID3,C4.5)转载⾃: https:///jerry81333/article/details/53125197Decision Tree 决策树:决策树是属于机器学习监督学习分类算法中⽐较简单的⼀种,决策树是⼀个预测模型;他代表的是对象属性与对象值之间的⼀种映射关系。

树中每个节点表⽰某个对象,⽽每个分叉路径则代表的某个可能的属性值,⽽每个叶结点则对应从根节点到该叶节点所经历的路径所表⽰的对象的值。

决策树仅有单⼀输出,若欲有复数输出,可以建⽴独⽴的决策树以处理不同输出。

下⾯来看个范例,就能很快理解了。

范例:假设,我们有以下数据,表⽰当天是否回去玩⾼尔夫:⽤决策树建⽴起来后,能得到这样的模型:⾄此可以看出,说⽩了,决策树就是If()语句的层层嵌套,知道最后能总结出点什么。

(原谅我实在不会描述点什么,不过看了这图应该对决策树有个⼤致的了解了吧。

)决策树中的元素:决策树中的元素基本和树中的差不多。

最上⾯的⼀个称为根节点,如上图的Outlook,⽤数据中的属性作为根节点或是节点,如Humidity,Windy等。

分⽀使⽤的是节点属性中的离散型数据,如果数据是连续型的,也需要转化成离散型数据才能在决策树中展⽰,如上图将Outlook属性作为根节点,sunny,overcast,rain作为该节点的三个分⽀。

信息熵 Entropy:现在,问题来了,在算法中如何确定使⽤数据的哪个属性作为根节点或是节点。

当然不能随便选,我们追求的⼀直都是最优解,即使是局部最优。

因此我们需要引⼊信息熵这个概念。

1948年,⾹农提出了“信息熵”概念。

⼀条信息的信息量⼤⼩和它的不确定性有直接的关系。

我们对⼀样东西越是⼀⽆所知,想要了解它就需要越多的信息。

举个栗⼦,如果我随机⼀个1-8之间的数字,给你猜,只回答你是或否。

那最好的猜测⽅式应该是,“是不是在1-4之间?”,如果得到否,我们就知道在5-8之间,如果得到是,我们继续猜“是否在1-2之间?”。

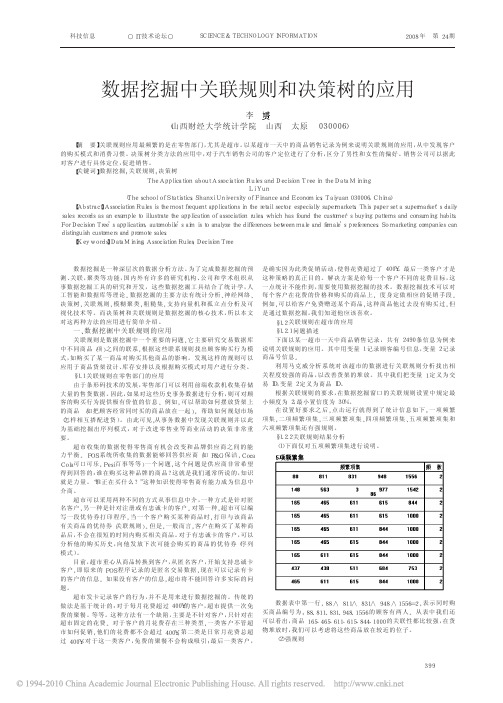

数据挖掘中关联规则和决策树的应用

结果说明: 421==>>82 置信度=0.67, 表示: 购买商 品 421 的 顾 客 中 有 67%的 顾客购买了商品 82。 以此类推: 465∧611∧1000==>>844, 置信度=1.00 表示: 同时购买商品 465、 611、1000 的顾客 100%地购买了商品 844。 844==>>465∧615∧1000, 置信度=0.67 表示 : 购买商品 844 的 顾 客中有 67%的顾客购买了商品 465、615、1000。 465∧1000==>>611∧844, 置 信 度=1.00 表 示 : 同 时 购 买 商 品 465 和 1000 的顾客 100%地购买了商品 611 和 844 根据上面的关联规则分析, 超市在摆放货价时 , 应 该 把 商 品 465、 611 和 1000 还有 844 放在一起。这样, 可以节省 顾 客 的 购 物 时 间 , 增 加超市的销售额。 §1.3 关联规则在电信部门的应用 如果在电信部门的通话记录中, 在 Phones 数据仓 库 中 存 储 了 大 量的一条条通话事务记录, 每条记录存储了事务处理时间, 呼叫类型, 主被叫类型, 通话时间长度, 花费以及关于客户的基本情况。这些数据 中, 常常隐含着形式如下的关联规则: 在上午八点到十点时间通话流 量达到整个设计容量的 95%以上, 18- 30 岁之间的客户发送手机短信 数量占整个通话记录中手机短信数量的 80%等。这些关联规则都很有 价值。电信管理人员可以根据这些关联规则更好的为电信部门服务, 如线路维护时间尽量避免在上午八点到十点之间, 手机短信方式的广 告宣传及其优惠措施应以面向 18- 30 岁的为主等。 关 联 规 则 的 发 现 的 思 路 还 可 以 用 于 序 列 模 式 的 发 现 。用 户 在 电 话 联系时, 除了具有上述关联规律, 还有时间上或序列上的规律, 如很多 时候由于手机花费仍然偏高, 还有手机辐射对身体的负面影响, 顾客 会首先用手机对手机发送短信息, 然后再用座机通电话。 二 、数 据 挖 掘 中 决 策 树 分 类 的 应 用 决策树学习方法是人工智能中的重要理论, 也是数据挖掘的主要 分类决策方法。决策树是建立在信息论的基础之上, 对数据进行分类 的一种方法。首先, 通过一批已知的样本数据建立一棵决策树。然后, 利用建好的决策树, 对数据进行预测。决策树的建立过程可以看作是 数据规则的生成过程, 因此可以认为决策树实现了数据规则的可视 化, 其输出结果也容易理解。 它是一种常用于模型的算法, 它能通过将大数据有目的的分类, 从而能系统的分解数据集中包含的信息, 以发现潜在的规律和关系。 它 能 将 反 反 复 复 所 发 现 的 规 律 以 一 棵 类 似 于 流 程 图 的 树 显 示 出 来 。其 中每个内部节点表示在一个属性上的测试, 每个分枝代表一个测试输 出, 而每个树叶节点代表类或类分布, 树的最顶层节点是根节点。 例如: 在金融领域中将贷款对象分为低贷款风险与高贷款风险两 类。通过决策树, 我们可以很容易地确定贷款申请者是属于高风险的 还是低风险的。 下面应用一个实例对这种方法的应用进行说明。 §2.1 问题描述和决策树分类 这里有某汽车销售公司购车的记录, 一共有 7 个变量, 为: 汽车的 结构( 2 门或 4 门) 、发动机的气缸数( V4 或更高) 、购车者的年龄( ≤50 岁 或>50 岁 ) 、汽 车 的 花 费 ( ≤$30, 000 或>$30, 000) 、汽 车 的 颜 色 ( 红 、 黑、其他) 、购买者性别( 男、女) 。 令 汽车的结构: 2 门=2; 4 门=4 发动机的气缸数: V4=1; 更高=2 购车者的年龄: ≤50 岁=1; >50 岁=2 汽车的花费: ≤$30000=1; >$30000=2

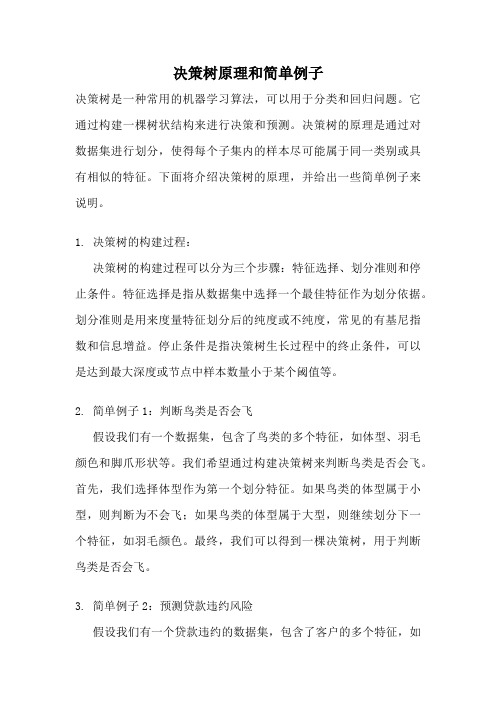

决策树原理和简单例子

决策树原理和简单例子决策树是一种常用的机器学习算法,可以用于分类和回归问题。

它通过构建一棵树状结构来进行决策和预测。

决策树的原理是通过对数据集进行划分,使得每个子集内的样本尽可能属于同一类别或具有相似的特征。

下面将介绍决策树的原理,并给出一些简单例子来说明。

1. 决策树的构建过程:决策树的构建过程可以分为三个步骤:特征选择、划分准则和停止条件。

特征选择是指从数据集中选择一个最佳特征作为划分依据。

划分准则是用来度量特征划分后的纯度或不纯度,常见的有基尼指数和信息增益。

停止条件是指决策树生长过程中的终止条件,可以是达到最大深度或节点中样本数量小于某个阈值等。

2. 简单例子1:判断鸟类是否会飞假设我们有一个数据集,包含了鸟类的多个特征,如体型、羽毛颜色和脚爪形状等。

我们希望通过构建决策树来判断鸟类是否会飞。

首先,我们选择体型作为第一个划分特征。

如果鸟类的体型属于小型,则判断为不会飞;如果鸟类的体型属于大型,则继续划分下一个特征,如羽毛颜色。

最终,我们可以得到一棵决策树,用于判断鸟类是否会飞。

3. 简单例子2:预测贷款违约风险假设我们有一个贷款违约的数据集,包含了客户的多个特征,如年龄、收入和负债比等。

我们希望通过构建决策树来预测客户的贷款违约风险。

首先,我们选择年龄作为第一个划分特征。

如果客户的年龄小于30岁,则判断为低风险;如果客户的年龄大于等于30岁,则继续划分下一个特征,如收入。

最终,我们可以得到一棵决策树,用于预测客户的贷款违约风险。

4. 决策树的优缺点决策树的优点包括易于理解和解释、能处理多分类问题、能处理缺失数据和异常值等。

然而,决策树也有一些缺点,如容易过拟合、对输入数据的变化敏感、不适用于处理连续型特征等。

5. 决策树的剪枝为了解决决策树容易过拟合的问题,可以对决策树进行剪枝。

剪枝是指通过减少决策树的复杂度来提高模型的泛化能力。

常用的剪枝方法有预剪枝和后剪枝。

预剪枝是在构建过程中提前停止生长,而后剪枝是在构建完成后对决策树进行修剪。

决策树——从原理到实战

1 概念决策树,顾名思义,就是帮我们做出决策的树。

现实生活中我们往往会遇到各种各样的抉择,把我们的决策过程整理一下,就可以发现,该过程实际上就是一个树的模型。

决策树分为分类树和回归树两种,分类树对离散变量做决策树,回归树对连续变量做决策树,这里我们只讨论分类树。

比如选择好瓜的时候:我们可以认为色泽、根蒂、敲声是一个西瓜的三个特征,每次我们做出抉择都是基于这三个特征来把一个节点分成好几个新的节点。

在上面的例子中,色泽、根蒂、声音特征选取完成后,开始进行决策,在我们的问题中,决策的内容实际上是将结果分成两类,即是(1)否(0)好瓜。

这一类智能决策问题称为分类问题,决策树是一种简单的处理分类问题的算法。

一颗完整的决策树包含以下三个部分:●根节点:就是树最顶端的节点,比如上面图中的“色泽”。

●叶子节点:树最底部的那些节点,也就是决策结果,好瓜还是坏瓜。

●内部节点,除了叶子结点,都是内部节点。

树中每个内部节点表示在一个属性特征上的测试,每个分支代表一个测试输出,每个叶节点表示一种类别。

给定一个决策树的实例:构造决策树如下:第一层根节点:被分成17份,8是/9否,总体的信息熵为:第二层清晰:被分成9份,7是/2否,它的信息熵为:稍糊:被分成5份,1是/4否,它的信息熵为:模糊:被分成3份,0是/3否,它的信息熵为:我们规定,假设我们选取纹理为分类依据,把它作为根节点,那么第二层的加权信息熵可以定义为:我们规定,,也就是随着决策的进行,其不确定度要减小才行,决策肯定是一个由不确定到确定状态的转变。

因此,决策树采用的是自顶向下的递归方法,其基本思想是以信息熵为度量构造一棵熵值下降最快的树,到叶子节点处的熵值为0,此时每个叶子节点中的实例都属于同一类。

2 生成算法构建决策树时,首先要选择一个根节点,而究竟选择谁来当根节点的准则,有以下三种。

2.1 ID3(信息增益)从信息论的知识中我们知道:信息熵越大,样本的纯度越低。

关联规则和决策树的应用

结束语

• 从决策树和关联规则的应用中,我们可以 看出数据挖掘在生活中的广泛应用。商业 动力的强大动力将会不断的促进数据挖掘 的发展。我们期待着它能解决更多的问题。

谢谢观看!

关联规则的应用

• 啤酒与尿布 • ATM机上的小广告 • 欲罢不能的网上购物

决策树的概念

• 决策树一般都是自上而下的来生成的。每 个决策或事件(即自然状态)都可能引出 两个或多个事件,导致不同的结果,把这 种决策分支画成图形很像一棵树的枝干, 故称决策树。

决策树的特点

• 它 是一种 常用于模 型 的算法,它能通过将大数 据有目的的分类,从而能系统的分解数据集中包含 的信息,以发现潜在的规律和关系。它能将反反复 复所发现的规律以一棵类似 于流程图的树显示出 来中每个内部节点表 示在一个属性上的测试,每个 分枝代表一个 测试输出,而每个树叶节点代表类或 类分布, 树的最顶层节点是根节点。 • 建立决策树的过程,即树的生长过程是不断的把数 据进行切分的过程,每次切分对应一个问题,也对 应着一个节点。对每个切分都要求分成的组之间的 “差异”最大。

数据挖掘

—关联规则与决策树的应用

关联规则的概念

• 关联规则用来发现在同一事件中出现的不 同项的相关性,即找出事务中频繁发生的 项或属性的所有子集,以及项目之间的相 互关联性。 • 关联规则就是形如XY的逻辑蕴含关系,其 中XI,YI且XY=Φ,X称作规则的前件,Y是 结果,对于关联规则XY,存在支持度和信 任度。关联规则就是支持度和信任度分别 满足用户给定阈值的规则。

关联规则的算法

• 1993年,R.Agrawal等人首次提出了挖掘顾 客交易数据中项目集间的关联规则问题, 其核心是基于两阶段频繁集思想的递推算 法。该关联规则在分类上属于单维、单层 及布尔关联规则,典型的算法是Aprior算 法。

决策树(彭展)

《Using Decision Trees to Improve Signature-Based Intrusion Detection》在入侵检测系统中,数据包与规则集之间的匹配过程是最耗时的,目前许多算法都是将每一个输入的数据包依次和所有的规则进行比较,从而确定匹配上的规则,或无任何匹配,但在该过程中存在大量冗余比较,所以这种方法远远没有达到最优。

这里给出了一种方法,将机器学习中的聚类算法应用到规则匹配过程中,以提高匹配效率。

该方法依据给定的规则集来构造一棵决策树,使匹配过程中的比较次数尽可能少,从而提高了整体效率。

一、基本思想:该方法可以分为两个步骤,首先依据给定的规则集建立一棵决策树,接着利用该决策树对网络上的数据包进行匹配,具体过程如下:1. 建立“决策树”:该方法将最初的包含所有规则的集合作为决策树的根节点,然后运用ID3算法,在根节点所包含的规则集合中选取最具有区分度的规则属性,作为根节点的属性标签,再按照规则集在该属性上的不同取值,对其进行分组,分组后的每一个子集都作为根节点的孩子节点并入决策树,在由根节点到孩子节点的分支上,标注该孩子节点所代表的规则集在根节点属性上的取值。

当决策树中,存在一个节点包含多于一个规则时,继续使用ID3算法和上述步骤对该节点进行分组,但在选取属性时不能选择前面已经标注过的属性。

在决策树中,每一个叶子节点,都只包含一条规则,或者一些规则,这些规则不能被任何属性区分开(即这些规则在所有未标注属性上的取值相同)。

依照上述过程,可以确保建立起一棵最优“决策树”,即决策树的高度最短,从而将其用于数据包与规则集的匹配时,能够使平均比较次数最少。

2. 利用“决策树”进行规则匹配:当IDS接受到一个数据包时,匹配过程将从决策树的根结点开始,根据当前节点的属性标签,来检测数据包中该属性的实际取值,依据该属性值选择相应的孩子节点,作为下一步进行检测的节点。

如果匹配过程持续,直到在检测某节点时,无法找到与数据包在该节点属性值一致的孩子节点,这说明没有任何规则与该数据包匹配,匹配过程立即结束。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

IQ=Medium

中

500 1000

低有

200 700 900 400

IQ=Low

பைடு நூலகம்

1800 1600 1400 1200 1000

800 600 400 200

0

PI=low

1200 1000

800 600 400 200

0

无

300 1600

高低 男女

400 600 500 500

400 1600 110 900 0

• 事例表中ordernumber为主键,嵌套表中 Linenumber为主键,model为predict列。

4种不同类型的列

• 键列 • 输入列 • 可预测列(predictonly) • 输入与可预测列(predict) • 对于大多数的数据挖掘模型使用一组输入

列来预测输出列,有一些算法(如聚类算 法)不需要可预测列。

PE=TRUE

PE=FALSE

Male

Female

是 否

帮助高中生进入大学的决定性因素是…

IQ=高

进入大学: 79% 是 21% 否

Wealth

所有学生

进入大学: 55% 是 45% 否

IQ ?

IQ=低

Gender Incom region e

男

高 北美

女

中 北美

男

高 中部

嵌套表内容

ordernu mber

S0001

S0021 S0055 S0007

linenu mber

1 2 3 1 2 1 2 1 2

productn quanti

ame

ty

牛奶

2

面包

3

啤酒

3

蛋糕

5

果汁

2

奶酪

10

面包

3

面包

2

果汁

事例表与嵌套表

• 事例表包含要分析的实体的事例,嵌套 表包含每一事例附加的信息(通常是事务信 息)。

• 事例表是维度表,嵌套表是事实表

•

购买事务表(VassocseqlineItem)

嵌套表示例

Vassocorder(示例表)

Vassoclineitem(嵌套表)

custID C0001

C0002 C0004

算它们的间隔。此时就会得到古怪的逻辑,比如 绿色(4)-红色(3)=蓝色(1)!

•

数据挖掘向导有能力自动检测出一个数值列

是分类类型(离散)的列还是连续型的列。在向导

的“指定列的内容和数据类型”页中,单击“检

测”按钮,该向导就会采样和分析源数据,并且

选择一种合适的内容类型。

• 如果选择了连续的内容类型,但是所选择的算 法不支持连续的列,则内容类型将会被指定为 DISCRETIZED。在设计器中,可以设置离散化 参数,在进入向导的下一步之前,应该确保为每

关重要的。

• 例如,如果有一个字段(比如Income)标记为 DISCRETE,则算法将会假定每一个可能的 Income值是完全不同的类别,并且可能花费额外 的时间进行处理,而无法得到真正有用的信息。

相反,如果有一个分类类型的列,分类由标记为 CONTINUOUS的整型指定(例如,1-蓝色,2- 黄色,3-红色,4-绿色,等等),数据挖掘算法 将会假定:可以对这些分类进行数学比较,并计

• • 挖掘的结论易于理解

• • 初始状态是一个大的空间,挖掘的过程是 递 归分区 – 不断分割

案例

• 我们有大量的会员 • – 年龄在 20 – 60 岁 • – 月薪在 0 – 8000 元 • • 55% 的被我们认可为忠实会员(好会员) • • 里面潜在的规律是什么?

谁是我们的忠实会员?

4

• 事例表主键:唯一确定每个事例的属性 ordernumber

• 嵌套键:嵌套键和外键不一样,嵌套键十 分重要,在嵌套部分,其他属性用于描述 嵌套键。嵌套键不是一个标识符,它包含 有关模式的有用信息。经常用PRODUCT作 为嵌套键。

• 本例中用linenumber,可以表示不同的商品。

分析单一购物篮

一列都指定了正确的内容类型,如果还没有正确 指定,则应该修改。

决策树

分类(Classification)

•分类的意义

数据库

分类模型

预测

了解类别属性 与 特征

Decision Tree决策树

• 决策树是用二叉树形图来表示处理逻辑的一种工 具,是对数据进行分类的方法。决策树的目标是 针对类别因变量加以预测或解释反应结果。

单维挖掘

结果如下图

多维挖掘:添加收入和地区为输入 列,model为输入及预测列

•

如果表有很多列,则很难知道选择哪些列

作为输入列。通常可以使用所有列,但是这会导

致额外的处理开销,而且,根据具体的算法,也

可能会使最终模型很难理解。

• 单击向导的“指定定型数据(Specify the Training Data)”页面中的“建议(Suggest)”按钮 将会执行一个基于熵(entropy-based)的快速分析, 它可以指出哪些列对于所选择的输出列可以提供

帮助高中生进入大学的主要因素 都有哪些?

决策树的工作方式

IQ

父母的鼓励

家庭收入 性别

进入大 是

学

否

1000 900 800 700 600 500 400 300 200 100 0

IQ=High

1800 1600 1400 1200 1000

800 600 400 200

0

PI=High

高

• 主要有两个步骤:首先,通过一批已知的样本数 据建立一棵决策树;然后,利用建好的决策树, 对数据进行预测。

• 决策树的建立过程可以看成是数据规则的生成过 程,因此,决策树实现了数据规则的可视化,其 输出结果也容易理解。

2020/5/18

24

• 可以预测离散的,或者连续的数值

• • 把已知条件(不论是离散还是连续)自动 分 解为多个离散的类别。

一些有用的信息,进而可以在最终模型中减少列 的数量。要注意,通过这个功能进行分析时,只 对事例级列起作用,而且不能保证选择的列会对 目标变量有影响,没有选择的列不会对目标变量 产生影响

关于数据类型

•

下一步,在向导中将会列出已经选择的列

和这些列的数据类型及内容类型,如图4-14所示。

指定合适的内容类型对模型的性能和精确度是至

• 不能只以购物事务表作为事例表 • 只有一个购物事务表,因Linenumber不能

当主键(有重复),而其又代表同一次购 买行为中购买的不同商品。最适合做嵌套 表中的主键 • ordernumber也有重复

• 结果集只有一个项

• 按实验要求,将顾客情况与购物事务表当 做事例表与嵌套表一起操作,如下表