Fisher线性判别

模式识别FISHER线性判别实验

模式识别FISHER线性判别实验

人工知能领域中的模式识别是计算机实现人类识别物体的能力的一种

技术。

它的主要目的是根据给定模式的样本及其特征,自动识别出新的样

本的特征并做出判断。

其中最著名的技术之一就是FISHER线性判别法。

FISHER线性判别法基于正态分布理论,通过计算样本的统计特征来

分类,它是一种基于参数的最优分类算法。

算法的基本思想是通过计算两

个类别的最大类间差异度,以及最小类内差异度,来有效地分类样本。

具

体而言,FISHER线性判别法即求出一个线性超平面,使这个超平面把样

本区分开来,使样本离类中心向量之间的距离最大,同时使类中心向量之

间的距离最小。

FISHER线性判别法的具体实现过程如下:

1.准备好建立模型所需要的所有数据:训练样本集,其样本特征与对

应的类标号。

2.确定每个类的类中心向量c_1,c_2,…,c_m,其中m为类的数目。

3.根据类中心向量求出类间离散度矩阵S_b和类内离散度矩阵S_w。

4.将S_b与S_w相除,得到S_b/S_w,从而求出矩阵的最大特征值

λ_1及最小特征值λ_n。

5.将最大特征值λ_1进行特征值分解,求出其特征向量w,求出判

定函数:

f(x)=w·x+w_0。

6.根据判定函数,将样本进行分类。

线性判别分析

介绍

线性判别分析(Linear Discriminant Analysis, LDA),也 叫做Fisher线性判别(Fisher Linear Discriminant ,FLD), 是模式识别的经典算法,1936年由Ronald Fisher首次提出, 并在1996年由Belhumeur引入模式识别和人工智能领域。

LDA

对于N(N>2)分类的问题,就可以直接写出以下的结论:

这同样是一个求特征值的问题,求出的第i大的特征向量,即为 对应的Wi。

LDA在人脸识别中的应用

要应用方法

K-L变换 奇异值分解 基于主成分分析 Fisher线性判别方法

主要应用方法

K-L变换

为了得到彩色人脸图像的主分量特征灰度图像,可以采用Ohta[3]等人提 出的最优基来模拟K-L变换方法,从而得到新的包含了彩色图像的绝大多 数特征信息的主分量特征图像.

LDA

LDA与PCA(主成分分析)都是常用的降维技术。PCA主要是从 特征的协方差角度,去找到比较好的投影方式。LDA更多的是 考虑了标注,即希望投影后不同类别之间数据点的距离更大, 同一类别的数据点更紧凑。

下面给出一个例子,说明LDA的目标:

可以看到两个类别,一个绿色类别,一个红色类别。左图是两个 类别的原始数据,现在要求将数据从二维降维到一维。直接投影 到x1轴或者x2轴,不同类别之间 会有重复,导致分类效果下降。 右图映射到的直线就是用LDA方法计算得到的,可以看到,红色 类别和绿色类别在映射之后之间的距离是最大的,而且每个类别 内 部点的离散程度是最小的(或者说聚集程度是最大的)。

LDA

假设用来区分二分类的直线(投影函数)为: LDA分类的一个目标是使得不同类别之间的距离越远越好,同 一类别之中的距离越近越好,所以我们需要定义几个关键的值:

判别分析公式Fisher线性判别二次判别

判别分析公式Fisher线性判别二次判别判别分析是一种常用的数据分析方法,用于根据已知的类别信息,将样本数据划分到不同的类别中。

Fisher线性判别和二次判别是两种常见的判别分析方法,在实际应用中具有广泛的应用价值。

一、Fisher线性判别Fisher线性判别是一种基于线性变换的判别分析方法,该方法通过寻找一个合适的投影方向,将样本数据投影到一条直线上,在保持类别间离散度最大和类别内离散度最小的原则下实现判别。

其判别函数的计算公式如下:Fisher(x) = W^T * x其中,Fisher(x)表示Fisher判别函数,W表示投影方向的权重向量,x表示样本数据。

具体来说,Fisher线性判别的步骤如下:1. 计算类别内离散度矩阵Sw和类别间离散度矩阵Sb;2. 计算Fisher准则函数J(W),即J(W) = W^T * Sb * W / (W^T * Sw * W);3. 求解Fisher准则函数的最大值对应的投影方向W;4. 将样本数据投影到求得的最优投影方向上。

二、二次判别二次判别是基于高斯分布的判别分析方法,将样本数据当作高斯分布的观测值,通过估计每个类别的均值向量和协方差矩阵,计算样本数据属于每个类别的概率,并根据概率大小进行判别。

二次判别的判别函数的计算公式如下:Quadratic(x) = log(P(Ck)) - 0.5 * (x - μk)^T * Σk^-1 * (x - μk)其中,Quadratic(x)表示二次判别函数,P(Ck)表示类别Ck的先验概率,x表示样本数据,μk表示类别Ck的均值向量,Σk表示类别Ck的协方差矩阵。

具体来说,二次判别的步骤如下:1. 估计每个类别的均值向量μk和协方差矩阵Σk;2. 计算每个类别的先验概率P(Ck);3. 计算判别函数Quadratic(x);4. 将样本数据划分到概率最大的类别中。

判别分析公式Fisher线性判别和二次判别是常见的判别分析方法,它们通过对样本数据的投影或概率计算,实现对样本数据的判别。

实验二Fisher线性判别分类器

实验二 Fisher 线性判别分类器本实验旨在让同学进一步了解分类器的设计概念,理解并掌握用Fisher 准则函数确定线性决策面方法的原理及方法,并用于实际的数据分类。

一、实验原理线性判别函数的一般形式可表示成0()T g w =+X W X 其中12d x x x ⎛⎫ ⎪ ⎪= ⎪ ⎪⎝⎭ X 12d w w w ⎛⎫ ⎪ ⎪= ⎪ ⎪⎝⎭W 根据Fisher 选择投影方向W 的原则,即使原样本向量在该方向上的投影能兼顾类间分布尽可能分开,类内样本投影尽可能密集的要求,用以评价投影方向W 的函数为:2122212()()F m m J S S -=+ W *112()W S -=-W m m上面的公式是使用Fisher 准则求最佳法线向量的解,该式比较重要。

另外,该式这种形式的运算,我们称为线性变换,其中12-m m 是一个向量,1-WS 是W S 的逆矩阵,如12-m m 是d 维,W S 和1-W S 都是d ×d 维,得到的*W 也是一个d 维的向量。

向量*W 就是使Fisher 准则函数)(W J F 达极大值的解,也就是按Fisher 准则将d 维X 空间投影到一维Y 空间的最佳投影方向,该向量*W 的各分量值是对原d 维特征向量求加权和的权值。

以上讨论了线性判别函数加权向量W 的确定方法,并讨论了使Fisher 准则函数极大的d 维向量*W 的计算方法,但是判别函数中的另一项0W 尚未确定,一般可采用以下几种方法确定0W ,如2~~210m m W +-= 或者 m N N m N m N W ~~~2122110=++-= 或当1)(ωp 与2)(ωp 已知时可用[]⎥⎦⎤⎢⎣⎡-+-+=2)(/)(ln 2~~2121210N N p p m m W ωω ……当W 0确定之后,则可按以下规则分类,2010ωω∈→->∈→->X w X W X w X W T T二、实验内容已知有两类数据1ω和2ω,1ω中数据点的坐标对应一一如下:数据:x 1 =0.2331 1.5207 0.6499 0.7757 1.0524 1.19740.2908 0.2518 0.6682 0.5622 0.9023 0.1333-0.5431 0.9407 -0.2126 0.0507 -0.0810 0.73150.3345 1.0650 -0.0247 0.1043 0.3122 0.66550.5838 1.1653 1.2653 0.8137 -0.3399 0.51520.7226 -0.2015 0.4070 -0.1717 -1.0573 -0.2099y 1=2.3385 2.1946 1.6730 1.6365 1.7844 2.01552.0681 2.1213 2.4797 1.5118 1.9692 1.83401.87042.2948 1.7714 2.3939 1.5648 1.93292.2027 2.4568 1.7523 1.6991 2.4883 1.7259 2.0466 2.0226 2.3757 1.7987 2.0828 2.0798 1.9449 2.3801 2.2373 2.1614 1.9235 2.2604 z1=0.5338 0.8514 1.0831 0.4164 1.1176 0.55360.6071 0.4439 0.4928 0.5901 1.0927 1.07561.0072 0.4272 0.4353 0.9869 0.4841 1.0992 1.0299 0.7127 1.0124 0.4576 0.8544 1.1275 0.7705 0.4129 1.0085 0.7676 0.8418 0.8784 0.9751 0.7840 0.4158 1.0315 0.7533 0.9548 数据点的对应的三维坐标为2x2 =1.4010 1.23012.0814 1.1655 1.3740 1.1829 1.7632 1.9739 2.4152 2.5890 2.8472 1.9539 1.2500 1.2864 1.2614 2.0071 2.1831 1.79091.3322 1.1466 1.7087 1.59202.9353 1.46642.9313 1.8349 1.8340 2.5096 2.7198 2.3148 2.0353 2.6030 1.2327 2.1465 1.5673 2.9414 y2 =1.0298 0.9611 0.9154 1.4901 0.8200 0.9399 1.1405 1.0678 0.8050 1.2889 1.4601 1.4334 0.7091 1.2942 1.3744 0.9387 1.2266 1.18330.8798 0.5592 0.5150 0.9983 0.9120 0.71261.2833 1.1029 1.2680 0.7140 1.2446 1.3392 1.1808 0.5503 1.4708 1.1435 0.7679 1.1288 z2 =0.6210 1.3656 0.5498 0.6708 0.8932 1.43420.9508 0.7324 0.5784 1.4943 1.0915 0.76441.2159 1.3049 1.1408 0.9398 0.6197 0.66031.3928 1.4084 0.6909 0.8400 0.5381 1.37290.7731 0.7319 1.3439 0.8142 0.9586 0.73790.7548 0.7393 0.6739 0.8651 1.3699 1.1458三、实验要求1) 请把数据作为样本,根据Fisher 选择投影方向W 的原则,使原样本向量在该方向上的投影能兼顾类间分布尽可能分开,类内样本投影尽可能密集的要求,求出评价投影方向W 的函数,并求使)(w J F 取极大值的*w 。

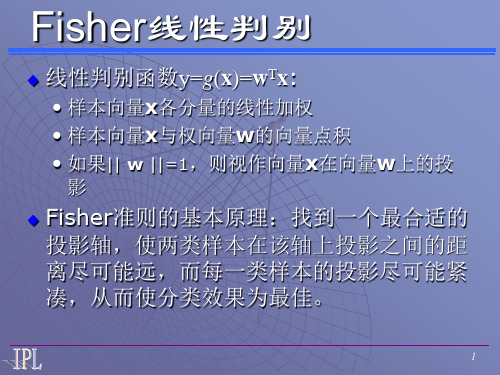

Fisher线性判别

3·4 Fisher线性判别多维 Þ Fisher变换 Þ 利于分类的一维对于线性判别函数( 3-4-1)可以认为是矢量在以为方向的轴上的投影的倍。

这里,视作特征空间中的以为分量的一个维矢量希望所求的使投影后,同类模式密聚,不同类模式相距较远。

求权矢量Þ 求满足上述目标的投影轴的方向和在一维空间中确定判别规则。

从另一方面讲,也是降维,特征提取与选择等问题的需要。

(R.A.Fisher,1936)下面我们用表示待求的。

图 (3-4-1) 二维模式向一维空间投影示意图(1)Fisher准则函数对两类问题,设给定维训练模式,其中有个和个模式分属类和类。

为方便,各类的模式又可分别记为和,于是,各类模式均值矢量为( 3-4-2)各类类内离差阵和总的类内离差阵分别为( 3-4-3)( 3-4-4)我们取类间离差阵为( 3-4-5)作变换,维矢量在以矢量为方向的轴上进行投影( 3-4-6)变换后在一维空间中各类模式的均值为( 3-4-7)类内离差度和总的类内离差度为( 3-4-8)( 3-4-9)类间离差度为( 3-4-10)我们希望经投影后,类内离差度越小越好,类间离差度越大越好,根据这个目标作准则函数( 3-4-11)称之为Fisher准则函数。

我们的目标是,求使最大。

(2)Fisher变换将标量对矢量微分并令其为零矢量,注意到的分子、分母均为标量,利用二次型关于矢量微分的公式可得( 3-4-12)令可得当时,通常是非奇异的,于是有( 3-4-13)上式表明是矩阵相应于本征值的本征矢量。

对于两类问题,的秩为1,因此只有一个非零本征值,它所对应的本征矢量称为Fisher最佳鉴别矢量。

由式( 3-4-13)有( 3-4-14)上式右边后两项因子的乘积为一标量,令其为,于是可得式中为一标量因子。

这个标量因子不改变轴的方向,可以取为1,于是有( 3-4-15)此时的是使Fisher准则函数取最大值时的解,即是维空间到一维空间投影轴的最佳方向,( 3-4-16)称为Fisher变换函数。

Fisher线性判别原理(实例论证解析)

Fisher 线性判别原理原始数据:111212122212p p n n np n px x x x x x X x x x ⨯⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦ 寻找关于X 的线性组合,使得Y Xa =,其中121p p a a a a ⨯⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦为p 维列向量。

使得111212111212222211221p p p p n n p np n n a x a x a x y a x a x a x y Y Xa a x a x a x y ⨯+++⎡⎤⎡⎤⎢⎥⎢⎥+++⎢⎥⎢⎥==⎢⎥⎢⎥⎢⎥⎢⎥+++⎢⎥⎣⎦⎣⎦对于Y 中的每个分量来说,离差平方和为:22211()nniii i y y yny ==-=-∑∑令11111n n n H I n⨯⨯'=-,则有:[][][][]121212121212100101011(111)0011111111111111n n n n n n y y Y HY y y y n y n n n y y y y y n nn y nn n y y y y y y y y y ⎡⎤⎡⎤⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥'=-⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦⎣⎦⎡⎤---⎢⎥⎡⎤⎢⎥⎢⎥⎢⎥---⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦⎢⎥---⎢⎥⎣⎦⎡⎤⎢⎥⎢⎥=---⎢⎥⎢⎣⎦22211()n nii i i y ny y y ==⎥=-=-∑∑而21()()nii y y Y HY Xa HXa a X HXa a Ta ='''''-====∑若n 个原始数据X 来自J 个不同的组,每个组有j n 个数据,12++J n n n n +=。

将X ,Y 重新标记为:111(1)(1)(1)11121(1)(1)(1)21222(1)(1)(1)12()()()11121()()()21222()()()12J J J pp n n n p J J J p J J J p J J J n n n p n p x x x x x x x x x X x x x x x x x x x ⨯⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦1(1)1(1)2(1)()1()2()J n J J J n y y y Y y y y ⎡⎤⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎢⎥⎣⎦,Y Xa = 其中(j)表示其属于第j 组的数据。

fisher判别函数

Fisher判别函数,也称为线性判别函数(Linear Discriminant Function),是一种经典的模式识别方法。

它通过将样本投影到一维或低维空间,将不同类别的样本尽可能地区分开来。

一、算法原理:Fisher判别函数基于以下两个假设:1.假设每个类别的样本都服从高斯分布;2.假设不同类别的样本具有相同的协方差矩阵。

Fisher判别函数的目标是找到一个投影方向,使得同一类别的样本在该方向上的投影尽可能紧密,而不同类别的样本在该方向上的投影尽可能分开。

算法步骤如下:(1)计算类内散度矩阵(Within-class Scatter Matrix)Sw,表示每个类别内样本之间的差异。

Sw = Σi=1 to N (Xi - Mi)(Xi - Mi)ᵀ,其中Xi 表示属于类别i 的样本集合,Mi 表示类别i 的样本均值。

(2)计算类间散度矩阵(Between-class Scatter Matrix)Sb,表示不同类别之间样本之间的差异。

Sb = Σi=1 to C Ni(Mi - M)(Mi - M)ᵀ,其中 C 表示类别总数,Ni 表示类别i 中的样本数量,M 表示所有样本的均值。

(3)计算总散度矩阵(Total Scatter Matrix)St,表示所有样本之间的差异。

St =Σi=1 to N (Xi - M)(Xi - M)ᵀ(4)计算投影方向向量w,使得投影后的样本能够最大程度地分开不同类别。

w= arg max(w) (wᵀSb w) / (wᵀSw w),其中w 表示投影方向向量。

(5)根据选择的投影方向向量w,对样本进行投影。

y = wᵀx,其中y 表示投影后的样本,x 表示原始样本。

(6)通过设置一个阈值或使用其他分类算法(如感知机、支持向量机等),将投影后的样本进行分类。

二、优点和局限性:Fisher判别函数具有以下优点:•考虑了类别内和类别间的差异,能够在低维空间中有效地区分不同类别的样本。

Fisher线性判别分析实验(模式识别与人工智能原理实验1)

F i s h e r线性判别分析实验(模式识别与人工智能原理实验1)-CAL-FENGHAI-(2020YEAR-YICAI)_JINGBIAN实验1 Fisher 线性判别分析实验一、摘要Fisher 线性判别分析的基本思想:通过寻找一个投影方向(线性变换,线性组合),将高维问题降低到一维问题来解决,并且要求变换后的一维数据具有如下性质:同类样本尽可能聚集在一起,不同类的样本尽可能地远。

Fisher 线性判别分析,就是通过给定的训练数据,确定投影方向W 和阈值y0,即确定线性判别函数,然后根据这个线性判别函数,对测试数据进行测试,得到测试数据的类别。

二、算法的基本原理及流程图 1 基本原理(1)W 的确定各类样本均值向量mi样本类内离散度矩阵i S 和总类内离散度矩阵w S12w S S S =+样本类间离散度矩阵b S在投影后的一维空间中,各类样本均值T i i m '= W m 。

样本类内离散度和总类内离散度 T T i i w w S ' = W S W S ' = W S W 。

样本类间离散度T b b S ' = W S W 。

Fisher 准则函数满足两个性质:·投影后,各类样本内部尽可能密集,即总类内离散度越小越好。

·投影后,各类样本尽可能离得远,即样本类间离散度越大越好。

根据这个性质确定准则函数,根据使准则函数取得最大值,可求出W :-1w 12W = S (m - m ) 。

(2)阈值的确定实验中采取的方法:012y = (m ' + m ') / 2。

(3)Fisher 线性判别的决策规则T x S (x m)(x m ), 1,2ii ii X i ∈=--=∑T1212S (m m )(m m )b =--对于某一个未知类别的样本向量x,如果y=W T·x>y0,则x∈w1;否则x∈w2。

模式识别fisher判别

论文(设计)《模式识别》题目Fisher线性判别的基本原理及应用Fisher判别准则一、基本原理思想Fisher线性判别分析的基本思想:通过寻找一个投影方向(线性变换,线性组合),将高维问题降低到一维问题来解决,并且要求变换后的一维数据具有如下性质:同类样本尽可能聚集在一起,不同类的样本尽可能地远。

Fisher线性判别分析,就是通过给定的训练数据,确定投影方向W和阈值y0,即确定线性判别函数,然后根据这个线性判别函数,对测试数据进行测试,得到测试数据的类别。

二、算法的实现及流程图1 算法实现 (1)W 的确定x 1m x, 1,2ii X ii N ∈==∑各类样本均值向量mi样本类内离散度矩阵和总类内离散度矩阵Tx S (x m )(x m ), 1,2ii i i X i ∈=--=∑样本类间离散度矩阵T1212S (m m )(m m )b =--在投影后的一维空间中,各类样本均值。

样本类内离散度和总类内离散度。

样本类间离散度。

Fisher 准则函数满足两个性质:·投影后,各类样本内部尽可能密集,即总类内离散度越小越好。

·投影后,各类样本尽可能离得远,即样本类间离散度越大越好。

根据这个性质确定准则函数,根据使准则函数取得最大值,可求出W :。

(2)阈值的确定采取的方法:【1】【2】【3】(3)Fisher 线性判别的决策规则对于某一个未知类别的样本向量x ,如果y=W T·x>y0,则x ∈w1;否则x ∈w2。

2 流程图归一化处理载入训练数据三、实验仿真1.实验要求试验中采用如下的数据样本集:ω1类: (22,5),(46,33),(25,30),(25,8),(31, 3),(37,9),(46,7),(49,5),(51,6),(53,3)(19,15),(23,18),(43,1),(22,15),(20,19),(37,36),(22,22),(21,32),(26,36),(23,39)(29,35),(33,32),(25,38),(41,35),(33,2),(48,37)ω2类: (40,25),(63,33),(43,27),(52,25),(55,27),(59,22) ,(65,59),(63,27)(65,30),(66,38),(67,43),(52,52),(61,49) (46,23),(60,50),(68,55) (40,53),(60,55),(55,55) (48,56),(45,57),(38,57) ,(68,24)在实验中采用Fisher线性判别方法设计出每段线性判别函数。

fisher线性判别

fisher线性判别

fisher 判决⽅式是监督学习,在新样本加⼊之前,已经有了原样本。

原样本是训练集,训练的⽬的是要分类,也就是要找到分类线。

⼀⼑砍成两半!

当样本集确定的时候,分类的关键就在于如何砍下这⼀⼑!

若以⿊⾊的来划分,很明显不合理,以灰⾊的来划分,才是看上去合理的

1.先确定砍的⽅向

关键在于如何找到投影的向量u,与u的长度⽆关。

只看⽅向

找到样本点的中⼼均值m1,m2,以及在向量u上的投影的m1~,m2~。

因为u的⽅向与样本点都有关,所以需要考虑⼀个含有所有样本点的表达式

不妨算出离差阵

算出类内离差矩阵,两个都要求出来,并求和

并且投影的离差阵

根据聚类的理想情况,类内距离⼩,类间距离⼤,所以就⽤类间去处理类内,我们现在的变量是向量u,我们就对u求导,算出max存在的时后u的条件。

为了⽅便化简,引⼊⼀个参数不要以为下⾯除以是向量,(1*2)*(2*2)(2*1)=1 维度变成1,这是⼀个常数。

当求导公式

分⼦为0的时候,推出

所以

⽽且是(1*2)*(2*1)等于1,也是⼀个常数

到此为⽌,u的⽅向已经确定了

2.具体切哪⼀个点。

a,切

切投影均值的终点

2.

切贝叶斯概率的⽐例点

⽅向和具体点均已找到,分析完毕。

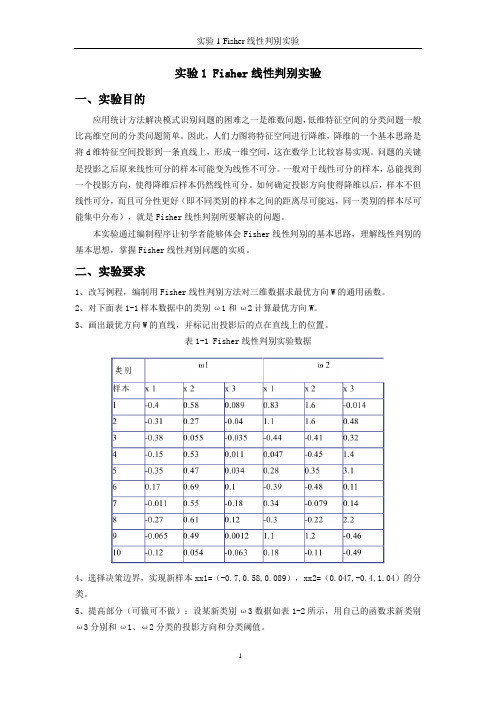

实验1 Fisher线性判别实验

实验1 Fisher线性判别实验一、实验目的应用统计方法解决模式识别问题的困难之一是维数问题,低维特征空间的分类问题一般比高维空间的分类问题简单。

因此,人们力图将特征空间进行降维,降维的一个基本思路是将d维特征空间投影到一条直线上,形成一维空间,这在数学上比较容易实现。

问题的关键是投影之后原来线性可分的样本可能变为线性不可分。

一般对于线性可分的样本,总能找到一个投影方向,使得降维后样本仍然线性可分。

如何确定投影方向使得降维以后,样本不但线性可分,而且可分性更好(即不同类别的样本之间的距离尽可能远,同一类别的样本尽可能集中分布),就是Fisher线性判别所要解决的问题。

本实验通过编制程序让初学者能够体会Fisher线性判别的基本思路,理解线性判别的基本思想,掌握Fisher线性判别问题的实质。

二、实验要求1、改写例程,编制用Fisher线性判别方法对三维数据求最优方向W的通用函数。

2、对下面表1-1样本数据中的类别ω1和ω2计算最优方向W。

3、画出最优方向W的直线,并标记出投影后的点在直线上的位置。

表1-1 Fisher线性判别实验数据4、选择决策边界,实现新样本xx1=(-0.7,0.58,0.089),xx2=(0.047,-0.4,1.04)的分类。

5、提高部分(可做可不做):设某新类别ω3数据如表1-2所示,用自己的函数求新类别ω3分别和ω1、ω2分类的投影方向和分类阈值。

表1-2 新类别样本数据三、部分参考例程及其说明求取数据分类的Fisher投影方向的程序如下:其中w为投影方向。

clear %Removes all variables from the workspace.clc %Clears the command window and homes the cursor.% w1类训练样本,10组,每组为行向量。

w1=[-0.4,0.58,0.089;-0.31,0.27,-0.04;-0.38,0.055,-0.035;-0.15,0.53,0. 011;-0.35,0.47,0.034;...0.17,0.69,0.1;-0.011,0.55,-0.18;-0.27,0.61,0.12;-0.065,0.49,0.0012;-0 .12,0.054,-0.063];% w2类训练样本,10组,每组为行向量。

fisher判别法

1 实验1 Fisher 线性判别实验一、实验目的应用统计方法解决模式识别问题的困难之一是维数问题,在低维空间行得通的方法,在高维空间往往行不通。

因此,降低维数就成为解决实际问题的关键。

Fisher 的方法,实际上涉及维数压缩。

如果要把模式样本在高维的特征向量空间里投影到一条直线上,实际上就是把特征空间压缩到一维,这在数学上容易办到。

问题的关键是投影之后原来线性可分的样本可能变得混杂在一起而无法区分。

在一般情况下,总可以找到某个最好的方向,使样本投影到这个方向的直线上是最容易分得开的。

如何找到最好的直线方向,如何实现向最好方向投影的变换,是Fisher 法要解决的基本问题。

这个投影变换就是我们寻求的解向量*w本实验通过编制程序体会Fisher 线性判别的基本思路,理解线性判别的基本思想,掌握Fisher 线性判别问题的实质。

二、实验原理1.线性投影与Fisher 准则函数各类在d 维特征空间里的样本均值向量:∑∈=i k X x k i i x n M 1,2,1=i (4.5-2)通过变换w 映射到一维特征空间后,各类的平均值为:∑∈=i k Y y k i i y n m 1,2,1=i (4.5-3)映射后,各类样本“类内离散度”定义为:22()k i i k i y Y S y m ∈=-∑,2,1=i (4.5-4)显然,我们希望在映射之后,两类的平均值之间的距离越大越好,而各类的样本类内离散度越小越好。

因此,定义Fisher 准则函数:2122212||()F m m J w s s -=+ (4.5-5) 使F J 最大的解*w 就是最佳解向量,也就是Fisher 的线性判别式。

2.求解*w从)(w J F 的表达式可知,它并非w 的显函数,必须进一步变换。

2 已知:∑∈=i k Y y k ii y n m 1,2,1=i , 依次代入(4.5-1)和(4.5-2),有: i T X x k i T k X x T i i M w x n w x w n m i k i k ===∑∑∈∈)1(1,2,1=i (4.5-6) 所以:221221221||)(||||||||M M w M w M w m m T T T -=-=- w S w w M M M M w b T T T =--=))((2121 (4.5-7) 其中:T b M M M M S ))((2121--= (4.5-8) b S 是原d 维特征空间里的样本类内离散度矩阵,表示两类均值向量之间的离散度大小,因此,b S 越大越容易区分。

线性判别分析(LDA)准则:FIsher准则、感知机准则、最小二乘(最小均方误差)准则

线性判别分析(LDA)准则:FIsher准则、感知机准则、最⼩⼆乘(最⼩均⽅误差)准则准则采⽤⼀种分类形式后,就要采⽤准则来衡量分类的效果,最好的结果⼀般出现在准则函数的极值点上,因此将分类器的设计问题转化为求准则函数极值问题,即求准则函数的参数,如线性分类器中的权值向量。

分类器设计准则:FIsher准则、感知机准则、最⼩⼆乘(最⼩均⽅误差)准则Fisher准则Fisher线性判别分析LDA(Linearity Distinction Analysis)基本思想:对于两个类别线性分类的问题,选择合适的阈值,使得Fisher准则函数达到极值的向量作为最佳投影⽅向,与投影⽅向垂直的超平⾯就是两类的分类⾯,使得样本在该⽅向上投影后,达到最⼤的类间离散度和最⼩的类内离散度。

Fisher线性判别并不对样本的分布进⾏任何假设,但在很多情况下,当样本维数⽐较⾼且样本数也⽐较多时,投影到⼀维空间后样本接近正态分布,这时可以在⼀维空间中⽤样本拟合正态分布,⽤得到的参数来确定分类阈值。

类间离差平⽅和最⼤,类内离差平⽅和最⼩的投影⽅向。

准则函数:组间离差平⽅和/组内离差平⽅和;准则:超过阈值?感知机准则基本思想:对于线性判别函数,当模式的维数已知时,判别函数的形式实际上就已经确定下来,线性判别的过程即是确定权向量 。

感知机是⼀种神经⽹络模型,其特点是随意确定判别函数初始值,在对样本分类训练过程中,针对分类错误的样本不断进⾏权值修正,逐步迭代直⾄最终分类符合预定标准,从⽽确定权向量值。

可以证明感知机是⼀种收敛算法,只要模式类别是线性可分的,就可以在有限的迭代步数⾥求出权向量的解。

优点:简单、便于实现。

缺点:结果不唯⼀,在线性不可分情况下不收敛。

给定初始权值向量,通过样本的训练分类过程逐渐修正权值直到最终确定。

准则函数:错分样本数,准则:错分样本数为0上述两个准则的区别和联系Fisher线性判别是把线性分类器的设计分为两步,⼀是确定最优⽅向,⼆是在这个⽅向上确定分类阈值;感知机则是通过不断迭代直接得到完整的线性判别函数。

(模式识别)Fisher线性判别

Fisher 判别

各类样本均值

1

mi Ni yi y, i 1, 2

样本类内离散度和总类内离散度

Si ( y mi )2, i 1,2 yi

样本类间离散度

Sw S1 S2 Sb (m1 m2 )2

以上定义描述d维空间样本点到一向量投影的分 散情况,因此也就是对某向量w的投影在w上的 分布。样本离散度的定义与随机变量方差相类似

Sw1(m1 m2 )R

w*

R

Sw1(m1

m2 )

Sw1(m1 m2 )

10

8

判别函数的确定

Fisher 判别

前面讨论了使Fisher准则函数极大的d维向 量w*的计算方法,判别函数中的另一项w0 (阈值)可采用以下几种方法确定:

w0

m1

2

m2

w0

N1m1 N2m2 N1 N2

m

w0

m1

m2 2

lnP(1) / P( 1 y wT x w0 0 x 2

Fisher线性判别

线性判别函数y=g(x)=wTx:

• 样本向量x各分量的线性加权 • 样本向量x与权向量w的向量点积 • 如果|| w ||=1,则视作向量x在向量w上的投

影

Fisher准则的基本原理:找到一个最合适的 投影轴,使两类样本在该轴上投影之间的距 离尽可能远,而每一类样本的投影尽可能紧 凑,从而使分类效果为最佳。

Si (x mi )(x mi )T , i 1,2 xi

Sw S1 S2

样本类间离散度矩阵Sb:Sb (m1 m2 )(m1 m2 )T

离散矩阵在形式上与协方差矩阵很相似,但协方 差矩阵是一种期望值,而离散矩阵只是表示有限 个样本在空间分布的离散程度

Fisher线性判别分析

Fisher线性判别分析

Fisher线性判别分析

1、概述

在使⽤统计⽅法处理模式识别问题时,往往是在低维空间展开研究,然⽽实际中数据往往是⾼维的,基于统计的⽅法往往很难求解,因此降维成了解决问题的突破⼝。

假设数据存在于d维空间中,在数学上,通过投影使数据映射到⼀条直线上,即维度从d维变为1维,这是容易实现的,但是即使数据在d维空间按集群形式紧凑分布,在某些1维空间上也会难以区分,为了使得数据在1维空间也变得容易区分,需要找到适当的直线⽅向,使数据映射在该直线上,各类样本集群交互较少。

如何找到这条直线,或者说如何找到该直线⽅向,这是Fisher线性判别需要解决的问题。

2、从d维空间变换到1维空间

3、介绍⼏个基本的参量

A. 在d维原始空间

B. 在1维映射空间

4、Fisher准则函数

5、学习算法推导

6、决策分类。

线性判别函数-Fisher

任意x,在H上投影 xp X与xp距离r

多类的情况:

将c类问题转化为c个两类问题,有c个判别函数。

把ωi作为一类,其余作为一类,构建c个超平面

更复杂一些,用C(C-1)/2个线性判别函数进行判别。

判别函数和决策面:

超平面Hij的法向量 决策规则:对一切i ≠ j有gi(x)>gj(x),则把x归为ωi类。

线性判别函数的齐次简化

令x0=1则:

增广特征向量

增广权向量

一个三维增广特征空间y和增广权向量a(在原点)

这是广义线性判别函数的一个特例。y与x相比, 虽然增加了一维,但保持了样本间的欧式距离不变。

变换得到的y向量仍然都在d维的子空间中,即原X 空间中,方程aTy=0在Y空间确定了一个通过原点 的超平面H’,它对d维子空间的划分与原决策面 wTx+w0=0对原X空间的划分完全相同。

映射y把一条直线映射为三维空间中的一条抛物线01122123321xcyayyaacxyac????????????????????????????????????????????22gxccxcx令

线性判别函数

已知条件

贝叶斯决策

实际问题

条件未知

利用样本集直接设计分类器,即给定某个判别函 数类,然后利用样本集确定出判别函数中的未知 参数。

N个d维样本x , x ,...x ,

1

2

N

其中: X : N 个属于 的样本集

1

1

1

X : N 个属于 的样本集

2

2

2

对xn的分量作线性组合:

y wT x , n 1,2,..., N

n

线性判别分析(LinearDiscriminantAnalysis,LDA)

线性判别分析(LinearDiscriminantAnalysis,LDA)⼀、线性判别器的问题分析线性判别分析(Linear Discriminant Analysis, LDA)是⼀种经典的线性学习⽅法,在⼆分类问题上亦称为 "Fisher" 判别分析。

与感知机不同,线性判别分析的原理是降维,即:给定⼀组训练样本,设法将样本投影到某⼀条直线上,使相同分类的点尽可能地接近⽽不同分类的点尽可能地远,因此可以利⽤样本点在该投影直线上的投影位置来确定样本类型。

⼆、线性判别器的模型还是假定在p维空间有m组训练样本对,构成训练集T=(x1,y1),(x2,y2),...,(x n,y n),其中x i∈R1×p,y i∈{−1,+1},以⼆维空间为例,在线性可分的情况下,所有样本在空间可以描述为:我们的⽬的就是找到⼀个超平⾯Φ:b+w1x1+w2x2+..+w n x n=0,使得所有的样本点满⾜ “类内尽可能接近,类外尽可能遥远"。

那么我们⽤类内的投影⽅差来衡量类内的接近程度,⽤类间的投影均值来表⽰类间的距离。

这⾥,我们另w代表投影⽅向,如下图所⽰,在这⾥,x,w均为p×1 的列向量,那么根据投影定理,x在w上的投影p既有⽅向⼜有距离,那么:p与w同⽅向,表⽰为:w||w||;p的长度为:||x||cosθ=||x||x⋅w||w||||x||=x⋅w||w||由于w的长度不影响投影结果,因此我们为了简化计算,设置 ||w||=1,只保留待求w的⽅向:||p||=x⋅w=w T x 2.1 类间投影均值我们假设⽤u0,u1分别表⽰第1,2类的均值,那么:u0=1mm∑i=1x i,u1=1nn∑i=1x i所以,第⼀,⼆类均值在w⽅向上的投影长度分别表⽰为:w T u0,w T u1 2.2 类内投影⽅差根据⽅差的计算公式,第⼀类的类内投影⽅差可以表⽰为:z0=1nn∑i=1(w T x i−w T u0)2=1nn∑i=1(w T x i−w T u0)(w T x i−w T u0)T即:z0=1nn∑i=1w T(x i−u0)(x i−u0)T w=w T[1nn∑i=1(x i−u0)(x i−u0)T]w如下图所⽰:当x i,u0都是⼀维时,式⼦1n∑ni=1(x i−u0)(x i−u0)T就表⽰所有输⼊x i的⽅差;当x i,u0都是⼆维时,式⼦1n∑ni=1(x i−u0)(x i−u0)T就表⽰:1nn∑i=1x11−u01x12−u02x11−u01x12−u02=1nn∑i=1(x11−u01)2(x11−u01)(x12−u02)(x12−u02)(x11−u01)(x12−u02)2其中:u01表⽰第⼀类集合中在第⼀个维度上的均值,u01表⽰第⼀类集合中在第⼆个维度上的均值,x11表⽰第⼀类集合中第⼀个维度的坐标值,x12表⽰第⼀类集合中第⼆个维度的坐标值[][][]综上:当x i,u0都是p维时,式⼦1n∑ni=1(x i−u0)(x i−u0)T表⽰p个维度之间的协⽅差矩阵,我们⽤符号M0表⽰。

线性判别函数-Fisher-PPT课件

gx a y r' a a

T

设计线性分类器的主要步骤

1.给定一组有类别标志的样本集S

2.确定准则函数J(S,w,w0) 3.用优化技术得到极值解w*,w0* 这样就得到线性判别函数g(x)=w*Tx+w0*,对未知 样本xk,计算g(xk),然后根据决策规则就可判断xk 所属的类别。

2 T 1 2 b F 2 2 T 1 2 w

Lagrange乘子法求极值: 令:

w S w c 0

T w

T

定义函数:

L w , w S w w S w c

线性判别函数

已知条件 实际问题

贝叶斯决策 条件未知

利用样本集直接设计分类器,即给定某个判别函 数类,然后利用样本集确定出判别函数中的未知 参数。

一类简单的判别函数:线性判别函数

线性判别函数(discriminant

function)是指 由x的各个分量的线性组合而成的函数 ,一 般表达式为:

1 2

~ ~ 两类均值之差 m m 越大越好

2.各类样本内部尽量密集

~ ~ 类内离散度 S S 越小越好

2 2 1 2

准则函数

~ m ~ m ~ ~ J w S S

1 2 F 2 2 1 2

T

2

求准则函数的极大值

化简分子:

1 1 1 ~ m y w x w x w m N N N

2.在一维Y空间 各类样本均值:

1 ~ m y ,i 1 ,2 N

i Y i i

样本类内离散度:

~ ~ S y m , i 1 , 2

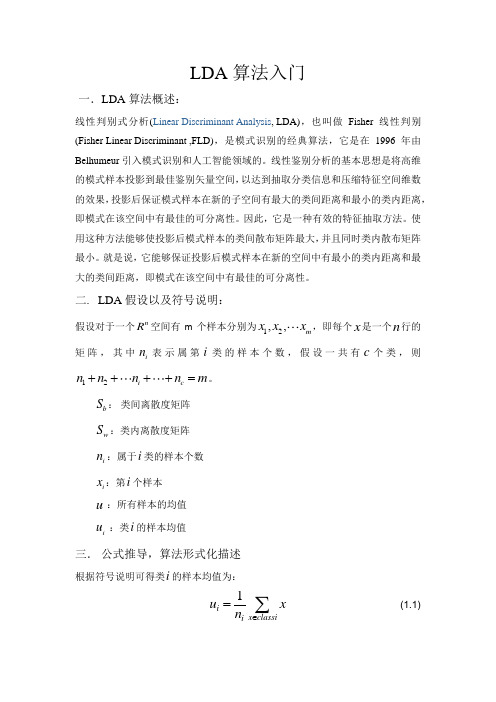

线性判别分析LDA

LDA 算法入门一.LDA 算法概述:线性判别式分析(Linear Discriminant Analysis , LDA),也叫做Fisher 线性判别(Fisher Linear Discriminant ,FLD),是模式识别的经典算法,它是在1996年由Belhumeur 引入模式识别和人工智能领域的。

线性鉴别分析的基本思想是将高维的模式样本投影到最佳鉴别矢量空间,以达到抽取分类信息和压缩特征空间维数的效果,投影后保证模式样本在新的子空间有最大的类间距离和最小的类内距离,即模式在该空间中有最佳的可分离性。

因此,它是一种有效的特征抽取方法。

使用这种方法能够使投影后模式样本的类间散布矩阵最大,并且同时类内散布矩阵最小。

就是说,它能够保证投影后模式样本在新的空间中有最小的类内距离和最大的类间距离,即模式在该空间中有最佳的可分离性。

二. LDA 假设以及符号说明:假设对于一个nR 空间有m 个样本分别为12,,m x x x ,即每个x 是一个n 行的矩阵,其中in 表示属第i类的样本个数,假设一共有c 个类,则12i c n n n n m ++++=。

b S : 类间离散度矩阵 w S :类内离散度矩阵i n :属于i 类的样本个数 i x :第i 个样本 u :所有样本的均值i u :类i 的样本均值三. 公式推导,算法形式化描述根据符号说明可得类i 的样本均值为:1i x classiiu x n ∈=∑ (1.1)同理我们也可以得到总体样本均值:11mi i u x m ==∑(1.2)根据类间离散度矩阵和类内离散度矩阵定义,可以得到如下式子:()()1cTb i i i i S n u u u u ==--∑(1.3)()()1k cTw i k i k i x classiS u x u x =∈=--∑∑ (1.4)当然还有另一种类间类内的离散度矩阵表达方式:()()()1cTb i i i S P i u u u u ==--∑ (1.5)()()()(){}11(i)(i)E |k cTw i k i k i x classii cTi i i P S u x u x n P u x u x x classi=∈==--=--∈∑∑∑ (1.6)其中()P i 是指i 类样本的先验概率,即样本中属于i 类的概率()in P i m=,把()P i 代入第二组式子中,我们可以发现第一组式子只是比第二组式子都少乘了1m ,我们将在稍后进行讨论,其实对于乘不乘该1m,对于算法本身并没有影响,现在我们分析一下算法的思想, 我们可以知道矩阵()()Ti i u u u u --的实际意义是一个协方差矩阵,这个矩阵所刻画的是该类与样本总体之间的关系,其中该矩阵对角线上的函数所代表的是该类相对样本总体的方差(即分散度),而非对角线上的元素所代表是该类样本总体均值的协方差(即该类和总体样本的相关联度或称冗余度),所以根据公式(1.3)可知(1.3)式即把所有样本中各个样本根据自己所属的类计算出样本与总体的协方差矩阵的总和,这从宏观上描述了所有类和总体之间的离散冗余程度。