大数据平台技术—实验1(2019-2020)222

大数据实训结果与总结

大数据实训结果与总结1.引言1.1 概述在这篇文章中,我们将介绍大数据实训的结果和总结。

大数据实训是一个具有挑战性和实践性质的项目,旨在通过实际操作和案例研究,提升学生在大数据领域的实际能力和技术水平。

本文将包括实训的背景和内容,以及我们所取得的成果和总结。

通过这篇文章,我们将展示大数据实训对我们的学习和职业发展带来的重要意义,并展望未来在大数据领域的发展趋势和可能的挑战。

通过本文的阅读,读者将能够了解大数据实训的整体情况以及我们团队在实训过程中所遇到的问题和解决方案。

我们将分享我们所使用的工具和技术,并提供我们在实际项目中所遇到的挑战和应对策略的案例分析。

通过本文,读者还将获得我们在大数据实训中获得的具体成果和经验教训。

我们将针对实际项目的需求和挑战,提出自己的解决方案,并对实训过程中的不足之处进行总结和反思。

最后,我们将对未来的发展趋势进行展望,提出我们自己的建议和思考。

总之,本文将通过对大数据实训的概述,为读者介绍实训的背景和内容,并分享我们在实际操作中所取得的成果和总结。

我们希望通过这篇文章,能够对读者在大数据领域的学习和职业发展提供一定的启示和帮助。

1.2 文章结构本文主要介绍了大数据实训的结果与总结。

文章按照以下结构进行组织:引言部分主要概述了本文的背景和目的。

首先,提出了大数据实训的重要性和当前应用的广泛性。

接着,简要介绍了本文的组织结构,给读者对整篇文章的内容有一个整体的把握。

最后,明确了本文的目的,即总结大数据实训的结果并展望未来的发展方向。

正文部分主要分为两个部分:实训背景和实训内容。

实训背景部分将介绍大数据实训的起因和背景。

首先,概述了大数据时代的到来和对相关技能需求的增加。

然后,介绍了本实训的背景和目标,包括所使用的数据集和技术工具。

接着,详细说明了实训的流程和步骤,包括数据清洗、数据挖掘和数据分析等环节。

结论部分包括实训成果和总结与展望两个部分。

实训成果部分将详细介绍通过实训所达到的具体成果,包括数据处理的准确性、模型预测的准确率等指标。

《大数据技术》MapReduce和Spark实验报告一

《大数据技术》MapReduce和Spark实验报告一、实验目的:1.通过实验掌握基本的MapReduce编程方法;2.掌握用MapReduce解决一些常见数据处理问题的方法;3.掌握使用Spark访问本地文件和HDFS文件的方法。

4.掌握Spark应用程序的编写、编译和运行方法。

二、实验平台:1.操作系统:Ubuntu18.04(或Ubuntu16.04)。

2.Hadoop版本:3.1.3。

3. Spark版本:2.4.0。

4.JDK版本:1.8;5.Java IDE:Eclipse。

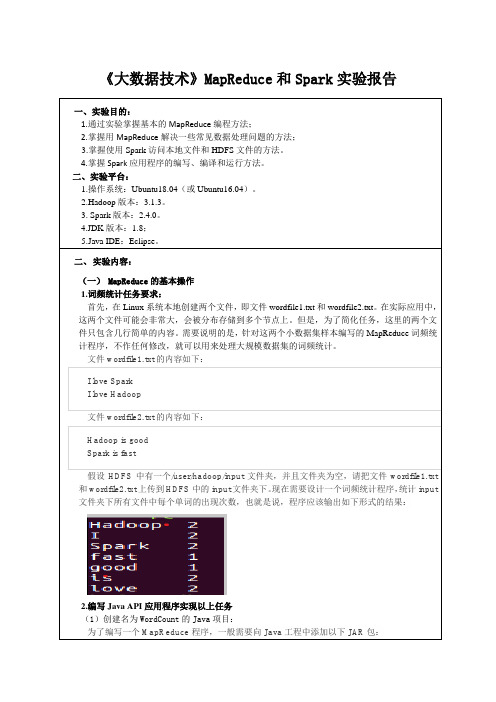

二、实验内容:(一) MapReduce的基本操作1.词频统计任务要求:首先,在Linux系统本地创建两个文件,即文件wordfile1.txt和wordfile2.txt。

在实际应用中,这两个文件可能会非常大,会被分布存储到多个节点上。

但是,为了简化任务,这里的两个文件只包含几行简单的内容。

需要说明的是,针对这两个小数据集样本编写的MapReduce词频统计程序,不作任何修改,就可以用来处理大规模数据集的词频统计。

文件wordfile1.txt的内容如下:I love SparkI love Hadoop文件wordfile2.txt的内容如下:Hadoop is goodSpark is fast假设HDFS中有一个/user/hadoop/input文件夹,并且文件夹为空,请把文件wordfile1.txt 和wordfile2.txt上传到HDFS中的input文件夹下。

现在需要设计一个词频统计程序,统计input 文件夹下所有文件中每个单词的出现次数,也就是说,程序应该输出如下形式的结果:2.编写Java API应用程序实现以上任务(1)创建名为WordCount的Java项目:为了编写一个MapReduce程序,一般需要向Java工程中添加以下JAR包:20170103 x20170104 y20170104 z20170105 y20170105 z20170106 z3. 编写独立应用程序实现求平均值问题每个输入文件表示班级学生某个学科的成绩,每行内容由两个字段组成,第一个是学生名字,第二个是学生的成绩;编写Spark独立应用程序求出所有学生的平均成绩,并输出到一个新文件中。

大数据基础实验报告

大数据基础实验报告1.引言1.1 概述概述大数据是指以传统数据处理软件无法处理的规模和复杂度而闻名的数据集合。

随着信息技术和互联网的快速发展,大数据技术在各个领域得到广泛应用,并对社会和经济产生了革命性的影响。

大数据的特征有三个方面:大量性、高速性和多样性。

首先,大数据的数据规模巨大,通常以TB、PB、EB等单位来衡量;其次,大数据的处理速度要求较高,需要在有限的时间内对大量数据进行处理和分析;最后,大数据的数据类型多样,涵盖了结构化数据和非结构化数据等多种形式。

大数据的产生源自各个方面,包括个人社交网络、移动设备、传感器技术、云计算和物联网等。

这些数据的产生以指数级增长,给传统的数据处理方式带来了巨大的挑战。

为了能够高效地处理大数据,人们开发了一系列的大数据技术和工具。

其中,分布式存储和计算技术是大数据处理的核心。

通过将数据分散存储在多台服务器上,可以实现对数据的高效访问和并行计算,大大提高了数据处理的速度和效率。

大数据的应用领域广泛,包括金融、医疗、电商、交通、能源等。

通过对大数据的分析和挖掘,可以发现隐藏在数据中的规律和趋势,为决策者提供有力的支持。

例如,在金融领域,通过对交易数据的分析,可以及时发现异常交易和风险,保护投资者的利益;在医疗领域,通过对患者的病历数据和基因组数据的分析,可以实现个性化医疗,提高治疗效果。

尽管大数据技术取得了显著的成果,但同时也面临一些挑战和问题。

例如,数据的隐私保护、数据的可信度和数据的有效利用等。

因此,在大数据的发展过程中,我们需要不断完善和发展相关的技术和政策,以更好地应对这些挑战。

本实验报告将通过对大数据的基础概念和数据收集与处理的探索,进一步加深对大数据技术的理解和认识。

同时,通过对实验结果的总结和对大数据基础的思考,探讨大数据对社会和经济的影响以及未来的发展趋势。

1.2 文章结构文章结构部分的内容应该包括以下内容:文章结构部分主要介绍了整篇报告的组织结构,以及各个部分的主要内容。

hadoop大数据技术实验指导书

Hadoop大数据技术实验指导书第一章实验概述1.1 实验目的本实验旨在全面了解Hadoop大数据技术的相关概念、架构和使用方法,通过实际操作掌握Hadoop大数据技术的基本应用和管理技能。

1.2 实验内容本实验内容包括Hadoop大数据技术的基本概念、HDFS分布式文件系统的搭建和管理、MapReduce分布式计算框架的使用、Hadoop 生态系统的其他相关工具等。

1.3 实验环境本实验采用Ubuntu 18.04操作系统,Hadoop版本为3.1.3,Java 版本为1.8。

1.4 实验预备知识对Linux操作系统的基本操作有一定了解,对Java编程语言有一定的基础认识,了解分布式系统和大数据概念。

第二章 Hadoop基础概念2.1 Hadoop概述Hadoop是一个开源的分布式计算框架,用于存储和处理大规模数据。

Hadoop项目由Apache软件基金会开发,主要包括Hadoop分布式文件系统(HDFS)和MapReduce分布式计算框架。

2.2 Hadoop架构Hadoop架构包括HDFS、MapReduce和YARN(资源调度和管理),HDFS负责数据的存储和管理,MapReduce负责数据的计算和处理,YARN负责集裙资源的调度和管理。

2.3 Hadoop生态系统除了HDFS和MapReduce,Hadoop生态系统还包括其他相关工具,如HBase(分布式数据库)、Hive(数据仓库)、Pig(数据分析)、Spark(内存计算框架)等。

第三章 HDFS分布式文件系统实验3.1 HDFS搭建1) 准备Hadoop安装包,解压到指定目录2) 配置hadoop-env.sh文件,设置JAVA_HOME环境变量3) 配置core-site.xml和hdfs-site.xml文件,设置Hadoop集裙的基本信息和存储路径3.2 HDFS管理1) 使用命令行工具上传、下载、删除文件2) 查看HDFS存储空间情况3) 监控HDFS集裙状态第四章 MapReduce分布式计算实验4.1 MapReduce程序编写1) 编写Map阶段的程序2) 编写Reduce阶段的程序3) 编译打包MapReduce程序4.2 MapReduce作业提交与监控1) 将MapReduce程序提交到Hadoop集裙2) 查看作业运行状态和日志3) 监控作业的运行情况第五章 Hadoop生态系统实验5.1 HBase实验1) 安装HBase并配置2) 创建HBase表并进行CRUD操作3) 监控HBase集裙状态5.2 Hive实验1) 安装Hive并配置2) 创建Hive表并进行数据查询3) 执行HiveQL语句进行数据分析5.3 Spark实验1) 安装Spark并配置2) 编写Spark应用程序3) 提交Spark应用程序到集裙运行结语通过本实验指导书的学习,相信读者对Hadoop大数据技术有了更深入的了解,掌握了HDFS的搭建与管理、MapReduce的编程与作业监控、Hadoop生态系统的应用等相关技能。

大数据分析实验报告(3篇)

第1篇一、实验背景随着互联网技术的飞速发展,数据已经成为现代社会的重要资源。

大数据分析作为一种新兴的技术手段,通过对海量数据的挖掘和分析,为企业、政府和研究机构提供了决策支持。

本实验旨在通过实际操作,掌握大数据分析的基本流程和方法,提高对大数据技术的理解和应用能力。

二、实验目的1. 熟悉大数据分析的基本流程。

2. 掌握常用的数据预处理方法。

3. 熟悉大数据分析工具的使用。

4. 能够对实际数据进行有效的分析和解读。

三、实验环境1. 操作系统:Windows 102. 数据库:MySQL 5.73. 编程语言:Python 3.74. 大数据分析工具:Pandas、NumPy、Matplotlib、Scikit-learn5. 云计算平台:阿里云四、实验内容(一)数据采集本实验选取某电商平台的用户购买数据作为分析对象,数据包含用户ID、购买时间、商品ID、商品类别、购买金额等字段。

(二)数据预处理1. 数据清洗:去除重复数据、处理缺失值、修正错误数据。

2. 数据转换:将时间戳转换为日期格式,对金额进行归一化处理。

3. 特征工程:提取用户购买行为特征,如购买频率、购买金额等。

(三)数据分析1. 用户画像:分析用户购买偏好、购买频率等特征。

2. 商品分析:分析商品销量、商品类别分布等特征。

3. 购买行为分析:分析用户购买时间分布、购买金额分布等特征。

(四)实验结果与分析1. 用户画像分析根据用户购买数据,我们可以得出以下结论:(1)年轻用户购买频率较高,偏好时尚、电子产品等商品。

(2)中年用户购买金额较高,偏好家居、家电等商品。

(3)老年用户购买频率较低,偏好健康、养生等商品。

2. 商品分析根据商品购买数据,我们可以得出以下结论:(1)电子产品销量最高,其次是家居、家电等商品。

(2)商品类别分布较为均匀,但电子产品、家居、家电等类别占比相对较高。

3. 购买行为分析根据购买时间、购买金额等数据,我们可以得出以下结论:(1)用户购买时间主要集中在上午10点到下午6点。

大数据工程实习报告

实习报告一、实习背景及目的随着互联网和信息技术的飞速发展,大数据时代已经来临。

大数据工程作为一门跨学科、跨领域的技术,正逐渐改变着我们的生活和工作方式。

为了更好地了解大数据工程的技术特点、应用领域和未来发展,提高自己在相关领域的实践能力,我选择了大数据工程方向的实习。

本次实习的目的主要有以下几点:1. 学习并掌握大数据工程的基本原理和技术方法。

2. 了解大数据工程在实际应用中的具体场景和解决方案。

3. 提高自己在团队协作中的沟通与协作能力。

4. 培养自己解决实际问题的能力和创新思维。

二、实习内容及收获1. 实习内容(1)大数据采集与处理:学习并使用Python编程语言,基于Hadoop和Spark平台进行大数据的采集、存储和处理。

(2)数据挖掘与分析:运用机器学习算法,对采集到的数据进行挖掘和分析,提取有价值的信息。

(3)实际项目实践:参与团队项目,为某企业提供大数据解决方案,包括数据采集、处理、分析和可视化等。

(4)团队协作与沟通:与团队成员共同完成项目,提高自己在团队协作中的沟通与协作能力。

2. 实习收获(1)掌握了大数据采集、处理和分析的基本技术,如Hadoop、Spark、Python等。

(2)学会了使用机器学习算法进行数据挖掘,提取有价值的信息。

(3)了解了大数据在实际应用中的具体场景,如金融、医疗、电商等。

(4)提高了自己在团队协作中的沟通与协作能力,培养了团队精神。

(5)培养了解决实际问题的能力和创新思维。

三、实习总结通过本次实习,我对大数据工程有了更深入的了解,从理论到实践,全面掌握了大数据的基本技术和应用方法。

同时,实习过程中的团队协作和项目实践,使我在沟通、协作和创新能力方面得到了很大的提升。

实习期间,我也认识到自己在某些方面的不足,如在大数据处理和分析能力上的欠缺,需要在今后的学习和工作中继续努力提高。

此外,随着大数据技术的不断发展,我们还需不断学习新知识、新技能,以适应行业的变化。

大数据技术实验一平台搭建

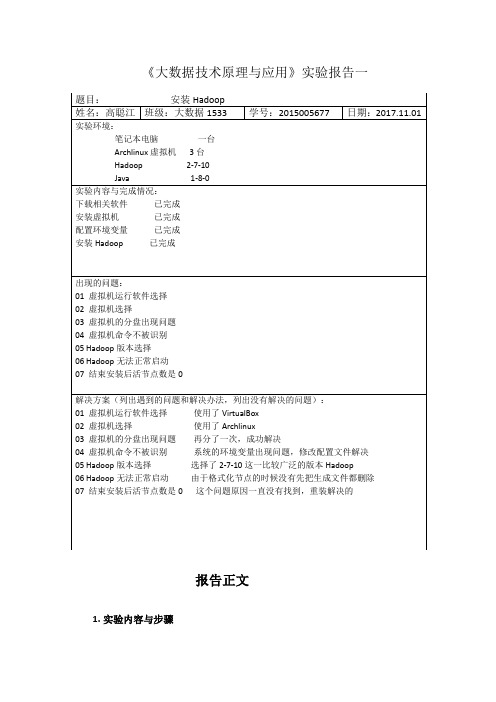

《大数据技术原理与应用》实验报告一题目:安装Hadoop姓名:高聪江班级:大数据1533 学号:2015005677 日期:2017.11.01 实验环境:笔记本电脑一台Archlinux虚拟机3台Hadoop 2-7-10Java 1-8-0实验内容与完成情况:下载相关软件已完成安装虚拟机已完成配置环境变量已完成安装Hadoop 已完成出现的问题:01 虚拟机运行软件选择02 虚拟机选择03 虚拟机的分盘出现问题04 虚拟机命令不被识别05 Hadoop版本选择06 Hadoop无法正常启动07 结束安装后活节点数是0解决方案(列出遇到的问题和解决办法,列出没有解决的问题):01 虚拟机运行软件选择使用了VirtualBox02 虚拟机选择使用了Archlinux03 虚拟机的分盘出现问题再分了一次,成功解决04 虚拟机命令不被识别系统的环境变量出现问题,修改配置文件解决05 Hadoop版本选择选择了2-7-10这一比较广泛的版本Hadoop06 Hadoop无法正常启动由于格式化节点的时候没有先把生成文件都删除07 结束安装后活节点数是0 这个问题原因一直没有找到,重装解决的报告正文1.实验内容与步骤本实验主要内容和步骤如下:1.1.实验内容Hadoop集群搭建(由于伪分布比较简单,所以实验报告描述集群搭建),WorldCount实例测试。

1.2.实验步骤1>下载相关软件。

主要是Java,VirtualBox,Hadoop安装包,虚拟机的镜像文件。

2>安装ArchLinux虚拟机(由于此发行版本比较洁净,系统体积小,运行比较流畅)安装结果如图:3>进行Hadoop集群安装>>启用网络并安装SSH和JDK>>配置SSH免密登录>>配置JAVA环境变量显示上图说明JAVA环境变量已经配置完成。

>>安装Hadoop安装结束如上图>>配置Hadoop 环境变量在~/.bashrc文件中添加如下内容:保存并执行$ source ~/.bashrc使其生效。

大数据实践课程 实验报告

大数据实践课程实验报告一、引言大数据技术在当今社会中扮演着越来越重要的角色。

为了更好地应对和利用大数据,大数据实践课程成为了许多学校和企业培养人才的重要一环。

本实验报告旨在总结和分析大数据实践课程的相关实验内容,以及实验过程中所遇到的问题和解决方案。

二、实验内容在大数据实践课程中,学生通常会接触到大数据处理框架、数据分析和可视化、机器学习等方面的内容。

这些实验旨在让学生通过实际操作和项目实践,深入了解大数据的处理和应用。

1. 大数据处理框架实验在大数据处理框架实验中,学生会学习和使用一些主流的大数据处理框架,如Hadoop、Spark等。

通过搭建和配置这些框架,学生可以学习到大数据的分布式存储和计算的原理和方法。

2. 数据分析和可视化实验数据分析和可视化是大数据处理中非常重要的一环。

在这个实验中,学生将学习如何使用Python或R等编程语言进行数据分析,并通过绘制图表和可视化工具展示分析结果。

这些实验将帮助学生掌握数据清洗、特征提取、数据可视化等技能。

3. 机器学习实验机器学习是大数据中的关键技术之一。

在机器学习实验中,学生将学习和实践常见的机器学习算法,如线性回归、逻辑回归、决策树等。

通过使用真实的数据集进行训练和测试,学生可以了解机器学习的原理和应用。

三、实验问题和解决方案在进行大数据实践过程中,学生可能会遇到一些问题。

下面列举了一些常见的问题和相应的解决方案。

1. 数据清洗问题在进行数据分析和机器学习实验时,往往需要对原始数据进行清洗和预处理。

这个过程中可能会遇到缺失值、异常值等问题。

解决方案可以包括删除缺失值或异常值、使用插补方法填充缺失值等。

2. 算法选择问题在进行机器学习实验时,选择合适的算法对于结果的准确性和效率都非常重要。

解决方案可以包括对比不同算法的优缺点,根据数据特点选择最合适的算法。

3. 模型评估问题在机器学习实验中,模型的评估是判断模型好坏的重要指标。

解决方案可以包括使用交叉验证、绘制学习曲线等方法来评估模型的性能。

HCNA-BigData大数据平台实验手册

HCNA-Big Data大数据平台实验手册目录一、安装FusionInsight实验 (5)1.1 安装准备 (5)1.1.1 准备硬件 (5)1.1.2 准备操作系统 (6)1.1.3 准备工具和软件 (10)1.1.4 准备数据 (11)1.1.5 物理组网拓扑 (14)1.2 安装过程 (14)1.2.1 检验软件包 (14)1.2.2 生成配置文件 (17)1.2.3 配置并检查安装环境 (33)1.2.4 安装双机Manager (38)1.2.5 安装集群 (40)二、日常维护实验 (45)2.1集群、服务、实例实验 (45)2.1.1 添加服务 (45)2.1.2 启动、停止、重启及删除服务 (47)2.1.3 导出服务的配置数据 (48)2.1.4 导入服务的配置数据 (49)2.1.5 配置服务参数 (50)22.1.6 添加角色实例 (52)2.1.7 启动、停止、重启及删除角色实例 (53)2.1.8 导出角色实例的配置数据 (54)2.1.9 导入角色实例的配置数据 (55)2.1.10导出集群的配置数据 (56)2.1.11 导入导出集群安装模板 (57)2.2 OMS备份恢复实验 (58)2.2.1 备份Manager数据 (58)2.2.2 恢复Manager数据 (61)2.3集群健康检查 (70)2.3.1 执行健康检查 (70)2.3.2 查看并导出检查报告 (73)2.3.3 配置健康检查报告保存数 (74)2.3.4 管理健康检查报告 (75)三、业务操作实验 (77)3.1 创建用户实验 (77)3.1.1 流程概述 (77)3.1.2 创建角色 (78)3.1.3 创建用户组 (82)3.1.4 创建用户 (84)3.2安装Client (86)3.2.1 安装客户端 (86)3.2.2 使用客户端 (90)33.2.3 切换多实例的客户端 (91)3.3 HDFS实验 (92)3.3.1 创建HDFS角色 (92)3.3.2 使用HDFS客户端实验 (93)3.4 HBase实验 (95)3.4.1 创建HBase角色 (95)3.4.2使用HBase客户端 (97)3.4.3 HBase 创建/更改/删除/启动/禁用表 (98)3.5 Extract Transform Load实验 (100)3.5.1从HDFS导入数据到HBase (100)3.5.2从HBase导出数据到HDFS (103)4一、安装FusionInsight实验(本实验预估时间2.5小时)1.1 安装准备1.1.1 准备硬件华为FusionInsight HD系统支持通用的X86服务器(不限于华为服务器),可根据自身需求灵活选择。

大数据技术实训报告书

大数据技术实训报告书

一、实训目标

本次实训的目标是掌握大数据技术的核心概念和技能,包括数据的收集、存储、处理和分析,以及大数据应用系统的设计和开发。

通过实训,我们希望能够培养学员解决实际问题的能力,提高对大数据技术的理解和应用水平。

二、实训内容

1. 大数据基础知识:介绍大数据的概念、特点和发展趋势,以及大数据技术体系的基本构成。

2. 数据采集与存储:学习如何利用Flume、Logstash等工具采集数据,以及如何使用HDFS、HBase等存储数据。

3. 数据处理与分析:掌握MapReduce、Spark等数据处理框架的使用,学习数据清洗、数据转换和数据分析的技能。

4. 大数据应用开发:通过实践项目,学习如何设计和开发大数据应用系统,包括需求分析、系统设计、系统开发和测试等环节。

三、实训过程

在实训过程中,我们采用了多种教学方法,包括理论授课、案例分析、实践操作和小组讨论等。

通过这些方法,学员们可以更加深入地理解大数据技术的实际应用,提高解决实际问题的能力。

四、实训总结

通过本次实训,学员们对大数据技术有了更深入的理解,掌握了大数据技术的核心技能,提高了解决实际问题的能力。

在未来的工作中,学员们可以将所学知识应用到实践中,推动大数据技术的发展和应用。

同时,我们也发现了学员们在学习过程中存在的一些问题,如基础知识不够扎实、实践经验不足等。

针对这些问题,我们将加强学员的基础知识培训和实践操作训练,提高学员的综合素质和能力水平。

大数据技术原理的实训报告

大数据技术原理的实训报告

大数据技术是指用于处理大规模数据集的技术和工具。

在实训

报告中,我们可以从以下几个方面来全面介绍大数据技术的原理和

应用:

1. 概述大数据技术,首先,我们可以介绍大数据技术的概念、

发展历程和应用领域,以及大数据技术对于企业和社会的重要性和

影响。

2. 大数据处理原理,接着,可以详细介绍大数据处理的原理,

包括数据采集、存储、处理和分析等环节。

可以介绍常见的大数据

处理框架,如Hadoop、Spark等,以及它们的工作原理和特点。

3. 数据存储技术,我们可以深入介绍大数据存储技术,包括分

布式文件系统(如HDFS)、NoSQL数据库(如MongoDB、Cassandra)等,以及它们的特点、适用场景和优缺点。

4. 数据处理和分析技术,针对大数据处理和分析,可以介绍MapReduce编程模型、Spark计算框架等技术,以及它们在大数据处

理和分析中的应用。

5. 大数据应用案例,最后,可以通过具体的案例来展示大数据技术在各个领域的应用,如电商行业的用户行为分析、金融行业的风险控制、医疗健康领域的数据挖掘等,以及这些应用对于业务决策和社会发展的意义。

通过以上几个方面的介绍,可以全面而深入地展示大数据技术的原理和应用,为实训报告提供丰富的内容和详尽的讲解。

大数据技术原理与应用课程实验报告一

大数据技术原理与应用课程实验报告一随着科技的不断发展,“大数据技术原理与应用”课程在许多学校中受到了广泛的重视,并开设了相应的专业课程。

本文将简要介绍“大数据技术原理与应用”课程的实验内容、分析方法、实验要求,以及实验结果的讨论。

一、实验内容本次实验的主要内容是,用Hadoop环境来进行海量数据分析处理,结合大数据技术原理开展相应实验。

1.建Hadoop环境首先,我们要搭建一个Hadoop环境,并使用Hadoop平台上的HDFS文件系统来组织和管理大规模数据。

2.立数据仓库接下来,我们需要在HDFS文件系统中建立一个统一的数据仓库,便于我们进行有效的数据处理分析。

3.计MapReduce程序最后,应根据实验要求,设计MapReduce程序,用来处理海量数据,并提取出所需的有效信息。

二、分析方法本次实验主要采用MapReduce程序来进行分析处理,我们要对海量数据进行分组,然后分别进行分析处理,提取有用的数据,最后形成相应结果。

三、实验要求本次实验要求根据所给数据,设计一个MapReduce程序,对海量数据进行有效的分组处理,并从中提取出有用的结果。

四、实验结果在本次实验中,我们首先搭建Hadoop环境和HDFS文件系统,然后建立相应的数据仓库,再根据实验要求设计并实现MapReduce程序,用来处理海量数据,最后获得了有效的实验结果。

通过实验,我们可以了解到用Hadoop环境来进行海量数据处理,是一种有效的方式。

五、结论本文介绍了“大数据技术原理与应用”课程的实验内容、分析方法、实验要求,以及实验结果的讨论。

搭建Hadoop环境,利用MapReduce程序进行大规模数据的分析处理,是一种有效的大数据处理方法。

大数据技术综合实训 实验报告

大数据技术综合实训实验报告概述大数据技术在当今信息时代已经成为一个重要的研究领域。

大数据技术能够处理海量的数据,提取有价值的信息,并为决策提供支持。

本实训旨在通过实际操作和探索,深入探讨大数据技术在实际应用中的使用和优化。

任务一:数据收集与清洗在大数据处理过程中,数据的收集和清洗是非常重要的环节。

本任务要求收集一定规模的数据,并对数据进行清洗以去除噪声和不完整的信息。

数据收集1.确定数据收集的目标,明确需要收集的信息类型和数量。

2.制定数据收集计划,选择合适的数据收集方法,如网络爬虫、传感器、问卷调查等。

3.根据数据收集计划,实施数据收集并记录所使用的收集方法和工具。

数据清洗1.对收集到的数据进行初步的清洗,包括去除重复数据、去除不完整的数据、转换数据格式等。

2.分析数据中的噪声和异常值,并处理这些异常数据,如替换、删除或重采样等。

任务二:数据存储与管理大数据处理的效率和性能与数据的存储和管理密切相关。

本任务要求选择合适的数据存储和管理方案,并实施数据的存储与管理。

数据存储选择1.根据数据的特点和需求,选择合适的数据存储方案,如关系型数据库、分布式文件系统、NoSQL等。

2.对比不同的数据存储方案的优缺点,选择最适合本次实训的方案。

数据管理实施1.根据数据存储方案,设计数据模型和表结构。

2.实施数据的导入、导出和查询操作,并记录执行过程,包括使用的工具和命令。

3.对数据进行备份和恢复,保证数据的安全性和可靠性。

任务三:数据处理与分析大数据的处理和分析是大数据技术的核心内容。

本任务要求使用合适的数据处理和分析工具,对所收集和清洗的数据进行处理和分析。

数据处理1.使用合适的数据处理工具,对原始数据进行加工和转换。

2.分析数据的特征和规律,对数据进行筛选、聚类、分类等操作。

数据分析1.使用合适的数据分析工具,对处理后的数据进行分析和建模。

2.根据分析结果,提取有价值的信息,并进行可视化展示。

任务四:数据优化与应用大数据技术的应用范围非常广泛,本任务要求对所处理和分析的数据进行优化和应用。

《Hadoop大数据技术》课程实验教学大纲

课程代码: 1041139课程名称: Hadoop 大数据技术/Hadoop Big Data Technology 课程类别:专业必修课 总学分: 3.5 总学时: 56实验/实践学时: 24合用专业:数据科学与大数据技术 合用对象:本科先修课程: JAVA 程序设计、 Linux 基础《Hadoop 大数据技术》课程是数据科学与大数据技术专业的专业必修课程,是数据科学与 大数据技术的交叉学科,具有极强的实践性和应用性。

《Hadoop 大数据技术》实验课程是理论 课的延伸,它的主要任务是使学生对Hadoop 平台组件的作用及其工作原理有更深入的了解,提 高实践动手能力,并为 Hadoop 大数据平台搭建、基本操作和大数据项目开辟提供技能训练,是 提高学生独立操作能力、分析问题和解决问题能力的一个重要环节。

实验目的:1.掌握 Hadoop 伪分布式模式环境搭建的方法;2.熟练掌握 Linux 命令(vi 、tar 、环境变量修改等)的使用。

实验设备:1.操作系统: Ubuntu16.04实验/实践项目名称实验一 Hadoop 环境搭建实验二 通过 API 和 Shell 访问 HDFS 实验三 MapReduce 基础编程与 WordCount 程序实验四 HBase 的安装与配置、 Shell 访 问与 Java API 访问实验五 基于 Local 模式的 Hive 环境搭 建和常用操作实验六 Flume 的安装与基本使用 实验七 Sqoop 的安装与基本使用合计对应的课程 教学目标52 1 、2116 6实验 类型 综合性 验证性 验证性综合性验证性验证性 验证性实验 学时 4 4 4422 4 24实验 要求 必做 必做 必做必做必做必做 必做每组 人数 1 1 1111 1序 号 1 2 3456 72.Hadoop 版本:2.7.3 或者以上版本实验主要内容及步骤:1.实验内容在Ubuntu 系统下进行Hadoop 伪分布式模式环境搭建。

大数据实验报告 (精选可编辑)

大数据实验报告(精选可编辑)本实验旨在通过使用大数据技术,分析并可视化COVID-19病毒在全球范围内的传播情况。

在实验中,我们将使用Python编程语言,并使用一些流行的数据科学工具和库,如numpy、pandas、matplotlib和plotly等来收集、清理、处理和呈现数据。

数据获取我们从全球卫生组织(WHO)的官方网站下载了COVID-19病毒数据。

这些数据包括全球范围内每天的确诊和死亡病例数,以及每个国家的详细数据。

我们将数据以CSV格式保存在本地。

数据清理为了能够更好地处理和呈现数据,我们需要对其进行清理和预处理。

这包括删除无用的列、填充缺失值、处理不准确的数据、去除重复项等。

数据分析我们使用Python中的pandas库来更好地处理数据。

我们将数据导入pandas数据帧,然后使用describe()函数来获取各个字段的统计信息。

在此基础上,我们可以进一步分析数据并绘制可视化图表。

第一个可视化图表是每天的全球COVID-19病例图。

它展示了自2020年1月22日以来全世界每天的确诊病例和死亡病例。

我们可以看到疫情在几个月内迅速增长,然后在几个月后开始缓慢下降。

我们还可以使用世界地图来可视化COVID-19在全球范围内的传播情况。

我们使用Plotly库创建了一个可交互的地图,以显示每个国家的确诊和死亡病例数。

通过将鼠标悬停在地图上,用户可以查看每个国家的确诊和死亡病例数。

结论本实验使用Python编程语言和一些流行的数据科学工具和库处理并可视化了COVID-19病毒全球传播的数据。

我们展示了每天的全球COVID-19病例图和可交互的世界地图,以展示每个国家的确诊和死亡病例数。

通过这些可视化图表,我们可以更好地了解这场全球危机的严重性。

国开大数据技术概论实验1理解

国开大数据技术概论实验1理解概述:国开大数据技术概论实验1是一门针对大数据技术的入门实验课程,旨在帮助学生了解大数据技术的基本原理和应用。

本文将从实验目的、实验内容、实验过程和实验结果等方面进行详细阐述,以便更好地理解该实验的内容。

一、实验目的国开大数据技术概论实验1的主要目的是让学生通过实际动手操作,掌握大数据技术的基本原理和应用。

通过该实验,学生可以了解大数据技术的概念、特点和发展趋势,并能够使用相应的工具和技术进行数据处理和分析。

二、实验内容国开大数据技术概论实验1的内容主要包括以下几个方面:1. 大数据技术基础知识:学生需要了解大数据的定义、特点和应用场景,以及常见的大数据处理工具和技术。

2. 大数据处理工具的安装与配置:学生需要按照实验指导书的要求,下载和安装相应的大数据处理工具,如Hadoop、Spark等。

3. 数据预处理:学生需要使用所安装的大数据处理工具,对给定的数据进行预处理,包括数据清洗、数据转换和数据集成等。

4. 数据分析与挖掘:学生需要使用所安装的大数据处理工具,对预处理后的数据进行分析和挖掘,提取有价值的信息和知识。

5. 实验报告撰写:学生需要根据实验结果,撰写实验报告,详细描述实验过程、方法和结果,并对实验中遇到的问题进行分析和总结。

三、实验过程国开大数据技术概论实验1的实验过程如下:1. 下载和安装大数据处理工具:根据实验指导书的要求,学生需要访问相应的官方网站,下载并安装Hadoop、Spark等大数据处理工具。

2. 数据预处理:学生需要使用所安装的大数据处理工具,对给定的数据进行预处理。

首先,学生需要对数据进行清洗,去除重复、缺失和错误的数据。

其次,学生需要对数据进行转换,将数据从原始格式转换为可被大数据处理工具处理的格式。

最后,学生需要对数据进行集成,将来自不同数据源的数据进行整合。

3. 数据分析与挖掘:学生需要使用所安装的大数据处理工具,对预处理后的数据进行分析和挖掘。

大数据技术综合实训 实验报告

大数据技术综合实训实验报告实验报告1. 实验目的:通过综合实训,对大数据技术进行实践和应用,掌握大数据处理的基本技术和方法,提高数据分析和处理能力。

2. 实验内容:a. 理论学习:学习大数据处理的基本概念、技术原理和应用场景;b. 实验环境搭建:搭建大数据处理的实验环境,包括Hadoop和Spark等工具和框架;c. 数据采集与清洗:使用爬虫技术采集大量的数据,并进行数据清洗,包括去重、去噪等操作;d. 数据存储与管理:使用Hadoop分布式文件系统(HDFS)进行数据存储和管理;e. 数据分析与挖掘:使用Spark进行大数据分析和挖掘,包括数据统计、机器学习等操作;f. 结果展示与报告撰写:对实验结果进行展示和报告撰写,包括实验过程、数据处理方法和分析结果等。

3. 实验步骤:a. 学习理论知识:通过教材、网络资源等学习大数据处理的基本概念、技术原理和应用场景;b. 搭建实验环境:根据实验要求安装和配置Hadoop、Spark等工具和框架;c. 数据采集与清洗:使用合适的爬虫技术采集大量的数据,并进行数据清洗操作,去除重复数据和噪声数据;d. 数据存储与管理:将清洗后的数据存储到HDFS中,使用Hadoop进行数据管理和存储;e. 数据分析与挖掘:使用Spark进行大数据分析和挖掘,包括数据统计、机器学习等操作;f. 结果展示与报告撰写:根据实验结果进行结果展示,包括统计图表、模型预测等,并撰写实验报告,记录实验过程和方法。

4. 实验工具:a. Hadoop:用于大数据存储和分布式处理的开源框架;b. Spark:用于大数据分析和挖掘的开源框架;c. Python或其他编程语言:用于数据采集、清洗和分析的编程工具;d. 数据可视化工具:用于展示实验结果的图表和可视化效果。

5. 实验结果:a. 数据采集与清洗:成功使用爬虫技术采集了大量的数据,并进行了去重、去噪等操作;b. 数据存储与管理:成功将清洗后的数据存储到HDFS中,并使用Hadoop进行数据管理和存储;c. 数据分析与挖掘:成功使用Spark进行了数据分析和挖掘,包括数据统计、机器学习等操作;d. 结果展示与报告撰写:通过统计图表和模型预测等方式展示了实验结果,并整理了实验报告,记录了实验过程和方法。

大数据实验——精选推荐

⼤数据实验实验⼀:熟悉常⽤的Linux操作和Hadoop操作⼀、实验⽬的Hadoop运⾏在Linux系统上,因此,需要学习实践⼀些常⽤的Linux命令。

本实验旨在熟悉常⽤的Linux操作和Hadoop操作,为顺利开展后续其他实验奠定基础。

⼆、实验平台l 操作系统:Linux;l Hadoop版本:2.7.1。

三、实验步骤(⼀)熟悉常⽤的Linux操作l cd命令:切换⽬录(1)切换到⽬录“/usr/local”(2)切换到当前⽬录的上⼀级⽬录(3)切换到当前登录Linux系统的⽤户的⾃⼰的主⽂件夹l ls命令:查看⽂件与⽬录(4)查看⽬录“/usr”下的所有⽂件和⽬录l mkdir命令:新建⽬录(5)进⼊“/tmp”⽬录,创建⼀个名为“a”的⽬录,并查看“/tmp”⽬录下已经存在哪些⽬录(6)进⼊“/tmp”⽬录,创建⽬录“a1/a2/a3/a4”l rmdir命令:删除空的⽬录(7)将上⾯创建的⽬录a(在“/tmp”⽬录下⾯)删除(8)删除上⾯创建的⽬录“a1/a2/a3/a4” (在“/tmp”⽬录下⾯),然后查看“/tmp”⽬录下⾯存在哪些⽬录l cp命令:复制⽂件或⽬录(9)将当前⽤户的主⽂件夹下的⽂件.bashrc复制到⽬录“/usr”下,并重命名为bashrc1(10)在⽬录“/tmp”下新建⽬录test,再把这个⽬录复制到“/usr”⽬录下l mv命令:移动⽂件与⽬录,或更名(11)将“/usr”⽬录下的⽂件bashrc1移动到“/usr/test”⽬录下(12)将“/usr”⽬录下的test⽬录重命名为test2l rm命令:移除⽂件或⽬录(13)将“/usr/test2”⽬录下的bashrc1⽂件删除(14)将“/usr”⽬录下的test2⽬录删除l cat命令:查看⽂件内容(15)查看当前⽤户主⽂件夹下的.bashrc⽂件内容 xQWl tac命令:反向查看⽂件内容(16)反向查看当前⽤户主⽂件夹下的.bashrc⽂件的内容l more命令:⼀页⼀页翻动查看(17)翻页查看当前⽤户主⽂件夹下的.bashrc⽂件的内容l head命令:取出前⾯⼏⾏(18)查看当前⽤户主⽂件夹下.bashrc⽂件内容前20⾏(19)查看当前⽤户主⽂件夹下.bashrc⽂件内容,后⾯50⾏不显⽰,只显⽰前⾯⼏⾏l tail命令:取出后⾯⼏⾏(20)查看当前⽤户主⽂件夹下.bashrc⽂件内容最后20⾏(21)查看当前⽤户主⽂件夹下.bashrc⽂件内容,并且只列出50⾏以后的数据l touch命令:修改⽂件时间或创建新⽂件(22)在“/tmp”⽬录下创建⼀个空⽂件hello,并查看⽂件时间(23)修改hello⽂件,将⽂件时间整为5天前l chown命令:修改⽂件所有者权限(24)将hello⽂件所有者改为root帐号,并查看属性l find命令:⽂件查找(25)找出主⽂件夹下⽂件名为.bashrc的⽂件l tar命令:压缩命令(26)在根⽬录“/”下新建⽂件夹test,然后在根⽬录“/”下打包成test.tar.gz(27)把上⾯的test.tar.gz压缩包,解压缩到“/tmp”⽬录l grep命令:查找字符串(28)从“~/.bashrc”⽂件中查找字符串'examples'l 配置环境变量(29)请在“~/.bashrc”中设置,配置Java环境变量(30)查看JAVA_HOME变量的值(⼆)熟悉常⽤的Hadoop操作(31)使⽤hadoop⽤户登录Linux系统,启动Hadoop(Hadoop的安装⽬录为“/usr/local/hadoop”),为hadoop⽤户在HDFS中创建⽤户⽬录“/user/hadoop”./sbin/start -all.sh(32)接着在HDFS的⽬录“/user/hadoop”下,创建test⽂件夹,并查看⽂件列表Hadoop fs -mkdir /test(33)将Linux系统本地的“~/.bashrc”⽂件上传到HDFS的test⽂件夹中,并查看testHadoop fs -put ~/.bashrc /testHadoop fs -ls /test(34)将HDFS⽂件夹test复制到Linux系统本地⽂件系统的“/usr/local/hadoop”⽬录下Hadoop fs -get test /usr/local四、实验报告实验报告题⽬:实验⼀姓名郭⼦鹏⽇期:2020年6⽉实验环境:l 操作系统:Linux;l Hadoop版本:2.7.1。

大数据技术实践实验报告

⼤数据技术实践实验报告实验报告课程名称:⼤数据技术实践实验项⽬:⼤数据平台实验仪器: PC机学院:计算机学院专业:计算机科学与技术班级姓名: *学号: *⽇期: 2019-5-9 指导教师: *成绩:⼀. 实验⽬的1. 熟练掌握⼤数据计算平台相关系统的安装部署2. 理解⼤数据MapReduce计算模型,并掌握MapReduce程序开发3. 掌握Hive的查询⽅法4. 掌握Spark的基本操作⼆. 实验内容1. Hadoop完全分布模式安装2. Hadoop开发插件安装3. MapReduce代码实现4. Hive安装部署5. Hive查询6. Spark Standalone模式安装7. Spark Shell操作三. 实验过程Hadoop开发插件安装实验步骤:1.Eclipse开发⼯具以及Hadoop默认已经安装完毕,安装在/apps/⽬录下。

2.在Linux本地创建/data/hadoop3⽬录,⽤于存放所需⽂件。

切换⽬录到/data/hadoop3⽬录下,并使⽤wget命令,下载所需的插件hadoop-eclipse-plugin-2.6.0.jar。

2.将插件hadoop-eclipse-plugin-2.6.0.jar,从/data/hadoop3⽬录下,拷贝到/apps/eclipse/plugins的插件⽬录下。

3.进⼊ubuntu图形界⾯,双击eclipse图标,启动eclipse。

5.在Eclipse窗⼝界⾯,依次点击Window => Open Perspective => Other。

弹出⼀个窗⼝。

选择Map/Reduce,并点击OK,可以看到窗⼝中,有三个变化。

(左侧项⽬浏览器、右上⾓操作布局切换、⾯板窗⼝)如果在windows下,则需要⼿动调出⾯板窗⼝Map/Reduce Locations⾯板,操作为,点击window => show view => Other。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

重庆交通大学信息科学与工程学院实验报告班级:曙光1701班姓名学号:实验项目名称:实验一, Hadoop平台搭建与维护实验项目性质:验证性实验所属课程:大数据平台技术实验室(中心):语音楼11楼第三实验室指导教师:实验完成时间:2019 年9 月22 日一、实验概述:【实验目的】1.掌握Linux命令行操作及JA V A环境变量设计方法;2.掌握Linux操作系统安装或虚拟机安装配置方法;3.掌握Hadoop平台单机模式、伪分布式模式的安装配置方法;4.掌握HDFS分布式文件系统的文件读写命令行使用方法;5.掌握MapReduce分布式程序的命令行示例程序使用方法。

【实验要求】1.保存程序,并自行存档;2.最终的程序都必须经过测试,验证是正确的;3.认真记录实验过程及结果,回答实验报告中的问题。

【实施环境】(使用的材料、设备、软件)Linux操作系统环境,VirtualBox虚拟机,Java开发环境,Hadoop/HBase/Spark等程序。

二、实验内容第1题. Ubuntu操作系统安装。

以双系统或者虚拟机方式安装Ubuntu操作系统。

安装双系统:安装前准备工作1.压缩磁盘,新建分区- 桌面电脑图标上右键 --> 管理 --> 存储 --> 磁盘管理图1.- 磁盘0 --> OS(C:)上右键压缩卷--> 选择合适大小,压缩完成后就退出,保持未分区状态,不要格式化图22.关闭快速启动(也许不管也可以)图33.制作UEFI格式U盘启动盘将ISO镜像中的所有文件复制到一个干净的U盘中。

4.关闭Secure Boot(1)进入BIOS:重启电脑,在MI出现后马上按F2(可以多按几次,也可以在还是黑屏时就开始按)(2)Security—>Set Supervisor Password(必须设置,否则下面的Secure Boot无法更改)图4(3)Security—>Secure Boot—>更改为Disabled图5(4)Boot—>Boot Type—>UEFI图6(5)最后F10后回车,会保存更改后直接启动安装中1. 进入启动U盘: 同进入BIOS类似,在上面重启后出现MI时按F12,进入选择菜单,选择你的U盘就可以了图72.之后就是正常的Ubuntu系统安装步骤,需要注意的是一定要选择其他选项(自己分区),3. 分区:共60G/bootext4 300MB /ext4 50GB/swap 1000MB4. 分完区后,下面的安装启动引导器的设备选择/boot所在的分区5. 安装完成后重启时会出现一个选择菜单,选择Ubuntu则进入linux系统,选择Windows boot Manager则进入Win10图8安装完成第2题Linux环境下Hadoop开发环境的安装【实验内容】(1)JA V A环境安装与配置;(2)SSH环境安装与配置;(3)Hadoop伪分布式模式安装与配置。

【实验结果】(步骤、记录、数据、程序等)请结合课程实验教材第3章内容,完成JA V A环境、SSH以及Hadoop平台的安装和配置任务,并在下方描述和记录安装过程,提供JA V A、SSH及Hadoop安装配置完成后正常运行的界面截图证明。

1.安装SSHUbuntu默认已安装了SSH客户端,因此,这里还需要安装SSH服务端,在Linux的终端中执行一下命令:$sudo apt-get install openssh-server安装后,可以使用如下命令登录本机:$ssh localhost执行该命令后会出现SSH首次登录提示,输入yes,然后按提示输入密码Hadoop,就登陆到本机了。

(由于这样每次登录都需要输入密码,所以,需要配置成SSH无密码登录,就比较方便)首先输入命令exit退出刚才的SSH,就回到了原先的终端窗口,然后可以利用sshkeygen 生成密钥,并将密钥加入到授权中,命令如下:$cd~/.ssh/ #若没有该目录,请先执行一次 ssh localhost$ssh-keygen-t rsa #会有提示,按enter键即可$cat ./id_rsa.pub>> ./authorized_keys #加入授权此时,在执行ssh localhost命令,无需输入密码就可以直接登录了,如图8所示:图92.安装Java环境安装方式,命令如下:$sudo apt-get install default-jre default-jdk注:需保持联网状态下载好相关文件后,需要配置JAVA_HOME环境变量,在Linux终端中输入以下命令打开当前登录用户的环境变量配置文件.bashrc$vim~/.bashrc在文件最前面添加如下单独一行,然后保存退出:export JAVA_HOME=/usr/lib/jvm/default-java让环境变量立即生效,代码如下:$source~/.bashrc检验是否正确:$echo $JAVA_HOME$java-version$$JAVA_HOME/bin/java-version #执行后会出现Java的版本信息,则安装成功如图9所示:图103.安装HaDoopHadoop包括3种安装模式:1.单机模式2.伪分布模式3.分布模式在Linux系统的FireFox浏览器进入Hadoop官网下载安装文件,下载完安装文件以后,需要对文件进行解压.使用hadoop用户登陆Linux系统,打开一个终端,执行如下命令:$sudo tar -zxf~/下载/hadoop-2.7.1.tar.gz -c/uer/local #解压到/usr/local目录中$cd/usr/local/$sudo mv ./hadoop-2.7.1/ ./hadoop #将文件名改为hadoop$sudo chown -R hadoop ,/hadoop #修改文件权限Hadoop解压后即可使用,用以下命令来检查hadoop是否可用,若成功会显示hadoop 版本信息:$cd /usr/local/hadoop$./bin/hadoop version如图11所示:图11这样就安装好了。

接下来我们来配置伪分布模式:Hadoop伪分布模式是指同一个节点既作为名称结点,也作为数据结点,读取的是分布式文件系统HDFS中的文件。

要实现这种分布模式,需要修改以下两个配置文件:①修改core-site.xml文件(用vim文本编译器打开该文件,指令如下):vim /usr/local/hadoop/etc/hadoop/core-site.xml修改后的文件如图12所示:图12②修改hdfs-site.xml文件,打开该文件的指令如下:vim /usr/local/hadoop/etc/hadoop/hdfs-site.xml修改后的文件如图13所示:图13③当修改了这两个配置文件后,接下来还需要将此名称结点进行格式化,命令如下:$cd /usr/local/hadoop$./bin/hdfs namenode –format如果成功就会看到下图14所示内容:14第3题HDFS 分布式文件系统的文件读写命令行使用方法【实验内容】(1)在HDFS中创建用户目录/user/xxx;(xxx为安装用户名)(2)在HDFS的/user/xxx目录下创建input目录;(3)在Linux桌面创建test.txt文件,在其中输入包含20个以上的单词;(4)将test.txt文件复制到input目录下;(5)将etc/hadoop目录下的所有xml配置文件载入到input目录下;(6)在HDFS的命令行中读取并显示input目录下包含的文件及内容;【实验结果】(步骤、记录、数据、程序等)请完成上述实验内容,提供相应Shell命令和运行结果的截图。

回答:1.在HDFS中创建名为yqy的用户名:$cd/usr/local/hadoop$./bin/hdfs dfs -mkdir -p /user/yqy效果如图15图152.在HDFS的/user/yqy目录下创建input目录:$cd /usr/local/hadoop$./bin/hdfs dfs -mkdir input如图16所示:3.在Linux桌面创建test.txt文件,在其中输入包含20个以上的单词:命令如图17.18所示:图17.18创建结果如图19所示:图194.将test.txt文件复制到input目录下:代码为:$cd /usr/local/hadoop$./bin/hdfs dfs -put home yqy/桌面/test.txt input结果如下图20所示:5.将etc/hadoop目录下的所有xml配置文件载入到input目录下;代码:$cd /usr/local/hadoop$./bin/hdfs dfs -put ./etc/hadoop/*.xml input结果如下图21所示:6.在HDFS的命令行中读取并显示input目录下包含的文件及内容;代码:$cd /usr/local/hadoop$./bin/hdfs dfs -ls input结果显示:图22第4题MapReduce分布式程序的命令行示例程序使用方法【实验内容】(1)在第3题的基础上,以input目录中数据作为输入,调用mapreduce示例程序的grep命令行程序,进行正则表达式’dfs[a-z.]+’的匹配,将结果输出到output目录,并显示出输出结果;(2)调用mapreduce示例程序的wordcount命令行程序,分别完成input目录内所有文件,以及test.txt文件的单词计数,并将结果输出到新的output目录,并显示程序输出结果;(3)调用mapreduce示例程序的圆周率计算命令行程序,输入不同参数,尽可能使得pi值计算精确,并显示程序输出结果。

【实验过程】(步骤、记录、数据、程序等)请完成上述实验内容,提供相应Shell命令和运行结果的截图。

回答:1.在第3题的基础上,以input目录中数据作为输入,调用mapreduce示例程序的grep 命令行程序,进行正则表达式’dfs[a-z.]+’的匹配,将结果输出到output目录,并显示出输出结果;图23.242.调用mapreduce示例程序的wordcount命令行程序,分别完成input目录内所有文件,以及test.txt文件的单词计数,并将结果输出到新的output目录,并显示程序输出结果;将input目录内所有文件输出到新的output目录的指令如下:hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-*.jar wordcount input output执行后的效果如下:图25注意:在执行这一命令前,需要将刚才生成的output目录删除,否则会报错(下同),删除该目录的指令为:hdfs dfs –rm –r output接着可以用指令:hdfs dfs –cat output/*对output中的内容进行查看,效果如下:(结果很多,只截取了部分)图26将input目录内的test.txt输出到新的output目录的指令如下:hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-.jar wordcount input/test.txt output执行后的效果如下:图27这里同样地用指令:hdfs dfs –cat output/*对output中的内容进行查看,效果如下:图283.调用mapreduce示例程序的圆周率计算命令行程序,输入不同参数,尽可能使得pi 值计算精确,并显示程序输出结果。