数据库分库分表(sharding)

使用MySQL进行数据分片和分库分表处理

使用MySQL进行数据分片和分库分表处理在现代的互联网应用中,随着用户数量的增加和数据量的急剧增长,对数据库的需求也越来越高。

为了提高数据库的承载能力和性能,很多大型网站和应用选择使用数据分片和分库分表的方式来处理数据。

本文将介绍如何使用MySQL进行数据分片和分库分表处理。

一、什么是数据分片和分库分表?数据分片(Sharding)是指将一张巨大的表按照某种规则拆分成多个小表,把不同的数据分布在不同的数据库节点中。

这样可以实现数据的并行处理,提高数据库的并发能力。

分库分表(Separation)是指将一张表分散到多个数据库中的不同表中,将不同的数据分布在不同的表中。

这样可以减小单个数据库的负载,并提高查询性能。

二、为什么使用数据分片和分库分表?1. 提高数据库的承载能力:将海量数据分散到不同的节点中,可以充分利用系统资源,提高数据库的承载能力。

2. 提高查询性能:将数据分布在多个表或数据库中,可以并行查询多个节点,减少单点查询的压力,提高查询效率。

3. 提高系统的可用性:将数据分布到多个节点中,即使其中一个节点发生故障,其他节点仍然可以正常工作,提高了系统的可用性。

4. 降低数据库的维护成本:通过分片和分库分表,可以将数据分布到不同的节点中,降低了单个数据库的负载,减少了数据库的维护成本。

三、数据分片的策略在进行数据分片之前,需要选择一个合适的分片策略。

常用的分片策略包括:1. 哈希分片:根据数据的哈希值将数据分布到不同的节点中。

这种策略可以保证数据均匀分布,但对于范围查询和排序操作的支持较差。

2. 范围分片:根据数据的范围将数据分布到不同的节点中。

这种策略适合于按照某个范围进行查询的场景。

3. 一致性哈希分片:通过一致性哈希算法将数据分布到不同的节点中,可以保证数据的负载均衡和扩展性。

分片策略的选择需要根据具体的业务场景和需求进行,合理设计分片策略可以提高系统的性能和可扩展性。

四、分库分表的实现分库分表是在数据分片的基础上,进一步将数据分散到多个数据库中的不同表中。

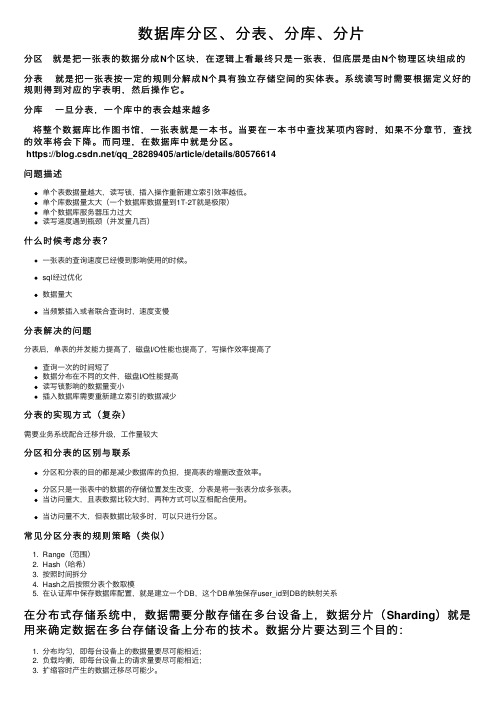

数据库分区、分表、分库、分片

数据库分区、分表、分库、分⽚分区就是把⼀张表的数据分成N个区块,在逻辑上看最终只是⼀张表,但底层是由N个物理区块组成的分表就是把⼀张表按⼀定的规则分解成N个具有独⽴存储空间的实体表。

系统读写时需要根据定义好的规则得到对应的字表明,然后操作它。

分库⼀旦分表,⼀个库中的表会越来越多将整个数据库⽐作图书馆,⼀张表就是⼀本书。

当要在⼀本书中查找某项内容时,如果不分章节,查找的效率将会下降。

⽽同理,在数据库中就是分区。

https:///qq_28289405/article/details/80576614问题描述单个表数据量越⼤,读写锁,插⼊操作重新建⽴索引效率越低。

单个库数据量太⼤(⼀个数据库数据量到1T-2T就是极限)单个数据库服务器压⼒过⼤读写速度遇到瓶颈(并发量⼏百)什么时候考虑分表?⼀张表的查询速度已经慢到影响使⽤的时候。

sql经过优化数据量⼤当频繁插⼊或者联合查询时,速度变慢分表解决的问题分表后,单表的并发能⼒提⾼了,磁盘I/O性能也提⾼了,写操作效率提⾼了查询⼀次的时间短了数据分布在不同的⽂件,磁盘I/O性能提⾼读写锁影响的数据量变⼩插⼊数据库需要重新建⽴索引的数据减少分表的实现⽅式(复杂)需要业务系统配合迁移升级,⼯作量较⼤分区和分表的区别与联系分区和分表的⽬的都是减少数据库的负担,提⾼表的增删改查效率。

分区只是⼀张表中的数据的存储位置发⽣改变,分表是将⼀张表分成多张表。

当访问量⼤,且表数据⽐较⼤时,两种⽅式可以互相配合使⽤。

当访问量不⼤,但表数据⽐较多时,可以只进⾏分区。

常见分区分表的规则策略(类似)1. Range(范围)2. Hash(哈希)3. 按照时间拆分4. Hash之后按照分表个数取模5. 在认证库中保存数据库配置,就是建⽴⼀个DB,这个DB单独保存user_id到DB的映射关系在分布式存储系统中,数据需要分散存储在多台设备上,数据分⽚(Sharding)就是⽤来确定数据在多台存储设备上分布的技术。

【转】mysql分库分表,数据库分库分表思路

【转】mysql分库分表,数据库分库分表思路原⽂:同类参考:⼀. 数据切分关系型数据库本⾝⽐较容易成为系统瓶颈,单机存储容量、连接数、处理能⼒都有限。

当单表的数据量达到1000W或100G以后,由于查询维度较多,即使添加从库、优化索引,做很多操作时性能仍下降严重。

此时就要考虑对其进⾏切分了,切分的⽬的就在于减少数据库的负担,缩短查询时间。

数据库分布式核⼼内容⽆⾮就是数据切分(Sharding),以及切分后对数据的定位、整合。

数据切分就是将数据分散存储到多个数据库中,使得单⼀数据库中的数据量变⼩,通过扩充主机的数量缓解单⼀数据库的性能问题,从⽽达到提升数据库操作性能的⽬的。

数据切分根据其切分类型,可以分为两种⽅式:垂直(纵向)切分和⽔平(横向)切分1、垂直(纵向)切分垂直切分常见有垂直分库和垂直分表两种。

垂直分库就是根据业务耦合性,将关联度低的不同表存储在不同的数据库。

做法与⼤系统拆分为多个⼩系统类似,按业务分类进⾏独⽴划分。

与"微服务治理"的做法相似,每个微服务使⽤单独的⼀个数据库。

如图:垂直分表是基于数据库中的"列"进⾏,某个表字段较多,可以新建⼀张扩展表,将不经常⽤或字段长度较⼤的字段拆分出去到扩展表中。

在字段很多的情况下(例如⼀个⼤表有100多个字段),通过"⼤表拆⼩表",更便于开发与维护,也能避免跨页问题,MySQL底层是通过数据页存储的,⼀条记录占⽤空间过⼤会导致跨页,造成额外的性能开销。

另外数据库以⾏为单位将数据加载到内存中,这样表中字段长度较短且访问频率较⾼,内存能加载更多的数据,命中率更⾼,减少了磁盘IO,从⽽提升了数据库性能。

垂直切分的优点:解决业务系统层⾯的耦合,业务清晰与微服务的治理类似,也能对不同业务的数据进⾏分级管理、维护、监控、扩展等⾼并发场景下,垂直切分⼀定程度的提升IO、数据库连接数、单机硬件资源的瓶颈缺点:部分表⽆法join,只能通过接⼝聚合⽅式解决,提升了开发的复杂度分布式事务处理复杂依然存在单表数据量过⼤的问题(需要⽔平切分)2、⽔平(横向)切分当⼀个应⽤难以再细粒度的垂直切分,或切分后数据量⾏数巨⼤,存在单库读写、存储性能瓶颈,这时候就需要进⾏⽔平切分了。

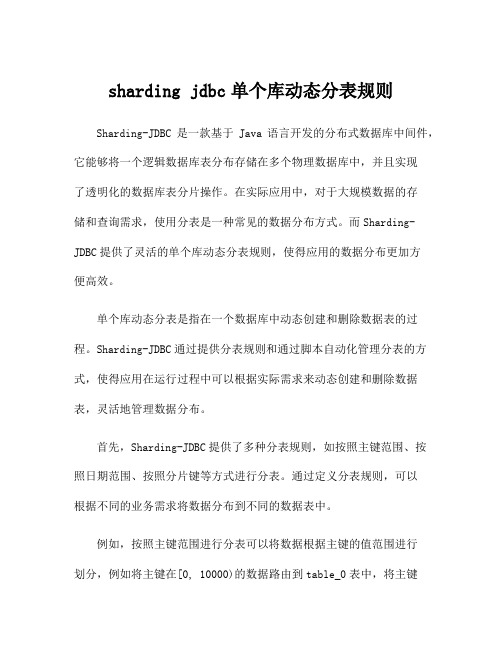

sharding jdbc单个库动态分表规则

sharding jdbc单个库动态分表规则Sharding-JDBC是一款基于Java语言开发的分布式数据库中间件,它能够将一个逻辑数据库表分布存储在多个物理数据库中,并且实现了透明化的数据库表分片操作。

在实际应用中,对于大规模数据的存储和查询需求,使用分表是一种常见的数据分布方式。

而Sharding-JDBC提供了灵活的单个库动态分表规则,使得应用的数据分布更加方便高效。

单个库动态分表是指在一个数据库中动态创建和删除数据表的过程。

Sharding-JDBC通过提供分表规则和通过脚本自动化管理分表的方式,使得应用在运行过程中可以根据实际需求来动态创建和删除数据表,灵活地管理数据分布。

首先,Sharding-JDBC提供了多种分表规则,如按照主键范围、按照日期范围、按照分片键等方式进行分表。

通过定义分表规则,可以根据不同的业务需求将数据分布到不同的数据表中。

例如,按照主键范围进行分表可以将数据根据主键的值范围进行划分,例如将主键在[0, 10000)的数据路由到table_0表中,将主键在[10000, 20000)的数据路由到table_1表中,以此类推。

这种方式适用于主键递增的场景,可以将数据均匀地分布到不同的表中,便于查询和管理。

其次,对于单个库动态分表,Sharding-JDBC通过提供脚本来实现自动化的表管理。

开发人员可以定义创建和删除表的脚本,在应用启动时执行脚本来创建表,在表不再使用时执行脚本来删除表。

这样就可以轻松地管理动态分布的数据表。

例如,在创建表的脚本中,可以使用"CREATE TABLE IF NOT EXISTS"语句来创建表,同时可以根据分表规则来动态生成表的名字。

在删除表的脚本中,可以使用"DROP TABLE IF EXISTS"语句来删除表。

通过使用脚本,可以方便地管理和操作动态分布的数据表,提高了系统的可维护性和灵活性。

分表分库解决方案(mycat,tidb,shardingjdbc)

分表分库解决⽅案(mycat,tidb,shardingjdbc)公司最近有分表分库的需求,所以整理⼀下分表分库的解决⽅案以及相关问题。

1.sharding-jdbc(sharding-sphere)优点:1.可适⽤于任何基于java的ORM框架,如:JPA、Hibernate、Mybatis、Spring JDBC Template,或直接使⽤JDBC2.可基于任何第三⽅的数据库连接池,如:DBCP、C3P0、Durid等3.分⽚策略灵活,可⽀持等号、between、in等多维度分⽚,也可⽀持多分⽚键。

4.SQL解析功能完善,⽀持聚合、分组、排序、limit、or等查询,并⽀持Binding Table以及笛卡尔积表查询。

5.性能⾼,单库查询QPS为原⽣JDBC的99.8%,双库查询QPS⽐单库增加94%。

缺点:1.理论上可⽀持任意实现JDBC规范的数据库。

⽬前仅⽀持mysql2.维护会⽐较⿇烦,需要逐个项⽬的修改配置。

不能进⾏跨库连接,代码需要进⾏改造。

3.在扩展数据库服务器时需要考虑⼀致性哈希问题,或者采⽤分⽚键局部取模⽅式,也难免要进⾏部分的数据迁移。

2.mycat优点:1.⽀持Mysql集群,可以作为Proxy使⽤2.⽀持JDBC连接ORACLE、DB2、SQL Server,将其模拟为MySQL Server使⽤3.⾃动故障切换,⾼可⽤性4.⽀持读写分离,⽀持Mysql双主多从,以及⼀主多从的模式,⽀持全局表,数据⾃动分⽚到多个节点,⽤于⾼效表关联查询5.⽀持独有的基于E-R 关系的分⽚策略,实现了⾼效的表关联查询6.多平台⽀持,部署和实施简单缺点:1.mycat不⽀持⼆维路由,仅⽀持单库多表或多库单表由于⾃定义连接池,这样就会存在mycat⾃⾝维护⼀个连接池,MySQL也有⼀个连接池,任何⼀个连接池上限都会成为性能的瓶。

3.tidb优点:1 .⾼度兼容 MySQL ⼤多数情况下,⽆需修改代码即可从 MySQL 轻松迁移⾄ TiDB,分库分表后的 MySQL 集群亦可通过 TiDB ⼯具进⾏实时迁移。

数据库分片知识分享

关于数据库分片的知识分享一、基本概念1分片的定义数据分片(sharding),有时也称切片或切分,是指当数据规模很大的时候,根据一定的规则、定义,将一个数据库中的数据分散到多个数据库中的做法。

分片是把一个数据库横向扩展到多个节点的有效方式。

它的主要目的是:●利用分片突破单节点数据库的性能限制,解决数据库的扩展性问题;●利用分片可以使用廉价的硬件(或云资源)获得性能上的潜在优势。

2分表、分库、分区、分表对于关系数据库而言,与分片类似的概念还有分表、分库、分区。

分表是指将一张大表分割成若干个结构相同的小表,以此降低单个表的数据规模。

分表后,每个小表除了结构相同以外相互之间独立,它们所涉及的数据库对象(数据、索引、约束、触发器等)、所涉及的资源(数据文件、控制文件等)实际上彼此无关。

进行数据处理时,须由应用程序负责各子表之间的协助和冲突。

分库更进一步,是将大表分割为多个数据库的小表。

分表只能解决单表数据过大时的性能下降,而分库可充分利用多个数据库的资源提升性能。

分库的情况比较复杂,有主-从库(多见)和多主库之分,子表间有必须一致的,也有允许一定程度异构的;小表间的协助和冲突,有应用程序负责、专用软件负责等不同形式。

与上述概念均不同,分区(partition)不用将大表进行物理拆分,只是将数据存放到不同的小块。

大表仍然存在,小表只是逻辑上的概念。

分区对应用程序透明,不需要对代码进行修改。

3分片形式根据分片规则,有两种形式的分片:●垂直分片也称为纵向分片,是指对数据的列进行分片,用于按功能划分数据库的场合。

例如,将一个销售明细表拆分到用户库、销售库、收支库的相应表里。

实际情况中,采用此种分片方式的情形较少。

●水平分片也称为横向分片,是指按数据的行进行分片,即不同的记录分配到不同数据库,例如将全国用户按省市区划分。

在大多数情况下都使用的是水平分片,本文若无特别说明,也指的水平分片。

二、分片的优缺点1分片的优点对于分片来说,它的优点有:●以水平扩展来提高整体性能随着数据的增长,通过增加更多服务器,将新增数据及负载放置到新增服务器即可。

数据库分库分表的实现方法

数据库分库分表的实现方法数据库是现代软件系统中非常重要的组成部分,用于存储和管理大量的数据。

随着业务的发展和数据的增长,单一数据库的负载和性能压力也越来越大。

为了提高数据库的性能和扩展能力,数据库分库分表成为了一种常用的解决方案。

数据库分库分表是指将一个大的数据库拆分成多个小的数据库,或者将一个大表拆分成多个小表,每个小数据库或小表可以独立存储数据,提供更好的负载均衡和可扩展性。

下面介绍几种常用的数据库分库分表的实现方法:一、垂直分库分表垂直分库分表是将一个数据库中的不同表按照业务功能或者关联性划分到不同的数据库中,每个数据库负责处理特定的业务功能或者数据类型。

这种方式使得不同业务功能的数据库可以独立操作,减少了锁竞争和数据冗余。

垂直分表的实现方法主要有两种:1.数据库切分将不同表按照某种规则划分到不同的数据库中,可以按照常用的主从复制方式进行数据同步和高可用性保证。

通过垂直分库可以将不同业务的数据分开,减少数据库的负载压力,提高性能。

2.数据库复制将一个大数据库中的表复制多份,每份只包含自己所需的数据,这样每个数据库只负责处理一部分数据,可以独立操作和扩展。

通过数据库复制可以实现读写分离,提高数据库读取性能。

二、水平分库分表水平分库分表是将一个大的表按照某种规则拆分成多个小的表,分散存储在不同的数据库中,每个小表存储一部分数据,这样可以提高数据库的并发读写能力和查询性能。

水平分库分表的实现方法主要有两种:1.范围分片按照数据的某个或某些列进行切割,将不同范围的数据存储在不同的表中,比如按照用户的地理位置、ID范围或者时间范围等进行划分。

这样可以将查询请求均匀地分散到不同的数据库中,减少单个数据库的负载压力。

2.哈希分片通过哈希函数将数据分散存储到不同的表中,通过哈希函数的散列结果来决定数据在哪个表中存储。

这样可以保证数据均匀分布,减少了数据库的负载压力和锁竞争。

三、分库分表的中间件为了简化分库分表的实现和管理,一些数据库中间件如MyCat、ShardingSphere等提供了分库分表的功能,可以自动将数据分散到不同的数据库和表中。

shardingjdbc 分表原理

shardingjdbc 分表原理Sharding JDBC 分表原理一、引言Sharding JDBC 是一个开源的基于Java 的分布式数据库中间件,可以将数据分散存储在多个数据库中,实现数据的水平分片。

分表是在水平分片的基础上进行的,即将数据按照某种规则分散存储在多个表中。

二、分表原理1. 数据库水平分片数据库水平分片是将一个表的数据拆分成多个部分,分散存储在不同的数据库中。

分片的规则可以根据业务需求来制定,常见的分片规则有基于范围、基于哈希和基于列表等。

2. 分表规则分表是在数据库水平分片的基础上进行的,即将一个表的数据按照某种规则分散存储在多个表中。

分表的规则可以根据业务需求来制定,常见的分表规则有基于日期、基于地区和基于业务类型等。

3. Sharding JDBC 分表策略Sharding JDBC 提供了多种分表策略,可以根据业务需求选择合适的策略。

常见的分表策略有固定分表策略、分库分表策略和虚拟分表策略。

- 固定分表策略:将数据按照固定的规则分散存储在多个表中,如按照用户ID的奇偶性将数据存储在不同的表中。

- 分库分表策略:将数据按照一定的规则分散存储在多个数据库和多个表中,如按照用户ID的哈希值将数据存储在不同的数据库和表中。

- 虚拟分表策略:通过逻辑表和物理表的映射关系,将数据按照一定的规则分散存储在多个表中,如按照用户ID的范围将数据存储在不同的表中。

4. 分表策略配置在使用 Sharding JDBC 进行分表时,需要进行相应的配置。

首先,需要配置数据源,指定分库分表的规则。

然后,需要配置分表策略,指定表的分片规则和分片算法。

最后,需要配置数据节点,指定每个表的具体存储位置。

5. 分表查询在进行分表查询时,Sharding JDBC 会根据分表规则自动路由到相应的数据库和表,将查询结果进行合并返回。

对于涉及多个表的复杂查询,Sharding JDBC 会自动进行跨库跨表的查询,并将结果进行合并返回。

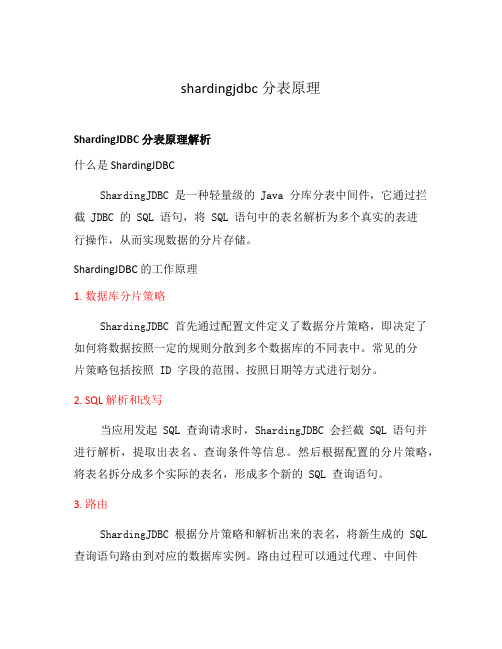

shardingjdbc分表原理

shardingjdbc分表原理ShardingJDBC 分表原理解析什么是 ShardingJDBCShardingJDBC 是一种轻量级的 Java 分库分表中间件,它通过拦截 JDBC 的 SQL 语句,将 SQL 语句中的表名解析为多个真实的表进行操作,从而实现数据的分片存储。

ShardingJDBC 的工作原理1. 数据库分片策略ShardingJDBC 首先通过配置文件定义了数据分片策略,即决定了如何将数据按照一定的规则分散到多个数据库的不同表中。

常见的分片策略包括按照 ID 字段的范围、按照日期等方式进行划分。

2. SQL 解析和改写当应用发起 SQL 查询请求时,ShardingJDBC 会拦截 SQL 语句并进行解析,提取出表名、查询条件等信息。

然后根据配置的分片策略,将表名拆分成多个实际的表名,形成多个新的 SQL 查询语句。

3. 路由ShardingJDBC 根据分片策略和解析出来的表名,将新生成的 SQL 查询语句路由到对应的数据库实例。

路由过程可以通过代理、中间件等方式实现,确保每个 SQL 查询请求都能正确地定位到需要查询的数据库。

4. 数据聚合当多个表的查询结果需要进行合并时(如涉及表连接、分组等操作),ShardingJDBC 会将查询的结果进行聚合,最后返回给应用。

5. 事务一致性ShardingJDBC 通过对分片事务的支持,保证了分布式数据库操作的事务一致性。

它支持分布式事务的两阶段提交机制,确保多个数据库节点的数据一致性。

使用 ShardingJDBC 进行分表操作的例子假设有一个订单表 order,我们希望按照订单的创建时间进行分表操作。

1. 配置分片策略首先需要在配置文件中定义分片策略,如下所示::order:actualDataNodes: ds$->{0..1}.order_$->{2018..2019} tableStrategy:standard:shardingColumn: create_timepreciseAlgorithmClassName:strategy:inline:shardingColumn: create_timealgorithmExpression: order_$->{create_time % 2 + 2018}2. 编写分片算法然后编写自定义的分片算法 PreciseShardingAlgorithm,用于根据订单创建时间将数据路由到不同的表中。

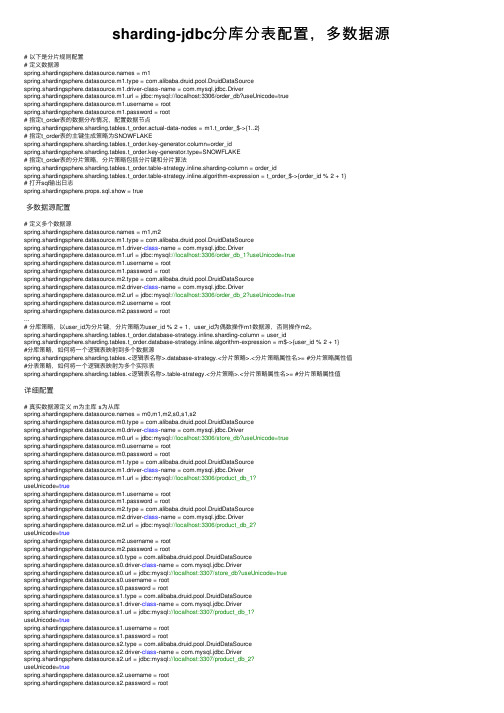

sharding-jdbc分库分表配置,多数据源

sharding-jdbc分库分表配置,多数据源# 以下是分⽚规则配置# 定义数据源s = m1spring.shardingsphere.datasource.m1.type = com.alibaba.druid.pool.DruidDataSourcespring.shardingsphere.datasource.m1.driver‐class‐name = com.mysql.jdbc.Driverspring.shardingsphere.datasource.m1.url = jdbc:mysql://localhost:3306/order_db?useUnicode=trueername = rootspring.shardingsphere.datasource.m1.password = root# 指定t_order表的数据分布情况,配置数据节点spring.shardingsphere.sharding.tables.t_order.actual‐data‐nodes = m1.t_order_$‐>{1..2}# 指定t_order表的主键⽣成策略为SNOWFLAKEspring.shardingsphere.sharding.tables.t_order.key‐generator.column=order_idspring.shardingsphere.sharding.tables.t_order.key‐generator.type=SNOWFLAKE# 指定t_order表的分⽚策略,分⽚策略包括分⽚键和分⽚算法spring.shardingsphere.sharding.tables.t_order.table‐strategy.inline.sharding‐column = order_idspring.shardingsphere.sharding.tables.t_order.table‐strategy.inline.algorithm‐expression = t_order_$‐>{order_id % 2 + 1}# 打开sql输出⽇志spring.shardingsphere.props.sql.show = true多数据源配置# 定义多个数据源s = m1,m2spring.shardingsphere.datasource.m1.type = com.alibaba.druid.pool.DruidDataSourcespring.shardingsphere.datasource.m1.driver‐class‐name = com.mysql.jdbc.Driverspring.shardingsphere.datasource.m1.url = jdbc:mysql://localhost:3306/order_db_1?useUnicode=trueername = rootspring.shardingsphere.datasource.m1.password = rootspring.shardingsphere.datasource.m2.type = com.alibaba.druid.pool.DruidDataSourcespring.shardingsphere.datasource.m2.driver‐class‐name = com.mysql.jdbc.Driverspring.shardingsphere.datasource.m2.url = jdbc:mysql://localhost:3306/order_db_2?useUnicode=trueername = rootspring.shardingsphere.datasource.m2.password = root...# 分库策略,以user_id为分⽚键,分⽚策略为user_id % 2 + 1,user_id为偶数操作m1数据源,否则操作m2。

数据库分库分表与数据切片的实施方法

数据库分库分表与数据切片的实施方法在现代互联网应用的快速发展过程中,数据库的性能和扩展能力成为了亟待解决的难题。

传统的单一数据库架构已经很难满足高并发访问和海量数据存储的需求。

为了解决这个问题,数据库分库分表和数据切片成为了常用的解决方案。

本文将详细介绍数据库分库分表与数据切片的实施方法。

数据库分库分表是指将一个大型的数据库拆分成多个独立的小数据库(分库)和表拆分成多个较小的表(分表),从而实现数据库的水平扩展和负载均衡。

数据库分库分表的实施方法包括以下几个步骤:第一步,需求分析:在进行数据库分库分表之前,需要对现有系统的业务需求进行充分的了解和分析。

根据业务需求和数据库的读写比例,确定需要拆分的库和表,以及分库分表的策略和规则。

第二步,数据拆分:一旦确定了分库分表的策略和规则,就可以开始进行数据的拆分。

在进行数据拆分时,需要考虑到数据库的主键和外键关系,并根据业务需求进行数据的水平划分,使得每个分库分表之间的数据量相对均衡。

第三步,数据同步:数据分库分表之后,不同的库和表之间的数据同步成为了一个问题。

为了确保数据的一致性,可以采用同步工具或者自定义的同步程序进行数据同步。

常用的同步方法包括主从复制、分布式事务等。

第四步,查询路由:在客户端进行数据库查询时,需要通过合适的方式将查询请求路由到正确的库和表上。

为了实现查询路由,可以使用分库分表的中间件或者自定义的路由程序。

第五步,数据迁移:在完成数据分库分表之后,可能需要将现有的数据迁移到新的数据库中。

数据迁移的过程中,需要考虑到数据的一致性和完整性,并选择合适的迁移方案和工具。

数据切片是指将一个大型的数据集合分散存储在多个节点中,从而实现数据的分布式存储和查询。

数据切片的实施方法包括以下几个步骤:第一步,数据切分:在进行数据切片之前,需要对现有的数据集合进行充分的了解和分析。

根据数据的特点和查询的模式,确定需要切分的字段和切分的规则。

第二步,数据分布:一旦确定了数据切分的规则,就可以开始进行数据的分布存储。

说说分库与分表的设计

说说分库与分表的设计分库与分表是在数据库设计中常用的水平切分(Horizontal Partitioning)策略,用于提高数据库的性能、扩展性和可维护性。

下面分别介绍分库与分表的设计思想:分库(Sharding)1. 定义:分库是将一个大型数据库按照某种规则划分成多个独立的数据库实例。

每个数据库实例可以独立运行在不同的物理服务器上。

2. 设计思想:•垂直切分:将数据库中的表按照功能模块或业务划分到不同的数据库中。

例如,将用户信息表、订单表分别存放在不同的数据库中。

•水平切分:将数据库中的某个表按照一定的规则(例如,按照用户ID、时间范围等)划分成多个分片,每个分片存放在不同的数据库中。

3. 优势:•提高了数据库的并发处理能力,因为不同的数据库实例可以并行处理请求。

•更好地支持水平扩展,可以将不同的数据库实例分布在不同的物理服务器上。

4. 挑战:•事务处理的复杂性增加,需要考虑分布式事务的一致性。

•跨分片的查询可能变得复杂,需要通过分布式查询或中间层进行处理。

分表(Sharding)1. 定义:分表是将一个大型表按照某种规则划分成多个独立的子表。

每个子表可以独立存储数据,从而降低单表的数据量。

2. 设计思想:•水平切分:将表按照某个规则划分成多个子表,每个子表存储部分数据。

例如,可以按照用户ID、时间范围等划分。

•垂直切分:将表按照列划分,不同的子表包含不同的列。

例如,将一个包含大量列的表划分成多个只包含相关列的子表。

3. 优势:•提高了表的查询性能,因为每个子表的数据量相对较小。

•更好地支持水平扩展,可以将不同的子表存储在不同的物理存储介质上。

4. 挑战:•需要维护分表之间的关联关系,例如,跨表的查询可能需要通过联合查询进行。

•事务处理可能涉及到多个分表,需要考虑分布式事务的问题。

综合考虑:1. 联合使用:在实际应用中,可以联合使用分库和分表的策略,以更好地满足系统的需求。

2. 分布式缓存:在分库分表的架构中,使用分布式缓存(如Redis)来缓存热点数据,减轻数据库的压力。

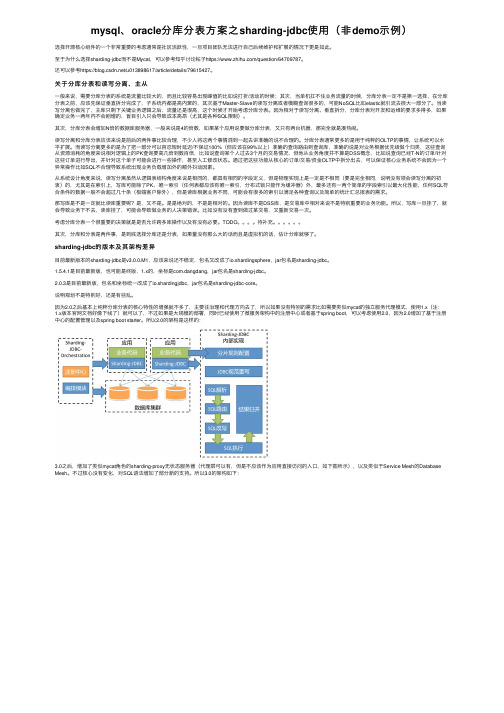

mysql、oracle分库分表方案之sharding-jdbc使用(非demo示例)

mysql、oracle分库分表⽅案之sharding-jdbc使⽤(⾮demo⽰例)选择开源核⼼组件的⼀个⾮常重要的考虑通常是社区活跃性,⼀旦项⽬团队⽆法进⾏⾃⼰后续维护和扩展的情况下更是如此。

⾄于为什么选择sharding-jdbc⽽不是Mycat,可以参考知乎讨论帖⼦https:///question/64709787。

还可以参考https:///u013898617/article/details/79615427。

关于分库分表和读写分离、主从⼀般来说,需要分库分表的系统是流量⽐较⼤的,⽽且⽐较容易出现峰值的⽐如说打折/活动的时候;其次,当单机扛不住业务流量的时候,分库分表⼀定不是第⼀选择,在分库分表之前,应该先保证垂直拆分完成了,⼦系统内都是⾼内聚的,其次基于Master-Slave的读写分离或者模糊查询很多的,可能NoSQL⽐如elastic就引流去很⼤⼀部分了。

当读写分离也做完了,主库只剩下关键业务逻辑之后,流量还是很⾼,这个时候才开始考虑分库分表。

因为相对于读写分离、垂直拆分,分库分表对开发和运维的要求多得多,如果确定业务⼀两年内不会剧增的,盲⽬引⼊只会导致成本⾼昂(尤其是各种SQL限制)。

其次,分库分表会增加N倍的数据库服务器,⼀般来说是4的倍数,如果某个应⽤说要做分库分表,⼜只有两台机器,那完全就是凑热闹。

读写分离和分库分表应该来说是前后的两件事⽐较合理,不少⼈将这两个事情混到⼀起去讲准确的说不合理的。

分库分表通常更多的是⽤于纯粹的OLTP的事情,让系统可以⽔平扩展。

⽽读写分离更多的是为了把⼀部分可以容忍短时延迟/不保证100%(但应该在99%以上)准确的查询路由到查询库,准确的说是对业务根据优先级做个归类,这些查询从资源消耗的⾓度来说相对逻辑上的PK查询要⾼⼏倍到数百倍,⽐如说查询某个⼈过去3个⽉的交易情况,但他从业务⾓度并不算是DSS概念,⽐如说查询已经T-N的订单/针对这些订单进⾏导出,并针对这个单⼦可能会进⾏⼀些操作,甚⾄⼈⼯修改状态。

mysql大表拆分方案

在面对大表拆分的问题时,可以考虑以下方案:

1. 垂直拆分(Vertical Partitioning):将原始大表按照业务或数据类型进行拆分,每个拆分后的表只包含部分列。

这种方式可以减少单个表的数据量和字段数目,提高查询性能。

但需要注意的是,垂直拆分可能会引入多表关联查询的开销。

2. 水平拆分(Horizontal Partitioning):按照某个条件将原始大表中的数据行划分到多个子表中,例如按照时间范围、地理区域等。

这样可以将数据均匀分布到多个表中,减少单个表的数据量,提高并发处理能力和查询性能。

但需要注意的是,水平拆分可能会引入跨表查询的开销。

3. 分库分表(Sharding):将原始大表划分到多个数据库实例中,每个实例再分成多个表。

这样可以将数据分散到多个数据库中,实现读写负载均衡。

但需要注意的是,分库分表会增加系统复杂度和维护成本,可能需要额外的中间件支持。

4. 数据归档(Data Archiving):将历史数据从原始大表中迁移到归档表中,只保留最新的活跃数据在原始表中。

这样可以缩小原始表的规模,提高查询性能。

但需要注意的是,归档数据的访问可能需要特殊处理。

选择适合的拆分方案需要综合考虑业务需求、数据特点、系统架构和资源成本等因素。

在拆分过程中,还需要考虑数据迁移、一致性维护、查询优化等问题,并建立相应的监控和管理机制来保证系统的稳定性和可用性。

分库分表的几种实现形式

分库分表的几种实现形式伴随着互联网技术的快速发展,企业的业务规模不断扩大,数据库规模也在不断增加,而单机的性能有限,以及单机的系统的扩展性差,让不少企业无法满足业务需求和容量需求,这时候就要求数据库管理者对数据库进行分库分表,以提高系统的并发性、可用性和性能,加快系统的处理能力。

一、什么是分库分表分库分表(Sharding),是把数据存储到多个数据库或表中,以提高系统的性能。

分库分表的思想是:把一个大的数据表拆分成多个小的数据表,分别存储在不同的数据库或表中,以减轻单台数据库的压力,提高性能和可用性,同时可以实现有效的数据库扩容。

二、分库分表的实现形式1、水平分库分表:水平分库分表是按照某一个字段进行拆分,比如将所有以A开头的记录放到一个库里,以B开头的放到另一个库里,以此类推,可以有效的实现对数据库的分库和表的分表。

2、垂直分库分表:垂直分库分表是把表的某一些字段提取出来,作为一个完整的表存在单独的库里。

比如一张客户表,表中有客户的基本信息,下单信息,收货地址等信息,如果将这张表拆分成多个表,将客户的基本信息存放在一张表里,下单信息和收货地址分别存放在另一张表里,可以更有效的使用数据库资源,并减少查询次数。

3、混合分库分表:混合分库分表方式是将水平分库和垂直分库分表结合使用,混合分库分表可以更有效的优化系统性能和可用性,同时减少分库分表所需要的开发成本和维护成本。

三、分库分表的优势1、可以有效的提高数据库的可用性和性能,可以支持更多的并发量,更稳定的提供服务。

2、可以更灵活的进行扩容,可以更节省的成本,同时可以更简单的把一个大表拆分成多个小表,分别存放在不同的库中,避免一台数据库机器的性能和容量单一性,使数据库能够进行更加灵活的扩展,以满足业务的需求。

3、可以增加数据的横向扩展能力,更容易实现分布式,提高平台的可用性和安全。

四、分库分表的缺点1、需要充分的数据库设计,以提高系统的可用性和性能。

在MySQL中如何进行数据分片和水平拆分

在MySQL中如何进行数据分片和水平拆分引言在当今的互联网时代,数据量的增长是不可避免的。

针对大规模数据集的存储和处理,数据分片和水平拆分成为了一种常用的解决方案。

在众多数据库中,MySQL也提供了相关的功能和工具,本文将介绍在MySQL中如何进行数据分片和水平拆分。

一、什么是数据分片和水平拆分数据分片(Sharding)是指将庞大的数据集划分为多个子集,分别存储在不同的数据库节点上。

每个数据库节点负责存储和处理一部分数据,从而实现了数据的分布式存储和查询。

水平拆分(Horizontal Partitioning)则是指按照某个字段或规则对数据进行拆分和分片,使得数据在多个节点上分布均匀。

数据分片和水平拆分的优势在于提升数据库的吞吐量和性能,减轻单个节点的负担,提高系统的可扩展性和稳定性。

二、MySQL中的数据分片技术MySQL提供了多种数据分片的技术和工具,下面将介绍其中的几种常用方法。

1. 哈希分片哈希分片是通过对某个字段进行哈希计算,将数据分配到不同的节点上。

一种常用的哈希函数是MD5,它能够将任意长度的输入转换为固定长度的哈希值。

在分片的过程中,将数据的哈希值与节点的哈希范围进行比较,确定数据所属的节点。

哈希分片的优势在于均衡地分配数据,但无法按照特定的查询条件进行路由。

2. 范围分片范围分片是按照某个字段的范围将数据划分到不同的节点上。

比如按照用户ID的范围进行分片,可以将ID在1-10000的用户数据存储在节点1上,ID在10001-20000的用户数据存储在节点2上,以此类推。

范围分片的优势在于能够按照特定的查询条件进行路由,但可能存在数据不均衡的问题。

3. 列分片列分片是按照某个字段的取值将数据划分到不同的节点上。

比如按照地区将数据进行分片,可以将北京地区的数据存储在节点1上,上海地区的数据存储在节点2上,以此类推。

列分片的优势在于能够按照特定的查询条件进行路由,且更容易实现数据均衡。

sharding-jdbc结合mybatis实现分库分表功能

sharding-jdbc结合mybatis实现分库分表功能 最近忙于项⽬已经好久⼏天没写博客了,前2篇⽂章我给⼤家介绍了搭建基础springMvc+mybatis的maven⼯程,这个简单框架已经可以对付⼀般的⼩型项⽬。

但是我们实际项⽬中会碰到很多复杂的场景,⽐如数据量很⼤的情况下如何保证性能。

今天我就给⼤家介绍数据库分库分表的优化,本⽂介绍mybatis结合当当⽹的sharding-jdbc分库分表技术(原理这⾥不做介绍) ⾸先在pom⽂件中引⼊需要的依赖<dependency><groupId>com.dangdang</groupId><artifactId>sharding-jdbc-core</artifactId><version>1.4.2</version></dependency><dependency><groupId>com.dangdang</groupId><artifactId>sharding-jdbc-config-spring</artifactId><version>1.4.0</version></dependency> ⼆、新建⼀个sharding-jdbc.xml⽂件,实现分库分表的配置<?xml version="1.0" encoding="UTF-8"?><beans xmlns="/schema/beans"xmlns:xsi="/2001/XMLSchema-instance"xmlns:context="/schema/context"xmlns:tx="/schema/tx"xmlns:rdb="/schema/ddframe/rdb"xsi:schemaLocation="/schema/beans/schema/beans/spring-beans.xsd/schema/tx/schema/tx/spring-tx.xsd/schema/context/schema/context/spring-context.xsd/schema/ddframe/rdb/schema/ddframe/rdb/rdb.xsd"><rdb:strategy id="tableShardingStrategy" sharding-columns="user_id" algorithm-class="mon.sharding.MemberSingleKeyTableShardingAlgorithm"/><rdb:data-source id="shardingDataSource"><rdb:sharding-rule data-sources="dataSource"><rdb:table-rules><rdb:table-rule logic-table="member_index" actual-tables="member_index_tbl_${[0,1,2,3,4,5,6,7,8,9]}${0..9}" table-strategy="tableShardingStrategy"/><rdb:table-rule logic-table="member_details" actual-tables="member_details_tbl_${[0,1,2,3,4,5,6,7,8,9]}${0..9}" table-strategy="tableShardingStrategy"/></rdb:table-rules></rdb:sharding-rule></rdb:data-source><bean id="transactionManager" class="org.springframework.jdbc.datasource.DataSourceTransactionManager"><property name="dataSource" ref="shardingDataSource"/></bean></beans> 这⾥我简单介绍下⼀些属性的含义, <rdb:strategy id="tableShardingStrategy" sharding-columns="user_id" algorithm-class="mon.sharding.MemberSingleKeyTableShardingAlgorithm"/> 配置分表规则器sharding-columns:分表规则 依赖的名(根据user_id取模分表),algorithm-class:分表规则的实现类 <rdb:sharding-rule data-sources="dataSource"> 这⾥填写关联数据源(多个数据源⽤逗号隔开), <rdb:table-rule logic-table="member_index" actual-tables="member_index_tbl_${[0,1,2,3,4,5,6,7,8,9]}${0..9}" table-strategy="tableShardingStrategy"/> logic-table:逻辑表名(mybatis中代替的表名)actual-tables: 数据库实际的表名,这⾥⽀持inline表达式,⽐如:member_index_tbl_${0..2}会解析成member_index_tbl_0,member_index_tbl_1,member_index_tbl_2;member_index_tbl_${[a,b,c]}会被解析成 member_index_tbl_a,member_index_tbl_b和member_index_tbl_c,两种表达式⼀起使⽤的时候,会采取笛卡尔积的⽅式:member_index_tbl_${[a,b]}${0..2}解析为member_index_tbl_a0,member_index_tbl_a1member_index_tbl_a2,member_index_tbl_b0,member_index_tbl_b1,member_index_tbl_b2;table-strategy:前⾯定义的分表规则器;三、配置好改⽂件后,需要修改之前我们的spring-dataSource的⼏个地⽅,把sqlSessionFactory和transactionManager原来关联的dataSource统⼀修改为shardingDataSource(这⼀步作⽤就是把数据源全部托管给sharding去管理) 四、实现分表(分库)逻辑,我们的分表逻辑类需要实现SingleKeyTableShardingAlgorithm接⼝的三个⽅法doBetweenSharding、doEqualSharding、doInSharding/*** 分表逻辑* @author zhangwentao**/public class MemberSingleKeyTableShardingAlgorithm implements SingleKeyTableShardingAlgorithm<Long> {/*** sql between 规则*/public Collection<String> doBetweenSharding(Collection<String> tableNames, ShardingValue<Long> shardingValue) {Collection<String> result = new LinkedHashSet<String>(tableNames.size());Range<Long> range = (Range<Long>) shardingValue.getValueRange();for (long i = range.lowerEndpoint(); i <= range.upperEndpoint(); i++) {Long modValue = i % 100;String modStr = modValue < 10 ? "0" + modValue : modValue.toString();for (String each : tableNames) {if (each.endsWith(modStr)) {result.add(each);}}}return result;}/*** sql == 规则*/public String doEqualSharding(Collection<String> tableNames, ShardingValue<Long> shardingValue) {Long modValue = shardingValue.getValue() % 100;String modStr = modValue < 10 ? "0" + modValue : modValue.toString();for (String each : tableNames) {if (each.endsWith(modStr)) {return each;}}throw new IllegalArgumentException();}/*** sql in 规则*/public Collection<String> doInSharding(Collection<String> tableNames, ShardingValue<Long> shardingValue) {Collection<String> result = new LinkedHashSet<String>(tableNames.size());for (long value : shardingValue.getValues()) {Long modValue = value % 100;String modStr = modValue < 10 ? "0" + modValue : modValue.toString();for (String tableName : tableNames) {if (tableName.endsWith(modStr)) {result.add(tableName);}}}return result;}}五、以上四步,我们就完成了sharding-jdbc的搭建,我们可以写⼀个测试demo来检查我们的成果<select id="getDetailsById" resultType="com.meiren.member.dataobject.MemberDetailsDO"parameterType="ng.Long">select user_id userId ,qq,email from member_details where user_id =#{userId} limit 1</select>private static final String SERVICE_PROVIDER_XML = "/spring/member-service.xml";private static final String BEAN_NAME = "idcacheService";private ClassPathXmlApplicationContext context = null;IdcacheServiceImpl bean = null;IdcacheDao idcacheDao;@Beforepublic void before() {context= new ClassPathXmlApplicationContext(new String[] {SERVICE_PROVIDER_XML});idcacheDao=context.getBean("IdcacheDao", IdcacheDao.class);}@Testpublic void getAllCreditActionTest() {// int id = bean.insertIdcache();Long s=100l;MemberDetailsDO memberDetailsDO=idcacheDao.getDetailsById(s);System.out.println("QQ---------------------"+memberDetailsDO.getQq());} 打印sql语句,输出结果:QQ-------------------------------------100,证明成功! 注意点:这次搭建过程中,我有碰到⼀个⼩坑,就是执⾏的时候会报错:,官⽅⽂档是有解决⽅案:引⼊ <context:property-placeholderlocation="classpath:/member_service.properties" ignore-unresolvable="true" /> ,引⼊这⾏代码的时候,·必须要要把这边管理配配置⽂件的bean删除,换句话说,即Spring容器仅允许最多定义⼀个PropertyPlaceholderConfigurer(或<context:property-placeholder/>),其余的会被Spring忽略掉(当时搞了半天啊)⼩结:这次给⼤家分享了sharding-jdbc的配置是为了解决⼤数据量进⾏分库分表的架构,下⼀张,我将介绍拆分业务所需的duboo+zookeeper的配置(分布式),欢迎关注!。

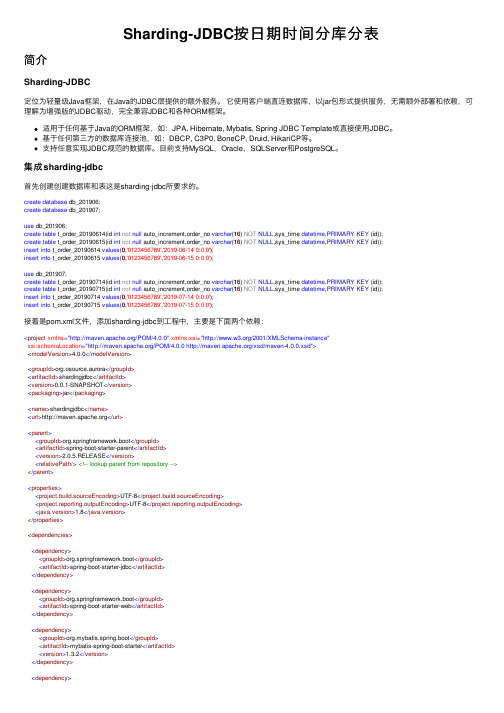

Sharding-JDBC按日期时间分库分表

Sharding-JDBC按⽇期时间分库分表简介Sharding-JDBC定位为轻量级Java框架,在Java的JDBC层提供的额外服务。

它使⽤客户端直连数据库,以jar包形式提供服务,⽆需额外部署和依赖,可理解为增强版的JDBC驱动,完全兼容JDBC和各种ORM框架。

适⽤于任何基于Java的ORM框架,如:JPA, Hibernate, Mybatis, Spring JDBC Template或直接使⽤JDBC。

基于任何第三⽅的数据库连接池,如:DBCP, C3P0, BoneCP, Druid, HikariCP等。

⽀持任意实现JDBC规范的数据库。

⽬前⽀持MySQL,Oracle,SQLServer和PostgreSQL。

集成sharding-jdbc⾸先创建创建数据库和表这是sharding-jdbc所要求的。

create database db_201906;create database db_201907;use db_201906;create table t_order_20190614(id int not null auto_increment,order_no varchar(16) NOT NULL,sys_time datetime,PRIMARY KEY (id));create table t_order_20190615(id int not null auto_increment,order_no varchar(16) NOT NULL,sys_time datetime,PRIMARY KEY (id));insert into t_order_20190614 values(0,'0123456789','2019-06-14 0:0:0');insert into t_order_20190615 values(0,'0123456789','2019-06-15 0:0:0');use db_201907;create table t_order_20190714(id int not null auto_increment,order_no varchar(16) NOT NULL,sys_time datetime,PRIMARY KEY (id));create table t_order_20190715(id int not null auto_increment,order_no varchar(16) NOT NULL,sys_time datetime,PRIMARY KEY (id));insert into t_order_20190714 values(0,'0123456789','2019-07-14 0:0:0');insert into t_order_20190715 values(0,'0123456789','2019-07-15 0:0:0');接着是pom.xml⽂件,添加sharding-jdbc到⼯程中,主要是下⾯两个依赖:<project xmlns="/POM/4.0.0" xmlns:xsi="/2001/XMLSchema-instance"xsi:schemaLocation="/POM/4.0.0 /xsd/maven-4.0.0.xsd"><modelVersion>4.0.0</modelVersion><groupId>org.osource.aurora</groupId><artifactId>shardingjdbc</artifactId><version>0.0.1-SNAPSHOT</version><packaging>jar</packaging><name>shardingjdbc</name><url></url><parent><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-parent</artifactId><version>2.0.5.RELEASE</version><relativePath/><!-- lookup parent from repository --></parent><properties><project.build.sourceEncoding>UTF-8</project.build.sourceEncoding><project.reporting.outputEncoding>UTF-8</project.reporting.outputEncoding><java.version>1.8</java.version></properties><dependencies><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-jdbc</artifactId></dependency><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-web</artifactId></dependency><dependency><groupId>org.mybatis.spring.boot</groupId><artifactId>mybatis-spring-boot-starter</artifactId><version>1.3.2</version></dependency><dependency><groupId>mysql</groupId><artifactId>mysql-connector-java</artifactId></dependency><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-test</artifactId><scope>test</scope></dependency><!--sharding-jdbc --><dependency><groupId>io.shardingjdbc</groupId><artifactId>sharding-jdbc-core</artifactId><version>2.0.3</version></dependency><dependency><groupId>commons-dbcp</groupId><artifactId>commons-dbcp</artifactId><version>1.3</version></dependency></dependencies><build><plugins><plugin><groupId>org.apache.maven.plugins</groupId><artifactId>maven-scm-plugin</artifactId><version>1.9.4</version><configuration><connectionType>developerConnection</connectionType></configuration></plugin><plugin><groupId>org.apache.maven.plugins</groupId><artifactId>maven-release-plugin</artifactId><version>2.5.3</version><configuration><releaseProfiles>release</releaseProfiles><autoVersionSubmodules>true</autoVersionSubmodules><tagBase>https:///sharding/shardingjdbc-framework.git</tagBase><tagNameFormat>v@{project.version}</tagNameFormat></configuration></plugin><plugin><groupId>org.apache.maven.plugins</groupId><artifactId>maven-javadoc-plugin</artifactId><configuration><skip>true</skip><aggregate>true</aggregate><charset>UTF-8</charset><encoding>UTF-8</encoding><docencoding>UTF-8</docencoding></configuration></plugin><plugin><groupId>org.apache.maven.plugins</groupId><artifactId>maven-jar-plugin</artifactId><configuration><excludes><exclude>**/*.xml</exclude></excludes></configuration></plugin><plugin><groupId>org.apache.maven.plugins</groupId><artifactId>maven-compiler-plugin</artifactId><configuration><source>1.8</source><target>1.8</target><encoding>UTF-8</encoding></configuration></plugin><plugin><groupId>org.apache.maven.plugins</groupId><artifactId>maven-surefire-plugin</artifactId><configuration><!-- 设置成true在使⽤maven打包发布时不做junit测试 --><skip>true</skip></configuration></plugin></plugins></build></project>⾸先是数据源配置和库策略、表策略:import java.sql.SQLException;import java.util.HashMap;import java.util.Map;import java.util.Properties;import java.util.concurrent.ConcurrentHashMap;import javax.sql.DataSource;import mons.dbcp.BasicDataSource;import org.apache.ibatis.session.SqlSessionFactory;import org.mybatis.spring.SqlSessionFactoryBean;import org.mybatis.spring.SqlSessionTemplate;import org.springframework.beans.factory.annotation.Value;import org.springframework.boot.context.properties.ConfigurationProperties;import org.springframework.context.annotation.Bean;import org.springframework.context.annotation.Configuration;import org.springframework.context.annotation.Primary;import org.springframework.core.io.support.PathMatchingResourcePatternResolver;import org.springframework.jdbc.datasource.DataSourceTransactionManager;import io.shardingjdbc.core.api.config.ShardingRuleConfiguration;import io.shardingjdbc.core.api.config.TableRuleConfiguration;import io.shardingjdbc.core.api.config.strategy.StandardShardingStrategyConfiguration;import io.shardingjdbc.core.jdbc.core.datasource.ShardingDataSource;@Configurationpublic class ShardingDataSourceConfiguration {@Value("${ername:root}")private String username;@Value("${spring.datasource.password:123456}")private String password;@Value("${spring.datasource.url}")private String jdbcUrl;@Value("${spring.datasource.driver-class-name}")private String driverClassName;@Value("${shardingjdbc.sql.show:true}")private String sqlShow;@Value("${mybatis.mapper-locations:mappper/**/*.xml}")private String mapperLocations;// 配置sharding-jdbc的DataSource,给上层应⽤使⽤,这个DataSource包含所有的逻辑库和逻辑表,应⽤增删改查时,修改对应sql // 然后选择合适的数据库继续操作。

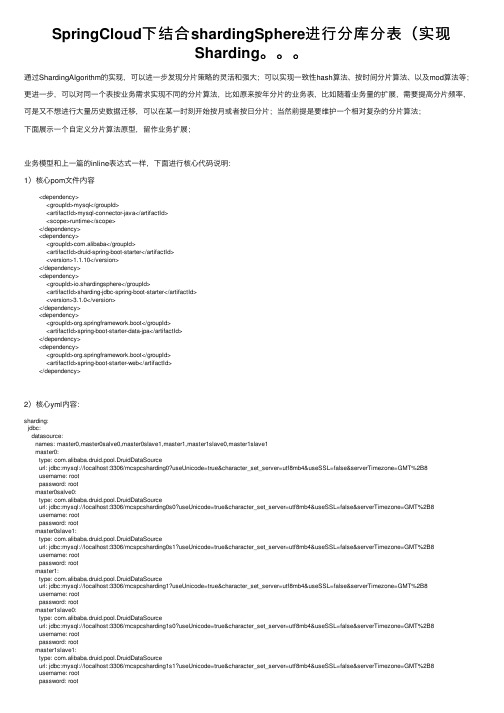

SpringCloud下结合shardingSphere进行分库分表(实现Sharding。。。

SpringCloud下结合shardingSphere进⾏分库分表(实现Sharding。

通过ShardingAlgorithm的实现,可以进⼀步发现分⽚策略的灵活和强⼤;可以实现⼀致性hash算法、按时间分⽚算法、以及mod算法等;更进⼀步,可以对同⼀个表按业务需求实现不同的分⽚算法,⽐如原来按年分⽚的业务表,⽐如随着业务量的扩展,需要提⾼分⽚频率,可是⼜不想进⾏⼤量历史数据迁移,可以在某⼀时刻开始按⽉或者按⽇分⽚;当然前提是要维护⼀个相对复杂的分⽚算法;下⾯展⽰⼀个⾃定义分⽚算法原型,留作业务扩展;业务模型和上⼀篇的inline表达式⼀样,下⾯进⾏核⼼代码说明:1)核⼼pom⽂件内容<dependency><groupId>mysql</groupId><artifactId>mysql-connector-java</artifactId><scope>runtime</scope></dependency><dependency><groupId>com.alibaba</groupId><artifactId>druid-spring-boot-starter</artifactId><version>1.1.10</version></dependency><dependency><groupId>io.shardingsphere</groupId><artifactId>sharding-jdbc-spring-boot-starter</artifactId><version>3.1.0</version></dependency><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-data-jpa</artifactId></dependency><dependency><groupId>org.springframework.boot</groupId><artifactId>spring-boot-starter-web</artifactId></dependency>2)核⼼yml内容:sharding:jdbc:datasource:names: master0,master0salve0,master0slave1,master1,master1slave0,master1slave1master0:type: com.alibaba.druid.pool.DruidDataSourceurl: jdbc:mysql://localhost:3306/mcspcsharding0?useUnicode=true&character_set_server=utf8mb4&useSSL=false&serverTimezone=GMT%2B8username: rootpassword: rootmaster0salve0:type: com.alibaba.druid.pool.DruidDataSourceurl: jdbc:mysql://localhost:3306/mcspcsharding0s0?useUnicode=true&character_set_server=utf8mb4&useSSL=false&serverTimezone=GMT%2B8username: rootpassword: rootmaster0slave1:type: com.alibaba.druid.pool.DruidDataSourceurl: jdbc:mysql://localhost:3306/mcspcsharding0s1?useUnicode=true&character_set_server=utf8mb4&useSSL=false&serverTimezone=GMT%2B8username: rootpassword: rootmaster1:type: com.alibaba.druid.pool.DruidDataSourceurl: jdbc:mysql://localhost:3306/mcspcsharding1?useUnicode=true&character_set_server=utf8mb4&useSSL=false&serverTimezone=GMT%2B8username: rootpassword: rootmaster1slave0:type: com.alibaba.druid.pool.DruidDataSourceurl: jdbc:mysql://localhost:3306/mcspcsharding1s0?useUnicode=true&character_set_server=utf8mb4&useSSL=false&serverTimezone=GMT%2B8username: rootpassword: rootmaster1slave1:type: com.alibaba.druid.pool.DruidDataSourceurl: jdbc:mysql://localhost:3306/mcspcsharding1s1?useUnicode=true&character_set_server=utf8mb4&useSSL=false&serverTimezone=GMT%2B8username: rootpassword: rootconfig:sharding:tables:mc_member:actual-nodes: mcspcsharding$->{0..1}.mc_member$->{0..1}database-strategy:standard:sharding-column: genderprecise-algorithm-class-name: com.chong.mcspcshardingdbtable.sharding.DbShardingAlgorithmtable-strategy:complex:sharding-columns: idalgorithm-class-name: com.chong.mcspcshardingdbtable.sharding.MemberTblComplexKeyShardingbinding-tables: mc_member # 多个时逗号隔开broadcast-tables: mc_mastermaster-slave-rules:ms0:master-data-source-name: master0slave-data-source-names: master0salve0,master0slave1ms1:master-data-source-name: master1slave-data-source-names: master1slave0,master1slave1props:sql:show: true3)database数据源的sharding算法,实现了PreciseShardingAlgorithmpackage com.chong.mcspcshardingdbtable.sharding;import io.shardingsphere.api.algorithm.sharding.PreciseShardingValue;import io.shardingsphere.api.algorithm.sharding.standard.PreciseShardingAlgorithm;import ponent;import java.util.Collection;@Componentpublic class DbShardingAlgorithm implements PreciseShardingAlgorithm<Integer> {@Overridepublic String doSharding(Collection<String> collection, PreciseShardingValue<Integer> preciseShardingValue) { Integer index = preciseShardingValue.getValue() % 2;for (String dataSourceName : collection) {if (dataSourceName.endsWith(index + "")) {return dataSourceName;}}throw new UnsupportedOperationException();}}4)table的sharding算法,实现了ComplexKeysShardingAlgorithmpackage com.chong.mcspcshardingdbtable.sharding;import mon.collect.Range;import io.shardingsphere.api.algorithm.sharding.ListShardingValue;import io.shardingsphere.api.algorithm.sharding.PreciseShardingValue;import io.shardingsphere.api.algorithm.sharding.RangeShardingValue;import io.shardingsphere.api.algorithm.sharding.ShardingValue;import plexKeysShardingAlgorithm;import ponent;import java.util.ArrayList;import java.util.Collection;import java.util.List;/*** 通过复合分⽚键进⾏演⽰,覆盖Precise,Range,List三种类型的ShardingValue。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

一、基本思想Sharding的基本思想就要把一个数据库切分成多个部分放到不同的数据库(server)上,从而缓解单一数据库的性能问题。

对于海量数据的数据库,如果是因为表多而数据多,这时候适合使用垂直切分,即把关系紧密(比如同一模块)的表切分出来放在一个服务器上。

如果表并不多,但每张表的数据非常多,这时候适合水平切分,即把表的数据按某种规则(比如按ID散列)切分到多个数据库(server)上。

根据实际情况做出选择,也可能会综合使用垂直与水平切分。

1、垂直切分数据的垂直切分,也可以称之为纵向切分。

将数据库想象成为由很多个一大块一大块的“数据块”(表)组成,我们垂直的将这些数据块切开,然后将他们分散到多台数据库主机上面,这样的切分方法就是一个垂直(纵向)的数据切分。

系统功能可以基本分为以下四个功能模块:用户、群组消息、相册以及事件,分别对应为如下这些表:1.用户模块表user、user_profile、user_group、user_photo_album2.群组讨论表 groups、group_message、group_message_content、top_message3.相册相关表 photo、photo_album、photo_album_relation、photo_comment4.事件信息表 event模块之间的关系:1.群组讨论模块和用户模块之间主要存在通过用户或者是群组关系来进行关联。

一般关联的时候都会是通过用户id或者nick_name以及group的 id来进行关联,,通过模块之间的接口实现不会带来太多麻烦。

2.相册模块仅仅与用户模块存在通过用户的关联。

这两个模块之间的关联基本就有通过用户id关联的内容,简单清晰,接口明确。

3.事件模块与各个模块可能都有关联,但是都只关注其各个模块中对象的信息ID,同样可以做到很容易分拆。

所以,我们第一步可以将数据库按照功能模块相关的表进行一次垂直拆分,每个模块涉及的表单独到一个数据库中,模块与模块之间的表关联都在应用系统端通过接口来处理。

如下图所示:通过这样的垂直切分之后,之前只能通过一个数据库来提供的服务,就被分拆成四个数据库来提供服务,服务能力自然是增加几倍了。

垂直切分的优点◆数据库的拆分简单明了,拆分规则明确◆应用程序模块清晰明确,整合容易◆数据维护方便易行,容易定位垂直切分的缺点◆部分表关联无法在数据库级别完成,需要在程序中完成◆对于访问极其频繁且数据量超大的表仍然存在性能平静,不一定能满足要求◆事务处理相对更为复杂◆切分达到一定程度之后,扩展性会遇到限制◆过度切分可能会带来系统过渡复杂而难以维护2、水平切分数据的水平切分,一般来说,简单的水平切分主要是将某个访问极其平凡的表再按照某个字段的某种规则来分散到多个表之中,每个表中包含一部分数据。

简单来说,我们可以将数据的水平切分理解为是按照数据行的切分,就是将表中的某些行切分到一个数据库,而另外的某些行又切分到其他的数据库中。

对于我们的示例数据库来说,大部分的表都可以根据用户ID来进行水平的切分,不同用户相关的数据进行切分之后存放在不同的数据库中。

如将所有用户ID通过2取模,然后分别存放于两个不同的数据库中,每个和用户ID关联上的表都可以这样切分。

这样,基本上每个用户相关的数据,都在同一个数据库中,即使是需要关联,也可以非常简单的关联上。

我们可以通过下图来更为直观的展示水平切分相关信息:水平切分的优点◆表关联基本能够在数据库端全部完成◆不会存在某些超大型数据量和高负载的表遇到瓶颈的问题◆应用程序端整体架构改动相对较少◆事务处理相对简单◆只要切分规则能够定义好,基本上较难遇到扩展性限制水平切分的缺点◆切分规则相对更为复杂,很难抽象出一个能够满足整个数据库的切分规则◆后期数据的维护难度有所增加,人为手工定位数据更困难◆应用系统各模块耦合度较高,可能会对后面数据的迁移拆分造成一定的困难3、垂直与水平联合切分一般来说,我们数据库中的所有表很难通过某一个(或少数几个)字段全部关联起来,所以很难简单的仅仅通过数据的水平切分来解决所有问题。

而垂直切分也只能解决部分问题,对于那些负载非常高的系统,即使仅仅只是单个表都无法通过单台数据库主机来承担其负载,我们必须结合“水平” 和“垂直”两种切分方式同时使用,充分利用两者的优点,避开其缺点。

每一个应用系统的负载都是一步一步增长上来的,在开始遇到性能瓶颈的时候,大多数架构师和DBA都会选择先进行数据的垂直拆分,然而,随着业务的不断扩张,系统负载的持续增长,在系统稳定一段时期之后,经过了垂直拆分之后的数据库集群可能又再一次不堪重负,遇到了性能瓶颈。

这时候我们就必须要通过数据的水平切分的优势,来解决这里所遇到的问题。

对于我们的示例数据库,假设在最开始,我们进行了数据的垂直切分,然而随着业务的不断增长,数据库系统遇到了瓶颈,我们选择重构数据库集群的架构。

如何重构?考虑到之前已经做好了数据的垂直切分,而且模块结构清晰明确。

而业务增长的势头越来越猛,即使现在进一步再次拆分模块,也坚持不了太久。

我们选择了在垂直切分的基础上再进行水平拆分。

在经历过垂直拆分后的各个数据库集群中的每一个都只有一个功能模块,而每个功能模切中的所有表基本上都会与某个字段进行关联。

如用户模块全部都可以通过用户ID进行切分,群组讨论模块则都通过群组ID 来切分,相册模块则根据相册 ID 分,最后的事件通知信息表考虑到数据的时限性(仅仅只会访问最近某个事件段的信息),则考虑按时间来切分。

下图展示了切分后的整个架构:在应对不同的应用场景的时候,也需要充分考虑到这两种切分方法各自的局限,以及各自的优势,在不同的时期(负载压力)使用不同的结合方式。

联合切分的优点◆可以充分利用垂直切分和水平切分各自的优势而避免各自的缺陷◆让系统扩展性得到最大化提升联合切分的缺点◆数据库系统架构比较复杂,维护难度更大◆应用程序架构也相对更复杂二、拆分实施策略和示例演示第一部分:实施策略1.准备阶段对数据库进行分库分表(Sharding化)前,需要充分了解系统业务逻辑和数据库schema.绘制一张数据库ER图,以图为基础划分shard,直观易行,可以确保清醒思路。

2.分析阶段1.垂直切分垂直切分的依据原则是:将业务紧密,表间关联密切的表划分在一起,例如同一模块的表。

结合已经准备好的数据库ER图或领域模型图,仿照活动图中的泳道概念,一个泳道代表一个shard,把所有表格划分到不同的泳道中。

下面的分析示例会展示这种做法。

这种方式多个数据库之间的表结构不同。

2.水平切分垂直切分后,需要对shard内表格的数据量和增速进一步分析,以确定是否需要进行水平切分。

这些数据库中的表结构完全相同。

2.1若划分到一起的表格数据增长缓慢,在产品上线后可遇见的足够长的时期内均可以由单一数据库承载,则不需要进行水平切分,所有表格驻留同一shard,所有表间关联关系会得到最大限度的保留,同时保证了书写SQL的自由度,不易受join、group by、order by等子句限制。

2.2若划分到一起的表格数据量巨大,增速迅猛,需要进一步进行水平分割。

进一步的水平分割就这样进行:2.2.1结合业务逻辑和表间关系,将当前shard划分成多个更小的shard,通常情况下,这些更小的shard每一个都只包含一个主表(将以该表ID进行散列的表)和多个与其关联或间接关联的次表。

这种一个shard一张主表多张次表的状况是水平切分的必然结果。

这样切分下来,shard数量就会迅速增多。

如果每一个shard代表一个独立的数据库,那么管理和维护数据库将会非常麻烦,而且这些小shard往往只有两三张表,为此而建立一个新库,利用率并不高,因此,在水平切分完成后可再进行一次“反向的Merge”,即:将业务上相近,并且具有相近数据增长速率(主表数据量在同一数量级上)的两个或多个shard 放到同一个数据库上,在逻辑上它们依然是独立的shard,有各自的主表,并依据各自主表的ID进行散列,不同的只是它们的散列取模(即节点数量)必需是一致的。

这样,每个数据库结点上的表格数量就相对平均了。

2.2.2 所有表格均划分到合适的shard之后,所有跨越shard的表间关联都必须打断,在书写sql时,跨shard的join、group by、order by 都将被禁止,需要在应用程序层面协调解决这些问题。

3.实施阶段如果项目在开发伊始就决定进行分库分表,则严格按照分析设计方案推进即可。

如果是在中期架构演进中实施,除搭建实现sharding逻辑的基础设施外,还需要对原有SQL逐一过滤分析,修改那些因为sharding而受到影响的sql。

第二部分:示例演示以下使用jpetstore(宠物店的电子商务系统)来演示如何进行分库分表(sharding)在分析阶段的工作。

jpetstore来自原ibatis官方的一个Demo 版本,SVN地址为:/svn/tags/java_release_2.3.4 -726/jpetstore-5由于系统较简单,我们很容易从模型上看出,其主要由三个模块组成:用户,产品和订单。

那么垂直切分的方案也就出来了。

接下来看水平切分,如果我们从一个实际的宠物店出发考虑,可能出现数据激增的单表应该是Account和Order,因此这两张表需要进行水平切分。

对于Product模块来说,如果是一个实际的系统,Product和Item的数量都不会很大,因此只做垂直切分就足够了,也就是(Product,Category,Item,Iventory,Supplier)五张表在一个数据库结点上(没有水平切分,不会存在两个以上的数据库结点)。

但是作为一个演示,我们假设产品模块也有大量的数据需要我们做水平切分,那么分析来看,这个模块要拆分出两个shard:一个是(Product(主),Category),另一个是(Item(主),Iventory,Supplier),同时,我们认为:这两个shard在数据增速上应该是相近的,且在业务上也很紧密,那么我们可以把这两个shard放在同一个数据库节点上,Item和Product数据在散列时取一样的模。

根据前文介绍的图纸绘制方法,我们得到下面这张sharding示意图:对于这张图再说明几点:1.使用泳道表示物理shard(一个数据库结点)2.若垂直切分出的shard进行了进一步的水平切分,但公用一个物理shard的话,则用虚线框住,表示其在逻辑上是一个独立的shard。

3.深色实体表示主表4.X表示需要打断的表间关联三、全局主键生成策略一旦数据库被切分到多个物理结点上,我们将不能再依赖数据库自身的主键生成机制。