简单线性回归模型

各种线性回归模型原理

各种线性回归模型原理线性回归是一种广泛应用于统计学和机器学习领域的方法,用于建立自变量和因变量之间线性关系的模型。

在这里,我将介绍一些常见的线性回归模型及其原理。

1. 简单线性回归模型(Simple Linear Regression)简单线性回归模型是最简单的线性回归模型,用来描述一个自变量和一个因变量之间的线性关系。

模型方程为:Y=α+βX+ε其中,Y是因变量,X是自变量,α是截距,β是斜率,ε是误差。

模型的目标是找到最优的α和β,使得模型的残差平方和最小。

这可以通过最小二乘法来实现,即求解最小化残差平方和的估计值。

2. 多元线性回归模型(Multiple Linear Regression)多元线性回归模型是简单线性回归模型的扩展,用来描述多个自变量和一个因变量之间的线性关系。

模型方程为:Y=α+β1X1+β2X2+...+βnXn+ε其中,Y是因变量,X1,X2,...,Xn是自变量,α是截距,β1,β2,...,βn是自变量的系数,ε是误差。

多元线性回归模型的参数估计同样可以通过最小二乘法来实现,找到使残差平方和最小的系数估计值。

3. 岭回归(Ridge Regression)岭回归是一种用于处理多重共线性问题的线性回归方法。

在多元线性回归中,如果自变量之间存在高度相关性,会导致参数估计不稳定性。

岭回归加入一个正则化项,通过调节正则化参数λ来调整模型的复杂度,从而降低模型的过拟合风险。

模型方程为:Y=α+β1X1+β2X2+...+βnXn+ε+λ∑βi^2其中,λ是正则化参数,∑βi^2是所有参数的平方和。

岭回归通过最小化残差平方和和正则化项之和来估计参数。

当λ=0时,岭回归变为多元线性回归,当λ→∞时,参数估计值将趋近于0。

4. Lasso回归(Lasso Regression)Lasso回归是另一种用于处理多重共线性问题的线性回归方法,与岭回归不同的是,Lasso回归使用L1正则化,可以使得一些参数估计为0,从而实现特征选择。

简单线性回归模型的公式和参数估计方法以及如何利用模型进行

简单线性回归模型的公式和参数估计方法以及如何利用模型进行数据预测一、简单线性回归模型的公式及含义在统计学中,线性回归模型是一种用来分析两个变量之间关系的方法。

简单线性回归模型特指只有一个自变量和一个因变量的情况。

下面我们将介绍简单线性回归模型的公式以及各个参数的含义。

假设我们有一个自变量X和一个因变量Y,简单线性回归模型可以表示为:Y = α + βX + ε其中,Y表示因变量,X表示自变量,α表示截距项(即当X等于0时,Y的值),β表示斜率(即X每增加1单位时,Y的增加量),ε表示误差项,它表示模型无法解释的随机项。

通过对观测数据进行拟合,我们可以估计出α和β的值,从而建立起自变量和因变量之间的关系。

二、参数的估计方法为了求得模型中的参数α和β,我们需要采用适当的估计方法。

最常用的方法是最小二乘法。

最小二乘法的核心思想是将观测数据与模型的预测值之间的误差最小化。

具体来说,对于给定的一组观测数据(Xi,Yi),我们可以计算出模型的预测值Yi_hat:Yi_hat = α + βXi然后,我们计算每个观测值的预测误差ei:ei = Yi - Yi_hat最小二乘法就是要找到一组参数α和β,使得所有观测值的预测误差平方和最小:min Σei^2 = min Σ(Yi - α - βXi)^2通过对误差平方和进行求导,并令偏导数为0,可以得到参数α和β的估计值。

三、利用模型进行数据预测一旦我们估计出了简单线性回归模型中的参数α和β,就可以利用这个模型对未来的数据进行预测。

假设我们有一个新的自变量的取值X_new,那么根据模型,我们可以用以下公式计算对应的因变量的预测值Y_new_hat:Y_new_hat = α + βX_new这样,我们就可以利用模型来进行数据的预测了。

四、总结简单线性回归模型是一种分析两个变量关系的有效方法。

在模型中,参数α表示截距项,β表示斜率,通过最小二乘法估计这些参数的值。

简单线性回归模型

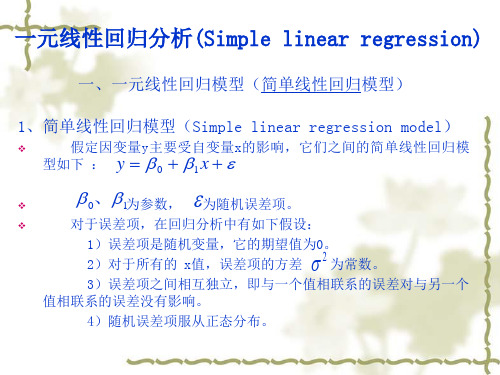

Yt = β1+ β2Xt+et et ~N(0,1) 兩個分析模型的理由: 解釋應變數 (yt) 會如何隨著自變數 (xt ) 的改變而

改變。

在 x0 已知下預測 y0。

開南大學公管所與國企所合開選修課 --量化分析與應用 --黃智聰 1

y, y, yˆ

yt y yˆt y eˆt

最小平方估計式的變異數與共變數

(1) σ2 Var(b2) 越不精確

(2)T

Var(b2) 越精確

(3)Var(X2 )

Var(b2) 越精確

(4)Cov(X2 , X3 ) Var(b2) 越不精確

開南大學公管所與國企所合開選修課 --量化分析與應用 --黃智聰15

誤差為常態分配之最小平方估計式的性質

R2↑

Notice : 殘差模式也有許多其他的不足之處,例 如有被忽略的變數,異質變異性 (heteroskedasticity),自我相關 (autocorrelation) 錯誤建立迴歸模型。

開南大學公管所與國企所合開選修課 --量化分析與應用 --黃智聰10

殘差為常態分配嗎?

1.平均值→0 2.傑古貝拉檢定(Jarque-Bera test for normality),用來檢定常態性。 Ho: 常態,H1:非常態 若 P>α 無法拒絕虛無假設

選擇函數形式:實證議題

技術的改變

1.散佈(plot)

2.模型 Yt=β1+β2 Xt+et 3.估計

4.預測

時間

5.殘差分佈 → 檢查是否為常態分配?

開南大學公管所與國企所合開選修課 --量化分析與應用 --黃智聰 9

简单线性回归模型

简单线性回归模型在一个回归模型中,我们需要关注或预测的变量叫做因变量,我们选取的用来解释因变量变化的变量叫做自变量。

一元线性回归模型y=w0+w1x+ε,其中w0,w1为回归系数,ε为随机误差项,假设ε~N(0,σ2),则随机变量y~N(w0+w1x,σ2)。

面对一个具体问题,给定样本集合D={(x1,y1),…,(x n.yn)},我们的目标是找到一条直线y=w0+w1x使得所有样本点尽可能落在它的附近。

数据模型为( w 0 ^ , w 1 ^ ) = a r g m i n ( w 0 ^ , w 1 ^ ) ∑ i = 1 n ( y i − w 0 − w 1 x i ) 2(\hat{w_{0}},\hat{w_{1}})=argmin_{(\hat{w_{0}},\hat{w_{1}})}\sum_{i=1}^{n}(y_{i}-w_{0}-w_{1}x_{i})^{2}(w0^,w1^)=argmin(w0^ ,w1^)i=1∑n(yi−w0−w1xi)2多元线性回归模型y=w0x0+w1x1+w2x2+…+w dxd+ε或y=wT x+ε,其中x=(x1,x2,…,x d)为自变量,w=(w1,w2,…,w d)为回归系数。

假设将训练集中的输入特征部分记为n*d维矩阵X,矩阵第一列值全为1,训练数据的输出特征部分写成向量形式y=(y1,y2,…,yn)T。

在多元线性模型中,输入X对应的模型输出为y ^ = X w \hat{y}=Xwy^=Xw线性回归的问题实际数据可能不是线性的●使用R2等指标进行模型诊断,R2越接近1,证明模型拟合的越好。

多重共线性●正则化、主成分回归、偏最小二乘回归过度拟合问题当模型的变量过多时,线性回归可能会出现过度拟合问题。

假如在房价预测问题中,假设x表示房屋面积,如果将x2,x3等作为独立变量可能出现以下情况简单线性回归通常对模型作了以下假设:1.输入特征是非随机的且互相不相关;2.随机误差具有零均值,同方差的特点,且彼此不相关;3.输入特征与随机误差不相关;4.随机误差项服从正态分布N(0, σ2 ).。

简单线性回归模型

简单线性回归模型线性回归是统计学中一个常见的分析方法,用于建立自变量与因变量之间的关系模型。

简单线性回归模型假设自变量与因变量之间存在线性关系,可以通过最小二乘法对该关系进行拟合。

本文将介绍简单线性回归模型及其应用。

一、模型基本形式简单线性回归模型的基本形式为:y = β0 + β1x + ε其中,y为因变量,x为自变量,β0和β1为常数项、斜率,ε为误差项。

二、模型假设在使用简单线性回归模型之前,我们需要满足以下假设:1. 线性关系假设:自变量x与因变量y之间存在线性关系。

2. 独立性假设:误差项ε与自变量x之间相互独立。

3. 同方差性假设:误差项ε具有恒定的方差。

4. 正态性假设:误差项ε符合正态分布。

三、模型参数估计为了估计模型中的参数β0和β1,我们使用最小二乘法进行求解。

最小二乘法的目标是最小化实际观测值与模型预测值之间的平方差。

四、模型拟合度评估在使用简单线性回归模型进行拟合后,我们需要评估模型的拟合度。

常用的评估指标包括:1. R方值:衡量自变量对因变量变异的解释程度,取值范围在0到1之间。

R方值越接近1,说明模型对数据的拟合程度越好。

2. 残差分析:通过观察残差分布图、残差的均值和方差等指标,来判断模型是否满足假设条件。

五、模型应用简单线性回归模型广泛应用于各个领域中,例如经济学、金融学、社会科学等。

通过建立自变量与因变量之间的线性关系,可以预测和解释因变量的变化。

六、模型局限性简单线性回归模型也存在一些局限性,例如:1. 假设限制:模型对数据的假设比较严格,需要满足线性关系、独立性、同方差性和正态性等假设条件。

2. 数据限制:模型对数据的需求比较高,需要保证数据质量和样本的代表性。

3. 线性拟合局限:模型只能拟合线性关系,无法处理非线性关系的数据。

简单线性回归模型是一种简单且常用的统计方法,可以用于探索变量之间的关系,并进行预测和解释。

然而,在使用模型时需要注意其假设条件,并进行适当的拟合度评估。

庞浩计量经济学第二章简单线性回归模型

最小二乘法的应用

在统计学和计量经济学中,最 小二乘法广泛应用于估计线性 回归模型,以探索解释变量与 被解释变量之间的关系。

通过最小二乘法,可以估计出 解释变量的系数,从而了解各 解释变量对被解释变量的影响 程度。

最小二乘法还可以用于时间序 列分析、预测和数据拟合等场 景。

最小二乘法的局限性

最小二乘法假设误差项是独立同分布 的,且服从正态分布,这在实际应用 中可能不成立。

最小二乘法无法处理多重共线性问题, 当解释变量之间存在高度相关关系时, 最小二乘法的估计结果可能不准确。

最小二乘法对异常值比较敏感,异常 值的存在可能导致参数估计的不稳定。

04

模型的评估与选择

R-squared

总结词

衡量模型拟合优度的指标

详细描述

R-squared,也称为确定系数,用于衡量模型对数据的拟合程度。它的值在0到1之间,越接近1表示模型拟合越 好。R-squared的计算公式为(SSreg/SStot)=(y-ybar)2 / (y-ybar)2 + (y-ybar)2,其中SSreg是回归平方和, SStot是总平方和,y是因变量,ybar是因变量的均值。

数据来源

本案例的数据来源于某大型电商 平台的销售数据,包括商品的销 售量、价格、评价等。

数据处理

对原始数据进行清洗和预处理, 包括处理缺失值、异常值和重复 值,对分类变量进行编码,对连 续变量进行必要的缩放和转换。

模型建立与评估

模型建立

基于处理后的数据,使用简单线性回 归模型进行建模,以商品销售量作为 因变量,价格和评价作为自变量。

线性回归模型是一种数学模型, 用于描述因变量与一个或多个 自变量之间的线性关系。它通 常表示为:Y = β0 + β1X1 + β2X2 + ... + ε

简单线性回归模型的估计与解释

简单线性回归模型的估计与解释简介简单线性回归模型是统计学中常用的一种回归模型,用于分析两个变量之间的关系。

本文将介绍简单线性回归模型的估计与解释方法。

一、模型的建立简单线性回归模型可以表示为:Y = β0 + β1X + ε,其中Y是因变量,X是自变量,β0是截距,β1是斜率,ε是误差项。

二、模型参数的估计为了估计模型参数,常用的方法是最小二乘法。

最小二乘法的目标是使残差平方和最小化。

通过最小二乘法,我们可以得到β0和β1的估计值。

三、模型的解释1. 截距(β0)的解释截距表示当自变量X等于0时,因变量Y的平均值。

截距的估计值可以用来解释在X为0时的预测值。

2. 斜率(β1)的解释斜率表示因变量Y对自变量X的变化率。

当自变量X增加1个单位时,因变量Y的平均变化量为斜率的估计值。

斜率的正负决定了变量之间的正向或负向关系。

3. 模型的拟合优度拟合优度是用来评估模型对数据的拟合程度。

常用的指标是R方(R-Squared),它表示因变量的变异中能够被自变量解释的比例,取值范围为0到1。

R方越接近1,说明模型对数据的拟合越好。

四、模型的显著性检验为了检验自变量和因变量之间的关系是否显著,我们可以进行假设检验。

通常使用t检验对截距和斜率进行检验。

若p值小于显著性水平(通常为0.05),则认为存在显著关系。

五、模型的诊断与改进在应用简单线性回归模型时,需要进行模型诊断和改进。

常见的诊断方法包括残差分析、离群值检测和多重共线性检验等。

根据诊断结果,可以尝试改进模型,如加入非线性项或引入其他解释变量。

六、模型的应用简单线性回归模型广泛应用于各个领域,如经济学、金融学、社会学等。

通过建立和解释简单线性回归模型,可以分析变量之间的相关性,预测未来趋势,为决策提供科学依据。

结论通过对简单线性回归模型的估计与解释,我们可以得到模型参数的估计值,解释截距和斜率的含义,评估拟合优度以及进行显著性检验。

同时,还需进行模型诊断和改进,以提高模型的准确性和可解释性。

Chapter 2 简单线性回归模型

2. 相关分析是对称(symmetric)对待 X 和 Y 不区分解释变量(自变量)和被解释变量(因变量) ,两个变量都是随机的 例:统计考试成绩和数学考试成绩相关系数

四、回归分析与因果关系 1. 回归分析研究一个变量对另一个变量统计上的依存关系,但是并不表明 两个变量之间有因果关系。

2. 因果关系的建立一定是来自于统计关系之外,最终应该来自于理论。 (所 以要有经济理论) 例:降水量与产量 统计上并没有否定以下回归关系的存在 降水量 = beta0 + beta1*产量 + error 但是直觉告诉我们产量并不能决定降水量,产量并不是降水量的原因。

Variance: var X ≡ E X

μ

E X

2

μ

Covariance: Cov X, Y ≡ E X

μ

Y

μ

E XY

E X E Y

3. 线性相关系数(correlation coefficient) 总体(population)相关系数 Corr X, Y Cov X, Y Var X Var Y

(2) 回归线: 对于每一个 X 的取值,都有 Y 的条件期望 E(Y|Xi)与之对应,代表这些 Y 的 条件期望的点的轨迹所形成的直线或曲线,称为回归线。

Y 的条件分布:当解释变量 X 取某固定值时(条件) ,Y 的值不确定,Y 的不同取值形成一定的分布,即 Y 的条件分布。

Y 的条件期望:对于 X 的每一个取值,对 Y 所形成的分布确定其期望或 均值,称为 Y 的条件期望或条件均值,E(Y|X)

3. 用 x 的变化解释 y 的变化要解决的三个问题 问题 1:因为两个变量之间的关系是非精确的关系(not exact relationship) , 如何让其它因素也影响 y? ε 代表影响 y 的其他因素

一元回归线性模型

一元回归线性模型

一元线性回归模型,又称为简单线性回归模型,是机器学习中常

用的回归模型,它是利用一个自变量X来预测因变量Y的结果。

一元

线性回归模型将样本数据映射为一条直线,如y=ax+b,其中a是斜率,b是截距,也就是说,一元线性回归模型中的参数是斜率和截距,而拟

合的直线就是根据样本数据估计出来的最佳拟合直线。

目标函数是求解参数 a 和 b,使得误差平方和最小,具体来说,

目标函数的表达式为:J(a,b)=Σi(yi-f(xi))^2,其中f(x)=ax+b,yi为观测值,xi为观测值对应的自变量。

对于一元线性回归模型,求解参数 a 和 b 的最优方法要么是直

接用梯度下降法求解,要么是用最小二乘法求解。

梯度下降法求解时,需构造损失函数,使用梯度下降法迭代更新参数,直到获得最优结果;而最小二乘法求解时,通过求解参数关于损失函数的导数,便可解出

模型参数,从而得到最优结果。

一元线性回归模型在实际应用中有很多优点,其中最重要的就是

它易于拟合和解释,它求解简单,可以很大程度上减少了计算复杂度,而且可以很好地预测因变量的值,也可以用来检验变量之间的关系。

简单线性回归

注意: 这里将样本回归线看成总体回归线的近似替代

则

样本回归函数的随机形式/样本回归模型:

同样地,样本回归函数也有如下的随机形式: Yi Yˆi ˆi ˆ0 ˆ1 X i ei

式中,ei 称为(样本)残差(或剩余)项(residual),代表

回归函数在坐标系中用图形表示出来就 是回归线。它表示了应变量和解释变量 之间的平均关系。

回归线图示

概率密度函数 f(Yi)

Y

x1 xi Xk

PRF

X

注意:

一般地,在重复抽样中解释变量被假定 为固定的。所以回归分析中,解释变量 一般当作非随机变量处理。

1.4 总体回归函数

由于变量间关系的随机性,回归分析关心的是 根据解释变量的已知或给定值,考察被解释变量的总 体均值,即当解释变量取某个确定值时,与之统计相 关的被解释变量所有可能出现的对应值的平均值。

1.3.1 回归分析 是对一个应变量对若干解释变量依存 关系的研究; 其目的是:由固定的解释变量去估计 和预测应变量的平均值等。

1.3.2 回归函数、回归线

应变量Y的条件期望E(Y/X i )随着解释变量 X的变化而有规律地变化。把这种变化关 系用函数表示出来,就是回归函数:

E(Y/X i ) f(X i )

列入模型的那些次要因素的综合影响。

由中心极限定理μ服从的均值

不妨假设

m

rj 1

j 1

则有

m

rj zj Z j 1

因此,由中心极限定理,无论Zj原来的分布形式如何,只要它们 相互独立,m足够大,就会有μ趋于正态分布。

而且正态分布简单易用,且数理统计学中研究的成果很多,可以 借鉴。

各种线性回归模型原理

各种线性回归模型原理线性回归是一种经典的统计学方法,用于建立自变量和因变量之间的线性关系。

在这个模型中,我们假设自变量和因变量之间存在一个线性函数关系,通过找到最佳的拟合直线,我们可以预测和解释因变量。

在线性回归中,我们通常使用以下三种模型:简单线性回归模型、多元线性回归模型和多项式回归模型。

1.简单线性回归模型:简单线性回归是最基本的线性回归模型。

它用于研究只有一个自变量和一个因变量之间的关系。

假设我们有一个自变量x和对应的因变量y。

简单线性回归模型可以表示为:y=β0+β1*x+ε其中,y是因变量,x是自变量,β0和β1是回归系数,ε是误差项。

我们的目标是找到最佳的回归系数,使得模型对观测数据的拟合最好。

2.多元线性回归模型:当我们需要考虑多个自变量对因变量的影响时,可以使用多元线性回归模型。

多元线性回归模型可以表示为:y = β0 + β1 * x1 + β2 * x2 + ... + βn * xn + ε其中,y是因变量,x1, x2, ..., xn是自变量,β0, β1,β2, ..., βn是回归系数,ε是误差项。

我们通过最小化误差项的平方和来估计回归系数。

3.多项式回归模型:多项式回归模型是在线性回归模型的基础上引入了多项式项的扩展。

在一些情况下,自变量和因变量之间的关系可能不是简单的线性关系,而是复杂的曲线关系。

多项式回归模型可以通过引入自变量的高次幂来建立非线性关系。

例如,二阶多项式回归模型可以表示为:y=β0+β1*x+β2*x^2+ε我们可以使用最小二乘法来估计回归系数,从而找到最佳的拟合曲线。

在以上三种线性回归模型中,我们以最小二乘法作为求解回归系数的方法。

最小二乘法通过最小化观测值与模型拟合值之间的残差平方和来选择最佳的回归系数。

通过最小二乘法,我们可以得到回归系数的闭式解,即可以明确得到回归系数的数值。

除了最小二乘法,还有其他求解回归系数的方法,例如梯度下降法和正规方程法。

回归分析法计算公式

回归分析法计算公式回归分析是一个统计方法,用于建立变量之间的关系模型,并通过该模型预测一个或多个自变量对应的因变量的值。

回归分析方法通常基于最小二乘法,通过寻找使得预测值和实际值之间的误差平方和最小的参数估计。

以下是回归分析中常用的计算公式及其含义:1.简单线性回归模型:简单线性回归模型可以用来分析一个自变量和一个因变量之间的关系。

它的数学形式如下:Y=β₀+β₁X+ε其中,Y是因变量,X是自变量,β₀和β₁是回归系数,ε是误差项。

2.多元线性回归模型:多元线性回归模型可以用来分析多个自变量和一个因变量之间的关系。

它的数学形式如下:Y=β₀+β₁X₁+β₂X₂+...+βₚXₚ+ε其中,Y是因变量,X₁,X₂,...,Xₚ是自变量,β₀,β₁,β₂,...,βₚ是回归系数,ε是误差项。

3.最小二乘法:最小二乘法是一种常用的参数估计方法,用于确定回归系数的值。

它通过最小化残差平方和来估计回归系数,使得预测值和实际值之间的差异最小。

4.残差:残差是实际观测值与回归模型预测值之间的差异。

在最小二乘法中,残差被用来评估模型的拟合程度,残差越小表示模型与实际值越接近。

5.回归系数的估计:回归系数可以通过最小二乘法估计得到。

简单线性回归模型的回归系数β₀和β₁的估计公式如下:β₁=∑((Xi-Xₚ)(Yi-Ȳ))/∑((Xi-Xₚ)²)β₀=Ȳ-β₁Xₚ其中,Xi和Yi是样本数据的自变量和因变量观测值,Xₚ和Ȳ分别是自变量和因变量的样本均值。

6.R²决定系数:R²决定系数用来衡量回归模型对因变量变异程度的解释能力,它的取值范围在0到1之间。

R²的计算公式如下:R²=1-(SSR/SST)其中,SSR是回归平方和,表示模型对因变量的解释能力;SST是总平方和,表示总体变异程度。

以上是回归分析常用的一些计算公式,通过这些公式可以计算回归系数、残差、决定系数等指标,用于评估回归模型的拟合程度和预测能力。

线性回归分析

r 2 SSR / SST 1 SSE / SST L2xy Lxx Lyy

❖

两个变量之间线性相关的强弱可以用相关系数r(Correlation

coefficient)度量。

❖ 相关系数(样本中 x与y的线性关系强度)计算公式如下:

❖ 统计学检验,它是利用统计学中的抽样理论来检验样本 回归方程的可靠性,具体又可分为拟合程度评价和显著 性检验。

1、拟合程度的评价

❖ 拟合程度,是指样本观察值聚集在估计回归线周围的紧密 程度。

❖ 评价拟合程度最常用的方法是测定系数或判定系数。 ❖ 对于任何观察值y总有:( y y) ( yˆ y) ( y yˆ)

当根据样本研究二个自变量x1,x2与y的关系时,则有

估计二元回归方程: yˆ b0 b1x1 b2 x2

求估计回归方程中的参数,可运用标准方程如下:

L11b1+L12b2=L1y

L12b1+L22b2=L2y b0 y b1 x1 b2 x2

例6:根据表中数据拟合因变量的二元线性回归方程。

21040

x2

4 36 64 64 144 256 400 400 484 676

2528

练习3:以下是采集到的有关女子游泳运动员的身高(英寸)和体

重(磅)的数据: a、用身高作自变量,画出散点图 b、根据散点图表明两变量之间存在什么关系? c、试着画一条穿过这些数据的直线,来近似身高和体重之间的关 系

测定系数与相关系数之间的区别

第一,二者的应用场合不同。当我们只对测量两个变量之间线性关系的 强度感兴趣时,采用相关系数;当我们想要确定最小二乘直线模型同数据符 合的程度时,应用测定系数。

最简单的线形回归模型

最简单的线形回归模型线性回归是一种常见的机器学习算法,也是最简单的回归模型之一。

它用于建立一个输入变量和输出变量之间的线性关系模型,通过拟合一条直线来预测未知数据的输出值。

在线性回归模型中,我们假设输入变量和输出变量之间存在一个线性关系,即输出变量可以通过输入变量的线性组合来表示。

这个线性关系可以用数学表达式 y = wx + b 来表示,其中 y 是输出变量,x 是输入变量,w 是权重,b 是偏差。

线性回归模型的目标是找到最佳的权重和偏差,使得模型预测的输出值与真实值之间的差距最小。

为了衡量模型的预测准确度,我们使用损失函数来计算预测值与真实值之间的差距。

常见的损失函数有平方损失函数和绝对值损失函数。

在训练线性回归模型时,我们需要使用一组已知的输入变量和对应的输出值来拟合模型。

通过最小化损失函数,我们可以使用梯度下降等优化算法来调整模型的权重和偏差,逐步接近最佳的拟合结果。

线性回归模型的优点是简单易懂,计算效率高。

由于模型的线性特性,可以通过解析方法直接计算出最佳的权重和偏差。

此外,线性回归模型也具有较好的解释性,可以通过权重的大小来判断输入变量对输出变量的影响程度。

然而,线性回归模型也存在一些局限性。

首先,线性回归模型假设输入变量和输出变量之间存在线性关系,但现实中的数据往往是复杂的非线性关系。

如果数据呈现非线性关系,线性回归模型的拟合效果会很差。

此外,线性回归模型对异常值比较敏感,异常值的存在会对模型的拟合结果产生较大影响。

为了解决线性回归模型的局限性,可以使用多项式回归模型或者其他非线性回归模型。

多项式回归模型可以通过添加多项式特征来拟合非线性关系,从而提高模型的拟合能力。

其他非线性回归模型如决策树回归、支持向量回归等也可以用来建立复杂的非线性模型。

线性回归是一种简单而常用的回归模型,通过拟合一条直线来预测未知数据的输出值。

它具有简单易懂、计算高效的优点,但在处理非线性关系和异常值方面存在局限性。

简单线性回归模型与多元线性回归模型的基本假定

简单线性回归模型与多元线性回归模型的基本假定统计学家们常常尝试利用数据建立模型,以解释客观世界中发生的事物,而线性回归是其中一种用来预测变量之间关系的模型。

线性回归模型可以用来尝试理解客观世界的运行规律,并用来预测变量之间的关系。

简单线性回归模型是一种用来描述两个变量之间的线性关系的模型,它假设变量之间存在一个线性关系,即y=ax+b,其中a和b 是回归参数,y表示被解释变量,而x表示解释变量。

简单线性回归模型的基本假设如下:(1)自变量和因变量之间存在线性关系;(2)存在独立误差项;(3)误差项具有正态分布,其标准差为σ;(4)误差项之间相互独立,其均值为0。

另一种常见的回归模型是多元线性回归模型,它考虑的是解释变量有多个的情况,即y=β0+β1x1+β2x2+…+βkxk,这时,变量x1,x2,…,xk分别称为自变量,而β0,β1,…,βk分别称为回归系数。

多元线性回归模型的基本假设如下:(1)自变量和因变量之间存在线性关系;(2)存在独立误差项;(3)误差项具有正态分布,其标准差σ,均值为0;(4)误差项之间相互独立;(5)错误项的方差应相等。

以上是简单线性回归模型和多元线性回归模型的基本假设,在使用这些模型之前,统计学家必须首先测试这些假设,以确保模型的可信性。

一旦假设得到证实,统计学家就可以开始运用这些模型来拟合数据,以确定变量之间的线性关系。

当数据中存在非线性变量时,统计学家可以尝试使用多项式模型来代替线性模型,以更好地拟合数据。

总之,简单线性回归模型和多元线性回归模型是常用的统计学方法,而他们分别有一组基本假设,统计学家应首先测试这些假设,以确保模型的可信性,然后再利用它们来拟合数据并预测变量之间的关系。

计量经济学实验简单线性回归模型

计量经济学实验简单线性回归模型引言计量经济学是经济学中的一个分支,致力于通过经验分析和实证方法来研究经济问题。

实验是计量经济学中的重要方法之一,能够帮助我们理解和解释经济现象。

简单线性回归模型是实验中常用的工具之一,它能够通过建立两个变量之间的数学关系,预测一个变量对另一个变量的影响。

本文将介绍计量经济学实验中的简单线性回归模型及其应用。

简单线性回归模型模型定义简单线性回归模型是一种用于描述自变量(X)与因变量(Y)之间关系的线性模型。

其数学表达式为:Y = β0 + β1X + ε其中,Y表示因变量,X表示自变量,β0和β1为未知参数,ε表示误差项。

参数估计在实际应用中,我们需要通过数据来估计模型中的参数。

最常用的估计方法是最小二乘法(OLS)。

最小二乘法的目标是通过最小化观测值与拟合值之间的平方差来估计参数。

具体而言,我们需要求解以下两个方程来得到参数的估计值:∂(Y - β0 - β1X)^2 / ∂β0 = 0∂(Y - β0 - β1X)^2 / ∂β1 = 0解释变量与被解释变量在简单线性回归模型中,解释变量(X)用来解释或预测被解释变量(Y)。

例如,我们可以使用房屋的面积(X)来预测房屋的价格(Y)。

在实验中,我们可以根据收集到的数据来建立回归模型,并利用该模型进行预测和分析。

应用实例数据收集为了说明简单线性回归模型的应用,我们假设收集了一些关于学生学习时间与考试成绩的数据。

下面是收集到的数据:学习时间(小时)考试成绩(百分制)2 723 784 805 856 88模型建立根据收集到的数据,我们可以建立简单线性回归模型来分析学生学习时间与考试成绩之间的关系。

首先,我们需要确定自变量和因变量的符号。

在这个例子中,我们可以将学习时间作为自变量(X),考试成绩作为因变量(Y)。

然后,我们使用最小二乘法来估计模型中的参数。

通过计算,可以得到如下参数估计值:β0 = 69.85β1 = 2.95最终的回归方程为:Y = 69.85 + 2.95X预测与分析通过建立的回归模型,我们可以进行预测和分析。

金融学《简单线性回归模型》课件

4500

2277 2388 2526 2681 2887 3050 3189 3353 3534 3710 3834

Hale Waihona Puke 30395000 5500

2469 2924 2889 3338 3090 3650 3156 3802 3300 4087 3321 4298 3654 4312 3842 4413 4074 4165

9

“线性”的判断p39

计量经济学中,线性回归模型的“线性” 有两种解释: ◆就变量而言是线性的 ——Y的条件期望(均值)是 X 的线性函数 ◆就参数而言是线性的 ——Y的条件期望(均值)是参数 β 的线性函数:

例如: E(Yi Xi ) 1 2Xi 对变量、参数均为“线性”

E(Yi Xi ) 1 2 ln Xi 对参数“线性”,对变量”非线性”

样本回归函数:

Y

SRF

如果把被解释变量Y的样本条件

均值Yˆi 表示为解释变量X的某种

函数,这个函数称为样本回归函

Yˆi

•• •••

数(SRF)。

Xi

X

13

样本回归函数的表现形式

条件均值形式:

将样本条件均值表现为解释变量的函数,样本回归函数如果为

线性函数,可表示为 Yˆi ˆ1 ˆ2 Xi

其中:Yˆi 是与 X i相对应的 Y 的样本条件均值 ˆ1 和 ˆ2 分别是样本回归函数的参数

一、明确几个概念(为深刻理解“回归”)

●被解释变量 Y 的条件分布:

当解释变量 X 取某固定值时(条件),Y 的值不确定, Y的不同取值会形成一定的分布,这是Y的条件分布。 ●被解释变量 Y 的条件概率:

X取某固定值时,Y 取不同值的概率称为Y的条件概率。

最简单的线形回归模型

最简单的线形回归模型线性回归是一种基本的统计分析方法,用于研究两个或多个变量之间的线性关系。

它是一种预测模型,通过拟合一条直线,来描述自变量和因变量之间的关系。

线性回归模型可以用于预测因变量的值,并对自变量的影响进行量化。

线性回归模型的基本形式是y = β0 + β1x,其中y是因变量,x 是自变量,β0和β1是回归系数。

β0是截距,表示当自变量x为0时,因变量y的值。

β1是斜率,表示因变量y对自变量x的变化率。

通过最小化残差平方和,也就是实际值与预测值之间的差异的平方和,可以得到最佳拟合直线。

线性回归模型的建立需要满足一些假设条件,包括线性关系、独立性、常态性、同方差性等。

如果这些假设条件不满足,可能会导致回归结果不准确或失效。

因此,在进行线性回归分析时,需要对数据进行严格的前处理,检验假设条件的合理性。

线性回归模型的拟合程度可以通过R方值来衡量,R方值越接近1,说明模型拟合程度越好。

然而,R方值并不是唯一的评估指标,还可以通过残差分析、方差分析等方法来评估模型的准确性。

线性回归模型的应用非常广泛。

在经济学领域,线性回归模型可以用于分析不同因素对经济增长的影响;在医学领域,可以用于预测某种疾病的发生风险;在市场营销领域,可以用于分析广告投放对销售额的影响等。

线性回归模型还可以进行扩展,包括多元线性回归模型、多项式回归模型、非线性回归模型等。

这些模型可以更好地拟合数据,提高预测准确性。

在实际应用中,线性回归模型也存在一些局限性。

例如,线性回归模型假设自变量和因变量之间存在线性关系,但实际情况中很多关系是非线性的。

此外,线性回归模型对异常值和离群点比较敏感,需要进行异常值检测和处理。

线性回归模型是一种简单但常用的统计分析方法,可以用于研究变量之间的线性关系。

通过拟合一条直线来描述自变量和因变量之间的关系,并对自变量的影响进行量化。

线性回归模型的应用广泛,但也需要满足一些假设条件,并进行严格的前处理和模型评估。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

加强交通建设管理,确保工程建设质 量。08: 57:0108:57:0108:57F riday, October 30, 2020

安全在于心细,事故出在麻痹。20.10.3020.10.3008: 57:0108:57:01October 30, 2020

踏实肯干,努力奋斗。2020年10月30日上午8时57分 20.10.3020.10.30

3

描述学生人数和销售收入之间的关系

协方差(315.56)和相关系数(0.95),散点图;

250

季度销售收入/千美圆

200

150

100

50

0

0

5

10

15

20

25

30

学生人数/千人

根据这些你可以得到什么结论?

4

Types of Regression Models

Positive Linear Relationship

学生人数/千人

理解?

12

回归方程的判定系数

y的总变差的分解

SST ( yi y)2 ( yi yˆi yˆi y)2

( yi yˆi )2 ( yˆi y)2 SSE SSR

定义判定系数R2=SSR/SST. 判定系数的含义是什么? 阿姆德比萨饼连锁店的例子:R2=0.9027. 判定系数和相关系数的关系。

点估计:110

20

使用你建立的模型(二)

对于问题一,如何得到这种连锁店平均 销售收入的一个95%的置信区间?

对于给定的xp , yˆ p b0 b1xp是E( y p )的无偏估计。

yˆ p的分布是N (E( yp ),

2 yˆ p

), 其中

2 的估计是

yˆ p

s2 yˆ p

s

2

1 n

(xp x)2

使用EXCEL对阿姆德连锁店的数据 建立模型,并进行分析,基于EXCEL的输 出结果,你对该模型有些什么认识?

19

使用你建立的模型(一)

问题一:对于那些附近学校人数是1万的 连锁店,他们的季度销售收入一定是一 样吗?这种连锁店平均的季度销售收入 是多少?你能够给出一个估计吗?

问题二:某家连锁店附近学生总数约1万 人,你能够给出它的季度销售收入的一 个估计值吗?

变量x的确对y有解释作用吗?(H0: =0) 检验统计量

F=MSR/MSE 其中MSR=SSR/自变量的个数 拒绝域

F>F(1, n-2)

17

回归方程的方差分析表

方差来源 回归 误差 总计

平方和 SSR SSE SST

自由度 1 n-2 n-1

均方 F值 MSR MSR/MSE MSE

18

阿姆德连锁店的情形

13

Coefficients of Determination (r2) and Correlation (r)

Y r2 = 1,r = +1

Y r2 = 1, r = -1

X

Yr2 = .8, r = +0.9

X

Y r2 = 0, r = 0

X

X

14

的估计

理解误差平方和 SSE ( yi yˆi )2 ( yi b0 b1xi )2

连锁店

1

学生人数/千人 2

销售额/千元 58

2 3 4 5 6 7 8 9 10 6 8 8 12 16 20 20 22 26 105 88 118 117 137 157 169 149 202

根据以上数据,你能否判断学生人数(x)如何影 响到销售收入(y)?根据一家连锁店附近大学的人数, 你能够预测该家连锁店的季度销售收入吗?

好的事情马上就会到来,一切都是最 好的安 排。上 午8时57分1秒 上午8时 57分08:57:0120.10.30

专注今天,好好努力,剩下的交给时 间。20.10.3020.10.3008:5708:57:0108:57:01Oct-20

牢记安全之责,善谋安全之策,力务 安全之 实。2020年10月30日 星期五8时57分 1秒Fri day, October 30, 2020

第十讲

简单线性回归模型

1

建立两个变量X和Y间的关系模型,推断变量Y 如何依赖于变量X, 从而可以用X预测Y.

例:

广告费用和销售量

公司的市值与CEO的年薪

原始股的销售数量和期望价格

证券市场收益率与某只股票的收益率

商品价格和销售量

装配线的速度和次品数量

年收入与信用卡消费金额

年龄与手机话费

随机误 差

因变量(响 应变量,被 预测变量)

斜率

自变量(解释 变量,预测变 量)

7

Y

观测值

Yi 0 1Xi i 观测值

i

=

随机误差

Y 0 1X

X

8

模型的假定

1) E()=0; (E(y)=x) 2) 对于所有的x,Var()=. 3) 是服从正态分布N(0, ) 的. 4) 对于不同的x, 是相互独立的.

散点图; 利用学生化标准残差基本服从标 准正态分布来检测(落在2个标准差之外 时)。

32

带有异常值的散点图示例

80

70

60

50

40

30

20

10

0

0

1

2

3

4

5

6

7

33

检测有影响的观测值

什么是有影响的观测? 观测的杠杆率:

第i个观测的杠杆率 高杠杆率的点意hi 味 着1n 它(的x(ixi x自)x2)2变i 量 1距,2,离别n 的自变

追求至善凭技术开拓市场,凭管理增 创效益 ,凭服 务树立 形象。2020年10月30日星期 五上午8时57分 1秒08: 57:0120.10.30

严格把控质量关,让生产更加有保障 。2020年10月 上午8时 57分20.10.3008:57O ctober 30, 2020

作业标准记得牢,驾轻就熟除烦恼。2020年10月30日星期 五8时57分1秒08:57:0130 October 2020

这些假定意味着什么?

9

f

y 服从在回归直线附近的正态分布

对每个 x 值, y分布的方差相同.

Y

X2

X1 X

回归直线

10

估计的回归方程

如何估计参数和?

最小二乘准则

n

求解 min ( yi 0 1 xi )2 0 ,1 i1

得出达到最小值点(b0 , b1)为0和1的点估计

b1

xi yi ( xi2 (

xi xi

)

2

yi ) /n

/

n

,

b0 y b1 x

估计的回归直线 yˆ b0 b1x

11

阿姆德连锁店的回归直线

估计参数

b1=5

250

季度销售收入/千美圆

b0=60

200 150

回归直线

100

50

yˆ 60 5x

0

0

5

10

15

20

25

30

你对系数的含义怎么

35

树立质量法制观念、提高全员质量意 识。20.10.3020.10.30F riday, October 30, 2020

人生得意须尽欢,莫使金樽空对月。08:57:0108:57: 0108:5710/30/2020 8:57:01 AM

安全象只弓,不拉它就松,要想保安 全,常 把弓弦 绷。20.10.3008:57:0108:57O ct-2030-Oct-20

第i个标准化残差

其中

Std_ˆi ˆi / sˆi

sˆi s

1 hi ,

1

h i n

( xi x)2 ( xi x)2

26

如何分析残差图

如果模型是符合的,那么残差图上的散 点应该落在一条水平带中间,除此之外, 残差图上的点不应呈现出什么规律性。

使用EXCEL对阿姆德连锁店的数据产生残 差图。你能得到什么结论?

yˆ p t / 2 (n 2) sind

其中

s2 ind

s2 1

1 n

(xp x)2

xi2 ( xi )2 / n

( 76.13, 143.87)

22

两种区间的关系

均值的置信区间 预测区间边界

xp

23

对模型作进一步的探讨

回忆我们使用的模型; 对模型作了什么假定? 逻辑问题:如何判断我们的问题符合这

量的值距离较大的点。 识别影响的观测: 杠杆率>6/n的观测.

34

对于建立简单线性回归模型, 你知道了些什么?

什么情况下需要建立简单线性回归模型? 对模型的假定有哪些? 如何估计模型的参数? 如何检验模型及其参数的显著性? 如何使用你建立的模型进行预测? 如何分析你的问题符合对模型做的假定?

相信相信得力量。20.10.302020年10月 30日星 期五8时57分1秒20.10.30

谢谢大家!

27

非线性

ˆ

✓ 线性

ˆ

X

X

ห้องสมุดไป่ตู้28

方差不等

ˆ

✓ 方差相等

ˆ

X

X

29

不独立

ˆ

✓ 独立

ˆ

X

X

30

一个残差不独立的例子

0.8 0.6 0.4 0.2

0 -0.2 -0.4 -0.6 -0.8

31

异常值的检测

异常值是与其它点显示的趋势不合的点。 检查它是否可能是被错误输入的数据。 检测异常值的方法:

的一个无偏估计 s2=MSE=SSE/(n-2)

15

关于回归系数的假设检验

H0 : 1 0 H1 : 1 0