解决linux打开文件数

Linux系统中打开文件数量的查看方法

已分配文件句柄的数目[来源]

已使用文件句柄的数目

文件句柄的最大数目

该文件是只读的,仅用于显示信息。

查看所有进程的文件打开数

lsof |wc -l

查看某个进程打开的文件数

lsof -p pid |wc -l

3、对这个值的修改,退出了当前的shell就会消失

比如说,我先运行了一个程序a,然后通过ulimit修改了限制为2048,然后运行b,然后退出了shell再登录,然后运行c.那就只有b可以打开2048个句柄。

如果我们需要改变整体的限制值,或者我们运行的程序是系统启动的,应该怎么处理呢

这个就是限制数量

这里,有很多ulimit的文章都说的很含糊,究竟这个1024是系统的限制,还是用户的限制呢。其实,这个是用户限制来的,完整的说法,应该是当前用户准备要运行的程序的限制。

1、这个限制是针对单个程序的限制

2、这个限制不会改变之前已经运行了的程序的限制

补充说明:ulimit为shell内建指令,可用来控制shell执行程序的资源。

参 数:

-a 显示目前资源限制的设定。

-c <core文件上限> 设定core文件的最大值,单位为区块。

-d <数据节区大小> 程序数据节区的最大值,单位为KB。

-f <文件大小> shell所能建立的最大文件,单位为区块。

其中一个方法,是想ulimit修改命令放入 /etc/profile里面,但是这个做法并不好

正确的做法,应该是修改/etc/security/limits.conf

里面有很详细的注释,比如

* soft nofile 2048

linux的最大打开文件数限制修改方法命令是什么

linux的最大打开文件数限制修改方法命令是什么linux的最大打开文件数限制修改方法命令是什么Linux继承了Unix以网络为核心的设计思想,是一个性能稳定的多用户网络操作系统。

有时我们需要同时打开很多个文件,不过系统设置中是有限制的,这篇文章主要给大家介绍了关于linux最大打开文件数限制修改的方法,需要的朋友们下面随着我来一起学习学习吧。

前言本文主要给大家介绍了关于linux最大打开文件数限制修改的相关内容,共享出来供大家参考学习,下面话不多讲了,来一起看看具体的介绍:linux会为每个用户登录系统打开最大文件数都有限制,这个限制通过ulimit-n能够看到,一般是1024.在一些并发或多线程情况下,需要突破这个限制.修改第一步编辑/etc/security/limits.conf并确保其包含下列行:*softnofile65535*hardnofile65535这里*表示所有用户,但有的系统不认,需要详细的用户名,比方:rootsoftnofile65535roothardnofile65535第二步编辑etc/pam.d/login,确保有如下行:sessionrequiredpam_limits.so第三步退出终端重新登录.验证使用ulimit-Hn和ulimit-Sn命令能够分别查看当前进程用户的hard和soft的限制数.或者当前用户启动某个程序后,通过cat/proc//limits(pid是该进程的,或者其随意一个子进程的pid)补充:Linux基本命令1.ls命令:格式::ls[选项][目录或文件]功能:对于目录,列出该目录下的所有子目录与文件;对于文件,列出文件名以及其他信息。

常用选项:-a:列出目录下的所有文件,包括以.开始的隐含文件。

-d:将目录像文件一样显示,而不是显示其他文件。

-i:输出文件的i节点的索引信息。

-k:以k字节的形式表示文件的大小。

-l:列出文件的具体信息。

linux最大打开文件数计算方式

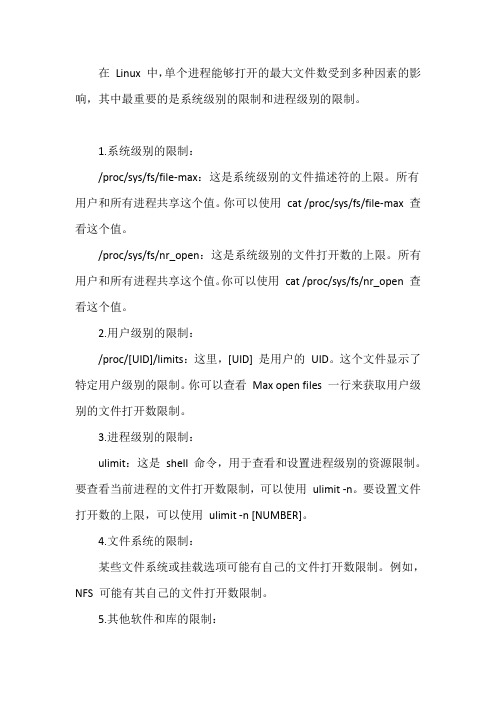

在Linux 中,单个进程能够打开的最大文件数受到多种因素的影响,其中最重要的是系统级别的限制和进程级别的限制。

1.系统级别的限制:

/proc/sys/fs/file-max:这是系统级别的文件描述符的上限。

所有用户和所有进程共享这个值。

你可以使用cat /proc/sys/fs/file-max 查看这个值。

/proc/sys/fs/nr_open:这是系统级别的文件打开数的上限。

所有用户和所有进程共享这个值。

你可以使用cat /proc/sys/fs/nr_open 查看这个值。

2.用户级别的限制:

/proc/[UID]/limits:这里,[UID] 是用户的UID。

这个文件显示了特定用户级别的限制。

你可以查看Max open files 一行来获取用户级别的文件打开数限制。

3.进程级别的限制:

ulimit:这是shell 命令,用于查看和设置进程级别的资源限制。

要查看当前进程的文件打开数限制,可以使用ulimit -n。

要设置文件打开数的上限,可以使用ulimit -n [NUMBER]。

4.文件系统的限制:

某些文件系统或挂载选项可能有自己的文件打开数限制。

例如,NFS 可能有其自己的文件打开数限制。

5.其他软件和库的限制:

某些应用程序或库可能有自己的文件打开数限制,这可能会影响单个进程能够打开的文件数量。

要计算一个进程能够打开的最大文件数,你需要考虑上述所有因素,并确保所有这些限制都没有达到其上限。

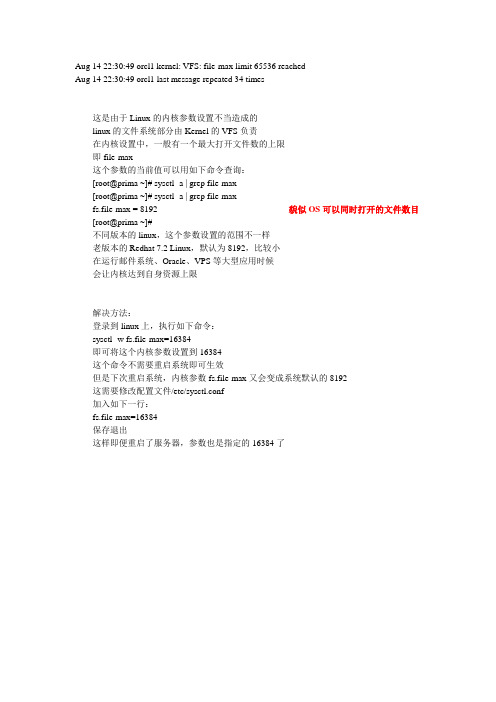

【经验共享】linux kernel :file-max limit分析解决

Aug 14 22:30:49 orcl1 kernel: VFS: file-max limit 65536 reached

Aug 14 22:30:49 orcl1 last message repeated 34 times

这是由于Linux的内核参数设置不当造成的

linux的文件系统部分由Kernel的VFS负责

在内核设置中,一般有一个最大打开文件数的上限

即file-max

这个参数的当前值可以用如下命令查询:

[root@prima ~]# sysctl -a | grep file-max

[root@prima ~]# sysctl -a | grep file-max

fs.file-max = 8192 貌似OS可以同时打开的文件数目[root@prima ~]#

不同版本的linux,这个参数设置的范围不一样

老版本的Redhat 7.2 Linux,默认为8192,比较小

在运行邮件系统、Oracle、VPS等大型应用时候

会让内核达到自身资源上限

解决方法:

登录到linux上,执行如下命令:

sysctl -w fs.file-max=16384

即可将这个内核参数设置到16384

这个命令不需要重启系统即可生效

但是下次重启系统,内核参数fs.file-max又会变成系统默认的8192

这需要修改配置文件/etc/sysctl.conf

加入如下一行:

fs.file-max=16384

保存退出

这样即便重启了服务器,参数也是指定的16384了。

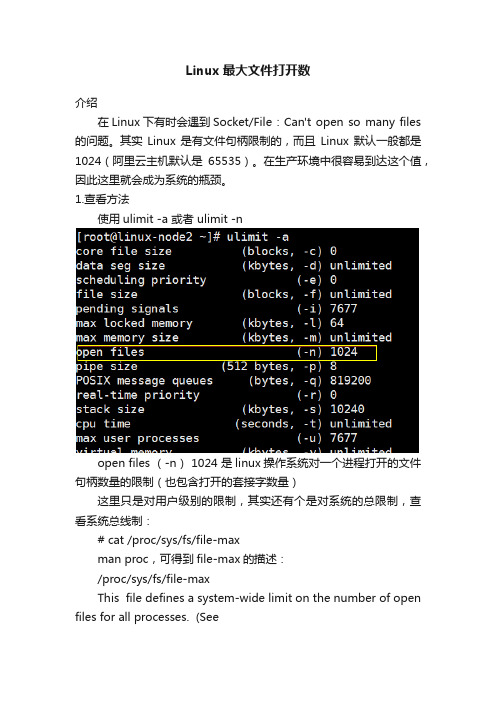

Linux最大文件打开数

Linux最大文件打开数介绍在Linux下有时会遇到Socket/File : Can't open so many files 的问题。

其实Linux是有文件句柄限制的,而且Linux默认一般都是1024(阿里云主机默认是65535)。

在生产环境中很容易到达这个值,因此这里就会成为系统的瓶颈。

1.查看方法使用ulimit -a 或者 ulimit -nopen files (-n) 1024 是linux操作系统对一个进程打开的文件句柄数量的限制(也包含打开的套接字数量)这里只是对用户级别的限制,其实还有个是对系统的总限制,查看系统总线制:# cat /proc/sys/fs/file-maxman proc,可得到file-max的描述:/proc/sys/fs/file-maxThis file defines a system-wide limit on the number of open files for all processes. (Seealsosetrlimit(2), which can be used by a process to set the per-process limit,RLIMIT_NOFILE, on the number of files it may open.) If you get lots of error messagesabout running out of file handles, try increasing this value:即file-max是设置系统所有进程一共可以打开的文件数量。

同时一些程序可以通过setrlimit调用,设置每个进程的限制。

如果得到大量使用完文件句柄的错误信息,是应该增加这个值。

也就是说,这项参数是系统级别的。

2.修改方法临时生效:# ulimit -SHn 10000其实ulimit 命令身是分软限制和硬限制,加-H就是硬限制,加-S 就是软限制。

Toomanyopenfiles问题解决

Toomanyopenfiles问题解决

项⽬运⾏过程出现如下问题

经查询,找出原因,并进⾏解决

具体原因如下:

too many open files(打开的⽂件过多)是Linux系统中常见的错误,从字⾯意思上看就是说程序打开的⽂件数过多,不过这⾥的files不单是⽂件的意思,

也包括打开的通讯链接(⽐如socket),正在监听的端⼝等等,所以有时候也可以叫做句柄(handle),这个错误通常也可以叫做句柄数超出系统限制。

引起的原因就是进程在某个时刻打开了超过系统限制的⽂件数量以及通讯链接数,通过命令ulimit -a可以查看当前系统设置的最⼤句柄数是多少:

open files那⼀⾏就代表系统⽬前允许单个进程打开的最⼤句柄数,这⾥是1024。

使⽤命令lsof -p 进程id可以查看单个进程所有打开的⽂件详情,使⽤命令lsof -p 进程id | wc -l可以统计进程打开了多少⽂件:

以裸启动的tomcat为例,可以看到它⽬前打开了108个⽂件数,如果⽂件数过多使⽤lsof -p 进程id命令⽆法完全查看的话,可以使⽤lsof -p

进程id > openfiles.log将执⾏结果内容输出到⽇志⽂件中查看。

解决⽅法如下:

1、增⼤允许打开的⽂件数——命令⽅式

ulimit -n 2048

这样就可以把当前⽤户的最⼤允许打开⽂件数量设置为2048了,但这种设置⽅法在重启后会还原为默认值。

ulimit -n命令⾮root⽤户只能设置到4096。

2、增⼤允许打开的⽂件数——修改系统配置⽂件

vim /etc/security/limits.conf

加⼊

* - nofile 8192

来源:。

Linux系统打开文件最大数量限制(进程打开的最大文件句柄数设置)

Linux系统打开⽂件最⼤数量限制(进程打开的最⼤⽂件句柄数设

置)

ulimit [-HSTabcdefilmnpqrstuvx [limit]]

利⽤ulimit命令可以对资源的可⽤性进⾏控制。

-H选项和-S选项分别表⽰对给定资源的硬限制(hard limit)和软限制(soft limit)进⾏设置。

硬限制(hard limit)⼀旦被设置以后就不能被⾮root⽤户修改,软限制(soft limit)可以增长达到硬限制(hard limit)。

如果既没有指定-H选项也没有指定-S选项,那么硬限制(hard limit)和软限制(soft limit)都会被设置。

limit的值可以是⼀个数值,也可以是⼀些特定的值,⽐如:hard,soft,unlimited,分别代表当前硬件限制、当前软件限制、不限制。

如果limit参数被省略,除⾮指定-H选项,否则资源当前的软限制(soft limit)将会被打印出来。

下⾯是ulimit命令的⼀些选项:

查看进程打开⽂件最⼤限制

cat /proc/sys/fs/file-max 查看系统级的最⼤限制

ulimit -n 查看⽤户级的限制(⼀般是1024,向阿⾥云华为云这种云主机⼀般是65535)

查看某个进程已经打开的⽂件数

修改限制

临时修改

ulimit -HSn 2048

永久修改

vi /etc/security/limits.conf。

解决linux打开文件数1024限制的解决办法

解决linux打开文件数1024限制的解决办法24 十1、/etc/pam.d/login 添加session required /lib/security/pam_limits.so注意看这个文件的注释2. /etc/security/limits.conf 添加www – nofile 1006154www 是一个用户,如果是想所有用户生效的话换成 * ,设置的数值与硬件配置有关,别设置太大了。

—————————————————————————–3. 修改 /etc/rc.local 添加echo 8061540 > /proc/sys/fs/file-max做完3个步骤,就可以了。

补充说明:/proc/sys/fs/file-max该文件指定了可以分配的文件句柄的最大数目。

如果用户得到的错误消息声明由于打开文件数已经达到了最大值,从而他们不能打开更多文件,则可能需要增加该值。

可将这个值设置成有任意多个文件,并且能通过将一个新数字值写入该文件来更改该值。

缺省设置:4096/proc/sys/fs/file-nr该文件与 file-max 相关,它有三个值:已分配文件句柄的数目已使用文件句柄的数目文件句柄的最大数目该文件是只读的,仅用于显示信息。

关于“打开文件数”限制Linux系统上对每一个用户可使用的系统资源都是有限制的,这是多用户系统必然要采用的一种资源管理手段,试想假如没有这种机制,那么任何一个普通用户写一个死循环程序,用不了多久系统就要“拒绝服务”了。

今天我遇到了tomcat日志报的错误信息”too many open files”,第一意识就想到了是ulimit控制的”open files“限制。

然而问题来了。

我在/etc/profile 里加入了 ulimit -n 4096保存之后,普通用户登录的时候均会收到一条错误信息ulimit: open files: cannot modify limit: Operation not permitted。

Linux命令高级技巧使用lsof命令查看打开文件和进程

Linux命令高级技巧使用lsof命令查看打开文件和进程在Linux系统中,lsof(list open files)命令是一种用于查看打开文件和进程的强大工具。

它可以帮助我们了解系统中当前打开的文件、网络连接以及与之相关的进程等信息。

本文将介绍使用lsof命令进行高级技巧的一些方法和技巧。

一、基本用法使用lsof命令的基本语法如下:lsof [options]其中,options为命令的选项,可以根据需求进行相应的选择。

现在我们来看几个常用的选项:1. -p选项:指定进程ID使用-p选项可以筛选出某个特定进程打开的文件和网络连接。

例如,要查看进程ID为1234的进程打开的文件,可以使用以下命令:lsof -p 12342. -u选项:指定用户名使用-u选项可以筛选出某个特定用户打开的文件和网络连接。

例如,要查看用户名为user的用户打开的文件,可以使用以下命令:lsof -u user3. -c选项:指定进程名使用-c选项可以筛选出某个特定进程名相关的文件和网络连接。

例如,要查看进程名为nginx的进程打开的文件,可以使用以下命令:lsof -c nginx二、进阶用法除了基本的选项外,lsof还提供了一些进阶的用法,可以更灵活地查看和筛选文件和进程。

1. 查看某个目录下的打开文件使用lsof命令可以方便地查看某个目录下的打开文件。

例如,要查看目录“/var/log”下的打开文件,可以使用以下命令:lsof /var/log2. 查看通过网络建立的连接lsof命令还可以查看通过网络建立的连接。

例如,要查看所有的TCP连接,可以使用以下命令:lsof -i TCP3. 查看指定端口的进程和连接有时候我们需要查看某个特定端口的进程和连接情况,lsof也可以胜任这个任务。

例如,要查看TCP端口80的进程和连接,可以使用以下命令:lsof -i :804. 查看由某个进程打开的文件除了按照进程ID查看文件外,我们还可以通过进程名来查看。

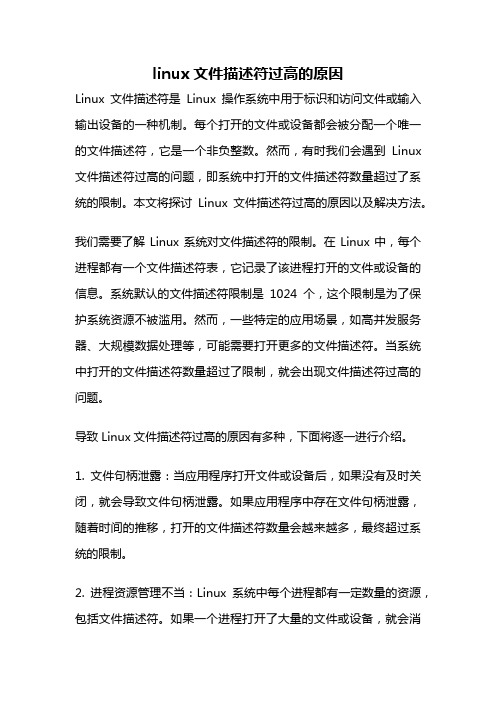

linux文件描述符过高的原因

linux文件描述符过高的原因Linux文件描述符是Linux操作系统中用于标识和访问文件或输入输出设备的一种机制。

每个打开的文件或设备都会被分配一个唯一的文件描述符,它是一个非负整数。

然而,有时我们会遇到Linux 文件描述符过高的问题,即系统中打开的文件描述符数量超过了系统的限制。

本文将探讨Linux文件描述符过高的原因以及解决方法。

我们需要了解Linux系统对文件描述符的限制。

在Linux中,每个进程都有一个文件描述符表,它记录了该进程打开的文件或设备的信息。

系统默认的文件描述符限制是1024个,这个限制是为了保护系统资源不被滥用。

然而,一些特定的应用场景,如高并发服务器、大规模数据处理等,可能需要打开更多的文件描述符。

当系统中打开的文件描述符数量超过了限制,就会出现文件描述符过高的问题。

导致Linux文件描述符过高的原因有多种,下面将逐一进行介绍。

1. 文件句柄泄露:当应用程序打开文件或设备后,如果没有及时关闭,就会导致文件句柄泄露。

如果应用程序中存在文件句柄泄露,随着时间的推移,打开的文件描述符数量会越来越多,最终超过系统的限制。

2. 进程资源管理不当:Linux系统中每个进程都有一定数量的资源,包括文件描述符。

如果一个进程打开了大量的文件或设备,就会消耗大量的文件描述符资源。

如果系统中有多个这样的进程存在,就会导致文件描述符过高。

3. 系统限制设置不当:默认情况下,Linux系统的文件描述符限制是1024个。

但是,管理员可以根据实际需求来调整这个限制。

如果管理员没有根据系统的实际情况来适当地增加文件描述符的限制,就会导致文件描述符过高的问题。

接下来,我们将介绍解决Linux文件描述符过高问题的方法。

1. 优化应用程序:检查应用程序的代码,确保在打开文件或设备后及时关闭。

避免文件句柄泄露。

2. 调整系统限制:管理员可以通过修改系统配置文件来调整文件描述符的限制。

在/etc/security/limits.conf文件中,可以设置每个用户或组的文件描述符限制。

linux最大打开文件数计算方式

linux最大打开文件数计算方式在Linux中,每个进程可以同时打开的文件数量是有限制的。

这个限制是通过内核中的一个参数来控制的,即"最大文件描述符数"或"最大打开文件数"。

在Linux中,每个打开的文件都被赋予一个唯一的文件描述符(file descriptor)。

文件描述符是一个非负整数,它在进程打开一个文件时分配给文件,之后可以用来引用该文件。

例如,标准输入、标准输出和标准错误流的文件描述符分别是0、1和2。

每个进程都有一个文件描述符表,该表存储了该进程打开文件的文件描述符。

默认情况下,文件描述符的数量是有限制的。

通过查看系统的限制值,可以确定该值。

可以使用`ulimit -n`命令来查看当前进程的最大打开文件数。

有几个因素会影响最大打开文件数的计算。

1.系统限制:操作系统对每个进程可以打开的最大文件数设置了一个硬限制和一个软限制。

硬限制是操作系统默认的最大文件数,不能超过这个限制值。

软限制是根据需要可以调整的最大文件数。

软限制不能超过硬限制,但可以增加到硬限制值。

2.内核参数:内核参数`fs.file-max`指定了系统范围内的最大文件数。

这个参数代表了整个系统中所有进程可以打开文件的总数目。

要查看或修改这个参数,可以使用`sysctl`命令。

3.进程限制:除了系统限制之外,每个进程还可以设置自己的最大打开文件数。

这通常可以通过将`ulimit`命令的文件数限制值设置为一个更小的值来实现。

通常情况下,要计算最大打开文件数,需要考虑上述因素的综合影响。

以下是一般情况下最大打开文件数的计算方式的伪代码:```bashsystem_limit = sysctl fs.file-max #获取系统范围内的最大文件数process_limit = ulimit -n #获取进程的最大文件数限制if process_limit < system_limit:max_open_files = process_limitelse:max_open_files = system_limit```总的来说,要计算Linux最大打开文件数,需要考虑系统限制、内核参数和进程限制。

Linux命令高级技巧使用lsof命令查看系统中打开的文件和进程

Linux命令高级技巧使用lsof命令查看系统中打开的文件和进程lsof命令是Linux系统中一个非常实用的命令,用于查看系统中打开的文件和进程。

在系统管理和故障排查中,lsof是一个强大的工具,可以帮助我们快速了解系统资源的使用情况。

本文将介绍lsof命令的基本用法和高级技巧,帮助读者更好地使用这个命令。

一、基本用法1. 查看系统中所有打开的文件和进程:使用命令lsof即可查看系统中所有已打开的文件和进程列表。

命令示例:```lsof```该命令将列出系统中所有已打开的文件和进程的详细信息,包括文件路径、进程ID、用户、权限等。

2. 查看指定进程的打开文件:使用命令lsof -p <进程ID>可以查看指定进程的打开文件列表。

命令示例:```lsof -p 1234```其中,1234为进程的ID。

该命令将列出指定进程打开的文件列表。

3. 查看指定文件被哪些进程打开:使用命令lsof <文件路径>可以查看指定文件被哪些进程打开。

命令示例:```lsof /var/log/syslog```该命令将列出打开/var/log/syslog文件的进程列表。

二、高级技巧1. 以用户角度查看文件和进程:使用命令lsof -u <用户名>可以以指定的用户角度查看系统中的文件和进程。

命令示例:```lsof -u root```该命令将列出用户root打开的文件和进程列表。

2. 查找指定端口被哪个进程占用:使用命令lsof -i :<端口号>可以查找指定端口被哪个进程占用。

命令示例:```lsof -i :80```该命令将列出占用端口80的进程信息。

3. 查看指定目录下被打开的文件:使用命令lsof +D <目录路径>可以查看指定目录中被打开的文件列表。

命令示例:```lsof +D /etc```该命令将列出目录/etc中被打开的文件列表。

4. 查看指定用户打开的文件数:使用命令lsof -u <用户名> | wc -l可以查看指定用户打开的文件数。

RedHat5修改打开文件数

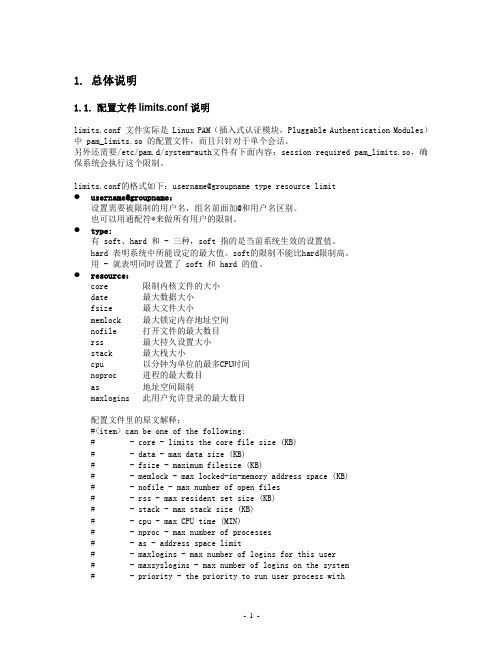

1.总体说明1.1.配置文件limits.conf说明limits.conf 文件实际是 Linux PAM(插入式认证模块,Pluggable Authentication Modules)中 pam_limits.so 的配置文件,而且只针对于单个会话。

另外还需要/etc/pam.d/system-auth文件有下面内容:session required pam_limits.so,确保系统会执行这个限制。

limits.conf的格式如下:username@groupname type resource limit●username@groupname:设置需要被限制的用户名,组名前面加@和用户名区别。

也可以用通配符*来做所有用户的限制。

●type:有 soft、hard 和 - 三种,soft 指的是当前系统生效的设置值。

hard 表明系统中所能设定的最大值。

soft的限制不能比hard限制高。

用 - 就表明同时设置了 soft 和 hard 的值。

●resource:core 限制内核文件的大小date 最大数据大小fsize 最大文件大小memlock 最大锁定内存地址空间nofile 打开文件的最大数目rss 最大持久设置大小stack 最大栈大小cpu 以分钟为单位的最多CPU时间noproc 进程的最大数目as 地址空间限制maxlogins 此用户允许登录的最大数目配置文件里的原文解释:#<item> can be one of the following:# - core - limits the core file size (KB)# - data - max data size (KB)# - fsize - maximum filesize (KB)# - memlock - max locked-in-memory address space (KB)# - nofile - max number of open files# - rss - max resident set size (KB)# - stack - max stack size (KB)# - cpu - max CPU time (MIN)# - nproc - max number of processes# - as - address space limit# - maxlogins - max number of logins for this user# - maxsyslogins - max number of logins on the system# - priority - the priority to run user process with# - locks - max number of file locks the user can hold# - sigpending - max number of pending signals# - msgqueue - max memory used by POSIX message queues (bytes)# - nice - max nice priority allowed to raise to# - rtprio - max realtime priority1.2. ulimit命令参数说明ulimit [options] [limit][options] 含义-H 设置硬资源限制。

Linux修改最大打开文件数

Linux 最大文件数(转)1、修改用户进程可打开文件数限制在Linux平台上,无论编写客户端程序还是服务端程序,在进行高并发TCP连接处理时,最高的并发数量都要受到系统对用户单一进程同时可打开文件数量的限制(这是因为系统为每个TCP连接都要创建一个socket句柄,每个socket句柄同时也是一个文件句柄)。

可使用ulimit命令查看系统允许当前用户进程打开的文件数限制:[speng@as4 ~]$ ulimit -n1024这表示当前用户的每个进程最多允许同时打开1024个文件,这1024个文件中还得除去每个进程必然打开的标准输入,标准输出,标准错误,服务器监听socket,进程间通讯的unix域socket等文件,那么剩下的可用于客户端socket连接的文件数就只有大概1024-10=1014个左右。

也就是说缺省情况下,基于Linux的通讯程序最多允许同时1014个TCP并发连接。

对于想支持更高数量的TCP并发连接的通讯处理程序,就必须修改Linux对当前用户的进程同时打开的文件数量的软限制(soft limit)和硬限制(hardlimit)。

其中软限制是指Linux在当前系统能够承受的范围内进一步限制用户同时打开的文件数;硬限制则是根据系统硬件资源状况(主要是系统内存)计算出来的系统最多可同时打开的文件数量。

通常软限制小于或等于硬限制。

修改上述限制的最简单的办法就是使用ulimit命令:[speng@as4 ~]$ ulimit -n <file_num>上述命令中,在<file_num>中指定要设置的单一进程允许打开的最大文件数。

如果系统回显类似于“Operation notpermitted”之类的话,说明上述限制修改失败,实际上是因为在<file_num>中指定的数值超过了Linux系统对该用户打开文件数的软限制或硬限制。

因此,就需要修改Linux系统对用户的关于打开文件数的软限制和硬限制。

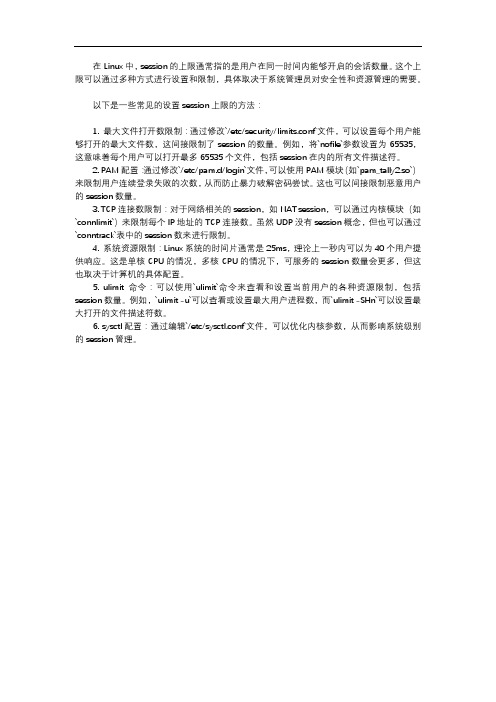

linux中设置的session上限

在Linux中,session的上限通常指的是用户在同一时间内能够开启的会话数量。

这个上限可以通过多种方式进行设置和限制,具体取决于系统管理员对安全性和资源管理的需要。

以下是一些常见的设置session上限的方法:1. 最大文件打开数限制:通过修改`/etc/security/limits.conf`文件,可以设置每个用户能够打开的最大文件数,这间接限制了session的数量。

例如,将`nofile`参数设置为65535,这意味着每个用户可以打开最多65535个文件,包括session在内的所有文件描述符。

2. PAM配置:通过修改`/etc/pam.d/login`文件,可以使用PAM模块(如`pam_tally2.so`)来限制用户连续登录失败的次数,从而防止暴力破解密码尝试。

这也可以间接限制恶意用户的session数量。

3. TCP连接数限制:对于网络相关的session,如NAT session,可以通过内核模块(如`connlimit`)来限制每个IP地址的TCP连接数。

虽然UDP没有session概念,但也可以通过`conntrack`表中的session数来进行限制。

4. 系统资源限制:Linux系统的时间片通常是25ms,理论上一秒内可以为40个用户提供响应。

这是单核CPU的情况,多核CPU的情况下,可服务的session数量会更多,但这也取决于计算机的具体配置。

5. ulimit命令:可以使用`ulimit`命令来查看和设置当前用户的各种资源限制,包括session数量。

例如,`ulimit -u`可以查看或设置最大用户进程数,而`ulimit -SHn`可以设置最大打开的文件描述符数。

6. sysctl配置:通过编辑`/etc/sysctl.conf`文件,可以优化内核参数,从而影响系统级别的session管理。

解决linux打开文件数

57 24231

56 24264

其中第一行是打开的文件句柄数量,第二行是进程号。得到进程号后,我们可以通过ps命令得到进程的详细内容。

ps -aef|grep 24204

mysql 24204 24162 99 16:15 ? 00:24:25 /usr/sbin/mysqld

其中大部分的信息中提到 将 /proc/sys/fs/file-max的值设置为4096和ulimit -n 4096是相同的效果。对此我很怀疑,为什么呢?首先ulimit 是一个普通用户也可以使用的命令,而fs.file-max只有root有权设置。其次,很明显fs.file-max是一个全局的设置,而ulimit 是一个局部的设置,很明显的是不相同的。

回答一、

[root@lxadmin nginx]# cat /proc/sys/fs/file-max

8192

文件系统最大可打开文件数

[root@lxadmin nginx]# ulimit -n

1024

程序限制只能打开1024个文件

使用[root@lxadmin nginx]# ulimit -n 8192调整一下

带着疑虑,又在网上搜索了许久,未果(实际上是我搜索的关键字不够准确)。

最后终于在内核文档/usr/src/linux/Documentation/sysctl/fs.txt里找到下面一段话:

file-max & file-nr:

The kernel allocates file handles dynamically, but as yet it doesn’t free them again. The value in file-max denotes the maximum number of file-handles that the Linux kernel will allocate. When you get lots of error messages about running out of file handles, you might want to increase this limit.

在Linux中打开了太多文件(Toomanyopenfiles)的三种解决方法

在Linux中打开了太多⽂件(Toomanyopenfiles)的三种解决⽅法回答⼀、[root@lxadmin nginx]# cat /proc/sys/fs/file-max8192⽂件系统最⼤可打开⽂件数[root@lxadmin nginx]# ulimit -n1024程序限制只能打开1024个⽂件使⽤[root@lxadmin nginx]# ulimit -n 8192调整⼀下或者永久调整打开⽂件数可在启动⽂件/etc/rc.d/rc.local末尾添加(在/etc/sysctl.conf末尾添加fs.file-max=xxx⽆效)ulimit -n 8192回答⼆、Linux内核有时会报告“Too many open files”,起因是file-max默认值(8096)太⼩。

要解决这个问题,可以root⾝份执⾏下列命令(或将它们加⼊/etc/rcS.d/*下的init脚本。

)# echo "65536" > /proc/sys/fs/file-max # 适⽤于2.2和2.4版内核# echo "131072" > /proc/sys/fs/inode-max # 仅适⽤于2.2版内核回答三、办法是修改操作系统的打开⽂件数量限制,⽅法如下:1. 按照最⼤打开⽂件数量的需求设置系统,并且通过检查/proc/sys/fs/file-max⽂件来确认最⼤打开⽂件数已经被正确设置。

# cat /proc/sys/fs/file-max如果设置值太⼩,修改⽂件/etc/sysctl.conf的变量到合适的值。

这样会在每次重启之后⽣效。

如果设置值够⼤,跳过下步。

# echo 2048 > /proc/sys/fs/file-max编辑⽂件/etc/sysctl.conf,插⼊下⾏。

fs.file-max = 81922. 在/etc/security/limits.conf⽂件中设置最⼤打开⽂件数,下⾯是⼀⾏提⽰:#添加如下这⾏。

linux最大打开文件数计算方式

linux最大打开文件数计算方式Linux是一个开源的操作系统,具有高度的灵活性和可定制性。

在Linux系统中,打开文件是对文件进行读取、写入或执行等操作的过程。

每个进程都有一个打开文件的限制,称为最大打开文件数。

了解如何计算Linux系统的最大打开文件数对于系统管理员和开发人员来说是非常重要的。

在Linux中,最大打开文件数是通过ulimit命令来设置和管理的。

ulimit命令用于限制进程资源的使用,包括打开文件数。

要查看当前系统的最大打开文件数限制,可以使用以下命令:ulimit -n该命令将返回当前进程的最大打开文件数限制。

如果返回值为“unlimited”表示没有限制,否则返回具体的数字表示最大打开文件数的限制。

要计算Linux系统的最大打开文件数,需要考虑以下几个因素:1.内核参数(fs.file-max):Linux内核有一个参数控制系统范围内的最大打开文件数。

这个参数通常存储在/proc/sys/fs/file-max 文件中。

可以使用以下命令查看该参数的值:cat /proc/sys/fs/file-max该命令将返回系统范围内的最大打开文件数的值。

注意,该值是一个系统级别的限制,而不是单个进程的限制。

2.用户级别限制(ulimit -n):ulimit命令可以用于设置和管理用户级别的资源限制,其中包括最大打开文件数限制。

系统管理员可以使用ulimit命令为特定用户或用户组设置最大打开文件数的限制。

要查看当前用户的最大打开文件数限制,可以使用以下命令:ulimit -n3.进程级别限制:每个进程在运行时都有一个最大打开文件数的限制。

这个限制可以由系统管理员在启动进程时设置,也可以由进程自身在运行过程中通过调用ulimit命令来设置。

要查看特定进程的最大打开文件数限制,可以使用以下命令:cat /proc/[进程ID]/limits上述命令将返回特定进程的资源限制,包括最大打开文件数限制。

Linux下设置最大文件打开数nofile及nr_open、file-max

Linux下设置最⼤⽂件打开数nofile及nr_open、file-max在开发运维的时候我们常常会遇到类似“Socket/File: Can’t open so many files”,“⽆法打开更多进程”,或是coredump过⼤等问题,这些都可以设置资源限制来解决。

今天在教某位客户设置最⼤⽂件数⽅法时,搜索⽹上的⽅法时发现各家说法并不⼀致,便写了这篇⽂档。

通常对Linux某个⽤户设置系统资源,我们都已经知道可以⽤ulimit命令来查看和设置。

表 1. ulimit 参数说明选项[options]含义例⼦-H设置硬资源限制,⼀旦设置不能增加。

ulimit – Hs 64;限制硬资源,线程栈⼤⼩为 64K。

-S设置软资源限制,设置后可以增加,但是不能超过硬资源设置。

ulimit – Sn 32;限制软资源,32 个⽂件描述符。

-a显⽰当前所有的 limit 信息。

ulimit – a;显⽰当前所有的 limit 信息。

-c最⼤的 core ⽂件的⼤⼩,以 blocks 为单位。

ulimit – c unlimited;对⽣成的 core ⽂件的⼤⼩不进⾏限制。

-d进程最⼤的数据段的⼤⼩,以 Kbytes 为单位。

ulimit -d unlimited;对进程的数据段⼤⼩不进⾏限制。

-f进程可以创建⽂件的最⼤值,以 blocks 为单位。

ulimit – f 2048;限制进程可以创建的最⼤⽂件⼤⼩为 2048 blocks。

-l最⼤可加锁内存⼤⼩,以 Kbytes 为单位。

ulimit – l 32;限制最⼤可加锁内存⼤⼩为 32 Kbytes。

-m最⼤内存⼤⼩,以 Kbytes 为单位。

ulimit – m unlimited;对最⼤内存不进⾏限制。

-n可以打开最⼤⽂件描述符的数量。

ulimit – n 128;限制最⼤可以使⽤ 128 个⽂件描述符。

-p管道缓冲区的⼤⼩,以 Kbytes 为单位。

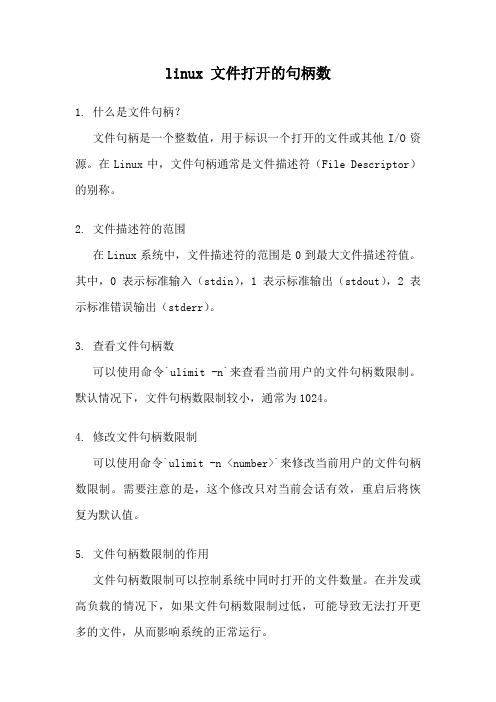

linux 文件打开的句柄数

linux 文件打开的句柄数1. 什么是文件句柄?文件句柄是一个整数值,用于标识一个打开的文件或其他I/O资源。

在Linux中,文件句柄通常是文件描述符(File Descriptor)的别称。

2. 文件描述符的范围在Linux系统中,文件描述符的范围是0到最大文件描述符值。

其中,0表示标准输入(stdin),1表示标准输出(stdout),2表示标准错误输出(stderr)。

3. 查看文件句柄数可以使用命令`ulimit -n`来查看当前用户的文件句柄数限制。

默认情况下,文件句柄数限制较小,通常为1024。

4. 修改文件句柄数限制可以使用命令`ulimit -n <number>`来修改当前用户的文件句柄数限制。

需要注意的是,这个修改只对当前会话有效,重启后将恢复为默认值。

5. 文件句柄数限制的作用文件句柄数限制可以控制系统中同时打开的文件数量。

在并发或高负载的情况下,如果文件句柄数限制过低,可能导致无法打开更多的文件,从而影响系统的正常运行。

6. 查看当前文件句柄数使用情况可以使用命令`cat /proc/sys/fs/file-nr`来查看当前系统中已分配的文件句柄数和可用的文件句柄数。

其中,第一个数字表示已分配的文件句柄数,第二个数字表示可用的文件句柄数。

7. 修改全局文件句柄数限制可以通过修改系统配置文件来修改全局文件句柄数限制。

具体的配置文件路径和修改方法可能因不同的Linux发行版而有所不同。

8. 文件句柄数限制与进程数限制的关系文件句柄数限制与进程数限制是相关的。

当一个进程达到了文件句柄数限制,就无法再打开更多的文件,从而可能导致无法创建更多的子进程。

9. 文件句柄数限制与网络连接数的关系在Linux中,网络连接也使用文件句柄来表示。

因此,文件句柄数限制也会影响到系统能够同时处理的网络连接数。

10. 如何优化文件句柄数限制为了提高系统的并发性能,可以适当增加文件句柄数限制。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

3. 修改 /etc/rc.local 添加

echo 8061540 > /proc/sys/fs/file-max

做完3个步骤,就可以了。

补充说明:

/proc/sys/fs/file-max

该文件指定了可以分配的文件句柄的最大数目。如果用户得到的错误消息声明由于打开文件数已经达到了最大值,从而他们不能打开更多文件,则可能需要增加该值。可将这个值设置成有任意多个文件,并且能通过将一个新数字值写入该文件来更改该值。

缺省设置:4096

/proc/sys/fs/file-nr

该文件与 file-max 相关,它有三个值:

已分配文件句柄的数目

已使用文件句柄的数目

文件句柄的最大数目

该文件是只读的,仅用于显示信息。

关于“打开文件数”限制

Linux系统上对每一个用户可使用的系统资源都是有限制的,这是多用户系统必然要采用的一种资源管理手段,试想假如没有这种机制,那么任何一个普通用户写一个死循环程序,用不了多久系统就要“拒绝服务”了。

echo 8061540 > /proc/sys/fs/file-max

解决linux打开文件数1024限制的解决办法

上一篇 / 下一篇 2010-03-03 23:43:04 / 个人分类:linux

查看( 290 ) / 评论( 0 ) / 评分( 0 / 0 )

linux为redhat服务器版本(非个人版),必须设置的内容

带着疑虑,又在网上搜索了许久,未果(实际上是我搜索的关键字不够准确)。

最后终于在内核文档/usr/src/linux/Documentation/sysctl/fs.txt里找到下面一段话:

file-max & file-nr:

The kernel allocates file handles dynamically, but as yet it doesn’t free them again. The value in file-max denotes the maximum number of file-handles that the Linux kernel will allocate. When you get lots of error messages about running out of file handles, you might want to increase this limit.

候使用的是root用户,而当我再次使用普通用户测试的时候,预料中的错误信息出现了:”Too many open files in system”。可见,file-max的减少对系统也是影响力的。前面的结论“所以我猜想对于file-max的任何减少的操作都是毫无意义的”是错误 的。

其中大部分的信息中提到 将 /proc/sys/fs

/file-max的值设置为4096和ulimit -n 4096是相同的效果。对此我很怀疑,为什么呢?首先ulimit 是一个普通用户也可以使用的命令,而fs.file-max只有root有权设置。其次,很明显fs.file-max是一个全局的设置,而ulimit 是一个局部的设置,很明显的是不相同的。

57 24244

57 24231

56 24264

其中第一行是打开的文件句柄数量,第二行是进程号。得到进程号后,我们可以通过ps命令得到进程的详细内容。

ps -aef|grep 24204

mysql 24204 24162 99 16:15 ? 00:24:25 /usr/sbin/mysqld

----------------------------------------------------------------------------

1、/etc/pam.d/login 添加

session required /lib/security/pam_limits.so

注意看这个文件的注释

然后便是/etc/security/limits.conf文件,这个文件很简单,一看就能明白。

于是我按照注释中描述的格式两个两行:

* soft nofile 4096

* hard nofile 4096

恐怖的是,网上居然有人说改了这个设置是需要重启系统的!实在是让人想不通啊,鼎鼎大名的UNIX系统,怎么可能因为这么小小的一个改动就需要 重启系统呢?结果当我再次以普通用户登录的时候,那个”ulimit: open files: cannot modify limit: Operation not permitted”提示没有了,查看ulimit -n,果然已经变成了4096。

linux lsof 修改句柄限制(转)

在Linux下,我们使用ulimit -n 命令可以看到单个进程能够打开的最大文件句柄数量(socket连接也算在里面)。系统默认值1024。

对于一般的应用来说(象Apache、系统进程)1024完全足够使用。但是如何象squid、mysql、java等单进程处理大量请求的应用来说就有点捉襟见肘了。如果单个进程打开的文件句柄数量超过了系统定义的值,就会提到“too many files open”的错误提示。如何知道当前进程打开了多少个文件句柄呢?下面一段小脚本可以帮你查看:

2. /etc/security/limits.conf 添加

www – nofile 1006154

www 是一个用户,如果是想所有用户生效的话换成 * ,设置的数值与硬件配置有关,别设置太大了。

-----------------------------------------------------------------------------

ulimit -HSn 4096

以上命令中,H指定了硬性大小,S指定了软性大小,n表示设定单个进程最大的打开文件句柄数量。个人觉得最好不要超过4096,毕竟打开的文件句柄数越多响应时间肯定会越慢。设定句柄数量后,系统重启后,又会恢复默认值。如果想永久保存下来,可以修改.bash_profile文件,可以修改 /etc/profile 把上面命令加到最后。

1024

程序限制只能打开1024个文件

使用[root@lxadmin nginx]# ulimit -n 8192调整一下

这两段话的大致意思是:

内核动态地分配和释放“file handles”(句柄)。file-max的值是内核所能分配到的最大句柄数。当你收到大量关于句柄用完的错误信息时,你可以需要增加这个值以打破老的限制。

file-nr中的三个值的含意分别是:系统已经分配出去(正在使用)的句柄数,没有用到的句柄数和所有分配到的最大句柄数。当分配出去的句柄数接近 最大句柄数,而“无用的句柄数”大于零时,表明你遇到了一个“句柄”使用高峰,这意为着你不需要增加file-max的值。

The three values in file-nr denote the number of allocated file handles, the number of unused file handles and the maximum number of file handles. When the allocated file handles come close to the maximum, but the number of unused file handles is significantly greater than 0, you’ve encountered a peak in your usage of file handles and you don’t need to increase the maximum.

回答、

[root@lxadmin nginx]# cat /proc/sys/fs/file-max

8192

文件系统最大可打开文件数

[root@lxadmin nginx]# ulimit -n

看完这段话,相信大家都明白了。file-max是系统全局的可用句柄数。根据我后来又翻查的信息,以及对多个系统的查看求证,这个参数的默认值是跟内存大小有关系的,增加物理内存以后重启机器,这个值会增大。大约1G内存10万个句柄的线性关系。

再回过头来看这两段话,不知道你意识到了没有,文中只提到了file-max的增加,而没有提到了该值的减少。那些在操作ulimit时同时操 作了file-max的哥们儿,估计无一例外地将file-max设置成了4096或者2048。但以似乎也没有因此而导致系统无法打开文件或者建议连 接。(实际上,我将file-max的值设备成256,然后使用shell编写用vi打开500个文件角本运行,并没有得到任何错误信息,查看file- nr的值,系统当前分配的句柄值已经远超过了后面的最大值。所以我猜想对于file-max的任何减少的操作都是毫无意义的,姑且不去管他。实践中需要减 少file-max的时候总是不多见的。 )实事证明我犯了一个致命的错误。我测试的时

lsof |wc -l (lsof pid|wc -l)

1、修改当前 ulimit -n 8192

2. /etc/security/limits.conf 添加

www – nofile 1006154

哦,原来是mysql进程打开最多文件句柄数量。但是他目前只打开了131个文件句柄数量,远远底于系统默认值1024。

但是如果系统并发特别大,尤其是squid服务器,很有可能会超过1024。这时候就必须要调整系统参数,以适应应用变化。Linux有硬性限制和软性限制。可以通过ulimit来设定这两个参数。方法如下,以root用户运行以下命令:

lsof -n |awk ‘{print $2}’|sort|uniq -c |sort -nr|more