ETL工具kettle

kettle操作手册

1.什么Kettle?Kettle是一个开源的ETL(Extract-Transform-Load的缩写,即数据抽取、转换、装载的过程)项目,项目名很有意思,水壶。

按项目负责人Matt的说法:把各种数据放到一个壶里,然后呢,以一种你希望的格式流出。

Kettle包括三大块:Spoon——转换/工作(transform/job)设计工具(GUI方式)Kitchen——工作(job)执行器(命令行方式)Span——转换(trasform)执行器(命令行方式)Kettle是一款国外开源的etl工具,纯java编写,绿色无需安装,数据抽取高效稳定。

Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

2.Kettle简单例子2.1下载及安装Kettle下载地址:/projects/pentaho/files现在最新的版本是 3.6,为了统一版本,建议下载 3.2,即下载这个文件pdi-ce-3.2.0-stable.zip。

解压下载下来的文件,把它放在D:\下面。

在D:\data-integration文件夹里,我们就可以看到Kettle的启动文件Kettle.exe或Spoon.bat。

2.2 启动Kettle点击D:\data-integration\下面的Kettle.exe或Spoon.bat,过一会儿,就会出现Kettle的欢迎界面:稍等几秒,就会出现Kettle的主界面:2.3 创建kettle后台管理点击【新建】,新建资源库信息这里我们选择KETTLE 后台管理数据库的类型,以及配置JDBC设置完成后,点击【创建或更新】,将会在指定的数据库里面新建KETTLE的后台管理数据表。

再设置【名称】,点击【确定】。

回到登陆界面,选择新建的【资源库】,输入用户账号密码(默认账号:admin,密码:admin)进入KTETTLE 的开发界面2.4 kettle说明主对象树:转换(任务),作业(JOB)核心对象:主对象中可用的组件2.5 值映射组件使用的字段名:源字段目标字段名:目标字段源值:源数据的值目标值:替换的值注:最好先将源值去空格,再进行替换2.6 增加常量组件名称:映射字段类型:字段类型格式:数据格式长度:值:常量的值2.7计算器组件新字段:映射字段计算:计算类型字段A,B,C:需计算的字段值类型:数据的类型2.8获取系统信息组件名称:显示的名称类型:显示的类型(系统时间,IP,指令等等)2.9增加序列组件值的名称:映射值的名称起始值:序列的初始值增加值:设置增加的值最大值:设置最大值2.10 表输出组件数据库连接:设置数据库目标表:设置目标的表提交记录数量:设置提交数量忽略插入错误:跳过错误,继续执行指定库字段:数据库字段:选择插入的字段2.11 多路选择(Switch/Case) 组件更多路选择的字段:设置Switch的字段分支值的数据类型:设置值的类型分支值:值:设置case的值目标步骤:跳过的操作步骤缺省的目标步骤:未通过的操作步骤2.12 Null if... 组件名称:选择替换的字段需要转换成NULL的值:需要转换成NULL的值2.12 执行SQL脚本组件数据库连接:选择数据库SQL script :输入要执行的SQL语句参数:设置要替换的参数字段2.13 Modified Java Script Value 组件Java Script:脚本的输入:输入字段:输出字段字段名称:定义的字段名改成为:新的字段名类型:字段类型Replace Value:是否替换的值2.14 合并记录组件旧数据源:输入数据源新数据源:输入数据源匹配关键字段:匹配关键字段数据字段:数据字段2.15 记录关联(笛卡尔输出) 组件条件:输入关联的条件2.16 Merge Join 组件第一个步骤:第一个操作的步骤第二个步骤:第二个操作的步骤步骤选择的字段:步骤关联的字段2.17 行转列组件关键字:选择表的关键字分组字段:分组的字段目标字段:选择目标在字段VALUE:值字段名称关键字值:关键字值类型:数据类型2.18 生成随机值组件名称:新生成字段名类型:随机数的类型2.19 去除重复行组件字段名称:关键字的字段忽略大小写:是否忽略大小写注意:去掉重复行需先排序2.20 插入/ 更新组件数据库连接:选择数据库目标表:选择目标表不执行任何更新:是否执行更新操作查询的关键字:关键字更新字段:选择要插入更新的字段2.21 表输入组件数据库连接:选择数据库SQL:输入SQL语句预览:数据预览获得SQL查询语句:获得SQL查询语句2.22 排序记录组件字段名称:选择排序的字段名称升序:是否升序大小写敏感:是否区分大小写2.23 XML输出组件文件名称:输出文件的名称跟路径扩展:扩展名2.24 文本文件输出组件文件名称:输出文件的名称跟路径扩展:扩展名2.25 Write to log 组件日志级别:选择日志级别字段:选择打印的字段2.26 过滤记录组件条件:输入条件发送True给的步骤:返回True的步骤发送false给的步骤:返回false的步骤2.27 JOB定时组件重复:是否重复类型:选择类型2.28 转换组件转换文件名:选择执行转换的文件指定日志文件:输出日志文件2.5 命令行运行ktr和kjb在上面的过程中,我们都是在IDE工具中,直接点击按钮进行运行文件的,但在实际中,我们需要脱离IDE,进行单独的运行,这时就必须用到命令行来运行文件了。

kettle etl设计方案

kettle etl设计方案1. 引言Kettle是一款强大的ETL(Extract, Transform, Load)工具,可以帮助用户实现数据的抽取、转换和加载。

本文档旨在介绍Kettle的设计方案,包括架构设计、任务调度、数据传输等重要内容。

2. 架构设计Kettle的架构由三个主要组件组成:Spoon、Pan和Kitchen。

•Spoon:是Kettle的图形用户界面工具,用于创建和编辑Kettle的转换和作业。

•Pan:是一个命令行工具,用于在命令行模式下执行Kettle的转换和作业。

•Kitchen:也是一个命令行工具,用于在命令行模式下执行Kettle的作业,和Pan相比,Kitchen可以更好地管理和监控作业的执行过程。

Kettle的架构还包括一个元数据数据库,用于存储转换和作业的定义、日志、错误信息等。

3. 任务调度Kettle提供了多种任务调度的方式,可以根据实际需求选择合适的方式。

3.1 定时任务调度Kettle可以通过定时任务调度器(例如Quartz)实现定时执行转换和作业。

用户可以配置任务的执行时间、频率和参数等信息,实现自动化的数据处理。

3.2 事件触发任务调度Kettle还支持通过事件触发的任务调度。

用户可以定义一个事件,当满足特定条件时触发任务的执行。

例如,可以设置一个文件变化的事件,当指定的文件发生变化时,触发转换或作业的执行。

4. 数据传输Kettle支持多种数据传输方式,可以方便地从源数据源中抽取数据、进行转换,并加载到目标数据源中。

4.1 数据抽取Kettle可以从各种关系型数据库、文件系统、Web服务等数据源中抽取数据。

用户可以通过Kettle提供的数据抽取组件,配置数据源的连接信息、查询语句等参数,实现数据的快速抽取。

4.2 数据转换Kettle的转换组件提供了丰富的数据转换功能,包括数据清洗、数据过滤、字段映射、数据计算等操作。

用户可以通过拖拽转换组件并连接它们,定义数据的转换逻辑和处理流程。

kettle 核心对象详解

kettle 核心对象详解Kettle是一种开源的ETL工具,用于数据集成、转换和加载。

它是由Pentaho公司开发的,旨在简化数据仓库和商业智能应用程序的开发过程。

Kettle的核心对象包括作业(Job)和转换(Transformation),它们是构建ETL过程的基本单位。

作业是一个由一系列步骤组成的流程,用于执行一系列相关的任务。

每个步骤代表一个特定的操作,如读取数据、转换数据或写入数据。

作业可以通过连接这些步骤来定义数据流,以便在不同的步骤之间传递数据。

作业可以被调度执行,也可以手动触发执行。

转换是一个更加灵活的单位,它由一系列的转换步骤组成。

每个转换步骤代表一个特定的转换操作,如过滤数据、排序数据或合并数据。

转换步骤可以通过连接来定义数据流,以便在不同的步骤之间传递数据。

转换可以作为作业的一部分执行,也可以独立地执行。

Kettle的核心对象还包括字段(Field)、记录集(Rowset)和数据库连接(Database Connection)。

字段是数据集中的一个列,代表一个特定的数据类型。

记录集是一组记录的集合,每个记录包含一组字段的值。

数据库连接是与数据库建立连接的对象,用于读取和写入数据。

Kettle还提供了丰富的步骤和插件,用于执行各种数据集成和转换操作。

例如,输入步骤用于从各种数据源读取数据,输出步骤用于将数据写入不同的目标,转换步骤用于对数据进行各种转换操作,脚本步骤用于执行自定义的脚本代码等。

Kettle的核心对象可以通过图形界面进行配置和管理。

用户可以使用Kettle的可视化工具来创建、编辑和管理作业和转换。

通过拖放和连接步骤,用户可以轻松地定义数据流和转换操作。

Kettle还支持参数化配置,允许用户在运行时动态地配置作业和转换。

Kettle的核心对象具有很高的灵活性和可扩展性。

用户可以根据自己的需求定义和定制各种步骤和插件。

Kettle还支持脚本编程,允许用户使用JavaScript、Python等脚本语言来扩展和定制ETL过程。

kettle原理

kettle原理Kettle原理概述:Kettle是一个强大的ETL工具,可以实现不同数据源(如关系型数据库、CSV、Excel、XML等)之间的数据抽取、转换和装载操作,是BI系统中不可缺少的一部分。

Kettle 作为一个开源的工具,目前已经被大量应用于企业信息化建设。

Kettle的原理主要包括以下几个方面:数据抽取:Kettle支持多种不同的数据源,包括关系型数据库、CSV、Excel、XML等等。

在数据抽取的过程中,Kettle的主要目标是将这些数据源中的数据尽可能地准确、高效地抽取出来。

Kettle的采用基于元数据的开发方式,通过对目标数据源的格式及其对应的元数据进行映射,实现对真实数据源的精准操作。

数据转换:数据转换是指将抽取出来的数据进行数据清洗、过滤、变换等操作,以适应目标数据仓库的格式和需求。

在数据转换的过程中,Kettle提供了丰富的数据处理组件,可以完成数据的各种复杂操作。

数据装载:数据装载是指将转换后的数据直接存储到目标数据仓库中,以供后续的数据分析和应用。

Kettle支持多种数据仓库,包括关系型数据库、NoSQL数据库、文件系统等等,并且提供了多种数据装载方式,包括全量+增量、覆盖+追加等不同方式,以适应不同的应用场景。

核心原理:Kettle的核心原理包括元数据、元数据驱动开发、基于JDBC的数据抽取和加载等方面:元数据:Kettle将数据源和目标数据仓库定义为元数据,这些元数据包括需要连接的数据库地址、用户名和密码,以及数据库表名、字段名、数据类型等信息。

通过对元数据的定义,Kettle可以自动识别和映射不同数据源之间的差异,从而实现快速、准确地数据抽取和装载操作。

元数据驱动开发:Kettle采用了元数据驱动的开发方式,可以在元数据的基础上进行大规模的开发和部署操作。

在该开发模式下,开发人员只需要定义数据源和目标数据仓库的元数据,就可以直接使用Kettle提供的各种模板和组件实现数据的抽取、转换和装载操作,从而大大简化了BI系统的开发和维护。

kettle的基本介绍

kettle的基本介绍Kettle主要内容:⼀.ETL介绍⼆.Kettle介绍三.调⽤Kettle API⼀、ETL介绍1. ETL是什么?1).ETL分别是“Extract”、“ Transform” 、“Load”三个单词的⾸字母缩写也即数据抽取、转换、装载的过程,但我们⽇常往往简称其为数据抽取。

ETL包含了三⽅⾯:Extract(抽取):将数据从各种原始的业务系统中读取出来,这是所有⼯作的前提。

⼀般抽取过程需要连接到不同的数据源,以便为随后的步骤提供数据。

这⼀部分看上去简单⽽琐碎,实际上它是 ETL 解决⽅案的成功实施的⼀个主要障碍。

Transform(转换):按照预先设计好的规则将抽取得数据进⾏转换,使本来异构的数据格式能统⼀起来。

任何对数据的处理过程都是转换。

这些处理过程通常包括(但不限于)下⾯⼀些操作:移动数据根据规则验证数据数据内容和的修改将多个数据源的数据集成根据处理后的数据计算派⽣值和聚集值Load(装载):将转换完的数据按计划增量或全部导⼊到数据仓库中。

也就是说将数据加载到⽬标系统的所有操作。

2).ETL是(Extract)、清洗(Cleaning)、转换(Transform)、装载(Load)的过程。

是构建的重要⼀环,⽤户从抽取出所需的数据,经过,最终按照预先定义好的数据仓库模型,将数据加载到数据仓库中去。

3).ETL是BI/DW( Business Intelligence/Data Warehouse , 商务智能/数据仓库)的核⼼和灵魂,按照统⼀的规则集成并提⾼数据的价值,是负责完成数据从数据源向⽬标数据仓库转化的过程,是实施数据仓库的重要步骤。

DW(Data Warehouse)即数据仓库:这个概念是由被誉为“数据仓库之⽗”的WilliamH.Inmon博⼠提出的:数据仓库是⼀个⾯向主题的、集成的、随时间变化的、信息相对稳定的数据集合,它⽤于对企业管理和决策提供⽀持。

Kettle简介及使用

Kettle简介及使⽤1.1 ETL简介ETL(Extract-Transform-Load的缩写,即数据抽取、转换、装载的过程),对于企业或⾏业应⽤来说,我们经常会遇到各种数据的处理,转换,迁移,所以了解并掌握⼀种ETL⼯具的使⽤,必不可少。

市⾯上常⽤的ETL⼯具有很多,⽐如Sqoop,DataX,Kettle,Talend等,作为⼀个⼤数据⼯程师,我们最好要掌握其中的两到三种,这⾥我们要学习的ETL⼯具是Kettle!1.2.1 Kettle是什么Kettle是⼀款国外开源的ETL⼯具,纯java编写,可以在Window、Linux、Unix上运⾏,绿⾊⽆需安装,数据抽取⾼效稳定。

Kettle 中⽂名称叫⽔壶,该项⽬的主程序员MATT 希望把各种数据放到⼀个壶⾥,然后以⼀种指定的格式流出。

Kettle这个ETL⼯具集,它允许你管理来⾃不同数据库的数据,通过提供⼀个图形化的⽤户环境来描述你想做什么,⽽不是你想怎么做。

Kettle中有两种脚本⽂件,transformation和job,transformation完成针对数据的基础转换,job则完成整个⼯作流的控制。

Kettle(现在已经更名为PDI,Pentaho Data Integration-Pentaho数据集成)。

1.2.2 Kettle的两种设计1.2.3 Kettle的核⼼组件1.2.4 Kettle特点2.1 Kettle下载2.2 Kettle安装部署2.2.1 概述在实际企业开发中,都是在本地Windows环境下进⾏kettle的job和Transformation开发的,可以在本地运⾏,也可以连接远程机器运⾏2.2.2 安装1) 安装jdk,版本建议1.8及以上2) 下载kettle压缩包,因kettle为绿⾊软件,解压缩到任意本地路径即可3) 双击Spoon.bat,启动图形化界⾯⼯具,就可以直接使⽤了2.3 Kettle界⾯简介2.3.1 ⾸页2.3.2 转换2.3.3 作业2.4 Kettle转换初次体验体验案例:将csv⽂件⽤Kettle转换成excel⽂件1)在Kettle中新建⼀个转换,然后选择转换下⾯的“csv⽂件输⼊”和“Excel输出”控件验.csv),然后点击下⾯的获取字段按钮,将我们需要的字段加载到kettle中3)按住键盘SHIFT键,并且点击⿏标左键将两个控件链接起来,链接时选择“主输出步骤”4)双击Excel输出控件,在弹出的设置框⾥设置⽂件输出路径和⽂件名称,然后点击上⾯的字段框,依次点击下⾯的获取字段和最⼩宽度,获取到输出字段。

2024版年度搞定Kettle详细教程

降低工作强度。

12

03

数据抽取、转换与加载实战演练

2024/2/3

13

数据源连接配置方法论述

确定数据源类型

根据实际需求选择合适的数据源类型,如关系 型数据库、文件、API等。

2024/2/3

配置数据源连接参数

根据所选数据源类型,配置相应的连接参数,如数据 库地址、端口、用户名、密码等。

测试数据源连接

可视化展示

通过图表等方式直观展示监控指标和报警信息,提高问题发现和处理 效率。

2024/2/3

21

Hale Waihona Puke 日志查看和问题排查方法根据日志信息快速定位问题所在,如 数据源连接失败、数据转换错误等。

对问题排查和解决过程进行总结和归 纳,形成经验库,为后续类似问题提 供参考和借鉴。

日志查看

问题定位

问题解决

经验总结

提供详细的日志查看功能,包括任务 执行日志、系统日志等,以便追踪任 务执行过程和排查问题。

2024/2/3

针对定位到的问题,提供相应的解决 方案和修复措施,确保任务能够恢复 正常执行。

22

05

高级功能拓展与应用场景探讨

2024/2/3

23

自定义函数编写技巧分享

掌握Kettle内置函数

了解并熟悉Kettle提供的内置函数,包括字符串处理、日期转换、 数学计算等,为编写自定义函数打下基础。

2024/2/3

3

Kettle简介及应用场景

1

Kettle是一款开源的ETL工具,全称为Pentaho Data Integration,主要用于数据抽取、转换和 加载。

2

Kettle可以应用于数据迁移、数据整合、数据处 理等多种场景,支持多种数据源和数据格式。

kettle的用法

kettle的用法Kettle 是一款开源的 ETL(Extract, Transform, Load)工具,用于数据的提取、转换和加载。

它提供了一个图形化界面,使用户能够通过拖拽和连接组件来构建数据处理流程。

下面是一些 Kettle 的基本用法:1. 安装和启动 Kettle:首先,你需要下载并安装 Kettle。

然后,启动 Kettle 并打开 Spoon 应用程序。

2. 创建转换(Transformation):在 Spoon 中,点击“File”菜单,选择“New”,然后选择“Transformation”来创建一个新的转换。

3. 添加源和目标:在转换设计界面中,你可以通过拖拽源(Source)和目标(Target)组件来定义数据的来源和去处。

例如,你可以添加一个 CSV 文件读取源来读取 CSV 数据,然后添加一个数据库写入目标来将数据写入数据库。

4. 配置源和目标:双击源或目标组件,可以配置它们的属性。

你需要提供适当的连接信息、文件路径或数据库表名等。

5. 添加转换步骤:在源和目标之间,你可以添加各种转换步骤来对数据进行处理。

例如,你可以使用过滤(Filter)、排序(Sort)、字段转换(Field Transformer)等组件来修改数据。

6. 连接组件:通过连接(Connector)将源、转换步骤和目标组件连接起来,以定义数据的流动路径。

7. 运行转换:在完成转换设计后,你可以点击运行(Run)按钮来执行转换。

Kettle 将执行转换步骤,并将结果输出到目标。

8. 创建作业(Job):除了转换,你还可以创建作业来执行一系列相关的转换。

作业可以按照顺序执行多个转换,并可以设置执行时间和条件。

9. 保存和部署:在完成转换或作业的设计后,记得保存你的工作。

你可以将转换或作业保存为 KTR 或 JAR 文件,以便在其他环境中部署和运行。

这只是 Kettle 的一些基本用法,它还提供了更多高级功能和扩展选项,例如数据清洗、数据集成、数据仓库等。

kettle原理

kettle原理Kettle原理。

Kettle是一种开源的ETL工具,ETL是Extract-Transform-Load的缩写,意为数据抽取、转换和加载。

Kettle主要用于数据仓库的建设和维护,它提供了强大的数据抽取、转换和加载功能,能够帮助用户快速、高效地实现数据的处理和分析。

Kettle原理是指Kettle工具实现数据处理的基本原理和机制,下面将详细介绍Kettle的原理。

首先,Kettle采用了元数据驱动的设计思想,即通过元数据描述数据处理的逻辑和流程。

元数据是描述数据的数据,它包括数据的结构、属性、关系、约束等信息。

在Kettle中,用户可以通过图形化界面设计数据处理的流程,包括数据抽取、转换和加载的步骤,每个步骤都可以通过元数据进行配置和定制。

这种设计思想使得Kettle具有很高的灵活性和可扩展性,用户可以根据实际需求定制和修改数据处理的流程,而不需要修改程序代码。

其次,Kettle采用了基于插件的架构,即Kettle的核心功能是由一系列插件组成的。

每个插件负责实现特定的功能,比如数据抽取、数据转换、数据加载等。

用户可以根据自己的需求选择和配置不同的插件,从而实现不同的数据处理功能。

这种架构使得Kettle具有很高的可扩展性和灵活性,用户可以根据实际需求定制和扩展Kettle的功能,而不需要修改程序代码。

另外,Kettle采用了基于元数据的数据处理引擎,即Kettle的数据处理是通过元数据驱动的。

在Kettle中,用户可以通过元数据描述数据处理的逻辑和流程,包括数据抽取、转换和加载的步骤,每个步骤都可以通过元数据进行配置和定制。

Kettle的数据处理引擎会根据元数据自动生成数据处理的代码,然后执行数据处理的流程。

这种设计思想使得Kettle具有很高的灵活性和可扩展性,用户可以根据实际需求定制和修改数据处理的流程,而不需要修改程序代码。

最后,Kettle采用了基于元数据的作业调度引擎,即Kettle的作业调度是通过元数据驱动的。

ETL开源工具kettle学习笔记

ETL开源⼯具kettle学习笔记⼀ Kettle配置与部署1.下载kettle安装包下载kettle压缩包,解压缩到任意本地路径。

2.安装和配置jdk3.运⾏kettle在windows中执⾏spoon.bat,在类unix系统中执⾏spoon.sh。

⼆ kettle⽂档教程官⽅教程csdn博客(翻译)三 kettle的HelloWorld⽰例环境准备开始设计⼀个转换之前,我们先创建⼀个⽂件夹Tutorial,我们将保存所有的⽂件到该⽂件夹中,然后创建⼀个csv⽂件,内容就是前⾯⼈员信息,你可以复制到⽂本⽂件中,然后命名为list.csv。

设计转换有三个⼦任务组成:ü 创建⼀个转换ü 设计转换中的步骤和连接ü 配置步骤和连接创建转换1) 点击⽂件菜单中新建,或者通过快捷键Ctrl+N,选择转换.2) 在“主对象树”视图中点右击转换1,然后点击设置,或者在设计界⾯中右击,然后点击转换设置,或者使⽤Ctrl+T快捷⽅式。

3) 在设置窗⼝中可以设置转换的相关属性;我们这⾥写名称和描述,然后保存。

4) 保存该转换到Tutorial⽂件夹中,命名为hello,最终创建了hello.ktr⽂件。

步骤和连接pan命令pan是在终端执⾏转换的⼯具。

在window是pan.bat,其他平台是pan.sh,在安装⽬录可以找到。

如果你直接运⾏pan,不加任何选项,可以看到pan打印所有的选项。

简单命令如下:pan /file <Job_path>/Hello.ktl/norep/norep 选项是让spoon不要去连接资源库;/file是转换⽂件的名称;<job_path>是我们教程⽂件夹,如:c:/tutorial 或/home/tutorial其他选项在运⾏时是缺省值;你输⼊命令并确定后,转换同样被执⾏。

这时,⽇志被打印到终端界⾯中,也可以设置⽇志打印到⽂件中。

kettle数据库连接的用法

Kettle数据库连接的用法一、Kettle概述Kettle是一款开源的ETL工具,由Pentaho公司开发,是业界公认的ETL工具之一。

Kettle具有可视化的操作界面,基于元数据实现数据抽取、转换和装载的功能,同时支持多种数据库和文件格式的数据源。

在Kettle中,连接数据库是进行数据处理的基础操作之一,本文将从Kettle数据库连接的使用方法进行详细介绍。

二、Kettle数据库连接的配置步骤1. 打开Kettle打开Kettle软件,在左侧的导航栏中选择“数据库连接”,进入数据库连接配置界面。

2. 新建数据库连接在数据库连接界面,点击“新建”按钮,弹出新建数据库连接对话框。

3. 填写连接信息在新建数据库连接对话框中,填写数据库连接的相关信息,包括连接名称、数据库类型、数据库主机、端口号、数据库名称、用户名、密码等。

4. 测试连接填写完数据库连接信息后,点击“测试连接”按钮,测试连接是否成功。

如果连接成功,则会提示“连接成功”;如果连接失败,则会提示“连接失败”,需要重新检查连接信息。

5. 保存数据库连接测试连接成功后,点击“确定”按钮,保存数据库连接信息。

此时,就可以在数据库连接界面看到新建的数据库连接。

6. 修改和删除数据库连接在数据库连接界面,可以对已有的数据库连接进行修改和删除操作。

点击“编辑”按钮可以修改数据库连接信息,点击“删除”按钮可以删除数据库连接。

三、Kettle数据库连接的常见问题及解决方法1. 连接超时在使用Kettle连接数据库时,有时会遇到连接超时的问题,导致无法正常连接到数据库。

这时可以尝试以下解决方法:- 检查数据库连接信息是否填写正确,包括主机名、端口号、用户名和密码等;- 检查网络是否畅通,确保可以正常访问数据库服务器;- 增加连接超时时间,可以在数据库连接配置界面中设置连接超时时间。

2. 数据库版本不兼容在使用Kettle连接数据库时,有时会因为数据库版本不兼容而无法连接到数据库,这时可以尝试以下解决方法:- 更新Kettle版本,确保支持当前数据库的最新版本;- 更新数据库驱动程序,Kettle连接数据库需要使用相应数据库的驱动程序,确保使用的驱动程序与数据库版本兼容。

2024年史上最强Kettle培训教程

史上最强Kettle培训教程一、引言Kettle是一款开源的ETL工具,具有简单易用、功能强大、扩展性强等特点。

本教程旨在帮助读者全面了解Kettle的基础知识、高级应用以及最佳实践,从而掌握这款强大的ETL工具。

二、Kettle简介1.1Kettle概述Kettle是一款基于Java开发的ETL工具,主要用于数据抽取、转换和加载。

它由Pentaho公司开发,并在2006年开源。

Kettle支持多种数据源,如关系型数据库、文本文件、Excel文件等,并且提供了丰富的转换组件,可以满足各种复杂的数据处理需求。

1.2Kettle主要组件Kettle主要包括两个组件:Spoon和Pan。

Spoon是Kettle的图形界面设计工具,用于创建和编辑ETL转换;Pan是Kettle的命令行执行工具,用于执行Spoon中创建的转换。

三、Kettle基础教程2.1环境搭建2.2Spoon界面介绍启动Spoon,看到的是欢迎界面。

“新建”按钮,创建一个转换或作业。

在转换编辑界面,左侧为组件面板,右侧为画布。

在画布上,我们可以通过拖拽组件来创建ETL流程。

2.3创建转换在本节中,我们将学习如何创建一个简单的ETL转换。

从组件面板中拖拽一个“表输入”组件到画布上,双击该组件,设置数据库连接和SQL查询。

然后,拖拽一个“表输出”组件到画布上,双击该组件,设置目标数据库连接和表名。

将“表输入”和“表输出”组件连接起来,保存并运行转换。

2.4执行转换pan.sh-file=/path/to/your/transformation.ktr其中,`/path/to/your/transformation.ktr`为转换文件的路径。

四、Kettle高级教程3.1数据类型转换在ETL过程中,我们经常需要对数据进行类型转换。

Kettle提供了丰富的类型转换组件,如“复制记录”、“字段选择”等。

在本节中,我们将学习如何使用这些组件进行数据类型转换。

kettle 核心对象详解

kettle 核心对象详解以kettle核心对象详解为标题的文章Kettle是一款开源的ETL工具,广泛应用于数据仓库、数据集成和数据转换等领域。

它由一系列核心对象组成,这些对象在Kettle中扮演着重要的角色。

本文将详细介绍Kettle核心对象的功能和作用。

1. Transformation(转换)Transformation是Kettle中最重要的核心对象之一。

它代表了数据转换过程的抽象。

一个Transformation由多个步骤(Step)组成,每个步骤负责特定的数据处理操作。

通过将不同的步骤组合在一起,可以实现复杂的数据转换逻辑。

2. Job(作业)Job是另一个重要的核心对象,用于定义和管理Kettle的作业流程。

一个Job由多个作业条目(Entry)组成,每个作业条目代表一个具体的任务。

通过在作业中定义作业条目之间的依赖关系,可以实现作业的自动化执行。

3. Step(步骤)Step是Transformation中的基本处理单元,代表了具体的数据处理操作。

Kettle提供了丰富的步骤类型,包括数据输入输出、数据转换、数据过滤等。

通过将不同的步骤组合在一起,可以构建复杂的数据转换逻辑。

4. Entry(条目)Entry是Job中的基本处理单元,代表了具体的任务。

Kettle提供了多种类型的作业条目,包括作业、转换、脚本等。

通过将不同的作业条目组合在一起,可以构建复杂的作业流程。

5. Hop(连接)Hop代表了Transformation或Job中步骤或作业条目之间的连接关系。

通过定义Hops,可以实现数据的流动和任务的执行顺序。

每个Hop都有一个起始点和一个结束点,起始点和结束点可以是步骤、作业条目或起始/结束节点。

6. Database Connection(数据库连接)Database Connection是Kettle中连接数据库的重要对象。

通过定义数据库连接,可以在Transformation或Job中执行SQL查询、数据导入导出等操作。

开源ETL工具之Kettle介绍

开源ETL⼯具之Kettle介绍What起源Kettle是⼀个Java编写的ETL⼯具,主作者是Matt Casters,2003年就开始了这个项⽬,最新稳定版为7.1。

2005年12⽉,Kettle从2.1版本开始进⼊了开源领域,⼀直到4.1版本遵守LGPL协议,从4.2版本开始遵守Apache Licence 2.0协议。

Kettle在2006年初加⼊了开源的BI公司Pentaho, 正式命名为:Pentaho Data Integeration,简称“PDI”。

⾃2017年9⽉20⽇起,Pentaho已经被合并于⽇⽴集团下的新公司: Hitachi Vantara。

总之,Kettle可以简化数据仓库的创建,更新和维护,使⽤Kettle可以构建⼀套开源的ETL解决⽅案。

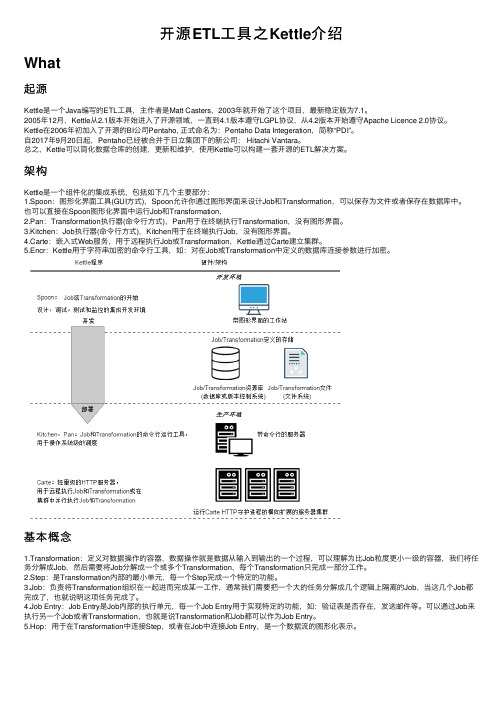

架构Kettle是⼀个组件化的集成系统,包括如下⼏个主要部分:1.Spoon:图形化界⾯⼯具(GUI⽅式),Spoon允许你通过图形界⾯来设计Job和Transformation,可以保存为⽂件或者保存在数据库中。

也可以直接在Spoon图形化界⾯中运⾏Job和Transformation,2.Pan:Transformation执⾏器(命令⾏⽅式),Pan⽤于在终端执⾏Transformation,没有图形界⾯。

3.Kitchen:Job执⾏器(命令⾏⽅式),Kitchen⽤于在终端执⾏Job,没有图形界⾯。

4.Carte:嵌⼊式Web服务,⽤于远程执⾏Job或Transformation,Kettle通过Carte建⽴集群。

5.Encr:Kettle⽤于字符串加密的命令⾏⼯具,如:对在Job或Transformation中定义的数据库连接参数进⾏加密。

基本概念1.Transformation:定义对数据操作的容器,数据操作就是数据从输⼊到输出的⼀个过程,可以理解为⽐Job粒度更⼩⼀级的容器,我们将任务分解成Job,然后需要将Job分解成⼀个或多个Transformation,每个Transformation只完成⼀部分⼯作。

2024版kettle使用教程(超详细)

分布式计算原理

阐述Kettle分布式计算的原理, 如何利用集群资源进行并行处理 和任务调度。

01 02 03 04

集群配置与部署

详细讲解Kettle集群的配置步骤, 包括环境准备、节点配置、网络 设置等。

集群监控与管理

介绍Kettle提供的集群监控和管 理工具,方便用户实时了解集群 状态和作业执行情况。

03

实战演练

以一个具体的实时数据处理任务为例, 介绍如何使用Kettle设计实时数据处理 流程。

案例四:Kettle在数据挖掘中应用

数据挖掘概念介绍

01

数据挖掘是指从大量数据中提取出有用的信息和知识的

过程,包括分类、聚类、关联规则挖掘等任务。

Kettle在数据挖掘中的应用

02

Kettle提供了丰富的数据处理和转换功能,可以方便地

Chapter

案例一:ETL过程自动化实现

ETL概念介绍

ETL即Extract, Transform, Load,是数据仓 库技术中重要环节,包括数据抽取、清洗、转 换和加载等步骤。

Kettle实现ETL过程

通过Kettle的图形化界面,可以方便地设计ETL流程, 实现数据的自动化抽取、转换和加载。

作业项配置

对作业项进行详细配置,包括数据源、目标库、 字段映射等。

作业项管理

支持作业项的复制、粘贴、删除等操作,方便快速构建作业。

定时任务设置与执行

定时任务设置

支持基于Cron表达式的定时任务设置,实现 周期性自动执行。

立即执行

支持手动触发作业执行,满足即时数据处理 需求。

执行日志查看

kettle工具用法 -回复

kettle工具用法 -回复Kettle 工具是一款强大的数据集成和数据处理工具,经常被用于数据仓库建设、ETL (Extract-Transform-Load)操作、数据清洗、数据迁移等方面。

在本文中,我们将一步一步地讨论Kettle 工具的用法。

第一步:安装和配置Kettle要开始使用Kettle 工具,首先你需要下载和安装Kettle。

Kettle 目前由Pentaho维护,你可以在其官方网站上获取到最新的稳定版本。

安装过程非常简单,只需按照指示一步步操作即可。

安装完成后,你需要配置Kettle 工具。

打开Kettle,你会看到一个配置向导。

在这个向导中,你需要设置一些基本的配置,如默认编码、默认数据库连接等。

根据你的实际需求,逐步完成配置向导。

第二步:创建一个新的转换(Transformation)在Kettle 中,转换是处理数据的基本单位。

一个转换由一系列的步骤(S t e p)组成,每个步骤执行特定的数据处理操作。

要创建一个新的转换,打开Kettle 并点击菜单栏上的“文件”选项,然后选择“新建转换”选项。

在弹出的对话框中,你可以输入一个名称来标识该转换,然后单击“确定”。

第三步:添加步骤(Step)转换中的每个步骤都有特定的功能。

在Kettle 的工具箱面板中,你可以找到各种可用的步骤,如读取数据源的输入步骤、过滤数据的过滤步骤、转换数据的转换步骤等。

你可以通过在工具箱中选择一个步骤并将其拖放到转换的画布中来添加步骤。

添加步骤后,你可以双击步骤来设置其属性。

每个步骤都有各自的属性对话框,你可以在其中配置步骤的输入、输出、转换逻辑等。

根据具体的需求,设置步骤的属性。

第四步:连接步骤在转换中,步骤之间需要进行连接以确定数据流的方向和顺序。

在Kettle 中,你可以通过拖动一个步骤的输出连接点并将其连接到另一个步骤的输入连接点来连接步骤。

连接步骤后,你可以通过双击连接线来设置连接的属性。

Kettle的使用说明

KETTLE使用说明简介Kettle是一款国外开源的ETL工具,纯java编写,可以在Window、Linux、Unix上运行,绿色无需安装,数据抽取高效稳定。

Kettle 中文名称叫水壶,该项目的主程序员MATT 希望把各种数据放到一个壶里,然后以一种指定的格式流出。

Kettle这个ETL工具集,它允许你管理来自不同数据库的数据,通过提供一个图形化的用户环境来描述你想做什么,而不是你想怎么做。

Kettle中有两种脚本文件,transformation和job,transformation完成针对数据的基础转换,job则完成整个工作流的控制。

Kettle可以在/网站下载到。

注:ETL,是英文Extract-Transform-Load 的缩写,用来描述将数据从来源端经过萃取(extract)、转置(transform)、加载(load)至目的端的过程。

ETL 一词较常用在数据仓库,但其对象并不限于数据仓库。

下载和安装首先,需要下载开源免费的pdi-ce软件压缩包,当前最新版本为5.20.0。

下载网址:/projects/pentaho/files/Data%20Integration/然后,解压下载的软件压缩包:pdi-ce-5.2.0.0-209.zip,解压后会在当前目录下上传一个目录,名为data-integration。

由于Kettle是使用Java开发的,所以系统环境需要安装并且配置好JDK。

žKettle可以在/网站下载ž 下载kettle压缩包,因kettle为绿色软件,解压缩到任意本地路径即可。

运行Kettle进入到Kettle目录,如果Kettle部署在windows环境下,双击运行spoon.bat 或Kettle.exe文件。

Linux用户需要运行spoon.sh文件,进入到Shell提示行窗口,进入到解压目录中执行下面的命令:# chmod +x spoon.sh# nohup ./spoon.sh & 后台运行脚本这样就可以打开配置Kettle脚本的UI界面。

kettle 用法

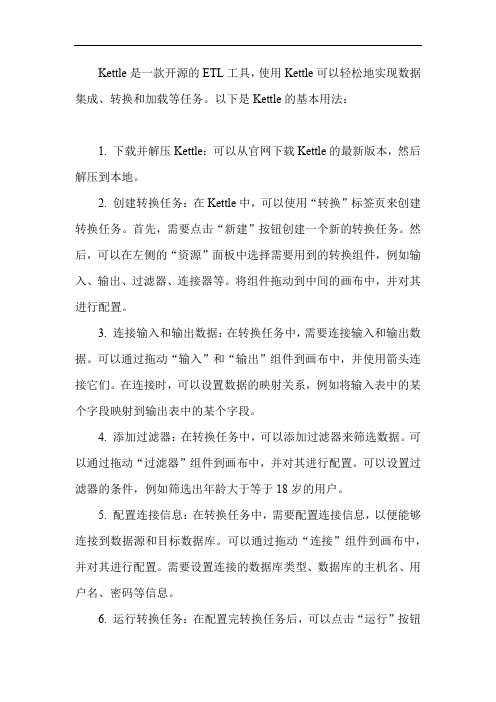

Kettle是一款开源的ETL工具,使用Kettle可以轻松地实现数据集成、转换和加载等任务。

以下是Kettle的基本用法:1. 下载并解压Kettle:可以从官网下载Kettle的最新版本,然后解压到本地。

2. 创建转换任务:在Kettle中,可以使用“转换”标签页来创建转换任务。

首先,需要点击“新建”按钮创建一个新的转换任务。

然后,可以在左侧的“资源”面板中选择需要用到的转换组件,例如输入、输出、过滤器、连接器等。

将组件拖动到中间的画布中,并对其进行配置。

3. 连接输入和输出数据:在转换任务中,需要连接输入和输出数据。

可以通过拖动“输入”和“输出”组件到画布中,并使用箭头连接它们。

在连接时,可以设置数据的映射关系,例如将输入表中的某个字段映射到输出表中的某个字段。

4. 添加过滤器:在转换任务中,可以添加过滤器来筛选数据。

可以通过拖动“过滤器”组件到画布中,并对其进行配置。

可以设置过滤器的条件,例如筛选出年龄大于等于18岁的用户。

5. 配置连接信息:在转换任务中,需要配置连接信息,以便能够连接到数据源和目标数据库。

可以通过拖动“连接”组件到画布中,并对其进行配置。

需要设置连接的数据库类型、数据库的主机名、用户名、密码等信息。

6. 运行转换任务:在配置完转换任务后,可以点击“运行”按钮来执行转换任务。

在运行时,需要选择转换任务的输入和输出路径,并设置其他相关参数。

如果一切正常,转换任务将会执行成功,并将数据加载到目标数据库中。

以上是Kettle的基本用法,通过Kettle可以轻松地实现数据集成、转换和加载等任务。

如果需要更复杂的操作,可以参考Kettle的官方文档或者搜索相关教程进行学习。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

概览Kettle也叫PDI(全称是Pentaho Data Integeration),是一款开源的ETL工具,项目开始于2003年,2006年加入了开源的BI 组织Pentaho, 正式命名为PDI。

官方网站:/术语1.Transformation转换步骤,可以理解为将一个或者多个不同的数据源组装成一条数据流水线。

然后最终输出到某一个地方,文件或者数据库等。

2.Job作业,可以调度设计好的转换,也可以执行一些文件处理(比较,删除等),还可以ftp上传,下载文件,发送邮件,执行shell命令等,3.Hop连接转换步骤或者连接Job(实际上就是执行顺序)的连线Transformation hop:主要表示数据的流向。

从输入,过滤等转换操作,到输出。

Job hop:可设置执行条件:1,无条件执行2,当上一个Job执行结果为true时执行3,当上一个Job执行结果为false时执行Kettle,etl设计及运行1.Kettle整体结构图Kettle整体结构图2.转换设计样例图绿色线条为hop,流水线转换设计样例3.运行方式使用java web start 方式运行的配置方法命令行方式1)Windows下执行kitchen.bat,多个参数之间以“/”分隔,Key和value以”:”分隔例如:kitchen.bat /file:F:\samples\demo-table2table.ktr /level:Basic /log:test123.log/file:指定转换文件的路径/level:执行日志执行级别/log: 执行日志文件路径2)Linux下执行kitchen.sh,多个参数之间以“-”分隔,Key和value以”=”分隔kitchen.sh -file=/home/updateWarehouse.kjb -level=Minimal如果设计的转换,Job是保存在数据库中,则命令如下:Kitchen.bat /rep:资源库名称/user:admin /pass:admin /job:job名4.Xml保存转换,job流程设计用户定义的作业可以保存在(xml格式)中或某一个特定的数据库中转换的设计文件以.ktr结尾(xml文格式),保存所有配置好的数据库连接,文件相对路径,字段映射关系等信息。

Job的设计文件以.kjb结尾,下面是一个调用已经设计好的转换的job文件的一部分:<entry><name>demo test</name><description>Transformation</description><type>TRANS</type><filename>${Internal.Job.Filename.Directory}/demo-table2table.ktr</filename><transname>load customer data job</transname><directory>${Internal.Job.Filename.Directory}</directory><arg_from_previous>N</arg_from_previous><exec_per_row>N</exec_per_row><clear_rows>N</clear_rows><clear_files>N</clear_files><set_logfile>N</set_logfile><logfile/><logext/>………</entry >5.数据库保存转换,job流程列出几个重要的表1)r_job:保存job的id,name,status,执行时间,创建时间,修改时间等信息建表语句:DROP TABLE IF EXISTS `r_job`;CREATE TABLE `r_job` (`ID_JOB` bigint(20) NOT NULL,`ID_DIRECTORY` int(11) DEFAULT NULL,`NAME` varchar(255) DEFAULT NULL,`DESCRIPTION` mediumtext,`EXTENDED_DESCRIPTION` mediumtext,`JOB_VERSION` varchar(255) DEFAULT NULL,`JOB_STATUS` int(11) DEFAULT NULL,`ID_DATABASE_LOG` int(11) DEFAULT NULL,`TABLE_NAME_LOG` varchar(255) DEFAULT NULL,`CREATED_USER` varchar(255) DEFAULT NULL,`CREATED_DATE` datetime DEFAULT NULL,`MODIFIED_USER` varchar(255) DEFAULT NULL,`MODIFIED_DATE` datetime DEFAULT NULL,`USE_BATCH_ID` char(1) DEFAULT NULL,`PASS_BATCH_ID` char(1) DEFAULT NULL,`USE_LOGFIELD` char(1) DEFAULT NULL,`SHARED_FILE` varchar(255) DEFAULT NULL,PRIMARY KEY (`ID_JOB`))2)r_jobentry:设计界面上的一个实体对应一个entry,通过job的id关联DROP TABLE IF EXISTS `r_jobentry`;CREATE TABLE `r_jobentry` (`ID_JOBENTRY` bigint(20) NOT NULL,`ID_JOB` int(11) DEFAULT NULL,`ID_JOBENTRY_TYPE` int(11) DEFAULT NULL,`NAME` varchar(255) DEFAULT NULL,`DESCRIPTION` mediumtext,PRIMARY KEY (`ID_JOBENTRY`))3)r_jobentry_attribute:job的详细信息表,包括job执行规则,执行过程中的参数来源,日志记录等DROP TABLE IF EXISTS `r_jobentry_attribute`;CREATE TABLE `r_jobentry_attribute` (`ID_JOBENTRY_ATTRIBUTE` bigint(20) NOT NULL,`ID_JOB` int(11) DEFAULT NULL,`ID_JOBENTRY` int(11) DEFAULT NULL,`NR` int(11) DEFAULT NULL,`CODE` varchar(255) DEFAULT NULL,`VALUE_NUM` double DEFAULT NULL,`VALUE_STR` mediumtext,PRIMARY KEY (`ID_JOBENTRY_ATTRIBUTE`))4)r_step:保存转换的步骤id,名字等r_step建表语句:DROP TABLE IF EXISTS `r_step`;CREATE TABLE `r_step` (`ID_STEP` bigint(20) NOT NULL,`ID_TRANSFORMATION` int(11) DEFAULT NULL,`NAME` varchar(255) DEFAULT NULL,`DESCRIPTION` mediumtext,`ID_STEP_TYPE` int(11) DEFAULT NULL,`DISTRIBUTE` char(1) DEFAULT NULL,`COPIES` int(11) DEFAULT NULL,`GUI_LOCATION_X` int(11) DEFAULT NULL,`GUI_LOCATION_Y` int(11) DEFAULT NULL,`GUI_DRAW` char(1) DEFAULT NULL,PRIMARY KEY (`ID_STEP`))5)r_step_attribute:转换步骤的详细信息,字段重命名,字段映射等。

通过外键id_transformation与r_step的id_transformation关联DROP TABLE IF EXISTS `r_step_attribute`;CREATE TABLE `r_step_attribute` (`ID_STEP_ATTRIBUTE` bigint(20) NOT NULL,`ID_TRANSFORMATION` int(11) DEFAULT NULL,`ID_STEP` int(11) DEFAULT NULL,`NR` int(11) DEFAULT NULL,`CODE` varchar(255) DEFAULT NULL, --操作编码譬如:truncate,也可以是字段映射等信息`VALUE_NUM` bigint(20) DEFAULT NULL, --操作值`VALUE_STR` mediumtext, --操作值,譬如truncate对应的是Y或者NPRIMARY KEY (`ID_STEP_ATTRIBUTE`),UNIQUE KEY `IDX_STEP_ATTRIBUTE_LOOKUP` (`ID_STEP`,`CODE`,`NR`))说明:如果有一个字段firtstname映射到name则在r_step_attribute中增加两条记录。

6.Kettle组成部分Chef:是一个图形用户界面,使用SWT开发,用来设计一个作业,转换,SQL,FTP,邮件,检查表存在,检查文件存在,执行SHELL脚本Kitchen:作业执行引擎,用来进行转换,校验,FTP上传。

可以执行xml格式定义的任务以及保存在数据库上的。

kitchen.bat /file:D:\Jobs\updateWarehouse.kjb /level:Basickitchen.sh -file=/PRD/updateWarehouse.kjb -level=Minimalkitchen.bat/rep:"Production Repository"/job:"Update dimensions"/dir:/Dimensions/user:matt/pass:somepassword123/level:Basickitchen.bat/file:F:\java\pdi-ce-3.2.0-stable\data-integration\samp les\transformations\files\demo-table2table.ktr/level:Basic /log:test123.logSpoon:Spoon 是Kettle的另一个图形用户界面,用来设计数据转换过程Pan:Pan是一个数据转换引擎,负责从不同的数据源读写和转换数据。