机器学习经典算法详解及Python实现–决策树(Decision Tree) _ 数盟

id3决策树算法python程序

id3决策树算法python程序关于ID3决策树算法的Python程序。

第一步:了解ID3决策树算法ID3决策树算法是一种常用的机器学习算法,用于解决分类问题。

它基于信息论的概念,通过选择最佳的特征来构建决策树模型。

ID3算法的核心是计算信息增益,即通过选择最能区分不同类别的特征来构建决策树。

第二步:导入需要的Python库和数据集在编写ID3决策树算法的Python程序之前,我们需要导入一些必要的Python库和准备好相关的数据集。

在本例中,我们将使用pandas库来处理数据集,并使用sklearn库的train_test_split函数来将数据集拆分为训练集和测试集。

pythonimport pandas as pdfrom sklearn.model_selection import train_test_split# 读取数据集data = pd.read_csv('dataset.csv')# 将数据集拆分为特征和标签X = data.drop('Class', axis=1)y = data['Class']# 将数据集拆分为训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2) 第三步:实现ID3决策树算法的Python函数在此步骤中,我们将编写一个名为ID3DecisionTree的Python函数来实现ID3决策树算法。

该函数将递归地构建决策树,直到满足停止条件。

在每个递归步骤中,它将计算信息增益,并选择最佳特征作为当前节点的分裂依据。

pythonfrom math import log2from collections import Counterclass ID3DecisionTree:def __init__(self):self.tree = {}def calc_entropy(self, labels):label_counts = Counter(labels)entropy = 0for count in label_counts.values():p = count / len(labels)entropy -= p * log2(p)return entropydef calc_info_gain(self, data, labels, feature):feature_values = data[feature].unique()feature_entropy = 0for value in feature_values:subset_labels = labels[data[feature] == value]feature_entropy += len(subset_labels) / len(labels) * self.calc_entropy(subset_labels)return self.calc_entropy(labels) - feature_entropydef choose_best_feature(self, data, labels):best_info_gain = 0best_feature = Nonefor feature in data.columns:info_gain = self.calc_info_gain(data, labels, feature)if info_gain > best_info_gain:best_info_gain = info_gainbest_feature = featurereturn best_featuredef build_tree(self, data, labels):if len(set(labels)) == 1:return labels[0]elif len(data.columns) == 0:return Counter(labels).most_common(1)[0][0] else:best_feature = self.choose_best_feature(data, labels)sub_data = {}for value in data[best_feature].unique():subset = data[data[best_feature] == value].drop(best_feature, axis=1)sub_labels = labels[data[best_feature] == value]sub_data[value] = (subset, sub_labels)tree = {best_feature: {}}for value, (subset, sub_labels) in sub_data.items():tree[best_feature][value] = self.build_tree(subset, sub_labels)return treedef fit(self, data, labels):self.tree = self.build_tree(data, labels)def predict(self, data):predictions = []for _, row in data.iterrows():node = self.treewhile isinstance(node, dict):feature = list(node.keys())[0]value = row[feature]node = node[feature][value]predictions.append(node)return predictions第四步:使用ID3决策树模型进行训练和预测最后一步是使用我们实现的ID3DecisionTree类进行训练和预测。

使用Python实现决策树算法

使用Python实现决策树算法

Python实现决策树算法的主要思路是通过使用训练数据装载

特征和标签,然后使用分类算法来从实例数据中学习可以形成一个决策树。

决策树算法中,根节点表示当前所要求解的决策问题,每一个内部节点表示某个特征值,二叉树中的每一个非叶节点都有两个分支,每一个分支代表一个特征值的取值。

叶节点表示对应的决策结果。

Python实现决策树算法的具体步骤如下:

1、首先要准备训练数据,它要包含所有的特征和标签,这些

数据需要被组织成一个矩阵,其中的每一行代表一个样本,每一列代表一个特征或者标签。

2、接下来就是确定最佳划分特征以及相应的取值。

在这里,

会采用ID3或者C4.5算法来选择合适的划分特征以及相应值,它们能够帮助机器在建立决策树的过程中做出精确判断。

3、接下来就是通过训练数据生成决策树,在这里,我们采用

信息增益指标来判断每一个特征在划分数据集上的信息增益,随后,将每一个特征值一一检测,然后决定其作为首要划分特征。

然后,得到一个最优决策树。

4、最后,使用训练得到的决策树来对新的输入进行分类,比如,给定一组数据,我们可以得到相应的特征取值,然后输入

到决策树中,根据输入特征取值的路径,从而判断该数据属于哪个类别。

总的来说,Python实现决策树算法的主要步骤有:准备训练数据,确定最佳划分特征,使用训练数据建立决策树,最后使用决策树进行分类。

经典算法决策树代码

经典算法决策树代码决策树算法(Classic Decision Tree Algorithm)决策树算法是一种常用的机器学习算法,它通过对给定数据集的特征进行分析和判断,构建一个决策树模型,从而实现对未知数据的预测和决策。

本文将深入探讨决策树算法的原理、构建方法和代码实现。

一、决策树算法原理决策树算法基于数据集的特征值进行划分,通过对数据集中各个特征的分析和计算,确定最佳的划分点,从而构建一个能够对未知数据进行预测和决策的模型。

其基本原理如下:1. 特征选择:决策树算法首先通过对给定数据集进行特征选择,确定最佳的划分点。

特征选择的目标是使得划分后的子集尽可能地纯净,即同一类别的数据尽量集中在一起。

2. 特征划分:在特征选择的基础上,决策树算法将数据集划分为子集。

根据特征属性的不同类型,决策树算法可以分为三种划分方法:离散型特征划分、连续型特征划分和多值型特征划分。

3. 决策节点生成:特征划分后,决策树算法根据划分结果生成决策节点。

决策节点存储了特征划分的结果和对应的判定条件。

4. 子集生成:决策节点生成后,决策树算法将当前数据集划分为多个子集,然后对每个子集递归地应用上述步骤,直到满足停止条件为止。

5. 停止条件:决策树算法在生成过程中需要设置合适的停止条件。

常见的停止条件有:数据集为空、特征集为空、所有实例都属于同一类别等。

二、构建决策树的步骤构建决策树模型的过程可以分为如下几个步骤:1. 数据预处理:导入数据集并进行必要的预处理工作,包括数据清洗、缺失值处理、数据标准化等。

数据预处理是决策树算法的前提,能够有效提高算法的准确性和鲁棒性。

2. 特征选择:通过计算特征的信息增益、信息增益率、基尼指数等指标,选择最佳的划分特征。

特征选择是决策树算法的关键步骤,直接影响到模型的性能和泛化能力。

3. 特征划分:根据特征的属性类型,将数据集划分为多个子集。

离散型特征根据属性值进行划分,连续型特征根据阈值进行二分,多值型特征根据属性值集合进行划分。

Python_sklearn机器学习库学习笔记(四)decision_tree(决策树)

Python_sklearn机器学习库学习笔记(四)decision_tree(决策树)# 决策树import pandas as pdfrom sklearn.tree import DecisionTreeClassifierfrom sklearn.cross_validation import train_test_splitfrom sklearn.metrics import classification_reportfrom sklearn.pipeline import Pipelinefrom sklearn.grid_search import GridSearchCVimport zipfile#压缩节省空间z=zipfile.ZipFile('ad-dataset.zip')# df=pd.read_csv(z.open(list()[0]),header=None,low_memory=False)# df = pd.read_csv(z.open(list()[0]), header=None, low_memory=False)df=pd.read_csv('.\\tree_data\\ad.data',header=None)explanatory_variable_columns=set(df.columns.values)response_variable_column=df[len(df.columns.values)-1]#最后⼀列是代表的标签类型explanatory_variable_columns.remove(len(df.columns)-1)y=[1 if e =='ad.'else 0 for e in response_variable_column]X=df.loc[:,list(explanatory_variable_columns)]#匹配?字符,并把值转化为-1X.replace(to_replace=' *\?', value=-1, regex=True, inplace=True)X_train,X_test,y_train,y_test=train_test_split(X,y)#⽤信息增益启发式算法建⽴决策树pipeline=Pipeline([('clf',DecisionTreeClassifier(criterion='entropy'))])parameters = {'clf__max_depth': (150, 155, 160),'clf__min_samples_split': (1, 2, 3),'clf__min_samples_leaf': (1, 2, 3)}#f1查全率和查准率的调和平均grid_search=GridSearchCV(pipeline,parameters,n_jobs=-1,verbose=1,scoring='f1')grid_search.fit(X_train,y_train)print'最佳效果:%0.3f'%grid_search.best_score_print'最优参数'best_parameters=grid_search.best_estimator_.get_params()best_parameters输出结果:Fitting 3 folds for each of 27 candidates, totalling 81 fits[Parallel(n_jobs=-1)]: Done 46 tasks | elapsed: 21.0s[Parallel(n_jobs=-1)]: Done 81 out of 81 | elapsed: 34.7s finished最佳效果:0.888最优参数Out[123]:{'clf': DecisionTreeClassifier(class_weight=None, criterion='entropy', max_depth=160,max_features=None, max_leaf_nodes=None, min_samples_leaf=1,min_samples_split=3, min_weight_fraction_leaf=0.0,presort=False, random_state=None, splitter='best'),'clf__class_weight': None,'clf__criterion': 'entropy','clf__max_depth': 160,'clf__max_features': None,'clf__max_leaf_nodes': None,'clf__min_samples_leaf': 1,'clf__min_samples_split': 3,'clf__min_weight_fraction_leaf': 0.0,'clf__presort': False,'clf__random_state': None,'clf__splitter': 'best','steps': [('clf',DecisionTreeClassifier(class_weight=None, criterion='entropy', max_depth=160,max_features=None, max_leaf_nodes=None, min_samples_leaf=1,min_samples_split=3, min_weight_fraction_leaf=0.0,presort=False, random_state=None, splitter='best'))]}for param_name in sorted(parameters.keys()):print ('\t%s:%r'%(param_name,best_parameters[param_name]))predictions=grid_search.predict(X_test)print classification_report(y_test,predictions)输出结果:clf__max_depth:150clf__min_samples_leaf:1clf__min_samples_split:1precision recall f1-score support0 0.97 0.99 0.98 7031 0.91 0.84 0.87 117avg / total 0.96 0.96 0.96 820df.head()输出结果;0123456789 (1549155015511552155315541555155615571558)01251251.01000000...000000000ad. 1574688.21051000000...000000000ad. 2332306.96961000000...000000000ad. 3604687.81000000...000000000ad. 4604687.81000000...000000000ad.# 决策树集成#coding:utf-8import pandas as pdfrom sklearn.ensemble import RandomForestClassifierfrom sklearn.cross_validation import train_test_splitfrom sklearn.metrics import classification_reportfrom sklearn.pipeline import Pipelinefrom sklearn.grid_search import GridSearchCVdf=pd.read_csv('.\\tree_data\\ad.data',header=None,low_memory=False)explanatory_variable_columns=set(df.columns.values)response_variable_column=df[len(df.columns.values)-1]df.head()0123456789 (1549155015511552155315541555155615571558)01251251.01000000...000000000ad. 1574688.21051000000...000000000ad. 2332306.96961000000...000000000ad. 3604687.81000000...000000000ad. 4604687.81000000...000000000ad.#The last column describes the targets(去掉最后⼀列)explanatory_variable_columns.remove(len(df.columns.values)-1)y=[1 if e=='ad.'else 0 for e in response_variable_column]X=df.loc[:,list(explanatory_variable_columns)]#置换有?的为-1X.replace(to_replace=' *\?', value=-1, regex=True, inplace=True)X_train,X_test,y_train,y_test=train_test_split(X,y)pipeline=Pipeline([('clf',RandomForestClassifier(criterion='entropy'))])parameters = {'clf__n_estimators': (5, 10, 20, 50),'clf__max_depth': (50, 150, 250),'clf__min_samples_split': (1, 2, 3),'clf__min_samples_leaf': (1, 2, 3)}grid_search = GridSearchCV(pipeline,parameters,n_jobs=-1,verbose=1,scoring='f1')grid_search.fit(X_train,y_train)print(u'最佳效果:%0.3f'%grid_search.best_score_)print u'最优的参数:'best_parameters=grid_search.best_estimator_.get_params()for param_name in sorted(parameters.keys()):print('\t%s:%r'%(param_name,best_parameters[param_name]))输出结果:最佳效果:0.929 最优的参数: clf__max_depth:250 clf__min_samples_leaf:1 clf__min_samples_split:3 clf__n_estimators:50 predictions=grid_search.predict(X_test)print classification_report(y_test,predictions)输出结果:precision recall f1-score support0 0.98 1.00 0.99 7051 0.97 0.90 0.93 115avg / total 0.98 0.98 0.98 820。

机器学习经典算法详解及Python实现–决策树(Decision Tree) _ 数盟

人工智能

作者:Adan

℃

0评论

(一)认识决策树

1,决策树分类原理

决策树是通过一系列规则对数据进行分类的过程。它提供一种在什么条件下会得到什么值的类似 规则的方法。决策树分为分类树和回归树两种,分类树对离散变量做决策树,回归树对连续变量 做决策树。 近来的调查表明决策树也是最经常使用的数据挖掘算法,它的概念非常简单。决策树算法之所以 如此流行,一个很重要的原因就是使用者基本上不用了解机器学习算法,也不用深究它是如何工 作的。直观看上去,决策树分类器就像判断模块和终止块组成的流程图,终止块表示分类结 果(也就是树的叶子)。判断模块表示对一个特征取值的判断(该特征有几个值,判断模块就有 几个分支)。 如果不考虑效率等,那么样本所有特征的判断级联起来终会将某一个样本分到一个类终止块 上。实际上,样本所有特征中有一些特征在分类时起到决定性作用,决策树的构造过程就是找到 这些具有决定性作用的特征,根据其决定性程度来构造一个倒立的树–决定性作用最大的那个特 征作为根节点,然后递归找到各分支下子数据集中次大的决定性特征,直至子数据集中所有数据 都属于同一类。所以,构造决策树的过程本质上就是根据数据特征将数据集分类的递归过程,我 们需要解决的第一个问题就是,当前数据集上哪个特征在划分数据分类时起决定性作用。 为了找到决定性的特征、划分出最好的结果,我们必须评估数据集中蕴含的每个特征,寻找分类 数据集的最好特征。完成评估之后,原始数据集就被划分为几个数据子集。这些数据子集会分布 在第一个决策点的所有分支上。如果某个分支下的数据属于同一类型,则则该分支处理完成,称 为一个叶子节点,即确定了分类。如果数据子集内的数据不属于同一类型,则需要重复划分数据 子集的过程。如何划分数据子集的算法和划分原始数据集的方法相同,直到所有具有相同类型的 数据均在一个数据子集内(叶子节点)。如下图就是一个决策树实例(目标是两类–见或者不 见,每个样本有年龄、长相、收入、是否公务员四个特征):

python决策树例题经典案例

python决策树例题经典案例摘要:一、决策树简介- 决策树的定义- 决策树的作用- 决策树在Python 中的实现二、经典案例介绍- 案例一:鸢尾花数据集分类- 案例二:泰坦尼克号乘客生存预测- 案例三:房价预测三、案例实现步骤- 数据准备- 特征选择- 构建决策树模型- 模型评估与优化四、总结与展望- 决策树模型的优缺点- 决策树在实际应用中的限制- 未来发展方向正文:一、决策树简介决策树(Decision Tree)是一种基本的分类和回归方法,可以用于二元和多元分类以及连续和离散的数值预测。

决策树的构建过程就是递归地选择最优的特征并根据该特征对数据进行分裂的过程,直到满足某种条件为止,然后构建出一颗决策树。

在进行分类预测时,对输入数据从根节点开始沿着特定的路径向下走,直到到达某个叶节点,此时该叶节点所对应的类别就是该输入数据的预测类别。

Python 中可以使用scikit-learn 库实现决策树模型,其中包括ID3、C4.5 和CART 等算法。

二、经典案例介绍1.案例一:鸢尾花数据集分类鸢尾花数据集(Iris dataset)是一个常用的数据集,包含了鸢尾花的4 个特征(花萼长度、花萼宽度、花瓣长度、花瓣宽度)和3 个类别(Iris-Setosa,Iris-Versicolour,Iris-Virginica)。

通过决策树模型可以对鸢尾花进行正确分类。

2.案例二:泰坦尼克号乘客生存预测泰坦尼克号数据集(Titanic dataset)包含了泰坦尼克号沉船事件中幸存的乘客信息,包括性别、年龄、兄弟姐妹/配偶数量、父母/子女数量、船票号码等特征。

通过决策树模型,可以预测乘客是否在泰坦尼克号沉船事件中幸存。

3.案例三:房价预测房价预测是一个实际问题,通过收集房屋的特征数据(如面积、卧室数量、卫生间数量、地段等),可以使用决策树模型预测房价。

三、案例实现步骤1.数据准备首先需要收集和整理数据,将数据转换为适用于决策树模型的格式。

Python中的决策树算法详解

Python中的决策树算法详解决策树是一种常用的机器学习算法,它通过建立一棵树形的模型来进行决策。

在Python中,有多种库和框架可以实现决策树算法,例如scikit-learn和pydotplus。

本文将详细介绍Python中的决策树算法原理、应用以及相关的编程实现。

一、决策树算法原理决策树算法基于一种树形结构来进行决策的模型。

它将问题划分为一系列的决策节点和叶子节点,在每个节点上进行判断和选择。

决策树的核心目标是通过在每个节点上选择最佳的划分策略,使得整棵树的预测准确度达到最优。

决策树算法的原理可以分为以下几个步骤:1. 选择最佳划分属性:决策树通过计算每个属性的信息增益或信息增益比来选择最佳的划分属性。

信息增益衡量了在给定划分属性的情况下,使用该属性进行划分所获得的信息增加量。

2. 划分节点:根据选择的最佳划分属性,将当前节点分为子节点,并将数据集划分到相应的子节点中。

3. 递归构建子树:对每个子节点递归应用上述步骤,直到满足停止条件。

停止条件可以是节点中的样本数小于某个阈值或者节点中的样本属于同一类别等。

4. 剪枝处理:为了防止决策树的过拟合问题,我们可以采用剪枝处理来减少决策树的复杂度。

常用的剪枝方法有预剪枝和后剪枝。

二、决策树算法的应用决策树算法广泛应用于分类和回归问题。

在分类问题中,决策树可以用于对事物进行分类,如垃圾邮件过滤、医学诊断等。

在回归问题中,决策树可以用于预测数值型变量,如房价预测、销售预测等。

决策树算法的优点包括:1. 简单易懂:决策树的模型可以直观地表示为一棵树形结构,易于理解和解释。

2. 数据无需预处理:决策树算法对数据的处理较为宽松,可以直接使用原始数据进行建模。

3. 可处理多类型特征:决策树算法可以处理同时包含离散型和连续型特征的数据。

然而,决策树算法也存在一些限制:1. 容易过拟合:决策树的建模容易受到数据中的噪声和离群点的影响,容易产生过拟合问题。

2. 不稳定性:对于数据的微小变化十分敏感,可能导致不同的决策树模型。

Python中的随机森林算法详解

Python中的随机森林算法详解随机森林是集成学习中常用的一种算法,它是一种基于决策树(Decision Tree)的集成学习方法。

随机森林利用多个决策树来进行分类或回归,并且通过随机特征选择和有放回的随机抽样来提高模型的准确性和泛化能力。

一、随机森林的特点1.1集成学习(Ensemble Learning)随机森林是一种集成学习方法,它是基于“集思广益”的思想,利用多个分类或回归器的结果,通过一定的方式来得到最终的分类或回归结果。

集成学习在现代机器学习技术中占有重要地位,常见的集成学习方法除了随机森林,还有Boosting、Bagging等。

1.2决策树(Decision Tree)随机森林的基础是决策树,决策树是一种树形结构的分类器或回归器,用来对样本进行分类或回归。

在决策树中,每个节点表示一个特征,每个分支表示一个可能的取值,叶子节点表示一个类别或数值。

决策树常常用图形化的形式来表示,可以非常方便地解释模型的结果。

1.3随机特征选择(Random Feature Selection)随机森林的另一个特点是随机特征选择,即在构建每个决策树时,从所有特征中随机选择一部分特征进行训练。

这种随机特征选择可以有效地减少特征之间的相关性,从而提高模型的准确性和泛化能力。

1.4有放回的随机抽样(Bootstrap Sampling)随机森林还使用了一种有放回的随机抽样方法,即对于每次构建决策树,从样本集中随机选择一定数量的样本,构建子样本集用于训练决策树。

这种方法可以增加模型的多样性,避免过拟合。

二、随机森林的应用2.1分类(Classification)随机森林可以用于分类问题,它适用于二分类和多分类问题。

随机森林在分类问题中的应用非常广泛,如医学诊断、信用评估等。

2.2回归(Regression)随机森林也可以用于回归问题,它适用于连续值预测的问题。

例如,可以用随机森林预测股票价格、房价等连续值问题。

决策树算法笔记及ID3算法的Python实现

决策树算法笔记及ID3算法的Python实现决策树是多叉树,决策树是彼此互斥且完备的⼀系列的if-then规则。

决策树还可以看成给定条件下类的条件概率分布,每条路径对应于划分中的⼀个单元。

决策树的损失函数通常是正则化的极⼤似然函数。

决策树的核⼼算法就是对可能的决策树空间进⾏⾃上⽽下的贪⼼搜索。

特征选择,怎么选特征:熵的解释:信息论中对熵的解释就是熵是对S任⼀成员的分类信息进⾏编码所需的最少的bit数量。

如果p是1,那么接收器知道是正类,不需要额外信息,因此熵是0;如果p是0.5,那么需要⽤1个bit来编码是正类还是负类;如果p是0.8,那么⼀串s的平均所需编码是少于1个bit的。

因为熵是对信息编码所需的bit的长度的期望值,因此对数的底是2。

Entropy(S) = \sum_{i=1}^{c}{-p_i log_2 p_i}Gain(S, A) = Entropy(S) - \sum_{v \in Values(A)} {\frac{|S_v|}{|S|} Entropy(S_v)}信息增益就是知道属性A后,熵减⼩的值;也可以理解为知道属性A的值后,对信息编码所需的bit的长度的减⼩的值。

熵H(Y)与熵H(Y|X)的之差⼜称为互信息。

即决策树中的信息增益等价于训练数据集中类与特征的互信息。

为什么叫互信息?根据熵的定义\begin{equation} \begin{aligned} H(X,Y) &= -\sum_{x,y} {p(x,y) logp(x,y)} \\ &= -\sum_{x,y}{p(x,y)log(p(x)p(y|x))} \\ &= -\sum_{x,y}{p(x,y)logp(x) - \sum_{x,y}{p(x)p(y|x)logp(y|x)}} \\ &= -\sum_{x}p(x)logp(x) - \sum_{x}{p(x)}\sum_{y}p(y|x)logp(y|x) \\&= H(X) + H(Y|X) \end{aligned}\end{equation}同理,H(X,Y) = H(Y) + H(X|Y),因此H(Y) + H(X|Y) = H(X) + H(Y|X) \\ I(X;Y) = H(X) - H(X|Y) = H(Y) - H(Y|X)I(X;Y)即是X和Y的互信息,即知道Y之后X的熵减和知道X之后Y的熵减是相同的,彼此相互提供的信息量是相同的。

机器学习--决策树(ID3)算法及案例

机器学习--决策树(ID3)算法及案例1基本原理决策树是一个预测模型。

它代表的是对象属性与对象值之间的一种映射关系。

树中每个节点表示某个对象,每个分支路径代表某个可能的属性值,每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。

一般情况下,决策树由决策结点、分支路径和叶结点组成。

在选择哪个属性作为结点的时候,采用信息论原理,计算信息增益,获得最大信息增益的属性就是最好的选择。

信息增益是指原有数据集的熵减去按某个属性分类后数据集的熵所得的差值。

然后采用递归的原则处理数据集,并得到了我们需要的决策树。

2算法流程检测数据集中的每个子项是否属于同一分类:If 是,则返回类别标签;Else计算信息增益,寻找划分数据集的最好特征划分数据数据集创建分支节点(叶结点或决策结点)for 每个划分的子集递归调用,并增加返回结果到分支节点中return 分支结点算法的基本思想可以概括为:1)树以代表训练样本的根结点开始。

2)如果样本都在同一个类.则该结点成为树叶,并记录该类。

3)否则,算法选择最有分类能力的属性作为决策树的当前结点.4 )根据当前决策结点属性取值的不同,将训练样本根据该属性的值分为若干子集,每个取值形成一个分枝,有几个取值形成几个分枝。

匀针对上一步得到的一个子集,重复进行先前步骤,递归形成每个划分样本上的决策树。

一旦一个属性只出现在一个结点上,就不必在该结点的任何后代考虑它,直接标记类别。

5)递归划分步骤仅当下列条件之一成立时停止:①给定结点的所有样本属于同一类。

②没有剩余属性可以用来进一步划分样本.在这种情况下.使用多数表决,将给定的结点转换成树叶,并以样本中元组个数最多的类别作为类别标记,同时也可以存放该结点样本的类别分布[这个主要可以用来剪枝]。

③如果某一分枝tc,没有满足该分支中已有分类的样本,则以样本的多数类生成叶子节点。

算法中2)步所指的最优分类能力的属性。

这个属性的选择是本算法种的关键点,分裂属性的选择直接关系到此算法的优劣。

决策树(DecisionTree)(附源码)

决策树(DecisionTree)(附源码)决策树(DecisionTree)决策树所属类别:监督学习,分类优点:直观易懂,算法简单缺点:容易过拟合,对连续型数据不太容易实现实现⽅案:ID3,CART,C4.5详细的资料见连接:这篇博客主要把重点放在决策树程序的实现上,也仅实现了ID3算法,对其他两个算法仅作简单介绍1.决策数相关知识1.1数据不纯度信息熵和基尼系数都是⽤来评价数据的不纯度的,数据越分散,其不纯度越⾼,可知当所有数据都相同时其不纯度最低,当所有数据都不同时,其不纯度最⾼。

信息熵:{}{}假设⼀个变量的取值有n个:x1,x2,x3,⋯x n,x值对应取到的概率为p1,p2,p3,⋯p n,那么信息熵为:Entropy(x)=−∑n i=1p i log2(p i)可以看出,变量取值的个数越多的数据信息熵越⼤,数据分布的越平均,信息熵越⼤;熵越⼤说明其数据纯度越低。

实际⼯作中,使⽤经验熵作为实际计算⽅法;经验熵⾥认为变量的极⼤似然概率等同于变量出现的概率。

经验熵:假定D表⽰所有数据的集合,‖表⽰集合中数据的个数;n表⽰D中数据种类的个数, D_{i} 表⽰第i个种类的数据集合,\left \| D_{i} \right \|表⽰第i个种类的数据个数;那么下经验熵公式则为:Entropy(D) = -\sum_{i=1}^{n}\frac{\left \| D_{i} \right \|}{\left \| D \right \|}log_{2}(\frac{\left \| D_{i} \right \|}{\left \| D \right \|})\\基尼系数:基尼系数与熵⽐较类似,不过⼆者的计算⽅式略有不同;在实际中基尼系数通常会⽣成与熵⾮常类似的结果,基尼系数表达式为:Gini(D)=-\sum_{i=1}^{n}p_{i}(1-p_{i})=1-\sum_{i=1}^{n}p_{i}^{2}\\特性与信息熵很类似。

决策树分类算法及python代码实现案例

决策树分类算法及python代码实现案例决策树分类算法1、概述决策树(decision tree)——是⼀种被⼴泛使⽤的分类算法。

相⽐贝叶斯算法,决策树的优势在于构造过程不需要任何领域知识或参数设置在实际应⽤中,对于探测式的知识发现,决策树更加适⽤。

2、算法思想通俗来说,决策树分类的思想类似于找对象。

现想象⼀个⼥孩的母亲要给这个⼥孩介绍男朋友,于是有了下⾯的对话:⼥⼉:多⼤年纪了?母亲:26。

⼥⼉:长的帅不帅?母亲:挺帅的。

⼥⼉:收⼊⾼不?母亲:不算很⾼,中等情况。

⼥⼉:是公务员不?母亲:是,在税务局上班呢。

⼥⼉:那好,我去见见。

这个⼥孩的决策过程就是典型的分类树决策。

实质:通过年龄、长相、收⼊和是否公务员对将男⼈分为两个类别:见和不见假设这个⼥孩对男⼈的要求是:30岁以下、长相中等以上并且是⾼收⼊者或中等以上收⼊的公务员,那么这个可以⽤下图表⽰⼥孩的决策逻辑上图完整表达了这个⼥孩决定是否见⼀个约会对象的策略,其中:◊绿⾊节点表⽰判断条件◊橙⾊节点表⽰决策结果◊箭头表⽰在⼀个判断条件在不同情况下的决策路径图中红⾊箭头表⽰了上⾯例⼦中⼥孩的决策过程。

这幅图基本可以算是⼀颗决策树,说它“基本可以算”是因为图中的判定条件没有量化,如收⼊⾼中低等等,还不能算是严格意义上的决策树,如果将所有条件量化,则就变成真正的决策树了。

决策树分类算法的关键就是根据“先验数据”构造⼀棵最佳的决策树,⽤以预测未知数据的类别决策树:是⼀个树结构(可以是⼆叉树或⾮⼆叉树)。

其每个⾮叶节点表⽰⼀个特征属性上的测试,每个分⽀代表这个特征属性在某个值域上的输出,⽽每个叶节点存放⼀个类别。

使⽤决策树进⾏决策的过程就是从根节点开始,测试待分类项中相应的特征属性,并按照其值选择输出分⽀,直到到达叶⼦节点,将叶⼦节点存放的类别作为决策结果。

3、决策树构造假如有以下判断苹果好坏的数据样本:样本红⼤好苹果0 1 1 11 1 0 12 0 1 03 0 0 0样本中有2个属性,A0表⽰是否红苹果。

决策树例题经典案例python

题目:决策树例题经典案例Python1.引言在数据分析和机器学习中,决策树是一种常用的预测模型,它能够根据已知数据来做出决策,并且可以很好地解释预测结果。

本文将以Python为工具,通过经典案例来深入探讨决策树模型的应用和实现原理。

2.决策树的基本原理决策树是一种树形结构的模型,它通过对已知数据进行分析和归纳,构建出一颗树来表示决策过程。

在每个非叶节点上,根据一个特征进行划分,直到达到叶节点并给出预测结果。

3.决策树的构建过程在Python中,我们可以使用scikit-learn库来构建决策树模型,首先需要准备好数据集,然后通过调用相应的函数来构建模型并进行训练。

4.决策树的应用场景决策树模型在实际应用中有着广泛的应用场景,比如在金融领域中可以用来进行信用评分,在医疗领域中可以用来辅助医生做出诊断决策,以及在市场营销领域中可以用来进行用户分类等。

5.经典案例分析下面以一个二分类问题为例来说明决策树的应用。

假设有一个数据集,包含了一些患者的相关信息和是否患有某种疾病的标记,我们希望通过这些信息来预测一个新患者是否患有该疾病。

首先我们需要将数据集划分为训练集和测试集,然后利用训练集来构建决策树模型,最后使用测试集来评估模型的预测效果。

6.个人观点决策树作为一种简单且直观的模型,具有很强的可解释性,适用于中小规模的数据集。

但是在处理大规模数据和复杂关系时,可能会出现过拟合的问题。

决策树也有一些改进的版本,比如随机森林和梯度提升树,它们可以进一步提高模型的泛化能力。

7.总结通过本文的分析,我们对决策树模型的基本原理和构建过程有了更深入的了解,并且通过经典案例的分析,也能够更加直观地感受决策树模型的应用。

希望读者通过本文的学习,能够对决策树模型有个更全面、深刻和灵活的认识。

至此,这篇有关"决策树例题经典案例Python"的文章写作完成。

决策树模型是一种常用的机器学习算法,它在实际应用中有着广泛的应用场景。

决策树算法-Python实现

决策树算法-Python实现决策树⽐较常⽤的算法模型,可以做分类也可以回归决策树算法重点对特征的选择,可以使⽤熵,也可以使⽤基尼系数,通过信息增益或者信息增益率选择最好的特征决策树的剪枝,有两种策略,⼀种是预剪枝,⼀种是后剪枝,预剪枝可以通过限制树的⾼度,叶⼦节点个数,信息增益等进⾏,使得树边建⽴边剪枝,后剪枝通过增加损失项,使得树建⽴后,然后对不符合的叶⼦节点进⾏合并。

达到减⼩树的要求,避免过拟合集成算法Bagging 主要通过并⾏建⽴多个决策模型,然后通过投票或者平均输出最后的值Boosting 主要是通过串⾏的思想,通过弱分类器开始加强,然后通过加权来进⾏训练,⽐如先训练⼀棵树,然后在增加⼀棵树,达到提⾼模型的效果Stacking 聚合多个分类或者回归模型来提⾼模型的效果、import matplotlib.pyplot as pltimport pandas as pdfrom sklearn.datasets import fetch_california_housinghousing = fetch_california_housing()# print(housing.DESCR)print(housing.data.shape)print(housing.data[0])from sklearn import treedtr = tree.DecisionTreeRegressor(max_depth=2)dtr.fit(housing.data[:, [6, 7]], housing.target)# 树模型参数# 1.criterion gini or entroy# 2.splitter best or random 前者是在所有特征最终找到最好的切分点,后者实在部分特征中# 3.max_features None, log2, sqrt, N特征⼩于50⼀般使⽤所有的# 4.mini_depth 数据少或者特征少的情况下,可以不管这个值,如果模型数据样本量多或者特征多的情况下,可以尝试限制# 5.mini_samples_split 如果节点数量少,不⽤管,如果样本数⾮常⼤,则推荐增加这个值# 6.mini_samples_leaf 限制了叶⼦节点的样本权重和最⼩值,如果⼩于这个值,样本量不⼤,不需要管这个值,⼤些如果10w,可以设置5from sklearn.model_selection import train_test_splitdata_train, data_test, target_train, target_test = train_test_split(housing.data, housing.target, test_size=0.1, random_state=42)# dtr = tree.DecisionTreeRegressor(random_state= 42)# dtr.fit(data_train, target_train)## print(dtr.score(data_test, target_test))##from sklearn.ensemble import RandomForestRegressor## rfr = RandomForestRegressor(random_state=42)# rfr.fit(data_train, target_train)# print(rfr.score(data_test, target_test))from sklearn.model_selection import GridSearchCVtree_param_grid = {'min_samples_split':list((3, 6, 9)), 'n_estimators':list((10, 50, 100))}grid = GridSearchCV(RandomForestRegressor(), param_grid=tree_param_grid, cv=5)grid.fit(data_train, target_train)print(grid.error_score, grid.best_params_, grid.best_score_)。

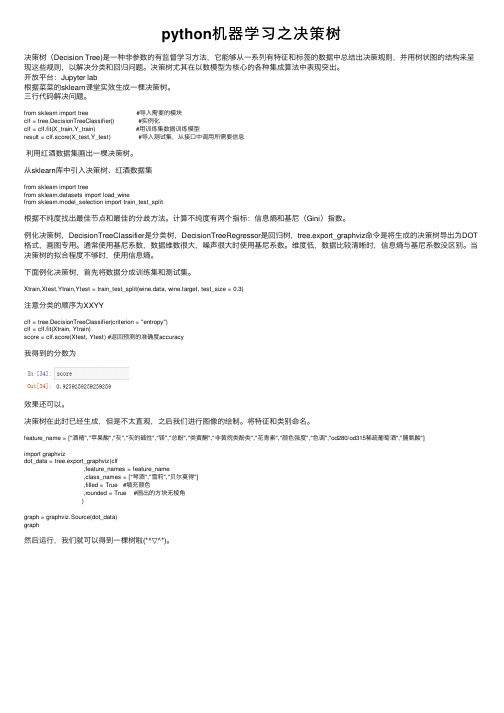

python机器学习之决策树

python机器学习之决策树决策树(Decision Tree)是⼀种⾮参数的有监督学习⽅法,它能够从⼀系列有特征和标签的数据中总结出决策规则,并⽤树状图的结构来呈现这些规则,以解决分类和回归问题。

决策树尤其在以数模型为核⼼的各种集成算法中表现突出。

开放平台:Jupyter lab根据菜菜的sklearn课堂实效⽣成⼀棵决策树。

三⾏代码解决问题。

from sklearn import tree #导⼊需要的模块clf = tree.DecisionTreeClassifier() #实例化clf = clf.fit(X_train,Y_train) #⽤训练集数据训练模型result = clf.score(X_test,Y_test) #导⼊测试集,从接⼝中调⽤所需要信息利⽤红酒数据集画出⼀棵决策树。

从sklearn库中引⼊决策树、红酒数据集from sklearn import treefrom sklearn.datasets import load_winefrom sklearn.model_selection import train_test_split根据不纯度找出最佳节点和最佳的分歧⽅法。

计算不纯度有两个指标:信息熵和基尼(Gini)指数。

例化决策树,DecisionTreeClassifier是分类树,DecisionTreeRegressor是回归树,tree.export_graphviz命令是将⽣成的决策树导出为DOT 格式,画图专⽤。

通常使⽤基尼系数,数据维数很⼤,噪声很⼤时使⽤基尼系数。

维度低,数据⽐较清晰时,信息熵与基尼系数没区别。

当决策树的拟合程度不够时,使⽤信息熵。

下⾯例化决策树,⾸先将数据分成训练集和测试集。

Xtrain,Xtest,Ytrain,Ytest = train_test_split(wine.data, wine.target, test_size = 0.3)注意分类的顺序为XXYYclf = tree.DecisionTreeClassifier(criterion = "entropy")clf = clf.fit(Xtrain, Ytrain)score = clf.score(Xtest, Ytest) #返回预测的准确度accuracy我得到的分数为效果还可以。

决策树:原理以及python实现

决策树:原理以及python实现Table of Contents决策树概述决策树的决策⽅式 如下图所⽰,决策树的决策过程本质上是⼀系列的if/then语句,通过学习到的规则来做出决策。

在下图的邮件分类应⽤中,我们的规则是如果邮件来⾃那么邮件就被分类为“⽆聊的时候再读”,否则再判断邮件内容是否包含“曲棍球”,如果是,那么就是来⾃朋友的邮件,被分类为“⽴刻阅读”,否则被分类为“垃圾邮件”。

显然,决策树的决策规则具有⼀个重要性质:互斥且完备。

这意味着,对于每⼀个样本,有且只有⼀条路径使其从根节点⾛到某个叶节点。

同时,由于对样本特征不断的进⾏⼀系列的条件X_i的判断,决策树也可以理解为对P(y_i|X_i)的条件概率的求解。

⽐如下⾯这个例⼦可以理解为,在邮件来⾃时,邮件属于“⽆聊的时候再读”的概率是100%。

决策树的规则学习过程 为了构造决策树,算法遍历所有可能询问的问题,找出对于⽬标变量来说信息量最⼤的⼀个,将数据集分为两部分,重复此过程直到结束,其原理如下:输⼊:训练集D=\{(x_1,y_1),(x_2,y_2),...,(x_m,y_m)\}属性集A=\{a_1,a_2,a_3,...,a_n\}createBranch()⽅法:检测数据集D中的所有数据的分类标签A是否相同:If so return 类标签Else:从A中寻找最优划分特征划分数据集创建分⽀节点for 每个划分的⼦集调⽤函数 createBranch(创建分⽀的函数)并增加返回结果到分⽀节点中return 分⽀节点特征选择 上⼀节说到,决策树在划分节点时,选择⼀个最佳特征将样本数据划分到不同的节点中,那么,该如何选择最优特征呢?信息熵 第⼆节中的算法中,某个节点停⽌划分成为叶节点的条件是,节点内所有样本均属于同⼀类别。

也就是节点是“纯净的”。

因此,在选择特征进⾏划分时,使得节点越纯净的特征就是越好的特征。

我们使⽤信息熵(Entropy)来衡量⼀组样本的“纯净度”。

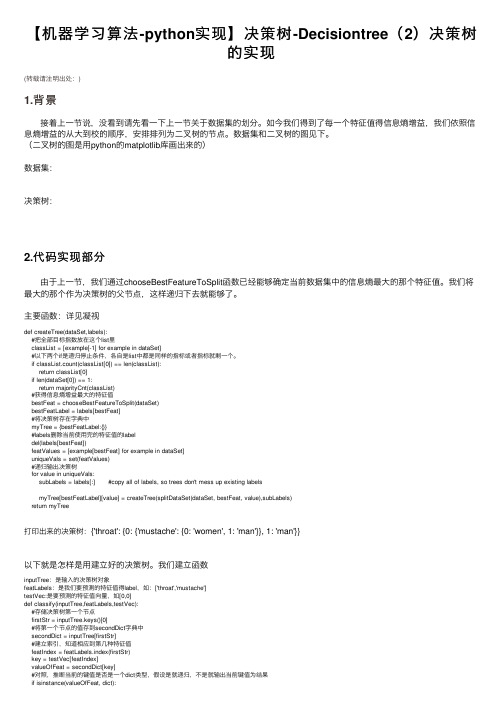

【机器学习算法-python实现】决策树-Decisiontree(2)决策树的实现

【机器学习算法-python实现】决策树-Decisiontree(2)决策树的实现(转载请注明出处:)1.背景接着上⼀节说,没看到请先看⼀下上⼀节关于数据集的划分。

如今我们得到了每⼀个特征值得信息熵增益,我们依照信息熵增益的从⼤到校的顺序,安排排列为⼆叉树的节点。

数据集和⼆叉树的图见下。

(⼆叉树的图是⽤python的matplotlib库画出来的)数据集:决策树:2.代码实现部分由于上⼀节,我们通过chooseBestFeatureToSplit函数已经能够确定当前数据集中的信息熵最⼤的那个特征值。

我们将最⼤的那个作为决策树的⽗节点,这样递归下去就能够了。

主要函数:详见凝视def createTree(dataSet,labels):#把全部⽬标指数放在这个list⾥classList = [example[-1] for example in dataSet]#以下两个if是递归停⽌条件,各⾃是list中都是同样的指标或者指标就剩⼀个。

if classList.count(classList[0]) == len(classList):return classList[0]if len(dataSet[0]) == 1:return majorityCnt(classList)#获得信息熵增益最⼤的特征值bestFeat = chooseBestFeatureToSplit(dataSet)bestFeatLabel = labels[bestFeat]#将决策树存在字典中myTree = {bestFeatLabel:{}}#labels删除当前使⽤完的特征值的labeldel(labels[bestFeat])featValues = [example[bestFeat] for example in dataSet]uniqueVals = set(featValues)#递归输出决策树for value in uniqueVals:subLabels = labels[:] #copy all of labels, so trees don't mess up existing labelsmyTree[bestFeatLabel][value] = createTree(splitDataSet(dataSet, bestFeat, value),subLabels)return myTree打印出来的决策树:{'throat': {0: {'mustache': {0: 'women', 1: 'man'}}, 1: 'man'}}以下就是怎样是⽤建⽴好的决策树。

Python机器学习之决策树算法

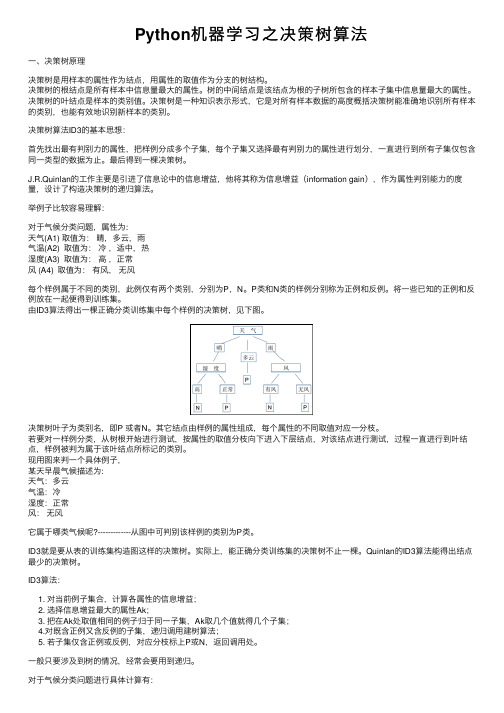

Python机器学习之决策树算法⼀、决策树原理决策树是⽤样本的属性作为结点,⽤属性的取值作为分⽀的树结构。

决策树的根结点是所有样本中信息量最⼤的属性。

树的中间结点是该结点为根的⼦树所包含的样本⼦集中信息量最⼤的属性。

决策树的叶结点是样本的类别值。

决策树是⼀种知识表⽰形式,它是对所有样本数据的⾼度概括决策树能准确地识别所有样本的类别,也能有效地识别新样本的类别。

决策树算法ID3的基本思想:⾸先找出最有判别⼒的属性,把样例分成多个⼦集,每个⼦集⼜选择最有判别⼒的属性进⾏划分,⼀直进⾏到所有⼦集仅包含同⼀类型的数据为⽌。

最后得到⼀棵决策树。

J.R.Quinlan的⼯作主要是引进了信息论中的信息增益,他将其称为信息增益(information gain),作为属性判别能⼒的度量,设计了构造决策树的递归算法。

举例⼦⽐较容易理解:对于⽓候分类问题,属性为:天⽓(A1) 取值为:晴,多云,⾬⽓温(A2) 取值为:冷,适中,热湿度(A3) 取值为:⾼,正常风 (A4) 取值为:有风,⽆风每个样例属于不同的类别,此例仅有两个类别,分别为P,N。

P类和N类的样例分别称为正例和反例。

将⼀些已知的正例和反例放在⼀起便得到训练集。

由ID3算法得出⼀棵正确分类训练集中每个样例的决策树,见下图。

决策树叶⼦为类别名,即P 或者N。

其它结点由样例的属性组成,每个属性的不同取值对应⼀分枝。

若要对⼀样例分类,从树根开始进⾏测试,按属性的取值分枝向下进⼊下层结点,对该结点进⾏测试,过程⼀直进⾏到叶结点,样例被判为属于该叶结点所标记的类别。

现⽤图来判⼀个具体例⼦,某天早晨⽓候描述为:天⽓:多云⽓温:冷湿度:正常风:⽆风它属于哪类⽓候呢?-------------从图中可判别该样例的类别为P类。

ID3就是要从表的训练集构造图这样的决策树。

实际上,能正确分类训练集的决策树不⽌⼀棵。

Quinlan的ID3算法能得出结点最少的决策树。

ID3算法:1. 对当前例⼦集合,计算各属性的信息增益;2. 选择信息增益最⼤的属性Ak;3. 把在Ak处取值相同的例⼦归于同⼀⼦集,Ak取⼏个值就得⼏个⼦集;4.对既含正例⼜含反例的⼦集,递归调⽤建树算法;5. 若⼦集仅含正例或反例,对应分枝标上P或N,返回调⽤处。

机器学习决策树的Python实现详细流程及原理解读

机器学习决策树的Python实现详细流程及原理解读1. 决策树的优势决策树作为处理分类问题最经常被用到的算法,它有着优于其他机器学习算法的简明性特征,即无需了解机器学习的原理知识也能够轻松的了解这个算法是如何工作的。

2.决策树的构造(1). 找到决定性的特征,这个特征将帮助我们最好的划分集合举例:完成测试,原始数据被划分成几个子集,如果某个分支下的所有数据已经属于同一子集,则无需继续划分。

如果数据集合中的数据仍然不属于同一类型,则需要继续划分。

划分原则同划分原始数据,该过程将一直持续直到所有数据子集都属于同一类型。

(2). 算法伪代码–递归实现createBranch()Check whether data belong to the same class:if return class_labelelsefind the optimal feature to divide the datasetdivide datasetcreate branch nodefor every divided subsetcall function createBranch() and add return result to branch nodereturn branch_node•1•2•3•4•5•6•7•8•9•10(3). 度量划分好坏的标准–信息增益《Data Mining Concepts andTechniques》Third Edition(数据挖掘:概念与技术第三版)在本书中阐述了属性选择的三个度量,分别为信息增益,增益率和基尼指数(Gini 指数)由于我们不使用增益率和基尼指数构建决策树,所以在这里不再阐述。

信息增益定义为一个特征能够为分类系统带来多少信息,带来的信息越多,该特征越重要,所以我们将选择信息增益大的作为划分属性.假设节点N存放D的元组,那么选择信息增益最高的作为N的划分属性对于D中的元组所需要的期望信息由下表示Info(D)是识别D中元组的类标号所需要的平均信息量,又称为D的熵(entropy)。

机器学习_决策树Python代码详解

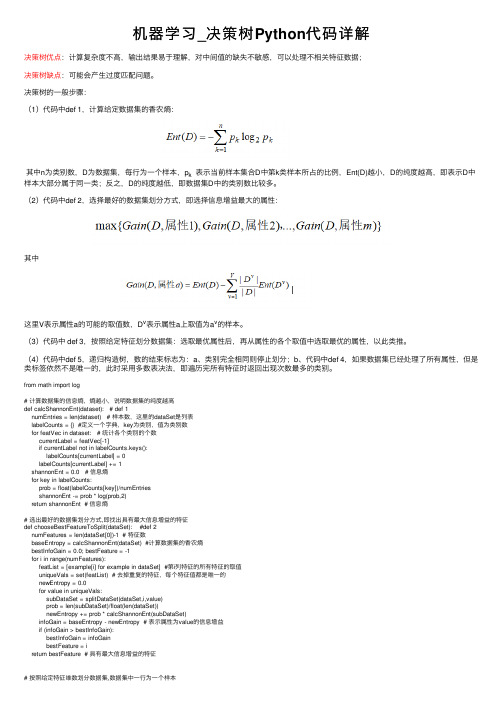

机器学习_决策树Python代码详解决策树优点:计算复杂度不⾼,输出结果易于理解,对中间值的缺失不敏感,可以处理不相关特征数据;决策树缺点:可能会产⽣过度匹配问题。

决策树的⼀般步骤:(1)代码中def 1,计算给定数据集的⾹农熵:其中n为类别数,D为数据集,每⾏为⼀个样本,p k 表⽰当前样本集合D中第k类样本所占的⽐例,Ent(D)越⼩,D的纯度越⾼,即表⽰D中样本⼤部分属于同⼀类;反之,D的纯度越低,即数据集D中的类别数⽐较多。

(2)代码中def 2,选择最好的数据集划分⽅式,即选择信息增益最⼤的属性:其中这⾥V表⽰属性a的可能的取值数,D v表⽰属性a上取值为a v的样本。

(3)代码中 def 3,按照给定特征划分数据集:选取最优属性后,再从属性的各个取值中选取最优的属性,以此类推。

(4)代码中def 5,递归构造树,数的结束标志为:a、类别完全相同则停⽌划分;b、代码中def 4,如果数据集已经处理了所有属性,但是类标签依然不是唯⼀的,此时采⽤多数表决法,即遍历完所有特征时返回出现次数最多的类别。

from math import log# 计算数据集的信息熵,熵越⼩,说明数据集的纯度越⾼def calcShannonEnt(dataset): # def 1numEntries = len(dataset) # 样本数,这⾥的dataSet是列表labelCounts = {} #定义⼀个字典,key为类别,值为类别数for featVec in dataset: # 统计各个类别的个数currentLabel = featVec[-1]if currentLabel not in labelCounts.keys():labelCounts[currentLabel] = 0labelCounts[currentLabel] += 1shannonEnt = 0.0 # 信息熵for key in labelCounts:prob = float(labelCounts[key])/numEntriesshannonEnt -= prob * log(prob,2)return shannonEnt # 信息熵# 选出最好的数据集划分⽅式,即找出具有最⼤信息增益的特征def chooseBestFeatureToSplit(dataSet): #def 2numFeatures = len(dataSet[0])-1 # 特征数baseEntropy = calcShannonEnt(dataSet) #计算数据集的⾹农熵bestInfoGain = 0.0; bestFeature = -1for i in range(numFeatures):featList = [example[i] for example in dataSet] #第i列特征的所有特征的取值uniqueVals = set(featList) # 去掉重复的特征,每个特征值都是唯⼀的newEntropy = 0.0for value in uniqueVals:subDataSet = splitDataSet(dataSet,i,value)prob = len(subDataSet)/float(len(dataSet))newEntropy += prob * calcShannonEnt(subDataSet)infoGain = baseEntropy - newEntropy # 表⽰属性为value的信息增益if (infoGain > bestInfoGain):bestInfoGain = infoGainbestFeature = ireturn bestFeature # 具有最⼤信息增益的特征# 按照给定特征维数划分数据集,数据集中⼀⾏为⼀个样本# def 3def splitDataSet(dataSet,axis,value): # axis可表⽰数据集的列,也就是特征为数,value表⽰特征的取值 retDataSet = []for featVec in dataSet:if featVec[axis] == value:reducedFeatVec = featVec[:axis] # 在数据集中去掉axis这⼀列reducedFeatVec.extend(featVec[axis+1:])retDataSet.append(reducedFeatVec)return retDataSet # 表⽰去掉在axis中特征值为value的样本后⽽得到的数据集# 当处理了所有属性,但是类标签依然不是唯⼀的,此时采⽤多数表决法决定该叶⼦节点的分类def majorityCnt(classList): # def 4classCount = {}for vote in classList:if vote not in classCount.keys():classCount[vote] = 0classCount += 1sortedClassCount = sorted(classCount.items(),key=lambda classCount: classCount[1],reverse = True) return sortedClassCount[0][0]# 创建树def createTree(dataSet,labels): # def 5classList = [example[-1] for example in dataSet] #类别列表if classList.count(classList[0]) == len(classList): # 如果类别完全相同就停⽌划分return classList[0]if (len(dataSet[0]) == 1):return majorityCnt(classList)bestFeat = chooseBestFeatureToSplit(dataSet) # 选出最好的特征,也就是信息增益最⼤的特征bestFeatLabel = labels[bestFeat]myTree = {bestFeatLabel:{}}del(labels[bestFeat]) # 每划分⼀层,特征数⽬就会较少featValues = [example[bestFeat] for example in dataSet] # 最好的特征的特征值uniqueVals = set(featValues) #去掉重复的特征for value in uniqueVals:subLabels = labels[:] # 减少后的特征名myTree[bestFeatLabel][value] = createTree(splitDataSet(dataSet,bestFeat,value),subLabels)return myTreedef createDateSet():dataSet = [[1,1,'yes'],[1,1,'yes'],[1,0,'no'],[0,1,'no'],[0,1,'no']]labels = ['no surfacing','flippers'] #属性名return dataSet,labelsmyData,myLabel = createDateSet()createTree(myData,myLabel)print(createTree(myData,myLabel))#print(chooseBestFeatureToSplit(myData))# print(splitDataSet(myData,0,1))# print(splitDataSet(myData,0,0))。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2,ID3算法推导

(1)分类系统信息熵 假设一个分类系统的样本空间(D,Y),D表示样本(有m个特征),Y表示n个类别,可能的取 值是C1,C2,…,Cn。每一个类别出现的概率是P(C1),P(C2),…,P(Cn)。该分类系统的熵为:

离散分布中,类别Ci出现的概率P(Ci),通过该类别出现的次数除去样本总数即可得到。对于连续 分布,常需要分块做离散化处理获得。 (2)条件熵 根据条件熵的定义,分类系统中的条件熵指的是当样本的某一特征X固定时的信息熵。由于该特征 X可能的取值会有(x1,x2,……,xn),当计算条件熵而需要把它固定的时候,每一种可能都 要固定一下,然后求统计期望。 因此样本特征X取值为xi的概率是Pi,该特征被固定为值xi时的条件信息熵就是H(C|X=xi),那么 H(C|X)就是分类系统中特征X被固定时的条件熵(X=(x1,x2,……,xn)): 若是样本的该特征只有两个值(x1 = 0,x2=1)对应(出现,不出现),如文本分类中某一个单词的 出现与否。那么对于特征二值的情况,我们用T代表特征,用t代表T出现, 表示该特征出现。那么: 与前面条件熵的公式对比一下,P(t)就是T出现的概率, 就是T不出现的概率。结合信息熵的计算公式,可得: 特征T出现的概率P(t),只要用出现过T的样本数除以总样本数就可以了;P(Ci|t)表示出现T的时 候,类别Ci出现的概率,只要用出现了T并且属于类别Ci的样本数除以出现了T的样本数就得到 了。

/5107.html 3/10

2015/11/30

机器学习经典算法详解及Python实现–决策树(Decision Tree) | 数盟

下Y的条件概率分布的熵对X的数学期望:

(3)信息增益 信息增益(information gain)表示得知特征X的信息后,而使得Y的不确定性减少的程度。定义为:

标准,如何选择特征有着很多不同量化评估标准标准,从而衍生出不同的决策树算法。

决策树生成: 根据选择的特征评估标准,从上至下递归地生成子节点,直到数据集不可

分则停止决策树停止生长。 树结构来说,递归结构是最容易理解的方式。

剪枝:决策树容易过拟合,一般来需要剪枝,缩小树结构规模、缓解过拟合。剪枝技术

人工智能

作者:Adan

小林子

11个月前 (12-24)

6845℃

0评论

(一)认识决策树

1,决策树分类原理

决策树是通过一系列规则对数据进行分类的过程。它提供一种在什么条件下会得到什么值的类似 规则的方法。决策树分为分类树和回归树两种,分类树对离散变量做决策树,回归树对连续变量 做决策树。 近来的调查表明决策树也是最经常使用的数据挖掘算法,它的概念非常简单。决策树算法之所以 如此流行,一个很重要的原因就是使用者基本上不用了解机器学习算法,也不用深究它是如何工 作的。直观看上去,决策树分类器就像判断模块和终止块组成的流程图,终止块表示分类结 果(也就是树的叶子)。判断模块表示对一个特征取值的判断(该特征有几个值,判断模块就有 几个分支)。 如果不考虑效率等,那么样本所有特征的判断级联起来终会将某一个样本分到一个类终止块 上。实际上,样本所有特征中有一些特征在分类时起到决定性作用,决策树的构造过程就是找到 这些具有决定性作用的特征,根据其决定性程度来构造一个倒立的树–决定性作用最大的那个特 征作为根节点,然后递归找到各分支下子数据集中次大的决定性特征,直至子数据集中所有数据 都属于同一类。所以,构造决策树的过程本质上就是根据数据特征将数据集分类的递归过程,我 们需要解决的第一个问题就是,当前数据集上哪个特征在划分数据分类时起决定性作用。 为了找到决定性的特征、划分出最好的结果,我们必须评估数据集中蕴含的每个特征,寻找分类 数据集的最好特征。完成评估之后,原始数据集就被划分为几个数据子集。这些数据子集会分布 在第一个决策点的所有分支上。如果某个分支下的数据属于同一类型,则则该分支处理完成,称 为一个叶子节点,即确定了分类。如果数据子集内的数据不属于同一类型,则需要重复划分数据 子集的过程。如何划分数据子集的算法和划分原始数据集的方法相同,直到所有具有相同类型的 数据均在一个数据子集内(叶子节点)。如下图就是一个决策树实例(目标是两类–见或者不 见,每个样本有年龄、长相、收入、是否公务员四个特征):

(二)ID3算法的数学原理

前面已经提到C4.5和CART都是由ID3演化而来,这里就先详细阐述ID3算法,奠下基础。

1,ID3算法的信息论基础

关于决策树的信息论基础可以参考“决策树1-建模过程” (1)信息熵 信息熵:在概率论中,信息熵给了我们一种度量不确定性的方式,是用来衡量随机变量不确定性 的,熵就是信息的期望值。若待分类的事物可能划分在N类中,分别是x1,x2,……,xn,每一 种取到的概率分别是P1,P2,……,Pn,那么X的熵就定义为: ,从定义中可知:0≤H(X)≤log(n) 当随机变量只取两个值时,即X的分布为 P(X=1)=p,X(X=0)=1−p,0≤p≤1则熵为:H(X)=−plog

2, 决策树的学习过程

/5107.html

1/10

2015/11/30

机器学习经典算法详解及Python实现–决策树(Decision Tree) | 数盟

一棵决策树的生成过程主要分为以下3个部分:

特征选ቤተ መጻሕፍቲ ባይዱ:特征选择是指从训练数据中众多的特征中选择一个特征作为当前节点的分裂

(三)C4.5算法

1,信息增益比选择最佳特征

以信息增益进行分类决策时,存在偏向于取值较多的特征的问题。于是为了解决这个问题人们有 开发了基于信息增益比的分类决策方法,也就是C4.5。C4.5与ID3都是利用贪心算法进行求 解,不同的是分类决策的依据不同。 因此,C4.5算法在结构与递归上与ID3完全相同,区别就在于选取决断特征时选择信息增益比最 大的。 信息增益比率度量是用ID3算法中的的增益度量Gain(D,X)和分裂信息度量SplitInformatio n(D,X)来共同定义的。分裂信息度量SplitInformation(D,X)就相当于特征X(取值为x1,x

/5107.html 2/10

2015/11/30

机器学习经典算法详解及Python实现–决策树(Decision Tree) | 数盟

CART算法的全称是Classification And Regression Tree,采用的是Gini指数(选Gini指数最小的 特征s)作为分裂标准,同时它也是包含后剪枝操作。ID3算法和C4.5算法虽然在对训练样本集的 学习中可以尽可能多地挖掘信息,但其生成的决策树分支较大,规模较大。为了简化决策树的规 模,提高生成决策树的效率,就出现了根据GINI系数来选择测试属性的决策树算法CART。

2,……,xn,各自的概率为P1,P2,…,Pn,Pk就是样本空间中特征X取值为xk的数量除上该样

本空间总数)的熵。 SplitInformation(D,X) = -P1 log2(P1)-P2 log2(P)-,…,-Pn log2(Pn) GainRatio(D,X) = Gain(D,X)/SplitInformation(D,X) 在ID3中用信息增益选择属性时偏向于选择分枝比较多的属性值,即取值多的属性,在C4.5中由 于除以SplitInformation(D,X)=H(X),可以削弱这种作用。

有预剪枝和后剪枝两种。

3,基于信息论的三种决策树算法

划分数据集的最大原则是:使无序的数据变的有序。如果一个训练数据中有20个特征,那么选取 哪个做划分依据?这就必须采用量化的方法来判断,量化划分方法有多重,其中一项就是“信息 论度量信息分类”。基于信息论的决策树算法有ID3、CART和C4.5等算法,其中C4.5和CART两 种算法从ID3算法中衍生而来。 CART和C4.5支持数据特征为连续分布时的处理,主要通过使用二元切分来处理连续型变量,即 求一个特定的值-分裂值:特征值大于分裂值就走左子树,或者就走右子树。这个分裂值的选取 的原则是使得划分后的子树中的“混乱程度”降低,具体到C4.5和CART算法则有不同的定义方 式。 ID3算法由Ross Quinlan发明,建立在“奥卡姆剃刀”的基础上:越是小型的决策树越优于大的决 策树(be simple简单理论)。ID3算法中根据信息论的信息增益评估和选择特征,每次选择信息 增益最大的特征做判断模块。ID3算法可用于划分标称型数据集,没有剪枝的过程,为了去除过 度数据匹配的问题,可通过裁剪合并相邻的无法产生大量信息增益的叶子节点(例如设置信息增 益阀值)。使用信息增益的话其实是有一个缺点,那就是它偏向于具有大量值的属性–就是说在 训练集中,某个属性所取的不同值的个数越多,那么越有可能拿它来作为分裂属性,而这样做有 时候是没有意义的,另外ID3不能处理连续分布的数据特征,于是就有了C4.5算法。CART算法 也支持连续分布的数据特征。 C4.5是ID3的一个改进算法,继承了ID3算法的优点。C4.5算法用信息增益率来选择属性,克服 了用信息增益选择属性时偏向选择取值多的属性的不足在树构造过程中进行剪枝;能够完成对连 续属性的离散化处理;能够对不完整数据进行处理。C4.5算法产生的分类规则易于理解、准确率 较高;但效率低,因树构造过程中,需要对数据集进行多次的顺序扫描和排序。也是因为必须多 次数据集扫描,C4.5只适合于能够驻留于内存的数据集。

/5107.html 4/10

2015/11/30

机器学习经典算法详解及Python实现–决策树(Decision Tree) | 数盟

(3)信息增益 根据信息增益的公式,分类系统中特征X的信息增益就是:Gain(D, X) = H(C)-H(C|X) 信息增益是针对一个一个的特征而言的,就是看一个特征X,系统有它和没它的时候信息量各是 多少,两者的差值就是这个特征给系统带来的信息增益。每次选取特征的过程都是通过计算每个 特征值划分数据集后的信息增益,然后选取信息增益最高的特征。 对于特征取值为二值的情况,特征T给系统带来的信息增益就可以写成系统原本的熵与固定特征T 后的条件熵之差: (4)经过上述一轮信息增益计算后会得到一个特征作为决策树的根节点,该特征有几个取值,根节 点就会有几个分支,每一个分支都会产生一个新的数据子集Dk,余下的递归过程就是对每个Dk 再重复上述过程,直至子数据集都属于同一类。 在决策树构造过程中可能会出现这种情况:所有特征都作为分裂特征用光了,但子集还不是纯净 集(集合内的元素不属于同一类别)。在这种情况下,由于没有更多信息可以使用了,一般对这 些子集进行“多数表决”,即使用此子集中出现次数最多的类别作为此节点类别,然后将此节点作 为叶子节点。