第三章 编写UDF

python的udf编写例子

python的udf编写例⼦简介Hive为我们提供了众多的内置函数,但是在实际的运⽤过程中仍然不能满⾜我们所有的需求.hive是⽤java开发的,本⾝提供了使⽤java去开发UDF的⽅式.⽽这⾥我们采⽤python的⽅式去实现UDF函数.DEMO实现我们这⾥⽤python⾃定义函数,去实现⼀个⽅法,利⽤⾝份证号去判断性别(18位⾝份证的倒数第⼆位偶数为⼥,奇数为男.15位⾝份证的倒数第⼀位偶数为⼥,奇数为男.).其实这个需求可以使⽤hive⾃带的function去进⾏解决.我们接下来使⽤2种⽅式去实现这个需求.数据准备我们在hive上创建⼀个external表(名字person表),执⾏如下代码:create external table person(name string,idcard string)ROW FORMAT DELIMITEDFIELDS TERMINATED BY'\t'STORED as TEXTFILE;该表两个字段,⼀个为name,另⼀个为idcard数据格式如下:neil 411326************pony 411325************jcak 12312423454556561tony 412345671234908field分隔符使⽤\t我们将数据放⼊hive的warehouse中:hdfs dfs -put person.txt /user/hive/warehouse/test_neil.db/person执⾏select,我们发现数据已经进⼊到hive了.使⽤Hive Function去实现我们可以执⾏⼀下的hql去实现select idcard,case when length(idcard) =18thencase when substring(idcard,-2,1) %2=1then'男'when substring(idcard,-2,1) %2=0then'⼥'else'unknown'endwhen length(idcard) =15thencase when substring(idcard,-1,1) %2=1then'男'when substring(idcard,-1,1) %2=0then'⼥'else'unknown'endelse'不合法'endfrom person;得到的结果如下(beeline下):+---------------------+------+--+| idcard | _c1 |+---------------------+------+--+|12312423454556561|不合法||123124234545565|男||411325************|男|| 411325************ |⼥|UDF编写如下是我们的udf代码:# -*- coding: utf-8 -*-import sysfor line in sys.stdin:detail = line.strip().split("\t")if len(detail) != 2:continueelse:name = detail[0]idcard = detail[1]if len(idcard) == 15:if int(idcard[-1]) % 2 == 0:print("\t".join([name,idcard,"⼥"]))else:print("\t".join([name,idcard,"男"]))elif len(idcard) == 18:if int(idcard[-2]) % 2 == 0:print("\t".join([name,idcard,"⼥"]))else:print("\t".join([name,idcard,"男"]))else:print("\t".join([name,idcard,"⾝份信息不合法!"]))这⾥我们使⽤python的重定向,将hive控制台的输出进⾏split,split默认使⽤的为\t.然后根据split后的idcard的倒数第⼆位进⾏判断这个⼈的性别. 测试我们在hive中去执⾏查询时,报错的提⽰不是很详细.我们可以使⽤cat指令去测试python脚本的执⾏效果.我们在终端中执⾏如下指令:cat person.txt|python person.py输⼊结果如下:neil 411325************ 男pony 411325************ ⼥jack 12312423454556561 ⾝份信息不合法!tony 123124234545565 男说明我们的解析是成功的.使⽤我们在hive中使⽤python定义的UDF函数要借助transform函数去执⾏.transform函数的语法如下:SELECT TRANSFORM (<columns>)USING 'python <python_script>'AS (<columns>)FROM <table>;transfrom和as的columns的个数不必⼀致.我们⾸先需要将我们的person.py加载⼊我们在hive中去执⾏如下代码:add file /xxx/person.pyxxx为本地⽂件的路径.然后使⽤transform函数执⾏:select transform(name,idcard) USING 'python person.py' AS (name,idcard,gender) from person;java版本也需要打成jar包,使⽤add⽅式添加到hive中add jar jar_path;并且要创建函数:create function fun_name as'java class name' USING jar 'hdfs_jar_path';//上⽅为官⽅⽂档案例,下⾯的是我⾃⼰写的,属于临时函数,重启hive后失效create function fun_name as'java class name';查询:select fun_name(字段...) from table_name;我们同样可以得到如下的结果:neil 411325************男pony 411325************ ⼥jack 12312423454556561⾝份信息不合法!tony 123124234545565男。

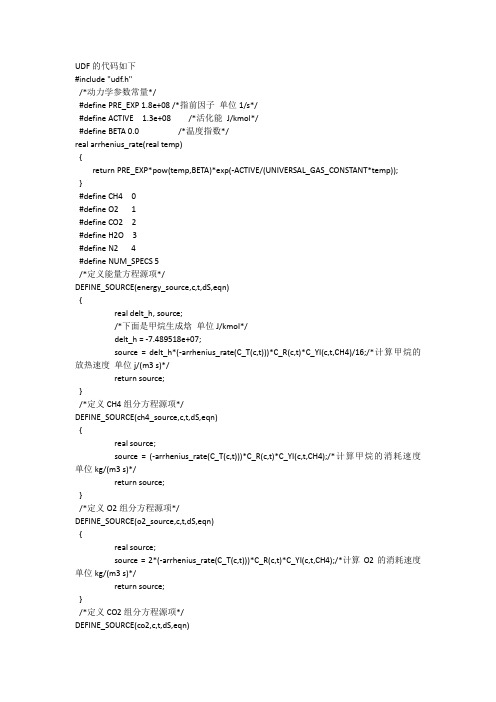

fluent关于化学反应的udf编写

放热速度 单位 j/(m3 s)*/

return source;

}

/*定义 CH4 组分方程源项*/

DEFINE_SOURCE(ch4_source,c,t,dS,eqn)

{

real source;

source = (-arrhenius_rate(C_T(c,t)))*C_R(c,t)*C_YI(c,t,CH4);/*计算甲烷的消耗速度

udf的代码如下includeudfh动力学参数常量definepreexp18e08指前因子单位1sdefineactive13e08活化能jkmoldefinebeta00温度指数realarrheniusraterealtempreturnpreexppowtempbetaexpactiveuniversalgasconstanttemp

单位 kg/(m3 s)*/

return source;

}

/*定义 CO2 组分方程源项*/

DEFINE_SOURCE(co2,c,t,dS,eqn)

{ real source; source = (arrhenius_rate(C_T(c,t)))*C_R(c,t)*C_YI(c,t,CH4);/*计算 CO2 的生成速度 单

单位 kg/(m3 s)*/

return source;

}

/*定义 O2 组分方程源项*/

DEFINE_SOURCE(o2_source,c,t,dS,eqn)

{

real source;

source = 2*(-arrhenius_rate(C_T(c,t)))*C_R(c,t)*C_YI(c,t,CH4);/*计算 DEFINE_SOURCE(energy_source,c,t,dS,eqn)

第3章 编写UDF

第 3 章 编写 UDF第 3 章 编写 UDF本章包含了 FLUENT 中如何写 UDFs 的概述。

3.1 概述 3.2 写解释式 UDFs 的限制 3.3 FLUENT 中 UDFs 求解过程的顺序 3.4 FLUENT 网格拓扑 3.5 FLUENT 数据类型 3.6 使用 DEFINE Macros 定义你的 UDF 3.7 在你的 UDF 源文件中包含 udf.h 文件 3.8 定义你的函数中的变量 3.9 函数体 3.10 UDF 任务 3.11 为多相流应用写 UDFs 3.12 在并行中使用你的 UDF 3.1 概述(Introduction) 在你开始编写将挂到 FLUENT 代码以增强其标准特征的 UDF 之前,你必须 知道几个基本的要求。

首先,UDFs 必须用 C 语言编写。

它们必须使用 FLUENT 提供的 DEFINE macros 来定义。

UDFs 必须含有包含于源代码开始指示的 udf.h 文件;它允许为 DEFINE macros 和包含在编译过程的其它 FLUENT 提供的函数 定义。

UDFs 只使用预先确定的宏和函数从 FLUENT 求解器访问数据。

通过 UDF 传递到求解器的任何值或从求解器返回到 UDF 的,都指定为国际(SI)单位。

总之,当写 UDF 时,你必须记住下面的 FLUENT 要求。

UDFs: 1. 采用 C 语言编写。

2. 必须为 udf.h 文件有一个包含声明。

3. 使用 Fluent.Inc 提供的 DEFINE macros 来定义。

4. 使用 Fluent.Inc 提供的预定义宏和函数来访问 FLUENT 求解器数据。

5. 必须使返回到 FLUENT 求解器的所有值指定为国际单位。

3.2 写解释式 UDFs 的限制(Restriction on Writing Interpreted UDFs)第 3 章 编写 UDF无论 UDFs 在 FLUENT 中以解释还是编译方式执行,用户定义 C 函数(说明在 Section 3.1 中)的基本要求是相同的,但还是有一些影响解释式 UDFs 的重大编 程限制。

UDF

1.1什么是UDF?UDF是一种可以被加载到fluent求解器中的函数,以提高源代码的功能。

比如,你可以使用UDF定义你的边界条件,材料属性和流型源项,以及自定义模型参数,初始化一种算法或增强后处理进程。

UDF可以在任何文本里用C语言编写,然后源代码保存格式为“e.g., myudf.c”。

一个源文件可以包含一个或多个UDF,或者你可以定义多个源文件。

关于C语言编程的一些基本资料见附录A。

UDF是被fluent Inc提供的宏定义进行定义。

它们使用附加的宏代码,使fluent具有数据访问和执行其他任务的功能。

每一个UDF必须在源代码文件的开头包含“#include "udf.h"”,使得宏定义和fluent的其他宏及功能可以在运行的过程中被包含。

含有UDF的源文件可以在fluent里进行解释或编译。

对于解释型UDF,在一个单一的运算进程中,源文件被解释后在运行时直接加载。

而对于编译型UDF,这个过程包含2个步骤。

需要首先建立一个共享的对象代码库,然后将其加载到fluent中。

一旦被解释或编译,UDF将会在fluent界面中可见并可选择,然后通过在相应的控制面板中选择函数名称被连接到求解器中。

1.2为什么使用UDF?UDF可以让你自定义fluent来满足你的特殊模型需要。

UDF可以在多个应用中使用,下面列举的就是一些例子。

●定义边界条件,材料属性,表面和体积反应速率,fluent输运方程的源项,UDS输运方程的源项,扩散系数函数等。

●一次迭代的计算值的调整。

●初始化一种算法。

●UDF的异步执行。

●在迭代结束后执行,退出fluent或者加载编译UDF库。

●增强后处理。

●增强现有的fluent模型。

1.3局限性虽然在FLUENT的UDF功能可以解决广泛的应用,但是不可能解决所有的应用。

并不是所有的计算变量或fluent模型可以使用UDF。

比如比热值就不能被定义,这将需要额外的求解能力。

udf 创建流程(一)

udf 创建流程(一)UDF 创建1. 什么是 UDF•UDF 的全称是 User-Defined Function,中文意为用户自定义函数。

•它是一种在编程语言中允许用户自己定义函数的特性,可以让用户根据自己的需求创建新的函数。

•UDF 可以提高代码的可重用性和可维护性,同时也能提高程序的执行效率。

2. UDF 的优势•灵活性:UDF 可以根据用户的需求进行自定义,不受限于现有的函数库。

•可重用性:创建的 UDF 可以在多个项目中重复使用,减少了代码的重复编写。

•可维护性:通过封装一些常用的功能为自定义函数,可以使程序更易于维护和修改。

3. UDF 创建的流程创建一个 UDF 的过程可以分为以下几个步骤:定义函数名和参数首先需要确定函数的名称和参数列表,这些信息将会在调用函数时使用。

需要考虑参数的类型和数量,以及函数名的命名规范。

编写函数的代码逻辑根据函数的功能需求,编写函数的具体代码逻辑。

可以使用编程语言提供的语法和函数库进行编写,也可以结合自定义的方法。

测试函数的正确性在编写完函数的代码逻辑后,需要进行测试来验证函数的正确性。

可以通过编写测试样例,并对比预期结果和实际输出结果来进行验证。

保存和管理 UDF当函数通过测试后,需要将其保存和管理起来,以便在其他地方进行调用和使用。

可以将函数保存在独立的文件中,或者通过特定的工具保存和管理。

4. 使用 UDF在创建了 UDF 后,可以在编程语言中的其他地方进行调用和使用。

根据函数的定义,提供相应的参数,然后使用函数的返回值进行后续操作。

结论通过创建和使用 UDF,我们可以根据自己的需求扩展编程语言的功能,提高代码的灵活性、可重用性和可维护性。

在实际应用中,合理利用 UDF 可以大大提高开发效率和代码质量。

5. UDF 创建的注意事项在创建 UDF 的过程中,有一些注意事项需要注意,以确保函数的正确性和可用性。

命名规范•函数名应该具有描述性,能够清晰表达函数的功能。

UDF制作

图1

图1:先把需要用到的参数编成表达式,然后建模时就使用表达式,这个就不用多讲了吧。

可参考我做好的,建好模之后就开始以下步骤。

图2

图2:执行用户定义特征功能里的向导。

图3

图5

图8

1.完成后。

(.cgm和.prt文件)会生成于UGII目录下,

2.把这两个文件剪切到

\UGS\NX 7.5\UGII\udf\resource\metric下。

3.再把udf_database.txt复制到\UGS\NX 7.5\UGII下

图9

4.如果你只做了一个自定义特征,那就要把第2组和第3组删掉。

如果你做了好几个,那就把红线画掉的部分改成你取的名字。

如此类推。

如还不够,就在第3

组后面增加一组,把第1组复制下来,再改XXX即可。

图9:把自定义特征库添加到资源板。

图10

图11

图12

到此结束了

最后跟各位说几点:

1. 做自定义特征时,父项越少越好,父子关系要关

联好。

修改表达式参数时才不会容易出错。

2. 拉伸的时候,矢量方向不要选基准轴和基准平面

(即XYZ 面、轴),要改选面或边。

执行其它命令时的矢量方向亦如此。

3. 下面图14、图15是插入时的选项了,

图14

图15

图16。

Fluent中的UDF详细中文教程

第一章.介绍本章简要地介绍了用户自定义函数(UDF)及其在Fluent中的用法。

在1.1到1.6节中我们会介绍一下什么是UDF;如何使用UDF,以及为什么要使用UDF,在1.7中将一步步的演示一个UDF例子。

1.1 什么是UDF?1.2 为什么要使用UDF?1.3 UDF的局限1.4 Fluent5到Fluent6 UDF的变化1.5 UDF基础1.6 解释和编译UDF的比较1.7一个step-by-stepUDF例子1.1什么是UDF?用户自定义函数,或UDF,是用户自编的程序,它可以动态的连接到Fluent求解器上来提高求解器性能。

用户自定义函数用C语言编写。

使用DEFINE宏来定义。

UDF中可使用标准C语言的库函数,也可使用Fluent Inc.提供的预定义宏,通过这些预定义宏,可以获得Fluent求解器得到的数据。

UDF使用时可以被当作解释函数或编译函数。

解释函数在运行时读入并解释。

而编译UDF则在编译时被嵌入共享库中并与Fluent连接。

解释UDF用起来简单,但是有源代码和速度方面的限制不足。

编译UDF执行起来较快,也没有源代码限制,但设置和使用较为麻烦。

1.2为什么要使用UDF?一般说来,任何一种软件都不可能满足每一个人的要求,FLUENT也一样,其标准界面及功能并不能满足每个用户的需要。

UDF正是为解决这种问题而来,使用它我们可以编写FLUENT代码来满足不同用户的特殊需要。

当然,FLUENT的UDF并不是什么问题都可以解决的,在下面的章节中我们就会具体介绍一下FLUENT UDF的具体功能。

现在先简要介绍一下UDF的一些功能:z定制边界条件,定义材料属性,定义表面和体积反应率,定义FLUENT输运方程中的源项,用户自定义标量输运方程(UDS)中的源项扩散率函数等等。

z在每次迭代的基础上调节计算值z方案的初始化z(需要时)UDF的异步执行z后处理功能的改善z FLUENT模型的改进(例如离散项模型,多项混合物模型,离散发射辐射模型)由上可以看出FLUENT UDF并不涉及到各种算法的改善,这不能不说是一个遗憾。

hivejava编写udf函数

hivejava编写 udf函数

(一)创建JAVA 代码--例子

package hiveOpt;

import org.apache.hadoop.hive.ql.exec.UDF; import org.apache.hadoop.io.Text;

( 四)测试自定义函数 select phone_num,max(myCol1) from temp_qiu_test1 LATERAL VIEW explode(split(col1,',')) myTable1 AS myCol1 group by phone_num;

hadoop fs -put /data/soft/splitMax.jar /tmp

(三)登录hive命令行加载jar

hive> add jar hdfs:///tmp/splitMax.jar; hive> create temporary function splitmax as 'hiveOpt.splitMax'; hive> show funcations hive> select splitmax(id) from wobcongfu;

public Text evaluate(String String[] a = mdimlr.split(",");

result.set(String.valueOf(getMax(a))); return result;

}

}

(二)上传jar到hdfs

public class splitMax extends UDF {

Fluent中的UDF详细中文教程(7)

Fluent中的UDF详细中文教程(7)第七章 UDF的编译与链接编写好UDF件(详见第三章)后,接下来则准备编译(或链接)它。

在7.2或7.3节中指导将用户编写好的UDF如何解释、编译成为共享目标库的UDF。

_ 第 7.1 节: 介绍_ 第 7.2 节: 解释 UDF_ 第 7.3 节: 编译 UDF7.1 介绍解释的UDF和编译的UDF其源码产生途径及编译过程产生的结果代码是不同的。

编译后的UDF由C语言系统的编译器编译成本地目标码。

这一过程须在FLUENT运行前完成。

在FLUENT运行时会执行存放于共享库里的目标码,这一过程称为“动态装载”。

另一方面,解释的UDF被编译成与体系结构无关的中间代码或伪码。

这一代码调用时是在内部模拟器或解释器上运行。

与体系结构无关的代码牺牲了程序性能,但其UDF可易于共享在不同的结构体系之间,即操作系统和FLUENT版本中。

如果执行速度是所关心的,UDF 文件可以不用修改直接在编译模式里运行。

为了区别这种不同,在FLUENT中解释UDF和编译UDF的控制面板其形式是不同的。

解释UDF的控制面板里有个“Compile按钮”,当点击“Compile按钮”时会实时编译源码。

编译UDF的控制面板里有个“Open 按钮”,当点击“Open按钮” 时会“打开”或连接目标代码库运行FLUENT(此时在运行FLUENT之前需要编译好目标码)。

当FLUENT程序运行中链接一个已编译好的UDF库时,和该共享库相关的东西都被存放到case文件中。

因此,只要读取case文件,这个库会自动地链接到FLUENT处理过程。

同样地,一个已经经过解释的UDF文件在运行时刻被编译,用户自定义的C函数的名称与内容将会被存放到用户的case文件中。

只要读取这个case文件,这些函数会被自动编译。

注:已编译的UDF所用到的目标代码库必须适用于当前所使用的计算机体系结构、操作系统以及FLUENT软件的可执行版本。

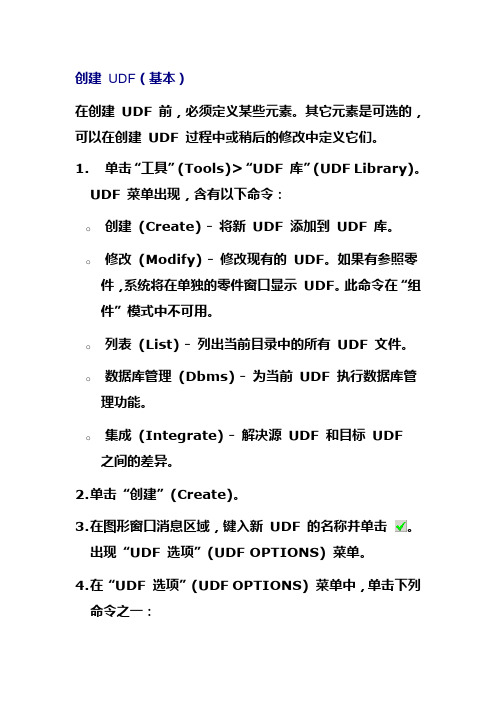

创建 UDF(基本)

创建UDF(基本)在创建UDF 前,必须定义某些元素。

其它元素是可选的,可以在创建UDF 过程中或稍后的修改中定义它们。

1.单击“工具”(Tools)>“UDF 库”(UDF Library)。

UDF 菜单出现,含有以下命令:o创建(Create) - 将新UDF 添加到UDF 库。

o修改(Modify) - 修改现有的UDF。

如果有参照零件,系统将在单独的零件窗口显示UDF。

此命令在“组件”模式中不可用。

o列表(List) - 列出当前目录中的所有UDF 文件。

o数据库管理(Dbms) - 为当前UDF 执行数据库管理功能。

o集成(Integrate) - 解决源UDF 和目标UDF 之间的差异。

2.单击“创建”(Create)。

3.在图形窗口消息区域,键入新UDF 的名称并单击。

出现“UDF 选项”(UDF OPTIONS) 菜单。

4.在“UDF 选项”(UDF OPTIONS) 菜单中,单击下列命令之一:o独立(Stand Alone) - 将全部所需信息复制到UDF。

o从属(Subordinate) - 运行时,自原始零件中复制大部分信息。

注意:o独立的UDF 不能有作为参照模型的组件,但从属的UDF 可以有。

o冲孔和切口UDF(Pro/SHEETMETAL)不能是从属的。

5.单击“完成”(Done)。

“UDF <udf 名称> 独立”(UDF <udf name> Standalone)或“UDF <udf 名称> 附属”(UDF <udf name> Subordinate)对话框打开,列出下列元素:注意,缺省情况下选取的是“特征”(Features)。

o特征(Features) - 选取要包括在UDF 中的特征。

o参照提示(Ref Prompts) - 为指定放置参照,输入提示。

放置UDF 时,系统将打印这些提示作为指导。

o可变元素(Var Elements) - 在零件中放置UDF 时,指定要重定义的特征元素。

udf 创建流程

udf 创建流程UDF 创建1. 什么是 UDFUDF(User-defined Function)是用户自定义函数的缩写,是一种在编程语言中允许用户自行定义的函数。

UDF 可以扩展编程语言的功能,使用户能够根据自己的需求创建特定的函数,从而提升编程体验和效率。

2. UDF 创建流程确定需求在创建 UDF 之前,首先需要明确自己的需求。

确定需要创建的函数的功能,参数和返回值的类型,以及函数的名称等。

选择合适的编程语言根据项目的需求和自己的编程技能,选择适合的编程语言来实现UDF。

常见的编程语言如 Python、JavaScript、Java、C++ 等都支持UDF 的创建,根据自己的需求选择最适合的语言。

编写代码根据需求开始编写 UDF 的代码。

根据编程语言的语法规则,定义函数的参数和返回值,并实现函数的具体功能。

在编写代码时,建议采用良好的编程风格,注释代码并进行适当的代码复用,以提高代码的可读性和维护性。

调试和测试完成代码编写后,进行调试和测试。

通过编程语言提供的调试工具,逐步调试代码,并确保代码的正确性和稳定性。

同时,利用合适的测试工具编写测试用例,对 UDF 进行全面的测试,确保其功能的正确性和性能的稳定性。

集成和部署当 UDF 的代码经过调试和测试后,可以将其集成到项目中。

根据编程语言的要求,将 UDF 的相关代码集成到项目中,并进行编译、部署等工作。

在集成和部署过程中,需要注意相关配置和依赖项的正确设置,以确保项目的正常运行。

文档撰写在完成 UDF 创建和部署后,建议撰写相应的文档,记录 UDF 的使用方法、参数说明和示例代码等。

文档的编写可以帮助其他开发人员了解和使用你创建的 UDF,提高项目的可维护性和团队的协作效率。

3. 总结通过以上流程,我们可以创建出满足自己需求的 UDF。

UDF 的创建不仅可以提升编程的效率和体验,还可以使项目拥有更强大的功能和扩展性。

在创作过程中遵循以上流程,并结合具体的编程语言和项目需求,相信你可以成功地创建出高质量的 UDF。

hive udf函数计算编写

hive udf函数计算编写摘要:一、Hive UDF简介1.Hive简介2.UDF概念介绍3.Hive UDF的作用二、Hive UDF编写环境与工具1.编写环境准备2.常用工具介绍三、Hive UDF编写流程1.创建UDF类2.编写UDF函数3.注册UDF函数4.使用UDF函数四、Hive UDF实战案例1.字符串处理UDF2.数学运算UDF3.日期处理UDF五、Hive UDF优化与调试1.性能优化2.调试方法正文:Hive是一个基于Hadoop的数据仓库工具,可以用来存储、查询和分析大规模的结构化数据。

在Hive中,用户可以通过编写UDF(用户自定义函数)来实现自定义的计算需求。

本文将详细介绍Hive UDF的编写方法、流程以及实战案例。

一、Hive UDF简介Hive UDF是Hive中一种非常重要的功能,它允许用户在HiveQL语句中使用自定义的函数,从而实现更加灵活和复杂的计算需求。

UDF可以用于各种数据处理任务,如字符串处理、数学运算、日期处理等。

1.Hive简介Hive是一个基于Hadoop的数据仓库工具,可以用来存储、查询和分析大规模的结构化数据。

Hive提供了类SQL的查询语言HiveQL,用户可以通过HiveQL语句实现数据查询、数据操作以及数据定义等任务。

2.UDF概念介绍UDF(User-Defined Function)即用户自定义函数,是一种允许用户在HiveQL语句中使用的自定义函数。

UDF可以实现复杂的计算逻辑,扩展Hive 的功能。

3.Hive UDF的作用Hive UDF的主要作用是弥补HiveQL语句在某些计算任务上的不足,例如字符串处理、数学运算、日期处理等。

通过编写UDF,用户可以实现更加灵活和复杂的计算需求。

二、Hive UDF编写环境与工具1.编写环境准备要编写Hive UDF,首先需要确保环境配置正确。

具体来说,需要安装Hive、Hadoop以及相关的开发工具,如Java、Maven等。

hive3 udf函数编写

hive3 udf函数编写Hive是一个用于数据仓库和大数据分析的开源数据仓库工具,它是基于Hadoop的一个数据仓库基础架构,提供类似于SQL的查询语言HiveQL,使得开发人员可以使用常见的SQL语言来处理分布式存储中的大数据。

在Hive中,用户自定义函数(User-Defined Functions,UDFs)可以用于扩展HiveQL语言的功能,使得开发人员可以根据自己的需求编写自定义的函数。

本文将讨论在Hive3中编写UDF函数的方法和步骤。

首先,我们需要了解Hive的UDF函数的分类。

Hive的UDF函数可以分为以下几类:1. 标量函数(Scalar Functions):接受一些输入参数,并返回一个单一的输出结果。

例如,将一个字符串转换为大写或者将两个数字相加。

2. 聚合函数(Aggregate Functions):接受一组输入值,并返回一个聚合结果。

例如,计算平均值或求和。

3. 表生成函数(Table Generating Functions):接受一些输入参数,并生成一个输出表。

接下来,我们将以一个简单的示例来演示如何编写Hive3的UDF函数。

假设我们有一个包含员工姓名和薪水的表格,我们想要创建一个函数来计算员工薪水的增长百分比。

首先,我们需要创建一个新的Java类来实现我们的UDF函数。

这个类需要继承Hive的UDF类,并且重写evaluate()方法。

```import org.apache.hadoop.hive.ql.exec.Description;import org.apache.hadoop.hive.ql.exec.UDF;import org.apache.hadoop.hive.ql.udf.UDFType;@Description(name = "salary_growth_percentage",value = "Calculates the growth percentage of an employee's salary",extended = "SELECT salary_growth_percentage(salary) FROM employees")@UDFType(deterministic = true, stateful = false)public class SalaryGrowthPercentage extends UDF {public Double evaluate(Double currentSalary, Double previousSalary) {if (currentSalary == null || previousSalary == null) {return null;}double growthPercentage = (currentSalary - previousSalary) / previousSalary * 100;return growthPercentage;}}```在上述代码中,我们创建了一个名为SalaryGrowthPercentage的类,它继承自Hive的UDF类。

UDF的创建和使用

UDF的创建和使用用户自定义特征(User Defined Functions,UDF)是一种在关系型数据库或数据分析工具中创建和使用的函数,用于自定义数据处理逻辑。

UDF允许用户根据自己的需求创建函数,以便在数据库查询或数据处理过程中使用。

UDF的创建和使用分为三个主要步骤:定义、注册和使用。

首先是定义UDF的逻辑。

定义UDF时,需要指定函数的输入和输出类型,以及函数的处理逻辑。

根据具体需求,UDF可以是纯粹的数据转换逻辑,也可以是复杂的算法或模型。

例如,假设我们需要在数据库中创建一个计算两个数的平方和的UDF。

我们可以定义一个输入类型为两个整数,输出类型为整数的UDF函数,如下所示:```sqlCREATE FUNCTION square_sum(a INT, b INT) RETURNS INTBEGINDECLARE result INT;SET result = a*a + b*b;RETURN result;END;```接下来是UDF的注册。

将定义好的UDF注册到数据库中,以便其他用户可以在查询或数据处理过程中调用该函数。

注册UDF的方式与具体数据库或工具有关。

例如,在MySQL数据库中,可以使用以下命令来注册上述定义的UDF:```sqlCREATE FUNCTION square_sum(a INT, b INT) RETURNS INTBEGINDECLARE result INT;SET result = a*a + b*b;RETURN result;END;```Once the UDF is defined and registered, it can be used in database queries or data processing tasks. Users can call the UDF by its name and pass the required parameters.For example, assuming we have a table named "numbers" with two columns "num1" and "num2", we can use the UDF in a querylike this:```sqlSELECT square_sum(num1, num2) AS sum_of_squares FROM numbers;```This will calculate the square sum of each pair of numbers in the table and return the result as a new column"sum_of_squares".UDFs can also be used in data analysis tools like Apache Spark or Python libraries like Pandas. The process of creating and using UDFs in these tools may vary, but the generalprinciple is the same – define the function logic, register the function, and then use it in data processing tasks.In Spark, for example, UDFs can be defined using Python or Scala and registered using the `spark.udf.register` method. Once registered, the UDF can be used in Spark SQL queries or DataFrame operations.Overall, UDFs provide users with the flexibility to define and use custom functions in database queries or data processing tasks. This allows for more advanced data manipulation and analysis, as users can tailor the functions to their specific needs.。

UDF的创建和使用

UDF的创建和使用用户自定义特征(User-Defined Functions,UDF)是一种在数据处理过程中自定义函数的方式。

在大数据处理和分析中,UDF提供了一种灵活且高效的方法来处理和转换数据。

下面将详细介绍UDF的创建和使用。

UDF的创建需要根据具体的处理需求,使用编程语言来定义函数的逻辑。

常用的编程语言包括Python、Java、Scala等。

以下是UDF的创建步骤:1.确定处理逻辑:首先,需要确定要实现的处理逻辑,例如字符串的转换、数值计算等。

这些逻辑将作为UDF的函数体。

2. 编写函数代码:根据处理逻辑,使用所选的编程语言编写相应的函数代码。

例如,使用Python时,可以使用`def`关键字定义函数。

同时,可以利用编程语言提供的丰富特性和库来实现函数的功能。

3.添加输入参数:根据需要,添加相应的输入参数。

输入参数可以是一到多个,可以是任意数据类型。

在函数体中,可以使用这些输入参数进行处理。

4. 指定返回值:确定函数的返回值类型,并在函数体中使用`return`语句返回结果。

返回值可以是标量,也可以是复合类型,如数组或结构体。

5. 注册UDF:将编写的函数注册为UDF。

不同的数据处理平台和工具可能有不同的注册方式。

例如,在Spark中,可以使用`sqlContext.udf.register`方法来注册UDF。

UDF的使用可以在各种数据处理环境中实现,如Spark、Hive等。

以下是UDF的使用步骤:1.导入UDF:首先,需要导入所需的UDF。

导入的方式取决于所使用的数据处理平台和工具。

2.调用UDF:使用导入的UDF,在数据处理流程中调用相应的函数。

可以将UDF应用于单个数据点或整个数据集。

3.传递参数:根据函数定义,将需要处理的数据传递给UDF。

参数的传递方式可以根据具体情况来确定,例如使用变量、列名称等。

4.获取结果:根据函数定义,获取UDF的输出结果。

可以将结果赋值给变量、存储到数据库或写入文件等。

3-udf的解释和编译

3-udf的解释和编译udf的解释和编译包含udf的源代码文件可以在ANSYS FLUENT中进行解释或编译,在这两种情况下,都会编译函数,但是对于这两种方法,编译源代码的方式和编译过程产生的代码是不同的。

编译udf编译后的udf的构建方式与ANSYS FLUENT可执行文件本身的构建方式相同:使用Makefile脚本调用system C编译器来构建目标代码库。

在“已编译UDFs”对话框中单击“build”来启动此操作。

目标代码库包含高级C源代码的本机机器语言翻译。

共享库必须在运行时通过一个称为“动态加载”的过程加载到ANSYS FLUENT中。

在已编译的UDFs对话框中,通过单击Load启动此操作。

对象库特定于所使用的计算机体系结构,以及正在运行的ANSYS FLUENT可执行程序的特定版本。

因此,当ANSYS FLUENT升级、计算机的操作系统级别发生变化或作业在不同类型的计算机上运行时,必须重新构建这些库。

总之,编译后的udf是使用图形用户界面从源文件编译而来的,这需要两个步骤。

该过程涉及到已编译UDFs对话框,在该对话框中,首先从源文件构建一个共享库对象文件,然后加载刚构建到ANSYS FLUENT中的共享库。

解释udf解释过的udf使用图形用户界面从源文件解释,但在单个步骤过程中。

该过程在运行时发生,涉及到使用解释的UDFs对话框,在该对话框中解释源文件。

在ANSYS FLUENT中,使用C预处理器将源代码编译成与体系结构无关的中间机器码。

然后,当调用UDF时,此机器码在内部仿真器或解释器上执行。

这一额外的代码层会带来性能损失,但是可以在不同的体系结构、操作系统和ANSYS FLUENT版本之间轻松地共享经过解释的UDF。

如果执行速度确实成为一个问题,则解释的UDF始终可以在编译模式下运行,而无需修改。

用于解释udf 的解释器不具备标准C编译器(用于编译udf)的所有功能。

具体来说,解释udf不能包含以下任何C编程语言元素:· goto statements·Non-ANSI-C prototypes for syntax· Directdata structure references·Declarations of local structures· Unions· Pointersto functions· Arrays of functions· Multi-dimensionalarrays.解释的udf和编译的udf之间的差异解释的udf和编译的udf之间的主要区别是,解释的udf不能使用直接的结构引用访问ANSYS FLUENT求解器数据; 他们只能通过ANSYS提供的宏间接访问数据。

PROE用户定义特征UDF创建教程

PS:参数“TRUTH”的类型为什么不用”是/否“(布尔型)?因为布尔型在UDF的界面 值下不能像在参数窗口中可以下拉选择,用0或1来作为条件,更便于输入而已。

刻字UDF制作

衍生 3

完成上一步(注意先保持参数”truth“的值是”0“),在重新制作UDF PS:为什么不用UDF库中”修改“命令来修改刚刚已经制作好的UDF?--因为这只能修改UDF已经约定好的条件,并不能增加条件。

MS是从事模具设计工作,在每一套新模拆3D后都需给零件刻上编号,若模仁、镶件、 行位、斜顶之类的零件数量有几十个,那估计半天其他事都不用做,都在那拉伸→草 绘→刻字了……及其枯燥的一个过程… 借助于UDF,一个零件的可以时间可以缩短成几秒钟,姑且用5秒给个参考吧,,, 当然,还可以更快些。

首先,需要解决一个麻烦,如何能让刻字的内容自动提取零件的名称?这是关键! 这里需要用到一个关系函数:rel_model_name,这个函数用来提取模型名称,下面做 详细的步骤:

刻字UDF制作

STEP 12

为加亮的面输入提示

提示2 为加亮的面输入提示

提示1

为加亮的面输入提示

三个提示输入完成后 按确定(或中键)

提示3

PS:此处系统出现的3个提示参考是模型树中“拉伸2” 创建时所用到的参考,注意,如果有多余的参考, 系统会继续让你填写参考提示,所以,创建时将多 余的参考删除!过多的参考也是浪费。

参考、可变尺寸定义都和之前一样, 这次需要加入“可变参数”选项。

双击定义

刻字UDF制作

衍生 4

选中特征后,按下鼠标中 键或点击“选择”框的“确定”, 跳出可变参数对话框。

刻字UDF制作

衍生 5

勾选这两个变量,点击右下角 “关闭”按钮。

hive udf开发流程

hive udf开发流程下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by theeditor. I hope that after you download them,they can help yousolve practical problems. The document can be customized andmodified after downloading,please adjust and use it according toactual needs, thank you!In addition, our shop provides you with various types ofpractical materials,such as educational essays, diaryappreciation,sentence excerpts,ancient poems,classic articles,topic composition,work summary,word parsing,copy excerpts,other materials and so on,want to know different data formats andwriting methods,please pay attention!1. 确定需求:明确你要实现的函数功能和输入输出要求。

考虑函数的参数类型、返回值类型以及可能的异常情况。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第 3 章 编写 UDF第 3 章 编写 UDF本章包含了 FLUENT 中如何写 UDFs 的概述。

3.1 概述 3.2 写解释式 UDFs 的限制 3.3 FLUENT 中 UDFs 求解过程的顺序 3.4 FLUENT 网格拓扑 3.5 FLUENT 数据类型 3.6 使用 DEFINE Macros 定义你的 UDF 3.7 在你的 UDF 源文件中包含 udf.h 文件 3.8 定义你的函数中的变量 3.9 函数体 3.10 UDF 任务 3.11 为多相流应用写 UDFs 3.12 在并行中使用你的 UDF 3.1 概述(Introduction) 在你开始编写将挂到 FLUENT 代码以增强其标准特征的 UDF 之前,你必须 知道几个基本的要求。

首先,UDFs 必须用 C 语言编写。

它们必须使用 FLUENT 提供的 DEFINE macros 来定义。

UDFs 必须含有包含于源代码开始指示的 udf.h 文件;它允许为 DEFINE macros 和包含在编译过程的其它 FLUENT 提供的函数 定义。

UDFs 只使用预先确定的宏和函数从 FLUENT 求解器访问数据。

通过 UDF 传递到求解器的任何值或从求解器返回到 UDF 的,都指定为国际(SI)单位。

总之,当写 UDF 时,你必须记住下面的 FLUENT 要求。

UDFs: 1. 采用 C 语言编写。

2. 必须为 udf.h 文件有一个包含声明。

3. 使用 Fluent.Inc 提供的 DEFINE macros 来定义。

4. 使用 Fluent.Inc 提供的预定义宏和函数来访问 FLUENT 求解器数据。

5. 必须使返回到 FLUENT 求解器的所有值指定为国际单位。

3.2 写解释式 UDFs 的限制(Restriction on Writing Interpreted UDFs)第 3 章 编写 UDF无论 UDFs 在 FLUENT 中以解释还是编译方式执行,用户定义 C 函数(说明在 Section 3.1 中)的基本要求是相同的,但还是有一些影响解释式 UDFs 的重大编 程限制。

FLUENT 解释程序不支持所有的 C 语言编程原理。

解释式 UDFs 不能 包含以下 C 语言编程原理的任何一个: 1. goto 语句。

2. 非 ANSI-C 原型语法 3. 直接的数据结构查询(direct data structure references) 4. 局部结构的声明 5. 联合(unions) 6. 指向函数的指针(pointers to functions) 7. 函数数组。

在访问 FLUENT 求解器数据的方式上解释式 UDFs 也有限制。

解释式 UDFs 不能 直接访问存储在 FLUENT 结构中的数据。

它们只能通过使用 Fluent 提供的宏间 接地访问这些数据。

另一方面, 编译式 UDFs 没有任何 C 编程语言或其它注意的 求解器数据结构的限制。

3.3 FLUENT 求解过程中 UDFs 的先后顺序 (Sequencing of UDFs in the FLUENT Solution Process) 当你开始写 UDF 代码的过程时(依赖于你写的 UDF 的类型) ,理解 FLUENT 求 解过程中 UDFs 调用的内容或许是重要的。

求解器中包含连接你写的用户定义函 数的 call-outs。

知道 FLUENT 求解过程中迭代之内函数调用的先后顺序能帮助你 在给定的任意时间内确定那些数据是当前的和有效的。

分离式求解器 在分离式求解器求解过程中(Figure 3.3.1) ,用户定义的初始化函数(使用 DEFINE_INIT 定义的)在迭代循环开始之前执行。

然后迭代循环开始执行用户 定义的调整函数(使用 DEFINE_ADJUST 定义的) 。

接着,求解守恒方程,顺序 是从动量方程和后来的压力修正方程到与特定计算相关的附加标量方程。

守恒方 程之后,属性被更新(包含用户定义属性) 。

这样,如果你的模型涉及到气体定 律,这时,密度将随更新的温度(和压力 and/or 物质质量分数)而被更新。

进 行收敛或者附加要求的迭代的检查,循环或者继续或停止。

第 3 章 编写 UDFFigure 3.3.1: Solution Procedure for the Segregated Solver耦合求解器 在耦合求解器求解过程中(Figure 3.3.2),用户定义的初始化函数(使用 DEFINE_INIT 定义的)在迭代循环开始之前执行。

然后,迭代循环开始执行用 户定义的调整函数 (使用 DEFINE_ADJUST 定义的) 接着, 。

FLUENT 求解连续、 动量和(适合的地方)能量的控制方程和同时地一套物质输运或矢量方程。

其余 的求解步骤与分离式求解器相同(Figure 3.3.1) 。

Figure 3.3.2: Solution Procedure for the Coupled Solver第 3 章 编写 UDF3.4 FLUENT 网格拓扑 在我们开始讨论 FLUENT 特殊的数据类型之前,你必须理解网格拓扑学的术语 因为 FLUENT 数据类型是为这些实体定义的。

下面是显示在 Figure 3.4.1 中的网 格实体的定义。

单元(cell) 单元中心(cell center) 面(face) 边(edge) 节点(node) 单元线索(cell thread) 区域被分割成的控制容积 FLUENT 中场数据存储的地方 单元(2D or 3D)的边界 面(3D)的边界 网格点 在其中分配了材料数据和源项的单元组第 3 章 编写 UDF面线索(face thread) 节点线索(node thread) 区域(domain)在其中分配了边界数据的面组 节点组 由网格定义的所有节点、面和单元线索的组合Figure 3.4.1: Grid Terminology3.5 FLUENT 数据类型(FLUENT Data Types) 除了标准的 C 语言数据类型如 real, int 等可用于在你的 UDF 中定义数据外,还 有几个 FLUENT 指定的与求解器数据相关的数据类型。

这些数据类型描述了 FLUENT 中定义的网格的计算单位(见 Figure 3.4.1) 。

使用这些数据类型定义的 变量既有代表性地补充了 DEFINE macros 的自变量,也补充了其它专门的访问 FLUENT 求解器数据的函数。

一些更为经常使用的 FLUENT 数据类型如下: cell_t face_t第 3 章 编写 UDFThread Domain Node cell_t 是线索(thread)内单元标识符的数据类型。

它是一个识别给定线索内单 元的整数索引。

face_t 是线索内面标识符的数据类型。

它是一个识别给定线索内 面的整数索引。

Thread 数据类型是 FLUENT 中的数据结构。

它充当了一个与它描述的单元或面 的组合相关的数据容器。

Node 数据类型也是 FLUENT 中的数据结构。

它充当了一个与单元或面的拐角相 关的数据容器。

Domain 数据类型代表了 FLUENT 中最高水平的数据结构。

它充当了一个与网格 中所有节点、面和单元线索组合相关的数据容器。

! !注意,FLUENT 中所有数据类型都是 情形敏感的(case-sensitive) 。

3.6 使用 DEFINE Macros 定义你的 UDF(Defining Your UDF Using DEFINE Macros) Fluent.Inc 为你提供了一套你必须使用它来定义你的 UDF 的预定义函数。

这些定 义 UDFs 的函数在代码中作为宏执行,可在作为 DEFINE(全部大写)宏的文献中 查阅。

对每个 DEFINE 宏的完整描述和它的应用例子,可参考第四章。

DEFINE 宏的通用格式为: DEFINE_MACRONAME(udf_name, passed-in variables) 这里括号内第一个自变量是你的 UDF 的名称。

名称自变量是情形敏感的必须用 小写字母指定。

一旦函数被编译 (和连接)你为你的 UDF 选择的名字在 FLUENT , 下拉列表中将变成可见的和可选的。

第二套输入到 DEFINE 宏的自变量是从 FLUENT 求解器传递到你的函数的变量。

在下面的例子中,宏 DEFINE_PROFILE(inlet_x_velocity, thread, index) 用 两 个 从 FLUENT 传 递 到 函 数 的 变 量 thread 和 index 定 义 了 名 字 为 inlet_x_velocity 的分布函数。

这些 passed-in 变量是边界条件区域的 ID(作为指 向 thread 的指针)而 index 确定了被存储的变量。

一旦 UDF 被编译,它的名字第 3 章 编写 UDF(例如, inlet_x_velocity) 将在 FLUENT 适当的边界条件面板 (例如, Velocity Inlet 面板)的下拉列表中变为可见的和可选的。

! !注意,所有用于 DEFINE 宏的自变量必须放在你的源代码的同一行上。

分割 DEFINE 的声明为几行可能导致编译错误。

3.7 在你的 UDF 源文件中包含 udf.h 文件(Including the udf.h File in Your UDF Source File) DEFINE 宏的定义位于称为 udf.h(见附录 A 的列表)的头文件中。

为了使 DEFINE 宏延伸到编译过程,你必须在你写的每个 UDF 源文件的开始包含 udf.h 文件。

#include "udf.h"/* Always include udf.h when writing a UDF. It translates the DEFINE */ /* and other macros into C, which is what the compiler understands. */通过在你的 UDF 源文件中包含 udf.h, 编译过程中所有的 DEFINE 宏的定义与源 代码一起被包含进来。

udf.h 文件也为所有的 C 库函数头文件包含#include 指示, 与大部分头文件是针对 Fluent 提供的宏和函数是一样的(例如,mem.h) 。

除非 有另外的指示,没必要在你的 UDF 中个别地包含这些头文件。

还有,当你编译你的 UDF 时,你不必放置 udf.h 的拷贝在你的当地目录下;一旦 你的 UDF 被编译,FLUENT 求解器会自动地从 Fluent.Inc/fluent6.x/src/目录来读 取 udf.h 文件。