对 数 运 算 法 则

对数加减法法则范文

对数加减法法则范文对数加法法则:1.对数相加时,可以将两个对数相加作为一个对数的结果。

对于任意实数a,b,以及正实数c,有logc(ab) = logc(a) +logc(b)。

这个法则的推导可以通过指数的性质进行,即根据指数法则可知:c^(logc(ab)) = ab = c^(logc(a) + logc(b)),从而可将两者相等。

这个法则在计算上非常有用,因为其允许我们将一个复杂的对数问题简化为两个较小的对数的加法。

例如,计算log10(1000)可以使用对数加法法则:log10(1000) = log10(10) + log10(100) = 1 + 2 = 32.对数相加时,可以通过指数运算进行计算。

对于任意实数a,b,以及正实数c,有a^b*a^c=a^(b+c)。

将这个性质应用于对数运算,可以得出对数之和的规则。

具体来说,如果logc(a) + logc(b)等于一个对数,那么这个对数就是c底下的一个数。

例如,计算log2(8)可以使用对数加法法则:log2(8) = log2(4 * 2) = log2(4) + log2(2) = 2 + 1 = 3对数减法法则:1.对数相减时,可以将两个对数相减作为一个对数的结果。

对于任意实数a,b,以及正实数c,有logc(a/b) = logc(a) - logc(b)。

这个法则的推导可以通过指数的性质进行,即根据指数法则可知:c^(logc(a/b)) = a/b = c^(logc(a) - logc(b)),从而可将两者相等。

2.对数相减时,可以通过指数运算进行计算。

对于任意实数a,b,以及正实数c,有(a^b)/(a^c)=a^(b-c)。

将这个性质应用于对数运算,可以得出对数之差的规则。

具体来说,如果logc(a) - logc(b)等于一个对数,那么这个对数就是c底下的一个数。

例如,计算log10(10/2)可以使用对数减法法则:log10(10/2) = log10(10) - log10(2) = 1 - 0.3010 = 0.699总结:对数加减法法则是计算对数加减运算的基本原则。

数的运算知识点归纳

数的运算知识点归纳数学运算是我们生活中不可或缺的一部分,它涵盖了加、减、乘、除等基本运算以及更加复杂的运算方式。

正确地掌握这些数学运算,可以帮助我们更好地理解数学知识,提高数学水平,本文将对数的运算知识点进行归纳总结。

一、小数的加减乘除小数是数学中的重要知识点,在加减乘除中,小数与整数之间的运算方法基本相同,但小数之间的运算则需要注意小数点的位置、数位的对齐等。

在小数的加减法中,首先需要将小数点对齐,然后按照整数加减法的方法计算即可。

在小数的乘法中,需要将两个小数中的小数点忽略掉,计算乘积后再根据小数点的位置确定答案。

在小数的除法中,则需要将被除数和除数都乘以一个适当的数,使得除数变为整数,然后计算商,最后再根据小数点的位置确定答案。

二、分数的加减乘除分数是数学中较为困难的知识点,它的加减乘除需要掌握相应的方法。

在分数的加减法中,首先需要将两个分数化成相同的分母,然后按照整数加减法的方法计算即可。

在分数的乘法中,需要将两个分数的分子和分母分别相乘,然后化简分数。

在分数的除法中,则需要将除数倒数后,转化为乘法计算。

三、整式的加减乘除整式是代数中的一种常见形式,在加减乘除中需要掌握相应的方法。

在整式的加减法中,首先需要将同类项进行合并,然后按照整数加减法的方法计算即可。

在整式的乘法中,需要将两个整式中的每一项都相乘,然后将所有的乘积相加得到结果。

在整式的除法中,则需要将除式乘以被除式的倒数,然后进行化简。

四、三角函数的计算三角函数是高一数学中的难点,需要掌握各种三角函数的定义、性质以及计算方法。

在三角函数的计算中,根据三角函数的定义和性质,可以得到各种三角函数的计算公式。

例如,正弦函数的计算公式为sin(x)=对边/斜边,余弦函数的计算公式为cos(x)=邻边/斜边,正切函数的计算公式为tan(x)=对边/邻边等。

五、向量的运算向量是高中数学中的重要知识点,在向量的加减、数量积、向量积等方面需要掌握对应的运算方法。

对数的概念及运算法则

对数的概念及运算法则对数是数学中的一个概念,它表示一个数相对于一些给定的底数的幂。

在日常生活中,对数经常被用来解释指数增长或减少的情况。

首先,对数的定义是:对于给定的正数a(a ≠ 1),将正数x表达为底数a的幂的等式,即x = a^m (m为任意实数),称m为x的以a为底的对数,记作m =log[底数a](x),即m = loga(x)。

对数有以下几个重要特点:1.底数必须是一个正数,并且不能等于12.对数函数中x的取值范围为正实数,因为负数和0的对数不存在。

3.对数的结果m可以是任意实数,包括正数、负数和零。

对数具有一些重要的性质和运算法则,下面介绍其中的一些:1.换底公式:对于任意给定的x和任意的正数a、b(a、b≠1),有以下等式成立:loga(x) = logb(x) / logb(a)换底公式可以将一个对数用另一个底数的对数表示,这样在计算和比较对数时更加方便。

2.加减法法则:对于任意给定的正数a、b和任意的正数x、y,有以下等式成立:loga(x * y) = loga(x) + loga(y)loga(x / y) = loga(x) - loga(y)加减法法则可以将对数的乘法和除法分解为对数的加法和减法,简化对数运算。

3.乘方法则:对于任意给定的正数a和任意的正数x和正整数n,有以下等式成立:loga(x^n) = n * loga(x)乘方法则可以将对数中的指数化简为对数本身的乘法。

4.对数的乘法和除法法则:对于任意给定的正数a、b和任意的正数x,有以下等式成立:loga(x^b) = b * loga(x)loga(b^x) = x * loga(b)乘法和除法法则可以将指数中的对数化简为对数本身的乘法或除法。

5.对数的幂次法则:对于任意给定的正数a、b和任意的正数x,有以下等式成立:a^(loga(x)) = x如果a ≠ 1,则loga(a^x) = x幂次法则可以将对数中的幂次化简为原指数。

对数四则运算

对数四则运算对数是一种特殊的数学运算方法,用它可以快速解决复杂的数学问题。

对数的运用可以有效提高数学解题的速度,成为解决复杂的数学问题的重要工具。

数四则运算是指使用对数技巧解决遇到的数学题目,借助这种运算可以完成相对复杂的数学问题。

本文将介绍这种运算方法的基本原理和具体做法,以及在实际应用中常见的问题。

一、对数四则运算的基本原理1.数运算的基本原理:对数作为一种技巧,非常适合用来处理具有一定规律的数学题目。

这种运算的核心原理是使用对数的特性来解决数学问题,从而提高解题的效率。

2.数的特征:对数的特征是它的数值大小有排列规律,可以利用这种规律进行快速运算。

3.数的运用:数的特性使它可以用于解决复杂的数学问题,可以将数学题目中的运算转化为对数的运算,从而更容易求解。

二、常见的对数四则运算1.法:两个数字相加,将它们用相同的底数表示,就可以用对数运算来计算它们的和:给定两个数a和b,用相同的底数表示,可以得出:loga+logb=log(a+b)即能够将加法转化为对数的乘法。

2.法:两个数相减,可以将减法转化为加法:给定两个数a和b,用相同的底数表示,可以得出:loga-logb=log(a-b)即能够将减法转化为对数的加法。

3. 乘法:两个数相乘,可以将乘法转化为加法:给定两个数a和b,用相同的底数表示,可以得出:loga*logb=log(a*b)即能够将乘法转化为对数的加法。

4.法:两个数相除,可以将除法转化为减法:给定两个数a和b,用相同的底数表示,可以得出:loga÷logb=log(a÷b)即能够将除法转化为对数的减法。

三、实际应用中的问题1.底号问题:必须使用相同的底号才能够把两个数相加、减、乘、除等,如果使用不同的底号,则需要先将数字转换成相同底号表示形式才能够进行计算。

2.殊情况:有时候在计算某个数字对数的时候,会遇到0或负数,这种情况下需要加以特殊处理,例如:计算log(-1),需要用到虚数的特殊解法。

对数与对数运算说课稿(精选5篇)

对数与对数运算说课稿(精选5篇)以下是网友分享的关于对数与对数运算说课稿的资料5篇,希望对您有所帮助,就爱阅读感谢您的支持。

篇一§2.2.1对数与对数运算说课稿大家好,我是。

,我今天的讲课内容是对数与对数的运算。

我将从以下5个方面来进行今天的说课,第一是教学内容分析,第二是学生的学情分析,第三是教学方法的策略,第四是教学过程的设计,第五的教学反思。

一、教学内容分析对数与对数的运算是人教版高中教材必修一第二章第二节第一课时的内容。

本节课是第一课时,主要讲的就是认识对数和对数的一些基本运算性质。

本节课的学习蕴含着转化化规的数学思想,类比与对比等基本数学方法。

在上节课,我们学习了指数函数以及指数函数的性质,是本节课学习对数与对数的运算的基础,而下节课,我们又将学习对数函数与对数函数的性质,这节课恰好为下节课的学习做了一个铺垫。

二、学生学情分析接下来我将从认知、能力、情感三个方面来进行学生的学情分析。

首先是认知,该阶段的高中生已经学习了指数及指数函数的性质,具备了学习对数的基础知识;在能力方面,高一的学生已经初步具备运用所学知识解决问题的能力,但是大多数同学还缺乏类比迁移的能力;而在情感方面,大多数学生有积极的学习态度,能主动参与研究,但是还有部分的学生还是需要老师来加以引导的。

三、教学方法的策略根据教材的要求以及本阶段学生的具体学习情况,我制定了一下的教学目标。

首先是知识与技能,理解对数与指数的关系,能进行指对数互化并可利用对数的简单性质求值;接着是过程与方法,通过探究对数和指数之间的互化,培养发现问题、分析问题、解决问题的能力;最后是情感态度与价值观,通过对问题转化过程的引导,培养学生敢于质疑、勇于开拓的创新精神。

基于以上的分析,我制定了本节课的重难点。

本节课的教学重点是对数的定义,对数式与指数式的互化,对数的运算法则及其推导和应用;本节课的难点是对数概念的理解和对数运算法则的探究和证明;本节课我所采用的教学方法是探究式教学法,分为以下几个环节:教师创设问题情境,启发式地讲授,讲练结合,引导学生思考,最后鼓励学生自主探究学习。

初中数学运算法则知识点归纳

初中数学运算法则知识点归纳数学是一门需要掌握基本运算法则的学科,初中阶段是学生们打下数学基础的重要时期。

在初中数学课程中,有一些基本的运算法则需要学生们掌握和理解。

本文将对初中数学运算法则的知识点进行归纳和总结。

一、四则运算法则四则运算是数学中最基本的运算法则,包括加法、减法、乘法和除法。

1. 加法:加法是两个数的结果与它们的和的基本关系。

加法满足交换律和结合律,即a + b = b + a,(a + b) + c = a + (b + c)。

同时,加法还有零元素的概念,即a + 0 = a。

2. 减法:减法是两个数的结果与它们的差的基本关系。

减法可转化为加法,即a -b = a + (-b)。

在减法中,要注意减法不能交换,即a - b ≠ b - a。

3. 乘法:乘法是两个数的结果与它们的积的基本关系。

乘法满足交换律和结合律,即a × b = b × a,(a × b) × c = a × (b × c)。

同时,乘法还有单位元素的概念,即a × 1 = a。

4. 除法:除法是两个数的结果与它们的商的基本关系。

除法也可转化为乘法,即a ÷ b = a × (1/b)。

在除法中,要注意除法不能交换,即a ÷ b ≠ b ÷ a。

同时,在除法中要避免除以0的情况,即a ÷ 0 无意义。

二、乘方和开方的运算法则1. 乘方:乘方是将一个数自己乘以自己多次的运算,用a的n次方表示为an。

乘方满足乘法法则,即a的m次方乘以a的n次方等于a的m + n次方。

同时,任何数的0次方都等于1,即a的0次方等于1。

2. 开方:开方是与乘方相反的运算,表示一个数的平方根。

开方满足乘法法则的逆运算。

例如,a的n次方的开n次方等于a。

三、整数运算法则1. 整数的加减法:整数的加减法满足与正数的加减法相同的规律。

对数之间的运算法则

对数之间的运算法则对数是数学中常用的一种运算方法,它有着独特的运算法则。

本文将介绍对数之间的运算法则,包括对数的乘法法则、对数的除法法则、对数的幂法法则以及对数的换底法则。

一、对数的乘法法则对数的乘法法则是指两个数的对数相加等于这两个数的乘积的对数。

例如,log_a(b) + log_a(c) = log_a(b * c)。

这个法则可以帮助我们简化复杂的乘法运算,将乘法转化为加法运算。

二、对数的除法法则对数的除法法则是指两个数的对数相减等于这两个数的商的对数。

例如,log_a(b) - log_a(c) = log_a(b / c)。

这个法则可以帮助我们简化复杂的除法运算,将除法转化为减法运算。

三、对数的幂法法则对数的幂法法则是指一个数的对数与指数相乘等于这个数本身。

例如,log_a(b^c) = c * log_a(b)。

这个法则可以帮助我们求解指数运算中的对数值。

四、对数的换底法则对数的换底法则是指用一个底数的对数表示另一个底数的对数。

换底法则可以将对数从一个底数转化为另一个底数的对数。

具体来说,log_a(b) = log_c(b) / log_c(a)。

这个法则在实际计算中非常有用,可以将对数运算转化为常用的底数进行计算。

通过运用对数之间的运算法则,我们可以简化复杂的数学运算,提高计算的效率。

同时,对数法则的应用也有助于我们理解数学中的一些概念和关系,拓宽数学思维。

在实际运用中,对数的乘法法则和除法法则常常被用于处理大数乘除运算,例如在科学计算、金融领域中的复利计算等。

对数的幂法法则则可以用于求解指数方程,解决一些与指数相关的问题。

对数的换底法则则可以将不常用的底数转化为常用的底数,方便计算和比较。

对数之间的运算法则是数学中重要且实用的工具。

通过熟练掌握这些法则,我们可以更加灵活地运用对数进行计算,并且深入理解数学中的一些概念和关系。

在实际应用中,对数运算法则可以帮助我们简化复杂的数学计算,提高计算的效率和准确性。

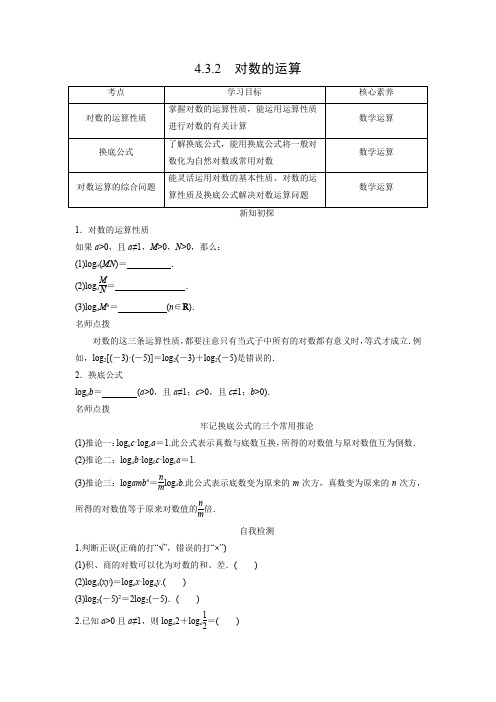

学案3:4.3.2 对数的运算

4.3.2 对数的运算1.对数的运算性质如果a >0,且a ≠1,M >0,N >0,那么: (1)log a (MN )= . (2)log a MN = .(3)log a M n = (n ∈R ). 名师点拨对数的这三条运算性质,都要注意只有当式子中所有的对数都有意义时,等式才成立.例如,log 2[(-3)·(-5)]=log 2(-3)+log 2(-5)是错误的. 2.换底公式log a b = (a >0,且a ≠1;c >0,且c ≠1;b >0). 名师点拨牢记换底公式的三个常用推论(1)推论一:log a c ·log c a =1.此公式表示真数与底数互换,所得的对数值与原对数值互为倒数. (2)推论二:log a b ·log b c ·log c a =1.(3)推论三:log amb n =nm log a b .此公式表示底数变为原来的m 次方,真数变为原来的n 次方,所得的对数值等于原来对数值的nm倍.自我检测1.判断正误(正确的打“√”,错误的打“×”) (1)积、商的对数可以化为对数的和、差.( ) (2)log a (xy )=log a x ·log a y .( ) (3)log 2(-5)2=2log 2(-5).( )2.已知a >0且a ≠1,则log a 2+log a 12=( )A .0B .12C .1D .23.计算log 510-log 52等于( ) A .log 58 B .lg 5 C .1D .24.(1)lg 10=__________;(2)已知ln a =0.2,则ln ea =__________.5.log 35·log 56·log 69=________. 讲练互动探究点1 对数运算性质的应用 例1 计算下列各式: (1)log 5325; (2)log 2(32×42);(3)log 535-2log 573+log 57-log 595;(4)lg 25+23lg 8+lg 5·lg 20+(lg 2)2.规律方法对数式化简与求值的基本原则和方法(1)基本原则对数式的化简求值一般是正用或逆用公式,对真数进行处理,选哪种策略化简,取决于问题的实际情况,一般本着便于真数化简的原则进行. (2)两种常用的方法①“收”,将同底的两对数的和(差)收成积(商)的对数;②“拆”,将积(商)的对数拆成同底的两对数的和(差). 跟踪训练 计算下列各式的值: (1)lg 5100; (2)log 345-log 35; (3)(lg 5)2+2lg 2-(lg 2)2; (4)lg 3+25lg 9+35lg 27-lg 3lg 81-lg 27.探究点2 换底公式的应用 例2 计算:(1)log 29·log 34;(2)log 52×log 79log 513×log 734.反思反馈利用换底公式求值的思想与注意点跟踪训练1.log 916·log 881的值为( ) A .18B .118C .83D .382.1log 1419+1log 1513=________. 3.计算:(log 2125+log 425+log 85)·(log 52+log 254+log 1258).探究点3 对数运算中的综合问题例3 已知log 189=a ,18b =5,求log 3645(用a ,b 表示). 互动探究1.(变问法)若本例条件不变,如何求log 1845(用a ,b 表示)?2.(变条件)若将本例条件“log 189=a ,18b =5”改为“log 94=a ,9b =5”,则又如何求解呢? 规律方法解对数综合应用问题的3种方法(1)统一化:所求为对数式,条件转为对数式. (2)选底数:针对具体问题,选择恰当的底数.(3)会结合:学会换底公式与对数运算法则结合使用. 跟踪训练1.已知log 142=a ,用a 表示log 27.2.已知2x =3y =a ,若1x +1y=2,求a 的值.达标反馈1.log 242+log 243+log 244=( ) A .1 B .2 C .24D.122.若a >0,a ≠1,x >y >0,n ∈N *,则下列各式: (1)(log a x )n =n log a x ; (2)(log a x )n =log a x n ; (3)log a x =-log a 1x ;(4)nlog a x =1n log a x ;(5)log a x n =log a n x .其中正确的有( ) A .2个 B .3个 C .4个D .5个 3.计算log 219·log 3125·log 514=( )A .8B .6C .-8D .-6 4.已知a 2=1681(a >0),则log 23a =________.5.计算下列各式的值. (1)3log 72-log 79+2log 7⎝⎛⎭⎫322; (2)lg 2+lg 5-lg 8lg 50-lg 40.巩固提升 A 基础达标1.化简12log 612-2log 62的结果为( )A .62B .122C .log 63D .122.若lg x -lg y =t ,则lg ⎝⎛⎭⎫x 23-lg ⎝⎛⎭⎫y 23=( ) A .3t B .32tC .tD .t 23.设log 34·log 48·log 8m =log 416,则m 的值为( ) A .12B .9C .18D .27 4.如果lg x =lg a +3lg b -5lg c ,那么( ) A .x =ab 3c 5B .x =3ab5cC .x =a +3b -5cD .x =a +b 3-c 3 5.已知2x =3,log 483=y ,则x +2y 等于( )A .3B .8C .4D .log 48 6.log 48-log 193=________.7.已知m >0,且10x =lg(10m )+lg 1m ,则x =________.8.若lg x +lg y =2lg(x -2y ),则xy =__________.9.用lg x ,lg y ,lg z 表示下列各式: (1)lg(xyz );(2)lg xy 2z ;(3)lg xy 3z .10.计算下列各式的值: (1)log 3(813);(2)2lg (lg a 100)2+lg (lg a );(3)log 6112-2log 63+13log 627.B 能力提升11.根据有关资料,围棋状态空间复杂度的上限M 约为3361,而可观测宇宙中普通物质的原子总数N 约为1080.则下列各数中与MN 最接近的是( )(参考数据:lg 3≈0.48)A .1033B .1053C .1073D .109312.设a =log 2m ,b =log 5m ,且1a +1b =1,则m =________.13.计算下列各式的值:(1)log 535+2log 122-log 5150-log 514.(2)[(1-log 63)2+log 62·log 618]÷log 64.14.若a ,b 是方程2(lg x )2-lg x 4+1=0的两个实根,求lg(ab )·(log a b +log b a )的值.C 拓展探究15.已知2y ·log y 4-2y -1=0,log x 5x ·log 5x =-1,试问是否存在一个正数P ,使得P =1x -y ?参考答案新知初探1.(1)log a M +log a N (2)log a M -log a N (3)n log a M 2.log c b log c a自我检测1.【答案】(1)√ (2)× (3)×2.【答案】A4.【答案】(1)12 (2)0.85.【答案】2【解析】log 35·log 56·log 69=lg 5lg 3·lg 6lg 5·lg 9lg 6=lg 9lg 3=2lg 3lg 3=2. 讲练互动探究点1 对数运算性质的应用 例1 解:(1)原式=13log 525=13log 552=23.(2)原式=log 232+log 242=5+4=9.(3)原式=log 5(5×7)-2(log 57-log 53)+log 57-log 595=log 55+log 57-2log 57+2log 53+log 57-2log 53+log 55=2log 55=2.(4)原式=2lg 5+2lg 2+(1-lg 2)(1+lg 2)+(lg 2)2=2(lg 5+lg 2)+1-(lg 2)2+(lg 2)2=2+1=3.跟踪训练 解:(1)原式=lg 10015=15lg 100=15×2=25.(2)原式=log 3455=log 39=log 332=2.(3)原式=(lg 5+lg 2)(lg 5-lg 2)+2lg 2=lg 10(lg 5-lg 2)+2lg 2=lg 5-lg 2+2lg 2=lg 5+lg 2=1.(4)原式=lg 3+45lg 3+910lg 3-12lg 34lg 3-3lg 3=⎝⎛⎭⎫1+45+910-12lg 3(4-3)lg 3=115.探究点2 换底公式的应用 例2 解:(1)由换底公式可得, log 29·log 34=lg 9lg 2·lg 4lg 3=2lg 3lg 2·2lg 2lg 3=4.(2)原式=log 52log 513×log 79log 734=log 132×log 349=lg 2lg 13×lg 9lg 413=12lg 2-lg 3×2lg 323lg 2=-32.跟踪训练【解析】原式=log 3224·log 2334=2log 32·43log 23=83.2.【答案】log 310【解析】1log 1419+1log 1513=lg 14lg 19+lg 15lg13=-2lg 2-2lg 3+-lg 5-lg 3=lg 2lg 3+lg 5lg 3=1lg 3=log 310.3.解:法一:原式=⎝⎛⎭⎫log 253+log 225log 24+log 25log 28(log 52+log 54log 525+log 58log 5125) =⎝⎛⎭⎫3log 25+2log 252log 22+log 253log 22(log 52+2log 522log 55+3log 523log 55) =⎝⎛⎭⎫3+1+13log 25·(3log 52)=13log 25·log 22log 25=13. 法二:原式=⎝⎛⎭⎫lg 125lg 2+lg 25lg 4+lg 5lg 8(lg 2lg 5+lg 4lg 25+lg 8lg 125) =⎝⎛⎭⎫3lg 5lg 2+2lg 52lg 2+lg 53lg 2(lg 2lg 5+2lg 22lg 5+3lg 23lg 5) =⎝⎛⎭⎫13lg 53lg 2⎝⎛⎭⎫3lg 2lg 5=13.探究点3 对数运算中的综合问题 例3 解:因为18b =5,所以b =log 185. 所以log 3645=log 1845log 1836=log 18(5×9)log 18(2×18)=log 185+log 189log 182+log 1818=a +b 1+log 182 =a +b 1+log 18189=a +b 2-log 189=a +b 2-a.互动探究1.解:因为18b =5,所以log 185=b ,所以log 1845=log 189+log 185=a +b . 2.解:因为9b =5,所以log 95=b . 所以log 36 45=log 945log 936=log 9(5×9)log 9(4×9)=log 95+log 99log 94+log 99=b +1a +1. 跟踪训练1.解:因为log 142=a ,所以log 214=1a .所以1+log 27=1a .所以log 27=1a-1.由对数换底公式,得log 27=log 27log 22=log 272. 所以log 27=2log 27=2⎝⎛⎭⎫1a -1=2(1-a )a. 2.解:因为2x =3y =a ,所以x =log 2a ,y =log 3a ,所以1x +1y =1log 2a +1log 3a=log a 2+log a 3=log a 6=2,所以a 2=6,解得a =± 6.又因为a >0,所以a = 6.达标反馈1.l 【答案】A【解析】log 242+log 243+log 244=log 24(2×3×4)=log 2424=1.2.【答案】A【解析】根据对数的运算性质log a M n =n log a M (M >0,a >0,且a ≠1)知(3)与(5)正确.3.【答案】C【解析】log 219·log 3125·log 514=log 23-2·log 35-2·log 52-2=-8log 23·log 35·log 52=-8. 4.【答案】2【解析】由a 2=1681(a >0)得a =49, 所以log 2349=log 23⎝⎛⎭⎫232=2. 5.解:(1)原式=log 723-log 79+log 7⎝⎛⎭⎫3222=log 789+log 798=log 7⎝⎛⎭⎫89×98=log 71=0. (2)原式=lg 2×58lg 5040=lg 54lg 54=1. 巩固提升A 基础达标 1.【答案】C【解析】原式=log 612-log 62=log 6122=log 6 3.2.【答案】A【解析】lg ⎝⎛⎭⎫x 23-lg ⎝⎛⎭⎫y 23=3lg x 2-3lg y 2=3lg x y=3(lg x -lg y )=3t . 3.【答案】B【解析】由题意得lg 4lg 3·lg 8lg 4·lg m lg 8=log 416=log 442=2,所以lg m lg 3=2, 即lg m =2lg 3=lg 9.所以m =9,选B.4.【答案】A【解析】因为lg x =lg a +3lg b -5lg c =lg a +lg b 3-lg c 5=lg ab 3c 5,所以x =ab 3c 5. 5.【答案】A【解析】因为2x =3,所以x =log 23.又log 483=y , 所以x +2y =log 23+2log 483=log 23+2(log 48-log 43)=log 23+2⎝⎛⎭⎫32log 22-12log 23 =log 23+3-log 23=3.故选A.6.【答案】2【解析】log 48=log 2223=32, log 193=-12, 所以原式=32-⎝⎛⎭⎫-12=2. 7.【答案】0【解析】lg(10m )+lg 1m =lg 10+lg m +lg 1m=1, 所以10x =1=100,所以x =0.8.【答案】4【解析】因为lg x +lg y =2lg(x -2y ),所以⎩⎪⎨⎪⎧x >0,y >0,x -2y >0,xy =(x -2y )2.由xy =(x -2y )2,知x 2-5xy +4y 2=0,所以x =y 或x =4y .又x >0,y >0且x -2y >0,所以舍去x =y ,故x =4y ,则x y=4. 9.解:(1)lg(xyz )=lg x +lg y +lg z .(2)lg xy 2z=lg(xy 2)-lg z =lg x +2lg y -lg z . (3)lg xy 3z=lg(xy 3)-lg z =lg x +3lg y -12lg z . 10.解:(1)原式=log 381+log 33=log 334+log 3312=4+12=92. (2)原式=2lg (100lg a )2+lg (lg a )=2[lg 100+lg (lg a )]2+lg (lg a )=2[2+lg (lg a )]2+lg (lg a )=2. (3)法一:原式=-log 6(22×3)-2log 63+13log 633 =-(log 622+log 63)-2log 63+log 63=-(2log 62+log 63)-2log 63+log 63=-2(log 62+log 63)=-2log 6(2×3)=-2.法二:原式=log 6112-log 632+log 62713 =log 6312×9=log 6136=log 66-2=-2. B 能力提升11.【答案】D【解析】因为lg 3361=361×lg 3≈361×0.48≈173,所以M ≈10173,则M N ≈101731080=1093,故选D. 12.【答案】10【解析】因为a =log 2m ,b =log 5m ,所以1a =1log 2m =log m 2,1b =1log 5m =log m 5,因为1a +1b=1,所以log m 2+log m 5=log m 10=1,所以m =10.13.解:(1)原式=log 535+log 550-log 514+2log 12212=log 535×5014+log 122=log 553-1=2. (2)原式=[(log 66-log 63)2+log 62·log 6(2×32)]÷log 64=⎣⎢⎡⎦⎥⎤⎝⎛⎭⎫log 6632+log 62·(log 62+log 632)÷log 622=[(log 62)2+(log 62)2+2log 62·log 63]÷2log 62=log 62+log 63=log 6(2×3)=1.14.解:原方程可化为2(lg x )2-4lg x +1=0,设t =lg x ,则原方程可化为2t 2-4t +1=0.所以t 1+t 2=2,t 1t 2=12.由已知a ,b 是原方程的两个根, 则t 1=lg a ,t 2=lg b ,即lg a +lg b =2,lg a ·lg b =12, 所以lg(ab )·(log a b +log b a )=(lg a +lg b )⎝⎛⎭⎫lg b lg a +lg a lg b=(lg a +lg b )[(lg b )2+(lg a )2]lg a lg b=(lg a +lg b )·(lg b +lg a )2-2lg a lg b lg a lg b=2×22-2×1212=12. 即lg(ab )·(log a b +log b a )=12.C 拓展探究15.解:由2y ·log y 4-2y -1=0得2y ⎝⎛⎭⎫log y 4-12=0,所以log y 4=12,即y =16. 由log x 5x ·log 5x =-1得log x 5x =-1log 5x ,则log x 5x =-log x 5>0. 12(log x 5+1)=(-log x 5)2,整理得2(log x 5)2-log x 5-1=0,解得log x 5=-12(log x 5=1舍去), 所以1x=25. 所以P =1x -y =25-16=3, 即存在一个正数P =3,使得P =1x -y 成立.。

指数与对数的运算总结

指数与对数的运算总结指数和对数是数学中的重要概念,它们在各个领域中都有广泛的应用。

通过对指数和对数的运算规则的学习和掌握,我们可以更好地理解和解决实际问题。

本文将总结指数和对数的运算规则,并通过例子来说明其应用。

一、指数的运算规则指数运算是指以某个数为底数,用整数表示的运算。

以下是指数运算的几个重要规则:1.指数和底数相等时,结果为1当指数和底数相等时,即a^a,结果为1。

例如:2^2 = 42.指数相同,底数相乘当指数相同时,底数相乘。

例如:2^3 × 3^3 = (2 × 3)^3 = 6^3 = 2163.指数相同,底数相除当指数相同时,底数相除。

例如:8^2 ÷ 4^2 = (8 ÷ 4)^2 = 2^2 = 44.指数相加,底数不变当指数相加时,底数不变。

例如:6^2 × 6^3 = 6^(2 + 3) = 6^5 = 77765.指数相减,底数不变当指数相减时,底数不变。

例如:25^3 ÷ 25^2 = 25^(3 - 2) = 25^1 = 25二、对数的运算规则对数是指底数的几次方等于一个数的运算,常用的对数有以10为底的常用对数和以e为底的自然对数。

以下是对数运算的几个重要规则:1.乘法转换成加法对数的乘法可以转换成对数的加法。

例如:log(a × b) = log(a) + log(b)2.除法转换成减法对数的除法可以转换成对数的减法。

例如:log(a ÷ b) = log(a) - log(b)3.指数转换成乘法对数中的指数可以转换成乘法。

例如:log(a^b) = b × log(a)4.对数运算与指数运算相反对数运算与指数运算相反。

例如:log(a^b) = b × log(a) 等价于 a^b = 10^(b × log(a))三、指数和对数的应用指数和对数在实际问题中有广泛的应用。

数字的正负数乘除法运算

数字的正负数乘除法运算在数学中,我们经常会遇到对数字进行正负数乘除法运算的情况。

正负数的乘除法运算有一些特殊的规则和性质,掌握了这些规则和性质,我们可以更加轻松地解决相关的问题。

本文将介绍正负数乘除法运算的基本规则和性质,并通过实例来说明如何进行这些运算。

1. 正负数的乘法运算正负数相乘的结果有以下几种情况:- 两个正数相乘,结果仍为正数。

- 两个负数相乘,结果仍为正数。

- 一个正数和一个负数相乘,结果为负数。

举例来说,如果我们要计算 3 × (-2),我们可以使用以下步骤:- 取绝对值相乘:3 × 2 = 6- 再确定符号:一个正数和一个负数相乘,结果为负数,所以最终结果为 -6。

通过上述步骤,我们可以得出:3 × (-2) = -6。

2. 正负数的除法运算正负数相除的结果也有一些规律:- 两个正数相除,结果仍为正数。

- 两个负数相除,结果仍为正数。

- 一个正数和一个负数相除,结果为负数。

比如,我们要计算 (-8) ÷ 4,可以按照以下步骤进行:- 取绝对值相除:8 ÷ 4 = 2- 根据符号规则,一个正数和一个负数相除,结果为负数,所以最终结果为 -2。

综上所述,(-8) ÷ 4 = -2。

3. 符号的运算顺序当对多个数进行乘法和除法运算时,符号的运算顺序也是需要注意的。

正负数的乘除法运算优先级高于加减法运算。

举例来说,如果我们要计算 -5 + 3 × 2,可以按照以下步骤进行:- 先进行乘法运算:3 × 2 = 6- 再进行加法运算:-5 + 6 = 1所以,-5 + 3 × 2 = 1。

4. 括号的运用括号在数学运算中起到分组和优先级控制的作用。

使用括号可以改变计算的顺序和结果。

比如,我们要计算 2 × (-3 + 4),可以按照以下步骤进行:- 先进行括号内的加法运算:(-3 + 4) = 1- 再进行乘法运算:2 × 1 = 2所以,2 × (-3 + 4) = 2。

指数与对数的运算法则

指数与对数的运算法则一、指数的运算法则在数学中,指数是一种表示乘法的简便方式,用于表示以某个数为底的乘方。

指数的运算法则是指在进行指数运算时遵循的规则和原则。

1. 相同底数相乘,指数相加当两个相同底数的指数相乘时,其结果为底数不变,指数相加的乘方。

例如,若a和b为任意实数,且n和m为任意整数,则有:a^n * a^m = a^(n+m)2. 相同底数相除,指数相减当两个相同底数的指数相除时,其结果为底数不变,指数相减的乘方。

例如,若a和b为任意实数,且n和m为任意整数,则有:a^n / a^m = a^(n-m)3. 指数与指数相乘,底数不变,指数相乘当两个指数相乘时,其结果为底数不变,指数相乘的乘方。

例如,若a为任意实数,且n和m为任意整数,则有:(a^n)^m = a^(n*m)4. 乘方的乘方,底数不变,指数相乘当一个乘方再次乘方时,其结果为底数不变,指数相乘的乘方。

例如,若a为任意实数,且n和m为任意整数,则有:(a^n)^m = a^(n*m)这些法则可以用于简化指数的复杂运算,使计算更加简便和高效。

二、对数的运算法则对数是指数的逆运算,用于求解指数方程。

对数的运算法则是指在进行对数运算时遵循的规则和原则。

1. 对数的定义对数的定义是:若幂等于a,则称b为以底数为a的对数,记作logₐb。

其中,a为底数,b为真数。

2. 对数的乘法法则当进行对数乘法运算时,即求两个数的乘积的对数,其结果等于两个数的对数相加。

即:logₐ(a*b) = logₐa + logₐb3. 对数的除法法则当进行对数除法运算时,即求两个数的比值的对数,其结果等于两个数的对数相减。

即:logₐ(a/b) = logₐa - logₐb4. 对数的幂法法则当进行对数幂运算时,即对一个数求幂的对数,其结果等于幂乘以对数。

即:logₐ(a^m) = m * logₐa这些法则可以用于简化对数的复杂运算,使计算更加简便和高效。

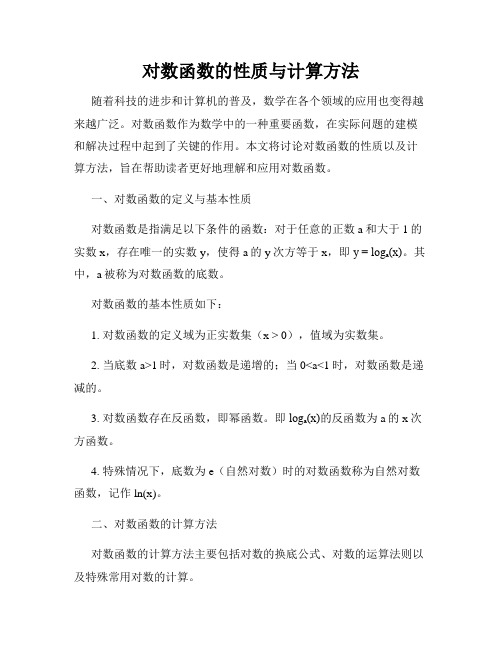

对数函数的性质与计算方法

对数函数的性质与计算方法随着科技的进步和计算机的普及,数学在各个领域的应用也变得越来越广泛。

对数函数作为数学中的一种重要函数,在实际问题的建模和解决过程中起到了关键的作用。

本文将讨论对数函数的性质以及计算方法,旨在帮助读者更好地理解和应用对数函数。

一、对数函数的定义与基本性质对数函数是指满足以下条件的函数:对于任意的正数a和大于1的实数x,存在唯一的实数y,使得a的y次方等于x,即y = logₐ(x)。

其中,a被称为对数函数的底数。

对数函数的基本性质如下:1. 对数函数的定义域为正实数集(x > 0),值域为实数集。

2. 当底数a>1时,对数函数是递增的;当0<a<1时,对数函数是递减的。

3. 对数函数存在反函数,即幂函数。

即logₐ(x)的反函数为a的x次方函数。

4. 特殊情况下,底数为e(自然对数)时的对数函数称为自然对数函数,记作ln(x)。

二、对数函数的计算方法对数函数的计算方法主要包括对数的换底公式、对数的运算法则以及特殊常用对数的计算。

1. 换底公式对于任意底数a、b和正实数x,换底公式表达为:logₐ(x) = log_b(x) / log_b(a)利用换底公式,可以将对数函数的底数转化为常见的底数,从而简化计算过程。

2. 对数的运算法则(1)对数的乘法法则:logₐ(x·y) = logₐ(x) + logₐ(y)(2)对数的除法法则:logₐ(x/y) = logₐ(x) - logₐ(y)(3)对数的幂法法则:logₐ(x^m) = m·logₐ(x)(4)对数的换底法则(已在前文提及)通过运用对数的运算法则,可以对对数函数进行合并、拆分和化简,使得计算更加灵活和高效。

3. 特殊常用对数的计算(1)10为底的常用对数:log₁₀(x)常用记作log(x),表示10的几次方等于x。

在计算过程中,可以直接利用计算器或者查表得到对应的数值。

数学中的指数与对数定律

数学中的指数与对数定律数学中的指数与对数是一对重要的概念,它们在解决各种数值问题时起着极其重要的作用。

指数和对数之间有一系列的定律和性质,它们帮助我们简化计算,解决复杂的数学问题。

本文将介绍数学中的指数与对数定律。

一、指数定律指数是表示一个数要连乘几次的简写形式。

在数学中,我们常用字母n表示指数。

例如,2的n次方可以写作2^n,读作“2的n次方”或“2的指数n”。

1. 乘法法则:对于相同的底数,指数相加。

例如,a^m * a^n = a^(m+n)。

这个规则表明,在进行乘法运算时,指数相加,底数保持不变。

2. 除法法则:对于相同的底数,指数相减。

例如,a^m / a^n = a^(m-n)。

这个规则表明,在进行除法运算时,指数相减,底数保持不变。

3. 幂法法则:对导数运算和求幂运算的结果进行指数运算。

例如,(a^m)^n =a^(m*n)。

这个规则表明,在进行幂运算时,将指数相乘。

二、对数定律对数是指用某个数的幂来表示另一个数的运算。

对数在解决指数运算中的未知数问题时非常有用。

通常,我们用log表示对数运算。

1. 对数定义:对于一个正数x和一个底数a(a>0且a≠1),x=loga(b)定义为a的多少次幂等于b。

例如,log2(8)等于3,表示2的3次方等于8。

2. 对数换底公式:对于不同的底数,我们可以通过换底公式将其转化为同一底数的对数。

换底公式为loga(b) = logc(b) / logc(a),其中c为一个正数。

3. 对数乘法法则:loga(b * c) = loga(b) + loga(c)。

这个规则表明,在进行乘法运算时,对数相加。

4. 对数除法法则:loga(b / c) = loga(b) - loga(c)。

这个规则表明,在进行除法运算时,对数相减。

5. 对数幂法法则:loga(b^m) = m * loga(b)。

这个规则表明,在进行幂运算时,对数乘以幂指数。

三、应用举例指数与对数定律在各个数学领域都有广泛的应用。

对数的运算

1 a

b=-logab.

[典例 2] (1)计算(log2125+log425+log85)·(log52+log254+log1258)的值; (2)已知 log189=a,18b=5,用 a,b 表示 log3645 的值.

[解] (1)法一:原式=log253+lloogg22245+lloogg2258· log52+lloogg55245+lologg515825 =3log25+22lloogg2225+3lloogg2252log52+22lloogg5525+33lloogg5525 =3+1+13log25·(3log52) =13log25·lloogg2225=13.

答案:1

C.6

D.1

()

知识点二 换底公式 (一)教材梳理填空

logcb logab= logca

对数换底公式.

(a>0,且a≠1;b>0;c>0,且c≠1).我们把上式叫做

[微思考] 换底公式中底数c是特定数还是任意数?

提示:是大于0且不等于1的任意数.

(二)基本知能小试

1.判断正误:

(1)由换底公式可得 logab=lloogg- -22ba.

()

(2)log2M+log3N=log6(MN).

()

(3)log23·log32=1.

()

答案:(1)× (2)× (3)√

2.填空:

(1)logab·logba=________;

(2)logab·logbx=________;

(3)logamNn=________.

答案:(1)1

(2)logax

log(c+b)a+log(c-b)a=2log(c+b)a·log(c-b)a.

使用查表法 实现log 对数运算的步骤

一、概述在数学和计算机领域中,对数运算是一种常见且重要的运算方式。

对数运算可以帮助我们简化复杂的计算过程,使得数值计算更加高效准确。

在实际的计算过程中,我们常常需要对数函数进行计算,而查表法便是一种有效实现对数运算的方式之一。

二、对数运算的概念1. 对数运算是指以某个数为底数,使得该底数的几次方等于目标数。

以 2 为底数,2 的几次方等于 8,则可以得出 2 的对数等于 3。

对数运算的数学表达式为 loga x = b,其中 a 为底数,x 为目标数,b 为对数。

2. 对数运算可以转化为指数运算,即 loga x = b 可以转化为 a^b = x。

三、查表法实现对数运算的步骤1. 确定对数的底数和目标数在进行对数运算之前,首先需要确定对数的底数和目标数。

底数通常为常数,而目标数则为需要进行对数运算的数值,可以是实数或复数。

2. 准备对数表对数表是存储不同底数和目标数对应的对数值的表格。

对数表可以通过数学软件或者书籍进行查询或者生成。

通常,对数表的列标包括底数、目标数和对数值。

3. 查找对数值根据确定的底数和目标数,在对数表中查找对应的对数值。

首先找到目标数所在的行,然后在该行中找到对应的底数列,即可得到对数值。

4. 结果验证查表法得到的对数值可以通过反向运算进行验证。

即将底数的对应次方值计算出来,检查是否等于目标数。

如果结果相符,则说明查表法得到的对数值是正确的。

四、查表法实现对数运算的优缺点1. 优点(1)简单易行:查表法不需要进行复杂的数学计算,只需要在对数表中进行查找即可得到对数值。

(2)节省时间:对数表包含了大量常见对数值的对应关系,可以大大节省对数运算的时间。

(3)准确性高:对数表经过验证和整理,所得到的对数值通常准确无误。

2. 缺点(1)受限于对数表:查表法实现对数运算的前提是需要有相应的对数表,受限于已有的对数表内容。

(2)对数精度限制:对数表中的对数值通常是有限精度的,可能无法满足特定精度要求的对数计算。

初中数学复习如何简化指数和对数函数的运算

初中数学复习如何简化指数和对数函数的运算指数和对数函数是初中数学中重要的知识点之一,掌握其运算方法对于数学学习的深入和应用非常关键。

本文将从简化指数运算和简化对数运算两个方面进行论述,帮助同学们更好地理解和掌握这两个运算过程。

一、简化指数运算指数运算是通过幂运算来简化复杂的数学表达式。

在简化指数运算时,我们需要牢记以下两个基本规律:1. 乘幂法则:对于相同的底数,指数相加等于将底数乘积的指数。

例如,对于a的m次方乘以a的n次方,可以简化为a的m+n次方。

2. 除幂法则:对于相同的底数,指数相减等于将底数除以指数的差。

例如,对于a的m次方除以a的n次方,可以简化为a的m-n次方。

在运用这两个基本规律时,应注意与数的运算法则相结合,同时要进行合理的拆分和整合。

下面以具体的例子来说明简化指数运算的过程。

例1:简化指数运算将5的2次方乘以5的4次方除以5的3次方。

解析:我们可以利用乘幂法则和除幂法则将该运算式简化为以下形式:5^(2+4-3) = 5^3 = 125简化后的结果为125。

例2:简化指数运算将3的4次方的平方除以3的2次方。

解析:我们可以利用乘幂法则和除幂法则将该运算式简化为以下形式:(3^4)^2 / 3^2 = 3^(4×2-2) = 3^6 = 729简化后的结果为729。

通过上述例子,我们可以看到,在简化指数运算中,我们需要熟练掌握乘幂法则和除幂法则,并结合其它数的运算法则进行综合运算。

熟练运用这些规则可以极大地简化指数运算的过程,提高运算效率。

二、简化对数运算对数函数是指数函数的逆运算,是一种特殊的函数关系。

在简化对数运算时,我们主要需要掌握以下两个基本规律:1. 对数幂法:对于底数为a的对数,其幂运算为a的指数。

例如,对于以2为底的对数log2x,其幂运算为2的x次方等于x。

2. 对数乘除法:对于相同底数的对数,乘法运算等于指数相加,除法运算等于指数相减。

例如,对于以2为底的对数,log2(x×y) = log2x + log2y,log2(x/y) = log2x - log2y。

对数法的知识点总结

对数法的知识点总结一、对数的定义对数是指数运算的倒数。

通常来说,对数是一个数对应的指数。

比如,log2(8) = 3,表示2的多少次方等于8。

在这里,log2表示以2为底的对数,8是对数的真数,3是对数的值。

对数的底数必须大于0且不等于1,对数的真数必须大于0。

对数常用符号log来表示,底数和真数用括号括起来。

对数的定义是指数的一个有用的补充。

指数表示一个数重复相乘的次数,而对数表示一个数重复乘积的次数。

例如,2的3次方等于8,那么log2(8) = 3。

可以看出,对数和指数是互相对立的,通过对数可以方便地解决指数运算不易解决的问题。

二、对数的性质对数有一些重要的性质,比如乘法性质、除法性质、幂次性质和换底性质等。

这些性质是对数运算的基础,也是对数问题的解决关键。

1. 乘法性质:loga(m*n) = loga(m) + loga(n),其中a > 0且a ≠ 1,m和n都是大于0的实数。

这个性质表示两个数的乘积的对数等于这两个数的对数之和。

2. 除法性质:loga(m/n) = loga(m) - loga(n),其中a > 0且a ≠ 1,m和n都是大于0的实数。

这个性质表示两个数的商的对数等于这两个数的对数之差。

3. 幂次性质:loga(m^p) = p * loga(m),其中a > 0且a ≠ 1,m是大于0的实数,p是任意实数。

这个性质表示一个数的幂次的对数等于这个数的对数乘以幂次。

4. 换底性质:loga(b) = logc(b) / logc(a),其中a、b、c都是大于0且不等于1的实数。

这个性质表示底数不同的对数可以相互换底,该性质在解决对数问题时非常有用。

这些性质对于解决对数问题非常重要,可以大大简化对数的运算和求解。

三、对数的运算规则对数的运算规则是指对数的加减乘除和幂次运算法则,它们是对数运算的基础,可以帮助我们解决各种对数问题。

1. 加减法规则:对数的加减法规则是乘法性质和除法性质的直接应用。

log加减法运算法则

log加减法运算法则

log加减法运算法则指的是对于两个实数a和b,以及底数为c的对数函数,

log(ac)与log(bc)的和或者差,可以化简为log函数里面的乘积或者商。

具体来说,

如果需要计算log(ac) + log(bc),则可以将其化简为log(abc),而如果需要计算

log(ac) - log(bc),则可以化简为log(a/b)。

这个法则可以用来简化复杂的对数运算。

需要注意的是,这个法则只适用于同一底数的对数函数之间的加减运算,如果底数不同,则需要先使用换底公式将其转化为同一底数的对数函数,再使用log加减法运算法则进行化简。

此外,还需要注意对数函数的定义域和值域,以及底数的取值范围。

对于定义在正实数集合上的对数函数,其定义域为正实数集合,值域为实数集合;而对于以其他数为底的对数函数,其定义域和值域的范围可能有所不同。

底数的取值范围也需要根据具体情况来确定。

总之,log加减法运算法则是对数运算中的一个重要的化简法则,可以用来简

化复杂的对数运算,但需要注意对数函数的定义域和值域以及底数的取值范围。

对数公式的运算

对数公式的运用1.对数的概念如果a(a>0,且a≠1)的b次幂等于N,即a b=N,那么数b叫做以a为底N的对数,记作:log a N=b,其中a叫做对数的底数,N叫做真数.由定义知:①负数和零没有对数;②a>0且a≠1,N>0;③log a1=0,log a a=1,a logaN=N(对数恒等式),log a a b=b。

特别地,以10为底的对数叫常用对数,记作log10N,简记为lgN;以无理数e(e=2.718 28…)为底的对数叫做自然对数,记作log e N,简记为lnN.2.对数式与指数式的互化式子名称a b=N指数式a b=N(底数)(指数)(幂值)对数式log a N=b(底数) (真数) (对数)3.对数的运算性质如果a>0,a≠1,M>0,N>0,那么(1)log a(MN)=log a M+log a N.(2)log a(M/N)=log a M-log a N.(3)log a M n=nlog a M(n∈R).问:①公式中为什么要加条件a>0,a≠1,M>0,N>0?②log a a n=? (n∈R)③对数式与指数式的比较.(学生填表)式子a b=N,log a N=b名称:a—幂的底数b—N—a—对数的底数b—N—运算性质:a m·a n=a m+na m÷a n= a m-n(a>0且a≠1,n∈R) log a MN=log a M+log a Nlog a MN=log a M n= (n∈R) (a>0,a≠1,M>0,N>0)难点疑点突破对数定义中,为什么要规定a>0,,且a≠1?理由如下:①a<0,则N的某些值不存在,例如log-28=?②若a=0,则N≠0时b不存在;N=0时b不惟一,可以为任何正数?③若a=1时,则N≠1时b不存在;N=1时b也不惟一,可以为任何正数?为了避免上述各种情况,所以规定对数式的底是一个不等于1的正数?解题方法技巧1.(1)将下列指数式写成对数式:①54=625;②26=64;③3x=27;④13m=5.73.(2)将下列对数式写成指数式:①log216=4;②log2128=7;③log327=x;④lg0.01=-2;⑤ln10=2.303;⑥lgπ=k.解析由对数定义:a b=N,log a N=b.解答(1)①log5625=4.②log264=6.③log327=x.④log135.73=m.解题方法指数式与对数式的互化,必须并且只需紧紧抓住对数的定义:a b=N log a N=b(2)①24=16,②27=128,③3x=27,④10-2=0.01,⑤e2.303=10,⑥10k=π.2.根据下列条件分别求x的值:(1)log8x= -2/3;(2)log2(log5x)=0;(3)log x27=3×;(4)log x(2+)= -1.解析(1)对数式化指数式,得:x==?(2)log5x=20=1.x=?(3)3×3log32=? .27=x?(4) 2+=x-1=1/x.x=?解答(1)x===2-2=1/4.(2)log5x=20=1,x=51=5.(3)log x27=3×=3×2=6,∴x6=27=33=()6,故x=.(4) +=x-1=1/x,∴x=1/(+)=.解题技巧①转化的思想是一个重要的数学思想,对数式与指数式有着密切的关系,在解决有关问题时,经常进行着两种形式的相互转化.②熟练应用公式:log a1=0,log a a=1,alog a M=M,log a a n=n.3.已知log a x=4,log a y=5,求A=〔x5/12·y-1/3〕的值.解析:思路一,已知对数式的值,要求指数式的值,可将对数式转化为指数式,再利用指数式的运算求值;思路二,对指数式的两边取同底的对数,再利用对数式的运算求值?解答:解法一∵log a x=4,log a y=5,∴x=a4,y=a5,∴A=x(5/12)y(-1/3)=(a4)5/12(a5)-1/3=a5/3·a-5/3=a0=1.解法二对所求指数式两边取以a为底的对数得log a A=log a(x(5/12)y(-1/3))=(5/12)log a x-(1/3)log a y=(5/12)×4-(1/3)×5=0,∴A=1.解题技巧有时对数运算比指数运算来得方便,因此以指数形式出现的式子,可利用取对数的方法,把指数运算转化为对数运算.4 .设x,y均为正数,且x·y1+lgx=1(x≠1/10),求lg(xy)的取值范围.解析一个等式中含两个变量x、y,对每一个确定的正数x由等式都有惟一的正数y与之对应,故y是x的函数,从而lg(xy)也是x的函数.因此求lg(xy)的取值范围实际上是一个求函数值域的问题,怎样才能建立这种函数关系呢?能否对已知的等式两边也取对数?解答∵x>0,y>0,x·y1+lgx=1,两边取对数得:lgx+(1+lgx)lgy=0.即lgy=-lgx/(1+lgx) (x≠1/10,lgx≠-1).令lgx=t,则lgy=-t/(1+t) (t≠-1).∴lg(xy)=lgx+lgy=t-t/(1+t)= t2/(1+t) (t≠-1).(解题规律:对一个等式两边取对数是解决含有指数式和对数式问题的常用的有效方法;而变量替换可把较复杂问题转化为较简单的问题.)设S=t2/(1+t),得关于t的方程t2-St-S=0因为它一定有实数解.∴Δ=S2+4S≥0,得S≤-4或S≥0,故lg(xy)的取值范围是(-∞,-4〕∪〔0,+∞).5 .求值:(1)lg25+lg2·lg50+(lg2)2;(2)2log32-log3(32/9)+log38-52log53;(3)设lga+lgb=2lg(a-2b),求log2a-log2b的值;(4)求7lg20·(1/2)lg0.7的值.解析:(1)25=52,50=5×10。

指数与对数运算-高考复习

loga =__________

logaM-logaN

a>0,且 a≠1,M>0,N>0

nlogaM

logaMn=__________(n∈R)

换底公式

lo g

logab=lo g (a>0,且

a≠1;c>0,且 c≠1;b>0)

常用结论

1.lg 2+lg 5=1.

1

n

2.换底公式的变形:logab= ,logab·logbc·logcd=logad,lo b = logab.

(4)若是根式,应化为分数指数幂,尽可能用幂的形式表示并用幂的运算法

则解答.

考点二

对数的运算(多考向探究预测)

考向1 对数式的化简与计算

例 2(1)(2024·河南平顶山模拟)若 2lg(x-2y)=lg x+lg

A.4

B.1

1

或4

C.1 或 4

y

y,则 的值为(

1

D.4

D )

解析 (1)∵2lg(x-2y)=lg(x-2y)2=lg x+lg y=lg(xy),∴(x-2y)2=xy,

0.1

10

=

1

10

10

≈

1

1.259

≈0.8.

研考点

精准突破

考点一

指数幂的运算

1

例

2

16 -2

0.25 4

3

1(1)( ) +(-8) +8 ×

49

1

16 -2

解析 (1)(49)

2+

2

4

0.25

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

对数几率回归(Logistic Regression)分析与实践1 对数几率回归原理分析1.2?损失函数1.3 ?求最优解2 对数几率回归实践Logistic回归的一般过程Logistic回归的优缺点Logistic回归算法描述(改进的随机梯度下降)《机器学习实战》第五章代码解析5-1 Logistic回归梯度上升优化方法5-2 画出数据集和Logistic回归最佳拟合直线的函数5-3 随机梯度上升算法5-4 改进的随机梯度上升算法5-5 ?示例:从疝气病症预测病马的死亡率1 对数几率回归原理分析Logistic Regression,对数几率回归,又称逻辑斯谛回归。

该模型最初是用来解决0-1二分类问题,明明是分类问题,为何叫回归?科普一下,线性回归是找到一条直线或超平面尽可能地接近所有的训练数据点(就是用线性方程来拟合数据),而对数几率回归是找到一条直线或超平面尽可能地分开两种不同类别的数据点(就是在公式中的线性部分来做了回归)。

首先,我们要解决的问题是:在线性模型上做二分类(这里不讨论多分类)。

把问题转化为,让模型输出为0或者1,而且在分界处变化很陡。

直接想法是套一个函数来实现一个单位阶跃函数,如下: 也就是把?线性模型?看作为一个两种类别的分界线。

由于分段函数性质太差,不符合优化问题的目标函数要连续可微的特点。

所以我们找一个形似的函数(由下图可见),Sigmoid 函数(S型函数)中的杰出代表——对数几率函数(一个任意阶可导的凸函数,有良好的数学性质,很适合优化问题)。

将线性模型代入就得到总的模型其实,对数几率回归模型就是在拟合?线性模型,使得这条直线尽可能地将原始数据中的两个类别正确的划分开(引用张磊的知乎)。

1.2?损失函数解决机器学习问题就要明确损失函数,回归问题一般用均方误差(平均损失)或者其平均数——平均误差平方损失来作为损失函数(这就是最小二乘法,用来找到一条直线使所有样本到直线的欧式距离之和最小)。

平均误差平方损失公式如下:Logistic回归模型,要用到的是对数损失来作为损失函数先来看它的效果,再来说怎么得来的效果:真实值?是有 0-1 两种情况,而推测值由于借助对数几率函数,其输出是介于0~1之间连续概率值。

这个损失函数其实在每次计算时永远都只有一项在发挥作用,转换为分段函数如下:所以该损失函数可以达到这样的效果:当真实值?y为1时,输出值?y越接近1,则?L越小,当真实值?y为 0 时,输出值?y尖越接近于0,则?L越小。

由来:这与周志华《机器学习》的3.3节的对数几率回归模型最大化“对数似然”的似然项(详细过程看书P59)有着异曲同工之妙,可能存在某种联系吧。

1.3 ?求最优解对数几率函数作为高阶可导连续凸函数,根据凸优化理论,典型的数值优化算法如梯度下降算法,牛顿法等牛顿法的求法看周志华《机器学习》的P59~60。

下面我们用的是梯度下降算法(梯度上升同理,符号变为加号)来得到核心参数的更新方式:w看做是一个向量的话,迭代同样要加减一个向量,α是每次迭代的步长(大小),α后面的偏导表示的是迭代的方向,这种通过多次迭代能够使得函数收敛到局部最小值。

具体怎么得来的看张磊知乎梯度下降算法,写得很棒。

通过链式求导法则,(具体推导见张磊知乎梯度下降算法)最终迭代方式为(矩阵形式,也是接下来实践用到的公式,其实是通过一系列推导得来的):(归入了矩阵中)2 对数几率回归实践Logistic回归的一般过程(1)收集数据:采用任意方法收集数据。

(2)准备数据:由于需要进行距离计算,因此要求数据类型为数值型。

(有限)另外,结构化数据格式则最佳。

(3)分析数据:采用任意方法对数据进行分析。

(4)训练算法:大部分时间将用于训练,训练的目的是为了找到最佳的分类回归系数(5)测试算法:一旦训练完成,分类将会很快。

(6)使用算法:首先,我们需要输入一些数据,并将起转化成对应的结构化数值。

接着,基于训练好的回归系数既可以对这些数值进行简单的回归计算,在这之后,我们就可以在输出的类别上做一些其他分析工作。

Logistic回归的优缺点优点:计算代价不高,易于理解和实现。

缺点:容易欠拟合,分类精度可能不高。

Logistic回归算法描述(改进的随机梯度下降)输入:训练集?,是维样本向量,即?,是对应的分类标签学习率过程:由对数似然得到代价函数##下面采用梯度下降对代价函数进行迭代,迭代次(选择一个较大值,如500),得到最终的参数向量初始化为全1矩阵for all?do(这里采用随机选取样本来更新回归系数)动态调整从数据集中删除该样本(避免重复)util: 迭代了次(要到达达到局部最小的效果)输出:的最优解《机器学习实战》第五章代码解析5-1 Logistic回归梯度上升优化方法算法伪代码:每个回归系数初始化为1重复R次:计算整个数据集的梯度使用 alpha*gradient 更新回归系数的向量返回回归系数数据集特点:testSet.txt每行如下:?-0.017612 14.053064 0每个样本点包括两个特征值x,y坐标,和对应的分类标签(0或1)from numpy import *def loadDataSet(): # 加载数据集dataMat = [] # 创建数据列表labelMat = [] # 创建标签列表fr = open('testSet.txt') # 打开测试数据文件for line in fr.readlines(): # 读取文件每一行lineArr = line.strip().split() # 除去每一行的空格后拆分成列表,例如 ['0.317029', '14.739025', '0']dataMat.append([1.0, float(lineArr[0]), float(lineArr[1])]) # 增加子列表,[1.0,lineArr第一个元素(float),lineArr第二个元素(float)]return dataMat, labelMat # 返回数据列表,标签列表# 注:[1.0, float(lineArr[0]), float(lineArr[1])] 中的1.0 表示的是特征X0 的值,一般默认X0 = 1.0(or 1)def sigmoid(inX): # 定义sigmoid函数,同书P74return 1.0-(1+exp(-inX))def gradAscent(dataMatIn, classLabels): # 定义梯度上升函数dataMatrix = mat(dataMatIn) # 把数据列表转化成矩阵形式(列表和矩阵的简单差别:列表一般是一行,以逗号分隔,而矩阵是多行,没逗号)labelMat = mat(classLabels).transpose() # 把标签列表转化成矩阵形式,然后转置(行向量 - 列向量)m,n = shape(dataMatrix) # 取数据矩阵的行和列第一个是行数m=100,第二个是列数n=3alpha = 0.001 # 学习率初始化 = 0.001,步长为0.001maxCycles = 500 # 最大循环次数 = 500weights = ones((n,1)) # 权重初始化为全1矩阵列向量(形式为n行1列)for k in range(maxCycles):h = sigmoid(dataMatrix * weights) # 1.0-(1+exp(-Z) f[x,y] = Z = dataMatrix * weightserror = (labelMat - h)#损失函数,真实值与预测值之间的差值weights = weights + alpha * dataMatrix.transpose() * error # 更新权重:要注意矩阵运算,几行几列要对应,注意转置,error(m 行1列),return weights # 返回权重#运行代码dataArr, labelMat = loadDataSet()dataMatrix = mat(dataArr)#print(dataMatrix)res = gradAscent(dataArr,labelMat)print(res)结果如下:[[ 4.12414349][ 0.48007329][-0.6168482 ]]5-2 画出数据集和Logistic回归最佳拟合直线的函数def plotBestFit(weights):import matplotlib.pyplot as pltdataMat, labelMat = loadDataSet()dataArr = array(dataMat) # 列表要转为数组n = shape(dataArr)[0] # n=100 数组的行n=100,(数组的列m=3)xcord1 = [] #类型1的x,y值ycord1 = []xcord2 = [] #类型0的x,y值ycord2 = []for i in range(n): # 遍历(0-100-1)if int(labelMat[i]) == 1: # 如果第i个元素的标签值是 1 xcord1.append(dataArr[i,1]) # 把对应数据数组(形似矩阵)的第i行的第2个元素增加到 xcord1ycord1.append(dataArr[i,2]) # 把对应数据数组(形似矩阵)的第i行的第3个元素增加到 ycord1else: # 如果标签列表(labelMat)中第i个元素的标签是 0 xcord2.append(dataArr[i,1]) # 同上ycord2.append(dataArr[i,2]) # 同上fig = plt.figure()#画图画布ax = fig.add_subplot(111)#子图#画散点图ax.scatter(xcord1, ycord1, s=30, c='red', marker='s') ax.scatter(xcord2, ycord2, s=30, c='green')# 绘制拟合直线x = arange(-3.0,3.0) # x取值范围起点-3.0,终点3.0 步长0.1y = (-weights[0]-weights[1]*x)-weights[2] # weight[1]是1*1的矩阵,z=w[0]+w[1]*x+w[2]*y,#print(x)#print(y)ax.plot(x,y)#绘制拟合直线plt.xlabel('X1')plt.ylabel('X2')plt.show()#运行代码%matplotlib inline#在界面上显示dataArr, LabelMat = loadDataSet()weights = gradAscent(dataArr,LabelMat)plotBestFit(weights.getA()) #getA()将numpy矩阵转换为数组结果如图“梯度上升法”的不足在于每次更新回归系数时都要遍历整个数据集,计算复杂度高因此,产生了“随机梯度上升法”,即每次仅使用1个样本点数据来更新回归系数5-3 随机梯度上升算法随机梯度上升算法:一次仅用一个样本点来更新回归系数随机梯度上升伪代码:每个回归系数初始化为1对数据集中每个样本:计算该样本的梯度使用 alpha*gradient 更新回归系数的向量返回回归系数和梯度上升法的区别:第一,后者的变量h和error都是向量,而前者则全是数值;第二,前者没有矩阵的转化过程,所有变量的数据类型都是Numpy数组def stocGradAscent0(dataMatrix, classLabels):m,n = shape(dataMatrix) # 取数组的行m,列nalpha = 0.01 # 学习率初始化weights = ones(n) # 创建含有 n 个元素的数组for i in range(m): # 循环每一行的元素h = sigmoid(sum(dataMatrix[i]*weights))# sum(dataMatrix[i]*weights)=w0*x0+w1*x1+w2*x2error = classLabels[i] - hweights = weights + alpha * error * dataMatrix[i] # 更新权重return weights # 返回权重#运行代码:dataArr,labelMat = loadDataSet()weights = stocGradAscent0(array(dataArr), labelMat)plotBestFit(weights)结果如图“随机梯度上升法”分错了三分之一,因为原始梯度上升算法(5-1)是在整个数据集上迭代500次得来的,这是不公平,我们对本算法同样进行多次迭代,发现问题如下:不足在于回归系数存在周期震荡波动。