属性约简方法概述

粗糙集属性约简的方法

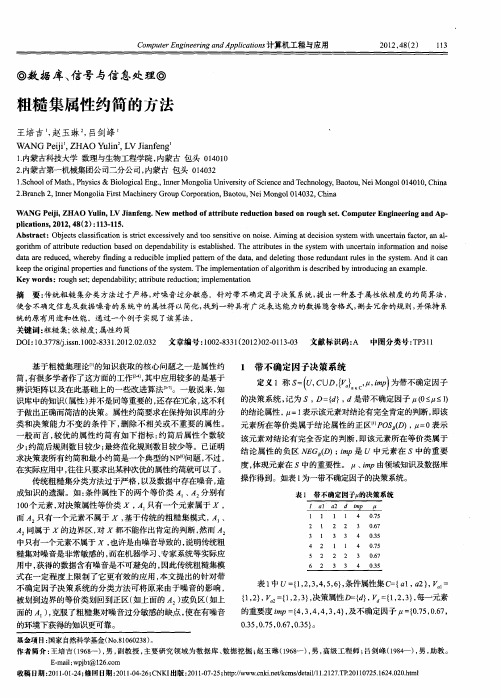

WANG P i, AO Y l , VJa fn . w meh do t iuerd c o ae nr u hstCo ue n ier ga dAp e iZH ui L ine g Ne to f t b t ut nb sdo o g e. mp tr gn ei n — j n ar e i E n piain , 0 2 4 ( )131 5 l t s2 1, 8 2 :1 —1 . c o Ab tat Obet c sict ni sit xes e n osn iv nn i . miga eio s m wi n e a c ra l src: jcs l s ai tc e csi l a dt s i o os Ai n t c ins t t u cr i f t .na・ a f o s r i vy o e te e d s ye h tn a o

的决 策系统 , 为 S, } d是 带不确定 因子 (-. ) 记 D= , 0I <t 1 的结论属性 , =1 示该元 素对 结论有 完全肯定 的判断 , 表 即该

识 库 中的知识 ( 属性 ) 并不 是同等重要 的 , 还存在 冗余 , 不利 这 于 做出正确 而简洁的决策 。属性约简要求 在保持知识库 的分 类和 决策 能力 不变 的 条件 下 , 除不 相关 或不 重要 的属 性 。 删 般而言, 较优 的属 性 约简 有如 下指 标 : 简后 属性 个 数较 约 少; 约简后规则数 目较少 ; 最终范化规 则数 目较少等 。已证明

Ke r s o g e; e e d bl ; t iuerd cin i lme tt n ywo d :ru hst d p n a i t at b t e u t ;mpe n ai i y r o o

基于互信息变化率的属性约简算法

关键 词 :粗 糙 集 ;属 性 约 简 ;互信 息 ቤተ መጻሕፍቲ ባይዱ 变化 率 中图分 类号 :T 3 3 8 文 献标识 码 :A 文章 编号 :17— 12( 02 7 0 4— 3 P9. 0 6 1 12 2 1 )0— 0 0 0

Al o ihm o ti t d to sd n M u ua-n o m ain g rt fr Atrbu eRe uci nba e o t lI f r to

摘 要: 属性 约 简是 粗 糙 集理 论 中的 基本 内容之 一 , 获得 决策 系统 的 最 小相 对约 简是 一 个 NP问题 。 但 文章从 信 息论的 角度 ,结合 微积 分 中的 变化 率 思 想 ,定 义 了一种 基 于 互信 息 变化 率 的 属性 重要 性 度 量 方 法 ,然后 在 此基 础 上 提 出了 两种相 对 属性 约 简的 启发 式 算 法。 最后 ,通过 实验 结果 证 明 该方 法 能有 效 地

0引言

粗糙集理论是波 兰科学 家 P w a a lk教授提 出的一种处 理不确定和不精确性问题的数学工具 , 】 作为人 工智能 的一种新研究方 法。粗糙 集理论不仅为信息科学 和认 知科 学提供了新 的科学逻辑 和研 究方法 , 还为知识发现 、机器学 习、专家系统 、数据 的决 策分 析和支持 、模 式识别等 领域 的信息处 理提供了很有效的理论框架 。同时,其方法在 医学 、金融、气象学 、图像处理 、语音

Absr c :At i t e cin saf nd me t lis n t et e r fr ug e s Bu th sb e pr v d ta ta t t bu erdu to i u a n a suei h h o y o o h s t. ti a e n o e h t r c omp i h nm u e ucin o e ii n tb ei ut ng te mi i m r d to fd cso a l saNP- r r blm . n t a e , c o dig t ec nc p had p o e I hep p r a c r n o t o e t h o ha e rt .an w trb t mpo tn em e s r t o Sd fne r m h iwpon fif r ain te r , fc ng ae e ati u e i ra c a u e me d i e h i d fo te ve ito n m to h o y o a w o ago ih sf rAtrbu eRe ucin a e nd t l rt m o ti t d to b s d on muta —nfr ai n c a ger t epr po e Atl s.t e u li o m to h n a ea o s d. a t h r e e m e t l e u t h w h theag rt sc n rd et ed csons tm fe tv l. xp f n a s lss o t a lo i i r t hm a e uc e ii yse e ciey h Ke ywor : o h e s at b t e ucin; t a nf m ai n c a er t ds r ug s t; t u er d to mu u 1i or to ; h ng a e i r

《决策形式背景属性约简及分类规则提取的方法研究》范文

《决策形式背景属性约简及分类规则提取的方法研究》篇一一、引言在大数据时代,决策形式背景属性约简及分类规则提取是数据挖掘和分析领域中一项至关重要的技术。

其目标是在保留重要信息的前提下,降低数据的复杂性和维度,进而提升数据处理和决策的效率和准确性。

本文旨在研究并分析这一过程的策略和方法,以实现对数据的更有效处理和利用。

二、决策形式背景属性约简决策形式背景属性约简主要是通过一定的算法和技术,对原始数据进行处理和筛选,以减少数据的复杂性和维度。

这一过程主要涉及到两个关键步骤:数据预处理和属性约简。

1. 数据预处理数据预处理是决策形式背景属性约简的第一步,其主要目的是清洗和整理数据,以便后续的属性约简工作。

这一步骤包括数据清洗、数据转换和数据归一化等操作。

(1)数据清洗:主要目的是去除或修正数据中的噪声和错误。

例如,对于缺失值、重复值或异常值进行处理。

(2)数据转换:将原始数据转化为更适合分析的形式。

例如,对于非数值型数据,可能需要转化为数值型数据。

(3)数据归一化:将数据的值限定在一定的范围内,以便于后续的属性约简工作。

2. 属性约简属性约简是决策形式背景属性约简的核心步骤,其主要目的是在保留重要信息的前提下,减少数据的维度。

这一步骤通常通过一些算法和技术实现,如粗糙集理论、信息熵等。

(1)粗糙集理论:基于等价类和不可分辨关系进行属性约简。

其主要思想是通过计算属性的重要性来决定其是否保留。

(2)信息熵:通过计算各个属性的信息增益或信息熵来评估其重要性,从而进行属性约简。

三、分类规则提取分类规则提取是在属性约简的基础上,进一步从数据中提取出分类规则的过程。

这一过程主要涉及到决策树、支持向量机等机器学习算法。

1. 决策树决策树是一种常用的分类算法,其通过构建树形结构来描述数据的分类规则。

在决策形式背景中,可以通过构建决策树来提取分类规则。

具体而言,通过计算各个属性的分裂准则和信息增益等指标,来决定树的构建过程。

粗糙集理论的属性约简方法及其在实际问题中的应用

粗糙集理论的属性约简方法及其在实际问题中的应用引言粗糙集理论是一种基于不确定性的数据分析方法,它通过对数据集中属性之间的关系进行分析,提供了一种有效的数据降维和特征选择的方法。

在实际问题中,属性约简是粗糙集理论的一个重要应用,它可以帮助我们从大规模的数据中提取出最为关键和有价值的属性,减少数据处理的复杂性,提高数据分析的效率和准确性。

一、粗糙集理论概述粗糙集理论是由波兰学者Pawlak于1982年提出的,它是一种处理不确定性信息的数学工具,主要用于数据分析和知识发现。

粗糙集理论的核心思想是基于近似和不确定性,通过对属性之间的关系进行分析,找出属性的重要性和相关性,从而对数据进行降维和特征选择。

二、属性约简方法属性约简是粗糙集理论的一个重要应用,它可以帮助我们从大规模的数据中提取出最为关键和有价值的属性,减少数据处理的复杂性,提高数据分析的效率和准确性。

常用的属性约简方法主要有以下几种:1. 正域约简:正域约简是一种基于属性重要性的约简方法,它通过计算属性的依赖度和冗余度来评估属性的重要性,从而选择出最为重要的属性。

正域约简方法在处理具有大量属性的数据集时具有较好的效果。

2. 直接约简:直接约简是一种基于属性关系的约简方法,它通过计算属性之间的相似度和相关性来选择出最为相关的属性。

直接约简方法在处理具有复杂关系的数据集时具有较好的效果。

3. 快速约简:快速约简是一种基于属性搜索的约简方法,它通过快速搜索算法来选择出最为关键的属性。

快速约简方法在处理大规模数据集时具有较好的效果。

三、属性约简方法在实际问题中的应用属性约简方法在实际问题中具有广泛的应用价值,可以帮助我们从大规模的数据中提取出最为关键和有价值的属性,减少数据处理的复杂性,提高数据分析的效率和准确性。

以下是属性约简方法在实际问题中的一些应用案例:1. 医学诊断:在医学诊断中,属性约简方法可以帮助医生从大量的医学数据中提取出最为关键和有价值的属性,辅助医生进行疾病诊断和治疗方案选择。

基于粗糙集理论的评价指标属性约简

基于粗糙集理论的评价指标属性约简摘要:粗糙集理论是一种对数据进行约简的有效工具。

文章运用粗糙集理论对评价指标进行了属性约简,并根据各指标包含信息量的大小确定权重,构建了基于粗糙集理论的指标综合评价模型。

标签:指标评价;粗糙集;属性约简引言粗糙集(Rough set)是由波兰数学家Z.Pawlak于1982年提出的一种处理模糊、不确定信息的方法。

粗糙集理论把知识看做关于论域的划分,以不可分辨关系为基础,在保持分类能力不变的前提下,通过知识属性约简,导出问题的决策分类规则。

属性约简是指对知识库中冗余繁杂的信息进行精简,以较少的数据进行较多信息的表达,从而方便对数据的处理和分析。

根据其客观性和自身特点,其用在评价指标属性约简具有可行性,众多学者和专家们对该方法在各个领域运用的可行性方面进行了研究。

1 粗糙集理论1.1 信息表。

S=(U,R,V,f)表示为信息表,其中U是一个非空集合,称为论域,U={x1,x2,x3……xn},其中xi表示对象;R表示对象的属性集合,R=C∪D,即对象的属性集合是条件属性(C)和决策属性(D)的并集;V是属性值的集合,Va是属性a∈R的值域;f是U×R→V的一个信息函数,它为每个属性a赋予一个属性值,即a∈R,x∈U,fa(x)∈Va。

1.2 等价关系。

对于任意a∈A(A中包含一个或多个属性),A?R,x∈U,它们的属性值相同,即fa(x)=fa(y)成立,称对象x和y是对属性A的等价关系,表示为IND(A)={(x,y)|(x,y)∈U×U,?a∈A,fa(x)=fa(y)}。

1.3 等价类。

在U中,对属性集A中具有相同等价关系的元素集合称为等价关系IND(A)的等价类,表示为[x]A={y|(x,y)∈IND(A)}。

1.4 属性约简。

给定一个信息表IT(U,A),若有属性集B?A,且满足IND(B)=IND(A),称B为A的一个约简,记为red(A),即B=red(A)。

粗糙集理论的属性重要性评估方法及其实际应用

粗糙集理论的属性重要性评估方法及其实际应用引言:粗糙集理论是一种用于处理不确定性和模糊性问题的数学工具,它在数据挖掘、模式识别和决策分析等领域中得到了广泛的应用。

在粗糙集理论中,属性重要性评估是一个重要的问题,它能够帮助我们识别出对决策结果具有重要影响的属性,从而提高决策的准确性和可靠性。

本文将介绍一种基于粗糙集理论的属性重要性评估方法,并探讨其在实际应用中的价值。

一、粗糙集理论概述粗糙集理论是由波兰学者Pawlak于1982年提出的,它是一种处理不确定性和模糊性问题的数学工具。

粗糙集理论通过将对象的属性进行划分,将属性值之间的差异进行模糊化处理,从而实现对不完备和不精确数据的分析和决策。

粗糙集理论的核心思想是近似和约简,即通过近似的方法对数据进行简化和压缩,从而提取出最重要的信息。

二、属性重要性评估方法在粗糙集理论中,属性重要性评估是一个关键问题。

属性重要性评估的目标是确定哪些属性对决策结果的影响最大,从而帮助我们进行决策和分析。

常用的属性重要性评估方法有正域、核和约简等方法。

1. 正域方法正域方法是一种基于粗糙集的属性重要性评估方法。

它通过计算属性在正域中的覆盖度来评估属性的重要性。

正域是指在给定条件下能够唯一确定决策结果的属性取值,它反映了属性对决策结果的贡献程度。

正域方法的优点是简单直观,容易理解和计算,但它没有考虑属性之间的依赖关系。

2. 核方法核方法是一种基于粗糙集的属性重要性评估方法。

它通过计算属性在核中的约简度来评估属性的重要性。

核是指在给定条件下能够唯一确定决策结果的最小属性集合,它反映了属性对决策结果的决定性影响。

核方法考虑了属性之间的依赖关系,能够更准确地评估属性的重要性,但计算复杂度较高。

3. 约简方法约简方法是一种基于粗糙集的属性重要性评估方法。

它通过对属性集合进行约简,得到一个最小的属性子集,从而实现对属性的重要性评估。

约简方法的优点是能够同时考虑属性之间的依赖关系和决策结果的覆盖度,能够更全面地评估属性的重要性。

属性约简(MATLAB算法)有实例有讲解

粗糙集属性约简注:这是我学粗糙集时老师给的作业属性约简的顺序如下:求正域、生成未经处理的区分矩阵、对区分矩阵进行化简、求核、对已经处理过的区分矩阵进行属性约简。

约简后的决策表有26行,所有12个属性都是正域中的属性,核为空程序:% main.mtic;a=[ 1,1,1,1,0,0,0,0,1,1,0,1;0,0,0,0,0,0,0,0,0,0,0,0;1,0,1,0,0,0,0,0,0,1,0,0;0,0,0,1,1,1,1,0,1,0,1,1;1,0,0,1,1,1,1,1,0,1,1,0;0,1,0,1,1,1,1,1,1,0,0,1;1,0,0,0,1,1,1,0,0,1,1,1;1,1,1,1,0,0,0,0,1,1,0,1;1,0,1,1,1,0,0,0,1,1,0,1;1,1,1,1,0,0,0,0,1,1,0,1;1,0,1,1,1,0,0,0,1,1,0,1;1,0,1,1,1,0,0,0,1,1,0,1 ];d=[1;0;0;0;0;0;0;1;1;1;1;1];pos=posCD(a,d);dismat=dismatrix(a,d,pos);dism=disbe(dismat);core=cor(dism); [red,row]=redu(dism); time=toc% dismatrix.m% 生成未经处理的区分矩阵dismatfunction dismat=dismatrix(a,d,pos)[m,n]=size(a);p=1;index1=0;index2=0;index=0;dis=-1*ones(m*(m-1)/2,n);for i=1:mfor j=i+1:mif (isxbelongtopos(i,pos)&~isxbelongtopos(j,pos))...|(~isxbelongtopos(i,pos)&isxbelongtopos(j,pos)). ..|(isxbelongtopos(i,pos)&isxbelongtopos(j,pos)&~i sxybelongtoindD(i,j,d))index2=1;endif index2==0continue;endfor k=1:nif a(i,k)~=a(j,k)dis(p,k)=1;index1=1;else dis(p,k)=0;endendif index1==1p=p+1;index=1;endindex1=0;index2=0;endendif p<=m*(m-1)/2if index==0dismat=[];return;endif dis(p,1)==-1p=p-1;endelse p=m*(m-1)/2;enddismat=dis(1:p,:);% redu.m% 对已经处理过的区分矩阵进行知识约简function [red,row]=redu(dism)[m,n]=size(dism);red=[];row=0;if m<=0return;endfor i=1:nif dism(1,i)~=0row=row+1;endendred(1:row,:)=zeros(row,n);j=1;for i=1:rowwhile dism(1,j)==0j=j+1;endred(i,j)=1;j=j+1;endtemp=[];tempdis=[];rowd=0;rowd1=0;for i=2:mj=1;while j<=rowtemp=uni(dism(i,:),red(j,:));[s,n]=size(temp);rowd1=rowd+s;tempdis(rowd+1:rowd1,:)=temp;rowd=rowd1;j=j+1;temp=[];endred=[];red=disbe(tempdis);tempdis=[];[row,n]=size(red);rowd=0;rowd1=0;end% disbe.m% 对区分矩阵或者约简矩阵进行化简即去掉包含关系function dism=disbe(dis)[m,n]=size(dis);p=m;for i=1:mif dis(i,1)~=-1for j=1:mif i~=j & dis(j,1)~=-1if dis(i,:)<=dis(j,:)dis(j,1)=-1;p=p-1;elseif dis(i,:)>=dis(j,:)dis(i,:)=dis(j,:);dis(j,1)=-1;p=p-1;endendendendenddism=ones(p,n);j=1;for i=1:pwhile j<=m & dis(j,1)==-1j=j+1;enddism(i,:)=dis(j,:);j=j+1;end% posCD.m% a为条件属性矩阵,d为决策属性向量% pos为正域,保存条件属性矩阵的索引值function pos=posCD(a,d)[m,n]=size(a);p=m;index=0;for i=1:mif a(i,1)~=-1for j=i+1:mif a(j,1)~=-1 &(a(i,:)==a(j,:)&d(i)~=d(j))a(j,1)=-1;p=p-1;index=1;endendif index==1a(i,1)=-1;p=p-1;index=0;endendendpos=zeros(p,1);i=1;for r=1:pwhile a(i,1)==-1&i<=mi=i+1;endpos(r)=i;r=r+1;i=i+1;end% cor.m% 对已经处理过的区分矩阵求核function core=cor(dism)[m,n]=size(dism);core1=zeros(1,n);number=0;for i=1:mnum=0;p=0;for j=1:nif dism(i,j)~=0num=num+1;p=j;endendif num==1core1(p)=1;number=number+1;endendif number==0core=0;elsecore=zeros(1,number);j=1;for i=1:numberwhile core1(j)==0j=j+1;endcore(i)=core1(j);j=j+1;endend% uni.m%对区分矩阵的第i行和red(j,:)运算,即将a中%所有的1分别插入到red(j,:)中,待去掉包含关系function tempred=uni(disa,red)[m,n]=size(red);num=0;for i=1:nif disa(i)~=0num=num+1;endendtempred=ones(m*num,n);temp=[];j=1;for i=1:numwhile disa(j)==0j=j+1;endtemp=red;temp(:,j)=ones(m,1);tempred((i-1)*m+1:i*m,:)=temp;j=j+1;end% isxbelongtopos.m% 判断x是否在正域pos中% x为索引值% 返回值p,如果x在pos中p=1否则p=0 function p=isxbelongtopos(x,pos)[m,n]=size(pos);p=0;if x<=0p=-1;return;endfor i=1:mif x==pos(i)p=1;break;endend% isxybelongtoindD.m% 判断x,y是否在indD中% x,y为索引值% 返回值p,如果x,y在indD中p=1否则p=0 function p=isxybelongtoindD(x,y,d)if x<=0 | x>size(d) | y<=0 | y>size(d) p=-1;return;endif d(x)==d(y)p=1;else p=0;end约简后的决策表如有侵权请联系告知删除,感谢你们的配合!。

属性约简

粗糙集的研究对象是一个数据集,数据集一般被保存为数据表格形式,即数据库或信息系统。

信息系统的形式是由研究对象和属性值关系构成的二维数据表,类似于基础数学中的关系数据库。

信息系统实现了粗糙集模型的知识表示。

定义 2.1.1[46] 设(,,,)S U A V f =为一个数据库,即信息系统,也称为知识表示系统。

其中12{,}U U x x x = 为一个非空的有限对象集,12{,,}A A a a a = 是属性的有限非空集合,a V V =⋃,a A ∈,a V 为属性a 的值域;定义信息函数:U V c a f A ⨯→ .例如表2.1.1是一个信息系统,其中12345{,,,,}U x x x x x =,1234{,,,}A a a a a =,123a a a V V V ==={0,1},4a V ={0,1,2}.表2.1.1 信息系统定义2.1.2[46] 对于a A ∀∈,x U ∀∈,(,)a f x a V ∈,对于P A ∀∅≠⊆,定义:{(,):(,)(,),}I x y U U f x q f y q q P =∈⨯=∀∈,I U 称为上的不可分辨关系。

(1)若(,)x y I ∈,则称:x y 和是不可分辨的。

(2)不可分辨关系是等价关系,具有:自反性:xIx ; 对称性:xIy yIx ⇒;传递性:,xIy yIz xIz ⇒ .(3) I 是U 上的一个等价关系,[]{,}I x y y U xIy =∈,12{[]}{,}I k U I x x U X X X =∈= ,12,k X X X 称为U 关于I 的一个划分。

(4)P I ∅≠⊆,1,2I I I ∈, 112{,}k U I X X X = ,212{,}l U I Y Y Y = ,12{,1,2,1,2}i j U I I X Y i k j l ⋂=⋂== ,()I Pind P I P ∈== ,则称:()ind P U 是上的一个等价关系,称为P 上的不可区分关系。

粗糙集理论的使用方法和步骤

粗糙集理论的使用方法和步骤粗糙集理论是一种用于处理不完全、不确定和模糊信息的数学工具,它在决策分析、数据挖掘和模式识别等领域具有广泛的应用。

本文将介绍粗糙集理论的使用方法和步骤,帮助读者更好地理解和应用这一理论。

一、粗糙集理论的基本概念粗糙集理论是由波兰学者Pawlak于1982年提出的,它的核心思想是通过对数据集进行粗糙化处理,找出数据集中的重要信息,从而进行决策和分析。

在粗糙集理论中,数据集由属性和决策组成,属性是描述对象的特征,决策是对对象进行分类或判断的结果。

二、粗糙集理论的步骤1. 数据预处理:在使用粗糙集理论之前,需要对原始数据进行预处理。

预处理包括数据清洗、数据变换和数据归一化等步骤,旨在提高数据的质量和可用性。

2. 属性约简:属性约简是粗糙集理论的核心步骤之一。

在属性约简过程中,需要根据属性的重要性对属性进行选择和优化。

常用的属性约简方法有基于信息熵的属性约简和基于模糊熵的属性约简等。

3. 决策规则的生成:在属性约简完成后,可以根据属性和决策之间的关系生成决策规则。

决策规则是对数据集中的决策进行描述和判断的规则,可以帮助决策者进行决策和分析。

4. 决策规则的评价:生成的决策规则需要进行评价和优化。

常用的决策规则评价方法有支持度和置信度等指标,通过对决策规则进行评价,可以提高决策的准确性和可靠性。

5. 决策与分析:最后一步是根据生成的决策规则进行决策和分析。

根据决策规则,可以对新的数据进行分类和判断,从而帮助决策者做出正确的决策。

三、粗糙集理论的应用案例粗糙集理论在实际应用中具有广泛的应用价值。

以电商平台为例,可以使用粗糙集理论对用户行为进行分析和预测。

首先,对用户的行为数据进行预处理,包括清洗和归一化等步骤。

然后,通过属性约简找出用户行为中的关键属性,如浏览时间、购买频率等。

接下来,根据属性和决策之间的关系生成决策规则,如用户购买商品的决策规则。

最后,根据生成的决策规则对新的用户行为进行分类和分析,从而提供个性化的推荐和服务。

不完备信息系统中属性的重要度及约简方法

E ma : 12 @1 3 o - i  ̄ 54 6 . r l cn Y G j —i , H - u 。 I Ke y nI o tn e re o t iu e a d atiu e rd cin i n o l e ifr - AN i l Z OU Yu h a Q N - u . n mp r td g e f at b t n t b t e u t n ic mpe n o ma a r r o t

C m u rE gneiga dA pi t n 计算机工程与应用 o p t n i r n p lai s e e 、 数 信号 与信 息处 理◎

不完备信息系统 中属性 的重要 度及 约简 方法

杨 霁琳 , 周玉 华 2秦 克云 1 ,

关键词 : 不完备信 息系统 ; 相似 关系; 粗糙 集; 属性约 简; WA算子 O D :03 7/i n10 — 3 1 0 0O . 1 文 章 编号 :0 2 8 3 ( 0 0 0 — 0 9 0 文 献 标 识码 : 中 图 分 类  ̄ : P 8 OI1 . 8 .s.02 8 3 . 1 .1 3 7 js 2 0 10 — 3 1 2 1 ) 10 9 —4 A 'T 1

Y N il 1Z O u h a. I e y n A G J—i , H U Y - u Q N K - u n

1 . 西南交通大学 数学学院 , 成都 6 03 10 1 2信阳职业技术学院 , . 河南 信 阳 4 4 0 600

属性约简方法概述

属性约简方法概述属性约简又称维规约或特征选择,从数学的角度考虑,就是有p维数据x=(x1,x2……xp),通过某种方法,得到新的数据x’=(x’1,x’2……x’k),k≤p,新的数据在某种评判标准下,最大限度地保留原始数据的特征。

属性约简主要是为了解决高维数据计算的复杂性和准确性问题。

目标是消除冗余和不相关属性对计算过程和最终结果造成的影响。

数据属性约简的意义主要从以下几个方面考虑:a)从机器学习的角度来看,通过属性约简去除噪音属性是非常有意义的;b)对一些学习算法来说,训练或分类时间随着数据维数的增加而增加,经过属性约简可以降低计算复杂度,减少计算时间;c)如果不进行属性约简,噪声或无关属性对分类的影响将与预期属性相同,这将对最终结果产生负面影响;d)当用较多的特征来描述数据时,数据均值表现得更加相似,难以区分。

为了描述属性约简方法,这里假设数据集合为d,d={x1,x2….xn},xi表示d中第i个实例,1≤i≤n,n为总的实例个数。

每个实例包含p个属性{|xi|=p}。

从机器学习的角度来看,属性约简方法可以分为监督的和非监督的两类。

下面是几种常用的方法。

(1)主成分分析主成分概念是karlparson于1901年最先引进。

1933年,hotelling把它推广到随机变量。

主成分分析把高维空间的问题转换到低维空间来处理,有效的降低了计算的复杂度。

通过主成分的提取,降低了部分冗余属性的影响,提高了计算的精度。

主成分分析的基本思想是通过正交变换将具有成分相关性的原始随机变量转换为具有成分不相关性的新变量。

从代数的角度,将原始变量的协方差矩阵变换为对角矩阵;从几何角度来看,将原始变量系统转换为一个新的正交系统,指向样本点分布最广的正交方向,然后降低多维变量系统的维数[43]。

定义4-1[44]:设x?(x1,x2,...,xp)'为p维随机向量,它的第i主成分分量可表示yi?ui'x,i=1,2,…,p。

粗糙集理论中的属性约简方法介绍

粗糙集理论中的属性约简方法介绍粗糙集理论是一种用于处理不确定性和模糊性问题的数学工具,它在数据挖掘、机器学习和模式识别等领域得到了广泛应用。

属性约简是粗糙集理论中的一个重要概念,它能够帮助我们从大量的属性中找到最为重要的属性,减少数据处理的复杂性。

本文将介绍粗糙集理论中的一些常用属性约简方法。

1. 正域约简方法正域约简方法是粗糙集理论中最为常用的一种属性约简方法。

其基本思想是通过比较不同属性对决策类别的区分能力,来确定最为重要的属性。

具体步骤如下:首先,计算每个属性与决策类别之间的依赖度,依赖度越大表示属性对决策类别的区分能力越强。

然后,根据依赖度的大小进行排序,选择依赖度最大的属性作为初始约简。

接下来,逐步添加其他属性,并计算约简后的属性集对决策类别的依赖度。

如果添加属性后的依赖度没有显著提高,则停止添加,得到最终的约简属性集。

2. 相关属性约简方法相关属性约简方法是一种基于属性之间相关性的约简方法。

它通过计算属性之间的相关系数或互信息量来评估属性之间的相关性,并选择相关性较低的属性进行约简。

具体步骤如下:首先,计算属性之间的相关系数或互信息量。

然后,根据相关系数或互信息量的大小进行排序,选择相关性较低的属性作为初始约简。

接下来,逐步添加其他属性,并计算约简后的属性集的相关系数或互信息量。

如果添加属性后的相关性没有显著提高,则停止添加,得到最终的约简属性集。

3. 基于粒计算的约简方法基于粒计算的约简方法是一种基于粒度理论的属性约简方法。

它通过将属性集划分为不同的粒度,来减少属性的数量。

具体步骤如下:首先,将属性集划分为不同的粒度。

每个粒度包含一组相关性较高的属性。

然后,选择每个粒度中最为重要的属性作为初始约简。

接下来,逐步添加其他粒度,并计算约简后的属性集的重要性。

如果添加粒度后的重要性没有显著提高,则停止添加,得到最终的约简属性集。

4. 基于遗传算法的约简方法基于遗传算法的约简方法是一种基于进化计算的属性约简方法。

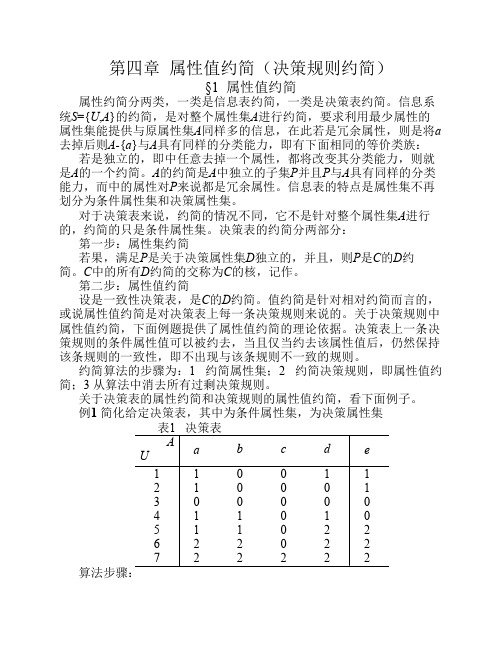

第四章 属性值约简(决策规则约简)

第四章 属性值约简(决策规则约简)§1 属性值约简属性约简分两类,一类是信息表约简,一类是决策表约简。

信息系统S ={U ,A }的约简,是对整个属性集A 进行约简,要求利用最少属性的属性集能提供与原属性集A 同样多的信息,在此若A a ∈是冗余属性,则是将a 去掉后则A -{a }与A 具有同样的分类能力,即有下面相同的等价类族:{}A U a A U =-若{}a A -是独立的,即{}a A -中任意去掉一个属性,都将改变其分类能力,则{}a A -就是A 的一个约简。

A 的约简是A 中独立的子集P 并且P 与A 具有同样的分类能力,而{}P A -中的属性对P 来说都是冗余属性。

信息表的特点是属性集A 不再划分为条件属性集和决策属性集。

对于决策表()D C A U T ==,来说,约简的情况不同,它不是针对整个属性集A 进行的,约简的只是条件属性集。

决策表的约简分两部分: 第一步:属性集约简若果C P ⊆,满足P 是关于决策属性集D 独立的,并且()()D Pos D Pos C P =,则P 是C 的D 约简。

C 中的所有D 约简的交()D RED C 称为C 的核,记作()C Core D 。

第二步:属性值约简设()D C U T ,=是一致性决策表,C P ⊆是C 的D 约简。

值约简是针对相对约简P 而言的,或说属性值约简是对决策表上每一条决策规则来说的。

关于决策规则中属性值约简,下面例题提供了属性值约简的理论依据。

决策表上一条决策规则的条件属性值可以被约去,当且仅当约去该属性值后,仍然保持该条规则的一致性,即不出现与该条规则不一致的规则。

约简算法的步骤为:1 约简属性集;2 约简决策规则,即属性值约简;3 从算法中消去所有过剩决策规则。

关于决策表的属性约简和决策规则的属性值约简,看下面例子。

例1 简化给定决策表,其中{}d c b a C ,,,=为条件属性集,{}e D =为决策属性集算法步骤:第一步:约简属性集:从决策表中,将属性A 中的属性逐个移去,每移去一个属性立刻检查其决策表,如果决策表中的所有决策规则不出现新的不一致,则该属性是可以被约去的,否则,该属性不能被约去,称这种方法为属性约简的数据分析法。

布尔决策表的属性约简新方法:应用于欺诈识别

t n u c l a d e u e h ag r h i eW i h rltd he re o o g s t n sn te r eig d a, i a e i q iky n rd c te lo i m t . t te eae t o is f r u h es d u ig h od rn ie t s p p r o t m h a h

关键词 : 粗糙 集; 决策表 ; 属性幂 ; 排序

DOI1 .7 8 .s.0 28 3 .0 11 .3 文章 编号 :0 28 3 (0 1 1—1 60 文献 标识码 : 中图 分类 ̄ : P 9 :03 7  ̄i n10 -3 1 1 . 0 6 s 2 2 1 0 —3 l2 1 )20 2 —4 A JT 31 '

1 . 西南交通大 学 经 济管理学院 , 成都 6 0 3 10 1 2电子科技大 学 计 算机 科学与工程 学院 , 都 6 0 5 . 成 10 4

第四章 属性值约简(决策规则约简)

第四章属性值约简(决策规则约简)§1 属性值约简属性约简分两类,一类是信息表约简,一类是决策表约简。

信息系统S={U,A}的约简,是对整个属性集A进行约简,要求利用最少属性的属性集能提供与原属性集A同样多的信息,在此若是冗余属性,则是将a 去掉后则A-{a}与A具有同样的分类能力,即有下面相同的等价类族:若是独立的,即中任意去掉一个属性,都将改变其分类能力,则就是A的一个约简。

A的约简是A中独立的子集P并且P与A具有同样的分类能力,而中的属性对P来说都是冗余属性。

信息表的特点是属性集不再划分为条件属性集和决策属性集。

对于决策表来说,约简的情况不同,它不是针对整个属性集A进行的,约简的只是条件属性集。

决策表的约简分两部分:第一步:属性集约简若果,满足P是关于决策属性集D独立的,并且,则P是C的D约简。

C中的所有D约简的交称为C的核,记作。

第二步:属性值约简设是一致性决策表,是C的D约简。

值约简是针对相对约简而言的,或说属性值约简是对决策表上每一条决策规则来说的。

关于决策规则中属性值约简,下面例题提供了属性值约简的理论依据。

决策表上一条决策规则的条件属性值可以被约去,当且仅当约去该属性值后,仍然保持该条规则的一致性,即不出现与该条规则不一致的规则。

约简算法的步骤为:1 约简属性集;2 约简决策规则,即属性值约简;3 从算法中消去所有过剩决策规则。

关于决策表的属性约简和决策规则的属性值约简,看下面例子。

例1 简化给定决策表,其中为条件属性集,为决策属性集第一步:约简属性集:从决策表中,将属性A中的属性逐个移去,每移去一个属性立刻检查其决策表,如果决策表中的所有决策规则不出现新的不一致,则该属性是可以被约去的,否则,该属性不能被约去,称这种方法为属性约简的数据分析法。

解法1:从条件属性集中移去c列后,决策表不出现新的不一致,所以c列可约去;从中移去a或移去b,或移去d后,决策表中都出现新的不一致,故a,b,d都不能移去,即a,b,d都是C的D核属性。

相容矩阵的高效属性约简算法

相容矩阵的高效属性约简算法相容矩阵是一种重要的数据结构,它能够用于描述不同属性之间的相容性关系。

在实际应用中,相容矩阵往往非常大,所以需要对其进行属性约简。

本文将重点介绍一个高效的相容矩阵属性约简算法。

1. 相容矩阵与属性约简相容矩阵是描述不同属性之间的相容性关系的一种数据结构,通常用1和0表示两个属性是否相容。

相容矩阵能够为决策系统提供关键信息,以帮助决策者做出更加符合实际的决策。

但是,随着相容矩阵规模的增大,其计算复杂度将呈指数级增长,因此需要进行属性约简来减小计算复杂度。

属性约简是指从决策系统的全部属性中选出一些重要的属性来代替全部属性,以达到减小计算复杂度和提高决策效果的目的。

2. 算法步骤基于属性的依赖关系进行属性约简是一种常见的方法。

现在,我们将介绍一种高效的基于依赖关系的相容矩阵属性约简算法,其中主要分为以下步骤:步骤1:建立初始决策属性集合R,将所有决策属性的编号存入集合R中。

步骤2:循环执行以下操作:(1)在集合R中选出一个属性,计算该属性和其他属性之间的相容性,将结果保存在相容性矩阵中。

(2)根据相容性矩阵,确定该属性与其他属性之间的依赖关系。

(3)对于集合R中的每个属性,进行依赖关系检验,若该属性不依赖于其他任何属性,则将其从集合R中删除。

(4)若集合R没有变化,则结束循环;否则,继续执行步骤2。

步骤3:得到最终的属性集合,即为属性约简结果。

3. 算法分析该算法基于属性的依赖关系进行属性约简,在每次循环中计算相容性和依赖关系,以及进行依赖关系检验,通过逐步缩小属性集合R的大小,实现了属性的约简。

该算法的时间复杂度为O(D×n3),其中D表示决策属性的数量,n表示属性的数量。

相对于其他属性约简算法,该算法具有计算复杂度较小、精度较高等优点,适用于大规模相容矩阵的属性约简。

4. 应用实例该算法已经成功应用于多个实际应用中,例如银行信用评级、保险赔偿等领域。

在银行信用评级中,该算法可以将大量的信用评估指标约简为少量的关键指标,提高信用评级的准确性和效率;在保险赔偿中,该算法可以减少需要考虑的因素,降低赔偿处理成本和提高赔偿质量。

属性约简

粗糙集的研究对象是一个数据集,数据集一般被保存为数据表格形式,即数据库或信息系统。

信息系统的形式是由研究对象和属性值关系构成的二维数据表,类似于基础数学中的关系数据库。

信息系统实现了粗糙集模型的知识表示。

定义 2.1.1[46] 设(,,,)S U A V f =为一个数据库,即信息系统,也称为知识表示系统。

其中12{,}U U x x x = 为一个非空的有限对象集,12{,,}A A a a a = 是属性的有限非空集合,a V V =⋃,a A ∈,a V 为属性a 的值域;定义信息函数:U V c a f A ⨯→ .例如表2.1.1是一个信息系统,其中12345{,,,,}U x x x x x =,1234{,,,}A a a a a =,123a a a V V V ==={0,1},4a V ={0,1,2}.表2.1.1 信息系统定义2.1.2[46] 对于a A ∀∈,x U ∀∈,(,)a f x a V ∈,对于P A ∀∅≠⊆,定义:{(,):(,)(,),}I x y U U f x q f y q q P =∈⨯=∀∈,I U 称为上的不可分辨关系。

(1)若(,)x y I ∈,则称:x y 和是不可分辨的。

(2)不可分辨关系是等价关系,具有:自反性:xIx ; 对称性:xIy yIx ⇒;传递性:,xIy yIz xIz ⇒ .(3) I 是U 上的一个等价关系,[]{,}I x y y U xIy =∈,12{[]}{,}I k U I x x U X X X =∈= ,12,k X X X 称为U 关于I 的一个划分。

(4)P I ∅≠⊆,1,2I I I ∈, 112{,}k U I X X X = ,212{,}l U I Y Y Y = ,12{,1,2,1,2}i j U I I X Y i k j l ⋂=⋂== ,()I Pind P I P ∈== ,则称:()ind P U 是上的一个等价关系,称为P 上的不可区分关系。

构建粗糙集模型的基本步骤与方法

构建粗糙集模型的基本步骤与方法引言:粗糙集理论是一种基于不确定性的数学模型,被广泛应用于数据挖掘、模式识别、决策分析等领域。

构建粗糙集模型是研究者们在实践中积累的经验总结,下面将介绍构建粗糙集模型的基本步骤与方法。

一、数据预处理构建粗糙集模型的第一步是进行数据预处理。

数据预处理是为了清洗数据、填补缺失值、去除异常值等,以保证数据的质量和完整性。

常用的数据预处理方法包括数据清洗、缺失值处理、异常值检测等。

二、属性约简属性约简是构建粗糙集模型的关键步骤之一。

属性约简的目的是通过删除冗余属性,减少数据集的维度,提高模型的效率和可解释性。

常用的属性约简方法有基于信息熵的属性约简、基于粗糙集的属性约简等。

三、决策规则提取决策规则提取是构建粗糙集模型的核心步骤之一。

决策规则提取的目的是从数据集中提取出具有较高可信度和泛化能力的决策规则,用于描述数据集的特征和规律。

常用的决策规则提取方法有基于粗糙集的决策规则提取、基于关联规则的决策规则提取等。

四、模型评估与优化模型评估与优化是构建粗糙集模型的重要环节。

模型评估的目的是评估模型的性能和泛化能力,以确定模型的有效性和可靠性。

常用的模型评估方法有交叉验证、留一法、自助法等。

模型优化的目的是通过调整模型的参数和结构,提高模型的预测能力和稳定性。

常用的模型优化方法有遗传算法、粒子群优化算法等。

五、模型应用与推广构建粗糙集模型的最终目的是将模型应用于实际问题,并推广到更广泛的领域。

模型应用的过程中,需要根据实际需求进行模型调整和优化,以满足实际问题的需求。

模型推广的过程中,需要将模型的思想和方法进行总结和归纳,以便更好地应用于其他领域和问题。

结论:构建粗糙集模型是一个复杂而又有挑战性的过程,需要经验丰富的研究者进行指导和实践。

本文介绍了构建粗糙集模型的基本步骤与方法,包括数据预处理、属性约简、决策规则提取、模型评估与优化、模型应用与推广等。

希望本文能够对研究者们在构建粗糙集模型时提供一定的参考和帮助。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

属性约简方法概述

属性约简又称维规约或特征选择,从数学的角度考虑,就是有p 维数据 x =(x 1,x 2……x p ),通过某种方法,得到新的数据 x’=(x’1,x’2…… x’k ) , k ≤p , 新的数据在某种评判标准下,最大限度地保留原始数据的特征。

属性约简主要是为了解决高维数据计算的复杂性和准确性问题。

目标是消除冗余和不相关属性对计算过程和最终结果造成的影响。

对数据进行属性约简的意义,主要从以下几个方面考虑:

a) 从机器学习的角度来看,通过属性约简去除噪音属性是非常有意义的; b) 对一些学习算法来说,训练或分类时间随着数据维数的增加而增加,经过属性约简可以降低计算复杂度,减少计算时间;

c) 假如不进行属性约简,噪音或不相关属性和期望属性对分类的作用一样,就会对最终结果产生负面影响;

d) 当用较多的特征来描述数据时,数据均值表现得更加相似,难以区分。

为了描述属性约简方法,这里假设数据集合为D ,D ={x 1,x 2….x n }, x i 表示D 中第i 个实例,1≤i≤n ,n 为总的实例个数。

每个实例包含p 个属性{|x i |=p }。

从机器学习的角度来看,属性约简方法可以分为监督的和非监督的两类。

下面是几种常用的方法。

(1) PCA 主成分分析

主成分概念是Karl parson 于1901年最先引进。

1933年,Hotelling 把它推广到随机变量。

主成分分析把高维空间的问题转换到低维空间来处理,有效的降低了计算的复杂度。

通过主成分的提取,降低了部分冗余属性的影响,提高了计算的精度。

主成分分析的基本思想为:借助一个正交变换,将分量相关的原随机变量转换成分量不相关的新变量。

从代数角度,即将原变量的协方差阵转换成对角阵;从几何角度,将原变量系统变换成新的正交系统,使之指向样本点散布最开的正交方向,进而对多维变量系统进行降维处理[43]。

定义4-1[44]:设12(,,...,)'p X X X X =为p 维随机向量,它的第i 主成分分量可表示'i i Y u X =,i =1,2,…, p 。

其中i u 是正交阵U 的第i 列向量。

并且满足:

1Y 是12,,...,p X X X 的线性组合中方差最大者;

k Y 是与11,...k Y Y -不相关的12,,...,p X X X 的线性组合中方差最大。

(k =2,3,…p )。

定义4-2[45]: 设∑是随机向量12(,,...,)'p X X X X =的协方差矩阵,其特征值-特征向量对1122(,),(,),...(,)p p e e e λλλ,其中12...0p λλλ≥≥≥≥。

则第i 个主成分为:

1122

'...i i i i i p p Y e X e X e X e X ==+++ i =1, 2, …p ………………….式

(4-1)

且 var()'i i i i Y e e λ=∑= i =1, 2, …p ;cov(,)'0j j i i Y Y e e =∑= i j ≠。

定义4-3[45]: 设随机向量12(,,...,)'p X X X X =有协方差矩阵∑,其特征值-特征向量对1122(,),(,),...(,)p p e e e λλλ,其中12...0p λλλ≥≥≥≥,i Y 是主成分,则

1122

121

1

...var()...var()p

p

pp i p i i i X Y σσ

σλλλ==++==++=∑∑ ………….式(4-2)

定义4-3说明主成分向量的协方差阵∑为对角矩阵Λ。

总体信息量可以用特征值来衡量,相应的特征值反映的是对应主成分的信息量。

进而可以计算每个主成分的贡献率。

定义4-4[44]:记

k

p

i i i

λλ

=∑ 为第k 主成分的贡献率,1

k

i

i p

i

i i

λλ

=

=∑∑为前k 个主成分的累

积贡献率。

主成分分析经常用于减少数据集的维数,同时保持数据集的对方差贡献最大的特征。

这是通过保留低阶主成分,忽略高阶主成分做到的。

主成分描述了数据的可变性,通过它可以模拟原始数据。

主成分分析作为最重要的多元统计方法之一,在经济社会、企业管理、工业控制、模式识别等各领域有极其广泛的应用。

(2) 监督条件下的维规约方法(Chi-Square 检测, 信息增益, 增益率) 监督的维规约方法主要用来辨别属性值预测类标识的能力。

设考察的属性为V ,V 有p 个取值V ={V 1,V 2… …V p },数据集有z 个类,用 C ={C 1,C 2… …C z }表示。

nr i 是指当属性V 的值为V r 时,类为C i 的个数,ur i 是指当数据为均匀分布此属性值时期望的类的数目,1≤r ≤p ,1≤i ≤z 。

属性V 的取值分布见表4-1。

表4-1属性V 取值分布表

Table 4-1 Value Distribution Table of Attribute V

a) Chi-Square 检测

卡方检验是一种假设检验方法,它在分类资料统计推断中的应用,包括:两个概率或两个构成比比较的卡方检验;多个概率或多个构成比比较的卡方检验以及分类资料的相关分析等,它引入了一个服从卡方分布的评分准则。

在数据集合D 上,特征f 和类c 的相关性评分公式如下:

()

2

211

(,,)p z

j j i j j

ni ui D c f ui χ==-=∑∑

……………………………式(4-3)

从本质上来看,卡方分布是对数据集的实际属性值类别数目与期望中的属性和类无关时的类别数目差别的评分。

b) 信息增益 (IG)

息增益(information gain )是指期望信息或者信息熵的有效减少量。

从数据分类的角度看,根据它能够确定在什么样的层次上选择什么样的变量来分类。

信息增益度量了某个特征给训练集带来的信息量大小。

它定义为用特征f 划分数据集D 引起熵的约简。

如公式4-4和公式4-5所示。

()()v values f IG(D,c,f)=H(D,c)-

,Dv

H Dv c D

∈∑

…………………………式(4-4)

H 表示熵, p

z

2i =1

j =1

H (D ,c )=-l o g j

j

ni ni ni

ni

∑∑…………………………式(4-5) 信息增益越大,说明属性对最终类别的影响越大。

在分类问题上,可以选作分类的属性。

本文则看作对聚类结果有较大影响的属性,保留起来。

c) 增益率(信息增益比,GR )

以信息增益作为属性划分的尺度,倾向于选择值域中含有较多值的属性。

从信息论的角度讲,就是倾向于选择更加取值混乱的属性。

事实上这种倾向并不一定合理。

信息增益率,用 f 的信息增益除以 f 的初始信息量来消除这种影响。

如公式4-6 -公式4-8所示:

GR(D ,c ,f) = (H(D ,c) - H(D | c )) / H(D, f). ………………………式(4-6)

()()

v values f H(D|c)=-

,Dv H Dv c D

∈∑

……………………………式(4-7)

()2

1

,log p

r nr nr

H D f n n ==-∑

……………………………式(4-8) 增益率方法不仅考虑了属性的值域的大小,而且还考虑了取值的分布。

它有如下特点:(1)在值域大小相同时,取值分布越均匀,则H (D,f )越大,即当相应地属性重要性最小;(2)属性在自己值域内各种取值全为均匀分布时,即等概率

分布时,值域越大则H(D,f)越大,相应地属性重要性越小。

以上两个特点符合人们对重要属性评判的刻度。

其它特征选择方法包括:奇异值分解,是一种现行代数技术,它与PCA有关;嵌入方法,在数据挖掘算法运行期间,算法本身决定使用哪些属性和忽略哪些属性;过滤方法,使用某种独立于数据挖掘任务的方法,在数据挖掘算法运行前进行特征选择;包装方法,将目标数据挖掘算法作为黑盒,使用理想算法的方法,但通常并不枚举所有可能的子集来找出最佳属性集。