avocentKVM安装指南

Avocent_KVM手册

美国通告 警告:未经负责符合性一方明确认可对本产品进行改造或改动会使用户丧失操作设备的权利。 注:经测试,本设备符合 FCC 规范第 15 部分中有关 A 类数字设备的限制。这些限制用于为商业环境 下使用本设备提供合理的防有害干扰的保护。本设备产生、使用并可能辐射射频能量,如果不按照说 明手册进行安装和使用,可能会对无线电通讯造成有害干扰。本设备在居住区使用时可能会造成有害 干扰,在此情况下,用户应自行负责消除干扰。 加拿大通告 本数字设备符合《加拿大通讯部无线电干扰法规》(Radio Interference Regulations of the Canadian Department of Communications) 规定的数字设备无线电噪音发射 A 类限制标准。 Le présent appareil numérique n’émet pas de bruits radioélectriques dépassant les limites applicables aux appareils numériques de la classe A prescrites dans le Règlement sur le brouillage radioélectrique édicté par le Ministère des Communications du Canada. 日本批文号

安全和 EMC 标准 EN55022 Class A、EN55024、EN 61000-3-2、EN 61000-3-3、EN60950、FCC 47CFR Part15 Class A、 CSA C22.2 No. 60950、IEC 60950、FCC 15 Class A、UL 60950 third edition、VCCI Classntents

KVM--安装及初步使用

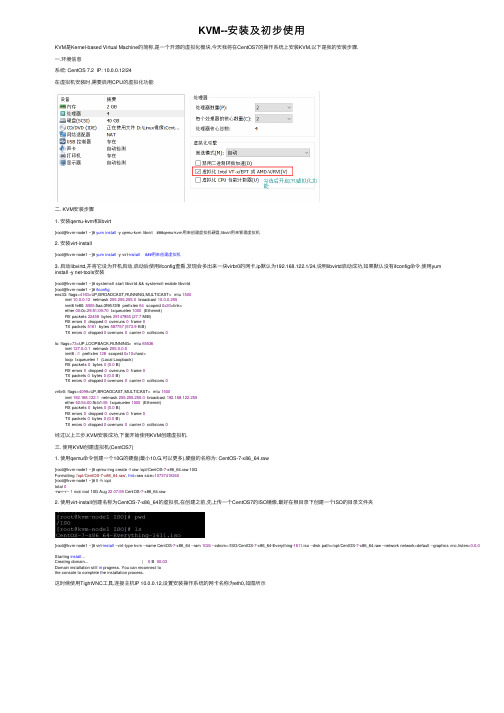

KVM--安装及初步使⽤KVM是Kernel-based Virtual Machine的简称,是⼀个开源的虚拟化模块,今天我将在CentOS7的操作系统上安装KVM,以下是我的安装步骤.⼀.环境信息系统: CentOS 7.2 IP: 10.0.0.12/24在虚拟机安装时,需要启⽤CPU的虚拟化功能⼆. KVM安装步骤1. 安装qemu-kvm和libvirt[root@kvm-node1 ~]# yum install -y qemu-kvm libvirt ###qemu-kvm⽤来创建虚拟机硬盘,libvirt⽤来管理虚拟机2. 安装virt-install[root@kvm-node1 ~]# yum install -y virt-install ###⽤来创建虚拟机3. 启动libvirtd,并将它设为开机启动,启动后使⽤ifconfig查看,发现会多出来⼀块virbr0的⽹卡,ip默认为192.168.122.1/24,说明libvirtd启动成功,如果默认没有ifconfig命令,使⽤yuminstall -y net-tools安装[root@kvm-node1 ~]# systemctl start libvirtd && systemctl enable libvirtd[root@kvm-node1 ~]# ifconfigens33: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet 10.0.0.12 netmask 255.255.255.0 broadcast 10.0.0.255inet6 fe80::5505:5aa:3f96:f3f8 prefixlen 64 scopeid 0x20<link>ether 00:0c:29:51:09:70 txqueuelen 1000 (Ethernet)RX packets 22459 bytes 29147955 (27.7 MiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 5161 bytes 587757 (573.9 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536inet 127.0.0.1 netmask 255.0.0.0inet6 ::1 prefixlen 128 scopeid 0x10<host>loop txqueuelen 1 (Local Loopback)RX packets 0 bytes 0 (0.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 0 bytes 0 (0.0 B)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0virbr0: flags=4099<UP,BROADCAST,MULTICAST> mtu 1500inet 192.168.122.1 netmask 255.255.255.0 broadcast 192.168.122.255ether 52:54:00:fb:b1:55 txqueuelen 1000 (Ethernet)RX packets 0 bytes 0 (0.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 0 bytes 0 (0.0 B)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0经过以上三步,KVM安装成功,下⾯开始使⽤KVM创建虚拟机.三. 使⽤KVM创建虚拟机(CentOS7)1. 使⽤qemu命令创建⼀个10G的硬盘(最⼩10,G,可以更多),硬盘的名称为: CentOS-7-x86_64.raw[root@kvm-node1 ~]# qemu-img create -f raw /opt/CentOS-7-x86_64.raw 10GFormatting '/opt/CentOS-7-x86_64.raw', fmt=raw size=10737418240[root@kvm-node1 ~]# ll -h /opttotal 0-rw-r--r-- 1 root root 10G Aug 2207:59 CentOS-7-x86_64.raw2. 使⽤virt-install创建名称为CentOS-7-x86_64的虚拟机,在创建之前,先上传⼀个CentOS7的ISO镜像,最好在根⽬录下创建⼀个ISO的⽬录⽂件夹[root@kvm-node1 ~]# virt-install --virt-type kvm --name CentOS-7-x86_64 --ram 1024 --cdrom=/ISO/CentOS-7-x86_64-Everything-1611.iso --disk path=/opt/CentOS-7-x86_64.raw --network network=default --graphics vnc,listen=0.0.0.0 Starting install...Creating domain... | 0 B 00:03Domain installation still in progress. You can reconnect tothe console to complete the installation process.这时候使⽤TightVNC⼯具,连接主机IP 10.0.0.12,设置安装操作系统的⽹卡名称为eth0,如图所⽰安装步骤和我们平时安装操作系统的⽅法⼀样,安装完成后,可以使⽤virsh list --all显⽰KVM上所有的虚拟机[root@kvm-node1 ~]# virsh list --allId Name State----------------------------------------------------- CentOS-7-x86_64 shut off ### 可以看到虚拟机的名称和状态四. 管理KVM1. 使⽤virsh启动KVM中的虚拟机[root@kvm-node1 ~]# virsh start CentOS-7-x86_64Domain CentOS-7-x86_64 started启动后,使⽤VNC连接⼯具,登录后可以看到⽹卡的名称为eth0,默认没有ip地址,是因为⽹卡没有激活,将ONBOOT改为yes,重启⽹卡,可以看到ip地址为192.168.122.0⽹段的当KVM中的虚拟机启动后,可以在/etc/libvirt/qemu⽬录下,看到启动的虚拟机的信息[root@kvm-node1 ~]# cd /etc/libvirt/qemu[root@kvm-node1 qemu]# pwd/etc/libvirt/qemu[root@kvm-node1 qemu]# ls -lhtotal 4.0K-rw------- 1 root root 3.8K Aug 2208:18 CentOS-7-x86_64.xmldrwx------ 3 root root 42 Aug 2207:51 networksCentOS-7-x86_64.xml就是启动的虚拟机的信息,当我们使⽤vim编辑器查看时,会提⽰如下信息:<!--WARNING: THIS IS AN AUTO-GENERATED FILE. CHANGES TO IT ARE LIKELY TO BEOVERWRITTEN AND LOST. Changes to this xml configuration should be made using:virsh edit CentOS-7-x86_64or other application using the libvirt API.-->看到提⽰需要修改虚拟机的信息,需要使⽤命令 virsh edit CentOS-7-x86_64,是⽤这条命令后,我们可以看到很多虚拟机的信息,包括vcpu,memory等2. CPU热添加(KVM⽀持CPU的热添加,不过局限是宿主机和虚拟机的系统相同才⾏,这⾥宿主机是CentOS7,虚拟机也是CentOS7,所以可以模拟CPU热添加,不过真实⽣产环境不建议这样操作)[root@kvm-node1 ~]# virsh edit CentOS-7-x86_646 <vcpu placement='static'>1</vcpu> 修改为:<vcpu placement='auto' current="1">4</vcpu>##意思是当前cpu为1核,最多可以有4核,修改完虚拟机的配置⽂件,必须关闭虚拟机再启动,配置才能⽣效[root@kvm-node1 ~]# virsh shutdown CentOS-7-x86_64 ##关闭虚拟机Domain CentOS-7-x86_64 is being shutdown[root@kvm-node1 ~]# virsh list --all ##查看虚拟机状态Id Name State----------------------------------------------------- CentOS-7-x86_64 shut off[root@kvm-node1 ~]# virsh start CentOS-7-x86_64 ##启动虚拟机Domain CentOS-7-x86_64 started[root@kvm-node1 ~]# virsh list --allId Name State----------------------------------------------------3 CentOS-7-x86_64 running先通过VNC⼯具查看虚拟机的cpu信息在宿主机上通过命令添加核数[root@kvm-node1 ~]# virsh setvcpus CentOS-7-x86_64 2 --live ##虚拟机的cpu添加到2core再通过VNC⼯具查看虚拟机CPU信息3. 内存热添加(还是不建议⽣产中使⽤,知道功能就⾏了)通过VNC连接虚拟机,查看虚拟机内存[root@kvm-node1 ~]# virsh qemu-monitor-command CentOS-7-x86_64 --hmp --cmd info balloon ## 查看当前虚拟机的内存balloon: actual=1024[root@kvm-node1 ~]# virsh qemu-monitor-command CentOS-7-x86_64 --hmp --cmd balloon 512 ## 修改当前虚拟机的内存为512 [root@kvm-node1 ~]# virsh qemu-monitor-command CentOS-7-x86_64 --hmp --cmd info balloon ## 查看修改的内存信息已经改变成了512 balloon: actual=512使⽤VNC⼯具连接虚拟机,查看内存是否有变:4. ⽹卡配置(如何将KVM虚拟机中的⽹卡改为桥接模式,让局域⽹的其他⽤户可以正常访问)[root@kvm-node1 ~]# brctl show ##查看已有⽹桥bridge name bridge id STP enabled interfacesvirbr0 8000.525400fbb155 yes virbr0-nicvnet0创建⼀个脚本,删除ens33⽹卡的ip信息,新建⼀个桥接⽹卡,并且将ens33⽹卡的ip信息富裕新建的桥接⽹卡[root@kvm-node1 ~]# vim br0.sh#!/bin/bashbrctl addbr br0 #创建⼀个桥接⽹卡br0brctl addif br0 ens33 #将ens33⽹卡的桥接信息转到br0⽹卡ip addr del dev ens33 10.0.0.12/24 #将ens33⽹卡的ip信息删除ifconfig br0 10.0.0.12/24 up #将ens33⽹卡的ip信息这只到br0⽹卡上route add default gw 10.0.0.2 #添加⽹关[root@kvm-node1 ~]# chmod u+x br0.sh[root@kvm-node1 ~]# ./br0.sh使⽤ifocnfig查看⽹卡的ip信息,可以看到br0的地址已经变为了10.0.0.12/24[root@kvm-node1 ~]# ifconfigbr0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet 10.0.0.12 netmask 255.255.255.0 broadcast 10.0.0.255inet6 fe80::20c:29ff:fe51:970 prefixlen 64 scopeid 0x20<link>ether 00:0c:29:51:09:70 txqueuelen 1000 (Ethernet)RX packets 553 bytes 41723 (40.7 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 680 bytes 63511 (62.0 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0ens33: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet6 fe80::5505:5aa:3f96:f3f8 prefixlen 64 scopeid 0x20<link>ether 00:0c:29:51:09:70 txqueuelen 1000 (Ethernet)RX packets 6107998 bytes 8708309251 (8.1 GiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 534420 bytes 68906654 (65.7 MiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0lo: flags=73<UP,LOOPBACK,RUNNING> mtu 65536inet 127.0.0.1 netmask 255.0.0.0inet6 ::1 prefixlen 128 scopeid 0x10<host>loop txqueuelen 1 (Local Loopback)RX packets 0 bytes 0 (0.0 B)RX errors 0 dropped 0 overruns 0 frame 0TX packets 0 bytes 0 (0.0 B)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0virbr0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet 192.168.122.1 netmask 255.255.255.0 broadcast 192.168.122.255ether 52:54:00:fb:b1:55 txqueuelen 1000 (Ethernet)RX packets 6685 bytes 278745 (272.2 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 6981 bytes 34351624 (32.7 MiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0vnet0: flags=4163<UP,BROADCAST,RUNNING,MULTICAST> mtu 1500inet6 fe80::fc54:ff:fe6b:5fee prefixlen 64 scopeid 0x20<link>ether fe:54:00:6b:5f:ee txqueuelen 1000 (Ethernet)RX packets 16 bytes 1650 (1.6 KiB)RX errors 0 dropped 0 overruns 0 frame 0TX packets 987 bytes 52236 (51.0 KiB)TX errors 0 dropped 0 overruns 0 carrier 0 collisions 0使⽤命令修改KVM虚拟机的信息[root@kvm-node1 ~]# virsh edit CentOS-7-x86_6469 <interface type='network'> 修改为:<interface type='bridge'> ##桥接71 <source network='default'/> 修改为:<source bridge='br0'/>修改完成后关闭虚拟机,启动虚拟机,通过VNC⼯具修改ip为10.0.0.14/24,尝试ping宿主机是否可以ping通,并通过ssh连接[root@kvm-node1 ~]# virsh shutdown CentOS-7-x86_64Domain CentOS-7-x86_64 is being shutdown[root@kvm-node1 ~]# virsh start CentOS-7-x86_64Domain CentOS-7-x86_64 started通过本地的ssh软件,尝试连接,可以连接,并且可以看到IP信息以上就是CentOS7中KVM的安装和简单管理.。

KVM解决方案(AVOCENT)

XX机房集中控管系统解决方案2009年9月目录1、机房集中控管系统需求分析 (3)1.1 简介 (3)1.2 客户需求 (3)2、机房集中控管系统针对性解决方案 (4)2.1 集中控制管理系统拓扑图 (4)2.2 机房方案实现概述 (5)2.3 集中控制管理针对性实现说明 (5)2.4 先进的Virtual Media管理方式 (7)2.5 Avocent机房系统资源整体解决方案特点总结 (7)3、数据中心集中控管系统产品简介 (9)4、Avocent公司介绍及解决方案成功案例 (14)4.1 Avocent公司介绍 (14)4.2 Avocent解决方案成功案例应用介绍 (16)1、机房集中控管系统需求分析1.1 简介现有先进完备的数据中心机房,由于操作人员时常需在监控室进行办公,需通过本地终端对机房内的各种服务器及串口设备进行各种统一管理。

现正在寻求一种能够满足这种需求的解决方案,以便使有关操作人员不必去到机房内也能操控所有的机房服务器和串口设备,且当系统规模扩张时仍能保持整个系统的完整性而达到管理上的简单有效。

1.2 客户需求根据通盘考虑,所有数据中心机房的众多设备需在一个整合了多种机房系统资源的集成大平台上得到统一管理,以解决因大量设备分散分布所带来的管理上的不便性,免除了众多不必要的外围设备而节省大量空间,使得各管理员可在监控室内从键盘、鼠标、显示器组成的控制台便可登陆所有的设备,方便快捷地排除机器故障,从而更有效地保障整体机房的正常运营。

具体需求如下:1)本项目KVM系统至少能控制40台设备,其中20台服务器设备,20台串口设备,用户通过KVM系统对机房设备进行全域远程控制。

2)考虑到单点故障率和布线的方便,要求单台数字KVM端口数不低于32,32口的KVM支持的并发用户数不低于2个;3)要求KVM和串口管理设备在同一集中认证平台上集中管理;在综合考虑了以上各因素及反复探讨后,我方经过反复研究,推出以下合理化方案供各位领导参考。

Avocent KVM系统使用管理手册

CentOS7.2图形化安装KVM详解、虚拟机迁移【范本模板】

2017.08。

221-1、简介KVM(Kernel-based Virtual Machine)基于内核的虚拟机.KVM是集成到Linux内核的Hypervisor,是X86架构且硬件支持虚拟化技术(Intel VT或AMD-V)的linux的全虚拟化解决方案。

它是Linux的一个很小的模块,利用Linux做大量的事,如任务调度、内存管理与硬件设备交互等.但仅有KVM模块是远远不够的,因为用户无法直接控制内核模块去作事情,你还必须有一个运行在用户空间的工具才行。

如果要让用户在KVM上完成一个虚拟机相关的操作,显然需要用户空间的东西,同时还包括IO虚拟化,所以KVM的解决方案借鉴了QEMU的东西并做了一定的修改,形成了自己的KVM虚拟机工具集和IO虚拟化的支持,也就是所谓的qemu-kvm.1-2、实验环境1)在实体机win7系统上安装VMware软件。

2)三台主机CentOS7.2 64位(在VMware里安装好,IP地址自己可以配置的,)virt—manager工具主机(图形化桌面)ip: 192.128。

228.137KVM主机1 ip: 192.128.228.200 (桥接)KVM主机2 ip: 192。

128。

228.201 (桥接)说明:下面安装virt—manager工具主机简称为“工具主机”;安装KVM虚拟机的主机简称为“KVM主机".用两个kvm主机是为了测试虚拟机迁移。

2、在KVM主机安装KVM2-0、在VMware中开启支持虚拟化,在虚拟机设置里,虚拟化勾选上,见下图红框处。

2—1、验证CPU是否支持KVM;如果结果中有vmx(Intel)或svm(AMD)字样,就说明CPU的支持的。

# cat /proc/cpuinfo |grep vmx #查看intel cpu#cat /proc/cpuinfo |grep svm #查看AMD cpu2—2、安装KVM及其依赖项# yum install qemu-kvm libvirt virt—install bridge—utils #软件包说明见页面底部附录1# lsmod | grep kvm # 验证安装结果,看到Kvm说明已经成功安装了[root@kvm1 ~]# systemctl start libvirtd #开启kvm服务[root@kvm1 ~]#systemctl enable libvirtd #设置开机自动启动[root@kvm1 ~]#systemctl status libvirtd #查看状态2—3、配置网桥模式1)先将/etc/sysconfig/network-scripts/ 目录下的网卡配置文件(ifcfg—eno16777736)备份一份(我备份到了/root/)# cp /etc/sysconfig/network—scripts/ifcfg—eno16777736 /root2)创建ifcfg—br0文件内容如下#vim ifcfg-br0TYPE="Bridge"BOOTPROTO="static”DEFROUTE="yes"PEERDNS="yes”PEERROUTES="yes”IPV4_FAILURE_FATAL=”no"IPV6INIT=”yes”IPV6_AUTOCONF="yes”IPV6_DEFROUTE=”yes”IPV6_PEERDNS=”yes"IPV6_PEERROUTES="yes"IPV6_PRIVACY=”no"IPV6_FAILURE_FATAL="no"STP="yes”DELAY="0”NAME=”br0"DEVICE=”br0”ONBOOT=”yes”IPADDR=192.168。

Centos7的KVM安装配置详解

Centos7的KVM安装配置详解KVM和虚拟化虚拟化有⼏种类型:完全虚拟化(Full virtualization), 虚机使⽤原始版本的操作系统, 直接与CPU通信, 是速度最快的虚拟化.半虚拟化(Paravirtualization), 虚机使⽤修改过的操作系统, 与hypervisor通信, hypervisor不修改请求, 直接转发给CPU和其他接⼝.软件虚拟化(Software virtualization), 使⽤模拟器运⾏原始版本的操作系统. hypervisor将虚机请求翻译为宿主系统可以理解的格式. ⽐半虚拟化更慢.容器化(Containerization). 与KVM虚拟化创建⼀个单独的内核实例不同, 容器化直接在现有的内核实例上创建互相隔离的容器环境. 容器在适⽤性上不如KVM 虚拟化, 但是更加轻量与灵活.关于KVMKVM (Kernel-based Virtual Machine) 属于完全虚拟化在内核中内置了KVM与QEMU (Quick Emulator) 集成libvirt API ⽤于管理KVMvirt-manager和virsh是libvirt提供的管理⼯具使⽤virsh edit guestname修改虚机配置⽽不是直接编辑虚机xml⽂件. 如果直接编辑虚机xml⽂件, 容易导致修改被覆盖. 通过virsh edit修改完配置后, 需要保存xml⽂件并重启虚机才能⽣效.KVM模拟的⽹络设备e1000 设备模拟 Intel E1000 network adapter (Intel 82540EM, 82573L, 82544GC).rtl8139 设备模拟 Realtek 8139 network adapter.Centos KVM环境硬件环境CPU需要⽀持虚拟化主板需要⽀持VT-x, 最好⽀持VT-dVT-x: 运⾏64bit Guest OS基本指令VT-d: 虚拟机可以直接针对硬件设备做存取,由北桥晶⽚来⽀援及BIOS来开启VT-c: 以Network为主, 要由I/O装置来⽀援, 包含Virtual Machine Direct Connect 及 Virtual Machine Device Queues两项技术, 前者使⽤了SR-IOV(Single Root I/O Virtualization).系统环境总核数 = 物理CPU个数 X 每颗物理CPU的核数总逻辑CPU数 = 物理CPU个数 X 每颗物理CPU的核数 X 超线程数# 查看物理CPU个数cat /proc/cpuinfo| grep "physical id"| sort| uniq| wc -l# 查看每个物理CPU中core的个数(即核数)cat /proc/cpuinfo| grep "cpu cores"| uniq# 查看逻辑CPU的个数cat /proc/cpuinfo| grep "processor"| wc -l# 查看物理机的cpu是否⽀持虚拟化, 找到flags部分,如果其中输出有VMX或SVM,即表明⽀持虚拟化技术。

KVM安装步骤及基本操作

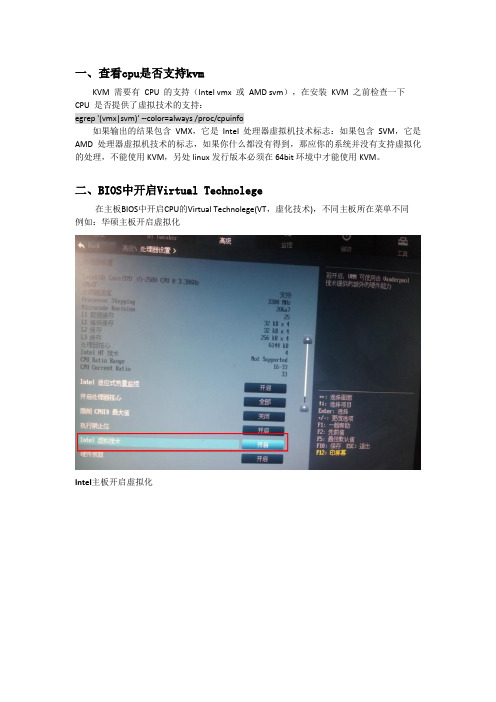

一、查看cpu是否支持kvmKVM 需要有CPU 的支持(Intel vmx或AMD svm),在安装KVM 之前检查一下CPU 是否提供了虚拟技术的支持:egrep '(vmx|svm)' --color=always /proc/cpuinfo如果输出的结果包含VMX,它是Intel处理器虚拟机技术标志:如果包含SVM,它是AMD 处理器虚拟机技术的标志,如果你什么都没有得到,那应你的系统并没有支持虚拟化的处理,不能使用KVM,另处linux发行版本必须在64bit环境中才能使用KVM。

二、BIOS中开启Virtual Technolege在主板BIOS中开启CPU的Virtual Technolege(VT,虚化技术),不同主板所在菜单不同例如:华硕主板开启虚拟化Intel主板开启虚拟化三、安装KVM服务器安装KVM 虚拟机和安装其他服务器一样,在选择操作系统类型是选择“Virtual Host”即可,其它步骤可参考“AiSchool平台安装指导”中操作系统安装部分。

如果使用此服务器管理其他KVM 主机,需要额外安装openssh-askpass软件包。

注:(已安装好的操作系统,里面有重要资料无法重新安装的可以在已有的系统上安装如下软件包yum install kvmkmod-kvmqemukvm-qemu-imgvirt-viewer virt-manager libvirtlibvirt-python python-virtinstopenssh-askpass或者如下图,安装需要的组四、检查kvm模块是否安装使用以下命令显示两个模块则表示安装完成[root@vm76 ~]# lsmod | grepkvmkvm_intel54285 0kvm 333172 1 kvm_intel以上表明安装完成五、配置宿主机1、关闭防火墙(如不用)chkconfigiptables offserviceiptables stop2、执行如下命令打开文件selinux配置文件。

KVM安装与设置

基本过程1、KVM 需要有CPU 的支持(Intel vmx或AMD svm),在安装KVM 之前检查一下CPU 是否提供了虚拟技术的支持# egrep '^flags.*(vmx|svm)' /proc/cpuinfo有显示说明CPU支持VT功能2、在主板BIOS中开启CPU的Virtual Technolege(VT,虚化技术)3、安装kvm# yum install kvmvirt-* libvirt4、检查kvm模块是否安装# lsmod | grepkvm5、启动服务# service libvirtd start6、启动界面管理# virt-manager作业环境服务器端操作系统:Red Hat Enterprise Linux Server release 6.0 (Santiago)KVM:qemu-kvm-0.12.1.2-2.113.el6.x86_64客户端操作系统:Windows 7KVM管理工具:Xming 6.9一、安装KVM及相关软件1、KVM 需要有 CPU 的支持(Intel vmx 或 AMD svm),在安装 KVM 之前检查一下 CPU 是否提供了虚拟技术的支持:[root@etone ~]# egrep '^flags.*(vmx|svm)' /proc/cpuinfo有显示, 有显示则说明处理器具有VT功能2、在主板BIOS中开启CPU的Virtual Technolege(VT,虚化技术)3、安装kvm及其需要的软件包[root@etone ~]# yum install kvmvirt-* libvirt4、检查kvm模块是否安装,使用以下命令显示两个模块则表示安装完成[root@etone ~]# lsmod | grepkvm5、客户端安装Xming远程管理软件一路默认就OK了,装到当前Win 7系统的系统盘。

二、启动virt-manager管理界面1、客户端运行Xming,需要若干设置,基本是一路默认,在“Specify parameter settings”中,勾选“No Access Control”选项。

Avocent_高性能KVM_201312

模拟KVM矩阵 vs 数字KVM切换系统

AMX模拟KVM矩阵

24

HMX数字KVM矩阵

AMX-IQ

HMX-IQ

AMX-Switch

HMX-Manager Network Switch

AMX-Station

HMX-TX

主机端: N个 AMX-IQ

→ N个 HMX-IQ

交换机端: 1个AMX-Switch → 1个 HMX-Manager + 网络交换机

宽屏支持 1360 x 768 @ 60 Hz 1280 x 720 @ 50 Hz, 60 Hz 1440 x 900 @ 60 Hz 1920 x 1154 @ 50 Hz (DVI computer only) 1920 x 1080 @ 50 Hz (DVI-D computers only) 1920 x 1200 @ 60 Hz (DVI-D computers only)

• 工业生产线 • 其他

4

业务中心场景应用特点

• 监控主机需后置到机房,确保良好的机房环境保护及主机物理安全,同时确保 监控大厅有良好工作环境(温度、噪音)

• 各席位人员需主机系统进行7x24小时轮班监控,要求图像质量好 • 部分应用系统的图像有1920*1080高清分辨率及主副双屏需求 • 各席位采用专用终端进行KVM切换,可分权管理,确保安全性 • 音视频同传,声光告警,支持KVM共享

支持

支持

支持

支持

支持 A M W o rk s 集中管理软件

支持

支持

支持

支持

方案组件③——AMX KVM监控终端

VGA接 口

电源接口

支 持 冗 余链路方式连接 至 AM X矩 阵 交换机

KVM解决方案(AVOCENT)

XX机房集中控管系统解决方案2009年9月目录1、机房集中控管系统需求分析 (3)1.1 简介 (3)1.2 客户需求 (3)2、机房集中控管系统针对性解决方案 (4)2.1 集中控制管理系统拓扑图 (4)2.2 机房方案实现概述 (5)2.3 集中控制管理针对性实现说明 (5)2.4 先进的Virtual Media管理方式 (7)2.5 Avocent机房系统资源整体解决方案特点总结 (7)3、数据中心集中控管系统产品简介 (9)4、Avocent公司介绍及解决方案成功案例 (14)4.1 Avocent公司介绍 (14)4.2 Avocent解决方案成功案例应用介绍 (16)1、机房集中控管系统需求分析1.1 简介现有先进完备的数据中心机房,由于操作人员时常需在监控室进行办公,需通过本地终端对机房内的各种服务器及串口设备进行各种统一管理。

现正在寻求一种能够满足这种需求的解决方案,以便使有关操作人员不必去到机房内也能操控所有的机房服务器和串口设备,且当系统规模扩张时仍能保持整个系统的完整性而达到管理上的简单有效。

1.2 客户需求根据通盘考虑,所有数据中心机房的众多设备需在一个整合了多种机房系统资源的集成大平台上得到统一管理,以解决因大量设备分散分布所带来的管理上的不便性,免除了众多不必要的外围设备而节省大量空间,使得各管理员可在监控室内从键盘、鼠标、显示器组成的控制台便可登陆所有的设备,方便快捷地排除机器故障,从而更有效地保障整体机房的正常运营。

具体需求如下:1)本项目KVM系统至少能控制40台设备,其中20台服务器设备,20台串口设备,用户通过KVM系统对机房设备进行全域远程控制。

2)考虑到单点故障率和布线的方便,要求单台数字KVM端口数不低于32,32口的KVM支持的并发用户数不低于2个;3)要求KVM和串口管理设备在同一集中认证平台上集中管理;在综合考虑了以上各因素及反复探讨后,我方经过反复研究,推出以下合理化方案供各位领导参考。

005-Avocent MPU-新产品资料(KVM+串口)

1.1 数据中心服务器管理交换机))数据中心服务器管理((MPU交换机MPU同时提供服务器KVM及串口管理的能力。

由于服务器的用户操作界面是有显示器、鼠标及键盘组成,简称KVM信号,因此DSView需要相关设备对KVM 信号进行采样并汇总到DSView,为用户提供一个远程IP方式的集中管理界面。

我们使用MPU交换机实现。

首先需要为每台需要管控的服务器的键盘/鼠标/显示器配置一个信号装换器,简称IQ,接口类型可选择USB或PS/2(如果需要实现远程虚拟媒体功能必须使用USB2接口的IQ),IQ服务器接口线缆将采集到服务器KVM信号转换为能在CAT5线缆传输的模拟信号,通过网线传输到DSR数字交换机的被控主机连接端口MPU的本地控制端可以直接连接一套USB接口类型的键盘、鼠标和显示器,提供运维人员进入机房在机架旁边操作管理其所连接的服务器;此外DSR数字交换机还具有2个的10/100/1000自适应网络端口,通过网络交换机将KVM信号传输到管控平台DSView上,为用户提供服务器操作界面监控应用。

KVM交换机有个重要的参数叫KVM数字通道数,由于IP-KVM技术是由KVM 交换机主板上的KVM处理芯片实现的,每个处理芯片可支持一路服务器上的鼠标/键盘/显示信号转换为IP数字信号,当IP用户通过IP-KVM对服务器进行操作时,就是由KVM处理芯片负责用户与服务器之间的操作。

因此当远程IP用户同时打开2台服务器进行操作时,就必须有2路KVM处理芯片参与,在这里,每个KVM处理芯片就称为一个KVM数字通道。

如果1台KVM交换机可最多支持远程IP 用户打开8台服务器进行操作,那么这台KVM交换机的数字通道数就为8。

及串口会话1.1.1 同时支持KVM及串口会话MPU和传统的DSR系列KVM交换机相比,MPU最大的特色就是可以同时支持服务器KVM/VM管理及基于串口管理的网络设备,只需采用不同类型的主机转换器,即可实现服务器及串口管理,如下图所示。

KVM虚拟化安装部署及管理教程

KVM虚拟化安装部署及管理教程⽬录1.kvm部署1.1 kvm安装1.2 kvm web管理界⾯安装1.3 kvm web界⾯管理1.3.1 kvm连接管理1.3.2 kvm存储管理1.3.3 kvm⽹络管理1.3.4 实例管理故障1.kvm部署1.1 kvm安装//关闭防⽕墙和selinux[root@kvm ~]# systemctl disable --now firewalld.serviceRemoved /etc/systemd/system/multi-user.target.wants/firewalld.service.Removed /etc/systemd/system/dbus-org.fedoraproject.FirewallD1.service.[root@kvm ~]# sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config[root@kvm ~]# reboot//下载epel源和⼯具包[root@kvm ~]# yum -y install epel-release vim wget net-tools unzip zip gcc gcc-c++//验证CPU是否⽀持KVM;如果结果中有vmx(Intel)或svm(AMD)字样,就说明CPU的⽀持的[root@kvm ~]# egrep -o 'vmx|svm' /proc/cpuinfo//安装kvm[root@kvm ~]# yum -y install qemu-kvm qemu-kvm-tools qemu-img virt-manager libvirt libvirt-python libvirt-client virt-install virt-viewer bridge-utils libguestfs-tools//桥接⽹卡,⽤br0来桥接ens160⽹卡[root@kvm ~]# cd /etc/sysconfig/network-scripts/[root@kvm network-scripts]# cp ifcfg-ens33 ifcfg-br0[root@kvm network-scripts]# cat ifcfg-br0TYPE=BridgeDEVICE=br0NM_CONTROLLED=noBOOTPROTO=staticNAME=br0ONBOOT=yesIPADDR=192.168.237.131NETMASK=255.255.255.0GATEWAY=192.168.237.2DNS1=114.114.114.114DNS2=8.8.8.8[root@kvm network-scripts]# cat ifcfg-ens33TYPE=EthernetBOOTPROTO=staticNAME=ens33DEVICE=ens33ONBOOT=yesBRIDGE=br0NM_CONTROLLED=no//重启⽹络[root@kvm ~]# systemctl restart network[root@kvm ~]# ip a1: lo: <LOOPBACK,UP,LOWER_UP> mtu 65536 qdisc noqueue state UNKNOWN group default qlen 1000link/loopback 00:00:00:00:00:00 brd 00:00:00:00:00:00inet 127.0.0.1/8 scope host lovalid_lft forever preferred_lft foreverinet6 ::1/128 scope hostvalid_lft forever preferred_lft forever2: ens33: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc pfifo_fast master br0 state UP group default qlen 1000link/ether 00:0c:29:7b:10:a5 brd ff:ff:ff:ff:ff:ffinet6 fe80::20c:29ff:fe7b:10a5/64 scope linkvalid_lft forever preferred_lft forever3: br0: <BROADCAST,MULTICAST,UP,LOWER_UP> mtu 1500 qdisc noqueue state UP group default qlen 1000link/ether 00:0c:29:7b:10:a5 brd ff:ff:ff:ff:ff:ffinet 192.168.237.131/24 brd 192.168.237.255 scope global br0valid_lft forever preferred_lft foreverinet6 fe80::20c:29ff:fe7b:10a5/64 scope linkvalid_lft forever preferred_lft forever4: virbr0: <NO-CARRIER,BROADCAST,MULTICAST,UP> mtu 1500 qdisc noqueue state DOWN group default qlen 1000link/ether 52:54:00:1c:33:d6 brd ff:ff:ff:ff:ff:ffinet 192.168.122.1/24 brd 192.168.122.255 scope global virbr0valid_lft forever preferred_lft forever5: virbr0-nic: <BROADCAST,MULTICAST> mtu 1500 qdisc pfifo_fast master virbr0 state DOWN group default qlen 1000link/ether 52:54:00:1c:33:d6 brd ff:ff:ff:ff:ff:ff//启动服务[root@kvm ~]# systemctl enable --now libvirtd//验证安装结果[root@kvm ~]# lsmod|grep kvmkvm_intel 188740 0kvm 637289 1 kvm_intelirqbypass 13503 1 kvm//测试[root@kvm ~]# virsh -c qemu:///system listId 名称状态----------------------------------------------------[root@kvm ~]# virsh --version4.5.0[root@kvm ~]# virt-install --version1.5.0[root@kvm ~]# ln -s /usr/libexec/qemu-kvm /usr/bin/qemu-kvm[root@kvm ~]# ll /usr/bin/qemu-kvmlrwxrwxrwx 1 root root 21 10⽉ 20 23:14 /usr/bin/qemu-kvm -> /usr/libexec/qemu-kvm//查看⽹桥信息[root@kvm ~]# brctl showbridge name bridge id STP enabled interfacesbr0 8000.000c297b10a5 no ens33virbr0 8000.5254001c33d6 yes virbr0-nic1.2 kvm web管理界⾯安装kvm 的 web 管理界⾯是由 webvirtmgr 程序提供的。

KVM延长器安装施工方案

KVM延长器安装施工方案一、项目准备1、确定所需材料和工具在项目开始前,需要明确所需的材料和工具,以确保安装进程顺利进行。

这可能包括但不限于:1.1、KVM延长器设备:发射端和接收端设备适配器、电缆和连接线1.2、设备安装支架或架子:根据安装位置选择合适的设备安装支架或架子1.3、电源和网络设备:适配器或电源线网络电缆1.4、工具箱:螺丝刀、扳手、电线剪刀、电缆固定夹等基本工具1.5、标识和标签:标识设备和电缆以方便管理2、确定安装位置在安装过程中,确保已确定并标记好KVM延长器的发射端和接收端的安装位置。

这些位置应根据以下因素确定:2.1、物理布局:确定发射端(连接至计算机)和接收端(连接至目标显示器和输入设备)的最佳位置,确保便捷访问和良好的空气流通。

2.2、电源和网络接入点:确保安装位置附近有可用的电源插座和网络接入点。

2.3、电缆长度和路径:根据设备之间的距离,计划好电缆的长度和路径,以确保适当的连接和整洁的布线。

3、联系供应商并购买所需设备与供应商沟通并购买所需的KVM延长器设备、电缆、适配器、电源设备等。

确保设备符合项目需求并满足技术规格要求。

4、安排施工时间表制定项目施工时间表,确保合理安排施工时间,并将项目分阶段进行。

考虑到设备安装、测试、培训和客户验收的时间,以确保项目顺利完成并满足客户要求。

二、安装KVM延长器发射端1、安装发射端设备架或支架根据之前确定的安装位置,安装发射端设备架或支架,确保其稳固且适合承载发射端设备。

2、连接发射端设备到计算机将KVM延长器发射端设备连接到计算机。

将KVM延长器发射端与计算机的对应端口相连接。

通常有视频、键盘、鼠标等接口。

请确保连接正确,根据设备和计算机的接口类型,选择适当的连接线缆。

确保连接牢固,所有连接应该能够完全插入,避免松动或断开。

3、连接电源和网络电缆连接发射端设备的电源线缆到可用的电源插座。

确保电源电压与设备要求相符。

如果有网络功能,连接网络电缆到发射端设备,确保设备可以联网(如果适用)。

Avocent MPU说明书

Avocent 新一代管控交换机MergePoint UnityAvocent MergePoint Unity 交换机(以下简称MPU)在单个设备中结合了 KVM over IP 和串行控制台管理技术。

这项独特的结合为 IT 管理员提供了用于访问和控制服务器、网络设备及其他数据中心和分支办公室设备的完整远程管理解决方案。

MergePoint Unity 交换机直接与物理 KVM、USB 和串行端口进行安全的远程带外连接,加强了通常通过网络接口卡完成的 IT 设备带内管理。

这种统一的方法使得 IT 管理员能够更快速地诊断、重新配置或恢复设备,以符合服务水平协议和最大程度地减少停机时间。

改善远程管理和提高员工效率9通过串行配置和/或管理控制台减少了远程诊断/配置/修理/恢复服务器、网络设备和其他硬件所需的时间。

9配合带内工具可创造出更加完善的远程管理方案,便于远程访问服务器和网络设备。

9虚拟媒体功能实现了远程 USB 连接,可将 CD-ROM 和其他 USB 大容量存储设备直接映射到远程服务器以进行文件传输/复制、更新加载或新应用程序安装等。

9集成的串行设备支持可确保与 MPUIQ-SRL 模块相连设备的物理串行端口进行安全的 SSH 连接。

9Cisco® 配置设置以电子模式连接到模块,无需任何额外的外部布线接头或特殊布线就能快速、直接地连接到 Cisco 配置端口。

提高物理安全性9提供远程智能卡/CAC 读卡器支持,可满足高级安全要求。

9通过 MergePoint Unity 交换机的虚拟媒体功能,可将智能卡读卡器从台式 PC 映射到远程服务器。

9减少了物理进入数据中心进行本地访问和控制的需要。

9MergePoint Unity 交换机使得远程用户能够在任何地点以物理方式直接连接到服务器以及其他 IT 设备的 KVM、USB 和串行端口。

增强控制能力9Avocent 电源管理配电设备 (PM PDU) 可直接连接到两个专用电源控制端口中的一个,使得管理员能通过 MergePoint Unity 交换机对正在访问的设备进行电源控制。

KVM(系统虚拟化模块)安装

KVM(系统虚拟化模块)安装Kernel-based Virtual Machine的简称,是⼀个开源的系统虚拟化模块,⾃Linux 2.6.20之后集成在Linux的各个主要发⾏版本中。

它使⽤Linux⾃⾝的调度器进⾏管理,所以相对于Xen,其核⼼源码很少。

KVM⽬前已成为学术界的主流VMM之⼀。

KVM的虚拟化需要硬件⽀持(如Intel VT技术或者AMD V技术) 。

是基于硬件的完全虚拟化。

⽽Xen早期则是基于软件模拟的Para-Virtualization,新版本则是基于硬件⽀持的完全虚拟化yum install -y qemu-kvm qemu-kvm-tools virt-manager libvirt virt-install python-virtinst⼀、 KVM虚拟机克隆⽅法1、克隆KVM虚拟机的语法和注意事项语法:virt-clone –o 原虚拟机 –n 新虚拟机 –f 新虚拟机存放的路径注:需要克隆的虚拟机必须是关机状态,不然没办法克隆。

2、克隆KVM虚拟机(centos7.0)1)关闭centos7.0虚拟机[root@xuegod110 ~]# virsh shutdown centos7.0————————————————virsh snapshot-create-as 虚拟机名称 ##创建快照virsh snapshot-list 虚拟机名称 ##查看快照virsh snapshot-revert 虚拟机名称快照名 ##利⽤快照恢复数据[root@room9pc01 ~]# clone-vm7.4请输⼊虚拟机号码:100正在创建镜像........[ok]正在创建虚拟机.......[ok][root@room9pc01 ~]# virsh start host100 ##开虚拟机域 host100 已开始[root@room9pc01 ~]# virsh snapshot-create host100 ##创建快照已⽣成域快照 1522667947[root@room9pc01 ~]# virsh snapshot-list host100 ##查看快照名称⽣成时间状态1522667947 2018-04-02 19:19:07 +0800 running[root@room9pc01 ~]# virsh snapshot-revert host100 1522667947 ##恢复数据1.安装要⽤的软件;安装软件的时,关闭selinux安装kvm模块#yum install qemu-kvm.x86_64安装kvm调试⼯具(可以不安装)#yum install qemu-kvm-tools.x86_64安装python组件,主要⽤来记录创建vm时的xml⽂件#yum install python-virtinst.noarch安装qemu组件,使⽤qemu命令来创建磁盘,启动虚拟机等(这个可能在安装时qemu-kvm.x86_64已安装)#yum install qemu-img.x86_64安装⽹络⽀持⼯具#yum install bridge-utils.x86_64安装虚拟机管理⼯具,使⽤virsh来管理虚拟机#yum install libvirt⼆.汇总:安装软件:yum -y install qemu-kvm kvm qemu-kvm qemu-img python-virtinst libvirt bridge-utils qemu-kvm-tools virt-viewer virt-v2v tunctl virt-manager libvirt-python kmod-kvm qemu三.重新启动libvirtd#/etc/init.d/libvirtd start#ps -e| grep libvirtd30706 ? 00:00:01 libvirtd四.检查kvm模块是否安装完成#lsmod | grep kvm会显⽰两个模块kvm_intel/ kvm_amdkvm五.配置⽹卡桥接[ network-scripts]# cat ifcfg-eth0 |awk '{if($0 !~ /^$/ && $0 !~ /^#/) {print $0}}'DEVICE=eth0TYPE=EthernetONBOOT=yesBOOTPROTO=noneBRIDGE=br0IPV6INIT=noHWADDR=F8:BC:12:60:99:86[ network-scripts]# cat ifcfg-br0 |awk '{if($0 !~ /^$/ && $0 !~ /^#/) {print $0}}'DEVICE=br0TYPE=BridgeONBOOT=yesBOOTPROTO=staticIPADDR=192.168.10.103GATEWAY=192.168.10.1NETMASK=255.255.255.0DNS1=192.168.10.1IPV6INIT=noDELAY=0#service network restart重启⽹络报错:弹出界⾯ br0:错误:激活连接失败:Failed to determine connection's virtual interface name解决的⽅法:#service NetworkManager stop //这个关闭掉就⾏如果以下内容就说明配置成功了:[ network-scripts]# ifconfigbr0 Link encap:Ethernet HWaddr 5E:0E:C2:8E:CC:E6inet addr:192.168.23.89 Bcast:192.168.23.255 Mask:255.255.255.0inet6 addr: fe80::5c0e:c2ff:fe8e:cce6/64 Scope:LinkUP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1RX packets:0 errors:0 dropped:0 overruns:0 frame:0TX packets:10 errors:0 dropped:0 overruns:0 carrier:0collisions:0 txqueuelen:0RX bytes:0 (0.0 b) TX bytes:636 (636.0 b)eth0 Link encap:Ethernet HWaddr 00:0C:29:EA:5F:9Ainet addr:10.10.21.13 Bcast:10.10.255.255 Mask:255.255.0.0inet6 addr: fe80::20c:29ff:feea:5f9a/64 Scope:LinkUP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1RX packets:2995655 errors:0 dropped:0 overruns:0 frame:0TX packets:40564 errors:0 dropped:0 overruns:0 carrier:0collisions:0 txqueuelen:1000RX bytes:302081352 (288.0 MiB) TX bytes:3884529 (3.7 MiB)Interrupt:19 Base address:0x2000lo Link encap:Local Loopbackinet addr:127.0.0.1 Mask:255.0.0.0inet6 addr: ::1/128 Scope:HostUP LOOPBACK RUNNING MTU:16436 Metric:1RX packets:80537 errors:0 dropped:0 overruns:0 frame:0TX packets:80537 errors:0 dropped:0 overruns:0 carrier:0collisions:0 txqueuelen:0RX bytes:8967119 (8.5 MiB) TX bytes:8967119 (8.5 MiB)virbr0 Link encap:Ethernet HWaddr 52:54:00:B2:93:53inet addr:192.168.122.1 Bcast:192.168.122.255 Mask:255.255.255.0UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1RX packets:0 errors:0 dropped:0 overruns:0 frame:0TX packets:0 errors:0 dropped:0 overruns:0 carrier:0collisions:0 txqueuelen:0RX bytes:0 (0.0 b) TX bytes:0 (0.0 b)[ network-scripts]# brctl showbridge name bridge id STP enabled interfacesbr0 8000.000c29ea5f9a no eth0 //显⽰这个okvirbr0 8000.525400b29353 yes virbr0-nic六、可以⽤virt-install ⽣成.img⽂件;来新建虚拟机了,但是启动后没办法看到所以要安装客户端来管理,也可以⽤virsh来管理但还要加VNC来连接虚拟机①安装VNC#yum install tigervnc-server.x86_64改防⽕墙:还要改⼀下iptables #vi /etc/sysconfig/iptables-A INPUT -m state --state NEW -m tcp -p tcp --dport 6900 -j ACCEPT#service iptables restart②开始新建虚拟机[ ~]# virt-install --name vmxp1 --ram 1024 --vcpus=1 --disk path=/home/kvm/img/xp1.img,size=20 --network bridge=br0 --os-variant=winxp --cdrom /home/kvm/soft/XP.iso --vnclisten=192.168.1.12 --vncport=6900 --vnc[ network-scripts]# virt-install --name=ubuntu1 --ram 1024 --vcpus=1 --disk path=/root/ubuntu1.img,size=10 --accelerate --cdrom/root/ubuntu-14.04-desktop-amd64.iso --graphics vnc,port=5920 --network bridge=br0报错:could not open disk image : Permission denied解决⽅法:[ ~]# cat /etc/libvirt/qemu.conf |awk '{if($0 !~ /^$/ && $0 !~ /^#/) {print $0}}'vnc_listen = "0.0.0.0"user = "root" //去掉注释group = "root" //去掉注释dynamic_ownership = 0 //去掉注释,把1改为0这⼀步做完,系统⽂件就好了七.启动虚拟机如果报错:[ ~]# virsh start ubuntu1错误:域已经活跃解决⽅法:[ ~]# pkill qemu-kvm[ ~]# virsh start ubuntu1域 ubuntu1 已开始[ ~]# virt-viewer ubuntu1 //进⼊图形界⾯或者进⼊系统;应⽤程序中;找到虚拟系统管理器==>配置新系统#qemu-img snapshot #创建虚拟快照#使⽤ virsh snapshot-create-as 命令进⾏⽣成快照关闭虚拟机并转换磁盘#virsh shutdown oeltest01查看虚拟状态#virsh list --allraw格式的不具备快照功能,需要raw镜像转换为qcow2格式,#qemu-img convert -f raw -O qcow2 100.img 111.img# qemu-img snapshot -l test.qcow2 #列出某个镜像的所有快照#qemu-img snapshot -a snapshot01 test.qcow2#使⽤快照附:'snapshot' is the name of the snapshot to create, apply or delete'-a' applies a snapshot (revert disk to saved state)'-c' creates a snapshot'-d' deletes a snapshot'-l' lists all snapshots in the given image3 查看虚拟机testsnp已有的快照[root@nc1 boss]# virsh snapshot-list testsnp4 可以通过snapshot-dumpxml命令查询该虚拟机某个快照的详细配置[root@nc1 boss]# virsh snapshot-dumpxml testsnp 13153850655 查看最新的快照信息[root@nc1 boss]# virsh snapshot-current testsnp6 使⽤快照,指定使⽤哪⼀个快照恢复虚拟机[root@nc1 boss]# virsh snapshot-revert testsnp snapshot027 删除指定快照[root@nc1 boss]# virsh snapshot-delete testsnp snapshot02。

KVM 安装配置和常见操作

安装KVM1、安装需要的包yum install -y bridge-utils wget lrzsz gcc gcc-c++ net-tools telnet #系统基础包yum install -yqemu-kvm libvirt virt-install bridge-utilsdocbook-utils.noarchvirt-viewer yum -y install kvm python-virtinst libvirt bridge-utils virt-manager qemu-kvm-to ols virt-viewer virt-v2vtunctl####################桥接网卡需要tunctl ##########################下载tunctl-1.5.tar.gztar xzvf tunctl-1.5.tar.gzcd tunctl-1.5makemake install2、禁用网络管理器:chkconfig NetworkManager off ##和桥接有冲突,要关闭service NetworkManager stop3、桥接网卡在/etc/sysconfig/network-scripts/ 目录新建ifcfg-br0DEVICE=br0TYPE=BridgeBOOTPROTO=staticIPV6INIT=noONBOOT=yesIPADDR=192.168.1.66NETMASK=255.255.255.0GATEWAY=192.168.1.1DNS1=8.8.8.8DELAY=0[root@vfeelit network-scripts]# cat ifcfg-eth0DEVICE=eth0TYPE=EthernetBRIDGE=br0BOOTPROTO=noneIPV6INIT=noONBOOT=yes附加说明:这里配置成桥接方式,实际上本机的数据包发送是通过br0发送的,br0的TYPE 是Bridge,其它的信息跟配置一个物理网卡一样,本机的eth0通过桥接到br0(通过BRIDGE 指定)进行通信,它根本不需要配置IP信息,实际上数据发送还是通过本机的物理网卡。

CentOS5的KVM安装使用说明

CentOS5的KVM安装使用说明1. 查看硬件是否支持虚拟化KVM需要CPU支持虚拟化,执行以下命令查看是否支持虚拟化:egrep '(vmx|svm)' --color=always /proc/cpuinfo如果含有vmx或者svm字样,则表示支持CPU虚拟化,Intel是vmx,AMD是svm。

2. 启用SELinux安装KVM之前需要启用SELinux,执行:system-config-securitylevel-tui3. 安装KVM直接在线安装KVM:yum install -y kvm kmod-kvm kvm-qemu-img libvirt python-virtinst virt-manager virt-viewer bridge-utils 安装完成后重启主机:reboot重启完成后,检查kvm模块是否加载:lsmod | grep kvm显示结果如下表示kvm模块已经加载,如果没有输出信息,则表示没有加载成功:kvm_amd 50452 0kvm 109264 1 kvm_amd4. 配置网络4.1. 配置桥接安装tunctl:yum install -y tunctl桥接网络配置文件,从ifcfg-eth0复制现有网卡的配置文件,改名为ifcfg-br0:cp /etc/sysconfig/network-scripts/ifcfg-eth0 /etc/sysconfig/network-scripts/ifcfg-br0修改ifcfg-br0,注意红色的两行,其他部分基本上不用改。

vi /etc/sysconfig/network-scripts/ifcfg-br0DEVICE=br0TYPE=BridgeBOOTPROTO=staticBROADCAST=192.168.200.255IPADDR=192.168.200.180NETMASK=255.255.255.0NETWORK=192.168.200.0ONBOOT=yes修改ifcfg-br0,注意红色的行,其他部分基本上不用改。

美国AVOCENTKVM高校机房设备集中控管系统

© 2006 AVOCENT CORPORATION

我们要解决什么问题呢?

---机房设备集中管理模式(远 程)

© 2006 AVOCENT CORPORATION

数据中心接入方式

• 通过IP网络,以用

户的身份,目的:

Web / email / database Applications 带内管理

© 2006 AVOCENT CORPORATION

高校典型应用案例

• 清华计算中心机房需求

在清华大学主楼地下一层计算中心机房,160台PS/2、 SUN、VSN服务器上运行不同的操作系统,希望统一在二 层办公室集中管理

• KVM解决方案

5台DSR2035管理160台服务器,5个本地用户用20米延长 线接至机房外的控制室,用于网络出现故障时保障服务器 的正常运行, 10个网络管理员在二层办公室管理权限内 的服务器,并可根据网速调整远程显示效果(256色、真彩 等)

© 2006 AVOCENT CORPORATION

中国典型用户

金融行业:中国银联总部,工商银行南方数据中心总部,江苏工商银行,江苏建行, 中国银行上海分行,上海太平洋保险,中银国际,进出口银行总行,花旗银行,银 河证券,民族证券,四川工商银行,友邦保险等 中国电信:上海电信IDC,广东电信IDC,江苏电信IDC,四川电信IDC,贵州电信 IDC,广州电信IDC,南京电信IDC,重庆电信IDC,深圳电信,厦门电信,沈阳电 信,东莞电信、中山电信。 中国移动:移动总部计费中心,移动总部清算中心,北京移动IDC,广东移动IDC, 江苏移动IDC,浙江移动BOSS,四川移动IDC,云南移动IDC,湖南移动IDC,新 疆移动IDC,贵州移动IDC,山东移动IDC,广州移动IDC,佛山移动,惠州移动。 中国网通:北京通信IDC,山东网通IDC,西南网通,新疆网通,网通国际,杭州 网通IDC 政府行业:上海政府,北京市政府,上海标准化院,上海公安,深圳市政府等 企业主要有:AT&T,GM,UT斯达康,LG,GE,IBM,NOKIA,MOTO,SINA 其他行业:上海电力,绍兴电力,江苏电力,腾讯QQ,北京航空、南京电视台, 中国国航

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

The Power of Being There®

Schnellinstallationsanleitung

AutoView® Switch

AutoView 3050 | 3100 | 3200 Switches

Die folgenden Anweisungen helfen Ihnen beim

Server Server

Server Server

IAC or IQ Modules

4

NOTE: The AutoView 3050/3100/3200 switches support Integrated Access Cables (IAC modules) and AVRIQ, DSRIQ and DSAVIQ modules.

Ethernet

5

2

AutoView 3100/3200

Shown

2 Connecting local peripherals

1

3

Locate your local peripherals. Plug your VGA

monitor, PS/2 or USB keyboard and mouse cables into the corresponding local connection ports.

Weitere Informationen Die aktuellen AutoView Switch-Softwareund -Firmware-Updates können Sie unserer Webseite unter entnehmen.

The Power of Being There®

Quick Installation Guide

AutoView® Switch

AutoView 3050 | 3100 | 3200 Switches

The following instructions will help you connect your AutoView switch.

Should you require further assistance, please consult your installer/user guide.

To connect an AutoView switch

1 Connecting power to the switch

Turn off all servers that will be part of your AutoView switching system. Locate the power cord that came with the switch and plug the appropriate end into the power socket on the rear panel of the switch. Plug the other end into an appropriate AC wall outlet.

Schließen Sie die VGA-Monitor-, die PS/2oder USB-Tastatur- und Mauskabel an die entsprechenden lokalen Anschlussports an.

Lokale USBVerbindung

3 Einen Server an den Switch

anschließen Wählen Sie einen verfügbaren Serverport auf der Geräterückseite des Switches aus. Schließen Sie ein Ende eines CAT 5-Kabels oder IAC-Moduls an einen nummerierten Port an. Wenn Sie ein CAT 5-Kabel verwenden, verbinden Sie das andere Ende mit dem RJ-45Anschluss eines IQ-Moduls.

4 Completing the connection

Plug the IAC or IQ module into the appropriate ports on the back of the server. Repeat this procedure for all servers that are to be connected to the switch.

5 Connecting network and remote users

Hale Waihona Puke Accessing your switch remotely

Plug a CAT 5 cable from your Ethernet network into the To access the AutoView 3050/3100/3200

Betrieb Ihres AutoView Switches.

Nähere Informationen sind in Ihrer

Installations- und Bedienungsanleitung

enthalten.

1 Den Switch mit Strom versorgen

Fahren Sie den Zielserver herunter, der an das AutoView Switching-System angeschlossen werden soll. Schließen Sie das entsprechende Ende des im Lieferumfang des Switches enthaltenen Stromkabels an den Stromanschluss auf der Rückseite des Switches an. Stecken Sie das andere Ende in eine geeignete Netzsteckdose.

AutoView switch software and firmware updates.

To Contact Avocent Technical Support: Visit /support

590-641-629B

Avocent, the Avocent logo, The Power of Being There and AutoView are registered trademarks of Avocent Corporation or its affiliates in the U.S. and other countries. All other marks are the property of their respective owners. ©2008 Avocent Corporation. All rights reserved.

So erreichen Sie den technischen Kundendienst von Avocent: Besuchen Sie /support

Avocent, das Avocent Logo, The Power of Being There und AutoView sind eingetragene Marken der Avocent Corporation oder ihrer Tochterunternehmen in den USA und anderen Ländern. Alle anderen Marken sind Eigentum der jeweiligen Unternehmen. ©2008 Avocent Corporation. Alle Rechte vorbehalten.

LAN connector on the rear of the AutoView switch.

switch remotely, point your browser to

6 Powering up targets and switch

Turn on each target server and then turn on the AutoView switch.

http://192.168.1.1 and enter Admin as the username. No password is necessary. For additional information Visit for the latest

Server Server Server Server

IAC- oder IQModule

4

HINWEIS: Die AutoView 3050/3100/3200 Switches unterstützen IAC-Module (Integrated Access Cables) und AVRIQ-, DSRIQ- und DSAVIQ-Module.

So schließen Sie einen AutoView Switch an

Ethernet

5

2

AutoView 3100/3200 abgebildet

2 Anschließen von lokalen

Peripheriegeräten

1

3

Legen Sie Ihre lokalen Peripheriegeräte bereit.

6 Zielserver und den Switch hochfahren

Schalten Sie alle Zielserver und danach den AutoView Switch ein.

Remote-Zugriff auf den Switch Geben Sie in Ihrem Browser http://192.168.1.1 ein und geben Sie Admin als Benutzernamen an, um auf den AutoView 3050, 3100 und 3200 Switch remote zuzugreifen. Ein Kennwort wird nicht benötigt.