缓存技术PPT

合集下载

服务器存储培训ppt课件(2024)

服务器存储培训 ppt课件

contents

目录

• 服务器存储概述 • 服务器存储硬件基础 • 服务器存储软件配置与管理 • 网络附加存储(NAS)技术应用 • 存储区域网络(SAN)技术应用 • 服务器虚拟化与容器化技术应用 • 总结回顾与展望未来发展趋势

01

CATALOGUE

服务器存储概述

服务器存储定义与分类

存储区域网络(SAN)技术应用

SAN架构原理及优势分析

架构原理

通过专用高速网络将多个存储设备连接起来,形成一个存储区域网络 ,提供高可用性、高性能、可扩展的存储服务。

高性能

SAN采用高速光纤通道技术,提供极高的数据传输速率和低延迟,满 足高性能应用需求。

高可用性

SAN具备冗余设计和故障切换功能,确保数据的可靠性和业务的连续 性。

降低成本

虚拟化技术可以减少物理服务器的数量,从而降 低硬件成本、维护成本和管理成本。

提高资源利用率

通过虚拟化技术,可以将物理服务器的资源利用 率提高到80%以上,避免资源浪费。

提高业务连续性

虚拟化技术可以实现快速部署、备份和恢复,提 高业务连续性和数据安全性。

容器化技术原理及优势分析

01

容器化技术原理

优化文件系统性能

通过调整文件系统参数(如块大小、inode数量等),以及使用RAID、SSD等硬件技术, 提高文件系统的I/O性能和数据可靠性。

定期监控和维护文件系统

定期检查文件系统的状态和使用情况,及时处理出现的问题,如修复损坏的文件系统、清 理无用文件等。

数据备份恢复策略制定和实施

制定备份策略

硬盘驱动器类型与性能参数

接口类型

硬盘与主板连接的接口,如SATA、SAS等,影响数据传输速 度。

contents

目录

• 服务器存储概述 • 服务器存储硬件基础 • 服务器存储软件配置与管理 • 网络附加存储(NAS)技术应用 • 存储区域网络(SAN)技术应用 • 服务器虚拟化与容器化技术应用 • 总结回顾与展望未来发展趋势

01

CATALOGUE

服务器存储概述

服务器存储定义与分类

存储区域网络(SAN)技术应用

SAN架构原理及优势分析

架构原理

通过专用高速网络将多个存储设备连接起来,形成一个存储区域网络 ,提供高可用性、高性能、可扩展的存储服务。

高性能

SAN采用高速光纤通道技术,提供极高的数据传输速率和低延迟,满 足高性能应用需求。

高可用性

SAN具备冗余设计和故障切换功能,确保数据的可靠性和业务的连续 性。

降低成本

虚拟化技术可以减少物理服务器的数量,从而降 低硬件成本、维护成本和管理成本。

提高资源利用率

通过虚拟化技术,可以将物理服务器的资源利用 率提高到80%以上,避免资源浪费。

提高业务连续性

虚拟化技术可以实现快速部署、备份和恢复,提 高业务连续性和数据安全性。

容器化技术原理及优势分析

01

容器化技术原理

优化文件系统性能

通过调整文件系统参数(如块大小、inode数量等),以及使用RAID、SSD等硬件技术, 提高文件系统的I/O性能和数据可靠性。

定期监控和维护文件系统

定期检查文件系统的状态和使用情况,及时处理出现的问题,如修复损坏的文件系统、清 理无用文件等。

数据备份恢复策略制定和实施

制定备份策略

硬盘驱动器类型与性能参数

接口类型

硬盘与主板连接的接口,如SATA、SAS等,影响数据传输速 度。

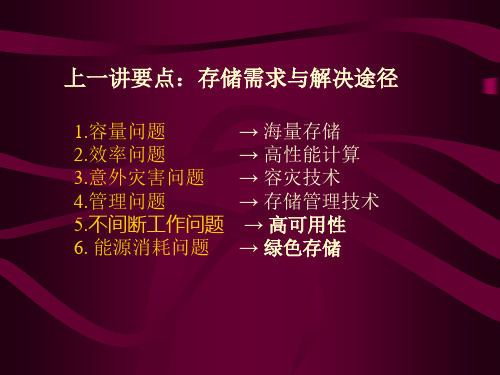

第二讲:高速缓存技术

2.1读算法(常用两种) 读算法(常用两种) 读算法 •最近使用(LRU:least recently used)缓存 最近使用( 最近使用 : ) •预先读缓存 预先读缓存

LRU的基本思想:最近读过的数据不久将再次被读。 的基本思想:最近读过的数据不久将再次被读。 的基本思想

缓存内存

操作期间, 在I/O操作期间,读磁盘 操作期间 数据的同时, 数据的同时,数据也拷 贝到缓存 响应 请求

2)设备/子系统中的预先读缓存与在主机内实现不同,它不额 )设备 子系统中的预先读缓存与在主机内实现不同 子系统中的预先读缓存与在主机内实现不同, 外增加主机CPU的负担,及降低竞争主机资源进程的干扰。 的负担, 外增加主机 的负担 及降低竞争主机资源进程的干扰。

3)设备/子系统中透写缓存 对I/O吞吐量要求不高,写操作较 )设备 子系统中透写缓存 吞吐量要求不高, 吞吐量要求不高 少的应用时,透写缓存的效果较好。 少的应用时,透写缓存的效果较好。

磁盘 缓存

图 2.12

设备/子系统中的缓存实现 设备 子系统中的缓存实现

1)设备/子系统中的 )设备 子系统中的 子系统中的LRU缓存效率不如在主机内的缓存系统, 缓存效率不如在主机内的缓存系统, 缓存效率不如在主机内的缓存系统 但它适用主机负荷重的场合(超过75%),或没有适当内存建缓 但它适用主机负荷重的场合(超过 ) 或没有适当内存建缓 存。

1)主机系统的LRU缓存 )主机系统的 缓存 在传输数据并将其装入主 机内存的过程中, 机内存的过程中,LRU对系统性能影响 很小。在主 对系统性能影响 很小。 机内存中实现LRU效率很高。 效率很高。 机内存中实现 效率很高 要消耗更多的CPU周期、 周期、 2)主机系统的预先缓存 要消耗更多的 ) 周期 存储路径、系统I/O总线和系统存储总线的带宽 总线和系统存储总线的带宽。 存储路径、系统 总线和系统存储总线的带宽。 3)主机系统中的透写缓存 ) 一致。 一致。 并可避免数据数据的不

Memcached 缓存技术介绍

优化

调试块大小 使用 Growth Factor进行调试: 启动时指定 Growth Factor(通过 -f选项),可以适当控制 slab差异,默认值为1.25。

以 verbose模式启动 Memcached: 默认 Growth Factor输出(f=1.25): # memcached -m 1024 -c 40960 -u root -p 11219 -P /var/run/m11219.pid -vv slab class 1: chunk size 96 perslab 10922 slab class 2: chunk size 120 perslab 8738 slab class 3: chunk size 152 perslab 6898 slab class 4: chunk size 192 perslab 5461 …… 设置 Growth Factor为 2倍(f=2): # memcached -m 1024 -c 40960 -u root -p 11219 -P /var/run/m11219.pid -f2 -vv slab class 1: chunk size 96 perslab 10922 slab class 2: chunk size 192 perslab 5461 slab class 3: chunk size 384 perslab 2730 slab class 4: chunk size 768 perslab 1365 …… 输出可见,从192字节的组开始,组大小依次增大为原来的 2倍。 这样设置后,slab之间的差别比较大,有些情况下会浪费内存。 通过重新计算数据的预期平均长度,调整 growth factor,以获得最恰当的内存使用。

命中率

cache结构与操作.ppt

e tc

tc

11

ta htc (1 h)tm h (1 h)r r (1 r)h

(4-4)

其中,r=tm/tc,表示访问主存慢于访问 Cache的倍率。r的取值一般是5-10 。

例【4-1】设CPU执行一般程序时,访问 Cache次数Nc=1500,访问主存次数Nm=90,又假 设访问Cache存取周期为50ns,访问主存存取周期 为300ns,试求h、r、ta以及e的值

存储器系统的层次关 系

2、Cache命中率

从微机系统来看,增加Cache的目 的,就是要在性能上使主存的平均访问 时间尽可能接近Cache的访问时间,即 保证在大多数情况下,CPU访问Cache, 而不是访问主存。

在 某 一 程 序 执 行 期 间 , 设 Nc 表 示 CPU 访 问 Cache 的 总 次 数 , Nm 表 示 CPU 访 问 主 存 的 总 次数,h为命中率,则

·优点:灵活,不易产生冲突; 缺点:比较电路难于实现,且效率低,速度慢

• 例:设访问存储器地址的块号序列为22、26、 22、26、16、4、16、18,采用全相联映射方 式时,Cache行分配情况

2.直接映射方式

某一主存块只能能映射到Cache的特定行

i = j mod m 其中: i:Cache的行号; j:主存的块号; m:Cache的总行数

解:

h Nc 1500 0.943

N cNm 1500 90

r tm 300 ns 6 tc 50ns

ta=htc+(1-h)tm=0.943×50ns+(1-0.943)×300ns=64.25ns

e tc 50ns 77.82% ta 64.25ns

4.6.2 Cache组织方式

存储技术入门介绍ppt课件

12

12

2.1Raid相关技术

Raid产生的原因

• CPU运算速度飞速 提高,数据读写速 度不应该成为计算 机系统处理的瓶颈

容量

性能

可靠性

• 计算机发展初期, 大容量硬盘价格非 常高,而需要存储 的数据量越来越大

13

• 信息时代,数据对 企业和个人的重要 性越来越大,数据 存储安全更需要保 障

RAID

•JBOD:AS300J、AS500J、FF4G16

•单控制器阵列:如AS300N-M1、AS500N2-M2、AS500N6

•双控制器阵列:如AS500G、AS500E、AS500H、 AS600G3、AS1000G3、AS1000G6、AS2000

按主机接口的类型分

•FC阵列:AS500E、AS500G、AS600G3、 AS1000G3、AS1000G6、AS2000

4、存储系统的产品组成 5、存储应用

5.1 存储前端应用技术介绍 5.2 存储发展趋势及相关热点 5.3 存储应用方案简析

11

11

2.1Raid相关技术

RAID基本概念——定义

RAID (Redundant Array of Independent Disks)即独立磁盘冗余阵 列,RAID技术将多个单独的物理硬盘以不同的方式组合成一个逻辑硬盘,从而 提高了硬盘的读写性能和数据安全性

存储连接设备

✓光纤HBA卡 ✓SAS RAID卡 ✓SCSI卡 ✓光纤交换机 ✓光纤连接线缆

6

存储软件

存储内置软件

✓存储管理软件 ✓数据镜像软件 ✓数据复制软件 ✓路径冗余软件 ✓数据快照软件

其他存储软件

✓双机高可用 ✓存储虚拟化 ✓数据备份容灾 ✓数据归档 ✓数据迁移

CDN技术PPT课件

CDN工作原理

• 集群抗攻击

集群抗攻击 广泛分布的CDN节点加上节点之间的 智能冗余机制,可以有效地预防黑客入侵以及降低 各种DoS攻击对网站的影响,同时保证较好的服务 质量 。

CDN具体应用

CDN工作原理

• 设计思路

CDN简介 CDN作用

• 原理介绍

CDN工作原理

CDN具体应用

CDN基本设计思路

CDN简介

CDN简介

CDN作用

• •

CDN – Content Delivery Networks 以现有互联网为基础的专业化综合应用平台,为网站提供高 效、稳定、安全的内容和应用的分布、加速服务(MPLS) 由分布在网络边缘的应用服务器群组成 通过应用层的内容智能路由,自动保证用户实现就近访问

CDN工作原理

Squid:用Squid设置一台机器为代理服务器 首先安装squid sudo apt-get install squid 然后看一下squid安装到那里了 whereis squid 修改squid的配置文件 sudo gedit /etc/squid/squid.conf 然后,定位到 # And finally deny all other access to this proxy http_access deny all #这里把deny改成allow就可以让任意用户通过你的机器作为代 理了 隔几行下面两句: #Default: #http_reply_access allow all //把这句的注释去掉 第三步:启动Squid sudo squid -z sudo /etc/init.d/squid reload sudo /etc/init.d/squid restart 这样你的代理服务器默认端口是3128,你就可以在其他机器上设置此机器为代理 了。

2024年度-计算机硬件PPT课件

碳纳米管

一种新型纳米材料,可应用于制造更 小、更快、更节能的计算机芯片。

柔性电子

可弯曲、可折叠的电子设备,为可穿 戴设备和物联网等领域带来创新。

45

未来硬件发展趋势预测

人工智能硬件

AI芯片、智能传感器等将推动人工智能技术 在各领域的广泛应用。

边缘计算硬件

随着云计算向边缘延伸,边缘计算硬件将实 现更高效的数据处理和分析。

正确安装

按照说明书和主板标识正确安装各个部件,避免插错或损坏。

37

硬件组装步骤与注意事项

散热处理

确保CPU、显卡等发热部件的散热器安装 牢固,散热膏涂抹均匀。

VS

连接稳固

连接线需插入到位,避免松动或接触不良。

38

常见故障诊断及排除方法

开机无显示 检查电源是否插好,电源线是否损坏。 检查显示器连接线是否插好,显示器是否开启。

检查硬盘或光驱是否损坏,或更换硬 盘或光驱尝试。

检查主板SATA接口是否损坏,或更换 SATA数据线尝试。

42

硬件维护技巧与建议

注意散热

确保CPU、显卡等发热部件的 散热器工作正常,定期更换散 热膏。

定期备份数据

定期备份重要数据,以防硬盘 故障导致数据丢失。

定期清理灰尘

定期清理机箱内部的灰尘,保 持硬件清洁,避免散热不良。

ROM(只读存储器)

13

内存储器类型及特点

断电后数据保留

用于存储固定信息,如BIOS芯片 14

外存储器类型及特点

硬盘 容量大,价格相对较低

读写速度较慢

15

外存储器类型及特点

长期保存数据 固态硬盘(SSD)

读写速度快

16

外存储器类型及特点

与程序员相关的CPU缓存知识

被缓存到任何一个Cache Line中

另一种方式,为了降低缓存搜索算法,使用类似

2

H a s h Ta b l e 这 样 的 数 据 结 构 , 但 是 使 用 Ha sh

Ta b l e 就 有 可 能 存 在 h a sh 冲 突 的 问 题

3

为了避免上述两种方案的缺点,采用了N-

Way关联方式

速度变慢

2. 多个CPU需 要同步缓存信息, Cache与RAM 的速度差距大, 多级不同尺寸的 缓存,有利于提

高整体性能

基础知识

1. 缓存命中率问题

2. 缓存更新的一致 性问题

02 缓存命中

Cache Line

主流的CPU的Cache Line

大小是 16个3

6 2

4 位

Byt 整型

es;64 ,是CP

从CPU硬件层面,有两种解决方法

1. Directory 协议

这种方法的典型实现是要设计一个集中式的控制器, 他是主存储器控制器的一部分。其中一个目录存在再 主存中,其中包含了有关各种本地缓存内容的全局状 态信息。当单个CPU Cache发出读写请求时,这个 集中式控制器会检查并发出必要的命令,以在主存和 CPU Cache或CPU Cache质检进行数据同步和传输

4

对于L2/L3 同样采用 N-Way的方法

5

缓存淘汰算法有两种

内存地址映射缓 存的方法

内存地址映射缓存的方法

一种方式是任何一个内存地址的数据都可以被缓存到任何一个Cache Line中

有点:最灵活 缺点:当需要确定内存是否存在于Cache中时,需要进行O(n)复杂度的

Cache遍历,效率很低

内存地址映射缓存的方法

2024版IT运维管理解决方案PPT课件

降低成本

有效的IT运维管理能够降 低故障发生率和重复性问 题,从而减少维修成本和 资源浪费。

IT运维管理现状及挑战

现状

当前,许多企业已经建立了初步的IT运维管理体系,但仍存在管理不规范、流程不清晰、人员技能不足等问题。

挑战

随着企业业务的快速发展和IT技术的不断创新,IT运维管理面临着越来越多的挑战,如复杂性增加、安全性威胁、 数据增长等。为了应对这些挑战,企业需要不断完善IT运维管理体系,提高管理水平和效率。

利用专业工具

使用专门的故障诊断工具,如 Wireshark、strace等,提高排查效 率。

典型案例分析与经验总结

案例一

服务器宕机故障排查

案例三

存储读写故障排查

案例二

网络中断故障排查

经验总结

掌握基础设施监控和故障排查的基本方法和技巧, 积累实践经验,提高应对突发故障的能力。同时, 不断完善监控策略和故障排查流程,提高运维管理 水平和效率。

知识共享平台搭建和内容更新机制

知识库建设

构建统一的知识库,分类存储运维过程中的经验、 技巧、案例等。

内容更新与维护

制定知识库内容更新和维护机制,确保知识的时 效性和准确性。

ABCD

知识共享平台选择

选用适合团队的知识共享平台,如企业内部 Wiki、在线文档协作工具等。

知识推广与应用

通过培训、分享会等形式推广知识库,提高团队 成员的知识应用水平。

IT运维管理解决方案PPT课件

目录

• IT运维管理概述 • IT运维管理解决方案设计 • 基础设施监控与故障排查 • 应用系统性能优化与提升 • 数据安全与隐私保护策略部署 • 团队协作与知识共享机制建立 • 总结与展望

Cache基础知识介绍ppt课件

+ CPU在访问内存时,首先判断所要访问的内容是否在 cache中,如果在,则称为命中(hit),此时CPU直接从 cache中调用该内容;否则称为未命中(miss), CPU会 通过cache对主存中的相应内容进行操作。

5

Cache与主存之间可以采取的地址映射方式有 以下三种:

+ 全相联映射方式 + 直接相联映射方式 + 组组相联映射方式

9

10

+ 块:块是cache与主存的传输单位。 + 路(way): 路是组相联映射方式的cache结构中的

基本存储单位,每一路存储一个块的数据。 + 组(entry):组是组相联映射方式的cache对块进行

管理的单位。 + 区 (tag) :块的地址对应的主存储器中的区。 + 块内偏移地址(offset): 用来标示块内一个字节的

存。 优点:速度较高。 缺点:可靠性较差,控制操作比较复杂。

20

+ 对于多个主设备的共享存储总线系统,如带有DMA 的系统,或者多处理器系统,由于其他的主设备也 可以改变主存的内容,而这种改变是cache无法得知 的,因此必须对cache的一致性问题进行处理。

CPU

Cache

X`

DMA

主存储器

X``

7

+ 直接相联方式 地址映射规则: 主存储器中一块只能映射到 cache的一个特定的块中。 (1) 主存与cache分成相同大小的数据块。 (2) 主存容量应是cache容量的整数倍,将主存 空间按cache的容量分成区,主存中每一区的 块数与cache的总块数相等。 (3) 主存中某区的一块存入cache时只能存入缓 存中块号相同的位置。 优点:地址映射方式简单,数据访问时,只需 检查区号是否相等即可,因而可以得到比较快 的访问速度,硬件设备简单。 缺点:替换操作频繁,命中率比较低。

5

Cache与主存之间可以采取的地址映射方式有 以下三种:

+ 全相联映射方式 + 直接相联映射方式 + 组组相联映射方式

9

10

+ 块:块是cache与主存的传输单位。 + 路(way): 路是组相联映射方式的cache结构中的

基本存储单位,每一路存储一个块的数据。 + 组(entry):组是组相联映射方式的cache对块进行

管理的单位。 + 区 (tag) :块的地址对应的主存储器中的区。 + 块内偏移地址(offset): 用来标示块内一个字节的

存。 优点:速度较高。 缺点:可靠性较差,控制操作比较复杂。

20

+ 对于多个主设备的共享存储总线系统,如带有DMA 的系统,或者多处理器系统,由于其他的主设备也 可以改变主存的内容,而这种改变是cache无法得知 的,因此必须对cache的一致性问题进行处理。

CPU

Cache

X`

DMA

主存储器

X``

7

+ 直接相联方式 地址映射规则: 主存储器中一块只能映射到 cache的一个特定的块中。 (1) 主存与cache分成相同大小的数据块。 (2) 主存容量应是cache容量的整数倍,将主存 空间按cache的容量分成区,主存中每一区的 块数与cache的总块数相等。 (3) 主存中某区的一块存入cache时只能存入缓 存中块号相同的位置。 优点:地址映射方式简单,数据访问时,只需 检查区号是否相等即可,因而可以得到比较快 的访问速度,硬件设备简单。 缺点:替换操作频繁,命中率比较低。

使用缓存数据PPT课件

System.out.println("用户名:"+u2.getLoginName());

}

7

15.2 一级缓存

3.在一个Session中先save,再执行load查询

@Tes在t 测试类HibernateTest中添加testSessionCache_3()方

法pu,bl并ic 使vo用id@tTeessttSe注ss解io加nCa以ch修e_3饰(),{ 在一个session中先执行save

@Test 1.一个session中发出两次get查询 public将vo项id目tehsitbSeesrsniaotneCa-c1h0e复_1(制){并命名为“hibernate-11”,

User u1=(User)session.get(User.class, 1);

再导入Sys到teMm.yoEuctl.ipprisnet开ln(发"用环户境名中:"。+u在1.g项et目LoghiinbNearmen(a)t)e;-10的测试 类HibUeserrnaut2e=(TUessetr)中se添ssi加ont.egestt(SUessers.icolnaCssa,ch1e)_;1()方法,并使用 @}TestS注yst解em加.ou以t.修pr饰int,ln在("用同户一名个:s"e+sus2.igoent中Log发in出Na两me(次))g;et查询。

要经缓常到存数和据外库置里缓查询存,。那就没有必要用缓存了。

务的生Se(命s1s周) i事期on,务的当范事围缓务:存结缓束存是时只内,能缓被置存当的也前,就事结务不束访能生问命。被周缓卸期存。的载在生,此命范周也围期被下依,赖称缓于为存事 的介H质i是be内rn存a。te的第一级缓存。SessionFactory的缓存又被称为

}

7

15.2 一级缓存

3.在一个Session中先save,再执行load查询

@Tes在t 测试类HibernateTest中添加testSessionCache_3()方

法pu,bl并ic 使vo用id@tTeessttSe注ss解io加nCa以ch修e_3饰(),{ 在一个session中先执行save

@Test 1.一个session中发出两次get查询 public将vo项id目tehsitbSeesrsniaotneCa-c1h0e复_1(制){并命名为“hibernate-11”,

User u1=(User)session.get(User.class, 1);

再导入Sys到teMm.yoEuctl.ipprisnet开ln(发"用环户境名中:"。+u在1.g项et目LoghiinbNearmen(a)t)e;-10的测试 类HibUeserrnaut2e=(TUessetr)中se添ssi加ont.egestt(SUessers.icolnaCssa,ch1e)_;1()方法,并使用 @}TestS注yst解em加.ou以t.修pr饰int,ln在("用同户一名个:s"e+sus2.igoent中Log发in出Na两me(次))g;et查询。

要经缓常到存数和据外库置里缓查询存,。那就没有必要用缓存了。

务的生Se(命s1s周) i事期on,务的当范事围缓务:存结缓束存是时只内,能缓被置存当的也前,就事结务不束访能生问命。被周缓卸期存。的载在生,此命范周也围期被下依,赖称缓于为存事 的介H质i是be内rn存a。te的第一级缓存。SessionFactory的缓存又被称为

微机原理 第五章 IO接口PPT课件

• I/O指令

• I/O保护

⑴ 寄存器I/O指令(IN,OUT)

允许在累加器和I/O端口间交换数据 • 8位立即数直接寻址端口的I/O指令 • DX间接寻址端口的I/O指令

⑵ 串数据I/O指令

允许在存储器和I/O端口间交换数据

5.2.3 80X86系列处理器的I/O编址方式

5-1111121

• I/O地址 空间

●两个相邻的8位端口可构成一个16位端口, 一般应对准于偶数地址。

●4个相邻的8位端口可构成一个32位端口 (80386以上),一般应对准于能被4整除的地址。

实 际 的 80X86 系 统 中 只 使 用 了 1K 字 节 的 I/O空间,即只用A9~A0这十根地址线对I/O 寻址,并且对这1K字节的I/O地址空间也大都 按AT系统的技术标准作了分配。

2.中断式

• 接口简单,硬件电路不多,查询程序也不复 杂。

3.DMA式 4.等待式

(4)缺点:

在MPU使用效率与响应实时性间有矛盾, 软件开销大,MPU使用效率低。

这种I/O控制方式是优是劣,不能一概而论, 要看具体应用场合。

5.3 I/O同步控制方式

5-1111129

1.查询式

(1)特点:每次I/O操作都是由I/O设备向

• MPU访问I/O端口 必须采用专用I/O指 令。

5.2.2 隔离I/O方式

20 AB 20

MPU 8 DB

8

R/W

控制

MEMR

MEMW

控

制

8

逻

8

辑

IOR

IOW

存储器 (1MB)

I/O 端口 (256个)

5-1111115

2.优点:

• I/O保护

⑴ 寄存器I/O指令(IN,OUT)

允许在累加器和I/O端口间交换数据 • 8位立即数直接寻址端口的I/O指令 • DX间接寻址端口的I/O指令

⑵ 串数据I/O指令

允许在存储器和I/O端口间交换数据

5.2.3 80X86系列处理器的I/O编址方式

5-1111121

• I/O地址 空间

●两个相邻的8位端口可构成一个16位端口, 一般应对准于偶数地址。

●4个相邻的8位端口可构成一个32位端口 (80386以上),一般应对准于能被4整除的地址。

实 际 的 80X86 系 统 中 只 使 用 了 1K 字 节 的 I/O空间,即只用A9~A0这十根地址线对I/O 寻址,并且对这1K字节的I/O地址空间也大都 按AT系统的技术标准作了分配。

2.中断式

• 接口简单,硬件电路不多,查询程序也不复 杂。

3.DMA式 4.等待式

(4)缺点:

在MPU使用效率与响应实时性间有矛盾, 软件开销大,MPU使用效率低。

这种I/O控制方式是优是劣,不能一概而论, 要看具体应用场合。

5.3 I/O同步控制方式

5-1111129

1.查询式

(1)特点:每次I/O操作都是由I/O设备向

• MPU访问I/O端口 必须采用专用I/O指 令。

5.2.2 隔离I/O方式

20 AB 20

MPU 8 DB

8

R/W

控制

MEMR

MEMW

控

制

8

逻

8

辑

IOR

IOW

存储器 (1MB)

I/O 端口 (256个)

5-1111115

2.优点:

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

对象缓存分类

对映射数据库表记录的entity对象进行缓存 对1对n关系的集合进行缓存 对n对1关系的关联对象进行缓存

Hibernate对象缓存配置

配置entity对象缓存 对象缓存 配置

@Entity @Cache(usage = CacheConcurrencyStrategy.NONSTRICT_READ_WRITE) public class Forest { ... }

Oracle的raw device(裸设备) – 直接抛弃文件系统 MySQL的InnoDB: innodb_flush_method = O_DIRECT

Windows的Disk Cache

Linux的Disk Cache

数据库缓存的重要性

为什么数据库非常依赖缓存?

数据库通常是企业应用系统最核心的部分 数据库保存的数据量通常非常庞大 数据库查询操作通常很频繁,有时还很复杂 以上原因造成数据库查询会引起非常频繁的磁盘I/O读取 操作,迫使CPU挂起等待,数据库性能极度低下

Servlet缓存

针对URL访问返回的页面结果进行缓存,适 用于粗粒度的页面缓存,例如新闻发布 可以进行权限的检查 OScache提供了简单的Servlet缓存(通过 web.xml中的配置) 也可以自己编程实现Servlet缓存

OSCache Servlet缓存示例

<filter> <filter-name>CacheFilter</filter-name> <filter-class>com.opensymphony.oscache.web.filter.CacheFilter</filter-class> <init-param> <param-name>time</param-name> <param-value>600</param-value> </init-param> <init-param> <param-name>scope</param-name> <param-value>session</param-value> </init-param> </filter> <filter-mapping> <filter-name>CacheFilter</filter-name> <url-pattern>/news/*</url-pattern> </filter-mapping>

MySQL Query Cache监控工具

show status like 'Qcache%'; mysqlreport脚本 MySQL Administrator

Query Cache状态示例

__ Query Cache ______________________________________________ Memory usage 25.77M of 64.00M %Used: 40.26 Block Fragmnt 24.73% Hits 6.98M 3.2/s Inserts 100.87M 46.9/s Insrt:Prune 34.15:1 45.5/s Hit:Insert 0.07:1

缓存技术浅谈

Robbin Fan

缓存是什么,解决什么问题?

Cache是高速缓冲存储器 一种特殊的存储器 子系统,其中复制了频繁使用的数据以利于 快速访问 凡是位于速度相差较大的两种硬件/软件之间 的,用于协调两者数据传输速度差异的结构, 均可称之为 Cache

基于Web应用的系统架构图

浏览器 Web服务器 应用服务器 数据库

Hibernate查询缓存会自动清理过期缓存

一旦结果集涉及的entity被修改,查询缓存就被自动清理

页面缓存

页面缓存的作用是什么?

针对页面的缓存技术不但可以减轻数据库服务器压力, 还可以减轻应用服务器压力 好的页面缓存可以极大提高页面渲染速度 页面缓存的难点在于如何清理过期的缓存

页面缓存技术有哪些?

MySQL buffer 监控工具

show innodb status\G show status like 'innodb%'; mysqlreport脚本 innotop

InnoDB buffer状态示例

__ InnoDB Buffer Pool ______________________________________ Usage 1000.00 of 1000.00 %Used: 100.00 Read hit 99.99% Pages Free 0 %Total: 0.00 Data 59.69k 93.26 % Drty: 0.02 Misc 4311 6.74 Latched 0 0.00 Reads 60.30G 28.0k/s From file 7.01M 3.3/s 0.01 Ahead Rnd 98684 0.0/s Ahead Sql 9548 0.0/s Writes 86.79M 40.3/s Flushes 14.08M 6.5/s Wait Free 0 0/s

操作系统的文件系统

Web应用架构

存储设备

Web应用系统存在哪些速度差异?

读取文件系统 读取数据库内存 读取应用内存 读取静态文件 读取浏览器缓存 读取磁盘 读取文件系统 访问数据库服务器 访问应用服务器 访问网站

缓存技术分类

操作系统磁盘缓存 数据库缓存 应用程序缓存 Web服务器缓存 客户端浏览器缓存 减少磁盘机械操作 减少文件系统I/O 减少对数据库的查询 减少应用服务器请求 减少对网站的访问

Data Buffer

data buffer是数据库数据在内存中的容器 data buffer的命中率直接决定了数据库的性 能 data buffer越大越好,多多益善 MySQL的InnoDB buffer: innodb_buffer_pool_size = 2G MySQL建议buffer pool开大到服务器物理内 存60-80%

配置关联集合的缓存

@OneToMany(cascade=CascadeType.ALL, fetch=FetchType.EAGER) @JoinColumn(name="CUST_ID") @Cache(usage = CacheConcurrencyStrategy.NONSTRICT_READ_WRITE) public SortedSet<Ticket> getTickets() { return tickets; } 仅仅添加Annotation就可以了,无须编码,即可自动享受对象缓存。Hibernate会拦截 对象的CRUD操作,针对对象读取操作进行缓存,针对对象修改操作自动清理缓存

数据库有哪些缓存策略?

Query Cach为key值缓存查询结果集 一旦查询涉及的表记录被修改,缓存就会被 自动删除 设置合适的Query Cache会极大提高数据库 性能 Query Cache并非越大越好,过大的Qquery Cache会浪费内存。 MySQL: query_cache_size= 128M

Hibernate二级缓存是提升web应用性能的法宝

OLTP类型的web应用,由于应用服务器端可以进行群集水平扩展,最终 的系统瓶颈总是逃不开数据库访问; 哪个框架能够最大限度减少数据库访问,降低数据库访问压力,哪个框 架提供的性能就更高; 针对数据库的缓存策略: 对象缓存:细颗粒度,针对表的记录级别,透明化访问,在不改变 程序代码的情况下可以极大提升web应用的性能。对象缓存是ORM 的制胜法宝。 对象缓存的优劣取决于框架实现的水平,Hibernate是目前已知对象 缓存最强大的开源ORM 查询缓存:粗颗粒度,针对查询结果集,应用于数据实时化要求不 高的场合

操作系统缓存概述

文件系统提供的Disk Cache:操作系统会把经常访问到的文 件内容放入到内存当中,由文件系统来管理 当应用程序通过文件系统访问磁盘文件的时候,操作系统从 Disk Cache当中读取文件内容,加速了文件读取速度 Disk Cache由操作系统来自动管理,一般不用人工干预,但 应当保证物理内存充足,以便于操作系统可以使用尽量多的 内存充当Disk Cache,加速文件读取速度 特殊的应用程序对文件系统Disk Cache有很高的要求,会绕 开文件系统Disk Cache,直接访问磁盘分区,自己实现Disk Cache策略

页面局部缓存

针对动态页面的局部片断内容进行缓存,适 用于一些个性化但不经常更新的页面(例如博 客) OSCache提供了简单的页面缓存 可以自行扩展JSP Tag实现页面局部缓存

OSCache的页面局部缓存

<%@ taglib uri="/oscache" prefix="cache" %> <cache:cache> ... some jsp content ... </cache:cache> <cache:cache key="foobar" scope="session"> ... some jsp content ... </cache:cache> <cache:cache key="<%= product.getId() %>" time="1800" refresh="<%= needRefresh %>"> ... some jsp content ... </cache:cache> <cache:cache key="<%= product.getId() %>" cron="0 2 * * *" refresh="<%= needRefresh %>"> ... some jsp content ... </cache:cache>