大数据项目之电商数仓(4即席查询数据仓库)V6.3.0

大数据:数据仓库和数据集市的比较

大数据:数据仓库和数据集市的比较随着科技的发展,数据成为了当下最热门的话题之一。

随着互联网的普及和各行各业的信息化建设与发展,数据规模与数据类型也日益增加。

面对如此巨大的数据量,如何正确地处理和分析数据,如何从中发现有价值的信息,也日益成为了各个企业必须面对的挑战。

在处理这些大数据时,数据仓库和数据集市是两种常见的数据存储和分析方式。

本文将详细比较数据仓库和数据集市的优缺点。

一、数据仓库数据仓库是指将企业内部不同系统中的数据进行收集和汇总,形成一个一致且具有高性能的数据存储库,并且保证数据的一致性、可更新性和可查询性。

数据仓库的主要特点:1、定期批量更新数据:数据仓库通常会对企业内部的数据进行定期批量的更新,而且一般是在业务量相对较小时进行。

2、面向历史:数据仓库主要面向数据的历史信息,针对的是过去的数据。

3、专注于查询:在数据仓库中,主要对数据进行查询操作。

4、主题导向:数据仓库是围绕着业务主题进行组织的,它包含了企业整个业务的各个方面。

数据仓库的优点:1、高效性:基于数据仓库的数据分析拥有更高的业务性能,用于大量数据处理时更加简单、高效。

2、数据一致性好:由于数据仓库的数据集中存储,因此能够保证数据的一致性。

3、适用于大型企业:数据仓库的搭建需要较高的成本,会考虑到企业经营的全局信息。

数据仓库的缺点:1、对实时更新的需求差:数据仓库的数据一般是较为静态的,更新时延相对较高。

2、对数据的一致性要求高:数据仓库在数据插入、更新、删除等操作上的成本相对更高,因此数据的一致性也更加重视。

3、可变性不强:数据仓库在建库时便需要考虑到全局信息,所以数据的构建相对比较稳定。

二、数据集市数据集市是指将企业内部不同系统中的数据进行收集,然后根据需要进行分类、整合、清洗、分析等操作,组成具有相同语义的业务数据集合,提供给业务部门,以支持各个业务部门的分析需求和决策需要。

数据集市的主要特点:1、实时更新:数据集市需要及时更新数据,这样业务部门才能随时获取到最新的数据信息。

湖仓一体大数据平台解决方案相关两份资料

结果的合并,增加了运维成本

批处理 视图

增量处理 视图

即席查询

API服务 自助取数

实时计算数据流

增量处理结果

流处理

Lambda架构-数仓分层结构

ADS

Kafka

ES

DWS

S Q L

Kafka

DWD

S Q L

Kafka

S Q L

ODS

Kafka

Source

S

C

Q

D

L

C

Messae Queue

HBase

结论:实时计算支持主流数据库1500万/小时的数据处理能力,且资源占用较低

湖仓一体大数据平台产品未来支持功能-①增强SQL能力

更多语法与特性支持

更多数据源支持

任务自动调优

湖仓一体大数据平台产品未来支持功能-②精细化资源管理

Flink on K8s

自动扩容缩容

细粒度资源调度

4、Hudi数据湖典型应用场景

全链血缘

元数据检索 元数据分析

2. 湖仓一体数仓建设思路

传统数仓的问题

开发效率

实时指标烟囱式开发 效率低门槛高

技术架构

实时离线架构不统一 依赖离线T+1导出报表

平台管理

缺少实时元数据管理 未打通实时离线数据的联系

湖仓一体数仓建设思路

批流统一

统一数仓标准与元数据 基于SQL统一开发流程

宽表建设

引入Hudi加速宽表产出 基于Flink SQL 构建实时数仓

数据集成

DataX (批量同步)

Flink-CDC (流式写入)

API接口 (Restful)

文件直传

大数据平台湖仓一体平台 计算/分析引擎

电商数据库考试题及答案

电商数据库考试题及答案一、单项选择题(每题2分,共20分)1. 在数据库中,用于存储数据的文件称为()。

A. 数据文件B. 索引文件C. 系统文件D. 配置文件答案:A2. 关系数据库管理系统中,关系是指()。

A. 表B. 行C. 列D. 数据库答案:A3. SQL语言中的“SELECT”语句用于()。

A. 插入数据B. 更新数据C. 删除数据D. 查询数据答案:D4. 在数据库设计中,规范化的主要目的是()。

A. 提高查询速度B. 减少数据冗余C. 提高数据安全性D. 增加数据存储量答案:B5. 数据库中的主键(Primary Key)是()。

A. 可以有多个值的字段B. 可以为空的字段C. 表中任意的字段D. 唯一标识表中每条记录的字段答案:D6. 数据库事务的ACID属性中,D代表的是()。

A. 原子性B. 一致性C. 隔离性D. 持久性答案:D7. 在数据库中,外键用于()。

A. 存储数据B. 建立表之间的关系C. 提高查询速度D. 限制数据的输入答案:B8. 数据库中的索引用于()。

A. 存储数据B. 优化查询性能C. 限制数据的输入D. 增加数据的安全性答案:B9. 数据库备份的目的主要是()。

A. 提高查询速度B. 优化数据库性能C. 恢复数据D. 增加数据存储量答案:C10. 数据库中的视图(View)是一种()。

A. 存储数据的表B. 存储过程C. 虚拟表D. 数据库答案:C二、多项选择题(每题3分,共15分)11. 数据库管理系统(DBMS)的主要功能包括()。

A. 数据定义B. 数据操纵C. 数据控制D. 数据备份答案:ABCD12. 在关系数据库中,以下哪些操作是合法的()。

A. 插入一行数据B. 删除一列数据C. 更新一条记录D. 删除整个数据库答案:ACD13. 数据库设计过程中,实体-关系模型(ER Model)的主要组成部分包括()。

A. 实体B. 关系C. 属性D. 约束答案:ABCD14. 数据库中的触发器(Trigger)可以用于()。

数据仓库-数据集市-BI-数据分析-介绍

数据仓库-数据集市-BI-数据分析-介绍数据仓库数据集市BI数据分析介绍在当今数字化的时代,数据已经成为企业和组织最宝贵的资产之一。

如何有效地管理、分析和利用这些数据,以获取有价值的信息和洞察,成为了摆在众多企业面前的重要课题。

在这个过程中,数据仓库、数据集市、商业智能(BI)和数据分析等技术和概念发挥着至关重要的作用。

接下来,让我们一起深入了解一下这些概念。

数据仓库,简单来说,就是一个用于存储和管理企业数据的大型数据库系统。

它的目的是将来自不同数据源(如操作系统、数据库、文件等)的数据整合到一个统一的、一致的环境中,以便进行分析和决策支持。

数据仓库中的数据通常是经过清洗、转换和集成的,以确保数据的质量和一致性。

它采用了特定的架构和技术,如星型模式、雪花模式等,来优化数据的存储和查询性能。

数据仓库就像是一个大型的数据仓库,将各种各样的数据收集起来,经过整理和分类,以便后续的使用。

与数据仓库密切相关的是数据集市。

数据集市可以看作是数据仓库的一个子集,它专注于特定的业务领域或主题,例如销售数据集市、客户数据集市等。

数据集市的数据来源于数据仓库,经过进一步的筛选和加工,以满足特定业务部门或用户的需求。

数据集市的规模通常比数据仓库小,但更具针对性和灵活性,能够更快地提供相关的数据和分析结果。

接下来,我们谈谈商业智能(BI)。

BI 是一套用于将数据转化为有价值的信息和知识的技术和工具。

它包括数据报表、数据可视化、数据挖掘、联机分析处理(OLAP)等功能。

通过 BI 系统,用户可以以直观的方式查看和分析数据,从而发现数据中的趋势、模式和关系。

BI 帮助企业管理层做出更明智的决策,提高企业的竞争力和运营效率。

例如,通过数据报表,管理层可以清晰地了解企业的销售业绩、成本支出等情况;通过数据可视化,复杂的数据可以以图表、地图等形式展现,更容易理解和分析。

数据分析则是一个更广泛的概念,它涵盖了从数据收集、数据处理、数据分析到结果解释和报告的整个过程。

数仓基本知识

数仓基本知识数仓(Data Warehouse)是指企业或组织中用于存储和管理大量数据的系统。

在现代企业中,数据已经成为宝贵的资产和竞争优势的来源。

而数仓作为数据的集中存储和管理平台,发挥着至关重要的作用。

数仓的基本概念可以追溯到20世纪80年代,当时企业开始意识到数据的价值,并开始建立数据仓库用于支持决策和分析。

数仓的目标是将来自不同数据源的数据集成到一个统一的平台上,为企业决策提供准确、一致和可靠的数据。

数仓还会对数据进行清洗、整合、转换、聚合和存储,以便进行更高效的数据分析和挖掘。

数仓的架构通常包括以下几个关键组件:1. 数据源:数仓可以从多个数据源中获取数据,包括企业内部的各种业务系统、传感器、社交媒体等。

这些数据源可能包含结构化数据(如数据库表)和非结构化数据(如日志文件、文本文档)。

2. 数据抽取:数据抽取是将数据从源系统中提取出来并加载到数仓中的过程。

这一步骤通常需要进行数据清洗、转换和规整,以确保数据的质量和一致性。

3. 数据存储:数仓中的数据通常以多维模型的形式存储,例如星型模型或雪花模型。

这些模型可以更好地支持数据分析和查询。

4. 数据集成:数据集成是将来自不同数据源的数据整合到一起的过程。

这包括数据的聚合、关联和变换,以便进行更高级别的分析和挖掘。

5. 数据查询和分析:数仓提供了各种查询和分析工具,以便用户可以轻松地访问和分析数据。

这些工具可以是标准的SQL查询工具,也可以是更高级别的分析工具,如数据挖掘和机器学习工具。

6. 数据可视化:数据可视化是将数据以图表、报表和仪表盘等形式展示出来,以便用户可以更直观地理解和分析数据。

数据可视化可以帮助用户发现数据中的模式、趋势和异常情况。

数仓的建设和维护需要专业的团队和技术支持。

数仓团队通常由数据工程师、数据分析师、业务专家等组成,他们负责数仓的设计、构建、运维和优化工作。

数仓的好处不仅体现在数据分析和决策支持方面,还可以帮助企业提高运营效率、降低成本、改善客户体验等。

华为云数据仓库服务(DWS) 8.1.3.310 API 参考文档说明书

数据仓库服务(DWS) 8.1.3.310API参考文档版本01发布日期2023-03-30版权所有 © 华为云计算技术有限公司 2023。

保留一切权利。

非经本公司书面许可,任何单位和个人不得擅自摘抄、复制本文档内容的部分或全部,并不得以任何形式传播。

商标声明和其他华为商标均为华为技术有限公司的商标。

本文档提及的其他所有商标或注册商标,由各自的所有人拥有。

注意您购买的产品、服务或特性等应受华为云计算技术有限公司商业合同和条款的约束,本文档中描述的全部或部分产品、服务或特性可能不在您的购买或使用范围之内。

除非合同另有约定,华为云计算技术有限公司对本文档内容不做任何明示或暗示的声明或保证。

由于产品版本升级或其他原因,本文档内容会不定期进行更新。

除非另有约定,本文档仅作为使用指导,本文档中的所有陈述、信息和建议不构成任何明示或暗示的担保。

目录1 使用前必读 (1)1.1 概述 (1)1.2 调用说明 (1)1.3 终端节点 (1)1.4 基本概念 (1)2 API概述 (3)3 如何调用API (5)3.1 构造请求 (5)3.2 认证鉴权 (8)3.3 返回结果 (9)4 快速入门 (11)5 API说明 (17)5.1 集群管理接口 (17)5.1.1 创建集群 (17)5.1.2 查询集群列表 (22)5.1.3 查询集群详情 (29)5.1.4 查询节点类型 (37)5.1.5 删除集群 (39)5.1.6 重启集群 (41)5.1.7 扩容集群 (42)5.1.8 重置密码 (44)5.1.9 集群工作负载管理 (46)5.1.9.1 查询工作负载管理计划列表 (46)5.1.9.2 查询工作负载管理计划 (49)5.1.9.3 切换工作负载计划阶段 (52)5.1.9.4 启动工作负载计划 (53)5.1.9.5 停止工作负载计划 (55)5.2 快照管理接口 (56)5.2.1 创建快照 (56)5.2.2 查询快照列表 (58)5.2.3 查询快照详情 (60)5.2.4 删除手动快照 (63)5.2.5 恢复集群 (64)5.3 数据库监控管理接口 (67)5.3.1 查询DWS集群状态 (67)5.3.2 查询DWS集群中数据库使用情况 (72)5.3.3 查询DWS集群各节点磁盘IO使用情况 (74)5.3.4 查询DWS集群各节点磁盘IO使用情况(聚合类型) (77)5.3.5 查询DWS集群各节点文件系统使用情况 (81)5.3.6 查询DWS集群各节点文件系统使用情况(聚合类型) (83)5.3.7 查询DWS集群节点各网卡流量 (87)5.3.8 查询DWS集群查询执行情况 (90)5.3.9 查询DWS集群会话执行情况 (94)5.3.10 查询DWS硬件资源使用情况 (96)5.3.11 查询DWS集群硬件资源使用情况(聚合类型) (99)6 附录 (103)6.1 状态码 (103)6.2 错误码 (105)6.3 创建VPC (113)6.4 获取资源集ID (113)6.5 获取租户ID (114)6.6 获取集群ID (114)6.7 获取Endpoint (115)1使用前必读1.1 概述欢迎使用数据仓库服务GaussDB(DWS)。

电商平台的数据仓库设计与实现

电商平台的数据仓库设计与实现随着互联网技术的不断发展,电子商务成为新的商业模式,电商平台已经成为企业和消费者交流的新平台。

然而,随着电商平台的不断发展,数据量也不断增加,如何管理和分析这些数据成为了电商平台所面临的挑战。

因此,为了更好的管理和分析大量数据,电商平台需要建立自己的数据仓库。

一、数据仓库简介数据仓库是为了满足企业分析和决策需要而建立的一种数据管理系统。

数据仓库具有决策支持和分析功能,是基于主题的、集成的、稳定的、随时间变化而更新的且支持管理决策的数据集合。

二、电商平台数据仓库的设计和实现1.需求分析在设计和实现电商平台数据仓库之前,首先需要进行需求分析。

需求分析的目的是确定数据仓库需要包含什么数据、数据的来源、数据存储方式以及数据的分析需求。

具体的需求分析包括以下几个方面:(1)确定数据仓库的主题和范围。

电商平台的数据包括交易记录、用户信息、商品信息、库存状态等信息,因此需要确定数据仓库的主题和范围。

(2)确定数据来源。

确定数据仓库的数据来源,包括各个系统的数据、外部数据源的数据等。

(3)确定数据存储方式。

确定数据存储方式,需要考虑到数据的规模、岛屿的数据集成以及数据的安全性等因素。

(4)确定数据的分析需求。

需求分析的关键是确定数据的分析需求,包括数据的分析维度、分析对象等。

2.数据集成数据集成是指将来自不同数据源的数据集成到数据仓库中。

因为电商平台的数据来源是多样的,包括终端设备、交易系统、物流系统等,因此需要进行数据集成。

数据集成的过程包括数据抽取、数据转换和数据加载三个步骤。

具体来说,数据抽取是将外部数据源中的数据抽取到本地数据库中;数据转换是将抽取的数据进行转换、清洗和质量控制;数据加载是将处理后的数据加载到数据仓库中。

3.数据建模数据建模是指利用数据建模工具将抽取的数据进行建模,分析其业务规则,形成数据模型。

在电商平台数据仓库的建模中,需要注意以下几个方面:(1)建立事实表和维度表。

电商平台数据分析平台使用手册

电商平台数据分析平台使用手册第1章系统概述 (4)1.1 数据分析平台简介 (4)1.2 系统功能与特点 (4)1.3 系统架构与模块划分 (4)第2章账户与权限管理 (5)2.1 账户注册与登录 (5)2.1.1 注册账户 (5)2.1.2 登录账户 (5)2.2 用户权限设置 (5)2.2.1 权限分配 (5)2.2.2 权限调整 (5)2.3 角色管理 (6)2.3.1 角色创建 (6)2.3.2 角色修改与删除 (6)2.4 修改密码与找回密码 (6)2.4.1 修改密码 (6)2.4.2 找回密码 (6)第3章数据源接入 (6)3.1 数据源类型与接入方式 (6)3.1.1 数据源类型 (6)3.1.2 接入方式 (7)3.2 数据源配置与接入流程 (7)3.2.1 数据源配置 (7)3.2.2 接入流程 (7)3.3 数据同步与更新策略 (7)3.3.1 数据同步 (7)3.3.2 更新策略 (8)第4章数据处理与清洗 (8)4.1 数据预处理操作 (8)4.1.1 数据导入 (8)4.1.2 数据整合 (8)4.1.3 数据规范 (8)4.2 数据清洗规则配置 (8)4.2.1 规则设置 (8)4.2.2 规则应用 (9)4.2.3 规则管理 (9)4.3 数据脱敏与加密 (9)4.3.1 数据脱敏 (9)4.3.2 数据加密 (9)4.4 数据质量监控 (9)4.4.1 监控指标设置 (9)4.4.3 异常处理 (9)第5章数据存储与管理 (9)5.1 数据仓库架构 (9)5.1.1 数据仓库分层 (9)5.1.2 数据仓库技术选型 (10)5.1.3 数据仓库扩展性与容错性 (10)5.2 数据表设计与优化 (10)5.2.1 数据表设计原则 (10)5.2.2 数据表设计方法 (10)5.2.3 数据表优化策略 (10)5.3 数据存储策略与压缩 (11)5.3.1 数据存储策略 (11)5.3.2 数据压缩 (11)5.4 数据备份与恢复 (11)5.4.1 数据备份 (11)5.4.2 数据恢复 (11)第6章数据分析模型与方法 (11)6.1 常用数据分析模型 (11)6.1.1 描述性分析模型 (11)6.1.2 关联分析模型 (12)6.1.3 聚类分析模型 (12)6.1.4 时间序列分析模型 (12)6.2 数据挖掘算法与应用 (12)6.2.1 决策树算法 (12)6.2.2 逻辑回归算法 (12)6.2.3 神经网络算法 (12)6.2.4 聚类算法 (12)6.3 数据可视化技术 (12)6.3.1 柱状图 (12)6.3.2 折线图 (13)6.3.3 饼图 (13)6.3.4 散点图 (13)6.4 用户行为分析模型 (13)6.4.1 RFM模型 (13)6.4.2 用户留存分析模型 (13)6.4.3 用户路径分析模型 (13)6.4.4 用户价值分析模型 (13)第7章报表与仪表盘 (13)7.1 报表类型与设计 (13)7.1.1 报表分类 (13)7.1.2 报表设计原则 (14)7.1.3 报表模板 (14)7.2 报表制作与发布 (14)7.2.2 发布报表 (14)7.3 仪表盘配置与展示 (14)7.3.1 仪表盘概述 (14)7.3.2 仪表盘配置 (14)7.3.3 仪表盘展示 (15)7.4 数据导出与打印 (15)7.4.1 数据导出 (15)7.4.2 数据打印 (15)第8章数据挖掘与预测 (15)8.1 数据挖掘任务创建与管理 (15)8.1.1 创建数据挖掘任务 (15)8.1.2 管理数据挖掘任务 (15)8.2 挖掘算法选择与参数设置 (16)8.2.1 挖掘算法选择 (16)8.2.2 参数设置 (16)8.3 模型评估与优化 (16)8.3.1 模型评估 (16)8.3.2 模型优化 (16)8.4 数据预测与决策支持 (16)8.4.1 数据预测 (17)8.4.2 决策支持 (17)第9章系统监控与维护 (17)9.1 系统功能监控 (17)9.1.1 功能监控概述 (17)9.1.2 功能监控指标 (17)9.1.3 功能监控工具 (17)9.2 数据安全与审计 (17)9.2.1 数据安全策略 (17)9.2.2 数据审计 (17)9.3 系统日志分析 (18)9.3.1 日志收集 (18)9.3.2 日志分析工具 (18)9.3.3 日志分析应用 (18)9.4 系统故障排查与恢复 (18)9.4.1 故障排查流程 (18)9.4.2 系统恢复 (18)9.4.3 预防措施 (18)第10章常见问题与解决方案 (19)10.1 数据分析常见问题解答 (19)10.1.1 如何处理数据缺失问题? (19)10.1.2 如何解决数据异常值问题? (19)10.1.3 如何提高数据分析模型的准确性? (19)10.2 系统使用技巧与建议 (19)10.2.1 如何快速创建数据分析报告? (19)10.2.2 如何实现多维度数据分析? (20)10.2.3 如何进行数据可视化展示? (20)10.3 技术支持与售后服务 (20)10.3.1 如何获取技术支持? (20)10.3.2 如何享受售后服务? (20)10.4 用户反馈与建议渠道 (20)10.4.1 如何提交反馈与建议? (20)第1章系统概述1.1 数据分析平台简介电商平台数据分析平台是为了满足电商企业在数据挖掘、分析及决策支持方面的需求而设计的一款高效、实用的数据分析工具。

数仓基本知识

数仓基本知识什么是数仓数仓(Data Warehouse)是指将企业各个业务系统中的数据进行整合、清洗、转换和存储,以支持企业决策分析和业务需求的一种数据管理系统。

数仓将数据从不同的源系统中提取出来,并进行一系列的处理和加工,最终形成一个统一、一致、可信的数据集合,供企业用户进行数据分析、报表生成、决策支持等工作。

数仓的目标数仓的主要目标是提供高质量的、一致的和可信的数据,以支持企业的决策分析和业务需求。

具体来说,数仓的目标包括:1.数据整合:将来自不同业务系统的数据整合到一个统一的数据存储中,消除数据的冗余和不一致性。

2.数据清洗:对数据进行清洗和校验,确保数据的准确性和完整性。

3.数据转换:将数据进行转换和加工,使其适应不同的数据分析和报表生成需求。

4.数据存储:将经过整合和加工的数据存储到数据仓库中,提供高效的数据访问和查询能力。

5.数据分析:为企业用户提供灵活、高效的数据分析工具和技术,支持数据挖掘、业务智能和决策支持等工作。

数仓的架构数仓的架构通常包括以下几个组成部分:1.数据源:数仓的数据源包括企业各个业务系统中的数据,如销售系统、采购系统、财务系统等。

这些数据源可以是关系型数据库、文件系统、API接口等。

2.数据抽取:数据抽取是将数据从源系统中提取出来的过程。

通常可以使用ETL(Extract, Transform, Load)工具来完成数据抽取,将数据导入到数据仓库中。

3.数据存储:数据存储是指将经过整合和加工的数据存储到数据仓库中。

数据仓库可以采用关系型数据库、列式数据库、分布式文件系统等存储技术。

4.数据加工:数据加工是指对数据进行转换和加工的过程,以满足不同的数据分析和报表生成需求。

数据加工可以包括数据清洗、数据转换、数据聚合等操作。

5.数据分析:数据分析是指对数据进行统计、挖掘和分析的过程,以发现数据中的规律和模式。

数据分析可以使用各种工具和技术,如SQL查询、数据挖掘算法、机器学习模型等。

数据仓库数据集市BI数据分析介绍

数据仓库数据建模步骤

一般按照主题进行建模 一般步骤

业务建模

领域建模

逻辑建模

物理建模

✓梳理组织架构关系

✓抽象业务概念

✓具化抽象概念的属性✓针对特定物理平台

✓梳理系统用户、角色

✓分组业务概念,按照业务主线 ✓细化业务流程

作出相应的技术调整

✓梳理业务流程(实际工作流程)聚合类似的分组的数据是不一样的,让管理者无所适从

报表的生产率问题:由于OLTP的单项系统导致数据的分散性和相同元素定

义不一致所致不可能把数据转换成信息

数据动态集成问题:不同的需求,要求将操作型环境和分析型环境相分离

历史数据问题:单项系统之间保留的历史数据时间范围不一致,无法满足

DSS分析的需要数据的综合问题:非细节数据、多种程度的综合 提升现有的信 息:

由于做了大量数据预处理, 查询性能很快。

只是依靠单纯的维度建模, 不能保证数据来源的一致 性和准确性

结论:一般在数据仓库底层使用范式建模,在数据集市层或多维数据库使用维度建模

数据应用-多维分析之切片、切块

数据应用-多维分析之钻取

按

时

间

维

60

向

上

钻

取

按 时 间 维 向 下 钻 取

数据应用-多维分析之旋转

9

数据仓库领域另外一名重要的人物

比尔·恩门的对头 随着拉尔夫·金博尔(Ralph Kimball)博士出版了他的第

一本书“The DataWarehouse Toolkit”(《数据仓库工具 箱》),数据仓库行业就开始喧哗起来,恩门的“Building the Data Warehouse”主张建立数据仓库时采用自上而下 (DWDM)方式,以第3范式进行数据仓库模型设计,而他 生活上的好朋友Ralph Kimball在“The DataWarehouse Toolkit”则是主张自下而上(DMDW)的方式,力推数据集 市建设,以致他们的FANS吵闹得差点打了起来,直至恩门推 出新的BI架构CIF(Corporation information factory),把 Kimball的数据集市包括了进来才算平息。

大数据项目之电商分析平台

大数据项目之电商分析系统1项目框架1.1 项目概述本项目来源于企业级电商网站的大数据统计分析平台,该平台以 Spark 框架为核心,对电商网站的日志进行离线和实时分析。

该大数据分析平台对电商网站的各种用户行为(访问行为、购物行为、广告点击行为等)进行分析,根据平台统计出来的数据,辅助公司中的PM(产品经理)、数据分析师以及管理人员分析现有产品的情况,并根据用户行为分析结果持续改进产品的设计,以及调整公司的战略和业务。

最终达到用大数据技术来帮助提升公司的业绩、营业额以及市场占有率的目标。

本项目使用了Spark 技术生态栈中最常用的三个技术框架,Spark Core、SparkSQL 和Spark Streaming,进行离线计算和实时计算业务模块的开发。

实session 分析、页面单跳转化率统计、热门商品离线统计、广告流量实时统计4 个业务模块。

通过合理的将实际业务模块进行技术整合与改造,该项目几乎完全涵盖了Spark Core、Spark SQL 和Spark Streaming 这三个技术框架中大部分的功能点、知识点,学员对于Spark 技术框架的理解将会在本项目中得到很大的提高。

图1-1 Spark 计数框架户访问现了包括用1.1项目框架1.1.1项目整体框架图1-2 项目整体框架本项目分为离线分析系统与实时分析系统两大模块。

在离线分析系统中,我们将模拟业务数据写入Hive 表中,离线分析系统从Hive 中获取数据,并根据实际需求(用户访问Session 分析、页面单跳转化率分析、各区域热门商品统计)对数据进行处理,最终将分析完毕的统计数据存储到MySQL 的对应表格中。

在实时分析系统中,我们将模拟业务数据写入Kafka 集群中,实时分析系统从Kafka broker 中获取数据,通过Spark Streaming 的流式处理对广告点击流量进行实时分析,最终将统计结果存储到MySQL 的对应表格中。

《数据仓库建模》课件

分析型数据仓库(Analytical Data Warehouse, ADW):用于数据分析、 报表生成和数据挖掘等高级应用场景。

第三章

数据仓库建模理论

C ATA L O G U E

维度建模理论

总结词

维度建模理论是一种以业务需求为导向的数据仓库建模方法,通过构建事实表和维度表来满足业务分析需求。

01

CATALOGUE

02

05

索引技术

索引概述

01

索引是提高数据仓库查询性能的重要手段,通过建立索引

可以快速定位到所需数据,避免全表扫描。

索引类型

02

常见的索引类型包括B树索引、位图索引、空间索引等,根据

数据仓库中数据的特性和查询需求选择合适的索引类型。

索引维护

03

定期对索引进行维护,如重建索引、更新统计信息等,以

包括数据库连接技术、数据抽取技术、数据转 换技术、数据加载技术和元数据管理等。这些 技术是ETL过程的基础,确保了ETL过程的稳定 性和高效性。

提供了图形化界面和自动化功能,使得ETL过程 更加高效和易于管理。常见的ETL工具有 Apache NiFi、Talend、Pentaho等。

ETL工具

数据仓库的性能优化

对数据进行必要的转换和处理,以满足业务需求和数据仓库模 型的要求。

ETL过程

数据存储

将转换后的数据加载到数据仓库中, 确保数据的存储安全和可靠。

数据加载策略

根据数据量、数据变化频率等因素选 择实时加载或批量加载。

数据审计

记录数据的加载过程和结果,以便进 行数据审计和追溯。

ETL技术

ETL工具和技术

第一章 数 据 仓 库 建 模

目录

尚硅谷大数据项目之电商数仓(2业务数据采集平台)

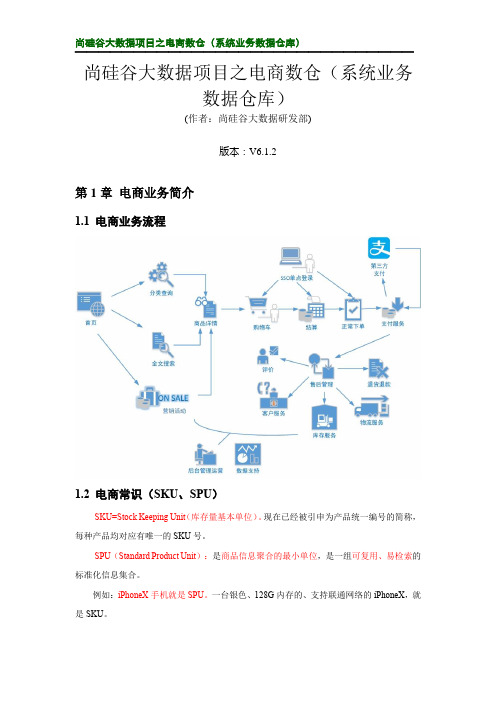

尚硅谷大数据项目之电商数仓(系统业务数据仓库)(作者:尚硅谷大数据研发部)版本:V6.1.2第1章电商业务简介1.1 电商业务流程1.2 电商常识(SKU、SPU)SKU=Stock Keeping Unit(库存量基本单位)。

现在已经被引申为产品统一编号的简称,每种产品均对应有唯一的SKU号。

SPU(Standard Product Unit):是商品信息聚合的最小单位,是一组可复用、易检索的标准化信息集合。

例如:iPhoneX手机就是SPU。

一台银色、128G内存的、支持联通网络的iPhoneX,就是SKU。

SPU 表示一类商品。

好处就是:可以共用商品图片,海报、销售属性等。

1.3 电商业务表结构电商表结构订单表order_info商品评论表comment_info 加购表cart_info 商品收藏表favor_info用户表user_info 支付流水表payment_info优惠卷领用表coupon_use优惠卷表coupon_info 活动表Activity_info 活动订单表Activity_order优惠规则表Activity_rule参与活动商品表Activity_sku省份表base_province地区表base_region订单详情表order_detailSKU 商品表sku_info商品三级分类表base_category3商品二级分类表base_category2商品一级分类表base_category1SPU 商品表spu_info品牌表base_trademark退单表order_redund_info订单状态表order_status_log编码字典表base_dic1.3.1 订单表(order_info )标签 含义 id 订单编号 consignee 收货人 consignee_tel 收件人电话 final_total_amount 总金额 order_status 订单状态 user_id用户id delivery_address 送货地址 order_comment 订单备注out_trade_no 订单交易编号(第三方支付用)trade_body 订单描述(第三方支付用) create_time 创建时间operate_time 操作时间expire_time 失效时间tracking_no 物流单编号parent_order_id 父订单编号img_url 图片路径province_id 地区benefit_reduce_amount 优惠金额original_total_amount 原价金额feight_fee 运费1.3.2 订单详情表(order_detail)标签含义id 订单编号order_id 订单号sku_id 商品idsku_name sku名称(冗余)img_url 图片名称(冗余)order_price 商品价格(下单时sku价格)sku_num 商品数量create_time 创建时间1.3.3 SKU商品表(sku_info)标签含义id skuIdspu_id spuidprice 价格sku_name 商品名称sku_desc 商品描述weight 重量tm_id 品牌idcategory3_id 品类idsku_default_img 默认显示图片(冗余) create_time 创建时间1.3.4 用户表(user_info)标签含义id 用户idlogin_name 用户名称nick_name 用户昵称passwd 用户密码name 姓名phone_num 手机号email 邮箱head_img 头像user_level 用户级别birthday 生日gender 性别M男,F女create_time 创建时间operate_time操作时间1.3.5 商品一级分类表(base_category1)标签含义id idname 名称1.3.6 商品二级分类表(base_category2)标签含义id idname 名称category1_id 一级品类id1.3.7 商品三级分类表(base_category3)标签含义id idname 名称Category2_id 二级品类id1.3.8 支付流水表(payment_info)标签含义id 编号out_trade_no 对外业务编号order_id 订单编号user_id 用户编号alipay_trade_no 支付宝交易流水编号total_amount 支付金额subject 交易内容payment_type 支付类型payment_time 支付时间1.3.9 省份表(base_province)标签含义id idname 省份名称region_id 地区IDarea_code 地区编码iso_code 国际编码1.3.10 地区表(base_region)标签含义id 大区idregion_name 大区名称1.3.11 品牌表(base_trademark)标签含义tm_id 品牌idtm_name 品牌名称1.3.12 订单状态表(order_status_log)标签含义id 编号order_id 订单编号order_status 订单状态operate_time 操作时间1.3.13 SPU商品表(spu_info)标签含义id 商品idspu_name spu商品名称description 商品描述(后台简述)category3_id 三级分类idtm_id 品牌id1.3.14 商品评论表(comment_info)标签含义id 编号user_id 用户idsku_id 商品idspu_id spu_idorder_id 订单编号appraise 评价 1 好评 2 中评 3 差评comment_txt 评价内容create_time 创建时间1.3.15 退单表(order_refund_info)标签含义id 编号order_id 订单编号sku_id sku_idrefund_type 退款类型refund_amount 退款金额refund_reason_type 原因类型refund_reason_txt 原因内容create_time 创建时间1.3.16 加购表(cart_info)标签含义id 编号user_id 用户idsku_id SKU商品cart_price 放入购物车时价格sku_num 数量img_url 图片文件sku_name sku名称 (冗余)create_time 创建时间operate_time 修改时间is_ordered 是否已经下单order_time 下单时间1.3.17 商品收藏表(favor_info)标签含义id 编号user_id 用户名称sku_id 商品idspu_id spu_idis_cancel 是否已取消 0 正常 1 已取消create_time 创建时间cancel_time 修改时间1.3.18 优惠券领用表(coupon_use)标签含义id 编号coupon_id 购物券IDuser_id 用户IDorder_id 订单IDcoupon_status 购物券状态get_time 领券时间using_time 使用时间used_time 支付时间expire_time 过期时间1.3.19 优惠券表(coupon_info)标签含义id 购物券编号coupon_name 购物券名称coupon_type 购物券类型 1 现金券 2 折扣券 3 满减券 4 满件打折券condition_amount 满额数condition_num 满件数activity_id 活动编号benefit_amount 减金额benefit_discount 折扣create_time 创建时间range_type 范围类型 1、商品 2、品类 3、品牌spu_id 商品idtm_id 品牌idcategory3_id 品类idlimit_num 最多领用次数operate_time 修改时间expire_time 过期时间1.3.20 活动表(activity_info)标签含义id 活动idactivity_name 活动名称activity_type 活动类型activity_desc 活动描述start_time 开始时间end_time 结束时间create_time 创建时间1.3.21 活动订单关联表(activity_order)标签含义id 编号activity_id 活动idorder_id 订单编号create_time 发生日期1.3.22 优惠规则表(activity_rule)标签含义id 编号activity_id 活动idcondition_amount 满减金额condition_num 满减件数benefit_amount 优惠金额benefit_discount 优惠折扣benefit_level 优惠级别1.3.23 编码字典表(base_dic)标签含义dic_code 编号dic_name 编码名称parent_code 父编号create_time 创建日期operate_time 修改日期1.3.24 活动参与商品表(activity_sku)(暂不导入)标签含义id 编号activity_id 活动idsku_id sku_idcreate_time 创建时间1.4 时间相关表1.4.1 时间表(date_info)标签含义date_id 日期idweek_id 周idweek_day 周day 日month 月quarter 季度year 年is_workday 是否是周末holiday_id 假期id1.4.2 假期表(holiday_info)标签含义holiday_id 假期idholiday_name 假期名称1.4.3 假期年表(holiday_year)标签含义holiday_id 假期idholiday_name 假期名称start_date_id 假期开始时间end_date_id 假期结束时间第2章 业务数据采集模块Flume 消费MySQL 业务数据Nginx业务日志数据(后端埋点数据)Web/App 前端埋点日志服务器(Springboot)Nginx业务服务器(Springboot)日志服务器(Springboot)logFilelogFile业务服务器(Springboot)生产Flume生产FlumeKafkaKafka KafkaSparkSt reamingHbaseHDFSHive (ods dwd dws ads)消费FlumeMysql数据可视化SqoopWeb/App 业务交互PrestoKylin实时指标分析业务交互数据:业务流程中产生的登录、订单、用户、商品、支付等相关的数据,通常存储在DB 中,包括Mysql 、Oracle 埋点用户行为数据:用户在使用产品过程中,与客户端产品交互过程中产生的数据,比如页面浏览、点击、停留、评论、点赞、收藏等2.1 MySQL 安装 2.1.1 安装包准备1)卸载自带的Mysql-libs (如果之前安装过mysql ,要全都卸载掉)[atguigu@hadoop102 software]$ rpm -qa | grep -i-Emysql\|mariadb | xargs -n1 sudo rpm -e --nodeps 2)将安装包和JDBC 驱动上传到/opt/software ,共计6个01_mysql-community-common-5.7.29-1.el7.x86_64.rpm 02_mysql-community-libs-5.7.29-1.el7.x86_64.rpm03_mysql-community-libs-compat-5.7.29-1.el7.x86_64.rpm 04_mysql-community-client-5.7.29-1.el7.x86_64.rpm 05_mysql-community-server-5.7.29-1.el7.x86_64.rpm mysql-connector-java-5.1.48.jar2.1.2 安装MySQL1)安装mysql 依赖[atguigu@hadoop102 software]$ sudo rpm -ivh 01_mysql-community-common-5.7.29-1.el7.x86_64.rpm[atguigu@hadoop102 software]$ sudo rpm -ivh 02_mysql-community-libs-5.7.29-1.el7.x86_64.rpm[atguigu@hadoop102 software]$ sudo rpm -ivh 03_mysql-community-libs-compat-5.7.29-1.el7.x86_64.rpm 2)安装mysql-client[atguigu@hadoop102 software]$ sudo rpm -ivh 04_mysql-community-client-5.7.29-1.el7.x86_64.rpm 3)安装mysql-server[atguigu@hadoop102 software]$ sudo rpm -ivh 05_mysql-community-server-5.7.29-1.el7.x86_64.rpm4)启动mysql[atguigu@hadoop102 software]$ sudo systemctl start mysqld5)查看mysql密码[atguigu@hadoop102 software]$ sudo cat /var/log/mysqld.log | grep password2.1.3 配置MySQL配置只要是root用户+密码,在任何主机上都能登录MySQL数据库。

即席查询研究

即席查询研究摘要:即席查询,数据库应用最普遍的一种查询,利用数据仓库技术,可以让用户随时可以面对数据库,获取所希望的数据.使用此功能的用户都必须对关系型数据库操作有一定的了解,同时对目前的底层数据库有比较深刻的认识。

它是一种条件不固定,格式灵活的查询报表。

关键词:商业智能;数据仓库;即席查询1 商业智能的概念商务智能是20世纪90年代末首先在国外企业界出现的一个术语,其代表为提高企业运营性能而采用的一系列方法、技术和软件。

它把先进的信息技术应用到整个企业,不仅为企业提供信息获取能力,而且通过对信息的开发,将其转变为企业的竞争优势。

互联网数据中心idc(internet data center)将商业智能bi(business intellience)定义为多种软件工具的集合。

其中包括终端用户查询和报告工具。

该专门用来支持初级用户的原始数据访问,不包括适用于专业人士的成品报告生成工具。

olap工具。

提供多维数据管理环境,其典型的应用是对商业问题的建模与商业数据分析。

olap也被称为多维分析。

数据挖掘(data minin)软件。

使用诸如神经网络、规则归纳等技术,用来发现数据之间的关系,做出基于数据的推断。

主管信息系统(eis,executive information system)。

以及数据集市(data mart)和数据仓库(data warehouse)产品。

包括数据转换、管理和存取等方面的预配置软件,通常还包括一些业务模型,如财务分析模型。

2 数据仓库的实现数据仓库不同于企业现有的操作型数据库,他是一种面向分析型数据处理的技术。

它是对多个异构的数据源的高度有效的集成,集成后然后再按照主题进行重组,并包含历史数据,一般情况下存放在数据仓库里的数据不再需要经过修改。

我们的传统数据库技术是以单一的数据资源,即数据库为中心,进行从事务处理、批处理到决策分析等各种类型的数据处理工作。

不同类型的数据有着不同的处理特点,以单一的数据组织方式进行组织的数据库并不能反映这种差异,特别是满足不了现代商业企业数据处理多样化的要求。

大数据项目 电商数仓(用户行为离线)

大数据项目电商数仓(用户行为离线)大数据项目:电商数仓(用户行为离线)1. 项目背景:电商平台拥有大量的用户行为数据,包括用户浏览商品、下单购买、评价等行为。

为了更好地理解用户行为和需求,提高用户体验和销售效果,电商平台需要建立一个电商数仓,对用户行为数据进行离线处理和分析。

2. 项目目标:通过建立电商数仓,对用户行为数据进行离线处理和分析,实现以下目标:- 提供准确、高效的数据查询和分析能力,支持业务决策和运营优化。

- 实现用户行为数据的清洗、转换和聚合,提供高质量的数据源。

- 构建用户行为分析模型,挖掘用户行为规律和趋势,提供个性化推荐和营销策略。

- 支持数据可视化和报表展示,方便业务人员进行数据分析和监控。

3. 项目流程:- 数据采集:通过埋点技术或日志收集系统,收集用户行为数据,包括浏览记录、购买记录、评价记录等。

- 数据清洗:对采集到的原始数据进行清洗,去除重复数据、异常数据和无效数据,确保数据的准确性和完整性。

- 数据转换:将清洗后的数据进行格式转换,统一数据模型和数据结构,方便后续的数据处理和分析。

- 数据聚合:对转换后的数据进行聚合操作,例如按照用户、商品、时间等维度进行聚合,生成用户行为指标和统计结果。

- 数据存储:将聚合后的数据存储到数仓中,可以选择关系型数据库、NoSQL数据库或分布式文件系统等进行存储。

- 数据分析:基于存储在数仓中的数据,进行用户行为分析,例如用户购买转化率、商品热销排行等。

- 数据挖掘:通过机器学习和数据挖掘算法,挖掘用户行为规律和趋势,例如用户画像、个性化推荐等。

- 数据可视化:将分析结果进行可视化展示,例如生成报表、图表和数据仪表板,方便业务人员进行数据分析和监控。

4. 技术架构:- 数据采集:使用埋点技术或日志收集系统,将用户行为数据收集到中心化的数据平台。

- 数据清洗:使用数据清洗工具,对原始数据进行清洗和预处理,去除重复、异常和无效数据。

- 数据转换:使用ETL工具或编写自定义代码,将清洗后的数据进行格式转换和数据模型转换。

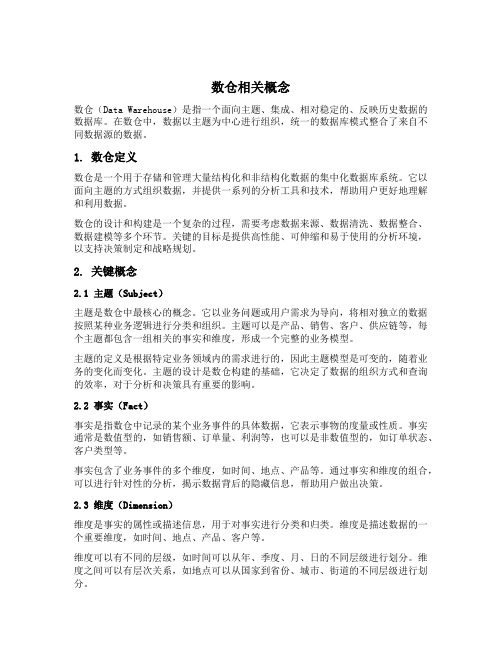

数仓相关概念

数仓相关概念数仓(Data Warehouse)是指一个面向主题、集成、相对稳定的、反映历史数据的数据库。

在数仓中,数据以主题为中心进行组织,统一的数据库模式整合了来自不同数据源的数据。

1. 数仓定义数仓是一个用于存储和管理大量结构化和非结构化数据的集中化数据库系统。

它以面向主题的方式组织数据,并提供一系列的分析工具和技术,帮助用户更好地理解和利用数据。

数仓的设计和构建是一个复杂的过程,需要考虑数据来源、数据清洗、数据整合、数据建模等多个环节。

关键的目标是提供高性能、可伸缩和易于使用的分析环境,以支持决策制定和战略规划。

2. 关键概念2.1 主题(Subject)主题是数仓中最核心的概念。

它以业务问题或用户需求为导向,将相对独立的数据按照某种业务逻辑进行分类和组织。

主题可以是产品、销售、客户、供应链等,每个主题都包含一组相关的事实和维度,形成一个完整的业务模型。

主题的定义是根据特定业务领域内的需求进行的,因此主题模型是可变的,随着业务的变化而变化。

主题的设计是数仓构建的基础,它决定了数据的组织方式和查询的效率,对于分析和决策具有重要的影响。

2.2 事实(Fact)事实是指数仓中记录的某个业务事件的具体数据,它表示事物的度量或性质。

事实通常是数值型的,如销售额、订单量、利润等,也可以是非数值型的,如订单状态、客户类型等。

事实包含了业务事件的多个维度,如时间、地点、产品等。

通过事实和维度的组合,可以进行针对性的分析,揭示数据背后的隐藏信息,帮助用户做出决策。

2.3 维度(Dimension)维度是事实的属性或描述信息,用于对事实进行分类和归类。

维度是描述数据的一个重要维度,如时间、地点、产品、客户等。

维度可以有不同的层级,如时间可以从年、季度、月、日的不同层级进行划分。

维度之间可以有层次关系,如地点可以从国家到省份、城市、街道的不同层级进行划分。

维度的作用是提供多个视角对数据进行分析,通过不同维度的组合,可以发现数据的交叉关系和变化趋势,从而深入理解业务情况。

数仓项目文档

数仓项目1. 背景介绍数仓(Data Warehouse)是一个用于集成、存储和分析企业数据的系统。

它的目标是为企业提供一个一致、可信赖的数据源,帮助企业在决策和分析过程中更好地理解业务和抓住商机。

数仓项目是为了建立和维护一个数仓系统而进行的项目。

本文将对数仓项目的重要性、流程和关键步骤进行详细说明。

2. 数仓项目的重要性数仓项目的重要性体现在以下几个方面:2.1 数据集成和一致性数仓项目能够将来自不同业务系统的数据进行集成和整理,保证数据的一致性。

这使得企业能够在决策和分析过程中使用准确、完整的数据,避免了数据分散和冗余带来的问题。

2.2 数据可信度和可靠性数仓项目可以将数据从源系统中抽取到数仓中,通过数据清洗和转换等过程,确保数据的可信度和可靠性。

这使得企业能够更加信任和依赖数据,为决策提供支持和依据。

2.3 决策支持和业务分析数仓项目的目标是为企业提供一个可信赖的数据源,帮助企业在决策和业务分析过程中更好地理解业务和抓住商机。

数仓中存储的数据经过整合和清洗,可以为企业提供多维度的数据分析和报表,帮助企业更好地了解产品销售情况、市场趋势等。

3. 数仓项目的流程数仓项目通常包括以下几个主要的流程:3.1 需求分析在数仓项目开始之前,需要进行需求分析工作。

这一步骤的目标是与业务部门沟通,了解业务需求,明确数仓项目应该提供的功能和数据内容。

3.2 数据抽取和清洗数仓项目的核心工作是将来自多个业务系统的数据抽取到数仓中,然后进行数据清洗和转换等操作,确保数据的一致性和可靠性。

3.3 数据集成和存储经过数据抽取和清洗后,将数据进行集成并存储到数仓中。

数据集成通常涉及数据模型设计、ETL(Extract, Transform, Load)开发等工作。

3.4 数据分析和报表在数据集成和存储完成后,可以基于数仓中的数据进行多维度的数据分析和报表开发工作。

这有助于企业更好地理解业务和做出正确的决策。

3.5 数仓维护和优化数仓项目完成后,并不意味着工作结束。

大数据电商离线数仓业务流程模块

大数据电商离线数仓业务流程模块下载温馨提示:该文档是我店铺精心编制而成,希望大家下载以后,能够帮助大家解决实际的问题。

文档下载后可定制随意修改,请根据实际需要进行相应的调整和使用,谢谢!并且,本店铺为大家提供各种各样类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,如想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by theeditor. I hope that after you download them,they can help yousolve practical problems. The document can be customized andmodified after downloading,please adjust and use it according toactual needs, thank you!In addition, our shop provides you with various types ofpractical materials,such as educational essays, diaryappreciation,sentence excerpts,ancient poems,classic articles,topic composition,work summary,word parsing,copy excerpts,other materials and so on,want to know different data formats andwriting methods,please pay attention!1. 数据采集从各个数据源(如电商平台、支付系统、物流系统等)收集数据。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

大数据项目之电商数仓(即席查询)

版本:V4.0

第1章Presto

1.1 Presto简介

1.1.1 Presto概念

Presto概念

Presto是一个开源的分布式SQL查询引擎,数据量支持GB到PB字节,主要用来处理秒级查询的场景。

注意:虽然Presto可以解析SQL,但它不是一个标准的数据库。

不是MySQL、Oracle的代替品,也不能用来处理在线事务(OLTP)。

1

2

Presto 架构

Presto 由一个Coordinator 和多个Worker 组成。

Presto CLI

Hive Metastore

Presto Coordinator

Presto Worker

Presto Worker

Presto Worker

Hive Connector

Schema Table

Hive

Catalog

Kafka Connector

Schema

Table

Kafka

Catalog

Redis Connector

Schema Table

Redis

Catalog

1)由客户端提交查询,从Presto 命令行CLI 提交到Coordinator 。

2)Coordinator 解析查询计划,然后把任务分发给Worker 执行。

3)Worker 负责执行任务和处理数据

7)Coordinator 是负责从Worker 获5)Connector 是适配器,用于Presto 和数据源(如Hive 、Redis )的连接,类似于JDBC 。

4)Catolog 表示数据源。

一个Catelog 包含Schema 和Connector

6)Schema 类似于

Mysql 中数据库,Table 类似于MySQL 中表

1.1.3 Presto 优缺点

Presto 优缺点

1)优点

(1)Presto 基于内存运算,减少了硬盘IO ,计算更快。

(2)能够连接多个数据源,跨数据源连表查,如从Hive 查询大量网站访问记录,然后从Mysql 中匹配出设备信息。

2)缺点

Presto 能够处理PB 级别的海量数据分析,但Presto 并不是

把PB 级数据都放在内存中计算的。

而是根据场景,如Count ,A VG 等聚合运算,是边读数据边计算,再清内存,再读数据再计算,这种耗的内存并不高。

但是连表查,就可能产生大量的临时数据,因此速度会变慢,反而Hive 此时会更擅长。

1.1.4 Presto 、Impala 性能比较

s:/u012551524/article/details/79124532

测试结论:Impala 性能稍领先于Presto ,但是Presto 在数据源支持上非常丰富,包括Hive 、图数据库、传统关系型数据库、Redis 等。

1.2.1 Presto Server安装

0)官网地址

s:prestodb.github.io/

1)下载地址

s:/maven2/com/facebook/presto/presto-server/0.196/presto -server-0.196.tar.gz

2)将presto-server-0.196.tar.gz导入hadoop102的/opt/software目录下,并解压到/opt/module目录

[atguiguhadoop102 software]$ tar -zxvf presto-server-0.196.tar.gz -C /opt/module/

3)修改名称为presto

[atguiguhadoop102 module]$ mv presto-server-0.196/ presto

4)进入到/opt/module/presto目录,并创建存储数据文件夹

[atguiguhadoop102 presto]$ mkdir data

5)进入到/opt/module/presto目录,并创建存储配置文件文件夹

[atguiguhadoop102 presto]$ mkdir etc

6)配置在/opt/module/presto/etc目录下添加jvm.config配置文件

[atguiguhadoop102 etc]$ vim jvm.config

添加如下内容

-server

-Xmx16G

-XX:+UseG1GC

-XX:G1HeapRegionSize=32M

3

-XX:+UseGCOverheadLimit

-XX:+ExplicitGCInvokesConcurrent

-XX:+HeapDumpOnOutOfMemoryError

-XX:+ExitOnOutOfMemoryError

7)Presto可以支持多个数据源,在Presto里面叫catalog,这里我们配置支持Hive的数据源,配置一个Hive的catalog

[atguiguhadoop102 etc]$ mkdir catalog

[atguiguhadoop102 catalog]$ vim hive.properties

添加如下内容

=hive-hadoop2

hive.metastore.uri=thrift:hadoop102:9083

8)将hadoop102上的presto分发到hadoop103、hadoop104

[atguiguhadoop102 module]$ xsync presto

9)分发之后,分别进入hadoop102、hadoop103、hadoop104三台主机的/opt/module/presto/etc的路径。

配置node属性,node id每个节点都不一样。

[atguiguhadoop102 etc]$vim node.properties

node.environment=production

node.id=ffffffff-ffff-ffff-ffff-ffffffffffff

node.data-dir=/opt/module/presto/data

[atguiguhadoop103 etc]$vim node.properties

node.environment=production

node.id=ffffffff-ffff-ffff-ffff-fffffffffffe

node.data-dir=/opt/module/presto/data

4

[atguiguhadoop104 etc]$vim node.properties

node.environment=production

node.id=ffffffff-ffff-ffff-ffff-fffffffffffd

node.data-dir=/opt/module/presto/data

10)Presto是由一个coordinator节点和多个worker节点组成。

在hadoop102上配置成coordinator,在hadoop103、hadoop104上配置为worker。

(1)hadoop102上配置coordinator节点

[atguiguhadoop102 etc]$ vim config.properties

添加内容如下

coordinator=true

node-scheduler.include-coordinator=false

-server..port=8881

query.max-memory=50GB

discovery-server.enabled=true

discovery.uri=:hadoop102:8881

(2)hadoop103、hadoop104上配置worker节点

[atguiguhadoop103 etc]$ vim config.properties

添加内容如下

coordinator=false

-server..port=8881

query.max-memory=50GB

discovery.uri=:hadoop102:8881

[atguiguhadoop104 etc]$ vim config.properties

添加内容如下

5。