回归分析中异常值的诊断与处理

线性回归模型中的异常点分析

华中科技大学硕士学位论文1 引言经典的线性回归模型理论创立以来,在医学科研与实践中已得到广泛应用,并取得许多成果,例如运用于疾病的病因学研究及疾病预测、控制等方面。

其中我们感兴趣的回归系数一般采用“最小二乘估计”(least squares estimator, LS estimator)求解,但是在应用中容易忽视的问题是LS估计只有在数据满足相应条件的情况下才会具有统计描述和推断的优良性质,如要求误差服从正态分布、总体方差相同且相互独立等。

当实际数据没有近似满足这些假定时,就会出现一些异常点(outliers)、杠杆点(leverage point)及影响点(influential observations),使分析结果变得不可靠,不能发现数据中的真实结构,从专业上难以解释结果,甚至得到完全错误的结论。

尤其是随着统计软件的日渐普及,某些科研工作者倾向于简单地将数据交给软件来分析,而不注意具体方法的应用条件,尽管采用了SAS、SPSS这些国际标准软件,但是输出结果有时却与专业解释相悖。

针对此问题应运而生的回归诊断(regression diagnostic)与稳健估计(robust estimation)方法得到越来越多学者的注意,已成为一个新的统计学分支,其中针对多个异常点的诊断及其稳健化处理是一个难度较大但又具有较高理论与实用价值的研究方向,值得深入研究。

1.1 异常点在统计诊断中的地位异常点(outlier)是统计诊断中很重要的一个概念。

统计诊断(Statistical Diagnostics)就是对从实际问题中收集起来的数据、提炼出来的模型以及由此出发所作的推断方法的合理性进行深入而细致的分析,并通过一些诊断统计量来检查数据、模型及推断方法中可能存在的毛病,进而提出治疗方案,进行模型或者推断方法的改进。

统计诊断主要包括异常点识别、残差分析、影响分析和数据变换等内容,异常点的识别是处理统计诊断的重要内容之一,它进行的好坏通常影响到整个过程的诊断。

回归分析中的异常值处理方法(四)

回归分析是统计学中一种重要的分析方法,用于研究因变量和自变量之间的关系。

然而,在进行回归分析时,常常会遇到异常值的情况。

异常值是指与其他观测值明显不同的数据点,它可能会对回归分析结果产生负面影响。

因此,在进行回归分析时,必须采取合适的方法对异常值进行处理,以确保分析结果的准确性和可靠性。

异常值处理方法一:删除异常值最简单的处理方法就是直接删除异常值。

这样做可以确保回归分析结果不受异常值的影响,但也可能会导致数据丢失严重。

因此,删除异常值的方法只适用于异常值数量较少、对整体数据分布影响不大的情况。

在删除异常值时,需要谨慎对待,必须确保异常值的确是错误的数据记录,而非真实存在的特殊情况。

异常值处理方法二:替换异常值另一种常见的异常值处理方法是将异常值替换为合适的数值。

常用的替换方法包括用均值、中位数或众数替换异常值。

替换异常值的好处在于可以保留数据的完整性,但替换过程中需要注意选择合适的替换数值,以避免对回归分析结果产生偏差。

同时,替换异常值也需要考虑异常值的原因,避免由于替换而掩盖了真实的数据特征。

异常值处理方法三:转换异常值除了删除和替换,还可以考虑对异常值进行转换。

常见的转换方法包括对数转换、平方根转换等。

转换异常值的好处在于可以在一定程度上减弱异常值的影响,同时保留了原始数据的基本特征。

然而,转换异常值也需要谨慎操作,需要根据实际情况选择合适的转换方法,并对转换后的数据进行验证,确保转换后的数据符合回归分析的要求。

异常值处理方法四:使用鲁棒回归除了上述方法外,还可以考虑使用鲁棒回归来处理异常值。

鲁棒回归是一种能够在数据中存在异常值情况下保持高精度的回归方法。

它通过采用鲁棒的估计方法,可以有效抵抗异常值的影响,从而得到更为稳健的回归分析结果。

使用鲁棒回归处理异常值需要对回归模型有一定的了解,并且需要根据实际情况选择合适的鲁棒回归方法。

结语在进行回归分析时,异常值的存在可能会对分析结果产生负面影响,因此需要采取合适的方法对异常值进行处理。

回归分析中异常值的诊断与处理

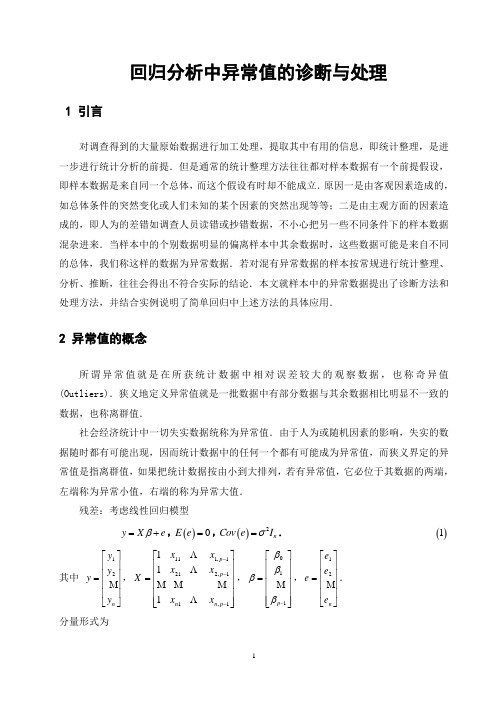

回归分析中异常值的诊断与处理1 引言对调查得到的大量原始数据进行加工处理,提取其中有用的信息,即统计整理,是进一步进行统计分析的前提.但是通常的统计整理方法往往都对样本数据有一个前提假设,即样本数据是来自同一个总体,而这个假设有时却不能成立.原因一是由客观因素造成的,如总体条件的突然变化或人们未知的某个因素的突然出现等等;二是由主观方面的因素造成的,即人为的差错如调查人员读错或抄错数据,不小心把另一些不同条件下的样本数据混杂进来.当样本中的个别数据明显的偏离样本中其余数据时,这些数据可能是来自不同的总体,我们称这样的数据为异常数据.若对混有异常数据的样本按常规进行统计整理、分析、推断,往往会得出不符合实际的结论.本文就样本中的异常数据提出了诊断方法和处理方法,并结合实例说明了简单回归中上述方法的具体应用.2 异常值的概念所谓异常值就是在所获统计数据中相对误差较大的观察数据,也称奇异值(Outliers).狭义地定义异常值就是一批数据中有部分数据与其余数据相比明显不一致的数据,也称离群值.社会经济统计中一切失实数据统称为异常值.由于人为或随机因素的影响,失实的数据随时都有可能出现,因而统计数据中的任何一个都有可能成为异常值,而狭义界定的异常值是指离群值,如果把统计数据按由小到大排列,若有异常值,它必位于其数据的两端,左端称为异常小值,右端的称为异常大值.残差:考虑线性回归模型y X e β=+,()0E e =,()2n Cov e I σ=.()1 其中 ⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y y 21,⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=---1,11,2211,111111p n n p p x x x x x x X ,⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=-110p ββββ ,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n e e e e 21. 分量形式为011,11i i i p p i y x x e βββ--=++++,n i ,, 1=.()2 定义ˆˆˆey y y X β=-=-为残差向量,其中ˆˆy X β=称为拟合值向量,βˆ为β在模型()1下的最小二乘估计.如果用n x x '',1表示X 的n 个行向量,则称 ˆˆi i i ey x β'=-, n i ,, 1=, 为第i 次试验或观测的残差.对简单回归,12111n x x X x ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y y 21,⎥⎦⎤⎢⎣⎡=10βββ.则ˆˆiiie y x β'=-,n i ,, 1=,其中()1,i ix x '=.于是,异常值就是在回归分析中,一组数据()i i y x ,'如果它的残差i eˆ较其它组数据的残差大的多,则称此数据为异常值.异常值的出现有主客观的原因.主观上抽样调查技术有问题,疏忽大意记错,或人为的虚报,谎报数据等都可能导致异常数据,这直接影响了统计数据的质量;客观上某些样品由于特定原因在某些变量上的确表现突出,明显超出平均水平,这也可能产生异常值.异常值的存在必将导致相应统计分析误差增大,会对分析结果(平均值与标准差)产生重要影响,会降低测量的精度.如果不预先处理它们,用通常的统计整理方法所得出的结论可靠性差.而异常值的诊断与处理是保证原始数据可靠性,平均值与标准差计算准确性的前提.3 异常值的诊断方法在讨论异常值诊断问题时,通常要假设所得样本观测值在某中意义下遵从一定的分布规律.拿到一批数据,若能从其实际背景中明确看出它服从某中分布形式时,一般的做法是在这种分布假设下,导出能较好反映异常值与正常值差异的统计量,在没有异常值的原假设下作假设检验.以下给出两种检验方法.3.1 F 分布检验法学生化残差:考虑线性回归模型()1,记ˆˆyX β=,称y ˆ为拟合值向量,称其第i 个分量βˆˆi i x y'=为第i 个拟合值,则 ()1ˆy X X X X y Hy -''==,这里()1H X X X X -''=.文献中通常称H 为帽子矩阵.前面已经定义了ˆˆi i i ey x β'=-, n i ,, 1=, 为第i 次试验或观测的残差.将其标准化为iii h e-1ˆσ,再用σˆ代替σ,得到所谓学生化残差ii i i h e r -=1ˆˆσ, n i , ,1=,这里ii h 为H 的第i 个对角元,pn eni i-=∑=122ˆˆσ.把正态线性回归模型()1改写成分量形式i i i e x y +'=β,()2,0~σN e i ,n i ,, 1=,这里i e ,)1(n i ,, =相互独立.如果第j 组数据()j j y x ,'是一个异常点,那么它的残差就很大.它的残差之所以很大是因为它的均值()j y E 发生了非随机性漂移η.从而()ηβ+'=j j x y E .这产生了一个新的模型i i ijj j y x e y x e ββη'=+⎧⎪⎨'=++⎪⎩ ()2~0,,i i j e N σ≠ ()3 记[]0,,0,1,0,,0j d '=.将模型()3改写成矩阵的形式j y X d e βη=++, ()I N e 2,0~σ, ()4模型()3和()4称为均值漂移线性回归模型.要判定()j j y x ,'不是异常点,等价于检验假设0=η:H .引理1 用()i y ,()i X 和()i e 分别表示从Y 、X 和e 剔除第i 行所得到的向量或矩.从线性回归模型()1剔除第i 组数据后,剩余的1-n 组数据的线性回归模型为()()()i i i y X e β=+,()()0i E e =,()()21n i Cov e I σ-=. ()5 将从这个模型求到的β的最小二乘估计记为()i βˆ,则 ()()i iii i x X X h e11ˆˆˆ-'--=ββ. 证明:因为()()()()()()1ˆi i i i i X X X y β-''=. ()6设A 为n n ⨯可逆阵,v u 和均为1⨯n 向量.用恒等式()vA u A v u A A v u A 111111-----'-'+='-有()()()()()()()111111i i i i iiiiX X x x X X X X X X x x X X h -----'''''''=-=+-, ()7这里i x '为X 的第i 行.将上式两边右乘X y ',并利用()()i i i i X y X y y x ''=+以及()6式,有()()()()()()iii i ii i i i h x x X X x X X y -''-'+=--1ˆˆˆ11βββ.()8将()7式右乘i x ,可以得到如下关系式()()()()i iii iix X X h x X X 1111--'-='. 将其代入()8式,得到()()i iii i x X X h e11ˆˆˆ-'--=ββ. 引理2 对均值漂移线性回归模型()4,β和η的最小二乘估计分别为()j ββˆ=*和j jje h ˆ11-=*η,其中()j βˆ为从非均值漂移线性回归模型()1剔除第j 组数据后得到的β的最小二乘估计.()()X X X X h H jj ''==-1,jj h 为H 的第j 个对角元.j eˆ为从模型()2导出的第j 个残差. 证明:显然,j j y y d =',1='j j d d .记()12,,,n X x x x '=.则j j x d X ='.于是,根据定义()111j j j j j j X X X Xx X y Xd y d d x y βη-*-*''''⎡⎤⎛⎫⎡⎤⎡⎤⎛⎫⎡⎤==⎢⎥ ⎪ ⎪⎢⎥⎢⎥⎢⎥'''⎢⎥⎣⎦⎝⎭⎣⎦⎣⎦⎝⎭⎣⎦. 根据分块矩阵的逆矩阵公式(见附录1),以及()j j jj x X X x h 1-''=.()()()()()()()()111111111111111111ˆˆ1111ˆ111ˆˆ11ˆ1j j j jj jj j j jj jjj j j j jj jjj j jj jj j j jjj jj X X X X x x X X X X x h h X y y x X X h h X X x x X X x y h h x y h h X X x e h e h βηββββ----**----⎡⎤'''''+-⎢⎥--'⎡⎤⎡⎤⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦''-⎢⎥--⎣⎦⎛⎫'''+- ⎪--⎪= ⎪'-+ ⎪ ⎪--⎝⎭⎛'--=-⎝⎫ ⎪⎪ ⎪ ⎪ ⎪⎭. 再由引理1知命题得证.现在应用引理来求检验0=η:H 的检验统计量.注意到,对现在的情形,在约束条件0=η下,模型()4就化为模型()1,于是=H RSS 模型()1无约束情形下的残差平方和 y X y y ''-'=βˆ. 而模型()4的无约束残差平方和y d y X y y RSS j '-'-'=**'ηβ. ()9利用引理2得()2ˆˆˆ1ˆˆ111H jj j j j j jj jj jjRSS RSS X y d y e y e e x h h h ββηβ**'''-=-+'=-+=---.这里βˆˆj j j x y e'-=为第j 组数据的残差. 利用*β和*η的具体表达式将()9式作进一步化简:jj j j jjj j h y e h y e y X y y RSS ---+''-'=1ˆ1ˆˆˆβ=()jjj h e p n ---1ˆˆ22σ,其中pn eni i-=∑=122ˆˆσ.根据引理2,所求的检验统计量为()()()()22222111ˆ1ˆ1ˆ1jj jj j jj jH r p n r p n h p n e p n p n h e p n RSS RSSRSS F ----=--------=---=σ. 于是,我们证明了如下事实:定理[]2 对于均值漂移线性回归模型()4,如果假设0=η:H 成立,则()1,122~1------=p n j j j F r p n r p n F .据此,我们得到如下检验:对给定的()10<<αα,若()()α1,1221-->----=p n jj j F rp n r p n F ,则判定第j 组数据()j j y x ,'为异常点.当然,这种检验会犯“判无为有”的错误,也就是()jjy x ,'可能不是异常点,而被误判为异常点.但我们犯这种错误的概率只有α,事先我们可以把它控制的很小.显然,根据t 分布与F 分布的关系,我们也可以用t 检验法完成上面的检验.若定义()()212211⎥⎥⎦⎤⎢⎢⎣⎡----==j j j j r p n p n r F t . 对给定的α,当⎪⎭⎫⎝⎛>--21αp n j t t时,我们拒绝假设0=η:H .即判定第j 组数据()j j y x ,'为异常点.3.2 残差及残差图检验异常值前面定义了βˆˆX y e-=,称为残差向量,其分量形式ˆˆi i i e y x β'=-,()1,,i n =,称为第i 次试验或观测的残差.特别地,对简单回归,()i i x x ,1=',n i ,, 1=.⎪⎪⎪⎪⎪⎪⎭⎫ ⎝⎛---=⎥⎦⎤⎢⎣⎡=∑∑==n i i n i i i x n x y x n y x x y 1221110ˆˆˆˆββββ.所以,()i i i x y e 10ˆˆˆββ+-=,n i ,, 1=. 残差是最重要的一种回归诊断量,它蕴涵了有关模型基本假设的许多重要信息.残差分析就是对残差进行统计处理,从中提炼出这些信息的方法.而残差图就是残差分析中使用的基本工具.所谓残差图就是残差i eˆ对因变量y 或自变量n X X X ,, 21,,或其它导出统计量(如拟合值i yˆ)的点子图,有时候也用残差对时间或对数据序数的点子图.最简单的图,尤其在简单回归中,为残差i eˆ对拟合值i y ˆ的图. 所谓异常数据就是相对于其它观测值来说,具有大的残差的数据点.利用残差及残差图检验异常值的方法是用所给数据计算出残差i eˆ,与其余观测值的残差进行比较,具有大的残差的数据点被怀疑为异常值.然后作出自变量与因变量的散点图,残差i eˆ对拟合值i y ˆ的残差图以及残差i eˆ对自变量i x 的残差图,从图中观察,那些远离大多数观测点的孤立的点有理由被认为是异常点.然后从数据中删除这些点,再次估计回归方程,作出X 与Y 的散点图以及i eˆ对i y ˆ的残差图,计算标准差,与删除前进行比较. 4 提出两种处理方法4.1 采用虚拟变量消除异常值的影响(1) 虚拟变量某类变量(如性别、种族、颜色、宗教、国家、战争、地震等)常常表示某属性是否存在,如男或女,黑种人或白种人,教徒或非教徒,对于这类变量可用“数量化”方法设计人为变量来表示,如用 “0”或“1”,“0”表示不存在某种属性,“1”表示存在该属性.例如:用“1”表示男性,“0”表示女性,或用“1”表示大学毕业,“0”表示没有大学毕业,等等.这样假设的变量,如“0”或“1”称为虚拟变量,也称为类型变量或属性变量,它的主要特点就是将一些可以划分为不同类型或属性的变量用“0”和“1”分别表示,即属于某一类型的变量用“1”表示,不属于这一类型的变量用“0”表示.这里用D 表示虚拟变量.(2) 处理异常值的方法在这里,我们用虚拟变量(0或1)把试验数据划分为两类,属于异常值一类用“1”表示,属于正常值一类用“0”表示.引入虚拟变量D ,建立回归方程:01122221ˆˆˆˆˆp p p Y X X X D βββββ---=+++++, 其中⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y Y 21,111,11212,121,1111p p n n p n x x d x x d X x x d ---⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦,011ˆˆˆˆp ββββ-⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦,12n d d D d ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦.特别地,对简单回归,建立回归方程:012ˆˆˆY X D βββ=++, 其中,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y Y 21,1122111n n x d x d Z x d ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦,()0112ˆˆˆˆZ Z Z y ββββ-⎡⎤⎢⎥''==⎢⎥⎢⎥⎢⎥⎣⎦. 利用所给数据,作出回归估计.这样,异常值的影响被虚拟变量D 的系数吸收,从而估计更接近于现实.4.2 剔除异常值的方法对于测定中的异常值的剔除,我们必须持慎重态度,不能贸然从事.否则会出现误删有效数据或保留异常数据的错误.通常处理步骤大致如下:(1)初分析:首先利用所给数据作出回归估计:βˆˆX y=. 其中111,1212,11,1111p p n n p x x xx x x x ---⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦,()y X X X p ''=⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=--1110ˆˆˆˆββββ .特别地,对简单回归,x y 10ˆˆˆββ+=,其中x y 10ˆˆββ-=,∑∑==--=ni ini ii x n xy x n yx 12211ˆβ,并计算标准差:s =值i yˆ、残差i e ˆ,并列入表.然后作出i x 与i y 的散点图,拟合值i y ˆ与残差i e ˆ的残差图,分析判别出异常值.(2)判别出异常值后,从测量数据中删除异常值,然后利用余下的观测值再次作回归估计,同第一步,计算标准差、拟合值以及残差,作出删除异常数据后的散点图与残差图.(3)对比删除异常值前后的标准差以及残差图.对于单一可疑异常数据,直接按上述步骤进行剔除异常值.对于多个可疑异常值的情况,上述剔除步骤反复逐次进行至无可剔除为止.通常可采用两种方法:向前逐一剔除法(从极大值依次向次大值逐一剔除)和向后逐一剔除法(从可疑的j 个最大值依次从小到大逐一剔除).5 实例分析5.1 实例一假定某调查数据X 和Y 由表1中给出.表1 数据X 和Y根据表中数据作回归估计,得回归方程:ˆ0.6610.837yx =+.并算得 ()()457.0ˆ112212=---=∑∑==n i ini i iy yy yR .表2 各组数据的诊断统计量()120.05 3.65t =.从表2最后一列可以看出只有841.96=t 超过这个值,于是我们诊断出第六号数据为异常值.然后引入虚拟变量D ,建立回归方程:D x Y 210ˆˆˆβββ++=,作回归估计.令 βˆZ Y =,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=15152211111d x d xd x Z ,()y Z Z Z ''=⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡=-1210ˆˆˆˆββββ. 得0ˆ0.303β=-,1ˆ 1.007β=,2ˆ 4.985β=.所以,回归模型为:ˆ0.303 1.007 4.985y x D =-++.并且算得993.02=R .从2R 的值来看,这个回归方程[见图2中()2]要比未采用虚拟变量所估计的回归方程[见图2中()1]其拟合程度好多了.这是因为异常值的影响被虚拟变量D 的系数吸收,所以比处理前求得的估计值更接近于现实.因此虚拟变量是消除异常值的影响,探求变量之间真正关系的一种有效方法.01234567812345675.2 实例二表3给出了Forbes 数据.表3 Forbes 数据根据表中数据,(气压用100log ⨯的数据),估计回归方程,算得x y 895.0131.42ˆ+-=.计算出Forbes 数据的拟合值及残差,如表4,进一步作出散点图(图3)、残差i eˆ对拟合值i y ˆ的残差图(图4).表4 Forbes 数据的拟合值及残差-0.6-0.4-0.200.20.40.60.811.21.41.6比较表中所列的残差,并观察残差图,我们发现序号12的残差比其它的残差大的多.其它残差的绝对值都小于0.35,而第12号数据的残差为1.36.并且从残差图(图4)中观察到第12号数据的跳跃度比较大,远离其它点.由残差及残差图法诊断出第12号数据为异常数据.然后剔除第12号数据.再估计回归方程,重新拟合数据,检查参数估计,拟合值,残差方差的变化.删除第12号数据后,得到回归方程:x y891.0302.41ˆ+-=. 表5 Forbes 数据中删除12号数据后的拟合值及残差图4 Forbes 数据的残差图ˆi yˆi e-2.5-2-1.5-1-0.50.511.522.5表6 删除异常值前后的比较量对删除异常值前后的结果进行对比,我们得到对于删除前后获得的参数估计基本是相同的,所以第12号数据是无关的.但是,第12号数据在标准误差上的影响要显著些.删除后标准误差减小约3.1倍,方差减小约10倍.并且,从删除异常值获得的残差图()图5和散点图(图6)显示出,对余下的16个数据无明显的拟合失败.图5 Forbes 数据中删除12号数据后的残差图ˆi yˆi e6 结束语异常值的诊断与处理问题是一个很有实际意义的问题,是一个逐步研究逐步实践的问题.但迄今为止,还没有一种广泛适用的方法,本文所介绍的方法也是一种尝试,对于异常值的诊断与处理问题的研究还有待于进一步完善.致谢本文在撰写过程中得到了李惠东老师的悉心指导和大力支持.在论文撰写过程中遇到的难点和疑点李老师都给我作了详细的讲解,并提供了许多有参考价值的资料和专业软件,使我学到了很多知识和方法.在此表示深深的敬意与感谢.参考文献[1] 魏立力.概率论与数理统计[M].银川:宁夏人民出版社,1999.[2] 王松桂等.线性模型引论[M].北京:科学出版社,2004.[3] 何平.剔除测量数据中异常值的若干方法[J].数理统计与管理,1995,(1):19-22.[4] 王静龙,梁小筠,等译.应用线性回归[M].北京:中国统计出版社,1998.[5] 刘宗鹤,赵明强译.计量经济学概论[M].北京:农业出版社,1988.附录1:分块矩阵的逆矩阵:设0>A ,将其分块为:⎥⎦⎤⎢⎣⎡=22211211A A A AA ,则它的逆矩阵 ⎥⎦⎤⎢⎣⎡--+=-⋅--⋅-⋅---⋅---1122111211122112212111111211122*********A A A A A A A A A A A A A A=⎥⎦⎤⎢⎣⎡+----⋅---⋅---⋅-⋅122121************211211221221212111211A A A A A A A A A A A A A . 这里 121112122122A A A A A -⋅-=,211221211211A A A A A -⋅-=.附录2:SPSS处理实例1数据:1.未用虚拟变量的数据处理:RegressionModel Summary(b)b Dependent Variable: YCoefficients(a)Casewise Diagnostics(a)Case Number Std. Residual Y PredictedValue Residual1 -.516 .90 1.5815 -.68152 -.405 1.80 2.3348 -.53483 -.443 2.00 2.5859 -.58594 -.420 2.70 3.2555 -.55555 -.508 2.50 3.1718 -.67186 3.401 7.50 3.0044 4.49567 -.257 3.00 3.3392 -.33928 -.258 3.50 3.8414 -.34149 -.385 3.50 4.0088 -.508810 -.133 4.00 4.1762 -.176211 -.135 4.50 4.6784 -.178412 -.035 4.80 4.8458 -.045813 .053 5.00 4.9295 .07052.引进虚拟变量后的数据处理:Model Summary(b)b Dependent Variable: YCoefficients(a)Casewise Diagnostics(a)Case Number Std. Residual Y PredictedValue Residual1 .606 .90 .8038 .09622 .569 1.80 1.7097 .09033 -.073 2.00 2.0117 -.01174 -.736 2.70 2.8169 -.11695 -1.362 2.50 2.7162 -.21626 .000 7.50 7.5000 .00007 .519 3.00 2.9176 .08248 -.135 3.50 3.5215 -.02159 -1.403 3.50 3.7228 -.222810 .478 4.00 3.9241 .075911 -.176 4.50 4.5280 -.028012 .445 4.80 4.7293 .070713 1.071 5.00 4.8300 .170014 -1.486 5.50 5.7359 -.235915 1.684 5.50 5.2326 .2674a Dependent Variable: Y附录3:SPSS处理实例2的数据:1.删除前的数据处理:Coefficients(a)a Dependent Variable: YModel Summary(b)a Predictors: (Constant), Xb Dependent Variable: YCasewise Diagnostics(a)Case Number Std. Residual Y PredictedValue Residual1 -.651 131.79 132.0366 -.24662 -.178 131.79 131.8575 -.06753 -.161 135.02 135.0812 -.06124 .056 135.55 135.5289 .02115 .094 136.46 136.4244 .03566 -.111 136.83 136.8721 -.04217 .138 137.82 137.7676 .05248 .141 138.00 137.9466 .05349 -.410 138.06 138.2153 -.155310 -.200 138.05 138.1257 -.075711 -.383 140.04 140.1853 -.145312 3.587 142.44 141.0808 1.359213 .004 145.47 145.4685 .001514 -.851 144.34 144.6626 -.322615 -.642 146.30 146.5431 -.243116 -.205 147.54 147.6176 -.0776a Dependent Variable: Y2.删除后的数据处理:a Dependent Variable: YModel Summary(b)b Dependent Variable: YCasewise Diagnostics(b)Case Number Std. Residual Y PredictedValue Residual Status1 -1.759 131.79 131.9893 -.19932 -.186 131.79 131.8111 -.02113 .013 135.02 135.0185 .00154 .759 135.55 135.4640 .08605 .927 136.46 136.3549 .10516 .261 136.83 136.8004 .02967 1.136 137.82 137.6914 .12868 1.152 138.00 137.8696 .13049 -.679 138.06 138.1369 -.076910 .020 138.05 138.0478 .002211 -.503 140.04 140.0970 -.057012 1.028 145.47 145.3536 .116413 -1.870 144.34 144.5518 -.211814 -1.084 146.30 146.4228 -.122815 .425 147.54 147.4919 .048116 .360 147.80 147.7592 .040817 . . . . M(a)a Missing Caseb Dependent Variable: Y。

回归分析中的数据处理技巧(九)

回归分析是统计学中一种重要的分析方法,其主要用于研究自变量与因变量之间的关系。

在进行回归分析时,我们需要对数据进行处理,以确保分析的准确性和可靠性。

本文将探讨回归分析中的数据处理技巧,帮助读者更好地理解和运用这一方法。

数据清洗在进行回归分析之前,首先要对数据进行清洗。

数据清洗包括处理缺失值、异常值和重复值等问题。

缺失值会影响回归分析的结果,因此我们需要采取适当的方法来处理缺失值,比如删除缺失值所在的行或列,或者使用插补方法填充缺失值。

异常值可能会对回归模型产生较大的影响,因此需要对异常值进行识别和处理。

重复值也需要被删除,以确保数据的唯一性。

变量选择在回归分析中,变量选择是非常重要的一步。

我们需要选择与因变量相关性较高的自变量,以确保模型的准确性。

变量选择可以通过相关性分析、方差膨胀因子(VIF)检验等方法来进行。

相关性分析可以用来评估自变量与因变量之间的线性关系,而VIF检验可以用来评估自变量之间的多重共线性问题。

数据转换在进行回归分析时,有时候需要对数据进行转换,以满足模型的假设条件。

比如,如果数据不满足正态分布的假设,我们可以对数据进行对数转换或者Box-Cox变换。

对数转换可以将偏态分布的数据转换为近似正态分布的数据,而Box-Cox变换可以将数据进行幂次转换,以使其满足正态分布的要求。

数据转换可以提高回归模型的拟合度和预测准确性。

异常值处理异常值是指与其他观测值明显不同的数值,可能会对回归分析结果产生较大的影响。

因此,我们需要对异常值进行识别和处理。

异常值的识别可以通过箱线图、散点图等方法来进行。

一旦发现异常值,我们可以选择删除、替换或者进行敏感性分析来处理异常值。

交互项和多项式在回归分析中,有时候我们需要考虑自变量之间的交互作用或者自变量的高次项。

交互项可以用来描述不同自变量之间的联合作用,而多项式可以用来描述非线性关系。

在引入交互项和多项式时,我们需要注意过度拟合的问题,以及如何选择合适的模型。

回归分析中的异常值处理方法(Ⅱ)

在回归分析中,异常值是一个常见的问题。

异常值指的是与其他观测值明显不同的观测值,它们可能是由于测量误差、数据录入错误或者真实情况下的特殊情况所致。

在进行回归分析时,异常值可能会对模型的准确性和稳健性产生不利影响。

因此,处理异常值是回归分析中的一个重要环节。

一种常见的处理异常值的方法是通过观察数据分布的方式来检测异常值。

观察数据的分布可以通过绘制散点图、直方图或者箱线图来实现。

这些图形可以帮助我们直观地发现数据中的异常值。

在观察数据分布时,我们可以寻找与其他数据明显不同的数据点,这些数据点很可能就是异常值。

除了通过观察数据分布来检测异常值之外,我们还可以利用统计方法来辅助检测异常值。

统计方法包括计算数据的均值、标准差、四分位数等指标,然后根据这些指标来确定异常值的阈值。

一般来说,超过均值加减3倍标准差的数据点可以被认为是异常值,同样,四分位数也可以用来确定异常值的阈值。

一旦我们检测到异常值,我们需要考虑如何处理这些异常值。

处理异常值的方法有很多种,常见的方法包括删除异常值、替换异常值和使用鲁棒回归等。

删除异常值是最直接的方法,但是可能会导致数据的丢失,从而降低模型的准确性。

替换异常值可以通过将异常值替换为均值、中位数或者邻近数值来实现,这样可以保留数据的完整性,但是可能会引入额外的误差。

使用鲁棒回归可以通过采用对异常值不敏感的估计方法来实现,从而提高模型的稳健性。

除了上述方法之外,我们还可以尝试通过利用异常值来构建新特征的方式来处理异常值。

有时候,异常值可能包含了一些特殊的信息,通过将异常值作为新特征来加入模型中,可以提高模型的预测能力。

总的来说,处理异常值是回归分析中一个重要的环节。

通过观察数据分布、利用统计方法来检测异常值,然后选择合适的方法来处理异常值,可以帮助我们提高模型的准确性和稳健性。

在处理异常值时,需要综合考虑数据的完整性、准确性以及模型的预测能力,选择合适的方法来处理异常值。

希望本文的介绍可以帮助读者更好地处理回归分析中的异常值问题。

回归分析中的异常值处理方法(Ⅰ)

回归分析是统计学中一种常用的数据分析方法,通过建立自变量和因变量之间的数学关系模型,来预测或解释因变量的变化。

然而,在进行回归分析时,异常值的存在往往会对模型的建立和结果的准确性产生负面影响。

因此,如何有效处理异常值成为回归分析中的一个重要问题。

本文将围绕回归分析中的异常值处理方法展开讨论。

一、异常值的定义及影响异常值通常指在一组数据中与其他数据明显不同的值,它可能是由于测量误差、实验操作失误或者数据记录错误所造成的。

在回归分析中,异常值的存在会导致模型的拟合不准确,降低预测的准确性,甚至使得模型产生偏差。

因此,及时有效地处理异常值对于回归分析的结果具有重要意义。

二、异常值的识别方法在回归分析中,识别异常值是首要任务。

常用的识别方法包括基于统计学原理的方法和基于图形分析的方法。

基于统计学原理的方法主要包括箱线图、Z得分和学生化残差等方法,通过设定阈值或者计算得分来判断是否为异常值。

而基于图形分析的方法则是通过绘制散点图、残差图等图形来直观地观察数据的分布情况,从而识别异常值。

三、异常值的处理方法一旦识别出异常值,就需要对其进行处理。

常见的异常值处理方法包括删除、替换和转换。

删除异常值是最直接的方法,但可能会使得样本量减少,降低模型的稳健性。

替换异常值则是用其他数值代替异常值,可以选择用平均数、中位数或者最近邻值等进行替换,但需要注意替换后对模型结果的影响。

另外,转换异常值也是一种处理方法,可以对异常值进行变换,使其更接近于正常数据分布,如对数变换、平方根变换等。

四、异常值处理实例分析以某城市房价与面积的回归分析为例,假设样本数据中存在异常值。

首先,通过绘制散点图或者残差图来识别异常值,然后可以根据具体情况选择合适的处理方法。

如果异常值较少且对模型影响较大,可以考虑删除异常值;如果异常值较多或者无法确定其来源,可以考虑替换异常值;如果异常值分布较为集中,可以考虑对异常值进行转换。

五、结论回归分析中的异常值处理是一个复杂而重要的问题,需要根据具体情况选择合适的处理方法。

回归分析中的异常值处理方法(Ⅲ)

回归分析中的异常值处理方法回归分析是一种用来研究变量之间关系的统计方法,通过建立数学模型来探究自变量和因变量之间的关联程度。

然而,在现实数据中,常常会出现异常值,即与其他观测值明显不同的数值。

这些异常值会对回归分析结果产生影响,因此需要采取相应的异常值处理方法。

1. 数据可视化在进行回归分析之前,首先应对数据进行可视化,以便发现异常值。

常用的可视化方法包括散点图和箱线图。

散点图可以直观地展示自变量和因变量之间的关系,而箱线图则可以反映数据分布的离散程度,从而帮助发现异常值。

2. 基于标准差的异常值处理方法一种常见的异常值处理方法是基于标准差的方法。

在这种方法中,可以计算出数据的标准差,并将超出某个标准差范围之外的数据视为异常值。

通常情况下,超过3倍标准差的数值可以被认为是异常值。

3. 箱线图识别异常值箱线图是一种用来展示数据分布情况的图表,通过箱线图可以清晰地看出数据的中位数、上下四分位数以及异常值的分布情况。

在箱线图中,异常值通常被定义为小于下四分位数减倍四分位距或大于上四分位数加倍四分位距的数值。

4. 孤立森林算法孤立森林算法是一种基于树的异常值检测方法,通过构建随机森林来识别异常值。

在这种方法中,每个样本都被视为一个孤立点,算法通过测量样本点在树中的分裂次数来判断其异常程度。

孤立森林算法对于高维数据和大规模数据的异常值检测有较好的效果。

5. 基于距离的异常值处理方法基于距离的异常值处理方法是一种常用的异常值检测方法,通过计算数据点之间的距离来判断异常值。

其中,一种常用的方法是基于k近邻的异常值检测方法,通过计算每个数据点与其最近的k个邻居之间的距离来确定异常程度。

6. 局部离群因子局部离群因子是一种用于检测局部异常值的方法,它能够识别局部区域内的异常值而忽略全局分布情况。

局部离群因子的计算基于数据点周围邻居点的密度,从而可以准确地找出局部异常值。

7. 异常值处理的注意事项在进行异常值处理时,需要注意以下几点。

缺失值和异常值的处理方法 回归方程

缺失值和异常值的处理方法回归方程导语缺失值和异常值是数据处理过程中常见的问题,对于回归方程的建模和预测结果会产生不良影响,因此如何正确处理缺失值和异常值成为了数据分析领域中的重要课题。

本文将从缺失值和异常值的定义、影响、处理方法和回归方程的应用等方面展开讨论,旨在帮助读者全面理解和掌握相关知识。

一、缺失值和异常值的定义及影响1. 缺失值的定义及影响缺失值是指数据集中的部分观测值因某种原因而缺失的情况,通常用NaN(Not a Number)或空值来表示。

缺失值的存在会导致数据样本减少、统计分析结果不准确以及建模过程失败等问题,严重影响了数据分析的结果和结论的可信度。

2. 异常值的定义及影响异常值(Outlier)是指在数据集中与其他观测值存在显著偏离或差异的数值,通常称之为离群点。

异常值的存在会扭曲数据的分布、影响统计量的计算以及损害模型的准确性,导致建模结果不可靠而无法有效预测。

二、缺失值和异常值的处理方法1. 缺失值的处理方法(1)删除缺失值:当缺失值的比例较低且对整体数据影响不大时,可以选择将含有缺失值的观测样本删除,以保证数据集的完整性和准确性。

(2)填补缺失值:采用均值、中位数、众数等统计量填补缺失值,或者使用插值法、回归模型等进行缺失值的估计。

2. 异常值的处理方法(1)删除异常值:当异常值对数据分析和建模产生严重影响时,可以选择将异常值排除在外,以确保模型的准确性和稳定性。

(2)平滑处理:采用分箱、截尾、转换等方法对异常值进行平滑处理,使得异常值不再对模型产生显著的影响。

三、回归方程在缺失值和异常值处理中的应用1. 缺失值的处理在回归方程中的应用在回归分析中,缺失值的存在会导致数据样本减少,从而影响了回归模型的构建和预测能力。

正确处理缺失值对于回归方程的准确性至关重要。

可以利用各种填补方法进行缺失值的处理,如均值填补、插值法填补等,以确保回归方程基于完整的数据集进行建模。

2. 异常值的处理在回归方程中的应用异常值对回归方程的影响往往较大,会扭曲自变量与因变量之间的关系,导致回归模型的参数估计不准确。

回归分析中的异常值处理方法(八)

回归分析是一种用于探究变量之间关系的统计分析方法。

在进行回归分析时,我们常常会遇到异常值的问题。

异常值是指与其他观测值有显著差异的特殊观测值,它可能会对回归分析的结果产生影响。

因此,处理异常值是进行回归分析时必须重视的问题。

本文将从检测异常值的方法、异常值的处理原则以及常用的异常值处理方法等方面展开探讨。

异常值的检测方法在进行回归分析前,首先需要对数据进行异常值的检测。

常见的异常值检测方法包括离群值检测、箱线图检测、Cook's距离检测等。

离群值检测是一种基于数据分布的异常值检测方法,它通过计算观测值与均值的偏离程度来判断是否为异常值。

离群值检测方法的优点是简单易行,但缺点是对数据分布的假设较为严格。

箱线图检测是一种直观的异常值检测方法,通过绘制箱线图,可以清晰地看出数据的分布情况,从而判断是否存在异常值。

箱线图检测方法的优点是直观易懂,但缺点是对数据量较大时不够直观。

Cook's距离检测是一种基于回归分析残差的异常值检测方法,它通过计算每个观测值对回归系数的影响程度来判断是否为异常值。

Cook's距离检测方法的优点是能够直接评估异常值对回归结果的影响,但缺点是对多元回归模型的计算较为复杂。

异常值的处理原则在进行异常值处理时,需要遵循一些处理原则。

首先,需要谨慎处理异常值,不可以擅自删除或修改异常值,必须经过充分的分析和论证。

其次,需要考虑异常值对回归结果的影响程度,对于影响较小的异常值可以适当处理,对于影响较大的异常值需要谨慎处理。

最后,需要充分记录异常值的处理过程,以便后续分析和验证。

常用的异常值处理方法针对不同类型的异常值,可以采用不同的处理方法。

常用的异常值处理方法包括删除异常值、修正异常值和转换异常值等。

删除异常值是一种常见的异常值处理方法,它适用于对回归结果影响较大的异常值。

在删除异常值时,需要谨慎选择删除的观测值,不能盲目删除。

另外,删除异常值会导致样本量的减少,可能会影响回归结果的稳定性。

回归分析中的异常值处理方法(五)

回归分析中的异常值处理方法引言回归分析是一种用来探究变量之间关系的统计方法,通过建立一个数学模型来预测一个或多个自变量对因变量的影响。

然而,在实际应用中,由于数据收集和测量误差等原因,数据集中往往会存在异常值,这些异常值可能会对回归分析的结果产生严重影响。

因此,如何有效处理回归分析中的异常值成为一个重要的问题。

异常值的检测在进行回归分析之前,首先需要对数据集进行异常值的检测。

常用的方法包括Z分数法、Cook距离和杠杆统计量。

Z分数法是通过计算每个数据点的Z分数来判断其是否为异常值,Z分数的绝对值大于3通常被认为是异常值。

Cook距离用于检测在回归模型中对模型拟合产生影响的数据点,通常将Cook距离超过特定阈值的数据点视为异常值。

杠杆统计量则用于检测数据点对回归系数的影响程度,通常将杠杆统计量超过(2p/n)的数据点视为异常值,其中p为自变量的个数,n为样本容量。

异常值的处理方法一旦发现异常值,就需要对其进行处理。

常用的异常值处理方法包括删除、替换和转换。

删除异常值是最简单的处理方法,即直接将异常值从数据集中删除。

然而,这种方法可能会导致数据集的样本容量减小,从而影响回归分析的结果。

替换异常值是将异常值用其他数值代替,代替的数值可以是平均数、中位数或者是最近邻数值。

这种方法可以避免样本容量减小的问题,但是会改变数据的原始分布。

转换异常值是通过对异常值进行变换来降低其对结果的影响,常用的方法包括对数变换、幂变换和分位数变换。

这种方法可以保留数据的原始分布,但是需要根据具体情况选择合适的变换方法。

异常值处理的注意事项在处理异常值时,需要注意一些事项。

首先,需要根据具体问题和数据集的特点选择合适的异常值处理方法,没有一种方法适用于所有情况。

其次,需要在处理异常值之前对数据进行深入的探索和分析,了解异常值可能产生的原因。

最后,需要在处理异常值后重新进行回归分析,并对结果进行比较和评估,以确保异常值处理不会对结果产生过大的影响。

回归分析中的异常值处理方法(六)

回归分析是统计学中常用的一种方法,用于研究自变量和因变量之间的关系。

在回归分析中,异常值是一个常见的问题,它们可能会对模型的准确性产生很大的影响。

因此,处理异常值是回归分析中非常重要的一部分。

在本文中,我们将探讨回归分析中的异常值处理方法。

异常值,又称离群值,是指在数据集中与其他观测值明显不同的数值。

异常值可能是由于测量误差、记录错误或者是真实存在的极端情况所导致的。

在进行回归分析时,异常值可能会对拟合的模型产生很大的影响,从而影响到模型的准确性和可靠性。

因此,处理异常值是非常重要的。

首先,一种处理异常值的方法是删除异常值。

这是最直接和简单的方法,但也是最容易引发争议的方法之一。

因为删除异常值可能会导致数据集的缩小,从而影响到模型的拟合和预测。

此外,删除异常值还可能导致数据集的偏倚,从而影响到统计推断的可靠性。

因此,在实际应用中,删除异常值需要谨慎对待,需要考虑到异常值对模型的影响程度以及数据集的大小等因素。

另一种处理异常值的方法是替换异常值。

替换异常值的方法有很多种,比如用中位数、均值或者是最近邻的数值来替换异常值。

这种方法相对于删除异常值来说,可以保持数据集的完整性,同时也可以减小异常值对模型的影响。

但是,替换异常值也需要谨慎操作,要考虑到替换方式对模型的影响以及替换后数据的分布是否发生了改变。

除了删除和替换,还有一种处理异常值的方法是使用鲁棒回归。

鲁棒回归是一种对异常值较为敏感的回归方法,它可以通过对残差进行加权或者使用不同的损失函数来减小异常值对模型的影响。

与传统的最小二乘法相比,鲁棒回归可以更好地抵抗异常值的干扰,从而得到更加稳健的估计结果。

另外,还有一种处理异常值的方法是使用高级统计技术,比如局部敏感度分析和离群值检测算法。

这些方法可以帮助研究人员更好地识别异常值,并对异常值进行针对性的处理。

不过,这些方法通常需要较高的专业知识和技能,因此在实际应用中需要谨慎使用。

在回归分析中处理异常值是一个复杂而又重要的问题。

回归分析中的异常值处理方法(十)

回归分析是统计学中一种用来研究变量之间关系的方法。

在实际应用中,数据集中常常存在一些异常值,这些异常值可能会对回归分析的结果产生不良影响。

因此,处理异常值是回归分析中非常重要的一环。

本文将就回归分析中的异常值处理方法进行深入探讨。

首先,我们需要了解异常值的定义。

异常值,也称为离群值,是指在数据集中与其他观测值显著不同的观测值。

异常值可能是由于数据记录错误、实验误差或者真实的特殊情况所导致。

在回归分析中,异常值可能会对拟合的回归方程产生较大的影响,因此需要进行适当的处理。

一种常见的异常值处理方法是删除异常值。

当数据集中存在个别的异常值,且这些异常值不具备代表性时,可以考虑将这些异常值从数据集中删除。

这样做的好处是可以减少异常值对回归分析结果的干扰,使得回归方程更加稳健。

但是,删除异常值也可能会导致数据集的信息损失,因此需要谨慎对待。

在实际操作中,可以通过箱线图或者3σ原则等方法来识别异常值,然后根据实际情况进行删除处理。

除了删除异常值外,还可以考虑对异常值进行调整。

一种常见的调整方法是通过替换异常值。

当异常值的出现是由于数据记录错误或者实验误差导致时,可以考虑将异常值替换为相邻观测值的均值或者中位数。

这样可以减少异常值对回归分析结果的影响,同时又能够保留了数据集的信息。

需要注意的是,替换异常值时需要谨慎选择替换的方法,以确保不会对数据集的统计性质产生较大的改变。

另外,还可以考虑对异常值进行转换。

异常值转换是指将异常值进行缩放或者平移,使其不再对回归分析产生较大的影响。

常见的异常值转换方法包括平方根变换、对数变换、倒数变换等。

这些方法可以通过改变数据的分布形态来减小异常值的影响,同时又能够保留了数据集的原始信息。

需要注意的是,异常值转换时需要选择合适的变换方法,以确保不会对数据集的统计性质产生较大的改变。

除了上述提及的处理方法之外,还可以考虑使用鲁棒回归来处理异常值。

鲁棒回归是一种可以在存在异常值的情况下依然能够保持较好性能的回归方法。

回归分析中的数据处理技巧(六)

回归分析是统计学中一种常用的数据分析方法,它通常用来探究自变量与因变量之间的关系。

在进行回归分析时,数据的处理技巧至关重要。

本文将探讨回归分析中的数据处理技巧,从数据清洗到变量选择,帮助读者更好地理解和应用回归分析方法。

数据清洗是回归分析的第一步,它包括缺失值处理、异常值检测和处理、变量转换等。

在进行回归分析时,缺失值会严重影响模型的准确性,因此需要对缺失值进行处理。

常见的方法包括删除缺失值、插补缺失值、使用均值或中位数替代缺失值等。

异常值是指与其他观测值相比明显不同的观测值,它可能会对回归分析结果产生较大影响。

因此,需要对异常值进行检测和处理,常用的方法包括箱线图检测、Cook's距离检测等。

此外,变量转换也是数据清洗的一部分,它用来改变变量的分布形式,使其更适合回归分析。

常见的变量转换包括对数变换、幂次变换、分位数变换等。

在进行回归分析时,变量选择是非常重要的一步。

变量选择可以帮助我们建立更简洁、更解释性强的模型。

常见的变量选择方法包括前向选择、后向选择、逐步回归等。

前向选择是从一个空模型开始,逐步加入变量直到模型的性能不再提高。

后向选择是从包含所有变量的模型开始,逐步剔除变量直到模型的性能不再提高。

逐步回归则是同时考虑加入和剔除变量,直到找到最佳的模型。

此外,还可以使用岭回归、Lasso回归等方法来进行变量选择。

除了上述的技巧外,还可以利用交叉验证来评估模型的性能。

交叉验证是一种通过多次拆分数据集来评估模型性能的方法,常见的交叉验证方法包括K折交叉验证、留一交叉验证等。

交叉验证可以帮助我们评估模型的泛化能力,避免过拟合。

最后,需要提醒读者的是,在进行回归分析时,需要注意变量之间的共线性问题。

共线性是指自变量之间存在较强的相关性,它可能会导致模型的系数估计不准确。

在面对共线性问题时,可以使用方差膨胀因子(VIF)来评估变量间的相关性,并采取相应的处理措施,如剔除相关性较强的变量。

总之,回归分析是一种强大的数据分析方法,但在实际应用中需要注意数据的处理技巧。

回归分析中的数据处理技巧(七)

回归分析是统计学中一种重要的数据分析方法,它用来研究一个或多个自变量与因变量之间的关系。

在实际应用中,回归分析需要进行一系列的数据处理和技巧应用,以保证模型的准确性和可靠性。

本文将从数据清洗、变量选择和模型诊断三个方面探讨回归分析中的数据处理技巧。

数据清洗是回归分析中至关重要的一步。

首先,需要对数据进行缺失值处理。

缺失值可能会对回归分析产生较大影响,因此需要对缺失值进行处理。

常见的方法包括删除缺失值、使用均值或中位数进行填补和使用插值方法进行填补。

选择合适的方法对数据进行处理至关重要,需要结合数据本身的特点进行判断。

其次,需要对异常值进行处理。

异常值可能会对回归模型的拟合产生较大影响,因此需要进行识别和处理。

常见的方法包括箱线图识别异常值、Z-score标准化识别异常值和专家判断。

在识别异常值后,需要进行适当的处理,可以删除异常值或者使用合适的方法进行修正。

另外,对于分类变量的处理也是数据清洗中的重要环节。

在回归分析中,分类变量需要进行哑变量处理。

哑变量处理是将分类变量转化为虚拟变量,以便于回归模型的建立。

在进行哑变量处理时,需要注意避免虚拟变量陷阱和多重共线性问题,选择适当的参照组和控制组。

除了数据清洗外,变量选择也是回归分析中的关键步骤。

变量选择的目的是从大量的自变量中筛选出对因变量影响显著的变量,以建立简洁有效的回归模型。

在变量选择过程中,可以使用逐步回归、正则化方法和信息准则等技术进行筛选。

在进行变量选择时,需要兼顾自变量的解释性和模型的拟合优度,选择最合适的变量组合。

此外,模型诊断也是回归分析中的一项重要工作。

模型诊断的目的是检验回归模型的假设,评估模型的准确性和可靠性。

常见的模型诊断方法包括残差分析、异方差检验和共线性检验等。

在进行模型诊断时,需要对回归模型的假设进行适当的检验,判断模型是否满足条件,及时发现和处理模型中的问题。

总之,回归分析中的数据处理技巧对于建立准确、可靠的回归模型至关重要。

回归分析中常见问题与解决策略

回归分析中常见问题与解决策略回归分析是一种广泛应用于数据分析和预测的统计方法,它旨在建立自变量与因变量之间的线性或非线性关系。

然而,在实际应用中,常常会遇到各种问题。

下面我们就来探讨回归分析中常见的问题以及相应的解决策略。

首先,多重共线性是回归分析中一个常见的问题。

多重共线性指的是自变量之间存在高度的线性相关关系。

这会导致回归系数的估计不稳定,标准误差增大,t 值变小,从而使得一些原本显著的变量变得不显著。

解决多重共线性的方法有多种。

一是可以通过相关系数矩阵来初步判断自变量之间的相关性,如果相关系数较高,就需要考虑剔除一些相关的变量。

二是采用逐步回归法,让模型自动选择最优的自变量组合。

三是使用主成分分析或因子分析,将相关的自变量转化为不相关的主成分或因子,然后再进行回归分析。

其次,异方差性也是一个不容忽视的问题。

异方差性是指误差项的方差不是恒定的,而是随着自变量的取值不同而变化。

这会导致回归系数的估计不再是最优无偏估计,影响模型的准确性和可靠性。

检测异方差性可以通过绘制残差图,如果残差的分布呈现出明显的“喇叭口”形状,就可能存在异方差性。

解决异方差性的方法包括加权最小二乘法,即给不同的观测值赋予不同的权重,使得误差项的方差变得稳定;或者对数据进行变换,如取对数、开方等,以消除异方差性的影响。

再者,自相关性也是可能出现的问题之一。

自相关性是指误差项之间存在相关关系,通常在时间序列数据中较为常见。

自相关性会导致标准误差的低估,从而使 t 检验和 F 检验失效。

判断自相关性可以通过绘制残差的自相关图和偏自相关图,如果存在明显的自相关模式,就说明存在自相关性。

解决自相关性的方法包括使用广义差分法,对数据进行差分处理,以消除自相关性;或者在模型中加入滞后项,将自相关性纳入模型。

另外,遗漏变量偏差也是回归分析中容易出现的问题。

如果在模型中遗漏了重要的自变量,就会导致回归系数的估计有偏差,模型的解释能力下降。

回归分析中的异常值处理方法(九)

回归分析是统计学中的一种重要方法,用于研究自变量和因变量之间的关系。

在进行回归分析时,我们常常会遇到异常值(outliers)的问题,这些异常值可能会对回归结果产生影响。

处理异常值成为了回归分析中非常重要的一部分,本文将讨论一些常见的异常值处理方法。

1. 异常值的定义和影响异常值通常指的是样本中与其他样本有明显不同的个体。

这些个体可能是由于测量误差、录入错误或者真实存在的极端情况所导致。

在回归分析中,异常值可能会对回归系数的估计产生较大影响,导致结果不稳定甚至错误。

2. 删除异常值最简单直接的异常值处理方法是删除异常值。

这种方法适用于异常值的个数较少,且异常值对样本整体的影响较小的情况。

在实际操作中,可以通过绘制散点图或者箱线图来识别异常值,然后将其从数据集中删除。

然而,删除异常值可能会导致样本量减少,进而影响回归结果的稳定性和可靠性。

3. 替换异常值除了删除异常值,我们还可以选择用其他数值来替代异常值。

常见的替代方法包括用该变量的均值、中位数或者邻近数值来替代异常值。

替代异常值可能会使得回归结果更加稳定,但也需要对替代数值的选择进行合理的考量。

4. 异常值的变换有时候,我们可以通过对异常值进行变换来减轻其对回归结果的影响。

例如,对数变换、平方根变换或者倒数变换等。

这些变换方法可以使得数据更加符合回归模型的假设,从而减少异常值的影响。

5. 使用鲁棒回归模型除了传统的最小二乘回归模型外,我们还可以使用一些鲁棒回归模型来对异常值进行处理。

鲁棒回归模型对异常值更加敏感,可以有效地减轻异常值对回归系数的影响。

6. 数据分组在处理异常值时,我们还可以考虑将数据进行分组分析。

通过将数据分成若干个小组,我们可以更好地理解异常值的分布情况,并对每个小组进行单独的回归分析,从而减轻异常值对整体回归结果的影响。

7. 整体分析最后,我们需要意识到异常值的存在并不一定意味着其必然是错误的。

在对异常值进行处理时,我们应该进行全面的分析,包括异常值的原因、产生异常值的可能机制以及异常值对结论的影响等方面。

利用稳健回归分析解决统计学中的异常值问题

利用稳健回归分析解决统计学中的异常值问题统计学中的异常值问题一直是研究者们关注的焦点之一。

异常值,也称为离群值,是指在数据集中与其他观测值相差较大的极端值。

异常值的存在可能会对统计分析的结果产生重大影响,因此如何有效地处理异常值成为了统计学家们的挑战。

传统的回归分析方法在处理异常值时往往表现不佳。

线性回归模型假设数据服从正态分布,而异常值的存在会使数据的分布发生偏移,导致回归结果产生较大误差。

因此,为了更准确地估计回归模型的参数,研究者们提出了稳健回归分析方法。

稳健回归分析是一种能够有效处理异常值的统计方法。

与传统的回归分析方法相比,稳健回归分析不依赖于数据分布的假设,而是通过对数据进行适当的加权处理,降低异常值对回归结果的影响。

稳健回归分析通过使用鲁棒估计量,能够更好地抵抗异常值的影响,提高回归模型的拟合效果。

稳健回归分析方法有多种,其中最常用的是M估计和S估计。

M估计通过最小化加权残差的平方和来估计回归模型的参数,对异常值的影响具有一定的鲁棒性。

而S估计则通过最小化加权残差的绝对值和来估计回归模型的参数,对异常值的鲁棒性更强。

这两种方法在实际应用中都能够有效地处理异常值,但在不同的数据情况下可能表现出不同的性能。

除了M估计和S估计,还有一些其他的稳健回归分析方法,如MM估计、LTS估计等。

这些方法在处理异常值时都具有一定的优势,可以根据具体的数据情况选择合适的方法进行分析。

稳健回归分析不仅可以用于处理异常值,还可以用于处理其他类型的数据不完全或缺失的情况。

例如,在面对缺失数据时,传统的回归分析方法往往会忽略缺失数据的影响,导致估计结果的偏差。

而稳健回归分析方法可以通过合理地处理缺失数据,提高回归模型的拟合效果。

然而,稳健回归分析方法也并非完美无缺。

在某些情况下,稳健回归分析可能会对正常观测值产生一定的偏差,从而影响回归结果的准确性。

因此,在应用稳健回归分析方法时,需要根据具体的数据情况和研究目的进行权衡和选择。

r语言回归模型异常值的识别与处理

R语言是一种流行的统计分析工具,它具有强大的数据建模和分析能力。

在数据分析的过程中,回归模型是一种常用的工具,用于建立自变量和因变量之间的关系。

然而,在回归分析中,异常值的存在可能会对模型的准确性和可靠性产生负面影响。

识别和处理回归模型中的异常值是非常重要的。

一、异常值的识别1.1 直方图和散点图分析在使用R语言进行回归分析时,通常会首先绘制自变量和因变量的直方图和散点图,以便观察数据的分布和可能存在的异常值。

通过直方图和散点图的分析,可以初步判断数据是否存在异常值,并对异常值的位置和数量进行初步的估计。

1.2 Cook's距离Cook's距离是一种常用的异常值识别方法,它通过计算每个观测值对回归系数的影响程度来判断是否存在异常值。

在R语言中,可以使用"cooks.distance()"函数来计算每个观测值的Cook's距离,通过设定一个阈值来判断哪些观测值可能是异常值。

1.3 离裙点分析离裙点分析是一种常用的异常值识别方法,它通过计算观测值与其他观测值之间的距离来判断是否存在异常值。

在R语言中,可以使用"outlierTest()"函数来进行离裙点分析,从而识别可能存在的异常值。

二、异常值的处理2.1 删除异常值删除异常值是一种常用的异常值处理方法,它可以有效地提高回归模型的准确性和可靠性。

在R语言中,可以使用"subset()"函数来删除异常值所对应的观测值,从而得到一个相对更可靠的回归模型。

2.2 替换异常值替换异常值是一种常用的异常值处理方法,它可以通过使用平均值、中位数或者其他合适的数值来替换异常值,从而减小异常值对回归模型的影响。

在R语言中,可以使用"na.omit()"函数来替换异常值所对应的观测值,从而得到一个更可靠的回归模型。

2.3 转换异常值转换异常值是一种常用的异常值处理方法,它可以通过对异常值进行数值转换来减小其对回归模型的影响。

回归分析中的异常值处理方法(七)

回归分析是统计学中一种常用的分析方法,用于研究自变量和因变量之间的关系。

然而,在实际应用中,数据往往受到各种因素的影响,包括测量误差、数据录入错误等,这些因素都可能导致回归分析中出现异常值。

异常值的存在会对回归分析结果产生负面影响,因此需要采取相应的方法进行处理。

本文将探讨回归分析中的异常值处理方法。

首先,我们需要了解异常值的概念。

异常值,又称离群值,是指在数据集中明显偏离其他观测值的数值。

异常值可能是由于实际存在的极端情况,也可能是由于测量错误或数据录入错误所导致。

在回归分析中,异常值的存在会对模型的拟合产生扰动,使得参数估计偏离真实值,降低模型的预测能力。

为了处理异常值,我们可以采取以下几种方法。

首先,一种常用的方法是基于统计学的标准来识别异常值。

例如,可以计算数据的均值和标准差,然后将与均值相差超过3倍标准差的观测值标记为异常值。

这种方法简单直观,但对数据分布的偏态和厚尾情况处理能力有限。

其次,我们可以利用箱线图来识别异常值。

箱线图能够直观地显示数据的分布情况,通过观察箱线图的上下边界和离群点来识别异常值。

这种方法对数据分布的偏态和厚尾情况处理能力较强,是一种常用的异常值识别方法。

除了识别异常值,我们还需要考虑如何处理异常值。

一种常用的方法是删除异常值。

当异常值是由于数据录入错误或测量误差导致时,可以考虑将异常值从数据集中删除。

然而,删除异常值可能会导致数据丢失和样本量减小,从而影响模型的稳定性和预测能力。

另一种处理异常值的方法是进行变换。

对于偏态分布和厚尾分布的数据,可以考虑进行对数变换或Box-Cox变换,将数据转化为近似正态分布,从而减小异常值对模型的影响。

这种方法能够有效地提高模型的稳定性和拟合效果。

此外,我们还可以利用鲁棒回归模型来处理异常值。

鲁棒回归模型能够对异常值具有一定的容忍性,通过使用稳健的估计方法,减小异常值对模型参数估计的影响。

这种方法对于含有大量异常值的数据集效果显著,能够提高模型的鲁棒性和预测能力。

回归分析中的数据处理技巧

回归分析中的数据处理技巧在统计学中,回归分析是一种用来探讨自变量与因变量之间关系的重要方法。

在进行回归分析时,数据处理技巧是非常关键的,它直接影响到最终的分析结果和结论。

本文将就回归分析中的数据处理技巧进行讨论,包括数据清洗、变量选择、异常值处理、多重共线性等方面。

数据清洗在进行回归分析之前,首先要对数据进行清洗。

数据清洗是指对数据进行筛选、整理、处理,以便得到干净、完整的数据集。

在数据清洗过程中,需要检查数据是否存在缺失值、异常值、重复值等问题。

对于缺失值,可以选择删除或填充,具体方法要根据实际情况来确定。

对于异常值和重复值,也应该及时处理,以避免对分析结果产生影响。

变量选择在回归分析中,变量选择是非常重要的一环。

合适的变量选择可以提高模型的拟合度和预测能力。

在进行变量选择时,一般可以采用逐步回归、岭回归、Lasso回归等方法。

此外,还可以通过相关性分析、主成分分析等技术来辅助变量选择。

需要注意的是,变量选择时应该考虑自变量之间的相关性以及自变量与因变量之间的相关性,避免多重共线性问题。

异常值处理异常值是指与整体数据模式差异较大的数据点,它们可能会对回归分析的结果产生显著影响。

因此,在进行回归分析时,需要对异常值进行处理。

处理异常值的常用方法包括删除、替换、转换等。

具体方法应根据异常值的性质和数量来确定,需要综合考虑数据的分布情况、样本大小等因素。

多重共线性多重共线性是指自变量之间存在高度相关性的情况,它会导致回归系数估计不准确、方差膨胀因子增大等问题。

因此,需要对多重共线性进行处理。

处理多重共线性的常用方法包括逐步回归、主成分回归、岭回归等。

在进行处理时,应该考虑自变量的实际意义、模型的解释能力等因素。

结语回归分析是一种常用的统计方法,它在实际应用中具有广泛的价值。

而数据处理技巧则是进行回归分析的前提和基础。

本文从数据清洗、变量选择、异常值处理、多重共线性等方面对回归分析中的数据处理技巧进行了讨论,希望对读者们有所帮助。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

回归分析中异常值的诊断与处理1 引言对调查得到的大量原始数据进行加工处理,提取其中有用的信息,即统计整理,是进一步进行统计分析的前提.但是通常的统计整理方法往往都对样本数据有一个前提假设,即样本数据是来自同一个总体,而这个假设有时却不能成立.原因一是由客观因素造成的,如总体条件的突然变化或人们未知的某个因素的突然出现等等;二是由主观方面的因素造成的,即人为的差错如调查人员读错或抄错数据,不小心把另一些不同条件下的样本数据混杂进来.当样本中的个别数据明显的偏离样本中其余数据时,这些数据可能是来自不同的总体,我们称这样的数据为异常数据.若对混有异常数据的样本按常规进行统计整理、分析、推断,往往会得出不符合实际的结论.本文就样本中的异常数据提出了诊断方法和处理方法,并结合实例说明了简单回归中上述方法的具体应用.2 异常值的概念所谓异常值就是在所获统计数据中相对误差较大的观察数据,也称奇异值(Outliers).狭义地定义异常值就是一批数据中有部分数据与其余数据相比明显不一致的数据,也称离群值.社会经济统计中一切失实数据统称为异常值.由于人为或随机因素的影响,失实的数据随时都有可能出现,因而统计数据中的任何一个都有可能成为异常值,而狭义界定的异常值是指离群值,如果把统计数据按由小到大排列,若有异常值,它必位于其数据的两端,左端称为异常小值,右端的称为异常大值.残差:考虑线性回归模型y X e β=+,()0E e =,()2n Cov e I σ=.()1 其中 ⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y y 21,⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=---1,11,2211,111111p n n p p x x x x x x X ,⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=-110p ββββ ,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n e e e e 21. 分量形式为011,11i i i p p i y x x e βββ--=++++,n i ,, 1=.()2 定义ˆˆˆey y y X β=-=-为残差向量,其中ˆˆy X β=称为拟合值向量,βˆ为β在模型()1下的最小二乘估计.如果用n x x '',1表示X 的n 个行向量,则称 ˆˆi i i ey x β'=-, n i ,, 1=, 为第i 次试验或观测的残差.对简单回归,12111n x x X x ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y y 21,⎥⎦⎤⎢⎣⎡=10βββ.则ˆˆiiie y x β'=-,n i ,, 1=,其中()1,iix x '=.于是,异常值就是在回归分析中,一组数据()i i y x ,'如果它的残差i eˆ较其它组数据的残差大的多,则称此数据为异常值.异常值的出现有主客观的原因.主观上抽样调查技术有问题,疏忽大意记错,或人为的虚报,谎报数据等都可能导致异常数据,这直接影响了统计数据的质量;客观上某些样品由于特定原因在某些变量上的确表现突出,明显超出平均水平,这也可能产生异常值.异常值的存在必将导致相应统计分析误差增大,会对分析结果(平均值与标准差)产生重要影响,会降低测量的精度.如果不预先处理它们,用通常的统计整理方法所得出的结论可靠性差.而异常值的诊断与处理是保证原始数据可靠性,平均值与标准差计算准确性的前提.3 异常值的诊断方法在讨论异常值诊断问题时,通常要假设所得样本观测值在某中意义下遵从一定的分布规律.拿到一批数据,若能从其实际背景中明确看出它服从某中分布形式时,一般的做法是在这种分布假设下,导出能较好反映异常值与正常值差异的统计量,在没有异常值的原假设下作假设检验.以下给出两种检验方法.3.1 F 分布检验法学生化残差:考虑线性回归模型()1,记ˆˆyX β=,称y ˆ为拟合值向量,称其第i 个分量βˆˆi i x y'=为第i 个拟合值,则 ()1ˆy X X X X y Hy -''==,这里()1H X X X X -''=.文献中通常称H 为帽子矩阵.前面已经定义了ˆˆi i i ey x β'=-, n i ,, 1=, 为第i 次试验或观测的残差.将其标准化为iii h e-1ˆσ,再用σˆ代替σ,得到所谓学生化残差ii i i h e r -=1ˆˆσ, n i , ,1=,这里ii h 为H 的第i 个对角元,pn eni i-=∑=122ˆˆσ.把正态线性回归模型()1改写成分量形式i i i e x y +'=β,()2,0~σN e i ,n i ,, 1=,这里i e ,)1(n i ,, =相互独立.如果第j 组数据()j j y x ,'是一个异常点,那么它的残差就很大.它的残差之所以很大是因为它的均值()j y E 发生了非随机性漂移η.从而()ηβ+'=j j x y E .这产生了一个新的模型i i ijj j y x e y x e ββη'=+⎧⎪⎨'=++⎪⎩ ()2~0,,i i j e N σ≠ ()3 记[]0,,0,1,0,,0j d '=.将模型()3改写成矩阵的形式j y X d e βη=++, ()I N e 2,0~σ, ()4模型()3和()4称为均值漂移线性回归模型.要判定()j j y x ,'不是异常点,等价于检验假设0=η:H .引理1 用()i y ,()i X 和()i e 分别表示从Y 、X 和e 剔除第i 行所得到的向量或矩.从线性回归模型()1剔除第i 组数据后,剩余的1-n 组数据的线性回归模型为()()()i i i y X e β=+,()()0i E e =,()()21n i Cov e I σ-=. ()5 将从这个模型求到的β的最小二乘估计记为()i βˆ,则 ()()i iii i x X X h e11ˆˆˆ-'--=ββ. 证明:因为()()()()()()1ˆi i i i i X X X y β-''=. ()6设A 为n n ⨯可逆阵,v u 和均为1⨯n 向量.用恒等式()vA u A v u A A v u A 111111-----'-'+='-有()()()()()()()111111i i i i iiiiX X x x X X X X X X x x X X h -----'''''''=-=+-, ()7这里i x '为X 的第i 行.将上式两边右乘X y ',并利用()()i i i i X y X y y x ''=+以及()6式,有()()()()()()iii i ii i i i h x x X X x X X y -''-'+=--1ˆˆˆ11βββ.()8将()7式右乘i x ,可以得到如下关系式()()()()i iii iix X X h x X X 1111--'-='. 将其代入()8式,得到()()i iii i x X X h e11ˆˆˆ-'--=ββ. 引理2 对均值漂移线性回归模型()4,β和η的最小二乘估计分别为()j ββˆ=*和j jje h ˆ11-=*η,其中()j βˆ为从非均值漂移线性回归模型()1剔除第j 组数据后得到的β的最小二乘估计.()()X X X X h H jj ''==-1,jj h 为H 的第j 个对角元.j eˆ为从模型()2导出的第j 个残差. 证明:显然,j j y y d =',1='j j d d .记()12,,,n X x x x '=.则j j x d X ='.于是,根据定义()111j j j j j j X X X Xx X y Xd y d d x y βη-*-*''''⎡⎤⎛⎫⎡⎤⎡⎤⎛⎫⎡⎤==⎢⎥ ⎪ ⎪⎢⎥⎢⎥⎢⎥'''⎢⎥⎣⎦⎝⎭⎣⎦⎣⎦⎝⎭⎣⎦. 根据分块矩阵的逆矩阵公式(见附录1),以及()j j jj x X X x h 1-''=.()()()()()()()()111111111111111111ˆˆ1111ˆ111ˆˆ11ˆ1j j j jj jj j j jj jjj j j j jj jjj j jj jj j j jjj jj X X X X x x X X X X x h h X y y x X X h h X X x x X X x y h h x y h h X X x e h e h βηββββ----**----⎡⎤'''''+-⎢⎥--'⎡⎤⎡⎤⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦⎣⎦''-⎢⎥--⎣⎦⎛⎫'''+- ⎪--⎪= ⎪'-+ ⎪ ⎪--⎝⎭⎛'--=-⎝⎫ ⎪⎪ ⎪ ⎪ ⎪⎭. 再由引理1知命题得证.现在应用引理来求检验0=η:H 的检验统计量.注意到,对现在的情形,在约束条件0=η下,模型()4就化为模型()1,于是=H RSS 模型()1无约束情形下的残差平方和 y X y y ''-'=βˆ. 而模型()4的无约束残差平方和y d y X y y RSS j '-'-'=**'ηβ. ()9利用引理2得()2ˆˆˆ1ˆˆ111H jj j j j j jj jj jjRSS RSS X y d y e y e e x h h h ββηβ**'''-=-+'=-+=---.这里βˆˆj j j x y e'-=为第j 组数据的残差. 利用*β和*η的具体表达式将()9式作进一步化简:jj j j jjj j h y e h y e y X y y RSS ---+''-'=1ˆ1ˆˆˆβ=()jjj h e p n ---1ˆˆ22σ,其中pn eni i-=∑=122ˆˆσ.根据引理2,所求的检验统计量为()()()()22222111ˆ1ˆ1ˆ1jj jj j jj jH r p n r p n h p n e p n p n h e p n RSS RSSRSS F ----=--------=---=σ. 于是,我们证明了如下事实:定理[]2 对于均值漂移线性回归模型()4,如果假设0=η:H 成立,则()1,122~1------=p n j j j F r p n r p n F .据此,我们得到如下检验:对给定的()10<<αα,若()()α1,1221-->----=p n jj j F rp n r p n F ,则判定第j 组数据()j j y x ,'为异常点.当然,这种检验会犯“判无为有”的错误,也就是()jjy x ,'可能不是异常点,而被误判为异常点.但我们犯这种错误的概率只有α,事先我们可以把它控制的很小.显然,根据t 分布与F 分布的关系,我们也可以用t 检验法完成上面的检验.若定义()()212211⎥⎥⎦⎤⎢⎢⎣⎡----==j j j j r p n p n r F t . 对给定的α,当⎪⎭⎫⎝⎛>--21αp n j t t时,我们拒绝假设0=η:H .即判定第j 组数据()j j y x ,'为异常点.3.2 残差及残差图检验异常值前面定义了βˆˆX y e-=,称为残差向量,其分量形式ˆˆi i i e y x β'=-,()1,,i n =,称为第i 次试验或观测的残差.特别地,对简单回归,()i i x x ,1=',n i ,, 1=.⎪⎪⎪⎪⎪⎪⎭⎫ ⎝⎛---=⎥⎦⎤⎢⎣⎡=∑∑==n i i n i i i x n x y x n y x x y 1221110ˆˆˆˆββββ.所以,()i i i x y e 10ˆˆˆββ+-=,n i ,, 1=. 残差是最重要的一种回归诊断量,它蕴涵了有关模型基本假设的许多重要信息.残差分析就是对残差进行统计处理,从中提炼出这些信息的方法.而残差图就是残差分析中使用的基本工具.所谓残差图就是残差i eˆ对因变量y 或自变量n X X X ,, 21,,或其它导出统计量(如拟合值i yˆ)的点子图,有时候也用残差对时间或对数据序数的点子图.最简单的图,尤其在简单回归中,为残差i eˆ对拟合值i y ˆ的图. 所谓异常数据就是相对于其它观测值来说,具有大的残差的数据点.利用残差及残差图检验异常值的方法是用所给数据计算出残差i eˆ,与其余观测值的残差进行比较,具有大的残差的数据点被怀疑为异常值.然后作出自变量与因变量的散点图,残差i eˆ对拟合值i y ˆ的残差图以及残差i eˆ对自变量i x 的残差图,从图中观察,那些远离大多数观测点的孤立的点有理由被认为是异常点.然后从数据中删除这些点,再次估计回归方程,作出X 与Y 的散点图以及i eˆ对i y ˆ的残差图,计算标准差,与删除前进行比较. 4 提出两种处理方法4.1 采用虚拟变量消除异常值的影响(1) 虚拟变量某类变量(如性别、种族、颜色、宗教、国家、战争、地震等)常常表示某属性是否存在,如男或女,黑种人或白种人,教徒或非教徒,对于这类变量可用“数量化”方法设计人为变量来表示,如用 “0”或“1”,“0”表示不存在某种属性,“1”表示存在该属性.例如:用“1”表示男性,“0”表示女性,或用“1”表示大学毕业,“0”表示没有大学毕业,等等.这样假设的变量,如“0”或“1”称为虚拟变量,也称为类型变量或属性变量,它的主要特点就是将一些可以划分为不同类型或属性的变量用“0”和“1”分别表示,即属于某一类型的变量用“1”表示,不属于这一类型的变量用“0”表示.这里用D 表示虚拟变量.(2) 处理异常值的方法在这里,我们用虚拟变量(0或1)把试验数据划分为两类,属于异常值一类用“1”表示,属于正常值一类用“0”表示.引入虚拟变量D ,建立回归方程:01122221ˆˆˆˆˆp p p Y X X X D βββββ---=+++++, 其中⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y Y 21,111,11212,121,1111p p n n p n x x d x x d X x x d ---⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦,011ˆˆˆˆp ββββ-⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦,12n d d D d ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦.特别地,对简单回归,建立回归方程:012ˆˆˆY X D βββ=++, 其中,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=n y y y Y 21,1122111n n x d x d Z x d ⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎣⎦,()0112ˆˆˆˆZ Z Z y ββββ-⎡⎤⎢⎥''==⎢⎥⎢⎥⎢⎥⎣⎦. 利用所给数据,作出回归估计.这样,异常值的影响被虚拟变量D 的系数吸收,从而估计更接近于现实.4.2 剔除异常值的方法对于测定中的异常值的剔除,我们必须持慎重态度,不能贸然从事.否则会出现误删有效数据或保留异常数据的错误.通常处理步骤大致如下:(1)初分析:首先利用所给数据作出回归估计:βˆˆX y=. 其中111,1212,11,1111p p n n p x x xx x x x ---⎡⎤⎢⎥⎢⎥=⎢⎥⎢⎥⎢⎥⎣⎦,()y X X X p ''=⎥⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎢⎣⎡=--1110ˆˆˆˆββββ .特别地,对简单回归,x y 10ˆˆˆββ+=,其中x y 10ˆˆββ-=,∑∑==--=ni ini ii x n xy x n yx 12211ˆβ,并计算标准差:s =值i yˆ、残差i e ˆ,并列入表.然后作出i x 与i y 的散点图,拟合值i y ˆ与残差i e ˆ的残差图,分析判别出异常值.(2)判别出异常值后,从测量数据中删除异常值,然后利用余下的观测值再次作回归估计,同第一步,计算标准差、拟合值以及残差,作出删除异常数据后的散点图与残差图.(3)对比删除异常值前后的标准差以及残差图.对于单一可疑异常数据,直接按上述步骤进行剔除异常值.对于多个可疑异常值的情况,上述剔除步骤反复逐次进行至无可剔除为止.通常可采用两种方法:向前逐一剔除法(从极大值依次向次大值逐一剔除)和向后逐一剔除法(从可疑的j 个最大值依次从小到大逐一剔除).5 实例分析5.1 实例一假定某调查数据X 和Y 由表1中给出.表1 数据X 和Y根据表中数据作回归估计,得回归方程:ˆ0.6610.837yx =+.并算得 ()()457.0ˆ112212=---=∑∑==n i ini i iy yy yR .表2 各组数据的诊断统计量()120.05 3.65t =.从表2最后一列可以看出只有841.96=t 超过这个值,于是我们诊断出第六号数据为异常值.然后引入虚拟变量D ,建立回归方程:D x Y 210ˆˆˆβββ++=,作回归估计.令 βˆZ Y =,⎥⎥⎥⎥⎦⎤⎢⎢⎢⎢⎣⎡=15152211111d x d xd x Z ,()y Z Z Z ''=⎥⎥⎥⎦⎤⎢⎢⎢⎣⎡=-1210ˆˆˆˆββββ. 得0ˆ0.303β=-,1ˆ 1.007β=,2ˆ 4.985β=.所以,回归模型为:ˆ0.303 1.007 4.985y x D =-++.并且算得993.02=R .从2R 的值来看,这个回归方程[见图2中()2]要比未采用虚拟变量所估计的回归方程[见图2中()1]其拟合程度好多了.这是因为异常值的影响被虚拟变量D 的系数吸收,所以比处理前求得的估计值更接近于现实.因此虚拟变量是消除异常值的影响,探求变量之间真正关系的一种有效方法.01234567812345675.2 实例二表3给出了Forbes 数据.表3 Forbes 数据根据表中数据,(气压用100log ⨯的数据),估计回归方程,算得x y 895.0131.42ˆ+-=.计算出Forbes 数据的拟合值及残差,如表4,进一步作出散点图(图3)、残差i eˆ对拟合值i y ˆ的残差图(图4).表4 Forbes 数据的拟合值及残差-0.6-0.4-0.200.20.40.60.811.21.41.6比较表中所列的残差,并观察残差图,我们发现序号12的残差比其它的残差大的多.其它残差的绝对值都小于0.35,而第12号数据的残差为1.36.并且从残差图(图4)中观察到第12号数据的跳跃度比较大,远离其它点.由残差及残差图法诊断出第12号数据为异常数据.然后剔除第12号数据.再估计回归方程,重新拟合数据,检查参数估计,拟合值,残差方差的变化.删除第12号数据后,得到回归方程:x y891.0302.41ˆ+-=. 表5 Forbes 数据中删除12号数据后的拟合值及残差图4 Forbes 数据的残差图ˆi yˆi e-2.5-2-1.5-1-0.50.511.522.5表6 删除异常值前后的比较量对删除异常值前后的结果进行对比,我们得到对于删除前后获得的参数估计基本是相同的,所以第12号数据是无关的.但是,第12号数据在标准误差上的影响要显著些.删除后标准误差减小约3.1倍,方差减小约10倍.并且,从删除异常值获得的残差图()图5和散点图(图6)显示出,对余下的16个数据无明显的拟合失败.图5 Forbes 数据中删除12号数据后的残差图ˆi yˆi e6 结束语异常值的诊断与处理问题是一个很有实际意义的问题,是一个逐步研究逐步实践的问题.但迄今为止,还没有一种广泛适用的方法,本文所介绍的方法也是一种尝试,对于异常值的诊断与处理问题的研究还有待于进一步完善.致谢本文在撰写过程中得到了李惠东老师的悉心指导和大力支持.在论文撰写过程中遇到的难点和疑点李老师都给我作了详细的讲解,并提供了许多有参考价值的资料和专业软件,使我学到了很多知识和方法.在此表示深深的敬意与感谢.参考文献[1] 魏立力.概率论与数理统计[M].银川:宁夏人民出版社,1999.[2] 王松桂等.线性模型引论[M].北京:科学出版社,2004.[3] 何平.剔除测量数据中异常值的若干方法[J].数理统计与管理,1995,(1):19-22.[4] 王静龙,梁小筠,等译.应用线性回归[M].北京:中国统计出版社,1998.[5] 刘宗鹤,赵明强译.计量经济学概论[M].北京:农业出版社,1988.附录1:分块矩阵的逆矩阵:设0>A ,将其分块为:⎥⎦⎤⎢⎣⎡=22211211A A A AA ,则它的逆矩阵 ⎥⎦⎤⎢⎣⎡--+=-⋅--⋅-⋅---⋅---1122111211122112212111111211122*********A A A A A A A A A A A A A A=⎥⎦⎤⎢⎣⎡+----⋅---⋅---⋅-⋅122121************211211221221212111211A A A A A A A A A A A A A . 这里 121112122122A A A A A -⋅-=,211221211211A A A A A -⋅-=.附录2:SPSS处理实例1数据:1.未用虚拟变量的数据处理:RegressionModel Summary(b)b Dependent Variable: YCoefficients(a)Casewise Diagnostics(a)2.引进虚拟变量后的数据处理:Model Summary(b)b Dependent Variable: YCoefficients(a)Casewise Diagnostics(a)附录3:SPSS处理实例2的数据:1.删除前的数据处理:Coefficients(a)a Dependent Variable: YModel Summary(b)a Predictors: (Constant), Xb Dependent Variable: YCasewise Diagnostics(a)a Dependent Variable: Y2.删除后的数据处理:a Dependent Variable: YModel Summary(b)b Dependent Variable: YCasewise Diagnostics(b)a Missing Caseb Dependent Variable: Y。