面向热点新闻的爬虫系统设计与实现

Python网络爬虫技术在新闻媒体领域的应用与实践

Python网络爬虫技术在新闻媒体领域的应用与实践随着互联网的快速发展,新闻媒体行业也面临着巨大的变革。

传统的新闻采访和报道方式已经无法满足大众获取信息的需求,而Python 网络爬虫技术的出现,为新闻媒体领域带来了新的机遇和挑战。

本文将探讨Python网络爬虫技术在新闻媒体领域的应用与实践。

一、Python网络爬虫技术的概述Python网络爬虫技术是指利用Python编程语言进行网页内容的抓取和分析,通过模拟人工操作来实现自动化的数据采集。

Python语言具有简单易学、功能强大、应用广泛等特点,因此成为了网络爬虫开发的首选工具。

二、Python网络爬虫技术在新闻媒体领域的应用1. 新闻采集与分析通过Python网络爬虫技术,可以自动从各大新闻媒体网站上收集新闻内容,并进行分析和整理。

这样一来,新闻编辑人员可以更加高效地获取各种类型的新闻信息,同时还能够分析用户对不同新闻话题的关注度,从而优化新闻报道的策略。

2. 舆情监测与分析Python网络爬虫技术也可以应用于舆情监测与分析领域。

通过定制化的爬虫程序,可以自动抓取社交媒体、论坛、博客等平台上的用户评论和意见,从而对公众对某一具体事件或话题的情感倾向进行分析。

这对于新闻媒体来说是一个重要的参考因素,可以帮助他们更好地把握社会热点,提供用户感兴趣的新闻内容。

3. 数据可视化与呈现Python网络爬虫技术在新闻媒体领域的另一个应用就是数据的可视化与呈现。

通过抓取大量的新闻数据并进行分析,可以生成各种形式的图表和统计报告,直观地展现新闻事件的发展趋势和影响力。

这不仅为新闻机构提供了一个直观的参考依据,也增加了用户在新闻阅读和信息获取过程中的可视化体验。

三、Python网络爬虫技术应用的挑战与解决方案1. 网站数据的动态加载目前,很多网站采用了动态加载的方式来呈现数据,这给爬虫程序的编写带来了一定的难度。

为了应对这个问题,可以使用Selenium等工具来模拟用户浏览器的操作,从而实现数据的正确抓取。

爬虫----爬取搜狐新闻时政类

爬⾍----爬取搜狐新闻时政类⼀、整体流程获取url——爬取出版社及新闻名称及其超链接——解析数据——存储数据⼆、分析观察页⾯发现,搜狐新闻页⾯属于动态页⾯(动态页⾯也可采取selenium获取数据,效率⽐较慢)打开network,XHR并没有想要的内容,所以得换个思路network中杂七杂⼋的请求⽐较多,可以过滤掉便于查看可疑请求在ALL中发现该⽂件有需要的内容分析⼀下url发现page每次变化可以采⽤字符串拼接出来url三、代码实现import requestsimport re# 获取数据def get_one_page(url):response = requests.get(url)return response.text# 采⽤正则进⾏提取数据def parse_one_page(data):result = re.findall(r'(\"title\":\".*?\").*?(\"authorName\":\".*?\").*?(\"originalSource\":\".*?\")', data)return result# 写⼊数据def write_to_file(content):with open('result.txt', 'a', encoding='utf-8') as f:f.write(content)# 根据page获取数据def main(page):url = "https:///public-api/feed?scene=CATEGORY&sceneId=1460&size=20&page=" + str(page)data = get_one_page(url)for item in parse_one_page(data):write_to_file(str(item))if __name__ == '__main__':for i in range(1, 20):main(page=i)四、结果。

基于网络爬虫技术的舆情监测系统设计与实现

基于网络爬虫技术的舆情监测系统设计与实现一、引言近年来,随着互联网的迅猛发展,如何通过海量的网络信息获取对社会事件的有用信息成为了一项重要课题。

在这个背景下,通过网络爬虫技术设计舆情监测系统,对舆论进行定性及定量的分析及研究,已经成为了舆情研究中不可或缺的重要手段。

本文将基于网络爬虫技术设计并实现一个舆情监测系统。

在本文中我们将介绍舆情监测系统的设计思路、实现细节及其功能。

二、舆情监测系统的设计思路1. 系统架构本系统采用B/S结构,即浏览器(Browser)/服务器(Server)结构。

在这种结构下,用户可以在任何有网络连接的地方通过浏览器访问该系统,在服务器端对用户发出的请求做出相应的处理后返回给用户。

2. 数据获取为了获取多个不同来源的在线数据,我们采用网页爬虫技术,使用Python编写网络爬虫程序,自动化获取、清洗、处理从多个特定网站上收集的数据,收集舆情信息的来源广泛,包括官方媒体、社交媒体等。

3. 数据分析在舆情监测系统中,数据分析是非常重要的一环。

我们会对收集到的数据进行如下几个方面的分析:(1)情感分析:本系统将通过文本分析技术对文本进行判断,确定其蕴含的情感色彩,判断是否具有积极或消极倾向。

(2)话题聚类:对所有收集到的数据进行语义分析,确定语义相似度,并进行聚类。

(3)事件检测:通过时间和空间等维度进行数据分析,将数据分为不同的事件类别,并根据数据量的变化情况,预警事件。

三、舆情监测系统的功能1. 舆情监测本系统可以根据设定的规则,自动化地采集相关的数据、分析、展示舆情信息,提供数据报表、可视化等信息。

2. 舆情预警当系统检测到一些特定的事件发生时,可以及时向舆论监测人员发出信息报警,及时稳定局势、缓和矛盾,避免因误判而出现不良后果。

3. 舆情分析本系统通过对爬取数据进行情感分析、话题聚类、事件检测等多种分析,对舆情进行可视化展示,便于舆论监测人员更细致地分析舆情信息。

4. 数据查询该系统提供舆情数据筛选查询功能,让舆论监测人员可以根据需求快速查询舆情数据,对于舆情事件的发展有全面的把握。

新闻爬虫如何实现

新闻爬虫如何实现新闻爬虫如何实现?或者说如何利用爬虫爬取到我所需要的的新闻信息。

首先我们应该了解何为爬虫,新闻爬虫只是整个爬虫家族的一份子。

爬虫的英文名叫spider,解释为蜘蛛,对于不太了解互联网的人来说,可能不太能理解爬虫到底是什么意思,那爬虫到底是什么意思呢。

爬虫软件又是什么,可以用来作什么呢?所谓爬虫,简单来说其实就是一个程序,你也可以理解为一段代码,它是按照一定的规则来自动获取并采集互联网的信息和数据的,这些数据可以是来源于各个网站、APP、应用软件等。

举个例子,我们常用的搜索引擎某度等其实就是一个特殊的巨大的爬虫,它能根据我们输入的内容自动去采集整个互联网上和你输入内容相关的数据,然后将爬虫采集到的数据结果展示给你,就是你看到的搜索结果。

所以,爬虫软件就是可以收集大量网页信息的软件。

假如你想要收集某家资讯平台最近一个月比较热门的文章,或者是想了解最近招聘网站有关金融行业的岗位信息,就可以借助爬虫工具来帮你获取想要的数据。

当然,如果你爬虫代码写的比较好,也可以自己写代码解决这个问题。

对于零编程基础的人来说,选择一款好用的爬虫软件,可以提高工作效率,达到事半功倍的效果。

这里给大家推荐一款好用的爬虫工具——八爪鱼,这是一款上手及其容易的爬虫工具,很适合想采集数据但是不会写爬虫代码的人。

到八爪鱼官网下载安装之后打开客户端,选择简易模式,找到目标网站的简易模板,就可以进行网页采集了。

下面我们来看一下这个工具是怎么操作的。

以东方财经网的财经新闻爬取为例:爬取字段:新闻标题,新闻发布时间,吧龄,作者,来源及编辑,影响力,发表客户端,页面网址,财经新闻内容。

需要采集东方财经网里详细内容的,在网页简易模式界面里点击东方财经网,进去之后可以看到关于东方财经网的三个规则信息,我们依次直接使用就可以的。

新闻爬虫实现步骤1采集东方财经网-股吧-财经评论吧内容(下图所示)即打开东方财经网主页点击第一个(股吧-财经评论吧)采集搜索到的内容。

基于Python的新浪新闻爬虫系统的设计与实现

在爬 虫开发上具有很高 的效率 。

息 , 将 网 址 在 储 存 时 分 为 两 类 : 己爬 取 和 待 爬 2.2.4数 据 导 出

中 蕾 群 相科 *c

毕 懈

2。19 ∞ 月 21日 ∞ 曲 E∞ 崩 21日 ∞ ts ̄ ,q21日 ∞ ta ̄0atl2lH

1 引 言

新 浪新 闻由新 浪 官方 出品 ,及 时 发布 全 球新 闻资讯,国 内国外要 闻,精彩 的体育赛事 报道 ,金 融财经动 向,影视娱 乐事件 ,还有独 家微博 “微 ”新闻 ,精彩 随你看 ,新 闻、星座、 笑话一个都不少 。新 闻是我们生活 中的一部分, 通过新浪 的新 闻板 块可 以坐在家里看世 界。如 此 多 的新 闻信 息 , 其 中 蕴 含 的 巨大 信 息 量 是 不

f鞋 絮)靠 树 辨 证 辫 麟 懈嚣 酋 往 盎

静睫赡辑

^ 蝇 摊

蜂 謦 博 * 靛 济 斑 氍摧

拱舞 f采#J 簟群报蛹 癣蔗羞

聘孵

馘 蝌醐黼献舣舣 舣 觚瓤触 撑一 幢 稆 啊黻斑的蚺 戈

取样■ 瘴Tl觉 啦帆蝴幡砖肯诲梅艟

砖 璇 艟 培

■ ■ 墟 ^ % 日

∞ I8 Hn 日 ∞ l8举 雌 自n Fi

2 髓往 艚馨 ,

中 嘲新 阚 蹦

∞ IB年 日3月21日

盘往 糖鼍

∞lB卑∞H21日

口 街任 柏辑

新 虫撮

∞ l8 H21日

言而喻的 ,因此 如何获取是十分关键 的。本 文 我们将通过爬虫技 术获取相关新闻信息 。

如 Requests,极大简化 了对 网站的访 问请求 。 在 解 析 HTML源码 时 ,提 供 的 BeautifulSoup 库能用 极简 短的代码 完成过 滤 html标 签并提

使用Python进行网络爬虫的设计与实现

使用Python进行网络爬虫的设计与实现随着互联网的快速发展,网络上的信息量越来越庞大,人们需要从海量数据中获取有用信息。

而网络爬虫作为一种自动化获取网页信息的工具,受到了广泛关注和应用。

Python作为一种简洁、易学、功能强大的编程语言,被广泛应用于网络爬虫的设计与实现中。

本文将介绍如何使用Python进行网络爬虫的设计与实现。

1. 网络爬虫简介网络爬虫(Web Crawler)是一种按照一定规则自动地抓取万维网信息的程序或脚本。

它可以模拟人类浏览网页的行为,访问网页并提取其中的信息。

网络爬虫在搜索引擎、数据挖掘、舆情监控等领域有着广泛的应用。

2. Python语言简介Python是一种高级编程语言,具有简洁、易读、易学的特点,被称为“优雅”、“明确”、“简单”。

Python拥有丰富的第三方库和工具,使得开发者能够快速地实现各种功能。

3. 网络爬虫的设计与实现3.1 确定需求在设计网络爬虫之前,首先需要明确需求。

确定要抓取的网站、要提取的信息以及爬取频率等。

3.2 选择合适的库Python有许多优秀的网络爬虫库,如BeautifulSoup、Scrapy、Requests等。

根据需求选择合适的库进行开发。

3.3 编写爬虫程序编写网络爬虫程序时,需要注意以下几点:设置User-Agent:模拟浏览器发送请求,避免被网站屏蔽。

处理异常:处理网络异常、超时等情况,保证程序稳定运行。

数据解析:使用正则表达式或XPath等方法提取所需信息。

数据存储:将抓取到的数据存储到数据库或文件中。

3.4 遵守法律法规在进行网络爬虫时,需要遵守相关法律法规,尊重网站所有者的权益,不得擅自抓取他人网站数据。

4. 实例演示下面通过一个简单的实例演示如何使用Python进行网络爬虫的设计与实现。

示例代码star:编程语言:pythonimport requestsfrom bs4 import BeautifulSoupurl = '对应网址'headers = {'User-Agent': 'Mozilla/5.0'}response = requests.get(url, headers=headers)soup = BeautifulSoup(response.text, 'html.parser')# 提取标题title = soup.title.textprint('标题:', title)# 提取正文内容content = soup.find('div', class_='content').textprint('内容:', content)示例代码end5. 总结本文介绍了使用Python进行网络爬虫的设计与实现过程,包括确定需求、选择库、编写程序、遵守法律法规等方面。

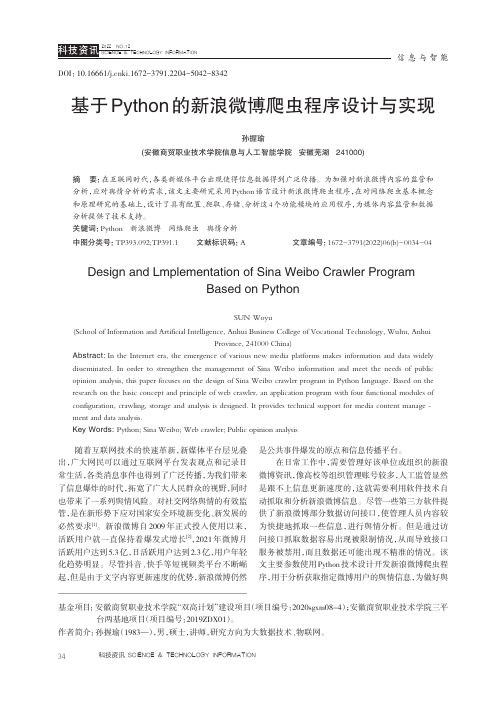

基于Python的新浪微博爬虫程序设计与实现

基于Python的新浪微博爬虫程序设计与实现孙握瑜(安徽商贸职业技术学院信息与人工智能学院安徽芜湖241000)摘要:在互联网时代,各类新媒体平台出现使得信息数据得到广泛传播。

为加强对新浪微博内容的监管和分析,应对舆情分析的需求,该文主要研究采用Python语言设计新浪微博爬虫程序,在对网络爬虫基本概念和原理研究的基础上,设计了具有配置、爬取、存储、分析这4个功能模块的应用程序,为媒体内容监管和数据分析提供了技术支持。

关键词:Python新浪微博网络爬虫舆情分析中图分类号:TP393.092;TP391.1文献标识码:A文章编号:1672-3791(2022)06(b)-0034-04 Design and Lmplementation of Sina Weibo Crawler ProgramBased on PythonSUN Woyu(School of Information and Artificial Intelligence,Anhui Business College of Vocational Technology,Wuhu,AnhuiProvince,241000China)Abstract:In the Internet era,the emergence of various new media platforms makes information and data widely disseminated.In order to strengthen the management of Sina Weibo information and meet the needs of public opinion analysis,this paper focuses on the design of Sina Weibo crawler program in Python language.Based on the research on the basic concept and principle of web crawler,an application program with four functional modules of configuration,crawling,storage and analysis is designed.It provides technical support for media content manage‐ment and data analysis.Key Words:Python;Sina Weibo;Web crawler;Public opinion analysis随着互联网技术的快速革新,新媒体平台层见叠出,广大网民可以通过互联网平台发表观点和记录日常生活,各类消息事件也得到了广泛传播,为我们带来了信息爆炸的时代,拓宽了广大人民群众的视野,同时也带来了一系列舆情风险。

基于Python的新浪新闻爬虫系统的设计与实现

基于Python的新浪新闻爬虫系统的设计与实现作者:陈猛来源:《现代信息科技》2018年第07期摘要:网络爬虫属于网络机器人,也被称为网页蜘蛛。

随着科学技术在人们生活中的不断渗透,对计算机的依赖程度逐渐提升,搜索引擎也变得更加重要,但是以往传统的搜索引擎已经难以满足现代化需求。

对此,本文在Python的基础上研究出了一种新型的网络爬虫,它能够很好地克服传统引擎中存在的弊端,为人们提供更多、更全面的搜索内容。

基于此,本文将以新浪新闻为例,对Python爬虫系统的设计与实现进行分析。

关键词:Python;新浪新闻;爬虫系统中图分类号:TP391.1;TP393.092 文献标识码:A 文章编号:2096-4706(2018)07-0111-02Abstract:The network crawler belongs to the network robot,also known as the web spider. With the continuous infiltration of science and technology in human life,the dependence degree of the computer is increasing gradually,and the search engine is becoming more important. But the traditional search engine has been difficult to meet the needs of modernization. Based on Python,a new type of web crawler is developed. It can overcome the drawbacks in the traditional engine and provide more comprehensive search content for people. Based on this,this article will take Sina News as an example to analyze the design and implementation of Python crawler system.Keywords:Python;Sina News;crawler system0 引言在以往使用传统搜索引擎的过程中,通常会存在一些不需要的信息,这些信息使人们对所需信息的获取受到阻碍,展现出搜索引擎的弊端。

基于网络爬虫技术的新闻舆情预警系统设计与实现

基于网络爬虫技术的新闻舆情预警系统设计与实现随着网络技术的快速发展,越来越多的信息被媒体报道与交流,让人们无法快速了解整个社会的动态变化。

在这种情况下,透过数据与网络技术的应用,可以有效分析整个社会的动态变化,帮助决策者快速依据舆情做出相应的决策。

而基于网络爬虫技术的新闻舆情预警系统,正是为了达到这个目的而设计和实现的。

一、系统设计1.数据源的选择在新闻舆情预警系统的开发过程中,最重要的一点是选择合适的数据源,以便从中获取新闻资讯、评论等信息。

数据源的选择需要根据需求进行分析,目前国内的数据源有众多的选择,但是却不是每个数据源都适用于我们的系统。

因此,我们首先需要评估数据源的可行性,包括信誉度的高低、实时性的好坏、质量的优劣、所覆盖的范围及种类等因素,综合考虑后选择多个合适的数据源进行整合。

2.爬虫的设计爬虫是新闻舆情预警系统的核心部分,它的作用是从各个数据源中获取相关的新闻资讯、评论、转发、点赞等信息。

爬虫模块的设计需要考虑以下几个方面:(1)搜集各类新闻链接,并按照一定规则进行分类整理。

(2)遍历链接,获取相关新闻的标题、时间、正文、配图等。

(3)获取评论信息,同时进行评论情感分析。

(4)获取转发、点赞等数据。

在实现爬虫的过程中,需要注意避免一些限制性规则的触发,如IP被封禁、过于频繁的访问等问题,保证爬虫的稳定性和高效性。

3.文本分析与情感分析模块新闻舆情预警系统采用文本分析技术对所获取的新闻、评论等信息进行处理与分析,提取其中的有用信息,包括关键词、实体、情感等等。

情感分析的算法一般采用基于深度学习的方法,通过自然语言处理技术,从文本中提取出情感信息,判断其为正面还是负面情感。

响应用户进行操作,如定向营销、调整企业舆论方向等。

4.数据可视化与展现因为数据量过大,新闻舆情预警系统需要将爬虫获取到的信息进行整合处理,然后将处理后的结果展示给决策者。

为了更加清晰明了地向决策者展示整个系统的运行状态与舆情变化趋势,新闻舆情预警系统中需要实现数据可视化与展现,目前比较常用的方式是采用仪表盘式的可视化方式。

新闻主题爬虫教案

新闻主题爬虫教案教案标题:新闻主题爬虫教案教案概述:本教案旨在通过教授学生如何使用Python编程语言和爬虫技术来开发一个新闻主题爬虫,以培养学生的计算机编程能力和信息获取与处理能力。

通过本教案的学习,学生将能够理解爬虫的基本原理、掌握Python编程语言的基本知识,并能够设计和实现一个基于新闻主题的爬虫程序。

教案目标:1. 理解爬虫的基本原理和工作流程;2. 掌握Python编程语言的基本语法和常用库;3. 学会使用Python编写爬虫程序;4. 能够设计和实现一个基于新闻主题的爬虫程序;5. 培养学生的信息获取与处理能力。

教案内容:一、爬虫基础知识介绍(30分钟)1. 什么是爬虫?2. 爬虫的工作原理和流程3. 爬虫的应用领域二、Python编程基础(60分钟)1. Python的基本语法和数据类型2. Python常用库的介绍:requests、BeautifulSoup等3. Python的文件读写操作三、设计新闻主题爬虫(90分钟)1. 确定爬取的新闻网站和主题2. 分析网页结构和内容,确定需要爬取的数据3. 使用Python编写爬虫程序,实现数据的获取和保存四、爬虫程序的优化与扩展(60分钟)1. 爬虫程序的性能优化技巧2. 处理反爬虫机制3. 数据清洗与处理五、实践与应用(120分钟)1. 学生根据自己的兴趣和实际需求设计和实现一个新闻主题爬虫程序2. 学生进行实践操作,运行自己编写的爬虫程序3. 学生对爬取的数据进行分析和处理教学方法:1. 讲授与演示相结合:教师通过讲解爬虫原理和Python编程知识,结合实际案例进行演示。

2. 实践操作:学生通过实践操作,编写和运行自己的爬虫程序,加深对知识的理解和掌握。

3. 小组合作:鼓励学生在小组内进行合作,共同解决问题和完成实践任务。

评估与反馈:1. 课堂练习:通过课堂练习,考察学生对爬虫原理和Python编程的理解和掌握程度。

2. 项目作业:要求学生设计和实现一个新闻主题爬虫程序,并提交相应的代码和实验报告。

基于数据爬取的新闻宣传信息系统的设计与实现

基于数据爬取的新闻宣传信息系统的设计与实现下载提示:该文档是本店铺精心编制而成的,希望大家下载后,能够帮助大家解决实际问题。

文档下载后可定制修改,请根据实际需要进行调整和使用,谢谢!本店铺为大家提供各种类型的实用资料,如教育随笔、日记赏析、句子摘抄、古诗大全、经典美文、话题作文、工作总结、词语解析、文案摘录、其他资料等等,想了解不同资料格式和写法,敬请关注!Download tips: This document is carefully compiled by this editor. I hope that after you download it, it can help you solve practical problems. The document can be customized and modified after downloading, please adjust and use it according to actual needs, thank you! In addition, this shop provides you with various types of practical materials, such as educational essays, diary appreciation, sentence excerpts, ancient poems, classic articles, topic composition, work summary, word parsing, copy excerpts, other materials and so on, want to know different data formats and writing methods, please pay attention!一、引言随着互联网的迅猛发展,新闻媒体的传播方式也在发生着革命性的变化。

基于网络爬虫的在线舆情分析系统设计与实现

基于网络爬虫的在线舆情分析系统设计与实现网络爬虫是一种自动化工具,可以获取互联网上大量的数据并进行分析。

在当今社交媒体快速发展的背景下,舆情分析成为了企业和政府重要的工作之一。

基于网络爬虫的在线舆情分析系统的设计与实现,为用户提供了一个快速、高效地获取和分析舆情信息的平台。

系统的设计与实现过程可以分为四个主要步骤:数据获取、数据清洗、情感分析和可视化展示。

首先,在数据获取阶段,使用网络爬虫技术自动从各大社交媒体平台、新闻网站等获取大量的舆情数据。

网络爬虫根据关键词搜索和分类的需求,自动从互联网上收集数据,并将其存储在数据库中,以便后续分析。

其次,在数据清洗阶段,对爬取到的数据进行清洗和预处理。

这个步骤主要包括去除重复数据、去除垃圾信息、去除表情符号等。

清洗后的数据将被存储和用于后续的情感分析。

然后,进行情感分析。

利用自然语言处理技术和机器学习算法对清洗后的数据进行情感倾向性分析。

情感分析的目标是判断文本的情感态度,通常分为正面情感、负面情感和中性情感。

在情感分析过程中,可以应用词典匹配、机器学习等方法来实现。

根据分析结果,可以对舆情进行分类和统计。

最后,通过可视化展示来呈现舆情分析的结果。

设计直观清晰的图表、柱状图、词云等图表形式,可以直观地展示舆情数据的分布情况和趋势变化。

用户可以通过系统的界面来查询特定关键字的舆情信息,并可以根据需要进行数据筛选和组织。

为了实现一个高效可靠的基于网络爬虫的在线舆情分析系统,需要考虑以下几个关键点:首先,要合理选择舆情数据源。

根据用户需求和分析目标,选择适合的社交媒体平台和新闻网站进行数据获取。

不同的数据源可能有不同的特点和难点,需要根据实际情况进行相应的数据获取策略。

其次,要充分利用自然语言处理技术和机器学习算法。

这些技术和算法能够帮助我们对舆情数据进行情感分析和分类,提高分析的准确性和效率。

可以利用已有的情感词典和训练自己的模型,以适应不同领域和语境的舆情分析需求。

新闻爬虫系统的设计与实现毕业论文

摘要随着计算机网络在世界范围的飞速发展,互联网作为最具潜力与活力的媒体已经被公认是继报纸,广播,电视之后的“第四媒体",成为反映社会新闻热点的重要载体.为了及时了解网络新闻热点,相关机构引入了新闻热点分析系统。

本文设计的新闻爬虫系统是新闻热点分析系统的数据源,负责新闻信息的采集。

本文借助于爬虫领域的相关技术与工具,结合新闻热点分析系统的需求从原理或工作流程上详细论述了爬虫系统中核心模块的具体实现。

本文所描述的新闻爬虫系统其数据来源主要是新浪新闻,首先利用爬虫工具将新闻数据获取到本地数据库中,然后将新闻信息以及新闻分析的结果将在前台网页中进行可视化输出.本文主要进行了以下几个方面的工作:1)利用Java语言结合HTTPClient开源工具编写了一个针对新浪新闻的可扩展的网络爬虫,该爬虫程序能够按照广度优先的爬行策略对新闻数据(包括图片信息)进行全面的定向抓取以及周期性的增量抓取;2)采用HTMLParser对获取到的新闻信息进行元数据抽取,将新闻的编号、标题、内容、发布方、发布时间等元数据以及新闻图片等元数据解析出来并存入SQL Server数据库中;3)前端界面利用开源AJAX框架ExtJS结合Servlet进行实现,兼顾用户交互方式的多样性以及系统的跨浏览器兼容性。

通过使用该新闻爬取系统,用户能够实时的更新新闻信息,及时、全面、准确地掌握新闻热点动态,提高对于重大突发事件的处理能力,对于更及时,全面的了解各地的实时信息具有重要意义。

关键词:新闻热点,网络爬虫,元数据抽取,可视化ABSTRACTWith the rapid development of World Wide Web(WWW),it is widely accepted that the internet,called the Fourth Media,will be the most potential and energetic media after newspaper,radio and television as an important carrier of the hot society news。

基于Python的新浪新闻爬虫系统的设计与实现

基于Python的新浪新闻爬虫系统的设计与实现作者:于韬李伟代丽伟来源:《电子技术与软件工程》2018年第09期摘要随着大数据时代的到来,数据量呈几何倍增长。

以新浪新闻为代表的一系列新闻检索网站蕴含着大量的数据资源。

本文以新浪新闻为研究对象,利用Python爬虫技术实现网页下载与网页解析,完成了对目标数据的高效获取,并将获取的信息进行格式化存储。

实验结果表明,本文所提出的程序实现了网页数据的快速获取,为后续的数据挖掘提供支持。

【关键词】大数据 Python 爬虫新浪新闻1 引言新浪新闻由新浪官方出品,及时发布全球新闻资讯,国内国外要闻,精彩的体育赛事报道,金融财经动向,影视娱乐事件,还有独家微博“微”新闻,精彩随你看,新闻、星座、笑话一个都不少。

新闻是我们生活中的一部分,通过新浪的新闻板块可以坐在家里看世界。

如此多的新闻信息,其中蕴含的巨大信息量是不言而喻的,因此如何获取是十分关键的。

本文我们将通过爬虫技术获取相关新闻信息。

Python作为一种语法简洁的程序设计语言,对于爬虫开发上有很多优势,在发送HTTP请求时,Python提供优秀的第三方包譬如Requests,极大简化了对网站的访问请求。

在解析HTML源码时,提供的BeautifuISoup库能用极简短的代码完成过滤html标签并提取文本的工作。

利用Python中的pandas可以对获取到的数据进行整理、储存。

对于网站的反爬机制,Python提供了更为简便的解决方案,可以使用Requests库得到一个代理IP。

Python拥有足够多的简洁的语法和库的支持,使得它在爬虫开发上具有很高的效率。

本文提出的爬虫程序通过获取相关新闻信息,并将数据保存到本地,方便对数据的挖掘与分析。

使用本程序可以节省获取数据的时间,使用户可以将更多精力放在数据分析上面。

2 基于Python的新浪新闻爬虫设计2.1 爬虫系统设计需求设计爬虫系统需要解决以下几个问题:(1)评论数的获取:通过页面链接获取新闻id,然后传递获取评论数。

基于网络爬虫的新闻网站自动生成系统的设计与实现

网络天地• Network World18 •电子技术与软件工程 Electronic Technology & Software Engineering【关键词】网络爬虫 静态网页 新闻模板1 绪论网络媒体随着网络技术的发展迅速壮大,这使得人们能够更快地获取新闻信息。

网络媒体的新闻来源有来自于自己所采访的新闻,也基于网络爬虫的新闻网站自动生成系统的设计与实现文/刘晖 石倩有许多引用自其他的网站。

如何快速准确地采集新闻,更新新闻网站成为网络媒体的一个重要问题。

2 研究进展早期的新闻采集大多靠人工去搜索和整理,直到网络爬虫技术的出现才使得人工得以解放,大大提高了新闻的采集速度。

为了更加快速准确地抓取网页,Cho[1]等人在爬虫中引入了网页抓取策略的概念。

针对特定领域的新闻,王辛[2]等人基于站点分类的网页抓取策略,设计了即时新闻采集分析系统。

虽然现在有了不少爬虫框架,陈欢[3]等人也利用Scrapy 爬虫框架设计了有效的网络新闻爬虫。

但由于网络中的网页中存在着大量的与新闻无关的噪声信息,如何去除噪声,快速有效地找到有效的新闻信息近年被广泛地研究。

陈西安[4]提出了基于网页文本标签特征挖掘的网页正文提取方法来解决噪声问题。

快速新闻网站生成系统的重要组成部分,除了快速采集新闻,还有新闻页面模板。

新闻页面模板可以为采集到的新闻内容自动生成新闻页面,这能大大加快新网网站内容更新速度。

另一方面,可以借助新闻页面模板,将新闻网页转换成静态网页,这能大大提高用户访问页面的速度。

王莉利[5]等人提出的将动静技术相结合的思路则能够既保留动态网站的交互性,又克服传统网站访问效率低、并发性差的问题。

3 系统分析和设计3.1 系统功能模块划分本文根据新闻网站采集和更新的相关功能需求,设计一个新闻网站自动生成系统,它包括“新闻采集管理”、“新闻管理”、“新闻模板管理”三部分。

通过管理新闻网站网址及新闻内容的特殊标签,让爬虫根据预先设置的参数迅速地采集新闻信息,并利用网页模板自动生成新闻静态网页,从而达到新闻网站自增强党员间的知识、心得分享,共创和谐党建新生活。

Python网络爬虫在新闻与媒体行业中的应用案例

Python网络爬虫在新闻与媒体行业中的应用案例近年来,随着信息技术的快速发展和互联网的普及,新闻与媒体行业对于大数据的需求日益增长。

为了从海量的信息中提取有价值的数据,并在短时间内进行处理和分析,Python网络爬虫成为了新闻与媒体行业中不可或缺的工具。

本文将介绍几个Python网络爬虫在新闻与媒体行业中的应用案例。

1. 新闻信息采集在一个动态快速变化的新闻环境中,及时获取新闻信息对于新闻机构来说非常重要。

Python网络爬虫可以帮助新闻机构从各种网站和社交媒体平台上抓取新闻信息,并自动进行整理和分类。

这样,新闻机构就能够更快速地获取最新的新闻动态,为读者提供准确及时的报道。

2. 媒体舆情分析随着社交媒体的兴起,越来越多的用户在社交平台上发表对事件的看法和评论。

Python网络爬虫可以帮助媒体机构从社交媒体平台上抓取用户的评论和意见,并进行情感分析和主题分析。

媒体机构可以通过这些数据了解公众对于某一事件的态度和看法,从而更好地把握公众情绪,为报道提供参考依据。

3. 数据可视化在新闻与媒体行业中,数据可视化是一种直观表达方式,可以帮助读者更好地理解复杂的数据信息。

Python网络爬虫可以从各种数据源中抓取数据,并使用数据可视化工具进行展示。

通过将数据转化为图表、地图等可视化形式,读者可以更加直观地了解数据背后的故事,提高阅读体验。

4. 内容推荐在大量的新闻内容中,如何根据用户的个人兴趣和偏好进行内容推荐,是新闻与媒体行业面临的一个重要问题。

Python网络爬虫可以通过抓取用户的浏览历史、点击记录等数据,进行个性化推荐。

通过分析用户的偏好,系统可以向用户推荐更加符合其兴趣的新闻内容,提高用户的阅读体验。

5. 数据挖掘和预测Python网络爬虫可以从新闻与媒体行业的各个数据源中抓取数据,并进行数据挖掘和预测。

通过对大量数据的分析,新闻机构可以发现隐藏在数据中的规律和趋势,为决策提供依据。

例如,可以通过抓取股票新闻和财经数据,预测股票价格的走势。

基于Python的网络爬虫系统设计与实现

基于Python的网络爬虫系统设计与实现网络爬虫是一种利用网络技术自动访问和提取信息的程序,它可以按照一定的规则和算法,自动从互联网上抓取各类数据,并进行处理和分析。

在当今信息爆炸的时代,网络爬虫在多个领域有着广泛的应用。

基于Python的网络爬虫系统设计与实现,可以帮助用户高效、准确地获取网页中的数据,从而节省时间和人力成本。

在本文中,将介绍基于Python的网络爬虫系统的设计与实现,以及其应用方面的一些案例。

首先,基于Python的网络爬虫系统的设计需要考虑以下几个方面:1. 网络爬虫的目标和需求:确定爬取哪些网站或特定页面的数据,确定所需数据的类型和格式,以及设定合理的爬取策略和频率。

2. 网络爬虫的架构和模块划分:按照系统的功能,将网络爬虫系统划分为不同的模块,如下载模块、解析模块、存储模块等,从而实现各个模块的独立性和可复用性。

3. 爬取算法和策略:设计一种高效的爬取算法,在考虑到目标网站的反爬虫策略的同时,尽可能地减少网络请求和资源的浪费。

其次,基于Python的网络爬虫系统的实现可以按照以下步骤进行:1. 网页下载:利用Python的网络爬虫库,如Requests库或Scrapy库,实现网页的下载和保存。

2. 数据解析:使用Python的解析库,如BeautifulSoup或PyQuery,对下载下来的网页进行解析,提取所需的数据。

3. 数据存储:将解析得到的数据存储到数据库或者文件中,以备后续的数据分析和处理。

4. 反爬虫策略:合理设置爬取的频率和请求头,规避网站的反爬虫策略,例如设置合适的请求头信息、使用代理IP、使用延时等手段。

5. 异常处理和日志记录:对于网络请求、数据解析等可能出现异常的情况,要进行适当的异常处理,并记录相应的错误日志,以便后续的问题排查和修复。

最后,基于Python的网络爬虫系统的应用具有广泛的领域。

以下是一些常见的应用案例:1. 数据采集和分析:网络爬虫可以帮助用户从互联网上抓取大量的数据,并进行预处理和分析,用于市场调研、舆情监测、数据挖掘等。

基于python的新闻检索系统的设计与实现

基于python的新闻检索系统的设计与实现本文将介绍基于Python的新闻检索系统的设计与实现。

一、概述随着互联网技术和移动互联网的发展,人们获取新闻的渠道也越来越多样化。

本文旨在设计并实现一个基于Python的新闻检索系统,为用户提供一个快速、方便的查询新闻的工具。

二、功能要求本系统主要实现以下功能:1. 检索功能:用户可以根据关键词检索新闻,并按时间顺序显示结果。

2. 分类功能:将新闻按照不同的分类显示,如政治、经济、社会等。

3. 排序功能:用户可以根据相应的排序规则将检索结果排序,如按时间、按相关度等。

4. 收藏功能:用户可以将感兴趣的新闻添加到收藏夹中,以便下次查看。

三、系统设计1. 数据库设计为了存储新闻数据,需要设计一个数据库。

本系统采用MySQL关系型数据库进行设计,包括以下表:- news_info:存储新闻的基本信息,包括新闻标题、内容、发布时间、来源、分类等字段。

- user_info:存储用户的基本信息,包括用户名、密码等字段。

- news_collection:存储用户收藏的新闻信息,包括用户ID、新闻ID、收藏时间等字段。

2. 爬虫设计为了获取新闻数据,需要设计一个爬虫程序。

本系统采用Python 的爬虫框架Scrapy进行设计,包括以下模块:- spider:爬取新闻网站上的新闻数据,并将数据存储到数据库中。

- pipeline:对爬取到的数据进行简单的去重和过滤,保证数据的准确性。

- scheduler:设置定时任务,在每天定时执行爬虫程序,更新数据库中的新闻数据。

3. 检索功能设计本系统采用Elasticsearch搜索引擎进行检索,提供快速、准确的搜索结果。

具体实现过程为:- 建立索引:将数据库中的新闻数据按照指定的字段建立索引,方便搜索引擎检索。

- 查询功能:用户输入关键词后,将关键词作为查询条件进行搜索,将结果按时间顺序进行排序,并返回给用户。

4. 分类功能设计为了实现将新闻按照不同的分类进行显示,需要对新闻进行分类。

爬取百度实时热点并进行数据分析

爬取百度实时热点并进⾏数据分析⼀、主题式⽹络爬⾍设计⽅案1.爬⾍名称:爬取百度实时热点2.爬⾍爬取的内容:百度实时热点排⾏榜的排名,标题,热度。

3.爬⾍设计⽅案概述:⽤requests.get(url)命令向服务器提交请求,然后将响应的⽹页信息交给BeatifulSoup库解析,获取⾃⼰想要的内容。

然后使⽤pandans保存数据,并⽣成csv⽂件。

然后读取⽂件,清洗数据,数据分析与可视化,最后⽤最⼩⼆乘法分析两个变量之间的相关系数并建⽴变量之间的回归⽅程。

⼆、主题页⾯的结构特征分析1.主题页⾯的结构与特征分析:观察发现每个标题的各个元素是⼀个个td被包装在⼀个tr标签⾥⾯,每⼀个标题都是⼀个tr,排名:td class="first";关键词:td cass="keyword";搜索指数:td class = "last"。

2.Htmls页⾯解析三、⽹络爬⾍程序设计1.数据爬取与采集import requestsfrom bs4 import BeautifulSoupimport bs4#定义获取页⾯信息函数def get_html(url,headers):r = requests.get(url,headers=headers)r.encoding = r.apparent_encoding#解决中⽂字符编码问题return r.text#建⽴空表格准备数据填充name=[]rank=[]times=[]#定义解析页⾯函数def get_pages(html):soup = BeautifulSoup(html,'html.parser')#使⽤BeautifulSoup库解析页⾯all_topics=soup.find_all('tr')[1:] #获取标签内容for each_topic in all_topics:topic_times = each_topic.find('td',class_='last')#热度topic_rank = each_topic.find('td',class_='first')#排名topic_name = each_topic.find('td',class_='keyword')#标题⽬if topic_rank != None and topic_name!=None and topic_times!=None:topic_rank = each_topic.find('td',class_='first').get_text().replace('','').replace('\n','')rank.append(topic_rank)#填充数据topic_name = each_topic.find('td',class_='keyword').get_text().replace('','').replace('\n','')name.append(topic_name)topic_times = each_topic.find('td',class_='last').get_text().replace('','').replace('\n','')times.append(topic_times)tplt = "排名:{0:^4}\t标题:{1:{3}^15}\t热度:{2:^8}"#定义主函数def main():url = '/buzz?b=1&fr=20811'headers= {'User-Agent':'Mozilla/5.0'}#表头信息html = get_html(url,headers)get_pages(html)if__name__=='__main__':main()print(times)print(name)print(rank)#使⽤pandans保存数据from pandas.core.frame import DataFrameD={"排名":rank,"标题":name,"热度":times}data=DataFrame(D)print(data)#⽣成CSV⽂件filename="redian.csv"data.to_csv(filename,index=False)2.对数据进⾏清洗和处理(1)、读取⽂件import pandas as pd#读取⽂件df=pd.DataFrame(pd.read_csv('redian.csv'))print(df)(2)、删除⽆效列与⾏#删除⽆效列与⾏df.drop('标题', axis=1, inplace = True)df.head()(3)、重复值处理#重复值处理df.duplicated()(4)、空值与缺失值处理#空值与缺失值处理print(df['热度'].isnull().value_counts())df[df.isnull().values==True](5)、异常值处理#异常值处理df.describe()3.数据分析与可视化#数据处理与可视化import numpy as npimport pandas as pdimport sklearnfrom sklearn.linear_model import LinearRegressionX=df.drop("排名",axis=1)predict_model=LinearRegression()#训练模型predict_model.fit(X,df['热度'])#判断相关性print("回归系数为:",predict_model.coef_)回归图#排名与热度的回归图import seaborn as snssns.regplot(df.排名,df.热度)sns.set(font='SimHei') # 解决Seaborn中⽂显⽰问题柱状图#绘制柱状图import pandas as pdimport numpy as npimport matplotlib.pyplot as pltplt.rcParams['font.sans-serif']=['SimHei'] #⽤来正常显⽰中⽂标签plt.rcParams['axes.unicode_minus']=False #⽤来正常显⽰负号plt.figure()plt.bar(df.排名,df.热度,color='green')plt.xlabel('排名')plt.ylabel('热度')plt.title("热榜数据")plt.show()散点图#绘制散点图plt.figure()plt.scatter(df.排名,df.热度,color='blue', s=25, marker="o")plt.xlabel("排名")plt.ylabel("热度")plt.title("热榜数据")plt.show()#绘制折线图plt.figure()plt.plot(df.排名,df.热度,color='green')plt.xlabel('排名')plt.ylabel('热度')plt.title("热榜数据")plt.show()4.建⽴排名与热度之间的回归⽅程import numpy as npimport scipy as spimport matplotlib.pyplot as pltimport matplotlibfrom scipy.optimize import leastsqfrom numpy import genfromtxtX=df.排名Y=df.热度#构建⼀元⼀次⽅程def func(p,x):k,b=preturn k*x+b#设置误差函数def error_func(p,x,y):return func(p,x)-yp0=[1,0]Para=leastsq(error_func,p0,args=(X,Y))k,b=Para[0]print("k=",k,"b=",b)#设置画布⼤⼩plt.figure(figsize=(10,6))#绘制数据散点分布图plt.scatter(X,Y,color="green",label=u"样本数据",linewidth=2)#绘制拟合直线x=np.linspace(1,49,50)y=k*x+bplt.plot(x,y,color="red",label=u"拟合直线")plt.legend()plt.title("排名与热度的回归直线图")plt.grid()plt.show()5.代码总汇import requestsfrom bs4 import BeautifulSoupimport bs4#定义获取页⾯信息函数def get_html(url,headers):r = requests.get(url,headers=headers)r.encoding = r.apparent_encoding#解决中⽂字符编码问题return r.text#建⽴空表格准备数据填充name=[]rank=[]times=[]#定义解析页⾯函数def get_pages(html):soup = BeautifulSoup(html,'html.parser')#使⽤BeautifulSoup库解析页⾯all_topics=soup.find_all('tr')[1:] #获取标签内容for each_topic in all_topics:topic_times = each_topic.find('td',class_='last')#热度topic_rank = each_topic.find('td',class_='first')#排名topic_name = each_topic.find('td',class_='keyword')#标题⽬if topic_rank != None and topic_name!=None and topic_times!=None:topic_rank = each_topic.find('td',class_='first').get_text().replace('','').replace('\n','')rank.append(topic_rank)#填充数据topic_name = each_topic.find('td',class_='keyword').get_text().replace('','').replace('\n','') name.append(topic_name)topic_times = each_topic.find('td',class_='last').get_text().replace('','').replace('\n','')times.append(topic_times)tplt = "排名:{0:^4}\t标题:{1:{3}^15}\t热度:{2:^8}"#定义主函数def main():url = '/buzz?b=1&fr=20811'headers= {'User-Agent':'Mozilla/5.0'}#表头信息html = get_html(url,headers)get_pages(html)if__name__=='__main__':main()print(times)print(name)print(rank)#使⽤pandans保存数据from pandas.core.frame import DataFrameD={"排名":rank,"标题":name,"热度":times}data=DataFrame(D)print(data)#⽣成CSV⽂件filename="redian.csv"data.to_csv(filename,index=False)import pandas as pd#读取⽂件df=pd.DataFrame(pd.read_csv('redian.csv'))print(df)#删除⽆效列与⾏df.drop('标题', axis=1, inplace = True)df.head()#重复值处理df.duplicated()#空值与缺失值处理print(df['热度'].isnull().value_counts())df[df.isnull().values==True]#异常值处理df.describe()#数据处理与可视化import numpy as npimport pandas as pdimport sklearnfrom sklearn.linear_model import LinearRegressionX=df.drop("排名",axis=1)predict_model=LinearRegression()#训练模型predict_model.fit(X,df['热度'])#判断相关性print("回归系数为:",predict_model.coef_)#排名与热度的回归图import seaborn as snssns.regplot(df.排名,df.热度)sns.set(font='SimHei') # 解决Seaborn中⽂显⽰问题#绘制柱状图import pandas as pdimport numpy as npimport matplotlib.pyplot as pltplt.rcParams['font.sans-serif']=['SimHei'] #⽤来正常显⽰中⽂标签plt.rcParams['axes.unicode_minus']=False #⽤来正常显⽰负号plt.figure()plt.bar(df.排名,df.热度,color='green')plt.xlabel('排名')plt.ylabel('热度')plt.title("热榜数据")plt.show()#绘制散点图plt.figure()plt.scatter(df.排名,df.热度,color='blue', s=25, marker="o")plt.xlabel("排名")plt.ylabel("热度")plt.title("热榜数据")plt.show()#绘制折线图plt.figure()plt.plot(df.排名,df.热度,color='green')plt.xlabel('排名')plt.ylabel('热度')plt.title("热榜数据")plt.show()#建⽴排名和热度之间的回归⽅程import numpy as npimport scipy as spimport matplotlib.pyplot as pltimport matplotlibfrom scipy.optimize import leastsqfrom numpy import genfromtxtX=df.排名Y=df.热度#构建⼀元⼀次⽅程def func(p,x):k,b=preturn k*x+b#设置误差函数def error_func(p,x,y):return func(p,x)-yp0=[1,0]Para=leastsq(error_func,p0,args=(X,Y))k,b=Para[0]print("k=",k,"b=",b)#设置画布⼤⼩plt.figure(figsize=(10,6))#绘制数据散点分布图plt.scatter(X,Y,color="green",label=u"样本数据",linewidth=2)#绘制拟合直线x=np.linspace(1,49,50)y=k*x+bplt.plot(x,y,color="red",label=u"拟合直线")plt.legend()plt.title("排名与热度的回归直线图")plt.grid()plt.show()四、结论1..经过对主题数据的分析与可视化,可以更加清晰的看出排名与热度之间的关系,排名越靠前的热度越⾼。

基于Python对资讯信息的网络爬虫设计

基于Python对资讯信息的网络爬虫设计发布时间:2023-01-15T10:17:49.267Z 来源:《中国教工》2022年18期作者:杨勇[导读] 随着网络技术的发展,搜索引擎的出现使得用户可以足不出户杨勇襄阳职业技术学院441050摘要:随着网络技术的发展,搜索引擎的出现使得用户可以足不出户,在网络上获取自己需要的资讯信息。

然而搜索引擎由于数据量大,信息更新速度快,因此搜索网页所花费的时间也相对较长。

本文主要通过设计网络爬虫来实现对网络爬虫爬取网页信息。

关键词:Python;资讯信息;网络爬虫设计引言Python作为一种图形编程语言,被广泛应用于计算机领域当中;同时还被广泛应用于工程领域当中。

而在工程领域中,Python不仅可以应用于计算机相关领域以及设计领域中,还可以应用于工程设计行业以及相关研究领域当中。

如果想要做好一款真正实用且符合实际应用的网络爬虫数据收集平台,必须了解 Python如何更好地完成数据收集及获取等工作。

一、Python和网络爬虫概述网络爬虫是一种可以采集网页数据的技术,它可以通过服务器自动地抓取网页信息并进行解析、抓取等操作而获取数据[1]。

与传统系统相比更有优势。

Python是一种图形编程语言,具有结构简单、计算能力强、易于理解、使用方便等特点;目前被广泛运用于计算机领域当中众多领域中。

而近年来,随着网络技术的不断发展,越来越多的人开始关注到搜索引擎这一块,通过搜索引擎能为用户提供更为便捷准确以及高效的信息服务,同时,还能够给用户带来更多有趣的话题。

网络爬虫作为一种网络辅助工具,可以有效地对网页进行抓取与解析,同时还能自动进行各种数据信息采集、处理、存储、共享、分析等操作。

因此能够很好地解决用户实际搜索网页出现问题时查询不到或信息缺失、或不完整等问题。

同时,网络爬虫能够对一个特定网站中某个页面进行有效抓取和分析,使页面内容更加详细并便于用户进行检索筛选,对于搜索引擎也有着极大地帮助,而不是简单地浪费时间并提高搜索效率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Experience Exchange经验交流DCW261数字通信世界2019.011 引言在这信息如此庞杂的时代要使热点新闻信息更易于查询,易于获取。

用爬虫程序实现热点新闻高效、快速而便捷的获取与整合。

通过建立网站的方式来展示获取的新闻信息。

为了让用户定制个人信息获取偏好、保存历史记录等功能,而编写了用户模 块[1-2]。

2 热点新闻的爬虫系统设计原理与创新网络爬虫是通过程序或脚本借助现有爬虫技术或工具编写的系统,该系统将有目的性的自动抓取互联网信息[3]。

网络检索功能起于互联网内容爆炸性发展所带来的对内容检索的需求。

搜素引擎不断发展,人们的需求也不断提高,网络信息搜索已经成为人们每天都有进行的内容。

如何使搜索引擎能够时刻满足人们的需求?最初的检索功能通过索引站的方式实现,从而有了网络机器人[4]。

本项目来源于新闻爬虫系统项目的建设,旨在为相关机构或个人提供及时的网络信息服务。

2.1 设计原理(1)利用Python 语言结合该语言的相关库或技术如Requests/ urllib 等编写爬虫系统[5]。

系统可以定期的对几个大型的新闻发布平台进行广度优先的爬取策略来增量获取新闻数据。

(2)采用Xpath/Re/BeautifulSoup 库对获取到的新闻数据进行关键字段提取。

其中关键字段有新闻标题、编辑者、发布平台、发布时间等,之后再将这些关键字段与新闻图片、正文内容一并存储与本地,等待进一步操作。

(3)使用python 的pymysql 库对MySQL 数据库进行对接。

(4)通过Flask web 框架构建网站,负责为用户需求而控制和调度相应的模块以及对MySQL 数据库中资源的调用与整合,为实现前端页面的对接实现不同使用场景下的多种数据请求接口:由用户通过URL 请求时,服务器端将直接返回相应的HTML 页面;若碰到特殊的需求需要使用异步传输时,将返回以JSON 格式封装的数据,在前端通过JavaScript 脚本语言对其进行相应处理。

(5)前端界面利用Python 的Jinja2模板引擎以及Bootstrap/AJAX/JQurey 等相关技术实现,兼顾用户交互方式的多样性以及系统的跨浏览器兼容性。

2.2 爬虫程序编写逻辑本文中的基于网络爬虫的热点新闻发布系统可以简单的理解为,对新闻发布平台的众多的新闻页面格式化——根据需要提取该新闻页面中的关键信息。

因此,为了让程序更加易读、更容易拓展,在爬虫设计之初先编写了一个Website 类,供后续爬虫程序拓展。

图1 Website 类图在此类中根据系统需要,主要提取新闻页面的链接、新闻发布时间、新闻标题、新闻来源、新闻编辑、新闻内容、新闻类型。

根据上述程序,针对相应的新闻发布平台编写相应的爬虫类实现Website 类中的抽象方法。

其中,getLinks ()与fromRank ()方法用于在对应新闻发布平台遍历新闻页面。

当后续程序需要批量爬取新闻页面时只需调用getParams ()方法即可。

3 热点新闻发布系统设计与实现3.1 数据爬取在本系统中,数据获取依赖于python 编写的网络爬虫,爬虫程序基于Requests 来发起对新闻发布平台的请求,获取返回的HTML 页面,之后通过Xpath (XML 路径语言)与python 内置的re (正则表达式)库编写定位HTML 上关键字段的爬取逻辑,将新闻的标题、来源、编辑者、存储路径、发布时间、新闻类别等字段存储进MySQL ,新闻内容与新闻图片存储到本地中。

由此即可编写一个针对新闻信息的可扩展爬虫程序。

爬虫程序主要由链接过滤子模块、页面解析子模块、爬行控制子模块以及数据存储子模块构成,其模块结构如图2所示:3.1.1 链接过滤子模块面向热点新闻的爬虫系统设计与实现林文涛,陈伟强,刘杭燕,叶 楠(福州理工学院工学院,福州 350506)摘要:在现今随着互联网的发展,时刻流通的信息变得更加庞大而繁杂,获取信息,整合提取有实际效益的信息成为了一个难题。

要想了解当今世界发生了什么,获取新闻这种记录社会、传播信息、反映时代的文体。

显然是最佳的选择。

本文提出了一个基于网络爬虫的热点新闻发布系统,并在此系统中设计了相应的爬虫逻辑用于爬取热点新闻,以及编写了资源存储,信息展示等相关功能。

进行了有效的信息整合,极大的提高了获取信息的效率。

关键词:爬虫;新闻;python ;Flask doi :10.3969/J.ISSN.1672-7274.2019.01.211中图分类号:TP311.52 文献标示码:A 文章编码:1672-7274(2019)01-0261-03Design and Implementation of Crawler System for Hot NewsLin Wentao,Chen Weiqiang,Liu Hangyan,Ye Nan(The College of Engineering ,Fuzhou Institute of Technology ,Fuzhou ,350506)Abstract :Nowadays ,with the development of the Internet ,the information circulating at all times has become more huge and complex.It has become a difficult problem to acquire information ,integrate and extract information with practical benefits.To understand what is happening in the world today ,get the news ,which records society ,spreads information and reflects The Times.Clearly the best option.In this paper ,a hot news release system based on network crawler is proposed ,and corresponding crawler logic is designed to crawl hot news ,and related functions such as resource storage and information display are written.Effective information integration has greatly improved the efficiency of information acquisition.Keywords :Spider ;News ;Python ;Flask作者简介:叶 楠,女,1990年生,福建寿宁人,讲师,研究方向电子与通信工程。

基金项目:福建省福州理工学院大学生创新创业计划项目(项目编号:201713773017)。

交流Experience Exchange D I G I T C W经验262DIGITCW2019.01图2 数据获取功能模块结构图本系统的爬虫程序运行过程中,将会不断往URL队列中添加新的URL链接,其中某些URL链接可能并不是程序所需要的。

因此这时候就需要再编写一个用于过滤URL链接的过滤器。

对于这个过滤器只有某些条件符合的URL才能进入待爬URL队列,将其余不符合条件的URL剔除,不会加入到待抓取的爬行队列中。

同时对于符合条件的URL也要判断该URL是否被爬取过,如果已被爬过则舍弃。

在爬虫程序中使用链接过滤器对URL进行过滤是有必要的。

由于大量不符合条件的URL被过滤掉了,爬行队列中仅仅加入符合条件的URL,充分节省了宝贵的内存空间。

链接过滤子模块的工作方式如图3所示:图3 链接过滤子模块3.1.2 页面解析子模块通过链接过滤子模块过滤获取的URL队列,传输进此模块。

页面解析子模块将会对URL队列中的链接逐一解析,解析过程是通过Xpath(XML路径语言)定位页面中需要抽取消息的具体位置,后获取该信息并存储进数据库。

但是有些URL即使通过了过滤器子模块,也会因为排版的些许差异而使得Xpath无法定位,这是就需要有相应的程序来检测这样的URL。

页面解析子模块的工作方式如图4所示:图4 页面解析子模块3.1.3 爬取策略子模块爬取策略模块是整个爬虫程序的核心,它控制着整个爬虫的抓取策略(宽度优先或者深度优先)以及停止条件。

爬行控制子模块的工作流程如图5所示:图5 爬行控制子模块3.1.4 数据存储子模块对HTML页面进行解析后,获得的关键字段,将会存储于数据库中,而新闻内容与新闻图片将会被整合存储为本地文件。

数据存储子模块的工作流程如图6所示:3.2 数据可视化功能模块系统可视化功能模块的主要功能结构如图7所示,通过ExtJS结合Google Visualization API进行构建,其主要功能包括:首页新闻推荐:登录网站后首页将是按热度排序推荐的新闻条目;按类型查看:查看特定类型的新闻;按时间查看:查看某个时间段的新闻:通过关键字检索:输入关键字检索查看当前符合条件的新闻;每日新闻增量:查看近20天每日新增新闻的数量;当日新闻词频分析:查看发布日期为当日的新闻的词频分析柱状图;关键字检索查看每日词频变化折线图:数日某个关键字,获取该词近20日的词频变化。

图6 数据存储子模块图7数据可视化功能结构图图8 网站首页4 热点新闻发布系统测试与分析4.1 测试环境该系统的运行的性能会受到实验机器的网络与机器硬件性能的影响,本节列举测试环境。

表1 硬件环境CPU RAM 机器一Intel(R)Core(TM)i7-4710MQ CPU @ 2.50Hz 2.50GHz8GB 机器二Intel Core2 Duo CPU E4500 @ 2.20Hz 2.20GHz2GB由于条件限制,在测试系统时,本文只使用两台机器。

表2 软件环境OS Datebase Python 机器一Windows 10家庭版64bit MySQL5.7.21 3.6.3机器二CentOS 7.0MySQL5.7.8 3.6.04.2 测试在项目完成后需要对系统是否符合最初的需求做出一定的测试,系统测试就是对当前整个项目的检验。

检查项目中的不足的地方。

之后再进一步优化系统。

本节将依据系统测试规则设计一系列测试用例,以系统测试的一般方法来测试新闻爬虫系统。

发现系统中的漏洞与缺陷是软件测试的主要目的,软件测试在软件的整个开发过程中也占据着举足轻重的地位。