深度学习入门讲座PPT

合集下载

深度学习课件:从入门到实战

1 面向对象编程

了解面向对象编程的基本 概念与原理,为后续学习 深度学习打下基础。

2 深度学习基础概念

3 应用案例

探索深度学习的核心概念, 如神经网络、激活函数、 损失函数等。

了解深度学习在实际中的 应用,如图像分类、自然 语言处理等。

TensorFlow与PyTorch深度学习框架介绍

TensorFlow

深度学习课件:从入门到实战

这个课件将帮助你从入门到实战,掌握深度学习的基本概念和应用。通过丰 富的实例和详细的解析,让你轻松理解深度学习的原理和技术。

什么是深度学习?

深度学习是一种机器学习的分支,通过构建和训练多层神经网络模型,实现 对大规模数据的高效处理和复杂任务的自动学习与分析。

面向对象编程与深度学习基础概念

使用CNN进行图像分类

通过卷积神经网络(CNN),探究图像分类任务的原理和实现方法。

多层感知器(MLP)与回归分析

了解多层感知器(MLP)的基本原理和应用,以及如何应用 MLP 进行回归分析。

生成型模型(Generative Models) 初步

了解生成型模型的概念和应用领域,学习如何使用生成模型生成新的数据样 本。

深入了解 TensorFlow 框架,学习 如何构建、训练和部署深度学习 模型。

PyTorch

探索 PyTorch 框架的特点和优势, 学习如何灵活地设计和实现深度 学习模型。

选择适合的框架

比较 TensorFlow 和 PyTorch,选 择最适合你的深度学习框架。

深度学习模型建立与训练初学者指南

1

超参数调优

2

探索超参数对深度学习模型性能的影响,

学习如何选择最佳超参数配置。

3

170页PPT入门深度强化学习!

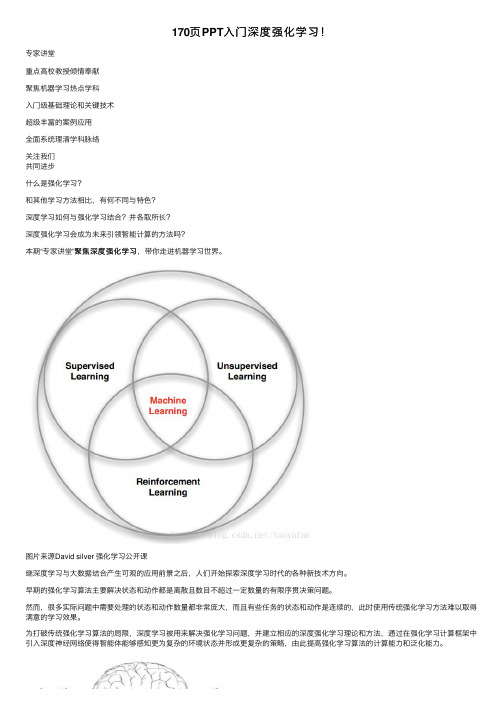

170页PPT⼊门深度强化学习!专家讲堂重点⾼校教授倾情奉献聚焦机器学习热点学科⼊门级基础理论和关键技术超级丰富的案例应⽤全⾯系统理清学科脉络关注我们共同进步什么是强化学习?和其他学习⽅法相⽐,有何不同与特⾊?深度学习如何与强化学习结合?并各取所长?深度强化学习会成为未来引领智能计算的⽅法吗?聚焦深度强化学习,带你⾛进机器学习世界。

本期“专家讲堂”聚焦深度强化学习图⽚来源David silver 强化学习公开课继深度学习与⼤数据结合产⽣可观的应⽤前景之后,⼈们开始探索深度学习时代的各种新技术⽅向。

早期的强化学习算法主要解决状态和动作都是离散且数⽬不超过⼀定数量的有限序贯决策问题。

然⽽,很多实际问题中需要处理的状态和动作数量都⾮常庞⼤,⽽且有些任务的状态和动作是连续的,此时使⽤传统强化学习⽅法难以取得满意的学习效果。

为打破传统强化学习算法的局限,深度学习被⽤来解决强化学习问题,并建⽴相应的深度强化学习理论和⽅法,通过在强化学习计算框架中引⼊深度神经⽹络使得智能体能够感知更为复杂的环境状态并形成更复杂的策略,由此提⾼强化学习算法的计算能⼒和泛化能⼒。

图⽚来源David silver 强化学习公开课深度强化学习将强化学习和深度学习有机地结合在⼀起,使⽤强化学习⽅法定义问题和优化⽬标,使⽤深度学习⽅法解决状态表⽰、策略表⽰等问题,通过各取所长的⽅式协同解决复杂问题。

深度强化学习理论和⽅法为解决复杂系统的感知决策问题提供了新的思路。

深度强化学习已经能够解决⼀部分在以前看来不可能完成的任务,在游戏博弈、优化控制等领域取得卓越应⽤成果。

很多学者认为深度强化学习将在不久的将来成为⼀种能够解决复杂问题的通⽤智能计算⽅式,并为⼈⼯智能领域带来⾰命性的变化。

深度学习介绍 ppt课件

自编码器的建立

建立AutoEncoder的方法是:

对于m个数据的输入,有:

Code编码:使用非线性激活函数,将维输入数据映射到维隐含层(隐含节点表示特 征)

其中W是一个的权重矩阵,b是一个d'维的偏移向量 Decode解码:通过反向映射,对映射后的数据进行重建

hi

yi

SAE网络每一次训练输入都会得到映射后的 与解码后的 。通过对代价函数的最优

深层带来的好处

为什么采用层次网络

预训练与梯度消失现象

主要内容

自编码器结构

单层自动编码器网络(AutoEncoder)实质上是一个三层的反向传播神经网络。它逐 层采用无监督学习的方式,不使用标签调整权值,将输入映射到隐含层上,再经过反 变换映射到输出上,实现输入输出的近似等价。

X1 X2 X3 X4 X5 +1

RBM网络有几个参数,一个是可视层与隐含 层之间的权重矩阵,一个是可视节点的偏移 量b,一个是隐含节点的偏移量c,这几个参 数决定了RBM网络将一个m维的样本编码成 一个什么样的n维的样本。

受限玻尔兹曼机

RBM介绍

RBM训练

一般地,链接权重Wij可初始化为来自正态分布N(0,0.01)的随机数,隐 单元的偏置cj初始化为0; 对于第i个可见单元,偏置bj初始化为log[pi/(1-pi)] 。pi表示训练样本中 第i个特征处于激活状态所占的比率 学习率epsilon至关重要,大则收敛快,但是算法可能不稳定。小则 慢。为克服这一矛盾引入动量,使本次参数值修改的方向不完全由当 前样本似然函数梯度方向决定,而是上一次参数值修改方向与本次梯 度方向的结合可以避免过早的收敛到局部最优点

激活函数

y f (x)

《机器学习与深度学习》PPT课件讲义

训练神经元网络 -- Back Propagation

梯度下降迭代算法

输出层误差: δki 隐含层误差: smi

BP 算法

初始化参数 θ 两阶段算法: Two-Pass

前向 Forward-Pass: 给定参数,计算输出值 后向 Backward-Pass: 计算输出层误差, 计算隐含层误差,更新

• 一个BN 是一个由随机变量 组成的有向非循环图

• 一部分变量为可观察已知 变量

• 如何由已知变量推断出非 观察变量的状态

• 调整变量之间连接的参数 优化:最大可能重新生成 观察变量

可信任, 信任什么?

随机的二元单元

(Bernoulli variables)

• 隐含层的神经元的状态 为0或1

• 该神经元激活的概率为 输入层加权和的 sigmoid 函数

什么为最佳匹配?

参数估计方法一: 最小化误差平方和

机器学习背景

RSS()

0

正则化 L2 (Ridge) Regularization

限制参数的大小 , 以避免过拟合

正则化 L1 Regularization (Lasso)

| j | j1...p

No closed form for β 限制参数的大小 , 以避免过拟合

➢ Still Perceptron ➢ 一个特殊的单隐含层网络 ➢ 每个训练案例用于构造一个

特征,该特征用于测量改训 练案例和测试案例的距离 ➢ SVM训练选择自由特征集以 及特征的权重 ➢ 1990-2010 很多让放弃NN, 选择 SVM

深层信任网络(Deep Belief Net,DBN) 是 部分解决了以上问题的神经元网络

小结一个基础的DBN网络

深度学习基础(PPT36页)

CNN的优点

参数减少与权值共享 如下图所示,如果我们有1000x1000(每个隐层神经元都连接图像的每一个像素点),就有 1 0 0 0 1 0 0 0 1 0 0 0 0 0 0 = 1 0 1 2个连接,也就是10^12个权值参数。

局部连接网络,每一个节点与上层节点同位置附近10x10的窗口相连接, 则1百万个隐层神经元就只有 16 0100 18 0,即10^8个参数。其权值连 接个数比原来减少了四个数量级。

深度学习可以通过学习一种深层非线性网络结构,实 现复杂函数逼近,表征输入数据分布式表示,并展现 了强大的从少数样本中集中学习数据及本质特征的能 力。

深度学习的实质

通过构建具有很多隐层的机器学习模型和海量的训练数 据,来学习更有用的特征,从而最终提升分类或预测的 准确性。因此,“深度模型”是手段,“特征学习”是 目的。

人脑的视觉机理

1981年的诺贝尔医学奖获得者 David Hubel和Torsten Wiesel发现了视觉系统的信息处理机制,他们发现了一 种被称为“方向选择性细胞的神经元细胞,当瞳孔发现 了眼前的物体的边缘,而且这个边缘指向某个方向时, 这种神经元细胞就会活跃。

由此可知人的视觉系统的信息处理是分级的,高 层的特征是低层特征的组合,从低层到高层的特征表示 越来越抽象,越来越能表现语义或者意图,抽象层面越 高,存在的可能猜测就越少,就越利于分类。

与神经网络的异同

深度学习与神经网络的异同

神经网络

深度学习

深度学习与神经网络的异同

相同点

二者均采用分层结构,系统包括输入层、隐层(多层)、 输出层组成的多层网络,只有相邻层节点之间有连接,同 一层以及跨层节点之间相互无连接,每一层可以看作是一 个logistic 回归模型。

深度学习课件-从入门到实战

梯度下降优化器

在分类任务中常用的损失函数, 用于衡量预测结果与真实标签 之间的差异。

通过计算梯度方向,并不断更 新参数,使损失函数最小化。

学习率调整

合理调整学习率,可以加速模 型的收敛速度和提高泛化能力。

模型评估与调参

1 交叉验证

2 超参数调优

3 过拟合与欠拟合

通过将数据集分为多个 子集,交叉验证可以评 估模型的稳定性和性能。

生成对抗网络(GAN)

由生成器和判别器组成,用于 生成逼真的样本和对抗学习。

前向传播与反向传播算法

1

前向传播

将输入数据通过神经网络从前往后进

反向传播

2

行计算,得到输出结果。

根据预测结果与真实标签的误差,通

过链式法则计算每个权重和偏置的梯

度。

3

优化算法

利用反向传播的梯度信息,通过优化 算法更新网络参数,提高模型的准确 性。

训练数据准备与处理

1 数据收集

2 数据预处理

深度学习需要大量的数据,收集和整 理合适的数据集是一个重要的步骤。

3 数据增强

对数据进行清洗、归一化、特征提取 等预处理操作,以提高模型的训练效 果。

利用数据扩增、数据合成等技术增加训练数据的多样性,提升模型的泛化能力。

损失函数的选择与优化方法

交叉熵损失函数

深度学习的模型设计和 评估中,概率论和统计 学起着重要的作用。

神经网络的基本结构和常见类型

多层感知器(MLP)

卷积神经网络(CNN) 循环神经网络(RNN)

是最基本的神经网络结构,由 输入层、隐藏层和输出层组成。

适合处理图像和视觉任务,具 有局部感知和权值共享的特点。

能够处理序列数据和时序任务, 具有记忆能力和上下文理解能 力。

深度学习技术介绍PPT课件

根据Marr(1982)年理论,理解一个信息处理系统,具有三个被称为分析层面的内容: 计算理论(computational theory)对应计算目标和任务的抽象定义。 表示和算法(representation and algorithm)是关于输人和输出如何表示和从输入到输

出变换的算法说明。 硬件实现(hardware implementation)是系统的实物物理实现。

29

29

M40 GPU加速特性

30

GPU与CPU连接

通过PCIe与CPU连接, 最大理论带宽8GB/s(gen2.0)、16GB/s(gen3.0) CPU称为主机(host), 显卡(GPU)称为设备(device)

31

31

最优连接数量:4

32

32

目前的GPU使用方案

33

33

CPU困境

34

机器学习还可以进行压缩(compression)。用规则拟合数据,我们能得到比数据更简 单的解释,需要的存储空间更少,处理所需要的计算更少,例如,一旦你掌握了加法 规则,你就不必记忆每对可能数字的和是多少。

机器学习的另一种用途是离群点检测(outlier detection),即发现那些不遵守规则的 例外实例。在这种情况下,学习规则之后,我们感兴趣的不是规则,而是规则未能覆 盖的例外,他们可能暗示出我们需要注意的异常,如诈骗等。

具体应用-人脸识别

对于人脸识别(face recognition)。输入是人脸 图像,类是需要识别的人,并且学习程序应当 学习人脸图像与身份之间的关联性。人脸会有 更多的类,输入图像也更大一些,并且人脸是 三维的,不同的姿势和光线等都会导致图像的 显著变化。另外,对于特定人脸的输人也会出 现问题,比如说眼镜可能会把眼睛和眉毛遮住 ,胡子可能会把下巴盖住等。

出变换的算法说明。 硬件实现(hardware implementation)是系统的实物物理实现。

29

29

M40 GPU加速特性

30

GPU与CPU连接

通过PCIe与CPU连接, 最大理论带宽8GB/s(gen2.0)、16GB/s(gen3.0) CPU称为主机(host), 显卡(GPU)称为设备(device)

31

31

最优连接数量:4

32

32

目前的GPU使用方案

33

33

CPU困境

34

机器学习还可以进行压缩(compression)。用规则拟合数据,我们能得到比数据更简 单的解释,需要的存储空间更少,处理所需要的计算更少,例如,一旦你掌握了加法 规则,你就不必记忆每对可能数字的和是多少。

机器学习的另一种用途是离群点检测(outlier detection),即发现那些不遵守规则的 例外实例。在这种情况下,学习规则之后,我们感兴趣的不是规则,而是规则未能覆 盖的例外,他们可能暗示出我们需要注意的异常,如诈骗等。

具体应用-人脸识别

对于人脸识别(face recognition)。输入是人脸 图像,类是需要识别的人,并且学习程序应当 学习人脸图像与身份之间的关联性。人脸会有 更多的类,输入图像也更大一些,并且人脸是 三维的,不同的姿势和光线等都会导致图像的 显著变化。另外,对于特定人脸的输人也会出 现问题,比如说眼镜可能会把眼睛和眉毛遮住 ,胡子可能会把下巴盖住等。

深度学习基础PPT幻灯片

Deep Learning

2020/4/2

1

目录

深度学习简介 深度学习的训练方法 深度学习常用的几种模型和方法 Convolutional Neural Networks卷积神经网络 卷积神经网络(CNN)在脑机接口中的应用源自2020/4/22

What is Deep Learning?

浅层结构的局限性在于有限的样本和计算单元情况下 对复杂的函数表示能力有限,针对复杂分类问题其泛 化能力受到一定的制约。

2020/4/2

9

受到大脑结构分层的启发,神经网络的研究发现多隐 层的人工神经网络具有优异的特征学习能力,学习得 到的特征对数据有更本质的刻画,从而有利于可视化 或分类;而深度神经网络在训练上的难度,可以通过 “逐层初始化”来有效克服。

A brief introduce of deep learning

2020/4/2

3

机器学习

机器学习(Machine Learning)是一门专门研究计算机 怎样模拟或实现人类的学习行为,以获取新的知识或 技能,重新组织已有的知识结构市值不断改善自身的 性能的学科,简单地说,机器学习就是通过算法,使 得机器能从大量的历史数据中学习规律,从而对新的 样本做智能识别或预测未来。

机器学习在图像识别、语音识别、自然语言理解、天 气预测、基因表达、内容推荐等很多方面的发展还存 在着没有良好解决的问题。

2020/4/2

4

特征的自学习

传统的模式识别方法:

通过传感器获取数据,然后经过预处理、特征提取、特 征选择、再到推理、预测或识别。 特征提取与选择的好坏对最终算法的确定性齐了非常关 键的作用。而特征的样式目前一般都是靠人工提取特征。 而手工选取特征费时费力,需要专业知识,很大程度上 靠经验和运气,那么机器能不能自动的学习特征呢?深 度学习的出现就这个问题提出了一种解决方案。

2020/4/2

1

目录

深度学习简介 深度学习的训练方法 深度学习常用的几种模型和方法 Convolutional Neural Networks卷积神经网络 卷积神经网络(CNN)在脑机接口中的应用源自2020/4/22

What is Deep Learning?

浅层结构的局限性在于有限的样本和计算单元情况下 对复杂的函数表示能力有限,针对复杂分类问题其泛 化能力受到一定的制约。

2020/4/2

9

受到大脑结构分层的启发,神经网络的研究发现多隐 层的人工神经网络具有优异的特征学习能力,学习得 到的特征对数据有更本质的刻画,从而有利于可视化 或分类;而深度神经网络在训练上的难度,可以通过 “逐层初始化”来有效克服。

A brief introduce of deep learning

2020/4/2

3

机器学习

机器学习(Machine Learning)是一门专门研究计算机 怎样模拟或实现人类的学习行为,以获取新的知识或 技能,重新组织已有的知识结构市值不断改善自身的 性能的学科,简单地说,机器学习就是通过算法,使 得机器能从大量的历史数据中学习规律,从而对新的 样本做智能识别或预测未来。

机器学习在图像识别、语音识别、自然语言理解、天 气预测、基因表达、内容推荐等很多方面的发展还存 在着没有良好解决的问题。

2020/4/2

4

特征的自学习

传统的模式识别方法:

通过传感器获取数据,然后经过预处理、特征提取、特 征选择、再到推理、预测或识别。 特征提取与选择的好坏对最终算法的确定性齐了非常关 键的作用。而特征的样式目前一般都是靠人工提取特征。 而手工选取特征费时费力,需要专业知识,很大程度上 靠经验和运气,那么机器能不能自动的学习特征呢?深 度学习的出现就这个问题提出了一种解决方案。

深度学习PPT幻灯片

❖ 案例:星光智能一号广泛应用于高清视频监控、智能驾驶辅助、无人机、 机器人等嵌入式机器视觉领域

14

深度学习硬件加速方式——ASIC

❖ 阻碍深度学习发展的瓶颈仍是算法速度 ❖ 传统处理器需要多条指令才能完成一个神经元的处理 ❖ ASIC根据深度学习算法定制:处理效率、能效均最高 ❖ 代表:Cambricon(寒武纪科技)DianNao芯片、谷歌的TPU芯片、

11

深度学习硬件加速方式——GPU

❖ SIMD方式,计算能力强,并行度支持好 ❖ 通用性,并非针对深度学习

➢ 运行效率受影响 ➢ 能耗仍较大 ❖ 代表: NVIDIA Tesla P100 GPU ❖ 案例:基于GPADAS)方面与众多车企进行合作

样思考

取新的知识技能,并

应用:国际跳棋程序

改善自身性能

应用:垃圾邮件过滤

深度学习

一种机器学习方法,模 拟人脑机制解释数据, 通过组合低层特征形成 更加抽象的高层属性类 别或特征

应用:谷歌视频寻猫

1950's 1960's 1970's 1980's 1990's 2000's 2010's

3

深度学习的流程

Horizon Robotics(地平线机器人)BPU芯片 ❖ 案例:基于TPU的AlphaGo与围棋冠军李世石人机大战,总比分4:1获胜

15

深度学习硬件加速方式比较

加速方式

优点

缺点

CPU

通用结构、可独立工作 通用性导致效率和能效比低

GPU FPGA DSP ASIC

强大的并行计算能力

通用性导致效率受影响、能耗大

灵活性好、设计空间大、 省去流片过程 改动小、计算能力较高

14

深度学习硬件加速方式——ASIC

❖ 阻碍深度学习发展的瓶颈仍是算法速度 ❖ 传统处理器需要多条指令才能完成一个神经元的处理 ❖ ASIC根据深度学习算法定制:处理效率、能效均最高 ❖ 代表:Cambricon(寒武纪科技)DianNao芯片、谷歌的TPU芯片、

11

深度学习硬件加速方式——GPU

❖ SIMD方式,计算能力强,并行度支持好 ❖ 通用性,并非针对深度学习

➢ 运行效率受影响 ➢ 能耗仍较大 ❖ 代表: NVIDIA Tesla P100 GPU ❖ 案例:基于GPADAS)方面与众多车企进行合作

样思考

取新的知识技能,并

应用:国际跳棋程序

改善自身性能

应用:垃圾邮件过滤

深度学习

一种机器学习方法,模 拟人脑机制解释数据, 通过组合低层特征形成 更加抽象的高层属性类 别或特征

应用:谷歌视频寻猫

1950's 1960's 1970's 1980's 1990's 2000's 2010's

3

深度学习的流程

Horizon Robotics(地平线机器人)BPU芯片 ❖ 案例:基于TPU的AlphaGo与围棋冠军李世石人机大战,总比分4:1获胜

15

深度学习硬件加速方式比较

加速方式

优点

缺点

CPU

通用结构、可独立工作 通用性导致效率和能效比低

GPU FPGA DSP ASIC

强大的并行计算能力

通用性导致效率受影响、能耗大

灵活性好、设计空间大、 省去流片过程 改动小、计算能力较高

深度学习基础理论ppt课件

13

AutoEncoder自动编码器

2)通过编码器产生特征,然后训练下一层。这样逐层训 练:

将第一层输出的code当成第二层的输入信号,同样最小化重构误差,就会 得到第二层的参数,并且得到第二层输出的code,也就是原输入信息的第 二个表达了。其他层就用同样的方法炮制。

14

AutoEncoder自动编码器

3)有监督微调: 到这里,这个AutoEncoder还不能用来分类数据,可

以在AutoEncoder的最顶的编码层添加一个分类器,然后 通过标准的多层神经网络的监督训练方法(梯度下降法) 去训练。

微调分为两种,一个是只调整分类器(黑色部分):

15

AutoEncoder自动编码器

另一种:通过有标签样本,微调整个系统:

在研究中可以发现,如果在原有的特征中加入这些自动学习得到的特 征可以大大提高精确度,甚至在分类问题中比目前最好的分类算法效果还 要好!

16

AutoEncoder自动编码器

AutoEncoder存在的一些变体:

a)Sparse AutoEncoder稀疏自动编码器 b)Denoising AutoEncoders降噪自动编码器

20

Sparse Coding稀疏编码

2)Coding阶段:

给定一个新的图片x,由上面得到的字典,通过解一 个LASSO问题得到稀疏向量a。这个稀疏向量就是这个输入 向量x的一个稀疏表达了。

21

深度学习的常用模型

3、Restricted Boltzmann Machine (RBM)限 制波尔兹曼机

18

Sparse Coding稀疏编码

19

Sparse Coding稀疏编码

Sparse coding分为两个部分:

AutoEncoder自动编码器

2)通过编码器产生特征,然后训练下一层。这样逐层训 练:

将第一层输出的code当成第二层的输入信号,同样最小化重构误差,就会 得到第二层的参数,并且得到第二层输出的code,也就是原输入信息的第 二个表达了。其他层就用同样的方法炮制。

14

AutoEncoder自动编码器

3)有监督微调: 到这里,这个AutoEncoder还不能用来分类数据,可

以在AutoEncoder的最顶的编码层添加一个分类器,然后 通过标准的多层神经网络的监督训练方法(梯度下降法) 去训练。

微调分为两种,一个是只调整分类器(黑色部分):

15

AutoEncoder自动编码器

另一种:通过有标签样本,微调整个系统:

在研究中可以发现,如果在原有的特征中加入这些自动学习得到的特 征可以大大提高精确度,甚至在分类问题中比目前最好的分类算法效果还 要好!

16

AutoEncoder自动编码器

AutoEncoder存在的一些变体:

a)Sparse AutoEncoder稀疏自动编码器 b)Denoising AutoEncoders降噪自动编码器

20

Sparse Coding稀疏编码

2)Coding阶段:

给定一个新的图片x,由上面得到的字典,通过解一 个LASSO问题得到稀疏向量a。这个稀疏向量就是这个输入 向量x的一个稀疏表达了。

21

深度学习的常用模型

3、Restricted Boltzmann Machine (RBM)限 制波尔兹曼机

18

Sparse Coding稀疏编码

19

Sparse Coding稀疏编码

Sparse coding分为两个部分:

深度学习Deep-Learning【精品PPT文档】

• 减轻梯度消失问题的一个方法是使用线性激活函数(比如rectifier

函数)或近似线性函数(比如softplus 函数)。这样,激活函数的 导数为1,误差可以很好地传播,训练速度得到了很大的提高。

目录

• • • • • • • • 深度学习简介 数学基础 机器学习简介 感知器 前馈神经网络 卷积神经网络 循环神经网络 深度学习应用

向量函数及其导数

按位计算的向量函数及其导数

logistic函数

softmax函数

softmax函数

softmax函数

softmax函数

目录

• • • • • • • • 深度学习简介 数学基础 机器学习简介 感知器 前馈神经网络 卷积神经网络 循环神经网络 深度学习应用

机器学习中的一些概念

目录

• • • • • • • • 深度学习简介 数学基础 机器学习简介 感知器 前馈神经网络 卷积神经网络 循环神经网络 深度学习应用

向量

向量的模和范数

常见的向量

矩阵

矩阵的基本运算

矩阵的基本运算

常见的矩阵

常见的矩阵

导数

向量导数

导数法则

导数法则

导数法则

常用函数及其导数

常用函数及其导数

深度学习Deep Learning

目录

• • • • • • • • 深度学习简介 数学基础 机器学习简介 感知器 前馈神经网络 卷积神经网络 循环神经网络 深度学习应用

深度学习概念

• 机器学习(Machine Learning,ML)主要是研究如何使计算机从给定的 数据中学习规律,即从观测数据(样本)中寻找规律,并利用学习到的 规律(模型)对未知或无法观测的数据进行预测。目前,主流的机器学 习算法是基于统计的方法,也叫统计机器学习。 • 人工神经网络(Artificial Neural Network ,ANN),也简称神经网络, 是众多机器学习算法中比较接近生物神经网络特性的数学模型。人工神 经网络通过模拟生物神经网络(大脑)的结构和功能,由大量的节点 (或称“神经元”,或“单元”)和之间相互联接构成,可以用来对数 据之间的复杂关系进行建模。

一天搞懂深度学习演示教学ppt课件

= Multi-class Classifier

Softmax

1-2 基本思想

Neural Network

1-2 基本思想

……

……

……

……

……

……

y1

y2

y10

Cross Entropy

“1”

……

1

0

0

……

target

Softmax

……

Given a set of parameters

目标识别

目标分析

图像捕获 图像压缩 图像存储

图像预处理 图像分割

特征提取 目标分类 判断匹配

模型建立 行为识别

2-1 机器视觉

关键技术与应用

A)生物特征识别技术——安全领域应用广泛 生物特征识别技术是一种通过对生物特征识别和检测,对身伤实行鉴定的技术。从 统计意义上讲人类的指纹、虹膜等生理特征存在唯一性,可以作为鉴另用户身份 的依据。目前,生物特征识别技术主要用于身份识别,包括语音、指纹、人脸、 静脉,虹膜识别等。

1958: Perceptron (linear model) 1969: Perceptron has limitation 1980s: Multi-layer perceptron Do not have significant difference from DNN today 1986: Backpropagation Usually more than 3 hidden layers is not helpful 1989: 1 hidden layer is “good enough”, why deep? 2006: RBM initialization 2009: GPU 2011: Start to be popular in speech recognition 2012: win ILSVRC image competition 2015.2: Image recognition surpassing human-level performance 2016.3: Alpha GO beats Lee Sedol 2016.10: Speech recognition system as good as humans

Softmax

1-2 基本思想

Neural Network

1-2 基本思想

……

……

……

……

……

……

y1

y2

y10

Cross Entropy

“1”

……

1

0

0

……

target

Softmax

……

Given a set of parameters

目标识别

目标分析

图像捕获 图像压缩 图像存储

图像预处理 图像分割

特征提取 目标分类 判断匹配

模型建立 行为识别

2-1 机器视觉

关键技术与应用

A)生物特征识别技术——安全领域应用广泛 生物特征识别技术是一种通过对生物特征识别和检测,对身伤实行鉴定的技术。从 统计意义上讲人类的指纹、虹膜等生理特征存在唯一性,可以作为鉴另用户身份 的依据。目前,生物特征识别技术主要用于身份识别,包括语音、指纹、人脸、 静脉,虹膜识别等。

1958: Perceptron (linear model) 1969: Perceptron has limitation 1980s: Multi-layer perceptron Do not have significant difference from DNN today 1986: Backpropagation Usually more than 3 hidden layers is not helpful 1989: 1 hidden layer is “good enough”, why deep? 2006: RBM initialization 2009: GPU 2011: Start to be popular in speech recognition 2012: win ILSVRC image competition 2015.2: Image recognition surpassing human-level performance 2016.3: Alpha GO beats Lee Sedol 2016.10: Speech recognition system as good as humans

深度学习课件-第2讲:深度学习基础

=

1

exp

2 2

1

− 2

2

−

2

由精度参数化(Parametrized by precision):

; , −1

=

exp

2

1

−

2

−

2

高斯分布

多元高斯分布

由协方差矩阵参数化(Parametrized by covariance

matrix):

1

exp

(2) det(σ)

摩尔-彭若斯广义逆

+

=

• 方程组解的情况包括:

― 仅有一个解:此时摩尔-彭若斯广义逆矩阵与逆矩阵相

同

― 无解:此时会给出解的最小误差 −

― 多个解:此时会给出范数最小的解

2

迹(Trace)

= ,

矩阵的迹的性质:

+ = +

自信息:

= −log ()

信息熵:

H = ~

= ~ log ()

KL散度:

∥ = ~

= ~ − ()

KL散度是不对称的

∗ = ∥

∗ = ∥

1979 – deep neocognitron, convolution, Fukushima

1987 – autoencoder, Ballard

1989 – convolutional neural networks (CNN), Lecun

1991 – deep recurrent neural networks (RNN), Schmidhuber

深度学习PPT幻灯片

❖ 配套首个深度学习指令集Cambricon(DianNaoYu) ➢ 直接面对大规模神经元和突触的处理 ➢ 一条指令即可完成一组神经元的处理 ➢ 对神经元和突触数据传输提供一系列支持

25

典型神经网络芯片——寒武纪DianNao

❖ 片上存储:芯片内含三块片上存储,用于存储input的NBin、output的 NBout和神经网络模型权重参数的SB;片上存储与片外通过DMA通信

❖ 案例:星光智能一号广泛应用于高清视频监控、智能驾驶辅助、无人机、 机器人等嵌入式机器视觉领域

14

深度学习硬件加速方式——ASIC

❖ 阻碍深度学习发展的瓶颈仍是算法速度 ❖ 传统处理器需要多条指令才能完成一个神经元的处理 ❖ ASIC根据深度学习算法定制:处理效率、能效均最高 ❖ 代表:Cambricon(寒武纪科技)DianNao芯片、谷歌的TPU芯片、

19

典型神经网络芯片——IBM TrueNorth

❖ TrueNorth芯片结构、功能、物理形态图

20

典型神经网络芯片——IBM TrueNorth

❖ 人脑分成三个层次——神经突触、脑功能区和脑皮层 ➢ 每个突触由诸多神经元组成,每个脑功能区由诸多突触组成,一个 能完整执行任务的皮层由诸多个功能区组成

❖ 谷歌TensorFlow占绝对优势

➢ 强大的人工智能研发水平、快速的迭代更新

7

深度学习的开源框架

❖ 谷歌2015年底发布开源深度学习框架TensorFlow

➢ Tensor(张量):多维数组在高维空间的数学运算 ➢ Flow(流):基于数据流图的计算 ❖ TensorFlow关键特性 ➢ 代码简洁多语言支持 ➢ 分布式算法执行效率高 ➢ 移值灵活伸缩性好 ➢ 支持多种神经网络算法

25

典型神经网络芯片——寒武纪DianNao

❖ 片上存储:芯片内含三块片上存储,用于存储input的NBin、output的 NBout和神经网络模型权重参数的SB;片上存储与片外通过DMA通信

❖ 案例:星光智能一号广泛应用于高清视频监控、智能驾驶辅助、无人机、 机器人等嵌入式机器视觉领域

14

深度学习硬件加速方式——ASIC

❖ 阻碍深度学习发展的瓶颈仍是算法速度 ❖ 传统处理器需要多条指令才能完成一个神经元的处理 ❖ ASIC根据深度学习算法定制:处理效率、能效均最高 ❖ 代表:Cambricon(寒武纪科技)DianNao芯片、谷歌的TPU芯片、

19

典型神经网络芯片——IBM TrueNorth

❖ TrueNorth芯片结构、功能、物理形态图

20

典型神经网络芯片——IBM TrueNorth

❖ 人脑分成三个层次——神经突触、脑功能区和脑皮层 ➢ 每个突触由诸多神经元组成,每个脑功能区由诸多突触组成,一个 能完整执行任务的皮层由诸多个功能区组成

❖ 谷歌TensorFlow占绝对优势

➢ 强大的人工智能研发水平、快速的迭代更新

7

深度学习的开源框架

❖ 谷歌2015年底发布开源深度学习框架TensorFlow

➢ Tensor(张量):多维数组在高维空间的数学运算 ➢ Flow(流):基于数据流图的计算 ❖ TensorFlow关键特性 ➢ 代码简洁多语言支持 ➢ 分布式算法执行效率高 ➢ 移值灵活伸缩性好 ➢ 支持多种神经网络算法

深度学习入门讲座ppt课件

图片取自lecun的ppt

33

PART 5 我能学懂深度学习吗?

34

需要具备的基础知识

● 微积分、线性代数、概率论 ● 基础的编程知识,最好有python基础 ● 良好的英文文献阅读能力

35

BP网络

36

卷积

37

深度学习网络的训练步骤

1. 导入数据

2. 把数据分成多个batch 3. 定义网络的参数,包括神经元的数量,卷积核的大小,学习率,迭代次数等 4. 定义网络结构 5. 初始化网络参数 6. 定义反向传播(主要是梯度下降法,如果用pytorch, tensorflow 等框架,只需 要调用相关函数即可) 7. 把训练数据按batch大小依次送入网络进行训练 8. 保存模型,进行测试

38

如何学习深度学习

1. 要懂得基本的原理,包括前向计算,反向传播的 数学原理 2. 要多写代码练习 3. 要多阅读论文,尤其是引用率比较大的论文 4. 要多和同行进行交流

39

谢谢!

THANK YOU FOR YOUR WATCHING

40

人工智能深度讲座

1

个人简介 人工智能简史 深度学习基本思想 深度学习在各行业的应用 我能学懂深度学习吗? 培训简介

2

PART 01 个人简介

3

PART 2 人工智能简史

4

孕育时期

公元前384-322 亚里 士多德(Aristotle) 形式逻辑 三段论

A

20世纪40年代,麦卡洛 克和皮茨 神经网络模 型 →连接主义学派

深度学习在各行业的应用深度学习基本思想人工智能简史个人简介2个人简介part013人工智能简史part24公元前384322亚里士多德aristotle形式逻辑三段论a20世纪30年代数理逻辑维纳弗雷治罗素等为代表对发展数理逻辑学科的贡献丘奇图灵和其它一些人关于计算本质的思想为人工智能的形成产生了重要影响b20世纪40年代麦卡洛克和皮茨神经网络模型连接主义学派c1948年维纳创立了控制论行为主义学派d孕育时期51956年在美国的达特茅斯大学召开了第一次人工智能研讨会标志人工智能学科的诞生a1965年诞生了第一个专家系统dendral可以帮助化学家分析分子结构b1969年召开了第一届人工智能联合会议此后每两年举行一次c1970年人工智能国际杂志创刊d形成时期195619706过高预言的失败给ai的声誉造成了重大伤害a下棋程序在与世界冠军对弈时以1

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

2. 1982年,Hopfield模型提出。1984年, J. Hopfield设计研制了 Hopfield网的电路,较好地解决了著名的旅行商问题,引起了较大的轰动。

3. 1986年, Rumelhart, Hinton 提出多层感知机与反向传播(BP) 学习算

法,该方法克服了感知器非线性不可分类问题,给神经网络研究带来了新

23

深度学习的发展历史

2020/3/8

24

深度学习的发展历史

2020/3/8

25

深度学习的发展历史

2020/3/8

26

PART 3 深度学习在各行业的应用

2020/3/8

27

深度学习在各个行业的应用

1. AlphaGo Zero的提升,让DeepMind看到了利用人工智能技术改变人类命运的突破。他们目前正积极 与英国医疗机构和电力能源部门合作,提高看病效率和能源效率。同时类似的技术应用在其他结构性 问题,比如蛋白质折叠、减少能耗和寻找新材料上,就能创造出有益于社会的突破。

的希望。

2020/3/8

9

深度学习的发展历史

2020/3/8

10

深度学习的发展历史

2020/3/8

11

深度学习的发展历史

2020/3/8

12

深度学习的发展历史

International Conference on Neural Information Processing Systems. Curran Associates Inc. 2012:1097-1105.

2020/3/8

13

深度学习的发展历史

2020/3/8

促进深度学习发展的2个因素: 1. 计算能力的增强,尤其是 GPU的出现,极大的提升了深 度学习的计算速度 2. 数据的迅猛增加

14

深度学习的发展历史

2020/3/8

15

深度学习的发展历史

2020/3/8

16

深度学习的发展历史

2020/3/8

人工智能深度讲座

2

1

2020/3/8

个人简介 人工智能简史 深度学习基本思想 深度学习在各行业的应用 我能学懂深度学习吗? 培训简介

2

PART 01 个人简介

2020/3/8

3

PART 2 人工智能简史

2020/3/8

4

孕育时期

2020/3/8

公元前384-322 亚里 士多德(Aristotle) 形式逻辑 三段论

2020/3/8

1956年,在美国的达特茅斯大 学召开了第一次人工智能研讨 会,标志人工智能学科的诞生

A

1969年召开了第一届人 工智能联合会议,此后

每两年举行一次

C

1965年诞生了第一个专家 系统 DENDRAL,可以帮

助化学家分析分子结构

B

1970年,《人工智能》 国际杂志创刊

D

6

暗淡期(1966 ~ 1976)

2020/3/8

MYCIN专家系统,用于 协助内科医生诊断细菌

感染疾病

A

计算机视觉、机器人、 自然语言理解、机器翻 译等取得了长足进步

C

斯坦福大学研制成功地 质勘探专家系统

B

1997年,IBM研发的 “深蓝”击败了国际象棋

冠军卡斯帕罗夫 D

8

深度学习的发展历史

1. 神经网络的原创文章发表于1943年,两位作者都是传奇人物,麦卡洛可 (McCulloch)和皮茨(Pitts),“A Logical Calculus of Ideas Immanent in Nervous Activity”, 发表在《数学生物物理期刊》

6. 农业上,可以用于发现农作物的病虫害,还可以用来识别哪些地方的环境适合种植

7.利用深度学习,可以将抓拍到的珍稀动物(比如鲸鱼)照片进行分类,从而更好地估算某种动物的存

活数量

2020/3/8

28

深度学习在各个行业的应用

2020/3/8

29

PART 4 深度学习的基本思想

2020/3/8

30

深度学习的基本思想

A

20世纪40年代,麦卡洛 克和皮茨 神经网络模 型 →连接主义学派

C

20世纪30年代,数理逻辑、维纳弗雷 治、罗素等为代表对发展数理逻辑学 科的贡献,丘奇、图灵和其它一些人 关于计算本质的思想,为人工智能的 形成产生了重要影响

B

1948年,维纳创立了 控制论,行为主义学派

D

5

形成时期(1956 ~ 1970)

2020/3/8

过高预言的失败,给AI 的声誉造成了重大伤害

A

出现了很离谱的翻译结果, 把“心有力而余不足”翻译 成“酒是好的,但肉变质了”

C

下棋程序在与世界冠军 对弈时以1:4告负

B

剑桥大学数学家詹姆士按照英 国政府的旨意发表报告,称AI 即便不是骗局也是庸人自扰

D

7

发展期(1976 ~ 1998)

2020/3/8

35

BP网络

2020/3/8

36

卷积

2020/3/8

37

深度学习网络的训练步骤

1. 导入数据

2. 把数据分成多个batch 3. 定义网络的参数,包括神经元的数量,卷积核的大小,学习率,迭代次数等 4. 定义网络结构 5. 初始化网络参数 6. 定义反向传播(主要是梯度下降法,如果用pytorch, tensorflow 等框架,只需 要调用相关函数即可) 7. 把训练数据按batch大小依次送入网络进行训练 8. 保存模型,进行测试

2. 无人驾驶

3.在医疗领域,可以用于识别癌细胞,发现新药物等

4.金融领域可以用来预测股价,还可以用来识别欺诈。摩根大通利用AI开发了一款金融合同解析软件。 经测试,原先律师和贷款人员每年需要360000小时才能完成的工作,这款软件只需几秒就能完成。而 且,不仅错误率大大降低,重要的是它还从不放假

5. 精准营销,为用户推荐感兴趣的产品广告

17

深度学习的发展历史

2020/3/8

18

深度学习的发展历史

2020/3/8

19

图片取自何凯明的ppt

深度学习的发展历史

2020/3/8

图片取自何凯明的ppt

20

深度学习的发展历史

2020/3/8

21

图片取自何凯明的ppt

深度学习的发展历史

2020/3/8

22

深度学习的发展历史

2020/3/8

2020/3/8

31

深度学习的基本思想

2020/3/8

32

深度学习在各个行业的应用

2020/3/8

图片取自lecun的ppt

33

Hale Waihona Puke PART 5 我能学懂深度学习吗?

2020/3/8

34

需要具备的基础知识

● 微积分、线性代数、概率论 ● 基础的编程知识,最好有python基础 ● 良好的英文文献阅读能力