增强学习ReinforcementLearning经典算法梳理

什么是强化学习

强化学习强化学习(Reinforcement Learning, RL),又称再励学习、评价学习或增强学习,是机器学习的范式和方法论之一,用于描述和解决智能体(agent)在与环境的交互过程中通过学习策略以达成回报最大化或实现特定目标的问题。

强化学习的常见模型是标准的马尔可夫决策过程(Markov Decision Process, MDP)。

按给定条件,强化学习可分为基于模式的强化学习(model-based RL)和无模式强化学习(model-free RL),以及主动强化学习(active RL)和被动强化学习(passive RL)。

强化学习的变体包括逆向强化学习、阶层强化学习和部分可观测系统的强化学习。

求解强化学习问题所使用的算法可分为策略搜索算法和值函数(value function)算法两类。

深度学习模型可以在强化学习中得到使用,形成深度强化学习。

强化学习理论受到行为主义心理学启发,侧重在线学习并试图在探索-利用(exploration-exploitation)间保持平衡。

不同于监督学习和非监督学习,强化学习不要求预先给定任何数据,而是通过接收环境对动作的奖励(反馈)获得学习信息并更新模型参数。

强化学习问题在信息论、博弈论、自动控制等领域有得到讨论,被用于解释有限理性条件下的平衡态、设计推荐系统和机器人交互系统。

一些复杂的强化学习算法在一定程度上具备解决复杂问题的通用智能,可以在围棋和电子游戏中达到人类水平。

中文名强化学习外文名Reinforcement Learning, RL别名再励学习,评价学习,增强学习;强化学习是智能体(Agent)以“试错”的方式进行学习,通过与环境进行交互获得的奖赏指导行为,目标是使智能体获得最大的奖赏,强化学习不同于连接主义学习中的监督学习,主要表现在强化信号上,强化学习中由环境提供的强化信号是对产生动作的好坏作一种评价(通常为标量信号),而不是告诉强化学习系统RLS(reinforcement learning system)如何去产生正确的动作。

强化学习算法中的反向动力学方法详解(Ⅰ)

强化学习(Reinforcement Learning, RL)是一种机器学习方法,它通过代理在与环境的互动中学习如何做出决策来最大化累积奖赏。

RL 中的核心问题是探索与利用的权衡,以及如何在不确定性环境下做出最优决策。

近年来,强化学习在许多领域取得了巨大的进展,并成为人工智能领域备受关注的研究方向之一。

在强化学习算法中,反向动力学方法是一种重要的学习策略。

与传统的基于值函数或策略函数的方法不同,反向动力学方法直接学习动作值函数或动作策略函数。

本文将详细介绍反向动力学方法在强化学习中的应用及其原理。

一、反向动力学方法的基本原理在强化学习中,代理与环境不断进行交互,代理根据环境的反馈调整自己的决策策略。

反向动力学方法的核心思想是从输出开始反向计算输入对应的价值函数或策略函数,以此来更新参数。

与直接从输入到输出的前向计算相比,反向动力学方法更适用于高维复杂的问题,并且能够在参数更新过程中更好地处理梯度消失和梯度爆炸等问题。

二、反向动力学方法在深度强化学习中的应用深度强化学习是指将深度学习技术应用于强化学习中,以解决高维、复杂环境下的决策问题。

在深度强化学习中,反向动力学方法被广泛应用于价值函数的估计和策略函数的优化。

通过神经网络逼近动作值函数或动作策略函数,可以有效地处理高维状态空间和动作空间,并且能够对复杂的非线性关系进行建模。

三、反向动力学方法的算法实现在实际应用中,反向动力学方法通常采用基于梯度的优化算法进行参数更新。

常用的算法包括随机梯度下降(Stochastic Gradient Descent, SGD)、Adam、RMSProp 等。

这些算法通过不断地迭代更新参数,使得神经网络逼近目标函数,并且能够处理高维、非凸的优化问题。

四、反向动力学方法的改进与应用近年来,学者们提出了许多改进的反向动力学方法,以应对深度强化学习中的挑战。

例如,基于自适应激励的增强学习方法(Intrinsically Motivated Reinforcement Learning, IMRL)可以有效地解决探索与利用的平衡问题;基于元学习的方法可以在少样本学习的场景下实现快速收敛。

基于多策略学习的强化学习算法研究

基于多策略学习的强化学习算法研究强化学习(Reinforcement Learning)是一种机器学习的方法,它在不知道正确答案的情况下,通过尝试和错误不断的学习,从而实现某种任务的优化。

强化学习的基本思想是在与环境的交互中,根据环境对智能体的反馈不断地进行学习和优化。

当然这意味着我们需要在某些情况下允许智能体犯错,但这是不可避免的。

强化学习为人工智能的进一步发展掀开了一个新的篇章。

然而,在传统强化学习算法中,由于智能体在优化过程中只能使用单一策略,且往往只能优化某些特定目标,其应用受到了很大的限制。

为了解决这一问题,出现了多策略学习的概念。

多策略学习(Multiple Policies Learning)指的是在一个智能体中使用多种策略来完成某个目标,以提高策略的适应性和稳定性。

多策略学习让机器在决策过程中更加具有灵活性和鲁棒性,在面对未知情况时能够采取更加合理的策略。

通常情况下,多策略学习算法涉及到动态策略选择和策略融合(如softmax和UCB等),能够在不同环境下使智能体能够更加平稳的完成任务。

为了更好地理解多策略学习,我们可以将其与单策略学习进行对比。

单策略学习只能使机器通过一个固定的策略来完成任务,无法很好地适应复杂和多变的情况。

与之相反,多策略学习通过使用多个策略,使机器在不同情况下选择相应策略,从而提高了性能、鲁棒性和可控性。

在多策略学习的算法中,一个主要的挑战是如何选择适合的策略。

通常情况下,我们可以通过混合(mixing)和转换(switching)两种方式来实现策略的选择。

混合(mixing)指的是在不同阶段使用不同的策略,而转换(switching)指的是在任务处理的过程中,根据一些标准或者加性系数动态选择适合的策略。

这两种选择策略的方式都需要考虑状态对策略的影响,从而实现最优策略的选择。

值得注意的是,虽然多策略学习方式可以有效提高机器在复杂任务中的性能和稳定性,但是也存在着一些问题。

integral reinforcement learning

integral reinforcement learning强化学习是一种机器学习算法,它通过利用试错方法来对多个环境中的行为作出预测和决策,以实现某个目标。

当与积分学习(Integral Learning)结合时,强化学习能够更好地学习和更新环境的状态,从而更快地实现预期目标。

本文将详细介绍“integral reinforcement learning”。

第一步:什么是强化学习?强化学习是一种通过与环境的不断交互来学习和改进决策策略的机器学习算法。

在强化学习中,智能体会与环境进行交互,根据环境的反馈来调整和改进自己的行为。

强化学习中的“强化”指的是通过环境的奖励和惩罚来引导智能体的学习。

第二步:什么是积分学习?积分学习是指在机器学习过程中对数据进行求和,以获得更好的结果的一种方法。

这种方法可以帮助算法更好地学习数据的概览特征,从而更有效地分类和预测数据。

第三步:为什么需要积分学习?强化学习中经常需要对多个状态和动作进行汇总分析。

积分学习可以对这些数据进行求和,从而得到更准确的结果。

除此之外,积分学习还可以帮助算法更好地处理不同的信号和噪声,从而减少误判和误判率。

第四步:什么是integral reinforcement learning?积分强化学习是强化学习与积分学习相结合的一种方法。

在这种方法中,智能体会根据环境的反馈进行调整和改进,同时进行积分分析以获取环境中的任何重要特征,并更好地学习数据的概览特征。

积分强化学习有助于智能体更快地学习和理解环境,并更好地决策和预测行为。

第五步:integral reinforcement learning的应用积分强化学习已经应用于各种领域,包括计算机视觉、自然语言处理、机器人学和自动化等。

在计算机视觉领域中,积分强化学习可以帮助识别图像中的物体和区域,并帮助智能体更快地识别和处理信号。

在自然语言处理中,积分强化学习可以帮助智能体更好地理解语言,从而更好地进行语音识别和翻译。

ai专业术语

ai专业术语AI专业术语:机器学习算法机器学习算法是人工智能领域中的重要组成部分,它是让机器能够自动学习和改进的关键。

机器学习算法可以通过分析和利用数据,从中发现模式并自动调整自身的行为。

下面将介绍几种常见的机器学习算法。

1. 监督学习算法(Supervised Learning Algorithms)监督学习算法是一种通过给机器输入带有标签的训练数据来进行学习的方法。

它的目标是根据已知输入和对应的输出,构建一个能够预测新输入对应输出的模型。

常见的监督学习算法包括线性回归、逻辑回归、决策树、支持向量机等。

2. 无监督学习算法(Unsupervised Learning Algorithms)无监督学习算法是一种在训练数据中没有标签的情况下进行学习的方法。

它的目标是通过发现数据中的内在结构和模式,将数据进行聚类、降维等操作。

常见的无监督学习算法包括聚类算法(如K均值聚类、层次聚类)、关联规则挖掘等。

3. 强化学习算法(Reinforcement Learning Algorithms)强化学习算法是一种通过试错和奖励机制来训练机器的方法。

它的目标是让机器在与环境进行互动的过程中,通过尝试不同的行动并根据行动的结果获得奖励或惩罚,从而学习到最优的行动策略。

常见的强化学习算法包括Q-Learning、Deep Q Network等。

4. 深度学习算法(Deep Learning Algorithms)深度学习算法是一种基于人工神经网络的机器学习算法。

它通过多层次的神经元网络来模拟人脑的工作原理,从而实现对复杂数据的学习和理解。

深度学习算法在图像识别、语音识别、自然语言处理等领域取得了巨大的成功。

常见的深度学习算法包括卷积神经网络(CNN)、循环神经网络(RNN)、长短期记忆网络(LSTM)等。

5. 迁移学习算法(Transfer Learning Algorithms)迁移学习算法是一种利用已学习到的知识来解决新问题的方法。

迁移学习10大经典算法

迁移学习10大经典算法在机器研究领域中,迁移研究是一种利用已学到的知识来解决新问题的方法。

迁移研究算法可以帮助我们将一个或多个已经训练好的模型的知识迁移到新的任务上,从而加快研究过程并提高性能。

以下是迁移研究领域中的10大经典算法:1. 预训练模型方法(Pre-trained models):通过在大规模数据集上进行预训练,然后将模型迁移到新任务上进行微调。

2. 领域自适应方法(Domain adaptation):通过将源领域的知识应用到目标领域上,解决领域差异导致的问题。

3. 迁移特征选择方法(Transfer feature selection):选择和目标任务相关的有效特征,减少特征维度,提高模型性能。

4. 迁移度量研究方法(Transfer metric learning):通过研究一个度量空间,使得源领域和目标领域之间的距离保持一致,从而实现知识迁移。

5. 多任务研究方法(Multi-task learning):通过同时研究多个相关任务的知识,提高模型的泛化能力。

6. 迁移深度卷积神经网络方法(Transfer deep convolutional neural networks):使用深度卷积神经网络进行特征提取,并迁移到新任务上进行训练。

7. 迁移增强研究方法(Transfer reinforcement learning):将已有的增强研究知识应用到新任务上,优化智能体的决策策略。

8. 迁移聚类方法(Transfer clustering):通过将已有的聚类信息应用到新数据上,实现对未标记数据的聚类。

9. 迁移样本选择方法(Transfer sample selection):通过选择源领域样本和目标领域样本的子集,减少迁移研究中的负迁移影响。

10. 迁移异构研究方法(Transfer heterogeneous learning):处理源领域和目标领域数据类型不一致的问题,例如将文本数据和图像数据进行迁移研究。

reinforce算法原理

reinforce算法原理Reinforce算法原理引言:Reinforce算法是一种强化学习算法,用于解决序列决策问题。

其核心思想是通过试错学习,从而找到最优的策略。

本文将介绍Reinforce算法的原理及其应用。

1. 强化学习简介强化学习是一种机器学习的分支,通常用于解决智能体与环境之间的交互问题。

在强化学习中,智能体通过与环境的交互来学习最优策略,以达到最大化累积奖励的目标。

2. Reinforce算法概述Reinforce算法是一种基于策略梯度的强化学习算法,旨在通过优化策略来最大化累积奖励。

其核心思想是通过采样轨迹来估计策略的期望奖励,并使用梯度上升法来更新策略参数。

3. 策略梯度方法在强化学习中,策略是指智能体根据当前状态选择动作的方式。

策略梯度方法是一种直接优化策略参数的方法,通过最大化累积奖励来更新策略。

4. 策略梯度定理策略梯度定理是Reinforce算法的核心理论基础。

该定理指出,策略的梯度可以通过采样轨迹来估计,进而用来更新策略参数。

具体而言,策略的梯度可以表示为累积奖励与梯度的乘积。

5. 重要性采样在实际应用中,由于策略的更新会改变智能体的行为,导致采样分布的变化,因此需要进行重要性采样来修正采样偏差。

重要性采样是一种校正采样分布的方法,用于估计策略的期望奖励。

6. Reinforce算法步骤Reinforce算法的具体步骤如下:(1) 初始化策略参数;(2) 采样轨迹,记录状态、动作和奖励;(3) 计算采样轨迹的累积奖励;(4) 计算策略的梯度;(5) 更新策略参数;(6) 重复步骤(2)-(5)直到收敛。

7. Reinforce算法的优缺点Reinforce算法作为一种基于策略梯度的强化学习算法,具有以下优点:(1) 可以处理连续动作空间的问题;(2) 可以学习到隐蔽的最优策略;(3) 可以在未知环境中进行学习。

然而,Reinforce算法也存在一些缺点:(1) 训练过程不稳定,容易陷入局部最优;(2) 难以处理高维状态空间的问题;(3) 训练时间长,计算复杂度高。

掌握机器学习中的集成学习和深度强化学习算法

掌握机器学习中的集成学习和深度强化学习算法集成学习和深度强化学习是机器学习领域中的两个重要研究方向。

本文将介绍集成学习和深度强化学习的基本概念、算法原理和应用领域。

一、集成学习集成学习(Ensemble Learning)是一种通过结合多个基学习器来提高机器学习算法性能的方法。

集成学习的基本思想是“三个臭皮匠,赛过诸葛亮”,通过将多个弱学习器集合在一起,形成一个强学习器,从而提高预测性能。

常见的集成学习方法包括投票法、平均法和Bagging、Boosting 等。

投票法是指通过多个弱学习器进行投票来决定最终的预测结果。

平均法则是将多个弱学习器的预测结果进行平均,作为最终的预测结果。

而Bagging和Boosting是将多个基学习器进行整合,分别通过并行和串行的方式进行训练,从而提高模型的泛化能力。

集成学习的应用非常广泛,其中最著名的应用之一是随机森林(Random Forest)。

随机森林是一种基于决策树的集成学习算法,通过多个决策树的投票或平均来进行分类或回归任务。

随机森林具有较强的鲁棒性和泛化能力,在各种实际应用中取得了良好的效果。

二、深度强化学习深度强化学习(Deep Reinforcement Learning)是结合深度学习和强化学习的一种方法。

强化学习是一种通过智能体在环境中执行动作并得到奖励信号,以达到最大化累积奖励的学习方法。

深度学习则是一种模仿人脑神经网络的学习方法,利用多层神经网络对输入特征进行高层抽象和表示学习。

深度强化学习的核心是使用深度神经网络来近似值函数或者策略函数。

一种经典的深度强化学习算法是深度Q网络(Deep Q-Network,DQN)。

DQN通过深度神经网络来逼近动作值函数(Q函数),从而实现智能体在环境中选取最优动作。

DQN具有较强的逼近能力和泛化能力,在很多领域,特别是游戏领域取得了非常好的效果。

深度强化学习在很多领域都有着广泛的应用。

例如,在机器人领域,深度强化学习可以用于实现机器人的自主导航和控制;在自然语言处理和机器翻译领域,深度强化学习可以用于语言模型的训练和优化;在金融领域,深度强化学习可以通过学习交易模式来进行股票交易。

fundamentals of reinforcement learning

强化学习(fundamentals of reinforcement learning)是一种机器学习技术,其核心思想是智能体通过与环境互动,通过试错学习如何做出最优决策。

在强化学习中,智能体不断地与环境交互,通过接收环境状态、采取行动、获得奖励的循环,学习如何在给定的环境下采取最优的行动,以最大化长期的累积奖励。

强化学习的基本要素包括:

状态(State):表示环境的当前状态。

行动(Action):智能体可以采取的行动。

奖励(Reward):智能体在采取行动后从环境中获得的正或负反馈。

策略(Policy):智能体的决策规则,用于确定在给定状态下应采取的行动。

价值函数(Value Function):评估在特定状态下采取特定行动的好坏。

回报函数(Return Function):描述从某个状态开始的一系列行动所能获得的累积奖励。

强化学习的算法可以分为基于模型的强化学习和无模型强化学习。

基于模型的强化学习利用环境的模型来预测未来的状态和奖励,而无需实际与环境互动。

无模型强化学习则直接在环境中进行试错,通过不断与环境互动来学习如何做出最优决策。

强化学习的应用非常广泛,包括但不限于:游戏AI、自动驾驶、机器人控制、自然语言处理、推荐系统等。

强化学习算法中的基于模型的强化学习方法详解

强化学习(Reinforcement Learning, RL)是一种机器学习方法,其目标是让智能体通过与环境的交互来学习最优的行为策略。

强化学习算法中的基于模型的强化学习方法是其中的一种重要方法,下面将对其进行详细的介绍。

1. 强化学习概述强化学习是一种通过观察周围环境而学会选择行为的机器学习方法。

与监督学习和无监督学习不同,强化学习是通过与环境的交互来学习的。

在强化学习中,智能体采取行动,环境对智能体的行动做出反馈,智能体根据这些反馈调整自己的行为策略,以使得获得的回报最大化。

2. 基于模型的强化学习方法基于模型的强化学习方法是强化学习中的一种重要方法,它的核心思想是建立一个对环境的模型,用这个模型来规划最优的行为策略。

在基于模型的强化学习中,智能体首先要对环境进行建模,然后利用这个模型来进行规划,最终选择最优的行为。

3. 模型建立在基于模型的强化学习中,建立环境模型是非常重要的一步。

环境模型可以是确定性的,也可以是随机的。

确定性的环境模型可以简化问题,但在现实世界中往往很难建立确定性模型,因此随机环境模型更为常见。

智能体通过与环境的交互,收集数据来建立环境模型,一般采用的方法有动态规划和模型学习。

4. 规划与控制在基于模型的强化学习中,一旦建立了环境模型,智能体就可以利用这个模型进行规划和控制。

规划是指根据环境模型来预测未来的状态和奖励,然后选择最优的行为策略。

而控制是指智能体根据规划选择最优的行为来与环境进行交互。

在规划和控制过程中,智能体需要解决探索和利用的平衡问题,即要在已知最优行为和探索未知行为之间进行权衡。

5. 基于模型的强化学习的优缺点基于模型的强化学习方法具有一定的优点和缺点。

其优点在于可以更好地利用环境模型进行规划,从而更有效地选择最优的行为策略。

而其缺点在于建立环境模型的过程可能非常复杂,尤其是在面对复杂的随机环境时,建立准确的模型可能非常困难。

6. 基于模型的强化学习的应用基于模型的强化学习方法在许多领域都有着广泛的应用。

强化学习及其常见算法介绍

强化学习及其常见算法介绍强化学习是一种机器学习方法,其目标是通过在环境中与该环境进行互动而学习最佳行为策略。

强化学习可应用于广泛的领域,包括游戏、机器人、自然语言处理和金融等领域。

本文将介绍常见的强化学习算法。

1. 马尔可夫决策过程马尔可夫决策过程(MDP)是强化学习的核心模型。

它由五个部分构成:状态集、动作集、奖励函数、转移函数和时间步长。

在MDP中,决策者学习一个策略,以最大化期望的累积奖励。

MDP是一个被广泛应用于强化学习的数学框架。

2. Q学习Q学习是一种基于值函数的强化学习算法,其目的是通过学习最优Q函数来学习最优策略。

在Q学习中,代理通过从当前状态中选择动作来获得奖励,并更新Q函数,以预测在该状态下执行特定动作的期望奖励。

Q函数的更新基于贝尔曼方程的形式。

Q学习是一种简单而有效的强化学习算法,被广泛应用于各种领域。

3. SARSASARSA是一种基于动作值实现的强化学习算法,其目的是通过学习最优动作值来学习最优策略。

SARSA使用一种叫做on-policy的方法,即学习策略是学习算法选择行为的那个策略。

与Q学习不同的是,在SARSA中,Q函数在更新时使用当前状态下的动作而不是下一个状态下的最佳动作。

4. 深度强化学习深度强化学习将深度学习和强化学习相结合,使用人工神经网络来学习策略或值函数。

深度强化学习已经在各种领域获得了成功,包括游戏和机器人控制。

在深度强化学习中,神经网络用于近似状态-动作或值函数,并由代理通过与环境互动来训练。

5. 策略梯度策略梯度是一种将参数化策略与梯度下降结合起来的算法。

策略梯度算法通过将策略视为参数化概率分布来学习策略。

策略梯度算法的更新是通过应用梯度下降优化策略参数的目标函数来实现的。

策略梯度算法的优点是能够学习连续动作域问题中的最优策略,并且比Q学习和SARSA更加稳定。

6. 强化学习中的探索与利用强化学习中的探索与利用问题是一个重要的问题。

探索是指代理通过在不确定性状态中选择动作来获得更多信息,而利用是指代理选择已知的最优动作以最大化收益。

Matlab中的强化学习算法介绍与应用

Matlab中的强化学习算法介绍与应用强化学习是机器学习领域的一个重要分支,它旨在通过与环境的交互学习最优策略,以最大化所获得的累积奖赏。

Matlab作为一种功能强大的科学计算软件,提供了丰富的工具和函数,用于实现和应用强化学习算法。

本文将介绍Matlab中常用的强化学习算法,并探讨其在实际应用中的潜力。

1. 强化学习算法简介强化学习算法主要分为基于价值的方法和基于策略的方法。

基于价值的方法侧重于估计状态或状态-动作对的价值函数,如Q-learning和SARSA算法。

基于策略的方法则直接学习最优策略,例如策略梯度算法和Actor-Critic算法。

这些算法可以用于解决各种强化学习问题,如贴地飞行控制、自动驾驶和智能游戏等。

2. Q-learning算法Q-learning是一种基于价值的强化学习算法,它通过估计状态-动作对的价值函数来学习最优策略。

在Matlab中,可以使用Q-learning工具箱来实现该算法。

首先,需要定义状态空间、动作空间和奖赏函数。

然后,使用Q-learning算法更新Q 值,并迭代地选择和执行动作,直到达到终止条件。

最后,根据学习到的Q值函数选择动作。

3. SARSA算法SARSA算法也是一种基于价值的强化学习算法,它与Q-learning算法类似,但不同之处在于它采用了SARSA(状态、动作、奖赏、状态、动作)元组的更新规则。

在Matlab中,可以利用Reinforcement Learning Toolbox实现SARSA算法。

该工具箱提供了方便的函数和工具,可用于定义环境、代理和奖赏,以及实现SARSA算法的训练和测试。

4. 策略梯度算法策略梯度算法是一种基于策略的强化学习算法,它直接学习最优策略而不需要估计价值函数。

在Matlab中,可以使用Deep Learning Toolbox实现策略梯度算法。

该工具箱提供了强大的深度学习框架,可用于构建神经网络模型,并通过梯度下降法更新网络参数。

强化学习(五)——策略梯度及reinforce算法

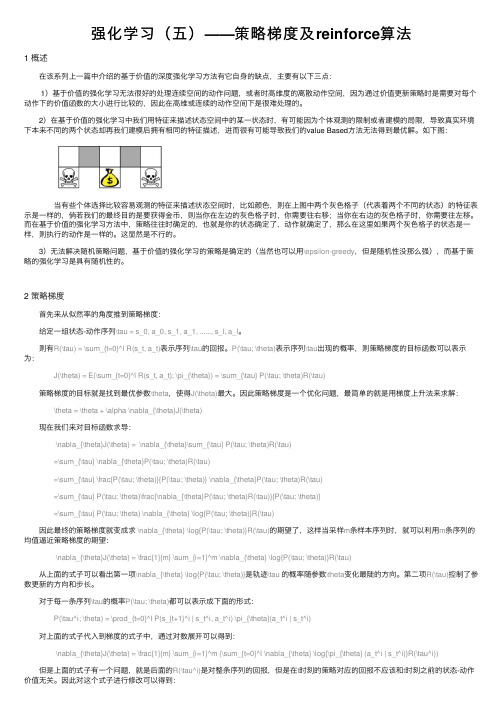

强化学习(五)——策略梯度及reinforce算法1 概述 在该系列上⼀篇中介绍的基于价值的深度强化学习⽅法有它⾃⾝的缺点,主要有以下三点: 1)基于价值的强化学习⽆法很好的处理连续空间的动作问题,或者时⾼维度的离散动作空间,因为通过价值更新策略时是需要对每个动作下的价值函数的⼤⼩进⾏⽐较的,因此在⾼维或连续的动作空间下是很难处理的。

2)在基于价值的强化学习中我们⽤特征来描述状态空间中的某⼀状态时,有可能因为个体观测的限制或者建模的局限,导致真实环境下本来不同的两个状态却再我们建模后拥有相同的特征描述,进⽽很有可能导致我们的value Based⽅法⽆法得到最优解。

如下图: 当有些个体选择⽐较容易观测的特征来描述状态空间时,⽐如颜⾊,则在上图中两个灰⾊格⼦(代表着两个不同的状态)的特征表⽰是⼀样的,倘若我们的最终⽬的是要获得⾦币,则当你在左边的灰⾊格⼦时,你需要往右移;当你在右边的灰⾊格⼦时,你需要往左移。

⽽在基于价值的强化学习⽅法中,策略往往时确定的,也就是你的状态确定了,动作就确定了,那么在这⾥如果两个灰⾊格⼦的状态是⼀样,则执⾏的动作是⼀样的。

这显然是不⾏的。

3)⽆法解决随机策略问题,基于价值的强化学习的策略是确定的(当然也可以⽤\epsilon-greedy,但是随机性没那么强),⽽基于策略的强化学习是具有随机性的。

2 策略梯度 ⾸先来从似然率的⾓度推到策略梯度: 给定⼀组状态-动作序列\tau = s_0, a_0, s_1, a_1, ......, s_l, a_l。

则有R(\tau) = \sum_{t=0}^l R(s_t, a_t)表⽰序列\tau的回报。

P(\tau; \theta)表⽰序列\tau出现的概率,则策略梯度的⽬标函数可以表⽰为: J(\theta) = E(\sum_{t=0}^l R(s_t, a_t); \pi_{\theta}) = \sum_{\tau} P(\tau; \theta)R(\tau) 策略梯度的⽬标就是找到最优参数\theta,使得J(\theta)最⼤。

人工智能中的深度强化学习与策略梯度算法

人工智能中的深度强化学习与策略梯度算法深度强化学习(Deep Reinforcement Learning,简称DRL)是人工智能领域的一个热门研究方向,它结合了深度学习和强化学习的理论与方法,用于训练智能体在未知环境中通过试错学习来获取最佳策略。

DRL的核心思想是通过将深度学习模型引入强化学习框架中,利用模型自动学习状态与动作之间的映射关系,从而实现对智能体的无监督学习和自主决策。

相比传统的强化学习方法,DRL在处理高维状态空间和连续动作空间的问题上表现更加出色。

在DRL中,深度神经网络通常被用作价值函数或策略函数的近似表示。

其中,价值函数表示了每个状态的长期回报,而策略函数则指导智能体在每个状态下选择最优动作。

DRL算法通过优化这两个函数来实现智能体的强化学习过程。

策略梯度算法是DRL中常用的一类算法,它直接优化策略函数的参数来获得最优策略。

与传统的值函数方法不同,策略梯度算法更适用于处理连续动作空间的问题,并且可以直接优化非凸的策略函数。

策略梯度算法的核心思想是使用梯度上升法更新策略函数的参数,使得智能体在“好”的状态上增加概率并在“坏”的状态上减少概率,从而实现最优策略的学习。

常见的策略梯度算法包括REINFORCE、Actor-Critic、Proximal Policy Optimization(PPO)等。

这些算法在实践中广泛应用于各种类型的强化学习问题,如机器人控制、游戏智能、自动驾驶等。

REINFORCE算法是策略梯度算法的一种简单形式,它通过采样轨迹的方式来更新策略函数的参数。

具体地,REINFORCE算法通过对状态-动作序列的抽样,计算出每个状态-动作对的梯度,并根据梯度信息来更新策略函数的参数。

尽管REINFORCE算法在理论上是可以收敛的,但由于采样效率低下和样本方差大的问题,它在实践中往往表现不佳。

Actor-Critic算法是一种更为高效的策略梯度算法,它在策略函数的基础上引入了一个值函数,用于评估每个状态的长期回报。

强化学习算法中的经验回放方法详解(Ⅲ)

强化学习(Reinforcement Learning,RL)是一种通过与环境交互,以期望获得最大累积奖赏的机器学习方法。

强化学习算法在近年来备受关注,其在多个领域中取得了显著的成果。

而其中,经验回放(Experience Replay)方法是强化学习算法中的一种重要技术,它通过存储和重新利用之前的经验来提高算法的效率和稳定性。

本文将对经验回放方法进行详细解析。

1. 经验回放的概念经验回放是一种强化学习算法中的重要技术,它的核心思想是将智能体(Agent)在与环境交互中获得的经验进行存储,并在训练过程中重新利用这些经验。

具体来讲,智能体在与环境交互中会生成许多状态-动作-奖赏-下一个状态的元组,这些元组就是智能体的经验。

经验回放的基本思想就是将这些经验进行存储,并通过随机抽样的方式来训练智能体的神经网络,以提高算法的效率和稳定性。

2. 经验回放的原理在强化学习算法中,往往会出现数据的相关性和非平稳性问题。

数据的相关性指的是相邻时间步的状态和动作往往是相关的,而非平稳性则指的是环境的变化会导致数据的分布发生变化。

这些问题会影响算法的训练效果,导致算法的不稳定性。

而经验回放方法通过存储和重新利用之前的经验,可以有效地缓解这些问题。

具体来说,经验回放方法会将智能体的经验存储在一个经验池(Experience Replay Buffer)中,然后在训练过程中,从经验池中随机抽样一批经验用于训练。

这样可以打破数据的相关性,降低数据的非平稳性,提高算法的效率和稳定性。

3. 经验回放的算法经验回放方法最常用于深度强化学习算法中,如深度Q网络(Deep Q-Network,DQN)和其衍生算法。

以DQN算法为例,其主要包括四个步骤:环境交互、存储经验、经验回放和更新神经网络。

在环境交互阶段,智能体与环境交互,获取状态-动作-奖赏-下一个状态的元组。

然后,这些元组会被存储到经验池中。

在经验回放阶段,算法会从经验池中随机抽样一批经验,并用于训练神经网络。

强化学习简介

强化学习简介

强化学习(Reinforcement Learning, RL)是一种对用来学习环境的最

佳决策方式的计算机算法。

它是一种多步骤机器学习算法,允许一个

智能体以微小的动作改变环境,以便获得最大的奖励。

强化学习不同

于监督学习,它不是从预先标记的训练数据中学习,而是通过大量的

实验学习,从而探索与最优决策相关的最佳政策。

强化学习借鉴了动

物学习的机制,通过尝试不同的行动来获得奖励来实现最佳效果,而

不是通过模仿和背诵。

强化学习的基本思想是“学习来选择”,也就是通过尝试不同的行动

来学习最有效的政策。

与普通的机器学习算法不同,强化学习算法不

是从预先标记的训练数据中学习,而是通过实践和实验学习,从而找

出最佳的行为策略。

简而言之,强化学习实质上是一种自我学习的过程,通过评估和反馈形式使智能体不断升级,从而实现有效的学习。

目前,强化学习已经成为机器学习领域的一种非常流行的算法,它被

广泛用于各种应用领域,包括机器人控制、游戏、机器翻译、自动驾驶、医疗决策支持等等。

简而言之,强化学习是一种机器学习方法,旨在帮助智能体从环境中

学习有利决策,通过尝试和评估不同的行动,以获得最大的奖励。

它

重视通过从实际中反复尝试和评估不断学习的机制,而不是假设学习。

C u r i o s i t y 算 法

深度增强学习方向论文整理责编:王艺一. 开山鼻祖DQNPlaying Atari with Deep Reinforcement Learning,V. Mnih et al., NIPS Workshop, 2013.Human-level control through deep reinforcement learning, V. Mnih et al., Nature, 2015.二. DQN的各种改进版本(侧重于算法上的改进)Dueling Network Architectures for Deep Reinforcement Learning. Z. Wang et al., arXiv, 2015.Prioritized Experience Replay, T. Schaul et al., ICLR, 2016.Deep Reinforcement Learning with Double Q-learning, H. van Hasselt et al., arXiv, 2015.Increasing the Action Gap: New Operators for Reinforcement Learning, M. G. Bellemare et al., AAAI, 2016.Dynamic Frame skip Deep Q Network, A. S. Lakshminarayanan et al., IJCAI Deep RL Workshop, 2016.Deep Exploration via Bootstrapped DQN, I. Osband et al., arXiv, 2016.How to Discount Deep Reinforcement Learning: Towards New Dynamic Strategies, V. Fran?ois-Lavet et al., NIPS Workshop, 2015.Learning functions across many orders of magnitudes,H Van Hasselt,A Guez,M Hessel,D SilverMassively Parallel Methods for Deep Reinforcement Learning, A. Nair et al., ICML Workshop, 2015.State of the Art Control of Atari Games using shallow reinforcement learningLearning to Play in a Day: Faster Deep Reinforcement Learning by Optimality Tightening(11.13更新)Deep Reinforcement Learning with Averaged Target DQN(11.14更新)三. DQN的各种改进版本(侧重于模型的改进)Deep Recurrent Q-Learning for Partially Observable MDPs, M. Hausknecht and P. Stone, arXiv, 2015.Deep Attention Recurrent Q-NetworkControl of Memory, Active Perception, and Action in Minecraft, J. Oh et al., ICML, 2016.Progressive Neural NetworksLanguage Understanding for Text-based Games Using Deep Reinforcement LearningLearning to Communicate to Solve Riddles with Deep Distributed Recurrent Q-NetworksHierarchical Deep Reinforcement Learning: Integrating TemporalAbstraction and Intrinsic MotivationRecurrent Reinforcement Learning: A Hybrid Approach四. 基于策略梯度的深度强化学习深度策略梯度:End-to-End Training of Deep Visuomotor PoliciesLearning Deep Control Policies for Autonomous Aerial Vehicles with MPC-Guided Policy SearchTrust Region Policy Optimization深度行动者评论家算法:Deterministic Policy Gradient AlgorithmsContinuous control with deep reinforcement learningHigh-Dimensional Continuous Control Using Using Generalized Advantage EstimationCompatible Value Gradients for Reinforcement Learning of Continuous Deep PoliciesDeep Reinforcement Learning in Parameterized Action SpaceMemory-based control with recurrent neural networksTerrain-adaptive locomotion skills using deep reinforcement learningCompatible Value Gradients for Reinforcement Learning of Continuous Deep PoliciesSAMPLE EFFICIENT ACTOR-CRITIC WITH EXPERIENCE REPLAY(11.13更新)搜索与监督:End-to-End Training of Deep Visuomotor PoliciesInteractive Control of Diverse Complex Characters with Neural Networks连续动作空间下探索改进:Curiosity-driven Exploration in DRL via Bayesian Neuarl Networks结合策略梯度和Q学习:Q-PROP: SAMPLE-EFFICIENT POLICY GRADIENT WITH AN OFF-POLICY CRITIC(11.13更新)PGQ: COMBINING POLICY GRADIENT AND Q-LEARNING(11.13更新)其它策略梯度文章:Gradient Estimation Using Stochastic Computation GraphsContinuous Deep Q-Learning with Model-based AccelerationBenchmarking Deep Reinforcement Learning for Continuous Control Learning Continuous Control Policies by Stochastic Value Gradients五. 分层DRLDeep Successor Reinforcement LearningHierarchical Deep Reinforcement Learning: Integrating Temporal Abstraction and Intrinsic MotivationHierarchical Reinforcement Learning using Spatio-Temporal Abstractions and Deep Neural NetworksStochastic Neural Networks for Hierarchical Reinforcement Learning –Authors: Carlos Florensa, Yan Duan, Pieter Abbeel (11.14更新)六. DRL中的多任务和迁移学习ADAAPT: A Deep Arc hitecture for Adaptive Policy Transfer from Multiple SourcesA Deep Hierarchical Approach to Lifelong Learning in MinecraftActor-Mimic: Deep Multitask and Transfer Reinforcement Learning Policy DistillationProgressive Neural NetworksUniversal Value Function ApproximatorsMulti-task learning with deep model based reinforcement learning (11.14更新)Modular Multitask Reinforcement Learning with Policy Sketches (11.14更新)七. 基于外部记忆模块的DRL模型Control of Memory, Active Perception, and Action in Minecraft Model-Free Episodic Control八. DRL中探索与利用问题Action-Conditional Video Prediction using Deep Networks in Atari GamesCuriosity-driven Exploration in Deep Reinforcement Learning viaBayesian Neural NetworksDeep Exploration via Bootstrapped DQNHierarchical Deep Reinforcement Learning: Integrating Temporal Abstraction and Intrinsic MotivationIncentivizing Exploration In Reinforcement Learning With Deep Predictive ModelsUnifying Count-Based Exploration and Intrinsic Motivation#Exploration: A Study of Count-Based Exploration for Deep Reinforcemen Learning(11.14更新)Surprise-Based Intrinsic Motivation for Deep Reinforcement Learning(11.14更新)九. 多Agent的DRLLearning to Communicate to Solve Riddles with Deep Distributed Recurrent Q-NetworksMultiagent Cooperation and Competition with Deep Reinforcement Learning十. 逆向DRLGuided Cost Learning: Deep Inverse Optimal Control via Policy OptimizationMaximum Entropy Deep Inverse Reinforcement LearningGeneralizing Skills with Semi-Supervised Reinforcement Learning (11.14更新)十一. 探索+监督学习Deep learning for real-time Atari game play using offline Monte-Carlo tree search planningBetter Computer Go Player with Neural Network and Long-term PredictionMastering the game of Go with deep neural networks and tree search, D. Silver et al., Nature, 2016.十二. 异步DRLAsynchronous Methods for Deep Reinforcement LearningReinforcement Learning through Asynchronous Advantage Actor-Critic on a GPU(11.14更新)十三:适用于难度较大的游戏场景Hierarchical Deep Reinforcement Learning: Integrating Temporal Abstraction and Intrinsic Motivation, T. D. Kulkarni et al., arXiv, 2016.Strategic Attentive Writer for Learning Macro-ActionsUnifying Count-Based Exploration and Intrinsic Motivation十四:单个网络玩多个游戏Policy DistillationUniversal Value Function ApproximatorsLearning values across many orders of magnitude十五:德州pokerDeep Reinforcement Learning from Self-Play in Imperfect-Information GamesFictitious Self-Play in Extensive-Form GamesSmooth UCT search in computer poker十六:Doom游戏ViZDoom: A Doom-based AI Research Platform for Visual Reinforcement LearningTraining Agent for First-Person Shooter Game with Actor-Critic Curriculum LearningPlaying FPS Games with Deep Reinforcement LearningLEARNING TO ACT BY PREDICTING THE FUTURE(11.13更新)Deep Reinforcement Learning From Raw Pixels in Doom(11.14更新)十七:大规模动作空间Deep Reinforcement Learning in Large Discrete Action Spaces十八:参数化连续动作空间Deep Reinforcement Learning in Parameterized Action Space十九:Deep ModelLearning Visual Predictive Models of Physics for Playing BilliardsJ. Schmidhuber, On Learning to Think: Algorithmic Information Theory for Novel Combinations of Reinforcement Learning Controllersand Recurrent Neural World Models, arXiv, 2015. arXiv Learning Continuous Control Policies by Stochastic Value GradientsData-Efficient Learning of Feedback Policies from Image Pixels using Deep Dynamical ModelsAction-Conditional Video Prediction using Deep Networks in Atari GamesIncentivizing Exploration In Reinforcement Learning With Deep Predictive Models二十:DRL应用机器人领域:Trust Region Policy OptimizationTowards Vision-Based Deep Reinforcement Learning for Robotic Motion ControlPath Integral Guided Policy SearchMemory-based control with recurrent neural networksLearning Hand-Eye Coordination for Robotic Grasping with Deep Learning and Large-Scale Data CollectionLearning Deep Neural Network Policies with Continuous Memory StatesHigh-Dimensional Continuous Control Using Generalized Advantage EstimationGuided Cost Learning: Deep Inverse Optimal Control via PolicyOptimizationEnd-to-End Training of Deep Visuomotor PoliciesDeepMPC: Learning Deep Latent Features for Model Predictive ControlDeep Visual Foresight for Planning Robot MotionDeep Reinforcement Learning for Robotic ManipulationContinuous Deep Q-Learning with Model-based AccelerationCollective Robot Reinforcement Learning with Distributed Asynchronous Guided Policy SearchAsynchronous Methods for Deep Reinforcement LearningLearning Continuous Control Policies by Stochastic Value Gradients机器翻译:Simultaneous Machine Translation using Deep Reinforcement Learning目标定位:Active Object Localization with Deep Reinforcement Learning目标驱动的视觉导航:Target-driven Visual Navigation in Indoor Scenes using Deep Reinforcement Learning自动调控参数:Using Deep Q-Learning to Control Optimization Hyperparameters人机对话:Deep Reinforcement Learning for Dialogue GenerationSimpleDS: A Simple Deep Reinforcement Learning Dialogue System Strategic Dialogue Management via Deep Reinforcement Learning Towards End-to-End Learning for Dialog State Tracking and Management using Deep Reinforcement Learning视频预测:Action-Conditional Video Prediction using Deep Networks in Atari Games文本到语音:WaveNet: A Generative Model for Raw Audio文本生成:Generating Text with Deep Reinforcement Learning 文本游戏:Language Understanding for Text-based Games Using Deep Reinforcement Learning无线电操控和信号监控:Deep Reinforcement Learning Radio Control and Signal Detection with KeRLym, a Gym RL AgentDRL来学习做物理实验:LEARNING TO PERFORM PHYSICS EXPERIMENTS VIA DEEP REINFORCEMENT LEARNING(11.13更新)DRL加速收敛:Deep Reinforcement Learning for Accelerating the Convergence Rate(11.14更新)利用DRL来设计神经网络:Designing Neural Network Architectures using Reinforcement Learning(11.14更新)Tuning Recurrent Neural Networks with Reinforcement Learning (11.14更新)Neural Architecture Search with Reinforcement Learning(11.14更新)控制信号灯:Using a Deep Reinforcement Learning Agent for Traffic Signal Control(11.14更新)二十一:其它方向避免危险状态:Combating Deep Reinforcement Learning’s Sisyphean Curse with I ntrinsic Fear (11.14更新)DRL中On-Policy vs. Off-Policy 比较:On-Policy vs. Off-Policy Updates for Deep Reinforcement Learning(11.14更新)130+位讲师,16大分论坛,中国科学院院士陈润生、滴滴出行高级副总裁章文嵩、联想集团高级副总裁兼CTO芮勇、上交所前总工程师白硕等专家将亲临2016中国大数据技术大会,票价折扣即将结束,预购从速。

增强学习中的策略梯度方法与应用

增强学习中的策略梯度方法与应用增强学习(Reinforcement Learning)是一种机器学习方法,通过试错与奖惩机制来训练智能体(Agent)在未知环境中自主学习,并最大化其所获得的累积回报。

在增强学习中,策略梯度(Policy Gradient)方法是一种广泛应用的方法,通过优化策略函数的参数来寻找最优的决策策略。

本文将介绍策略梯度方法的原理、常见的应用场景以及一些改进方法。

在策略梯度方法中,策略函数被定义为将状态映射到行动的概率分布。

Agent的目标是通过不断与环境交互,在实践中不断优化策略函数的参数,以最大化预期回报。

策略梯度方法将这个优化问题转化为通过对策略函数参数进行梯度上升的方式来更新策略。

通过估计梯度方向,策略梯度方法可以直接处理连续动作空间和高维状态空间,具有较好的适应性。

策略梯度方法在许多领域有广泛的应用。

例如,在机器人控制中,策略梯度方法可以用于训练机器人完成特定任务,如抓取和导航。

在游戏领域,策略梯度方法可以用于训练智能体学习游戏策略,如下棋和玩电子游戏。

此外,在金融领域,策略梯度方法可以用于为投资组合管理提供决策支持。

尽管策略梯度方法具有一定的优势,但也存在一些挑战和改进的空间。

首先,策略梯度方法通常需要大量的训练样本才能收敛到较好的策略。

此外,由于梯度上升的方式更新策略,策略梯度方法容易陷入局部最优。

针对这些问题,研究人员提出了一些改进方法。

一种常见的改进方法是引入基线(Baseline)。

基线是一个与状态无关的函数,用于减小方差,并加速梯度更新的收敛。

引入基线后,策略梯度方法将目标函数重新定义为当前回报与基线之差的期望,从而更准确地估计梯度。

另一种改进方法是采用重要性采样(Importance Sampling),用于解决样本收集过程中的数据相关性问题。

通过引入重要性采样权重,可以有效利用旧策略上采集的样本。

近年来,深度学习的发展使得策略梯度方法在大规模和复杂环境中的应用成为可能。

强化学习算法原理详解

强化学习是一种机器学习方法,其基本思想是通过智能体与环境的交互,通过迭代地学习从环境获得的奖励信号来学习如何做出决策,以达到最大的总奖励。

在强化学习中,智能体通过执行动作来与环境进行交互,并从环境中接收奖励和反馈。

这些奖励和反馈被用来更新智能体的策略,以在下一次决策中做出更好的选择。

强化学习的算法原理主要包含以下几个关键步骤:

1. 初始化:首先,我们需要初始化一个智能体和一个环境。

智能体需要在环境中执行动作,并根据环境返回的奖励信号进行决策。

2. 策略学习:接下来,我们需要通过强化学习算法来学习如何选择最优的动作。

这个过程通常通过一个强化学习算法来实现,例如Q-learning、Actor-Critic算法、深度强化学习算法(如深度Q网络,DQN)等。

这些算法通过在环境中反复迭代,利用历史数据来估计最优的动作选择。

3. 状态评估:智能体需要在环境中观察状态(包括动作和环境反馈),并根据状态评估来做出决策。

评估通常基于环境的反馈和奖励信号来进行。

4. 动作选择:智能体根据评估结果选择最优的动作,并在执行后接收环境反馈。

这个过程会不断重复,直到达到某个停止条件(如达到最大迭代次数或达到预设目标)。

强化学习算法的核心在于奖励信号的设计和策略学习的优化。

奖励信号的设计需要考虑到问题的复杂性和目标,而策略学习的优化则需要考虑到算法的复杂性和计算效率。

目前,强化学习已经广泛应用于许多领域,如游戏、机器人控制、自动驾驶等。

以上就是强化学习算法的基本原理和步骤,希望能对你有所帮助!。

系统中的增强学习算法

系统中的增强学习算法增强学习(Reinforcement learning)是机器学习的一个重要领域,旨在设计一种能让智能体通过与环境的交互来学习决策的算法。

与监督学习和无监督学习不同,增强学习不依赖于预先标记好的数据,而是根据智能体在环境中的反馈来进行学习和优化,通过试错来不断改进自己的决策能力。

以下是几种常用的增强学习算法:1. Q-Learning:Q-Learning是增强学习中最经典的算法之一,它基于一个Q-表(Q-table)来维护每种状态下可采取的动作的价值,通过不断地更新Q-表来实现策略的改进。

Q-Learning是一种基于模型的方法,即智能体对环境的状态转移概率不做任何假设,而是通过与环境的交互来学习环境的动态特性。

2.SARSA:SARSA算法是另一种基于Q-Learning的增强学习算法,在Q-Learning的基础上引入了一个新的概念,即时奖励(immediate reward)。

SARSA算法的基本思想是,智能体选择一个动作后,观察环境的反馈(如奖励或惩罚)以及下一个状态,并根据下一个状态来选择下一步的动作。

通过不断地更新Q-表,智能体可以学习到一种有策略的行动方式。

3. Deep Q-Network (DQN):DQN是一种基于深度学习的增强学习算法,它结合了深度神经网络和Q-Learning算法的思想。

相比于传统的Q-Learning方法,DQN利用深度神经网络来近似并更新Q-值函数,能够处理更为复杂的状态和动作空间。

DQN通过将智能体当前状态作为输入,输出每种动作的Q-值,然后选择具有最高Q-值的动作来进行决策。

同时,DQN还引入了经验回放(experience replay)和固定目标网络(fixed target network)等技术,以提高训练的效率和稳定性。

4. Proximal Policy Optimization (PPO):PPO是一种新兴的策略优化算法,它旨在通过优化策略函数来提高智能体的性能。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

前言就目前来看,深度增强学习(Deep Reinforcement Learning)中的很多方法都是基于以前的增强学习算法,将其中的value function价值函数或者Policy function策略函数用深度神经网络替代而实现。

因此,本文尝试总结增强学习中的经典算法。

本文主要参考:1;21 预备知识对增强学习有所理解,知道MDP,Bellman方程详细可见:很多算法都是基于求解Bellman方程而形成:Value IterationPolicy IterationQ-LearningSARSA2 Policy Iteration 策略迭代Policy Iteration的目的是通过迭代计算value function 价值函数的方式来使policy收敛到最优。

Policy Iteration本质上就是直接使用Bellman方程而得到的:那么Policy Iteration一般分成两步:Policy Evaluation 策略评估。

目的是更新Value FunctionPolicy Improvement 策略改进。

使用greedy policy 产生新的样本用于第一步的策略评估。

本质上就是使用当前策略产生新的样本,然后使用新的样本更新当前的策略,然后不断反复。

理论可以证明最终策略将收敛到最优。

具体算法:那么这里要注意的是policy evaluation部分。

这里的迭代很重要的一点是需要知道state状态转移概率p。

也就是说依赖于model模型。

而且按照算法要反复迭代直到收敛为止。

所以一般需要做限制。

比如到某一个比率或者次数就停止迭代。

3 Value Iteration 价值迭代Value Iteration则是使用Bellman 最优方程得到然后改变成迭代形式value iteration的算法如下:那么问题来了:Policy Iteration和Value Iteration有什么本质区别?为什么一个叫policy iteration,一个叫value iteration呢?原因其实很好理解,policy iteration使用bellman方程来更新value,最后收敛的value 即vπ是当前policy下的value值(所以叫做对policy进行评估),目的是为了后面的policy improvement得到新的policy。

而value iteration是使用bellman 最优方程来更新value,最后收敛得到的value即v∗就是当前state状态下的最优的value值。

因此,只要最后收敛,那么最优的policy也就得到的。

因此这个方法是基于更新value 的,所以叫value iteration。

从上面的分析看,value iteration较之policy iteration更直接。

不过问题也都是一样,需要知道状态转移函数p才能计算。

本质上依赖于模型,而且理想条件下需要遍历所有的状态,这在稍微复杂一点的问题上就基本不可能了。

4 异步更新问题那么上面的算法的核心是更新每个状态的value值。

那么可以通过运行多个实例同时采集样本来实现异步更新。

而基于异步更新的思想,DeepMind出了一篇不错的paper:Asynchronous Methods for Deep Reinforcement Learning。

该文对于Atari游戏的效果得到大幅提升。

5 小结Reinforcement Learning有很多经典算法,很多算法都基于以上衍生。

鉴于篇幅问题,下一个blog再分析基于蒙特卡洛的算法。

1 前言在上一篇文章中,我们介绍了基于Bellman方程而得到的Policy Iteration和Value Iteration两种基本的算法,但是这两种算法实际上很难直接应用,原因在于依然是偏于理想化的两个算法,需要知道状态转移概率,也需要遍历所有的状态。

对于遍历状态这个事,我们当然可以不用做到完全遍历,而只需要尽可能的通过探索来遍及各种状态即可。

而对于状态转移概率,也就是依赖于模型Model,这是比较困难的事情。

什么是状态转移?就比如一颗子弹,如果我知道它的运动速度,运动的当前位置,空气阻力等等,我就可以用牛顿运动定律来描述它的运动,进而知道子弹下一个时刻会大概在哪个位置出现。

那么这个基于牛顿运动定律来描述其运动就是一个模型Model,我们也就可以知道其状态(空间位置,速度)的变化概率。

那么基本上所以的增强学习问题都需要有一定的模型的先验知识,至少根据先验知识我们可以来确定需要多少输入可以导致多少输出。

比如说玩Atari这个游戏,如果输入只有屏幕的一半,那么我们知道不管算法多么好,也无法训练出来。

因为输入被限制了,而且即使是人类也是做不到的。

但是以此同时,人类是无需精确的知道具体的模型应该是怎样的,人类可以完全根据观察来推算出相应的结果。

所以,对于增强学习的问题,或者说对于任意的决策与控制问题。

输入输出是由基本的模型或者说先验知识决定的,而具体的模型则可以不用考虑。

所以,为了更好的求解增强学习问题,我们更关注Model Free的做法。

简单的讲就是如果完全不知道状态转移概率(就像人类一样),我们该如何求得最优的策略呢?本文介绍蒙特卡洛方法。

2 蒙特卡洛方法蒙特卡洛方法只面向具有阶段episode的问题。

比如玩一局游戏,下一盘棋,是有步骤,会结束的。

而有些问题则不一定有结束,比如开赛车,可以无限的开下去,或者说需要特别特别久才能结束。

能不能结束是一个关键。

因为只要能结束,那么每一步的reward都是可以确定的,也就是可以因此来计算value。

比如说下棋,最后赢了就是赢了,输了就是输了。

而对于结束不了的问题,我们只能对于value进行估计。

那么蒙特卡洛方法只关心这种能够较快结束的问题。

蒙特卡洛的思想很简单,就是反复测试求平均。

如果大家知道在地上投球计算圆周率的事情就比较好理解了。

不清楚的童鞋可以网上找找看。

那么如何用在增强学习上呢?既然每一次的episode都可以到结束,那么意味着根据:每一步的reward都知道,也就意味着每一步的return Gt都可以计算出来。

这就好了。

我们反复做测试,这样很多状态会被遍历到,而且不止一次,那么每次就可以把在状态下的return求和取平均。

当episode无限大时,得到的数据也就接近于真实的数据。

蒙特卡洛方法就是使用统计学的方法来取代Bellman方法的计算方法。

上面的算法叫first-visit MC。

也就是每一次的episode中state只使用第一次到达的t来计算return。

另一种方法就是every-visit,就是每一次的episode中state只要访问到就计算return求平均。

所以可以看到蒙特卡洛方法是极其简单的。

但是缺点也是很明显的,需要尽可能多的反复测试,而且需要到每一次测试结束后才来计算,需要耗费大量时间。

但是,大家知道吗?AlphaGo就是使用蒙特卡洛的思想。

不是蒙特卡洛树搜索,而是说在增强学习中使用蒙特卡洛方法的思想。

AlphaGo每次也是到下棋结束,而且只使用最后的输赢作为return。

所以这也是非常神奇的事,只使用最后的输赢结果,竟然能够优化每一步的走法。

3 使用蒙特卡洛方法来控制上面说的蒙特卡洛方法只是能够对当前的policy进行评估。

那么大家记得上一个blog说的policy iteration 方法吗?我们可以在policy iteration中使用蒙特卡洛方法进行评估,然后使用greedy policy更新。

那么依然是有两种做法。

一种就是在一个policy下测试多次,评估完全,然后更新policy,然后再做很多测试。

另一种就是不完全评估,每次测试一次完就评估,评估完就更新:第一种做法:第二种做法:两种做法都能够收敛,那么显然第二种做法的速度更快。

那么再改进一点,就是改变greedy policy中ϵ的值,使得不断变小趋于0,这个时候最后得到的policy就是完全的最优policy了。

这个算法就叫做GLIE Monte-Carlo Control:其他变种:Monte Carlo with Exploring Starts,使用Q(s,a),然后使用上面说的第二种做法,一次episod就更新一次policy,而且policy直接使用Q值。

policy的更新使用了ϵ−greedy,目的就是能够更好的探索整个状态空间。

4 Off Policy Learning那么上面的方法一直是基于当前的policy,为了探索状态空间,采用一个次优的策略ϵ−greedy policy来探索。

那么是不是可以更直接的使用两个policy。

一个policy用来探索空间,也就是behavior policy,另一个policy就是为了达到最优policy,叫做target policy。

那么这种方法就叫做off policy learning。

On-policy的方法比较简单,off-policy 方法需要更多的概念和标记,比较不好理解,而且,由于behaviour policy和target policy不相关,这种方法比较不容易收敛。

但是off-policy更强大,更通用,实际上的on-policy方法就是off-policy方法的一个子集。

比如,就可以使用off-policy从人类专家或者传统的控制算法来学习一个增强学习模型。

关键是要找到两个policy之间的权重关系,从而更新Q值。

关于off-policy learning的部分,之后结合TD方法再做分析。

小结本次blog分析了一下蒙特卡洛方法。

这种基于统计学的方法算法简单,但是更多的只能用于虚拟环境能进行无限测试的情况。

并且state 状态比较有限,离散的最好。

基于这个方法,比如简单的五子棋(棋盘最好小一点),就可以用这个方法来玩玩了。

1 前言在上一篇blog中,我们分析了蒙特卡洛方法,这个方法的一个特点就是需要运行完整个episode从而获得准确的result。

但是往往很多场景下要运行完整个episode是很费时间的,因此,能不能还是沿着bellman方程的路子,估计一下result呢?并且,注意这里,依然model free。

那么什么方法可以做到呢?就是TD (temporal-difference时间差分)方法。

有个名词注意一下:boostraping。

所谓boostraping就是有没有通过估计的方法来引导计算。

那么蒙特卡洛不使用boostraping,而TD使用boostraping。

接下来具体分析一下TD方法2 TD与MC的不同MC使用准确的return来更新value,而TD则使用Bellman方程中对value的估计方法来估计value,然后将估计值作为value的目标值进行更新。