基于多变量提升度量在Apriori算法中的研究与应用

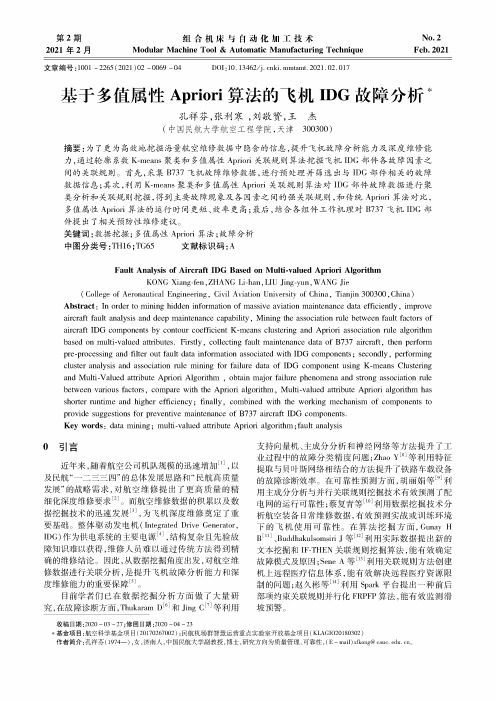

基于多值属性Apriori算法的飞机IDG故障分析

No.2Feb.2021第2期2021年2月组合机床与自动化加工技术ModularMachnneTool& AutomatncManufacturnng Technnque文章编号:1001 -2265(2021)02 -0069 -04DOI : 10.13462/j. cnki. mmtamt. 2021.02. 017基于多值属性Apriori 算法的飞机IDG 故障分析孔祥芬,张利寒,刘敬赞,王杰(中国民航大学航空工程学院,天津300300)摘要:为了更为高效地挖掘海量航空维修数据中隐含的信息,提升飞机故障分析能力及深度维修能 力,通过轮廓系数K-means 聚类和多值属性Ap/o/关联规则算法挖掘飞机IDG 部件各故障因素之 间的关联规则。

首先,采集B737飞机故障维修数据,进行预处理并筛选出与IDG 部件相关的故障 数据信息;其次,利用K-msns 聚类和多值属性Ap/o/关联规则算法对IDG 部件故障数据进行聚 类分析和关联规则挖掘,得到主要故障现象及各因素之间的强关联规则,和传统Ap/l 算法对比, 多值属性Ap/o/算法的运行时间更短、效率更高;最后,结合各组件工作机理对B737飞机IDG 部 件提出了相关预防性维修建议。

关键词:数据挖掘;多值属性Ap/o/算法;故障分析中图分类号:TH16;TG65 文献标识码:AFault Analysis of Aircraft IDG Based on Multi-valued Apriori AlgorittmKONG Xiang-fen ,ZHANG Li-han ,LIE Jing-Cun ,WANG Jic(CoXege of Aeronauhcol Engineering & Civil Aviation University of China & Tianjin 300300 & China)Abstracc : In order to mining hidden information of massive aviation maintenance data efficiently , improve aircrafhfaulhanalysisand deep mainhenancecapabilihy , Mining hhea s ociahion rulebehween faulhfachorsofaircraft IDG component by contour coefficient K-means clusteang and Apriori association rule algoathm based on multi-valued atWieuWs. Firstly & collecting fault maintenance data of B737 aircraft & then perform pre-processing and filter out fault data information asociated with IDG components ; secondly , performing clusteranalysisand a s ociation rulemining forfailuredataofIDG componentusing K-meansClustering and Multi-Valued a t ributeAprioriAlgorithm , obtain maeorfailurephenomenaand strong a s ociation rulebetween variousfactors , comparewith theApriorialgorithm , Multi-valued a t ributeApriorialgorithm has shorterruntimeand highere f iciency ; fina l y , combined with theworking mechanism ofcomponentstoprovidesuggestionsforpreventivemaintenanceofB 737 aircraftIDG components. Key wordt : datamining ; multi-valued a t ributeApriorialgorithm ; faultanalysis0引言近年来,随着航空公司机队规模的迅速增加[1],以 及民航“一二三三四”的总体发展思路和“民航高质量 发展”的战略需求,对航空维修提出了更高质量的精 细化深度维修要求⑵。

apriori算法实验报告

apriori算法实验报告Apriori 算法实验报告一、实验背景随着信息技术的快速发展,数据量呈现爆炸式增长。

如何从海量数据中挖掘出有价值的信息成为了一个重要的研究课题。

关联规则挖掘作为数据挖掘中的一个重要分支,能够发现数据中项集之间的关联关系。

Apriori 算法是关联规则挖掘中最经典、最具影响力的算法之一,它在商业、医疗、金融等领域有着广泛的应用。

二、实验目的本次实验的主要目的是深入理解和掌握 Apriori 算法的原理和实现过程,并通过实际数据进行实验,验证算法的有效性和性能,同时分析算法的优缺点,为实际应用提供参考。

三、实验原理Apriori 算法基于频繁项集的先验知识,通过逐层搜索的方式找出数据集中的频繁项集,进而生成关联规则。

其核心思想包括两个方面:一是如果一个项集是频繁的,那么它的所有子集也一定是频繁的;二是如果一个项集是非频繁的,那么它的所有超集也一定是非频繁的。

算法的实现过程主要包括以下步骤:1、首先,扫描数据集,统计每个项的出现次数,得到候选 1 项集的支持度。

根据设定的最小支持度阈值,筛选出频繁 1 项集。

2、然后,基于频繁 1 项集,通过自连接生成候选 2 项集,再次扫描数据集计算候选 2 项集的支持度,筛选出频繁 2 项集。

3、依此类推,不断通过自连接和剪枝操作生成更高阶的候选项集,并计算其支持度,筛选出频繁项集,直到没有新的频繁项集产生为止。

四、实验环境本次实验使用的编程语言为 Python,主要使用了`pandas`和`mlxtend`库来进行数据处理和算法实现。

开发环境:Jupyter Notebook操作系统:Windows 10五、实验数据实验数据采用了一个超市购物数据集,其中包含了顾客的购物记录,每条记录表示一位顾客购买的商品列表。

六、实验步骤1、数据预处理读取数据文件,将数据转换为适合算法处理的格式。

对数据进行清洗和整理,去除噪声和异常值。

2、算法实现定义计算支持度和置信度的函数。

Apriori算法总结

Apriori ['eɪprɪ'ɔ:rɪ]Apriori算法是一种挖掘关联规则的频繁项集算法,其核心思想是通过候选集生成和情节的向下封闭检测两个阶段来挖掘频繁项集。

而且算法已经被广泛的应用到商业、网络安全等各个领域。

其核心是基于两阶段频集思想的递推算法。

该关联规则在分类上属于单维、单层、布尔关联规则。

在这里,所有支持度大于最小支持度的项集称为频繁项集,简称频集。

经典的关联规则数据挖掘算法Apriori 算法广泛应用于各种领域,通过对数据的关联性进行了分析和挖掘,挖掘出的这些信息在决策制定过程中具有重要的参考价值。

Apriori算法广泛应用于商业中,应用于消费市场价格分析中,它能够很快的求出各种产品之间的价格关系和它们之间的影响。

通过数据挖掘,市场商人可以瞄准目标客户,采用个人股票行市、最新信息、特殊的市场推广活动或其他一些特殊的信息手段,从而极大地减少广告预算和增加收入。

百货商场、超市和一些老字型大小的零售店也在进行数据挖掘,以便猜测这些年来顾客的消费习惯。

Apriori算法应用于网络安全领域,比如网络入侵检测技术中。

早期中大型的电脑系统中都收集审计信息来建立跟踪档,这些审计跟踪的目的多是为了性能测试或计费,因此对攻击检测提供的有用信息比较少。

它通过模式的学习和训练可以发现网络用户的异常行为模式。

采用作用度的Apriori算法削弱了Apriori算法的挖掘结果规则,是网络入侵检测系统可以快速的发现用户的行为模式,能够快速的锁定攻击者,提高了基于关联规则的入侵检测系统的检测性。

Apriori算法应用于高校管理中。

随着高校贫困生人数的不断增加,学校管理部门资助工作难度也越加增大。

针对这一现象,提出一种基于数据挖掘算法的解决方法。

将关联规则的Apriori算法应用到贫困助学体系中,并且针对经典Apriori挖掘算法存在的不足进行改进,先将事务数据库映射为一个布尔矩阵,用一种逐层递增的思想来动态的分配内存进行存储,再利用向量求"与"运算,寻找频繁项集。

apriori算法做题实例

apriori算法做题实例Apriori算法是一种用于发现数据集中频繁出现项集的方法。

它基于一种称为“Apriori原则”的假设,该原则认为如果一个项集是频繁的,那么它的所有子集也必须是频繁的。

这种原则允许我们使用底层的子集来快速确定更高层次的频繁项集。

下面以一个简单的实例来说明Apriori算法的应用。

假设我们有一个包含多个交易记录的超市数据集,每条记录包括不同种类的商品。

我们想要找出哪些商品最常一起被购买。

首先,我们需要确定最小支持度阈值,即在数据集中频繁出现项集的最小数量。

我们可以尝试几个不同的阈值,最终选择产生最有用结果的那个。

假设我们选择最小支持度为2,也就是说,项集需要在至少两个交易记录中出现才能被认为是频繁的。

接下来,我们执行第一次扫描数据集,统计每种商品在多少个交易记录中出现。

对于那些出现次数大于等于最小支持度的商品,我们将其作为长度为1的频繁项集。

假设有以下频繁项集:{牛奶}、{面包}、{啤酒}、{尿布}。

接着,我们执行第二次扫描数据集。

针对每个长度为2的项集,我们统计它出现在多少个交易记录中。

对于那些出现次数大于等于最小支持度的项集,我们将其作为长度为2的频繁项集。

假设有以下频繁项集:{牛奶,啤酒}、{牛奶,面包}、{面包,啤酒}、{面包,尿布}、{啤酒,尿布}。

接下来,我们可以继续执行这个过程,找到更长的频繁项集。

最终,我们可得到所有频繁项集,以及它们在多少个交易记录中出现。

最后,我们可以使用这些频繁项集来推断出哪些商品最常一起被购买。

例如,由于{牛奶,啤酒}是一个频繁项集,我们可以推断出有很多人会在一次购物中同时购买牛奶和啤酒。

总之,Apriori算法是一种有效的方法,用于在大型数据集中发现频繁项集。

该算法可以帮助我们理解哪些元素经常一起出现,并且可以用于许多领域,如市场营销、推荐系统等。

aprioriall算法

aprioriall算法Apriori算法是一种常见的关联规则挖掘算法,它可以用于发现数据集中的频繁项集。

该算法的核心思想是利用频繁项集的性质,通过迭代的方式不断削减候选项集的规模,从而提高算法的效率。

Apriori算法的基本流程如下:1. 扫描数据集,统计每个项的出现次数,得到频繁1项集。

2. 根据频繁1项集,生成候选2项集。

3. 扫描数据集,统计候选2项集的出现次数,得到频繁2项集。

4. 根据频繁2项集,生成候选3项集。

5. 重复上述过程,直到无法生成新的频繁项集为止。

Apriori算法的优点是简单易懂,容易实现。

但是,它也存在一些缺点。

首先,由于需要频繁地扫描数据集,算法的效率较低。

其次,当数据集中的项数较多时,候选项集的规模会急剧增大,导致算法的效率进一步降低。

因此,在实际应用中,需要对Apriori算法进行优化。

一种常见的优化方法是使用Apriori-All算法。

该算法的基本思想是,利用频繁项集的性质,将所有频繁项集存储在一个列表中,然后通过列表的交集和并集操作来生成新的频繁项集。

具体来说,Apriori-All 算法的流程如下:1. 扫描数据集,统计每个项的出现次数,得到频繁1项集。

2. 将频繁1项集存储在一个列表L中。

3. 对于k>1,重复以下步骤:a. 通过列表L中的项集生成候选k项集。

b. 扫描数据集,统计候选k项集的出现次数,得到频繁k项集。

c. 将频繁k项集存储在列表L中。

d. 通过列表L中的项集生成候选k+1项集。

e. 将候选k+1项集与列表L中的项集取交集,得到新的频繁k+1项集。

f. 将新的频繁k+1项集存储在列表L中。

4. 重复上述过程,直到无法生成新的频繁项集为止。

Apriori-All算法的优点是可以避免频繁扫描数据集,从而提高算法的效率。

此外,由于所有频繁项集都存储在一个列表中,因此可以方便地进行交集和并集操作,从而生成新的频繁项集。

但是,该算法的缺点是需要占用大量的内存空间来存储频繁项集列表,因此在处理大规模数据集时可能会出现内存不足的问题。

关联规则(Apriori算法)

关联规则(Apriori算法)关联分析直观理解 关联分析中最有名的例⼦是“尿布与啤酒”。

据报道,美国中西部的⼀家连锁店发现,男⼈们会在周四购买尿布和啤酒。

这样商店实际上可以将尿布与啤酒放在⼀块,并确保在周四全价销售从⽽获利。

当然,这家商店并没有这么做。

频繁项集是指那些经常出现在⼀起的物品集合,⽐如{葡萄酒,尿布, ⾖奶}就是频繁项集的⼀个例⼦⽀持度(support) ⼀个项集的⽀持度(support)被定义为数据集中包含该项集的记录所占的⽐例 {⾖奶}的⽀持度为4/5。

{⾖奶,尿布}的⽀持度为3/5可信度(confidence ) 可信度或置信度(confidence)是针对⼀条诸如{尿布} ➞ {葡萄酒}的关联规则来定义的。

这条规则的可信度被定义为“⽀持度({尿布, 葡萄酒})/⽀持度({尿布})”。

由于{尿布, 葡萄酒}的⽀持度为3/5,尿布的⽀持度为4/5,所以“尿布➞葡萄酒”的可信度为3/4=0.75。

这意味着对于包含“尿布”的所有记录,我们的规则对其中75%的记录都适⽤。

Apriori算法的⽬标是找到最⼤的K项频繁集⽀持度和可信度是⽤来量化关联分析是否成功的⽅法。

假设想找到⽀持度⼤于0.8的所有项集,应该如何去做?⼀个办法是⽣成⼀个物品所有可能组合的清单,然后对每⼀种组合统计它出现的频繁程度,但当物品成千上万时,⾮常慢,这时就能⽤Apriori算法关联分析中最有名的例⼦是“尿布与啤酒”。

据报道,美国中西部的⼀家连锁店发现,男⼈们会在周四购买尿布和啤酒。

这样商店实际上可以将尿布与啤酒放在⼀块,并确保在周四全价销售从⽽获利。

当然,这家商店并没有这么做。

⼀般我们使⽤三个指标来度量⼀个关联规则,这三个指标分别是:⽀持度、置信度和提升度。

Support(⽀持度):表⽰同时包含A和B的事务占所有事务的⽐例。

如果⽤P(A)表⽰使⽤A事务的⽐例,那么Support=P(A&B)Confidence(可信度):表⽰使⽤包含A的事务中同时包含B事务的⽐例,即同时包含A和B的事务占包含A事务的⽐例。

Apriori改进算法讲解和实现

链接和修剪

• 其中, apriori- gen 是以频繁(k- 1)- 项目序列集Lk- 1 为自变量的候 选集生成函数。该函数返回包含所有频繁k- 项目集的超集, 分 链接和修剪两步执行: 第1 步:链接(join) • Procedure apriori_gen(Lk- 1:frequent(k- 1)- itemsets; minsup) • 1) for each itemset l1∈Lk- 1 • 2) for each itemset l2∈Lk- 1 L • 3) if ((l1[1]=l2[1])(l1[2]=l2[2])∧…∧(l1[k- 2]=l2[k- 2])∧(l1[k- 1]≠l2[k- 1])then { • 4) c=l1∪l2;//连接, 产生候选集 • 5) if has_infrequent_subset(c,Lk- 1) then • 6) delete c;//修剪, 去掉无用的候选项 • 7) else add c to Ck; • 8) } • 9) return Ck;

定义和性质

• 根据上述定义,可以这样描述Apriori 算法:Apriori 算法使用逐 层搜索的迭代方法来产生频繁项集,设有频繁k-项集L k,通过 Galois连接产生候选k + 1 项集Ck+1,再通过扫描数据集产生频繁 k + 1 项集L k+1,最后由产生的频繁项目集产生关联规则。 • 性质1 :(Apriori 性质)频繁项目集的所有非空子集都必须也是频 繁的。 • 证明(用反证法) :略。 • 推论1 :一个非频繁项目集的任一超集必定也是非频繁的。 • 证明:根据定义若有k-1 项集Ik -1 ,不满足最小支持度阈值minsup ,即P( Ik-1) < min-sup ,则称Ik-1 为非频繁的。若将任意一项 (集) A 添加到Ik - 1 中,则必有P( Ik - 1∪ A) < P( Ik - 1) < min- sup,即Ik - 1 的任一超集( Ik - 1 ∪A) 是非频繁的。得证。

数据挖掘_国防科技大学中国大学mooc课后章节答案期末考试题库2023年

数据挖掘_国防科技大学中国大学mooc课后章节答案期末考试题库2023年1.某超市研究销售纪录数据后发现,买啤酒的人很大概率也会购买尿布,这种属于数据挖掘的哪类问题?()答案:关联规则发现2.下列有关SVM说法不正确的是()答案:SVM因为使用了核函数,因此它没有过拟合的风险3.影响聚类算法效果的主要原因有:()答案:特征选取_聚类准则_模式相似性测度4.7、朴素贝叶斯分类器不存在数据平滑问题。

( )答案:错误5.决策树中包含一下哪些结点答案:内部结点(internal node)_叶结点(leaf node)_根结点(root node) 6.标称类型数据的可以利用的数学计算为:众数7.一般,k-NN最近邻方法在( )的情况下效果较好答案:样本较少但典型性好8.考虑两队之间的足球比赛:队0和队1。

假设65%的比赛队0胜出、P(Y=0)=0.65。

剩余的比赛队1胜出、P(Y=1)=0.35。

队0获胜的比赛中只有30%在队1的主场、P(X=1|Y=0)=0.3,而队1获胜的比赛中75%是主场获胜、P(X=1|Y=1)=0.75。

则队1在主场获胜的概率即P(Y=1|X=1)为:()答案:0.579.一组数据的最小值为12,000,最大值为98,000,利用最小最大规范化将数据规范到[0,1],则73,000规范化的值为:()答案:0.71610.以下哪个分类方法可以较好地避免样本的不平衡问题:()答案:KNN11.简单地将数据对象集划分成不重叠的子集,使得每个数据对象恰在一个子集中,下列哪些不属于这种聚类类型层次聚类_模糊聚类_非互斥聚类12.数据点密度分布不均会影响K-means聚类的效果。

答案:正确13.数据集成需要解决模式集成、实体识别、数据冲突检测等问题答案:正确14.决策树模型中应处理连续型属性数据的方法之一为:根据信息增益选择阈值进行离散化。

答案:正确15.数据库中某属性缺失值比较多时,数据清理可以采用忽略元组的方法。

大数据经典算法Apriori讲解

精品PPT

Apriori伪代码(dài mǎ)

算法:Apriori。使用逐层迭代方法基于候选产生找出频繁项集。 输入: D:实物数据库; Min_sup:最小支持度计数阈值。 输出:L:D中的频繁项集。 方法: L1=find_frequent_1-itemsets(D); for(k=2;Lk-1 !=¢;k++){ Ck=apriori_gen(Lk-1); For each 事务(shìwù) t∈D{//扫描D用于计数 Ct=subset(Ck,t);//得到t的子集,它们是候选 for each候选c∈C; C.count++; } Lk={c∈C|c.count>=min_stp} } return L=UkLk;

模式 通过牺牲精确度来减少算法开销,为了提高效率,样本大小应该以可以放在

内存中为宜,可以适当降低最小支持度来减少遗漏的频繁模式 可以通过一次全局扫描来验证从样本中发现的模式 可以通过第二此全局扫描来找到遗漏的模式 方法5:动态项集计数 在扫描的不同点添加候选项集,这样,如果一个候选项集已经满足最少支持

精品PPT

Procedure apriori_gen(Lk-1:frequent(k-1)-itemsets) for each项集l1∈Lk-1 for each项集l2∈Lk-1 If (l1[1]=l2[1]) ^ (l1[2]=l2[2]) ^… (l1[k-2]=l2[k-2]) ^ (l1[k-1]=l2[k-1]) then{ c=l1∞l2//连接步:产生候选(hòu xuǎn) if has_infrequent_subset(c,Lk-1)then delete c;//剪枝部;删除非频繁的候选(hòu xuǎn) else add c to Ck; } return Ck; procedure has_infrequent_subset (c:candidate k-itemset; Lk-1:frequent (k-1)-itemset)//使用先验知识 for each(k-1)-subset s of c If s∉ Lk-1then return TRUE; return FALSE;

Apriori算法

解决思路

减少对数据的扫描次数 缩小产生的候选项集 改进对候选项集的支持度计算方法

三、提高Apriori算法的有效性

方法1:基于hash表的项集计数

将每个项集通过相应的hash函数映射到hash表中的不同的桶中,这样可以通过将桶中的项 集计数跟最小支持计数相比较先淘汰一部分项集

3

{C}

3

{D}

1

{E}

3

Itemset

sup

{A, B}

1

{A, C}

2

{A, E}

1

{B, C}

2

{B, E}

3

{C, E}

2

Itemset

sup

L1

{A}

2

{B}

3

{C}

3

{E}

3

C2 2nd scan

Itemset {A, B} {A, C} {A, E} {B, C} {B, E}

C3 Itemset

Tid

Items

10

A, C, D

20

B, C, E

30

A, B, C, E

40

B, E

Itemset

sup

{B, C, E}

2

分别计算置信度,将满足最小置信度的关联规则保留下来 例:对于 confidence(B C,E)=2/3=0.67

三、提高Apriori算法的有效性

Apriori算法主要的挑战

Apriori算法——示例

最小支持计数:2

Database TDB

Tid

Items

10

A, C, D

stata apriori算法

一、介绍Stata是一种用于数据分析和统计建模的软件工具,而Apriori算法则是用于关联规则挖掘的一种经典算法。

本文将对Stata中Apriori算法的应用进行介绍,包括算法原理、使用方法和实际案例分析。

二、Apriori算法原理Apriori算法是一种基于频繁项集的挖掘方法,通过寻找频繁项集来发现数据中的关联规则。

其基本原理为先找出频繁项集,再由频繁项集生成关联规则。

算法主要包括三个步骤:1. 扫描数据集,找出频繁1项集;2. 基于频繁1项集,生成候选2项集,并通过扫描数据集找出频繁2项集;3. 重复以上步骤,直到找出所有频繁项集。

三、Stata中的Apriori算法使用方法Stata提供了丰富的数据挖掘和统计分析功能,包括对Apriori算法的支持。

用户可以使用Stata中的命令行或GUI界面进行Apriori算法的应用。

1. 命令行操作在Stata中,用户可以通过命令行输入对应的命令来进行Apriori算法的使用。

使用apriori命令可以指定数据集和参数进行关联规则挖掘,用户可以根据实际情况灵活调整参数以达到更好的挖掘效果。

2. GUI界面操作Stata还提供了直观友好的图形界面,用户可以通过简单的操作来完成Apriori算法的应用。

在Stata的GUI界面中,用户可以直接导入数据集、设置参数、启动算法等,整个操作流程更加直观和便捷。

四、实际案例分析以下通过一个实际的案例来展示Stata中Apriori算法的应用。

假设我们有一个超市的交易数据集,包括每个顾客购物的商品清单。

我们希望利用Apriori算法挖掘出顾客之间的购物关联规则,以便超市做出更精准的商品搭配和促销活动。

1. 数据预处理我们需要将原始交易数据导入Stata,并进行预处理。

预处理包括数据清洗、格式转换等操作,以确保数据的准确性和完整性。

2. Apriori算法应用在数据预处理完成后,我们可以使用Stata中的Apriori算法来进行关联规则挖掘。

Apriori算法实验报告

Apriori算法实验报告一、引言在数据挖掘领域,频繁项集挖掘是一项重要任务。

频繁项集指的是在一组交易记录中经常一起出现的物品集合。

Apriori算法是一种常用的频繁项集挖掘算法,其基本思想是通过迭代的方式逐渐生成和验证候选集合,从而找到频繁项集。

二、实验设计本实验旨在通过实际运用Apriori算法来挖掘某个购物网站的交易数据,从中发现频繁项集和关联规则。

实验数据集包含了一定数量的交易记录,每条记录包含了购买的商品列表。

我们将使用Python语言实现Apriori算法,并采用适当的数据结构和算法优化来提高运行效率。

三、数据预处理在进行频繁项集挖掘之前,我们首先需要对原始数据进行处理。

具体而言,需要将购买的商品列表进行编码,将商品名称映射为整数。

此外,还需要去除交易记录中的重复项,以减少数据的冗余性。

经过数据预处理后,我们得到了处理后的数据集。

四、Apriori算法实现首先,我们需要初始化候选集合。

将每个商品作为项集的初始候选项,并遍历整个数据集得到每个初始候选项的支持度。

根据设定的最小支持度阈值,过滤掉低频项,得到频繁1项集。

接下来,我们使用频繁1项集生成候选2项集。

具体而言,我们对于每个频繁1项集,两两组合,得到候选2项集,并计算其支持度。

同样根据最小支持度阈值,过滤掉低频项,得到频繁2项集。

然后,我们采用逐层迭代的方式生成更高阶的候选项集。

具体而言,我们使用频繁k-1项集生成候选k项集,然后计算其支持度,并过滤掉低频项,得到频繁k项集。

重复迭代,直到无法生成更高阶的候选项集为止。

最后,我们根据频繁项集生成关联规则。

具体而言,对于每个频繁项集,我们生成其所有非空子集,并计算其置信度。

根据设定的最小置信度阈值,过滤掉低置信度的关联规则,得到满足要求的关联规则。

五、实验结果分析经过实验运行,我们得到了购物网站交易数据的频繁项集和关联规则。

我们对实验结果进行分析如下:1. 频繁项集通过观察频繁项集,我们可以发现一些有趣的规律。

apriori算法原理及过程

apriori算法原理及过程一、前言Apriori算法是数据挖掘中常用的频繁项集挖掘算法之一。

它可以发现数据集中的频繁项集,即经常出现在一起的物品或事件。

本文将详细介绍Apriori算法的原理及过程。

二、Apriori算法原理1.支持度和置信度在介绍Apriori算法之前,先了解两个概念:支持度和置信度。

支持度指的是某个项集在所有事务中出现的概率,即该项集的出现次数与总事务数之比。

置信度指的是如果一个事务包含某个项集A,那么它也包含另一个项集B的概率,即包含A和B的事务数与包含A的事务数之比。

2.频繁项集频繁项集指出现次数大于等于最小支持度阈值(min_support)的项集。

例如,如果min_support=0.5,则出现次数占总事务数50%以上的项集为频繁项集。

3.Apriori原理Apriori原理指:如果一个项集是频繁项集,则它的所有子集也一定是频繁项集。

例如,{A,B,C}是频繁项集,则{A,B}、{A,C}、{B,C}都是频繁项集。

基于Apriori原理,可以通过逐层扫描数据集,从而发现所有的频繁项集。

具体过程如下。

三、Apriori算法过程1.生成候选1项集首先扫描数据集,统计每个物品出现的次数,并根据最小支持度阈值生成所有的候选1项集。

2.生成候选k项集根据上一步得到的频繁1项集,构建候选2项集。

具体方法是将两个不同的频繁1项集合并成一个新的2项集。

然后扫描数据集,统计每个2项集出现的次数,并根据最小支持度阈值筛选出频繁2项集。

接着,利用频繁2项集生成候选3项集。

方法与上述类似:将两个不同的频繁2项集合并成一个新的3项集,并根据最小支持度阈值筛选出频繁3项集。

依此类推,直到无法继续生成新的k+1项候选组合为止。

3.剪枝在每一轮生成候选k+1组合之后,需要进行剪枝操作。

即对于每个k+1组合,判断它是否存在非频繁子组合。

如果存在,则该k+1组合也一定不是频繁项集,需要将其删除。

4.重复步骤2和3,直到无法生成新的候选项集重复执行步骤2和3,直到无法继续生成新的k+1项候选组合为止。

Apriori算法的改进及实例

Apriori算法的改进及实例Apriori算法是数据挖掘中常用的关联规则挖掘算法之一,它能够发现数据集中频繁出现的项集及其关联规则。

原始的Apriori算法在处理大规模数据时存在效率低下的问题,因此研究人员提出了许多改进和优化的方法,以提高算法的性能和效率。

本文将介绍Apriori算法的改进方法,并通过实例进行演示。

一、Apriori算法的基本原理Apriori算法是一种基于频繁项集的挖掘方法,它能够从数据集中找出频繁项集及其关联规则。

算法的基本原理是利用Apriori原理,即如果一个项集是频繁的,那么它的所有子集也一定是频繁的。

根据这一原理,算法通过迭代的方式逐步生成频繁项集,然后根据支持度和置信度等指标来发现关联规则。

具体的算法流程如下:1. 首先扫描事务数据库,统计每个项的支持度,并找出频繁1-项集;2. 然后利用频繁1-项集生成候选2-项集,并通过扫描事务数据库统计每个候选2-项集的支持度,筛选出频繁2-项集;3. 依次类推,直到没有新的频繁k-项集生成为止,最后根据频繁项集生成关联规则,并计算它们的置信度。

1. 基于查找表的改进原始的Apriori算法需要多次扫描数据集,统计项集的支持度。

为了避免重复扫描数据集,可以使用查找表来存储项集的支持度信息。

通过构建一个查找表,可以在一次扫描事务数据库后,快速获取项集的支持度,从而提高算法的效率。

2. 剪枝技术的优化Apriori算法在生成候选项集和频繁项集时,采用了自连接和剪枝的技术。

原始的剪枝方法可能会产生大量的候选项集,导致计算复杂度高。

研究人员提出了一些剪枝技术的优化方法,如动态剪枝、预处理剪枝等,以减少候选项集的数量,提高算法的效率。

3. 多层次的数据表示对于大规模数据集,可以采用多层次的数据表示方法,将数据集划分成多个层次,每个层次都是一个粒度较小的子集。

这样可以减少数据集的规模,提高算法的处理效率。

4. 并行化处理随着计算机硬件的发展,可以采用并行化处理的方式来加速Apriori算法的执行。

《Apriori算法》课件

使用垂直数据格式加速关联规则的生成

垂直数据格式是一种数据表示方式,它 将数据按照列的形式进行组织。在关联 规则挖掘中,使用垂直数据格式可以提 高算法的效率。

在Apriori算法中,可以使用垂直数据格式来 加速关联规则的生成。通过将数据按照属性 进行划分,可以减少对数据库的扫描次数, 提高算法的效率。

推荐系统

பைடு நூலகம்

利用Apriori算法为用户提供个性化 的推荐服务,提高用户满意度和忠诚 度。

VS

在电子商务、在线音乐、视频等平台 上,用户经常需要推荐服务。Apriori 算法能够通过分析用户的消费记录和 行为数据,发现用户的兴趣和偏好, 从而为用户推荐相关联的商品、音乐 、视频等。这有助于提高用户满意度 和忠诚度,促进平台的可持续发展。

Apriori算法的应用场景

1 2

推荐系统

根据用户历史行为,推荐可能感兴趣的商品或服 务

市场篮子分析

分析商品之间的关联关系,帮助商家制定营销策 略

3

异常检测

识别数据中的异常模式,用于欺诈检测、故障预 测等场景

Apriori算法与其他关联规则学习算法的区别

01

与ECLAT算法相比,Apriori算 法采用候选集生成和剪枝策略 ,更加高效

在生成频繁项集时,可以利用哈希树快速查找和过滤掉不可能成为频繁项集的候选集,减少计算量。

使用事务压缩优化内存使用

事务压缩是一种技术,通过将多个事务合并为一个事务,减少内存的使用 。

在Apriori算法中,可以使用事务压缩来优化内存使用。通过合并相似的事 务,可以减少需要存储的事务数量,从而降低内存占用。

基于Apriori算法的课程内容关联分析及教学策略改进

基于Apriori算法的课程内容关联分析及教学策略改进一、引言1. Apriori算法概述Apriori算法是一种用于发现数据集内频繁模式的算法,它是由R. Agrawal和R. Srikant在1994年提出的。

该算法的核心思想是利用频繁项集的性质来减少搜索空间,从而降低算法的时间复杂度。

在具体的实现过程中,Apriori算法采用逐层搜索的方式,通过生成候选项集、计算支持度、筛选频繁项集等步骤,最终找到频繁模式并生成关联规则。

2. 课程内容关联分析在教学过程中,课程内容之间存在着各种关联关系,了解这些关联关系对于教师设计教学内容、调整教学策略具有重要意义。

通过基于Apriori算法的课程内容关联分析,可以发现课程内容之间的关联规则,帮助教师找到一些有意义的教学模式和方法。

以一个简单的例子来说明,在教学中如果我们发现学生学习了某门课程A,那么他们学习另外一门课程B的概率很高,那么这两门课程之间就存在着较强的关联关系。

通过分析这样的关联规则,可以为教师提供一些指导,比如合理安排教学进度,设计跨学科的教学活动等。

3. 教学策略改进通过分析发现学生在学习某一门课程时,经常需要用到另外一门课程的知识点,那么教师可以考虑将这两门课程的教学内容加强关联,设计一些跨学科的教学活动,以便更好地帮助学生理解和应用知识。

教师还可以根据课程内容关联关系,调整学习资源的分配和使用,合理安排教学进度和测试安排,以提高教学效果和学生学习动力。

三、教学策略改进实践案例在具体的教学实践中,我们可以通过基于Apriori算法的课程内容关联分析,结合课程特点,加以具体操作,来调整教学策略并提升教学效果。

随着信息技术的飞速发展,越来越多的课程开始向线上转移。

我们以一门大学计算机专业的课程为例来进行说明。

1. 数据收集与预处理我们需要收集学生的学习数据,比如学习时间、学习资源点击量、参与讨论区活跃度等。

然后对这些数据进行预处理,去除一些异常值和噪声数据,以保证数据的准确性和可靠性。

机器学习_温州大学中国大学mooc课后章节答案期末考试题库2023年

机器学习_温州大学中国大学mooc课后章节答案期末考试题库2023年1.GBDT由哪三个概念组成:( )参考答案:Regression Decision Tree(即 DT)_Gradient Boosting(即GB)_Shrinkage(缩减)2.对于非概率模型而言,可按照判别函数线性与否分成线性模型与非线性模型。

下面哪些模型属于线性模型?参考答案:K-means_k近邻_感知机3.逻辑回归分类的精度不够高,因此在业界很少用到这个算法参考答案:错误4.SMOTE算法是用了上采样的方法。

参考答案:正确5.支持向量是那些最接近决策平面的数据点参考答案:正确6.100万条数据划分训练集、验证集、测试集,数据可以这样划分:98%,1%,1% 。

参考答案:正确7.K均值是一种产生划分聚类的基于密度的聚类算法,簇的个数由算法自动地确定。

参考答案:错误8.朴素贝叶斯法的基本假设是条件独立性。

参考答案:正确9.PCA投影方向可从最大化方差和最小化投影误差这两个角度理解。

参考答案:正确10.相关变量的相关系数可以为零,对吗?参考答案:正确11.Sigmoid函数的范围是(-1,1)参考答案:错误12.影响KNN算法效果的主要因素包括( )。

参考答案:决策规则_K的值_距离度量方式13.逻辑回归的特征一定是离散的。

参考答案:错误14.闵可夫斯基距离中的p取1或2时的闵氏距离是最为常用的,以下哪项是正确的:( )。

参考答案:闵可夫斯基空间不同于牛顿力学的平坦空间_p取1时是曼哈顿距离_p取2时是欧氏距离_p取无穷时是切比雪夫距离15.KNN算法的缺点包括以下几点?( )参考答案:计算复杂性高;空间复杂性高,尤其是特征数非常多的时候_可解释性差,无法给出决策树那样的规则_对训练数据依赖度特别大,当样本不平衡的时候,对少数类的预测准确率低16.两个向量的余弦相似度越接近1,说明两者越相似。

参考答案:正确17.k近邻法(k-Nearest Neighbor,kNN)是一种比较成熟也是最简单的机器学习算法,可以用于分类,但不能用于回归方法。

人工智能单选练习题库+答案

人工智能单选练习题库+答案一、单选题(共100题,每题1分,共100分)1、抛掷一枚质地均匀的硬币,若抛掷95次都是正面朝上,则抛掷第100次正面朝上的概率是()A、大于 1/2B、小于1/2C、无法确定D、等于 1/2正确答案:D2、对于k折交叉验证,以下对k的说法正确的是?A、在选择k时,要最小化数据集之间的方差B、以上所有C、选择更大的k,就会有更小的bias(因为训练集更加接近总数据集)D、k越大,不一定越好,选择大的k会加大评估时间正确答案:B3、关于语音识别服务中的一句话识别指的是,用于短语音的同步识别。

一次性上传整个音频,响应中即返回识别结果。

A、TRUEB、FALSE正确答案:A4、哪项技术在BERT中没有使用()A、NormalizationB、全连接C、卷积D、自注意力正确答案:C5、在安装Linux操作系统时,必须创建的两个分区?A、/home和/usrB、/和/swapC、/var和/trapD、/和/boot正确答案:B6、人工智能产业三大要素是技术产品、改造提升行业融合和()。

A、深度学习B、算法运算C、集成应用D、云计算正确答案:C7、机器学习是()研究发展到一定阶段的必然产物。

A、计算机工程B、人工智能C、神经网络D、深度学习正确答案:B8、某二叉树的前序序列为ABDECFG,中序序列为DBEAFCG,则后序序列为A、DBEFCGAB、DEBFGCAC、DEFGBCAD、BDECFGA正确答案:B9、在统计语言模型中,通常以概率的形式描述任意语句的可能性,利用最大相似度估计进行度量,对于一些低频词,无论如何扩大训练数据,出现的频度仍然很低,下列哪种方法可以解决这一问题A、一元文法B、数据平滑C、N元文法D、一元切分正确答案:B10、linux操作系统中,文件权限-rwxr-xr-x,对文件拥有者而言,具有()权限。

A、可读,可写入,可执行B、可读,可执行C、可写入D、可读正确答案:A11、为数据的总体分布建模;把多维空间划分成组等问题属于数据挖掘的哪一类任务?()A、预测建模B、寻找模式和规则C、探索性数据分析D、建模描述正确答案:D12、python包安装命令正确的是A、python install xxxB、ipython install xxxC、pip install xxxD、conda install xxx正确答案:C13、专家系统是以为基础,以推理为核心的系统。

apriori算法步骤

apriori算法步骤一、什么是Apriori算法?Apriori算法是一种用于发现频繁项集(frequent itemset)的经典算法,它是基于频繁项集的性质,通过构建候选项集(candidate itemset)和剪枝(pruning)来减少搜索空间,从而提高算法的效率。

Apriori算法是数据挖掘中最常用的关联规则挖掘算法之一。

在实际应用中,Apriori算法被广泛应用于超市购物篮分析、网络推荐、医疗诊断等领域。

二、Apriori算法的原理Apriori算法的核心思想是利用频繁项集的性质,通过多次迭代扩展频繁项集,从而挖掘出所有频繁项集。

其步骤如下:1.扫描数据集,统计每个项的支持度(support),即出现的频率。

根据设定的最小支持度阈值,筛选出所有支持度不低于该阈值的项,形成1-项集(1-itemset)。

2.根据1-项集,构建2-项集(2-itemset),即包含2个元素的频繁项集。

具体方法是将1-项集中的每个项与其他项进行组合,得到所有可能的组合,再扫描数据集,统计每个组合的支持度,筛选出所有支持度不低于设定阈值的组合,形成2-项集。

3.根据2-项集,构建3-项集(3-itemset),即包含3个元素的频繁项集。

具体方法是将2-项集中的每个项与其他项进行组合,得到所有可能的组合,再扫描数据集,统计每个组合的支持度,筛选出所有支持度不低于设定阈值的组合,形成3-项集。

4.重复以上步骤,直到无法继续生成新的频繁项集为止。

5.根据频繁项集,生成关联规则(association rule)。

对于一个频繁项集A,将其分为两个非空子集B和C,那么A->B和A->C都是关联规则。

通过计算支持度和置信度(confidence)来评估关联规则的可信度,即可发现具有一定意义的关联规则。

三、Apriori算法的优缺点1.优点:Apriori算法易于实现,且能够挖掘出所有频繁项集,具有较高的准确率和可解释性。

基于 Hadoop的Apriori算法与实现

基于 Hadoop的Apriori算法与实现孙赵旭;谢晓兰;周国清;倪金生;胡莘【摘要】针对传统Aprion数据挖掘算法平台的硬件瓶颈以及算法运算耗时、需要重复扫描数据库等缺点,提出了一种基于Hadoop平台应用MapReduce模型与Hbase,对Apriori进行云端的迁移和优化的算法,并与其他的改进Apriori算法进行了分析与比较。

实验结果表明:新的云端算法降低了时间复杂度,使其可以更好的进行数据处理。

%Traditional Apriori algorithm,one of the most common algorithms for data mining,has two shortcom-ings:time-consuming and repeating scanning database.This paper presents the improvement of the Apriori algo-rithm through combining MapReduce model and Hbase under the Hadoop operating platform.The paper analyzes and compares other improved Apriori algorithm with our algorithm.The improved method is experimented under cloud and optimization test.The experimental results demonstrate that the improved algorithm can largely avoid the time-consuming,and make better data operation.【期刊名称】《桂林理工大学学报》【年(卷),期】2014(000)003【总页数】5页(P584-588)【关键词】数据挖掘;云计算;Hadoop;Hbase;MapReduce;Apriori【作者】孙赵旭;谢晓兰;周国清;倪金生;胡莘【作者单位】桂林理工大学信息科学与工程学院;桂林理工大学信息科学与工程学院; 桂林理工大学广西空间信息与测绘重点实验室,广西桂林 541004;桂林理工大学广西空间信息与测绘重点实验室,广西桂林 541004;桂林理工大学广西空间信息与测绘重点实验室,广西桂林 541004;桂林理工大学广西空间信息与测绘重点实验室,广西桂林 541004【正文语种】中文【中图分类】TP393;TP311.13目前,传统的数据挖掘模型已不适用于多维度、多噪声的海量GIS数据,由于传统的挖掘平台自身在计算处理能力上具有局限性,同时,平台在硬件方面遇到瓶颈,而在挖掘算法方面又遇到软件性能制约[1],因此,研究一种新的GIS海量数据的挖掘平台和高效的数据挖掘实现模型是当前急需解决的问题。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于多变量提升度量在Apriori 算法中的研究与应用高乾,吕成兴,王强德曲阜师范大学自动化研究所,山东日照(276826)E-mail :gaoqian925@摘 要:关联规则挖掘是数据挖掘的一个重要研究方向。

传统关联规则使用支持度-置信度框架来进行数据挖掘,所得到的规则并不一定全都是用户感兴趣的,有些甚至是误导的。

本文改进了传统的基于支持度-置信度框架的关联规则,引入了相关度量—提升度,并将提升度由二元变量扩展至多元变量使其更加适合于大型数据库。

实验结果表明,使用提升度框架进行关联规则挖掘,获得的规则数量少,能够挖掘出支持度-置信度框架下遗漏的许多有用规则,实用价值高,无错误规则,是一种比较理想的关联规则挖掘模式。

关键词:数据挖掘,关联规则,提升度,多元变量中图分类号:TP3191.引言数据挖掘[1],就是从大型数据库的数据中提取人们感兴趣的知识。

这些知识是隐含的、事先未知的、潜在的有用信息,提取的知识表示为概念、规则、规律、模式等形式。

数据挖掘的主要功能有:关联分析、分类、聚类、时序模式、偏差检测和预测等。

其中关联规则是数据挖掘的一个重要研究方向,旨在发现大型事务数据库或数值数据库中的项目之间有趣的关系。

自Agrawal 等人开创性的提出Apriori 算法[2]之后,关联分析在理论方面已有大量的研究成果。

专家们相继提出了FP-树频集算法,多层关联规则挖掘,多维关联规则挖掘等算法。

而这些关联规则算法本质上都是使用支持度-置信度框架来进行数据挖掘,所得到的规则并不一定全都是用户感兴趣的,有些甚至是误导的。

本文改进了传统基于支持度-置信度框架的关联规则,引入了相关度量—提升度,并将提升度由二元变量扩展至多元变量使其更加适合于大型数据库。

2. 关联规则描述关联规则[3]是形如 X Y → 的蕴含表达式,其中 X 和Y 是不相交的项集,即X Y ∩=∅。

关联规则的强度可以用它的支持度和置信度度量。

支持度 (sup ) 和置信度 (conf )的定义如下:()sup()()()X Y X Y N X Y conf X Y X σσ∪→=∪→= (2—1) 其中 ()X σ 表示事务集中含有项集 X 的事务个数,N 表示事务集中事务的总数。

()X Y σ∪ 表示事务集中同时出现项集 X 和项集 Y 的事务个数。

关联规则发现 对于给定事务的集合 T ,找出支持度大于等于 minsup 并且置信度大于等于 minconf 的所有规则,其中 minsup 和 minconf 是对应的支持度和置信度的阈值。

经典的关联规则算法是由 Agrawal 等人于 1993 年提出的 Apriori 算法,将关联规则挖掘任务分成两部分:(1) 频繁项集的产生,即发现满足最小支持度阈值的所有项集,这些项集称为频繁项集。

(2) 规则的产生,即从发现的频繁项集中提取所有满足最小置信度阈值的规则,这些规则称作强关联规则。

3.相关度框架在关联规则中的应用3.1相关度的引入基于支持度和置信度框架提取的强关联规则并不一定都是用户有用的,感兴趣的。

我们给出如下例子加以说明。

例 1 假设分析某商场足球与篮球的销售量之间的关系,我们现将收集的一组信息汇总于下表中。

表1 足球与篮球销售量的二元相依表表1是足球与篮球销售量的二元相依表,表中篮球和足球分别表示项集{篮球}和{足球}的负项,即为不购买篮球或足球的人数。

从表中我们可以得到一组规则{篮球}→{足球}(sup=15%,conf=75%),由于其支持度和置信度都比较高,人们似乎可以接受这个推论,但是在所有事物中,不管是否买篮球,买足球的人都占总数的80%,而购买足球的同时购买篮球的人却只占75%。

由此说明规则{篮球}→{足球}尽管有很高的置信度,但是它错误的。

而购买足球又同时购买篮球的人所占的比例明显少于单纯购买足球的人的比例,这表明篮球并不能促销足球反而起到了抑制的作用。

当支持度和置信度框架不能够完全正确的为规则的有效性把关时,一些学者提出了相关度的度量【4,5】。

3.2目前几种主要的相关度量(1)皮尔逊 2χ 统计量()()()22,f E f jk jkj k E f jk χ−∑= (3—1) f jk 表示列联表中一个特定单元的频率。

E(f jk ) 表示该单元的期望频率。

它的计算方法是: ()f f j k E f N jk N N++=×× (3—2) f j+ 表示第 j 行所有单元的频率之和, f +k 表示第 k 列所有单元的频率之和。

2χ 统计量把数据集的真实分布和在一个空假设下的期望作比较。

为了测试项间的相关性,空假设假定模式中的项之间是独立的。

那么,在由数据集提供的证据的基础上,人们能够确定是接受还是拒绝独立性假设。

简单地说,把数据集的真实分布和在一个空假设下的期望作比较。

2χ 度量观察到的频率和期望频率之间的标准化偏差。

偏差越大,我们就越有证据拒绝独立性假设。

如果变量之间有很强的正(负)关联,其值将会很大。

(2) 提升度 lift 度量:这个度量定义为规则置信度和规则后件中项集的支持度之间的比率。

()()sup()conf X Y lift X Y Y →→= (3—3) 基于提升度的定义,我们进一步讨论它的变形。

()()()()()()sup()sup()sup()sup()()1111X Y X Y N conf X Y X N X lift X Y Y Y Y X Y N X Y Nf X Y X Y f f σσσσσ∪∪→→====→∪==++ (3—4) 由推导过程我们可以看到对于二元变量提升度实际上是比较模式的频率与统计独立假定下计算的基线频率。

对于互相独立的两个变量,基线频率为:1111f f f N N N++=× (3—5) 该式中分式 11f N 是联合概率P(X,Y) 的估计,而 1f N + 和 1f N + 分别是概率P(X) 和 P(Y)的估计。

如果 A 和 B 是相互独立的,则 P(X,Y)= P(X)×P(Y),从而产生了(3—5)式。

使用(3—4)式和(3—5)式,提升度量可以解释如下:lift 的取值范围是 [)0,∞,当 ()lift X Y →<1 时,说明 X 的出现会抑制 Y 的出现,它们是负相关的;当 ()lift X Y →=1 时,说明 X 的出现和 Y 的出现无关,它们是独立的;当 ()lift X Y →>1 时,说明 X 的出现能够提升 Y 的出现,它们是正相关的。

(3)余弦度量给定两个项集 X 和 Y ,X 和 Y 的余弦度量定义为:cos (,)ine X Y (3—6) 余弦度量可以看作调和的提升度度量,余弦值只受 X 、Y 和X Y∪的支持度的影响,而不受事务个数的影响。

3.3 基于多变量的提升度量上文提到的几种度量都是针对二元变量定义的(如,2-项集或者规则)。

但是我们平时所涉及到的数据往往都是大型数据库,具有多个数据属性和多元数据变量。

通过挖掘将会找到较大的项目集,那么对于上述度量将无法使用。

所以我们将对提升度进行扩展使其适合较大的项目集或规则集。

根据(3-5)式,可以将二元变量的基线频率扩展至多元变量1212kki i i i i i f f f N N N N f ++++++×××=L L L L L (3—7)12ki i i N f L 表示联合概率12()k P i i i L 的估计,1i f N ++L ,2i f N ++L 和ki f N ++L 分别表示概率1()P i ,2()P i 和()k P i 的估计。

如果(3—7)式成立则有12,,,k i i i L 是相互独立的。

因而,给定一个k-项集 {}12,,,k i i i L ,其统计独立性条件可以定义为:12121k k i i i i i i k f f f f N ++++++−=×××L L L L L (3—8) 利用该定义以及(3-4)式,可以扩展基于背离统计独立性的提升度的度量至多元变量: 121211212121212()(,,,)()()()sup()sup()sup()sup()k k k i i i k k i i i k k k N f P i i i lift i i i f f f P i P i P i i i i i i i −++++++×==××××××∪∪∪=×××L L L L L L L L L L (3—9)根据统计独立性定义,如果对所有的11,,;,j j k i i i i +L L 有()1111(,,,,)(,,),j j k j j k P i i i i P i i P i i ++=×L L L L则称变量1{,,}j i i L 和1{,}j k i i +L 是相互独立的。

对于规则 11,,,j j k i i i i +⇒L L 它的 lift 值可以定义为:12111212121212(,,,)(,,,)(,,,)(,,,)(,,,)(,,,)(,,,)k j j k j j j k k j j j k P i i i lift i i i i P i i i P i i i lift i i i lift i i i lift i i i +++++⇒=×=×L L L L L L L L (3—10)多元变量的 lift 度量的解释与二元变量相同:1,,,12(,,,)1,,,12121,,,12i i i k lift i i i i i i k k i i i k⎧=⎪⎪>⎨⎪<⎪⎩L L L L 表明项集之间完全独立表明项集正相关表明项集负相关 3.4 算法描述 传统基于支持度—置信度框架的关联规则,由于自身的局限性导致产生的规则不一定是用户需要的。

通过重新对lift 值定义,我们可以看出如果某一频繁项集是独立的,那么由此项集提取的规则也必定是独立的,这样的项集对于用户就是无意义的。

我们在提取出频繁项集之后采用基于项集的提升度对所有频繁项集进行一下筛选,剔除掉那些独立的项集。

我们现将扩展后的 lift 应用于 Apriori 算法中,将会明显的减少无用的规则的输出。

算法具体描述如下:1输入最小支持度、置信度和提升度阈值2利用 Apriori 算法生成频繁项集。

3利用基于项集的lift 值对频繁项集进行筛选,剔除独立项集。

4输出用户感兴趣的强关联规则。