Apriori算法介绍PPT

关联规则Apriori算法

关联规则Apriori算法1. 算法概述在关联规则挖掘研究中,Apriori算法是目前许多串行算法中最著名的,其他大多数算法都是基于Apriori算法的不断改进。

这些算法都运用了一个共同的性质,即频繁项目集的任一子集必定也是频繁项目集。

Apriori算法通过不断增加候选项目集的长度来逐步发现最大频繁项目集。

首先搜索1-频繁项目集,然后搜索2-频繁项目集,直到不能再增加频繁项目集的长度为止。

在每次循环过程中,产生k-候选频繁项目集的集合C k,然后计算支持度来搜索k-频繁项目集L k。

Apriori算法主要有三个步骤:第一步:连接(k-1)-频繁项目集产生k-候选频繁项目集C k(k > 1)。

第二步:从C k中修剪所有(k-1)-子集不属于L k-1的项,即包含非频繁项目的候选项目集。

第三步:扫描事务数据库来计算候选项目集的支持度,获得频繁项目集。

2. 算法Apriori的挖掘过程Apriori算法用伪代码描述如下:Input: Database, D, of transaction; Minimum support threshold, min-sup;Output: L, frequent itemsets in D.(1) L1={large 1 - itemsets};(2) For (k=2; L k-1≠ ; k++) do begin(3) C k=Apriori-gen (L k-1); // C k是长度为k的候选频繁项目集的集合(4) For each transaction t∈D do begin(5) C t=subset (C k, t); //C t是transactions t包含的候选频繁项目集(6) For each candidate c∈C t do(7) c. count++;(8) End(9) L k={c∈C k| c. count ≥ min-sup}(10) End(11) Answer=∪k L k;Apriori算法调用了Apriori-gen(L k-1)是为了通过(k-1)-频繁项目集,连接产生k-候选频繁项目集。

apriori算法最大频繁项集

apriori算法最大频繁项集[Apriori算法最大频繁项集]Apriori算法是一种用于数据挖掘的常用算法,用于发现数据集中的频繁项集。

频繁项集是指经常同时出现在一个数据集中的一组项。

Apriori算法通过生成候选项集并使用支持度来筛选出频繁项集。

在本文中,我们将一步一步回答有关Apriori算法中最大频繁项集的问题。

第一步:理解频繁项集频繁项集是指经常同时出现在一个数据集中的一组项。

例如,在一个购物篮数据集中,频繁项集可以是一组同时出现在许多购物篮中的商品。

发现频繁项集可以帮助我们了解数据集中的潜在关联规则。

第二步:了解Apriori算法Apriori算法是一种用于发现频繁项集的经典算法。

该算法基于一个重要的性质,即如果一个项集是频繁的,那么它的所有子集也是频繁的。

Apriori算法通过迭代地产生候选项集并使用支持度来筛选出频繁项集。

第三步:生成候选项集Apriori算法首先生成长度为1的候选项集,即单个项。

然后,它根据频繁项集的支持度阈值筛选出频繁项集。

接下来,Apriori算法基于频繁项集生成长度为2的候选项集。

这个过程继续进行,直到无法生成更长的候选项集为止。

第四步:计算支持度支持度是指一个项集在数据集中出现的频率。

在Apriori算法中,支持度用来衡量一个项集的重要性。

Apriori算法计算每个候选项集的支持度,并用支持度阈值来筛选出频繁项集。

支持度阈值是指一个项集必须满足的最低支持度要求。

第五步:筛选出频繁项集Apriori算法根据支持度阈值筛选出频繁项集。

频繁项集是指满足最低支持度要求的项集。

这些频繁项集是数据集中经常出现的项集,它们可以帮助我们了解数据集中的关联规则。

第六步:找出最大频繁项集最大频繁项集是指不再包含其他频繁项集的项集。

在Apriori算法中,最大频繁项集可以由频繁项集合并来得出。

如果一个频繁项集的所有子集都不是频繁的,那么它就是最大频繁项集。

最后总结:Apriori算法是一种经典的发现频繁项集的算法。

Apriori算法总结

Apriori ['eɪprɪ'ɔ:rɪ]Apriori算法是一种挖掘关联规则的频繁项集算法,其核心思想是通过候选集生成和情节的向下封闭检测两个阶段来挖掘频繁项集。

而且算法已经被广泛的应用到商业、网络安全等各个领域。

其核心是基于两阶段频集思想的递推算法。

该关联规则在分类上属于单维、单层、布尔关联规则。

在这里,所有支持度大于最小支持度的项集称为频繁项集,简称频集。

经典的关联规则数据挖掘算法Apriori 算法广泛应用于各种领域,通过对数据的关联性进行了分析和挖掘,挖掘出的这些信息在决策制定过程中具有重要的参考价值。

Apriori算法广泛应用于商业中,应用于消费市场价格分析中,它能够很快的求出各种产品之间的价格关系和它们之间的影响。

通过数据挖掘,市场商人可以瞄准目标客户,采用个人股票行市、最新信息、特殊的市场推广活动或其他一些特殊的信息手段,从而极大地减少广告预算和增加收入。

百货商场、超市和一些老字型大小的零售店也在进行数据挖掘,以便猜测这些年来顾客的消费习惯。

Apriori算法应用于网络安全领域,比如网络入侵检测技术中。

早期中大型的电脑系统中都收集审计信息来建立跟踪档,这些审计跟踪的目的多是为了性能测试或计费,因此对攻击检测提供的有用信息比较少。

它通过模式的学习和训练可以发现网络用户的异常行为模式。

采用作用度的Apriori算法削弱了Apriori算法的挖掘结果规则,是网络入侵检测系统可以快速的发现用户的行为模式,能够快速的锁定攻击者,提高了基于关联规则的入侵检测系统的检测性。

Apriori算法应用于高校管理中。

随着高校贫困生人数的不断增加,学校管理部门资助工作难度也越加增大。

针对这一现象,提出一种基于数据挖掘算法的解决方法。

将关联规则的Apriori算法应用到贫困助学体系中,并且针对经典Apriori挖掘算法存在的不足进行改进,先将事务数据库映射为一个布尔矩阵,用一种逐层递增的思想来动态的分配内存进行存储,再利用向量求"与"运算,寻找频繁项集。

Apriori算法介绍PPT

的业务运营和辅助业务提供商的决策制定等方面具有十分重要的参考价值。

5.在地球科学数据分析中

关联模式可以揭示海洋、陆地和大气过程之间的有意义的关系。这些信息能够帮助地球科学家更好的理解地

球系统中不同的自然力之间的相互作用。

据挖掘算法的解决方法。将关联规则的Apriori算法应用到贫困助学体系中,并且针对经典Apriori挖掘算法存

在的不足进行改进,先将事务数据库映射为一个布尔矩阵,用一种逐层递增的思想来动态的分配内存进行存

储,再利用向量求"与"运算,寻找频繁项集。实验结果表明,改进后的Apriori算法在运行效率上有了很大的

Apriori 算法背景

L1={{面包},{牛奶},{啤酒},{尿布}}

(3)根据L1自连接L1⋈L1生成候选项目集C2={{面包,牛奶},{面包,啤酒},

{面包,尿布},{牛奶,啤酒},{牛奶,尿布},{啤酒,尿布}}。

Apriori 算法背景

C2={{面包,牛奶},{面包,啤酒},{面包,尿布},{牛奶,啤酒},{牛奶,尿布},{啤酒,

的比重。

置信度(confidence):置信度表示Y数据出现后,X数据出现

的可能性,也可以说是数据的条件概率。

强关联规则:满足最小支持度和最小置信度的关联规则。

Apriori 算法背景

举例

{面包}→{牛奶}

support(面包→牛奶)=

∣面包∪牛奶∣ 3

=

4

∣D∣

3

P(面包牛奶) 4

confidence(面包→牛奶)=

70%,可得},{面包,啤酒}—>{牛奶},{牛奶,啤酒}—>{面包}为频繁关联规则。也

关联规则(Apriori算法)

关联规则(Apriori算法)关联分析直观理解 关联分析中最有名的例⼦是“尿布与啤酒”。

据报道,美国中西部的⼀家连锁店发现,男⼈们会在周四购买尿布和啤酒。

这样商店实际上可以将尿布与啤酒放在⼀块,并确保在周四全价销售从⽽获利。

当然,这家商店并没有这么做。

频繁项集是指那些经常出现在⼀起的物品集合,⽐如{葡萄酒,尿布, ⾖奶}就是频繁项集的⼀个例⼦⽀持度(support) ⼀个项集的⽀持度(support)被定义为数据集中包含该项集的记录所占的⽐例 {⾖奶}的⽀持度为4/5。

{⾖奶,尿布}的⽀持度为3/5可信度(confidence ) 可信度或置信度(confidence)是针对⼀条诸如{尿布} ➞ {葡萄酒}的关联规则来定义的。

这条规则的可信度被定义为“⽀持度({尿布, 葡萄酒})/⽀持度({尿布})”。

由于{尿布, 葡萄酒}的⽀持度为3/5,尿布的⽀持度为4/5,所以“尿布➞葡萄酒”的可信度为3/4=0.75。

这意味着对于包含“尿布”的所有记录,我们的规则对其中75%的记录都适⽤。

Apriori算法的⽬标是找到最⼤的K项频繁集⽀持度和可信度是⽤来量化关联分析是否成功的⽅法。

假设想找到⽀持度⼤于0.8的所有项集,应该如何去做?⼀个办法是⽣成⼀个物品所有可能组合的清单,然后对每⼀种组合统计它出现的频繁程度,但当物品成千上万时,⾮常慢,这时就能⽤Apriori算法关联分析中最有名的例⼦是“尿布与啤酒”。

据报道,美国中西部的⼀家连锁店发现,男⼈们会在周四购买尿布和啤酒。

这样商店实际上可以将尿布与啤酒放在⼀块,并确保在周四全价销售从⽽获利。

当然,这家商店并没有这么做。

⼀般我们使⽤三个指标来度量⼀个关联规则,这三个指标分别是:⽀持度、置信度和提升度。

Support(⽀持度):表⽰同时包含A和B的事务占所有事务的⽐例。

如果⽤P(A)表⽰使⽤A事务的⽐例,那么Support=P(A&B)Confidence(可信度):表⽰使⽤包含A的事务中同时包含B事务的⽐例,即同时包含A和B的事务占包含A事务的⽐例。

Apriori改进算法讲解和实现

链接和修剪

• 其中, apriori- gen 是以频繁(k- 1)- 项目序列集Lk- 1 为自变量的候 选集生成函数。该函数返回包含所有频繁k- 项目集的超集, 分 链接和修剪两步执行: 第1 步:链接(join) • Procedure apriori_gen(Lk- 1:frequent(k- 1)- itemsets; minsup) • 1) for each itemset l1∈Lk- 1 • 2) for each itemset l2∈Lk- 1 L • 3) if ((l1[1]=l2[1])(l1[2]=l2[2])∧…∧(l1[k- 2]=l2[k- 2])∧(l1[k- 1]≠l2[k- 1])then { • 4) c=l1∪l2;//连接, 产生候选集 • 5) if has_infrequent_subset(c,Lk- 1) then • 6) delete c;//修剪, 去掉无用的候选项 • 7) else add c to Ck; • 8) } • 9) return Ck;

定义和性质

• 根据上述定义,可以这样描述Apriori 算法:Apriori 算法使用逐 层搜索的迭代方法来产生频繁项集,设有频繁k-项集L k,通过 Galois连接产生候选k + 1 项集Ck+1,再通过扫描数据集产生频繁 k + 1 项集L k+1,最后由产生的频繁项目集产生关联规则。 • 性质1 :(Apriori 性质)频繁项目集的所有非空子集都必须也是频 繁的。 • 证明(用反证法) :略。 • 推论1 :一个非频繁项目集的任一超集必定也是非频繁的。 • 证明:根据定义若有k-1 项集Ik -1 ,不满足最小支持度阈值minsup ,即P( Ik-1) < min-sup ,则称Ik-1 为非频繁的。若将任意一项 (集) A 添加到Ik - 1 中,则必有P( Ik - 1∪ A) < P( Ik - 1) < min- sup,即Ik - 1 的任一超集( Ik - 1 ∪A) 是非频繁的。得证。

大数据基础培训系列机器学习算法最新PPT课件

扫描一遍整个数据库, 计频算率。1-itemsets 出现的

剪满足支持度和可信度

的到这下些一轮1-i流tem程s,et再s移寻动找 出现的2-itemsets。

重复,对于每种水平的 项知集道我一们直之重前复定计义算的,项 集大小为止。

8. 经典算法之Expectation Maximization

? Matrix Factorization ① Principal component analysis ② Truncated singular value decomposition ③ Dictionary Learning ④ Factor Analysis ⑤ Independent component analysis ⑥ Non-negative matrix factorization ⑦ Latent Dirichlet Allocation

或 递归构建二叉树。对回归树采用 L1 L2损失函数最小化作为分裂准则,对分类树用基尼不纯度最小化或信息增 益最大化作为分裂准则

案个例测:点)17进年行8月了,分针析对,实找验出中区心分曹度受最天大提的供条宇件通,及从竞而争了车解型与的竞纵争向车加型速之度间数的据区(别五。

5. 经典算法之k-means clustering

? Biclustering ① Spectral Co-Clustring ② Spectral Biclustering

? Novelty and Outlier Detection ① One-class SVM ② Elliptic envelope ③ Isolating Forest ④ Local outlier factor

? Regression ① Ordinary Least Squares ② Elastic Net ③ Orthogonal Matching Pursuit ④ Bayesian Regression ⑤ Random Sample Consensus ⑥ Polynomial regression ⑦ Kernel Ridge Regression ⑧ Support vector Regression ⑨ Stochastic Gradient Descent ⑩ Nearest Neighbors

Apriori算法详解

Apriori算法详解之【一、相关概念和核心步骤】Apriori算法核心步骤感谢红兰整理的PPT,简单易懂,现在将其中精彩之处整理,与大家分享。

一、Apriori算法简介: Apriori算法是一种挖掘关联规则的频繁项集算法,其核心思想是通过候选集生成和情节的向下封闭检测两个阶段来挖掘频繁项集。

Apriori(先验的,推测的)算法应用广泛,可用于消费市场价格分析,猜测顾客的消费习惯;网络安全领域中的入侵检测技术;可用在用于高校管理中,根据挖掘规则可以有效地辅助学校管理部门有针对性的开展贫困助学工作;也可用在移动通信领域中,指导运营商的业务运营和辅助业务提供商的决策制定。

二、挖掘步骤:1。

依据支持度找出所有频繁项集(频度)2.依据置信度产生关联规则(强度)三、基本概念对于A—〉B①支持度:P(A ∩B),既有A又有B的概率②置信度:P(B|A),在A发生的事件中同时发生B的概率p(AB)/P(A) 例如购物篮分析:牛奶⇒面包例子:[支持度:3%,置信度:40%]支持度3%:意味着3%顾客同时购买牛奶和面包置信度40%:意味着购买牛奶的顾客40%也购买面包③如果事件A中包含k个元素,那么称这个事件A为k项集事件A满足最小支持度阈值的事件称为频繁k项集.④同时满足最小支持度阈值和最小置信度阈值的规则称为强规则四、实现步骤Apriori算法是一种最有影响的挖掘布尔关联规则频繁项集的算法Apriori使用一种称作逐层搜索的迭代方法,“K—1项集”用于搜索“K项集”。

首先,找出频繁“1项集"的集合,该集合记作L1.L1用于找频繁“2项集"的集合L2,而L2用于找L3。

如此下去,直到不能找到“K项集".找每个Lk都需要一次数据库扫描.核心思想是:连接步和剪枝步。

连接步是自连接,原则是保证前k-2项相同,并按照字典顺序连接。

剪枝步,是使任一频繁项集的所有非空子集也必须是频繁的。

反之,如果某个候选的非空子集不是频繁的,那么该候选肯定不是频繁的,从而可以将其从CK中删除.简单的讲,1、发现频繁项集,过程为(1)扫描(2)计数(3)比较(4)产生频繁项集(5)连接、剪枝,产生候选项集重复步骤(1)~(5)直到不能发现更大的频集2、产生关联规则,过程为:根据前面提到的置信度的定义,关联规则的产生如下:(1)对于每个频繁项集L,产生L的所有非空子集;(2)对于L的每个非空子集S,如果P(L)/P(S)≧min_conf则输出规则“SàL—S"注:L—S表示在项集L中除去S子集的项集一、Apriori算法伪代码实现:[plain]view plaincopy1.伪代码描述:2.// 找出频繁 1 项集3.L1 =find_frequent_1—itemsets(D);4.For(k=2;Lk-1 !=null;k++){5.// 产生候选,并剪枝6.Ck =apriori_gen(Lk-1 );7.// 扫描 D 进行候选计数8.For each 事务t in D{9.Ct =subset(Ck,t); // 得到t 的子集10.For each 候选 c 属于Ct11.c。

数据挖掘ppt课件(2024)

医疗数据类型及特点

电子病历、医学影像、基因测序等 。

数据预处理与特征提取

针对不同类型的医疗数据进行预处 理和特征提取,如文本处理、图像 识别、基因表达谱分析等。

2024/1/29

模型评估与应用

通过准确率、灵敏度、特异度等指 标评估模型性能,将模型应用于实 际医疗场景中,提高医生诊断效率 和准确性。

疾病预测与辅助诊断模型构建

贝叶斯分类器应用案例

03

如垃圾邮件识别、新闻分类、情感分析等。

17

神经网络在分类预测中应用

1 2

神经网络基本概念

模拟人脑神经元连接方式的计算模型,通过训练 学习输入与输出之间的映射关系。

神经网络在分类预测中的应用

通过构建多层感知机、卷积神经网络等模型,对 输入数据进行自动特征提取和分类预测。

3

神经网络应用案例

5

数据挖掘与机器学习关系

机器学习是数据挖掘的重 要工具之一。

2024/1/29

数据挖掘包括数据预处理 、特征提取、模型构建等 步骤,其中模型构建可以 使用机器学习算法。

机器学习算法如决策树、 神经网络、支持向量机等 在数据挖掘中有广泛应用 。

6

2024/1/29

02

数据预处理技术

7

数据清洗与去重

推荐模型构建

利用机器学习、深度学习等技 术构建推荐模型,如逻辑回归 、神经网络等。

模型评估与优化

通过准确率、召回率、F1值等 指标评估模型性能,采用交叉 验证、网格搜索等方法优化模

型参数。

32

金融欺诈检测模型构建与优化

金融欺诈类型及特点

信用卡欺诈、贷款欺诈、洗钱等。

2024/1/29

数据来源与处理

Apriori算法例子

Apriori算法例子1 Apriori介绍Apriori算法使用频繁项集的先验知识,使用一种称作逐层搜索的迭代方法,k项集用于探索(k+1)项集。

首先,通过扫描事务(交易)记录,找出所有的频繁1项集,该集合记做L1,然后利用L1找频繁2项集的集合L2,L2找L3,如此下去,直到不能再找到任何频繁k项集。

最后再在所有的频繁集中找出强规则,即产生用户感兴趣的关联规则。

其中,Apriori算法具有这样一条性质:任一频繁项集的所有非空子集也必须是频繁的。

因为假如P(I)< 最小支持度阈值,当有元素A添加到I中时,结果项集(A∩I)不可能比I出现次数更多。

因此A∩I也不是频繁的。

2连接步和剪枝步在上述的关联规则挖掘过程的两个步骤中,第一步往往是总体性能的瓶颈。

Apriori 算法采用连接步和剪枝步两种方式来找出所有的频繁项集。

1)连接步为找出L k(所有的频繁k项集的集合),通过将L k-1(所有的频繁k-1项集的集合)与自身连接产生候选k项集的集合。

候选集合记作C k。

设l1和l2是L k-1中的成员。

记l i[j]表示l i中的第j项。

假设Apriori算法对事务或项集中的项按字典次序排序,即对于(k-1)项集l i,l i[1]<l i[2]<……….<l i[k-1]。

将L k-1与自身连接,如果(l1[1]=l2[1])&&( l1[2]=l2[2])&&……..&& (l1[k-2]=l2[k-2])&&(l1[k-1]<l2[k-1]),那认为l1和l2是可连接。

连接l1和l2产生的结果是{l1[1],l1[2],……,l1[k-1],l2[k-1]}。

2)剪枝步C K是L K的超集,也就是说,C K的成员可能是也可能不是频繁的。

通过扫描所有的事务(交易),确定C K中每个候选的计数,判断是否小于最小支持度计数,如果不是,则认为该候选是频繁的。

第2讲 关联分析算法--Apriori FP

数据项与数据项集 – 设 I={i1,i2,...,in} 是 n 个不同项目的一个集合,每个 ik称为一个数据项(item),数据项的集合I为数据项集 ,简称为项集 (itemset) ,其中元素个数称为项集的长 度。长度为k的数据项集称为k-项集(k-itemset)。 – 如I={bread,coke,milk,beer,diaper}, I的长度为5 – 2-项集 {Coke,Milk} TID Items

TID Items

1 2 3 4 5

Bread, Coke, Milk Beer, Bread Beer, Coke, Diaper, Milk Beer, Bread, Diaper, Milk Coke, Diaper, Milk

事务

– 事务T是数据项集I上的一个子集 – 每个事务都有一个唯一的标识符TID与之联 系,如TID(1)={bread,coke,milk} – 不同事务的全体构成事务数据库D

TID

Items

Bread Milk

60 80

1 2 3 4 5

Bread, Coke, Milk Beer, Bread Beer, Coke, Diaper, Milk Beer, Bread, Diaper, Milk Coke, Diaper, Milk

Beer

Bread coke Bread milk

© Xu Gui-qiong

2014 Spring

‹#›

基本概念——示例

关联规则 R:X->Y,其中X in I,Y in I且X intersect Y={} ,它表 示如果项集X在某一事务中出现,则必然导致项集Y也会 在同一事务中出现。X叫做规则的先决条件,Y叫做规则 的结果。 关联规则的置信度 对于关联规则R:X ->Y,其中X in I,Y in I且X intersect Y={} 。规则R的臵信度(confidence)定义为 confidence(R)=support(X union Y)/support(X) 强关联规则 在事务数据库D中满足最小支持度和最小臵信度的关联 规则称为强关联规则。

调查资料分析专题-Apriori算法

关联规则挖掘的基本概念

4. 项集、k-项集、频繁k-项集

项集 K-项集

项的集合。

包含K个项的集合。 如:集合{computer, software}是一个2-项集

频繁K-项集 满足最小支持度的k-项集。

内容提要

1.关联规则的定义及实例 2. 关联规则挖掘的基本概念

3. 关联规则挖掘的步骤

5. Aprior算法及实例 6. AprioriTid及AprioriHybrid算法 7. Apriori算法在clementine中的应用实例

Apriori算法

3. 算法步骤

第一次遍历数据库D 确定频繁1-项集L1

由L1和Apriori-gen函数 产生候选2-项集C2

由C2和subset函数计算C2中候选项 的支持度,从而确定频繁2-项集L2

依次类推迭代下去 ……

直到不能找到频繁项集,循环结束

Apriori算法

4. 算法核心思想

Apriori算法

1)Apriori-gen函数

Apriori-gen 函数的功能

从第k-1次遍历数据库后,找出频繁项集集合 Lk-1,产生出第k次遍历所要计数的长度为k 的候选项集集合Ck,并保证Ck中项集的所有 k-1项子集都是频繁项集。

Apriori性质 频繁项集的所有非空子集都必须也是频繁项集。

Apriori算法

2. 显示数据--output(table)

Apriori算法在clementine中的 应用实例

3. 建立模型--filedops/modeling

Filedops -- type

Apriori算法在clementine中的 应用实例

Filedops -- type

机器学习经典算法(PPT45页)

培训专用

七、K-means

• K-means算法是很典型的基于距离的聚类算法,采 用距离作为相似性的评价指标,即认为两个对象的 距离越近,其相似度就越大。该算法认为簇是由距 离靠近的对象组成的,因此把得到紧凑且独立的簇 作为最终目标。

1)adaboost是一种有很高精度的分类器 2)可以使用各种方法构建子分类器,adaboost算法提

供的是框架 3)当使用简单分类器时,计算出的结果是可以理解的。

而且弱分类器构造极其简单 4)简单,不用做特征筛选 5)不用担心overfitting

培训专用

adaboost算法的一些实际可以使用的场景:

培训专用

步骤1:发现频繁项集

❖ 频繁项集发现过程: ❖ (1)扫描 ❖ (2)计数 ❖ (3)比较 ❖ (4)产生频繁项集 ❖ (5)连接、剪枝,产生候选项集 ❖ 重复步骤(1)~(5)直到不能发现更大频集

培训专用

步骤2:产生关联规则

• 根据前面提到的置信度的定义,关联规则的产生如 下:

• (1)对于每个频繁项集L,产生L的所有非空子集; • (2)对于L的每个非空子集S,如果

• 主要应用在电子邮件过滤和文本分类的研究

培训专用

朴素贝叶斯算法原理:

培训专用

培训专用

培训专用

培训专用

培训专用

四、KNN

• K-近邻分类算法(K Nearest Neighbors,简称KNN) 通过计算每个训练数据到待分类元组的距离,取和 待分类元组距离最近的K个训练数据,K个数据中哪 个类别的训练数据占多数,则待分类元组就属于哪 个类别。

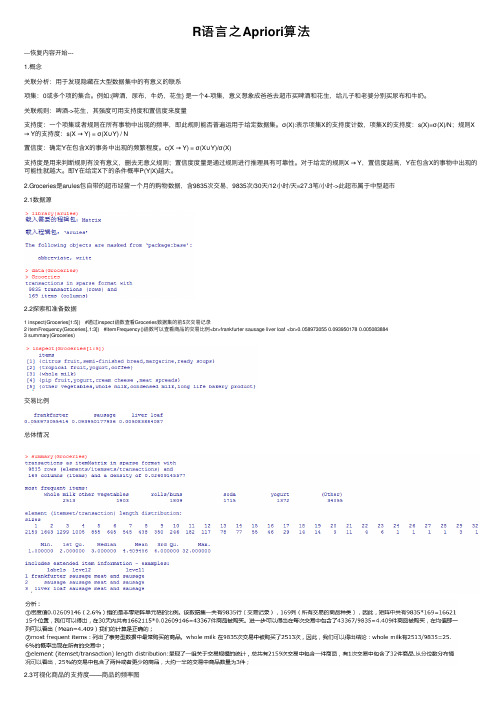

R语言之Apriori算法

R语⾔之Apriori算法---恢复内容开始---1.概念关联分析:⽤于发现隐藏在⼤型数据集中的有意义的联系项集:0或多个项的集合。

例如:{啤酒,尿布,⽜奶,花⽣} 是⼀个4-项集,意义想象成爸爸去超市买啤酒和花⽣,给⼉⼦和⽼婆分别买尿布和⽜奶。

关联规则:啤酒->花⽣,其强度可⽤⽀持度和置信度来度量⽀持度:⼀个项集或者规则在所有事物中出现的频率,即此规则能否普遍运⽤于给定数据集。

σ(X):表⽰项集X的⽀持度计数,项集X的⽀持度:s(X)=σ(X)/N;规则X → Y的⽀持度:s(X → Y) = σ(X∪Y) / N置信度:确定Y在包含X的事务中出现的频繁程度。

c(X → Y) = σ(X∪Y)/σ(X)⽀持度是⽤来判断规则有没有意义,删去⽆意义规则;置信度度量是通过规则进⾏推理具有可靠性。

对于给定的规则X → Y,置信度越⾼,Y在包含X的事物中出现的可能性就越⼤。

即Y在给定X下的条件概率P(Y|X)越⼤。

2.Groceries是arules包⾃带的超市经营⼀个⽉的购物数据,含9835次交易,9835次/30天/12⼩时/天=27.3笔/⼩时->此超市属于中型超市2.1数据源2.2探索和准备数据1 inspect(Groceries[1:5]) #通过inspect函数查看Groceries数据集的前5次交易记录2 itemFrequency(Groceries[,1:3]) #itemFrequency()函数可以查看商品的交易⽐例<br>frankfurter sausage liver loaf <br>0.058973055 0.093950178 0.0050838843 summary(Groceries)交易⽐例总体情况2.3可视化商品的⽀持度——商品的频率图为了直观地呈现统计数据,可以使⽤itemFrequenctyPlot()函数⽣成⼀个⽤于描绘所包含的特定商品的交易⽐例的柱状图。

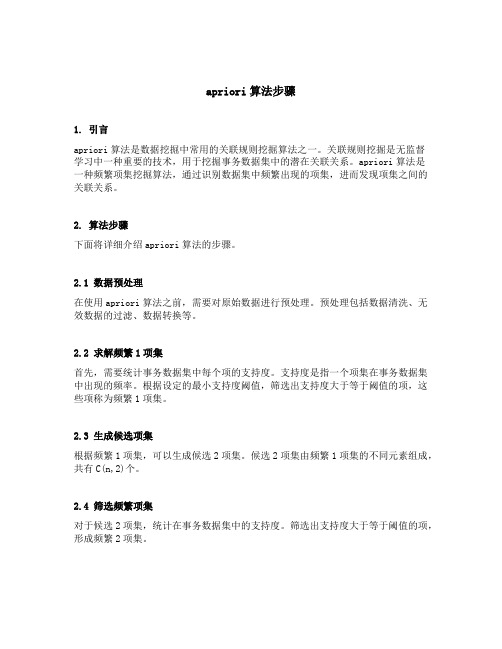

apriori算法步骤

apriori算法步骤1. 引言apriori算法是数据挖掘中常用的关联规则挖掘算法之一。

关联规则挖掘是无监督学习中一种重要的技术,用于挖掘事务数据集中的潜在关联关系。

apriori算法是一种频繁项集挖掘算法,通过识别数据集中频繁出现的项集,进而发现项集之间的关联关系。

2. 算法步骤下面将详细介绍apriori算法的步骤。

2.1 数据预处理在使用apriori算法之前,需要对原始数据进行预处理。

预处理包括数据清洗、无效数据的过滤、数据转换等。

2.2 求解频繁1项集首先,需要统计事务数据集中每个项的支持度。

支持度是指一个项集在事务数据集中出现的频率。

根据设定的最小支持度阈值,筛选出支持度大于等于阈值的项,这些项称为频繁1项集。

2.3 生成候选项集根据频繁1项集,可以生成候选2项集。

候选2项集由频繁1项集的不同元素组成,共有C(n,2)个。

2.4 筛选频繁项集对于候选2项集,统计在事务数据集中的支持度。

筛选出支持度大于等于阈值的项,形成频繁2项集。

2.5 递归生成候选n项集和筛选频繁n项集根据频繁(n-1)项集,可以生成候选n项集。

候选n项集由频繁(n-1)项集的不同元素组成,共有C(n-1,2)个。

2.6 终止条件重复步骤2.4和2.5,直到无法生成候选n项集为止。

此时,得到的频繁n项集即是最终的频繁项集。

2.7 生成关联规则根据频繁项集,可以根据设定的最小置信度阈值生成关联规则。

置信度是指关联规则中后件在前件的条件下出现的概率。

对于频繁项集中的每个项集,可以生成多个关联规则,根据置信度对规则进行排序。

3. 算法示例接下来,我们通过一个简单的示例来演示apriori算法的步骤。

假设我们有一个包含5个交易记录的事务数据集,每个交易记录包含不同的商品。

为了简化问题,我们将商品用不同的字母表示。

A B C DA C DB C D EA B CB C E假设我们设定最小支持度阈值为2,最小置信度阈值为0.6。

Apriori算法与FP

8000000

7000000 6000000 5000000 4000000 Apriori FP_growth

3000000

2000000 1000000 0 支持度

►►单独的 FP_growth算法 在不同支持度 下的运行时间 折线图:

运行时间/ms 12000 10000 8000 6000 FP_growth 4000 2000 0 支持度

1读入事务记录publiclistliststringreadtransdata2构造频繁1项集publicarraylisttreenodebuildf1itemslistliststringtransrecords3把事务数据库中的一条记录按照f1频繁1项集中的顺序排序iikitbitpubliclinkedliststringsortbyf1liststringtransrecordarraylisttreenodef14把节点插入树中publicvoidaddnodestreenodeancestorlinkedliststringrecordarraylisttreenodef15建立fp树树publictreenodebuildfptreelistliststringtransrecordsarraylisttreenodef16从一棵fptree上找到所有的前缀模式publicmapliststringintegerfindprepatterntreenoderoot7生成路径中所有元素的任意组合即从fptree中找到所有的频繁模式中找到所有的频繁模式publicmapliststringintegercombinationlisttreenodepath8找找到从指定节点root到所有可达叶子节点的路径publiclinkedlistlinkedlisttreenodebuildpathstreenoderoot单枝

《Apriori算法》课件

使用垂直数据格式加速关联规则的生成

垂直数据格式是一种数据表示方式,它 将数据按照列的形式进行组织。在关联 规则挖掘中,使用垂直数据格式可以提 高算法的效率。

在Apriori算法中,可以使用垂直数据格式来 加速关联规则的生成。通过将数据按照属性 进行划分,可以减少对数据库的扫描次数, 提高算法的效率。

推荐系统

பைடு நூலகம்

利用Apriori算法为用户提供个性化 的推荐服务,提高用户满意度和忠诚 度。

VS

在电子商务、在线音乐、视频等平台 上,用户经常需要推荐服务。Apriori 算法能够通过分析用户的消费记录和 行为数据,发现用户的兴趣和偏好, 从而为用户推荐相关联的商品、音乐 、视频等。这有助于提高用户满意度 和忠诚度,促进平台的可持续发展。

Apriori算法的应用场景

1 2

推荐系统

根据用户历史行为,推荐可能感兴趣的商品或服 务

市场篮子分析

分析商品之间的关联关系,帮助商家制定营销策 略

3

异常检测

识别数据中的异常模式,用于欺诈检测、故障预 测等场景

Apriori算法与其他关联规则学习算法的区别

01

与ECLAT算法相比,Apriori算 法采用候选集生成和剪枝策略 ,更加高效

在生成频繁项集时,可以利用哈希树快速查找和过滤掉不可能成为频繁项集的候选集,减少计算量。

使用事务压缩优化内存使用

事务压缩是一种技术,通过将多个事务合并为一个事务,减少内存的使用 。

在Apriori算法中,可以使用事务压缩来优化内存使用。通过合并相似的事 务,可以减少需要存储的事务数量,从而降低内存占用。

关联规则算法Apriori的学习与实现

关联规则算法Apriori的学习与实现(2011-07-18 11:28:52)首先我们来看,什么是规则?规则形如”如果…那么…(If…Then…)”,前者为条件,后者为结果。

关联规则挖掘用于寻找给定数据集中项之间的有趣的关联或相关关系。

关联规则揭示了数据项间的未知的依赖关系,根据所挖掘的关联关系,可以从一个数据对象的信息来推断另一个数据对象的信息。

例如购物篮分析。

牛奶⇒面包[支持度:3%,置信度:40%]支持度3%意味3%顾客同时购买牛奶和面包。

置信度40%意味购买牛奶的顾客40%也购买面包。

规则的支持度和置信度是两个规则兴趣度度量,它们分别反映发现规则的有用性和确定性。

关联规则是有趣的,如果它满足最小支持度阈值和最小置信度阈值。

这些阈值可以由用户或领域专家设定。

我们先来认识几个相关的定义:定义1:支持度(support)支持度s是事务数据库D中包含A U B的事务百分比,它是概率P(A U B),即support (A B)=P(A U B),它描述了A和B这两个物品集的并集在所有的事务中出现的概率。

定义2:置信度(confidence)可信度为事务数据库D中包含A的事务中同时也包含B的百分比,它是概率P(B|A),即confidence(A B)=P(B|A)。

定义3:频繁项目集支持度不小于用户给定的最小支持度阈值(minsup)的项集称为频繁项目集(简称频集),或者大项目集。

所有的频繁1-项集记为L1。

假设有如下表的购买记录。

顾客项目1orange juice, coke2milk, orange juice, window cleaner3orange juice, detergent4orange juice, detergent, coke5window cleaner将上表整理一下,得到如下的一个2维表Orange Win Cl Milk Coke DetergentOrange41122WinCl12100Milk11100Coke20021Detergent10002上表中横栏和纵栏的数字表示同时购买这两种商品的交易条数。