基于Spark的密度聚类算法并行化研究

面向云计算环境下基于Spark的大数据处理技术研究

面向云计算环境下基于Spark的大数据处理技术研究现代互联网时代,数据规模急剧增长,数据处理能力已成为企业竞争力的重要标志。

云计算作为一种新兴的技术,颠覆了传统数据处理方式,成为大数据处理时代的核心技术之一。

而Spark作为云计算时代的一个重要技术,也受到了越来越多企业的重视,并逐渐成为企业常用的大数据处理技术之一。

本文将对基于Spark的大数据处理技术进行探讨和研究。

一、Spark技术简介Spark是一种基于内存的分布式数据处理框架,由美国加州大学伯克利分校AMPLab开发,旨在解决Hadoop数据处理上的缺陷。

其拥有快速的批数据处理和交互式查询处理能力,以及面向数据流的处理能力,有着广泛的应用场景,被认为是大数据时代的“杀手锏”。

Spark的核心技术包括RDD(Resilient Distributed Datasets)、DataFrame、Spark SQL、MLlib、GraphX等,其中RDD是其核心技术之一。

RDD把数据分为多个数据块,存储在不同的节点上,通过多轮迭代,对数据进行分析和处理,避免了中间存储的开销,提高了处理效率。

Spark还具备内存计算和数据共享技术,同时通过高效的任务调度机制,实现了大规模集群处理。

二、Spark在云计算下的优势云计算的出现,为企业提供了强大的大数据处理能力,而Spark作为云计算的一种重要技术,更是为企业的大数据研究提供了更为高效和快捷的方式。

具体而言,Spark在云计算下的优势主要有以下几点:1.强大的分布式计算能力Spark适用于大规模集群,能够快速处理PB级别的数据,同时还具备水平扩展性,可以使用更多的节点进行数据处理。

2.高效的内存计算Spark内存计算能力非常强大,其可以将数据存储在内存中,避免了磁盘数据读取的瓶颈,大大提高了数据处理速度。

3.灵活的计算模型Spark支持多种计算模型,可以进行流处理、批处理以及机器学习等多种模型,并且容易扩展,能够满足不同场景的需求。

数据挖掘中的并行计算技巧(五)

数据挖掘是一门涉及大规模数据处理和分析的学科,而并行计算技巧则是在处理大规模数据时至关重要的一环。

本文将介绍在数据挖掘中常用的并行计算技巧,包括分布式计算、并行算法等内容。

分布式计算是大规模数据处理中常用的一种并行计算技巧。

在分布式计算中,计算任务被分发到多台计算机上进行并行处理,从而加快了数据处理的速度。

常见的分布式计算框架包括Hadoop和Spark。

Hadoop采用分布式文件系统HDFS来存储数据,并通过MapReduce框架来进行数据处理。

而Spark则是基于内存计算的分布式计算框架,拥有更快的计算速度和更丰富的API支持。

通过使用这些分布式计算框架,数据挖掘工程师可以充分利用集群中的计算资源,提高数据处理的效率。

除了分布式计算,并行算法也是数据挖掘中常用的一种技巧。

在并行算法中,数据挖掘任务被分解成多个子任务,并行执行。

常见的并行算法包括K-means并行算法、Apriori算法等。

K-means并行算法是一种用于聚类分析的算法,通过将数据集分成多个子集,并行执行聚类分析,从而提高了聚类的效率。

而Apriori算法则是一种用于关联规则挖掘的算法,通过并行处理频繁项集的生成和关联规则的发现,加速了关联规则挖掘的过程。

此外,数据挖掘中还可以采用GPU加速技术来进行并行计算。

GPU是图形处理器,其内部包含大量的小型处理单元,适合并行计算。

在数据挖掘中,可以利用GPU加速技术来加速矩阵运算、神经网络训练等计算密集型任务。

通过使用GPU加速技术,数据挖掘工程师可以在不增加硬件成本的情况下,提高数据处理的速度。

在实际的数据挖掘应用中,通常会综合运用以上的并行计算技巧。

例如,可以将数据集通过Hadoop分布式计算框架进行预处理,然后使用Spark进行并行算法的计算,最后通过GPU加速技术进行模型训练。

通过综合运用这些并行计算技巧,可以大大提高数据挖掘的效率和性能。

总之,数据挖掘中的并行计算技巧对于加速数据处理和分析至关重要。

密度聚类算法的原理

密度聚类算法的原理

密度聚类算法的原理基于样本点的密度来进行聚类。

该算法将密度高的样本点作为簇的核心,然后逐渐将密度相邻的样本点加入到簇中,最终形成具有足够密度的簇。

算法步骤如下:

1. 初始化:设定半径r和最小样本点数目minPts作为聚类的

参数,设置未访问标记和簇标记。

2. 选择一个未访问的样本点p,找到其未访问的邻域中的所有

样本点。

3. 如果邻域中的样本点数目大于等于minPts,则将p设定为核心样本点,并将其邻域中的样本点加入簇中。

4. 对簇中的样本点进行进一步的密度可达判断,即对簇中样本点的邻域进行递归访问,将密度可达的样本点加入簇中。

5. 在所有的样本点都被访问过之前,重复2-4步骤。

6. 最终得到一些具有足够密度的簇,并且将那些被访问但不满足成为核心样本点的样本点判定为噪声点或者边界点。

密度聚类算法的核心思想是通过样本点的密度来区分不同的簇,并且能够处理具有不同形状和密度的数据集。

基于密度的聚类算法和基于欧式距离的算法

基于密度的聚类算法和基于欧式距离的算法在数据挖掘和模式识别领域中扮演着重要的角色。

两种算法都有其独特的优势和适用场景,在实际应用中得到了广泛的应用和研究。

为了深入了解这两种算法的原理和应用,本文将对基于密度的聚类算法和基于欧式距离的算法进行详细的介绍和比较。

1. 基于密度的聚类算法基于密度的聚类算法是一种能够发现任意形状的聚类簇的算法。

该算法通过计算数据点周围的密度来确定是否属于同一个聚类簇,而不需要预先指定聚类簇的个数。

其中最具代表性的算法是DBSCAN算法。

DBSCAN算法是一种基于密度的聚类算法,它通过定义领域内的最小点数和邻域半径来识别核心对象和边界对象,从而识别出聚类簇。

DBSCAN算法对噪声点具有较强的鲁棒性,能够有效处理不同密度和大小的聚类簇,因此在实际应用中得到了广泛的应用。

2. 基于欧式距离的算法基于欧式距离的算法是一种常用的聚类算法,它通过计算数据点之间的距离来确定聚类簇。

其中最常用的算法是K均值算法。

K均值算法首先需要指定聚类簇的个数,然后通过迭代优化的方式,将数据点分配到最近的聚类中心,并更新聚类中心的位置,直至收敛为止。

K均值算法具有较好的可解释性和计算效率,在处理大规模数据时表现出较好的性能。

3. 比较与应用基于密度的聚类算法和基于欧式距离的算法在不同的应用场景中有着各自的优势和局限性。

基于密度的聚类算法适用于处理任意形状和密度分布的聚类簇,对数据的分布不敏感,能够有效处理噪声和离裙点,但是对于高维数据和大规模数据的计算复杂度较高。

而基于欧式距离的算法适用于处理高维数据和大规模数据,具有较好的可解释性和计算效率,但是对于非凸形状和不同密度分布的聚类簇处理能力较弱。

在实际应用中,可以根据数据的特点和应用需求来选择合适的聚类算法。

如果需要处理非凸形状和不同密度分布的聚类簇,可以选择基于密度的聚类算法,如DBSCAN算法。

如果需要处理高维数据和大规模数据,可以选择基于欧式距离的算法,如K均值算法。

基于Spark的并行DBSCAN算法的设计与实现

第44卷第11A期2017年11月计算机科学COMPUTER SCIENCEVol.44 No. 11ANov.2017基于Spark的并行DBSCAN算法的设计与实现黄明吉张倩(北京科技大学机械工程学院北京100083)摘要随着云应用对运行时间和性能水平要求的逐步提高,以及内存价格的持续走低,基于内存的分布式计算框架S p a rk获得了前所未有的关注。

主要研究D B S C A N算法在S p a rk上并行化的设计与实现,通过整体分析找到算法并行化可能的性能瓶颈,并从S p a rk的角度设计了并行D B S C A N算法的D A G图,优化了算法的并行化策略,最大化地 降低了s h u ffle频率和数据量。

最后将并行D B S C A N算法与单机D B S C A N算法进行性能对比,并通过实验分析不同 参数对聚类结果的影响。

结果表明,与单机D B S C A N算法相比,基于S p a rk的并行D B S C A N算法在聚类精度没有明显损失的情况下,数据量在3百万行时运行效率提高了37. 2%,且加速比达到1.6。

关键词S p a rk,并行D B S C A N算法,D A G,并行化策略中图法分类号T P301.6文献标识码ADesign and Implementation of Parallel DBSCAN Algorithm Based on SparkH U A N G M in g-ji Z H A N G Q ian(School of Mechanical Engineering,University of Science and Technology Beijing,Beijing 100083,China)Abstract W ith the cloud a pplication req u irin g less ru n n in g tim e and h ig h e r perform ance as w e ll as m em ory prices contin u in g to decline, the technology o f m em ory-based d is trib u te d com puting fra m e w o rk, such as S park, has received unprecedented a tte n tio n and is w id e ly applied. W e designed and im plem ented parallelized D B S C A N a lg o rith m based on S park, w h ich can m inim ize the sh u ffle frequency and the data am ount in shuffle. In o rder to optimize the algorithm paralle liz a tio n strate g y, we found the b o ttleneck o f a lg o rith m perform ance th ro u g h the analysis and described the D A G o f p a rallel D B S C A N a lg o rith m based on Spark. F in a lly,w e compared the perform ance o f p a rallel D B S C A N a lg o rith m w ith the D B S C A N a lg o rith m, and analyzed the influence o f d iffe re n t param eters on clustering results. E xp e rim e n ta l results show th a t, compared w ith D B S C A N a lg o rith m,th e ru n n in g tim e o f p a rallel D B S C A N a lg o rith m based on Spark decreases 37. 2%and the speedup reaches 1. 6 respectively on a data set containing three m illio n lines w ith o u t obvious loss o f clu ste rin g accuracy.Keywords S p a rk,P arallel D B S C A N a lg o rith m,D A G,P a rallelization strategy1引言聚类分析作为数据挖掘的核心技术之一,是人工智能和 机器学习领域的研究热点。

基于Spark的系统的设计与实现

为了在Spark上处理这些数据,我们需要将其加载到分布式数据结构中。在 Spark中,我们可以使用Spark SQL或者DataFrame API来处理数据。对于电影数 据集,我们可以使用以下代码将其加载到DataFrame中:

kotlin

val spark = SparkSession.builder.appName("RecommenderSystem").getOrCreate()

val evaluator = new RegressionEvaluator()

.setMetricName("rmse")

.setLabelCol("rating")

.setPredictionCol("prediction") val rmse = evaluator.evaluate(predictions)

val sortedPredictions = allPredictions.sort("prediction".desc).limit(10)

// Extract the userID and recommended movieID for top 10 predictions

val recommendations = sortedPredictions.

val evaluator = new RegressionEvaluator()

.setMetricName("rmse")

.setLabelCol("rating")

.setPredictionCol("prediction") val rmse = evaluator.evaluate(predictions)

《基于密度聚类算法的研究与改进》范文

《基于密度聚类算法的研究与改进》篇一一、引言随着大数据时代的到来,数据挖掘和数据分析技术得到了广泛的应用。

其中,聚类算法作为无监督学习的重要分支,被广泛应用于各种领域。

密度聚类算法是聚类算法中的一种,其基本思想是将数据空间划分为不同的密度区域,并通过高密度区域进行聚类。

本文旨在研究密度聚类算法的基本原理和实现方法,并提出相应的改进措施。

二、密度聚类算法的基本原理和实现方法2.1 基本原理密度聚类算法是一种基于密度的聚类方法,其基本思想是将数据空间划分为不同的密度区域,并通过高密度区域进行聚类。

该算法通过计算每个点的局部密度来确定其所属的聚类,并利用密度连通性来形成最终的聚类结果。

2.2 实现方法密度聚类算法的实现过程主要包括以下几个步骤:(1)计算每个点的局部密度;(2)根据局部密度确定每个点的邻域范围;(3)通过密度连通性将高密度区域连接起来形成聚类;(4)对形成的聚类进行后处理,如去除噪声点、合并小聚类等。

三、密度聚类算法的改进措施3.1 优化局部密度的计算方法局部密度的计算是密度聚类算法的关键步骤之一。

传统的局部密度计算方法往往只考虑了点的局部邻域内的密度信息,忽略了全局信息。

因此,我们可以采用基于全局信息的局部密度计算方法,如基于核密度的局部密度计算方法,以提高聚类的准确性和鲁棒性。

3.2 引入空间约束条件传统的密度聚类算法往往只考虑了数据点的密度信息,而忽略了空间约束条件。

因此,我们可以在算法中引入空间约束条件,如利用空间距离信息来调整局部密度的计算方法和邻域范围的确定等,以提高聚类的准确性和可解释性。

3.3 结合其他聚类算法的优点不同的聚类算法有其各自的优点和适用场景。

因此,我们可以将密度聚类算法与其他聚类算法相结合,如结合层次聚类、谱聚类等算法的优点,形成混合聚类算法,以提高聚类的效果和鲁棒性。

四、实验与分析为了验证上述改进措施的有效性,我们进行了实验分析。

实验结果表明,优化局部密度的计算方法、引入空间约束条件和结合其他聚类算法的优点等方法都可以有效地提高密度聚类算法的准确性和鲁棒性。

基于Spark的大数据聚类研究及系统实现

基于Spark的大数据聚类研究及系统实现王磊;邹恩岑;曾诚;奚雪峰;陆悠【摘要】传统聚类算法由于单机内存和运算能力的限制已经不能满足当前大数据处理的要求,因而迫切需要寻找新的解决方法.针对单机内存运算问题,结合聚类算法的迭代计算特点,提出并实现了一种基于Spark平台的聚类系统.针对稀疏集和密集集两种不同类型的数据集,系统首先采用不同策略实现数据预处理;其次分析比较了不同聚类算法在Spark平台下的聚类性能,并给出最佳方案;最后利用数据持久化技术提高了计算速度.实验结果表明,所提系统能够有效满足海量数据聚类分析的任务要求.【期刊名称】《数据采集与处理》【年(卷),期】2018(033)006【总页数】9页(P1077-1085)【关键词】Spark;聚类;大数据【作者】王磊;邹恩岑;曾诚;奚雪峰;陆悠【作者单位】苏州科技大学电子与信息工程学院 ,苏州 ,215009;苏州市虚拟现实智能交互及应用技术重点实验室 ,苏州 , 215009;苏州科技大学普开大数据重点实验室 ,苏州 ,215009;苏州科技大学电子与信息工程学院 ,苏州 ,215009;苏州市虚拟现实智能交互及应用技术重点实验室 ,苏州 , 215009;苏州科技大学普开大数据重点实验室 ,苏州 ,215009;昆山市公安局指挥中心 ,苏州 ,215300;苏州科技大学电子与信息工程学院 ,苏州 ,215009;苏州市虚拟现实智能交互及应用技术重点实验室 ,苏州 , 215009;苏州科技大学普开大数据重点实验室 ,苏州 ,215009;苏州科技大学电子与信息工程学院 ,苏州 ,215009;苏州市虚拟现实智能交互及应用技术重点实验室 ,苏州 , 215009;苏州科技大学普开大数据重点实验室 ,苏州 ,215009【正文语种】中文【中图分类】TP391引言聚类是数据挖掘研究的重要方法之一。

大数据聚类能有效支撑如客户群细分、文本主题发现和信息检索等大量实际应用[1]。

基于密度的聚类算法

基于密度的聚类算法

密度聚类算法是一种基于数据密度的聚类方法,主要特点是将数据点结合成聚类,旨在从数据集中查找最相近的点。

不同于传统的聚类算法,它更加侧重于计算空间内点的密度,而不是向量空间的距离。

密度聚类有很多类型,其中著名的算法有:DBSCAN(支持度基因聚类)、OPTICS(离散点优化视觉)以及DENCLUE (离散时间处理)等。

DBSCAN算法是一种基于密度的算法,它建立在空间数据点分布上,结合两个参数即半径(eps)和聚类最小数目(minPoints)来形成聚类。

它做的是,首先通过设定一个半径eps,将不同的点连接起来,组成相互之间距离小于eps的点构成一个新的聚类簇,然后将这些特征点的聚类扩大,直到形成一个稳定的聚类。

这就是DBSCAN算法。

而OPTICS算法则是基于密度的另一种聚类算法,它能够通过使用一个可变的半径来构建密度梯度,将离散点根据密度进行排序,并计算点间的可达距离。

根据密度梯度,它可以更好地分割空间中的离散点,并捕获出数据集中斑点和噪音的细节,从而得到比DBSCAN更具有有效性的结果。

最后,DENCLUE算法的主要思想是将数据由时间轴上的离散分布抽象出来,使用一个可变的高斯函数来计算每个点的密度,该可变半径适应于空间密度的可变程度,能够选择合适的结构来描述每个离散点,从而获取更好的聚类效果。

总而言之,基于密度的聚类算法是一种比较精准的聚类方法,通过设定半径和点的最小数目来形成聚类,从而使得空间中的点更加清晰准确的被整合在一起。

密度峰值聚类算法的研究与改进

密度峰值聚类算法的研究与改进密度峰值聚类算法的研究与改进摘要:随着大数据时代的到来,聚类算法在数据挖掘、机器学习等领域中扮演着重要的角色。

密度峰值聚类算法是一种基于数据点之间密度关系的聚类方法,通过寻找数据集中的密度峰值点来实现聚类。

本文对密度峰值聚类算法进行了详细研究,并提出了相应的改进方法。

1. 引言聚类是一种无监督学习方法,其目标在于发现数据集中相似的样本并将其分组。

聚类算法在数据挖掘、图像处理、生物信息学等领域中有着广泛的应用。

密度峰值聚类算法是近年来提出的一种新兴的聚类方法,与传统的基于距离度量的聚类算法有所不同,它主要通过对数据点之间的密度关系进行分析,来确定数据集中的聚类情况。

2. 密度峰值聚类算法原理密度峰值聚类算法主要有以下几个步骤:(1)计算每个数据点的局部密度,即该数据点周围一定半径范围内的数据点个数。

(2)对所有数据点按照局部密度进行降序排序。

(3)选择合适的邻域范围和密度阈值,判断每个数据点是否是一个峰值点。

(4)从峰值点出发,寻找局部密度更高的数据点,并逐步扩展聚类簇。

(5)将未分配到任何聚类簇的数据点标记为噪声点。

3. 密度峰值聚类算法的改进方法尽管密度峰值聚类算法在原理上很有吸引力,但在实际应用中也存在一些问题。

为了解决这些问题,我们提出以下改进方法:(1)调整邻域范围和密度阈值:在密度峰值聚类算法中,邻域范围和密度阈值是两个重要的参数。

我们可以通过交叉验证等方法,选择合适的邻域范围和密度阈值,以获得更好的聚类结果。

(2)考虑噪声点的处理:在原始的密度峰值聚类算法中,未分配到任何聚类簇的数据点会被标记为噪声点。

我们可以对这些噪声点进行二次聚类,或者利用密度峰值聚类算法分析其密度峰值情况,并将其重新分配到合适的聚类簇中。

(3)优化算法效率:密度峰值聚类算法的时间复杂度较高,通常需要较长的运行时间。

我们可以通过采用并行计算、优化数据结构等方法,提高算法的效率。

4. 实验与分析我们在多个数据集上进行了实验,比较了原始的密度峰值聚类算法和改进后的算法在聚类质量和运行时间上的差异。

Spark大数据处理架构设计与实践经验分享

Spark大数据处理架构设计与实践经验分享随着大数据时代的到来,对于数据处理和分析的需求日益增长。

传统的数据处理方式已经难以满足大规模数据的处理需求。

在这个背景下,Apache Spark的出现为大数据处理带来了全新的解决方案。

本文将分享Spark大数据处理架构设计和实践经验,探讨如何充分发挥Spark的优势进行高效的大数据处理。

首先,我们将介绍Spark的架构设计。

Spark采用了分布式的内存计算模型,通过将数据存储在内存中进行计算,大大提高了计算性能。

Spark的核心是弹性分布式数据集(RDD),RDD是一个容错的、可并行化的数据结构,能够在集群中进行分布式计算。

Spark的计算模型是基于RDD的转换(Transformation)和行动(Action)操作,通过一系列的转换操作构建数据处理的流程,最后触发行动操作执行计算。

其次,我们将分享Spark的实践经验。

在实际的大数据处理项目中,我们需要考虑以下几个方面。

首先是数据的预处理和清洗,包括数据的清理、转换和过滤等操作,以保证数据的准确性和一致性。

其次是合理的数据分区和调度策略,以避免数据倾斜和计算节点的负载不均衡问题。

此外,我们还需要充分利用Spark的并行计算能力,通过合理的并行化操作将计算任务分解为多个子任务并行执行,提高数据处理的效率。

最后是结果的输出和可视化,我们可以使用Spark的输出操作将处理结果保存到文件系统或者数据库中,并通过可视化工具展示结果,帮助我们更好地理解和分析数据。

此外,值得注意的是,Spark还支持多种数据处理引擎和编程语言,如Spark SQL、Spark Streaming、Spark MLlib等,可以根据具体的需求选择合适的引擎和语言进行数据处理。

在实践中,我们需要根据项目的具体要求选择合适的组件和工具来搭建Spark的架构,以满足不同数据处理场景的需求。

在实际的大数据处理项目中,我们还需要考虑数据安全和隐私保护的问题。

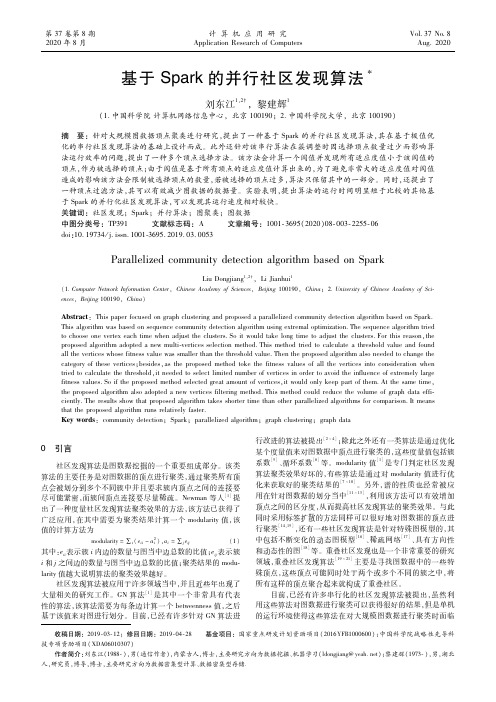

基于Spark的并行社区发现算法

收稿日期:2019 03 12;修回日期:2019 04 28 基金项目:国家重点研发计划资助项目(2016YFB1000600);中国科学院战略性先导科技专项资肋项目(XDA06010307)作者简介:刘东江(1988 ),男(通信作者),内蒙古人,博士,主要研究方向为数据挖掘、机器学习(ldongjiang@yeah.net);黎建辉(1973 ),男,湖北人,研究员,博导,博士,主要研究方向为数据密集型计算、数据密集型存储.基于Spark的并行社区发现算法刘东江1,2,黎建辉1(1.中国科学院计算机网络信息中心,北京100190;2.中国科学院大学,北京100190)摘 要:针对大规模图数据顶点聚类进行研究,提出了一种基于Spark的并行社区发现算法,其在基于极值优化的串行社区发现算法的基础上设计而成。

此外还针对该串行算法在簇调整时因选择顶点数量过少而影响算法运行效率的问题,提出了一种多个顶点选择方法。

该方法会计算一个阈值并发现所有适应度值小于该阈值的顶点,作为被选择的顶点;由于阈值是基于所有顶点的适应度值计算出来的,为了避免非常大的适应度值对阈值造成的影响该方法会限制被选择顶点的数量,若被选择的顶点过多,算法只保留其中的一部分。

同时,还提出了一种顶点过滤方法,其可以有效减少图数据的数据量。

实验表明,提出算法的运行时间明显短于比较的其他基于Spark的并行化社区发现算法,可以发现其运行速度相对较快。

关键词:社区发现;Spark;并行算法;图聚类;图数据中图分类号:TP391 文献标志码:A 文章编号:1001 3695(2020)08 003 2255 06doi:10.19734/j.issn.1001 3695.2019.03.0053ParallelizedcommunitydetectionalgorithmbasedonSparkLiuDongjiang1,2 ,LiJianhui1(1.ComputerNetworkInformationCenter,ChineseAcademyofSciences,Beijing100190,China;2.UniversityofChineseAcademyofSci ences,Beijing100190,China)Abstract:ThispaperfocusedongraphclusteringandproposedaparallelizedcommunitydetectionalgorithmbasedonSpark.Thisalgorithmwasbasedonsequencecommunitydetectionalgorithmusingextremaloptimization.Thesequencealgorithmtriedtochooseonevertexeachtimewhenadjusttheclusters.Soitwouldtakelongtimetoadjusttheclusters.Forthisreason,theproposedalgorithmadoptedanewmulti verticesselectionmethod.Thismethodtriedtocalculateathresholdvalueandfoundalltheverticeswhosefitnessvaluewassmallerthanthethresholdvalue.Thentheproposedalgorithmalsoneededtochangethecategoryofthesevertices;besides,astheproposedmethodtokethefitnessvaluesofalltheverticesintoconsiderationwhentriedtocalculatethethreshold,itneededtoselectlimitednumberofverticesinordertoavoidtheinfluenceofextremelylargefitnessvalues.Soiftheproposedmethodselectedgreatamountofvertices,itwouldonlykeeppartofthem.Atthesametime,theproposedalgorithmalsoadoptedanewverticesfilteringmethod.Thismethodcouldreducethevolumeofgraphdataeffi ciently.Theresultsshowthatproposedalgorithmtakesshortertimethanotherparallelizedalgorithmsforcomparison.Itmeansthattheproposedalgorithmrunsrelativelyfaster.Keywords:communitydetection;Spark;parallelizedalgorithm;graphclustering;graphdata0 引言社区发现算法是图数据挖掘的一个重要组成部分。

spark的原理及应用实验总结

Spark的原理及应用实验总结引言Spark是一种快速、通用、可扩展的大数据处理框架,它集成了分布式计算、数据处理和机器学习等功能。

Spark的出现极大地提高了大数据处理的效率和便捷性。

本文将介绍Spark的原理及应用实验总结。

Spark的原理1.Spark的分布式计算模型–Spark采用了基于内存的计算模型,将数据存储在内存中,提高了数据处理速度。

–Spark使用弹性分布式数据集(Resilient Distributed Datasets,RDD)作为基本数据结构,RDD是一个可分区、可并行操作的不可变集合。

–Spark利用RDD的特点将数据分区并并行处理,从而实现高效的分布式计算。

2.Spark的计算引擎–Spark采用了DAG(Directed Acyclic Graph,有向无环图)作为计算引擎,将数据处理过程抽象为一系列有向无环图的操作。

–这些操作通过依赖关系构建成DAG图,并根据依赖关系调度任务的执行顺序。

–Spark的计算引擎可以智能地优化任务的执行,提高计算效率。

3.Spark的容错性–Spark具有很高的容错性,通过将RDD分区复制到多个节点上实现数据冗余备份。

–当节点发生故障时,Spark可以自动恢复计算,并从备份节点上重新加载丢失的数据。

–Spark还可以利用容错性将计算过程中产生的中间结果保存在内存中,提高计算速度。

4.Spark的数据传输方式–Spark支持多种数据传输方式,包括内存传输、磁盘传输和网络传输。

–在数据处理过程中,Spark会根据数据的大小和调度策略选择合适的传输方式。

–Spark还支持数据压缩和序列化技术,以降低数据传输的网络带宽和存储空间占用。

Spark的应用实验总结1.实验1:WordCount–通过使用Spark编写WordCount程序,实现对文本数据中单词出现次数的统计。

–使用Spark的RDD操作,将文本数据分割为单词并生成键值对,然后使用reduceByKey函数进行统计。

基于Spark大数据平台的并行处理技术研究

基于Spark大数据平台的并行处理技术研究随着信息技术的不断发展,数据量也呈现出指数级的增长。

传统的单机处理方式已无法满足海量数据处理的需求。

解决这一问题的办法之一就是使用分布式计算框架,其中Spark是近年来备受关注的一款大数据处理框架。

本文将围绕基于Spark大数据平台的并行处理技术展开讨论。

一、Spark简介Spark是一款基于内存的分布式计算框架,它的目标是提供高性能、易用性和灵活性。

Spark最初是由加州大学伯克利分校AMPLab开发的,它的出现解决了Hadoop处理速度慢、无法实时处理等问题。

相比于Hadoop,Spark的主要优势在于内存计算和更好的处理复杂算法的能力。

另外,Spark还支持多种编程语言,包括Scala、Java、Python和R等,可以满足不同的应用需求。

二、Spark的并行处理机制Spark的并行处理机制主要包括两个部分:RDD和Task。

1. RDDRDD全称为Resilient Distributed Datasets,它是Spark的核心抽象。

RDD是一个可分区的、不可变的数据集合,每个RDD被分成多个分区(Partition),每个Partition在不同的计算节点上进行处理,从而实现并行处理。

RDD的不可变性指的是RDD中的数据内容是只读的,一旦创建后就不可以修改。

同时,RDD是弹性的,也就是说,如果由于节点或任务的失败导致RDD分区数据丢失,Spark可以快速地从一个可靠的存储器中(如HDFS)重新计算丢失的数据,保证数据的一致性和可靠性。

2. TaskTask指的是将被运行在RDD上的操作。

在Spark任务调度的过程中,相同RDD的数据会被分成多个Partition,每个Partition被分配给一个计算节点进行处理,任务调度器会将一批任务发送到每个计算节点上。

每个计算节点会接收到一组数据,组织起来执行任务。

执行任务的结果会写入到内存中或者持久化到磁盘上。

Spark技术在金融领域的应用案例研究

Spark技术在金融领域的应用案例研究引言:近年来,随着大数据技术的快速发展,Spark作为一种分布式计算框架,在金融领域的应用呈现出快速增长的趋势。

本文将以案例的形式探讨Spark技术在金融领域中的应用,分析其优势和具体应用方式。

案例一:实时欺诈检测实时欺诈检测是金融行业中的重要任务,通过Spark技术,可以实现对金融交易数据的实时处理和分析。

例如,某银行使用Spark构建了一个实时欺诈检测系统。

系统接收大量的交易数据,并使用Spark Streaming进行实时处理。

Spark Streaming将数据流分成微批次,每个微批次的数据进行分析和模型计算。

通过使用Spark的机器学习库MLlib,可以训练欺诈检测模型,并将其部署于实时流数据分析中。

该案例中使用Spark技术,能够高效地处理大规模交易数据,并快速检测出潜在的欺诈交易。

案例二:金融风控模型金融风控模型是保证金融机构稳定运行的关键要素之一。

Spark MLlib提供了丰富的机器学习算法,可以用于构建和训练金融风控模型。

例如,某证券公司使用Spark技术构建了一个用于客户风险评估的预测模型。

该模型基于大量的历史交易数据,通过Spark的机器学习算法,分析客户的交易特征,预测潜在的风险。

通过这个案例,我们可以看到Spark技术在金融风控领域的应用可以提供更准确、更高效的风险评估和监控。

案例三:金融市场数据分析金融市场数据分析是金融机构进行投资决策和风险控制的重要环节。

Spark的分布式计算能力使得大规模金融市场数据的分析成为可能。

例如,某投资公司使用Spark技术进行大规模金融数据的处理和分析。

通过构建Spark应用,对市场数据进行实时监测,并进行聚类、分类和预测等分析操作。

Spark的强大计算能力和灵活性使得该公司能够更准确地分析市场趋势,制定更科学的投资策略。

案例四:金融业务运营优化金融机构通过Spark技术可以优化其业务运营。

例如,某银行使用Spark构建了一个实时交易监控系统。

基于Spark的大数据机器学习模型构建与部署实践

基于Spark的大数据机器学习模型构建与部署实践随着互联网技术和数据量的快速发展,大数据机器学习逐渐成为数据科学领域的重要研究方向。

大数据机器学习模型的构建和部署是实现数据智能化应用的关键步骤之一。

本文将介绍基于Spark的大数据机器学习模型构建与部署的实践方法和注意事项。

首先,我们需要了解什么是Spark。

Spark是一个开源的分布式计算框架,它提供了高效的数据处理和分析能力,支持并行化计算,适用于处理大规模数据集。

Spark中的机器学习库MLlib提供了丰富的机器学习算法和工具,可以帮助我们快速构建和训练机器学习模型。

在进行大数据机器学习模型构建之前,我们需要准备好数据。

通常情况下,大数据集会以分布式存储的形式存在,如Hadoop分布式文件系统(HDFS)或云存储服务。

我们需要将数据加载到Spark的数据结构中,如Resilient Distributed Datasets(RDDs)或DataFrame。

加载数据时,我们可以根据业务需求进行数据清洗、转换和特征提取等预处理操作,以便更好地适应机器学习算法的训练要求。

在数据准备完毕后,我们可以选择合适的机器学习算法进行模型构建。

Spark的MLlib库提供了常见的机器学习算法,包括分类、回归、聚类和推荐等。

我们可以根据具体任务需求选择适合的算法,并使用Spark提供的API进行模型训练和参数调优。

在模型训练过程中,我们可以利用Spark的分布式计算能力,将工作负载分配到多台计算节点上,加速训练过程并提高模型的准确性。

完成模型训练后,我们需要对模型进行评估和验证。

Spark提供了一系列的模型评估指标,如准确率、召回率、F1值等,可以帮助我们评估模型的性能。

此外,我们还可以使用交叉验证等技术来验证模型的泛化能力和稳定性。

完成模型评估后,我们可以将模型部署到生产环境中。

在Spark中,我们可以使用Spark的分布式计算框架来部署模型。

通常情况下,我们会将模型封装为可执行的应用程序,以便在分布式集群上进行批处理或实时预测。

Spark大数据技术的基本原理及应用案例分析

Spark大数据技术的基本原理及应用案例分析概述:在今天的信息时代,大数据已成为各个行业公司应对业务需求的重要资源。

而Spark作为一种分布式计算框架,以其高性能和灵活性而备受关注。

本文将探讨Spark大数据技术的基本原理以及其在不同应用案例中的应用。

一、Spark的基本原理:1.1 分布式计算模型Spark采用了基于内存的分布式计算模型,其核心思想是将数据分为多个部分,分配到不同的节点上进行并行计算。

这种模型允许Spark在内存中保存和共享数据,从而提高计算速度。

1.2 弹性分布式数据集(RDD)RDD是Spark的核心数据抽象,它是一个可分区、可并行操作的数据集合。

RDD具备高容错性,可以在计算节点之间进行自动恢复。

此外,RDD还支持多种操作,如转换和动作,以实现各种大数据处理需求。

1.3 DAG执行引擎Spark采用了DAG(有向无环图)执行引擎,通过将任务划分为多个阶段,并在不同的节点上执行这些阶段,以实现任务的并行计算。

DAG执行引擎为Spark提供了高效的任务调度和资源管理。

二、Spark在应用案例中的应用:2.1 批处理任务Spark可以处理大规模的批处理任务,例如数据清洗、转换和分析。

通过对数据进行RDD转换和动作操作,我们可以高效地处理大规模数据集。

案例:某电商公司需要对大量订单数据进行清洗和分析。

使用Spark进行批处理任务,可以快速清洗掉无效数据,并运行复杂的分析算法,从而为公司提供准确的业务洞察。

2.2 实时流处理Spark也可以进行实时流处理,通过将数据流划分为小的批次并在内存中处理,使得实时计算速度得到极大提升。

案例:金融行业中的实时风险管理,利用Spark可以快速处理和分析市场数据,捕捉潜在风险。

通过实时计算和模型预测,从而高效提供金融机构的风险控制决策。

2.3 机器学习任务Spark提供了丰富的机器学习算法库,可以进行分布式的机器学习任务。

Spark的机器学习库支持常见的机器学习算法,如分类、聚类和推荐等。

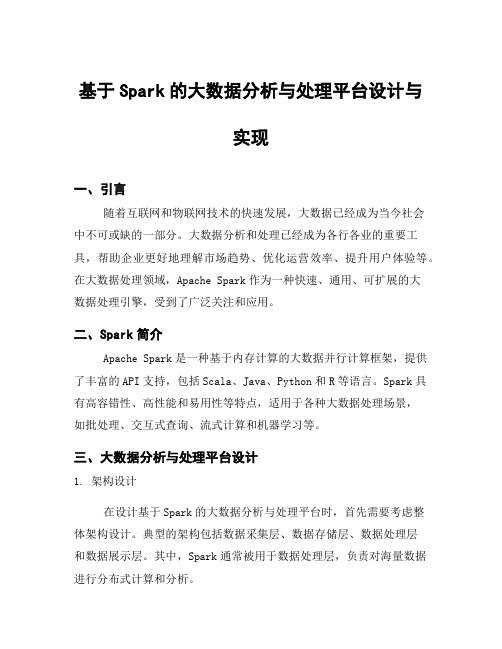

基于Spark的大数据分析与处理平台设计与实现

基于Spark的大数据分析与处理平台设计与实现一、引言随着互联网和物联网技术的快速发展,大数据已经成为当今社会中不可或缺的一部分。

大数据分析和处理已经成为各行各业的重要工具,帮助企业更好地理解市场趋势、优化运营效率、提升用户体验等。

在大数据处理领域,Apache Spark作为一种快速、通用、可扩展的大数据处理引擎,受到了广泛关注和应用。

二、Spark简介Apache Spark是一种基于内存计算的大数据并行计算框架,提供了丰富的API支持,包括Scala、Java、Python和R等语言。

Spark具有高容错性、高性能和易用性等特点,适用于各种大数据处理场景,如批处理、交互式查询、流式计算和机器学习等。

三、大数据分析与处理平台设计1. 架构设计在设计基于Spark的大数据分析与处理平台时,首先需要考虑整体架构设计。

典型的架构包括数据采集层、数据存储层、数据处理层和数据展示层。

其中,Spark通常被用于数据处理层,负责对海量数据进行分布式计算和分析。

2. 数据采集与清洗在构建大数据平台时,数据采集和清洗是至关重要的环节。

通过各种方式采集结构化和非结构化数据,并对数据进行清洗和预处理,以确保数据质量和准确性。

3. 数据存储与管理针对不同的业务需求,可以选择合适的数据存储方案,如HDFS、HBase、Cassandra等。

同时,需要考虑数据的备份、恢复和安全性等问题。

4. 数据处理与分析Spark提供了丰富的API和库,如Spark SQL、Spark Streaming、MLlib等,可以支持各种复杂的数据处理和分析任务。

通过编写Spark应用程序,可以实现对海量数据的实时处理和分析。

5. 数据展示与可视化为了更直观地展示分析结果,可以利用可视化工具如Tableau、Power BI等,将分析结果以图表或报表的形式展示给用户,帮助他们更好地理解数据。

四、平台实现步骤1. 环境搭建在搭建基于Spark的大数据平台之前,需要准备好相应的硬件设施和软件环境,包括服务器集群、操作系统、JDK、Hadoop等。

2022-3 大数据分析师(初级)考前冲刺题A1卷

信息素养培训平台2022.3 大数据分析师(初级)考前冲刺题A1卷1.【单选题】下面关于MapReduce任务描述不正确的是()。

A:不同的Map任务之间不会进行通信B:不同的Reduce任务之间也不会发生任何信息交换C:Map需要考虑数据全局性D:用户不能显式地从一台机器向另一台机器发送消息正确答案:C答案解析:在MapReduce工作工作中: 不同的Map任务之间不会进行通信。

不同的Reduce任务之间也不会发生任何信息交换。

Map需要考虑数据局部性,Reduce无需考虑数据局部性。

用户不能显式地从一台机器向另一台机器发送消息。

所有的数据交换都是通过MapReduce框架自身去实现的。

2.【单选题】下列不适用于大数据图计算的产品是()。

A:GraphXB:PregelC:FlumeD:PowerGraph正确答案:C答案解析:Flume是实时采集工具。

3.【单选题】利用Sqoop进行数据同步描述错误的是()。

A:将关系数据库数据导入HDFSB:将关系数据库数据导入HiveC:将关系数据库数据导入HBaseD:将HDFS数据导入Hive正确答案:D答案解析:Sqoop是一款开源的工具,主要用于在Hadoop与传统的关系数据库间进行数据的传递4.【单选题】散点图用于展示数据的相关性和分布关系,由X轴和Y轴两个变量组成。

通过因变量(Y轴数值)随自变量(X轴数值)变化的呈现数据的大致趋势,同时支持从类别和颜色两个维度观察数据的分布情况。

散点图支持()坐标系。

A:一维B:二维C:三维D:四维正确答案:B答案解析:散点图用于描述二维数据之间的关系。

5.【单选题】下列属于图形数据库的是()。

A:HBaseB:MongoDBC:Neo4JD:Oracle正确答案:C答案解析:图数据库的相关产品包括:Neo4J、OrientDB、InfoGrid、GraphDB等。

6.【单选题】哪种图形用于表示三维数据()。

大数据环境下的密度聚类算法

大数据环境下的密度聚类算法在大数据环境下,密度聚类算法是一种用于发现高密度数据区域的有效工具。

密度聚类算法基于数据点之间的密度,将数据点划分为不同的簇,每个簇内的数据点相对密集而簇间的数据点相对稀疏。

本文将介绍几种常用的大数据环境下的密度聚类算法,包括DBSCAN、OPTICS和HDBSCAN。

一、DBSCAN算法(Density-Based Spatial Clustering of Applications with Noise)DBSCAN算法是一种基于密度的聚类算法,它通过确定数据点的密度来划分簇。

它的核心思想是,对于每个数据点,如果其邻域内的数据点数量大于等于事先指定的阈值,则将其归为一个簇。

而不满足这个条件的数据点将被视为噪声或边界点。

DBSCAN算法的优点在于可以发现任意形状的簇,对噪声和离群点具有一定的鲁棒性。

然而,在处理大规模数据时,DBSCAN算法的效率较低。

二、OPTICS算法(Ordering Points To Identify the Clustering Structure)OPTICS算法是一种改进的密度聚类算法,它通过构建一个数据点的可及性图来发现簇结构。

可及性图中的X轴表示数据点排序,Y轴表示数据点的核心距离,通过分析可及性图,可以确定簇的边界和样本点的密度。

OPTICS算法的优点在于可以发现任意形状的簇,并且不需要预先指定阈值。

然而,对于具有高维数据和大规模数据的情况下,OPTICS算法的效率也不够高。

三、HDBSCAN算法(Hierarchical Density-Based Spatial Clusteringof Applications with Noise)HDBSCAN算法是一种层次化的密度聚类算法,它通过构建一棵树状结构来发现数据的聚类结构。

HDBSCAN算法可以自动识别不同密度级别的簇,并将数据点分配到合适的簇中。

HDBSCAN算法的优点在于可以处理任意形状的簇,并且自动确定簇的个数。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

收稿日期:2017-07-10 修回日期:2017-11-15 网络出版时间:2018-02-24基金项目:国家自然科学基金(61302158,61571238)作者简介:朱子龙(1991-),男,硕士研究生,研究方向为数据挖掘;李玲娟,教授,研究方向为数据挖掘㊁信息安全㊁分布式计算㊂网络出版地址:http :// /kcms /detail /61.1450.TP.20180224.1521.068.html基于Spark 的密度聚类算法并行化研究朱子龙,李玲娟(南京邮电大学计算机学院,江苏南京210023)摘 要:聚类分析目前是数据挖掘研究领域中热门的研究课题,DBSCAN 算法则是聚类分析中较为重要的一种基于密度的算法㊂Apache Spark 扩展了广泛使用的MapReduce 计算模型,提出了基于内存的并行计算框架㊂通过将中间结果缓存在内存中减少I /O 磁盘操作,使其能够更高效地支持交互式查询㊁迭代式计算等多种计算模式㊂为了更好地进行大数据聚类挖掘,研究如何对基于当今主流的大数据处理框架Spark 对DBSCAN 算法进行并行化㊂设计了基于Spark 的DBSCAN 算法并行化方案,通过合理利用RDD 和设计Sample 算子㊁map 函数㊁collectAsMap 算子㊁reduceByKey 算子,实现了对寻找核心对象的密度可达数据点过程的并行化㊂在Spark 平台上运用DBSCAN 算法对UCI 的Wine 数据集㊁Car Evaluation 数据集和Adult 数据集的并行化聚类结果表明,并行化的DBSCAN 算法具有较好的准确性和时效性,适用于大数据聚类㊂关键词:DBSCAN;聚类;Spark;并行化中图分类号:TP301.6 文献标识码:A 文章编号:1673-629X (2018)06-0080-05doi:10.3969/j.issn.1673-629X.2018.06.018Research on Parallelization of Density ClusteringAlgorithm Based on SparkZHU Zi -long ,LI Ling -juan(School of Computer Science ,Nanjing University of Posts and Telecommunications ,Nanjing 210023,China )Abstract :Clustering analysis is currently a hot research topic in data mining ,and DBSCAN algorithm is a density -based algorithm which is more important in clustering analysis.Apache Spark extends the widely used MapReduce computing model and proposes a memory -based parallel computing framework.It reduces I /O disk operations by caching intermediate results in memory ,enabling it to more effi⁃ciently support multiple computing modes such as interactive queries ,iterative calculations and so on.In order to mine the large data well ,we study how to parallelize the DBSCAN algorithm based on large data processing framework Spark ,and design a scheme on paralleliza⁃tion of density clustering algorithm based on Spark.Through the rational use of RDD and design of Sample operator ,map function ,collec⁃tAsMap operator ,reduceByKey operator ,it realizes the parallelization of the process of finding the density -reach data points for the core object.With DBSCAN algorithm on the Spark platform on the data set of UCI Wine ,Car Evaluation and Adult ,the parallel clustering re⁃sults show that the parallelized of DBSCAN algorithm has better accuracy and timeliness ,and it is suitable for large data clustering.Key words :DBSCAN ;clustering ;Spark ;parallelization0 引 言聚类是将未知数据集合分组成由较高相似度的对象组成的若干类或者簇的过程[1]㊂聚类算法大致分为划分方法㊁层次方法㊁基于密度的方法㊁基于网格的方法和基于模型的方法等五类[2-3]㊂DBSCAN 算法作为典型的基于密度的方法,具有聚类速度快㊁有效处理 噪声”点并且能够发现任意形状的簇等优点[4],因此研究用该算法高效并行化处理海量数据具有重要的现实意义㊂Hadoop 作为近年来比较流行的大数据处理平台,利用HDFS 分布式海量存储和MapReduce 分布式计算框架并行处理,其每次map 计算过程中产生的中间结果需要反复读写本地磁盘,在进行大量迭代计算时,MapReduce 计算模型将会耗费大量读写时间[5]㊂2009年加州大学伯克利分校创立基于内存的Spark 大数据处理计算框架,更好地支持交互式查询和迭代算法,扩展了MapReduce 计算框架,并且支持内存式存储和高效的容错机制㊂第28卷 第6期2018年6月 计算机技术与发展COMPUTER TECHNOLOGY AND DEVELOPMENT Vol.28 No.6June 2018文中研究了DBSCAN 算法在Spark 平台的并行化实现方案,并通过实验验证了方案的高效性㊂1 DBSCAN 聚类算法原理DBSCAN 算法是一种典型的基于密度的聚类算法,它将簇定义为高密度相连的点的最大集合㊂该算法能够将高密度的数据区域分为不同的簇,能够在具有 噪声”的数据集中识别出任意形状的聚类[3]㊂对于数据量为n 的数据集合,按照空间索引方法,DB⁃SCAN 的计算复杂度是O (n log n ),否则其计算复杂度为O (n 2)㊂(1)DBSCAN 算法涉及到的定义㊂定义1(Eps 邻域):对指定数据集D 中以x 为圆心的半径Eps 内的球形区域称为该点x 的Eps 邻域㊂定义2(核心对象):D 中任意一点x 的Eps 邻域内包含大于或等于最小数目MinPts 个对象,则称该点x 为核心对象㊂定义3(边界对象):D 中任意一个不是核心对象的点,当其在其他核心对象的Eps 邻域中时,称它为边界对象㊂不同核心对象的Eps 邻域中可能会有相同的边界对象㊂定义4(直接密度可达):如果D 中的点y 在点x 的Eps 邻域中而且点x 是核心对象,则称点y 是从点x 关于参数Eps 和MinPts 直接密度可达的[6]㊂定义5(密度可达):在给定半径Eps 和MinPts 的数据集D 中,存在对象链m 1,m 2, ,m n ,其中m 1=x ,m n =y ,对m i ∈R (1≤i ≤n ),如果m i +1是从m i 直接密度可达的,则点y 是从点x 关于Eps 和MinPts 密度可达的㊂密度可达关系是不对称的㊂定义6(密度相连):如果D 中的点x 和点y 是从点p 关于Eps 和MinPts 密度可达的,则称点x 和点y 是密度相连的[6]㊂定义7(簇):基于密度的DBSCAN 算法的簇是密度相连的数据点的最大集合[7]㊂对给定数据集D 的任意一个非空子集R ,如果称之为簇,必须满足如下条件:①最大性:任意对象点x ,y ∈D ,若x ∈R ,且点y 是从x 密度可达的,则y ∈R ㊂②连通性:任意对象点x ,y ∈R ,则点x ,y 是密度相连的㊂定义8(噪声):如果D 中的某点不被包含在任意簇中,则称为噪声㊂综上所述:当基于密度聚类时,数据集中的簇看作是被低密度区域分隔开的高密度数据区域[8]㊂数据集中的核心对象一定属于某簇,而且密度相连的点在同一簇中㊂噪声点是数据集中的干扰数据,会被舍弃㊂(2)DBSCAN 算法的基本思想㊂首先从给定数据对象集中随机选定一个点x ,在该点给定半径Eps 的区域寻找聚类㊂如果点x 的Eps 邻域内至少包含MinPts 个对象,那么以点x 为核心对象创建一个新簇,接着反复基于这些核心对象查找直接密度可达的数据对象,查找过程可能会涉及密度可达簇的相关合并[3]㊂直到没有新的点被合并到其他簇时,算法结束㊂(3)DBSCAN 算法的具体步骤㊂输入:包含n 个数据对象的数据集D ={x 1,x 2, ,x n },半径Eps 和最小对象数目MinPts ㊂输出:簇集合{R 1,R 2, ,R n }㊂①输入待处理数据集D 后,任意选择一个数据点x ,检查该对象的Eps 邻域;②如果数据点x 的Eps 区域内至少包含最小对象数MinPts ,则以点x 为核心对象形成新簇并从点x 出发寻找所有密度可达的数据点,随之更新簇;③如果数据点x 不是核心对象,将点x 当作噪声点处理;④repeat 以上步骤;⑤until 无新的数据点加入任何簇㊂2 Spark 大数据计算框架不同于Hadoop 的MapReduce 计算模型,Spark 能够使job 中间结果保存在内存中,减少对磁盘的大量读写操作,从而可以高效低延迟处理大型数据集[9-11]㊂Spark 引入了弹性分布式数据集(resilient distributed dataset ,RDD )概念,实现了任务调度㊁分发和处理等,同时提供了更多计算模式组件,如SparkSQL ㊁Spark Streaming ㊁MLib 和GraghX 等,可以适用于多种分布式平台场景㊂Spark 的RDD 核心概念,让其能够以基本一致的操作方式去处理不同的应用场景㊂RDD 本质上是一个不可变只读的分布式元素集合,每个RDD 包含不同的分区,这些分区就是多个dataset 片段,它们分别运行在不同的集群节点上可被同时并行处理㊂实际上,Spark 并行框架计算流程就是通过待处理数据创建RDD ㊁转化成新的RDD 和调用RDD 行动操作求值得到结果[12]㊂RDD 支持两种操作类型:转化(transfor⁃mation )和行动(action )㊂其中转化操作是将现有的RDD 转化成一个全新的RDD ,Spark 中转化操作都是惰性求值,只有在行动操作实际用到这些RDD 时才会被计算㊂而行动操作会触发实际计算,并且向驱动器程序返回结果或者将结果存入外部存储系统中㊂通常情况下,每个转化过的RDD 会在对其执行行动操作时被重新计算,但是大数据迭代算法中经常会多次使用㊃18㊃ 第6期 朱子龙等:基于Spark 的密度聚类算法并行化研究同一RDD,为避免多次调用行动操作对同一RDD计算而带来的开销,Spark支持对RDD进行持久化,计算出RDD的节点会分别保存其所求得的分区数据㊂Spark在分布式环境中采用了主从结构计算模型,其中包含驱动器(driver)节点和执行节点(见图1)㊂图1 Spark计算模型驱动器节点运行Application中的main()方法,创建SparkContext㊁创建RDD和对RDD转化㊁执行行动操作,它作为应用逻辑执行起点负责将用户程序转化为多个物理执行单元,然后将其分发到不同执行器节点执行处理,并且会根据执行器节点任务处理情况,负责执行器节点的任务调度以尽可能地提高效率㊂执行器节点接收到驱动器节点指令后,主要负责分区中任务执行并将任务执行结果反馈给驱动器节点,执行器节点可以为需要缓存的RDD进行内存式存储,从而可以提高运行效率㊂3 基于Spark的DBSCAN算法并行化方案DBSCAN算法定义类簇是密度相连点的最大集合,需要反复迭代寻找核心对象的密度可达数据点[13],所以可以使用Spark大数据计算框架RDD实现㊂在Spark应用中一个驱动器(Driver)程序定义了集群中执行器(executor)节点上的分布数据集,并实现任务分发㊁调度㊁执行和聚合结果等操作㊂文中设计的DBSCAN算法并行化方案如下:(1)配置Spark㊂首先,驱动器程序创建SparkConf对象,配置Spark如何连接到相关集群中,然后创建SparkContext 对象来连接访问Spark㊂如前文所说,Spark并行框架计算流程实际上是通过待处理数据创建RDD,转化成新的RDD,并调用RDD行动操作求值得到结果㊂一般可以通过两种方式创建RDD:读取外部文件系统中的数据集或者在驱动器程序中对数据集进行并行化,同时Spark支持常用文件格式和文件存储系统,比如HDFS㊁Amazon S3㊁HBase等㊂读取待处理数据集创建RDD后,分发到集群中各个执行器节点中,转化为Spark中数据块保存在内存或者磁盘中,并通过Block⁃Manager进行管理㊂RDD中partition是逻辑数据块,分别对应BlockManager管理的物理分区中相应的Block㊂由于Spark采用惰性求值的方式节省集群中的内存使用,只有RDD行动操作才能触发Job的提交计算㊂RDD的Action算子触发Job提交,Spark收到Job后生成具有逻辑性的有向循环图(RDD DAG),随后DAGScheduler会对DAG进行Stage划分㊂对应的每个Stage都会生成一组Task集合并提交到Task⁃Scheduler中,会由TaskScheduler将Task调度分发到各个执行器节点的线程池中执行㊂(2)多执行器节点并行执行DBSCAN算法㊂DBSCAN算法基于Spark的并行化流程见图2㊂图2 DBSCAN算法并行化流程㊃28㊃ 计算机技术与发展 第28卷 每个执行器节点通过多线程方式对其RDD分区内容中的数据使用DBSCAN算法进行计算,首先读取数据集形成RDD_1,RDD_1启动Sample算子,逐一随机选取某数据点x作为起始点并转化为RDD_2㊂设计map函数,计算点x的Eps邻域内是否包含大于或等于MinPts个数据对象,以判断其是否为核心对象,如果是则形成新簇,生成RDD_3㊂RDD_3启动collec⁃tAsMap算子,将已处理的相同类簇汇总到RDD_4同一数据分片中,RDD_4启动reduceByKey算子,寻找从核心对象出发直接密度可达的数据点,此过程中可能存在密度可达的类簇合并,重复迭代,直到无新的数据点加入任何簇时输出聚类结果㊂执行过程中,执行器节点会将需要缓存的RDD缓存在内存中,并将各自处理数据汇总到驱动器节点,并再次迭代计算后终止㊂此时驱动器节点调用saveAsT⁃extFile算子,将结果存储到分布式存储系统HDFS中㊂最后,通过调用SparkContext的stop方法退出Spark 应用㊂由于Spark大数据计算框架的核心数据模型RDD是分发到不同executer节点上并行计算的,并将中间结果缓存到内存中,因此对于需要大量迭代计算的DBSCAN算法可以节省大量时间㊂4 实验与结果分析为了测试和分析基于Spark的并行化DBSCAN 算法的性能,分别用单机DBSCAN算法和基于Spark 的并行DBSCAN算法对实验数据集进行聚类操作,在不同运行模式下,对聚类效果准确度和时间效率进行对比㊂4.1 实验环境和实验数据实验搭建的Spark集群包含1台驱动器节点,2台执行器节点㊂每个节点的CPU为Intel CORE i5-4210H,每个节点配有2个处理器,硬盘数据读写速度为600.00MB/s,其中驱动器节点拥有6G运行内存,执行器节点拥有2G运行内存㊂操作系统为centos 6.5;Java版本为JDK1.7.0_13;Spark版本为1.6.0; Scala版本为2.10.4㊂具体节点配置见表1㊂表1 节点配置编号角色内存处理器Spark-1驱动器节点6GB2CoreSpark-2执行器节点2GB2CoreSpark-3执行器节点2GB2Core 实验采用了UCI实验室提供的Wine数据集㊁Car Evaluation数据集和Adult数据集[14-15],详情见表2㊂表2 数据集数据集属性特征属性数目记录数Wine整数㊁实数13178Car Evaluation类别型61728 Adult类别型㊁整数1448842 4.2 聚类准确度对比实验以正确聚类的样本数占总样本数的百分比作为准确率,对DBSCAN算法的聚类结果进行评估,得到的结果如表3所示㊂表3 准确度对比数据集属性数目准确度/%单机DBSCAN算法Spark-DBSCAN算法Wine1373.1073.22 Car Evaluation671.8672.97 Adult1477.5578.33 可以看出,对3个数据集,基于Spark的并行DB⁃SCAN算法比传统单机运行模式的DBSCAN算法的聚类准确率都有所提高㊂算法准确度不会因为数据分布式处理而影响聚类结果,说明分布式数据处理具有良好的稳定性和准确度㊂4.3 聚类时效对比实验图3展示了传统单节点DBSCAN算法和基于Spark的并行DBSCAN算法处理不同数据集时的耗时情况㊂图3 算法运行效率对比可以看出,在数据量比较少的情况下,传统单节点DBSCAN算法运行时间比基于Spark的DBSCAN算法运行时间要少,因为Spark平台启动时的初始化需要消耗一定时间㊂伴随着数据量逐渐增大,单节点DBSCAN算法执行时间涨幅明显,因为数据逐步增多所消耗的处理器和内存等资源也在逐步增多,单个工㊃38㊃ 第6期 朱子龙等:基于Spark的密度聚类算法并行化研究作节点由于资源限制,运行速度会逐步降低导致消耗更多时间;相反,基于Spark 的DBSCAN 算法运行时间随着数据量增加涨幅明显低于单节点运行模式,此时分布式集群优势逐渐显示出来㊂可以得出这样的结论:在处理规模较大的数据时,基于Spark 平台的DB⁃SCAN 算法聚类时效性更好㊂5摇结束语对DBSCAN 算法如何在Spark 平台进行并行化实现进行了研究㊂通过设计该算法在Spark 集群中的并行化实现方案和对3个数据集进行聚类处理,验证了在大规模的数据处理中,基于Spark 平台的DB⁃SCAN 算法并行化能够有效完成聚类工作,并且具有更高的准确度和更好的执行效率㊂参考文献:[1] HAN Jiawei ,KAMBER M.数据挖掘概念与技术[M ].范明,译.北京:机械工业出版社,2001:232-236.[2] 张 丽.无参数网格聚类算法的研究[D ].郑州:郑州大学,2009.[3] 林建仁.聚类算法的研究与应用[D ].上海:复旦大学,2007.[4] CHEN Yixin ,TU Li.Density -based clustering for real -timestream data [C ]//Proceedings of the 13th ACM SIGKDDinternational conference on knowledge discovery and data mining.San Jose ,California ,USA :ACM ,2007:133-142.[5] 李 帅,吴 斌,杜修明,等.基于Spark 的BIRCH 算法并行化的设计与实现[J ].计算机工程与科学,2017,39(1):35-41.[6] 张世安.分布式环境下的数据挖掘算法的研究与实现[D ].上海:复旦大学,2004.[7] 范 敏,李泽明,石 欣.一种基于区域中心点的聚类算法[J ].计算机工程与科学,2014,36(9):1817-1822.[8] 高 兵.基于密度的数据流聚类方法研究[D ].哈尔滨:哈尔滨工程大学,2014.[9] 张 泉.面向云计算数据中心的存储服务质量技术研究[D ].武汉:华中科技大学,2014.[10]JAIN A K.Data clustering :50years beyond K -Means [J ].Pattern Recognition Letters ,2010,31(8):651-666.[11]PAN Donghua ,ZHAO Lilei.Uncertain data cluster based onDBSCAN [C ]//Proceedings of IEEE international confer⁃ence on multimedia technology.Hangzhou ,China :IEEE ,2011:3781-3784.[12]KELLNER D ,KLAPPSTEIN J ,DIETMAYER K.Grid -based DBSCAN for clustering extended objects in radar data [C ]//Intelligent vehicles symposium.Alcala de Henares ,Spain :IEEE ,2012:365-370.[13]唐振坤.基于Spark 的机器学习平台设计与实现[D ].厦门:厦门大学,2014.[14]罗启福.基于云计算的DBSCAN 算法研究[D ].武汉:武汉理工大学,2013.[15]ZAHARIA M ,CHOWDHURY M ,FRANKLIN M J ,et al.Spark :cluster computing with working sets [C ]//Proceed⁃ings of the 2nd USENIX conference on hot topics in cloud computing.Boston ,MA :[s.n.],2010:1765-1773.(上接第79页) 1795-1801.[11]韦明祥,陈 俊.基于C -V 模型的医学图像分割方法[J ].电子科技,2012,25(5):101-104.[12]GENG Hao ,LUO Min ,HU Feng.Improved self -adaptiveedge detection method based on Canny [C ]//5th internation⁃al conference on intelligent human -machine systems and cy⁃bernetics.Hangzhou ,China :IEEE ,2013:527-530.[13]SU Baofeng ,NOGUCHI N.Discrimination of land use pat⁃terns in remote sensing image data using minimum distance algorithm and watershed algorithm [J ].Engineering in Agri⁃culture ,Environment and Food ,2013,6(2):48-53.[14]ZNANATY E A ,AFIFI A.A watershed approach for impro⁃ving medical image segmentation [J ].Computer Methods in Biomechanics and Biomedical Engineering ,2013,16(12):1262-1272.[15]ZENG Weili ,LU X ,TAN X ,A local structural adaptive par⁃tial differential equation for image restoration [J ].MultimediaTools and Applications ,2015,74(3):743-757.[16]李雅梅,任婷婷.自适应分数阶微分小波图像增强方法的研究[J ].微电子学与计算机,2015,32(6):130-133.㊃48㊃ 计算机技术与发展 第28卷。