决定周期为upn序列的极小多项式的快速算法

pn序列产生原理

PN序列的基本原理1. 引言PN序列(Pseudo-Noise sequence)是一种伪随机序列,具有良好的随机性质,被广泛应用于通信、密码学和信号处理等领域。

本文将详细解释PN序列的产生原理,包括线性反馈移位寄存器(LFSR)和Gold序列的生成方法。

2. 线性反馈移位寄存器(LFSR)LFSR是产生PN序列的主要工具,它是一种由多个触发器组成的寄存器,在每个时钟周期内,通过对寄存器的状态进行移位和反馈,生成下一个时刻的输出。

LFSR由以下三个要素组成: - 寄存器:由若干个触发器(一般是D触发器)组成,每个触发器有一个时钟输入和一个输出。

- 反馈多项式:用于决定每个触发器的输入。

它是一个多项式,其系数为0或1,表示每个触发器的输出是否参与反馈。

- 反馈方式:决定每个触发器的输出是否参与反馈,可以是异或、与或非等逻辑运算。

LFSR的工作过程如下: 1. 初始状态:将寄存器的初始值设定为一个非零值。

2. 时钟触发:在每个时钟周期内,寄存器的状态向左移位,即将每个触发器的输出传递给下一个触发器。

3. 反馈:根据反馈多项式和反馈方式,计算新的输入值。

一般来说,将参与反馈的触发器的输出进行逻辑运算,得到新的输入值。

4. 输出:取寄存器的最低位作为输出。

LFSR的输出序列称为线性反馈移位寄存器序列,具有周期性。

当寄存器的状态重新回到初始状态时,序列将重复。

3. PN序列的生成方法PN序列的生成方法主要有两种:简单LFSR和Gold序列。

3.1 简单LFSR简单LFSR是最基本的PN序列生成方法,其特点是只使用一个LFSR。

简单LFSR的生成过程如下: 1. 初始化:选择适当的寄存器初始值。

2. 时钟触发和反馈:根据LFSR的结构,进行时钟触发和反馈操作。

3. 输出:取LFSR的最低位作为输出。

简单LFSR生成的PN序列周期性较短,安全性较低,易受到攻击。

3.2 Gold序列Gold序列是一种通过两个LFSR相互协作生成的PN序列,其特点是周期性较长,安全性较高。

潮流计算的基本算法及使用方法之欧阳历创编

潮流计算的基本算法及使用方法一、二、潮流计算的基本算法1.牛顿-拉夫逊法1.1 概述牛顿-拉夫逊法是目前求解非线性方程最好的一种方法。

这种方法的特点就是把对非线性方程的求解过程变成反复对相应的线性方程求解的过程,通常称为逐次线性化过程,就是牛顿-拉夫逊法的核心。

牛顿-拉夫逊法的基本原理是在解的某一邻域内的某一初始点出发,沿着该点的一阶偏导数——雅可比矩阵,朝减小方程的残差的方向前进一步,在新的点上再计算残差和雅可矩阵继续前进,重复这一过程直到残差达到收敛标准,即得到了非线性方程组的解。

因为越靠近解,偏导数的方向越准,收敛速度也越快,所以牛顿法具有二阶收敛特性。

而所谓“某一邻域”是指雅可比方向均指向解的范围,否则可能走向非线性函数的其它极值点,一般来说潮流由平电压即各母线电压(相角为0,幅值为1)启动即在此邻域内。

1.2一般概念对于非线性代数方程组即 ()0,,,21=n i x x x f ()n i ,2,1= (1-1) 在待求量x 的某一个初始计算值()0x 附件,将上式展开泰勒级数并略去二阶及以上的高阶项,得到如下的线性化的方程组()()()()()0000=∆'+x x f x f (1-2)上式称之为牛顿法的修正方程式。

由此可以求得第一次迭代的修正量()()()[]()()0100x f x f x -'-=∆ (1-3)将()0x ∆和()0x 相加,得到变量的第一次改进值()1x 。

接着再从()1x 出发,重复上述计算过程。

因此从一定的初值()0x 出发,应用牛顿法求解的迭代格式为()()()()()k k k x f x x f -=∆' (1-4)()()()k k k x x x ∆+=+1 (1-5)上两式中:()x f '是函数()x f 对于变量x 的一阶偏导数矩阵,即雅可比矩阵J ;k 为迭代次数。

由式(1-4)和式子(1-5)可见,牛顿法的核心便是反复形成求解修正方程式。

怎么计算极小多项式举例

极小多项式是一个线性代数和抽象代数中的重要概念,用于描述矩阵的性质。

计算极小多项式的过程相对复杂,需要一定的数学知识和技巧。

下面将介绍如何计算极小多项式,并提供一个示例来帮助理解。

1.构造行列式首先,考虑一个n阶方阵A,我们需要构造一个关于A的多项式。

定义一个矩阵多项式的行列式D(t): D(t) = det(tI - A)其中,I是单位矩阵,t是一个未知数。

方阵(tI - A) 称为伴随矩阵。

2.寻找零化多项式下一步是找到一个次数最低的非零多项式p(t),使得p(A) = 0。

根据伴随矩阵的定义,我们可以得到一个定理:p(t)必须是D(t)的因子。

所以,我们需要计算D(t)的因子来找到极小多项式。

这可以通过对D(t)进行因式分解来实现。

关于如何因式分解多项式的具体步骤,可以参考线性代数教材或内容。

3.确定极小多项式一旦我们找到了一个次数最低的非零多项式p(t)使得p(A) = 0,那么极小多项式就是p(t)。

以下是一个例子,用于帮助理解如何计算极小多项式:假设我们有一个2阶方阵A: A = [1 2] [3 4]首先,我们构造伴随矩阵: (tI - A) = [t-1 -2] [-3 t-4]然后,计算行列式: D(t) = det(tI - A) = (t-1)(t-4) - (-2)(-3) = t^2 - 5t + 6将D(t)进行因式分解:D(t)=(t-2)(t-3)因此,极小多项式是p(t) = (t-2)(t-3)通过验证,我们可以发现p(A) = 0。

以上是计算极小多项式的基本步骤和示例。

实际上,更复杂的方阵需要更复杂的计算方式来得到极小多项式。

有关更详细的计算方法和示例,可以参考相关专业的线性代数和抽象代数教材。

计算psupnsup—周期二元序列的最小错线性复杂度新算法

龙源期刊网

计算p n—周期二元序列的最小错线性复杂度新算法

作者:牛志华郭丹峰

来源:《计算机应用》2013年第01期

摘要:传统的计算序列k错线性复杂度的算法,每一步都要计算和存储序列改变的代价,基于节省计算量和存储空间的考虑,提出了一种计算周期为pn的二元序列的最小错线性复杂度的新算法,其中p为素数,2为模p2的一个本原根。

新算法省去了序列代价的存储和计算,主要研究在k为最小错,即使得序列线性复杂度第一次下降的k值时,序列线性复杂度的计算方法,给出了理论证明,并用穷举法与传统算法对序列的计算结果进行了比对。

结果完全一致且比传统算法节省了一半以上的存储空间和计算时间,是一种有效的研究特殊周期序列稳定性的计算方法。

关键词:流密码;周期序列;线性复杂度;k错线性复杂度。

怎么计算极小多项式举例

怎么计算极小多项式举例极小多项式是指最小的首项系数为1的整系数多项式,使得给定数的一些线性方程为其根。

在计算极小多项式时,可以采用多种方法,包括辗转相除法、特岗凯利法(Berlekamp-Kasiski algorithm)等。

下面以辗转相除法为例,来详细介绍如何计算极小多项式。

1. 假设已知一个数α的最小多项式为f(x) = a_nx^n + a_{n-1}x^{n-1} + ... + a_0,其中a_n ≠ 0。

则α是数域K上一个n次元的一个扩张域中的元素。

2.在扩张域K(u)上构造一个递推关系序列:ω_{-1}=0ω_0=1ω_{j+1}=αω_j-θjω_{j-1},其中θj为α的K(u)上的极小多项式的首项系数。

这里的递推关系序列实际上是通过把极小多项式代入线性方程,得到的线性组合。

3.递推关系序列的长度为n+1,即ω_{n+1}为0。

4. 对递推关系序列做mod x^m运算得到的结果会是一个线性关系:ω_{n+m} ≡ ζ_{n+m,n}ω_n + ζ_{n+m,n-1}ω_{n-1} + ... + ζ_{n+m,0}ω_0 (mod f(x))其中ζ_{n+m,j}为关于扩展域K(u)的K系数的多项式,满足ζ_{n+m,j} ≡ αζ_{n+m-1,j} - θnζ_{n+m-1,j-1} (mod f(x))根据递推关系的定义,我们可以知道,此时关于扩张域的多项式F(x) = x^{n+m} - ζ_{n+m,n}x^n - ζ_{n+m,n-1}x^{n-1} - ... -ζ_{n+m,0} (mod f(x))。

通过将F(x)与f(x)进行mod操作,我们可以得到一个新的多项式g(x)。

5.如果g(x)=0,则我们称f(x)为α在域K上的极小多项式;否则,我们需要重新以g(x)为α的极小多项式进行递推关系的计算。

需要注意的是,辗转相除法作为一种计算极小多项式的方法,只适用于一些特定的数,而对于一些特殊的数,如超越数,计算极小多项式可能会更加复杂。

例谈求函数周期的几种常见方法

例谈求函数周期的几种常见方法董㊀强(西安市第八十五中学ꎬ陕西西安710061)摘㊀要:周期性是函数的基本性质ꎬ文章通过高考真题和一些模拟题对函数周期的几种常见求法进行总结.关键词:周期性ꎻ公式法ꎻ函数ꎻ高考题中图分类号:G632㊀㊀㊀文献标识码:A㊀㊀㊀文章编号:1008-0333(2023)10-0012-03收稿日期:2023-01-05作者简介:董强(1985-)ꎬ硕士ꎬ中学一级教师ꎬ从事中学数学教学研究.基金项目:西安市教育科学研究 十四五 规划2021年度小课题: 思维型教学理论指导下的教师专业成长研究 (项目编号:2021XKT-ZXSX162).㊀㊀一般地ꎬ对于函数y=f(x)ꎬ设其定义域为Dꎬ若存在非零常数Tꎬ使得∀xɪDꎬf(x+T)=f(x)都成立ꎬ那么就称函数y=f(x)为周期函数ꎬT为函数f(x)的一个周期.当T为函数f(x)的周期时ꎬkT(kɪZ)也是该函数的周期.对于三角函数ꎬ可以通过公式求得其周期ꎻ对于抽象函数ꎬ可以根据周期函数的定义ꎬ合理运用所给函数性质ꎬ求出其周期.1三角函数的周期性(公式法)三角函数是典型的周期函数ꎬ对于三角函数y=Asin(ωx+φ)ꎬy=Acos(ωx+φ)ꎬy=Atan(ωx+φ)(xɪR)而言ꎬ它们的周期分别是2πωꎬ2πωꎬπωꎻ而函数y=A|sin(ωx+φ)|ꎬy=A|cos(ωx+φ)|ꎬy=A|tan(ωx+φ)|的周期均为πω.例1㊀(2015年天津理第15题第(1)问)已知函数f(x)=sin2x-sin2(x-π6)ꎬxɪR.求f(x)的最小正周期.解析㊀f(x)=1-cos2x2-1-cos(2x-π3)2=12(12cos2x+32sin2x)-12cos2x=34sin2x-14cos2x=12sin(2x-π6).所以f(x)周期T=2π2=π.评析㊀求解三角函数问题的一般思路是先通过三角函数恒等变形将函数式进行化简ꎬ再由公式求出三角函数的周期.本题先利用降幂公式将已知函数化简ꎬ再利用辅助角公式将其转化为同一个角的三角函数ꎬ从而利用公式法求得周期.㊀例2㊀(2015年重庆理第18题第(1)问)已知21函数f(x)=sin(π2-x)sinx-3cos2x.求f(x)的最小正周期和最大值.解析㊀f(x)=sin(π2-x)sinx-3cos2x=cosxsinx-32(1+cos2x)=12sin2x-32cos2x-32=sin(2x-π3)-32.所以f(x)的最小正周期为πꎬ最大值为2-32.评析㊀在求解三角函数的问题时常需进行恒等变形ꎬ常用方法有降幂法和变量归一法ꎬ本题利用诱导公式㊁二倍角公式㊁辅助角公式化简f(x)后ꎬ即可求出f(x)的最小正周期及最大值.2利用函数周期的定义求周期对于一些抽象函数ꎬ充分利用函数周期的定义是求函数周期的常见方法.例3㊀(2012年山东)定义在R上的函数f(x)满足f(x+6)=f(x).当-3ɤx<-1时ꎬf(x)=-(x+2)2ꎻ当-1ɤx<3时ꎬf(x)=x.则f(1)+f(2)+ +f(2012)=(㊀㊀).A.335㊀㊀B.338㊀㊀C.1678㊀㊀D.2012解析由f(x+6)=f(x)知ꎬ函数f(x)的周期为6ꎬ结合题设有f(-3)=f(3)=-1ꎬf(-2)=f(4)=0ꎬf(-1)=f(5)=-1ꎬf(0)=f(6)=0ꎬf(1)=1ꎬf(2)=2ꎬ所以f(1)+f(2)+ +f(6)=1+2-1+0-1+0=1.所以f(1)+f(2)+ +f(2012)=f(1)+f(2)+335ˑ1=1+2+335=338.评析㊀由函数周期的定义知f(x)的周期为6ꎬ故需要算出一个周期内的6个函数值ꎬ再将待求式子分成周期的倍数ꎬ利用分段函数来计算前6个函数值就可以了.例4㊀设f(x)是定义在R上的奇函数ꎬ且对任意实数xꎬ恒有f(x+2)=-f(x).当xɪ[0ꎬ2]时ꎬf(x)=2x-x2.求证:f(x)是周期函数.证明㊀因为f(x+2)=-f(x)ꎬ所以f(x+4)=-f(x+2)=f(x).故f(x)是周期为4的周期函数.评析㊀证明一个函数是周期函数ꎬ只需证明存在一个非零常数Tꎬ使f(x+T)=f(x).在周期性与奇偶性相结合的函数综合问题中ꎬ周期性起到转换自变量值的作用ꎬ奇偶性起到调节函数值符号的作用.㊀3利用抽象函数的对称性求周期函数的对称性往往和周期性密不可分ꎬ如果一个函数既有对称轴ꎬ又有对称中心ꎬ那么这个函数是一个周期函数ꎬ可结合函数周期的定义推出其周期.例5㊀已知函数f(x)是定义在R上的奇函数ꎬ且它的图象关于直线x=1对称ꎬ求证:f(x)是周期为4的周期函数.证明㊀由函数f(x)的图象关于x=1对称ꎬ有f(x+1)=f(1-x)ꎬ即有f(-x)=f(x+2).又函数f(x)是定义在R上的奇函数ꎬ故有f(-x)=-f(x).故f(x+2)=-f(x).从而f(x+4)=-f(x+2)=f(x).即f(x)是周期为4的周期函数.例6㊀已知定义在R上的函数f(x)ꎬ对任意xɪRꎬ都有f(x+6)=f(x)+f(3)成立ꎬ若函数y=f(x+1)的图象关于直线x=-1对称ꎬ则f(2013)=(㊀㊀).31A.0㊀㊀B.2013㊀㊀C.3㊀㊀D.-2013解析㊀由y=f(x+1)关于x=-1对称知ꎬy=f(x)关于x=0对称ꎬ故f(x)为偶函数.在f(x+6)=f(x)+f(3)中ꎬ令x=-3ꎬ得f(3)=f(-3)+f(3).即f(-3)=0.所以f(3)=0ꎬf(x+6)=f(x).所以T=6.f(2013)=f(6ˑ335+3)=f(3)=0.故选A.例7㊀已知函数f(x)对任意xɪR都有f(x+6)+f(x)=2f(3)ꎬy=f(x-1)的图象关于点(1ꎬ0)对称ꎬ且f(4)=4ꎬ则f(2012)=(㊀㊀).A.0㊀㊀㊀B.-4㊀㊀㊀C.-8㊀㊀㊀D.-16解析㊀由y=f(x-1)的图象关于点(1ꎬ0)对称ꎬ可知f(x)关于点(0ꎬ0)对称.故f(x)为奇函数.令x=-3ꎬ则f(3)+f(-3)=2f(3)ꎬf(-3)=f(3).又f(-3)=-f(3)ꎬ所以f(3)=0.所以f(6+x)+f(x)=0.所以f(12+x)=-f(6+x)=f(x).于是f(x)是一个周期为12的周期函数.因此f(2012)=f(-4)=-f(4)=-4.故选B.例8㊀已知定义在R上的奇函数f(x)ꎬ满足f(x-4)=-f(x)ꎬ且在区间[0ꎬ2]上单调递增ꎬ若方程f(x)=m(m>0)在区间[-8ꎬ8]上有四个不同的根x1ꎬx2ꎬx3ꎬx4ꎬ则x1+x2+x3+x4=.解析㊀因为函数f(x)在区间[0ꎬ2]上单调递增ꎬ又f(x)是R上的奇函数ꎬ故f(0)=0ꎬf(x)的图象关于坐标原点对称ꎬ这样就得到了函数f(x)在[-2ꎬ2]上的特征图象(如图1).由f(x-4)=-f(x)得f(4-x)=f(x).故函数f(x)的图象关于直线x=2对称ꎬ这样就得到了函数f(x)在[2ꎬ6]上的特征图象.因为f(x-4)=-f(x)ꎬ所以f(x-8)=-f(x-4)=f(x).故函数f(x)是以8为周期的周期函数.根据函数的周期性得到f(x)在[-8ꎬ8]上的特征图象(如图1所示).图1根据图象不难看出ꎬ方程f(x)=m(m>0)的两根关于直线x=2对称ꎬ另两根关于直线x=-6对称ꎬ故四个根的和为2ˑ(-6)+2ˑ2=-8.评析㊀例5~例8是根据函数的对称性求得函数的周期.一般地ꎬ有以下一些常用的结论:(1)若x=aꎬx=b都是函数f(x)图象的对称轴ꎬ则T=2a-b是函数f(x)的周期ꎻ(2)若(aꎬ0)ꎬ(bꎬ0)都是函数f(x)图象的对称中心ꎬ则T=2a-b是函数f(x)的周期ꎻ(3)若x=a是函数f(x)图象的对称轴ꎬ(bꎬ0)是函数f(x)图象的对称中心ꎬ则T=4a-b是函数f(x)的周期ꎻ(4)若x=a是函数f(x)图象的对称轴ꎬT是f(x)的一个周期ꎬ则直线x=a+nT2(nɪZ)也是函数f(x)图象的对称轴ꎻ(5)若(aꎬ0)是函数f(x)图象的对称中心ꎬT是f(x)的一个周期ꎬ则点(a+nT2ꎬ0)(nɪZ)也是函数f(x)图象的对称中心.参考文献:[1]任志鸿.十年高考分类解析与应试策略(数学)[M].北京:知识出版社ꎬ2015.[责任编辑:李㊀璟]41。

线性代数中的极小多项式与最小多项式

线性代数中的极小多项式与最小多项式线性代数是数学的一个分支,研究向量空间及其上的线性变换和线性方程组。

在线性代数中,极小多项式和最小多项式是两个重要的概念。

极小多项式是指一个线性变换在其定义域上表现出的最小多项式。

具体而言,假设我们有一个线性变换T和定义域V。

那么T的极小多项式是V上的一个首项系数为1的最低次多项式,使得T满足这个多项式。

换句话说,极小多项式是T的满足最低次多项式条件的多项式。

为了更好地理解极小多项式,我们可以通过一个例子来说明。

假设我们有一个二维向量空间V,线性变换T是将V中的向量向右旋转90度的变换。

我们可以通过矩阵来表示T,即:T = \begin{bmatrix} 0 & -1 \\ 1 & 0 \end{bmatrix}现在我们想找出T的极小多项式。

我们首先可以尝试一个一次多项式,即p(x) = x。

计算p(T)得到:p(T) = T = \begin{bmatrix} 0 & -1 \\ 1 & 0 \end{bmatrix}这个结果与T相同,说明我们需要一个更高次数的多项式来描述T。

我们再尝试一个二次多项式,即p(x) = x^2。

计算p(T)得到:p(T) = T^2 = \begin{bmatrix} -1 & 0 \\ 0 & -1 \end{bmatrix}这个结果不同于T,说明我们需要一个更高次数的多项式来描述T。

我们再尝试一个三次多项式,即p(x) = x^3。

计算p(T)得到:p(T) = T^3 = \begin{bmatrix} 0 & -1 \\ 1 & 0 \end{bmatrix} \cdot\begin{bmatrix} 0 & -1 \\ 1 & 0 \end{bmatrix} \cdot \begin{bmatrix} 0 & -1 \\ 1 & 0 \end{bmatrix} = \begin{bmatrix} 0 & 1 \\ -1 & 0 \end{bmatrix}这个结果与T相同,说明我们找到了T的极小多项式,即p(x) =x^3。

欧拉函数有概率多项式时间算法

欧拉函数有概率多项式时间算法一、前言欧拉函数是数论中的一个重要概念,它可以用来计算小于等于n的正整数中与n互质的数的个数。

在实际应用中,欧拉函数经常被用来加密和解密数据。

然而,计算欧拉函数通常需要耗费大量时间和资源。

因此,研究如何高效地计算欧拉函数是非常有意义的。

本文将介绍一种概率多项式时间算法,用于快速计算欧拉函数。

该方法基于Miller-Rabin素性测试和Pollard-Rho因子分解算法,并且具有较高的效率和可靠性。

二、欧拉函数简介欧拉函数(Euler's totient function)又称为φ函数,它表示小于等于n的正整数中与n互质的数的个数。

例如,φ(8)=4,因为小于等于8且与8互质的数有1、3、5、7四个。

φ(n)可以通过以下公式进行计算:φ(n) = n × ∏(p|n) (1 - 1/p)其中p|n表示p是n的一个质因子。

三、Miller-Rabin素性测试Miller-Rabin素性测试是一种基于费马小定理(Fermat's little theorem)的素性测试方法。

费马小定理表明:如果p是一个质数,a 是小于p的正整数,则a^(p-1) ≡ 1 (mod p)。

Miller-Rabin素性测试的基本思想是:如果一个数n不是质数,则它有至少一个小于n的因子p,那么对于任意一个a,如果a^(n-1) ≢ 1 (mod n),且对于所有0<i<k,a^(2^i × (n-1)) ≢ -1 (mod n),则n 一定不是质数。

根据费马小定理,如果n是质数,则上述条件都会满足。

Miller-Rabin素性测试可以通过多次随机选择a来增加正确率。

通常情况下,选择10次左右即可达到很高的正确率。

四、Pollard-Rho因子分解算法Pollard-Rho因子分解算法是一种用于分解大整数的方法。

它基于随机漫步的思想,在随机序列中寻找环,并通过环的长度来判断是否找到了因子。

快速多极子方法

快速多极子方法一、概述快速多极子方法是一种用于求解大规模线性方程组的数值方法。

它的基本思想是将空间分成若干个小立方体,然后在每个小立方体内部使用多项式逼近原函数,从而将原问题转化为求解多项式系数的问题。

通过这种方式,可以将计算复杂度从 $O(n^3)$ 降低到 $O(n)$ 或者$O(n\log n)$ 级别,从而大大提高计算效率。

二、基本原理快速多极子方法的基本原理可以概括为以下几点:1. 将空间分成若干个小立方体:首先需要将待求解区域分成若干个小立方体,每个小立方体内部使用多项式逼近原函数。

2. 计算相互作用矩阵:在每个小立方体内部,需要计算相互作用矩阵。

相互作用矩阵描述了不同小立方体之间的相互作用关系。

3. 递归求解:通过递归的方式,将整个问题划分为若干个子问题,并在每个子问题中使用快速多极子方法进行求解。

4. 处理边界条件:在处理边界条件时,需要采用特殊的处理方法,以确保计算结果的准确性。

三、具体步骤下面将详细介绍快速多极子方法的具体步骤。

1. 空间划分首先需要将待求解区域分成若干个小立方体。

一般情况下,可以采用递归划分的方式进行空间划分。

具体来说,可以从整个区域开始,逐渐将其划分为越来越小的子区域。

在每个子区域内部,使用多项式逼近原函数。

多项式的次数可以根据实际需要进行调整。

2. 计算相互作用矩阵在每个小立方体内部,需要计算相互作用矩阵。

相互作用矩阵描述了不同小立方体之间的相互作用关系。

一般情况下,可以采用格林函数法进行计算。

格林函数法是一种基于格林函数理论的数值计算方法,它可以非常高效地计算相互作用矩阵。

3. 递归求解通过递归的方式,将整个问题划分为若干个子问题,并在每个子问题中使用快速多极子方法进行求解。

具体来说,在每个子问题中,需要进行以下步骤:(1)计算相互作用矩阵:在当前子问题内部,需要计算相互作用矩阵。

(2)处理边界条件:在处理边界条件时,需要采用特殊的处理方法,以确保计算结果的准确性。

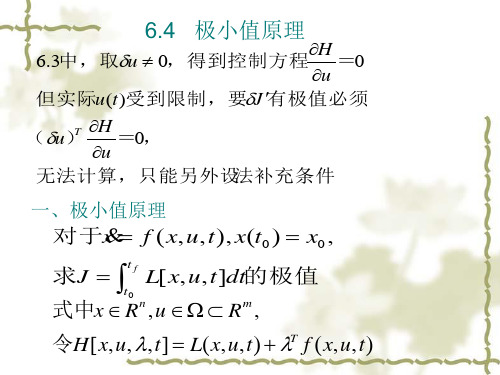

极小值原理

综上可得: c 最优控制为u (0) x ( 0) 1 2c c c * u (1) x(1) x(0) 1 c 1 2c 最优轨迹为x* (0) x0

*ห้องสมุดไป่ตู้

1 c x (1) x(0) 1 2c 1 1 x* (2) x(1) x(0) 1 c 1 2c

2)求 (t )以确定u的切换点 H 由协态方程 (1 )得+=- ,其解为=- +Ce t 1 1 x 当t f 1时 (t f ) (1) 0, C e, 故切换点:令 1, 得t 1 ln 2 0.307

二、补充说明

1、式H [ x* (t ), u * (t ), * (t ), t ] H [ x* (t ), u (t ), * (t ), t ] 说明当u (t )和u (t )都从容许的有界集中取 值时,

一道莫名其妙的数学题

⼀道莫名其妙的数学题⼀道莫名其妙的数学题上次写博客不知道是什么时候了,我也不知道为什么突然想写博客题⾯若n=∏p c i i定义τ(n)=∏(−1)c i,ξ(n)=∑d|nτ(d)我们需要得到∑n i=1∑m j=1ξ(ij)n,m≤1012做法先推式⼦,容易得到τ(n)的狄拉克雷⽣成函数为∏11+1p=∏p x ip x i+1ξ=I∗τ=∏(p x ip x i+1)(p x ip x i−1)=∏p2x ip2x i−1所以ξ(n)=[⌊√n⌋2=n]设h(n)=µ2(n)n ∑i=1m∑j=1ξ(ij)=n∑i=1h(i)nimi由于h在质数处的取值与I相同,所以我们考虑使⽤powerful number筛法计算h(i)的前缀和h=∏(1+1p z)I=∏p zp z−1u=h/I=∏p2z−1p2z=∏(1−1p2z)发现u(n)的值⾮常好求,为ξ(n)µ(√n),所以整除分块+powerful number筛法计算h(i)的前缀和即可下⾯计算时间复杂度:T(n)=n0.25∑i=1(i+n0.5i)≈√n ln n但是实际效率⾮常的⾼,可以在1s内跑过1014#include<bits/stdc++.h>using namespace std;# define ll long long# define read read1<ll>()# define Type template<typename T>Type T read1(){T t=0;char k;bool vis=0;do (k=getchar())=='-'&&(vis=1);while('0'>k||k>'9');while('0'<=k&&k<='9')t=(t<<3)+(t<<1)+(k^'0'),k=getchar();return vis?-t:t;}# define fre(k) freopen(k".in","r",stdin);freopen(k".out","w",stdout)int tot,prime[1000005];ll n,m;bool vis[1000005];void init(const int N=1000000){for(int i=2;i<=N;++i){if(!vis[i])prime[++*prime]=i;for(int j=1;j<=*prime&&prime[j]*i<=N;++j){vis[i*prime[j]]=1;if(!(i%prime[j]))break;}}}ll Getv(ll s,int w,int p){ll t=s*p;if(w>*prime)return t;while(w<=*prime&&1ll*prime[w]*prime[w]<=s){ll j=1ll*prime[w]*prime[w];t+=Getv(s/j,w+1,-p);++w;}return t;}ll Sqrt(ll x){ll v=sqrt(x);while(v*v<x)++v;while(v*v>x)--v;return v;⌊√⌋⌊√⌋}ll Getr(ll v){ll t=Sqrt(n/v);ll o=t?n/t/t:n;t=Sqrt(m/v);o=min(o,t?m/t/t:m);return o;}int main(){init();fre("lost");n=read,m=read;if(n>m)swap(n,m);ll ans=0,la=0;for(ll l=1,r=0,nw=0;l<=n;l=r+1){r=Getr(l);nw=Getv(r,1,1);ans+=(nw-la)*Sqrt(n/l)*Sqrt(m/l);la=nw;}cout<<ans;return 0;}第⼀次写powerfulnumber筛,居然没出锅!Processing math: 100%。

决定周期为upn序列的极小多项式的快速算法

决定周期为upn序列的极小多项式的快速算法

胡卫群;岳勤

【期刊名称】《东南大学学报(英文版)》

【年(卷),期】2012(028)003

【摘要】给出了一个快速算法决定有限域Fq上周期为upn序列的极小多项式.设p,q,u为不同素数,q为模p2的本原根,m为最小正整数使得qm≡1modu和

gcd(m,p(p-1))=1.利用一个算法把有限域Fq上周期为upn序列化为几个有限域Fq(ζ)上周期为pn序列,其中ζ为一个u次本原单位根,从而利用肖国正等的算法得到每个周期为pn序列的极小多项式.

【总页数】5页(P367-371)

【作者】胡卫群;岳勤

【作者单位】南京林业大学理学院,南京210037;南京航空航天大学理学院,南京210016

【正文语种】中文

【中图分类】O236.2

因版权原因,仅展示原文概要,查看原文内容请购买。

极小多项式

极小多项式?

在抽象代数中,一个域上的代数的元素之极小多项式(或最小多项式)是它满足的最低次多项式。

此概念对线性代数与代数扩张的研究极有助益。

1.形式定义

设为域,为有限维-代数。

对任一元素,集合张出有限维向量空间,所以存在非平凡的线性关系:

可以假设,此时多项式满足。

根据多项式环里的除法,可知这类多项式中只有一个次数最小者,称之为的极小多项式。

由此可导出极小多项式的次数等於,而且可逆若且唯若其极小多项式之常数项非零,此时可以表成的多项式。

2,矩阵的极小多项式

考虑所有矩阵构成的-代数,由於,此时可定义一个矩阵之极小多项式,而且其次数至多为;事实上,根据凯莱-哈密顿定理,可知其次数至多为,且其根属於该矩阵的特徵值集。

极小多项式是矩阵分类理论(约当标准形、有理标准形)的关键。

3,极小多项式与代数扩张

设为的有限扩张,此时可视为有限维-代数。

根据域的性质,极小多项式必为素多项式。

元素的迹数及范数等不变量可以从极小多项式的系数读出。

快速多极子算法

快速多极子算法快速多极子算法(Fast Multipole Method,简称FMM)是一种高效的计算N体问题的方法,它可以在O(N)的时间复杂度内求解N个粒子之间的相互作用力。

本文将从FMM的基本思想、算法流程、优缺点以及应用领域等方面进行详细介绍。

一、基本思想FMM的基本思想是将远距离作用力的计算转化为局部近距离作用力的计算,从而大大降低了计算复杂度。

具体来说,FMM将空间分割成一系列边长逐级递减的立方体网格,在每个网格中以多项式函数来逼近粒子分布,并利用多极展开和局部展开等技术来实现快速计算。

二、算法流程1. 空间划分:将整个空间划分成若干个立方体网格,并确定每个网格中包含的粒子数目。

2. 多项式逼近:对于每个网格中包含的粒子,采用多项式函数来逼近其分布情况。

3. 多极展开:利用多项式函数对每个网格进行多极展开,并计算其多极矩和电荷矩。

4. 局部展开:对于近距离作用力,采用局部展开技术来计算每个网格中的相互作用力。

5. 远距离作用力计算:对于远距离作用力,采用多极展开技术来计算每个网格之间的相互作用力。

6. 精度控制:根据需要,可以通过增加多项式阶数或网格密度等方式来提高计算精度。

三、优缺点1. 优点:(1) 计算速度快:FMM的时间复杂度为O(N),比传统的直接求解方法要快得多。

(2) 空间复杂度低:FMM只需要存储每个网格中的多项式系数和电荷矩等信息,空间占用较小。

(3) 适用范围广:FMM不仅适用于N体问题,还可以应用于其他需要求解远距离相互作用力的问题。

2. 缺点:(1) 实现难度较大:FMM需要掌握多项式函数、多极展开等专业知识,并且实现过程较为复杂。

(2) 对粒子分布要求较高:FMM需要将空间划分成若干个网格,并要求每个网格中的粒子分布较为均匀,否则会影响计算精度。

四、应用领域FMM在计算物理、计算化学、电磁学等领域都有广泛应用。

例如,在分子动力学模拟中,FMM可以用于求解分子之间的相互作用力,从而得到分子的结构和性质等信息;在电磁场模拟中,FMM可以用于求解电荷分布所产生的电场和磁场等问题。

深度学习试题500问

深度学习试题500问1.1标量、向量、张量之间的联系 1 [填空题]_________________________________1.2张量与矩阵的区别? 1 [填空题]_________________________________1.3矩阵和向量相乘结果 1 [填空题]_________________________________1.4向量和矩阵的范数归纳 1 [填空题]_________________________________1.5如何判断一个矩阵为正定? 2 [填空题]_________________________________1.6导数偏导计算 3 [填空题]_________________________________1.7导数和偏导数有什么区别? 3 [填空题]_________________________________1.8特征值分解与特征向量 3 [填空题]_________________________________1.9奇异值与特征值有什么关系? 4 [填空题]_________________________________1.10机器学习为什么要使用概率? 4 [填空题]_________________________________1.11变量与随机变量有什么区别? 4 [填空题]_________________________________1.12常见概率分布? 5 [填空题]_________________________________1.13举例理解条件概率 9 [填空题]_________________________________1.14联合概率与边缘概率联系区别? 10 [填空题]_________________________________1.15条件概率的链式法则 10 [填空题]_________________________________1.16独立性和条件独立性 11 [填空题]_________________________________1.17期望、方差、协方差、相关系数总结 11 [填空题] *_________________________________2.1 各种常见算法图示 14 [填空题]_________________________________2.2监督学习、非监督学习、半监督学习、弱监督学习? 15 [填空题] _________________________________2.3 监督学习有哪些步骤 16 [填空题]_________________________________2.4 多实例学习? 17 [填空题]_________________________________2.5 分类网络和回归的区别? 17 [填空题]_________________________________2.6 什么是神经网络? 17 [填空题]_________________________________2.7 常用分类算法的优缺点? 18 [填空题]_________________________________2.8 正确率能很好的评估分类算法吗? 20 [填空题]_________________________________2.9 分类算法的评估方法? 20 [填空题]_________________________________2.10 什么样的分类器是最好的? 22 [填空题]_________________________________2.11大数据与深度学习的关系 22 [填空题]_________________________________2.12 理解局部最优与全局最优 23 [填空题]_________________________________2.13 理解逻辑回归 24 [填空题]_________________________________2.14 逻辑回归与朴素贝叶斯有什么区别? 24 [填空题] _________________________________2.15 为什么需要代价函数? 25 [填空题]_________________________________2.16 代价函数作用原理 25 [填空题]_________________________________2.17 为什么代价函数要非负? 26 [填空题]_________________________________2.18 常见代价函数? 26 [填空题]_________________________________2.19为什么用交叉熵代替二次代价函数 28 [填空题]_________________________________2.20 什么是损失函数? 28 [填空题]_________________________________2.21 常见的损失函数 28 [填空题]_________________________________2.22 逻辑回归为什么使用对数损失函数? 30 [填空题] _________________________________0.00 对数损失函数是如何度量损失的? 31 [填空题] _________________________________2.23 机器学习中为什么需要梯度下降? 32 [填空题] _________________________________2.24 梯度下降法缺点? 32 [填空题]_________________________________2.25 梯度下降法直观理解? 32 [填空题]_________________________________2.23 梯度下降法算法描述? 33 [填空题]_________________________________2.24 如何对梯度下降法进行调优? 35 [填空题]_________________________________2.25 随机梯度和批量梯度区别? 35 [填空题]_________________________________2.26 各种梯度下降法性能比较 37 [填空题]_________________________________2.27计算图的导数计算图解? 37 [填空题]_________________________________2.28 线性判别分析(LDA)思想总结 39 [填空题] _________________________________2.29 图解LDA核心思想 39 [填空题]_________________________________2.30 二类LDA算法原理? 40 [填空题]_________________________________2.30 LDA算法流程总结? 41 [填空题]_________________________________2.31 LDA和PCA区别? 41 [填空题]_________________________________2.32 LDA优缺点? 41 [填空题]_________________________________2.33 主成分分析(PCA)思想总结 42 [填空题] _________________________________2.34 图解PCA核心思想 42 [填空题]_________________________________2.35 PCA算法推理 43 [填空题]_________________________________2.36 PCA算法流程总结 44 [填空题]_________________________________2.37 PCA算法主要优缺点 45 [填空题]_________________________________2.38 降维的必要性及目的 45 [填空题]_________________________________2.39 KPCA与PCA的区别? 46 [填空题]_________________________________2.40模型评估 47 [填空题]_________________________________2.40.1模型评估常用方法? 47 [填空题]_________________________________2.40.2 经验误差与泛化误差 47 [填空题]_________________________________2.40.3 图解欠拟合、过拟合 48 [填空题]_________________________________2.40.4 如何解决过拟合与欠拟合? 49 [填空题] _________________________________2.40.5 交叉验证的主要作用? 50 [填空题]_________________________________2.40.6 k折交叉验证? 50 [填空题]_________________________________2.40.7 混淆矩阵 50 [填空题]_________________________________2.40.8 错误率及精度 51 [填空题]_________________________________2.40.9 查准率与查全率 51 [填空题]_________________________________2.40.10 ROC与AUC 52 [填空题]_________________________________2.40.11如何画ROC曲线? 53 [填空题]_________________________________2.40.12如何计算TPR,FPR? 54 [填空题]_________________________________2.40.13如何计算Auc? 56 [填空题]_________________________________2.40.14为什么使用Roc和Auc评价分类器? 56 [填空题]_________________________________2.40.15 直观理解AUC 56 [填空题]_________________________________2.40.16 代价敏感错误率与代价曲线 57 [填空题]_________________________________2.40.17 模型有哪些比较检验方法 59 [填空题]_________________________________2.40.18 偏差与方差 59 [填空题]_________________________________2.40.19为什么使用标准差? 60 [填空题]_________________________________2.40.20 点估计思想 61 [填空题]_________________________________2.40.21 点估计优良性原则? 61 [填空题]_________________________________2.40.22点估计、区间估计、中心极限定理之间的联系? 62 [填空题] _________________________________2.40.23 类别不平衡产生原因? 62 [填空题]_________________________________2.40.24 常见的类别不平衡问题解决方法 62 [填空题] _________________________________2.41 决策树 64 [填空题]_________________________________2.41.1 决策树的基本原理 64 [填空题]_________________________________2.41.2 决策树的三要素? 64 [填空题]_________________________________2.41.3 决策树学习基本算法 65 [填空题]_________________________________2.41.4 决策树算法优缺点 65 [填空题]_________________________________2.40.5熵的概念以及理解 66 [填空题]_________________________________2.40.6 信息增益的理解 66 [填空题]_________________________________2.40.7 剪枝处理的作用及策略? 67 [填空题]_________________________________2.41 支持向量机 67 [填空题]_________________________________2.41.1 什么是支持向量机 67 [填空题]_________________________________2.25.2 支持向量机解决的问题? 68 [填空题]_________________________________2.25.2 核函数作用? 69 [填空题]_________________________________2.25.3 对偶问题 69 [填空题]_________________________________2.25.4 理解支持向量回归 69 [填空题]_________________________________2.25.5 理解SVM(核函数) 69 [填空题]_________________________________2.25.6 常见的核函数有哪些? 69 [填空题]_________________________________2.25.6 软间隔与正则化 73 [填空题]_________________________________2.25.7 SVM主要特点及缺点? 73 [填空题]_________________________________2.26 贝叶斯 74 [填空题]_________________________________2.26.1 图解极大似然估计 74 [填空题]_________________________________2.26.2 朴素贝叶斯分类器和一般的贝叶斯分类器有什么区别? 76 [填空题] _________________________________2.26.4 朴素与半朴素贝叶斯分类器 76 [填空题]_________________________________2.26.5 贝叶斯网三种典型结构 76 [填空题]_________________________________2.26.6 什么是贝叶斯错误率 76 [填空题]_________________________________2.26.7 什么是贝叶斯最优错误率 76 [填空题]_________________________________2.27 EM算法解决问题及实现流程 76 [填空题] _________________________________2.28 为什么会产生维数灾难? 78 [填空题]_________________________________2.29怎样避免维数灾难 82 [填空题]_________________________________2.30聚类和降维有什么区别与联系? 82 [填空题] _________________________________2.31 GBDT和随机森林的区别 83 [填空题]_________________________________2.32 四种聚类方法之比较 84 [填空题] *_________________________________3.1基本概念 88 [填空题]_________________________________3.1.1神经网络组成? 88 [填空题]_________________________________3.1.2神经网络有哪些常用模型结构? 90 [填空题] _________________________________3.1.3如何选择深度学习开发平台? 92 [填空题] _________________________________3.1.4为什么使用深层表示 92 [填空题]_________________________________3.1.5为什么深层神经网络难以训练? 93 [填空题]_________________________________3.1.6深度学习和机器学习有什么不同 94 [填空题]_________________________________3.2 网络操作与计算 95 [填空题]_________________________________3.2.1前向传播与反向传播? 95 [填空题]_________________________________3.2.2如何计算神经网络的输出? 97 [填空题]_________________________________3.2.3如何计算卷积神经网络输出值? 98 [填空题]_________________________________3.2.4如何计算Pooling层输出值输出值? 101 [填空题] _________________________________3.2.5实例理解反向传播 102 [填空题]_________________________________3.3超参数 105 [填空题]_________________________________3.3.1什么是超参数? 105 [填空题]_________________________________3.3.2如何寻找超参数的最优值? 105 [填空题]_________________________________3.3.3超参数搜索一般过程? 106 [填空题]_________________________________3.4激活函数 106 [填空题]_________________________________3.4.1为什么需要非线性激活函数? 106 [填空题]_________________________________3.4.2常见的激活函数及图像 107 [填空题]_________________________________3.4.3 常见激活函数的导数计算? 109 [填空题]_________________________________3.4.4激活函数有哪些性质? 110 [填空题]_________________________________3.4.5 如何选择激活函数? 110 [填空题]_________________________________3.4.6使用ReLu激活函数的优点? 111 [填空题]_________________________________3.4.7什么时候可以用线性激活函数? 111 [填空题]_________________________________3.4.8怎样理解Relu(<0时)是非线性激活函数? 111 [填空题] _________________________________3.4.9 Softmax函数如何应用于多分类? 112 [填空题]_________________________________3.5 Batch_Size 113 [填空题]_________________________________3.5.1为什么需要Batch_Size? 113 [填空题]_________________________________3.5.2 Batch_Size值的选择 114 [填空题]_________________________________3.5.3在合理范围内,增大 Batch_Size 有何好处? 114 [填空题] _________________________________3.5.4盲目增大 Batch_Size 有何坏处? 114 [填空题]_________________________________3.5.5调节 Batch_Size 对训练效果影响到底如何? 114 [填空题] _________________________________3.6 归一化 115 [填空题]_________________________________3.6.1归一化含义? 115 [填空题]_________________________________3.6.2为什么要归一化 115 [填空题]_________________________________3.6.3为什么归一化能提高求解最优解速度? 115 [填空题]_________________________________3.6.4 3D图解未归一化 116 [填空题]_________________________________3.6.5归一化有哪些类型? 117 [填空题]_________________________________3.6.6局部响应归一化作用 117 [填空题]_________________________________3.6.7理解局部响应归一化公式 117 [填空题]_________________________________3.6.8什么是批归一化(Batch Normalization) 118 [填空题] _________________________________3.6.9批归一化(BN)算法的优点 119 [填空题]_________________________________3.6.10批归一化(BN)算法流程 119 [填空题]_________________________________3.6.11批归一化和群组归一化 120 [填空题]_________________________________3.6.12 Weight Normalization和Batch Normalization 120 [填空题] _________________________________3.7 预训练与微调(fine tuning) 121 [填空题]_________________________________3.7.1为什么无监督预训练可以帮助深度学习? 121 [填空题]_________________________________3.7.2什么是模型微调fine tuning 121 [填空题]_________________________________3.7.3微调时候网络参数是否更新? 122 [填空题]_________________________________3.7.4 fine-tuning模型的三种状态 122 [填空题]_________________________________3.8权重偏差初始化 122 [填空题]_________________________________3.8.1 全都初始化为0 122 [填空题]_________________________________3.8.2 全都初始化为同样的值 123 [填空题]_________________________________3.8.3 初始化为小的随机数 124 [填空题]_________________________________3.8.4用1/sqrt(n)校准方差 125 [填空题]_________________________________3.8.5稀疏初始化(Sparse Initialazation) 125 [填空题]_________________________________3.8.6初始化偏差 125 [填空题]_________________________________3.9 Softmax 126 [填空题]_________________________________3.9.1 Softmax定义及作用 126 [填空题]_________________________________3.9.2 Softmax推导 126 [填空题]_________________________________3.10 理解One Hot Encodeing原理及作用? 126 [填空题] _________________________________3.11 常用的优化器有哪些 127 [填空题]_________________________________3.12 Dropout 系列问题 128 [填空题]_________________________________3.12.1 dropout率的选择 128 [填空题]_________________________________3.27 Padding 系列问题 128 [填空题] *_________________________________4.1LetNet5 129 [填空题]_________________________________ 4.1.1模型结构 129 [填空题]_________________________________ 4.1.2模型结构 129 [填空题]_________________________________ 4.1.3 模型特性 131 [填空题]_________________________________ 4.2 AlexNet 131 [填空题]_________________________________ 4.2.1 模型结构 131 [填空题]_________________________________ 4.2.2模型解读 131 [填空题]_________________________________ 4.2.3模型特性 135 [填空题]_________________________________ 4.3 可视化ZFNet-解卷积 135 [填空题] _________________________________ 4.3.1 基本的思想及其过程 135 [填空题] _________________________________ 4.3.2 卷积与解卷积 136 [填空题]_________________________________ 4.3.3卷积可视化 137 [填空题]_________________________________ 4.3.4 ZFNe和AlexNet比较 139 [填空题] _________________________________4.4 VGG 140 [填空题]_________________________________ 4.1.1 模型结构 140 [填空题]_________________________________ 4.1.2 模型特点 140 [填空题]_________________________________ 4.5 Network in Network 141 [填空题] _________________________________ 4.5.1 模型结构 141 [填空题]_________________________________ 4.5.2 模型创新点 141 [填空题]_________________________________ 4.6 GoogleNet 143 [填空题]_________________________________ 4.6.1 模型结构 143 [填空题]_________________________________ 4.6.2 Inception 结构 145 [填空题]_________________________________ 4.6.3 模型层次关系 146 [填空题]_________________________________ 4.7 Inception 系列 148 [填空题]_________________________________ 4.7.1 Inception v1 148 [填空题]_________________________________4.7.2 Inception v2 150 [填空题]_________________________________4.7.3 Inception v3 153 [填空题]_________________________________4.7.4 Inception V4 155 [填空题]_________________________________4.7.5 Inception-ResNet-v2 157 [填空题]_________________________________4.8 ResNet及其变体 158 [填空题]_________________________________4.8.1重新审视ResNet 159 [填空题]_________________________________4.8.2残差块 160 [填空题]_________________________________4.8.3 ResNet架构 162 [填空题]_________________________________4.8.4残差块的变体 162 [填空题]_________________________________4.8.5 ResNeXt 162 [填空题]_________________________________4.8.6 Densely Connected CNN 164 [填空题]_________________________________4.8.7 ResNet作为小型网络的组合 165 [填空题] _________________________________4.8.8 ResNet中路径的特点 166 [填空题]4.9为什么现在的CNN模型都是在GoogleNet、VGGNet或者AlexNet上调整的? 167 [填空题] *_________________________________5.1 卷积神经网络的组成层 170 [填空题]_________________________________5.2 卷积如何检测边缘信息? 171 [填空题]_________________________________5.2 卷积的几个基本定义? 174 [填空题]_________________________________5.2.1卷积核大小 174 [填空题]_________________________________5.2.2卷积核的步长 174 [填空题]_________________________________5.2.3边缘填充 174 [填空题]_________________________________5.2.4输入和输出通道 174 [填空题]_________________________________5.3 卷积网络类型分类? 174 [填空题]_________________________________5.3.1普通卷积 174 [填空题]_________________________________5.3.2扩张卷积 175 [填空题]_________________________________5.3.3转置卷积 176 [填空题]5.3.4可分离卷积 177 [填空题]_________________________________5.3 图解12种不同类型的2D卷积? 178 [填空题]_________________________________5.4 2D卷积与3D卷积有什么区别? 181 [填空题]_________________________________5.4.1 2D 卷积 181 [填空题]_________________________________5.4.2 3D卷积 182 [填空题]_________________________________5.5 有哪些池化方法? 183 [填空题]_________________________________5.5.1一般池化(General Pooling) 183 [填空题]_________________________________5.5.2重叠池化(OverlappingPooling) 184 [填空题]_________________________________5.5.3空金字塔池化(Spatial Pyramid Pooling) 184 [填空题] _________________________________5.6 1x1卷积作用? 186 [填空题]_________________________________5.7卷积层和池化层有什么区别? 187 [填空题]_________________________________5.8卷积核一定越大越好? 189 [填空题]_________________________________5.9每层卷积只能用一种尺寸的卷积核? 189 [填空题]_________________________________5.10怎样才能减少卷积层参数量? 190 [填空题]_________________________________5.11卷积操作时必须同时考虑通道和区域吗? 191 [填空题]_________________________________5.12采用宽卷积的好处有什么? 192 [填空题]_________________________________5.12.1窄卷积和宽卷积 192 [填空题]_________________________________5.12.2 为什么采用宽卷积? 192 [填空题]_________________________________5.13卷积层输出的深度与哪个部件的个数相同? 192 [填空题]_________________________________5.14 如何得到卷积层输出的深度? 193 [填空题]_________________________________5.15激活函数通常放在卷积神经网络的那个操作之后? 194 [填空题] _________________________________5.16 如何理解最大池化层有几分缩小? 194 [填空题]_________________________________5.17理解图像卷积与反卷积 194 [填空题]_________________________________5.17.1图像卷积 194 [填空题]_________________________________5.17.2图像反卷积 196 [填空题]_________________________________5.18不同卷积后图像大小计算? 198 [填空题]_________________________________5.18.1 类型划分 198 [填空题]_________________________________5.18.2 计算公式 199 [填空题]_________________________________5.19 步长、填充大小与输入输出关系总结? 199 [填空题] _________________________________5.19.1没有0填充,单位步长 200 [填空题]_________________________________5.19.2零填充,单位步长 200 [填空题]_________________________________5.19.3不填充,非单位步长 202 [填空题]_________________________________5.19.4零填充,非单位步长 202 [填空题]_________________________________5.20 理解反卷积和棋盘效应 204 [填空题]_________________________________5.20.1为什么出现棋盘现象? 204 [填空题]_________________________________5.20.2 有哪些方法可以避免棋盘效应? 205 [填空题]_________________________________5.21 CNN主要的计算瓶颈? 207 [填空题]_________________________________5.22 CNN的参数经验设置 207 [填空题]_________________________________5.23 提高泛化能力的方法总结 208 [填空题]_________________________________5.23.1 主要方法 208 [填空题]_________________________________5.23.2 实验证明 208 [填空题]_________________________________5.24 CNN在CV与NLP领域运用的联系与区别? 213 [填空题] _________________________________5.24.1联系 213 [填空题]_________________________________5.24.2区别 213 [填空题]_________________________________5.25 CNN凸显共性的手段? 213 [填空题]_________________________________5.25.1 局部连接 213 [填空题]_________________________________5.25.2 权值共享 214 [填空题]_________________________________5.25.3 池化操作 215 [填空题]_________________________________5.26 全卷积与Local-Conv的异同点 215 [填空题]_________________________________5.27 举例理解Local-Conv的作用 215 [填空题]_________________________________5.28 简述卷积神经网络进化史 216 [填空题] *_________________________________6.1 RNNs和FNNs有什么区别? 218 [填空题]_________________________________6.2 RNNs典型特点? 218 [填空题]_________________________________6.3 RNNs能干什么? 219 [填空题]_________________________________6.4 RNNs在NLP中典型应用? 220 [填空题]_________________________________6.5 RNNs训练和传统ANN训练异同点? 220 [填空题] _________________________________6.6常见的RNNs扩展和改进模型 221 [填空题]_________________________________6.6.1 Simple RNNs(SRNs) 221 [填空题]_________________________________6.6.2 Bidirectional RNNs 221 [填空题]_________________________________6.6.3 Deep(Bidirectional) RNNs 222 [填空题]_________________________________6.6.4 Echo State Networks(ESNs) 222 [填空题]_________________________________6.6.5 Gated Recurrent Unit Recurrent Neural Networks 224 [填空题] _________________________________6.6.6 LSTM Netwoorks 224 [填空题]_________________________________6.6.7 Clockwork RNNs(CW-RNNs) 225 [填空题] *_________________________________7.1基于候选区域的目标检测器 228 [填空题]_________________________________7.1.1滑动窗口检测器 228 [填空题]_________________________________7.1.2选择性搜索 229 [填空题]_________________________________7.1.3 R-CNN 230 [填空题]_________________________________7.1.4边界框回归器 230 [填空题]_________________________________7.1.5 Fast R-CNN 231 [填空题]_________________________________7.1.6 ROI 池化 233 [填空题]_________________________________7.1.7 Faster R-CNN 233 [填空题]_________________________________7.1.8候选区域网络 234 [填空题]_________________________________7.1.9 R-CNN 方法的性能 236 [填空题]_________________________________7.2 基于区域的全卷积神经网络(R-FCN) 237 [填空题] _________________________________7.3 单次目标检测器 240 [填空题]_________________________________7.3.1单次检测器 241 [填空题]_________________________________7.3.2滑动窗口进行预测 241 [填空题]_________________________________7.3.3 SSD 243 [填空题]_________________________________7.4 YOLO系列 244 [填空题]_________________________________7.4.1 YOLOv1介绍 244 [填空题]_________________________________7.4.2 YOLOv1模型优缺点? 252 [填空题]_________________________________7.4.3 YOLOv2 253 [填空题]_________________________________7.4.4 YOLOv2改进策略 254 [填空题]_________________________________7.4.5 YOLOv2的训练 261 [填空题]_________________________________7.4.6 YOLO9000 261 [填空题]_________________________________7.4.7 YOLOv3 263 [填空题]_________________________________8.1 传统的基于CNN的分割方法缺点? 269 [填空题]_________________________________8.1 FCN 269 [填空题]_________________________________8.1.1 FCN改变了什么? 269 [填空题]_________________________________8.1.2 FCN网络结构? 270 [填空题]_________________________________8.1.3全卷积网络举例? 271 [填空题]_________________________________8.1.4为什么CNN对像素级别的分类很难? 271 [填空题]_________________________________8.1.5全连接层和卷积层如何相互转化? 272 [填空题]_________________________________8.1.6 FCN的输入图片为什么可以是任意大小? 272 [填空题]_________________________________8.1.7把全连接层的权重W重塑成卷积层的滤波器有什么好处? 273 [填空题] _________________________________8.1.8反卷积层理解 275 [填空题]_________________________________8.1.9跳级(skip)结构 276 [填空题]_________________________________8.1.10模型训练 277 [填空题]_________________________________8.1.11 FCN缺点 280 [填空题]_________________________________8.2 U-Net 280 [填空题]_________________________________8.3 SegNet 282 [填空题]_________________________________8.4空洞卷积(Dilated Convolutions) 283 [填空题] _________________________________8.4 RefineNet 285 [填空题]_________________________________8.5 PSPNet 286 [填空题]_________________________________8.6 DeepLab系列 288 [填空题]_________________________________8.6.1 DeepLabv1 288 [填空题]_________________________________8.6.2 DeepLabv2 289 [填空题]_________________________________8.6.3 DeepLabv3 289 [填空题]_________________________________8.6.4 DeepLabv3+ 290 [填空题]_________________________________8.7 Mask-R-CNN 293 [填空题]_________________________________8.7.1 Mask-RCNN 的网络结构示意图 293 [填空题]_________________________________8.7.2 RCNN行人检测框架 293 [填空题]_________________________________8.7.3 Mask-RCNN 技术要点 294 [填空题]_________________________________8.8 CNN在基于弱监督学习的图像分割中的应用 295 [填空题] _________________________________8.8.1 Scribble标记 295 [填空题]_________________________________8.8.2 图像级别标记 297 [填空题]_________________________________8.8.3 DeepLab+bounding box+image-level labels 298 [填空题]_________________________________8.8.4统一的框架 299 [填空题] *_________________________________9.1强化学习的主要特点? 301 [填空题]_________________________________9.2强化学习应用实例 302 [填空题]_________________________________9.3强化学习和监督式学习、非监督式学习的区别 303 [填空题] _________________________________9.4 强化学习主要有哪些算法? 305 [填空题]_________________________________9.5深度迁移强化学习算法 305 [填空题]_________________________________9.6分层深度强化学习算法 306 [填空题]_________________________________9.7深度记忆强化学习算法 306 [填空题]_________________________________9.8 多智能体深度强化学习算法 307 [填空题]_________________________________9.9深度强化学习算法小结 307 [填空题] *_________________________________10.1 什么是迁移学习? 309 [填空题]_________________________________10.2 什么是多任务学习? 309 [填空题]_________________________________10.3 多任务学习有什么意义? 309 [填空题]_________________________________10.4 什么是端到端的深度学习? 311 [填空题]_________________________________10.5 端到端的深度学习举例? 311 [填空题]_________________________________10.6 端到端的深度学习有什么挑战? 311 [填空题] _________________________________10.7 端到端的深度学习优缺点? 312 [填空题] *_________________________________13.1 CPU和GPU 的区别? 314 [填空题]_________________________________13.2如何解决训练样本少的问题 315 [填空题]_________________________________13.3 什么样的样本集不适合用深度学习? 315 [填空题]_________________________________13.4 有没有可能找到比已知算法更好的算法? 316 [填空题]_________________________________13.5 何为共线性, 跟过拟合有啥关联? 316 [填空题]_________________________________13.6 广义线性模型是怎被应用在深度学习中? 316 [填空题]_________________________________13.7 造成梯度消失的原因? 317 [填空题]_________________________________13.8 权值初始化方法有哪些 317 [填空题]_________________________________13.9 启发式优化算法中,如何避免陷入局部最优解? 318 [填空题]_________________________________13.10 凸优化中如何改进GD方法以防止陷入局部最优解 319 [填空题] _________________________________13.11 常见的损失函数? 319 [填空题]_________________________________13.14 如何进行特征选择(feature selection)? 321 [填空题]_________________________________13.14.1 如何考虑特征选择 321 [填空题]_________________________________13.14.2 特征选择方法分类 321 [填空题]_________________________________13.14.3 特征选择目的 322 [填空题]_________________________________13.15 梯度消失/梯度爆炸原因,以及解决方法 322 [填空题]_________________________________13.15.1 为什么要使用梯度更新规则? 322 [填空题]_________________________________13.15.2 梯度消失、爆炸原因? 323 [填空题]_________________________________13.15.3 梯度消失、爆炸的解决方案 324 [填空题]_________________________________13.16 深度学习为什么不用二阶优化 325 [填空题]_________________________________13.17 怎样优化你的深度学习系统? 326 [填空题]_________________________________13.18为什么要设置单一数字评估指标? 326 [填空题]_________________________________13.19满足和优化指标(Satisficing and optimizing metrics) 327 [填空题] _________________________________13.20 怎样划分训练/开发/测试集 328 [填空题]_________________________________13.21如何划分开发/测试集大小 329 [填空题]_________________________________13.22什么时候该改变开发/测试集和指标? 329 [填空题]_________________________________13.23 设置评估指标的意义? 330 [填空题]_________________________________13.24 什么是可避免偏差? 331 [填空题]_________________________________13.25 什么是TOP5错误率? 331 [填空题]_________________________________13.26 什么是人类水平错误率? 332 [填空题]_________________________________13.27 可避免偏差、几大错误率之间的关系? 332 [填空题] _________________________________13.28 怎样选取可避免偏差及贝叶斯错误率? 332 [填空题] _________________________________13.29 怎样减少方差? 333 [填空题]_________________________________13.30贝叶斯错误率的最佳估计 333 [填空题]_________________________________13.31举机器学习超过单个人类表现几个例子? 334 [填空题] _________________________________13.32如何改善你的模型? 334 [填空题]_________________________________13.33 理解误差分析 335 [填空题]_________________________________13.34 为什么值得花时间查看错误标记数据? 336 [填空题] _________________________________13.35 快速搭建初始系统的意义? 336 [填空题]_________________________________13.36 为什么要在不同的划分上训练及测试? 337 [填空题] _________________________________13.37 如何解决数据不匹配问题? 338 [填空题]_________________________________13.38 梯度检验注意事项? 340 [填空题]_________________________________13.39什么是随机梯度下降? 341 [填空题]_________________________________13.40什么是批量梯度下降? 341 [填空题]_________________________________13.41什么是小批量梯度下降? 341 [填空题]_________________________________13.42怎么配置mini-batch梯度下降 342 [填空题]_________________________________13.43 局部最优的问题 343 [填空题]_________________________________13.44提升算法性能思路 346 [填空题] *_________________________________14.1 调试处理 358 [填空题]_________________________________14.2 有哪些超参数 359 [填空题]_________________________________14.3 如何选择调试值? 359 [填空题]_________________________________14.4 为超参数选择合适的范围 359 [填空题]_________________________________14.5 如何搜索超参数? 359 [填空题] *_________________________________15.1 什么是正则化? 361 [填空题]_________________________________15.2 正则化原理? 361 [填空题]_________________________________15.3 为什么要正则化? 361 [填空题]_________________________________15.4 为什么正则化有利于预防过拟合? 361 [填空题] _________________________________15.5 为什么正则化可以减少方差? 362 [填空题]_________________________________15.6 L2正则化的理解? 362 [填空题]_________________________________15.7 理解dropout 正则化 362 [填空题]_________________________________15.8 有哪些dropout 正则化方法? 362 [填空题]_________________________________15.8 如何实施dropout 正则化 363 [填空题]_________________________________。

基本函数增长快慢顺序

基本函数增长快慢顺序

常用函数增长快慢顺序如下:

1. 常数函数O(1):最快,无论输入数据的大小,其运行时间都是一个常数,不会随着输入数据的增大而增大。

2. 对数函数O(log n):次之,随着输入数据的增大,其运行时间增长率变慢,一般用于二分查找算法。

3. 线性函数O(n):随着输入数据的增大,其运行时间增长率逐渐增加,一般用于线性搜索算法。

4. 平方函数O(n2):随着输入数据的增大,其运行时间增长率急剧增加,一般用于冒泡排序算法。

5. 立方函数O(n3):极慢,随着输入数据的增大,其运行时间增长率极快,一般用于三重循环算法。

6. 指数函数O(2n):最慢,随着输入数据的增大,其运行时间增长率极快,一般用于求解NP完全问题算法。

时间序列部分周期模式的更新算法

时间序列部分周期模式的更新算法王晓晔;肖迎元;张德干【摘要】In order to solve the problem of high complexity in the computation of the on-line incremental partial periodic pattern mining, this paper presented mining technology from a time series database based on a moving-window. In the process of data mining in time series, in some scenarios, it is only necessary to mine the partial periodic patterns in the recent time series databases in order to forecast the future action trend in time series. Therefore, during the mining, it needs to mine the partial periodic patterns in the recent time series databases using time window based on the former mining results. The proposed incremental on-line mining algorithm can focus the discovery on the recent data using a moving-window, which only needs to scan the data set in the specified time window two times at most. The algorithm was demonstrated in synthetic time series databases and the traffic time series databases. The experimental results show that the new algorithm has a higher computing efficiency than the non-moving-window algorithm in many aspects for large databases.%针对在线增量部分周期模式挖掘中计算复杂度过高的问题,提出了一种带移动时间窗的时间序列部分周期模式挖掘算法.在时间序列的数据挖掘过程中,某些应用场合只要求对近期的时间序列数据进行挖掘发现部分周期模式,作为时间序列未来行为趋势的预测.因此在挖掘过程中,利用时间窗口,在先前挖掘结果的基础上,对最近的时间序列进行部分周期模式挖掘.文中增量式的在线挖掘算法对指定时间窗口中的数据搜索不多于2次.分别对合成时间序列和交通流时间序列数据进行了实验,数据表明,与不带移动窗的现有算法相比,搜索速度大大加快,该算法对大型时间序列数据非常有效.【期刊名称】《哈尔滨工程大学学报》【年(卷),期】2011(032)011【总页数】5页(P1484-1488)【关键词】对间序列;部分周期模式;移动窗;频繁模式【作者】王晓晔;肖迎元;张德干【作者单位】天津理工大学智能计算及软件新技术重点实验室,天津300191;天津理工大学计算机视觉与系统省部共建教育部重点实验室,天津300191;天津理工大学智能计算及软件新技术重点实验室,天津300191;天津理工大学计算机视觉与系统省部共建教育部重点实验室,天津300191;天津理工大学智能计算及软件新技术重点实验室,天津300191;天津理工大学计算机视觉与系统省部共建教育部重点实验室,天津300191【正文语种】中文【中图分类】TP391.4时间序列部分周期模式的挖掘是一类重要的数据挖掘任务,在许多场合都有重要的应用,如电力负荷时序数据的高峰期往往具有部分周期性,发现这种周期就可以避开高峰用电,减轻电厂的负担.对于时间序列数据挖掘的研究主要集中在相似性问题和时态模式挖掘的研究[1-2].其中相似性问题研究主要是面向查询的需要[3-4],包括各种相似性搜索算法[1]的研究.时态模式挖掘则主要包括各种序列的模式挖掘,进行时态因果、周期模式、关联规则和重要事件的预测[5]等内容.在时态模式的挖掘方面,从时间序列中抽取模式是一个比较新颖的方向.从研究内容来分,目前研究重点主要集中在2个方面:对时序中的事件出现加以模式发现和预测,如时态因果和关联规则;挖掘时序数据的周期模式,包括全周期模式和部分周期模式.部分周期模式的研究大多采用了Apriori-like启发式挖掘算法的思想和理论.由于Apriori-like不能发现不同周期之间的模式和计算复杂度过大等,文献[6]提出了一种对单周期和多周期都适用的部分周期模式挖掘算法:最大子模式迎合树算法(the max-subpattern hit set tree,Mht).但是该算法只能对现有时间序列数据库进行挖掘,不能进行在线部分周期模式的挖掘.文献[7]在此基础上提出了一种增量式的在线挖掘算法,可以根据新增的数据对最大子模式树进行调整,但是由于数据量会越来越大,因此总的计算量还是很大的.文中提出了一种带移动窗的部分周期模式挖掘算法,由于在某些应用场合数据的分布特性会随着时间的变化而有所变化,所以从较早的数据中提取的模式已经不能反映现有数据所隐含的模式.因此只要求对近期的时间序列数据进行挖掘,每次挖掘过程都是在最近的时间窗口[8]中进行,所挖掘的模式反映了最新的数据集中的知识.本算法对最新窗口中的数据搜索次数不多于2次,因此计算量要大大降低,非常适用于大型时间序列数据库的挖掘.1 时间序列的部分周期模式1.1 问题定义假设一个含有n个时间标记的特征序列,对于每个时刻i,Di为该时刻的特征值(由原始时间序列导出),特征序列的所有特征集定义为L,因此特征时间序列可以表示为例如对于某支股票的原始时间序列,是以天为单位记录该股票的收盘价,则每个时间点的数据为具体的数值,因此需要将其量化为某些特征值(如高、中、低等),然后用一系列字母来表示,则量化所得特征集 L 可以表示为{a,b,c,…}.定义1 模式是一个非空序列s=s1,s2,…,sp,长度p叫做模式的周期,对于∀i,si是一个特征集(若该特征集只包含一个字母,则省略集合符号,如{a}可以写成a,具有j维特征的模式也可以叫做j-模式,在模式中允许符号“*”出现,它表示可以与任意单个字母相匹配.定义2 如果模式s'=s1',s2'…,sp'与s具有相同的长度,且对于∀i,si'⊆si,则称模式 s'为模式 s的子模式.如对于模式 a{b,c}*{a,c}f,第 2 个位置可以是b或c,它是一个长度为5的模式,即周期为5,而模式中含有4个字母,因此又叫做4-模式.显然模式ac*cf和a**cf是模式a{b,c}*{a,c}f的子模式,而模式ab*ac不是它的子模式.由定义可知,任意模式的特征维数要大于或等于它的子模式的特征维数.定义3 一个特征时间序列S形式如式(1)所示,可以被分割成长度相等(长度为p)相互独立的模式,则 S=S1,S2,…,Si,…,其中 Si=Dip+1,…,Dip+p,i=0,…,[n/p]-1,则每个模式 Si叫做一个周期段,其周期为p.如果一个周期段Si是模式s的子模式,则称周期段Si与模式s相匹配.定义4 一个模式s在某个特征时间序列中的频率值是指这个时间序列中与模式相匹配的周期段的个数,记作frequency_count(s).显然若时间序列有m个周期段,则频率值应小于m,在极端情况下(所有周期段都与该模式匹配)等于m.定义5 一个模式s在某个特征时间序列中的置信度是指它在该模式中的频率值与周期段数m的比值,记作confidence(s).则定义6 如果一个模式在特征时间序列中的置信度不小于某个阈值(该阈值记作min_conf),则称这个模式是频繁部分周期模式,j维频繁部分周期模式集简称为j-频繁模式集,记作Fj.1.2 部分周期模式挖掘部分周期模式挖掘算法基于文献[6]中提出的最大子模式迎合树算法(Mht).算法中通过扫描特征时间序列构建了一个叫做最大子模式的树T(如图1所示),树上的节点代表了时间序列的所有候选频繁模式.子节点是父节点的子模式,由子模式的定义知,子节点的特征维数要小于父节点的特征维数.因此当将父节点的某个字母用*代替时,将形成子节点,由图中可知子节点和父节点之间的连接用被取代的字母所标识.构建最大子模式树的关键是产生根节点,它在所有候选频繁模式中特征维数最大,因此叫做最大模式Cmax.Cmax由1-频繁模式集F1的所有元素合并而产生.2个模式s和t的合并操作定义为(s∪t)i=si∪ti.如模式 a*bc*与模式bc*r*合并的结果为模式{a,b}cb{c,r}*,若F1={a**,*b* ,*c* ,**d},则Cmax=a{b,c}d.树的子节点的生长是将Cmax与时间序列中的周期段进行求交集时所产生的迎合(hit)的过程.迎合是指 Cmax与周期段的交集,如果 Cmax=a{b,c}d,Si=aba,则他们的迎合为ab*,若树中没有此节点,则在其相应的父节点下面增加该节点,此节点与父节点之间的连接用它与父节点相匹配所错失的字符来标识,并将此节点的迎合值置为1,若此节点已经存在,则将它的迎合值加1,图1中迎合值标注在该节点的旁边,是该节点所代表的模式的迎合次数值(简称迎合值).很显然,某个节点的迎合值并不是它的频率值,因为在它的所有隐含祖先节点中都包含有该节点所代表的模式(如图1中虚线所连接的都是隐含的父子节点关系),如模式*bd的直接父节点是*{b,c}d,隐含父节点是 adb,祖先节点是a{b,c}d,当然隐含父节点往往不止1个,因此求取模式*bd的频率值需要加入它的所有祖先节点的迎合值(即10+0+12+20).树中的节点构成了候选频繁模式集,当某个节点的频率值大于min_conf×m时,则认为该节点所代表的模式是频繁模式.图1 最大模式树举例Fig.1 Example of max pattern treeMht算法的实现步骤如下:1)给定周期p,将特征时间序列S分割成长度为p的一系列周期段S1,S2,…,Sm,m为周期段的段数.2)扫描所有的周期段,得到所有的1-模式集L1及每个模式的频率值,将频率值不小于min_conf×m的1-模式抽取出来组成1-频繁模式集F1.3)将F1的所有元素合并,产生Cmax.4)重新扫描所有周期段,求取周期段与Cmax的交集,若所得到的模式已经存在,则将节点的迎合值加1,否则在相应的父节点下插入新的节点(若它的祖先节点不存在,则插入祖先节点,并将祖先节点的迎合值置0),将新节点的迎合值置1.树的叶节点应该含有2个非*字母,因为已经有1-频繁模式集仅含有1个非*字母. 5)将每个节点的迎合值与它的所有隐含父节点的迎合值相加,得到该节点的频率值,若某个模式的频率值不小于min_conf×m,则该节点所代表的模式为频繁模式.2 带移动窗的的部分周期模式挖掘算法某些时间序列挖掘过程中只要求在近期数据库中进行,因此在挖掘过程中引入时间窗口的概念,时间窗口[8]是指在某个时间区域之前的时间序列数据都是过时的,不用于当前部分周期模式挖掘过程的,即部分周期模式的挖掘过程只是在当前时间区域中进行,提高了挖掘结果的时效性.令当前时间窗口为Cur_window,起止时间为Ttart和Tend,SC为当前时间窗口中的特征时间序列,D为周期段的段数,F为SC中的频繁模式集.从时间Tend到Tnow为时间序列新增的数据,新数据集合为sc,d为sc的周期段的段数,则新时间窗口 New_window的起止时间为 Tstart+(Tnow-Tend)和 Tnow.在Tstart和Tstart+(Tnow-Tend)之间的数据为老数据应淘汰,记为retire,周期段数为r,则新时间窗口New_window的时间序列记为NewSC,NewSC=SC∪sc/retire.模式 X 在 SC、retire、sc和 NewSC中的频率值记为X.frequencyS、X.frequencyr、X.frequencys和 X.frequencyN.经过时间序列数据库的更新,在新时间窗口中的1-模式存在4种情况:1)1-模式在Cur_window和New_window都是非频繁的即 X.frequencyS<min_conf×D,且 X.frequencyN<min_conf(D+d-r).2)1-模式在Cur_window和New_window都是频繁的即 X.frequencyS>min_conf×D,且 X.frequencyN>min_conf×(D+d-r).3)1-模式在Cur_window是频繁的,而在New_window中是非频繁的即X.frequencyS>min_conf×D,但X.frequencyN<min_conf×(D+d-r).4)1-模式在 Cur_window是非频繁的,而在New_window中是频繁的即X.frequencyS<min_conf×D,但X.frequencyN>min_conf×(D+d-r).显然,只需考察3)和4)2种情况即可.MW算法包括2步:1)根据频繁1-模式集的更新算法对F1集进行更新产生F1';2)由 F1'合并产生的最大模式为 C'max,若C'max=Cmax,则保留原来的树T,只需更新各节点的迎合值即可.考虑淘汰的时间序列retire的周期段,求取与C'max的交集,若所得到的模式存在,则将相应节点的迎合值减1;考虑新增时间序列sc的所有周期段,求取与C'max的交集,若所得到的模式存在,则将相应节点的迎合值加1;若C'max≠Cmax,则采用更新算法MTU对最大子模式树进行更新;下面分别介绍频繁1-模式集的更新算法和最大子模式的树的更新算法MTU.2.1 频繁1-模式集的更新算法1)遍历淘汰数据库retire,计算所有的模式X∈F1在retire中的频率值X.frequencyr;遍历新增数据库sc,计算所有的模式X∈F1在sc中的频率值X.frequencys,从而得到F1的所有模式在NewSC中的频率值,X.frequencyN=X.frequencyS+X.frequencyS-X.frequencyr.若 X.frequencyN<min_conf×(D+d-r),则将其淘汰,否则保留.2)在遍历retire和sc的同时,根据sc的每一个周期段构造不在F1中的候选1-模式集C1,对C1中的任一模式Y,若Y.frequencyS<min_conf×(d-r)+Y.frequencyr,依据文献[7]中的引理2,那么 Y 在更新后序列中就必是非频繁的,可将其从C1中删除.3)对原部分时间序列SC/retire进行遍历,计算C1中各个候选 Y在 SC/retire中的频率值,加上Y.frequencyS,便得到Y在更新后时间序列NewSC中的频率值Y.frequencyN,若Y.frequencyN不低于min_conf×(D+d-r),则Y为频繁模式,从而得到新的频繁模式集F1'为保留的F1和C1中的频繁模式的集合.2.2 最大子模式的树的更新算法假设C'max为更新后的最大模式,显然C'max由更新后的1-频繁模式集F1'的所有元素合并而产生.若cj为Cmax第j个位置特征值符号,cj'为C'max第j个位置特征值符号,如果cj≠cj',则cj将被更新为cj'.更新过程分 2 步[7],即先删除cj,形成 Ct max,然后在相应位置增加cj'形成C'max,记录F1与F1相比较有所更新的1-模式集记为U1.同样,相应的最大子模式树的更新过程也分为2步:1)更新是生成树Tt,它的根节点是,很显然是Cmax的子模式,因此,如果在T中有节点代表了,则这个节点变成Tt的根节点,否则,创造一个新的节点.考虑图1的树,若C'max=a{b,e}d,则=abd,abd以及它的直接后代节点ab*便是初始的Tt,而此时树Tt还不完整,需要加上它所有的非直接的后代节点,以及相应的迎合值,扫描树T,对于树T的每一个节点,求它与的交集,然后将所得节点连同其在T中的迎合值插入树Tt中(若该节点已存在,则将迎合值累加).则在树Tt中加入如下模式:abd(10+12),*bd(0+20),a*d(50+10),ab*(8+32).结果如图2所示,同时考虑淘汰的时间序列retire,只需求取那些不包含 U1中的1-模式的周期段与的交集,若所得到的模式存在,则将相应节点的迎合值减1.图2 插入所有后代节点后的树TtFig.2 Tree Ttafter inserting all the posterity node2)更新是在的基础上相应位置增加c'形j成C'max.以C'max为根节点形成的树为T'.显然是C'max的子模式,Tt是根节点C'max的孩子,在Tt根节点的基础上逐个增加新的cj',形成逐层的祖先节点,新形成的祖先节点迎合值初始化为0.显然,含有新增字符的子模式的迎合值不能确定.同时一些其他的新模式或许会出现,如模式aed,因此需要重新搜索时间序列.对原部分时间序列SC/retire进行遍历,只需求取那些包含U1中的1-模式的周期段与C'max的交集,若所得到的模式已经存在,则将节点的迎合值加1,否则在相应的父节点下插入新的节点(若它的祖先节点不存在,则插入祖先节点,并将祖先节点的迎合值置0),将它的迎合值置1.搜索新增时间序列sc的所有周期段,将它与Cmax'的交集加入树T'中,过程如上述.3 计算复杂度分析本文提出的MW算法,对于长度为D+d的时间序列,扫描次数最多为2次.在第1)步中的工作主要是检查F1中的频繁模式是否保持频繁,是在对sc和retire进行1次搜索完成的,同时对sc构造出的候选集C1进行修剪,搜索Sc/retire,从C1中发现新的频繁1-模式.总共在1)对Sc+sc搜索了1次,但是由于算法计算很简单,因此计算量很小.在2)中,若C'max=Cmax,则只需对retire和sc搜索1次,只有在C'max≠Cmax时,才需要对当前时间窗口Sc和新增窗口sc进行搜索,而且对Sc进行搜索时,只是对某些符合条件的周期段进行搜索,因此在第2)步中,最坏的情况下搜索1次,关于最大子模式树的构建中计算复杂度分析见文献[5].4 算法测试及结果分析在实验中使用2个数据库进行实验,其中一个是人工合成数据库,用一个随机时间序列生成器产生所需的1 000 000个含有4个特征值的时间序列数据.另一个是某城市某个主干道某检测面的交通流量检测数据,其检测间隔为5 min,数据库大小为12 M,截取的数据片度如图3所示,其中的连续数据通过行业专家的经验被量化为5个等级:很小、小,中等、大和很大.图3 交通流量数据Fig.3 Traffic flow data实验中分别将增量长度d和置信度阈值min_conf作了变化,其周期分别定为4和24.算法实现采用Matlab编程工具,运行机型为赛扬M,1.46GHz的主频,256M内存的PC机,为分析其计算效率,结果如下.实验发现,当周期为24时,可以得到明显的符合实际的周期模式.而由于周期为4时,周期过短而造成无法很好的识别部分周期的结果.表1 在人工合成时间序列上的运行结果Table 1 Run time on the synthetic data 新增数据长度运行时间/s MW Mht 100 0.053 75 4.859 200 0.050 16 4.281300 0.047 03 3.047 400 0.047 03 3.078 500 0.042 03 1.584 600 0.042 190.512表2 在交通时间序列上的运行时间比较Table 2 Run time on the traffic time series data新增数据长度运行时间/s MW Mht 240 0.082 5.281 360 0.0784.044 480 0.062 2.078 600 0.061 1.084 720 0.056 0.312表1和表2分别给出了当窗口长度分别固定为2 000和2 400,min_conf=30%时,2种算法在合成时间序列和交通流时间序列中的运行时间比较.由表中可以发现,本文所提出的基于移动窗的MW算法所用的时间要比最大子模式迎合树Mht算法要少的多,而且MW算法的运行时间几乎不随新增数据长度的变化而变化,对于大型时间序列数据运行时间比较稳定,这是因为MW算法每次的计算对象都是新窗口中的数据,而且当新窗口中的1-模式没有变化时,则不需要对最大子模式树的结构进行更新.而Mht算法随着新增数据长度的增长运行时间而减少,这是因为在总的数据长度不变的情况下,增加新增数据的长度将会减少最大子模式树总的更新次数,从而降低了计算时间.因此,MW算法更适合于大型时间序列数据. 图4 当min_conf值变化时的运行时间Fig.4 The run time when min_conf change为说明置信度阈值对计算时间的影响,图4给出了当窗口长度D=2 000和新增数据长度d=200,而改变置信度阈值min_conf时,2种算法对于合成时间序列的计算时间比较结果.由图4可见,2种算法随着置信度阈值的增大,计算时间都在减小,这是因为随着置信度阈值的增大,1-频繁模式越来越少,因此总的计算量也越来越小,而且当置信度阈值超过50%时,计算时间变化会很小,这是因为此时,满足条件的1-频繁模式很少,而且变化不大,从而使得不必进行过多的计算.5 结束语提出了一种带移动时间窗的时间序列部分周期模式挖掘算法.在挖掘过程中数据不断的被采集,数据的性能分布也会有相应的变化,为了挖掘最新的模式,利用移动时间窗,在先前挖掘结果的基础上,对最近的时间序列进行部分周期模式挖掘.文中提出的算法最多对指定时间窗口中的数据搜索2次即可.既保证了挖掘结果的时效性又降低了算法的计算复杂度.实验中在各种条件下,对算法进行了不同侧面的比较,搜索速度加快,使得该算法更适用于大型时间序列数据库的部分周期模式挖掘.参考文献:【相关文献】[1]RODDICK J F,SPILIOPOULOU M.A survey of temporal knowledge discovery paradigms and methods[J].IEEE Trans on Knowledge and Data Engineering,2002,14(4):750-767.[2]HU X,XU P,WU Sh,et al.A data mining framework for time series estimation [J].J Biomed Inform,2010,43(2):190-199.[3]LIAN X,CHEN L.Efficient similarity search over future stream time series[J].IEEE Trans on Knowledge and Data Engineering,2008,20(1):40-54.[4]MARTEAU P F.Time warp edit distance with stiffness adjustment for time series matching[J].IEEE Trans On Pattern A-nalysis and Machine Intelligence,2009,31(2):306-318.[5]RICHARD J.POVINELLI XIN F.A new temporal pattern identification methord for characterization and prediction of complex time series events[J].IEEE Trans on Knowledge and Data Engineering,2003,15(2):339-352.[6]HAN J,GONG W,YIN Y.Efficient mining of partial periodic patterns in time series database[C]//Proc 15th Int'l Conf Data Eng Sydney,Australia,1999:106-115.[7]AREF W G,ELFEKY M G,ELMAGARMID A K.Incremental,online,and merge mining of partial periodic patterns in time-series databases[J].IEEE Trans on Knowledge and Data Engineering,2004,16(3):332-342.[8]欧阳为民,蔡庆生.基于时间窗口的增量式关联规则更新技术[J].软件学报,1999,10(4):427-429.OUYANG Weimin,CAI Qingsheng.A Time-window based incremental technique for updating association rules[J].Journal of software,1999,10(4):427-429。

序列密码三

二、B-M算法与序列的线性复杂度

1、B-M算法解决的问题 给定序列能否找到阶数尽可能小的线性移位寄存器来生成。

具体的:设 a = ( a 0 a1 a 2 L )是长度为 N 的序列,

N

f N ( x )是一个能生成 a N 并且阶数最小的线性移 位寄存器的联系多项式, l N 是该线性移位寄存 器的阶数,( f N ( x ), l N )为 a N 的线性综合解。 BM 算法就是来求这一个线性综合解。

2、B-M算法

它是一个迭代算法,先算出 a n的综合解 , 再算出 a n +1的综合解,直到算出 a ( N )的综合解 , 具体如下:

1)设 n0 是满足 a 0 = a1 = L = a n0 −1 = 0, 而 a n0 ≠ 0的非 负整数。取 d 0 = d1 = L = d n0 −1 = 0, d n0 = a n0 f1 ( x ) = f 2 ( x ) = L f n0 ( x ) = 1, f n0 +1 ( x ) = 1 − d n0 x n0 +1 l1 = l2 = L = ln0 = 0, ln0 +1 = n0 + 1

5、 f ( x ) ∈ Fq [ x ]并且常数项为1,次数为 n ,则任意非零序列 a ∞ ∈ G(f )都是 m序列的充要条件 f(x )是本原多项式。

m序列的特性? 周期性

如 何 由 m序 列 求 出 f ( x )

一、m序列的伪随机性

1、GF(2)上的随机序列的一般特性

设ξ ∞ = (ξ 0 , ξ1 ,L)是GF(2)上的随机序列,则具有以下特性:

长为n的1游程有1个,因为一个周期中有状态11…11(n个) 但不会有n+1个1在一起,那样会出现两个全1状态,矛 盾。所以这n个1的前后都是0,从而是一个长为n的1游 程。形如: 011…110

数字信号处理_东南大学中国大学mooc课后章节答案期末考试题库2023年

数字信号处理_东南大学中国大学mooc课后章节答案期末考试题库2023年1.对x(n)(【图片】)和【图片】分别作20点的DFT,得X(k)和Y(k),F(k)=X(k)Y(k)【图片】,f(n)=IDFT[F(k)],n在范围内时,f(n)是x(n)和y(n)的线性卷积。

答案:2.计算两个N点序列的线性卷积,至少要做多少点得到DFT?答案:2N-13.在脉冲响应不变法设计IIR数字滤波器时,数字角频率【图片】与模拟角频率【图片】的关系为,其中T为采样周期。

答案:4.系统【图片】,其中【图片】,【图片】表示输出,【图片】表示输入。

试确定系统的因果性和稳定性。

答案:非因果稳定系统5.系统【图片】其中【图片】表示输出,【图片】表示输入,试确定系统是否是线性系统?是否是时不变系统?答案:线性时不变系统6.小信号极限环振荡是由运算的舍入引起的。

答案:正确7.频率采样法设计FIR滤波器只能用频率采样型结构实现。

答案:错误8.大信号极限环振荡是由舍入运算引起的。

答案:错误9.设模拟滤波器的系统函数为【图片】,若利用脉冲响应不变法设计IIR数字滤波器,采样周期为T,则IIR数字滤波器的系统函数为。

答案:10.巴特沃斯滤波器阶数越高,则。

答案:阻带衰减越大11.滤波器是带内带外等波纹的。

答案:椭圆12.在IIR数字滤波器设计中,用方法只适于分段常数频响特性滤波器的设计。

答案:双线性变换法13.请确定以下序列的周期长度:【图片】答案:5614.已知信号x(t)为带限信号,最高截止频率300Hz,当采样频率为500Hz时,采样信号频谱不会产生混叠。

答案:错误15.一带通模拟信号如图所示,现用以下采样频率对其采样。

(1)10Hz (2)25Hz(3)50Hz (4) 100Hz求采样后哪几种采样频率存在混叠?【图片】答案:(1)_(2)16.按照阻带衰减顺序将窗口排序为。

答案:布莱克曼窗,汉明窗,矩形窗17.已知FIR数字滤波器的单位脉冲响应为【图片】,则该滤波器为的线性相位FIR数字滤波器。