ELK日志系统部署方案 cycwll

ELK日志分析系统设计方案

ELK日志分析系统一、ELK日志分析系统介绍1.1传统的日志统计与分析方式日志主要包括系统日志、应用程序日志和安全日志。

系统运维和开发人员可以通过日志了解服务器软硬件信息、检查配置过程中的错误与错误发生的原因。

经常分析日志可以了解服务器的负荷,性能安全性,从而与时采取措施纠正错误。

通常,日志被分散的储存不同的设备上。

如果你管理数十上百台服务器,你还在使用依次登录每台机器的传统方法查阅日志。

这样是不是感觉很繁琐和效率低下。

当务之急我们使用集中化的日志管理,例如:开源的syslog,将所有服务器上的日志收集汇总。

集中化管理日志后,日志的统计和检索又成为一件比较麻烦的事情,一般我们使用grep、awk和wc等Linux命令能实现检索和统计,但是对于要求更高的查询、排序和统计等要求和庞大的机器数量依然使用这样的方法难免有点力不从心。

1.2 ELK介绍开源实时日志分析ELK平台能够完美的解决我们上述的问题,ELK由ElasticSearch、Logstash和Kiabana三个开源工具组成。

(1)、Elasticsearch是个开源分布式搜索引擎,它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。

(2)、Logstash是一个完全开源的工具,可以对日志进行收集、过滤,并将其存储供以后使用(如:搜索)。

(3)、Kibana 也是一个开源和免费的可视化工具,可以为 Logstash 和 ElasticSearch 提供的日志分析友好的 Web 界面,可以帮助汇总、分析和搜索重要数据日志。

1.2.1 Elasticsearch介绍Elasticsearch是一个基于Apache Lucene(TM)的开源搜索引擎,Lucene是当前行业最先进、性能最好的、功能最全的搜索引擎库。

但Lucene只是一个库。

无法直接使用,必须使用Java作为开发语言并将其直接集成到应用中才可以使用,而且Lucene非常复杂,需要提前深入了解检索的相关知识才能理解它是如何工作的。

ELK日志分析系统搭建

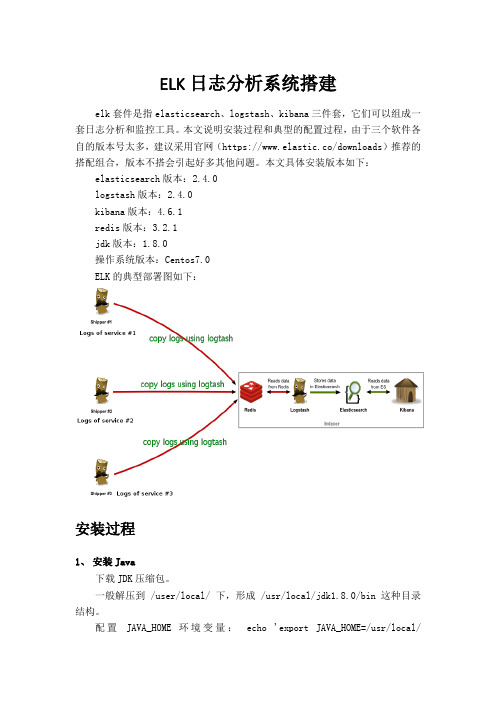

ELK日志分析系统搭建elk套件是指elasticsearch、logstash、kibana三件套,它们可以组成一套日志分析和监控工具。

本文说明安装过程和典型的配置过程,由于三个软件各自的版本号太多,建议采用官网(https://www.elastic.co/downloads)推荐的搭配组合,版本不搭会引起好多其他问题。

本文具体安装版本如下:elasticsearch版本:2.4.0logstash版本:2.4.0kibana版本:4.6.1redis版本:3.2.1jdk版本:1.8.0操作系统版本:Centos7.0ELK的典型部署图如下:安装过程1、安装Java下载JDK压缩包。

一般解压到 /user/local/ 下,形成 /usr/local/jdk1.8.0/bin 这种目录结构。

配置JAVA_HOME 环境变量:echo 'export JAVA_HOME=/usr/local/jdk1.8.0' >> ~/.bashrc 。

2、安装logstash使用root用户进行安装,实际上解压后直接运行就可以了# tar -zxvf logstash-2.4.0.tar.gz# cd logstash-2.4.0可通过bin/logstash -e 'input {stdin{}} output {stdout{}}'测试[root@localhost logstash-2.4.0]# bin/logstash -e 'input {stdin{}} output {stdout{}}'Settings: Default pipeline workers: 8Pipeline main started键入:hello elktest显示:2016-10-20T03:55:59.121Z localhost.localdomain hello elktest 表示把从标准输入设备输入的内容再通过标准输出设备输出。

ELK日志解决方案

ELK日志解决方案日志(log)是指记录系统运行过程中产生的各种信息的一种文件或数据。

在计算机系统中,日志记录是一种非常重要的功能,用于跟踪和监控系统运行状况、故障排查、性能优化、安全审计等方面。

而ELK则是一个用于日志收集、存储、和分析的开源解决方案,它由Elasticsearch、Logstash和Kibana三个开源组件组成。

ELK解决方案的核心组件分别是:1. Elasticsearch:一个基于Lucene的分布式和分析引擎,用于存储和索引大量的日志数据,并提供高性能的和分析能力。

3. Kibana:一个用于可视化和分析日志数据的Web界面,提供了丰富的图表和仪表盘功能,使用户可以通过简单的操作来实现日志数据的、过滤、聚合和可视化。

ELK解决方案的优势有多个方面:1.灵活和可扩展:ELK采用分布式架构,能够方便地进行横向扩展。

它可以适应不同规模和复杂度的日志数据需求,支持存储大量的日志数据,并提供高性能的和分析能力。

2. 强大的和分析功能:Elasticsearch作为核心组件,采用倒排索引和分布式技术,能够实现快速且准确的日志数据和分析。

它支持多种和过滤方式,如全文、模糊、通配符、正则表达式等。

3.实时性:ELK解决方案支持实时数据处理和实时可视化,可以对实时产生的日志数据进行及时的分析和可视化展示,帮助用户及时发现和解决问题。

5.易用性和可定制性:ELK解决方案提供了丰富的文档和示例,容易上手和使用。

同时,它也提供了丰富的插件和API接口,允许用户根据自己的需要对系统进行定制和扩展。

在实际应用中,ELK解决方案可以用于多种情况下的日志处理和分析1.系统性能监控:通过采集和分析系统的运行日志,可以实时监控系统的性能指标,如CPU利用率、内存使用率、磁盘IO等,及时发现并解决性能问题。

2.故障排查和日志审计:通过对日志数据进行、过滤和分析,可以快速定位和排查故障,解决问题。

同时,通过对日志的审计,可以追踪系统的操作记录和安全事件,提高系统的安全性。

日志系统方案

日志系统方案引言随着互联网和云计算的发展,日志系统在软件开发和系统运维中变得越来越重要。

一个高效可靠的日志系统能够帮助开发人员和运维人员快速定位问题和调试代码,提高系统的稳定性和性能。

本文将介绍一个日志系统的基本架构和关键组件,以及一些常用的最佳实践。

日志系统架构一个典型的日志系统包含以下几个组件:•日志收集器(Log Collector): 负责从各个应用程序和系统组件中收集日志信息。

•日志存储(Log Storage): 负责存储收集到的日志信息,通常使用分布式存储系统,如Elasticsearch或Hadoop HDFS。

•日志索引(Log Index): 负责对日志进行索引,以便快速的检索和分析。

•日志搜索(Log Search): 提供用户界面,让用户可以方便地进行日志搜索和查询。

•日志分析(Log Analysis): 对存储的日志数据进行分析,以提取有价值的信息和统计数据。

•日志可视化(Log Visualization): 将日志数据以图表和图形的方式展示,以便用户更直观地理解和分析。

日志收集器日志收集器是日志系统的关键组件之一,它负责从各个应用程序和系统组件中收集日志信息。

常见的日志收集方式有以下几种:1.基于日志框架: 许多编程语言都提供了成熟的日志框架,如Java的Log4j和Python的logging库。

通过使用这些框架,开发人员可以方便地将日志输出到文件、控制台或网络中,从而实现日志收集。

2.系统级日志: 操作系统和运行时环境通常提供了系统级日志功能,如Linux 的rsyslog和Windows的EventLog。

可以通过配置这些系统级日志来收集应用程序的日志信息。

3.应用程序日志调用接口: 对于某些定制化的应用程序,可以通过定义日志调用接口,来收集特定业务的日志信息。

日志存储日志存储是将收集到的日志信息持久化存储的过程。

传统的日志存储方式是将日志信息写入普通文件或数据库中,但随着日志量的增加,这种方式变得越来越不可行。

ELK技术基于邮件系统日志处理方案说明书

International Conference on Network, Communication, Computer Engineering (NCCE 2018)Mail Scheme Log Processing Based on ELK.Bu Yun a)School of Computer Science &Technology, Chongqing University of Posts and Telecommunications, Chongqing400065, Chinaa)Correspondingauthor:****************Abstract. With the continuous development of Internet technology, how to deal with and analyze a large number of data has become a hot spot. The mail system generates a large number of logs every day, and the traditional technology is not efficient in handling huge log data and is unable to make use of the information in the log. Proposing an information processing architecture based on ELK for mail logs to solve these problems. It ex-tracts information from logs by regular expressions, and define the concept of mail events, modeling data and storing them in graph database. The graph database is stored with the original graph of the data. When dealing with a large number of network relationships, it avoids the consumption of data connection in the traditional relational database. The experiment proves that the scheme can realize real-time processing and modeling storage of large moduli data and meet the needs of mail system.Key words: ELK; mail system; hot spot.; original graph; Internet technology.INTRODUCTIONWith the advent of the information age, e-mail has become an indispensable means of communication because of its convenience, speed, and cheap-ness. Users send emails frequently. The mail server generates a large number of logs. These logs contain a lot of valuable information. They record people's previous communication networks, communication habits, and even living habits. Mail is the medium for transmitting information.The effective analysis and processing of the mail log is an important task for the operation and management of the mail system. The mail server generates a large amount of data every day. Since most of the mail logs (such as smtpd, pop3, etc.) are not only large in data size, they also look obscure. In the face of the discovery of mail anomalies, and the need to check the delivery status of mail, if only relying on the manual work of the administrator to view the log records, each time a message is queried, it takes a minute or two, when the demand slightly increases. Large, the workload is very heavy, and the operation is inefficient and error-prone.The mail communication network is a complex flow network, similar to the social dynamic network diagram, without a fixed main structure. Everything has been continuously developed and updated over time [1]. In order to achieve rapid search and mining of these data in real time. This article provides a solution for processing mail logs, aiming to extract fragmented mail information for modeling, making it easier to use the information in the logs for data analysis and research.RELATED WORKThe Status of Email Log ResearchIn recent years, the processing and analysis of email logs has been one of the hot topics for researchers. Using email interaction data to mine user behavior patterns, Li Quangang et al. used Enron public data in the literature [1] to extract the structural features and functional characteristics of the mail network and used non-negative matrix factorization to calculate the basic behavioral units of the network, using vectors to represent User behavior pattern[1]. Yang Zhen et al. [2] also used the improved EM algorithm to determine mail labels in the Enron mail network. According to the interaction strength between users, a collaborative filtering mechanism was designed to filter spam [2]. Hu Tiantian et al. used JavaMail to parse the data in the literature [3], and then built a mail network, calculated the weighted center degree according to the node's connection center degree, closeness center and middle center degree, and excavated the modularity indication to mine the core community. [3]. Chen Bin et al [4] used the mail transfer protocol session log to analyze the behavior of the host based on the failed message in the log record and used the incremental passive attack learning algorithm to effectively adjust the host of the detected spam host. Recent mail classification behavior [4].The massive data processing generated by the mail server is often not a single node in the traditional technology. The distributed software processing framework provides a feasible solution to solve the impact brought by the information wave. Zhang Jianzhong and his colleagues used the ElaticSearch distributed indexing technology to perform distributed indexing and retrieval of resources in the literature [5]. The HDFS distributed file system was used to implement the university library resource retrieval system [5]. Bai Jun et al [6] proposed a software integration scheme based on ElasticSearch real-time large log data search. The experimental results show that with the increase in the number of logs, does not affect the search response time, indicating the feasibility of this program.Framework IntroductionWith the increase of data processing capacity, the storage, computing capacity and processing efficiency of a single node cannot meet the requirements of application scenarios. Traditional methods based on relational database management systems cannot handle analysis problems efficiently.ELK, which is a data processing tool chain consisting mainly of three open source software, Elasticsearch, Logstash, and Kibana, implements distributed and scalable data storage and search. It is a zero-configuration and easy-to-use full-text search mode, supporting distributed processing and supporting systems. Extensions.Elasticsearch, as an open source distributed search and data processing platform, is not only a database, but also an open source, distributed, RESTful-based information retrieval framework built on Lucene that enables real-time search, efficient retrieval, and adoption of JSON data formats. The Ruby DSL design pattern provides Aggregations-based statistics capabilities, while providing easy deployment and setup. The cluster can be easily extended to hundreds of servers to handle structured or unstructured data at the PB level, but it can also run on Single PC [7].Logstash can collect, analyze, and convert related network logs, store them for later use, store them in Elasticsearch, and convert/store them to other destinations. Logstash itself does not generate logs. It is only a pipeline that accepts a wide variety of log input and is processed and forwarded to multiple different destinations [8].Kibana can help aggregate, analyze, and search important data logs and provide a friendly visual interface.As one of the emerging NoSql, Neo4j is currently the most popular graphics database. It stores data in the form of nodes, edges, attributes, and graphs. It provides transaction operations similar to traditional databases for highly connected data, and at the same time It is also several orders of magnitude higher than traditional databases. For a meshed data structure, it turns out to be an ideal choice for dealing with complex data.APPLICATION IMPLEMENTATIONPreprocessing of data FiguresAn e-mail system is mainly composed of three parts: user agent, mail server, mail sending protocol (SMTP) and mail reading protocol. Log in to the email account, log out, delete emails, send emails, receive emails, and delete emails. These operations are logged. Taking the campus mail system as an example, there are 760,000 lines per day for access logs, and up to several million lines for passing logs.The data in the real world is incomplete, in-consistent, and most of the data is unstructured or semi-structured and cannot be used directly. In the experiment, incomplete log records were filtered out, and the daily generated logs were imported into Elasticsearch in JSON format. Visualized by Kibina, the log format in this experiment was as follows.FIGURE 1. visual logs in KibanaThis article selects the log of the message. The message contains the time of the operation, the name of the mail server, the action record, the ID of the current server, the email address, and the opera-tion status. By parsing the information of the mes-sage, you can understand the dynamic behavior of the mail in the current server.The Definition and Structure of Mail EventsIn order to effectively organize the data in the log, the event definitions in the mail log are given below.Definition 1: A complete mail event refers to the process of sending and receiving a mail in the network. Has the following properties:(1) The unique identifier of the mail.(2) Outgoing mailboxes and incoming emails.(3) Shipping time and receiving time.(4) Sending IP and receiving IP.(5) Mail delivery status.The sending relationship of the mail is in line with the graph of the network. We define nodes to represent users and mails, and edges represent the user's sending behavior to mails.SenderReceiver Sendtime Receivetime ReceiveipFIGURE 2. mail event modelAlgorithm DescriptionAccording to the definition requirements, in order to restore event events in a large number of tedious logs, it is logically divided into two steps. First, each message received from the beginning of the transmission to the first server becomes the only one on the server. The ID is identified and the event is restored using each of the above-mentioned IDs obtained after processing.1. Use a regular expression to extract the initial ID in the following log:Jul 28 20:58:39 mx postfix/smtpd[10206]: 8504634015B:Cli-ent= [14.17.44.30] AVYxleipJ4h_jrOyBL_DGet the initial ID set Q= {ids1, ids2..., idsn}.2. For j=1, 2..., n, get idsi∈Q, do3. Enter idsi,S:=Search(idsi), where S is the set of all idsi logs, S={p1,p2,...}.4. Traverse every log in S. The regular email address, the email address, the time of sending, the email, the unique ID of the email, the IP of the email, and the IP of the email in the log.5. Check the log for "status" and "queued as".(1) If "status" is included and the mail delivery status is extracted, the event is restored.(2) If "status" is not included, extract the ID containing the word "queued as" and repeat step 3.6. Take the next ID from Q and repeat step 3.Experimental ResultsThe mail event recovery document format and the import graph database neo4j are visualized as follows:FIGURE 3. mail event in TXT and Neo4jCONCLUSIONA traditional mail log processing method cannot meet the needs of large-scale enterprises or colleges and universities for mail systems. This paper proposes a data processing program based on the ELK software framework that can deal with a large number of mail logs in real time. By introducing the concept of mail events, it extracts the log information from the mail server and establishes a suitable model to achieve efficient query. Visualizing email dynamic network and user behavior has important use value for detecting spam and user behavior patterns.REFERENCES1.Li Jingang, Shi Jinqiao, Qin Zhiguang, Liu Hallwen. User Behavior Pattern Mining for Email Network EventMonitoring[J]. Chinese Journal of Computers, 2014,37(5): 1135-1146.2.Yang Zhen, Lai Yingxu, Duan Lijuan, Li Yujian, Xu Wei. Research on Collaborative Filtering Mechanism ofMail Networks[J]. Acta Automatica Sinica,2012,38(3):399-411.3.Hu Tiantian, Dai Hang, Huang Dongxu. CN-M Based Email Network Core Community Mining[J]. ComputerTechnology and Development. 2014, 24(11):9-12.4.Ian Robinson et al. Fig. Database [M]. Liu Wei et al. Beijing: People's Posts and Telecommunications Press,2016.5.Zhang Jianzhong, Huang Yanfei, Xiong Yongjun. Digital Library Retrieval System Based on ElasticSearch[J].Computer and Modernization. 2015, 6: 69-73.6.Bai Jun, Guo Hebin. Research on software integration scheme for real-time search of big logs based onElasticSearch[J]. Jilin Normal University (Natural Science Edition).2014,1:85-877.Chen Bin, Dong Yizhou, Mao Mingrong.Infrastructure learning algorithm-based campus network spamdetection model[J]. Journal of Computer Applications, 2017,37(1): 206-216.8.Gao Kai. Big Data Search and Log Mining and Visualization Scheme [M]. Beijing: Tsinghua University Press,2016.9.(U.S.) Ian Robinson et al. Fig. Database [M]. Liu Yi et al. Beijing: People's Posts and TelecommunicationsPress, 2016.10.Chen Bin, Dong Yizhou, Mao Mingrong.Infrastructure learning algorithm-based campus network spamdetection model[J]. Journal of Computer Applications, 2017,37(1): 206-216.。

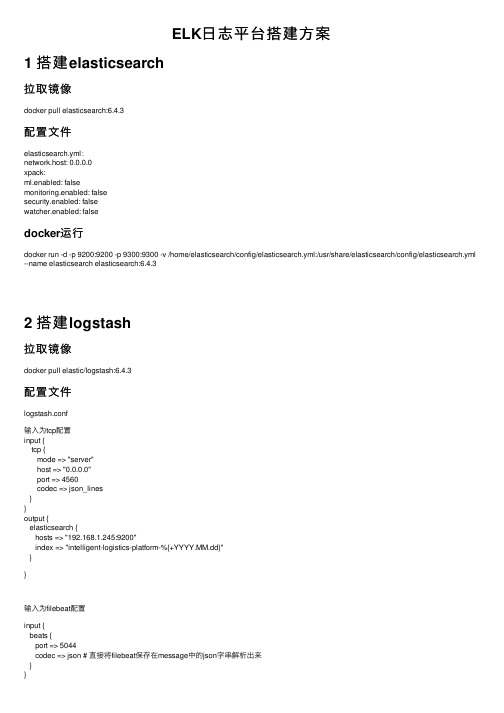

ELK日志平台搭建方案

ELK⽇志平台搭建⽅案1 搭建elasticsearch拉取镜像docker pull elasticsearch:6.4.3配置⽂件elasticsearch.yml:network.host: 0.0.0.0xpack:ml.enabled: falsemonitoring.enabled: falsesecurity.enabled: falsewatcher.enabled: falsedocker运⾏docker run -d -p 9200:9200 -p 9300:9300 -v /home/elasticsearch/config/elasticsearch.yml:/usr/share/elasticsearch/config/elasticsearch.yml --name elasticsearch elasticsearch:6.4.32 搭建logstash拉取镜像docker pull elastic/logstash:6.4.3配置⽂件logstash.conf输⼊为tcp配置input {tcp {mode => "server"host => "0.0.0.0"port => 4560codec => json_lines}}output {elasticsearch {hosts => "192.168.1.245:9200"index => "intelligent-logistics-platform-%{+YYYY.MM.dd}"}}输⼊为filebeat配置input {beats {port => 5044codec => json # 直接将filebeat保存在message中的json字串解析出来}}output {elasticsearch {hosts => ["192.168.48.17:9200","192.168.48.22:9200","192.168.48.18:9200"]index => "%{app_name}-%{+YYYY.MM.dd}"manage_template => true}stdout{codec=>rubydebug}}logstash.ymlhttp.host: "0.0.0.0"docker运⾏docker run -d -p 4560:4560 -v /home/logstash/config:/usr/share/logstash/config --name logstash elastic/logstash:6.4.3 -f /usr/share/logstash/config/logstash.conf3 搭建kibana拉取镜像docker pull docker.elastic.co/kibana/kibana:6.4.3配置⽂件elasticsearch.hosts: ["192.168.48.17:9300","192.168.48.22:9300","192.168.48.18:9300"] #集群连接xpack:apm.ui.enabled: falsegraph.enabled: falseml.enabled: falsemonitoring.enabled: falsereporting.enabled: falsesecurity.enabled: falsegrokdebugger.enabled: falsesearchprofiler.enabled: false4 filebeat k8s配置配置⽂件:filebeat-k8s.yml1 ---2 apiVersion: v13 kind: ConfigMap4 metadata:5 name: filebeat-config6namespace: platform7 data:8 filebeat.yml: |-9 filebeat.prospectors:10 - type: log11 paths:12 - /log/intelligent-logistics-platform/base-activiti/out*.log #容器中的路径13 #- /root/log/intelligent-logistics-platform/base-app-message/*.log14 #- /root/log/intelligent-logistics-platform/base-app-region/*.log15 #- /root/log/intelligent-logistics-platform/base-data-dict/*.log16 #- /root/log/intelligent-logistics-platform/base-gateway/*.log17 #- /root/log/intelligent-logistics-platform/base-id-center/*.log18 #- /root/log/intelligent-logistics-platform/base-logistics/*.log19 #- /root/log/intelligent-logistics-platform/base-message/*.log20 #- /root/log/intelligent-logistics-platform/base-third-party/*.log21 #- /root/log/intelligent-logistics-platform/base-uaa/*.log22 #- /root/log/intelligent-logistics-platform/base-upload-file/*.log23 tags: ["base-activiti"]24 fields_under_root: true25 fields:26 level: info27 app_name: base-activiti2829 - type: log30 paths:31 - /log/intelligent-logistics-platform/base-app-message/out*.log #容器中的路径32 tags: ["base-app-message"]33 fields_under_root: true34 fields:35 level: info36 app_name: base-app-message3738 - type: log39 paths:40 - /log/intelligent-logistics-platform/base-app-region/out*.log #容器中的路径41 tags: ["base-app-region"]42 fields_under_root: true43 fields:44 level: info45 app_name: base-app-region4647 - type: log48 paths:49 - /log/intelligent-logistics-platform/base-data-dict/out*.log #容器中的路径50 tags: ["base-data-dict"]51 fields_under_root: true52 fields:53 level: info54 app_name: base-data-dict5556 - type: log57 paths:58 - /log/intelligent-logistics-platform/base-gateway/out*.log #容器中的路径59 tags: ["base-gateway"]60 fields_under_root: true61 fields:62 level: info63 app_name: base-gateway6465 - type: log66 paths:67 - /log/intelligent-logistics-platform/base-id-center/out*.log #容器中的路径68 tags: ["base-id-center"]69 fields_under_root: true70 fields:71 level: info72 app_name: base-id-center7374 - type: log75 paths:76 - /log/intelligent-logistics-platform/base-logistics/out*.log #容器中的路径77 tags: ["base-logistics"]78 fields_under_root: true79 fields:80 level: info81 app_name: base-logistics8283 - type: log84 paths:85 - /log/intelligent-logistics-platform/base-message/out*.log #容器中的路径86 tags: ["base-message"]87 fields_under_root: true88 fields:89 level: info90 app_name: base-message9192 - type: log93 paths:94 - /log/intelligent-logistics-platform/base-third-party/out*.log #容器中的路径95 tags: ["base-third-party"]96 fields_under_root: true97 fields:98 level: info99 app_name: base-third-party100101 - type: log102 paths:103 - /log/intelligent-logistics-platform/base-uaa/out*.log #容器中的路径104 tags: ["base-uaa"]105 fields_under_root: true106 fields:107 level: info108 app_name: base-uaa109110 - type: log111 paths:112 - /log/intelligent-logistics-platform/base-upload-file/out*.log #容器中的路径113 tags: ["base-upload-file"]114 fields_under_root: true115 fields:116 level: info117 app_name: base-upload-file118119 - type: log120 paths:121 - /log/intelligent-logistics-platform/nginx/*.log #容器中的路径122 tags: ["nginx"]123 fields_under_root: true124 fields:125 level: info126 app_name: nginx127 # processors:128 # -drop_fields:129 # fields: ["beat.hostname","","beat.version","offset","prospector.type"] 130 output.logstash:131 hosts: ['logstash:5044']132133---134135apiVersion: apps/v1136kind: DaemonSet137metadata:138 name: filebeat139 namespace: platform140 labels:141 logs: filebeat142spec:143 selector:144 matchLabels:145 logs: filebeat146 template:147 metadata:148 labels:149 logs: filebeat150 spec:151 terminationGracePeriodSeconds: 30152 containers:153 - name: filebeat154 image: docker.elastic.co/beats/filebeat:6.4.3155 args: [156 "-c", "/usr/share/filebeat.yml",157 "-e",158 ]159 resources:160 limits:161 memory: 500Mi162 requests:163 cpu: 100m164 memory: 200Mi165 volumeMounts:166 - name: config167 mountPath: /usr/share/filebeat.yml168 subPath: filebeat.yml169 - name: data170 mountPath: /usr/share/filebeat/data171 - name: app-logs172 mountPath: /log173 - name: timezone174 mountPath: /etc/localtime175176 volumes:177 - name: config178 configMap:179 name: filebeat-config180 - name: data181 emptyDir: {}182 - name: app-logs183 hostPath:184 path: /root/log185 type: DirectoryOrCreate186 - name: timezone187 hostPath:188 path: /etc/localtimedocker运⾏docker run -d -p 5601:5601 -v /home/kibana/config/kibana.yml:/usr/share/kibana/config/kibana.yml --name kibanadocker.elastic.co/kibana/kibana:6.4.3⽇志采集⽅式⽇志作为任⼀系统不可或缺的部分,在K8S的官⽅⽂档中也介绍了多种的,总结起来主要有下述3种:原⽣⽅式、DaemonSet⽅式和Sidecar ⽅式。

ELK日志收集系统方案

ELK日志收集系统方案ELK是一个开源的日志管理和数据分析平台,它由Elasticsearch、Logstash和Kibana三个组件组成。

ELK日志收集系统方案可以用于实时收集、分析和可视化各种类型的日志数据,帮助企业快速发现问题、监控系统以及做出决策。

下面是一个基本的ELK日志收集系统方案:1.数据源:首先,需要确定要收集的日志数据源。

常见的数据源包括应用程序日志、系统日志、网络设备日志等。

每个数据源都有不同的格式和协议,需要根据实际情况选择合适的方法来收集数据。

对于应用程序日志,可以使用日志记录库(如log4j)将日志直接发送到Logstash;对于系统日志,可以使用rsyslog或syslog-ng等工具将日志发送到Logstash;对于网络设备日志,可以使用SNMP或syslog等协议来收集日志。

2. Logstash:Logstash是一个用于收集、处理和转发日志数据的工具。

它支持各种输入插件和过滤器,可以解析、筛选和转换各种格式的日志数据。

在ELK日志收集系统中,Logstash通常用于收集日志数据并将其发送到Elasticsearch进行存储和索引。

配置Logstash的主要步骤包括:-输入插件:配置输入插件来接收不同类型的日志数据,如文件输入插件、TCP/UDP输入插件等。

- 过滤器插件:配置过滤器插件进行数据转换、修正和筛选处理,如grok插件用于解析日志行、date插件用于解析时间戳等。

- 输出插件:配置输出插件将处理过的日志数据输出到Elasticsearch进行存储和索引。

3. Elasticsearch:Elasticsearch是一个分布式的和分析引擎,它用于存储和索引日志数据。

在ELK日志收集系统中,Elasticsearch负责存储和索引通过Logstash收集的日志数据,提供高性能的全文和聚合分析能力。

在配置Elasticsearch时,需要考虑以下方面:- 节点配置:根据数据量和请求负载的大小,配置适当数量的Elasticsearch节点。

ELK日志分析系统

ELK日志分析系统ELK日志分析系统(Elasticsearch, Logstash, Kibana)是一种用于实时数据分析和可视化的开源工具组合。

它结合了Elasticsearch、Logstash和Kibana这三个工具,可对大量的日志数据进行收集、存储、和分析,并通过直观的可视化界面展示分析结果。

本文将对ELK日志分析系统的原理、功能和应用进行介绍。

2. 数据存储和索引:ELK日志分析系统使用Elasticsearch作为底层存储和索引引擎。

Elasticsearch是一个高性能、分布式的和分析引擎,能够实时地处理大规模的数据,并提供复杂的、聚合和分析功能。

Elasticsearch使用倒排索引来加快速度,并支持多种查询和分析方式,如全文、聚合查询、时序分析等。

3. 数据和查询:ELK日志分析系统通过Elasticsearch提供强大的和查询功能。

用户可以使用简单的关键字查询或复杂的过滤条件来和筛选数据。

同时,Elasticsearch还支持模糊、近似和正则表达式等高级方式,以便更精确地找到所需的数据。

4. 数据可视化和分析:ELK日志分析系统的另一个重要功能是数据的可视化和分析。

通过Kibana工具,用户可以创建自定义的仪表板和图表,展示日志数据的各种指标和趋势。

Kibana支持多种图表类型,如柱状图、折线图、饼图等,并提供交互式过滤和数据透视功能,以帮助用户更好地理解和分析数据。

ELK日志分析系统在实际应用中具有广泛的用途。

首先,它可以用于系统监控和故障排查。

通过收集和分析系统日志,可以实时监控系统的运行状态,并及时发现和解决潜在的问题。

其次,ELK日志分析系统可以用于安全事件检测和威胁分析。

通过分析网络和应用日志,可以识别潜在的安全威胁,提高系统的安全性。

此外,ELK日志分析系统还可以用于运营分析、业务分析和市场分析等领域,帮助企业更好地理解和利用日志数据,提升业务效率和竞争力。

总之,ELK日志分析系统是一种功能强大的实时数据分析和可视化工具组合。

ELK日志分析系统

ELK日志分析系统ELK日志分析系统是一种常用的开源日志管理和分析平台。

它由三个主要组件组成,即Elasticsearch、Logstash和Kibana,分别用于收集、存储、分析和可视化日志数据。

本文将介绍ELK日志分析系统的原理、特点和应用场景等。

ELK日志分析系统具有以下几个特点。

首先,它是一个开源系统,用户可以自由获取、使用和修改代码,满足各种定制化需求。

其次,它具有高度的可扩展性和灵活性,可以处理海量的日志数据,并支持实时查询和分析。

再次,它采用分布式架构,可以部署在多台服务器上,实现高可用性和负载均衡。

最后,它提供了丰富的可视化工具和功能,让用户可以直观地了解和分析日志数据,发现潜在的问题和异常。

ELK日志分析系统在各种场景下都有广泛的应用。

首先,它可以用于系统日志的监控和故障诊断。

通过收集和分析系统的日志数据,可以及时发现和解决问题,保证系统的正常运行。

其次,它可以用于应用程序的性能监控和优化。

通过分析应用程序的日志数据,可以找到性能瓶颈和潜在的问题,并采取相应的措施进行优化。

再次,它可以用于网络安全监控和威胁检测。

通过分析网络设备和服务器的日志数据,可以及时发现并应对潜在的安全威胁。

最后,它还可以用于业务数据分析和用户行为追踪。

通过分析用户的访问日志和行为日志,可以了解用户的偏好和行为模式,为业务决策提供依据。

然而,ELK日志分析系统也存在一些挑战和限制。

首先,对于大规模的日志数据,ELK系统需要消耗大量的存储和计算资源,对硬件设施和系统性能要求较高。

其次,ELK系统对日志的结构有一定的要求,如果日志数据过于复杂或不规范,可能会造成数据解析和处理的困难。

再次,ELK系统对于数据的实时性要求较高,以保证用户能够在短时间内获取到最新的数据和分析结果。

最后,对于非技术人员来说,ELK系统的配置和使用可能较为复杂,需要一定的培训和专业知识。

总之,ELK日志分析系统是一种功能强大且灵活的日志管理和分析工具,可以帮助用户实现日志数据的收集、存储、分析和可视化展示。

ELK日志归集 - 搭建及使用说明文档V1

ELK使用指导书文件更改摘要目录1. 背景 (1)2. 架构 (1)3. ELK介绍 (2)4. ELK软件版本 (2)5. kafka、Zookeeper安装配置 (2)6. Filebeat安装配置 (6)7. elasticsearch安装配置 (8)8. logstash安装配置 (12)9. kibana安装配置 (14)1.背景早期在系统规模较小的时期,系统的运维工作主要靠运维人员手工完成,随着业务的急剧膨胀,及服务的多样化,让网络的组建变得越来越复杂,一个系统可能涉及到多个设备,部署多个实例,运维人员手工的去查看定位问题变得困难,效率低效。

设备的增加让跨运维小组之间的沟通代价变得很高,各种日志和告警散落在不同的设备上,如果日志的文件设计不合理,可能还会导致打开日志文件耗时高,甚至失败的结果。

为了解决这些困难,统一日志中心应运而生。

2.架构Elastic Stack 提供Beats 和Logstash 套件来采集任何来源、任何格式的数据。

其实Beats 和Logstash的功能差不多,都能够与Elasticsearch 产生协同作用,而且。

logstash比filebeat功能更强大一点,2个都使用是因为:Beats 是一个轻量级的采集器,支持从边缘机器向Logstash 和Elasticsearch 发送数据。

考虑到Logstash 占用系统资源较多,我们采用Filebeat 来作为我们的日志采集器。

并且这里采用kafka作为传输方式是为了避免堵塞和丢失,以实现日志的实时更新。

3.ELK介绍1.Filebeat:filebat是一个用于转发和集中日志数据的轻量级shipper。

作为代理安装在服务器上,filebeat监视指定的日志文件或位置,收集日志事件,并将它们转发给ElasticSearch或logstash进行索引。

2.Logstash:Logstash 是开源的服务器端数据处理管道,能够同时从多个来源采集数据,转换数据,然后将数据发送到存储库。

ELK日志平台搭建

ELK日志平台搭建安装环境centos7.0 单点搭建一,准备工作rpm包安装elkjdk环境:jdk-8u65-linux-x64.rpm(用于es和kibana) jdk-8u91-linux-x64.gz(用于logstash)elk安装包:elasticsearch-5.3.0.rpm ;kibana-5.3.0-x86_64.rpm; logstash-5.3.0.rpm elasticsearch head插件需要的node包 node-v6.10.2-linux-x64.tar.xz包放在 /usr/loacl/src/EShead插件所需要的包elasticsearch-head.tar phantomjs.tar关闭防火墙systemctl stop firewalld.service #停止firewallsystemctl disable firewalld.service #禁止firewall开机启动firewall-cmd --state #查看默认防火墙状态(关闭后显示notrunning,开启后显示running)修改hostnamehostname #查看主机名hostnamectl set-hostname elk_zabbix ##修改主机名hostnamectl status ##查看主机名状态修改hosts[root@elk_zabbix ~]# vim /etc/hosts127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4::1 localhost localhost.localdomain localhost6 localhost6.localdomain6110.24.166.104 elk_zabbix首先安装jdk包[root@elk_zabbix src]# yum localinstall -y jdk-8u65-linux-x64.rpm查看jdk版本[root@elk_zabbix src]# java -versionjava version "1.8.0_65"Java(TM) SE Runtime Environment (build 1.8.0_65-b17)Java HotSpot(TM) 64-Bit Server VM (build 25.65-b01, mixed mode)1.安装elasticsearch下载并安装GPG keyrpm --import https://packages.elastic.co/GPG-KEY-elasticsearch[root@elk_zabbix src]# yum localinstall -y elasticsearch-5.3.0.rpm配置文件【如果 ES 是单节点】[root@elk_zabbix etc]# grep ^[^#] /etc/elasticsearch/elasticsearch.yml: elk: elk_zabbix #节点的名称path.data: /data/elasticsearch #日志存储目录path.logs: /var/log/elasticsearch #elasticsearch启动日志路径network.host: 10.24.166.104【如果 elasticsearch 是集群】[root@elk_zabbix etc]# grep ^[^#] /etc/elasticsearch/elasticsearch.yml: elk: elk01path.data: /data/elasticsearchpath.logs: /var/log/elasticsearchnetwork.host: 10.50.200.220discovery.zen.ping.unicast.hosts: ["10.50.200.218", "10.50.200.219", "10.50.200.220"]discovery.zen.minimum_master_nodes: 3其他节点类似#以下两项设置es5.x版本的head插件可以访问eshttp.cors.enabled: true #开启跨域访问支持,默认为falsehttp.cors.allow-origin: "*" #跨域访问允许的域名地址,使用正则表达式创建日志存贮目录和elasticsearch启动日志路径mkdir -pv /data/elasticsearch设置权限 /data/elasticsearch(不设置权限启动不起来)chown -R elasticsearch:elasticsearch /data/elasticsearch启动elasticsearchsystemctl daemon-reloadsystemctl start elasticsearch.servicesystemctl enable elasticsearch.service安装部署head第一步,安装git需要从github上面下载代码,因此先要安装git[root@elk_zabbix ~]# yum -y install git第二步,安装node由于head插件本质上还是一个nodejs的工程,因此需要安装node,使用npm来安装依赖的包。

ELK日志管理系统详细安装和配置

ELK⽇志管理系统详细安装和配置ELK组成ELK由ElasticSearch、Logstash和Kiabana三个开源⼯具组成。

官⽅⽹站:Elasticsearch 是个开源分布式搜索引擎,它的特点有:分布式,零配置,⾃动发现,索引⾃动分⽚,索引副本机制,restful风格接⼝,多数据源,⾃动搜索负载等。

Logstash 是⼀个完全开源的⼯具,他可以对你的⽇志进⾏收集、过滤,并将其存储供以后使⽤(如,搜索)。

Kibana 是⼀个开源和免费的⼯具,它Kibana可以为Logstash 和 ElasticSearch 提供的⽇志分析友好的 Web 界⾯,可以帮助您汇总、分析和搜索重要数据⽇志。

1. 四⼤组件Logstash: logstash server端⽤来搜集⽇志;Elasticsearch: 存储各类⽇志;Kibana: web化接⼝⽤作查寻和可视化⽇志;Logstash Forwarder: logstash client端⽤来通过lumberjack ⽹络协议发送⽇志到logstash server;2. Elasticsearch 简介和安装(ELK的三个组建版本必须保持⼀致)2.1 ElasticSearch是⼀个基于Lucene的搜索服务器。

它提供了⼀个分布式多⽤户能⼒的全⽂搜索引擎,基于RESTful web接⼝。

Elasticsearch是⽤Java开发的,并作为Apache许可条款下的开放源码发布,是当前流⾏的企业级搜索引擎。

设计⽤于中,能够达到实时搜索,稳定,可靠,快速,安装使⽤⽅便。

2.2 从ELK官⽹下载Elasticsearch:下载elasticsearch-6.1.0.tar.gz的tar包后,使⽤ tar -xvf elasticsearch-5.2.1.tar 命令解压,使⽤cd命令进⼊⽂件夹⽬录;启动的时候⼀定要注意,因为es不可以进⾏root账户启动,所以你还需要开启⼀个elsearch账户。

Linux日志分析ELK环境搭建

Linux⽇志分析ELK环境搭建场景:ELK作为⼀个⽇志收集和检索系统,感觉功能还是相当的强⼤的。

ELK是啥, 其实是是三个组件的缩写, 分别是elasticsearch, logstash, kibana. ELK平台可以⽤于实现⽇志收集、⽇志搜索和⽇志分析. 当然, 如果你有花不完的money, 完全可以使⽤商业版的Splunk, Orz...ELK分别是什么1). ELK现在都是属于elastic公司的产品, .2). 简单流程下⾯图简单的展⽰了三组件之间的协作,总的来说分成四⼤部分, 第⼀, 应⽤产⽣数据, 第⼆, logstash从应⽤收集数据, 第三, 将数据放⼊es, 第四, 使⽤kibana进⾏数据展⽰以及分析.1 准备1.1 环境检测本⽂介绍安装 logstash 2.2.0 和 elasticsearch 2.2.0,操作系统环境版本是安装 JDK 是必须的,⼀般操作系统都会有,只是版本的问题,这⾥在安装的过程中发现ELK⼤部分都要求1.8以上的JDK,所以果断换1.8版本的JDK省事些。

⽽ Kibana 只是⼀个⽤纯 JavaScript 写的前端 UI。

⼀定要注意 Kibana 的版本,它会要求 ES 的版本。

下表展⽰了kibana和Elasticsearch之间的对应关系:1.2 软件下载注意:这三个软件之间的版本如果选择不对,中间会出现很多想不到的问题。

我这⾥的总结是elasticsearch和logstash最好保持版本⼀直,kibana和es的版本如上表所⽰的对应。

这⾥我都是选择Linux 64位的压缩包,然后将这三个⽂件通过FTP⼯具上传到⾃⼰建⽴的⽬录下⾯,这⾥以Etest为例。

ps:ELK三个软件的安装基本就是解压,然后执⾏就可以运⾏了,所以安装的⽬录完全可以⾃⼰选择。

logstash all plugins 2.2.0elasticsearch 2.2.0kibana 4.4.11.3 解压缩软件#将软件解压到/usr/local⽬录##tar -xzvf elasticsearch-5.0.1.tar.gz -C /usr/local#⾸先切换到软件下载⽬录,然后将三个软件直接解压到Etset⽬录tar -xzvf elasticsearch-2.2.0.tar.gztar -xzvf logstash-all-plugins-2.2.0.tar.gztar -xzvf kibana-4.4.1-linux-x64.tar.gz解压后⽂件如下图所⽰:2 elasticsearch2.1 启动elasticsearchps:启动时候不能以root⽤户启动,否则会报错。

日志收集系统ELK搭建

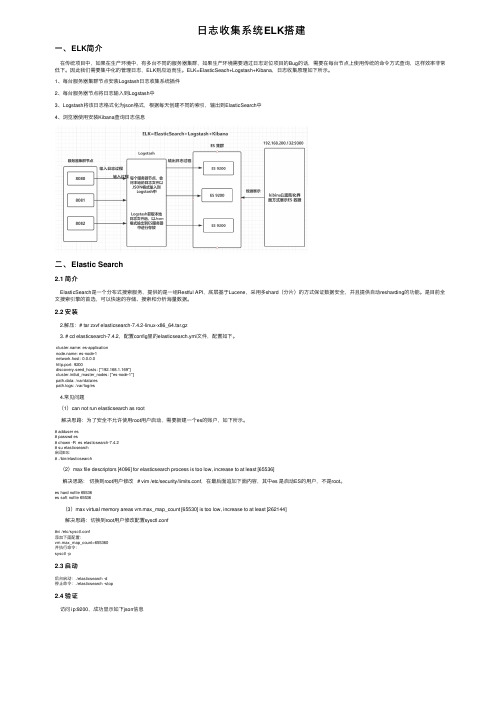

⽇志收集系统ELK搭建⼀、ELK简介在传统项⽬中,如果在⽣产环境中,有多台不同的服务器集群,如果⽣产环境需要通过⽇志定位项⽬的Bug的话,需要在每台节点上使⽤传统的命令⽅式查询,这样效率⾮常低下。

因此我们需要集中化的管理⽇志,ELK则应运⽽⽣。

ELK=ElasticSeach+Logstash+Kibana,⽇志收集原理如下所⽰。

1、每台服务器集群节点安装Logstash⽇志收集系统插件2、每台服务器节点将⽇志输⼊到Logstash中3、Logstash将该⽇志格式化为json格式,根据每天创建不同的索引,输出到ElasticSearch中4、浏览器使⽤安装Kibana查询⽇志信息⼆、Elastic Search2.1 简介ElasticSearch是⼀个分布式搜索服务,提供的是⼀组Restful API,底层基于Lucene,采⽤多shard(分⽚)的⽅式保证数据安全,并且提供⾃动resharding的功能。

是⽬前全⽂搜索引擎的⾸选,可以快速的存储、搜索和分析海量数据。

2.2 安装2.解压:# tar zxvf elasticsearch-7.4.2-linux-x86_64.tar.gz3. # cd elasticsearch-7.4.2,配置config⾥的elasticsearch.yml⽂件,配置如下。

: es-application: es-node-1network.host: 0.0.0.0http.port: 9200discovery.seed_hosts: ["192.168.1.169"]cluster.initial_master_nodes: ["es-node-1"]path.data: /var/data/espath.logs: /var/log/es4.常见问题(1)can not run elasticsearch as root解决思路:为了安全不允许使⽤root⽤户启动,需要新建⼀个es的账户,如下所⽰。

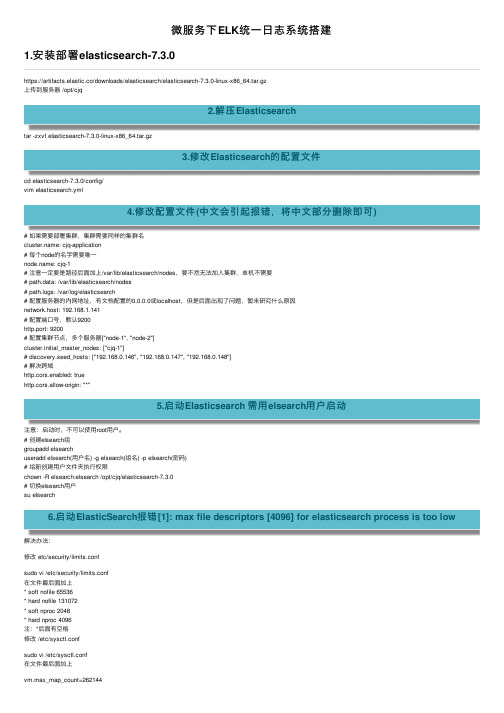

微服务下ELK统一日志系统搭建

微服务下ELK统⼀⽇志系统搭建1.安装部署elasticsearch-7.3.0https://artifacts.elastic.co/downloads/elasticsearch/elasticsearch-7.3.0-linux-x86_64.tar.gz上传到服务器 /opt/cjq2.解压Elasticsearchtar -zxvf elasticsearch-7.3.0-linux-x86_64.tar.gz3.修改Elasticsearch的配置⽂件cd elasticsearch-7.3.0/config/vim elasticsearch.yml4.修改配置⽂件(中⽂会引起报错,将中⽂部分删除即可)# 如果需要部署集群,集群需要同样的集群名: cjq-application# 每个node的名字需要唯⼀: cjq-1# 注意⼀定要是路径后⾯加上/var/lib/elasticsearch/nodes,要不然⽆法加⼊集群,单机不需要# path.data: /var/lib/elasticsearch/nodes# path.logs: /var/log/elasticsearch# 配置服务器的内⽹地址,有⽂档配置的0.0.0.0或localhost,但是后⾯出现了问题,暂未研究什么原因network.host: 192.168.1.141# 配置端⼝号,默认9200http.port: 9200# 配置集群节点,多个服务器["node-1", "node-2"]cluster.initial_master_nodes: ["cjq-1"]# discovery.seed_hosts: ["192.168.0.146", "192.168.0.147", "192.168.0.148"]# 解决跨域http.cors.enabled: truehttp.cors.allow-origin: "*"5.启动Elasticsearch 需⽤elsearch⽤户启动注意:启动时,不可以使⽤root⽤户。

ELK部署文档

ELK部署⽂档1. 前⾔在⽇常运维⼯作中,对于系统和业务⽇志的处理尤为重要。

尤其是分布式架构,每个服务都会有很多节点,如果要⼿⼯⼀个⼀个的去取⽇志,运维怕是要累死。

简单介绍:ELK 是 elasticsearch + logstash + kibana 三款开源软件的简称。

elasticsearch:是个开源的分布式搜索引擎,特点是:分布式、配置简单、⾃动发现、索引⾃动分⽚、索引副本机制、restful风格接⼝,多数据源,⾃动搜索负载等logstash:可以对⽇志进⾏收集、滤过、并将其存储在 elasticsearch中kibana:可以为 elasticsearch提供友好的⽤户交互界⾯,⽤户可以通过 kibana来分析、搜索甚⾄绘图来分析数据。

这⾥介绍下⽬前使⽤⽐较多的架构:ELK + filebeatFilebeat 是⼀个轻量级开源⽇志⽂件数据收集器,可以将它安装到需要收集的节点上,它会将⽇志输送到 logstash 或 elasticsearch有了 ELK 就可以将分布到多台的⽇志统⼀规划起来。

⽹络上有很多关于 ELK 的部署⽅案,参考了很多发现要不就是⽼版本的,要不就是不太完善,因此⾃⼰做下记录。

注意:在安装 ELK 的时候,这三个软件的版本必须保持⽀持,否则出现各种bug2. ELK搭建过程实验拓扑图:实验环境主机服务介绍:本次实验是收集 nginx ⽇志,并存储在 elasticsearch中。

将 elasticsearch 和 kibana 安装在同⼀主机上可以避免不必要的⽹络IO操作,直接本机交互。

2.1 Elasticsearch 的安装过程(1)初始化⼯作selinux、firewall 关闭时间同步主机名修改修改打开⽂件最⼤数时间同步:[root@192.168.118.14 ~]#ntpdate 修改主机名:[root@192.168.118.14 ~]#hostnamectl set-hostname node1修改完主机名别忘记在 /etc/hosts 中申明192.168.118.14 node1修改⽂件打开最⼤数:[root@192.168.118.14 ~]#vim /etc/security/limits.conf* soft nproc 655350* hard nproc 655350* soft nofile 655350* hard nofile 655350[root@192.168.118.14 ~]#ulimit -SHn 655350(2)配置 java 环境[root@192.168.118.14 /usr/local/src]#tar xf jdk-8u77-linux-x64.tar.gz -C /usr/local/在 /etc/profile ⽂件中追加JAVA_HOME=/usr/local/jdk1.8.0_77JAVA_BIN=$JAVA_HOME/binPATH=$PATH:$JAVA_BINCLASSPATH=$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jarexport JAVA_HOME JAVA_BIN PATH CLASSPATH[root@192.168.118.14 /usr/local/src]#source /etc/profile[root@192.168.118.14 /usr/local/src]#ln -vs /usr/local/jdk1.8.0_77/bin/java /usr/bin/[root@192.168.118.14 /usr/local/src]#java -versionjava version "1.8.0_77"Java(TM) SE Runtime Environment (build 1.8.0_77-b03)Java HotSpot(TM) 64-Bit Server VM (build 25.77-b03, mixed mode)(3)安装 elasticsearch下载地址:这⾥下载的是 6.8 的 rpm 包直接安装:[root@192.168.118.14 ~/ELK]#yum localinstall elasticsearch-6.8.2.rpm修改配置⽂件如下:[root@192.168.118.14 ~/ELK]#egrep ^[a-z] /etc/elasticsearch/elasticsearch.yml: super-cluster: node1path.data: /var/lib/elasticsearchpath.logs: /var/log/elasticsearchbootstrap.memory_lock: truenetwork.host: 0.0.0.0http.port: 9200discovery.zen.ping.unicast.hosts: ["192.168.118.14"]http.cors.enabled: truehttp.cors.allow-origin: "*"启动[root@192.168.118.14 ~/ELK]#systemctl enable elasticsearch ; systemctl start elasticsearch⾸次启动可能会启动失败,查看⽇志:[root@192.168.118.14 ~/ELK]#tail /var/log/elasticsearch/super-cluster.log…[1]: memory locking requested for elasticsearch process but memory is not locked…如上报错,需要修改启动脚本:[root@192.168.118.14 ~/ELK]#vim /lib/systemd/system/elasticsearch.service在 [Service] 配置段添加:…LimitMEMLOCK=infinity…[root@192.168.118.14 ~/ELK]#systemctl daemon-reload[root@192.168.118.14 ~/ELK]#systemctl start elasticsearch查看端⼝,如果 9200 和 9300 监听,则说明 elasticsearch启动成功。

ELK日志解决方案课件

. AI 老师1V1 ELK日志实践效果

A

14

实施要点

.应用层日志统一规范 统一日志库 C++ glog ,python logging

ቤተ መጻሕፍቲ ባይዱ

统一日志格式 [公共日志头] + logType + (分隔符连接的文本| | Json)

日志规范WIKi

注意点: 日志的字段切分要设计A好

15

AI老师1v1老版统计效果

四. 10 days window moving average 用户量是多少(trend)

A

18

THANKS

A

19

A

6

ELK能做什么

A

7

原理篇

. 网校公用日志服务基础架构和流程 . nlp日志服务基础架构和流程

A

8

网校日志中心架构

A

9

日志服务流程图

A

10

日志中心使用的问题

. 保存期限只有7天 . 没有权限控制,所有人都有读写权限

A

11

nlp日志解决方案

A

12

nlp日志流程图

A

13

. 实施要点

实践篇

传统日志分析思路

SSH cat/grep/regex FTP 脚本分析

缺点

手工操作,效率低,易出问题

延时高,无可视化效果

A

5

...

ELK日志分析

.主要需求

日志索引/检索/分类/排序,提供可视化界面 监控 分析重要日志 不同数据规模的横向扩展 可以做到准实时的日志分析

.设计思路

Logstash收集应用日志 ElasticSearch存储/索引日志 Kibana提供可视化界面

elk日志收集实施方案

elk日志收集实施方案ELK日志收集实施方案。

ELK是一套开源的日志管理工具,由Elasticsearch、Logstash和Kibana三个开源工具组成。

它们分别用于日志的存储、收集和可视化,是目前流行的日志管理解决方案之一。

在实际应用中,ELK日志收集实施方案的设计和部署对于系统运维和故障排查至关重要。

本文将介绍ELK日志收集的实施方案,帮助用户更好地利用ELK进行日志管理。

首先,我们需要在系统中部署Elasticsearch,用于存储日志数据。

Elasticsearch是一个分布式的搜索和分析引擎,它能够快速地存储、搜索和分析大量的数据。

在部署Elasticsearch时,需要考虑数据的备份和恢复策略,以及集群的扩展和负载均衡策略,确保系统的可靠性和稳定性。

其次,我们需要使用Logstash来收集日志数据,并将其发送到Elasticsearch进行存储。

Logstash是一个灵活的数据收集引擎,它能够从多种来源收集数据,并对数据进行过滤、转换和发送。

在配置Logstash时,需要考虑日志数据的格式和结构,以及数据的解析和清洗规则,确保数据的准确性和完整性。

最后,我们可以使用Kibana来可视化和分析存储在Elasticsearch中的日志数据。

Kibana是一个强大的数据可视化工具,它能够帮助用户快速地创建仪表板、图表和报表,对日志数据进行分析和展示。

在使用Kibana时,需要考虑数据的查询和过滤条件,以及数据的展示和呈现方式,确保用户能够直观地理解和分析日志数据。

综上所述,ELK日志收集实施方案包括Elasticsearch的部署、Logstash的配置和Kibana的使用。

通过合理的设计和部署,可以实现对日志数据的高效管理和分析,帮助用户及时发现和解决系统中的问题。

希望本文能够帮助用户更好地理解和应用ELK日志收集实施方案,提升系统的稳定性和可靠性。

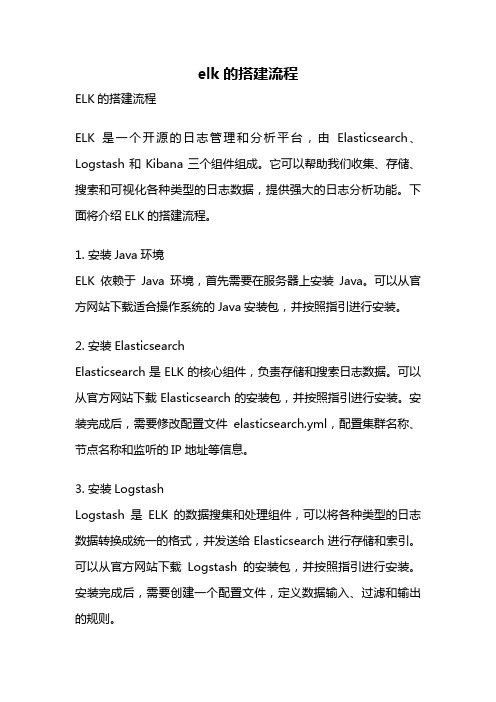

elk的搭建流程

elk的搭建流程ELK的搭建流程ELK是一个开源的日志管理和分析平台,由Elasticsearch、Logstash和Kibana三个组件组成。

它可以帮助我们收集、存储、搜索和可视化各种类型的日志数据,提供强大的日志分析功能。

下面将介绍ELK的搭建流程。

1. 安装Java环境ELK依赖于Java环境,首先需要在服务器上安装Java。

可以从官方网站下载适合操作系统的Java安装包,并按照指引进行安装。

2. 安装ElasticsearchElasticsearch是ELK的核心组件,负责存储和搜索日志数据。

可以从官方网站下载Elasticsearch的安装包,并按照指引进行安装。

安装完成后,需要修改配置文件elasticsearch.yml,配置集群名称、节点名称和监听的IP地址等信息。

3. 安装LogstashLogstash是ELK的数据搜集和处理组件,可以将各种类型的日志数据转换成统一的格式,并发送给Elasticsearch进行存储和索引。

可以从官方网站下载Logstash的安装包,并按照指引进行安装。

安装完成后,需要创建一个配置文件,定义数据输入、过滤和输出的规则。

4. 安装KibanaKibana是ELK的可视化组件,提供了丰富的图表和仪表盘,用于展示和分析存储在Elasticsearch中的日志数据。

可以从官方网站下载Kibana的安装包,并按照指引进行安装。

安装完成后,需要修改配置文件kibana.yml,配置Elasticsearch的地址和端口。

5. 启动ELK服务在安装完成后,可以使用命令行或启动脚本启动Elasticsearch、Logstash和Kibana服务。

首先启动Elasticsearch服务,然后启动Logstash服务,最后启动Kibana服务。

在启动过程中,需要确保各个组件的配置文件和日志文件路径正确。

6. 配置数据源在ELK搭建完成后,需要配置数据源,将需要分析的日志数据发送给Logstash进行处理。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

概述

日志分析主要包括系统日志、应用程序日志和安全日志。

系统运维和开发人员可以通过日志了解服务器软硬件信息、检查配置过程中的错误及错误发生的原因。

经常分析日志可以了解服务器的负荷,性能安全性,从而及时采取措施纠正错误。

通常,日志被分散的储存不同的设备上,依次登录每台机器查阅日志的传统方法很繁琐并且效率低下。

所以将日志集中管理成为运维工作必不可少的手段。

开源实时日志分析框架ELK是当前最流行的日志管理架构之一,能够实现对日志集中管理,并提供全文检索功能,组件kibana提供丰富的展示方法。

ELK能够起到实时系统监测、应用监测、网络监测、事件管理和发现bug等作用。

建设目的

为运维人员提供日志信息,实时了解操作系统、业务、数据库的运行情况。

提高解决故障的效率,提升故障预警能力。

为开发人员排查故障提供日志查看和搜索功能。

ELK简介

ELK是Elasticsearch、Logstash、Kibana的简称。

•Elasticsearch是实时全文搜索和分析引擎,提供搜集、分析、存储数据三大功能;

是一套开放REST和Java API等结构提供高效搜索功能,可扩展的分布式系统。

它构建于Apache Lucene搜索引擎库之上。

•Logstash是一个用来搜集、分析、过滤日志的工具。

它支持几乎任何类型的日志,包括系统日志、错误日志和自定义应用程序日志。

它可以从许多来源接收日志,这些来源包括syslog、消息传递(例如RabbitMQ)和JMX,它能够以多种方式输出数据,包括电子邮件、websockets和Elasticsearch。

•Kibana是一个基于Web的图形界面,用于搜索、分析和可视化存储在Elasticsearch指标中的日志数据。

它利用Elasticsearch的REST接口来检索数据,不仅允许用户创建他们自己的数据的定制仪表板视图,还允许他们以特殊的方式查询和过滤数据。

•Beats:包括filebeat和packetbeat,用来取代logstash-forward的轻量级日志代理,相对于logstash占用系统资源少。

日志类型

1、MySQL日志:包括MySQL错误、慢查询、MySQL methods、读写、流量。

2、Redis日志:

3、Nginx日志:按照固定格式输出的日志。

4、Tomcat日志:按照固定格式输出的日志。

5、系统日志messages:整体系统信息,系统层错误、告警、信息等。

6、系统日志secure:验证和授权方面信息。

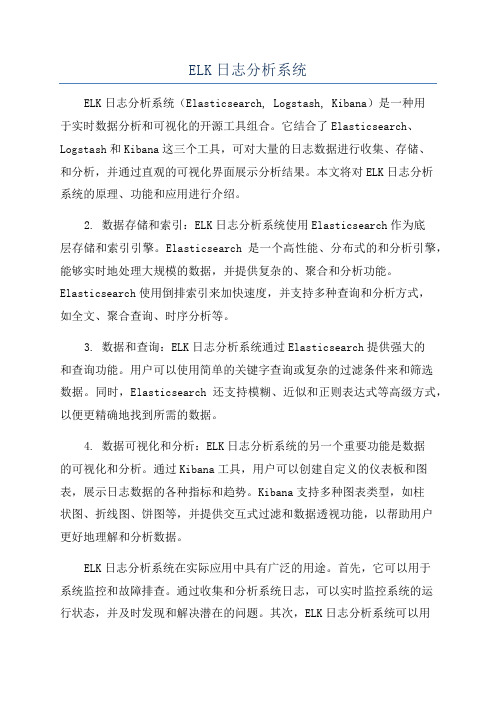

部署架构

由于当前日志量不大,所以暂时没有使用redis或kafka等队列工具,也没有使用集群。

后续可以根据实际负载情况加入缓存和集群。

具体部署方案如下:

1、使用filebeat收集所有服务器的/var/log/messages和/var/log/secure日志,并

发送给logstash集中转发给elasticsearch。

2、使用filebeat收集负载均衡访问和WEB服务器的Nginx日志和tomcat日志。

并

发送给logstash 匹配、解析后发送给elasticsearch。

3、使用packetbeat收集数据库MySQL和redis日志,直接发送给elasticsearch。

4、使用kibana做为日志展示与搜索的工具。

架构图:

效果展示MySQL日志仪表盘

Nginx日志仪表盘

Nginx日志

系统报错日志

部署文档

IP 域名组件日志文件

10.10.10.199 filebeat /usr/local/nginx/logs/access.log

10.10.10.200 Web03 filebeat /var/log/messages

10.10.10.206 filebeat /usr/local/syqyd2_809/log/catalina.out 10.10.20.20 mysql packetbeat 9032端口日志

10.10.10.210 ELK /var/log/message

示例:

修改hosts文件,增加域名与IP的映射关系

10.10.10.201

之后即可通过如下URL访问:

本例采集了不同服务器的nginx日志,tomcat日志,mysql日志,系统日志messages。

当然EKL可以采集任何日志,只要想要的都可以通过ELK收集和展现。

Nginx仪表盘

仪表盘如下截屏:点击仪表盘按钮”Dashboard”,点打开按钮,选择要打开的仪表盘名称。

可查看的信息包括:请求数、独立ip数、请求数趋势、独立ip排行、访问城市排行、http_code趋势。

MySQL仪表盘

可查看的信息包括:错误、方法、读写次数、出入流量、频繁的查询次数排行、慢查询。

Discover 实时查看搜索日志

首先在搜索日志界面的右上角可以选择要搜索的时间范围,也可以设置页面自动刷新时间。

Tomcat日志:

Tomcat日志采集了企易贷测试环境10.10.10.206 的访问日志,在discover菜单可以实时查看和搜索。

如在搜索栏输入:_type:tomcat;或者输入beat.hostname:TEST-QYD

Nginx日志

Nginx日志采集的是WEB02的nginx日志

在搜索栏输入:host:web02即可查看日志,也可以输入想要搜索的任何关键字。

如搜某一特定ip地址的日志,或者某个城市访问的日志。

系统messages日志

本例采集了web03的/var/log/messages日志,可以输入host:web03显示web03的messages日志,

使用Shield实现权限控制

使用shield插件可以实现不同用户只允许访问特定日志。

*注:测试环境没加权限控制。