ROS-turtlebot-follower-:让机器人跟随我们移动

基于ROS的移动机器人视觉跟随系统设计

基于ROS的移动机器人视觉跟随系统设计随着人工智能和机器人技术的不断发展,移动机器人在生活和工业领域的应用越来越广泛。

在实际应用中,移动机器人需要具备视觉跟随功能,能够自主地识别并跟随特定目标。

本文将介绍基于ROS(机器人操作系统)的移动机器人视觉跟随系统设计,详细介绍系统的架构和实现过程。

一、系统架构基于ROS的移动机器人视觉跟随系统由三部分组成:传感器模块、视觉处理模块和控制模块。

传感器模块用于获取周围环境信息,包括摄像头、激光雷达等传感器;视觉处理模块用于对目标进行识别和跟踪;控制模块用于控制机器人的移动。

1. 传感器模块传感器模块是整个系统的基础,通过传感器获取周围环境信息是视觉跟随系统工作的前提。

在ROS中,可以通过各种传感器包来获取数据,例如使用USB摄像头包获取摄像头数据,使用激光雷达包获取激光雷达数据等。

传感器模块需要将获取的数据发布到ROS中的对应话题,以供后续的视觉处理模块使用。

2. 视觉处理模块视觉处理模块是整个系统的核心,通过对传感器获取的数据进行处理,实现对目标的识别和跟踪。

在ROS中,可以使用OpenCV等视觉处理库来实现对图像数据的处理,包括目标检测、特征提取、运动跟踪等功能。

通过订阅传感器模块发布的数据,视觉处理模块可以实时地对目标进行识别和跟踪,并将跟踪结果发布到ROS中的对应话题。

3. 控制模块控制模块负责根据视觉处理模块发布的跟踪结果,控制机器人的移动。

在ROS中,可以使用移动机器人控制包来实现对机器人的运动控制,包括控制底盘的运动、姿态调整等。

控制模块需要订阅视觉处理模块发布的跟踪结果,根据跟踪结果来制定机器人的运动策略,并发布相应的控制指令到ROS中的对应话题。

二、实现过程传感器模块的实现主要包括传感器数据的获取和数据的发布。

以摄像头为例,可以使用USB摄像头包来获取摄像头数据,并发布到ROS中的对应话题,代码如下:```pythonimport rospyfrom sensor_msgs.msg import Imagefrom cv_bridge import CvBridgeimport cv2通过以上实现过程,基于ROS的移动机器人视觉跟随系统就可以得以实现。

ROS控制Turtlebot3移动机器人的基础教程

source ~/.bashrc

到此这篇关于ROS控制Turtlebot3移动机器人的文章就介绍到这了,更多相关ROS控制Turtlebot3移动机器人内容请搜索以前的 文章或继续浏览下面的相关文章希望大家以后多多支持!

这篇文章主要给大家介绍了关于ros控制turtlebot3移动机器人的相关资料文中通过示例代码介绍的非常详细对大家的学习或者工作具有一定的参考学习价值需要的朋友们下面随着小编来一起学习学习吧

ROS控制 Turtlebot3移动机器人的基础教程

中文教程

官方教程

注意

需要注意的是ROS需要IP地址在turtlebot和远程PC之间进行通信 修改.bashrc

nano ~/.bashrc

Pቤተ መጻሕፍቲ ባይዱ端配置

export ROS_MASTER_URI=http://PC端IP:11311 export ROS_HOSTNAME=PC端IP

Turtlebot端配置

export ROS_MASTER_URI=http://PC端IP:11311 export ROS_HOSTNAME=Turtlebot端IP

基于ROS的移动机器人视觉跟随系统设计

基于ROS的移动机器人视觉跟随系统设计移动机器人视觉跟随系统是指一种可以通过视觉传感器识别目标,并通过控制移动机器人实现目标跟随的系统。

在现实生活中,移动机器人视觉跟随系统已经广泛应用于自动巡航、物流配送、机器人陪护等领域。

本文将介绍一种基于ROS的移动机器人视觉跟随系统设计。

我们需要选择适合的硬件平台和软件框架。

在硬件平台方面,我们可以选择一台具备机械臂和激光雷达等传感器的移动机器人。

在软件框架方面,我们选择ROS作为我们的开发平台,因为ROS提供了丰富的机器人操作系统功能,可以方便地进行机器人控制和传感器数据处理。

接下来,我们需要设计移动机器人的硬件系统。

在这个系统中,我们需要将机械臂和激光雷达等传感器与ROS系统进行连接,以便进行数据的传输和控制。

我们还需要选择一种适合的图像传感器,用于目标识别。

目前,常用的图像传感器有摄像头和深度相机等。

然后,我们需要设计移动机器人的软件系统。

在这个系统中,我们需要编写ROS节点来实现相关功能。

我们需要编写一个目标识别节点,用于从图像传感器中获取图像,并使用计算机视觉算法进行目标识别。

常用的目标识别算法有卷积神经网络、支持向量机等。

然后,我们需要编写一个控制节点,用于通过ROS的机器人操作接口控制移动机器人实现目标跟随。

我们还需要编写其他辅助节点,用于数据的传输和处理等。

我们需要进行系统的集成和测试。

在集成的过程中,我们需要将硬件系统和软件系统进行连接,并进行相关参数的调整和校准。

在测试的过程中,我们需要验证系统的功能和性能是否满足要求,并进行相应的优化和调整。

基于ROS的移动机器人视觉跟随系统设计涉及到硬件系统的选择和设计、软件系统的编写和集成以及系统的测试和优化等方面。

只有在以上各个方面都做好工作,才能够设计出一个功能强大且稳定可靠的移动机器人视觉跟随系统。

基于ROS的室内自主移动机器人系统设计与实现

基于ROS的室内自主移动机器人系统设计与实现基于ROS的室内自主移动机器人系统设计与实现随着人工智能和机器人技术的不断发展,室内自主移动机器人逐渐成为人们关注的焦点。

它可以广泛应用于室内环境中,如酒店、医院、仓库等,帮助人们完成各种日常任务。

而为了实现机器人的自主移动和感知环境的能力,在设计和实现室内自主移动机器人系统时,使用ROS(机器人操作系统)是一种常见的选择。

ROS是一个灵活、通用且开放源代码的机器人操作系统,它提供了一系列库和工具,以帮助开发者快速构建机器人应用程序。

以ROS为基础,我们可以实现机器人的感知、决策和控制,使其能够在室内环境中自主移动。

在设计和实现基于ROS的室内自主移动机器人系统时,首先需要考虑机器人的定位和导航能力。

为了实现机器人的定位功能,可以使用激光雷达等传感器进行环境地图的构建和定位信息的更新。

同时,利用ROS提供的导航功能包,可以基于这些定位信息实现机器人的路径规划和导航功能,使机器人能够快速、准确地移动到指定的位置。

其次,在室内环境中,机器人需要具备感知能力,以便能够识别和避开障碍物。

通过使用ROS中的图像处理功能包,可以实现机器人对环境中物体的识别和跟踪。

结合深度学习算法,机器人还可以学习和识别更复杂的场景,提高其感知环境的能力。

此外,为了使机器人能够进行有效的交互,我们可以使用ROS提供的语音处理功能包。

可以利用语音识别和语音合成技术,实现机器人对人类语音指令的理解和响应,从而提升人机交互的体验。

另外,为了确保机器人的安全,我们可以通过ROS提供的运动控制和碰撞检测功能,实现机器人在移动过程中对障碍物的检测和避让。

同时,利用传感器数据和ROS的控制功能,我们可以对机器人的速度和轨迹进行实时调节,以确保其在复杂的室内环境中安全移动。

此外,基于ROS的室内自主移动机器人系统还可以扩展其他功能,如环境监测、智能巡检等。

通过与外部设备的连接,机器人可以收集环境参数、检测异常情况,并及时向操作员报警,以提高室内安全性和工作效率。

基于ROS的移动机器人视觉跟随系统设计

基于ROS的移动机器人视觉跟随系统设计移动机器人视觉跟随系统是一种利用机器人视觉技术,实现机器人能够跟随目标物体运动的系统。

基于ROS(Robot Operating System)的移动机器人视觉跟随系统设计,可以实现机器人自主地跟随人或物体移动,具有广泛的应用领域,如室内导航、仓库管理、服务机器人等。

在设计移动机器人视觉跟随系统时,需要考虑以下几个关键步骤:1.目标检测和识别:利用机器人视觉技术,对目标物体进行检测和识别。

常用的方法有基于颜色和形状的检测算法,以及深度学习算法(如卷积神经网络)。

2.目标跟踪:通过跟踪算法,实现对目标物体的实时跟踪。

跟踪算法可以基于特征点、边缘、轮廓等进行目标定位和追踪。

3.移动控制:根据目标物体的位置和运动信息,设计合适的移动控制算法,使机器人能够自主地跟随目标物体。

常见的移动控制算法包括PID 控制、适应性控制和模糊控制等。

4.传感器融合:结合机器人的其他传感器(如激光传感器、惯性传感器等),对目标物体进行精确的位置跟踪和运动估计。

5.环境建模与地图构建:基于机器人的传感器数据,对环境进行建模和地图构建,以提供机器人的位置估计和导航功能。

在设计过程中,可以选择ROS作为开发平台和框架,利用ROS的优势来实现模块化和分布式的系统架构。

可以利用ROS的图像处理库(如OpenCV)和机器人导航库(如Navigation Stack)来加速开发过程。

此外,还需要考虑系统的实时性和稳定性。

移动机器人视觉跟随系统通常需要在实时环境中运行,对延迟和噪声有较高的要求。

可以利用ROS 的消息传递机制和多线程编程,来提高系统的实时性和稳定性。

总之,基于ROS的移动机器人视觉跟随系统设计需要考虑目标检测和识别、目标跟踪、移动控制、传感器融合、环境建模与地图构建等关键步骤。

利用ROS的优势和功能,可以实现模块化和分布式的系统架构,同时考虑系统的实时性和稳定性。

这样设计出的系统能够实现机器人自主地跟随目标物体运动,具有广泛的应用潜力。

基于ROS的移动机器人视觉跟随系统设计

基于ROS的移动机器人视觉跟随系统设计随着人工智能和机器人技术的发展,移动机器人视觉跟随系统在各个领域得到了广泛的应用。

基于ROS(Robot Operating System)的移动机器人视觉跟随系统设计是一个重要的研究领域,本文将介绍该系统的设计原理、实现方法和应用场景。

移动机器人视觉跟随系统的设计原理主要包括目标检测、路径规划、运动控制等几个关键步骤。

通过视觉传感器获取环境中的目标信息,然后利用目标检测算法对目标进行识别和定位。

接下来,通过路径规划算法确定移动机器人到目标的最佳路径,并实现自主导航。

运动控制算法根据路径规划结果控制机器人的运动,实现目标跟随功能。

基于ROS的移动机器人视觉跟随系统利用ROS提供的各种功能包和工具,实现了数据传输、通讯、控制等功能,为系统设计提供了良好的基础。

在ROS的基础上,我们可以利用各种算法和传感器进行系统设计和开发,包括目标检测算法、路径规划算法、运动控制算法等。

二、移动机器人视觉跟随系统的实现方法1. 目标检测算法目标检测算法是移动机器人视觉跟随系统中的关键部分,它主要用于识别和定位环境中的目标。

常用的目标检测算法包括卷积神经网络(CNN)、YOLO(You Only Look Once)算法、Faster R-CNN算法等。

这些算法能够对目标进行高效的检测和定位,为路径规划和运动控制提供了必要的信息。

在ROS中,可以利用OpenCV、PCL等库实现目标检测算法,并通过ROS的图像传输功能获取环境中的图像信息。

在获取图像信息后,可以利用ROS提供的消息传输功能将图像信息传输给路径规划和运动控制模块,实现目标跟随功能。

2. 路径规划算法路径规划算法是移动机器人视觉跟随系统中另一个重要的部分,它主要用于确定机器人到目标的最佳路径。

常用的路径规划算法包括A*算法、D*算法、Dijkstra算法等。

这些算法能够根据环境的信息,快速、准确地确定机器人的移动路径。

基于ROS的移动机器人视觉跟随系统设计

基于ROS的移动机器人视觉跟随系统设计视觉跟随是指移动机器人通过识别和跟踪特定目标,实现对目标的自动追踪或跟随。

本设计基于ROS(机器人操作系统),旨在实现一个基于视觉的移动机器人跟随系统。

系统架构如下:1. 摄像头采集图像:使用ROS提供的摄像头驱动程序,获取移动机器人的视觉输入。

通过ROS的图像消息传输机制,将图像传输给后续的视觉处理模块。

2. 视觉目标检测与识别:通过使用计算机视觉算法,对采集到的图像进行处理,实现目标检测和识别。

可以使用传统的图像处理算法,如边缘检测、颜色分割等。

也可以使用深度学习算法,如卷积神经网络(CNN)进行目标识别。

3. 目标跟踪:对于识别出的目标,通过实时跟踪算法(如卡尔曼滤波器、粒子滤波器等),实现对目标的跟踪。

跟踪算法可以根据目标的运动特征和外部环境的信息,更新目标的位置和速度估计。

4. 移动控制:通过ROS提供的移动机器人控制接口,将目标的位置和速度指令发送给移动机器人的控制系统,实现对机器人的运动控制。

可以使用PID控制器或者其他控制算法,根据目标的位置和速度误差,调整机器人的轮速度。

5. 系统集成:将以上各个模块进行集成,形成一个完整的视觉跟随系统。

通过ROS的节点通信机制,实现数据的传输和处理。

在系统设计中,需要考虑以下几个关键问题:1. 环境适应性:视觉跟随系统需要适应不同的环境,包括不同的光照条件、背景干扰以及目标的外观变化等。

可以通过选择合适的目标检测和跟踪算法,以及对算法进行优化和调参,提高系统的鲁棒性和适应性。

2. 实时性:视觉跟随系统需要在实时性要求下运行,尤其是在移动机器人和目标的相对速度较快的情况下。

可以通过使用高效的图像处理算法、并行计算和硬件加速等技术手段,提高系统的实时性能。

3. 安全性:移动机器人在跟随过程中需要考虑避障和碰撞等安全问题。

可以通过结合视觉和激光传感器等多种传感器信息,实现移动机器人的安全导航和避障功能。

可以使用预测控制算法,对目标的运动进行预测,以避免机器人与目标之间的碰撞。

ROS教程——让模拟机器人动起来(键盘控制)

ROS教程——让模拟机器人动起来(键盘控制)ROS(Robot Operating System)是一个广泛应用于机器人领域的开源操作系统。

它提供了一系列工具、库和约定,用于简化开发、管理和控制机器人系统。

在这篇教程中,我们将通过键盘控制来让模拟机器人动起来。

```$ roscore```接下来,我们需要创建一个ROS包,包含了我们将要使用的节点、话题和服务等。

可以通过以下命令创建一个名为"robot_control"的ROS包:```$ catkin_create_pkg robot_control```创建完成后,我们需要在src文件夹中创建用于控制机器人的节点。

可以创建一个名为"keyboard_control.py"的Python脚本,以下是一个简单的示例代码:```python#!/usr/bin/env pythonimport rospyfrom std_msgs.msg import Stringdef keyboard_control(:#初始化ROS节点rospy.init_node('keyboard_control', anonymous=True)#创建一个发布者,用于发布控制指令#进入主循环while not rospy.is_shutdown(:#读取键盘输入#发布控制指令pub.publish(cmd)if __name__ == '__main__':try:keyboard_controlexcept rospy.ROSInterruptException:pass```在主函数中,我们首先通过调用"keyboard_control"函数来启动控制节点。

然后,我们使用try-except结构来处理异常,确保在ROS停止时能够正常退出程序。

接下来,我们需要在launch文件夹中创建一个启动文件。

基于ROS的移动机器人视觉跟随系统设计

基于ROS的移动机器人视觉跟随系统设计一、引言随着人工智能和机器人技术的迅猛发展,移动机器人在各种领域的应用越来越广泛。

移动机器人视觉跟随系统是其中一个重要的应用场景,它可以使机器人根据摄像头采集到的信息,实时跟踪和跟随特定目标,如行人或者其他移动物体,从而实现自主导航和交互功能。

在本文中,我们将基于ROS(Robot Operating System)平台,详细介绍移动机器人视觉跟随系统的设计过程和关键技术,以及系统的整体架构和实现细节。

二、ROS平台简介ROS是一个开源的机器人操作系统,它提供了一套丰富的工具和库,支持机器人的感知、定位、运动控制和人机交互等功能,同时也具有良好的可扩展性和兼容性。

ROS采用模块化设计,利用节点间的消息传递机制来实现不同功能模块之间的松耦合,从而为复杂机器人系统的开发和调试提供了很大的便利。

三、系统设计思路移动机器人视觉跟随系统的设计思路可以简单概括为:首先通过摄像头获取目标对象的视觉信息,然后通过图像处理和目标检测算法实现目标的识别和定位,最后通过运动控制算法实现机器人对目标的跟随和追踪。

整个系统需要实现对目标对象的识别和跟踪,以及机器人的运动控制功能。

在ROS平台上,可以利用其丰富的工具和库来实现系统所需的各个功能模块。

四、系统关键技术1. 目标检测与识别目标检测与识别是移动机器人视觉跟随系统的核心技术之一。

在ROS平台上,可以利用开源的目标检测算法,如YOLO、SSD等,来实现目标对象的实时检测和识别。

这些算法基于深度学习技术,能够高效地对图像中的对象进行检测和分类,具有较高的准确率和实时性。

通过在ROS中集成这些算法,可以实现对移动机器人所需跟随的目标对象的实时检测和识别。

2. 视觉定位与跟踪视觉定位与跟踪是实现机器人对目标的跟随和追踪的关键技术之一。

通过对目标对象的图像信息进行处理和分析,可以实现对目标的定位和追踪。

在ROS平台上,可以利用开源的视觉定位和跟踪算法,如ORB-SLAM、Kinect Fusion等,来实现对目标对象的实时定位和跟踪。

移动机器人自主跟随技术

挪动机器人自主跟随技术关键词:挪动机器人,自主跟随,计算机视觉,深度进修,路径规划,人机交互,智能物流,家庭服务,医疗护理一、探究现状目前,挪动机器人自主跟随技术已经成为人工智能技术领域的重要探究方向之一。

近年来,国内外学者和探究机构在该领域的探究和应用方面取得了丰硕的效果。

例如,美国麻省理工学院推出的“Cheetah”机器人就是一款接受了自主跟随技术的挪动机器人,它可以实现对人类进行追踪和交互;国内的清华高校、北京高校、中科院等一批高校和科研机构也在挪动机器人自主跟随技术的探究和应用方面进行了乐观的探究和尝试。

二、关键技术挪动机器人自主跟随技术的实现需要涉及多个关键技术,这些技术包括机器人感知和运动控制、机器人路径规划和任务分配、机器人人机交互等方面。

1. 机器人感知和运动控制机器人感知和运动控制是实现自主跟随技术的基础。

机器人感知系统需要能够准确地识别目标并跟踪其运动轨迹,同时能够在复杂的环境中自适应地调整行动路线。

机器人运动控制系统需要能够控制机器人的运动方向和速度,实现机器人的跟随操作。

2. 机器人路径规划和任务分配机器人路径规划和任务分配是实现自主跟随技术的关键环节。

机器人路径规划需要思量机器人的运动速度、障碍物的位置、目标物体的运动轨迹等多个因素。

机器人任务分配需要思量不同机器人的特点和能力,合理分配不同的任务,以实现最优的跟随效果。

3. 机器人人机交互机器人人机交互是实现跟随操作的重要手段。

通过机器人人机交互的方式,可以实现裁定目标物体的运动轨迹、调整机器人的运动路径和速度、异常状况的处理等多个功能。

三、应用领域挪动机器人自主跟随技术可以应用于多个领域,包括智能物流、家庭服务、医疗护理等方面。

1. 智能物流在智能物流领域,可以利用挪动机器人实现物品的自动采集、自动运输和自动分拣等功能,通过自主跟随技术,可以实现机器人与人类的协同操作,提高物流的效率和准确度。

2. 家庭服务在家庭服务领域,挪动机器人可以实现一系列家庭服务功能,例如指挥孩子外出游玩、给老人做家务、与宠物互动等。

自动跟随机器人的设计与实现

自动跟随机器人的设计与实现

简介

自动跟随机器人是一种能够自主移动、自动追随目标物体的智能机器人。

本文介绍了自动跟随机器人的设计和实现。

设计

自动跟随机器人的设计主要由以下几个模块组成:

- 传感器模块:用来感知周围环境,包括摄像头、超声波等传感器。

- 控制模块:用来控制机器人的行动,包括电机、舵机等控制器。

- 决策模块:用来根据传感器模块的数据作出判断和决策。

在设计自动跟随机器人时,需要考虑如何选择合适的传感器模块和控制器,同时需要设计合理的决策算法来实现机器人的自主跟随。

实现

自动跟随机器人的实现分为以下几个步骤:

1. 传感器数据的获取:通过传感器模块获取周围环境的数据。

2. 数据处理:将获取的数据进行处理,如图像处理、距离计算等。

3. 决策算法:根据处理后的数据作出跟随决策,如向左转、向右转等。

4. 控制器控制:将决策结果通过控制模块转化为控制信号,如电机速度、舵机角度等。

通过以上步骤,自动跟随机器人就可以实现自主跟随目标物体的功能。

结论

自动跟随机器人是一种应用广泛的智能机器人,本文介绍了自动跟随机器人的设计和实现,包括传感器模块、控制模块和决策算

法等。

实现自动跟随机器人需要综合运用多种知识和技能,具有较高的工程难度和技术门槛。

基于ROS的移动机器人视觉跟随系统设计

基于ROS的移动机器人视觉跟随系统设计摘要随着机器人技术的不断发展,移动机器人的应用范围也越来越广泛。

视觉跟随系统是移动机器人常见的一种应用场景,能够实现机器人对目标物体的自主跟随和导航。

本文基于ROS(机器人操作系统)平台,设计了一种基于视觉的移动机器人跟随系统,通过机器人搭载的相机传感器采集环境信息,利用图像处理技术实现目标检测和跟随算法,实现机器人对目标物体的识别和跟随。

本文首先介绍了ROS平台的基本概念和特点,然后介绍了移动机器人视觉跟随系统的设计原理和实现方法,最后通过实验验证了系统的稳定性和实用性。

关键词:ROS;移动机器人;视觉跟随系统;目标检测;图像处理1.引言移动机器人技术是近年来快速发展的领域之一,随着无人驾驶汽车、无人机等技术的不断成熟,移动机器人在工业自动化、物流配送、无人零售等领域得到了广泛的应用。

而移动机器人的视觉跟随系统作为其重要的应用场景之一,能够帮助机器人实现对目标物体的自主跟随和导航,在日常生活和工业生产中都具有很大的应用前景。

ROS(Robot Operating System)是一个开源的机器人操作系统,它提供了一套完整的工具和库,能够帮助开发人员快速地构建和部署机器人应用程序。

本文将基于ROS平台,设计一种基于视觉的移动机器人跟随系统,通过机器人搭载的相机传感器采集环境信息,利用图像处理技术实现目标检测和跟随算法,实现机器人对目标物体的识别和跟随。

2.ROS平台简介ROS是一种获取安装说明资源的能力,ROS执行功能从上层到下层层式软件栈,为机器人的自主操作,ROS自动且灵活,且提供丰富的功能,包括硬件抽象,程序库,视觉、键、映射、导航等等,这些功能的整合,让占用资源更好。

3.移动机器人视觉跟随系统设计原理3.1 系统框架设计移动机器人视觉跟随系统的框架设计主要包括以下几个模块:图像采集模块、目标检测模块、运动控制模块和导航规划模块。

图像采集模块负责从机器人搭载的相机传感器中获取环境图像数据;目标检测模块对获取的图像数据进行分析和处理,识别出目标物体的位置和大小;运动控制模块根据目标物体的位置信息,控制机器人实现对目标物体的跟随;导航规划模块负责规划机器人的路径,确保机器人能够安全、高效地跟随目标物体。

基于ros的移动机器人视觉跟随系统设计

【Abstract】: Visual following is an important part in the field of robot, which can be used in many fields such as storage and transportation, security, military and so on. Because the traditional algorithm can not track the target effectively when the background is complex, the resolution of the target and the external environment is high, so it can only do auxiliary tracking, and the computation is too large to meet the real-time requirement. In this paper, a ROS-based mobile robot visual following system is designed by using KCF Algorithm, which makes use of the property that circulant matrix can be diagonalized in Fourier space, so that the matrix operation can be transformed into the dot product of elements the computation is reduced and the computation speed is increased, which can meet the real-time requirement of the algorithm. Through experiments and data analysis, the mobile robot can follow the specified target effectively in real-time to achieve visual follow function. 【Key words】: ROS; Visual following; KCF algorithm; Mobile robot

基于ROS平台的特定目标自跟随机器人的设计

信息通信INFORMATION&COMMUNICATIONS2020 (Sum.No212)2020年第8期(总第212期)基于ROS平台的特定目标自跟随机器人的设计忽晓伟,支开来,赵一方(郑州西亚斯学院电子信息工程学院,河南新郑451150)摘要:文章介绍了一种基于ROS平台的自跟随机器人,机器人的主控分为ROS系统运行的大脑树莓派3B和控制底盘运动的小脑STM32,大脑与小脑通过串口通信,ROS系统部分节点根据需要采用Python语言编写,实现话题的发布和订阅。

树莓派搭载摄像头和激光雷达;机器人底盘由STM32,超声波模块,电机驱动模块,电机和全向轮组成。

被跟随者背后贴有特殊颜色拼块,树莓派通过摄像头采集图像信息,识别采集颜色拼块信息,判断是否为被跟随目标,并根据色块在视野中的坐标发布控制话题,调整机器人行进方向。

由于机器人配置的是全向轮,可实现机器人的平移运动,更易于目标的跟随。

机器人通过激光雷达判断与目标的距离,防止发生碰撞,并可实现避障,超声波用于透光障碍物的识别。

关键词:ROS;树莓派;目标跟踪;颜色识别中图分类号:TP18文献标识码:A文章编号:1673-1131(2020)08-0122-020引言随着科技的快速发展,智能机器人在各个领域有了大量的应用。

大部分采用AGV模式,需要对场地进行改造,才能实现机器人的引导,对于一些复杂场景的搬运,采用AGV已经有些不适合叫因此迫切需要研发出一种目标跟随机器人。

本文就提出了一种目标跟随机器人方案的设计。

1系统需求及方案设计机器人整体的方案可釆用单片机直接读取一些传感器,比如多个红外传感器,可实现目标的位置计算,但对于特定目标的识别是无法做到的叫要实现对特定目标的跟随需要使用图像的识别。

对于单片机为主控的机器人,对于图像处理这种复杂的处理是无法实现的,并且对于不同的任务,都需要对系统重新编写程序和算法。

基于ROS系统的机器人可以避免重新造轮子,因为运行在树莓派或者笔记本上,可实现一些复杂的算法,比如图像处理等。

Turtlebot3新手教程-应用-跟随

Turtlebot3新⼿教程-应⽤-跟随本⽂针对如何利⽤Turtlebot3可实现的各种应⽤进⾏讲解具体步骤如下:[Remote PC]安装应⽤包cd ~/catkin_ws/srccd ~/catkin_ws && catkin_makeTurtleBot跟随演⽰注意:需要在⽆障碍环境进⾏,只需要使⽤HLS-LFCD LDS雷达即可[TurtleBot] 更改配置vim ~/catkin_ws/src/turtlebot3/turtlebot3_bringup/launch/turtlebot3_unch修改前:修改后:[Remote PC]安装依赖包sudo apt-get install python-pipsudo pip install -U scikit-learn numpy scipysudo pip install --upgrade pip测试:[Remote PC] 运⾏roscoreRoscore[TurtleBot] 启动burgerroslaunch turtlebot3_bringup turtlebot3_unch[Remote PC] 启动filterroslaunch turtlebot3_follow_filter turtlebot3_follow_unch[Remote PC] 启动跟随cd ~/catkin_ws/src/turtlebot3_applications/turtlebot3_follower/src rosrun turtlebot3_follower follower.pyTurtleBot全景演⽰turtlebot3_panorama演⽰通过使⽤pano_ros来实现全景图[TurtleBot]启动Raspberry Pi cam V2roslaunch raspicam_node camerav2_unch[Remote PC] 启动panoramaroslaunch turtlebot3_panorama unch[Remote PC] 开始全景图制作rosservice call turtlebot3_panorama/take_pano 0 360.0 30.0 0.3参数设置:模式:0 : 旋转拍照 (例如:旋转,停⽌,拍照,旋转,停⽌,拍照...)1 : 持续(拍照时要保持旋转)2 : 停⽌拍照和创建全景图全景图像的总⾓度(⾓度)⾓度间隔 (⾓度) ⽤于旋转拍照模式或时间间隔 (秒) ⽤于其他模式旋转速度 (弧度/秒)[Remote PC] 查看结果rqt_image_view image:=/turtlebot3_panorama/panorama。

让ros机器人行走、建图、路径规划、定位和导航

让ros机器⼈⾏⾛、建图、路径规划、定位和导航准备导航所需要的包。

a.ros-kinetic-gampping :我们不需要修改包内的东西,所以直接安装可执⾏⽂件就好了。

sudo apt-get install ros-kinetic-slam-gmappingb.安装雷达的驱动(我的是robopack),直接将提供的ros驱动包拷贝到⼯作空间中,c.安装导航定位包,navigation 进⼊git:https:///ros-planning/navigation/tree/indigo-devel,下载和⾃⼰ros版本匹配的包,解压到⾃⼰的⼯作空间中,cd ~/catkin_wscatkin_makeindigo的navigation包会出现⼀个依赖问题,:Orocos-bfl not found while installing navigation stack ROS indigo + Ubuntu 14.04解决⽅法:rosdep install --from-paths src --ignore-src --rosdistro indigo -yd.由于导航包在/cmd_val下发布的移动数据加速度会过于不友好,所以我们需要对速度做平滑处理,其实就是控制加速,⼀般通过滤波即可实现,在此我们采⽤turtlebot的平滑包即可, 安装平滑包yocs_velocity_smoother,具体的平滑算法和输⼊切换请⾃⼰阅读源码。

apt-get install ros-indigo-yocs-velocity-smoother所有的包准包好后,我们去准备启动所需的launch⽂件,⾸先是机器⼈地盘的启动⽂件base_unch:<launch><param name="use_sim_time" value="false" /><node name="link_laser" pkg="tf" type="static_transform_publisher" args="0.15 0 0.15 0 0 0 base_link laser 50"/><node name="link_footprint" pkg="tf" type="static_transform_publisher" args="0 0 0 0 0 0 base_link base_footprint 50"/> <node pkg="odom_tf_package" type="tf_broadcaster_node" name="serial_send_recevice" output="screen"/><include file="$(find odom_tf_package)/launch/include/rplidar_unch.xml"></include><arg name="node_name" value="velocity_smoother"/><arg name="nodelet_manager_name" value="nodelet_manager"/><arg name="config_file" value="$(find odom_tf_package)/config/yocs_velocity_smoother.yaml"/><arg name="raw_cmd_vel_topic" value="cmd_vel"/><arg name="smooth_cmd_vel_topic" value="smoother_cmd_vel"/><arg name="robot_cmd_vel_topic" value="robot_cmd_vel"/><arg name="odom_topic" value="odom"/><!-- nodelet manager --><node pkg="nodelet" type="nodelet" name="$(arg nodelet_manager_name)" args="manager"/><!-- velocity smoother --><include file="$(find yocs_velocity_smoother)/launch/velocity_unch"><arg name="node_name" value="$(arg node_name)"/><arg name="nodelet_manager_name" value="$(arg nodelet_manager_name)"/><arg name="config_file" value="$(arg config_file)"/><arg name="raw_cmd_vel_topic" value="$(arg raw_cmd_vel_topic)"/><arg name="smooth_cmd_vel_topic" value="$(arg smooth_cmd_vel_topic)"/><arg name="robot_cmd_vel_topic" value="$(arg robot_cmd_vel_topic)"/><arg name="odom_topic" value="$(arg odom_topic)"/></include></launch>2.然后去准备建图包的启动⽂件unch<launch><arg name="scan_topic" default="scan" /><node pkg="gmapping" type="slam_gmapping" name="slam_gmapping" output="screen" clear_params="true"><!--because my used rtabmap_ros --><param name="odom_frame" value="/odom""/><!--param name="odom_frame" value="/base_controller/odom""/--><param name="map_update_interval" value="30.0"/><!-- Set maxUrange < actual maximum range of the Laser --><!-- Set maxUrange < actual maximum range of the Laser --><param name="maxRange" value="5.0"/><param name="maxUrange" value="4.5"/><param name="sigma" value="0.05"/><param name="kernelSize" value="1"/><param name="lstep" value="0.05"/><param name="astep" value="0.05"/><param name="iterations" value="5"/><param name="lsigma" value="0.075"/><param name="ogain" value="3.0"/><param name="lskip" value="0"/><param name="srr" value="0.01"/><param name="srt" value="0.02"/><param name="str" value="0.01"/><param name="stt" value="0.02"/><param name="linearUpdate" value="0.5"/><param name="angularUpdate" value="0.436"/><param name="temporalUpdate" value="-1.0"/><param name="resampleThreshold" value="0.5"/><param name="particles" value="80"/><!--<param name="xmin" value="-50.0"/><param name="ymin" value="-50.0"/><param name="xmax" value="50.0"/><param name="ymax" value="50.0"/>make the starting size small for the benefit of the Android client's memory... --><param name="xmin" value="-1.0"/><param name="ymin" value="-1.0"/><param name="xmax" value="1.0"/><param name="ymax" value="1.0"/><param name="delta" value="0.05"/><param name="llsamplerange" value="0.01"/><param name="llsamplestep" value="0.01"/><param name="lasamplerange" value="0.005"/><param name="lasamplestep" value="0.005"/><remap from="scan" to="$(arg scan_topic)"/></node></launch>3,导航包(move_base)和定位(amcl)的启动⽂件:savvy_unch<launch><param name="use_sim_time" value="false" /><!-- Set the name of the map yaml file: can be overridden on the command line. --><arg name="map" default="map.yaml" /><!--node name="map_odom" pkg="tf" type="static_transform_publisher" args="0 0 0 0 0 0 map odom 50"/--><!-- Run the map server with the desired map --><node name="map_server" pkg="map_server" type="map_server" args="$(find savvy)/maps/$(arg map)"/><!-- The move_base node --><include file="$(find savvy)/launch/move_base_unch" /><!--zxw add Fire up AMCL--><include file="$(find savvy)/launch/tb_unch" /></launch>move_base_unch:<launch><node pkg="move_base" type="move_base" respawn="false" name="move_base" output="screen" clear_params="true"><rosparam file="$(find savvy)/config/savvyconfig/costmap_common_params.yaml" command="load" ns="global_costmap" /> <rosparam file="$(find savvy)/config/savvyconfig/costmap_common_params.yaml" command="load" ns="local_costmap" /> <rosparam file="$(find savvy)/config/savvyconfig/local_costmap_params.yaml" command="load" /><rosparam file="$(find savvy)/config/savvyconfig/global_costmap_params.yaml" command="load" /><rosparam file="$(find savvy)/config/savvyconfig/base_local_planner_params.yaml" command="load" /><rosparam file="$(find savvy)/config/nav_obstacles_params.yaml" command="load" /></node></launch>tb_unch:<launch><arg name="use_map_topic" default="false"/><arg name="scan_topic" default="scan"/><node pkg="amcl" type="amcl" name="amcl" clear_params="true"> <param name="use_map_topic" value="$(arg use_map_topic)"/> <!-- Publish scans from best pose at a max of 10 Hz --><param name="odom_model_type" value="diff"/><param name="odom_alpha5" value="0.1"/><param name="gui_publish_rate" value="10.0"/><param name="laser_max_beams" value="60"/><param name="laser_max_range" value="12.0"/><param name="min_particles" value="500"/><param name="max_particles" value="2000"/><param name="kld_err" value="0.05"/><param name="kld_z" value="0.99"/><param name="odom_alpha1" value="0.2"/><param name="odom_alpha2" value="0.2"/><!-- translation std dev, m --><param name="odom_alpha3" value="0.2"/><param name="odom_alpha4" value="0.2"/><param name="laser_z_hit" value="0.5"/><param name="laser_z_short" value="0.05"/><param name="laser_z_max" value="0.05"/><param name="laser_z_rand" value="0.5"/><param name="laser_sigma_hit" value="0.2"/><param name="laser_lambda_short" value="0.1"/><param name="laser_model_type" value="likelihood_field"/><!-- <param name="laser_model_type" value="beam"/> --><param name="laser_likelihood_max_dist" value="2.0"/><param name="update_min_d" value="0.25"/><param name="update_min_a" value="0.2"/><param name="odom_frame_id" value="odom"/><param name="resample_interval" value="1"/><!-- Increase tolerance because the computer can get quite busy --> <param name="transform_tolerance" value="1.0"/><param name="recovery_alpha_slow" value="0.0"/><param name="recovery_alpha_fast" value="0.0"/><remap from="scan" to="$(arg scan_topic)"/></node></launch>4.导航的配置参数如下:base_local_planner_params.yamlcontroller_frequency: 2.0recovery_behavior_enabled: falseclearing_rotation_allowed: false TrajectoryPlannerROS:max_vel_x: 0.3min_vel_x: 0.05max_vel_y: 0.0 # zero for a differential drive robot min_vel_y: 0.0min_in_place_vel_theta: 0.5escape_vel: -0.1acc_lim_x: 2.5acc_lim_y: 0.0 # zero for a differential drive robot acc_lim_theta: 3.2holonomic_robot: falseyaw_goal_tolerance: 0.1 # about 6 degreesxy_goal_tolerance: 0.15 # 10 cmlatch_xy_goal_tolerance: falsepdist_scale: 0.8gdist_scale: 0.6meter_scoring: trueheading_lookahead: 0.325heading_scoring: falseheading_scoring_timestep: 0.8occdist_scale: 0.1oscillation_reset_dist: 0.05publish_cost_grid_pc: falseprune_plan: truesim_time: 2.5sim_granularity: 0.025angular_sim_granularity: 0.025vx_samples: 8vy_samples: 0 # zero for a differential drive robot vtheta_samples: 20dwa: truesimple_attractor: falsecostmap_common_params.yamlobstacle_range: 2.5obstacle_range: 2.5raytrace_range: 3.0robot_radius: 0.30inflation_radius: 0.15max_obstacle_height: 0.6min_obstacle_height: 0.0observation_sources: scanscan: {data_type: LaserScan, topic: /scan, marking: true, clearing: true, expected_update_rate: 0}global_costmap_params.yamlglobal_costmap:global_frame: /maprobot_base_frame: /base_linkupdate_frequency: 1.0publish_frequency: 0static_map: truerolling_window: falseresolution: 0.01transform_tolerance: 0.5map_type: costmaplocal_costmap_params.yamllocal_costmap:global_frame: /odomrobot_base_frame: /base_linkupdate_frequency: 1.0publish_frequency: 1.0static_map: falserolling_window: truewidth: 6.0height: 6.0resolution: 0.01transform_tolerance: 0.5map_type: costmap四,准备好以上所有的启动⽂件和配置参数后,我们开始创建地图和导航,1.创建地图:roslaunch savvy base_unch //启动地盘控制器roslaunch savvy base_unch //启动地盘控制器roslaunch savvy unchroscd savvy/maps/rosrun map_server map_saver -f mymap然后会产⽣以下地图⽂件mymap.pgm mymap.yaml2.开始导航roslaunch savvy base_unch //启动地盘控制器roslaunch savvy savvy_unch map:=mymap.yamlrosrun rviz rviz -d `rospack find savvy`/nav_test.rviz然后指定导航⽬标,开始⾃⼰慢慢玩吧,不过因为我的TF变换主要是⾥程计更新的,车体打滑或者地盘电机震荡都会积累误差,所以我们必须添加视觉⾥成计或者闭环检测。

基于ROS的移动机器人视觉跟随系统设计

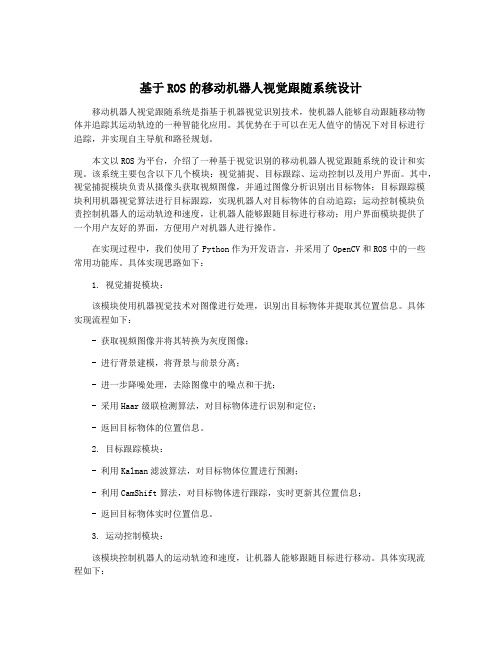

基于ROS的移动机器人视觉跟随系统设计移动机器人视觉跟随系统是指基于机器视觉识别技术,使机器人能够自动跟随移动物体并追踪其运动轨迹的一种智能化应用。

其优势在于可以在无人值守的情况下对目标进行追踪,并实现自主导航和路径规划。

本文以ROS为平台,介绍了一种基于视觉识别的移动机器人视觉跟随系统的设计和实现。

该系统主要包含以下几个模块:视觉捕捉、目标跟踪、运动控制以及用户界面。

其中,视觉捕捉模块负责从摄像头获取视频图像,并通过图像分析识别出目标物体;目标跟踪模块利用机器视觉算法进行目标跟踪,实现机器人对目标物体的自动追踪;运动控制模块负责控制机器人的运动轨迹和速度,让机器人能够跟随目标进行移动;用户界面模块提供了一个用户友好的界面,方便用户对机器人进行操作。

在实现过程中,我们使用了Python作为开发语言,并采用了OpenCV和ROS中的一些常用功能库。

具体实现思路如下:1. 视觉捕捉模块:该模块使用机器视觉技术对图像进行处理,识别出目标物体并提取其位置信息。

具体实现流程如下:- 获取视频图像并将其转换为灰度图像;- 进行背景建模,将背景与前景分离;- 进一步降噪处理,去除图像中的噪点和干扰;- 采用Haar级联检测算法,对目标物体进行识别和定位;- 返回目标物体的位置信息。

2. 目标跟踪模块:- 利用Kalman滤波算法,对目标物体位置进行预测;- 利用CamShift算法,对目标物体进行跟踪,实时更新其位置信息;- 返回目标物体实时位置信息。

3. 运动控制模块:该模块控制机器人的运动轨迹和速度,让机器人能够跟随目标进行移动。

具体实现流程如下:- 利用PID控制算法,控制机器人的速度和角度,以达到跟随目标的目的;- 利用ROS机器人底盘控制接口,将运动指令发送给机器人进行控制;- 实时检测机器人与目标之间的距离和角度,以保持跟随的稳定性。

4. 用户界面模块:该模块提供了一个用户友好的界面,方便用户对机器人进行操作。

在ROS中实现turtlebot路径规划

在ROS中实现turtlebot路径规划根据教程,运⾏

$roslaunch turtlebot_stage turtlebot_in_unch后

成功实现了turtlebot在地图中的2维路径规划。

接下来就是要搞懂这套仿真背后的机制,我把整个⼤问题分为⼏个⼩问题:

1.⿏标选中了⽬标点后,根据已知地图⾃动⽣成的这条路径,背后的算法和机理

2.机器⼈周围产⽣的绿⾊⼩箭头是做什么⽤的

3.机器⼈开始运动后,在机器⼈周围⽣成的矩形彩⾊区域作⽤是什么,以及⽣成彩⾊区域的算法

4.如何在地图中导⼊更加复杂的地图和我⾃⼰的机器⼈模型,来实现我的路径规划⽬的

5.如何再添加⼀个机器⼈,且让两个机器⼈在路径规划时做到不互相⼲扰

6.所有这⼀切的背后,每个节点每个主题,相互之间传递的消息弄清楚。

在接下来的学习中,我会不断更新这篇⽂章,并争取最后放上多个机器⼈进⾏路径规划的动图。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

ROS-turtlebot-follower-:让机器人跟随我们移动ROS turtlebot_follower :让机器人跟随我们移动ROS turtlebot_follower 学习首先在catkin_ws/src目录下载源码了解代码见注释(其中有些地方我也不是很明白)follower.cpp#include <ros/ros.h>#include <pluginlib/class_list_macros.h>#include <nodelet/nodelet.h>#include <geometry_msgs/Twist.h>#include <sensor_msgs/Image.h>#include <visualization_msgs/Marker.h>#include <turtlebot_msgs/SetFollowState.h>#include "dynamic_reconfigure/server.h"#include "turtlebot_follower/FollowerConfig.h" #include <depth_image_proc/depth_traits.h>namespace turtlebot_follower{//* The turtlebot follower nodelet./*** The turtlebot follower nodelet. Subscribes to point clouds* from the 3dsensor, processes them, and publishes command vel* messages.*/class TurtlebotFollower : public nodelet::Nodelet{public:/*!* @brief The constructor for the follower.* Constructor for the follower.*/TurtlebotFollower() : min_y_(0.1), max_y_(0.5),min_x_(-0.2),max_x_(0.2),max_z_(0.8),goal_z_(0.6),z_scale_(1.0),x_scale_(5.0){}~TurtlebotFollower(){delete config_srv_;}private:double min_y_; /**< The minimum y position of the points in the box. */double max_y_; /**< The maximum y position of the points in the box. */double min_x_; /**< The minimum x position of the points in the box. */double max_x_; /**< The maximum xposition of the points in the box. */double max_z_; /**< The maximum z position of the points in the box. 框中点的最大z位置,以上四个字段用来设置框的大小*/double goal_z_; /**< The distance away from the robot to hold the centroid 离机器人的距离,以保持质心*/double z_scale_; /**< The scaling factor for translational robot speed 移动机器人速度的缩放系数*/double x_scale_; /**< The scaling factor for rotational robot speed 旋转机器人速度的缩放系数*/bool enabled_; /**< Enable/disable following; just prevents motor commands 启用/禁用追踪; 只是阻止电机命令,置为false后,机器人不会移动,/mobile_base/mobile_base_controller/cmd_vel topic 为空*/// Service for start/stop followingros::ServiceServer switch_srv_;// Dynamic reconfigure server 动态配置服务dynamic_reconfigure::Server<turtlebot_followe r::FollowerConfig>* config_srv_;/*!* @brief OnInit method from node handle.* OnInit method from node handle. Sets up the parameters* and topics.* 初始化handle,参数,和话题*/virtual void onInit(){ros::NodeHandle& nh = getNodeHandle();ros::NodeHandle& private_nh = getPrivateNodeHandle();//从参数服务器获取设置的参数(launch文件中设置数值)private_nh.getParam("min_y", min_y_);private_nh.getParam("max_y", max_y_);private_nh.getParam("min_x", min_x_);private_nh.getParam("max_x", max_x_);private_nh.getParam("max_z", max_z_);private_nh.getParam("goal_z", goal_z_);private_nh.getParam("z_scale", z_scale_);private_nh.getParam("x_scale", x_scale_);private_nh.getParam("enabled",enabled_);//设置机器人移动的话题(用于机器人移动):/mobile_base/mobile_base_controller/cmd_vel (换成你的机器人的移动topic)cmdpub_ = private_nh.advertise<geometry_msgs::Twist> ("/mobile_base/mobile_base_controller/cmd_vel ", 1);markerpub_ = private_nh.advertise<visualization_msgs::Mark er>("marker",1);bboxpub_ = private_nh.advertise<visualization_msgs::Marker>("bbox",1);sub_=nh.subscribe<sensor_msgs::Image>("depth/ima ge_rect", 1, &TurtlebotFollower::imagecb, this);switch_srv_ = private_nh.advertiseService("change_state",&TurtlebotFollower::changeModeSrvCb, this);config_srv_ = new dynamic_reconfigure::Server<turtlebot_followe r::FollowerConfig>(private_nh);dynamic_reconfigure::Server<turtlebot_followe r::FollowerConfig>::CallbackType f =boost::bind(&TurtlebotFollower::reconfigure, this, _1, _2);config_srv_->setCallback(f);}//设置默认值,详见catkin_ws/devel/include/turtlrbot_follower/Follo werConfig.hvoidreconfigure(turtlebot_follower::FollowerConfig &config, uint32_t level){min_y_ = config.min_y;max_y_ = config.max_y;min_x_ = config.min_x;max_x_ = config.max_x;max_z_ = config.max_z;goal_z_ = config.goal_z;z_scale_ = config.z_scale;x_scale_ = config.x_scale;}/*!* @brief Callback for point clouds.* Callback for depth images. It finds the centroid* of the points in a box in the center of the image.* 它找到图像中心框中的点的质心* Publishes cmd_vel messages with the goal from the image.* 发布图像中目标的cmd_vel 消息* @param cloud The point cloud message.* 参数:点云的消息*/void imagecb(const sensor_msgs::ImageConstPtr& depth_msg) {// Precompute the sin function for each row and column wangchao预计算每行每列的正弦函数uint32_t image_width = depth_msg->width;ROS_INFO_THROTTLE(1,"image_width=%d", image_width);float x_radians_per_pixel = 60.0/57.0/image_width;//每个像素的弧度float sin_pixel_x[image_width];for (int x = 0; x < image_width; ++x) {//求出正弦值sin_pixel_x[x] = sin((x - image_width/ 2.0) * x_radians_per_pixel);}uint32_t image_height = depth_msg->height;float y_radians_per_pixel = 45.0/57.0/image_width;float sin_pixel_y[image_height];for (int y = 0; y < image_height; ++y) {// Sign opposite x for y up valuessin_pixel_y[y] = sin((image_height/ 2.0 - y) * y_radians_per_pixel);}//X,Y,Z of the centroid 质心的xyzfloat x = 0.0;float y = 0.0;float z = 1e6;//Number of points observed 观察的点数unsigned int n = 0;//Iterate through all the points in the region and find the average of the position 迭代通过该区域的所有点,找到位置的平均值const float* depth_row = reinterpret_cast<constfloat*>(&depth_msg->data[0]);int row_step = depth_msg->step / sizeof(float);for (int v = 0; v < (int)depth_msg->height; ++v, depth_row += row_step){for (int u = 0; u < (int)depth_msg->width; ++u){float depth = depth_image_proc::DepthTraits<float>::toMete rs(depth_row[u]);if(!depth_image_proc::DepthTraits<float>::valid( depth) || depth > max_z_) continue;//不是有效的深度值或者深度超出max_z_float y_val = sin_pixel_y[v] * depth;float x_val = sin_pixel_x[u] * depth;if ( y_val > min_y_ && y_val < max_y_ &&x_val > min_x_ && x_val < max_x_){x += x_val;y += y_val;z = std::min(z, depth); //approximate depth as forward.n++;}}}//If there are points, find the centroid and calculate the command goal.//If there are no points, simply publish a stop goal.//如果有点,找到质心并计算命令目标。