隐马尔科夫模型(原理图解)

隐马尔科夫模型(原理图解)ppt课件

t=1

t=2

t=3

t=4

t=5

S1

a11 a13a12

S1

a11 a12

S1

a11 a12

S1

a11 a12

S1

a21

a21

a21

a21

S2 a22

S2 a22

S2 a22

S2 a22

S2

a23

a23

a23

a23

a31 a32

a32

a32

a32

S3 a33

S3 a33

S3 a33

S3 a33

S3

• 从某时刻状态到下时刻的状态按一定概率转移

t=1

t=2

转移概率

S1

a11 a13a12

S1

a11 a12

t=3

t=4

t=5

SS11

a11 a12

S11

a11 a12

S1

a21

a21

a21

a21

S22 a22

S2 a22

S2 a22

S2 a22

S22

a23

a23

a23

a23

a31 a32

a32

a32

a32

S3 a33

S33 a33

S3 a33

S11

S1

A转移概率矩阵

N

π

S22

… a11 a12 L a1N

S2

AN *N

a21

aS222

L

a2 N

L L L L

S2

S22

…

…

…

…

aN1 aN 2 L aNN

SN

隐马尔可夫模型_刘秉权

实例

一房间有 N 只瓮,每只瓮中有 M 种不同颜色的球。 根据某一概率分布随机地选择一个初始瓮,根据不同颜色 球的概率分布从中随机取出一个球,并报告球的颜色。然 后根据某一概率分布随机地选择另一只瓮,再根据不同颜 色球的概率分布从中随机取出一个球,并报告球的颜 色,…。对房间外的观察者,可观察的过程是不同颜色球 的序列,而瓮的序列是不可观察的。 这里每只瓮对应 HMM 模型中的状态,球的颜色对应 于状态的输出符号,从一只瓮转向另一只瓮对应于状态转 换,从一只瓮中取球对应于从一状态输出观察符号。

P(q t = S j | q t -1 = Si , q t -2 = S k ,L)

如果系统在 t 时间的状态只与其在时间 t − 1 的状态相关, 则该 系统构成一个离散的一阶马尔可夫链(马尔可夫过程):

P(q t = S j | q t -1 = Si , q t -2 = S k ,L) = P(q t = S j | q t -1 = S i )

困难:穷尽所有可能的状态序列,复杂度 O ( N ) ,指数爆炸。 有效方法:向前算法,动态规划,复杂性 O ( N 2 T ) 。

隐马尔可夫模型 18

T

动态规划(Dynamic Programming)

也称为动态时间弯曲(Dynamic TimeWraping) 常用于有序数字的最优求解问题,例如 无向图中两点之间的最短距离问题或者 语料库对齐中基于长度的对齐都采用了 动态规划算法。

隐马尔可夫模型 3

马尔可夫模型(Markov Model)

如果只考虑独立于时间 t 的随机过程:

P(q t = S j | q t -1 = Si ) = a i, j , 1 ≤ i, j ≤ N

一文搞懂HMM(隐马尔可夫模型)

⼀⽂搞懂HMM(隐马尔可夫模型)什么是熵(Entropy)简单来说,熵是表⽰物质系统状态的⼀种度量,⽤它⽼表征系统的⽆序程度。

熵越⼤,系统越⽆序,意味着系统结构和运动的不确定和⽆规则;反之,,熵越⼩,系统越有序,意味着具有确定和有规则的运动状态。

熵的中⽂意思是热量被温度除的商。

负熵是物质系统有序化,组织化,复杂化状态的⼀种度量。

熵最早来原于物理学. 德国物理学家鲁道夫·克劳修斯⾸次提出熵的概念,⽤来表⽰任何⼀种能量在空间中分布的均匀程度,能量分布得越均匀,熵就越⼤。

1. ⼀滴墨⽔滴在清⽔中,部成了⼀杯淡蓝⾊溶液2. 热⽔晾在空⽓中,热量会传到空⽓中,最后使得温度⼀致更多的⼀些⽣活中的例⼦:1. 熵⼒的⼀个例⼦是⽿机线,我们将⽿机线整理好放进⼝袋,下次再拿出来已经乱了。

让⽿机线乱掉的看不见的“⼒”就是熵⼒,⽿机线喜欢变成更混乱。

2. 熵⼒另⼀个具体的例⼦是弹性⼒。

⼀根弹簧的⼒,就是熵⼒。

胡克定律其实也是⼀种熵⼒的表现。

3. 万有引⼒也是熵⼒的⼀种(热烈讨论的话题)。

4. 浑⽔澄清[1]于是从微观看,熵就表现了这个系统所处状态的不确定性程度。

⾹农,描述⼀个信息系统的时候就借⽤了熵的概念,这⾥熵表⽰的是这个信息系统的平均信息量(平均不确定程度)。

最⼤熵模型我们在投资时常常讲不要把所有的鸡蛋放在⼀个篮⼦⾥,这样可以降低风险。

在信息处理中,这个原理同样适⽤。

在数学上,这个原理称为最⼤熵原理(the maximum entropy principle)。

让我们看⼀个拼⾳转汉字的简单的例⼦。

假如输⼊的拼⾳是"wang-xiao-bo",利⽤语⾔模型,根据有限的上下⽂(⽐如前两个词),我们能给出两个最常见的名字“王⼩波”和“王晓波 ”。

⾄于要唯⼀确定是哪个名字就难了,即使利⽤较长的上下⽂也做不到。

当然,我们知道如果通篇⽂章是介绍⽂学的,作家王⼩波的可能性就较⼤;⽽在讨论两岸关系时,台湾学者王晓波的可能性会较⼤。

隐马尔可夫模型.pptx

第28页/共85页

学习问题

• Baum-Welch重估计公式

• 已知X和 的情况下,t时刻为状态i,t+1时刻为状态j的后验概率

θ

ij

(t

)

i

(t

1)aij P(XT

b |

jk

θ)

j

(t

)

向前

向后

T

jl (t)

t 1 l

bˆ v(t )vk

jk

T

jl (t)

t 1 l

第29页/共85页

例如:ML估计

第10页/共85页

估值问题

• 直接计算HMM模型产生可见长度为T的符号序列X的概率

其中,

表示状态 的初始概率

假设HMM中有c个隐状态,则计算复杂度为

!

例如:c=10,T=20,基本运算1021次!

(1)

第11页/共85页

O(cTT )

估值问题

• 解决方案

• 递归计算

t时刻的计算仅涉及上一步的结果,以及

x1和x3统计独立,而 其他特征对不独立

第32页/共85页

相关性例子

• 汽车的状态 • 发动机温度 • 油温 • 油压 • 轮胎内气压

• 相关性 • 油压与轮胎内气压相互独立 • 油温与发动机温度相关

第33页/共85页

贝叶斯置信网

• 用图的形式来表示特征之间的因果依赖性 • 贝叶斯置信网(Bayesian belief net) • 因果网(causal network) • 置信网(belief net)

P(θi )

P(θi | X)

θi P(X | θi )

第20页/共85页

解码问题

马尔科夫模型(转载)

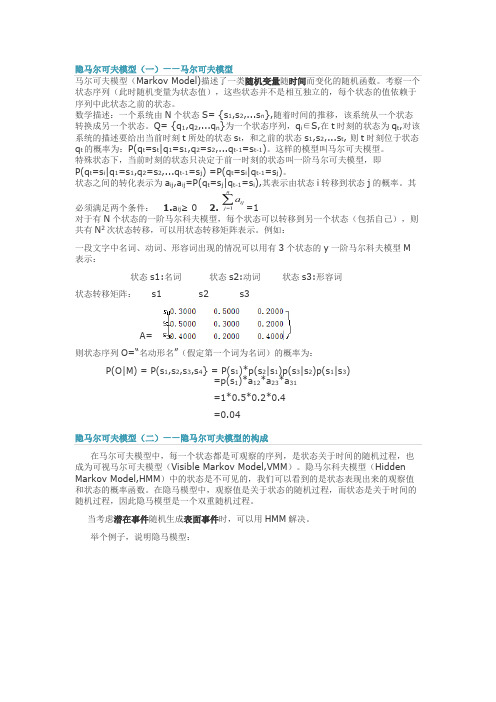

隐马尔可夫模型(一)——马尔可夫模型马尔可夫模型(Markov Model)描述了一类随机变量随时间而变化的随机函数。

考察一个状态序列(此时随机变量为状态值),这些状态并不是相互独立的,每个状态的值依赖于序列中此状态之前的状态。

数学描述:一个系统由N个状态S= {s1,s2,...s n},随着时间的推移,该系统从一个状态转换成另一个状态。

Q= {q1,q2,...q n}为一个状态序列,q i∈S,在t时刻的状态为q t,对该系统的描述要给出当前时刻t所处的状态s t,和之前的状态s1,s2,...s t, 则t时刻位于状态q t的概率为:P(q t=s t|q1=s1,q2=s2,...q t-1=s t-1)。

这样的模型叫马尔可夫模型。

特殊状态下,当前时刻的状态只决定于前一时刻的状态叫一阶马尔可夫模型,即P(q t=s i|q1=s1,q2=s2,...q t-1=s j) =P(q t=s i|q t-1=s j)。

状态之间的转化表示为a ij,a ij=P(q t=s j|q t-1=s i),其表示由状态i转移到状态j的概率。

其必须满足两个条件: 1.a ij≥ 0 2.=1对于有N个状态的一阶马尔科夫模型,每个状态可以转移到另一个状态(包括自己),则共有N2次状态转移,可以用状态转移矩阵表示。

例如:一段文字中名词、动词、形容词出现的情况可以用有3个状态的y一阶马尔科夫模型M 表示:状态s1:名词状态s2:动词状态s3:形容词状态转移矩阵: s1 s2 s3A=则状态序列O=“名动形名”(假定第一个词为名词)的概率为:P(O|M) = P(s1,s2,s3,s4} = P(s1)*p(s2|s1)p(s3|s2)p(s1|s3)=p(s1)*a12*a23*a31=1*0.5*0.2*0.4=0.04在马尔可夫模型中,每一个状态都是可观察的序列,是状态关于时间的随机过程,也成为可视马尔可夫模型(Visible Markov Model,VMM)。

马尔科夫和隐马尔科夫模型

一、Morkov模型

1913年俄国数学家马尔柯夫发现:某些事物的概率变化过程中,

第n次试验的结果常由第n-1次试验的结果决定。在学术研究上

把这种无后效的随机过程称为马尔柯夫过程。

一、Morkov模型

马尔可夫过程:在事件的发展过程中,若每次状态的转移都仅 与前一时刻的状态有关而与过去的状态无关,这样的状态转移 过程就称为马尔可夫过程。

f (0,1) 1, f (1, 0) 0.5 g(0,1) 0, g(1, 0) 0.5

关系式给出了问题的模型。满足条件的f 和g很多, 须确定它们的具体形式。在满足所有条件后,通常 取最简单的方案。如成功,问题就简单解决了;如 失败,可修正。

本题最简单的是假定f 和g都是自变量的 线性函数,即:

qk

1 yk 1

0.5qk 0.5qk

yk

qk 1

0.5qk

0.5qk 1

0.5(qk

qk 0.5qk 10.5qk 2

qk 1 )

0.75qk 1

0.25qk2

yk1 0.25qk1 0.25qk2

qk1 yk1 qk yk 1

1 0.5 0 0.5

1 0

0.75 0.25

0.5 0.5

P3

0.75 0.25

0.5 0.5 0.5 0.5

1 0

0.625 0.375

0.75 0.25

P1

0.5 0.5

1 0

P2

0.75 0.25

时刻t,处在状态i,并且部分 观察序列为o1o2o3…ot的概率。

前向算法

隐马尔科夫(HMM)模型详解及代码实现

机器学习之隐马尔科夫模型(HMM)机器学习之隐马尔科夫模型(HMM)1、隐马尔科夫模型介绍2、隐马尔科夫数学原理3、Python代码实现隐马尔科夫模型4、总结隐马尔可夫模型介绍马尔科夫模型(hidden Markov model,HMM)是关于时序的概率模型,描述由一个隐藏的马尔科夫随机生成不可观测的状态随机序列,再由各个状态生成一个观测从而产生观测随机序列的过程,属于一个生成模型。

下面我们来从概率学角度定义马尔科夫模型,从一个典型例子开始:假设有4个盒子,每个盒子里面有不同数量的红、白两种颜色的球,具体如下表:盒子编号1234红球数5368白球数5742现在从这些盒子中取出T个球,取样规则为每次选择一个盒子取出一个球,记录其颜色,放回。

在这个过程中,我们只能观测到球的颜色的序列,观测不到球是从哪个盒子中取出来的,即观测不到盒子的序列,这里有两个随机序列,一个是盒子的序列(状态序列),一个是球的颜色的观测序列(观测序列),前者是隐藏的,只有后者是可观测的。

这里就构成了一个马尔科夫的例子。

定义是所有的可能的状态集合,V是所有的可能的观测的集合:其中,N是可能的状态数,M是可能的观测数,例如上例中N=4,M=2。

是长度为T的状态序列,是对应的观测序列:A是状态转移概率矩阵:其中, 是指在时刻处于状态的条件下在时刻转移到状态的概率。

B是观测概率矩阵:其中, 是指在时刻处于状态的条件下生成观测的概率。

是初始状态概率向量:其中, 是指在时刻=1处于状态的概率。

由此可得到,隐马尔可夫模型的三元符号表示,即称为隐马尔可夫模型的三要素。

由定义可知隐马尔可夫模型做了两个基本假设:(1)齐次马尔科夫性假设,即假设隐藏的马尔科夫链在任意时刻的状态只和-1状态有关;(2)观测独立性假设,观测只和当前时刻状态有关;仍以上面的盒子取球为例,假设我们定义盒子和球模型:状态集合: = {盒子1,盒子2,盒子3,盒子4}, N=4观测集合: = {红球,白球} M=2初始化概率分布:状态转移矩阵:观测矩阵:(1)转移概率的估计:假设样本中时刻t处于状态i,时刻t+1转移到状态j 的频数为那么转台转移概率的估计是:(2)观测概率的估计:设样本中状态为j并观测为k的频数是那么状态j观测为k的概率, (3)初始状态概率的估计为S个样本中初始状态为的频率。

《隐马尔可夫模型》课件

隐马尔可夫模型在许多领域都有应用,如语音识 别、自然语言处理、生物信息学和金融预测等。

隐马尔可夫模型的应用领域

01

语音识别

用于将语音转换为文本,或识别说 话人的意图。

生物信息学

用于分析基因序列、蛋白质序列和 代谢物序列等。

03 隐马尔可夫模型的建立

观察概率矩阵的确定

总结词

观察概率矩阵描述了在给定状态下,观察到不同状态的概率 分布。

详细描述

观察概率矩阵是隐马尔可夫模型中的重要组成部分,它表示 了在给定状态下,观察到不同状态的概率分布。例如,在语 音识别中,观察概率矩阵可以表示在特定语音状态下发出不 同音素的概率。

状态转移概率矩阵的确定

VS

原理

通过动态规划找到最大概率的路径,该路 径对应于最可能的隐藏状态序列。

05 隐马尔可夫模型的优化与 改进

特征选择与模型参数优化

要点一

特征选择

选择与目标状态和观测结果相关的特征,提高模型预测准 确率。

要点二

模型参数优化

通过调整模型参数,如状态转移概率和观测概率,以改进 模型性能。

高阶隐马尔可夫模型

初始状态概率分布表示了隐马尔可夫模型在初始时刻处于各个状态的概率。这个概率分布是隐马尔可 夫模型的重要参数之一,它决定了模型在初始时刻所处的状态。在某些应用中,初始状态概率分布可 以根据具体问题来确定,也可以通过实验数据来估计。

04 隐马尔可夫模型的训练与 预测

前向-后向算法

前向算法

用于计算给定观察序列和模型参 数下,从初始状态到某个终止状 态的所有可能路径的概率。

《隐马尔可夫模型》 ppt课件

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

• 下时期状态只取决于当前时期状态和转移概率 P ( q t S j|q t 1 S i , q t 2 S k ,) P ( q t S j|q t 1 S i )

qt-1

t-1时 刻

3

qt

t时刻

q1 q2 q3 … qt-1

T=1 T=2 T=3

t-1时 刻

qt

t 时刻

S1

隐

藏

S2

)

aa2102 S2

S1

a11 S1 a12 2 ( 2 )

S2

a21

S1

S2

a22 aa0233

1(3) S3

S2

a22 a23

2 (3) S3

S2

SaN0a5aN014aaNNN2

1(4 S4

)

S3

a32 2 ( 4 ) a33 S4

SN

1(5)

O1

S5 O2

2 (5) S5 O3

3 (1 ) t=T-

S1

a11 a12

t=3

t=4

t=5

SS11

a11 a12

SS11

a11 a12

a21

SS22 a22

S2 a22

S2 a22

S2 a22

SS22

a23

a23

a23

a23

a31 a32

a32

a32

a32

S3 a33

SS33 a33

S3

a33

S3 a33

S3

I-隐藏状态

b2(Q3)

Q2

…

…

…

…

…

QM

QM

QM

…

QM

QM

t=1

t=2

t=3

t=T-

t=T

1

马儿科夫过程 隐藏状态序列

H M M

一般随机过程 观察状态序列

4. 隐马尔可夫模型(Hidden Markov Models,HMM)

一阶隐马尔可夫模型(Hidden Markov Models)图解

t=1

t=2

转移概率

S1

a11 a13a12

T (1 ) t=T

S1 1 3 ( 2 ) S1

…S2

a11 S1 a12 T ( 2 )

S2

a21

S1

aT1 aT2

3(3)

…S3

S2

a22 a23

T (3 S3

)

SSz22

aT3

aT4

3 ( 4 ) SN S4

a32 T ( 4 ) a33 S4

SN

aT5

3(5)

T (5)

S5 OT-1

N

π

SS22

… a11 a12 a1N

S2

AN *N

a

21

aS222

a

2

N

S2

SS22

…

…

…

…

a N 1 a N 2 a NN

SN

S3N

SN

…

SN

SN

…

…

B生成概率矩阵

M

O1

O2

b11 b12O 3 b1M OT-1

OT

…

…

…

… BN*M

b21 b22

…

b2

M

OM

q1 q2 q3 … qt-1

qt

T=1 T=2 T=3

t-1时 刻

t 时刻

5. 隐马尔可夫模型(Hidden Markov Models,HMM)

一阶隐马尔可夫模型(Hidden Markov Models)数学定 义

t=1

t=2

S1

S1

t=3

t=T-

t=T

1

… SS11

SS11

S1

A转移概率矩阵

OM

bN1 bNO2M bNM OM

OM

HMM模型五元组表示:λ =( N, M, π , A, B)用来描述HMM,或简写为 λ =(π , A, B)

6

提纲

1

Hidden Markov Model

2

隐马尔科夫模型的三个问题

概率计算问题

路径预测问题

参数学习问题

3

总结

7

1. 隐马尔可夫模型-全概率计算

S5 OT

A转移概率矩阵

a11 a12 a1N

AN *N

a

21

a

2

2

a

2

N

a N 1 a N 2 a NN

后

E

向

算 B生成概率矩阵 法 b11 b12 b1M

BN *M

b21 b22

b2

M

bN

1

bN

2

bNM

问题本质:计算产生观测序列O的所有可能的状态序列对应的概率之和

S12

S33

S3

…

S3

S3

aN1

SN

SN

…

SSNN

SN

S2 a 2 3

a 31

S3

S1

……

SN a N ,1

S1

一条马尔可夫链

2

2. 一阶马尔可夫模型概念

一阶马尔可夫模型(Markov Models)

系统状态数目(N=3) S1 晴 S2 阴 S3 雨

t=1

t=2

t=3

t=4

t=5

S1

a11 a13a12

S1

a11 a12

S1

a11 a12

S1

a11 a12

S1

a21

a21

a21

a21

S2 a22

S2 a22

S2 a22

S2 a22

S2

a23

a23

a23

a23

a31 a32

a32

a32

a32

S3 a33

S3

a33

S3 a33

S3 a33

S3

• 从某时刻状态到下时刻的状态按一定概率转移

aijP (qt Sj|qt 1Si)

生成概率

Q3

b3(Q4) Q4

b1(Q1) Q1

b1(Q1) Q1

b2(Q2) O2

II-观察序列

• 从某时刻状态到下时刻的状态按一定概率转移

aijP (qt Sj|qt 1Si)

qt-1

qt

t-1时

t时刻

刻

5

• 下时期状态只取决于当前时期状态和转移概率 P ( q t S j|q t 1 S i , q t 2 S k ,) P ( q t S j|q t 1 S i )

状

态

S3

SN

Q1

观 测

Q2

状

态

QM

4

…

…

3. 隐马尔可夫模型

t=1

t=2

t=3

S1

S1

SS11

…

S2

a 23

S3

S2

a 3 1 S2

S33

S3

… …

…

…

…

SN

SN

SN

…

t=T-

t=T

1

S1

S1

S2

S12

…

…

S3

S3

aN1

SSNN

SN

状态序列≠观测序列

QQ11

Q1

Q2

Q2

Q1

…

Q2

…

…

QQ11

Q1

Q2

问题1:给定观察序列O=O1,O2, …,OT,以及模型λ=(π,A,B),计算P(O|λ)?

Π:初始概率向

量

a01

a 01

前

a

0

2

向

算 a 0 N

法

π a02

B

a0N

… … … … … …

t=1

1 (1 ) t=2

2 (1 ) t=3

S1

a11 aa0113a12

S1 1(2

隐马尔可夫模型原理图解

Hidden Markov Models

张庆科

山东大学高性能计算与大数据处理学科组

High Performance Computing and Big Data Processing Group

提纲

1

Hidden Markov Model

2

隐马尔科夫模型的三个问题

概率计算问题

路径预测问题

参数学习问题

3

总结

1

1马尔可夫模型

马尔可夫模型是数学中具有马尔可夫性质的离散时间随机过程,是用于描述随机

过程统计特征的概率模型。

… …

… … …

…

S1 S2 S3

SN 系统状态数目(N个)

t=1 S1

S2

a 23

S3

SN

t=2

t=3

t=T-

t=T

1

S1

S11

…

S1

S1

S2 a状3 1 态S2序列=…观测序列 S2