典型的几个负载均衡算法PPT课件

第十一讲 负载均衡服务.ppt

2019-10-10

感谢你的欣赏

仅十多年年来,对效率问题的重视程度有所下降: 为提高开发效率,人们往往以牺牲代码效率为代价

例如大量系统软件、框架的引入 方便了应用软件的开发 同时导致调用层次过多、系统执行效率下降 只是由于硬件速度与容量提升较快 盖过了软件效率的下降 使最终用户感觉系统速度还是增加了

这个过程需要自动化的测试工具来辅助完成: 测试工具主要用来模拟多种正常、峰值以及异常

负载条件 从而对系统的各项性能指标进行测试 效率测试可以使在用户模拟的环境中进行的

由于软件的运行效率与运行环境有很大的关系

因此效率测试更需要在系统部署到实际环境中

但还没有实际上线时进行

2019-10-10

感谢你的欣赏

当客户数量众多而又无法依赖高速硬件来完 成2019-负10-10载分发时,多点感谢你负的欣载赏 平衡可能是必须的

负载平衡粒度

指负载分发(或迁移)基本单位的组合程度

对于网络层的负载平衡,基本单位是IP数据报。一 种可能的负载平衡粒度是目标地址为同一个IP的所 有数据报(如Linux服务器集群系统的目标地址散 列调度算法)

空间高效性主要是占用资源(例如:CPU、内存、 数据库连接、网络连接等等)少

类似内容还包括:同时服务的客户数目等

2019-10-10

感谢你的欣赏

由于早期CPU的计算能力有限 内存容量也有限

因此程序的效率问题在早期很受重视:

算法复杂性的研究长期以来是计算机科学 的重要内容

衡量一个算法好坏的主要标准是时间开销 与空间开销

– 独立的负载均衡器上、服务节点自身、客户端

在多数情况下负载平衡由单个节点完成

单点负载平衡好处:

– 便于获得系统的全局状态,作出全局一致的决策;

负载均衡实现原理ppt课件

加权随机算法实现:

将加权与随机算法配合,根据随机数与加权比例后计算出当前新连接应该发往哪个

服务器。

课件部分内容来源于网络,如有异 议侵权的话可以联系删除,可编辑 版!

12

调度算法:源地址散列(Source Hashing)

2 1 4

Internet

5 1 4 3 6

2

5 3 6

源地址散列算法实现:

3.实服务组:为了便于对多个实服务 进行管理,将多个实服务的一些共 有属性提取出来形成了实服务组。 一个虚服务对应一个实服务组,一 个实服务组对应多个实服务。相同 的实服务组不能属于不同的虚服务。

课件部分内容来源于网络,如有异 议侵权的话可以联系删除,可编辑 版!

16

服务器型负载均衡转发方式

服务器负载均衡是数据中心最常见的组网模型。依据转发方式,分为NAT方 式、DR方式。

课件部分内容来源于网络,如有异 议侵权的话可以联系删除,可编辑 版!

10

调度算法:最少连接(Least Connections)

1 4 4 2 5 3 6

Internet

1

5 6

2 3

最少连接算法实现:

最少连接均衡算法对内部中需负载的每一台服务器都有一个数据记录,记录当前该 服务器正在处理的连接数量,当有新的服务连接请求时,将把当前请求分配给连接数 最少的服务器,使均衡更加符合实际情况,负载更加均衡。 最少连接算法适合长时处理的请求服务,如FTP。

Server Farms

Application

192.168.1.10

Load Blance to Client: Source IP = VIP - 6.6.6.100 Destination = 4.3.2.1

常见负载均衡算法

常见负载均衡算法⼀、概要随着系统⽇益庞⼤、逻辑业务越来越复杂,系统架构由原来的单⼀系统到垂直系统,发展到现在的分布式系统。

分布式系统中,可以做到公共业务模块的⾼可⽤,⾼容错性,⾼扩展性,然⽽,当系统越来越复杂时,需要考虑的东西⾃然也越来越多,要求也越来越⾼,⽐如服务路由、负载均衡等。

此⽂将针对负载均衡算法进⾏讲解,不涉及具体的实现。

⼆、负载均衡算法在分布式系统中,多台服务器同时提供⼀个服务,并统⼀到服务配置中⼼进⾏管理,如图1-1。

消费者通过查询服务配置中⼼,获取到服务到地址列表,需要选取其中⼀台来发起RPC远程调⽤。

如何选择,则取决于具体的负载均衡算法,对应于不同的场景,选择的负载均衡算法也不尽相同。

负载均衡算法的种类有很多种,常见的负载均衡算法包括轮询法、随机法、源地址哈希法、加权轮询法、加权随机法、最⼩连接法等,应根据具体的使⽤场景选取对应的算法。

图1-11、轮询(Round Robin)法轮询很容易实现,将请求按顺序轮流分配到后台服务器上,均衡的对待每⼀台服务器,⽽不关⼼服务器实际的连接数和当前的系统负载。

这⾥通过实例化⼀个serviceWeightMap的Map变量来服务器地址和权重的映射,以此来模拟轮询算法的实现,其中设置的权重值在以后的加权算法中会使⽤到,这⾥先不做过多介绍,该变量初始化如下:private static Map<String, Integer> serviceWeightMap = new HashMap<String, Integer>();static {serviceWeightMap.put("192.168.1.100", 1);serviceWeightMap.put("192.168.1.101", 1); //权重为4serviceWeightMap.put("192.168.1.102", 4);serviceWeightMap.put("192.168.1.103", 1);serviceWeightMap.put("192.168.1.104", 1);//权重为3serviceWeightMap.put("192.168.1.105", 3);serviceWeightMap.put("192.168.1.106", 1);//权重为2serviceWeightMap.put("192.168.1.107", 2);serviceWeightMap.put("192.168.1.108", 1);serviceWeightMap.put("192.168.1.109", 1);serviceWeightMap.put("192.168.1.110", 1);}通过该地址列表,实现的轮询算法的部分关键代码如下private static Integer pos = 0;public static String testRoundRobin() {// 重新创建⼀个map,避免出现由于服务器上线和下线导致的并发问题Map<String, Integer> serverMap = new HashMap<String, Integer>();serverMap.putAll(serviceWeightMap);//取得IP地址listSet<String> keySet = serverMap.keySet();ArrayList<String> keyList = new ArrayList<String>();keyList.addAll(keySet);String server = null;synchronized (pos) {if (pos > keySet.size()) {pos = 0;}server = keyList.get(pos);pos++;}return server;}由于serviceWeightMap中的地址列表是动态的,随时可能由机器上线、下线或者宕机,因此,为了避免可能出现的并发问题,⽐如数组越界,通过在⽅法内新建局部变量serverMap,先将域变量拷贝到线程本地,避免被其他线程修改。

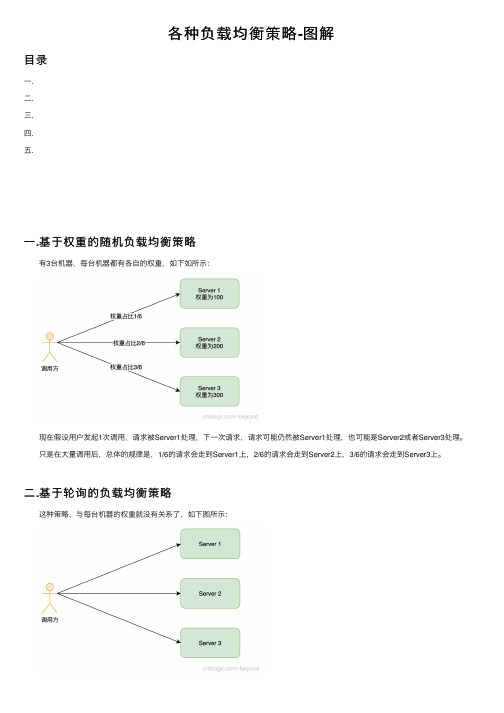

各种负载均衡策略-图解

各种负载均衡策略-图解⽬录⼀.⼆.三.四.五.⼀.基于权重的随机负载均衡策略 有3台机器,每台机器都有各⾃的权重,如下如所⽰: 现在假设⽤户发起1次调⽤,请求被Server1处理,下⼀次请求,请求可能仍然被Server1处理,也可能是Server2或者Server3处理。

只是在⼤量调⽤后,总体的规律是,1/6的请求会⾛到Server1上,2/6的请求会⾛到Server2上,3/6的请求会⾛到Server3上。

⼆.基于轮询的负载均衡策略 这种策略,与每台机器的权重就没有关系了,如下图所⽰: 在这种策略中,第1次请求被Server1处理,第2次请求被Server2处理,第3次请求被Server3处理,第4次请求被Server1处理,第5次请求被Server2处理,第6次请求被Server3处理....每个节点都会依次接收处理请求。

三.基于权重的轮询负载均衡策略 这种策略,是在轮询策略上增加了权重这个因素,如下图所⽰: 使⽤这种策略,会将请求“分组”,以上⾯这个图为例,因为总权重为600,和各节点约分后,分别占权重1/6,2/6,3/6,那么这个“分组”就是6,也就是说6个请求为⼀组,Server1会处理其中的1个请求(因为其权重占⽐为1/6),同理,Server2会处理2个请求,Server3会处理3个请求。

现在假设有2组(也就是12个请求),那么处理过程如下: 1.发起第1次请求,请求被Server1处理; 2.发起第2次请求,请求被Server2处理; 3.发起第3次请求,请求被Server3处理; 4.发起第4次请求,请求被Server2处理,注意,此时不是Server1处理,因为Server1已经处理了1/6的请求; 5.发起第5个请求,请求被Server3处理; 6.发起第6个请求,请求被Server3处理,注意,此时不是Server2处理,因为Server2已经处理2/6的请求; 此时,⼀组请求已经完成处理(共6个),接着进⾏第2组的处理。

深信服应用交付AD(负载均衡)幻灯片

选择最佳计算资源,分担任务处理

七层内容交换

c.jsp a.gif index.htm

c.jsp

JSP server

a.gif index.htm

GIF server HTML server

ISP 1 ISP 2

SANGFOR AD提供链路健康检查机制

• SANGFOR AD通过多个Internet站点的可达性,来共同判断一条链路的状况 • 内置多种协议TCP、UDP、ICMP、HTTP等 • 支持用户自定义,基于内容的链路健康检测机制 • 一旦链路出现问题,立即切换。

SANGFOR AD实现出站访问的链路负载均衡

• SANGFOR AD接收到内网的访问流量后,通过预先设定链路负载策略将用户访问流量分配到不同 的互联网链路之上。

• 静态就近性:根据目标网络进行NAT,内置全球地址库,实时动态更新 • 动态就近性:通过综合考虑与目标网络之间的网络延迟(Latency)和链路的实时负载(Load),

SANGFOR AD提供全面的七层调度策略

• 分析HTTP请求,基于URI、Cookies、HOST、HTTP-Head进行调度 • 将不同的HTTP请求交给不同的或多个服务器来响应以分担负载 • 支持HTTP请求改写和应答改写,以及页面跳转和丢弃

实现业务架构灵活配置和扩展

会话保持(Session Persistence)

深信服应用交付解决方案

——SANGFOR AD系列应用交付产品

目录

Sangfor AD 功能介绍 Sangfor AD 特色技术介绍 Sangfor AD 业务场景介绍

负载均衡配置手册ppt课件

CLI: 额外的一些提示符

• 冗余模式下

– vThunder-Active> – vThunder-Standby>

• 集群模式下(Avcs)

– vThunder-Active-vMaster[7/1]> – vThunder-Standby-vBlade[7/2]>

• 抓包模式下

5

CLI: 帮助命令

Pool Name Start Address End Address Mask

Gateway HA Group Vrid

nat1 10.0.2.15 10.0.2.16 /24 0.0.0.0

0 default

7

CLI: 禁用配置

• 配置时“no enable” 命令效果和“disable”

命令效果一致

– vThunder#show run | sec slb

– slb server s1 10.0.2.18

– vThunder(config)#slb server s1

– vThunder(config-real server)#no enable

– vThunder#show run | sec slb

– 更适于故障诊断,因为可以在一个界面上同时显 示所有配置

– 可以快速配置

– 操作设备时需要的带宽更小

• Web界面的优点

– 更灵活的配置方式

15

ADC配置组件

• ADC配置组件

– 配置文件 – (可选) aFleX 配置文件 – (可选) PBSLB配置文件 – (可选) SSL 证书和秘钥 – (可选) Geo-location配置文件(可用于GSLB和基

13

Web界面: 工作流

第十一讲 负载均衡服务.ppt

– 也可能单点失效 2019年8月23

感谢你的观看

多点负载平衡

可以获得比较好的伸缩性,但一般仅能使用 静态算法

存在两种类型的多点负载平衡

– 一种是多个节点独立地进行决策,其综合效果取 决于单个节点的负载平衡效果与多个节点的叠加 效果;

– 另一种是多个节点并行地做出相同的决策,如根 据请求的源地址(或目标地址)进行静态散列以 确定服务节点,此时多个物理负载平衡点等价于 单个逻辑负载平衡点。

很多参数的设置会影响到动态算法的效果

– 例如从各节点获取负载的频率以及确定节点是否

过载的界限等

2019年8月23

感谢你的观看

2、Web层的负载平衡

Web层负载平衡具有如下特点: 1)单点负载平衡,既逻辑上只有一个负载

平衡点,物理上也只有一个负载平衡点 2)请求级负载平衡,即每次客户请求都需

要经由负载平衡器进行请求分发

三种粒度的平衡

查找级(per-lookup) 向一个home对象以及该home 对象创建的所有remote对象发出的请求都由一个固 定的节点处理,仅支持同一个EJB的不同home对象 及不同EJB的负载平衡

会话级(per-session) 向home对象发出的不同请求 可以负载平衡,而向remote对象发出的请求则始终 由创建该对象的节点处理

常用的静态算法有轮循、随机及加权轮 循 算法(weighted round-robin)等几种

其中轮循与随机算法适合于所有节点处 理能力相当的情况,静态加权算法适合 于节点处理能力不同的情况

2019年8月23

感谢你的观看

动态算法

动态算法也称为适应性算法,参考运行时的 系统信息做出负载平衡决策

常见的负载均衡算法

常见的负载均衡算法

以内

负载均衡算法是指在集群运行环境中,根据所接收请求的特点,合理分配到不同服务

器上,从而实现系统负载均衡,达到最优的资源利用效果,是集群架构中的一种重要的网

络架构。

目前常见的负载均衡算法有轮询、权重轮询、最小连接数、哈希、动态调度等。

一、轮询:轮询是指服务器的负载均衡算法,它假设客户端发送的请求量是均匀的,

系统会采用轮流的方式将请求分配到每一个服务器上。

二、权重轮询:权重轮询算法是负载均衡算法中比较常用的一种,用于配置不同服务

器负载不同的“权重”,根据这个“权重”轮流分发任务。

在这种算法中,权重越高,单

个服务器收到的请求比例就越多。

三、最小连接数:最小连接数算法是指将新的请求指定到拥有最少连接的服务器上,

因为这样的服务器处理能力依然会比较强,降低请求处理延时。

四、哈希:哈希算法是一种比较常用的负载均衡算法,它的原理是采用特定的函数对

客户端发送的请求和服务器进行匹配,最终实现均衡负载。

五、动态调度:动态调度算法是指系统根据变化情况实时衡量系统负载,并将负载动

态分发到每一个服务器上,实现负载的动态调度、平衡等工作,从而保证系统的稳定运行。

介绍负载均衡算法

介绍负载均衡算法

负载均衡算法有以下几种:

1.轮询法:将请求按顺序轮流地分配到后端服务器上,它均衡地对待后端的每一台服务器,而不关心服务

器实际的连接数和当前的系统负载。

2.加权轮询法:不同的后端服务器可能机器的配置和当前系统的负载并不相同,因此它们的抗压能力也不

相同。

为保证处理能力强的服务器处理更多的访问流量,用相应的权值表示服务器的处理性能,将请求数目按权值的比例分配给各服务器。

调度器可以自动询问服务器的负载情况,并动态地调整其权值。

3.随机法:通过系统的随机算法,根据后端服务器的列表大小值来随机选其中一台服务器访问。

4.加权随机法:与加权轮询法一样,加权随机法也根据后端机器的配置、系统的负载分配不同的权重。

不

同的是,它是按照权重随机请求后端的服务器,而非顺序。

5.最小连接数:最小连接数算法比较灵活和智能,由于后端服务器的配置不尽相同,对于请求的处理有快

有慢,它是根据后端服务器的连接情况,动态地选取其中当前积压连接数最少的一台服务器来处理当前的请求,尽可能地提高后端服务的利用效率,将负责合理地分流到每一台服务器。

1。

云计算与负载均衡PPT课件

2020/2/25

7

2020/2/25

8

云安全 云物联 云教育 云游戏

物联网中的感知识别设 备(如传感器、RFID等) 生成的大量信息如果不 能有效地整合与利用, 那无异于入宝山而空返, 望“数据的海洋”而兴叹。 云计算架构可以用来解 决数据如何存储、如何 检索、如何使用、如何 不被滥用等关键问题。

2020/2/25

1

云计算定义 云计算起源及发展 云计算产业结构 云计算带来的技术变革 云OS

2020/2/25

2

云计算(Cloud Computing)是网格计算(Grid Computing )、分布式计算(DistributedComputing)、 并行计算(Parallel Computing)、效用计算(Utility Computing)、网络存储(Network Storage Technologies)、虚拟化(Virtualization)、负载均衡 (Load Balance)等传统计算机和网络技术发展融合的 产物。

2020/2/25

9

云计算操作系统,又称云计算中心操作系统、云OS, 是云计算后台数据中心的整体管理运营系统。它是 指构架于服务器、存储、网络等基础硬件资源和单 机操作系统、中间件、数据库等基础 软件管理的海 量的基础硬件、软资源之上的云平台综合管理系统。

云计算操作系统有以下几个作用,一是治众如治寡, 能管理和驱动海量服务器、存储等基础硬件,将一 个数据中心的硬件资源逻辑上整合成一台服务器; 二是为云应用软件提供统一、标准的接口;三是管 理海量的计算任务以及资源调配;

狭义云计算指IT基础设施的交付和使用模式,指通过网 络以按需、易扩展的方式获得所需资源;广义云计算指 服务的交付和使用模式,指通过网络以按需、易扩展的 方式获得所需服务。

《负载计算方法》课件

负载计算的重要性

,可 以避免因负载过大而导致 的系统崩溃或性能下降, 提高系统的稳定性。

提高系统效率

合理的负载计算有助于充 分发挥硬件和软件的性能 ,提高系统的运行效率。

优化资源利用

通过负载计算,可以合理 地分配系统资源,避免资 源的浪费,提高资源利用 率。

负载计算的基本原则

充分了解系统配置

在进行负载计算时,需要 充分了解系统的硬件配置 和软件配置,以便准确地 评估系统的负载能力。

考虑实际运行状态

在进行负载计算时,需要 考虑系统的实际运行状态 ,如当前正在运行的任务 、内存使用情况等。

留有余量

在进行负载计算时,需要 留有一定的余量,以应对 突发的高负载情况。

详细描述

通过将部分计算任务分配给边缘设备 处理,可以减轻中心服务器的负载压 力,提高计算效率和响应速度,降低 网络延迟和数据传输成本。

分布式系统的负载均衡技术

总结词

利用分布式系统的负载均衡技术,将负载分 配到多个节点上处理,提高系统整体的处理 能力。

详细描述

分布式系统通过负载均衡技术可以将负载分 配到多个节点上处理,实现并行计算和协同 处理,提高系统整体的处理能力和可靠性。 同时,通过合理的负载均衡策略,可以避免 节点间的负载不均和瓶颈问题,进一步提高

大数据处理中的负载计算

总结词

大数据处理中的负载计算主要用于优 化数据处理效率和资源分配。

详细描述

在大数据处理中,负载计算通过对数 据集的大小、处理复杂度和计算资源 的需求进行实时监测和分析,合理地 分配计算资源和任务,提高数据处理 效率。

物联网中的负载计算

总结词

物联网中的负载计算主要用于优化设备性能和网络资源分配。

解密负载均衡算法

解密负载均衡算法负载均衡算法指的是一种负载分担、负载映射和负载控制的复杂算法,旨在使得网络传输的最佳状态的负载均衡的策略。

负载均衡算法的本质是通过不断进行有效的加载分配来减少网络节点间的交互操作,从而有效降低网络拥塞。

负载均衡算法在不同的环境中有不同的应用,主要包括服务器负载均衡算法、网络负载均衡算法、路由器负载均衡算法等。

下面是其中的一些常见算法:1. 基于距离的算法(Distance-based Algorithm):是将负载映射给最近节点。

这种算法利用节点之间的距离来指示剩余负载,因此负载可以根据更精确的地址来确定,从而有效减少网络节点之间的延迟。

优点是可以大幅减少数据中心之间的无效负载流量。

2. 节点增量算法(Node Increment Algorithm):这种算法通过按照预先定义的负载均衡大小增加节点(nodes)的负载。

这种算法的优点是可以逐渐增加网络的容量,以便系统能够应对突发的流量和负载。

3. 加权可用负载算法(Weighted Available Load Algorithm):这种算法通过分配加权的可用负载(Load)来实现负载均衡。

它的优势在于可以在不同的负载节点上进行加权,使得可以保证数据中心的可用负载更加平均,从而减少网络延迟和拥塞。

4. 加权最小活动时间(Weighted Minimum Active Time)算法:这种算法通过结合有向图算法和加权最小活动时间算法来实现负载分担。

该算法可以将负载分散到网络中的各个节点,而同时又能确保负载的效率和完整性。

5. 平均响应时间(Average Response Time)算法:这是一种新颖的算法,可以通过两个相关参数——平均响应时间和异常采样率来实现自动分配和调整负载。

优点在于可以有效降低网络数据中心间的流量,同时还可以有效提高网络的吞吐率和可靠性。

负载均衡算法在现在的网络系统中起着越来越重要的作用,有效的负载均衡可以大大减少节点间的网络通信延迟,同时还可以保证网络的可靠性和性能。

典型的几个负载均衡算法共12页

Internet

Clients

The number of members that must be active in a priority group in order for the BIG-IP Controller to send its requests to that group

Router

Clients Router BIG-IP Controller

101 102

14ms 15ms 20ms 11ms Current Response Times

Servers

Load Balancing – Least Connection

Internet

Next requests goes to Node with fewest number of connections

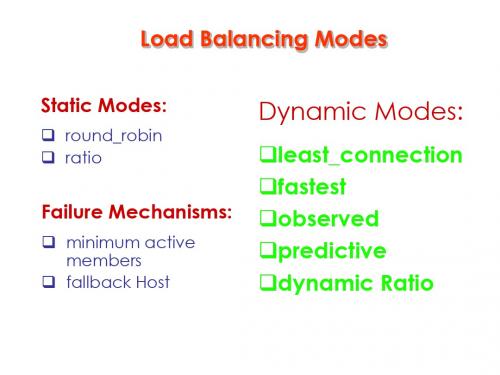

Load Balancing Modes

Static Modes:

round_robin ratio

Failure Mechanisms:

minimum active members

fallback Host

Dynamic Modes:

least_connection fastest observed predictive dynamic Ratio

Clients Router BIG-IP Controller

1 2

462 460 455 465 Current Connections

Servers

Load Balancing – Least Connection

Internet

Next requests goes to Node with fewest number of connections

深信服应用交付AD(负载均衡)幻灯片

VMware虚拟机自动化配置与迁移

VMware ESXi & ESX

调整VM 修改配置

自动添加 简化操作

VM Configure

vCenter Server

获取VM配置信息

• 报表定制化:提供报表定制服务

IT架构和业务决策提供直观数据和决策依据

服务器弹性负载

RST关闭连接、零窗口

14

2 57

3 68

SANGFOR AD提供基于TCP行为观测的动态调控机制

• 智能判断:SANGFOR AD通过持续观测发现,某服务器节点的状态满足失效条件时,即将该节点 标记为无效,并不再向此节点转发来自客户端的请求

13 57

13 57

24 68

SANGFOR AD提供全面的会话保持算法

24 68

• SANGFOR AD会话保持用以识别客户与服务器之间交互过程的关联性,在作负载均衡的同时,还 保证一系列相关联的访问请求会保持分配到一台服务器上,以确保应用不会出错

• 支持的会话保持方式:基于源IP保持、Cookie(插入、被动、改写)、HTTP-Header、Radius、 SSL Session ID

SANGFOR AD实现出站访问的链路负载均衡

• SANGFOR AD接收到内网的访问流量后,通过预先设定链路负载策略将用户访问流量分配到不同 的互联网链路之上。

• 静态就近性:根据目标网络进行NAT,内置全球地址库,实时动态更新 • 动态就近性:通过综合考虑与目标网络之间的网络延迟(Latency)和链路的实时负载(Load),

负载均衡算法

负载均衡算法

1. 轮询法:每个请求按照顺序轮流分配给后端服务器,平均分配后端服务器的负载,缺点是无法应对后端服务器性能不均衡的情况。

2. 最少连接法:负载均衡算法会优先将请求分配给当前连接数最少的后端服务器,从而将负载均衡分配到各个后端服务器上,但是无法考虑后端服务器的性能。

3. 权重轮询法:与轮询法类似,但是每个服务器可以设置不同的权重,按照权重比例将请求分配到后端服务器,可以根据后端服务器的性能设置不同的权重。

4. IP Hash法:将客户端的IP地址哈希之后,根据哈希值将请

求分配到不同的后端服务器,保证同一个客户端的请求会被分配到相同的后端服务器,但是无法应对后端服务器性能不均衡的情况。

5. 加权轮询法:结合轮询法和权重轮询法,每个服务器有一个权重值,按照权重值将请求分配到后端服务器,可以根据后端服务器的性能设置不同的权重。

6. 最小响应时间法:负载均衡算法会优先将请求分配给响应时间最短的后端服务器,从而将负载均衡分配到各个后端服务器上,可以根据后端服务器的性能设置不同的权重。

13种负载均衡算法

13种负载均衡算法目录•前言•(1)轮转调度(Round-Robin Scheduling)算法•(2)加权轮转调度(Weighted Round-Robin Scheduling)算法•(3)随机均衡调度(Random Scheduling)算法•(4)加权随机均衡调度(Weighted Random Scheduling)算法•(5)最小连接调度(Least-Connection Scheduling)算法•(6)加权最小连接调度(Weighted Least-Connection Scheduling)算法•(7)目标地址散列调度(Destination Hashing Scheduling)算法•(8)源地址散列调度(Source Hashing Scheduling)算法•(9)基于局部性的最少链接调度(Locality-Based Least ConnectionsScheduling)算法•(10)带复制的基于局部性最少链接调度(Locality-Based Least Connectionswith Replication Scheduling)算法•(11)响应速度均衡调度(Response Time Scheduling)算法•(12)处理能力均衡调度(Processing Capacity Scheduling)算法•(13)DNS均衡调度(DNSScheduling)算法前言所谓负载,一般指处理节点的CPU负载、MEM利用率、网络负载、可用的缓冲区、应用系统负载、用户数量以及其他的各种系统资源的当前状态信息。

所谓负载均衡,是指处理节点的负载信息通过某代理软件传递给均衡器,由均衡器做出决策并对负载进行动态分配,从而使集群中各处理节点的负载相对趋于平衡。

要实现(1)为用户提供更好的访问质量。

(2)提高服务器响应速度。

(3)提高服务器及其他资源的利用效率。

(4)避免了网络关键部位出现单点失效。

负载均衡技术

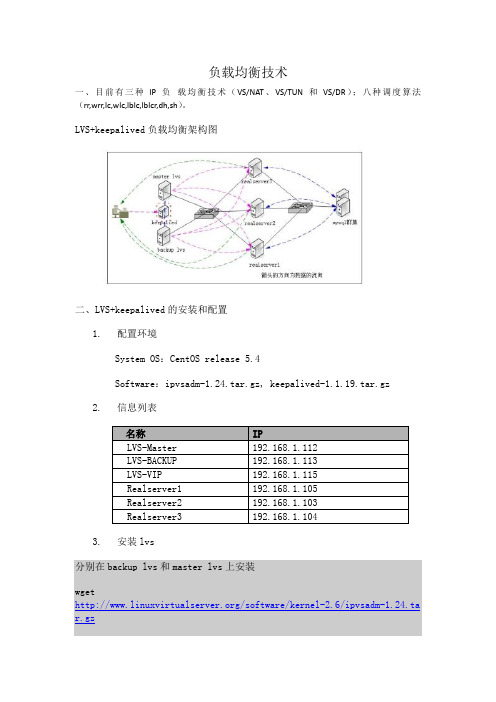

负载均衡技术一、目前有三种IP负载均衡技术(VS/NAT、VS/TUN和VS/DR);八种调度算法(rr,wrr,lc,wlc,lblc,lblcr,dh,sh)。

LVS+keepalived负载均衡架构图二、LVS+keepalived的安装和配置1.配置环境System OS:CentOS release 5.4Software:ipvsadm-1.24.tar.gz, keepalived-1.1.19.tar.gz2.信息列表3.安装lvs分别在backup lvs和master lvs上安装wget/software/kernel-2.6/ipvsadm-1.24.ta r.gzln -s /usr/src/kernels/2.6.18-164.el5-i686/ /usr/src/linuxtar zxvf ipvsadm-1.24.tar.gzcd ipvsadm-1.24make && make install4.安装keepalived分别在backup lvs和master lvs上安装wget /software/keepalived-1.1.19.tar.gztar zxvf keepalived-1.1.19.tar.gzcd keepalived-1.1.19./configure --prefix=/usr/local/keepalivedmakemake installcp /usr/local/keepalived/sbin/keepalived /usr/sbin/cp /usr/local/keepalived/etc/sysconfig/keepalived /etc/sysconfig/cp /usr/local/keepalived/etc/rc.d/init.d/keepalived /etc/init.d/ mkdir /etc/keepalived5.配置keepadlivedLVS-Master的配置文件如下[root@linux5 ~]# cat /etc/keepalived/keepalived.confglobal_defs {notification_email {jimo291@ #email 通知}notification_email_from jimo291@smtp_server 127.0.0.1smtp_connect_timeout 30router_id LVS1 #设置lvs的id,在一个网络内应该是唯一的}vrrp_sync_group test { #设置vrrp组group {loadbalance}}vrrp_instance loadbalance {state MASTER #设置lvs的状态,报错MASTER和BACKUP两种,必须大写interface eth0 #设置对外服务的接口lvs_sync_daemon_inteface eth0 #设置lvs监听的接口virtual_router_id 51 #设置虚拟路由表示priority 180 #设置优先级,数值越大,优先级越高advert_int 5 #设置同步时间间隔authentication { #设置验证类型和密码auth_type PASSauth_pass 1111}virtual_ipaddress { #设置lvs vip192.168.1.115}}virtual_server 192.168.1.115 80 {delay_loop 6 #健康检查时间间隔lb_algo rr #负载均衡调度算法lb_kind DR #负载均衡转发规则#persistence_timeout 20 #设置会话保持时间,对bbs等很有用 protocol TCP #协议real_server 192.168.1.105 80 {weight 3 #设置权重TCP_CHECK {connect_timeout 3nb_get_retry 3delay_before_retry 3connect_port 80}}real_server 192.168.1.103 80 {weight 3TCP_CHECK {connect_timeout 3nb_get_retry 3delay_before_retry 3connect_port 80}}real_server 192.168.1.104 80 {weight 3TCP_CHECK {connect_timeout 3nb_get_retry 3delay_before_retry 3connect_port 80}}}LVS-backup的配置文件如下global_defs {notification_email {jimo291@}notification_email_from jimo291@ smtp_server 127.0.0.1smtp_connect_timeout 30router_id LVS2}vrrp_sync_group test {group {loadbalance}}vrrp_instance loadbalance {state BACKUPinterface eth0lvs_sync_daemon_inteface eth0 virtual_router_id 51priority 150advert_int 5authentication {auth_type PASSauth_pass 1111}virtual_ipaddress {192.168.1.115}}virtual_server 192.168.1.115 80 {delay_loop 6lb_algo rrlb_kind DR#persistence_timeout 20protocol TCPreal_server 192.168.1.105 80 { weight 3TCP_CHECK {connect_timeout 3nb_get_retry 3delay_before_retry 3connect_port 80}}real_server 192.168.1.103 80 { weight 3TCP_CHECK {connect_timeout 3nb_get_retry 3delay_before_retry 3connect_port 80}}real_server 192.168.1.104 80 { weight 3TCP_CHECK {connect_timeout 3nb_get_retry 3delay_before_retry 3connect_port 80}}}6.Realserver的配置三台客户端的脚本都一样!cat /etc/rc.d/init.d/realserver.sh#!/bin/bash# description: Config realserver lo and apply noarpSNS_VIP=192.168.1.115/etc/rc.d/init.d/functionscase "$1" instart)ifconfig lo:0 $SNS_VIP netmask 255.255.255.255 broadcast $SNS_VIP /sbin/route add -host $SNS_VIP dev lo:0echo "1" >/proc/sys/net/ipv4/conf/lo/arp_ignoreecho "2" >/proc/sys/net/ipv4/conf/lo/arp_announceecho "1" >/proc/sys/net/ipv4/conf/all/arp_ignoreecho "2" >/proc/sys/net/ipv4/conf/all/arp_announcesysctl -p >/dev/null 2>&1echo "RealServer Start OK";;stop)ifconfig lo:0 downroute del $SNS_VIP >/dev/null 2>&1echo "0" >/proc/sys/net/ipv4/conf/lo/arp_ignoreecho "0" >/proc/sys/net/ipv4/conf/lo/arp_announceecho "0" >/proc/sys/net/ipv4/conf/all/arp_ignoreecho "0" >/proc/sys/net/ipv4/conf/all/arp_announceecho "RealServer Stoped";;*)echo "Usage: $0 {start|stop}"exit 1esacexit 07.测试1)首先测试各个realserver,确定各个realserver都能正常访问,测试realserver.sh脚本,看启动后能不能绑定lvs vip,停止后能不能去除绑定的vip2)测试lvs能否进行负载均衡转发,利用ipvsadm命令查看,如果想只当当前的请求转发到哪个服务器去了,可以用ipvsadm加选项来查看,其完整形式为:ipvsadm –lcn | grep 192.168.1.1153)停掉主lvs看lvs backup是否接管!更详细信息请查看日志,tail -f /var/log/messages实现高可用集群来源: ChinaUnix博客日期: 2009.07.21 14:49 (共有条评论) 我要评论entOS5.2lived介绍tual Server的简写,意即Linux虚拟服务器,是一个虚拟的服务器集群系统。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Clients Router BIG-IP Controller

2021/3/7

1

Servers

2

10ms 5ms 20ms 17ms Current Response Times

6

Load Balancing - Fastest

Internet

Next requests go to Node with shortest response time

Load Balancing Modes

Static Modes:

round_robin ratio

Failure Mechanisms:

minimum active members

fallback Host

Dynamic Modes:

least_connection fastest observed predictive dynamic Ratio

Clients Router BIG-IP Controller

2021/3/7

61 62

342 330 338 335 Current Connections

Servers

9

Load Balancing – Observed

Internet

Next requests goes to Node with combination of fewest connections and best response

Clients Router BIG-IP Controller

2021/3/7

101 102

Servers

14ms 15ms 20ms 11ms Current Response Times

7

Load Balancing – Least Connection

Internet

Next requests goes to Node with fewest number of connections

2021/3/7

1

Load Balancing – Round Robin

Internet

Clients

Client requests are distributed evenly

Router BIG-IP Controller

2021/3/7

1

2

3

4

5

6

7

8

Servers

2

Load Balancing - Ratio

BIG-IP Controller

Priority 2

Priority 1

1

2

35 4 6

Servers

2021/3/7 Minimum Active Members = 2

4

Load Balancing – Minimum Active Members

Internet

Clients

If the number of active members falls below this number, requests are sent to the next highest priority group

Internet

Clients

Administrator sets ratio for distributing Client requests 3:1:1:1

Router BIG-IP Controller

2021/3/7

1 23 45Βιβλιοθήκη 67 8 9 10

11

12

Servers

3

Load Balancing – Minimum Active Members

2021/3/7

1 2

Clients

Router BIG-IP Controller

Servers

10

Load Balancing – Predictive

Internet

Next requests goes to Node with combination of fewest connections and best response over time

Internet

Clients

The number of members that must be active in a priority group in order for the BIG-IP Controller to send its requests to that group

Router

2021/3/7

1 2

Clients Router BIG-IP Controller

Servers

11

素材和资料部分来自 网络,如有帮助请下载!

Clients Router BIG-IP Controller

2021/3/7

1 2

462 460 455 465 Current Connections

Servers

8

Load Balancing – Least Connection

Internet

Next requests goes to Node with fewest number of connections

Priority 2

Router

BIG-IP Controller Priority 1

1

2

3

4

5

6 Servers

2021/3/7 Minimum Active Members = 2

5

Load Balancing - Fastest

Internet

Next requests go to Node with shortest response time