SSE-Intrinsic函数优化

k均值聚类算法的收敛准则函数

k均值聚类算法的收敛准则函数

常见的收敛准则函数有两种:平均误差平方和(SSE)和轮廓系数。

1.平均误差平方和(SSE):

平均误差平方和是一种度量聚类质量的准则函数。

它衡量了每个数据

点与其所属簇的质心之间的距离之和,表示了簇内离散程度的度量。

SSE

计算公式如下:

SSE = Σ(Σdist(xi, ci))^2

其中,xi表示第i个数据点,ci表示第i个数据点所属的簇的质心,dist(x, c)表示数据点x与质心c之间的距离。

2.轮廓系数:

轮廓系数是一种度量聚类结果的准则函数,用于评估聚类的紧密性和

区分度。

它通过度量簇内样本的紧密度和不同簇之间的分离度来刻画聚类

的质量。

轮廓系数的计算公式如下:

s(i) = (b(i) - a(i))/max(a(i), b(i))

其中,a(i)表示数据点i到同簇其他点的平均距离,b(i)表示数据点

i到其他簇的平均最短距离。

s(i)的取值范围在-1到1之间,值越接近1

表示聚类效果越好。

综上所述,k均值聚类算法的收敛准则函数是SSE和轮廓系数。

根据

具体的应用场景和需求,可以选择合适的准则函数来评估聚类的质量和判

断算法的收敛性。

双三次插值算法的C++实现与SSE指令优化

双三次插值算法的C++实现与SSE指令优化在上篇⽂章中,我们讲解了常见的最邻近插值算法、双线性插值算法和双三次插值算法的原理与实现,三种插值算法中双三次插值算法的插值效果最好,但其也是三种算法中计算复杂度最⾼、耗时最长的算法。

本⽂在给出双三次插值C++代码的基础上,着重讲解如何使⽤SSE指令来优化该算法,并使⽤双三次插值来实现图像的缩放,⽐较SSE指令优化前后的耗时。

1. 基于C++与Opencv的代码实现算法原理在上篇⽂章中已经讲了,此处直接贴出代码:float cubic_w_f(float x, float a){if (x <= 1){return 1 - (a + 3)*x*x + (a + 2)*x*x*x;}else if (x < 2){return -4 * a + 8 * a*x - 5 * a*x*x + a*x*x*x;}return 0.0;}void cal_cubic_coeff(float x, float y, float *coeff){float u = x - floor(x);float v = y - floor(y);u += 1;v += 1;float a = -0.15;float A[4];A[0] = cubic_w_f(abs(u), a);A[1] = cubic_w_f(abs(u - 1), a);A[2] = cubic_w_f(abs(u - 2), a);A[3] = cubic_w_f(abs(u - 3), a);for (int s = 0; s < 4; s++){float C = cubic_w_f(abs(v - s), a);coeff[s * 4] = A[0] * C;coeff[s * 4 + 1] = A[1] * C;coeff[s * 4 + 2] = A[2] * C;coeff[s * 4 + 3] = A[3] * C;}}uchar cubic_inner(Mat src, float x_float, float y_float, float a){float coeff[16];cal_cubic_coeff(x_float, y_float, coeff); //计算权重系数float sum = 0.0;int x0 = floor(x_float) - 1;int y0 = floor(y_float) - 1;for (int i = 0; i < 4; i++){for (int j = 0; j < 4; j++){sum += coeff[i * 4 + j] * src.ptr<uchar>(y0 + i)[x0 + j];}}return ((uchar)sum);}2. SSE指令优化算法⾸先,我们来看⼀下浮点型坐标点周围的4*4个整型点分别在x⽅向与y⽅向上与该浮点型坐标点的像素距离,假设浮点型坐标点的x坐标的⼩数部分为u,y坐标的⼩数部分为v,那么x⽅向与y⽅向上的距离如下图所⽰(每⼀格的像素距离为1)。

SSE指令集学习:CompilerIntrinsic

SSE指令集学习:CompilerIntrinsic⼤多数的函数是在库中,Intrinsic Function却内嵌在编译器中(built in to the compiler)。

1. Intrinsic FunctionIntrinsic Function作为内联函数,直接在调⽤的地⽅插⼊代码,即避免了函数调⽤的额外开销,⼜能够使⽤⽐较⾼效的机器指令对该函数进⾏优化。

优化器(Optimizer)内置的⼀些Intrinsic Function⾏为信息,可以对Intrinsic进⾏⼀些不适⽤于内联汇编的优化,所以通常来说Intrinsic Function要⽐等效的内联汇编(inline assembly)代码快。

优化器能够根据不同的上下⽂环境对Intrinsic Function进⾏调整,例如:以不同的指令展开Intrinsic Function,将buffer存放在合适的寄存器等。

使⽤ Intrinsic Function对代码的移植性会有⼀定的影响,这是由于有些Intrinsic Function只适⽤于Visual C++,在其他编译器上是不适⽤的;更有些Intrinsic Function⾯向的是特定的CPU架构,不是全平台通⽤的。

上⾯提到的这些因素对使⽤Intrinsic Function代码的移植性有⼀些不好的影响,但是和内联汇编相⽐,移植含有Intrinsic Function的代码⽆疑是⽅便了很多。

另外,64位平台已经不再⽀持内联汇编。

2. SSE IntrinsicVS和GCC都⽀持SSE指令的Intrinsic,SSE有多个不同的版本,其对应的Intrinsic也包含在不同的头⽂件中,如果确定只使⽤某个版本的SSE指令则只包含相应的头⽂件即可。

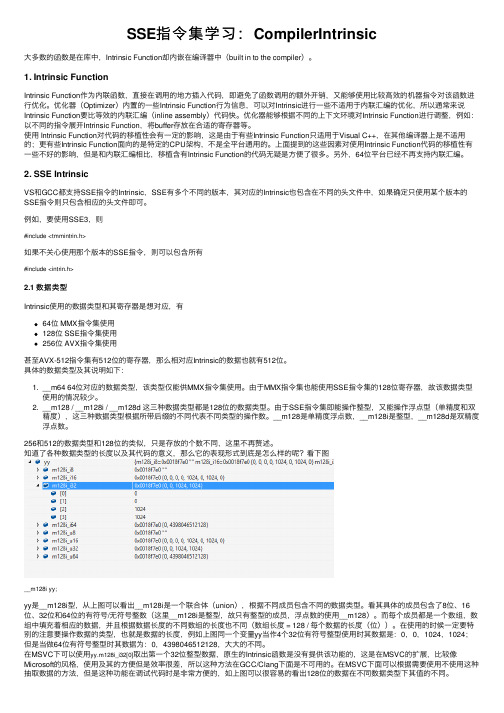

例如,要使⽤SSE3,则#include <tmmintrin.h>如果不关⼼使⽤那个版本的SSE指令,则可以包含所有#include <intrin.h>2.1 数据类型Intrinsic使⽤的数据类型和其寄存器是想对应,有64位 MMX指令集使⽤128位 SSE指令集使⽤256位 AVX指令集使⽤甚⾄AVX-512指令集有512位的寄存器,那么相对应Intrinsic的数据也就有512位。

scfde频偏估计ml算法matlab -回复

scfde频偏估计ml算法matlab -回复SC-FDE频偏估计ML算法(Matlab)频偏(frequency offset)是无线通信中常见的问题之一,它可以由多种因素引起,例如传输路径中的多径传播、时钟不精确等。

频偏会导致接收信号中的符号偏移,从而降低通信系统的性能。

因此,准确估计和补偿频偏是无线通信系统中的重要任务之一。

在本文中,我们将介绍一种基于最大似然(ML)算法的频偏估计方法,使用Matlab来进行实现。

1. 理论背景在单载波频分复用(SC-FDMA)系统中,采用了频域等效信道来简化多径传播的影响,但频偏仍然需要进行准确估计和补偿。

频偏可以通过计算接收信号中各个子载波的相位差来进行估计。

最大似然(ML)算法是一种常用的频偏估计方法,通过最大化接收数据的似然函数来估计频偏值。

2. 算法步骤(1) 生成发送信号:首先,生成长度为L的发送信号x,并将其通过带通信道进行传输。

我们可以使用Matlab中的randn函数生成高斯随机序列作为发送信号。

(2) 添加频偏:在接收端,通过向发送信号加入频偏来模拟实际通信环境。

在频域中,我们可以通过对发送信号进行快速傅里叶变换(FFT)来得到频域信号,然后对频域信号的每个子载波都加上相应的相移。

(3) 接收信号处理:接收到带有频偏的信号后,我们需要对信号进行处理,以便实施频偏估计算法。

具体来说,我们需要对接收信号进行快速傅里叶变换(FFT)来得到频域信号,然后对每个子载波的信号进行相位检测。

(4) 频偏估计:在已获得每个子载波的相位差后,我们可以使用最大似然(ML)算法来估计频偏值。

最大似然估计的基本思想是找到使接收数据的似然函数最大化的频偏值。

我们可以使用Matlab中的优化工具箱来实现此步骤,具体来说,可以使用"lsqnonlin"函数来求解最大似然问题。

(5) 频偏补偿:基于估计得到的频偏值,我们可以对接收信号进行相应的频偏补偿。

优化问题的Matlab求解方法

优化问题的Matlab求解方法引言优化问题在实际生活中有着广泛应用,可以用来解决很多实际问题。

Matlab作为一款强大的数学计算软件,提供了多种求解优化问题的方法。

本文将介绍在Matlab中求解优化问题的常见方法,并比较它们的优缺点。

一、无约束无约束优化问题是指没有约束条件的优化问题,即只需要考虑目标函数的最大或最小值。

在Matlab中,可以使用fminunc函数来求解无约束优化问题。

该函数使用的是拟牛顿法(quasi-Newton method),可以迭代地逼近最优解。

拟牛顿法是一种迭代方法,通过逐步近似目标函数的梯度和Hessian矩阵来求解最优解。

在使用fminunc函数时,需要提供目标函数和初始点,并可以设置其他参数,如迭代次数、容差等。

通过不断迭代,拟牛顿法可以逐步逼近最优解。

二、有约束有约束优化问题是指在优化问题中加入了约束条件。

对于有约束优化问题,Matlab提供了多种求解方法,包括线性规划、二次规划、非线性规划等。

1. 线性规划线性规划是指目标函数和约束条件都为线性的优化问题。

在Matlab中,可以使用linprog函数来求解线性规划问题。

该函数使用的是单纯形法(simplex method),通过不断迭代来逼近最优解。

linprog函数需要提供目标函数的系数矩阵、不等式约束矩阵和约束条件的右手边向量。

通过调整这些参数,可以得到线性规划问题的最优解。

2. 二次规划二次规划是指目标函数为二次型,约束条件线性的优化问题。

在Matlab中,可以使用quadprog函数来求解二次规划问题。

该函数使用的是求解二次规划问题的内点法(interior-point method),通过迭代来求解最优解。

quadprog函数需要提供目标函数的二次项系数矩阵、线性项系数矩阵、不等式约束矩阵和约束条件的右手边向量。

通过调整这些参数,可以得到二次规划问题的最优解。

3. 非线性规划非线性规划是指目标函数或者约束条件中至少有一个是非线性的优化问题。

sisnr损失函数实现

SISNR 损失函数是一种用于训练深度神经网络的新型损失函数,它可以有效地提高网络性能。

它是由Google Brain在2018年开发的,它可以有效地减少对图像语义信息的丢失,从而提高模型的分类精度。

SISNR 损失函数是一种基于语义信息的损失函数,它可以有效地减少神经网络对输入图像的语义信息的丢失。

它利用信噪比(Signal-to-Noise Ratio,SNR)的原理,根据输入图像的语义信息,计算出一个标准化的损失函数,从而使得模型能够更好地捕捉输入图像中语义信息的细微变化。

SISNR 损失函数的具体实现需要借助于另外的技术,比如卷积神经网络(Convolutional Neural Network)和深度残差网络(Deep Residual Network)等。

首先,

将输入图像通过一个卷积神经网络来提取特征,然后将这些特征送入深度残差网络,以计

算出图像的语义信息,最后,根据计算出的信噪比,得到SISNR 损失函数,从而提高模型

的分类精度。

总之,SISNR 损失函数是一种有效的损失函数,它可以有效减少图像语义信息的丢失,从而提高模型的分类精度。

它的实现需要借助于卷积神经网络和深度残差网络,通过计算图像的信噪比,得到SISNR 损失函数,从而实现模型的分类性能的提升。

函数优化测试函数

xi ≤ 2

其最优状态和最优值为

min( f ( X * )) = f (0,−1) = 3

智能优化计算

现代优化2012

1.2 最优化问题及其分类

1.2.1 函数优化问题 测试函数 (19)Hartman’s Function

⎤ ⎡ 3 2 f ( X ) = −∑ ci exp ⎢− ∑ aij ( x j − pij ) ⎥, i =1 ⎦ ⎣ j =1

2 f ( X ) = [1 + ( x1 + x2 + 1) 2 (19 − 14 x1 + 3 x12 − 14 x2 + 6 x1 x2 + 3 x2 )] 2 × [30 + (2 x1 − 3 x2 ) 2 (18 − 32 x1 + 12 x12 + 48 x2 − 36 x1 x2 + 27 x2 )],

其最优状态和最优值为

min( f ( X * )) ≈ f (0.1928,0.1928,0.1231,0.1358) ≈ 0.0003075

智能优化计算

现代优化2012

1.2 最优化问题及其分类

1.2.1 函数优化问题 测试函数 其中,

( ai ) = (0.1957,0.1947,0.1735,0.16,0.0844,0.0627,0.0456,0.0342, 0.0323,0.0235,0.0246) (1 / bi ) = (0.25,0.5,1,2,4,6,8,10,12,14,16)

智能优化计算

现代优化2012

1.2 最优化问题及其分类

1.2.1 函数优化问题 测试函数 (5)Generalized Rosenbrock’s Function

SIMD指令学习笔记

SIMD指令学习笔记SIMD发展所谓的SIMD指令,指的是single instruction multiple data,即单指令多数据运算,其⽬的就在于帮助CPU实现数据并⾏,提⾼运算效率。

MMXMMX是由57条指令组成的SIMD多媒体指令集,MMX将64位寄存当作2个32位或8个8位寄存器来⽤,只能处理整形计算,这样的64位寄存器有8组,分别命名为MM0~MM7.这些寄存器不是为MMX单独设置的,⽽是借⽤的FPU的寄存器,占⽤浮点寄存器进⾏运算(64位MMX寄存器实际上就是浮点数寄存器的别名),以⾄于MMX指令和浮点数操作不能同时⼯作。

为了减少在MMX和浮点数模式切换之间所消耗的时间,程序员们尽可能减少模式切换的次数,也就是说,这两种操作在应⽤上是互斥的。

SSESSE全称是Streaming SIMD Extensions,是⼀种在MMX基础上发展出来的SIMD指令集,其不再占⽤浮点寄存器,⽽是使⽤单独的128位XMM寄存器。

在此基础上⼜发展除了SSE2/SSE3/SSE4指令集。

SSE2则进⼀步⽀持双精度浮点数,由于寄存器长度没有变长,所以只能⽀持2个双精度浮点计算或是4个单精度浮点计算,另外,它在这组寄存器上实现了整型计算,从⽽代替了MMX。

SSE3⽀持⼀些更加复杂的算术计算。

SSE4增加了更多指令,并且在数据搬移上下了⼀番⼯夫,⽀持不对齐的数据搬移,增加了supershuffle引擎等。

AVX在SSE指令集的基础上将128位的XMM寄存器扩展为长度为256位的YMM寄存器,使其⽀持256位的⽮量计算,并且AVX全⾯兼容SSE/SSE2/SSE3/SSE4,也就是YMM寄存器的低128位就是XMM寄存器。

3DNow!3DNow!是对于Intel MMX寄存器的逻辑拓展,MMX仅提供了并⾏的整数操作,3DNow!实现了并⾏浮点操作。

3DNow!在现有MMX指令集基础上拓展可以做到混合操作整数代码和浮点代码,同时不需要MMX必须的上下⽂转换。

Intel平台编程总结----SIMD技术

Intel平台编程总结----SIMD技术SIMD是指单指令多数据技术,它已经成为Intel处理器的重要性能扩展。

⽬前Intel处理器⽀持的SIMD技术包括MMX,SSE,AVX.MMX提供了8个64bit的寄存器进⾏SIMD操作,SSE系列提供了128bit的8个寄存器进⾏SIMD指令操作。

⽽最新的AVX指令则⽀持256bit的SIMD操作。

⽬前SIMD指令可以有四种⽅法进⾏使⽤分别是汇编语⾔,C++类,编译器Intrisincs和⾃动⽮量化。

我们⽤下⾯的求⼀个整数数组的和作为例⼦:intSumAarray(intbuf,intN){inti,sum=0;for(i=0;i//MMX#include//SSE(alsoincludeivec.h)#include//SSE2(alsoincludefvec.h)这些⽀持SIMD的向量类型采取下⾯的命名规则:前⾯⽤I和F分别表⽰是⽀持浮点还是整数SIMD指令,接下来是数字取值为8,16,32,64,表⽰组向量的基本元素⼤⼩。

然后后⾯为字符串vec,最后的数组取值为8,4,2,1,表⽰组成向量的基本元素的个数。

使⽤64bit的MMX技术的整数类包括I64vec1,I32vec2,I16vec4和I8vec8,⽽使⽤128bit的XMM寄存器的浮点类则包括F32vec4,F32vec1,F64vec2。

SSE2中使⽤128bit的XMM寄存器,整数类包括:I128vec1,I64vec2,I32vec4,I16vec8,I8vec16,为了进⼀步区分封装的是有符号整数还是⽆符号整数,在那些整数之后也可以包含⼀个符号标志s或者u,⽐如I?vec4.通过类的封装,程序员⽆须关⼼那些对于类的运算到底使⽤了哪些汇编指令或者SIMDintrinsic函数,应⽤易于阅读和编码,并且没有直接使⽤SIMD代码,在不同的处理器之间不需要任何改动,但是其缺点是⽆法访问所有的指令和数据类型的组合。

在CC++代码中使用SSE等指令集的指令(1)介绍

在C/C++代码中使用SSE等指令集的指令(1)介绍转自/gengshenghong/article/details/7007100#我们知道,在C/C++代码中,可以插入汇编代码提高性能。

现在的指令集有了很多的高级指令,如果我们希望使用这些高级指令来实现一些高效的算法,就可以在代码中嵌入汇编,使用SSE等高级指令,这是可行的,但是如果对汇编不太熟悉,不愿意使用汇编的人来说,其实也是可以的,这就是Compiler Intrinsics(/zh-cn/site/26td21ds)。

PS:下面的内容以Windows平台为主,对于Linux下,也有类似的方法。

(1)什么是IntrinsicsIntrinsics是对MMX、SSE等指令集的指令的一种封装,以函数的形式提供,使得程序员更容易编写和使用这些高级指令,在编译的时候,这些函数会被内联为汇编,不会产生函数调用的开销。

在理解intrinsics指令之前,先理解intrinsics函数。

(3)#pragma intrinsic和#pragma function#pragma intrinsic(function[,function][,function]...):表示后面的函数将进行intrinsic,替换为内部函数,去掉了函数调用的开销,注意:有些地方解释为内联,但是和内联并不完全相同,对于内联,可以指定任意函数为内联,但是此pragma intrinsic 只能适用于编译器规定的一部分函数,不是所有函数都能使用,而且,inline关键字一般用于指定自定义的函数,intrinsic则是系统库函数的一部分。

参考/zh-cn/library/tzkfha43.aspx获取详细的说明。

下面分析这个例子:1.#include <math.h>2.void foo()3.{4.double var = cos(10);5.}使用VS2010的32bit的command line编译:cl /c test.c /FA输出得到其汇编文件:1.; Listing generated by Microsoft (R) Optimizing Compiler Version 16.00.30319.012.3. TITLE C:\tempLab\test.c4. .686P5. .XMM6. include listing.inc7. .model flat9.INCLUDELIB LIBCMT10.INCLUDELIB OLDNAMES11.12.PUBLIC __real@402400000000000013.PUBLIC _foo14.EXTRN _cos:PROC15.EXTRN __fltused:DWORD16.; COMDAT __real@402400000000000017.; File c:\templab\test.c18.CONST SEGMENT19.__real@4024000000000000 DQ 04024000000000000r ; 1020.; Function compile flags: /Odtp21.CONST ENDS22._TEXT SEGMENT23._var$ = -8 ; size = 824._foo PROC25.; Line 326. push ebp27. mov ebp, esp28. sub esp, 829.; Line 430. sub esp, 831. fld QWORD PTR __real@402400000000000032. fstp QWORD PTR [esp]33. call _cos34. add esp, 835. fstp QWORD PTR _var$[ebp]36.; Line 537. mov esp, ebp38. pop ebp39. ret 040._foo ENDP41._TEXT ENDS42.END可以看到,这里调用了call_cos函数进行运算,下面代码修改如下:1.#include <math.h>2.#pragma intrinsic(cos)3.void foo()4.{5.double var = cos(10);同样的命令编译,得到汇编如下:1.; Listing generated by Microsoft (R) Optimizing Compiler Version 16.00.30319.012.3. TITLE C:\tempLab\test.c4. .686P5. .XMM6. include listing.inc7. .model flat8.9.INCLUDELIB LIBCMT10.INCLUDELIB OLDNAMES11.12.PUBLIC __real@402400000000000013.PUBLIC _foo14.EXTRN __fltused:DWORD15.EXTRN __CIcos:PROC16.; COMDAT __real@402400000000000017.; File c:\templab\test.c18.CONST SEGMENT19.__real@4024000000000000 DQ 04024000000000000r ; 1020.; Function compile flags: /Odtp21.CONST ENDS22._TEXT SEGMENT23._var$ = -8 ; size = 824._foo PROC25.; Line 426. push ebp27. mov ebp, esp28. sub esp, 829.; Line 530. fld QWORD PTR __real@402400000000000031. call __CIcos32. fstp QWORD PTR _var$[ebp]33.; Line 634. mov esp, ebp35. pop ebp36. ret 037._foo ENDP38._TEXT ENDS39.END对比之后,它们的主要区别的代码段如下:1.sub esp, 82. fld QWORD PTR __real@40240000000000003.4. fstp QWORD PTR [esp]5. call _cos6. add esp, 81.fld QWORD PTR __real@40240000000000002.call __CIcos显然,使用了Intrinsics之后的cos函数的指令少了很多,其调用的内部函数是_CIcos(/zh-cn/library/ff770589.aspx),此函数会计算对栈顶的元素直接进行cos运算,所以节省了很多函数调用参数传递等的指令。

matlab 中的优化算法

matlab 中的优化算法MATLAB提供了多种优化算法和技术,用于解决各种不同类型的优化问题。

以下是一些在MATLAB中常用的优化算法:1.梯度下降法:梯度下降法是一种迭代方法,用于找到一个函数的局部最小值。

在MATLAB中,可以使用fminunc函数实现无约束问题的梯度下降优化。

2.牛顿法:牛顿法是一种求解无约束非线性优化问题的算法,它利用泰勒级数的前几项来近似函数。

在MATLAB中,可以使用fminunc 函数实现无约束问题的牛顿优化。

3.约束优化:MATLAB提供了多种约束优化算法,如线性规划、二次规划、非线性规划等。

可以使用fmincon函数来实现带约束的优化问题。

4.最小二乘法:最小二乘法是一种数学优化技术,用于找到一组数据的最佳拟合直线或曲线。

在MATLAB中,可以使用polyfit、lsqcurvefit等函数实现最小二乘法。

5.遗传算法:遗传算法是一种模拟自然选择过程的优化算法,用于求解复杂的优化问题。

在MATLAB中,可以使用ga函数实现遗传算法优化。

6.模拟退火算法:模拟退火算法是一种概率搜索算法,用于在可能的解空间中找到全局最优解。

在MATLAB中,可以使用fminsearchbnd函数实现模拟退火算法优化。

7.粒子群优化算法:粒子群优化算法是一种基于群体智能的优化算法,用于求解非线性优化问题。

在MATLAB中,可以使用particleswarm函数实现粒子群优化算法。

以上是MATLAB中常用的一些优化算法和技术。

具体的实现方法和应用可以根据具体问题的不同而有所不同。

Matlab中的音频特征提取技术详解

Matlab中的音频特征提取技术详解在音频处理和音乐信息检索等领域,音频特征提取是一个重要的技术环节。

Matlab作为一款功能强大的科学计算软件,在音频特征提取方面提供了丰富的工具和函数。

本文将详细介绍Matlab中的音频特征提取技术,并探讨其在实际应用中的价值和局限性。

一、音频特征提取的概述音频特征提取是指从音频信号中提取出具有表征性质的特征,用于描述音频的不同方面。

这些特征可以是时域特征、频域特征或时频域特征等。

常见的音频特征包括音频能量、频谱特征、声调特征、音调特征、过零率等。

这些特征对于音频信号的分析、分类和识别等任务至关重要。

二、Matlab中的音频特征提取函数Matlab提供了一系列用于音频特征提取的函数和工具箱。

其中最常用的是信号处理工具箱(Signal Processing Toolbox)和音频系统工具箱(Audio System Toolbox)。

以下是几个常用的音频特征提取函数的介绍:1. 频谱特征提取函数:spectrogramspectrogram函数可以将音频信号转换成时频图,从而展示音频的频谱特征。

它将音频信号分成多个时间窗口,并对每个窗口进行傅里叶变换得到频谱图。

通过调整窗口大小和窗口函数,可以获得不同时间分辨率和频率分辨率的频谱图,进而提取出不同的频谱特征。

2. 过零率特征提取函数:zerocross过零率是指音频信号通过零轴的次数,它反映了音频信号的变化速度和频率。

通过zerocross函数可以计算出音频信号的过零率特征。

这个函数会对音频信号进行快速傅里叶变换(FFT),然后计算变换结果的零交叉次数。

过零率通常用于语音识别和音乐节奏分析等任务中。

3. 音频能量特征提取函数:envelope音频信号的能量反映了音频的响度和音量大小。

envelope函数可以计算出音频信号的包络曲线,从而获取音频的能量特征。

它通过将音频信号分段,计算每个段落的均方根(RMS),然后将均方根进行平滑处理,得到音频的能量包络曲线。

Intrinsics函数总结

函数前缀(典型) _mm _mm _mm _mm _mm _mm _mm

_mm256 _mm256 _mm512

函数举例 _mm_add_pi16 (__m64 a, __m64 b) _mm_add_ps (__m128 a, __m128 b) _mm_add_epi16 (__m128i a, __m128i b) _mm_addsub_pd (__m128d a, __m128d b) _mm_abs_pi16 (__m64 a) _mm_ceil_ps (__m128 a) _mm_cmpgt_epi64 (__m128i a, __m128i b) _mm256_and_ps (__m256 a, __m256 b) _mm256_abs_epi16 (__m256i a) _mm512_set1_epi32 (int a)

常用的AVX Intrinsic函数举例

• _mm256_i32gather_pd 测试:

• 输出: • •

•

备注:scale:每步偏移的字节数 vindex:每个元素代表每次移动的步数 ipt:内存区域源指针 (内存的物理地址=基地址ipt+(scale*vindex)字节数)

常用的AVX Intrinsic函数举例

•

m2=_mm512_load_pd(ipt_2);//loading from memory

•

movValue=_mm512_mask_mov_pd(m1,mask,m2);

• 输出: if mask=-127 (1000 0001) movValue={3.1400000000000001, 1, 2, 3, 4, 5, 6, 3.1400000000000001}

• _mm256_store_pd 测试:

SSE自动向量化用户手册

使用并行化:向量化向量化概述向量优化单元(vectorizer)是Intel编译器中用来生成SIMD指令的,它会用到MMX™, Intel® Streaming SIMD 扩展 (Intel® SSE, SSE2, SSE3 and SSE4) 和附加Streaming SIMD 扩展 (SSSE3)等指令集. 向量优化单元检测到程序中可以被并行的操作后,就根据数据类型,转化成一系列的操作,例如一条可以同时并行处理2、4、8,最多16个元素的SIMD指令。

自动向量化支持IA-32和Intel® 64 架构。

本章将讨论如下内容:∙较高层面地讨论用来控制和影响向量化的编译器选项∙C++语言中控制向量化的功能说明∙向量化程度的讨论和一般原则:∙自动向量化∙用户介入的向量化(也称作自动向量化提示)∙演示典型的向量化问题,和对应解决方法的范例程序Intel编译器支持许多种类的自动向量化提示和用户指定的编译指示(pragma/directive),它们可以帮助编译器有效地生成向量指令。

参考“The Software Vectorization Handbook. Applying Multimedia Extensions for Maximum Performance, A.J.C. Bik. Intel Press, June, 2004”, 可以得到如何使用Intel®编译器向量化代码的详细讨论。

向量化选项快速索引如下选项支持IA-32和Intel® 64架构 .Linux* OS and Mac OS* X Windows*OS 说明-x /Qx 生成特定的二进制代码,只能运行在被扩展名指定的处理器上.查看Targeting IA-32 and Intel® 64 ArchitectureProcessors Automatically获得更多关于使用此选项的信息。

多峰连续函数优化的一种混合算法

多峰连续函数优化的一种混合算法

1 关于多峰连续函数优化的混合算法

多峰连续函数优化的混合算法是一种混合多峰优化算法,它使用

另外多种类型的优化方法求解多峰连续优化问题,来获得更好的优化

效果。

这种混合算法包含普通的梯度算法、贝叶斯优化算法、分数限

定规划(Fractional Programming,FP)、多峰算法和普通连续模糊

算法(Generalized Continuous Fuzzy Algorithm,GCFA)。

此外,

多峰算法及其变体是现在主要用于多峰优化的两个最重要的算法。

2 混合算法的优点

多峰连续函数优化的混合算法由于能够集成多种优化方法,因此

它优于其他单一算法,具有更强的准确性、鲁棒性、优化效率等优势。

除此之外,还具有容错能力强的特点,可以忽略异常的数据,并只关

注有效的数据,从而有效地避免由于数据集造成的运行错误。

此外,

混合算法还具有快速求解的优势,不需要额外的复杂的微调运算,可

以快速自动地求解多峰连续优化问题。

3 混合算法的应用

鉴于多峰连续函数优化的混合算法优点较多,因此它在优化技术

中也得到了广泛应用。

例如可以用混合算法来求解经济系统模型的优

化问题,还可以用它来解决智能汽车路径的优化问题,用来求解波形

分析的数字滤波问题,尤其是智能网络和电力系统装备部署优化问题,其各种优化效果显著。

总之,多峰连续函数优化的混合算法是一种可以有效提升优化效果的方法,但其使用也会带来一定的风险,值得谨慎考虑。

再中心化影响函数回归代码

再中心化影响函数回归代码1.引言1.1 概述概述再中心化影响函数回归代码是一种统计分析方法,用于解决回归分析中存在的问题。

在传统的回归分析中,我们通常假设数据的误差项服从正态分布,并且数据点之间是独立的。

然而,在实际应用中,数据点往往存在一定的相关性,同时误差项可能不满足正态分布的假设。

这些问题会给传统回归分析的结果产生不可忽视的影响。

再中心化影响函数回归代码通过引入影响函数的概念,对回归分析进行了改进。

影响函数是衡量变量对回归模型参数的影响程度的函数。

再中心化影响函数回归代码不仅考虑了数据点的相关性问题,还能够处理误差项不满足正态分布的情况。

它是一种非参数方法,不需要对数据的分布做出假设,从而提高了回归分析的灵活性和准确性。

本文将介绍再中心化影响函数回归代码的原理和应用。

首先,我们将详细解释再中心化影响函数回归代码的基本原理和算法流程。

然后,我们将通过具体案例来说明再中心化影响函数回归代码在实际问题中的应用。

通过这些实证研究的结果,我们将评估再中心化影响函数回归代码在解决复杂问题中的优势和效果。

本文的目的旨在向读者介绍再中心化影响函数回归代码的基本原理和应用,并探讨其在实践中的潜力和发展方向。

通过深入理解再中心化影响函数回归代码,读者将能够更加灵活地应用统计学工具解决实际问题,并在相关领域取得更好的研究成果。

1.2文章结构文章结构是指文章的章节安排和组织结构。

一个良好的文章结构能够使读者更加清晰地理解文章的内容和逻辑关系。

在本文中,我们将按照以下结构来组织和呈现我们的观点和信息:1. 引言1.1 概述在这一部分,我们将简要介绍再中心化影响函数回归代码的背景和意义,以引起读者的兴趣并让他们对本文感到好奇。

1.2 文章结构在这一部分,我们将概述整篇文章的结构,并简要解释每个章节的内容和目的。

通过这样的介绍,读者能够更好地理解文章的整体框架,并预先了解到将要涉及的主题。

1.3 目的在这一部分,我们将明确我们撰写本文的目的和目标。

损失函数超参数调试方法

损失函数超参数调试方法

调试损失函数的超参数是优化模型性能的重要步骤。

损失函数的超参数包括学习率、正则化参数、优化器类型等。

以下是一些常见的方法来调试损失函数的超参数:

1. 网格搜索,网格搜索是一种常见的超参数调试方法,它通过遍历给定的超参数组合来寻找最佳的超参数组合。

这种方法的缺点是计算成本高,特别是在超参数空间较大的情况下。

2. 随机搜索,与网格搜索相比,随机搜索在超参数空间中随机采样,这样可以更快地找到较好的超参数组合。

随机搜索的优点在于它可以在有限的计算资源下找到较好的超参数组合。

3. 贝叶斯优化,贝叶斯优化是一种基于贝叶斯方法的序列模型优化方法,它通过构建超参数与性能之间的概率模型来选择下一个要尝试的超参数组合。

这种方法在高维超参数空间中表现良好。

4. 自适应优化,一些优化器(如Adam)具有自适应学习率的特性,可以根据损失函数的表现自动调整学习率。

这种方法可以减少手动调试超参数的工作量。

5. 交叉验证,交叉验证是评估模型性能和选择超参数的重要工具。

通过将数据集分成训练集和验证集,可以在不同超参数下比较

模型的性能,从而选择最佳的超参数组合。

总的来说,调试损失函数的超参数是一个复杂而耗时的过程,

需要结合实际问题和计算资源来选择合适的调试方法。

同时,需要

注意避免过拟合和欠拟合,以及了解不同超参数对模型性能的影响,才能找到最佳的超参数组合。

SSE图像算法优化系列十七:多个图像处理中常用函数的SSE实现。

SSE图像算法优化系列⼗七:多个图像处理中常⽤函数的SSE实现。

在做图像处理的SSE优化时,也会经常遇到⼀些⼩的过程、数值优化等代码,本⽂分享⼀些个⼈收藏或实现的代码⽚段给⼤家。

⼀、快速求对数运算 对数运算在图像处理中也是个经常会遇到的过程,特备是在⼀些数据压缩和空间转换时常常会⽤到,⽽且是个⽐较耗时的函数,标准的SSE库⾥并没有提供该函数的实现,如果需要⾼精度的SSE版本,⽹络上已经有了,参考:,这个的精度和标准库的精度基本⼀致了,稍作整理后的代码如下:// 对数函数的SSE实现,⾼精度版inline __m128 _mm_log_ps(__m128 x){static const __declspec(align(16)) int _ps_min_norm_pos[4] = { 0x00800000, 0x00800000, 0x00800000, 0x00800000 };static const __declspec(align(16)) int _ps_inv_mant_mask[4] = { ~0x7f800000, ~0x7f800000, ~0x7f800000, ~0x7f800000 };static const __declspec(align(16)) int _pi32_0x7f[4] = { 0x7f, 0x7f, 0x7f, 0x7f };static const __declspec(align(16)) float _ps_1[4] = { 1.0f, 1.0f, 1.0f, 1.0f };static const __declspec(align(16)) float _ps_0p5[4] = { 0.5f, 0.5f, 0.5f, 0.5f };static const __declspec(align(16)) float _ps_sqrthf[4] = { 0.707106781186547524f, 0.707106781186547524f, 0.707106781186547524f, 0.707106781186547524f };static const __declspec(align(16)) float _ps_log_p0[4] = { 7.0376836292E-2f, 7.0376836292E-2f, 7.0376836292E-2f, 7.0376836292E-2f };static const __declspec(align(16)) float _ps_log_p1[4] = { -1.1514610310E-1f, -1.1514610310E-1f, -1.1514610310E-1f, -1.1514610310E-1f };static const __declspec(align(16)) float _ps_log_p2[4] = { 1.1676998740E-1f, 1.1676998740E-1f, 1.1676998740E-1f, 1.1676998740E-1f };static const __declspec(align(16)) float _ps_log_p3[4] = { -1.2420140846E-1f, -1.2420140846E-1f, -1.2420140846E-1f, -1.2420140846E-1f };static const __declspec(align(16)) float _ps_log_p4[4] = { 1.4249322787E-1f, 1.4249322787E-1f, 1.4249322787E-1f, 1.4249322787E-1f };static const __declspec(align(16)) float _ps_log_p5[4] = { -1.6668057665E-1f, -1.6668057665E-1f, -1.6668057665E-1f, -1.6668057665E-1f };static const __declspec(align(16)) float _ps_log_p6[4] = { 2.0000714765E-1f, 2.0000714765E-1f, 2.0000714765E-1f, 2.0000714765E-1f };static const __declspec(align(16)) float _ps_log_p7[4] = { -2.4999993993E-1f, -2.4999993993E-1f, -2.4999993993E-1f, -2.4999993993E-1f };static const __declspec(align(16)) float _ps_log_p8[4] = { 3.3333331174E-1f, 3.3333331174E-1f, 3.3333331174E-1f, 3.3333331174E-1f };static const __declspec(align(16)) float _ps_log_q1[4] = { -2.12194440e-4f, -2.12194440e-4f, -2.12194440e-4f, -2.12194440e-4f };static const __declspec(align(16)) float _ps_log_q2[4] = { 0.693359375f, 0.693359375f, 0.693359375f, 0.693359375f };__m128 one = *(__m128*)_ps_1;__m128 invalid_mask = _mm_cmple_ps(x, _mm_setzero_ps());/* cut off denormalized stuff */x = _mm_max_ps(x, *(__m128*)_ps_min_norm_pos);__m128i emm0 = _mm_srli_epi32(_mm_castps_si128(x), 23);/* keep only the fractional part */x = _mm_and_ps(x, *(__m128*)_ps_inv_mant_mask);x = _mm_or_ps(x, _mm_set1_ps(0.5f));emm0 = _mm_sub_epi32(emm0, *(__m128i *)_pi32_0x7f);__m128 e = _mm_cvtepi32_ps(emm0);e = _mm_add_ps(e, one);__m128 mask = _mm_cmplt_ps(x, *(__m128*)_ps_sqrthf);__m128 tmp = _mm_and_ps(x, mask);x = _mm_sub_ps(x, one);e = _mm_sub_ps(e, _mm_and_ps(one, mask));x = _mm_add_ps(x, tmp);__m128 z = _mm_mul_ps(x, x);__m128 y = *(__m128*)_ps_log_p0;y = _mm_mul_ps(y, x);y = _mm_add_ps(y, *(__m128*)_ps_log_p1);y = _mm_mul_ps(y, x);y = _mm_add_ps(y, *(__m128*)_ps_log_p2);y = _mm_mul_ps(y, x);y = _mm_add_ps(y, *(__m128*)_ps_log_p3);y = _mm_mul_ps(y, x);y = _mm_add_ps(y, *(__m128*)_ps_log_p4);y = _mm_mul_ps(y, x);y = _mm_add_ps(y, *(__m128*)_ps_log_p5);y = _mm_mul_ps(y, x);y = _mm_add_ps(y, *(__m128*)_ps_log_p6);y = _mm_mul_ps(y, x);y = _mm_add_ps(y, *(__m128*)_ps_log_p7);y = _mm_mul_ps(y, x);y = _mm_add_ps(y, *(__m128*)_ps_log_p8);y = _mm_mul_ps(y, x);y = _mm_mul_ps(y, z);tmp = _mm_mul_ps(e, *(__m128*)_ps_log_q1);y = _mm_add_ps(y, tmp);tmp = _mm_mul_ps(z, *(__m128*)_ps_0p5);y = _mm_sub_ps(y, tmp);tmp = _mm_mul_ps(e, *(__m128*)_ps_log_q2);x = _mm_add_ps(x, y);x = _mm_add_ps(x, tmp);x = _mm_or_ps(x, invalid_mask); // negative arg will be NANreturn x;} 看上去有⼀⼤堆代码,不过实测这个的速度越是标准库(本⽂是指启动增强指令集选项设置为:未设置,设计上编译器在此种情况下会⾃动设置为SSE2增强,这可以从反编译logf函数看到,因此,这⾥的速度⽐较还不是和纯Fpu实现的⽐较)的2倍,如果稍微降低点精度,⽐如_ps_log_p5到_ps_log_p8之间的代码,还能提⾼点速度。

sse 中值滤波

sse 中值滤波SSE中值滤波中值滤波是一种常用的信号处理方法,常用于图像处理领域,用于去除图像中的噪声。

在SSE(Streaming SIMD Extensions)中,也可以利用向量运算的特性来进行中值滤波,提高处理效率。

中值滤波的原理是通过对像素周围的邻域进行排序,然后选取中间值作为该像素的新值。

在传统的中值滤波方法中,对于每个像素点,需要遍历其邻域中的所有像素,并进行排序。

这种方法在处理大尺寸的图像时,效率较低。

而在SSE指令集中,可以利用向量寄存器的并行计算能力,将多个像素同时处理,提高了处理效率。

在使用SSE进行中值滤波时,可以将图像数据按照向量的方式进行加载,然后通过SSE指令进行向量运算。

具体步骤如下:1. 将图像数据按照向量长度进行对齐,使得每次向量加载的数据是连续的。

2. 将加载的向量数据进行排序,可以使用冒泡排序、插入排序等方法。

3. 选取排序后的中间值作为像素的新值。

4. 将结果保存到输出图像中。

在进行SSE中值滤波时,需要注意以下几点:1. 图像数据的边界处理:由于中值滤波需要对像素的邻域进行排序,因此在图像的边界处,需要对边界像素进行特殊处理。

可以采用镜像填充、边界复制等方法来处理边界问题。

2. 向量长度的选择:在使用SSE指令进行向量运算时,向量长度需要根据具体的处理器架构来选择,以充分利用CPU的计算能力。

一般来说,SSE2指令集支持128位的向量运算,SSE4指令集支持更长的256位向量运算。

3. 算法的优化:中值滤波是一个计算密集型的任务,通过合理选择算法和优化代码,可以进一步提高处理效率。

例如,可以使用快速排序算法或者局部排序算法来减少排序的时间复杂度。

总结起来,SSE中值滤波是一种利用SSE指令集进行图像处理的方法。

通过充分利用向量运算的特性,可以提高中值滤波的处理效率。

在实际应用中,可以根据具体的需求和硬件平台选择合适的向量长度和优化算法,以达到更好的效果。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

推荐函数定义:void SSE_Add(float* srcA, float* srcB, float* dest, int M) {}

编程实现:

// SSE.cpp : 定义控制台应用程序的入口点。

//

#include "stdafx.h"

#include <xmmintrin.h>

b = _mm_set_ps(0, 0, srcB[i+1], srcB[i]);

c = _mm_set_ps(0, 0, 0, 0);

c = _mm_add_ps(a, b);

dest[i+1] = c.m128_f32[1];

dest[i+3] = c.m128_f32[3];

dest[i+2] = c.m128_f32[2];

dest[i+1] = c.m128_f32[1];

dest[i] = c.m128_f32[0];

}

dest[i] = c.m128_f32[0];

}

if(last == 1)

{

int i = 4*len;

a = _mm_set_ps(0, 0, 0, srcA[i]);

b = _mm_set_ps(0, 0, 0, srcB[i]);

speedup = 0;

else

speedup = duration/duration1;

cout<<"优化后"<<"用时"<<duration1<<"ms"<<"速度提高"<<speedup<<"倍"<<endl;

double calcRunTime;

/*

SSE_Add(srcA,srcB,dest,len);

for(int i=0;i<len;i++)

cout<<setw(7)<<dest[i]<<endl;

*/

for(int m =0 ;m<3;m++)

b = _mm_set_ps(srcB[i+3], srcB[i+2], srcB[i+1], srcB[i]);

c = _mm_set_ps(0, 0, 0, 0);

c = _mm_add_ps(a, b);

b = _mm_set_ps(0, srcB[i+2], srcB[i+1], srcB[i]);

c = _mm_set_ps(0, 0, 0, 0);

c = _mm_add_ps(a, b);

dest[i+2] = c.m128_f32[2];

{

for(int i=0;i<N;i++)

dest[i] = srcA[i] + srcB[i];

}

int main()

{

double len=100009;//len=100010;

double run_time;

cout<<"运行"<<calcRunTime<<"次加法:";

//优化前

GetLocalTime( &sys );

for(i=0;i<run_time;i++)

normal_Add(srcA,srcB,dest,len);

{

cout<<"第"<<m<<"次测试:"<<endl;

run_time = 10;

for(;run_time <1000000;run_time = run_time*10)

{

calcRunTime = len * run_time;

SSE intrinsic函数优化

分类: C/C++/VC编程 2010-04-06 19:20 467人阅读 评论(3) 收藏 举报

编写一个基于SSE多媒体指令集的快速矩阵加法运算函数,输入参数为两个单精度浮点型数组srcA与srcB,长度为N,输出结果保存在一个单精度浮点型数组dest中,假设srcA、srcB以及dest内存空间的首地址均按照16-byte对齐。请利用多媒体指令集获得最大的程序性能(可以使用Visual Studio中的SSE intrinsic函数)

dest[i+1] = c.m128_f32[1];

dest[i] = c.m128_f32[0];

}

if(last == 2)

{

int i = 4*len;

a = _mm_set_ps(0, 0, srcA[i+1], srcA[i]);

}

}

return 0;

}

int last = N-4*len;

//cout <<last<<endl;

if(last == 3)

{

int i = 4*len;

a = _mm_set_ps(0, srcA[i+2], srcA[i+1], srcA[i]);

GetLocalTime( &sys_end );

duration1 = sys_end.wHour*3600000+sys_end.wMinute*60000 + sys_end.wSecond*1000+sys_end.wMilliseconds

//优化后

GetLocalTime( &sys );

for(i=0;i<run_time;i++)

SSE_Add(srcA,srcB,dest,10000);

c = _mm_set_ps(0, 0, 0, 0);

c = _mm_add_ps(a, b);

dest[i] = c.m128_f32[0];

}

}

void normal_Add(float* srcA, float* srcB, float* dest, int N)

for( i=0;i<len;i++)

{

srcA[i] = (float)i;

srcB[i] = (float)i;

}

SYSTEMTIME sys;

SYSTEMTIME sys_end;

#include <iomanip>

#include <stdlib.h>

#include <time.h>

#include <windows.h>

#include<iostream>

using namespace std;

void SSE_Add(float* srcA, float* srcB, float* dest, int N)

{

பைடு நூலகம்

__m128 a, b, c;

int len = N/4;

for(int i=0;i<4*len;i=i+4)

{

a = _mm_set_ps(srcA[i+3], srcA[i+2], srcA[i+1], srcA[i]);

double duration,duration1;

float *srcA = new float[len];

float *srcB = new float[len];

float *dest = new float[len];

int i;

-(sys.wHour*3600000+sys.wMinute*60000 + sys.wSecond*1000+sys.wMilliseconds);

float speedup;

if(duration1 == 0)

GetLocalTime( &sys_end );

duration = sys_end.wHour*3600000+sys_end.wMinute*60000 + sys_end.wSecond*1000+sys_end.wMilliseconds

-(sys.wHour*3600000+sys.wMinute*60000 + sys.wSecond*1000+sys.wMilliseconds);

cout<<"优化前"<<"用时"<<duration<<"ms ";