一维凸函数牛顿法的全局收敛性及其应用

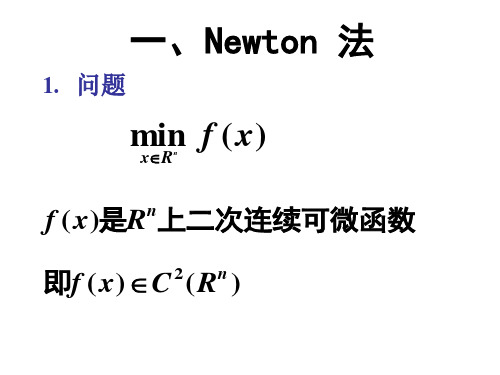

第二章 一维极小化方法-牛顿法

(2) 初始点的选取困难,甚至无法实施。 ) 初始点的选取困难,甚至无法实施。

(3)

−1 G k 的存在性和计算量问题

。

问题一: 问题一: 如何使得 f ( x k + 1 ) < f ( x k ) ?

法中, 在 Newton 法中,有

− x k +1 = x k − G k 1 g k = x k + d k

而

t k = 1。

3. 算法步骤

step 1. 给定初始点 x 0,精度 ε > 0 , k := 0

step2. 计算g k = ∇f ( x k )和G k = ∇ 2 f ( x k )

− 可逆时, 当 G k 可逆时, x k + 1 = x k − G k 1 g k 。

step3. 由方程组∇Q( x ) = g k + G k ( x − x k ) = 0 解出x k +1

− H k ≈ Gk1

↔

− 如何保证 H k > 0和 H k ≈ G k 1 ?

如何确定 ∆ H k ?

拟 Newton 条件

− 拟 Newton 条件 ↔ H k ≈ G k 1

分析: − 需满足的条件, G 分析: k 1 需满足的条件,并利用 此条件确定 H k 。

记 g ( x ) = ∇ f ( x ), g k = ∇ f ( x k ) G k = ∇ f 2 ( x k ), 则因为

f ( x ) ≈ f ( x k +1 ) + ∇f ( x k +1 )T ( x − x k +1 )

1 + ( x − x k +1 )T ∇ 2 f ( x K +1 )( x − x k +1 ) 2

凸优化与非线性规划

凸优化与非线性规划凸优化和非线性规划是数学领域中重要的优化问题研究方向。

它们在工程、经济学、计算机科学等领域中具有广泛的应用。

本文将介绍凸优化和非线性规划的基本概念、性质、求解方法以及应用场景。

一、凸优化1. 凸集与凸函数在凸优化中,凸集和凸函数是基本的概念。

凸集是指集合中的任意两点之间的连线上的所有点都属于该集合。

而凸函数是指定义域上的任意两点连线上的函数值都小于等于函数上其他点的函数值。

2. 凸优化问题凸优化问题是指在定义域上的凸函数的约束下,寻找使目标函数最小化(或最大化)的变量的取值。

通常的形式化描述是: min f(x)s.t. g_i(x) <= 0, i=1,...,mh_j(x) = 0, j=1,...,px ∈ X其中,f(x)是凸函数,g_i(x)是凸函数不等式约束,h_j(x)是等式约束,X是定义域。

3. 凸优化的性质凸优化具有以下重要性质:(1)局部最优解即为全局最优解:任何一个局部极小点都是全局极小点。

(2)凸优化问题的最优解是唯一的:只有一个点使得目标函数最小(最大)。

(3)约束最优化问题:在约束条件下寻找最优解。

当所有约束条件都是线性的时候,就是线性规划。

二、非线性规划1. 非线性规划问题非线性规划(Nonlinear Programming, NLP)是在定义域上的非线性函数的约束下,寻找使目标函数最小化(或最大化)的变量的取值。

通常的形式化描述为:min f(x)s.t. g_i(x) <= 0, i=1,...,mh_j(x) = 0, j=1,...,px ∈ X不同于凸优化,非线性规划问题中的目标函数和约束函数都可以是非线性的,定义域也可以是非凸的。

2. 非线性规划的求解方法非线性规划的求解方法有很多,包括梯度下降法、牛顿法、拟牛顿法等。

其中,拟牛顿法是非常常用且有效的算法之一。

拟牛顿法利用目标函数的一阶导数和二阶导数信息来近似求解最优解。

它通过迭代的方式逐步逼近最优解,直到满足一定的收敛条件。

凸优化课件

局部最优解和全局最优解

非线性凸优化问题可能存在多个局部最优解,需要研究如何找到全 局最优解或近似全局最优解。

大规模凸优化问题

计算复杂度

大规模凸优化问题的计算复杂度通常很高,需要采用高效的优化 算法。

并行计算和分布式计算

为了加速大规模凸优化问题的求解,可以采用并行计算和分布式计 算技术。

凸函数性质

凸函数具有单调性、有下界性、最小化性质等性质。在优化问题中,凸函数的最小值可 以通过优化方法求解。

凸集与凸函数的几何解释

凸集的几何解释

凸集可以用图形表示,例如二维平面上的一个凸集可以表示 为一个凸多边形。

凸函数的几何解释

对于凸函数,其图像是一个向上的曲线,且在该曲线上任意 两点之间画一条线,该线总是在函数图像之下。这意味着对 于凸函数,其最小值存在于其定义域的端点或边界上。

凸函数的性质

凸函数具有连续性、可微性、单调性 、凸性等性质,这些性质使得凸优化 问题在求解过程中具有一些特殊的优 势。

凸优化在数学与工程领域的应用

在数学领域的应用

凸优化在数学领域中广泛应用于最优化理论、统计推断、机器学习等领域。例 如,在机器学习中,凸优化方法可以用于求解支持向量机、神经网络等模型的 参数。

现状与挑战

目前,凸优化算法在理论和实际应用中都取得了很大的进展。然而,随着问题的复杂性和规模的增加,凸优化算 法也面临着一些挑战,如计算复杂度高、局部最优解等问题。未来,需要进一步研究和发展更高效的算法和技术 ,以解决更复杂的问题。

02

凸集与凸函数

凸集的定义与性质

凸集定义

一个集合称为凸集,如果该集合中的 任意两点之间的线段仍在集合中。

Newton法的局部收敛性

另外也可能不收敛, 或者不是收敛到离初值最近的根. 当然, 对于三次 函数, 除了个别点, 牛迭总是收敛到某个根的, 因为初值远离原点时由 于函数的单调性, 总会被拉回"局部".

事实上在复平面上三次函数的根的牛迭收敛行为是个著名的分形 ...足 见全局收敛性的复杂.

定义6.2

设迭代过程xk 1 ( xk )收敛于方程x ( x)的根x*, 如果迭代误差ek xk x*当k 时成立下列渐近关系式 ek 1 C (C 0为常数) p ek

具体来说

局部收敛性有如下定理 1.设已知 f(x) = 0 有根 a, f(x) 充分光滑(各阶导数存在且连续). 2.若 f'(a) != 0(单重零点), 则初值取在 a 的某个邻域内时, 迭代法 x[n+1] = x[n] - f(x[n])/f'(x[n]) 得到的序列 x[n] 总收敛到 a, 且收敛速度至少是 二阶的. 3.若 f'(a) == 0(多重零点), 则初值取在 a 的某个邻域内时, 收敛速度是 一阶的.

则称该迭代过程是p阶收敛的。特别地,p=1时称为线性收敛,p>1时 称为超线性收敛,p=2时称为平方收敛。

定理6.3

对于迭代过程xk 1 ( xk ), 如果 ( p ) ( x) 在所求根x*的邻近连续,并且

' * '' * ( p 1) ( x* ) 0, ( x ) ( x ) ... ( p) * ( x ) 0, 则该迭代过程在点x*邻近是p阶收敛的.

记 g(x)=x-f(x)/f'(x), 其中"某个邻域"可由 |g'(x)|<1 的区间确定, 但是 g'(a)==0, 所以这样的邻域总是能取到的. 说收敛速度是 r 阶指的是: 存在 r 及常数 c 使 lim_{n->\inf} |x[n+1]a|/|x[n]-a|^r = c 至于牛顿迭代法的全局收敛性, 一般的数值分析书都没有详细叙述, 而 只是举一些例子. 因为牛迭是否收敛依赖于函数是否"单调", 一些"曲折"大的函数就可能 使迭代法不收敛了.

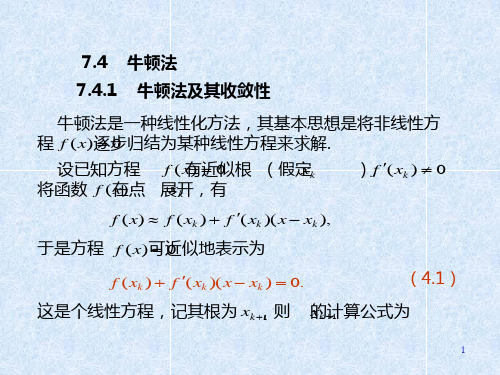

牛顿法及其收敛性课件

xk

C 2 C

q2

k

1 q

2k

.

对任意 x0 0,总有 q 1,故由上式推知,当 k 时 xk C ,即迭代过程恒收敛. 例8 解 求 115 .

表7 6 计算结果 k 0 1 2 3 4 xk 10 10.750000 10.723837 10.723805 10.723805

2

注意到切线方程为

y f ( xk ) f ( xk )( x xk ).

这样求得的值 xk 1 必满足(4.1),从而就是牛顿公式(4.2) 的计算结果. 由于这种几何背景,牛顿法亦称切线法. 牛顿法(4.2)的收敛性,可直接由定理4得到,对(4.2) 其迭代函数为

( x) x

若用此法解方程(4.8),当 x0 0.6 时由(4.9)求得

14

x1 17.9,它不满足条件(4.10).

通过 逐次取半进行试算,当 1 / 32时可求得 f ( x0 ) 1.384 x1 1.140625 f ( x1 ) 0.656643,而 . 此时有 显然 f ( x1 ) f ( x0 ) . 由 x1 计算 x2 , x3 , 时 1 , 成立. 计算结果如下 :

则 ( x*) 0

xk 1 xk m

.

f ( xk ) f ( xk )

用迭代法

(k 0,1, )

(4.13)

求 m重根,则具有2阶收敛,但要知道 x *的重数 m .

构造求重根的迭代法,还可令 ( x) f ( x) / f ( x) , 若 x* 是 f ( x) 0 的 m重根,则

9

取初值 x0 10,对 C 115 按(4.5)式迭代3次 便得到精度为 10 6 的结果 (见表7-6). 由于公式(4.5)对任意 初值 x0 0 均收敛,并且收 敛的速度很快,因此可取确定 的初值如 x0 1 编成通用程序.

牛顿法

如前面所提到的,最速下降法在最初几步迭代中函数值下降很快外,总的说来下降的并不快,且愈接近极值点下降的愈慢。

因此,应寻找使目标函数下降更快的方法。

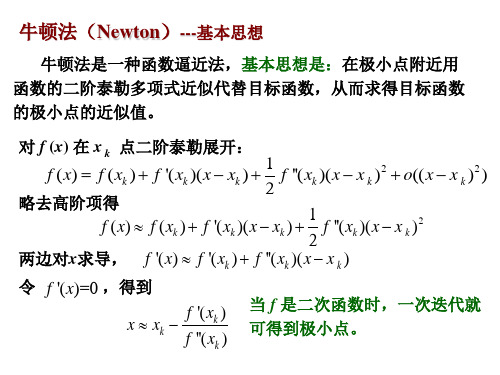

牛顿法就是一种收敛很快的方法,其基本思路是利用二次曲线来逐点近似原目标函数,以二次曲线的极小值点来近似原目标函数的极小值点并逐渐逼近改点。

一维目标函数()f x 在()k x 点逼近用的二次曲线(即泰勒二次多项式)为()()()()()()21()()()()()()2k k k k k k x f x f x x x f x x x ϕ'''=+-+- 此二次函数的极小点可由()()0k xϕ'=求得。

对于n 维问题,n 为目标函数()f X 在()k X 点逼近用的二次曲线为:()()()()()2()()1()()().[][].().[]2k k k k k T k k X f x f X X X X X f X X X ϕ⎡⎤=+∇-+-∇-⎣⎦令式中的Hessian 2()()()()k k f XH X ∇=,则上式可改写为:()()()()()()()1()()().[][].().[]2()k k k k k T k k X f x f X X X X X H X X X f X ϕ⎡⎤=+∇-+--⎣⎦≈当()0X ϕ∇=时可求得二次曲线()X ϕ的极值点,且当且仅当改点处的Hessian 矩阵为正定时有极小值点。

由上式得:()()()()()()[]k k k X f X H X X X ϕ∇=∇+-令()0X ϕ∇=,则()()()()()[]0k k k f X H X X X ∇+-=若()()k H X为可逆矩阵,将上式等号两边左乘1()()k H X -⎡⎤⎣⎦,则得1()()()()()[]0k k k n H X f X I X X -⎡⎤∇+-=⎣⎦整理后得1()()()()()k k k X X H X f X -⎡⎤=-∇⎣⎦当目标函数()f X 是二次函数时,牛顿法变得极为简单、有效,这时()()k H X 是一个常数矩阵,式()()()()()()()1()()().[][].().[]2()k k k k k T k k X f x f X X X X X H X X X f X ϕ⎡⎤=+∇-+--⎣⎦≈变成精确表达式,而利用式1()()()()()k k k X XH X f X -⎡⎤=-∇⎣⎦作一次迭代计算所得的X 就是最优点*X 。

凸优化之无约束优化(一维搜索方法:二分法、牛顿法、割线法)

凸优化之⽆约束优化(⼀维搜索⽅法:⼆分法、⽜顿法、割线法)1、⼆分法(⼀阶导)⼆分法是利⽤⽬标函数的⼀阶导数来连续压缩区间的⽅法,因此这⾥除了要求 f 在 [a0,b0] 为单峰函数外,还要去 f(x) 连续可微。

(1)确定初始区间的中点 x(0)=(a0+b0)/2 。

然后计算 f(x) 在 x(0) 处的⼀阶导数 f'(x(0)),如果 f'(x(0)) >0 , 说明极⼩点位于 x(0)的左侧,也就是所,极⼩点所在的区间压缩为[a0,x(0)];反之,如果 f'(x(0)) <0,说明极⼩点位于x(0)的右侧,极⼩点所在的区间压缩为[x(0),b0];如果f'(x(0)) = 0,说明就是函数 f(x) 的极⼩点。

(2)根据新的区间构造x(1),以此来推,直到f'(x(k)) = 0,停⽌。

可见经过N步迭代之后,整个区间的总压缩⽐为(1/2)N,这⽐黄⾦分割法和斐波那契数列法的总压缩⽐要⼩。

1 #ifndef _BINARYSECTION_H_2#define _BINARYSECTION_H_34 typedef float (* PtrOneVarFunc)(float x);5void BinarySectionMethod(float a, float b, PtrOneVarFunc fi, float epsilon);67#endif1 #include<iostream>2 #include<cmath>3 #include "BinarySection.h"45using namespace std;67void BinarySectionMethod(float a, float b, PtrOneVarFunc tangent, float epsilon)8 {9float a0,b0,middle;10int k;11 k = 1;12 a0 = a;13 b0 = b;14 middle = ( a0 + b0 )/2;1516while( abs(tangent(middle)) - epsilon > 0 )17 {18 #ifdef _DEBUG19 cout<<k++<<"th iteration:x="<<middle<<",f'("<<middle<<")="<<tangent(middle)<<endl;20#endif2122if( tangent(middle) > 0)23 {24 b0 = middle;25 }26else27 {28 a0 = middle;29 }30 middle =( a0+b0)/2;31 }3233 cout<<k<<"th iteration:x="<<middle<<",f'("<<middle<<")="<<tangent(middle)<<endl;34 }1 #include<iostream>2 #include "BinarySection.h"345float TangentFunctionofOneVariable(float x)6 {7return14*x-5;//7*x*x-5*x+2;8 }910int main()11 {12 BinarySectionMethod(-50, 50, TangentFunctionofOneVariable, 0.001);13return0;14 }1th iteration:x=0,f'(0)=-52th iteration:x=25,f'(25)=3453th iteration:x=12.5,f'(12.5)=1704th iteration:x=6.25,f'(6.25)=82.55th iteration:x=3.125,f'(3.125)=38.756th iteration:x=1.5625,f'(1.5625)=16.8757th iteration:x=0.78125,f'(0.78125)=5.93758th iteration:x=0.390625,f'(0.390625)=0.468759th iteration:x=0.195312,f'(0.195312)=-2.2656210th iteration:x=0.292969,f'(0.292969)=-0.89843811th iteration:x=0.341797,f'(0.341797)=-0.21484412th iteration:x=0.366211,f'(0.366211)=0.12695313th iteration:x=0.354004,f'(0.354004)=-0.043945314th iteration:x=0.360107,f'(0.360107)=0.041503915th iteration:x=0.357056,f'(0.357056)=-0.001220716th iteration:x=0.358582,f'(0.358582)=0.020141617th iteration:x=0.357819,f'(0.357819)=0.0094604518th iteration:x=0.357437,f'(0.357437)=0.0041198719th iteration:x=0.357246,f'(0.357246)=0.0014495820th iteration:x=0.357151,f'(0.357151)=0.0001144412、⽜顿法(⼆阶导)前提:f 在 [a0,b0] 为单峰函数,且[a0,b0] 在极⼩点附近,不能离的太远否则可能⽆法收敛。

第5章4节牛顿法

二是初始近似 x0 只在根 x *附近才能保证收敛,如

x0 给的不合适可能不收敛.

为克服这两个缺点,通常可用下述方法.

13

牛顿下山法. 牛顿法收敛性依赖初值 x0 的选取.

如果 x0 偏离所求根 x *较远,则牛顿法可能发散.

解 取初值 x0 10,对 按牛顿迭代公式迭代3 C 115 次 便得到精度为

10 6

2 3 4

的结果

1 C ( xk ). 2 xk

12

(见表5-6).

xk 1

3

牛顿下山法

牛顿法的优点是收敛快,缺点一是每步迭代要计算

f ( xk )及 f ( xk ) ,计算量较大且有时 f ( xk ) 计算较困难,

2

10

再讨论全局收敛性 1)当C>1时,f(x)=x2-C在[1,C]上满足全 局收敛性定理5,迭代法在[1,C]上全局收 敛。 2)当C<1时, f(x)=x2-C在[C,1]上满足全局 收敛性定理5,迭代法在[C,1]上全局收敛。

11

例8

求 115 .

表5 6 计算结果 k 0 1 xk 10 10.750000 10.723837 10.723805 10.723805

于是方程 f ( x) 0 可近似地表示为

f ( xk ) f ( xk )( x xk ) 0.

1

这是个线性方程,记其根为 xk 1 , 则 xk 1 的计算公式为

xk 1 xk f ( xk ) f ( xk ) ( k 0,1, ),

这就是牛顿(Newton)法. 牛顿法的几何解释. 方程 f ( x) 0 的根 x *可解释为 曲线 y f ( x) 与 x轴的交点的横坐标 (图5-3). 图5-3

牛顿迭代法收敛定理

关于牛顿迭代法的课程设计实验指导非线性方程(或方程组)问题可以描述为求 x 使得f (x ) = 0。

在求解非线性方程的方法中,牛顿迭代法是求非线性方程(非线性方程组)数值解的一种重要的方法。

牛顿是微积分创立者之一,微积分理论本质上是立足于对世界的这种认识:很多物理规律在微观上是线性的。

近几百年来,这种局部线性化方法取得了辉煌成功,大到行星轨道计算,小到机械部件设计。

牛顿迭代法正是将局部线性化的方法用于求解方程。

一、牛顿迭代法及其收敛速度牛顿迭代法又称为牛顿-拉夫逊方法(Newton-Raphson method ),是一种在实数域和复数域上通过迭代计算求出非线性方程的数值解方法。

方法的基本思路是利用一个根的猜测值x 0做初始近似值,使用函数f (x )在x 0处的泰勒级数展式的前两项做为函数f (x )的近似表达式。

由于该表达式是一个线性函数,通过线性表达式替代方程中的求得近似解x 1。

即将方程f (x ) = 0在x 0处局部线性化计算出近似解x 1,重复这一过程,将方程f (x ) = 0在x 1处局部线性化计算出x 2,求得近似解x 2,……。

详细叙述如下:假设方程的解x *在x 0附近(x 0是方程解x *的近似),函数f (x )在点x 0处的局部线化表达式为)()()()(000x f x x x f x f '-+≈由此得一次方程 0)()()(000='-+x f x x x f求解,得 )()(0001x f x f x x '-= 如图1所示,x 1比x 0更接近于x *。

该方法的几何意义是:用曲线上某点(x 0,y 0)的切线代替曲线,以该切线与x 轴的交点(x 1,0)作为曲线与x 轴的交点(x *,0)的近似(所以牛顿迭代法又称为切线法)。

设x n 是方程解x *的近似,迭代格式)()(1n n n n x f x f x x '-=+ ( n = 0,1,2,……) 就是著名的牛顿迭代公式,通过迭代计算实现逐次逼近方程的解。

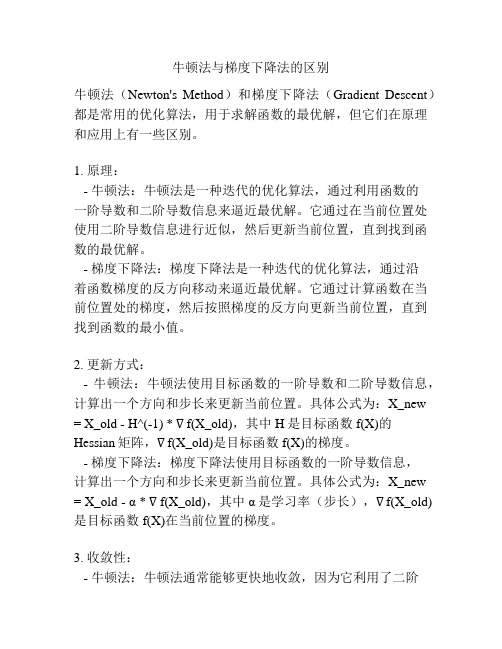

牛顿法与梯度下降法的区别

牛顿法与梯度下降法的区别牛顿法(Newton's Method)和梯度下降法(Gradient Descent)都是常用的优化算法,用于求解函数的最优解,但它们在原理和应用上有一些区别。

1. 原理:- 牛顿法:牛顿法是一种迭代的优化算法,通过利用函数的一阶导数和二阶导数信息来逼近最优解。

它通过在当前位置处使用二阶导数信息进行近似,然后更新当前位置,直到找到函数的最优解。

- 梯度下降法:梯度下降法是一种迭代的优化算法,通过沿着函数梯度的反方向移动来逼近最优解。

它通过计算函数在当前位置处的梯度,然后按照梯度的反方向更新当前位置,直到找到函数的最小值。

2. 更新方式:- 牛顿法:牛顿法使用目标函数的一阶导数和二阶导数信息,计算出一个方向和步长来更新当前位置。

具体公式为:X_new = X_old - H^(-1) * ∇f(X_old),其中H是目标函数f(X)的Hessian矩阵,∇f(X_old)是目标函数f(X)的梯度。

- 梯度下降法:梯度下降法使用目标函数的一阶导数信息,计算出一个方向和步长来更新当前位置。

具体公式为:X_new = X_old - α * ∇f(X_old),其中α是学习率(步长),∇f(X_old) 是目标函数f(X)在当前位置的梯度。

3. 收敛性:- 牛顿法:牛顿法通常能够更快地收敛,因为它利用了二阶导数信息,减少了迭代的次数。

但牛顿法可能会陷入局部最小值,特别是在起始点选择不当的情况下。

- 梯度下降法:梯度下降法可能会收敛得更慢,特别是在目标函数的条件数很大的情况下。

但梯度下降法通常能够逃离局部最小值,因为它只利用了目标函数的一阶导数信息。

4. 适用范围:- 牛顿法:牛顿法在求解凸函数和非凸函数的最优解时都表现良好,尤其是对于凸函数,牛顿法能够很快地收敛到全局最优解。

- 梯度下降法:梯度下降法在求解凸函数的最优解时也表现良好,但对于非凸函数,由于其容易陷入局部最小值,需要对初始点的选择和学习率的调整特别谨慎。

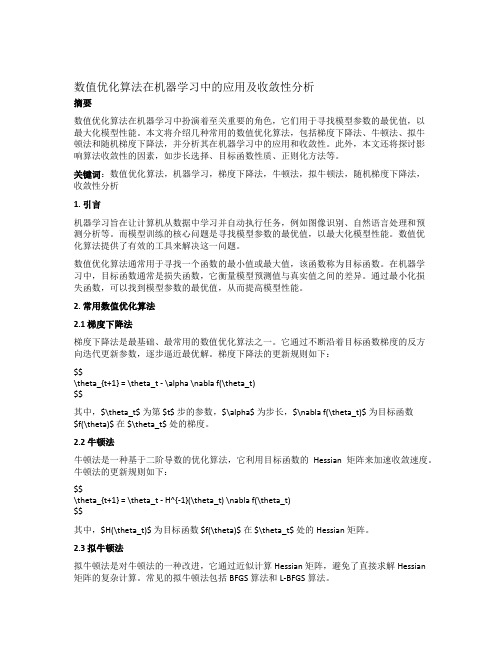

数值优化算法在机器学习中的应用及收敛性分析

数值优化算法在机器学习中的应用及收敛性分析摘要数值优化算法在机器学习中扮演着至关重要的角色,它们用于寻找模型参数的最优值,以最大化模型性能。

本文将介绍几种常用的数值优化算法,包括梯度下降法、牛顿法、拟牛顿法和随机梯度下降法,并分析其在机器学习中的应用和收敛性。

此外,本文还将探讨影响算法收敛性的因素,如步长选择、目标函数性质、正则化方法等。

关键词:数值优化算法,机器学习,梯度下降法,牛顿法,拟牛顿法,随机梯度下降法,收敛性分析1. 引言机器学习旨在让计算机从数据中学习并自动执行任务,例如图像识别、自然语言处理和预测分析等。

而模型训练的核心问题是寻找模型参数的最优值,以最大化模型性能。

数值优化算法提供了有效的工具来解决这一问题。

数值优化算法通常用于寻找一个函数的最小值或最大值,该函数称为目标函数。

在机器学习中,目标函数通常是损失函数,它衡量模型预测值与真实值之间的差异。

通过最小化损失函数,可以找到模型参数的最优值,从而提高模型性能。

2. 常用数值优化算法2.1 梯度下降法梯度下降法是最基础、最常用的数值优化算法之一。

它通过不断沿着目标函数梯度的反方向迭代更新参数,逐步逼近最优解。

梯度下降法的更新规则如下:$$\theta_{t+1} = \theta_t - \alpha \nabla f(\theta_t)$$其中,$\theta_t$ 为第 $t$ 步的参数,$\alpha$ 为步长,$\nabla f(\theta_t)$ 为目标函数$f(\theta)$ 在 $\theta_t$ 处的梯度。

2.2 牛顿法牛顿法是一种基于二阶导数的优化算法,它利用目标函数的Hessian矩阵来加速收敛速度。

牛顿法的更新规则如下:$$\theta_{t+1} = \theta_t - H^{-1}(\theta_t) \nabla f(\theta_t)$$其中,$H(\theta_t)$ 为目标函数 $f(\theta)$ 在 $\theta_t$ 处的Hessian矩阵。

基本牛顿法 无约束多维极值问题 原理

基本牛顿法无约束多维极值问题原理一、概述无约束多维极值问题是数学中的一个重要问题,涉及到优化理论和实际问题中的多种场景。

针对这类问题,基本牛顿法是一种常用的求解方法,具有较高的收敛速度和效率。

本文将介绍基本牛顿法在无约束多维极值问题中的应用,以及其原理和相关概念。

二、基本牛顿法概述1. 基本牛顿法的基本思想基本牛顿法是一种迭代方法,用于求解无约束多维极值问题的极小点。

其基本思想是利用目标函数的二阶导数信息来逼近极小点。

通过不断更新当前点的位置,使得目标函数在迭代过程中逐渐趋向最小值点。

2. 基本牛顿法的迭代公式设目标函数为f(x),在点x_k处的梯度为g_k,二阶导数矩阵为H_k,则基本牛顿法的迭代公式为:x_(k+1) = x_k - H_k^(-1) * g_k其中,H_k^(-1)为H_k的逆矩阵,代表了目标函数曲率信息的逆。

通过不断更新x_k的值,可以逐步逼近极小点的位置。

三、基本牛顿法的收敛性分析1. 收敛速度基本牛顿法具有较高的收敛速度。

在目标函数满足一定条件(如凸性和光滑性)的情况下,基本牛顿法通常能够在很少的迭代次数内达到较高的精度要求。

2. 局部收敛性基本牛顿法在局部收敛性上表现较好。

当初始点距离极小点较近时,通常能够快速收敛到极小点附近。

3. 全局收敛性基本牛顿法在全局收敛性上存在一定的局限性。

对于非凸函数或者特定类型的目标函数,可能会出现收敛到局部极小点而非全局极小点的情况。

四、基本牛顿法的应用举例1. 无约束多维极小化问题基本牛顿法广泛应用于无约束多维极小化问题的求解中。

在机器学习和优化理论中,经常需要对多维目标函数进行极小化操作,基本牛顿法能够快速有效地求解该类问题。

2. 凸优化问题在凸优化问题的求解中,基本牛顿法也具有良好的应用效果。

由于凸函数的特殊性质,基本牛顿法往往能够在很少的迭代次数内找到全局极小点。

五、基本牛顿法的改进与扩展1. 阻尼牛顿法阻尼牛顿法是基本牛顿法的一种改进形式,通过引入阻尼因子来增加迭代的稳定性和收敛性。

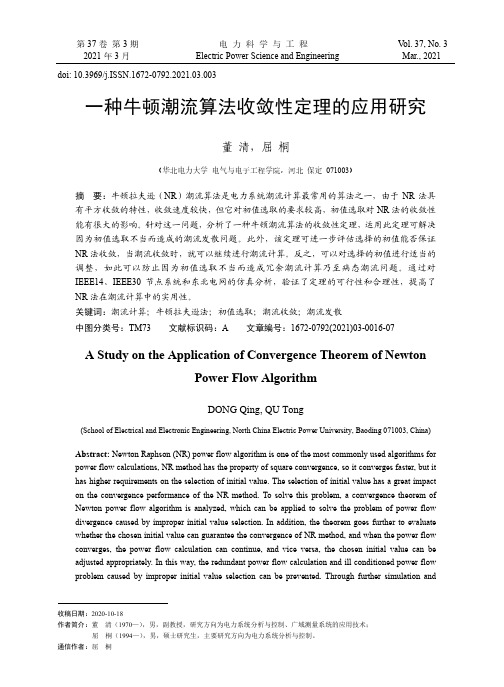

一种牛顿潮流算法收敛性定理的应用研究

第37卷第3期电力科学与工程V ol. 37, No. 3 2021年3月Electric Power Science and Engineering Mar., 2021 doi: 10.3969/j.ISSN.1672-0792.2021.03.003一种牛顿潮流算法收敛性定理的应用研究董清,屈桐(华北电力大学电气与电子工程学院,河北保定071003)摘要:牛顿拉夫逊(NR)潮流算法是电力系统潮流计算最常用的算法之一,由于NR法具有平方收敛的特性,收敛速度较快,但它对初值选取的要求较高,初值选取对NR法的收敛性能有很大的影响。

针对这一问题,分析了一种牛顿潮流算法的收敛性定理,运用此定理可解决因为初值选取不当而造成的潮流发散问题。

此外,该定理可进一步评估选择的初值能否保证NR法收敛,当潮流收敛时,就可以继续进行潮流计算。

反之,可以对选择的初值进行适当的调整,如此可以防止因为初值选取不当而造成冗余潮流计算乃至病态潮流问题。

通过对IEEE14、IEEE30节点系统和东北电网的仿真分析,验证了定理的可行性和合理性,提高了NR法在潮流计算中的实用性。

关键词:潮流计算;牛顿拉夫逊法;初值选取;潮流收敛;潮流发散中图分类号:TM73 文献标识码:A 文章编号:1672-0792(2021)03-0016-07A Study on the Application of Convergence Theorem of NewtonPower Flow AlgorithmDONG Qing, QU Tong(School of Electrical and Electronic Engineering, North China Electric Power University, Baoding 071003, China)Abstract: Newton Raphson (NR) power flow algorithm is one of the most commonly used algorithms for power flow calculations, NR method has the property of square convergence, so it converges faster, but it has higher requirements on the selection of initial value. The selection of initial value has a great impact on the convergence performance of the NR method. To solve this problem, a convergence theorem of Newton power flow algorithm is analyzed, which can be applied to solve the problem of power flow divergence caused by improper initial value selection. In addition, the theorem goes further to evaluate whether the chosen initial value can guarantee the convergence of NR method, and when the power flow converges, the power flow calculation can continue, and vice versa, the chosen initial value can be adjusted appropriately. In this way, the redundant power flow calculation and ill conditioned power flow problem caused by improper initial value selection can be prevented. Through further simulation and收稿日期:2020-10-18作者简介:董清(1970—),男,副教授,研究方向为电力系统分析与控制、广域测量系统的应用技术;屈桐(1994—),男,硕士研究生,主要研究方向为电力系统分析与控制。

凸优化问题的迭代收敛算法研究

凸优化问题的迭代收敛算法研究第一章引言1.1 研究背景及意义凸优化问题是数学和工程领域中的一个重要研究方向。

凸优化问题具有良好的性质和广泛的应用。

迭代收敛算法是解决凸优化问题的一种常用方法。

本文旨在通过研究凸优化问题的迭代收敛算法,深入了解和探讨凸优化问题的求解过程,为优化算法的进一步发展提供指导。

1.2 本文结构本文共分为以下几个章节来探讨凸优化问题的迭代收敛算法研究。

首先,在第二章中,我们将介绍凸优化问题的基本定义和性质。

第三章会详细介绍迭代收敛算法的原理和常用方法。

第四章将介绍凸优化问题的收敛性分析。

在第五章中,我们将详细研究凸优化问题迭代收敛算法的优化过程。

最后,在第六章中,我们将总结全文并展望未来的研究方向。

第二章凸优化问题基本定义和性质2.1 凸集的定义和性质凸优化问题的基础是凸集的理论。

我们首先介绍凸集的定义和性质。

一个集合称为凸集,如果对于集合中的任意两个点,该两点连线上的所有点也属于集合内。

凸集具有很多重要的性质,如任意两点的线段上的点也属于凸集,凸包是凸集的一个重要概念。

2.2 凸函数的定义和性质凸函数在凸优化问题中起着重要的作用。

一个函数称为凸函数,如果对于定义域内的任意两点,该函数在这两点间的线段上的值大于等于线段两端点的值。

凸函数有很多重要的性质,如局部极小值是全局最小值等。

第三章迭代收敛算法的原理和常用方法3.1 迭代收敛算法的原理迭代收敛算法通过迭代的方式逐步逼近凸优化问题的最优解。

我们将介绍一般迭代收敛算法的原理,包括优化方向的选择、步长的确定等。

3.2 基本迭代方法基本的迭代方法包括梯度下降法、牛顿法和拟牛顿法等。

这些方法在凸优化问题的求解中得到了广泛的应用。

我们将详细介绍这些基本迭代方法的原理和应用。

3.3 其他常用迭代方法除了基本的迭代方法,还有一些其他常用的迭代方法,如共轭梯度法、重启技术等。

这些方法在特定的凸优化问题中有着重要的应用。

我们将介绍这些方法的原理和应用。

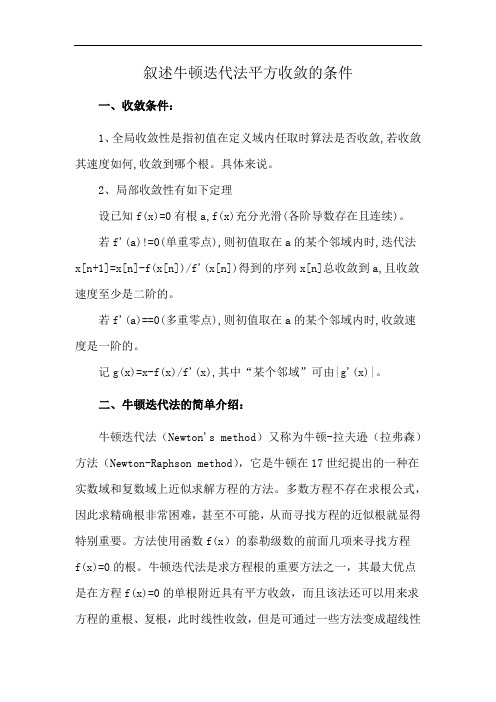

叙述牛顿迭代法平方收敛的条件

叙述牛顿迭代法平方收敛的条件

一、收敛条件:

1、全局收敛性是指初值在定义域内任取时算法是否收敛,若收敛其速度如何,收敛到哪个根。

具体来说。

2、局部收敛性有如下定理

设已知f(x)=0有根a,f(x)充分光滑(各阶导数存在且连续)。

若f'(a)!=0(单重零点),则初值取在a的某个邻域内时,迭代法x[n+1]=x[n]-f(x[n])/f'(x[n])得到的序列x[n]总收敛到a,且收敛速度至少是二阶的。

若f'(a)==0(多重零点),则初值取在a的某个邻域内时,收敛速度是一阶的。

记g(x)=x-f(x)/f'(x),其中“某个邻域”可由|g'(x)|。

二、牛顿迭代法的简单介绍:

牛顿迭代法(Newton's method)又称为牛顿-拉夫逊(拉弗森)方法(Newton-Raphson method),它是牛顿在17世纪提出的一种在实数域和复数域上近似求解方程的方法。

多数方程不存在求根公式,因此求精确根非常困难,甚至不可能,从而寻找方程的近似根就显得特别重要。

方法使用函数f(x)的泰勒级数的前面几项来寻找方程

f(x)=0的根。

牛顿迭代法是求方程根的重要方法之一,其最大优点是在方程f(x)=0的单根附近具有平方收敛,而且该法还可以用来求方程的重根、复根,此时线性收敛,但是可通过一些方法变成超线性

收敛。

另外该方法广泛用于计算机编程中。

04工程优化 第3章-2常用一维搜索牛顿法

解: f '( x) 4 x3 12 x 2 12 x 16, f ''( x) 12 x 2 24 x 12,

f '( x0 ) f '(6) 89 x1 x0 6 6 4.75 f ''( x0 ) f ''(6) 69

f '( x1 ) f '(4.75) 84.94 102 , 继续迭代; f '( x1 ) x2 x1 f ''( x1 ) f '(4.75) 84.94 4.75 =4.75 =4.163 f ''(4.75) 144.75 f '( x2 ) f '(4.163) 14.666 102 , 继续迭代;

3.若 x2 x ,则迭代结束,取 x* x ,否则在点

x1 , x2 , x3 , x 中,选取使f (x) 最小的点作为新的x2,并使新的

x 1 , x3各是新的x2近旁的左右两点,继续进行迭代,直到满 足终止准则。

例

用二次插值法求函数f(x)=3x3-4x+2的极小点, 给定 x0=0, h=1, ε=0.2。

应继续迭代。

(2) 在新区间,相邻三点及其函数值: x1=0, x2=0.555, x3=1;

根据公式计算差值多项式的极小点 f1=2, f2=0.292, f3=1.

1 c1 x a1 / 2a2 ( x1 x3 ), f1 f 2 2 c2 c1 f1 f 3 x1 x2 c1 , c2 x1 x3 x2 x3

Newton法----算例

f '( x2 ) x3 x2 f ''( x2 )

最优化理论与方法——牛顿法

牛顿法简介摘要:牛顿法作为求解非线性方程的一种经典的迭代方法,它的收敛速度快,有内在函数可以直接使用。

结合着matlab 可以对其进行应用,求解方程。

关键词:牛顿法,Goldfeld 等人修正牛顿法, matlab 实现1 介绍:迭代法也称辗转法,是一种不断用变量的旧值递推新值的过程,跟迭代法相对应的是直接法,即一次性解决问题。

但多数方程不存在求根公式,因此求解根非常困难,甚至不可能,从而寻找方程的近似根就显得特别重要。

迭代算法是用计算机解决问题的一种基本方法。

它利用计算机运算速度快、适合做重复性操作的特点,让计算机对一组指令(或一定步骤)进行重复执行,在每次执行这组指令(或这些步骤)时,都从变量的原值推出它的一个新值。

利用迭代算法解决问题,需要做好以下3个方面的工作:1,确定迭代变量。

在可以用迭代算法解决的问题中,至少存在一个直接或间接地不断由旧值递推出新值的变量,这个变量就是迭代变量。

2,建立迭代关系式。

所谓迭代关系式,是指如何从变量的前一个值推出下一个值的公式(或关系)。

迭代关系式的建立是解决迭代问题的关键,通常可以使用递推或倒推的方法来完成。

3,对迭代过程进行控制。

在什么时候结束迭代过程?这是编写迭代程序必须 考虑的问题。

不能让迭代过程无休止地重复下去。

迭代过程的控制通常可分为两种情况:一种是所需的迭代次数是个确定的值,可以计算出来;另一种是所需的迭代次数无法确定。

对于前一种情况,可以构建一个固定次数的循环来实现对迭代过程的控制;对于后一种情况,需要进一步分析出用来结束迭代过程的条件。

牛顿迭代法(Newton ’s method )又称为牛顿-拉夫逊方法(Newton-Raphson method ),它是牛顿在17世纪提出的一种在实数域和复数域上近似求解方程的方法,其基本思想是利用目标函数的二次Taylor 展开,并将其极小化。

牛顿法使用函数()f x 的泰勒级数的前面几项来寻找方程()0f x =的根。

拟牛顿法条件

拟牛顿法条件拟牛顿法是一种求解无约束优化问题的算法,它的核心思想是构造一个拟合原问题Hessian矩阵的矩阵作为近似的Hessian矩阵。

通过近似Hessian矩阵来避免每次迭代都需要计算Hessian矩阵的开销,从而提高了算法的效率。

但是,在使用拟牛顿法时,需要满足一些条件,才能保证算法的收敛性和全局收敛性。

一、单峰性和下降性拟牛顿法的第一个条件是最优解在可行域内存在,且函数f(x)在可行域内是单峰函数。

单峰函数是指函数的值随着自变量增加或减小而按照一个峰顶先升后降的趋势变化。

这意味着,如果x趋近于最小值,那么函数的值将趋近于一个确定的值。

而且,函数的值在x方向上也必须倾向于下降。

也就是说,如果x向最小值的方向移动,那么函数的值也应该随之下降。

二、连续性和Lipschitz连续拟牛顿法的第二个条件是函数f(x)在可行域内是连续的,并且存在一个常数L,使得函数在可行域内任意两点之间的函数值之差的绝对值不大于欧几里得距离的L倍。

也就是说,函数的变化率有界,并且越接近最优解,变化率越小。

Lipschiz连续性为拟牛顿法提供了一个保证它能够收敛到全局最小值的理论基础。

三、强凸性拟牛顿法的第三个条件是函数f(x)在可行域内是强凸函数。

强凸性指的是函数的一阶和二阶导数都是正的,并且存在一个正的常数m,使得对于可行域内的任意x和y,都满足:f(y) ≥ f(x) + ⟨∇f(x), y-x⟨ + (m/2) ||y-x||^2其中,⟨∇f(x), y-x⟨表示∇f(x)和y-x的点积,||y-x||表示y-x的欧几里得距离。

上式的含义是,对于可行域内的任意两点x和y,函数f(x)在这两点之间的一次方程不仅是下凸的,而且是强下凸的。

强凸性保证了f(x)与其强凸上罩函数的距离上界不随着x变化而增加,这保证了收敛性和全局收敛性。

四、正定性和拟正定性拟牛顿法的第四个条件是更新矩阵的正定性和拟正定性。

在拟牛顿法的迭代过程中,需要利用当前的Hessian矩阵近似值Hk和当前迭代点xk来构造一个近似的矩阵Bk,即拟Hessian矩阵。