泛化误差的各种交叉验证估计方法综述

泛化误差证明公式

泛化误差证明公式

泛化误差是指机器学习算法在新样本上的误差,它是训练样本和真实样本之间差异的度量。

泛化误差的大小可以反映模型的泛化能力,即对未知样本的预测能力。

泛化误差越小,说明模型对未知样本的预测能力越强。

泛化误差的计算公式如下:

泛化误差 = 预测误差 + 近似误差 + 估计误差

预测误差是模型在训练集上的误差,它衡量的是模型在已知样本上的拟合程度。

如果模型在训练集上表现良好,但在测试集上表现较差,说明模型过拟合,预测误差较大。

近似误差是模型选择的假设空间与真实模型之间的差距。

模型的假设空间越接近真实模型,近似误差越小。

估计误差是由于样本有限而引入的误差。

当样本数量较少时,估计误差较大。

随着样本数量的增加,估计误差逐渐减小。

为了降低泛化误差,可以采取以下方法:

1. 增加训练样本数量:通过增加训练样本数量,可以减小估计误差,提高模型的泛化能力。

2. 选择合适的模型复杂度:模型的复杂度越低,近似误差越小。

选择合适的模型复杂度可以降低泛化误差。

3. 使用正则化方法:正则化方法可以通过限制模型参数的大小,减

小模型的复杂度,从而降低泛化误差。

4. 交叉验证:交叉验证可以评估模型在不同数据集上的表现,选择最优的模型参数,从而降低泛化误差。

泛化误差是衡量模型泛化能力的重要指标。

通过合理选择模型复杂度、增加训练样本数量和使用正则化方法等手段,可以降低泛化误差,提高模型的预测能力。

交叉验证方法在模型评估中的应用

交叉验证方法在模型评估中的应用随着数据挖掘技术的发展和应用场景的不断扩大,建立准确、稳定的模型成为了提高预测精度和优化决策的关键。

而对模型的评估和性能检验则是确认模型有效性和可靠性的重要途径之一。

在众多的模型评估方法中,交叉验证方法是被广泛应用的一种,其主要目的是通过对数据集的划分和分组,从而提高模型的稳定性和泛化能力。

一、交叉验证方法的概念及原理交叉验证方法是一种比较现代的、基于数据对模型进行评估的方法。

它的主要思想是将数据集分为若干组,在模型训练和评估过程中,对不同的数据组进行交叉使用,从而更加精确地评估模型的性能表现。

通常,交叉验证方法分为简单交叉验证、留一交叉验证、k折交叉验证、随机子采样交叉验证等几种。

其中,k折交叉验证是应用最广泛的一种交叉验证方法。

其基本思路是将训练集分为k个子集,每次取其中k-1个子集作为训练集,剩余的那个子集作为测试集,重复进行k次,最后对k次测试结果进行取平均值得出最终结果。

留一交叉验证是k折交叉验证的一种特殊形式,指将训练集中的每个样本都作为测试集进行一次训练和测试,最后得出平均分数。

由于考虑了所有样本的情况,留一交叉验证方法具有很高的评估精度。

但同时也需要耗费更多的计算时间和空间资源。

二、交叉验证方法的应用在机器学习领域,交叉验证方法是一个不可或缺的评估手段。

在模型选择、超参数调优等方面,交叉验证方法都有着非常广泛的应用。

1. 模型选择在模型选择过程中,交叉验证方法可以帮助我们分析模型的过学习和欠学习程度。

针对过学习现象,我们可以通过交叉验证方法来筛选出精度更高的模型;而针对欠学习现象,则可以得出更加准确的模型评估结果。

2. 超参数调优超参数是机器学习过程中不可避免的一个问题。

通过交叉验证方法,我们可以将数据集分成训练集和验证集两部分,通过选取不同的超参数值来测试模型的验证集性能,从而选出最优的超参数组合。

3. 模型评估在模型评估过程中,交叉验证方法可以帮助我们检查模型的泛化性能。

交叉验证的3种方法

交叉验证的3种方法在机器学习中,数据集可以划分为以下3类1. 训练集,traning data2. 验证集,validation data3. 测试集,test data将数据集进行划分是非常必要的,如果所有的数据都作为训练集的话,不可避免的会遇到过拟合的问题,所以我们还需要另外的数据对训练集得到的模型的结果进行评估和验证。

三者的关系如下训练集用于训练模型,验证集用于评估模型,调整模型超参数,测试集则用于评估最后生成的模型的效果。

其中验证集是非必需的。

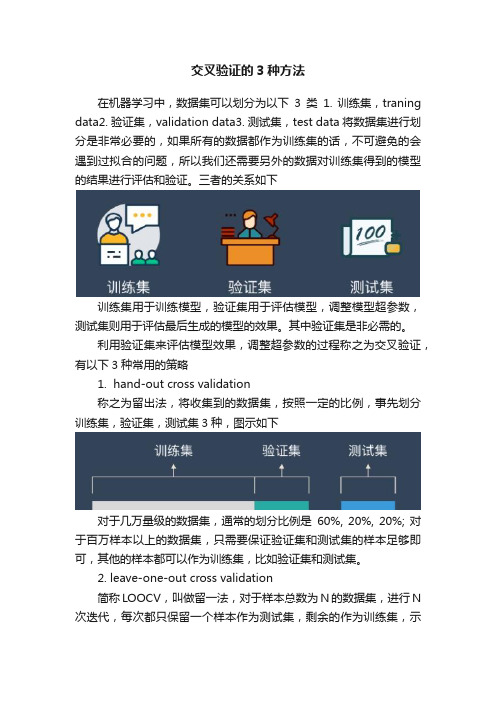

利用验证集来评估模型效果,调整超参数的过程称之为交叉验证,有以下3种常用的策略1. hand-out cross validation称之为留出法,将收集到的数据集,按照一定的比例,事先划分训练集,验证集,测试集3种,图示如下对于几万量级的数据集,通常的划分比例是60%, 20%, 20%; 对于百万样本以上的数据集,只需要保证验证集和测试集的样本足够即可,其他的样本都可以作为训练集,比如验证集和测试集。

2. leave-one-out cross validation简称LOOCV,叫做留一法,对于样本总数为N的数据集,进行N 次迭代,每次都只保留一个样本作为测试集,剩余的作为训练集,示意如下留一法每次只取一个样本作为测试集一样,实际上,这里的一可以扩展为其他的数字,与此对应的方法,叫做leave-p-out cross validation,比如p取值为4时,示意如下在留一法中,需要迭代N次,在留p法中,则是一个排列组合的问题,迭代次数的公式如下迭代的次数大于留一法。

3. k fold cross validation称之为K折交叉验证,K指定了迭代的次数,示意如下将数据集均匀划分为k个子集,每次迭代,使用一个子集作为测试集,其他的作为训练集。

LOOCV也可以看做是K折交叉验证的一个特例,K等于样本总数N。

对于得到的k个模型,从其中挑选误差最小的作为最终的模型。

交叉验证的方法范文

交叉验证的方法范文交叉验证(Cross-validation)是机器学习中常用的一种模型评估方法,主要用于衡量模型的泛化能力。

通过将数据集划分成多个子集,然后将每个子集轮流作为验证集,其余子集作为训练集,从而得到多个模型的评估结果。

本文将详细介绍交叉验证的方法及其优势。

交叉验证的主要目的是评估模型在未知数据上的性能,以判断模型是否过拟合或欠拟合,以及选择适当的模型参数。

通过将数据集分为训练集和验证集两个部分,训练集用于模型的训练,验证集用于评估模型的性能。

然而,这种简单的划分可能会导致模型的评估结果对数据的划分方式非常敏感,从而可能影响模型选择的准确性。

为了克服这一问题,交叉验证将数据集划分为k个大小相等的子集,其中一个子集作为验证集,其余k-1个子集作为训练集。

这个过程重复k 次,每次都选取不同的子集作为验证集,然后取平均值来得到最终的模型性能评估结果。

其中,最常用的交叉验证方法包括k折交叉验证和留一法交叉验证。

在k折交叉验证中,数据集被划分为k个子集,每个子集都被轮流作为验证集,其余k-1个子集作为训练集。

每次交叉验证都会生成一个模型,并将模型在验证集上的性能进行评估。

最终,k次交叉验证的结果取平均值,得到模型的最终性能评估。

这种方法的优势在于所有的数据都被用于训练和验证,从而可以最大限度地利用数据集来评估模型的性能。

另一种常见的交叉验证方法是留一法交叉验证。

在留一法交叉验证中,数据集被划分为k个子集,其中每个子集只包含一个样本。

然后,每个样本依次作为验证集,其余的样本作为训练集,从而得到k个模型的评估结果。

最终,将这k个模型的评估结果取平均值,得到模型的最终性能评估。

留一法交叉验证的优势在于对于小型数据集,可以提供最准确的性能评估,但计算成本较高。

除了上述两种常用的交叉验证方法,还有一些其他的变种方法,如分层交叉验证、重复交叉验证和随机划分交叉验证等。

这些方法都旨在解决特定情况下的问题,并提供更准确的模型性能评估。

机器学习知识:机器学习中的交叉验证

机器学习知识:机器学习中的交叉验证交叉验证是机器学习中常用的一种评估模型性能的方法。

它的主要作用是检验模型是否泛化能力良好,即在遇到新的数据集时是否能够保持较高的预测准确率。

本文将从交叉验证的基本概念、常用方法、优缺点及实践操作等方面进行介绍和分析。

一、交叉验证的基本概念交叉验证(Cross-validation)是指将数据集划分为若干个互不重叠的子集,然后将其中的一个子集作为测试集,其余子集作为训练集,进行模型训练和测试,得到一个模型在测试集上的表现,称之为一次交叉验证。

重复上述过程多次,直到每个子集都作为测试集,然后将多次交叉验证的结果取平均值,作为模型的最终性能评估。

常见的交叉验证方法有以下几种:1.简单交叉验证(Holdout)将数据集分为训练集和测试集两部分,一般将数据集的70%作为训练集,30%作为测试集。

然后用训练集训练模型,用测试集评估模型性能。

这种方法简单易懂,但是可能会因为样本划分的不一致而导致评估结果的不稳定。

2. K折交叉验证(K-fold)将数据集分成K份,其中K-1份作为训练集,剩下1份作为测试集,然后将测试集的结果累加起来,得到K个结果。

最后将这K个结果取平均值,作为模型性能的评估结果。

这种方法能够充分利用数据集中的信息,评估结果相对稳定。

3.留一交叉验证(Leave-one-out)将数据集分成N份,其中N为数据集大小,每次只用1个样本做测试集,其余N-1个样本做训练集。

这种方法能够充分利用数据集中的信息,但是计算量很大,适用于数据集比较小的情况。

二、交叉验证的优缺点1.优点(1)模型的性能评估更加准确。

通过交叉验证,可以避免过拟合和欠拟合的情况,提高模型的泛化性能。

(2)能够充分利用数据集中的信息。

交叉验证可以将数据集分为若干个子集,每个子集都参与到训练和测试中,保证数据集的每个样本都能够得到充分的利用,提高模型的效果。

(3)能够评估不同模型之间的性能差异。

通过交叉验证,可以比较不同模型的性能表现,选择最优的模型,提高模型的预测能力。

rademacher复杂度的泛化误差界_概述说明以及解释

rademacher复杂度的泛化误差界概述说明以及解释1. 引言1.1 概述在机器学习领域,模型的泛化能力是评估其在未见过样本上表现的能力。

泛化误差是用来度量模型预测效果与真实结果之间的差异程度。

为了探索模型的泛化性能,我们需要引入合适的复杂度衡量指标。

Rademacher复杂度就是一种常用的模型复杂度衡量方法之一,它通过引入随机变量来监测给定模型和数据集之间的关系。

1.2 文章结构本文将系统地介绍Rademacher复杂度及其与泛化误差界之间的关系。

首先,我们将深入探讨Rademacher函数和Rademacher随机变量的基本概念,并详细阐述Rademacher复杂度的定义和性质。

接着,我们将研究Rademacher 复杂度与泛化误差界之间的联系,包括其基本原理、关联定理以及求解方法和优化策略。

然后,我们会通过实例分析和讨论,以线性模型、支持向量机和深度学习为例子,展示如何利用Rademacher复杂度推导出相应的泛化误差界。

最后,我们将对全文进行总结,并提出Rademacher复杂度研究中存在的问题和挑战,探讨未来研究方向与应用前景。

1.3 目的本文的目的是介绍和解释Rademacher复杂度以及其在模型泛化误差界中的应用。

通过深入理解Rademacher复杂度的概念、性质和求解方法,我们可以更好地评估模型在未知数据上的预测能力,并为进一步研究模型推广性能提供指导和新思路。

此外,还将着重讨论Rademacher复杂度在线性模型、支持向量机和深度学习等领域中的具体应用案例,以帮助读者更好地理解其实际意义和作用。

2. Rademacher复杂度的基本概念:2.1 Rademacher函数与Rademacher随机变量Rademacher函数是一种定义在样本空间上的二值函数,常用符号为σ。

对于每个样本点,Rademacher函数将其映射为+1或-1。

具体地,对于一个包含n个样本的数据集D={x_1, x_2, ..., x_n},其中x_i表示第i个样本,则Rademacher 函数可以表示为{σ(x_1), σ(x_2), ..., σ(x_n)}。

统计学中的交叉验证方法

统计学中的交叉验证方法交叉验证(Cross-validation)是统计学中常用的一种模型评估技术,它通过将样本数据集分为训练集和测试集,以验证模型的性能和泛化能力。

交叉验证方法在模型训练和选择中起着重要的作用,本文将介绍几种常见的交叉验证方法。

一、留出法(Holdout method)留出法是交叉验证中最简单的一种方法,它将原始样本数据集划分为两部分,一部分用于模型训练,另一部分用于模型测试。

留出法的优点是操作简单,计算效率高,但其缺点是样本划分的方式可能会导致训练集和测试集的不平衡,而且只进行一次划分不能取得稳定的评估结果。

二、K折交叉验证(K-fold Cross-validation)K折交叉验证是一种常见且常用的交叉验证方法,它将原始样本数据集划分为K个大小相等的子集,其中K-1个子集用于模型训练,剩下的一个子集用于模型测试。

通过重复K次,每次选取不同的子集进行训练和测试,最终得到K个评估指标的平均值作为模型的性能指标。

K折交叉验证能够较好地克服留出法的缺点,减少了样本划分不平衡的问题,并且可以取得稳定的评估结果。

三、留一法(Leave-one-out Cross-validation)留一法是K折交叉验证的一种特殊情况,即将原始样本数据集划分为N个子集,其中N为样本的个数,每个子集只包含一个样本。

留一法的优点是能够使用最大的训练样本来进行模型训练,但缺点是计算开销大,特别是在数据集较大时。

留一法在模型参数的选择和模型复杂度的评估中具有重要意义。

四、自助法(Bootstrap method)自助法是一种有放回的抽样方法,即从原始样本数据集中随机抽取一个样本后,将其放回。

这样的操作重复多次,得到一个新的自助样本数据集。

由于每次抽样可能会重复抽取同一个样本,自助法得到的样本集中约有36.8%的样本没有被抽到,用于对模型的验证。

自助法能够较好地利用样本数据进行模型的评估,不需要额外的测试集,但会引入估计偏差。

【机器学习】图解机器学习中的12种交叉验证技术

【机器学习】图解机器学习中的12种交叉验证技术今天我给大家盘点下机器学习中所使用的交叉验证器都有哪些,用最直观的图解方式来帮助大家理解他们是如何工作的。

数据集说明数据集来源于kaggle M5 Forecasting - Accuracy[1]该任务是尽可能精确地预测沃尔玛在美国销售的各种产品的单位销售额(demand)。

本文将使用其中的一部分数据。

该数据样例如下。

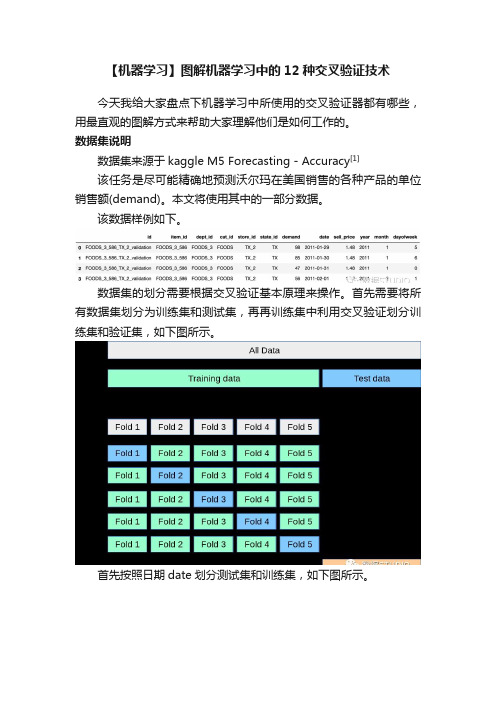

数据集的划分需要根据交叉验证基本原理来操作。

首先需要将所有数据集划分为训练集和测试集,再再训练集中利用交叉验证划分训练集和验证集,如下图所示。

首先按照日期date划分测试集和训练集,如下图所示。

为本次演示需求,创造了一些新的特征,最终筛选并使用了如下几个变量。

Training columns:['sell_price', 'year', 'month', 'dayofweek', 'lag_7','rmean_7_7', 'demand_month_mean', 'demand_month_max', 'demandmonth_max_to_min_diff', 'demand_dayofweek_mea n','demand_dayofweek_median', 'demand_dayofweek_max']设置如下两个全局变量,以及用来存储每种交叉验证得分结果的DataFrameSEED = 888 # 为了再现NFOLDS = 5 # 设置K折验证的折数stats = pd.DataFrame(columns=['K-Fold Variation','CV-RMSE','TEST-RMSE'])交叉验证交叉验证(Cross Validation) 是在机器学习建立模型和验证模型参数时常用的方法。

统计学习理论中的泛化误差估计

统计学习理论中的泛化误差估计统计学习理论是机器学习的基础理论之一,它的目标是通过从有限的训练数据中学习到一种能够适应未知数据的模型。

在统计学习中,泛化误差是评估一个学习算法性能的重要指标。

1. 简介泛化误差是指学习算法在未知数据上的误差,即模型对新的样本数据的适应能力。

泛化误差估计的目的是通过训练数据来估计模型在未知数据上的误差,以便选择一个适合的模型。

2. 经验误差与泛化误差学习算法在训练集上的误差被称为经验误差,它可以表示为模型与训练样本之间的拟合程度。

然而,经验误差并不能很好地反映模型在未知数据上的表现,因为模型可能出现过拟合或欠拟合的情况。

过拟合是指模型过于复杂,在训练数据上表现良好,但对新数据的泛化能力较差。

欠拟合是指模型过于简单,不能很好地拟合训练数据,因此在新数据上也表现较差。

3. 泛化误差估计方法为了准确地估计模型的泛化误差,统计学习理论提出了一些方法,包括留出法、交叉验证法和自助法等。

3.1 留出法留出法是将数据集划分为训练集和验证集两部分,其中训练集用于训练模型,验证集用于评估模型的性能。

通过计算模型在验证集上的误差,可以近似地估计模型的泛化误差。

3.2 交叉验证法交叉验证法是将数据集划分为k个互不重叠的子集,其中k-1个子集用于训练模型,剩下的一个子集用于验证模型。

重复k次后,将k 次验证结果的平均值作为模型的泛化误差估计。

3.3 自助法自助法通过从原始数据集中有放回地抽样得到新的数据集,新数据集与原始数据集大小相同。

由于自助法的抽样方式,新数据集中大约有36.8%的样本不会出现在原始数据集中,这些未出现的样本可以用于模型的泛化误差估计。

4. 正则化与泛化误差正则化是一种通过在模型的损失函数中加入正则项来控制模型复杂度的方法。

正则化可以有效防止过拟合,提高模型的泛化能力。

5. 总结泛化误差估计是统计学习理论中重要的内容之一。

通过合适的泛化误差估计方法,我们可以选择出适合的模型,从而提高机器学习算法的性能。

估计泛化误差典型做法

估计泛化误差典型做法估计泛化误差典型做法泛化误差是指模型在新数据上的表现能力,而不是在训练数据上的表现能力。

因此,对于机器学习模型来说,估计泛化误差是非常重要的。

本文将介绍一些常见的估计泛化误差的方法。

一、留出法留出法是最简单的估计泛化误差的方法之一。

它将数据集划分为两个互斥的集合:训练集和测试集。

训练集用于训练模型,测试集用于评估模型性能。

留出法有一个缺点,即它对数据划分非常敏感。

如果测试集和训练集之间存在很大偏差,则无法准确估计模型在新数据上的表现能力。

二、交叉验证法交叉验证法是一种更可靠的估计泛化误差方法。

它通过多次重复地将数据划分为训练和测试集,并对每个子集进行评估来得到一个更准确的估计值。

交叉验证法有三种主要形式:k折交叉验证、留一交叉验证和自助法。

1. k折交叉验证k折交叉验证将数据集划分为k个互斥的子集,其中k-1个子集用于训练模型,另一个子集用于测试模型。

这个过程重复k次,每次选择不同的测试集。

最后将k次测试结果的平均值作为模型性能的估计值。

2. 留一交叉验证留一交叉验证是k折交叉验证的特殊情况,其中k等于数据集大小。

每个样本都被用作测试数据,其余样本用于训练模型。

留一交叉验证非常耗时,但对于小数据集来说是一个很好的选择。

3. 自助法自助法是一种基于重采样技术的方法。

它通过从原始数据集中随机抽取n个样本进行训练,并将n个样本放回原始数据集中。

这个过程重复m次,每次选择不同的训练子集。

最后将m次测试结果的平均值作为模型性能的估计值。

自助法可以在数据量较小或存在严重偏差时提供更准确的估计。

三、自适应正则化方法自适应正则化方法是一种通过调整正则化参数来控制泛化误差的方法。

它可以根据不同数据集和模型来自动调整正则化参数。

自适应正则化方法有两种主要形式:岭回归和Lasso回归。

1. 岭回归岭回归是一种基于L2正则化的线性回归方法。

它通过添加一个惩罚项来限制模型的复杂度,从而减少过拟合。

岭回归的优点是可以处理高维数据,并且可以通过交叉验证来选择最佳正则化参数。

机器学习模型的泛化性能评估方法研究

机器学习模型的泛化性能评估方法研究引言:在机器学习领域,泛化性能评估是评估一个训练出来的模型对未知数据的预测能力的重要指标。

泛化性能评估方法的选择对于机器学习算法的研究和应用具有重要意义。

本文将介绍几种常见的机器学习模型的泛化性能评估方法,并进行比较和分析。

一、交叉验证方法交叉验证是一种常见且被广泛使用的泛化性能评估方法。

它将原始数据集划分为训练集和验证集,在训练集上训练模型,再在验证集上评估模型的性能。

常见的交叉验证方法有K折交叉验证和留一交叉验证。

K折交叉验证将数据集分成K个大小相等的子集,每次选取一个子集作为验证集,其余的K-1个子集作为训练集,然后计算模型在验证集上的性能指标,如准确率、精确率、召回率等。

重复K次,最后取K次结果的平均值作为模型的性能评估指标。

留一交叉验证是K折交叉验证的特殊情况,当K等于数据集的大小时,每个样本都被作为验证集一次。

这种方法在数据集较小的情况下比较适用,但计算开销较大。

二、自助法自助法是一种通过自助采样来估计模型性能的方法。

在自助法中,从原始数据集中有放回地采样出m个样本,形成一个新的训练集。

由于采样时有放回,部分样本可能被多次采样,而部分样本可能被完全遗漏。

原始数据集中未被采样到的样本则作为验证集进行模型性能评估。

自助法的优势在于能够更好地利用数据集,尤其是在数据集较小的情况下。

但自助采样引入的模型训练数据与原始数据集的差异可能会导致对模型性能的估计存在偏差。

三、留出法留出法是将原始数据集划分为训练集和验证集的方法。

通常将数据集按照一定比例划分,如70%的数据用于训练,30%的数据用于验证。

然后在训练集上训练模型,在验证集上评估模型的性能。

留出法的优点在于简单、直观,并且不需要重复计算。

然而,由于划分比例的不合理或者验证集选取的不恰当,可能会导致模型性能评估结果不准确。

四、Bootstrap方法Bootstrap方法是一种基于自助法的改进方法。

在Bootstrap方法中,通过自助采样形成m个训练集,然后使用这些训练集训练模型,并将模型应用于验证集。

交叉检验方法讲义

交叉检验方法讲义交叉检验方法是为了验证模型的效果和泛化能力而提出的一种评估方法。

它通过将数据集分为若干个互斥的子集,在不同的子集上进行训练和测试,来评估模型在未见过的数据上的表现。

交叉检验方法在机器学习和数据挖掘领域广泛应用,可有效地评估模型的性能。

常见的交叉检验方法主要包括k折交叉验证、留一法和随机划分。

下面将分别介绍这些方法及其特点。

1.k折交叉验证:将数据集分成k个大小相等的子集,每次使用k-1个子集进行训练,剩下的一个子集作为测试集。

重复k次,每次选择不同的子集作为测试集,最后将k次测试结果的平均值作为最终模型的性能评估指标。

k折交叉验证能够更充分地利用数据,减少因数据划分不合理而引入的偏差。

但是计算量较大,特别是在数据量较大时。

2.留一法:将数据集中的每个样本都作为测试集,其余样本作为训练集。

这种方法适用于数据集较小或者计算资源有限的情况。

留一法的缺点是计算量非常大,特别是在大数据集上。

3.随机划分:将数据集随机划分为训练集和测试集。

常见的划分比例是70%或80%的数据作为训练集,剩余的作为测试集。

随机划分方法简单快捷,计算量较小。

但是由于划分的随机性,可能会导致模型评估结果不稳定。

交叉检验方法的优点在于能够充分利用数据集,并在一定程度上消除数据划分的偏差。

交叉检验方法能够更客观地评估模型的泛化能力以及对未知数据的适应能力。

但是交叉检验方法也有一些缺点,例如计算量较大、无法保证每次划分的数据集是全新的、对于不平衡数据集可能导致评估结果不准确等。

为了更好地评估模型的性能,可以结合不同的交叉检验方法进行综合评估。

例如,可以使用k折交叉验证进行模型选取,然后使用留一法进行模型的最终评估。

此外,还可以使用交叉检验方法进行模型参数的选择,以得到更好的模型性能。

总结起来,交叉检验方法能够更全面、客观地评估模型的性能,可以解决数据划分不合理带来的偏差问题。

但是也需要注意交叉检验方法的计算量和数据集的特点,选择合适的方法进行模型的评估。

统计学习理论中的泛化误差估计

统计学习理论中的泛化误差估计概述在统计学习中,泛化误差估计是一个重要的概念。

泛化误差指的是模型在新样本上的预测误差。

为了有效应用统计学习算法,需要对模型的泛化误差进行估计。

本文将介绍几种常用的泛化误差估计方法,并探讨其优缺点。

一、交叉验证交叉验证是常用的泛化误差估计方法之一。

其基本思想是将数据集分成训练集和测试集两部分,利用训练集训练模型,然后利用测试集评估模型的性能。

常见的交叉验证方法包括k折交叉验证、留一交叉验证等。

k折交叉验证将数据集分成k个大小相等的子集,依次选取其中一个子集作为测试集,其余k-1个子集作为训练集,重复k次,最终得到k个模型。

将测试集上的误差平均作为泛化误差的估计值。

留一交叉验证是k折交叉验证的一个特例,当k等于样本数n时,即每次只留下一个样本作为测试集,其余n-1个样本作为训练集。

留一交叉验证的优点是在样本量较小时能够更好地估计泛化误差,但计算量较大。

二、自助法自助法是一种基于有放回抽样的泛化误差估计方法。

其基本思想是对于包含n个样本的数据集,我们进行n次有放回抽样,每次抽样得到的样本作为训练集,未被抽到的样本作为测试集。

这样,每个样本在平均而言约有36.8%的概率不被抽到,可作为我们对泛化误差的估计。

自助法的优点是能够更好地使用有限的数据集,但它引入了自助样本的相关性,可能导致估计偏差。

在样本量较大时,自助法与交叉验证方法相比,计算效率相对较低。

三、调参曲线调参曲线是一种寻找最优模型参数的方法,同时也可以用于泛化误差的估计。

通过观察不同参数取值下模型在训练集和测试集上的性能变化,可以了解模型对参数的敏感性,并选择最优参数。

常见的调参曲线包括学习曲线和验证曲线。

学习曲线用于观察训练集和测试集上的误差随样本数量的变化情况,当两者的误差收敛且相对较低时,可以认为模型具有较好的泛化能力。

验证曲线用于观察模型在不同参数取值下的性能变化,选择使测试集误差最小的参数取值。

调参曲线的优点是能够同时估计模型的泛化误差和寻找最优参数,但需要根据具体问题选取适当的曲线进行分析,且计算过程相对较为复杂。

交叉验证应用实例-概述说明以及解释

交叉验证应用实例-概述说明以及解释1.引言1.1 概述概述:交叉验证是一种用于评估模型性能和泛化能力的重要机制。

它通过将数据集分割成多个子集,轮流将其中一个子集作为测试集,其余子集作为训练集,在不同的训练集上训练模型,并在测试集上评估模型性能,从而减少由于数据分布不均匀而引起的误差,提高模型的泛化能力。

在实际应用中,交叉验证被广泛应用于机器学习、数据挖掘、统计分析等领域,用于评估模型的准确性和稳定性。

通过交叉验证,我们可以更加客观地评估模型的性能,选择最佳的模型参数,避免过拟合和欠拟合等问题,提高模型的预测能力和泛化能力。

本文将通过介绍交叉验证的定义和原理、应用场景,以及交叉验证在实际问题中的具体应用实例,来展示交叉验证在模型评估和选择中的重要作用以及其在解决实际问题中的价值和意义。

1.2文章结构文章结构部分将主要包括以下内容:1. 引言:介绍文章的研究背景和意义,以及交叉验证在机器学习中的重要性和应用范围。

2. 正文:- 交叉验证的定义和原理:详细阐述交叉验证的概念和工作原理,包括K折交叉验证和留一交叉验证等方法。

- 交叉验证的应用场景:介绍交叉验证在不同领域和问题中的应用情况,以及其在模型评估和参数调优中的重要作用。

3. 结论:- 交叉验证的优势和局限性:总结交叉验证的优点和局限性,探讨其在实际问题中的应用有哪些限制和挑战。

- 交叉验证在实际问题中的应用实例:通过具体的案例分析或实验结果展示,展示交叉验证在解决真实问题中的有效性和可靠性。

1.3 目的本文的目的是探讨交叉验证在实际问题中的应用实例,通过具体案例分析展示交叉验证在机器学习和数据分析领域的重要性和效果。

通过实际的案例分析,读者可以更加直观地了解交叉验证的原理和应用,为他们在实际工作中的决策和处理问题提供参考依据。

同时,本文也旨在引起研究者和从业者对于交叉验证方法的重视,促进其在实际问题解决中的广泛应用。

通过深入研究和讨论,探索交叉验证方法在不同领域的应用方式,为读者提供更多启发和思考。

交叉验证法

交叉验证法交叉验证法(Cross-Validation)是一种常见的机器学习算法评估方法。

在实际应用中,我们通常需要对模型进行评估和比较,以选择最优模型。

交叉验证法是一种常用的模型评估方法,能够更加客观地评估模型的性能,并提高模型的泛化能力。

本文将详细介绍交叉验证法的原理、步骤和应用。

一、交叉验证法的原理交叉验证法是一种通过反复使用数据样本进行训练、测试的方法,来评估模型预测性能的方法。

其基本原理是将数据集分为训练集和测试集,然后使用训练集进行模型训练,使用测试集进行模型评估,以此来评估模型的泛化能力。

在交叉验证法中,我们通常将数据集分为 K 个等分,其中 K-1 个等分作为训练集,剩下的 1 个等分作为测试集。

然后,我们对这些等分进行 K 次循环,每次选取不同的测试集,其他等分作为训练集,最终得到 K 个测试结果的平均值。

二、交叉验证法的步骤1.数据准备:将数据集划分为训练集和测试集。

2.模型训练:使用训练集进行模型训练。

3.模型测试:使用测试集对模型进行测试,得到测试结果。

4.模型评估:计算模型的性能指标,如准确度、精确度、召回率、F1 值等。

5.模型优化:根据模型评估结果,对模型进行优化,如调整模型参数、改变模型结构等。

6.重复步骤 2-5,直到得到最优模型。

三、交叉验证法的应用交叉验证法可以应用于各种机器学习算法的评估和比较,如分类、回归、聚类等。

下面以分类问题为例,介绍交叉验证法的应用。

1.分类问题在分类问题中,我们通常使用准确度、精确度、召回率、F1 值等指标来评估模型性能。

通过交叉验证法,我们可以计算出模型在不同数据集上的性能指标,以此来评估模型的泛化能力。

2.回归问题在回归问题中,我们通常使用均方误差、均方根误差等指标来评估模型性能。

通过交叉验证法,我们可以计算出模型在不同数据集上的性能指标,以此来评估模型的泛化能力。

3.聚类问题在聚类问题中,我们通常使用轮廓系数、Davies-Bouldin 系数等指标来评估模型性能。

支持向量机模型的泛化能力评估方法(八)

支持向量机(Support Vector Machine,简称SVM)是一种非常强大的机器学习算法,常用于分类和回归分析。

它在处理线性和非线性数据上都表现出色,并且在实际应用中取得了很好的效果。

然而,作为一种复杂的算法模型,SVM在泛化能力评估方面也面临着一些挑战。

本文将介绍支持向量机模型的泛化能力评估方法,并探讨如何有效地评估SVM模型在未知数据上的表现。

## 1. 交叉验证在评估SVM模型的泛化能力时,交叉验证是一种常用的方法。

交叉验证通过将数据集分为训练集和测试集,并重复多次实验来评估模型的性能。

其中,最常见的是K折交叉验证,即将数据集分为K个子集,然后依次将每个子集作为测试集,其余K-1个子集作为训练集,最终得到K个模型性能评估结果的平均值。

通过交叉验证,可以有效地评估SVM模型在不同数据集上的表现,减少因数据集划分不合理而引起的偶然性误差,提高泛化能力评估的准确性。

## 2. 留出法除了交叉验证,留出法也是一种常用的泛化能力评估方法。

留出法将数据集划分为训练集和验证集两部分,然后使用验证集来评估模型的性能。

由于该方法简单直观,因此在实际应用中也得到了广泛的应用。

然而,留出法也存在一些局限性,比如对数据集的划分方式敏感,可能会导致模型性能评估的不稳定性。

因此,在使用留出法进行泛化能力评估时,需要格外注意数据集的划分方式,以尽量减少偶然性误差的影响。

## 3. 自助法除了交叉验证和留出法,自助法也是一种常用的泛化能力评估方法。

自助法通过有放回地从原始数据集中抽取样本,构建多个不同的训练集,然后使用这些训练集来评估模型的性能。

由于自助法不需要对原始数据集进行划分,因此可以更好地利用数据,减少了因数据划分不合理而引起的偶然性误差。

然而,自助法也存在一些缺点,比如引入了自相关样本,使得模型性能评估的方差增大。

因此,在使用自助法进行泛化能力评估时,需要对模型性能评估结果进行一定的修正,以减少自相关样本引入的偏差。

泛化误差的各种交叉验证估计方法综述

优先出版 计 算 机 应 用 研 究 第32卷--------------------------------基金项目:国家自然科学基金资助项目(11171169);山西省科技基础条件平台建设项目(2013091003-0101)作者简介:杨柳(1979-),女,山西临汾人,讲师,硕士,主要研究方向为统计机器学习、概率统计(yang_liu@);王钰(1981-),男,讲师,硕士,主要研究方向为机器学习.泛化误差的各种交叉验证估计方法综述杨 柳1,王 钰2(1.山西财经大学 应用数学学院,太原 030031;2.山西大学 计算机中心,太原 030006)摘 要:在机器学习中,泛化误差(预测误差)是用于算法性能度量的最常用指标,然而,由于数据的分布未知,泛化误差不能被直接计算。

现实中常常通过各种形式的交叉验证方法来估计泛化误差。

详细地分析了泛化误差的各交叉验证估计方法的优缺点,对照了各种方法之间的差异,提出和分析了各方法中有待进一步研究的问题和方向。

关键词:机器学习;泛化误差;交叉验证;偏差;方差 中图分类号:TP181 文献标志码:ASurvey for various cross-validation estimators of generalization errorYANG Liu 1, WANG Yu 2(1. School of Applied Mathematics, Shanxi University of Finance & Economics, Taiyuan 030031, China; 2. Computer Center of Shanxi University, Taiyuan 030006, China)Abstract: In machine learning, generalization error is a commonly used index for measuring the performance of algorithm. However, due to unknown data distribution, generalization error may not be directly computed. In practice, it is often estimated by various cross-validation methods. The advantages and disadvantages of the cross-validation estimators of generalization error are analyzed in detail. The difference of various methods are compared. The future research problems and directions are also put forward and analyzed.Key Words: machine learning; generalization error; cross-validation; bias; variance0 引言在机器学习 (有监督学习) 的研究中,主要有三大目标: 特征选择,从所有特征中选择出一个小的特征子集,以便构造一个好的分类器;分类器 (算法) 选择,估计不同分类器的性能,从中选出最好的分类模型;模型评估,对已经选定的分类器,估计它在新数据上的预测误差。

最全交叉验证实验_公开普及版

交叉验证--Cross validation交叉验证(Cross validation),有时亦称循环估计,是一种统计学上将数据样本切割成较小子集的实用方法。

于是可以先在一个子集上做分析,而其它子集则用来测试训练得到的模型(model),以此来做为评价分类器的性能指标。

一开始的子集被称为训练集。

而其它的子集则被称为验证集或测试集。

交叉验证是一种评估统计分析、机器学习算法对独立于训练数据的数据集的泛化能力(generalize)。

交叉验证一般要尽量满足:训练集的比例要足够多,一般大于一半训练集和测试集要均匀抽样其中第2点特别重要,均匀取样的目的是希望减少training/test set与完整集合之间的偏差(bias),但却也不易做到。

一般的作法是随机取样,当样本数量足够时,便可达到均匀取样的效果。

然而随机也正是此作法的盲点,也是经常是可以在数据上做手脚的地方。

举例来说,当辨识率不理想时,便重新取样一组training set与test set,直到test set的辨识率满意为止,但严格来说这样便算是作弊了交叉验证主要分成以下几类:1)Hold-Out Method将原始数据随机分为两组,一组做为训练集,一组做为验证集,利用训练集训练分类器,然后利用验证集验证模型,记录最后的分类准确率为此Hold-OutMethod下分类器的性能指标.此种方法的好处的处理简单,只需随机把原始数据分为两组即可,其实严格意义来说Hold-Out Method并不能算是CV,因为这种方法没有达到交叉的思想,由于是随机的将原始数据分组,所以最后验证集分类准确率的高低与原始数据的分组有很大的关系,所以这种方法得到的结果其实并不具有说服性.2)K-fold cross-validation:将原始数据分成K组(一般是均分),将每个子集数据分别做一次验证集,其余的K-1组子集数据作为训练集,这样会得到K个模型,用这K个模型最终的验证集的分类准确率的平均数作为此K-CV下分类器的性能指标。

如何使用交叉验证来评估模型的泛化能力?

交叉验证是一种评估模型泛化能力的关键技术。

通过将数据分成多个部分,它允许模型在一个子集上进行训练,并在另一个不同的子集上进行测试。

这种方法可以减少模型的偶然误差和偏差,因为模型要在多轮不同的训练和测试集上证明其预测一致性。

理解和应用交叉验证,可以让我们从多个角度评估模型性能,从而获得对模型泛化能力的深入了解。

在这篇文章的第一部分中,我们将介绍交叉验证的基础知识和它如何工作。

从数据划分的理论讨论开始,至如何应用单轮和多轮的交叉验证技术,我们将逐步了解交叉验证流程和它如何帮助我们进行模型评估。

第二部分将聚焦于如何通过交叉验证结果来诊断模型问题,如过拟合和欠拟合。

我们将探讨如何使用学习曲线来可视化交叉验证中的多重练测试结果,了解模型在不同训练集大小时的表现,以及如何解释结果来优化模型参数。

最后,在第三部分,我们会具体讨论如何利用交叉验证的结果来优化模型的泛化能力。

这将包括选择合适的模型复杂度、正则化技术、和特征工程方法。

此外,我们也会探讨超参数调优过程中交叉验证的应用,以及如何通过自动化工具来简化这一过程。

通过本文,读者可以期望对交叉验证的理论有一个全面的理解,并且能够应用这些知识来提升自己在机器学习项目中模型评估的实践能力。

正如我们在第一部分中讨论的,交叉验证是一种强大的技术,用于评估模型的泛化能力。

继续我们关于交叉验证的探讨,第二部分将集中在如何利用交叉验证来诊断模型问题,特别是过拟合和欠拟合。

通过交叉验证,我们能够了解模型在不同训练测试拆分上的性能,从而为模型调优提供实证基础。

过拟合是机器学习中一个常见问题,当模型对训练数据学习得太好,以至于它捕捉到了数据中的噪声而不仅仅是底层分布特征。

这导致模型在新数据上的表现不佳。

欠拟合则是模型太过简单,不能捕捉到数据的基本结构,同样导致泛化性能差。

在交叉验证中,我们可以通过多个不同的数据子集来检测这两种情况。

如果模型在所有的训练集上表现都非常好,但在验证集上结果差强人意,那很可能就是过拟合。

交叉验证技术

交叉验证技术交叉验证技术(Cross-validation)是机器学习领域中常用的一种模型评估方法,是在给定的数据集上评估模型的泛化性能的一种方法。

本文将从什么是交叉验证、交叉验证的作用、交叉验证的步骤、交叉验证的优缺点等方面进行阐述。

一、什么是交叉验证数据集通常被分成训练集和测试集。

训练集用来训练模型,测试集作为新数据,用来测试模型的泛化能力。

交叉验证就是将数据集分成k份,其中k-1份被用作训练数据,剩下的一份用来测试模型。

如此重复k次,每次都用不同的测试集,将得到k个性能指标的平均值作为模型的性能指标。

二、交叉验证的作用最初的数据集有时候可能比较小,只是一小部分数据。

如果这样,用部分数据进行训练得到的模型可能并不好用。

而且,这样得到的模型在新数据集上的准确性很难保证。

为了避免这个问题,我们可以使用交叉验证,它可以在不增加数据集的数量时,提高模型的准确性和性能。

三、交叉验证的步骤1.将原始数据分成k份。

2.将其中的一份作为测试集,其余的作为训练集。

3.用训练集的数据训练模型,并对测试集进行测试。

4.计算模型的性能指标。

5.重复第二步到第四步k次,得到每次测试的性能指标。

6.计算k次性能指标的平均值,得到模型的性能指标。

四、交叉验证的优缺点1.优点a.交叉验证可以充分利用原始数据,提高模型的准确性。

b.经过多次重复训练和测试,可以减小误差,避免单一的评估方式对模型的评估松散。

2.缺点a.交叉验证需要更多的计算资源。

b.当数据集过大时,交叉验证可能会导致训练和测试的时间开销非常大。

c.在交叉验证过程中,训练集和测试集是交叉的,但是在某些情况下,这种交叉会导致误差的扭曲,影响其训练和测试的效果。

总之,交叉验证是一种用于评估机器学习模型性能和准确度的有用技术,虽然可能需要更多的计算资源,但其准确性比传统的评估方法更加可靠。

在实际应用中,我们需要选择适当的k值,避免数据集过大导致计算资源浪费,从而得到准确的模型性能评估。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

优先出版 计 算 机 应 用 研 究 第32卷

--------------------------------

基金项目:国家自然科学基金资助项目(11171169);山西省科技基础条件平台建设项目(2013091003-0101)

作者简介:杨柳(1979-),女,山西临汾人,讲师,硕士,主要研究方向为统计机器学习、概率统计(yang_liu@);王钰(1981-),男,讲师,硕士,主要研究方向为机器学习.

泛化误差的各种交叉验证估计方法综述

杨 柳1,王 钰2

(1.山西财经大学 应用数学学院,太原 030031;2.山西大学 计算机中心,太原 030006)

摘 要:在机器学习中,泛化误差(预测误差)是用于算法性能度量的最常用指标,然而,由于数据的分布未知,泛化误差不能被直接计算。

现实中常常通过各种形式的交叉验证方法来估计泛化误差。

详细地分析了泛化误差的各交叉验证估计方法的优缺点,对照了各种方法之间的差异,提出和分析了各方法中有待进一步研究的问题和方向。

关键词:机器学习;泛化误差;交叉验证;偏差;方差 中图分类号:TP181 文献标志码:A

Survey for various cross-validation estimators of generalization error

YANG Liu 1, WANG Yu 2

(1. School of Applied Mathematics, Shanxi University of Finance & Economics, Taiyuan 030031, China; 2. Computer Center of Shanxi University, Taiyuan 030006, China)

Abstract: In machine learning, generalization error is a commonly used index for measuring the performance of algorithm. However, due to unknown data distribution, generalization error may not be directly computed. In practice, it is often estimated by various cross-validation methods. The advantages and disadvantages of the cross-validation estimators of generalization error are analyzed in detail. The difference of various methods are compared. The future research problems and directions are also put forward and analyzed.

Key Words: machine learning; generalization error; cross-validation; bias; variance

0 引言

在机器学习 (有监督学习) 的研究中,主要有三大目标: 特征选择,从所有特征中选择出一个小的特征子集,以便构造一个好的分类器;分类器 (算法) 选择,估计不同分类器的性能,从中选出最好的分类模型;模型评估,对已经选定的分类器,估计它在新数据上的预测误差。

无论是对于哪个学习任务,算法性能的度量是关键。

而泛化误差就是其中最广泛使用的一种性能指标,所谓泛化误差 (generalization error) 指的是在独立测试样本上的期望预测误差,也被称为测试误差 (test error) 或预测误差 (prediction error) [1

,2]。

然而,在实际应用中,我们很难

得到样本的精确分布,因此也无法来直接计算泛化误差,基于训练样本上的平均损失的训练误差显然是它的一个直接的估计,遗憾的是训练误差是泛化误差的一个很差的估计 (过分乐观估计),因为训练误差随着模型复杂度的增加而减小,直至减小到0。

为此,一些学者通过对训练误差改进提出了传统学习中广泛使用的诸如AIC ,BIC 等的解析估计样本内误差的方法

[3-5]。

近些年,一类通过样本重用来直接估计泛化误差的方法被

提出,如交叉验证 (cross validation),自助法 (bootstrap) [1,6]。

交叉验证方法是其中最简单且被广泛使用的方法,也因此

得到了更多学者的关注,各种不同形式的交叉验证方法被提出,包括最早的留一交叉验证,标准K 折交叉验证,RLT (Repeated Learning Testing) 交叉验证,蒙特卡罗(Monte-Carlo) 交叉验证,Bootstrap 交叉验证,5×2交叉验证,组块3×2交叉验证等[7-17]。

1 泛化误差的定义及其记号

假定数据集D={z 1,z 2,…,z n }是从一个未知的分布P 中独立抽样得到的样本,其中z i =(x i ,y i )∈Z ⊆R p+1,x i 是p 维输入向量,y i 是一维输出变量。

令f=A(D)表示在数据集D 上训练由算法A 返回的预测函数,损失函数L(A(D),z)= L(A(D),(x ,y))= Q(A(D)(x),y)表示预测A(D)(x)与观测y 之间差异的度量,例如:对于分类问题, Q(ŷ,y)=I(ŷ≠y),其中I 表示示性函数;在回归情形,Q(ŷ ,y)=‖ŷ –y ‖2 。

这样,算法A 的泛化误差定义为:

µ(n)=EPE(n)=E[L(A(D),z)]

(1)

这里对D 和z 都取期望,其中z 也是从分布P 中独立于D 抽样得到的样本。

(1)式中的期望意味着我们是对一个算法的一般性能感兴趣,而不是仅考虑手边某个特定数据集上算法的性能。

文章预览已结束

获取全文请访问

/article/02-2015-06-001.html。