一种采用线性递减步长的自组织迁移算法

barzilar-borwein方法

barzilar-borwein方法关于Barzilai-Borwein方法的详细解释和应用引言:在数值计算和优化问题中,我们经常遇到需要求解最小化目标函数的问题。

其中,Barzilai-Borwein方法是一种非常有效的迭代优化算法,它可以用于解决无约束和约束优化问题。

本文将详细介绍Barzilai-Borwein方法的原理和应用,并且逐步解释算法的具体步骤和示例。

一、Barzilai-Borwein方法的原理:Barzilai-Borwein方法是一种基于梯度信息的一阶优化算法。

它的核心思想是利用最近两次迭代的梯度信息来计算下一次迭代步长,从而加速优化过程。

Barzilai-Borwein方法首先计算最近两次迭代之间的梯度差值,并通过一定的规则计算得到下一次迭代的步长。

具体的计算步骤如下:1. 初始化参数:将初始点设置为x0,并设置一个合适的步长t02. 计算初始梯度:计算目标函数在初始点x0处的梯度gk3. 更新参数:根据一定的规则,计算下一次迭代的步长tk+14. 迭代:使用新的步长tk+1计算下一次迭代的点xk+15. 判断收敛:判断是否满足收敛条件,如果满足则停止迭代;否则返回步骤2继续迭代。

二、Barzilai-Borwein方法的应用:Barzilai-Borwein方法可以广泛应用于各种优化问题中,特别是在凸优化和非线性优化问题中取得了很好的性能。

下面将以凸优化问题为例,详细介绍Barzilai-Borwein方法的应用过程。

假设我们需要最小化一个凸目标函数f(x),其中x为优化变量,目标是找到使得目标函数最小化的x*。

首先,我们需要计算目标函数在初始点x0处的梯度gk,并初始化步长t0。

具体的迭代过程如下:1. 初始化参数:将初始点设置为x0,并设置一个合适的步长t0。

2. 计算初始梯度:计算目标函数在初始点x0处的梯度gk。

3. 更新参数:根据以下计算规则,计算下一次迭代的步长tk+1:tk+1 = (xk - xk-1)'(gk - gk-1) / gk - gk-1 ^2其中, ... 表示向量的范数计算,'表示向量的转置。

一种采用线性递减步长的自组织迁移算法

一种采用线性递减步长的自组织迁移算法翁纯毅;李元香;王玲玲;林志毅【期刊名称】《计算机工程与应用》【年(卷),期】2011(047)018【摘要】Self-Organizing Migrating Algorithm(SOMA) is a kind of new swarm intelligent algorithm. After analyzing the basic self-organizing migrating algorithm and modified self-organizing migrating algorithm with random mutation step,this paper proposes a improved self-organizing migrating algorithm with linear-digress step. The algorithm accelerates the convergence ratio of swarm in multi-modal complex space and enhances the ability of local search by adjusting step length dynamic and linear under some directions.Experiments reveal that the proposed algorithm behaves better than the self-organizing migrating algorithm with random mutation step and the basic one.%自组织迁移算法(SOMA)是一种新型的群体智能算法.在对原始自组织迁移算法分析的基础上,针对基于随机变异步长的自组织迁移算法存在的不足,提出了线性递减步长策略,即有针对性地以线性方式动态调整步长,以满足群体迭代在不同阶段的需求,从而加速群体在多峰复杂空间中收敛速度的同时提高算法的局部搜索能力.实验结果表明,该算法优于原始自组织迁移算法和基于随机变异步长的自组织迁移算法.【总页数】4页(P26-28,111)【作者】翁纯毅;李元香;王玲玲;林志毅【作者单位】武汉大学,软件工程国家重点实验室,武汉,430072;武汉大学,软件工程国家重点实验室,武汉,430072;武汉大学,软件工程国家重点实验室,武汉,430072;广东工业大学,计算机学院,广州,510006【正文语种】中文【中图分类】TP312【相关文献】1.一种改进的线性递减权值的粒子群优化算法 [J], 崔新于;田梓君2.一种非线性递减惯性权重策略的粒子群优化算法 [J], 李会荣;高岳林;李济民3.采用随机变异步长的改进自组织迁移算法 [J], 柯晶;李歧强;乔谊正4.一种非线性变步长LMS自适应滤波算法 [J], 仝喜峰;陈卫松;钱隆彦;肖梦迪5.一种基于步长指数递减策略的果蝇优化算法 [J], 秋兴国;黄润青因版权原因,仅展示原文概要,查看原文内容请购买。

自适应步长算法

自适应步长算法是一种用于调整步长的算法,以适应不同的环境和条件。

这种算法可以根据当前的状态和环境信息,动态地调整步长,以优化算法的性能。

自适应步长算法通常用于各种优化问题中,如梯度下降法、遗传算法等。

通过自适应调整步长,可以加快收敛速度,提高算法的效率。

在自适应步长算法中,通常会设定一个初始步长,并根据当前的状态和环境信息,动态地调整步长。

调整的方式可以是线性的、非线性的或者其他方式。

例如,在梯度下降法中,可以根据梯度的方向和大小来动态调整步长,以加快收敛速度。

自适应步长算法通常具有较好的鲁棒性和适应性,可以在不同的环境和条件下表现出较好的性能。

但是,由于需要动态调整步长,因此可能会增加计算的复杂度。

因此,在选择自适应步长算法时,需要根据具体的问题和环境来权衡其优缺点。

迭代迁移的原理

迭代迁移是一种机器学习方法,它涉及到将模型的训练过程从一个数据集迁移到另一个数据集上。

这种方法通常用于处理数据分布的变化或者在源域和目标域之间存在差异的情况。

其核心思想是利用源域中学习到的知识来帮助在目标域上进行训练。

以下是一些迭代迁移的主要原理和步骤:

1. 源域和目标域:

源域(Source Domain)是指拥有大量训练数据的领域,在这里模型可以学习到通用的特征表示。

目标域(Target Domain)是指新的数据分布,模型需要在这个域上进行实际的任务。

2. 初始化:

首先在源域上训练一个初始模型,这个模型能够捕捉到源域数据的主要特征。

3. 知识迁移:

将这个初始模型应用到目标域上,用目标域的数据对模型进行微调,这一步通常使用较小的数据集进行。

微调的过程中,模型的参数会根据目标域的数据进行调整,以适应该新的数据分布。

4. 迭代过程:

重复上述过程,每次迭代都在源域上重新训练模型,然后将其迁移到目标域上进行微调。

每次迭代后,模型都会变得更加适应目标域的数据分布。

5. 性能评估:

在每个迭代步骤后,评估模型在目标域上的性能,确保它能够达到满意的准确率或性能标准。

6. 停止条件:

迭代迁移过程在达到预设的性能目标或者迭代次数上限时停止。

迭代迁移的关键在于不断利用源域的知识来改进目标域的模型,同时保留目标域数据的特点。

这种方法尤其适用于那些在源域和目标域之间存在差异,但是又无法获取大量目标域数据的场景。

通过迭代,模型能够逐步适应目标域的数据分布,提高在目标域上的性能。

gradientboostingregressor原理

gradientboostingregressor原理Gradient Boosting Regressor是一种机器学习算法,属于集成学习方法中的增强学习(Boosting)算法。

本文将详细介绍Gradient Boosting Regressor的原理,从基本概念出发,一步一步回答关于这一算法的问题。

1. 什么是Gradient Boosting Regressor?Gradient Boosting Regressor是一种用于回归问题的机器学习算法。

它是以决策树为基分类器的增强学习算法。

该算法通过迭代地训练一系列决策树,每棵树都尝试纠正前一棵树的预测结果,最终获得更准确的预测模型。

2. Gradient Boosting Regressor的基本原理是什么?Gradient Boosting Regressor的基本原理是通过梯度下降法来最小化损失函数。

当损失函数对于当前模型的预测结果的梯度(gradient)为零时,说明当前模型的预测结果已经达到最佳,此时算法停止迭代。

算法的目标是找到使损失函数达到最小的预测模型。

3. Gradient Boosting Regressor的训练过程是怎样的?Gradient Boosting Regressor的训练过程分为多个阶段,每个阶段都训练一棵决策树。

首先,初始化模型为一个常数值,通常是训练集样本目标值的平均值。

然后,依次迭代每个阶段,每个阶段都要计算残差(target值与当前模型预测值之差),并将残差作为下一棵决策树的训练目标。

4. 每棵决策树如何拟合数据?每棵决策树的拟合过程可以看做是一个回归问题。

目标是寻找一个函数,能够最小化残差的平方和。

通常使用最小二乘法或最小平方残差法,通过选择每个决策树的分裂节点和划分规则,来最小化残差。

5. Gradient Boosting Regressor中如何纠正前一棵树的预测结果?在每个阶段,当前训练的决策树需要尝试纠正前一棵树的预测结果。

马尔科夫区制转移向量自回归模型

马尔科夫区制转移向量自回归模型(Markov Regime-Switching Vector Autoregressive Model,简称MS-VAR)是一种经济时间序列分析模型,用于描述具有多个状态的变量之间的动态关系。

在MS-VAR模型中,时间序列被假设为处于不同状态或区域的马尔科夫过程。

每个状态对应着一组特定的方程参数和误差项,用于描述该状态下的变量之间的关系。

当状态发生变化时,模型会自适应地调整参数。

MS-VAR模型的核心是向量自回归(VAR)模型,它建立了变量之间的线性关系。

VAR模型是基于当前时刻的变量值和过去若干个时刻的变量值来预测未来时刻的变量值。

通过引入马尔科夫过程,MS-VAR模型可以根据当前状态选择适当的VAR模型,并进行状态转移。

通常,MS-VAR模型的参数估计和推断是基于最大似然估计等统计方法进行的。

这些方法可以通过观察已有的时间序列数据来确定模型的参数,并使用这些参数进行预测和分析。

MS-VAR模型在经济学、金融学等领域广泛应用,特别是在研究经济周期、金融市场波动和政策效果等方面具有重要意义。

它可以捕捉到时间序列数据中的非线性关系和变化模式,提供更准确的预测和解释。

需要指出的是,MS-VAR模型是一种复杂的统计模型,对于参数估计和解释需要一定的专业知识和技术。

在应用中,合理选择模型的状态数和期望的状态转移动态,以及进行模型诊断和验证等步骤也是重要的。

因此,在具体应用中,建议寻求专业人士的指导和支持。

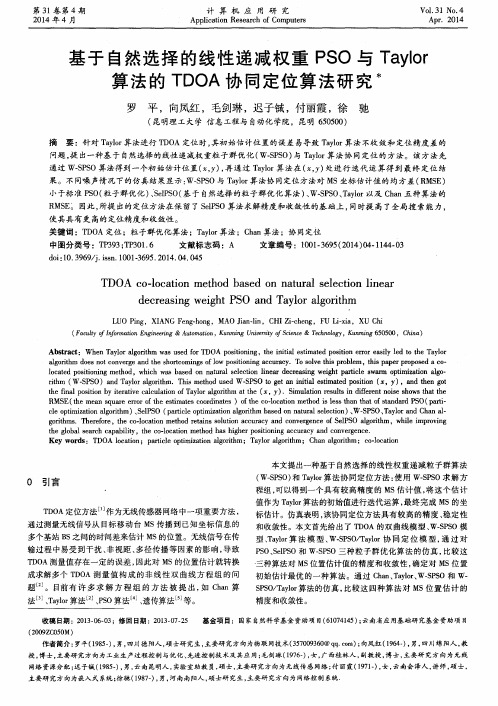

基于自然选择的线性递减权重PSO与Taylor算法的TDOA协同定位算法研究

a l g o i r t h m d o e s n o t c o n v e r g e a n d t h e s h o r t c o m i n g s o f l o w p o s i t i o n i n g a c c u r a c y .T o s o l v e t h i s p r o b l e m, t h i s p a p e r p r o p o s e d a c o -

中图分 类号 : T P 3 9 3 ; T P 3 0 1 . 6 文献标 志码 :A 文章 编号 :1 0 0 1 . 3 6 9 5 ( 2 0 1 4 ) 0 4 . 1 1 4 4 . 0 3

d o i : 1 0 . 3 9 6 9 / j . i s s n . 1 0 0 1 - 3 6 9 5 . 2 0 1 4 . 4. 0 45 0

T DO A C O — l o c a t i o n me t h o d b a s e d o n n a t u r a l s e l e c t i o n l i n e a r

d e c r e a s i n g we i g h t PS O a n d Ta y l o r a l g o r i t h m

L UO P i n g,XI ANG F e n g ・ h o n g , MAO J i a n — l i n, C HI Z i — c h e n g,F U L i — x i a , XU C h i

( F a c u l t y o f I n f o r m a t i o n E n g i n e e r i n g&A u t o m a t i o n , K u n mi n g U n i v e r s i t y o f S c i e n c e& T e c h n o l o g y , K u n m i n g 6 5 0 5 0 0 ,C h i n a )

自组织迁移算法

自组织迁移算法

自组织迁移算法(Self-Organizing Migration Algorithm,简称SOMA)是一种基于人工神经网络的优化算法,它模拟了生物进化的过程,

通过不断地自组织迁移来优化目标函数。

SOMA算法最初是用于解决函数

优化问题,后来被扩展应用到了其他领域,如机器学习、数据挖掘等。

SOMA算法的基本思想是:将一个目标函数空间映射到一个高维的神

经网络空间中,通过对神经网络中的神经元进行自组织迁移,不断优化目

标函数。

具体实现方式为:首先,随机生成一组初始的神经元,然后针对

目标函数的特性,定义一个距离度量函数。

在一次迭代中,根据距离度量

函数,选择一个最佳神经元作为“获胜神经元”,并将其和相邻的神经元

进行更新,使得它们更加接近目标函数的最优解。

然后,按照一定的规则

对所有神经元进行更新,使整个神经网络重新调整结构,达到更优的状态。

这个过程不断重复,直到达到预设的停止条件。

SOMA算法优点是具有较好的全局寻优能力和自适应性。

但是,由于

神经元的数量较大,算法实现复杂度较高,训练时间较长。

此外,对目标

函数特性要求较高,需要有较好的先验知识和经验。

因此,在具体应用中

需要结合具体问题进行调整。

迭代自组织聚类算法 -回复

迭代自组织聚类算法-回复什么是迭代自组织聚类算法(Iterative self-organizing clustering algorithm, ISOC)?迭代自组织聚类算法是一种用于数据聚类的算法。

它能够自动地将数据分为不同的组或聚类,并且能够根据数据的特征进行自适应调整。

ISOC算法是一种迭代算法,它通过不断地迭代来优化聚类结果。

在每一次迭代中,算法会根据已有的聚类结果和数据特征进行调整,直至达到聚类效果的最佳。

ISOC算法的主要特点是:1. 自适应性:ISOC算法能够根据数据的特征自动调整聚类结果,而不需要人工干预。

这使得它能够适应不同类型和规模的数据集。

2. 迭代优化:ISOC算法采用迭代的方式来优化聚类结果。

在每一次迭代中,算法会根据当前的聚类结果和数据特征进行调整,以获得更好的聚类效果。

3. 无监督学习:ISOC算法是一种无监督学习算法,它不需要事先知道数据的类别信息。

它只根据样本数据的相似性将它们分为不同的聚类。

ISOC算法的主要步骤如下:1. 初始化聚类中心:首先,需要初始化聚类中心。

可以随机选择一些数据样本作为初始的聚类中心,也可以利用其他聚类算法得到的结果作为初始中心点。

2. 分配样本到聚类中心:然后,根据每个样本与聚类中心的距离,将每个样本分配到最近的聚类中心中。

可以使用欧氏距离或其他距离度量来计算样本和聚类中心之间的距离。

3. 更新聚类中心:接下来,根据每个聚类中的样本,计算得到新的聚类中心。

可以使用均值、中位数或其他统计量来计算新的聚类中心。

4. 重复迭代:然后,重复进行第2步和第3步,直至聚类中心不再发生明显的变化,或达到预定的迭代次数。

5. 输出聚类结果:最后,根据最新的聚类中心,将样本分配到最近的聚类中心中,得到最终的聚类结果。

ISOC算法的优势在于能够自适应地调整聚类结果,能够处理大规模和复杂的数据集。

另外,它不需要事先知道数据的类别信息,适用于无监督学习的场景。

基于WPSO优化的LSSVM在中长期电力负荷预测的应用

基于WPSO优化的LSSVM在中长期电力负荷预测的应用羽、薇,马天男(华北电力大学经济管理系.河北保定071003)摘要:对基本最小二乘支持向量机(LSSVM)的负荷预测方法进行了改进,提出了一种采用带惯性权重的粒 子群算法(WPSO)对其参数进行优化处理的预测方法。

以某地区的历史负荷值作为算例,将优化所得的参数 运用到预测模型中进行计算验证。

关键词:电力负荷预测;最小二乘支持向量机;带惯性权重的粒子群优化算法中长期电力负荷预测在电力系统运营中有 着重要的作用,是电力系统规划建设的依据,其 预测的精度直接影响到了电力企业电网规划、布局以及其运行的合理性。

本文提出了一种采 用粒子群算法(W eig ht P article Swarm O p tim izatio n,简称 W P S O)对最小二乘支持向量机的参数 进行优化处理的预测方法。

带权重的粒子群算 法能够很好的处理函数优化、神经网络参数优 化等问题,并且其收敛速度快、鲁棒性高,能够 较好的调整全局和局部搜索能力之间的平衡。

同时,该预测方法具有操作简单、容易实现以及 调整参数少等优点。

实验结果表明:该方法不 仅能够提高预测速度和预测性能,而且比传统 的(least squares support vector m a c h in e,简称L S S V M)的精度要高,更加适合在中长期电力负 荷预测中的应用。

1WPSO算法简介(1)基本的PS0算法PS0算法基本思想是通过迭代运算搜索空 间中随机粒子群潜在的最优解;在每一次迭代 当中,粒子会找出当前时刻本身的最优解/\…,与 整个粒子群的最优解g b e s,,实际上,PS0算法也 是通过个体的竞争和协作来完成空间最优解的 搜寻。

设在D维目标空间中,有m个粒子组成的群 体,第;个粒子的位置表示为x,.= (%,a;l2,…,*i〇) ,«•= 1,2,…,m;其速度表不为 V,.= (,7;a,…,Kfl);其自身最优位置表不为jP b e S I = (P,.l,P,2,…,p1D);整个粒子群的最有位置为gb(!s l = (g,,g2,•••,&);则粒子的速度和位置更新方程vl d(t + 1) = vi d(t) +C lrl(pb e a -x l d(t)) +C2r2(i§W - ⑴)x,d(t + 1) = A:i d+V i d(t + 1)其中C l,c2——非负的加速常数;r,,r2—服从[0,1]上的均匀分布随机数。

PSO算法——精选推荐

PSO算法群体智能⽅法:是通过模拟⾃然界⽣物群体⾏为来实现⼈⼯智能的⼀种⽅法。

群体智能这个概念来⾃对⾃然界中⽣物群体的观察,群居性⽣物通过协作表现出的宏观智能⾏为特征被称为群体智能。

群体智能具有如下特点:(1) 控制是分布式的,不存在中⼼控制。

因⽽它更能够适应当前⽹络环境下的⼯作状态,并且具有较强的鲁棒性,即不会由于某⼀个或⼏个个体出现故障⽽影响群体对整个问题的求解。

(2) 群体中的每个个体都能够改变环境,这是个体之间间接通信的⼀种⽅式,这种⽅式被称为“激发⼯作”。

由于群体智能可以通过⾮直接通信的⽅式进⾏信息的传输与合作,因⽽随着个体数⽬的增加,通信开销的增幅较⼩,因此,它具有较好的可扩充性。

(3) 群体中每个个体的能⼒或遵循的⾏为规则⾮常简单,因⽽群体智能的实现⽐较⽅便,具有简单性的特点(4) 群体表现出来的复杂⾏为是通过简单个体的交互过程突现出来的智能,因此,群体具有⾃组织性。

PSO基本原理最初是为了在⼆维⼏何空间图形中优化模拟鸟群不可预测的运动。

PSO 算法从这种模型中得到启⽰并⽤于解决优化问题。

PSO算法中,每个优化问题的潜在解都是搜索空间中的⼀只鸟,称之为“粒⼦”。

所有的粒⼦都有⼀个由⽬标函数决定的适应值(fitness value),每个粒⼦都由⼀个两维的速度变量决定各⾃飞翔的⽅向和距离。

然后粒⼦们就追随当前的最优粒⼦在解空间中搜索。

PSO算法初始化为⼀群随机粒⼦(随机解),然后通过迭代找到最优解。

在每⼀次迭代中,粒⼦通过跟踪两个极值来更新⾃⼰。

第⼀个极值就是粒⼦本⾝所经历的最优解,这个解被称为个体极值。

另⼀个极值是整个种群⽬前所经历的最优解,这个极值被称为全局极值。

另外也可以只选取整个种群中的⼀部分作为粒⼦的邻居,在所有邻居中的极值被称为局部极值。

在算法中,每个粒⼦可以想象成算法空间中的⼀个潜在解.粒⼦的优劣由⽬标函数来衡量.各个粒⼦根据下⾯的信息来确定⾃⼰当前位置:(1)⾃⾝当前的位置:(2)⾃⾝当前的速度;(3)⾃⾝当前的位置和⾃⾝历史最优位置之问的距离;(4)⾃⾝当前的位置和整个群体历史最优位置之间的距离。

无线网络mac协议简介

无线网络mac协议简介篇一:无线自组网竞争类MAC协议分析及研究无线自组网竞争类MAC协议分析及研究无线自组网是一种没有任何中心实体的,由一组带有无线通信收发装置的移动终端节点组成的自治性网络。

依靠节点间的相互协作可在任何时刻、任何地点以及各种移动、复杂多变的无线环境中自行成网,并借助多跳转发技术来弥补无线设备的有限传输距离,从而拓宽网络的传输范围,为用户提供各种服务、传输各种业务。

在现代化战场上,如数字化与自动化战场、各种军事车辆、士兵之间的协同通信、发生地震等自然灾害后、搜救与营救以及移动办公、虚拟教室、传感器网络等通信领域应用非常广泛。

其中MAC协议是无线自组网协议的基础,控制着节点对无线媒体的占用,对自组织网的整体性能起着决定性的作用。

从自组织网出现至今,MAC协议设计一直是研究的重点。

目前,移动自组织网采用的信道访问控制协议大致包括3类:竞争协议、分配协议、竞争协议和分配协议的组合协议(混合类协议)。

这3种协议的区别在于各自的信道接入策略不同。

由于MAC协议的研究主要集中在基于竞争的机制,本文着重针对竞争类协议中几种较常用的典型MAC协议进行对比分析,并在OPNET仿真建模软件中创建出各协议的状态模型,这对无线自组织网络仿真研究及选择高效适用的MAC技术方案具有实际参考价值。

1 竞争协议的概念及特点竞争协议是使用直接竞争来决定信道访问权,并且通过随机重传来解决碰撞问题。

ALOHA协议和载波侦听多址访问CSMA协议就是竞争协议的典型例子。

除了时隙化的ALOHA协议,大多数竞争协议都使用异步通信模式。

这种协议在低传输负荷下运行良好,如碰撞次数少,信道利用率高、分组传输时延小。

随着传输负荷的增大,往往使协议性能下降、碰撞次数增多。

在传输负荷很重的时候,竞争协议可能随着信道利用率下降而变得不稳定。

这就可能导致分组传输时延呈指数形式增大,以及网络服务的崩溃。

这就对MAC协议的设计提出了较高的要求。

采用随机变异步长的改进自组织迁移算法

(c olo ot lSin e ad E g e r g S a dn nvri ,ia 5 0 1 C ia Sh o fC nr c c n n i ei ,h n og U ies y J n 2 0 6 , hn ) o e n n t n

s a e i a c l rt d S mu a in r s l e e l t a te p o o e l o t m s et r t a t e o gn l s l o g n z g p c s c e ea e .i lt e u t r v a h t h r p s d a g r h i o s i b t h n h r i a ef r a ii mi e i - n — r t lo h n h a t l wam p i ai a o h g ai g ag rt m a d t e p r c e s r o t z t n 'g rtm. n i i mi o l i Ke wo d :o t z t n; v l t n r lo t m ;e f o g n zn g a ig ag r h ; tt n y r s p i ai e o u i a ag r h s l r a ii g mi t lo t m mua i mi o o y i - r n i o

1 引言

进 化 算 法 是一 类 模 拟 生 物 进 化 和 自然 选 择 机 制 的 全 局 性 概 率 搜 索 算法 I1 化 算 法 通 常 采 用 群 体 寻优 策 略 , 体 巾 每 1。进 l 2 群

一

P O算 法 。 S

2 自组织 迁移算 法

变步长 ode23tb 算法

变步长ode23tb算法是一种用于解非刚性常微分方程初值问题的数值算法。

该算法由MathWorks公司的工程师开发,其特点是能够自适应调整步长以提高求解精度和效率。

ode23tb算法是ode23算法的改进版本,通过引入更高阶的解析技术和自适应的步长控制,使得求解过程更加可靠和高效。

二、算法原理ode23tb算法基于龙格-库塔(Runge-Kutta)方法,通过描述性的一阶创建步骤和更高阶的增补步骤来近似解微分方程。

算法会根据当前的解的精度和误差情况,自适应地调整步长以确保求解的精度和效率。

ode23tb算法还引入了自动时步的策略,以处理不同变化速度的微分方程。

三、算法特点1. 自适应调整步长:ode23tb算法能够根据当前解的情况实时调整步长,避免不必要的计算和提高求解效率。

2. 高阶解析技术:通过引入更高阶的解析技术,ode23tb算法能够更准确地近似微分方程的解,在不增加过多计算成本的情况下提高求解精度。

3. 自动时步策略:算法能够根据微分方程的变化速度自动调整时步,适应不同变化速度的微分方程的求解。

作为一种高效可靠的数值求解算法,ode23tb算法在科学计算、工程领域和其他需要求解微分方程的问题中得到了广泛的应用。

例如在控制系统的建模和仿真中,ode23tb算法能够准确地求解系统的状态方程,为系统性能分析提供有力的支持。

在生物医学领域,ode23tb算法被用于建立生物模型和仿真生物系统的动态行为。

ode23tb算法还被应用于气象学、天文学、材料科学等领域,为复杂的微分方程问题提供了强大的求解能力。

五、算法发展随着科学技术的发展和对求解微分方程精度和效率要求的不断提高,ode23tb算法也在不断地进行改进和优化。

未来的发展方向主要包括进一步提高算法的自适应调整能力,完善算法的并行计算和局部精度控制,以满足各种复杂微分方程求解问题的需求。

六、总结ode23tb算法作为一种自适应调整步长的高效数值求解算法,在科学计算和工程实践中发挥着重要作用。

机器学习技术中的迁移学习算法

机器学习技术中的迁移学习算法迁移学习算法是机器学习领域中的重要技术之一。

它旨在通过将一个任务中学习到的知识应用到另一个相关任务上,来提高模型的性能和泛化能力。

在实际应用中,迁移学习算法可以帮助解决数据不足、领域差异大和时间成本高等问题,同时还能加速模型的训练和优化过程。

本文将详细介绍几种常见的迁移学习算法。

一、领域自适应(Domain Adaptation)领域自适应是迁移学习中常用的算法之一,其目的是将源领域的知识迁移到目标领域上。

在领域自适应中,我们假设源领域和目标领域具有一定的关联性,但存在一定的差异。

该算法通过对源领域数据进行特征选择、特征映射或数据重标定等方式,使得源领域的知识在目标领域中仍然有效。

领域自适应算法可以通过最大化源领域和目标领域之间的相似性,进一步优化模型的泛化能力。

二、迁移聚类(Transfer Clustering)迁移聚类是迁移学习中的一个重要分支领域,其目的是通过迁移学习算法将源领域中学习到的聚类信息应用到目标领域中。

在迁移聚类中,我们利用源领域数据的聚类结果来辅助目标领域的聚类任务,并通过相似性匹配来找到对应的类别。

迁移聚类算法可以有效地减少目标领域样本的标注成本,提高聚类效果和效率。

三、迁移深度学习(Transfer Learning with Deep Learning)迁移深度学习是近年来兴起的一种迁移学习算法,其基于深度学习网络模型,并结合领域自适应和迁移学习的思想,进一步提高模型的性能。

迁移深度学习算法主要利用预训练的深度神经网络模型,在源领域上进行训练,然后将该模型应用到目标领域上重新调优和微调。

通过这种方式,可以利用源领域的大规模标注数据来提取通用的特征表示,从而加速目标领域模型的训练和迭代过程。

四、迁移度量学习(Transfer Metric Learning)迁移度量学习是一种通过建立距离度量或相似度度量来实现迁移学习的算法。

在迁移度量学习中,我们迁移源领域的度量矩阵到目标领域,从而通过学习目标领域的度量矩阵,来优化模型的分类效果。

自适应步长FISTA算法稀疏脉冲反褶积

自适应步长FISTA算法稀疏脉冲反褶积潘树林;闫柯;李凌云;蒋从元;石林光【摘要】FISTA算法(fast iterative shrinkage-thresholding algorithm)采用线性搜索方法寻找最佳内部梯度的步长L,而线性搜索只能使L向增大的方向搜索,严重影响了FISTA算法的收敛性.为此,提出了一种基于自适应步长FISTA算法的稀疏脉冲反褶积方法,该方法在FISTA算法的基础上,通过在每一次迭代之前适当减小常数L,然后利用线性搜索的方式寻找最优的常数L,以达到自适应调整L的目的.为了使算法达到理论收敛,通过结合前、后两次的L,对传统FISTA算法的辅助序列进行修改,最终使整套算法在理论上得以收敛.理论模型与实际地震资料的处理、分析结果表明,所提方法具有更好的收敛性,能在不同信噪比下得到理想的反演结果,较常规FISTA算法具有更好的抗噪能力.【期刊名称】《石油地球物理勘探》【年(卷),期】2019(054)004【总页数】7页(P737-743)【关键词】稀疏脉冲反褶积;FISTA算法;线性搜索;自适应;收敛性【作者】潘树林;闫柯;李凌云;蒋从元;石林光【作者单位】西南石油大学地球科学与技术学院,四川成都610500;中国石油西南油气田分公司,四川成都610051;胜利油田分公司物探研究院,山东东营257000;四川职业技术学院电子电气工程系,四川遂宁629000;胜利油田分公司物探研究院,山东东营257000【正文语种】中文【中图分类】P6310 问题的提出稀疏脉冲反褶积是目前较为常用的提高地震资料分辨率的方法,其目的是利用带限的地震记录反演地下反射系数,从而得到高分辨率的地震数据[1-2]。

稀疏脉冲反褶积的原理是在传统的最小二乘反褶积的基础上,加上一个稀疏先验约束项,通过求解L2范数与L1范数之和形式的目标函数得到高分辨率的反演结果[3-4]。

基追踪[5]方法利用Nesterov[6-8]提出的近端梯度的概念,使用二次函数近似表示目标函数,最终利用梯度法求解。

一种改进的自适应步长的萤火虫算法

一种改进的自适应步长的萤火虫算法

李顺;郭星

【期刊名称】《微电子学与计算机》

【年(卷),期】2018(35)8

【摘要】提出一种预防萤火虫失活的自适应步长的萤火虫算法(PA-GSO).第一,步长采用非线性递减方式,初期步长较大移动速度快,后期步长逐渐减少至固定的较小值,实现了算法精度和速度的平衡.第二,为了应对萤火虫的邻居集合为空集时可能丧失移动能力的现象,采用了预防萤火虫失活机制优化萤火虫运动.通过实验对比GSO,A-GSO和CSGSO算法,各方面指标验证了PA-GSO算法在寻优精度、收敛速度和稳定性等方面的提升.

【总页数】5页(P93-96)

【关键词】萤火虫算法;自适应步长;预防失活

【作者】李顺;郭星

【作者单位】安徽大学智能嵌入式技术研究中心;安徽大学计算机科学与技术学院【正文语种】中文

【中图分类】TP391.9

【相关文献】

1.基于自适应步长的萤火虫划分聚类算法 [J], 潘晓英;陈雪静;李昂儒;赵普

2.一种改进的自适应步长的人工萤火虫算法 [J], 唐少虎;刘小明

3.一种改进的变步长萤火虫优化算法 [J], 郁书好;杨善林;苏守宝

4.一种基于自适应搜索策略的改进萤火虫算法 [J], 于干;金丹丹

5.一种改进的变步长的萤火虫算法 [J], 李恒;郭星;李炜

因版权原因,仅展示原文概要,查看原文内容请购买。

dinkelbach’s method

dinkelbach’s methodDinkelbach’s Method(丁克尔巴赫法)是一种优化算法,常用于解决非线性规划问题。

该方法通过将目标函数转化为一系列线性规划问题,从而找到目标函数的最优解。

本文将介绍Dinkelbach’s Method的基本原理和应用。

让我们来了解一下非线性规划问题。

非线性规划是一类包含非线性目标函数和约束条件的优化问题。

在实际应用中,许多问题都可以归结为非线性规划问题,例如经济学、工程学和管理学等领域。

然而,由于非线性规划问题的复杂性,求解其最优解通常是一项困难的任务。

Dinkelbach’s Method通过引入一个辅助变量,将非线性规划问题转化为一系列线性规划问题。

具体而言,假设我们的目标是最小化一个非线性目标函数f(x),其中x是决策变量。

我们可以引入一个辅助变量y,然后将目标函数转化为线性形式g(x,y) = f(x) - y。

显然,当g(x,y)的最优解为0时,即可得到原始目标函数f(x)的最优解。

接下来,我们需要解决一系列线性规划问题。

对于每个固定的y值,我们需要求解g(x,y)的最优解。

然后,通过逐步迭代更新y值,直到g(x,y)的最优解为0。

这样,我们就可以得到原始目标函数f(x)的最优解。

Dinkelbach’s Method的优势在于,它将一个复杂的非线性规划问题转化为一系列相对简单的线性规划问题。

由于线性规划问题有着成熟的求解算法,因此我们可以利用这些算法来解决每个线性规划子问题。

这种迭代求解的过程通常会收敛到最优解,从而得到原始目标函数的最优解。

Dinkelbach’s Method的应用非常广泛。

例如,在能源经济学中,我们可以将能源生产的成本作为目标函数,通过优化决策变量来降低能源生产的成本。

在供应链管理中,我们可以将运输成本或库存成本作为目标函数,通过优化决策变量来提高供应链的效率。

此外,Dinkelbach’s Method还可以应用于机器学习领域,用于优化模型的性能指标。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

W ENG Ch n i LI u y 。 Yu n i n . ANG Li l g, t 1 o i e s l o g n z n mi r tn a g rt m wih i e r d g e s a xa g W ng n e a . d f d ef r a ii g i M i - g ai g lo i h t l a - i r s n

1 . 武汉大学 软 件工程 国家重点实验室 , 武汉 4 0 7 302

2广东 工 业 大 学 计 算 机 学 院 , 州 5 0 0 . 广 06 1

1S ae Ke a o a o y o o wa e E g n e n W u a i e st Wu a 3 0 2, i a . t t y L b r t r f S f r n i e r g, h n Unv r i t i y, h n 4 0 7 Ch n

段 的需求 , 而加速群体在 多峰复杂 空间中收敛速度 的 同时提 高算法 的局部搜 索能力 。实验 结果表明 , 从 该算法优于原始 自组织 迁移算法和基 于随机 变异步长的 自组 织迁移算 法。

关键词 : 组织 迁移算法; 自 步长; 线性递减; 优化 D :03 7 /i n10 .3 1 0 1 8 0 文章编号 :0 28 3 (0 1 1.0 60 文献标识码 : 中图分类号: P 1 OI1 . 8 .s . 283 . 1 . . 8 7 js 0 2 10 10 .3 12 1 )80 2 .3 A T 32

m i ai g a g rtm t a d m t t n se n h a i n . r n g t l o h wi r o mu ai t p a d t e b sc o e i h n o K e r s s l- r a ii g mi a i g a g r h ;t p l e r d g e s o t ia in y wo d : e f g n z n g t l o t m se ;i a i s ; p i z t o r n i n r m o

se . o u e n ie rn n p l ain ,0 1 4 ( 8 : 62 . tpC mp tr E gn e i g a d A p c t s 2 1 ,7 1 ) 2 - 8 i o

Ab t a t S l- g n zn Mirt g Alo i m ( OMA)i a kn o e sr c : efOr a iig gai g rt n h S s id f n w s r n el e t loi m. tr a ay ig h wam itlg n ag rt Afe n lzn te i h

gne rt fs mii l— dlc m l pc n n acste ait flclsac y ajs g s p l gh dnmi ec a o o wa n mutmo a o pe sae ad ehn e bl o a erh b dut t e t ya c i i x h i y o n i e n

a d i a n e s me ie to sE p rme t r v a t a t e p o o e ag rt m b h v s b te t a t e e fo g n zn n l ne r u d r o d r c i n . x e i n s e e l h t h r p s d l o ih e a e e t r h n h s l r a i i g -

b sc efo g n zn i r t g a g rt m a d a i s l r a i i g m g a i l o i - n h n mo iid s l o g n zn mi r t g l o i m t a d m d f ef r a i i g e - g a i ag rt n h wi r n o h mu a i n t p, i tt se t s o h p p r p o o e i r v d efo g n zn mi r t g l o i m wi l e rd g e s tp T e lo t m a c lr t s t e o v r a e r p s s a mp o e s l- r a ii g g ai a g rt n h t i a - i r s se . h ag r h h n i c ee a e h c n e -

摘 要 : 组织 迁移 算法 (O A) 自 S M 是一种新 型的群体智 能算 法。在对 原始 自 织迁移算法分析 的基础 上 , 对基 于随机 变异 步 组 针 长 的 自组织 迁移算法存在 的不足 , 出了线性递减步长策略 , 提 即有针对性地 以线性 方式动态调整步长 , 以满足群体迭代在 不同阶

C m ue n i ei d p l ai s' 机工程 与应用 o p t E gn r ga A pi t n  ̄算 r e n n c o 1 "

@研 究 、 讨 @ 探

一Байду номын сангаас

种采用线性递减步长 的 自组织迁移 算法

翁纯毅 李 元香 王 玲玲 林 志毅 , , ,

W ENG u i, a xin 、 NG Li gl LI Zhi i Ch ny LI Yu n a g , 7 l n i , N ng y