Learning more accurate metrics for self-organizing maps

评估算法的重要指标

评估算法的重要指标评估算法的重要指标在机器学习和数据挖掘领域中,评估算法的性能是非常关键的。

以下是一些重要指标,可用于评估算法的性能。

1. 精度(Accuracy):精度是指分类器正确分类的样本数占总样本数的比例。

它是最常用的分类器性能指标。

2. 灵敏度(Sensitivity):灵敏度也称为真阳性率,它是指真实正例中分类器正确分类的比例。

灵敏度越高,表示分类器对正例的识别能力越强。

3. 特异度(Specificity):特异度也称为真阴性率,它是指真实负例中分类器正确分类的比例。

特异度越高,表示分类器对负例的识别能力越强。

4. 精确率(Precision):精确率是指被分类为正例中实际为正例的比例。

精确率越高,表示分类器对正例判定正确性越高。

5. 召回率(Recall):召回率也称为查全率或灵敏度,它是指实际为正例中被正确识别为正例的比例。

召回率越高,表示分类器对正例判定漏报率越低。

6. F1值(F1 Score):F1值是精确率和召回率的加权平均值,它综合了精确率和召回率的优缺点。

F1值越高,表示分类器的性能越好。

7. ROC曲线(Receiver Operating Characteristic Curve):ROC 曲线是真阳性率与假阳性率之间的关系曲线。

ROC曲线下面积越大,表示分类器的性能越好。

8. AUC(Area Under Curve):AUC是ROC曲线下面积,它是评估分类器性能的重要指标。

AUC越大,表示分类器的性能越好。

以上是评估算法常用的一些指标,不同任务需要选择不同的指标进行评估。

除了这些指标外,还有其他一些指标可以用于评估算法性能,如错误率、Kappa系数等。

accuracy 指标

accuracy 指标

Accuracy指标是指机器学习模型对分类问题中所有样本分类的正确率。

简单来说,accuracy指标可以告诉我们模型分类预测的准确性有多高。

对于一个分类问题来说,accuracy指标需要基于数据集中所有分类样本的预测结果进行计算。

具体的计算方法是将模型正确预测分类样本

的数量除以数据集中所有分类样本的数量。

例如,如果我们使用一个机器学习模型来对100个样本分类,其中60个样本被正确分类,那么该模型的预测准确率就是60%。

这说明,在

这种情况下我们可以相信此模型的预测。

不过需要注意的是,accuracy指标并不能完全反映出机器学习模型的性能。

因为严格来说,它不能很好地处理类别不平衡问题。

当数据集中的某个类别数量比其他类别数量多很多时,accuracy指标容易出现偏差。

在这种情况下,尽管模型的预测结果对于少数类别的

分类样本进行了错误的分类,但是对于多数类别的分类样本的分类准

确率较高,accuracy指标仍然会偏高。

因此,对于数据集中出现类别不平衡问题的情况,我们往往需要使用

其他的指标来评估机器学习模型的性能。

如AUPR指标、AUC指标、F1-score指标等等。

总之,虽然accuracy指标并不能完美反映机器学习模型的性能,但它仍是一个很好的评估模型性能的起点,可以为我们提供一个很好的开始来确定模型的预测能力如何。

clf-c02中文题库

clf-c02中文题库文本分类文本分类是一项自然语言处理任务,旨在将文本数据分配到预定义的类别中。

它在各种实际应用中至关重要,包括电子邮件过滤、新闻分类和问答系统。

CLF-C02CLF-C02 中文文本分类数据集是一个广泛使用的基准数据集,包含超过 20 万个用中文书写的文本样本。

这些样本分为 10 个类别,包括:财经房产家居教育科技时尚时政游戏娱乐旅游任务CLF-C02 的文本分类任务涉及使用机器学习模型将给定的文本片段分配到正确的类别。

模型必须能够识别文本中的模式和特征,并将其与预定的类别联系起来。

评价指标CLF-C02 使用准确率作为评估指标。

准确率是指模型正确预测类别数与总样本数之比。

挑战CLF-C02 文本分类任务存在以下挑战:中文语言的复杂性:中文是一种复杂的语言,具有丰富的同义词和多义词,这给文本分类模型带来了挑战。

语义相似性:不同类别的文本片段可能具有相似的语义内容,这使得模型难以区分。

类别之间的重叠:一些文本片段可能跨越多个类别,这给模型带来了额外的困难。

模型选择用于 CLF-C02 文本分类任务的常用模型包括:支持向量机 (SVM):一种广泛使用的分类算法,以其处理高维特征的能力而闻名。

朴素贝叶斯:一种基于贝叶斯定理的分类算法,假设特征相互独立。

深度学习模型:如卷积神经网络 (CNN) 和循环神经网络(RNN),能够学习文本数据的复杂模式。

应用CLF-C02 文本分类数据集被广泛用于:评估文本分类算法的性能提供文本分类模型的训练数据研究中文文本分类中的新技术。

accuracy()方法

accuracy()方法一个电脑程序的好坏,最终的评判标准往往在于其结果的准确性。

在这个过程中,程序中的某些方法对结果的正确性有着至关重要的作用。

今天我们来讨论一个关于计算准确性的方法——accuracy()方法。

1. accuracy()方法是什么?accuracy()方法可以将机器学习模型的预测结果与实际结果进行比较,从而计算出模型的预测准确率。

在scikit-learn中,accuracy()方法属于metrics模块中的一个函数,可根据实际结果和预测结果计算出精确度。

2. accuracy()方法的使用在使用accuracy()方法之前,需要先导入对应的库和数据。

一般来说,我们会将数据分为训练集和测试集,然后使用训练集训练模型,再使用模型对测试集进行预测。

最后使用accuracy()方法将预测结果与实际结果进行对比,从而计算出模型的准确率。

以下为使用accuracy()方法的示例代码:```from sklearn.metrics import accuracy_score # 导入accuracy_score方法from sklearn.model_selection import train_test_splitfrom sklearn.linear_model import LogisticRegression# 导入数据data = pd.read_csv("data.csv")X = data.drop('target', axis=1)y = data['target']# 将数据分为训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y,test_size=0.2, random_state=42)# 构建逻辑回归模型model = LogisticRegression()# 使用训练集训练模型model.fit(X_train, y_train)# 使用模型对测试集进行预测y_pred = model.predict(X_test)# 使用accuracy_score方法计算准确率acc = accuracy_score(y_test, y_pred)print('模型准确率为:{:.2f}%'.format(acc * 100))```通过以上代码,我们将数据分为了训练集和测试集,并且使用训练集训练了一个逻辑回归模型。

中英文验证码深度训练

中英文验证码的深度训练通常涉及以下步骤:数据收集:首先需要收集大量的中英文验证码图片和对应的正确答案。

这些数据可以来自各种网站、应用程序或开源数据集。

数据预处理:对收集到的数据进行预处理,包括图像清洗、大小调整、灰度化等操作,以便于模型训练。

模型选择:选择适合的深度学习模型,例如卷积神经网络(CNN)、循环神经网络(RNN)或长短期记忆网络(LSTM)等。

模型训练:

使用训练数据集对模型进行训练,通过调整模型参数和优化器来最小化错误率。

模型评估:使用验证数据集对训练好的模型进行评估,以了解模型在未见过的数据上的表现。

模型优化:根据评估结果对模型进行优化,例如调整模型结构、增加或减少层数、改变激活函数等。

部署模型:将训练好的模型部署到生产环境中,用于实际的中英文验证码识别任务。

sklearn 评估指标

sklearn 评估指标Sklearn是Python中最流行的机器学习库之一,它提供了许多评估指标来帮助我们评估模型的性能。

在本文中,我们将介绍一些常用的评估指标,并讨论它们的优缺点。

1. 准确率(Accuracy)准确率是最常用的评估指标之一,它表示分类器正确分类的样本数与总样本数之比。

虽然准确率很容易理解,但它并不适用于所有情况。

例如,在一个高度不平衡的数据集中,如果分类器总是预测为多数类,那么准确率可能会非常高,但分类器的性能实际上很差。

2. 精确率(Precision)精确率是指分类器正确预测为正例的样本数与分类器预测为正例的样本数之比。

精确率适用于那些假阳性的代价很高的情况,例如医学诊断。

在这种情况下,我们更关心分类器正确预测为正例的能力,而不是分类器正确预测为负例的能力。

3. 召回率(Recall)召回率是指分类器正确预测为正例的样本数与实际正例的样本数之比。

召回率适用于那些假阴性的代价很高的情况,例如疾病筛查。

在这种情况下,我们更关心分类器正确预测为负例的能力,而不是分类器正确预测为正例的能力。

4. F1值(F1 Score)F1值是精确率和召回率的调和平均数,它综合了精确率和召回率的优缺点。

F1值适用于那些假阳性和假阴性的代价相等的情况。

5. ROC曲线(ROC Curve)ROC曲线是一种用于评估二元分类器性能的图形化工具。

ROC曲线的横轴是假阳性率(False Positive Rate,FPR),纵轴是召回率(Recall)。

ROC曲线越靠近左上角,分类器的性能越好。

6. AUC(Area Under Curve)AUC是ROC曲线下的面积,它是一种综合评估分类器性能的指标。

AUC的取值范围在0到1之间,越接近1,分类器的性能越好。

总之,评估指标是评估机器学习模型性能的重要工具。

在选择评估指标时,我们应该根据具体情况选择适当的指标,并综合考虑指标的优缺点。

在实际应用中,我们可以使用sklearn提供的评估函数来计算这些指标。

metric learning的评价指标

metric learning的评价指标一、准确率准确率是metric learning中最重要的评价指标之一。

它衡量了模型对正样本的识别能力,即模型能够准确地识别出相似样本之间的关系,从而正确地进行分类。

准确率的计算方法通常采用混淆矩阵(confusion matrix)来进行评估。

二、召回率召回率是metric learning模型另一个重要的评价指标,它衡量了模型对正样本的捕获能力。

在metric learning中,召回率是指模型能够正确识别出相似样本的比例,即模型能够正确地将相似样本归为一组,而将不同样本分在不同的组别中。

召回率的计算方法通常采用样本级别的比较来进行评估。

三、F1分数F1分数是metric learning模型的综合评价指标,它综合考虑了准确率和召回率两个指标。

F1分数越大,说明模型的表现越好。

在实际应用中,F1分数常用于多类问题的评估,例如情感分析、主题建模等任务。

四、多样性指标除了上述的准确性、召回率和F1分数外,metric learning模型的评价指标还包括多样性指标。

多样性指标衡量了模型生成的样本分布的多样性,它可以帮助我们评估模型是否能够生成丰富多样的样本,从而更好地描述数据集的特征。

常用的多样性指标包括信息熵、互信息等。

五、稳定性指标稳定性指标是衡量metric learning模型稳定性的指标,它可以帮助我们评估模型在不同数据集上的表现。

稳定性指标通常采用交叉验证的方法来计算,常用的稳定性指标包括均方误差(MSE)、平均绝对误差(MAE)等。

六、可解释性指标除了上述的定量指标外,metric learning模型的评价还包括可解释性指标。

可解释性指标衡量了模型对数据的解释能力,它可以帮助我们更好地理解模型的工作原理和优势,以便在未来的研究中进一步改进和完善模型。

综上所述,metric learning的评价指标包括准确率、召回率、F1分数、多样性指标和稳定性指标等定量指标以及可解释性指标等定性指标。

机器学习的目标与评价指标

机器学习的目标与评价指标机器学习的目标是通过构建模型,使计算机能够从数据中学习并做出预测或进行决策。

机器学习的核心任务之一是分类,即通过学习一组已标记的示例,将新的未标记示例分配到已知类别中的一个。

其它机器学习任务包括回归、聚类、降维等。

为了评价机器学习模型的性能,我们通常使用各种评价指标。

这些指标可以分为分类、回归和聚类任务的指标。

下面将介绍一些常用的评价指标。

对于分类任务,常用的评价指标包括准确率(Accuracy)、精确率(Precision)、召回率(Recall)、F1分数和ROC曲线。

准确率是指对于所有样本中,分类正确的样本数量占总样本数量的比例。

精确率是指真正例(True Positive)占被模型预测为正例的样本数量的比例,它衡量了模型预测的阳性样本中真正属于阳性样本的比例。

召回率是指真正例占实际正例的样本数量的比例,它衡量了模型对于所有正例样本的检出率。

F1分数是精确率和召回率的调和平均数,它综合考虑了预测的准确性和对正例的召回率。

ROC曲线是以假阳性率(False Positive Rate)为横坐标,真阳性率(True Positive Rate)为纵坐标的曲线,用于衡量模型在不同阈值下的分类性能。

对于回归任务,常用的评价指标包括均方误差(Mean Square Error,MSE)、均方根误差(Root Mean Square Error,RMSE)、均方对数误差(Mean Squared Logarithmic Error,MSLE)和R平方(R-Squared)。

MSE是预测值与目标值之间差值的平方的平均值。

RMSE是MSE的平方根,它消除了MSE的量纲差异,更直观地反映了预测误差的大小。

MSLE是预测值与目标值之间对数差值的平方的平均值。

R平方是预测值与目标值之间的相关性的平方,它衡量了模型对目标变量的解释能力。

对于聚类任务,常用的评价指标包括轮廓系数(Silhouette Coefficient)和互信息(Mutual Information)。

掌握机器学习模型的评估方法与调优方法

掌握机器学习模型的评估方法与调优方法机器学习(Machine Learning)是一种计算机科学领域的分支,致力于使用算法来从数据中学习模型,并对无法编程的未知数据进行预测和决策。

在机器学习的应用中,模型评估和调优是必不可少的步骤,对于确保模型的性能和准确性具有非常重要的作用。

模型评估方法模型评估的目的是测量和比较模型的性能,通常采用下面这些指标:1.准确率(Accuracy):是预测的正确率。

准确率越高,模型的性能就越好。

2.精确率(Precision):指真正预测为正(TRUE)的样本占所有预测为正的样本的比例。

正确预测为正的数量/预测为正的数量,精准率越高,误判率就越低。

3.召回率(Recall):指所有真正为正(TRUE)的样本被正确预测为正的比例。

正确预测为正的数量/样本真正为正的数量,召回率越高,漏掉的真实正例就会越少。

4. F1值(F1 Score):是精确率和召回率的加权(调和)计算结果。

F1值越高,说明模型的性能越好。

5. ROC曲线:以假正率(False Positive Rate)为横轴,真正率(True Positive Rate)为纵轴,来描述分类器在不同阈值下的性能。

6. AUC值(Area Under ROC Curve):计算ROC曲线下的面积大小,越接近1,模型的性能就越好。

常用机器学习模型中,比如分类模型,回归模型,聚类模型等,在评估时都存在自己的指标,需要针对具体的模型进行选择。

模型调优方法模型调优通常包括以下步骤:1.数据预处理:包括数据清洗,数据转换,特征提取等。

预处理能够为模型提供更好的数据,并自然可以改善模型的性能。

2.特征选择:对于具备分析价值的特征进行选择,减少不必要的特征,从而有效地降低了模型的计算成本和复杂性。

3.模型选择:选择适合任务的模型,选取适当的算法和超参数。

4.参数调节:现有的模型也有许多可调参数的空间。

例如,学习率,正则化系数等关键参数可能会影响模型的性能。

机器学习模型评估指标解析(Ⅰ)

机器学习模型评估指标解析机器学习模型的评估指标是评价模型性能的重要标准,它们可以帮助我们了解模型在处理数据时的表现,并帮助我们选择合适的模型。

在实际应用中,我们需要根据具体的问题和数据选择不同的评估指标。

本文将对几种常见的机器学习模型评估指标进行解析,帮助读者更好地理解和应用这些指标。

精确度(Accuracy)精确度是最常见的评估指标之一,它衡量的是模型预测正确的样本数量占总样本数量的比例。

精确度越高,模型的性能越好。

但是在某些情况下,精确度并不能完全反映模型的性能,比如当数据集中存在类别不平衡的情况时,精确度会失去意义。

因此,在实际应用中,我们需要结合其他评估指标来综合考量模型的性能。

准确率(Precision)和召回率(Recall)准确率和召回率是在二分类问题中常用的评估指标。

准确率衡量的是模型预测为正类别的样本中有多少是真正的正类别样本,而召回率衡量的是真正的正类别样本中有多少被模型预测为正类别。

在实际应用中,我们需要根据具体的问题来选择是更注重准确率还是召回率。

比如在医学诊断中,我们更希望模型能够尽可能多地识别出患病的病人,这时候我们会更注重召回率。

而在垃圾邮件识别中,我们更注重准确率,希望尽可能减少误判。

F1分数(F1 Score)F1分数是准确率和召回率的调和平均数,它综合考虑了准确率和召回率的性能。

F1分数越高,模型的性能越好。

在某些情况下,我们会更倾向于选择F1分数作为评估指标,特别是当我们需要平衡准确率和召回率时。

ROC曲线和AUC值ROC曲线是用于可视化二分类模型性能的一种方法,它的横轴是1-特异度,纵轴是灵敏度。

AUC值则是ROC曲线下的面积,它是评估模型性能的数量化指标。

AUC值越接近1,模型的性能越好。

ROC曲线和AUC值可以帮助我们直观地比较不同模型的性能,特别是在处理样本不均衡的情况下更为有效。

均方误差(MSE)和均方根误差(RMSE)均方误差和均方根误差是用于衡量回归模型性能的评估指标。

learning rate范围

learning rate范围

摘要:

1.介绍学习率

2.学习率的范围

3.不同范围学习率的影响

4.如何选择合适的学习率

正文:

学习率是机器学习和深度学习中一个非常重要的超参数,它直接影响到模型的训练效果和速度。

学习率范围是指在训练过程中,参数更新的幅度,它决定了模型每次迭代时参数的改变量。

合适的学习率范围可以加速模型收敛,提高模型性能,而不合适的学习率范围则可能导致模型训练不稳定,收敛速度过慢,甚至无法收敛。

一般来说,学习率的范围可以分为三个区间:较小的学习率、适中的学习率和较大的学习率。

较小的学习率可以使模型在训练过程中更加稳定,但可能导致收敛速度过慢,甚至无法收敛;适中的学习率可以使模型在训练过程中既能保证稳定性,又能有一定的收敛速度;较大的学习率虽然可以加速模型收敛,但可能导致模型训练不稳定,甚至无法收敛。

那么,如何选择合适的学习率呢?一般来说,可以从以下几个方面进行考虑:首先,根据模型的复杂度和数据集的大小选择合适的学习率范围。

如果模型复杂度高,数据集大,那么可以选择较大的学习率范围;反之,如果模型复杂度低,数据集小,那么可以选择较小的学习率范围。

其次,可以根据训练集

的性能和验证集的性能选择合适的学习率。

如果训练集的性能好,但验证集的性能差,那么可能是学习率过大,需要适当减小;反之,如果训练集的性能差,但验证集的性能好,那么可能是学习率过小,需要适当增大。

机器学习之常用的分类模型评价指标

机器学习之常用的分类模型评价指标常用的分类模型评价指标是衡量机器学习模型在分类问题上的性能的指标,用于评估模型的准确性和可靠性。

以下是常用的分类模型评价指标:1. 准确率(Accuracy):准确率是最简单直观的评价指标,表示模型正确预测样本的比例。

准确率定义为:准确率 = (正确预测的样本数)/ (总样本数)。

2. 精确度(Precision):精确度衡量模型预测为正样本的准确率,即在所有预测为正样本中,有多少是真正的正样本。

精确度定义为:精确度 = (真正的正样本数) / (预测的正样本数)。

3. 召回率(Recall):召回率衡量模型对正样本的识别能力,即在所有真正的正样本中,有多少被正确预测出来。

召回率定义为:召回率 = (真正的正样本数) / (真正的正样本数 + 假负样本数)。

4. F1分数(F1 Score):F1分数综合考虑了精确度和召回率,用于衡量模型的综合性能。

F1分数定义为:F1=2*(精确度*召回率)/(精确度+召回率)。

5. 特异度(Specificity):特异度衡量了模型对负样本的识别能力,即在所有真正的负样本中,有多少被正确预测出来。

特异度定义为:特异度 = (真正的负样本数) / (真正的负样本数+假正样本数)。

6. 假正例率(False Positive Rate,FPR):假正例率衡量了模型将负样本错误预测为正样本的能力。

FPR定义为:FPR = (假正样本数) / (真负样本数 + 假正样本数)。

7. AUC-ROC:AUC-ROC(Area Under the Receiver Operating Characteristic Curve)是ROC曲线下的面积,用于衡量模型分类准确性的整体能力。

AUC-ROC的取值范围为0.5到1,值越接近1表示模型性能越好。

8. 查准率-查全率曲线(Precision-Recall Curve):查准率-查全率曲线绘制了不同阈值下的查准率和查全率之间的关系。

机器学习中的效果评估指标(Ⅲ)

机器学习中的效果评估指标机器学习在近年来得到了广泛的应用,无论是在商业领域还是科学研究中都发挥着重要作用。

然而,对于机器学习算法的效果评估却是一个不容忽视的问题。

在实际应用中,我们需要准确地评估机器学习模型的性能,以便确定其是否满足实际需求。

本文将探讨机器学习中常用的效果评估指标,帮助读者更好地理解这一重要领域。

一、准确率(Accuracy)准确率是最常见的效果评估指标之一,它简单地表示模型预测正确的样本数量占总样本数量的比例。

例如,如果一个模型在100个样本中正确预测了90个,那么它的准确率就是90%。

虽然准确率直观简单,但在一些情况下并不能完全反映模型的性能。

特别是在样本不均衡的情况下,准确率容易受到影响。

二、精确率(Precision)和召回率(Recall)精确率和召回率是用于评估分类模型性能的重要指标。

精确率表示被预测为正样本的样本中有多少是真正的正样本,而召回率表示真正的正样本中有多少被成功预测出来。

这两个指标常常是矛盾的,提高精确率可能会导致召回率下降,反之亦然。

因此,在实际应用中需要综合考虑这两个指标。

三、F1值F1值是精确率和召回率的调和平均数,它综合考虑了精确率和召回率的性能。

F1值越高,表示模型在精确率和召回率上的表现越好。

在实际应用中,F1值常常被用来评估分类模型的性能,特别是在样本不均衡的情况下。

四、ROC曲线和AUC值ROC曲线是一种用于评估二分类模型性能的图表,它以真阳性率(True Positive Rate)为纵轴,假阳性率(False Positive Rate)为横轴。

ROC曲线下的面积(AUC值)被用来衡量模型的性能,AUC值越大,表示模型在不同阈值下的性能越好。

ROC曲线和AUC值能够有效地评估模型在不同阈值下的表现,特别适用于评估不同模型的性能差异。

五、均方误差(Mean Squared Error)和平均绝对误差(Mean Absolute Error)均方误差和平均绝对误差是用于评估回归模型性能的重要指标。

机器学习技术中的神经网络评估指标介绍

机器学习技术中的神经网络评估指标介绍神经网络评估指标介绍机器学习中的神经网络是一种强大的技术,已经在许多领域取得了巨大成功。

然而,为了确保神经网络的有效性和可靠性,我们需要准确评估其性能。

这就需要使用一些评估指标来衡量模型的表现。

本文将介绍几个常用的神经网络评估指标。

1. 准确性(Accuracy)准确性是最常用的评估指标之一。

它表示模型正确预测的样本比例。

准确性可通过以下公式计算:准确性 = 正确预测的样本数 / 总样本数例如,如果一个神经网络在100个样本中正确预测了80个样本,那么准确性就是80%。

准确性高表示模型的性能较好。

然而,准确性并不能告诉我们模型在不同类别上的性能。

除此之外,如果数据集不平衡,那么准确性可能会得出误导性的结果。

因此,我们还需要考虑其他评估指标。

2. 精确率(Precision)和召回率(Recall)精确率和召回率是用于解决数据集不平衡问题的评估指标。

精确率是指模型预测为正类的样本中真正为正类的比例,召回率是指真正为正类的样本中被模型正确预测为正类的比例。

精确率可通过以下公式计算:精确率 = 真正为正类的样本数 / 预测为正类的样本数召回率可通过以下公式计算:召回率 = 真正为正类的样本数 / 真正为正类的样本数 + 假负类的样本数精确率和召回率都是0至1之间的值,数值越高表示模型的性能越好。

3. F1分数(F1 Score)F1分数是精确率和召回率的调和平均值,用于综合考虑模型的精确性和召回性能。

F1分数可通过以下公式计算:F1分数 = 2 * (精确率 * 召回率) / (精确率 + 召回率)F1分数是0至1之间的值,数值越高表示模型的性能越好。

当模型在精确率和召回率上都有较高值时,F1分数也会相对较高。

4. 均方误差(Mean Squared Error)在回归问题中,我们需要使用不同的评估指标来衡量模型的性能。

均方误差是回归问题中最常用的评估指标之一。

它表示预测值与实际值之间的平均差异程度。

机器学习算法评估准确度分析方法整理

机器学习算法评估准确度分析方法整理机器学习算法的评估准确度分析方法是评估和比较不同算法的性能指标,以确定哪个算法能够更好地解决特定的问题。

在实际应用中,选择一个准确度高、性能稳定的机器学习算法非常重要。

本文将整理几种常用的机器学习算法评估方法,并进行详细介绍。

1. 精确度(Accuracy)精确度是最常见的衡量机器学习算法准确度的方法。

精确度定义为分类正确的样本数除以总样本数。

虽然精确度是一个简单直观的度量指标,但是在某些情况下可能会存在误导性。

特别是当不同类别的样本数量不平衡时,使用精确度评估可能会导致不准确的结果。

2. 混淆矩阵(Confusion Matrix)混淆矩阵是一种更全面的评估分类算法性能的方法。

它将算法的预测结果与真实结果进行比较,并将其分为四个不同的类别:真正例(True Positive,TP)、假正例(False Positive,FP)、真反例(True Negative,TN)和假反例(False Negative,FN)。

根据混淆矩阵,可以计算出准确度、精确度(Precision)、召回率(Recall)以及F1值等指标。

3. 准确度-召回率曲线(Precision-Recall Curve)准确度-召回率曲线是一种常用的评估分类算法性能的可视化方法。

它展示了不同切点阈值下准确度和召回率之间的权衡关系。

准确度指分类正确的正样本所占的比例,召回率指正确分类的正样本数量占总正样本数量的比例。

准确度-召回率曲线能够帮助我们选择合适的阈值,以平衡准确度和召回率之间的关系。

4. ROC曲线(Receiver Operating Characteristic Curve)ROC曲线是一种常用的评估二分类算法性能的方法。

它展示了真正率(True Positive Rate,TPR)和假正率(False Positive Rate,FPR)之间的关系。

TPR是正样本被正确分类的比例,FPR是负样本被错误分类的比例。

accuracy 泛,f1-score和gr作为评价指标 -回复

accuracy 泛,f1-score和gr作为评价指标-回复什么是准确率(accuracy)?准确率(accuracy)是评价一个模型或算法的分类能力的一项重要指标。

准确率是指模型预测正确的样本数量占总样本数量的比例。

准确率高意味着模型的分类能力较好,能够正确地对样本进行分类。

在机器学习和数据挖掘领域,准确率是最常用的评价指标之一。

它对于很多分类任务来说是一个直观且容易理解的指标,因为它为我们提供了一个简单的方式来了解模型的整体分类能力。

然而,准确率并不适用于所有情况,因为在某些场景下,准确率可能会失去作用。

例如,当数据集不平衡时,准确率可能会被主要类别的分类正确率主导,而对于较小类别的分类能力则无法准确反映。

准确率可以通过以下公式计算:准确率= (预测正确的样本数) / (总样本数)但是,准确率并不能提供关于模型的更详细的性能指标,对于不平衡数据集,准确率并不能很好地评估模型的分类能力。

因此,为了更准确地评估模型,我们需要使用其他评价指标,如F1值和GR值。

什么是F1值?F1值是基于准确率和召回率的综合评价指标,主要用于解决数据不平衡问题。

F1值是准确率和召回率的调和平均数,能够更全面地评估模型的分类性能。

准确率(precision)表示预测为正例的样本中真正为正例的比例,可以用以下公式表示:准确率(precision)= (真正为正例的样本数)/(预测为正例的样本数)召回率(recall)表示真实为正例的样本中被预测为正例的比例,可以用以下公式表示:召回率(recall)= (真正为正例的样本数)/(真实为正例的样本数)F1值是准确率和召回率的调和平均数,可以用以下公式计算:F1值= 2 * (准确率* 召回率) / (准确率+ 召回率)F1值的取值范围是0到1,越接近1表示模型的分类性能越好。

当准确率和召回率同时较高时,F1值会取得较高的分数,而当准确率和召回率之一较低时,F1值会相应下降。

深度学习分类问题中accuracy等评价指标的理解

深度学习分类问题中accuracy等评价指标的理解在处理深度学习分类问题时,会⽤到⼀些评价指标,如accuracy(准确率)等。

刚开始接触时会感觉有点多有点绕,不太好理解。

本⽂写出我的理解,同时以语⾳唤醒(唤醒词识别)来举例,希望能加深理解这些指标。

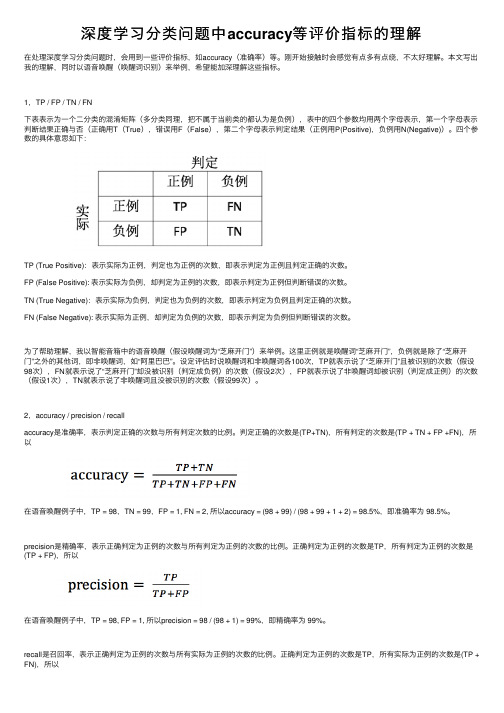

1,TP / FP / TN / FN下表表⽰为⼀个⼆分类的混淆矩阵(多分类同理,把不属于当前类的都认为是负例),表中的四个参数均⽤两个字母表⽰,第⼀个字母表⽰判断结果正确与否(正确⽤T(True),错误⽤F(False),第⼆个字母表⽰判定结果(正例⽤P(Positive),负例⽤N(Negative))。

四个参数的具体意思如下:TP (True Positive):表⽰实际为正例,判定也为正例的次数,即表⽰判定为正例且判定正确的次数。

FP (False Positive): 表⽰实际为负例,却判定为正例的次数,即表⽰判定为正例但判断错误的次数。

TN (True Negative):表⽰实际为负例,判定也为负例的次数,即表⽰判定为负例且判定正确的次数。

FN (False Negative): 表⽰实际为正例,却判定为负例的次数,即表⽰判定为负例但判断错误的次数。

为了帮助理解,我以智能⾳箱中的语⾳唤醒(假设唤醒词为“芝⿇开门”)来举例。

这⾥正例就是唤醒词“芝⿇开门”,负例就是除了“芝⿇开门”之外的其他词,即⾮唤醒词,如“阿⾥巴巴”。

设定评估时说唤醒词和⾮唤醒词各100次,TP就表⽰说了“芝⿇开门”且被识别的次数(假设98次),FN就表⽰说了“芝⿇开门”却没被识别(判定成负例)的次数(假设2次),FP就表⽰说了⾮唤醒词却被识别(判定成正例)的次数(假设1次),TN就表⽰说了⾮唤醒词且没被识别的次数(假设99次)。

2,accuracy / precision / recallaccuracy是准确率,表⽰判定正确的次数与所有判定次数的⽐例。

判定正确的次数是(TP+TN),所有判定的次数是(TP + TN + FP +FN),所以在语⾳唤醒例⼦中,TP = 98,TN = 99,FP = 1, FN = 2, 所以accuracy = (98 + 99) / (98 + 99 + 1 + 2) = 98.5%,即准确率为 98.5%。

远程医疗的现状和发展前景英语作文

远程医疗的现状和发展前景英语作文The current state and future prospects of telemedicineTelemedicine, also known as remote healthcare, is a rapidly growing field that uses technology to provide medical services to patients from a distance. It allows patients to consult with healthcare professionals, receive diagnoses, and even get treatment without the need to visit a doctor's office or hospital in person. The development of telemedicine has been greatly accelerated by advancements in communication technology, especially the widespread availability of high-speed internet and mobile devices with video conferencing capabilities.The current state of telemedicine is quite promising, with many healthcare providers and institutions embracing this innovative approach to delivering medical care. Patients can now connect with doctors and specialists through video calls, chat messages, and even virtual reality platforms. This has proven especially useful for people living in rural or remote areas, where access to healthcare services may be limited. Telemedicine has also been instrumental in improving healthcare access for people with disabilities or chronic conditions that make it difficult for them to travel to medical facilities regularly.One key advantage of telemedicine is its ability to reduce healthcare costs for both patients and providers. By eliminating the need for physical office visits, telemedicine can help lower expenses related to transportation, parking, and lost work hours. This makes healthcare more affordable and accessible for a wider range of people. Additionally, telemedicine can reduce the burden on healthcare facilities by allowing doctors to see more patients in less time, leading to improved efficiency and patient satisfaction.Looking ahead, the future of telemedicine looks very promising. As technology continues to advance, we can expect to see even more innovative applications of telemedicine in the healthcare industry. For example, the use of artificial intelligence and machine learning algorithms can help doctors make more accurate diagnoses and recommend personalized treatment plans based on a patient's medical history and symptoms. Remote monitoring devices can also enable doctors to track patients' vital signs and health metrics in real-time, allowing for earlier intervention and better management of chronic conditions.In addition, telemedicine has the potential to revolutionize mental health care by providing counseling and therapy servicesonline. This can help reduce the stigma associated with mental health issues and make it easier for people to seek help from the comfort of their own homes. Telemedicine can also play a crucial role in disaster response and emergency situations by allowing healthcare providers to quickly assess and treat patients in remote or hard-to-reach areas.Despite its many benefits, telemedicine still faces some challenges, such as regulatory barriers, concerns about data privacy and security, and the need for greater integration with traditional healthcare systems. However, with the ongoing support and adoption of telemedicine by patients, providers, and policymakers, we can expect to see continued growth and expansion of remote healthcare services in the years to come.In conclusion, telemedicine has the potential to transform the way healthcare is delivered and accessed, making it more convenient, cost-effective, and efficient for patients and providers alike. With ongoing advancements in technology and greater acceptance of remote healthcare solutions, the future of telemedicine looks bright and promising.。

机器学习模型评估指标

机器学习模型评估指标机器学习是一种应用于计算机系统的人工智能技术,能够使计算机系统通过自动学习和改进来进行数据分析、模式识别和决策预测。

在机器学习过程中,评估模型的性能和效果是非常重要的。

本文将介绍几种常见的机器学习模型评估指标。

一、准确率(Accuracy)准确率是最直观和常见的机器学习模型评估指标之一。

它是指模型正确分类的样本数量与总样本数量之间的比率。

准确率越高,模型的性能越好。

然而,准确率并不能反映出模型在不同类别上的表现,当数据集存在类别不平衡的情况时,准确率可能会失真。

二、精确率(Precision)和召回率(Recall)精确率和召回率是常用于评估二分类模型的指标。

精确率指的是模型在预测为正例的样本中,真实为正例的比例。

召回率指的是模型能够正确预测为正例的样本数量与真实正例的数量之间的比例。

精确率和召回率之间存在一种权衡关系,提高其中一个指标可能会导致另一个指标的下降。

三、F1分数(F1 Score)F1分数是综合考虑精确率和召回率的指标。

它是精确率和召回率的调和平均值,可以反映模型在同时考虑到预测准确性和覆盖率时的整体性能。

四、ROC曲线和AUC(Area Under Curve)ROC曲线是一种绘制真正例率和假正例率之间关系的图形。

真正例率指的是模型能够正确预测为正例的样本数量与总真实正例数量之间的比例。

假正例率指的是模型将负例样本错误分类为正例的比例。

AUC是ROC曲线下的面积,用来衡量模型分类器的能力。

AUC值越接近1,模型性能越好。

五、平均精度均值(Average Precision)平均精度均值是一种广泛用于信息检索系统中的评估指标。

它能够衡量模型在不同召回率下的精确率表现。

通过计算不同召回率下精确率的平均值,可以得到模型的平均精度均值。

六、对数损失(Log Loss)对数损失是一种常用的度量分类器预测概率分布的指标。

它将模型对每个样本的预测概率与真实标签之间的差异加权求和。

accuracy 泛,f1-score和gr作为评价指标 -回复

accuracy 泛,f1-score和gr作为评价指标-回复什么是准确率(accuracy)?准确率(accuracy)是一种常用的评估机器学习模型性能的指标。

它衡量的是预测正确的样本数量与总样本数量之间的比例。

准确性能反映模型的整体预测能力,它适用于分类问题中的二分类和多分类情况。

在二分类问题中,准确率可以通过以下公式计算:准确率= (True Positives + True Negatives) / (True Positives + True Negatives + False Positives + False Negatives)在多分类问题中,准确率的计算方式略有不同。

例如,在有5个类别的问题中,准确率可以通过以下公式计算:准确率= (预测正确的样本数量)/(总样本数量)准确率的优点在于简单直观,并且易于解释。

然而,在某些情况下,准确率并不能完全反映模型的性能。

什么是F1分数(F1 score)?F1分数是一种常用的综合评估机器学习模型性能的指标。

F1分数是基于准确率和召回率(recall)的调和平均值计算的。

它综合了准确率和召回率两个指标,适用于二分类问题和多分类问题。

F1分数可以通过以下公式计算:F1分数= 2 * (准确率* 召回率) / (准确率+ 召回率)准确率是预测结果中正类别的比例,召回率是真实类别中被正确预测为正类别的比例。

F1分数综合了这两个指标,旨在找到一个平衡点,使得模型在准确率和召回率之间取得最佳平衡。

F1分数相比准确率更能反映出模型的性能。

在不均衡类别分布的问题中,仅使用准确率可能会导致结果偏差。

使用F1分数可以更好地评估模型对于不同类别的预测能力。

什么是GR(generalized mean)作为评价指标?GR(generalized mean)是一种常用的综合评价指标,也被称为p-均值指标。

GR将多个指标的结果通过p次幂的方式进行综合考虑,可以适应不同问题和需求中的评价指标。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Learning More Accurate Metrics forSelf-Organizing MapsJaakko Peltonen,Arto Klami,and Samuel KaskiNeural Networks Research Centre,Helsinki University of Technology,P.O.Box9800,FIN-02015HUT,Finland{Jaakko.Peltonen,Arto.Klami,Samuel.Kaski}@hut.fihttp://www.cis.hut.fic Springer-VerlagAbstract.Improved methods are presented for learning metrics thatmeasure only important distances.It is assumed that changes in pri-mary data are relevant only to the extent that they cause changes inauxiliary data,available paired with the primary data.The metrics arehere derived from estimators of the conditional density of the auxiliarydata.More accurate estimators are compared,and a more accurate ap-proximation to the distances is introduced.The new methods improvedthe quality of Self-Organizing Maps(SOMs)significantly for four of thefive studied data sets.1IntroductionVariable selection or feature extraction is a burning problem especially for ex-ploratory(descriptive)data analysis.The quality of the results is determined by the selection since there is no other supervision.Poor features may emphasize uninteresting properties of the data.An alternative view to feature extraction is that the topology and the metric of the data space need be chosen.We study the choice of the metric;if the topology need be changed it can be done as a preprocessing step.Assume that there exists auxiliary data c paired with the primary data x. Here x is vector-valued and c categorical(finite number of possible values). Assume further that the goal is to study the x,explore or describe them,but that changes in x are only relevant to the extent they cause changes in c.An example is analysis of the causes of bankruptcy,where the x contains features of thefinancial state of a company and c denotes whether the company goes bankrupt or not.In the learning metrics principle([5,9];see[4,5]for more detailed discussion) the distance d between two close-by points x and x+d x of the primary data space is measured by approximations to the distance between the important things,the distribution of c:d2(x,x+d x)≡D KL(p(c|x),p(c|x+d x))=d x T J(x)d x.(1)Here D KL is the Kullback-Leibler divergence and J(x)is the Fisher information matrix having x as its parameters,J(x)=E p(c|x) (∇x log p(c|x))(∇x log p(c|x))T .(2) In earlier studies the metric has either been incorporated into the cost func-tion of a method[9],or the density p(c|x)has been estimated and the Fisher information matrix computed from the estimate[5].Here we extend the latter approach by more accurate density estimators and distance approximation.Since different kinds of data sets may require different kinds of estimators,we suggest choosing the estimator using a validation set.2Self-Organizing Maps in Learning MetricsWe will apply the learning metrics to Self-Organizing Maps(SOMs)[7]to im-prove our earlier results[5].A SOM is a regular lattice of units i.Each unit contains a model m i,a representation of particular kinds of data in the data space.The model vectors are adapted with an iterative training algorithm to follow the distribution of the training data.For brevity,we call a SOM trained in learning metrics SOM-L and a SOM in Euclidean metrics SOM-E.The training algorithm repeats two steps,winner search and adaptation.At each iteration t,an input sample x(t)is picked randomly from the data,and a winner SOM unit w(t)is selected byd2(x(t),m i(t)),(3)w(t)=arg miniwhere d2is the distance function.Here the distance is not in the traditional Euclidean metric but the learning metric(1)derived from the auxiliary data.When the winner has been selected,the model vectors are all adapted towards the input sample in the steepest descent direction.For learning metrics the direction is given by the natural gradient.For the local approximation(1)this leads to the familiar update rulem i(t+1)=m i(t)+α(t)h wi(t)(x(t)−m i(t))(4) which we have used in this paper.Hereα(t)is the learning rate and h wi(t)is the neighborhood function,a decreasing function of the distance between i and w(t)on the SOM lattice.In practical SOM-L training we use two approximations for calculating learn-ing metric distances.Firstly,the matrix J(x)is computed from an estimate of the conditional density p(c|x).The investigated alternatives are introduced in Section3.Secondly,the global distance between two points x and m is actually defined as the minimal path integral of the local distances,where the minimum is taken over all paths between x and m.Finding exact minimal path integrals is computationally prohibitive,so in Section4we consider several approximations. The approximations are compared empirically in Section5.3Estimating the Auxiliary DistributionLearning of the metric is based on the Fisher information matrix of a conditional density estimate.Here we discuss alternative kernel estimators.We have previously derived the conditional densities from estimators of the joint density of x and c.Two standard estimators,the nonparametric Parzen ker-nel estimate and a version of Mixture Discriminant Analysis(MDA2)were used. Here we compare other estimators to MDA2;Parzen was too computationally intensive to be included as such.Since only the conditional densities p(c|x)are needed here,directly estimating them should improve the results.We consider two alternatives.Thefirst is a kind of a mixture of experts(see[3]):ˆp MoE(c i|x)=N Uj=1y j(x)ψji.(5)Here N U is the number of mixture components.Theψji are the parameters of the multinomial distribution generated by the expert j.Their sum isfixed to unity by softmax-reparameterization(not shown).The y j(x)form the gating network;we used Gaussians normalized to sum to unity for each x.The second method for conditional density estimation is a product of experts [2],hereˆp P oE(c i|x)=1Table1.The Data SetsLandsat Satellite Data*3666435Letter Recognition Data*162620000Phoneme Data from L VQ*from UCI Machine Learning Repository[1]Our earlier conditional density estimates have been smooth,obtained with a small number of wide kernels.Such estimates may fail to notice some detail in the density but the simple local approximation(7)may be reasonably accurate be-cause of the smoothness.However,for more accurate estimators that potentially change more rapidly the local approximation may hold only very locally.A more accurate but still computable approximation is obtained by assuming that the minimal path is a line but that the metric may change along the line. When the metric along the line connecting x and m is evaluated at T points, the distance becomesˆd2 T (x,m)=1T(m−x) (m−x) 1/2 2.(8)We call the above the’T-point approximation’.The T-point approximations involve more computation.The computational complexity of a single SOM-L training iteration becomes O(N DIM N C N U N SOM T) for N SOM model vectors with dimensionality N DIM,N C classes,and N U mix-ture components.By comparison,the complexity of the1-point approximation is O(N DIM N C(N U+N SOM)).The T-point winner search may be speeded up byfirst using1-point distances to winnow the set of winner candidates;e.g.the W model vectors that are closest according toˆd21are selected and the winner is chosen from these byˆd2T. In the empirical tests of Section5we have used T=10evaluation points and W=10winner candidates,resulting in a20-fold speed-up compared to the unwinnowed T-point approximation,but computational time compared to the 1-point approximation was still about100-fold.5Empirical TestingThe methods were compared onfive different data sets(Table1).The class labels were used as the auxiliary data and the data sets were preprocessed by removing the classes with only a few samples.The metric was estimated from training data with the methods presented in Sections3and4.The number of mixture components(10,30,or100)and thedispersion parameter were selected using a validation set.The SOM-E and the SOM-L were trained in the resulting metrics,using both the1-point and T-point (T=10,W=10)distance approximations for SOM-L.The accuracy of the resulting SOMs in representing the important auxiliary data was measured by the conditional likelihood evaluated at the winner SOM units[5].The quality of the SOM visualizations was monitored visually.The significance of the difference between the best SOM-L and SOM-E was tested using10-fold cross-validation.The dispersion(Gaussian variance)was validated anew in each fold to maximize map accuracy,using part of the training set for validation.The accuracy(likelihood)for the best map was then calculated for the test set.To reduce the consumption of computational resources,we selected a subop-timal density estimator for the SOM-L having T-point distances:the estimator optimal for1-point SOM-L was chosen with30components.6ResultsThe learning metrics improved the accuracy of the SOMs on all data sets;the improvements were significant by t-test(p<0.05)between SOM-E and SOM-L with the T-point approximation,except for the Bankruptcy data(p=0.07).The mixture of experts(5)was best for SOM-L in three sets,the product of experts in one and MDA2in one.The more accurate distance approximation(8)is crucial.The SOM-L with the1-point approximation was only comparable or worse than SOM-E on two data sets,while SOM-Ls trained with the improved approximation are on average better on all sets.Figure1shows the performance of the SOM-L and SOM-E on one data set in the dispersion validation phase,averaged over the cross-validation folds.The SOM-L with the1-point approximation is here roughly equal to SOM-E,but the SOM-L with the T-point approximation is clearly better for all dispersion values.7DiscussionMore accurate estimation of the learning metrics still improves the SOM results from the earlier results.The computational complexity is higher but manageable with suitable approximations.Based on preliminary results it seems that both of the new elements,more accurate density estimation and more accurate distance approximation,are re-quired.The earlier one-point distance approximations are not accurate enough for the new density estimators capable of following more accurately the details of the conditional density.AcknowledgmentThis work was supported by the Academy of Finland,in part by the grant52123.σL o g −l i k e l i h o o d Fig.1.Average accuracy of SOM-L vs.SOM-E for the TIMIT data over the 10-fold validation sets.The likelihood given by the best pdf estimate (mixture of 100experts)is included for reference;it is the approximate upper limit.References1.Blake, C.L.,and Merz C.J.UCI Repository of machine learning databases./∼mlearn/MLRepository.html,1998.2.Hinton,G.E.Products of Experts.In Proceedings of ICANN’99,the Ninth Inter-national Conference on Artificial Neural Networks ,1–6,IEE,London,1999.3.Jordan,M.,and Jacobs,R.Hierarchical Mixtures of Experts and the EM Algorithm.Neural Computation ,6:181–214,1994.4.Kaski,S.,Sinkkonen,J.Principle of learning metrics for exploratory data analysis.Submitted to a journal.5.Kaski,S.,Sinkkonen,J.,and Peltonen,J.Bankruptcy Analysis with Self-OrganizingMaps in Learning Metrics.IEEE Transactions on Neural Networks ,12:936–947,2001.6.Kaski,S.,and Venna,J.Neighborhood preservation in nonlinear projection meth-ods:An experimental study.In G.Dorffner,H.Bischof,and K.Hornik,editors,Artificial Neural Networks–ICANN 2001,458–491,Springer,Berlin,2001.7.Kohonen,T.Self-Organizing Maps.Springer,Berlin,1995(Third,extended edition2001).8.Kohonen T,Kangas J,Laaksonen J,and Torkkola K.L VQ。